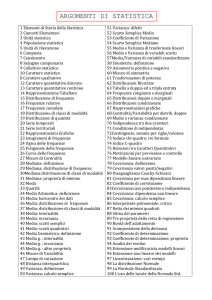

DISPENSE DEL CORSO DI METODOLOGIA DELLE SCIENZE SOCIALI 3

A.A. 2007/2008

PROF.SSA MARIA GRAZIA FISCHER

(Proprietà letteraria riservata)

1. L’ANALISI QUANTITATIVA DEI DATI

1.1 Perché quantificare

Nella ricerca sociale uno degli strumenti più utili è la quantificazione. Con questo termine si vuole definire il

ricorso sistematico ai numeri per descrivere, mettere in relazione e spiegare i fenomeni osservati. Si potrebbe

obiettare che la descrizione può essere fatta anche con il semplice uso delle parole e che la relazione tra due o

più fenomeni può essere individuata sulla base della semplice logica, ma è difficile negare come la quantific azione consenta al ricercatore, oltre ad altri vantaggi, un grado di precisione notevolmente elevato. Affermare

genericamente che, in Italia, gli studenti con maturità liceale raggiungono più facilmente la laurea dei compagni con altro tipo di diploma è, indubbiamente, meno rigoroso che partire dalla valutazione che, dei liceali, si

laurea il 54%, degli studenti con tipo di diploma tecnico il 27% e con diploma professionale il 21%.

Il ricercatore è in grado di rendere conto dei comportamenti umani senza quantificare? Se si vuole essere

precisi e obiettivi la risposta non può che essere negativa: non si può fare scienza, umana o no, senza utilizzare

delle cifre. Se mi limito a dire: “Carlo è alto” da un punto di vista scientifico la mia affermazione non ha nessun valore, può trattarsi di un bambino di prima elementare che è alto rispetto ai compagni della sua età. Dire

che “fa freddo” non ha nessun significato sul piano scientifico, se ci sono 18 gradi a Luglio si può dire che fa

freddo: queste affermazioni dipendono dalla situazione e dal punto di vista di chi le fa, si tratta, in altre parole,

di enunciati soggettivi. Per renderli oggettivi bisogna usare delle cifre, delle misure: la quantificazione consente una maggiore precisione. È certamente più preciso misurare la percentuale di abbandoni che si verifica nell’Università italiana che affermare semplicemente che “in Italia gli abbandoni a livello universitario sono

elevati”. Inoltre, poiché la quantificazione comporta l’operativizzazione dei concetti (nel senso che essi debbono essere definiti e resi misurabili) essa permette di valutare, in modo obiettivo, i fenomeni esaminati: ad esempio la riuscita negli studi può essere misurata usando la percentuale di diplomi o la media nelle votazioni

ottenute.

La quantificazione consente, inoltre, di fare delle comparazioni: il solo modo di verificare se Tizio è più anziano di Caio è di confrontare le rispettive età; se vogliamo confrontare la riuscita di A e B all’esame di Lingua Inglese, dobbiamo confrontare le loro rispettive votazioni: la quantificazione consente la comparazione

dei dati.

Poiché il ricercatore sociale deve accontentarsi, nella maggior parte dei casi, di studiare e analizzare dei

campioni, solo la quantificazione gli consente, per mezzo delle varie procedure statistiche, di generalizzare i

risultati ottenuti su campioni, anche piccoli, a tutta la popolazione di partenza.

La quantificazione permette di individuare delle tendenze generali: con l’uso di misure, più o meno semplici,

permette cioè di individuare le caratteristiche principali di un fenomeno, in modo che, anche partendo dallo

studio di un grande numero di avvenimenti individuali, sia possibile ridurre la massa di dati di base e rendere

più facilmente comprensibili le informazioni raccolte.

La quantificazione permette, inoltre, la verifica sistematica delle ipotesi di ricerca, in modo che i risultati ottenuti siano attendibili e non opinabili come quelli basati solo sulle opinioni o le semplici intuizioni.

Con questo non si vuole asserire che la quantificazione elimini i rischi d’errore nell’interpretazione dei risultati, per quanto precisi essi possano essere; inoltre il metodo impiegato può comportare uno o più errori, diffic ili da rilevare unicamente in base a calcoli statistici.

Facciamo alcuni esempi: anni fa una rivista italiana riportando uno dei tanti “studi” americani, affermava

che le persone che soffrono di miopia sono più intelligenti delle altre. Ovviamente, quello che si sarebbe dovuto scrivere è che chi legge molto e quindi ottiene buoni risultati nei Test di intelligenza, soffre molto più facilmente degli altri di problemi alla vista che generalmente portano alla miopia.

Per quanto riguarda i possibili errori dovuti al metodo basta considerare gli ormai infiniti articoli allarmistici

che riportano “scoperte” di alimenti naturali, da sempre ritenuti innocui e che all’improvviso si dimostrano altamente cancerogeni: cavie, sottomesse a dosi fortissime di un certo alimento, sviluppano dei tumori. Non c’è

tuttavia bisogno di essere grandi scienziati per capire che nessun organismo normale sarebbe mai in grado di

assorbire dosi così massicce come quelle che vengono normalmente usate in questi tipi di esperimenti, di qualunque sostanza si tratti.

Dobbiamo ricordare, quindi, che la quantificazione è una garanzia di precisione e di oggettività ma non va

usata per giustificare qualunque tipo di conclusione: va considerata una condizione necessaria ma non sufficiente

La descrizione numerica di un qualunque fenomeno sociale consente, oltre alla semplice numerazione di

quante volte questo fenomeno si verifica (frequenza), di determinare, con l’aiuto di semplici operazioni matematiche, quale sia la sua importanza relativa all'interno del gruppo sociale a cui si riferisce: in tal modo, per fare un esempio, il numero di studenti che lasciano l’Università può essere trasformato in tasso di abbandono,

ottenendo così un indicatore dell’importanza che questo particolare fenomeno riveste nella società italiana.

1.2. La matrice dei dati

Il disegno della ricerca implica l’individuazione e l’uso di strumenti di rilevazione delle informazioni sulla realtà socia le atte a convalidare, o invalidare, l’ipotesi di partenza fatta dal ricercatore; questi strumenti di rilevazione, che la metodologia sociale ha da tempo messo a disposizione dei ricercatori sono non solo numerosi ma

estremamente vari: tuttavia, qualunque metodo si voglia utilizzare, è indispensabile che i dati raccolti vengano

organizzati in una forma che consenta di analizzarli in modo semplice e corretto. Per ottenere questo tipo di

organizzazione è indispensabile quella che viene definita matrice dei dati: nell’uso corrente essa è costituita

da una griglia rettangolare in cui vengono registrati i dati raccolti. Generalmente le righe della matrice rappresentano i casi, le unità di analisi, mentre le colonne rappresentano le variabili: in ogni cella della griglia vengono

riportati i valori che ‘ogni’ determinato caso assume rispetto ad ‘ogni’ variabile considerata.

Fig. 1. Esempio di matrice di dati

1

2

3

4

5

6

7

8

9

10

2

1

1

2

2

2

1

1

1

2

72

73

73

72

74

72

74

73

73

74

3

1

2

0

3

3

2

1

1

1

24

26

26

27

28

22

28

30

30

26

2

2

3

3

3

2

2

1

1

1

5

4

4

4

5

3

4

5

4

4

Quando si affronta la fase della ricerca che consiste nel passaggio dai dati raccolti, ad esempio tramite

questionario, ad una matrice di dati, per poter procedere all’analisi delle informazioni ottenute, ci si accinge a

creare quello che viene definito il “file” di dati. La traduzione dall’inglese del termine file suggerisce la parola

archivio ed in effetti un file consiste in un insieme di componenti dello stesso tipo, quindi una serie di dati verrà

definito come “file di dati”.

L’analisi e l’interpretazione dei dati raccolti costituiscono la fase cruciale dell’intero processo di ricerca:

l’organizzazione delle informazioni in una matrice è il primo passo che consentirà di iniziarne un esame approfondito.

L’informatica mette ormai a disposizione dei ricercatori numerosi package statistici specifici per le scienze

sociali: uno dei più usati è l’SPSS, acronimo di Statistical Package for the Social Sciences. Questo “pacchetto” di programmi statistici consente di esaminare i dati applicando con facilità tutte le tecniche di analisi specifiche per le scienze sociali, dalle più semplici alle più sofisticate. Quando si entra nel programma la “finestra”

2

che si presenta al ricercatore è quella relativa all’editor dei dati: una matrice in cui le righe corrispondono ai

casi (le unità di analisi) e le colonne rappresentano le variabili.

L’intera finestra (cfr. fig.2) è formata da numerosi componenti: in testa troviamo la barra con il nome del

programma e l’informazione relativa al nome del file di dati su cui si intende la vorare. Nel caso dell’esempio,

la scritta Senza titolo indica che non è stato ancora memorizzato un file di dati e quindi il tabellone è vuoto, in

attesa, appunto, di nuovi dati.

Alla destra della barra del titolo si trovano tre pulsanti: il primo riduce ad icona il programma, il secondo

consente, invece, di allargare il più possibile lo spazio della finestra: puntando il mouse su questi pulsanti e

premendo il tasto di sinistra è possibile, per l’utente, modificare l’ampiezza della finestra in cui sta lavorando.

Il terzo pulsante consente di chiudere il programma ed uscire da SPSS.

Segue la barra relativa ai menu che possono essere aperti e che ha le seguenti voci di menu:

FILE MODIFICA VISUALIZZA DATI TRASFORMA ANALIZZA GRAFICI STRUMENTI

FINESTRA ed, infine, ? 1. Posizionandosi su di esse e premendo il tasto di sinistra del mouse, si apre il menu prescelto e si fanno comparire tutti i sottomenu implementati dal programma:

Fig. 2. Finestra dell’Editor dei dati in SPSS Windows

La finestra dell’Editor dei dati SPSS presenta la possibilità di due tipi di visualizzazione: la visualizzazione dei

dati, che vediamo nell’immagine precedente e la Visualizzazione variabili. I due pulsanti che riportano appunto

VISUALIZZAZIONE DATI e VISUALIZZAZIONE VARIABILI consentono di passare da un tipo di finestra all’altra

con un semplice clic sinistro del mouse. Mentre nella prima finestra vengono visualizzati i dati registrati, la seconda consente, tramite menu, di definire (o visualizzare se già definite) le variabili dando loro un nome, stabilendo se si tratta di una variabile numerica, stringa o di altro tipo, la sua lunghezza,, i decimali, un’etichetta della variabile, un’etichetta delle modalità delle variabili, eventuali valori mancanti, la rghezza della colonna, livello

di misurazione (cfr.Fig.3)

1 . Che sostituisce l’HELP delle precedenti versioni e permettere di accedere alla Guida in linea

3

Fig.3

Torniamo alla barra di menu: ad esempio premendo il tasto di sinistra del mouse alla voce ANALIZZA

della barra di menu, provochiamo la comparsa di un sotto-menu, a tendina, che ci permette di scegliere il tipo

di statistica a cui sottoporre i nostri dati. Per scegliere una delle voci occorre posizionare il cursore del mouse

sulla voce stessa e premere il tasto sinistro: compiendo questa operazione entriamo in una finestra di dialogo

che ci guiderà nella richiesta di elaborazione.

Al fondo della finestra di SPSS troviamo la barra di stato: su di essa viene costantemente segnalato lo stato

del programma. L’utente viene informato se il programma sta lavorando o se è in attesa di comandi, viene

mostrato il numero di casi che si stanno elaborando e, per le procedure statistiche che lo richiedono, il numero

di iterazioni. Sempre su questa barra viene segnalata l’eventuale presenza di un filtro dei dati (nel caso il ricercatore abbia richiesto al programma di compiere le elaborazioni richieste solo se si verificano determinate

condizioni, sulla barra compare la scritta Filtro attivo). Sempre su questa barra viene anche segnalato se i

dati in esame sono stati ponderati (in questo caso comparirà la scritta Peso attivo); infine, il messaggio Distingui attivo comparirà ad indicare che i casi in esame sono stati suddivisi, per l’analisi, in gruppi separati

basati sui valori di una o più variabili.

Nella finestra di Editor dei dati, che potremmo definire ‘foglio di lavoro’, è possibile incominciare a registrare i dati della propria ricerca: come si vede dalla figura, infatti, l’utente si trova automaticamente posizionato sulla prima cella in alto a sinistra della finestra dei dati, che risulta evidenziata da una linea di contorno più scura. Si può incominciare a digitare il primo valore, della prima variabile, del primo caso, valore che

comparirà nella barra che si trova al di sotto delle voci di menu. Premendo il tasto di invio, il dato registrato

viene memorizzato nella cella evidenziata mentre il cursore del programma si sposta nella cella successiva (in

verticale): si passa quindi a registrare il valore del secondo caso relativo alla prima varia bile, si preme invio, si

passa al terzo caso e si procede così fino alla registrazione di tutti i valori di tutti i casi per quanto riguarda la

prima variabile. Prima dell’inizio della registrazione dei dati, in testa ad ogni colonna relativa alle variabili, si

può vedere l’indicazione [ var ], appena leggibile perché non ancora attiva. Appena il processo di introduzione

dei dati ha inizio, invece, in testa alla colonna che si sta riempiendo, compare, nitido, il nome della variabile.

Questo nome, attribuito in modo standard dal programma, è VAR00001, ma naturalmente l’utente potrà, in un

4

momento successivo, variarlo a suo piacere. Sulla cornice della finestra dei dati, a sinistra, compare, inoltre,

accanto ad ogni casella, un numero: è il numero del caso che si sta registrando. Registrati tutti i valori della

prima variabile si può passare a registrare i valori della seconda variabile. Vi sono più modi per tornare in testa alla tabella dei dati: usando il mouse si può muovere il pulsante che si trova sulla barra verticale sulla destra della finestra; puntandovi il cursore del mouse lo si può trascinare fino all’inizio della tabella. Oppure, usando la tastiera, si possono premere contemporaneamente i tasti [Ctrl] e [ã]. Tornati all’altezza del primo

caso, ci si posiziona sulla seconda colonna, che corrisponde alla seconda variabile e si procede a memorizzarne tutti i valori e così via per tutte le variabili della ricerca in esame. Più pratico è però il metodo di

memorizzazione dei dati “caso per caso” invece che “variabile per variabile”. Ci si posiziona, come per il metodo precedente, sulla prima casella e si registra il primo valore della prima variabile del primo caso ma, invece di premere invio, si usa il tasto di tabulazione [ à| ] o la freccia a destra [à ] per procedere orizzontalmente invece che verticalmente. Una volta premuta la freccia, il valore registrato compare nella casella

e l’utente si trova posizionato sulla casella successiva che è la prima della seconda colonna: qui potrà registrare il valore della seconda variabile relativo al primo caso; premendo di nuovo la freccia ci si sposterà poi

sulla terza colonna, dove verrà memorizzato il valore della terza variabile del primo caso... e così via fino alla

registrazione completa dei valori di tutte le variabili per il primo caso. Si passerà quindi al secondo caso premendo il tasto [Invio] dopo l’ultimo dato del primo caso, oppure ci si servirà delle frecce o, ancora, si userà il

mouse, per posizionarsi sulla seconda casella in alto a sinistra, relativa al valore, della prima variabile, del secondo caso. Si procederà a memorizzare tutto il secondo caso e ci si posizionerà sulla terza casella in alto a

sinistra per registrare il valore della prima variabile del terzo caso e così via per tutti i casi della ricerca.

1.3. Editor dei dati e spostamenti all’interno del foglio di lavoro

Se occorre fare qualche correzione nei dati è sufficiente posizionare il cursore nella casella che li contiene,

digitare la correzione e premere [↵] (il tasto Invio). L’utente può copiare e/o muovere le celle che contengono i dati: per farlo è sufficiente posizionarsi su una delle caselle su cui si vuole operare, premere il tasto sinistro del mouse e trascinare il puntatore fino a selezionare tutte le celle. Scegliere Modifica dalla barra di menu e, se si vogliono copiare le celle (ad esempio per riprodurre dati uguali) fare clic su Copia, se invece si vogliono muovere le celle da un posto ad un altro fare clic su Taglia. Fatto questo, muovere il cursore nel punto

in cui si vuole copiare o spostare le celle, fare clic per selezionarle, scegliere dalla barra di menu il comando

Modifica e poi fare clic su Incolla.

Possono anche essere inserite nuove righe di dati: basta sele zionare una cella sulla riga sotto quella dove si

vuole inserire la nuova riga, scegliere dalla barra di menu Modifica ed Inserisci Caso. Per inserire una colonna occorre invece selezionare la cella a destra della posizione in cui deve avvenire l’inserimento e, successivamente, scegliere dal menu Modifica ed Inserisci Variabile .

Per cancellare colonne o righe è sufficiente selezionarle facendo clic sul nome della variabile (per le colonne) o sul numero di riga e scegliere Modifica e Taglia, oppure premere il tasto [Canc].

Per muoversi rapidamente nel tabellone dei dati si possono usare i tasti [ë] per posizionarsi immediatamente sulla prima casella della riga e il tasto [Fine] per raggiungere l’ultima casella della riga; il tasto [Ctrl]

premuto insieme al tasto [á] permette di andare sulla prima riga di una colonna e [Ctrl] premuto insieme al

tasto [â] sull’ultima riga di una colonna.

I tasti [Pagá] e [Pagâ] fanno scorrere la finestra verso l’alto o verso il basso mentre gli stessi tasti premuti contemporaneamente al tasto [Ctrl] permettono lo scorrimento a destra o a sinistra.

Sempre dal menu Modifica, scegliendo Trova è possibile digitare un valore che si desidera trovare (ad

esempio un dato sbagliato) sulla colonna su cui si è posizionati e selezionarlo immediatamente.

1. 4. Definizione delle variabili

5

Quando il ricercatore ha terminato di memorizzare la matrice di dati può passare a definire meglio le variabili: abbiamo visto che il programma assegna ad ogni variabile registrata un nome standard che consiste nelle

lettere VAR seguite da un numero di 5 cifre (es. VAR00001). La definizione delle variabili si effettua selezionando VISUALIZZAZIONE VARIABILI ed inserendo nelle varie colonne le definizioni desiderate.

In questa finestra il nome standard della variabile viene riproposto, evidenziato, nella casella contraddistinta

dalla dicitura Nome. L’utente a questo punto può cambiare il nome della variabile scegliendo quello che preferisce e che maggiormente chiarifica il contenuto della variabile stessa, seguendo però alcune regole fondamentali: i nomi non devono superare (nella versione 14) i 64 caratteri alfa numerici, il primo carattere deve

sempre essere alfabetico, non possono contenere spazi bianchi né terminare con il punto, non possono contenere caratteri speciali (! ? ’ *), possono essere usati una sola volta, cioè non è possibile attribuire lo stesso

nome a due variabili diverse2 . È altamente consigliabile usare un numero di caratteri il più possibile ridotto sia

per compatibilità con versioni precedenti, sia per comodità di riscrittura del nome nel caso si usi la sintassi invece del menu.

La colonna che porta la scritta Etichetta ci consente di abbinare delle etichette 3 alla variabile: queste etichette possono avere sino a 255 caratteri. Nel caso si tratti di una variabile qualitativa, alle sue modalità possono essere attribuite le etichette facendo clic sulla colonna Valori all’altezza della variabile da etichettare; si

apre così una nuova finestra di dialogo che porta, nella barra di testa, la dicitura Etichette dei valori. Qui si

può digitare il valore (in realtà un codice) e sotto un’etichetta che specifichi il significato del codice stesso.

Ad esempio per la variabile SESSO valore 1 maschio, valore 2 femmina. Mentre si attribuiscono le etichet-

Questo pulsante deve essere sempre ‘cliccato’ se si vuole che l’etichettatura sia registrata (nel riquadro centrale della finestra).

te si accende per ogni codice etichettato il pulsante

Fig. 4 – Attribuzione di etichette alle modalità

2. Se si attribuisce il nome TITSTUD alla variabile che indica il titolo di studio dell’intervistato, per indicare la variabile relativa al

titolo di studio del coniuge bisognerà usare un altro, diverso, nome.

3. Le etichette sono sequenze di caratteri associate ai nomi delle variabili o ai loro valori; il loro compito è di rendere chiaro il significato di un nome o di un codice

6

Tornati nel menu principale vediamo il pulsante che porta la scritta Mancante. Nelle ricerche a mezzo

questionario capita spesso che alcune registrazioni manchino: questo avviene soprattutto per le domande di

opinione a cui gli intervistati omettono di rispondere; è quindi importante poter segnalare al programma determinati valori come mancanti, in modo da evitare che un numero eccessivo di risposte non date deformi o invalidi i calcoli che si vogliono effettuare. Con SPSS è possibile ovviare a simili inconvenienti facendo clic su questa colonna nel riquadro relativo alla variabile cui si vuole attribuire uno o più valori mancanti : si apre così una

nuova finestra di dialogo in cui si possono definire sino a tre valori mancanti discreti, o, definire come tali un

intervalli di valori ed un valore discreto.

Fig 5

Il pulsante Colonna consente di intervenire sulla larghezza delle colonne in cui vengono visualizzati i dati,

nella finestra relativa alla matrice dei dati (cioè la finestra di Editor dei dati). La larghezza standard della colonna è determinata dalla larghezza della variabile così come è stata definita (8 al momento dell’immissione od

un altro valore se la variabile è stata ridefinita con il comando Tipo).

La colonna Allinea permette dii decidere se si vuole che i dati siano allineati a sinistra, a destra (lo standard) oppure centrati. Infine la colonna Misura consente di definire, per ogni variabile il suo livello di misurazione: nominale, ordinale o scala.

1.5. Come salvare il file di dati

Una volta che i dati siano stati registrati e le variabili comple tamente definite è bene procedere subito al

salvataggio del file per non rischiare di perdere il lavoro fatto. Per salvare il file occorre posizionarsi sulla barra di menu scegliendo

File ⇒ Salva con nome

Fig.6

7

Si apre così la finestra di dialogo Salva come che consente di dare un nome al proprio file e di memorizzarlo nella cartella scelta. Il salvataggio standard consente di creare un file SPSS Windows che può essere

registrato o su disco rigido o su dischetto; l’estensione dei file SPSS windows è sempre .SAV, in quanto il

programma ricerca automaticamente solo i files con questa estensione. Il ricercatore può, volendo, salvare il

proprio file anche in altro formato (Dbase, Lotus, Excel, Portable ecc). Per farlo l’utente dovrà posizionarsi

sulla lista di formati (elencati nella parte inferiore della finestra nel riquadro accanto alla dicitura Salva come)

e selezionare quello prescelto. Scegliendo, infine, il pulsante Salva si manderà in esecuzione il comando.

Questo tipo di salvataggio dovrà essere eseguito la prima volta che si registra il file. Per salvataggi successivi sarà sufficiente selezionare

File ⇒ Salva

Oppure sarà fare clic sul pulsante

eventuali cambiamenti e/o aggiunte ai dati verranno così registrati nello stesso file, con lo stesso nome.

Solo se si desidera creare un nuovo file, lasciando immutato il primo, si dovrà ricorrere nuovamente a File/Salva con nome e si digiterà un nuovo, diverso, nome di file.

1.7. Richiamare un file SPSS Windows

Per richiamare un file salvato in formato SPSS windows sarà sufficiente selezionare

File ⇒ Apri ⇒ Dati

Si entrerà così nella finestra di dialogo Apri File :

Fig. 7– Finestra di apertura files

8

cliccando su Dati si aprirà una nuova finestra in cui si potrà scegliere, specificando il disco e la cartella, il file

che si vuole richiamare. Facendo clic due volte sul nome del file prescelto, oppure selezionando il pulsante

Apri, i dati verranno richiamati e si aprirà la finestra di lavoro in cui compariranno i dati e le variabili .

1.8. L’ambiente Syntax

Chi usa da molti anni il package SPSS ha spesso avuto a che fare con il cosiddetto “file di comandi”: si

tratta di un file in cui viene registrato un certo numero di comandi SPSS che dicono al programma quali dati

deve usare, come deve leggerli, definirli, analizzarli. Quello che adesso il ricercatore fa aprendo le varie finestre di dialogo dei menu, nelle versioni DOS doveva essere indicato al programma scrivendo dei precisi comandi. In realtà questi comandi vengono tuttora impartiti ad SPSS, ma l’ambie nte windows ha fatto sì che essi

siano completamente “trasparenti” per l’utente. Se si vuole vedere a quali comandi corrispondono le varie azioni che si compiono nelle finestre di dialogo è sufficiente fare clic sul pulsante Incolla. Questa azione ha

l’effetto di immettere i comandi (che il ricercatore ha costruito intervenendo nella finestra di dialogo) in una

nuova finestra, che si chiama Sintax1 (nome standard che può essere cambiato) e costituisce l’Editor della

sintassi SPSS:

Fig. 8. Finestra di Sintassi

9

In questa finestra il ricercatore può agire come se stesse usando un qualunque editor: può scrivere, cancellare, correggere, copiare ecc. I comandi registrati in questa finestra vengono mandati in esecuzione, dopo essere stati selezionati (col mouse o con il tasto Shift [é] unitamente alle frecce) facendo clic sul pulsante

í

oppure scegliendo sulla barra dei menu la voce Esegui

Abbiamo visto come, per mezzo di Incolla, si possa entrare nella finestra di sintassi: l’utente però può,

quando vuole, creare una nuova finestra di sintassi sele zionando:

File ⇒ Nuovo ⇒ Sintassi

Si entrerà così in una finestra di sintassi, vuota, in cui il ricercatore potrà registrare tutta una serie di comandi da mandare in esecuzione. Il contenuto di una finestra di sintassi può essere modificato, a piacere, con

l’editor del programma.

I contenuti di queste finestre, cioè i file sintassi, possono essere salvati su disco e richiamati in qualunque

momento. Quando si desidera salvare questi file occorre attribuire loro un nome di non più di 8 caratteri alfanumerici, seguito dall’estensione .SPS

Per richiamare un file di sintassi è sufficiente scegliere

File ⇒ Apri ⇒ Sintassi

Lavorando si potrà comprendere meglio l’utilità di questi file in cui si possono registrare comandi, anche

lunghi e noiosi, che possono venir richiamati, per essere nuovamente eseguiti, in qualunque momento.

All’utente già esperto, o che abbia comunque già acquisito una certa conoscenza dei comandi SPSS sarà sufficiente, infatti, richiamare file Sintassi già creati, modificarli e mandarli in esecuzione, riducendo così, in modo

notevole, i tempi di lavoro.

Se si è scritta una riga di comandi, ed il cursore è posizionato su tale riga, ma non si è sicuri della sintassi,

facendo clic sul pulsante

che si trova sulla barra degli strumenti, nella parte superiore della finestra di sintassi, si può avere immediatamente in linea la guida SPSS per la costruzione dei comandi.

10

1.9. La Sintassi SPSS

La sintassi SPSS implica l’uso di alcune “parole chiave”, parole che hanno un valore particolare e che non

possono essere usate come nomi di variabili o di file; esse sono: THRU - BY - TO e servono, generalmente, a legare fra loro nomi di variabili (TO e BY) o valori (THRU).

In SPSS vengono usati anche i cosiddetti “delimitatori”: essi rappresentano la punteggiatura del linguaggio

SPSS e si dividono in delimitatori comuni (lo spazio e la virgola) e speciali (virgolette o apici, parentesi, il segno

di uguale (=), lo slash (/) che serve, ad esempio nell’etichettatura di variabili e modalità, ad indicare che il comando prosegue ed il punto (.), terminatore di comando che deve essere sempre inserito alla fine di ogni comando.

IL COMANDO RECODE

Nel corso di una ricerca una delle operazioni più correnti consiste nel ricodificare le variabili: infatti nella

prima fase di un'indagine capita facilmente di avere, per certe variabili, un grande numero di modalità. Un esempio può essere l'età degli intervistati di una inchiesta: una prima codifica di questa variabile, consistente

nell'annotare semplicemente l'età di ogni individuo, dà luogo ad una distribuzione di frequenza con pochi casi

per ogni valore e quindi poco significativa. È quindi importante poter procedere ad una ricodifica delle modalità raggruppandole, ad esempio, in classi di età. In SPSS le operazioni di ricodifica possono essere realizzate

per mezzo dell'istruzione RECODE, il cui campo di specificazione contiene il nome della variabile da ricodificare e, tra parentesi, la lista dei vecchi valori della variabile che si vogliono raggruppare, separati da virgole o

da spazi, il segno di uguale e il nuovo valore. Quando il nuovo valore comprende tutti i vecchi valori osservati,

compresi tra due valori-limite, la scrittura può essere modificata con l'aiuto della parola chiave THRU: ad esempio si può scrivere 18 THRU 23=1 e questa forma abbreviata equivale a 18,19,20,21,22,23=1.

Quando il nuovo valore corrisponde a tutti i vecchi valori inferiori o uguali ad un valore limite, la scrittura

può essere semplificata per mezzo della parola LOWEST. Per esempio la ricodifica di tutti gli individui di età

inferiore o uguale a 23 anni può essere scritta:

RECODE VAR (LOWEST THRU 23=1).

LOWEST può essere abbreviato in LO.

Quando invece il nuovo valore corrisponde a tutti i vecchi valori superiori o uguali ad un valore-limite, la

scrittura può essere semplificata per mezzo della parola HIGHEST. Per esempio la codifica di tutti gli individui di età uguale o superiore a 50 anni può essere scritta:

RECODE (50 THRU HIGHEST=4).

HIGHEST suo essere abbreviato in HI

Quando il ricercatore desidera creare una categoria residua, può utilizzare la parola chiave ELSE che ria ssume tutti i vecchi valori della variabile che non sono ancora stati specificati. La parentesi comprendente la

parola ELSE deve apparire alla fine del campo di specificazione. Quando si deve operare la stessa ricodifica

su più variabili è possibile rimpiazzarne i nomi con lista delle variabili stesse:

RECODE ETAMA ETAPA (60 THRU 68=1) (ELSE=0).

RECODE PROVA1 TO PROVA5 (LO THRU 10=1) (11 THRU HI=2).

Per la ricodifica delle variabili possono essere usate numerose parole chiave oltre a quelle già menzionate;

ad esempio MISSING e SYSMIS: la prima si riferisce alla ricodifica dei valori mancanti in input mentre

SYSMIS si riferisce ai valori mancanti di sistema, validi cioè sia in input che in output.

Esempio:

RECODE ETA (MISSING=9).

in questo caso i valori mancanti assegnati dal ricercatore alla variabile ETA (età dell'intervistato) vengono

ricodificati nel valore 9.

Per non perdere i dati originali è indispensabile ricodificare sempre la variabile originale in una

nuova variabile:

11

RECODE V10 (1,2=1) (3=2)(4=4) INTO STUDPA.

IL COMANDO COMPUTE

Partendo da una o più variabili originali ed effettuando dei calcoli, è possibile creare delle nuove variabili.

Se, per esempio, il ricercatore ha registrato i risultati delle 5 prove di un test, può creare una nuova variabile

che rappresenti la media ottenuta nelle 5 prove, cioè la somma delle votazioni ottenute divisa per cinque. Questa operazione può essere realizzata per mezzo dell'istruzione COMPUTE che comprende, nel suo campo di

specificazione, il nome della variabile calcolata, seguita dal segno di uguale e dall'espressione algebrica che

definisce il calcolo. Le operazioni aritmetiche sono rappresentate dai simboli:

+

*

/

**

addizione

sottrazione

moltiplicazione

divisione

elevazione a potenza

I1 calcolo della media delle prove nel test può, ad esempio, essere scritta:

COMPUTE MEDIAVOTI = ((PROVA1+PROVA2+PROVA3+PROVA4+PROVA5)/5).

Le parentesi vanno utilizzate secondo le regole abituali del calc olo algebrico.

L'espressione algebrica più semplice che possa comportare l'istruzione COMPUTE è quella di uguaglia nza:

COM PUTE NEWVAR=OLDVAR

Si può creare così, ad esempio una variabile identica ad un'altra già esistente in modo da poter procedere

ad eventuali ricodifiche senza dover riscrivere tutti i valori originali. Oppure è possibile creare una nuova variabile (ad esempio un indice) data dalla somma (o da un qualunque tipo di calcolo matematico) su variabili originali.

Esempio:

COMPUTE INDICESOC_CULT = PROFPA+STUDPA+STUDMA.

Con questo comando si crea una nuova variabile, l’Indice di estrazione socio culturale dei soggetti, data

dalla somma delle variabili professione del padre, titolo di studio del padre e titolo di studio della madre.

IL COMANDO IF

È possibile creare una nuova variabile, o un indice, partendo dalla combinazione di più variabili qualitative: questa operazione può essere realizzata per mezzo del comando IF. Questo è uno dei comandi più

potenti del programma e permette anche di realizzare tutte le trasformazioni effettuate per mezzo di

COMPUTE e RECODE. L'istruzione IF è composta da un'espressione logica: se la relazione indicata

nell’espressione logica si verifica, allora il calcolo indicato nella seconda parte dell'istruzione viene effettuato. Nell'ipotesi contraria, il calcolo non è realizzato. L'istruzione IF si presenta dunque come un'istruzione

COMPUTE condizionale. Mentre usando il COMPUTE il calcolo viene effettuato per tutti gli individui, nel

caso dell' IF il calcolo risulta valido solo per gli individui per i quali l'espressione logica risulta vera.

Un'espressione logica può essere semplice o complessa: un'espressione logica complessa è formata da più

espressioni logiche semplici. Un'espressione logica in SPSS si presenta come una relazione fra due quantità:

nell'ipotesi più elementare la comparazione riferisce il valore preso da una variabile ad una costante numerica,

i diversi tipi di relazione sono codificati per mezzo di sei operatori relazionali:

EQ (Equal to)

=

uguale a

NE (Not equal to )

~=

non uguale a

LT (Less than)

<

minore di

GT (Greather Than)

>

maggiore di

LE (Less than or equal to)

<=

minore o uguale

12

GE (Greather Than or equal to) >=

maggiore o uguale

(Possono essere usate sia le abbreviazioni che i simboli)

Così l'espressione logica “media generale superiore a 36” si scrive:

MEDGEN GT 36

I sei operatori possono essere classificati in tre coppie di antinomie

EQ e NE

LT e GE

GT e LE

Per ogni coppia quando uno è vero l'altro e falso, quando uno è falso l'altro e vero. Ad ogni coppia di antinomie può essere applic ata la regola: delle due cose l'una.

Gli operatori LT e GT sono dei contrari: quando uno è vero l'altro è falso, ma quando uno è falso l'altro non

è necessariamente vero, perché possono essere falsi entrambi quando le due quantità considerate sono uguali.

La stessa proprietà è osservabile per le coppie LT ed EQ; gli operatori LT, GT ed EQ costituiscono una triade

di contrari a cui si può applicare la regola: delle tre cose l'una. Gli operatori NE e GE sono dei subcontrari:

quando uno è falso l'altro è vero, ma quando uno è vero l'altro non è necessariamente falso perché essi possono essere veri entrambi quando la prima quantità considerata è più grande della seconda. La stessa proprietà è osservabile per le coppie NE e LE, LE e GE; gli operatori NE, LE, GE costituiscono una triade di sub continui a cui si può applicare la regola: di tre cose due. Vediamo di spiegare meglio con qualche esempio:

immaginiamo uno studio demografico sull'età dei coniugi al momento del matrimonio: per ogni coppia è registrata l'età del marito (variabile ETAMARI) e quella della moglie (variabile ETASPOSA).

I1 ricercatore può voler costruire una variabile rela tiva alla differenza di età (DIFFETA), che prenda valore 1 quando l'età del marito è inferiore a quella della moglie, 2 quando è uguale e 3 quando è superiore. In

questo caso si scriveranno tre istruzioni IF:

IF (ETAMARI LT ETASPOSA) DIFFETA=1.

IF (ETAMARI EQ ETASPOSA) DIFFETA=2.

IF (ETAMARI GT ETASPOSA) DIFFETA=3.

Si vede in questo esempio che l'espressione algebrica che segue l'espressione logica si può ridurre all'attribuzione di una costante; la stessa operazione può essere scritta:

IF (ETAMARI - ETASPOSA LT 0) DIFFETA=1.

IF (ETAMARI - ETASPOSA EQ 0) DIFFETA=2.

IF (ETAMARI - ETASPOSA GT 0) DIFFETA=3.

Si vede da questo secondo esempio che i termini da comparare fra loro possono essere costituiti da una

espressione algebrica

(ETAMARI - ETASPOSA) e da una costante ( 0 ).

Una espressione logica complessa è costituita dalla riunione di più espressioni logiche semplici per mezzo

degli operatori logici AND e OR. And ha lo stesso significato di "e" nel linguaggio corrente e l'espressione

logica complessa, formata dalla congiunzione di due espressioni logiche per mezzo di questo operatore, è vera

quando le due espressioni sono vere. Ad esempio:

(ETAMARI GE 18 AND ETASPOSA GE 18)

è vera solo nell'ipotesi in cui sia il marito che la moglie abbiano un'età superiore o uguale a 18 anni: l'espressione, quindi, ci permette di isolare le coppie in cui gli sposi sono maggiorenni.

13

L'operatore logico OR non ha lo stesso significato di "o" nel linguaggio corrente: si tratta infatti di un "o"

logico che si può tradurre con e/o. In effetti l'espressione logica complessa formata dalla congiunzione di due

espressioni logiche per mezzo dell'operatore OR è vera quando sia l'una, sia l'altra, sia entrambe le proposizioni risultino vere. Per esempio:

ETAMARI GE 18 OR ETASPOSA GE 18

è vera in tre casi:

- il marito è maggiorenne, la moglie minorenne

- il marito è minorenne, la moglie maggiorenne

- i due coniugi sono maggiorenni

L'espressione è falsa solo nel caso in cui entrambi siano minorenni.

Supponiamo che il ricercatore voglia costruire 4 varia bili:

SPMIN: (sposi minorenni) che valga 1 quando i coniugi sono minorenni e 0 negli altri casi

SPMAGG: (sposi maggiorenni) vale 1 se i due coniugi sono maggiorenni e 0 negli altri casi

SPMAGMIN: vale 1 se il marito è maggiorenne e la sposa minorenne, 0 negli altri casi

SPMINMAG: vale 1 se il marito è minorenne e la sposa maggiorenne, 0 negli altri casi.

Si costruisce inizialmente l'istruzione IF che determina le coppie per le quali SPMIN vale 1 (coppie di minorenni):

IF (ETAMARI LT 18 AND ETASPOSA LT 18) SPMIN=1.

che in linguaggio corrente significa: se il marito è minorenne e la moglie è minorenne, allora la variabile

SPMIN (che viene creata in questo momento) varrà 1.

Esaminiamo ora le coppie per le quali la variabile SPMIN varrà 0: sarà sufficiente che uno dei coniugi sia

maggiorenne perché SPMIN sia uguale a 0:

IF (ETAMARI GE 18 OR ETASPOSA GE 18) SPMIN=0.

Nello stesso modo si può procedere per creare la variabile SPMAGG (coppie di maggiorenni):

IF (ETAMARI GE 18 AND ETASPOSA GE 18) SPMAGG=1.

IF (ETAMARI LT 18 OR ETASPOSA LT 18) SPMAGG=0.

La variabile SPMAGMIN (coppie con marito maggiorenne e moglie minorenne) verrà costruita con le istruzioni:

IF (ETAMARI GE 18 AND ETASPOSA LT 18) SPMAGMIN=1.

IF (ETAMARI LT 18 OR ETASPOSA GE 18) SPMAGMIN=0.

Infine la variabile SPMINMAG (coppie con la sposa maggiorenne ed il marito minorenne verrà creata con:

IF (ETAMARI LT 18 AND ETASPOSA GE 18) SPMINMAG=1 .

IF (ETAMARI GE 18 OR ETASPOSA LT 18) SPMINMAG=0.

In SPSS è previsto anche un operatore supplementare NOT che permette di costruire la negazione di una

espressione logica; questo operatore non è indispensabile: si può sempre, con l’aiuto dei 6 operatori relazionali

e dei due operatori logici, costruire la negazione di una espressione logica. Se riprendiamo le istruzioni che

consentono di creare la variabile SPMIN vediamo come può essere usato l'operatore NOT; è sufficiente scrivere:

IF (NOT(ETAMARI LT 18 AND ETASPOSA LT 18)) SPMIN=0

Come si vede l'istruzione IF non è molto semplice da usare ed è assai facile commettere errori di logica.

Per cercare di evitarli si può procedere a numerose traduzioni tra il linguaggio comune e la scrittura logica; ad

esempio: analisi del problema, scrittura dell'espressione logica, ‘ritraduzione’ dell'espressione in linguaggio comune. È anche utile costruire la negazione dell'espressione scritta senza utilizzare l'operatore NOT. Spesso la

difficoltà di costruire l'espressione negativa o l'assurdità della formula ottenuta rivelano un errore nella scrittura dell'espressione positiva.

Quando l'espressione positiva è difficile da scrivere, può essere utile cominciare con il costruire l'espressione negativa e poi dedurne quella positiva. Infine, se il ricercatore ha una certa padronanza dell'algebra di

Boole, è bene scrivere l'espressione in formula simbolica prima di tradurla nella sintassi SPSS.

14

COMANDI DI SINTASSI PER L’OTTENIMENTO DELLE VARIE PROCEDURE STATIS TICHE

FREQUENZE (distribuzioni di frequenza)

FREQUENCIES VARIABLES=varlist .

Oltre a varie opzioni si possono richiedere numerose statistiche (prima del punto e dopo lo slash (/)

/STATISTICS= MEAN STDDEV MINIMUM MAXIMUM

RANGE MODE KURTOSIS MEDIAN SUM

Esempio

FREQUENCIES VAR=V02 TO V20/STATISTICS=mean.

Oppure, più semplicemente:

FREQ V02 TO V20/STAT=MEAN.

CROSSTABS (Tavole di contingenza)

CROSSTABS TABLES=varlist BY varlist [BY...] [/varlist.

CELLS= COUNT ROW COLUMN/STATISTICS= CHISQ.

ESEMPIO:

CROSSTABS TABLES=V02 BY TIPODIP

/CELLS=COUNT ROW/STATISTICS=CHISQ.

DESCRIPTIVES (DESCRITTIVE)

DESCRIPTIVES [VARIABLES=] varname … varname

[/SAVE]

[/STATISTICS=[DEFAULT**] [MEAN**] [MIN**] [SKEWNESS]]

[STDDEV** ] [SEMEAN] [MAX**] [KURTOSIS]

[VARIANCE ] [SUM ] [RANGE] [ALL]

Esempio:

DESCRIPTIVES VARIABLES=ALIMENTI REDDITO, CARNE TO VERDURA,

TIPODIETA/STATISTICS=VARIANCE DEFAULT

/MISSING=LISTWISE.

DESCR ETA REDDITO V12 TO V16.

MEANS (COMPARAZIONE DI MEDIE)

MEANS [TABLES=]{varlist} BY varlist [BY...] [/varlist...]

[/STATISTICS=[ANOVA] [{LINEARITY}] [NONE**]]

Example:

MEANS TABLES=ETA TO ETAISCR BY SESSO

/STAT(ISTICS)=ANOVA.

CORRELAZIONE

CORRELATIONS

/VARIABLES=etadip orelav v22.

15

REGRESSIONE LINEARE

REGRESSION /VARIABLES={varlist }]

/DEPENDENT=varlist

[/METHOD= ENTER (STEPWISE

ESEMPIO:

REGRESSION VARIABLES=POP15,POP75,REDDITO,CRIMINAL

/DEPENDENT=CRIMINAL

/METHOD=ENTER.

Oppure, più semplicemente:

REGRESSION

/DEPENDENT tfreq

/METHOD=ENTER etascpol v16 v47 .

REGRESSIONE LOGISTICA

LOGISTIC REGRESSION VAR=freq2

/METHOD=ENTER sex soccult2 tipodip2 lav2

/CRITERIA PIN(.05) POUT(.10) ITERATE(20) CUT(.5) .

ANALISI DEI GRUPPI (CLUSTER ANALYSIS)

(PER STANDARDIZZARE I DATI:

DESCR LIBRICA NLIBRILE PIALEGG ESTRCULT/SAVE)

CLUSTER ZLIBRICA ZNLIBRIL ZPIALEGG ZESTRCUL/

METHODE=WARD/PLOT=NONE/PRINT=NONE/

SAVE=CLUSTERS (1,4).

ANALISI FATTORIALE ESPLORATIVA

FACTOR

/VARIABLES SODD1 TO SODD4 ROUTINE1 TO ROUTINE4

/MISSING LISTWISE /ANALYSIS SODD1 SODD2 SODD3 SODD4 ROUTINE1 ROUTINE2 ROUTINE3

ROUTINE4

/PRINT INITIAL KMO EXTRACTION ROTATION

/FORMAT SORT

/CRITERIA MINEIGEN(1) ITERATE(25)

/EXTRACTION PC

/CRITERIA ITERATE(25)

/ROTATION VARIMAX

/SAVE REG(ALL)

/METHOD=CORRELATION .

16

La “pulizia dei dati”

Quando il file di dati è stato creato è indispensabile procedere alla correzione degli eventuali errori che

possono essersi verificati durante la raccolta o la registrazione delle informazioni. Pertanto il primo passo che

il ricercatore deve compiere consiste nel richiedere al programma il calcolo delle frequenze di tutte le variabili

introdotte nel file: solo esaminando attentamente tali variabili ci si può rendere conto se vi sono modalità non

previste (ad esempio un codice 5 o 6 nella variabile “Titolo di studio” se essa prevede solo quattro codici: 1=

elementari, 2= scuola dell’obbligo, 3=diploma, 4= laurea). Nel caso si riscontrino valori estranei a quelli prestabiliti è necessario risalire al mezzo di raccolta delle informazioni, si tratti di questionari o d’altro: l’errore

può essere avvenuto durante la registrazione su computer ed in tal caso sarà facile correggere l’inesattezza

sostituendo il valore effettivo a quello sbagliato, oppure può trattarsi si un errore verificatosi durante la raccolta delle informazioni. In questo secondo caso la possibilità di correzione diventa minima perché difficilmente si

potrà risalire all’intervistato per porre nuovamente la domanda: spesso si è costretti ad aggiungere i casi che

presentano valori errati o incongruenti alle mancate informazioni, incrementando così i cosiddetti “missing values”, i valori con cui si codificano le risposte non date o scorrette, che vanno considerati perduti e, quindi, eliminati dal file.

Di norma, prima di procedere all’analisi dei dati vera e propria, il ricercatore valuta, per ogni variabile, la

percentuale di risposte ottenute ed i cosiddetti outliers, termine con cui si definiscono i valori di una variabile

talmente estremi da risultare del tutto incoerenti rispetto alla serie complessiva dei dati: il problema degli outliers consiste nella loro capacità di distorcere, anche gravemente, l’interpretazione dei dati. Si prenda ad esempio una ricerca degli anni ’80 sull’uso del tempo libero degli abitanti della città di Torino: alla domanda relativa al numero di libri letti nell’ultimo anno cinque individui (su oltre 500) indicavano valori altissimi (oltre 90

libri letti). Questi casi estremi alzavano a 8 il numero medio di libri letti in un anno dai torinesi intervistati, mentre il valore della mediana (misura meno sensibile agli outliers) risultava essere 5. Ignorando la presenza di

questi valori estremi ed usando la media, si sarebbe, quindi, corso il rischio di sopravvalutare la capacità di le ttura del campione in esame. Nel caso si riscontri la presenza di outliers, dunque il ricercatore deve ricalcolare

la media escludendo i valori giudic ati incongruenti nel complesso della distribuzione esaminata oppure usare, al

posto della media, troppo sensibile ai valori estremi, la mediana.

L’organizzazione delle informazioni in una matrice è, dunque, il primo passo che consentirà di iniziarne un

esame approfondito e di procedere, secondo passo, alla pulizia dei dati.

Alla creazione del file fa seguito la fase che viene definita: “pulizia” dei dati; il ricercatore deve identificare

i possibili errori commessi durante la registrazione delle informazioni. A questo scopo è bene richiedere, per

prima cosa, le frequenze di tutte le variabili introdotte nel file di dati. L’SPSS risponde a questa richiesta fornendo un listato con tutti i valori delle variabili di cui sia stata richiesta la frequenza, le frequenze assolute e

relative di ciascuno di questi valori, i casi in cui la risposta non è stata data (missing data).

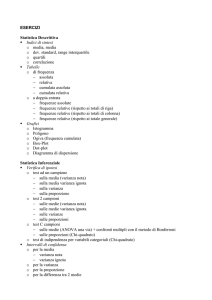

2. L’analisi monovariata

L’analisi e l’interpretazione dei dati raccolti costituiscono la fase cruciale dell’intero processo di ricerca:

partendo dalla matrice dei dati il ricercatore deve, innanzi tutto, prendere in esame singolarmente tutte le

variabili del suo file (ripulite da errori, missing values ed eventuali outliers).

Questa prima fase, che può essere definita “esplorativa”, è fondamentale in quanto anche se nel disegno

della ricerca vengono generalmente già previste le analisi che dovranno essere attuate con le informazioni

raccolte, la loro effettiva realizzazione dipende dalla quantità e qualità dei dati ottenuti e quindi da una iniziale accurata disamina delle variabili considerate singolarmente. Per fare ciò è necessario procedere alla

classificazione delle tecniche di analisi a seconda del tipo di variabili trattate, differenziandole a seconda che

si tratti di variabili nominali, ordinali (categoriali) o misurabili a livello di scale a intervalli o di rapporti (cardinali).

17

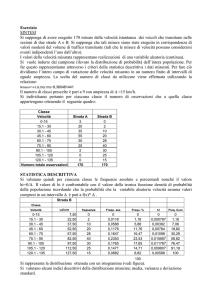

2.1. Le distribuzioni di frequenza

La forma più semplice per esaminare la matrice di dati consiste nel “contare” il numero di persone che

sceglie ognuna delle possibili risposte (modalità) di una domanda (variabile). Il risultato di questa semplicissima

operazione viene definito “distribuzione di frequenza”. Se si considera, ad esempio, la variabile “Tipo di diploma” la distribuzione di frequenza sarà la seguente:

Tab. 1 – Esempio di distribuzione di frequenza (output Spss Windows)

V15 TIPO DI DIPLOMA

Validi

1 MAT.CLASSICA

2 MAT.SCIENTIFICA

3 DIPL.MAGISTR.

4 LICEO LINGUIST.

5 MAT.ARTISTICA

6 RAGIONIERE

7 GEOMETRA

8 PERITO

9 ALTRO DIPLOMA

Totale

Frequenza

74

242

34

56

12

176

30

162

28

814

Percentuale

9.1

29.7

4.2

6.9

1.5

21.6

3.7

19.9

3.4

100.0

Percentuale

valida

9.1

29.7

4.2

6.9

1.5

21.6

3.7

19.9

3.4

100.0

Percentuale

cumulata

9.1

38.8

43.0

49.9

51.4

73.0

76.7

96.6

100.0

Questo esempio riproduce l’output4 fornito dal programma Spss, che dà, oltre alla distribuzione di frequenza, le percentuali, le cosiddette “percentuali valide” (cioè depurate dalle eventuali risposte mancanti e da

quelle che si desiderano togliere dal calcolo) e le percentuali cumulative.

Le frequenze assolute hanno una valenza meramente descrittiva del campione e non consentono alcun tipo

di confronto tra campioni diversi. È quindi necessario calcolare anche le cosiddette frequenze relative, cioè il

rapporto fra le frequenze assolute ed il totale dei casi. Di norma, tuttavia, non ci si limita al calcolo di questo

semplice rapporto ma si preferisce trasformarlo in percentuali, moltiplicandolo per cento. In pratica si preferisce rapportare le frequenze assolute non alla popola zione totale effettiva ma a 100. L’utilizzo delle percentuali

è fondamentale in quanto permette la comparazione di distribuzioni relative a campioni con un differente numero totale di osservazioni.

Il ricercatore sociale si trova a dover analizzare variabili di tipo diverso: si va, infatti, da quelle di tipo qualitativo (o categoriali) a quelle quantitative (o cardinali). Poiché l’analisi dei dati consiste appunto nel tentativo di

misurare le differenze fra le diverse modalità delle variabili di una indagine, è indispensabile usare, a seconda

del tipo di variabile, scale diverse di misurazione 5. La distinzione fra tipi di scale è fondamentale perché consente di determinare il tipo di analisi statistica appropriata: per le variabili di tipo nominale sono indicati solo alcuni tests non-parametrici, quelle ordinali consentono l’impiego dei tests non-parametrici, mentre le variabili

misurabili con scale a intervalli o di rapporti consentono l’uso di tests parametrici.

Le statistiche relative all’analisi monovariata vengono generalmente suddivise in tre gruppi:

− misure di tendenza centrale

− misure di dispersione

− misure relative alla forma della distribuzione

4 Con il termine output si indica il risultato di tutte le elaborazioni che vengono richieste.

5 Per quanto riguarda la classificazione e le scale (o livelli) di misura delle variabili si rimanda al relativo capitolo.

18

2.2.1. Le misure di tendenza centrale

Il ricercatore, al di là della conoscenza dei dettagli di ogni modalità o valore (forniti dalla distribuzione di

frequenza), deve poter individuare, per ogni variabile, degli indici che consentano di sintetizzare la distribuzione

stessa e, quindi, riassumano l’insieme delle informazioni fornite, permettendo così di concentrare, in un unico

valore, l’informazione fornita da una serie di dati. Moda, mediana e media sono le tre misure di tendenza centrale che consentono, appunto, di individuare i valori caratteristici che si trovano al centro di una distribuzione

di frequenza 6.

La moda

La moda è la misura di tendenza centrale più semplice da valutare in quanto è costituita dal valore o dalla

modalità con frequenza più elevata: se, ad esempio, richiediamo la distribuzione di frequenza della variabile relativa al tipo di diploma degli intervistati di un campione, come nell’esempio (cfr. Tab. 1) ci viene fornita una

tabella con una distribuzione in cui la moda è costituita dalla modalità 2 (che ha come frequenza assoluta

242).

Talvolta una distribuzione può avere due o più valori modali e, in tal caso, si parla di distribuzione bimodale

o multimodale: l’esistenza di più di una moda, tuttavia, complica l’interpretazione della distribuzione. A tale inconveniente si aggiunge il fatto che nel calcolo di questa misura non intervengono tutti i valori della distribuzione: il vantaggio di questo indice consiste nel poter essere calcolato per qualunque tipo di variabile in quanto il

livello di misurazione minimo richiesto è quello nominale.

La mediana

La mediana è la misura di tendenza centrale che divide la distribuzione in due parti uguali: questo parametro separa una serie statistica ordinata in due gruppi che comprendono ognuno, approssimativamente, il 50%

dei dati. Il fatto che la mediana si situi a metà della distribuzione consente di conoscere i valori maggiormente

rappresentativi del campione. Poiché la mediana indica la posizione centrale può essere calcolata soltanto per

variabili misurabili almeno a livello di scala ordinale.

Se si considera una distribuzione semplice7 per calcolare la mediana occorre, dopo averla ordinata, verificare se il numero delle osservazioni è dispari o pari. Nel primo caso il ricercatore non ha bisogno di effettuare

nessun calcolo in quanto la mediana sarà costituita dal valore al di sotto e al di sopra del quale viene a trovarsi

il 50% dei dati. Consideriamo, ad esempio, il numero di impiegati che lavorano in 7 diversi reparti amministrativi universitari:

4 6 7 9 11 13 15

la mediana di questa distribuzione è data dal valore 9, in quanto vi sono 3 casi prima di esso, ed altri 3 se ne

contano dopo.

Se il numero di osservazioni della distribuzione è pari, la mediana corrisponde alla media aritmetica delle

due osservazioni centrali:

4 6 7 9 11 13 15 18

Nell’esempio la mediana si situerà fra 9 e 11 e sarà data da:

6 Di qui la definizione di misure di tendenza centrale.

7 . Per distribuzione semplice si intende quel tipo di distribuzione in cui viene considerato un solo valore per ogni modali-

tà. Nelle distribuzioni di frequenza, al contrario, per ogni modalità viene considerata la frequenza, cioè più valori.

19

(9+11)/2 =10 impiegati

Il calcolo della mediana risulta un poco meno semplice se deve essere effettuato su di una distribuzione di

frequenza o su dati raggruppati in classi. Nell’esempio della distribuzione di frequenza relativa all’età, per calcolare la mediana occorre applicare la seguente formula:

Mdn = li + [(0,5n-Σfb)/fw] × i

dove li è il limite inferiore dell’intervallo di classe in cui è situata la mediana; 0,5n è la metà della frequenza

totale; fb è la frequenza cumula ta più alta al di sotto dell’intervallo che comprende la mediana; fw è la frequenza entro l’intervallo in cui si trova la mediana; i è l’ampiezza della classe.

Si consideri ad esempio, la distribuzione di frequenza dell’età delle matricole di Scienze Politiche di Alessandria in una ricerca del 1988 (cfr. Tab. 2.1). Per quanto riguarda la distribuzione dell’esempio si procede

dividendo il campione per 2 (102/2=51) e si trova che la 51ma osservazione è quella che divide la distribuzione

in due parti uguali. Per determinare il valore di li controlliamo le frequenze cumulative e vediamo che la cinquantunesima osservazione corrisponde alle frequenze del valore 20, per cui il limite di classe inferiore è 19,5.

La somma delle frequenze al di sotto dell’intervallo che contiene la mediana equivale a 40, la frequenza

dell’intervallo che contiene la mediana è 22; poiché, infine, i dati non sono raggruppati la i della formula, cioè

l’intervallo di classe sarà 1. Avremo quindi:

Mdn = 19,5 + ((51-40)/22)x 1 Mdn = 20

Tab. 2.1. - Distribuzione di frequenza dell’età degli intervistati8

ETA

Età degli intervistati

Value Label

Value

Frequency

Percent

Valid

Percent

Cum

Percent

18.00

19.00

20.00

21.00

22.00

23.00

24.00

25.00

26.00

27.00

28.00

29.00

30.00

31.00

32.00

33.00

34.00

36.00

44.00

47.00

1

39

22

9

7

1

1

4

2

2

1

2

1

2

1

1

2

2

1

1

------102

1.0

37.9

21.4

8.7

6.8

1.0

1.0

3.9

1.9

1.9

1.0

1.9

1.0

1.9

1.0

1.0

1.9

1.9

1.0

1.0

------100.0

1.0

38.2

21.6

8.8

6.9

1.0

1.0

3.9

2.0

2.0

1.0

2.0

1.0

2.0

1.0

1.0

2.0

2.0

1.0

1.0

------100.0

1.0

39.2

60.8

69.6

76.5

77.5

78.4

82.4

84.3

86.3

87.3

89.2

90.2

92.2

93.1

94.1

96.1

98.0

99.0

100.0

Total

Può accadere che, per meglio descrivere una distribuzione, si voglia indicarne un punto in termini di percentuali di valori che cadono al di sotto di quel punto: per indicare il valore al di sotto del quale si trova una determinata percentuale di valori individuali si usa il termine percentile. Poiché, come si è appena detto, la me8 Viene qui riportata la distribuzione di frequenza di una variabile cardinale al solo scopo di rendere più agevole la com-

prensione del procedimento di calcolo della mediana.

20

diana divide la distribuzione in due parti uguali, costituisce cioè il valore al di sopra e al di sotto del quale si trova il 50% dei valori individuali, essa viene anche definita come cinquantesimo percentile (P50).

I percentili che vengono usati più frequentemente sono il 25°, il 50° ed il 75°. Il valore del 25° percentile è

detto anche 1° quartile (Q1), poiché un quarto dei valori si trova al di sotto di esso. Il secondo quartile (Q2) è

la mediana, mentre il terzo quartile (Q3) corrisponde al 75° percentile, in quanto il 75% dei valori viene a trovarsi al di sotto di esso.

La media

La media aritmetica è la misura di tendenza centrale più comunemente usata e la più rappresentativa e costituisce il valore medio di una distribuzione. Essa costituisce, inoltre, la base di statistiche più complesse.

Il calcolo della media per le distribuzioni semplici avviene in base alla formula:

x=

∑ xi

n

la media aritmetica è data, dunque, dalla sommatoria dei valori individuali di una distribuzione, divisa per il totale delle osservazioni.

Per le distribuzioni di frequenza si ha:

x=

f1x1 + f2 x2 + f3 x3 +... + fn xn

n

dove f 1 f 2 ... f n sono le frequenze che corrispondono a ciascun valore della variabile. Si parla, in questo caso,

di media ponderata e la formula per calcolarla sarà:

x=

∑ fi xi

n

Per la variabile Età del precedente esempio, il calcolo avverrà, dunque, moltiplicando ogni valore per la sua

frequenza (1 x 18, 39 x 19, 22 x 20 ...1 x 47), sommando i prodotti ottenuti e dividendo il risultato per 102, che

è il totale delle osservazioni valide del campione in esame.

Per calcolare la media di una distribuzione di frequenza con dati raggruppati in classi, è indispensabile calcolare, per prima cosa, il valore che meglio rappresenta l’intervallo di classe: a questo scopo si usa il punto

medio di ogni intervallo. Ad esempio per un intervallo di età 18-20 il punto medio sarà 19 e verrà considerato

come il valore che meglio rappresenta l’intervallo. Nella formula del calcolo della media, nel caso di dati raggruppati, al valore verrà, quindi, sostituito il punto medio dell’intervallo e la formula risulterà così trasformata

x=

∑ fimi

n

dove f imi è la frequenza di ciascuna classe moltiplicata per il punto medio dell’intervallo.

L’inconveniente principale di questa statistica è di essere troppo sensibile ai valori estremi: quando la distribuzione include valori molto diversi (o estremi), la media perde di rappresentatività ed è la mediana, in questo caso, a costituire la misura di tendenza centrale più significativa.

2.3.2. La scelta della misura di tendenza centrale

La scelta delle misure di tendenza centrale dipende dal tipo di livello di misurazione delle variabili che si

stanno analizzando e dal tipo di informazione che si desidera. Per le variabili misurate a livello nominale la misura più adatta potrà essere la moda: non avrebbe certo senso calcolare la media della variabile sesso ma è

interessante sapere se, nel campione in esame, prevalgono i maschi o le femmine. Anche per variabili misurabili con altri tipi di scale la conoscenza della moda può rivestire un certo interesse: esso, infatti, indica il valore

più rappresentativo, in quanto più frequente, di una certa distribuzione.

21

La mediana viene usata per variabili il cui livello di misurazione è ordinale o più alto. Essa risulta particolarmente utile quando i valori estremi della distribuzione possono distorcere la media.

La media deve essere usata solo a livello di scale a intervalli o di rapporti: è questa l’unica misura di tendenza centrale che prende in considerazione tutti i valori della distribuzione.

La tabella che segue illustra le relazioni esistenti fra misure di tendenza centrale e livello di misurazione

delle variabili:

Validità d’ uso

Livello

Nominale

Ordinale

Intervalli

Rapporti

Media

Mediana

Moda

no

no

sì

sì

no

sì

sì

sì

sì

sì

sì

sì

LE MISURE DI DISPERSIONE (o VARIAZIONE)

Per riassumere adeguatamente le caratteristiche principali di una distribuzione, il ricercatore deve conoscere,

oltre alle misure di tendenza centrale anche le cosiddette misure di dispersione. Infatti un aspetto importante di

un insieme di dati è proprio il grado di variazione dei suoi valori, che viene definito dispersione. Questa ci permette di misurare il grado di dispersione o di concentrazione della distribuzione di una variabile, cioè in che misura i suoi valori sono simili o diversi fra loro.

Le misure di variazione, dunque, sono quelle misure che riassumono come i valori sono concentrati o dispersi: nel primo caso si dice che i valori sono omogenei, nel secondo si dice che sono eterogenei: due distribuzioni possono avere uno stesso valore centrale ma presentare dispersioni molto diverse. I parametri di dispersione più usati sono il campo di variazione , la differenza interquartile , la varianza e la deviazione

standard o scarto quadratico medio.

Il campo di variazione

La misura più semplice di variabilità di un gruppo di dati è il campo di variazione (o range) che è

costituito dalla differenza fra il valore minimo ed il valore massimo della distribuzione:

Range

= H − L

H = valore massimo

L = valore minimo

La varianza e la deviazione standard

La varianza permette di misurare la dispersione dei dati attorno alla media ed è costituita dal rapporto fra la

somma dei quadrati delle deviazioni dalla media ed il totale dei casi. Per devia zione dalla media si intende la

differenza fra un qualunque dato della distribuzione e la media della distribuzione stessa e viene descritta come x i − x .

La formula della varianza è:

22

σ

∑ fi ( x i − x )

=

N

2

2

Se si analizzano i dati di un campione estratto da una popolazione piuttosto ampia è necessario, per ottenere una stima migliore della varianza della popolazione, dividere per N-1, per cui la formula viene corretta in

questo modo:

s2 =

∑ fi ( xi − x )2

n− 1

Un valore della varianza ampio significa che i valori sono abbastanza dispersi; valori piccoli indicano che

le osservazioni sono abbastanza simili: un valore 0 indicherebbe che tutti i valori sono uguali.

SCARTO QUADRATICO MEDIO ( DEVIAZIONE STANDARD)

Poiché la varianza viene calcolata elevando al quadrato le differenze dalla media, per avere un’unità di misura che non sia espressa al quadrato ma sia la stessa unità di misurazione con cui sono espresse le osservazioni, al ricercatore conviene calcolare la radice quadrata della varianza, calcolare, cioè, la deviazione standard o scarto quadratico medio, che si ottiene con la formula:

s=

∑ fi ( xi − x ) 2

n−1

È la misura di dispersione più frequentemente usata; è basata sulla media

s =

∑ fi ( x i − x ) 2

n − 1

Consideriamo 2 serie di valori:

27 28 29 30 31 32 33

15 20 25 30 35 40 45

Queste due serie provengono da due gruppi distinti formati ciascuno da 7 bambini dei quali è stato misurato il

peso in chilogrammi. La media di entrambe è 30

(27 + 28 + 29 + 30 + 31 + 32 + 33) / 7 = 30 [1]

(15 + 20 + 25 + 30 + 35 + 40 + 45) / 7 = 30 [2]

tuttavia la seconda serie ha un campo di variazione maggiore della prima

Range 1 33 - 27 = 6

Range 2 45 - 15 = 30

Per confrontare la dispersione delle due serie possiamo sommare gli scarti di ciascun valore dalla media.

Questa somma ci permette di valutare se i valori si allontanano più o meno dal centro.

Scarto dalla media Serie 1

Scarto dalla media Serie 2

27-30 = -3

15-30 = -15

28-30 = -2

20-30 = -10

29-30 = -1

25-30 = -5

30-30 = 0

30-30 = 0

31-30 = 1

35-30 = 5

32-30 = 2

40-30 = 10

33-30 = 3

45-30 = 15

Totale = 0

Totale = 0

23

Sussiste però un problema: a causa dei segni negativi, la somma degli scarti darà sempre 0. Per ovviare a

questo inconveniente possiamo elevare ogni scarto al quadrato, perdendo in tal modo il segno negativo.

Scarto dalla media Serie 1

Scarto dalla media Serie 2

(27-30)2 = 9

(28-30)2 = 4

(29-30)2 = 1

(30-30)2 = 0

(31-30)2 = 1

(32-30)2 = 4

(33-30)2 = 9

Totale = 28

(15-30)2

(20-30)2

(25-30)2

(30-30)2

(35-30)2

(40-30)2

(45-30)2

= 225

= 100

= 25

= 0

= 25

= 100

= 225

Totale = 700

Come ci si poteva aspettare i valori ottenuti per la seconda serie sono più grandi di quelli ottenuti per la prima.

Per riportare questi valori ad una grandezza più ragionevole si può calcolarne la media dividendo la somma

per 7: troviamo così quella che viene chiamata VARIANZA che è 4 (28/7) per la prima serie e 100 (700/7)

per la seconda. Ma per togliere i segni meno abbiamo dovuto elevare al quadrato, quindi avremo dei pesi in

chilogrammi al quadrato. Per tornare ad avere una grandezza nella stessa unità della serie originale possiamo

fare la radice quadrata della varianza, ottenendo quello che in Italia viene definito SCARTO QUADRATICO

MEDIO (e nei paesi anglossassoni è definito DEVIAZIONE STANDARD)

Otteniamo così rispettivamente 2 e 10

Più la deviazione standard è piccola più la serie è vicina alla media , più è grande più la serie ha

valori che si allontanano dalla media.

2.5. Le misure relative alla forma della distribuzione

Queste misure considerano la disposizione dei valori in una distribuzione (rispetto alla curva normale) e

quindi l’asimmetria e la forma della distribuzione stessa.

L'Asimmetria (o Skewness) è un indicatore del modo in cui le frequenze si raggruppano sulla curva di

una distribuzione di frequenza: se il suo valore è zero la curva è simmetrica, corrisponde, cioè, alla curva normale e media, mediana e moda coincidono. Se l’indicatore di asimmetria è maggiore di zero si ha una distribuzione asimmetrica a destra (di segno positivo): ciò significa che i casi si raggruppano sulla sinistra della curva

e che, nella distribuzione esaminata, la maggior parte dei valori è inferiore alla media. Se, al contrario,

l’indicatore di asimmetria è minore di zero si ha una distribuzione asimmetrica a sinistra (di segno negativo), i

casi si raggruppano sulla destra della curva e la maggior parte dei valori è superiore alla media. In linea di

massima un valore dell’indicatore superiore a 0.8 in valore assoluto (cioè considerato indipendentemente dal

segno) segnala una rilevante asimmetria della distribuzione.

Un altro indicatore del tipo di forma della curva di una distribuzione è la Curtosi, che consente di rilevare

se si verifica una maggiore o minore concentrazione di valori intorno alla media . La distribuzione di certe variabili può essere più alta e più stretta: questa forma indica che la varianza è piccola in quanto vi è un’alta

concentrazione di valori intorno alla media; in questo caso la media è molto rappresentativa (in quanto la dispersione intorno ad essa è minima) e la curva viene definita leptocurtica (dal greco lepto = sottile). La curva

che ha una dispersione di osservazioni intorno alla media “normale” è simile alla curva normale e viene definita mesocurtica (dal greco mésos = medio). Una curva larga ed appiattita viene, invece, definita platicurtica

(da platys = largo) ed indica una varianza piuttosto grande in quanto si verifica un’elevata dispersione dei va-

24

lori intorno alla media. Se il valore dell’indicatore è positivo significa che la curva della variabile è leptocurtica,

se è 0 la distribuzione è mesocurtica, se è negativo è pla ticurtica.

Tutti i pacchetti statistici hanno specifiche procedure che consentono di ottenere in modo facile e veloce,

attraverso gli appositi Menu, le distribuzioni di frequenza delle variabili che si vogliono esaminare e le principali

statistiche relative all’analisi monovariata. Ad esempio Spss mette a disposizione, nel menu Analizza ð Statistiche descrittive, la voce Frequenze che apre una apposita finestra in cui compare, in un riquadro sulla

sinistra, l’elenco di tutte le variabili del file che si sta analizzando. Selezionando le variabili che si vogliono analizzare se ne può, così, ottenere velocemente la distribuzione di frequenza e, agendo sul pulsante specifico, se

ne possono avere le relative statistiche e/o i grafici.

Finestra “Frequenze” di Spss Windows

2.6. La rappresentazione grafica

Oltre che per mezzo delle tavole di frequenza le informazioni possono essere rappresentate anche in forma

grafica: proprio per le distribuzioni di frequenza il vecchio detto “un’immagine vale più di mille parole” si dimostra assai spesso veritiero in quanto un grafico è in grado di sintetizzare un gran numero di cifre. Fra i grafici

più usati ricordiamo il diagramma a barre, l’istogramma, il grafico a torta (o diagramma circolare.

Consideriamo ad esempio la variabile “Tipo di diploma” di cui abbiamo già visto la distribuzione di frequenza: con l’aiuto del programma Spss possiamo ottenere un grafico riassuntivo che consente di cogliere immediatamente le informazioni desiderate:

25

40

30

30

20

22

20

Percent

10

9

7

4

4

0

3

O

TR

AL

MA

LO

DIP

O

RIT

PE

RA

ET

OM

GE

E

IER

ON

GI

RA

ICA

IST

RT

T.A

MA

.

IST

GU

LIN

EO

LIC

R.

IST

AG

L.M

DIP

CA

IFI

NT

CIE

T.S

MA

A

IC

SS

LA

T.C

MA

TIPO DI DIPLOMA

Il diagramma a barre, come quello qui mostrato, viene usato per la rappresentazione grafica di variabili misurabili a livello di scala nominale o ordinale: esso è costituito da una serie di rettangoli9 (barre) il cui numero è

determinato dal numero delle modalità e la cui altezza è direttamente associata alla frequenza di ciascuna modalità. Si può scegliere di costruire il grafico sulla base delle frequenze assolute o sulle percentuali (come

nell’esempio). Questo tipo di diagramma è uno dei più semplici e dei più usati e può essere presentato con le

barre poste in modo verticale od orizzontale.

Anche il diagramma a torta viene usato per variabili nominali od ordinali: il cerchio, la torta, rappresenta la

totalità dei casi esaminati ed ogni settore, ogni porzione di torta, è associato alla frequenza di una modalità.

Poiché si avranno, quindi, tanti settori quante sono le modalità della variabile, questo tipo di diagramma è più

adatto a rappresentare variabili con non più di sei o sette modalità:

Titolo di studio del padre

laurea

elementari

13.5%

19.7%

superiori

medie

36.9%

30.0%

Per le variabili metriche il grafico più adeguato è l’istogramma: esso può assomigliare, a prima vista ad un

diagramma a barre ma fra i due vi è una differenza sostanziale: i rettangoli dell’istogramma sono disposti in

300

200

100

9 Attualmente tutti i package statistici consentono la costruzione di grafici bidimensionali o tridimensionali come questo

Std. Dev = 4.86

dell’esempio.

Mean = 25.3

N = 814

0

20.0

25.0

22.5

30.0

27.5

35.0

32.5

40.0

37.5

45.0

42.5

50.0

47.5

26

modo contiguo, senza il minimo spazio intermedio, in quanto servono ad illustrare variabili continue, anche se

sono state create (dal ricercatore o dal programma) delle classi. Queste possono essere più o meno ampie e,

abitualmente, vengono costruite in modo da presentare tutte la stessa ampiezza. Spss, ad esempio, raggruppa

automatic amente i valori in intervalli di cui mostra il punto medio e, a richiesta, sovrappone

all’istogramma dei dati del campione che si sta analizzando la curva normale, consentendo in tal modo di

controllare immediatamente quanto la distribuzione della variabile esaminate si avvicini o differisca da quella

“normale”.

3. L’analisi bivariata

L’osservazione dei comportamenti sociali o individuali permette di constatare come essi, spesso, non siano

indipendenti tra loro: si nota che fra i diversi fenomeni osservati esistono determinate associazioni o relazioni.

Il trovarsi di fronte ad un certo numero di avvenimenti o comportamenti diversi porta a domandarsi se esista

una relazione fra di essi, se siano, cioè, legati fra loro: non ci si può, quindi, accontentare di esaminarli singolarmente ma si cerca di individuare l’esistenza di relazioni che li uniscano. Quindi per quanto l’analisi monovariata sia importante e, almeno inizialmente, indispensabile, l’interesse maggiore del ricercatore sociale si rivolge allo studio delle relazioni fra variabili: molto spesso, del resto, le stesse ipotesi di ricerca si esprimono appunto in questa forma. Si procede, pertanto, ad effettuare quella che viene definita “analisi bivariata”: essa

può avere obiettivi meramente descrittivi o, come accade più frequentemente, avere finalità esplicative che

consistono nell’analisi delle relazioni causali fra due variabili, una indipendente e una dipendente.

Nella ricerca sociale, dove le variabili sono di tipo prevalentemente qualitativo, uno dei metodi più diffusi

per procedere a questo tipo di analisi è la costruzione delle tavole di contingenza (dette anche incroci, tabelle a

doppia entrata o tabulazioni incrociate). Si tratta di tabelle in cui, in uno spazio bidimensionale, vengono presentate le combinazioni delle categorie di due variabili, “incrociate” fra loro, e che ne mostrano, quindi, simultaneamente, le variazioni. In una tavola di contingenza a due variabili si hanno due assi, uno orizzontale ed uno

verticale: sul primo sono riportate le categorie della variabile che formerà le colonne della tabella, sul secondo

le categorie della variabile che formerà le righe. La dimensione di una tavola di questo tipo è data dal numero

delle variabili che la compongono, indipendentemente dal numero delle categorie: una tavola che prende in