1

Torna all’indice

Teoria dei Segnali

Introduzione

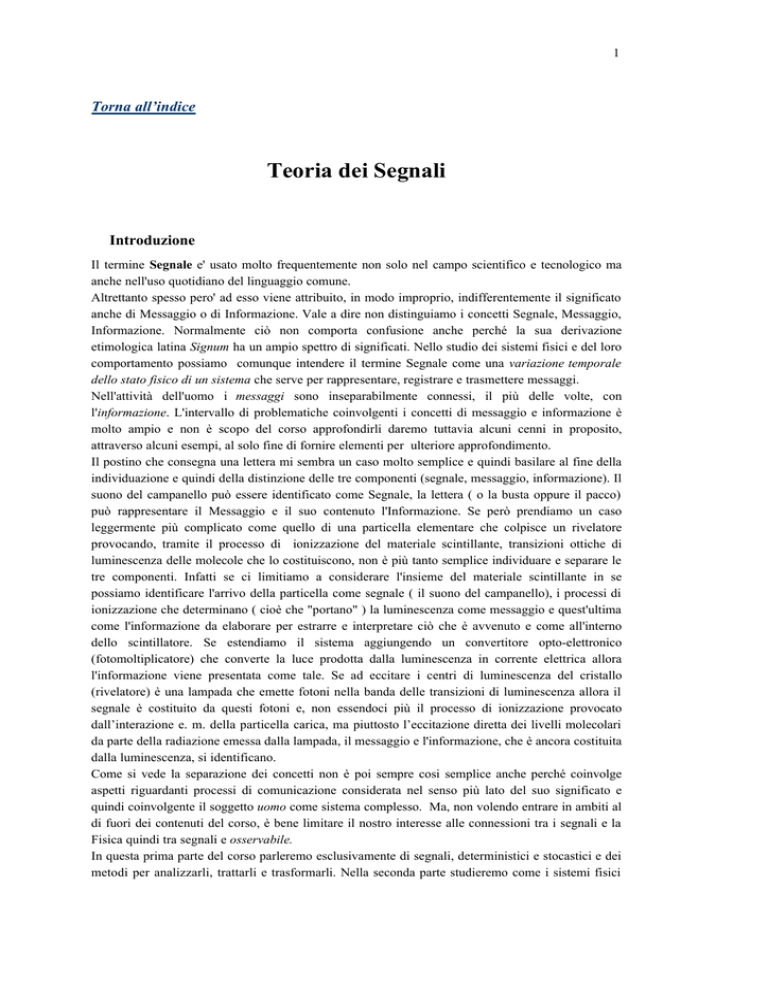

Il termine Segnale e' usato molto frequentemente non solo nel campo scientifico e tecnologico ma

anche nell'uso quotidiano del linguaggio comune.

Altrettanto spesso pero' ad esso viene attribuito, in modo improprio, indifferentemente il significato

anche di Messaggio o di Informazione. Vale a dire non distinguiamo i concetti Segnale, Messaggio,

Informazione. Normalmente ciò non comporta confusione anche perché la sua derivazione

etimologica latina Signum ha un ampio spettro di significati. Nello studio dei sistemi fisici e del loro

comportamento possiamo comunque intendere il termine Segnale come una variazione temporale

dello stato fisico di un sistema che serve per rappresentare, registrare e trasmettere messaggi.

Nell'attività dell'uomo i messaggi sono inseparabilmente connessi, il più delle volte, con

l'informazione. L'intervallo di problematiche coinvolgenti i concetti di messaggio e informazione è

molto ampio e non è scopo del corso approfondirli daremo tuttavia alcuni cenni in proposito,

attraverso alcuni esempi, al solo fine di fornire elementi per ulteriore approfondimento.

Il postino che consegna una lettera mi sembra un caso molto semplice e quindi basilare al fine della

individuazione e quindi della distinzione delle tre componenti (segnale, messaggio, informazione). Il

suono del campanello può essere identificato come Segnale, la lettera ( o la busta oppure il pacco)

può rappresentare il Messaggio e il suo contenuto l'Informazione. Se però prendiamo un caso

leggermente più complicato come quello di una particella elementare che colpisce un rivelatore

provocando, tramite il processo di ionizzazione del materiale scintillante, transizioni ottiche di

luminescenza delle molecole che lo costituiscono, non è più tanto semplice individuare e separare le

tre componenti. Infatti se ci limitiamo a considerare l'insieme del materiale scintillante in se

possiamo identificare l'arrivo della particella come segnale ( il suono del campanello), i processi di

ionizzazione che determinano ( cioè che "portano" ) la luminescenza come messaggio e quest'ultima

come l'informazione da elaborare per estrarre e interpretare ciò che è avvenuto e come all'interno

dello scintillatore. Se estendiamo il sistema aggiungendo un convertitore opto-elettronico

(fotomoltiplicatore) che converte la luce prodotta dalla luminescenza in corrente elettrica allora

l'informazione viene presentata come tale. Se ad eccitare i centri di luminescenza del cristallo

(rivelatore) è una lampada che emette fotoni nella banda delle transizioni di luminescenza allora il

segnale è costituito da questi fotoni e, non essendoci più il processo di ionizzazione provocato

dall’interazione e. m. della particella carica, ma piuttosto l’eccitazione diretta dei livelli molecolari

da parte della radiazione emessa dalla lampada, il messaggio e l'informazione, che è ancora costituita

dalla luminescenza, si identificano.

Come si vede la separazione dei concetti non è poi sempre cosi semplice anche perché coinvolge

aspetti riguardanti processi di comunicazione considerata nel senso più lato del suo significato e

quindi coinvolgente il soggetto uomo come sistema complesso. Ma, non volendo entrare in ambiti al

di fuori dei contenuti del corso, è bene limitare il nostro interesse alle connessioni tra i segnali e la

Fisica quindi tra segnali e osservabile.

In questa prima parte del corso parleremo esclusivamente di segnali, deterministici e stocastici e dei

metodi per analizzarli, trattarli e trasformarli. Nella seconda parte studieremo come i sistemi fisici

2

elaborano, trasferiscono e trasformano le sollecitazioni di natura sia deterministica che stocastica, per

generare una risposta interpretando la quale otterremo l'informazione relativa al processo fisico

avvenuto nel sistema. Come esempio molto diffuso di sistema nel quale avvengono processi

stocastici, nella terza parte prenderemo in esame i rivelatori di particelle con particolare attenzione a

quelli basati su i processi di luminescenza.

Per la trattazione dei segnali, in questa prima parte, e successivamente per l'analisi dei sistemi, ci

avvarremo spesso di esempi che fanno riferimento al mondo delle telecomunicazioni o

dell'elettronica a puro ed esclusivo scopo di semplicità intendendo che tutti i metodi sperimentali e

matematici descritti e analizzati hanno carattere di totale generalità e quindi applicabili a tutti i

segnali o sistemi fisici che sono e rimangono gli unici obiettivi del corso essendo, quelli appartenenti

al campo dell'elettronica, dei semplici strumenti per una più immediata e realizzabile modellazione

Modello matematico

I segnali, in quanto variazione temporale dello stato fisico di un sistema, possono essere osservati

ovvero sono suscettibili di una operazione di misura attraverso un gran numero di modi e di

strumenti che possono variare enormemente a seconda della variabile fisica sorgente della

variazione. Occorre però prestare molta attenzione all'approccio sperimentale in quanto può essere

soggetto a forti limitazioni. Infatti il processo osservato si manifesta sempre come specifico, come

evento singolo o individuale che manca del grado di generalità necessario per formarsi un'idea circa

le proprietà fondamentali che lo generano. Risulta quindi necessario affrontare lo studio dei

comportamenti per via teorica e definire, successivamente, un modello matematico che sia capace,

ovviamente, di descrivere il reale comportamento del .processo a tutti i tempi cioè darne l'evoluzione

temporale, in modo esatto se esso è di tipo deterministico o in modo probabilistico se invece è di tipo

stocastico e quindi di predire i risultati sotto mutate condizioni fisiche. L'importanza della

definizione di modello matematico risiede anche nel fatto che dà la possibilità allo sperimentatore di

separare le proprie convinzioni dalla natura specifica del processo preso in esame. Un altro aspetto

dell'utilità del metodo basato sul modello matematico consiste nel poter limitare l'analisi solo alle

proprietà oggettivamente più importanti, a quelle ritenute fondamentali e tralasciare un gran numero

di attributi secondari di minore importanza o comunque di minore interesse fisico.

La scelta del modello è il primo importante passo verso lo studio sistematico di un fenomeno fisico

che, nel nostro caso, è rappresentato da un segnale. E' anche interessante notare come uno stesso

modello matematico può descrivere ugualmente bene diversi processi fisici. Si pensi al modello a

strati atomico e al modello a shell nucleare o al modello dell'oscillatore armonico utilizzato nella

meccanica, nell'elettromagnetismo, nella fisica nucleare e subnucleare e cosi via, al modello

esponenziale che ben descrive i processi di assorbimento di radiazioni nella materia, la carica e

scarica di capacità,..ecc.

Possiamo in sintesi dire .che intendiamo per modello matematico, di un processo fisico in generale,

di un segnale in particolare, una relazione funzionale il cui argomento è il tempo e che indicheremo

pertanto con s(t), f(t), u(t),...

In ultima analisi il modello ci permette di confrontare, di classificare e di stabilire le somiglianze tra

segnali.

La loro classificazione può essere fatta in tanti modi diversi a seconda della proprietà che si intende

classificare. Quindi avremo segnali di tipo Unidimensionale o Multidimensionale (Vettori) se si

vuole evidenziare la dimensionalità attraverso la quale essi si esibiscono. Saranno di tipo

Deterministico oppure Stocastico se la loro modalità di evolversi nel tempo è prevedibile oppure

casuale. Potranno ancora essere Analogici oppure Discreti se si presentano come Continui o

Discontinui nel tempo. E' comunque possibile una combinazione qualsiasi delle suddette modalità e

3

risulta evidente la necessità di uno spazio rappresentativo per la definizione e la manipolazione dei

medesimi.

4

Segnali Deterministici

Un segnale è deterministico se il suo valore istantaneo può essere predetto ad ogni istante.

Esso può essere specificato:

1.Attraverso una formula matematica

2.Un algoritmo computazionale

Tuttavia occorre notare che segnali di tale tipo non esistono in natura!

Infatti a causa dell'inevitabile interazione tra la sorgente del segnale e l'ambiente circostante oppure

per le caotiche fluttuazioni, a livello macroscopico, della stessa variabile fisica sorgente del segnale (

si pensi alla temperatura, alla pressione, al campo elettrico, ecc.), o ancora ad effetti quantistici a

livello microscopico, portano alla conseguenza che gli unici segnali reali sono di natura casuale o

stocastica.

Nelle tele o radiocomunicazioni, fluttuazioni casuali si manifestano come rumore dal quale occorre

estrarre l'informazione. Questo è un problema molto serio quando si debbano ricomporre, ad

esempio, immagini provenienti da satellite. Si richiede allora l'uso di tecniche molto sofisticate che

impiegano algoritmi di ricostruzione dell'immagine ( come il filtro di Kalman).

Non sempre però il segnale casuale e' da considerarsi rumore o indesiderato. Infatti, ad esempio, una

sorgente cosmica emette delle fluttuazioni che non sono rumore ma anzi ci danno informazioni

importanti circa l'evoluzione e la natura dell'oggetto cosmico e quindi va considerato come segnale

significativo.

Molto spesso, come si vede, è difficile distinguere tra evento significativo (segnale) e fluttuazione

(rumore) comunque, come vedremo, si può assumere un modello matematico anche per segnali non

deterministici o quasi stocastici.

Segnali Unidimensionali

Tali segnali sono descritti tramite una funzione del tempo come, ad esempio, la tensione V(t) agli

estremi di un circuito elettrico, la temperatura T(t) di un sistema termodinamico, la velocità v(t) di

efflusso dei gas di un razzo, ecc.

Sono quelli che useremo di più in questa trattazione.

Segnali Multidimensionali

[

]

Insieme ordinato di segnali unidimensionali. V1 (t ), V 2 (t ), V3 (t ),... come, ad

esempio, le differenze di potenziale esistenti ai terminali di un dispositivo multi

porte (v. fig.). Attenzione

Attenzione :

[V1 (t ), V2 (t )] ≠ [V2 (t ), V1 (t )]

perchè è un insieme ordinato.

5

Segnali Continui

Volendo fare una classificazione utile in senso pratico possiamo distinguere i segnali in base alla loro

evoluzione temporale. Essi quindi possono essere: Continui, Discreti, Digitali

I segnali sono Continui o Analogici quando il loro valore può essere misurato in ogni istante.

L'aggettivo 'analogico' è usato in relazione al fatto che la loro forma in uscita da un sistema è

analoga a quella in ingresso.

Segnali Discreti

I segnali sono Discreti quando il loro valore può essere misurato solo in

determinati istanti di tempo.

Un semplice modello matematico è quello in cui ad un set numerabile di

punti {ti }, i = 1,2,3,... nel tempo è associata una ampiezza si ; quindi a

particolari istanti {ti }, meglio se equidistanti, si fa corrispondere il valore

del segnale.

Segnali Digitali

I segnali sono Digitali quando si tratta di segnali discreti la cui ampiezza è

associata ad un numero che ne rappresenta il valore in quell'istante In

genere per esprimere il numero viene usata, per semplicità, la base numerica

binaria {0,1}, che ha solo due ampiezze possibili, a quella minore è

associato uno dei due (in genere "0"), all'altra il rimanente ("1").

Molto spesso i segnali discreti sono utilizzati per campionare quelli

analogici, cioè per darne una rappresentazione. I vantaggi sono:

1) Non è necessario trasmettere il segnale 'continuamente', ma solo in quegli istanti di

campionamento.

2) E' possibile utilizzare lo "stesso" sistema di comunicazione per trasmettere messaggi da diverse

sorgenti a diversi utilizzatori. Questo modo è noto come "Time Division Multiplexing". Gli

intervalli di campionamento sono, in genere, uguali con la condizione ovvia che loro durata deve

essere minore di quella del segnale analogico da campionare.

Vi sono due modi di campionare:

1). Tramite impulsi con equidurata temporale, ∆t = cost.

e con ampiezza A proporzionale a quella del segnale

analogico nel punto di campionamento.

2). Tramite impulsi di uguale ampiezza e con durata

∆t proporzionale all'ampiezza del segnale nel punto

di campionamento.

Anche con segnali digitali è possibile campionare

segnali analogico: il segnale continuo nel punto di

campionamento è convertito in una serie di impulsi

digitali, ad es. binari, codificati che equivalgono al

valore dello stesso al tempo t.

6

Rappresentazione dinamica dei segnali

Molto spesso è importante conoscere non solo il valore istantaneo (presente) di un segnale, ma anche

il suo comportamento durante il tempo nel passato e nel futuro.

Il principio della rappresentazione dinamica ci consente di rispondere a questa esigenza. Essa

consiste nel descrivere un segnale reale attraverso una somma di segnali elementari contigui ovvero

che si susseguono ad istanti successivi di tempo. Essi possono essere scelti in una classe di segnali

arbitrari tuttavia quelli più usati per la loro semplicità e significatività sono :

1) Funzioni elementari a gradini o di

Heaviside, distanziati a intervalli

temporali ∆t uguali e con ampiezza

uguale alla variazione del segnale in

questo intervallo.

2) Impulsi rettangolari o funzione δ di

Dirac, contigui in modo tale da

formare una sequenza inscritta o circoscritta al segnale.

Funzione di Heaviside o a Gradino o Step Function

Consideriamo la funzione v(t) definita dal seguente modello matematico :

Questa rappresenta la transizione

0 per t< -ξ

di un sistema fisico dallo stato

1 t

v(t ) = + 1 per - ξ ≤ t ≤ ξ

definito "0" allo stato definito

2 ξ

"1". Se facciamo tendere la

1 per t> ξ

variabile ξ→0 si ottiene una

transizione istantanea. Allora essa prende il nome di Switching Function o funzione di Heaviside

σ(t)

0 per t < t o

0 per t < 0

σ (t ) =

transizione al tempo t=0; σ (t - t 0 ) =

transizione al

1 per t > 0

1 per t > t 0

tempo t=t0

Rappresentazione dinamica tramite la funzione di Heaviside

Prendiamo una funzione qualsiasi del tempo s(t) tale che :

s(t)=0 per t<0 e sia {∆t,2∆t,3∆t,...} la sequenza di intervalli temporali alla quale corrisponde la

sequenza {s1,s2,s3,...} dei rispettivi valori della s(t).

Se s0=s(0) è il valore a t=0 allora: il valore del segnale a qualsiasi t è

s(t)=s0σ(t) + (s1-s0)σ(t - ∆t)+(s2-s1)σ(t-2∆t)...o, in modo compatto:

∞

s (t ) = s0σ (t ) + ∑ (sk − sk −1 )σ (t − k∆t )

k =1

Se ora facciamo tendere l’intervallo temporale a zero (∆t→ 0) allora la variabile discreta k∆t tende

alla variabile continua τ ;(k∆t --> τ ).

ds

dτ

dτ

L'intervallo delle ampiezze (sk-sk-1)-->ds che possiamo scrivere come: ds =

quindi :

7

∞ ds

s(t)=s0σ(t) + ∫ σ(t − τ)dτ

− ∞ dτ

che è la rappresentazione dinamica di un segnale continuo tramite la funzione di Heaviside.

Esempio.

Calcolare il valore di una funzione arbitraria s(t) per t=∆t cioè al primo gradino.

Tutti i termini della somma che contengono la σ a tempi maggiori di ∆t cioè 2∆t, 3∆t,....sono

nulli perché è nulla la funzione di Heaviside σ mentre tutti quelli che contengono la σ a tempi

inferiori sopravvivono perché la funzione di Heaviside ha valore unitario.

Allora il valore della funzione per t=∆t sarà : s(t=∆t)= s0*1+ (s1-s0)*1+(s2-s1)*0+....0 quindi:

s(t=∆t)=s1

Esempio

Sia s(t) un segnale arbitrario avente il seguente modello matematico

s(t)= 0

per ∀ t<0

2

s(t)= A t per ∀ t>0

Trovare la sua rappresentazione dinamica in termini di funzione di Heaviside.

Essendo s(t)= 0 per ∀ t< 0, allora s0 = 0 e quindi la rappresentazione dinamica del segnale risulta

:

∞

s (t ) = 2 A ∫ τσ (t − τ )dτ

0

che può essere facilmente verificata sostituendo un valore qualsiasi di t.

Funzione delta di Dirac

Consideriamo un segnale, impulso rettangolare, definito dal

modello matematico:

v(t;ξ ) =

1 ξ

ξ

σ t + − σ t − cioè la differenza tra due

ξ 2

2 funzioni di Heaviside che

effettuano la transizione

a tempi diversi

Esso ha l'ampiezza pari a 1/ξ e durata ξ. Infatti

σ(t + ξ/2) = 0 per

t <−ξ/2

σ(t + ξ/2) = 1 per

t >−ξ/2

σ(t - ξ/2) = 0

per

t <ξ/2

σ(t - ξ/2) = 1

per

t >ξ/2

Quindi la loro differenza è pari a: v(t , ξ) = 1/ξ per −ξ/2 < t < ξ/2 e la durata è uguale a ξ.

Questa funzione è caratterizzata dal fatto che per ∀ scelta del parametro ξ l'area è sempre

unitaria.:

∞

Av = ∫ v(t ;ξ)dt=1

−∞

Infatti basta osservare che Av = base ∗ altezza = ξ∗1/ξ = 1 .

Se facciamo tendere ξ → 0 , per mantenere l'area unitaria, l'ampiezza

crescerà indefinitamente. Allora definiamo:

8

lim v(t ; ξ) = δ(t)

ξ →0

funzione impulsiva o Delta di Dirac

Essa è nulla ovunque tranne che nel punto che annulla l'argomento, cioè in t = 0 o t = t0 e gode

∞

della proprietà : ∫ δ (t)dt = 1

−∞

Esempio fisico :

L'impulso di una forza F(t) variabile nel tempo che agisce su un punto materiale di massa m

t2

nell'intervallo temporale ∆t =t2 - t1 è ∆p = ∫ F(t)dt

t1

Ciò che conta non è tanto la forza quanto l'impulso che viene trasferito alla massa m.

La funzione δ(t), Delta di Dirac, è il modello matematico di un impulso unitario (area unitaria).

Rappresentazione dinamica dei segnali con la δ(t)

Ricordando l'espressione della precedente rappresentazione (di Heaviside) come

somma di infiniti "gradini" elementari, possiamo esprimere il k-esimo impulso

elementare, ηk(t), come : ηk(t) = sk(t)[σ(t - tk) - σ(t - (tk+∆t))] essendo

sk(t) il k-esimo campione del segnale. Siamo quindi ora in grado di esprimere

un segnale continuo arbitrario s(t) come somma di infiniti impulsi ηk :

∞

s (t ) = ∑ η k (t )

k = −∞

∞

s (t ) = ∑ s k [σ (t − t k ) − σ (t − (t k + ∆t ))]

k = −∞

Moltiplicando e dividendo per ∆t : s (t ) =

passando

al

limite

∞

∑ sk

k =−∞

per

1

[σ (t − tk ) − σ (t − (tk + ∆t ))]∆t

∆t

∆t → 0

si

ha

che

1

[σ (t − tk ) − σ (t − (tk + ∆t ))] → δ(t-τ) per cui si può scrivere:

∑ → ∫ , ∆t ≈ τ , lim

∆t →0 ∆t

∞

s (t ) = ∫ s (τ )δ (t - τ )dτ

−∞

che è la rappresentazione dinamica dei segnali tramite la Delta di Dirac.

Si osservi che le dimensioni della δ sono omogenee con una "frequenza".

Dalla scrittura di questa rappresentazione si deduce: moltiplicando una qualsiasi s(t) per la δ(t - t0)

ed integrando, otteniamo proprio il valore della funzione al tempo t0 cioè s(t0): La δ ha la cosiddetta

proprietà di filtro cioè riesce a selezionare un solo valore della funzione nel punto in cui è

"concentrato" l'impulso.

Applicazione interessante:

Realizzando un sistema come schematizzato nella figura

costituito da un semplice moltiplicatore analogico e da un

integratore possiamo "estrarre" il valore del segnale

s(t)

Moltiplicatore

δ (t - t0)

Integratore

s(t0)

9

fornito in ingresso, s(t) all'istante t=t0. In pratica al posto della δ(t - t0) si utilizzerà un impulso

sufficientemente "stretto" per avere il valore istantaneo del segnale s(t).

Teoria geometrica o vettoriale dei segnali

In questo secolo la matematica ha sviluppato potenti tecniche di analisi funzionale che generalizzano

la nostra idea intuitiva circa la struttura geometrica dello spazio. Come è stato dimostrato l'analisi

funzionale rende possibile formulare una consistente teoria dei segnali basata sulla interpretazione

del segnale come vettore in uno spazio, opportunamente costruito, a infinite dimensioni. D’altronde

molti problemi in campo teorico e sperimentale nei settori più svariati portano a questioni che

coinvolgono domande del tipo:

1) In che senso possiamo affermare che un segnale eccede o no un altro?

2) E' possibile valutare oggettivamente quanto due segnali si "assomigliano"?

Per rispondere occorre introdurre un opportuno spazio rappresentativo ("virtuale") a infinite

dimensioni in cui il segnale è trattato come un vettore. Questo spazio è una generalizzazione

dell'idea intuitiva di spazio con struttura geometrica.

Spazio lineare dei segnali o spazio vettoriale

Sia M = {s1(t), s2(t), s3(t), ...} un insieme di segnali. tali che ciascuno abbia proprietà comuni a tutti

gli elementi dell'insieme. Tali proprietà possono essere studiate se è possibile stabilire delle relazioni

tra i membri individuali dell'insieme. In questo caso si dice che esso possiede una struttura definita.

Le caratteristiche di questa struttura sono dettate da considerazioni di carattere fisico. I segnali, ad

esempio quelli di natura elettrica, possono essere combinati e moltiplicati per un fattore di scala

arbitrario. Su tale base quindi per l'insieme M possiamo usare una struttura di tipo lineare.

Definiamo allora le condizioni per uno spazio lineare reale:

Assiomi di uno Spazio Lineare Reale L

r

per∀ u ∈ L , u assume solo valori ℜper∀t

r r

r r r

r

2

per∀u , v ∈ L , ∃ la somma : u + v = w tale che w ∈ L e

r r r r

u +v =v +u

r r r

r r

r commutativa e associativa:

u +(v +x ) = (u + v ) + x

1)

3)

4)

5)

6)

7)

8)

r

r

valgono

le

proprietà

r

per ∀ u ∈ L e per ∀α ∈ ℜ ∃f=α ⋅ u ∈ L

r

r

∃! l' elemento 0 tale che u+0=u ; 0 è detto elemento origine

r

r r

∃! l' elemento -u tale che - u+u = 0

r r

∃! l' elemento 1 tale che 1 ⋅ u=u ; 1 è detto elemento unitario

r

r

r

( a + b)u =au + bu

r r

r

r

a(u +v ) = au + av

Gli assiomi appena elencati sono molto stringenti anche se non sembra.

Se consideriamo, ad esempio, l'insieme M dei segnali impulsivi nell'intervallo [0,20µs] la cui

ampiezza V è V < 10V , esso non costituisce uno spazio lineare in quanto non soddisfa il 2 e 3

assioma. Infatti se prendiamo due segnali, nell'intervallo richiesto, con ampiezze pari a 6 volt e 8

r r

volt che singolarmente ∈ L , la loro somma (u + v ) ∉ L .Ugualmente è facile mostrare che ∃ un

numero α ∈ ℜ il cui prodotto con un segnale ∈ L viola il 3° assioma.

Concetto di Base

10

Come allo spazio ordinario anche a quello lineare dei segnali, L, può essere data una struttura

speciale che gioca il ruolo di un sistema di coordinate. Si dice allora che un insieme di segnali

r r r

r

(vettori) {u1 ,u2 ,u3 ,...u n }∈ L costituisce una base linearmente indipendente se l'uguaglianza

r

∑α i ui = 0 è soddisfatta solo quando i coefficienti α i svaniscono tutti insieme e allo stesso tempo

i

r r r r

1) Dati i vettori u1 ,u2 ,u3 ,...un essi si dicono linearmente dipendenti se

r

r

r

∃ n numeri a ℜ o C tali che a1u1 + a 2 u 2 + ... + a n u n = 0

altrimenti si dicono linearmente indipendenti.

2) Uno spazio lineare si dice n-dimensionale se ∃ almeno un insieme di n vettori linearmente

indipendenti.

3) Uno spazio lineare si dice infinito dimensionale se ∃ n vettori linearmente indipendenti

per ∀n intero > 0.

Nella teoria dei segnali, il numero di vettori di base, come regola, è infinitamente grande di

conseguenza lo spazio lineare dei segnali è ad infinite dimensioni.

Un vettore in uno spazio n-dimensionale può essere rappresentato come "somma pesata" di n vettori

r r

r

r

r

linearmente indipendenti. Infatti se u , u1 ,...,u n ∈ L e u1 ,...,u n sono linearmente indipendenti,

allora

∃ n+1 numeri a tali che:

r r

r

cioè u , u 1 ,..., u

n

r

r

r

r

a0 u+a1u1+a2u 2 ...+anu n = 0

sono linearmente dipendenti. Allora se a0≠0 si ha:

a

r

u = − 1

a0

r a2 r

a r

u1 + −

u 2 + ...... + − n u n

a0

a0

o, espresso in forma più compatta:

r

r n r

u = ∑ ck u k

k =1

ovvero qualsiasi vettore u ∈ L può essere espresso come somma di prodotti dei coefficienti ck per i

r

vettori u k. Si dice allora che:

r

gli u k costituiscono una base

r

r

i ck sono le componenti di u cioè le sue proiezioni su u k

Concetto di Norma

Per un maggiore approfondimento nella teoria geometrica dei segnali occorre introdurre un altro

concetto che corrisponde, nel significato, alla lunghezza di un vettore. In questo modo potremo dare

una risposta alla domanda quale dei segnali è maggiore o minore di un altro e soprattutto

determinare quanto.

In uno spazio lineare L si dice che è definita una norma se a ciascun vettore s(t) ∈ L è assegnato un

unico numero reale || s || che soddisfa le seguenti proprietà:

1.

|| s || ≥ 0 con || s || = 0 ⇔ se e solo se s = 0

2.

∀ α sussiste || αs || = |α| || s ||

3.

|| s + p || ≤ || s || + || p ||

Allora possiamo definire norma del vettore s(t) la seguente espressione:

1

+∞ 2

2

s = ∫ s (t)dt

−∞

Questa è utile in caso di segnali reali. Qualora ci trovassimo in presenza di segnali complessi sarà

opportuno definire, e utilizzare quindi, la seguente norma:

11

1

+ ∞

2

s = ∫ s(t)s*(t)dt

− ∞

12

Concetto di Metrica

r r

Uno spazio lineare L si dice metrico se a ciascuna coppia di elementi u , v ∈ L è assegnato un

numero reale positivo ρ(u,v) detto metrica o distanza tra gli elementi. La metrica deve rispettare i

seguenti assiomi:

1. ρ(u,v) =ρ(v,u)

riflettività

2. ρ(u,u) = 0 ∀ u ∈ L

3. ∀ w ∈ L si ha ρ(u,v) ≤ ρ(u,w) + ρ(w,v)

La metrica è anche definita come la norma della distanza tra due elementi:

ρ(u,v) = | u - v |.

Energia di un Segnale. Signal Energy

Il quadrato della norma è l'energia " portata " dal segnale ed è detta Energia del Segnale.

2 +∞

Es = s = ∫ s 2(t)dt

−∞

Notare che se il segnale è una tensione, espressa in Volt, allora la sua energia è espresso in [V2 s].

Nota. Se il segnale è rappresentato da una tensione V espressa in volt allora l'energia del segnale è

espressa in volt2*s e rappresenta l'energia dissipata dal segnale su un carico resistivo pari ad 1 ohm.

Infatti possiamo fare una verifica dimensionale: l'equazione dimensionale dell'energia è

M 2T −3 L4 Q −2 (volt 2 * s )

E ≡ ML2T − 2 ≡

2 −1 − 2

ML T Q (ohm)

[

]

Esempio.

Trovare l'energia e la norma del segnale s(t),definito dal modello matematico s(t)=V*t/τ ovvero

un segnale triangolare di ampiezza V, salita lineare e durata τ.

∞

τ V 2t 2

V 2τ

2

L'energia del segnale è Es = ∫ s (t ) dt = ∫

dt

=

avendo tenuto conto che il segnale è

2

3

0 τ

−∞

nullo per t>t e per t< 0. Mentre la norma è

s (t ) = E s =V

τ

3

Esempio

Trovare l'energia del segnale, s(t), definito dal modello matematico: s(t)=V0cos(ω0t+φ0)

nell'intervallo [0,τ]. ovvero una funzione armonica troncata al tempo τ

Passando alla variabile ε=ω0t+φ0 ; dε=ω0dt l'energia del segnale risulta :

V02 ε

Vo2

2

Es =

{sin(ε ) cos(ε ) + ε }

∫ cos (ε )dε =

ω0 0

2ω 0

V02

che possiamo riscrivere come E s =

{sin[2(ω 0τ + φ 0 ) + 2(ω 0τ + φ 0 )}

4ϖ 0

se il tempo t al quale viene troncata l'armonica è >> del periodo dell'armonica stessa, 1/ω0 , cioè se

V02τ

che risulta indipendente dalla frequenza

ω0t>>1, l'energia portata dal segnale diventa E s ≈

del segnale ω0. e, ovviamente, dalla fase φ0

2

13

Prodotto Scalare- Spazio di Hilbert

Definiamo il prodotto scalare nello spazio L.

Il prodotto scalare (u,v) è così definito:

(u,v ) =

+∞

∫ u(t)v(t)dt

−∞

e quindi l'angolo tra due vettori u e v in L è:

cosψ uv =

(u,v )

u⋅v

Le proprietà ovvie del prodotto scalare sono:

1. (u,v) ≥ 0

2. (u,v) = (v,u)

3. (λu,v) = λ(u,v)

4. (u+v,w) = (u,w) + (v,w)

Lo spazio lineare contenente i prodotti scalari e soddisfacenti queste condizioni è detto spazio di

Hilbert reale. I vettori dello spazio di Hilbert soddisfano la fondamentale disuguaglianza di CauchyBuniakovsky: |(u,v)| ≤ |u| ⋅ |v|

Se i segnali assumono anche valori complessi allora è possibile definire uno spazio di Hilbert

complesso nel quale il prodotto scalare assume la forma: (u,v ) =

+∞

∫ u(t)v (t)dt

*

ove la * indica il

−∞

complesso coniugato.

Cross Energy

r

r2

Dallo spazio ordinario a tre dimensioni abbiamo: A + B

(

r2 r2

r r

= A + B + 2 A⋅ B

)

Per analogia, nello spazio L avremo:

u+v

2

∞

∞

−∞

−∞

∞

= E S = ∫ (u + v )2 dt = Eu + E v + 2 ⋅ ∫ uvdt

Da qui si vede che le energie non sono additive. Il termine Euv = 2 ⋅ ∫ uvdt è detto termine di

−∞

cross energy.

Esempio.

Calcolo sviluppato con MATHCAD

Trovare il prodotto scalare e l'angolo di sfasamento tra due segnali definiti dal modello matematico :

v1 (t ) = V1e − ktσ (t )

-6

con V1=V2=5 v; e τ=2*10 s

− k (t −τ )

v 2 = V2 e

σ (t − τ )

L'energia dei due segnali è identica in quanto hanno la stessa ampiezza iniziale V1=V2 e la stessa

costante di tempo τ . L'unica differenza tra i due è l'istante di inizio, t=0 per v1 e t= t0 per v2.

Infatti:

14

Segnali Ortogonali- Serie di Fourier Generalizzata

Due segnali u, v si dicono ortogonali se (u,v) = 0 e di conseguenza anche la cross energy è nulla.

Sia H lo spazio di Hilbert a energia finita. Se prendiamo i segnali definiti nell'intervallo [t1,t2], non

r

r

necessariamente finito, possiamo definire, nello stesso intervallo un insieme di funzioni { u1 ,...,u n }

mutuamente ortogonali e con norma unitaria, cioè tali che :

(u i ,u j ) = 10

se i=j

se i ≠ j

Allora un qualsiasi segnale s(t) ∈ H si può sviluppare in serie di Fourier generalizzata, cioè:

∞

s(t) = ∑ ci u i(t)

i =1

dove ci.sono dei coefficienti incogniti che rappresentano il peso della corrispondente funzione nello

sviluppo. Per determinarli basta moltiplicare per uk,, generica base, il segnale s(t) ed integrare in

[t1,t2]. Si ottiene:

t2

∞ t2

t1

i =1 t1

∫ s (t )u k (t )dt = ∑ ∫ ci u i u k dt

e poiché la uk è una base orto-normale si avrà:

t2

∫ s (t )u k (t )dt = ck = (s, u k )

t1

cioè il k-esimo coefficiente si ottiene dal prodotto scalare tra il segnale e la k-esima base.

Esempi di Basi Ortogonali Normali

Funzioni armoniche in [ 0 , T ]

u

1

=

0

u

2

n

u

2

n

−

T

1

=

2

T

=

2

T

sin

cos

2

2

π

π

t

n

n

T

t

T

Funzioni di Walsh in [ -T/2 , T/2 ]

L'espressione analitica ha una forma complicata ed assume solo valori +1 o –1 per cui diamo solo il

grafico di quelle di ordine inferiore.

E' da notare che la k-esima base ha k zero crossing.

Ovviamente:

1

2

Wal(k,q) = ∫ + 12Wal 2(k,q)dq = 1

−2

l'ortogonalità è assicurata per costruzione geometrica:

15

∫−12Wal(1,θ ) ⋅ Wal(2,θ )dθ = ∫−14 (− 1)(− 1)dθ + ∫−1 (− 1)(1)dθ + ∫04(1)(1)dθ + ∫12 (1)(1)dθ = 1 − 1 + 1 − 1 = 0

+1

−1

2

2

1

0

4

1

4

Un qualsiasi s(t) sviluppata in serie di Fourier in termini di Walsh Functions è:

∞

s (θ ) = ∑ c k Wal (k , θ )

con θ = t/T

k =0

Esempio (da svolgere)

Trovare i primi due coefficienti dell'espansione in funzioni di Walsh del segnale triangolare definito,

nell'intervallo [ -T/2, T/2 ] dal modello matematico :

S(t) = U ( t/T + ½)

Energia di un segnale sviluppato in serie di Fourier generalizzata

Sia dato un segnale s(t) definito nell'intervallo [t1,t2], esso puo essere sviluppato in serie di Fourier

generalizzata:

∞

s (t ) = ∑ c k u k

in [ t1,t2 ]

k =1

La sua energia è:

t2

t2

t2 ∞ ∞

∞ ∞

2

E s = ∫ s (t )dt = ∫ ∑ ∑ ci c j u i u j dt = ∑ ∑ ci c j ∫ ui u j dt

i =1 j =1

t1

t1 i =1 j =1

t1

poiché le u(t) sono funzioni ortonormali cioè valgono 1 solo se i = j allora:

∞

E s = ∑ c i2

i =1

ossia "l'energia di un segnale è uguale alla somma delle energie delle singole componenti ". Questo

è il teorema di Pitagora generalizzato.

16

Ricerca delle condizioni sui coefficienti Ck in uno sviluppo finito

N

Sia ~

s (t ) = ∑ c k u k il segnale da sviluppare in serie di Fourier generalizzata in cui i coefficienti ck

k =1

siano sconosciuti. Per la ricerca imponiamo che sia minimo il modulo quadro della differenza µ tra il

valore esatto del segnale, s(t), e quello calcolato tramite lo sviluppo in serie ~

s , vale a dire, l'errore,

al quadrato, che si commette sostituendo lo sviluppo al segnale vero.

∂µ

2

s = minimo, quindi deve essere:

Si ha perciò: µ = s − ~

= 0 con m = 1, 2 ....., N.

∂c m

Otteniamo allora un sistema di equazioni lineari da risolvere. Scrivendo l'espressione di µ:

t2

N

N N

µ = ∫ s 2 − 2s ∑ c k u k + ∑ ∑ ci c j ui u j dt per l'm-esimo coefficiente, poiché le funzioni

k =1

i =1 j =1

t1

sono ortogonali, si avrà:

t

{

}

2

2 2

µ = ∫ s 2 − 2scmu m + cm

um dt

t1

per cui la condizione di minimo diventa:

t2

{

}

∂µ

2

= ∫ − 2su m + 2cm u m

dt = 0

∂c m t

1

t2

t2

2

Esplicitando avremo: ∫ su m dt = c m ∫ u m dt Poiché abbiamo scelto una base a norma unitaria si

t1

t1

t2

2

ha: ∫ u m dt = 1

t1

Si ottiene perciò per il coefficiente da noi cercato:

t2

∫ s (t )u m dt = c m = ( s, u m )

t1

Quindi il coefficiente che minimizza µ altri non è che il prodotto scalare tra il segnale s(t) e la mesima base um cioè l'm-esimo coefficiente dello sviluppo in serie di Fourier generalizzato.

Quindi lo sviluppo di Fourier generalizzato assicura un minimo nell'errore di approssimazione.

Deve inoltre essere notato che lo spazio di Hilbert H dei segnali gode della proprietà di completezza.

Ovvero se ∃ il limite della somma definito da s (t ) = lim

N

∑c u

i =1

N →∞

i

i

allora esso ∈H.

17

Rappresentazione Spettrale dei Segnali

Esistono molte funzioni orto-normali che possono costituire una base ma, di particolare interesse,

sono quelle armoniche. L'importanza di queste è dovuta alle seguenti particolarità:

•

Sono invarianti sotto trasformazioni effettuate da sistemi lineari.(cambiano solo l'ampiezza

e la fase)

•

Quando un qualsiasi segnale s(t) è rappresentato tramite funzioni armoniche di diversa

frequenza si dice che è risolto nel suo spettro.

Segnali periodici e serie di Fourier

Un segnale arbitrario, s(t), che si ripete ciclicamente nel tempo è un segnale periodico. Il suo

modello matematico è s(t) = s(t+nT) con n = ±1, ±2, ±3..e T periodo del segnale.

Definiamo nell'intervallo [-T/2, +T/2] un insieme di funzioni armoniche ortonormali:

Un segnale arbitrario purché sia:

•

periodico di periodo T

•

ad un sol valore nel periodo [0, T] o [ t, t+T]

•

continuo o con limitati punti di discontinuità di prima specie.

Può essere rappresentato con una serie di Fourier

∞

con t = [-∞,+∞] e con cm = (s,um).

s (t ) = ∑ cmum (t )

m =0

Definiamo ω1 = 2π/T la pulsazione fondamentale dello spettro.

E' uso corrente scrivere lo sviluppo in serie di Fourier nel modo seguente:

∞

a

s (t ) = 0 + ∑ (a n cosnω 1t + bn sin nω1t )

2 n =1

anziché con i coefficienti cm finora utilizzati senza togliere nulla alla validità e alla generalità dello

sviluppo stesso. Occorre però cercare le espressioni dei nuovi coefficienti a0, an e bn:

1.[Calcolo di a0] Integriamo la s(t) nell'intervallo [-T/2, +T/2]:

+T 2

+T 2

+T 2 ∞

a0

a

dt + ∫ ∑ (a n cos nω1t + bn sin nω1t )dt = 0 T + 0

∫ s(t)dt = ∫

2

−T 2

−T 2 2

− T 2 n =1

quindi il valore medio della s(t) nel periodo T sarà:

+T 2

a0 =

2

∫ s (t )dt

T −T

2

2.[Calcolo di an

]1:Integriamo

la s(t) nell'intervallo [-T/2, +T/2] avendo moltiplicato per cos(nω

1t):

t2

1

∫ s (t )u k (t )dt = ck = (s, u k )

t1

18

(

+T 2

)

T

+T 2 ∞

a0 + 2

2

∫ s(t)cos nω1tdt =

∫ cos nω1tdt + ∫ ∑ an cos nω1t + bnsinnω1t cos nω1t dt =

2

−T

−T

−T n=1

2

2

+T

2

−T

2

2

= 0 + ∫ an cos2 nω1tdt + 0 in quanto tutti i termini con sin(nω1t) e cos(nω1t),

+T 2

+T 2

T

2

nell'intervallo sono nulli quindi: ∫ s (t )cosnω1tdt = a n ∫ cos nω1tdt = a n , che ci

2

−T 2

−T 2

permette di ricavare il coefficiente an:

2+ 2

an =

∫ s (t )cosnω1tdt

T −T

T

2

3.[Calcolo di bn]1:Si procede analogamente avendo moltiplicato per sin(nω1t) e si ricava:

2+ 2

bn =

∫ s (t )sin nω1tdt

T −T

T

2

Allora un qualsiasi segnale periodico s(t) si può decomporre in:

•

Una componente costante, a0, ( valore medio del segnale )

•

Un insieme infinito di armoniche di frequenza ωn = nω1 multiple della fondamentale,ω1,

ciascuna caratterizzata da:

•

Un'ampiezza

An = a n2 + bn2

b

ϕ n = arc tan n

an

Se poniamo : an = Ancosϕn ; e bn = Ansinϕn , è possibile riscrivere la serie in una forma

•

Una fase iniziale

diversa ma equivalente:

∞

a

s (t ) = 0 + ∑ An cos(nω1t − ϕ n )

2 n =1

avendo fatto uso dell'uguaglianza : cosαcosβ + sinβsinα = cos(α-β)

Facciamo ora un'altra scelta per le nostre armoniche:

•

Un'ampiezza

Bn = a n2 + bn2

a

ϕ n = arc tan n

bn

Con questa scelta si avrà allora che:an = Bnsinϕn

bn = Bncosϕn

Si ottiene così, analogamente, l'espressione per la s(t):

∞

a

s (t ) = 0 + ∑ Bn sin( nω 1t + ϕ n )

2 n =1

•

Una fase iniziale

Annotazioni:

19

1.

Se il segnale s(t) è una funzione pari [ cioè s(t) = s(-t) ], tutti i coefficienti dello sviluppo

che contengono la funzione seno ( funzione dispari ) si annullano in quanto il prodotto di una

funzione pari per una dispari è dispari e integrata nell'intervallo simmetrico [-T/2,T/2] è nulla.

Quindi i coefficienti bn sono nulli. Quindi lo sviluppo si riduce a

2+ 2

an =

∫ s (t )cosnω1tdt

T −T

T

∞

a

s (t ) = 0 + ∑ a n cosnω 1t

2 n =1

con i coefficienti

2

2.

Analogamente se il segnale s(t) è una funzione dispari [ cioè s(t) = - s(-t) ] tutti i

coefficienti che contengono la funzione coseno (funzione pari) si annulleranno cioè

an = a0 = 0. Si avrà per la s(t) la seguente espressione:

s (t ) = ∑ bn sin nω 1t

n =1

Esempio.

2+ 2

bn =

∫ s (t )sin nω1tdt

T −T

T

∞

con i coefficienti

2

Onda quadra (Video-Clip) Notare l'importanza delle componenti a

frequenza piu' alta per la ricostruzione del fronte dell'onda quadra.

Esempio. Funzione periodica impulsiva (Calcolo)

Calcoliamo lo sviluppo di Fourier per una funzione periodica di impulsi rettangolari con il seguente

modello matematico:

t

s(t) = Aσ t + d

2

con : td :durata del segnale periodo; A ampiezza

Per una funzione periodica impulsiva è uso definire una grandezza adimensionale q = td/T

t

− σ t − d

2

data dal rapporto tra il tempo di durata dell'impulso e il periodo della funzione. Generalmente esso

viene chiamato " duty cycle " del segnale. La funzione si suppone sia pari rispetto a t = 0.

Essendo pari, la funzione va sviluppata in termini di coefficienti che contengono solo coseni e il

termine costante.

td

2+ 2

A + t2d

Quest'ultimo vale : a0 =

∫ Adt = 2 t t d = 2 Aq

T − td

T −2

2

Per gli altri termini si avrà:

td

td

t

+d

2+ 2

A+ 2

A 1

A 1

td

td

sin nω1t td2 = 2

an = ∫ s(t)cos nω1tdt = 2 ∫ cos nω1tdt = 2

sin nω1 − sin nω1(− )

−2

2

2

T −td

T −td

T nω1

T nω1

2

2

ossia:

an =

t

2A

sin nω 1 d

nπ

2

∞ 2A

t

Il segnale sviluppato in serie di Fourier sarà perciò: s (t ) = Aq + ∑

sin nω1 d cos nω1t

2

n =1 nπ

Ma ricordandoci che

ω1 = 2π/T allora la s(t) assumerà la forma

∞

sin nπ q

: s (t ) = Aq 1 + 2 ∑

cos nω1t

n =1 nπq

Forma Complessa della Serie di Fourier

20

Ricordiamo le formule di Eulero:

e ix + e − ix

cos x =

2

sinx =

eix − e −ix

2i

Se le sostituiamo nello sviluppo di Fourier della s(t) avremo:

s (t ) =

a0 ∞

e inω1t + e −inω1t

e inω1t − e − inω1t

+ ∑ (a n

+ bn

)

2 n=1

2

2i

Riscriviamo il termine dentro la sommatoria in questo modo:

−inω 1t

−inω1t

inω1 t

inω 1t

(

k n = an

+e

2

e

+ bn

e

−e

2i

=

a n − ibn ) inω1t (a n + ibn ) − inω 1t

+

e

e

2

2

Poiché:

a n − ibn 1 + 2

1+ 2

− inω1 t

dt

=

∫ s (t )[cos nω1t − isin nω1t ]dt =

∫ s (t )e

2

T −T

T −T

2

2

T

T

e

T

T

a n + ibn 1 + 2

1+ 2

inω t

=

∫ s (t )[cos nω1t + isin nω1t ]dt =

∫ s (t )e 1 dt

2

T −T

T −T

2

2

chiamando ora:

cn =

(an − ibn )

c− n =

2

(an + ibn ) = c*

2

n

per cui la s(t) assume la forma:

∞

s (t ) = ∑ cneinω1t

n= −∞

con

T

1+ 2

− inω1 t

cn =

dt

∫ s (t )e

T −T

2

Frequenze Negative

e inω1t + e − inω1t

per n =

2

1 i ω 1t

e

1 nel piano complesso la grandezza

rappresenta un

2

fasore di lunghezza 1/2 che ruota in senso antiorario con velocità

1 − i ω 1t

e

angolare ω1.Il fasore

ha la stessa ampiezza del primo

2

Considerando la quantità: cos nω 1t =

ma ruota in senso opposto con la stessa velocità angolare. ( Motori a induzione → campi rotanti )

Rappresentazione nel piano complesso

Un segnale periodico può quindi essere rappresentato come un'infinita somma di fasori nel piano

complesso.

1) Disegniamo c0, fasore reale per n = 0

2) A t = 0 avremo: c+ = c1 + c2 + c3 +

ω > 0 e c- = c-1 + c-2 + c- +.. ω < 0

Per una serie di Fourier convergente ciascuna somma rappresenta un fasore di lunghezza finita.

21

Poiché c+ e c- sono complessi coniugati allora c- + c+ è sempre reale.

22

Analisi Spettrale dei Segnali non Periodici. Trasformata di Fourier

Consideriamo un impulso s(t) qualsiasi di durata finita.

Immaginiamo che ad esso siano associati altri impulsi identici

ricorrenti con periodo T:

Allora

possiamo

rappresentare s(t) attraverso

la serie in armoniche di Fourier:

∞

inω1t

s (t ) = ∑ cne

n = −∞

∞

in 2π t

T

Ma ω1 = 2π/T per cui: s (t ) = ∑ cne

n = −∞

e cn =

con

T

1+ 2

− inω 1t

cn =

dt

∫ s (t )e

T −T

2

+T 2

1

− in2π Tt

dt

∫ s (t )e

T −T

2

Se vogliamo " tornare " all'impulso reale dobbiamo far tendere T → ∞.

Sia ωn la n-esima armonica dello spettro, allora:

ωn = n

2π

T

ω n +1 − ω n =

2π

= ∆ω

T

essendo ∆ω un intervallo di frequenze che tende a diminuire con l'aumentare di T, e ωn

frequenza estrema. Allora il coefficiente generico cn diventa:

T

+T 2

1 + 2

2π 1

− iω n t

− iω t

cn =

dt ≡ ∆ω

∫ s (t )e

∫ s (t )e n dt

2π − T

T 2π − T 2

2

+ 2

∆ω

− iω n t

avendo posto: ϕ (ω n ) = ∫ s (t )e

dt

che può essere scritta come: cn = ϕ (ω n )

2π

−T

T

2

Con il che il segnale s(t) diventa:

s(t ) =

∞

∑ ϕ (ω

n= −∞

n

)eiωnt ⋅

che per T → ∞ : [ ∆ω → dω ; ϕ(ωn) = ϕ(ω) ] diventa

1 +∞

iωt

s (t ) =

∫ ϕ (ω )e

2π − ∞

∆ω

2π

dω

e la densità spettrale o spettro delle ampiezze sarà:

+∞

ϕ (ω ) = ∫ s (t )e −iωt dt

−∞

Rimangono così definite:

•

la Trasformata di Fourier

+∞

~

f (ω ) = ∫ f (t )e −iωt dt

−∞

•

l'Antitrasformata

f (t ) =

1 +∞ ~

iωt

∫ f (ω )e dω

2π −∞

la

23

+∞

Queste espressioni hanno senso preciso solo se: ∫ f (t ) dt esiste ed è finito.

−∞

In questo caso la trasformata è:

1) Continua

+∞

~

2) Limitata

f (ω ) ≤ ∫ f (t )dt

−∞

3) Nulla all'infinito per ω → ±∞

+∞

+∞ ~

2

2

e vale l'identità di Parseval: ∫ f (t ) dt = ∫ f (ω ) dω

−∞

−∞

La trasformata e l'antitrasformata ci permettono di trasformare delle funzioni dal dominio delle

frequenze ω a quello del tempo t e viceversa. Quindi, quando è necessario, per esempio se un

modello è difficile da trattare in un dominio, tramite la trasformata di Fourier si può cambiare

dominio. Inoltre la rappresentazione nel dominio di ω, cioè la rappresentazione spettrale del

segnale, offre un approccio molto significativo nell'analisi della risposta in una larga fascia di sistemi

usati, in generale nell'elettronica, in particolare nelle telecomunicazioni.

Esempio. Spettro di un impulso rettangolare (Video-Clip)

Notare come al diminuire della larghezza temporale dell'impulso aumenta la banda delle frequenze

componenti.

Sia s(t), un segnale con ampiezza A e durata τ in [-τ/2,τ/2] il cui modello matematico è :

s(t)= A[σ(t-τ/2) - σ(t+τ/2)] .

Il suo spettro , ovvero la sua trasformata sarà:

τ

τ

+τ

+τ 2

1 − iωt 2

τ

1 − iω 2 1 iω 2 2 A

− iωt

= A − e

+

sin ω

s (ω ) = A ∫ e

dt = A e

e

=

iω

−τ 2

iω

−τ 2

Ponendo ξ = ωτ/2 si ha:

iω

ω

2

sin ξ

ξ

Notare che per ω = 0 l'ampiezza dello spettro s(0) = Aτ e’ uguale all'area dell'impulso.

s (ω ) = Aτ

Esempio. Spettro di un segnale esponenziale (Calcolo)

s(t ) = Ae −αt σ (t ) il modello matematico nel dominio del tempo del segnale per α>0

Il suo spettro, S(ω), ovvero la sua trasformata, sarà:

Sia :

∞

S(ω) = A∫ e e

0

−αt −iωt

∞

dt = A∫ e

−(α +iω )t

0

A −(α +iω )t

dt = −

e

α + iω

C'è da notare che:

1. Lo spettro va a zero solo per ω → ∞

2. Lo spettro è una funzione complessa: S (ω ) = S (ω ) e

iψ (ω )

in cui:

S (ω ) =

A

α +ω

2

2

e

ω

ψ = arc tan −

α

∞

=

0

A

α + iω

24

Esempio. Spettro della δ(t)

Sia s(t) = A δ(t) il modello matematico nel dominio del tempo.

Il suo spettro S(ω), ovvero la sua trasformata, sarà:

+∞

S (ω ) = A ∫ e −iωtδ (t )dt

−∞

Abbiamo già visto le proprietà di " filtro " della δ(t). L'integrale è uguale al valore della funzione nel

punto in cui la δ(t) è " concentrata ". In questo caso a t = 0. Quindi S(ω) = A

Allora la trasformata di Fourier di una δ-function è una funzione indipendente da ω e quindi il

suo spettro ha una larghezza infinita [ −∞, ∞ ] con tutte le frequenze con la stessa ampiezza A

Relazione tra banda e durata

Definiamo " banda " dello spettro quell'intervallo di frequenze entro il quale il modulo dello spettro è

non minore di un certo valore specificato. Per esempio, se |S(ω)|M è il modulo del valore massimo,

allora potremo scegliere l'intervallo:

|S(ω)|M ÷ 0.1 |S(ω)|M

•

Consideriamo un impulso rettangolare e assumiamo che la frequenza massima limite è

quella per cui si ha il " primo " zero nella |S(ω)|M / |S(0)|. Allora avremo:

ωτ

sin

S (ω )

2 =0

=

ωτ

S (0)

2

che si ha per: π = ωτ/2 ossia in termini di frequenza π = 2πfupτ/2

Allora si ha la seguente relazione di indeterminazione: fup⋅ τ = 1

Osservazione importante:

Il prodotto banda * durata è una costante e dipende solo dalla forma dell'impulso. Quindi, ad

esempio, la δ che ha una durata infinitesima, ha una banda infinita.

25

Proprietà basilari della trasformata

Siano

∑ p i s i (t ) un insieme di segnali " pesati " con peso pi. Allora la trasformata è:

i

~

f (ω ) = ∑ p i s i (ω )

i

cioè sinteticamente:

∑ p i s i (t ) ⇔ ∑ p i s i (ω )

i

i

Proprietà della parte reale e della parte immaginaria dello spettro

Vogliamo dimostrare che se la funzione s(t) ∈ ℜ allora la sua trasformata S(ω) = A(ω) - iB(ω)

gode della proprietà che la sua parte Reale è una funzione pari A(ω) = A(-ω) e quella

Immaginaria è una funzione dispari B(ω) = -B(-ω)

Sia s(t) un segnale che prende solo valori reali. In generale il suo spettro sarà rappresentato da una

funzione complessa:

+∞

+∞

S (ω ) = ∫ s (t ) cos ωtdt − i ∫ s (t ) sin ωtdt

−∞

−∞

o, scritta in modo più conciso: S(ω) = A(ω) - iB(ω)

Facciamo ora l'antitrasformata cioè ricaviamo la s(t):

1 +∞

s (t ) =

s (t ) =

∫ [A(ω ) − iB(ω )][cos ωt + i sin ωt ]dω

2π −∞

1 +∞

∫ [A(ω ) cos(ωt ) + B(ω )sin (ωt )] + i[ A(ω ) sin(ωt ) − B(ω ) cos(ωt )]dω

2π −∞

Ora, affinché la s(t) sia reale, come richiede l'ipotesi, dovrà verificarsi che la parte immaginaria sia

nulla, ossia:

+∞

+∞

∫ A(ω ) sin ωtdω =0

−∞

∫ B(ω ) cos ωtdω = 0

−∞

Queste condizioni sono verificate se:

A(ω) è pari (infatti il seno è una funzione dispari)

B(ω) è dispari (infatti il coseno è una funzione pari)

Quindi si arriva alle conclusioni che:

1. La parte reale A(ω) dello spettro è una funzione pari della frequenza. A(ω) = A(-ω)

2. La parte immaginaria B(ω) è una funzione dispari della frequenza. B(ω) = -B(-ω)

Dimostriamo ora che è valida anche la proposizione contraria, ovvero che se

A(ω) = A(-ω) e B(ω) = -B(-ω) allora la funzione s(t) ∈ℜ .

∞

i ωt

Infatti scriviamo il segnale s(t) tramite la sua trasformata : s (t ) = ∫ [ A(ω ) − iB (ω )]e dω

−∞

26

e applichiamo l'ipotesi cioè che A(ω) = A(-ω) e B(ω) = -B(-ω). Allora si ha :

∞

s (t ) = ∫ [ A(−ω ) + iB(−ω )]eiωt dω poiché è sempre possibile cambiare variabile ω → −ω

−∞

otteniamo:

∞

s (t ) = ∫ [ A(ω ) + iB(ω )]e−iωt dω che è proprio s * (t ) quindi la funzione s (t ) ∈ ℜ .

−∞

Spettro di un segnale traslato

Supponiamo che esista, del segnale s(t), la sua trasformata, cioè S(ω).

Prendiamo un segnale traslato nel tempo della quantità t0

~

s = s (t − t 0 )

La sua trasformata sarà:

≈

+∞

S (ω ) = ∫ s (t − t0 )e−iωt dt

−∞

Ponendo: x = t - t0 ; allora dt = dx si avrà:

≈

+∞

+∞

+∞

S (ω ) = ∫ s ( x)e −iω ( x +t0 ) dx = ∫ s ( x)e −iωx e −iωt0 dx = e −iωt0 ∫ s ( x)e −iωx dx = S (ω )e −iωt0

−∞

−∞

−∞

Poiché il modulo di e

−iωt0

è uguale ad uno, allora le ampiezze delle armoniche sono indipendenti

−iωt0

dalla posizione nel tempo del segnale. Questa informazione è contenuta nel fattore di fase e

.

Dipendenza dello spettro da un fattore di scala temporale

Supponiamo che il segnale s(t) sia soggetto ad una trasformazione della scala dei tempi

(compressione o espansione) ossia t → kt con k ∈ ℜ

Se k > 1

si ha compressione e se 0 < k < 1

si ha dilatazione

Allora se t → kt segue che s(t) → s(kt) e il suo spettro

≈

+∞

−iωt

S (ω ) = ∫ s (kt )e

dt

−∞

Ponendo: x = kt ; dx = k dt, si ha:

x

≈

−iω

1 +∞

1 ω

S (ω ) = ∫ s ( x )e k dx = S

k −∞

k k

cioè lo spettro di un segnale, ad esempio, compresso (k > 1) che mantiene la stessa forma,

distribuisce le stesse componenti spettrali su un intervallo più esteso di frequenze con una ampiezza

minore ( S/k).

Compressione

k

>

1

spettro allargato ω k

ampiezze minori S k

Dilatazione

k

<

1

spettro ristretto ω k

ampiezze maggiori S k

Nel caso particolare di k = -1 , ossia nel caso in cui il tempo scorre in senso inverso ( time reversal )

troviamo: s(tinv) ↔ - S(-ω)

27

Il modulo dello spettro rimane invariato ma le regioni di frequenze negative si scambiano con quelle

positive e le fasi iniziali traslano di 180°. Ovviamente questo ha solo un senso " virtuale " ma è un

utile procedimento matematico per costruire lo spettro immagine speculare di uno dato

28

Spettro della derivata e dell' integrale di un segnale

Derivata

Supponiamo che esista la trasformata di s(t) cioè: s(t) ↔

S(ω) allora sarà anche:

d

s(t ) ↔ iωS (ω )

dt

Infatti:

+∞ ds (t )

+∞

+∞

−iωt

− i ωt + ∞

−iωt

−iωt + ∞

− i ωt

=

−

−

ω

=

+

ω

e

dt

se

s

(

t

)

i

e

dt

s

(

t

)

e

i

dt

∫

∫

∫ s (t )e

−

∞

−

∞

dt

−∞

−∞

−∞

[

]

Risolto per parti, si vede che l'integrale si riduce a due termini: il primo svanisce per t → ±∞ in

quanto s(t) → 0 per la condizione di integrabilità del segnale s(t). Quindi si ha:

ds (t )

↔ iωS (ω )

dt

Notazione:

•In seguito ad una operazione di differenziazione il segnale, nel dominio del tempo, diventa più

"rapido ", come conseguenza lo spettro della derivata ha maggiori valori nella regione delle alte

frequenze.

•Una differenziazione nel dominio del tempo equivale ad una semplice moltiplicazione algebrica per

iω nel dominio delle frequenze. Si dice allora che il numero immaginario [iω ] gioca il ruolo di un

operatore di differenziazione nel dominio di ω.

•Il risultato ottenuto si può generalizzare scrivendo:

d ns

↔ (iω )n S (ω )

n

dt

Integrale

Lo spettro di un segnale è correlato al suo integrale definito dalla relazione:

t

1

∫ s (ξ )dξ ↔

−∞

infatti basta osservare che:

iω

S (ω )

d t

∫ s (ξ )dξ = s (t ) ed applicare il metodo precedente.

dt −∞

Notazione:

•In seguito ad una operazione d'integrazione il segnale, nel dominio del tempo, diventa meno "

rapido " (più smooth), di conseguenza il suo spettro risulta " arricchito " di frequenze basse.

•Un'integrazione nel dominio del tempo equivale ad una divisione algebrica per iω nel dominio di

ω. Si dice allora che il numero immaginario [1/iω ] gioca il ruolo di operatore di integrazione nel

dominio di ω.

29

Spettro del prodotto di due segnali (Convoluzione Calcolo con MATHCAD)

Abbiamo visto che lo spettro di due segnali sommati [ s1(t)+s2(t) ] è dato dalla combinazione dei

rispettivi spettri. Diversamente lo spettro del prodotto di due segnali u(t), v(t) non è dato dal

prodotto dei loro spettri.

Cerchiamo quindi a cosa equivale lo spettro del prodotto.

Siano u(t) ↔ U(ω)

v(t) ↔ V(ω) i segnali con i rispettivi spettri e s(t) = u(t)v(t) il

segnale prodotto allora lo spettro sarà:

+∞

S(ω) = ∫ u(t)v(t)e −iωt dt

−∞

1

Se mettiamo al posto di v(t) la sua antitrasformata: v(t ) =

2π

+∞

∫ V (ξ )e

iξt

dξ

−∞

otteniamo:

S (ω ) =

+∞

1 +∞

iξt −iωt

dt

∫ u(t) ∫ V (ξ )e dξ e

2π − ∞

-∞

Invertendo l'ordine d'integrazione otteniamo:

1 +∞

S (ω ) =

+ ∞

-i(ω -ξ ) t

dt dξ

∫ V (ξ ) ∫ u(t)e

2π − ∞

-∞

Possiamo perciò riscrivere lo spettro nel seguente modo:

1 +∞

S (ω ) =

+∞

∫ V (ξ )U(ω - ξ )dξ

2π −∞

∫ V(ξ)U(ω − ξ)dξ .è noto come integrale di convoluzione delle funzioni V e U e

−∞

viene indicato, simbolicamente: V(ω)*U(ω)

Possiamo allora concludere che lo spettro del prodotto ordinario di due segnali è uguale, a meno

di un fattore 1/2π

π , al prodotto di convoluzione degli spettri.

L'integrale

s(t) = u(t)v(t)

S(ω) = V(ω)*U(ω)

Ovviamente V(ω)*U(ω) = U(ω)*V(ω)

Si può anche dimostrare il teorema inverso:

•Se lo spettro di un segnale può essere rappresentato come prodotto ordinario di due spettri

S(ω) = S1(ω) S2(ω) tali che: S1(ω) ↔s1(t)

S2(ω)↔s2(t)

allora il segnale s(t) ↔ S(ω) è la convoluzione di s1(t) e s2(t) nel dominio del tempo.

+∞

S1 (ω )S 2 (ω ) ↔ ∫ s1 (t − ξ ) s2 (t )dξ

−∞

Una interessante conseguenza di questo è il teorema della convoluzione. Esso afferma che la

trasformata di Fourier del prodotto di convoluzione è equivalente al prodotto ordinario delle

trasformate. Per dimostrarlo riscriviamo in modo sintetico, indicando con ℑ la trasformata di

Fourier, il teorema già dimostrato: se s(t)=u(t)v(t)

ℑ[ s (t )] = ℑ[u (t )v (t )] = U (ω ) *V (ω ) = S (ω )

se ora facciamo la trasformata (anti) dell'espressione precedente, otteniamo:

30

s (t ) = u (t )v(t ) = ℑ−1[U (ω ) *V (ω )] = ℑ−1[ S (ω )]

se ora al posto delle due funzioni del tempo sostituiamo le loro trasformate otteniamo

ℑ−1[U (ω )]ℑ−1[V (ω )] = ℑ−1[U (ω ) *V (ω )] cvd

è ovviamente possibile dimostrare, ed è valido, il teorema inverso:

ℑ[u (t )]ℑ[v(t )] = ℑ[u (t ) * v(t )]

L'importanza di questo teorema è enorme in quanto molti processi fisici si presentano come

convoluzione di altri e quindi tramite l'applicazione di questo teorema è possibile risalire ai processi

primari. Questa metodo è noto come deconvoluzione (unfolding) delle componenti.

Convoluzione tra due segnali esponenziali con modello matematico): s(t)=exp(-t) ; v(t)=exp(-kt)

(Calcolo)

(Video-Clip)

u( t )

exp ( t ) k

exp ( ( k. t ) )

10 v( t )

0 , .05 .. 5

t

0 , .05 .. 5

a

1

u( t )

0.5

v( t )

0

0

0.5

1

1.5

2

2.5

3

3.5

4

4.5

5

t

t

conv

( t)

exp

λ ) . exp

(

(

( t

λ ) . k ) dλ

( exp (

conv ( t )

t)

(

0

k. t ) )

exp (

k )

1

0.1

conv ( t ) 0.05

0

0

0.5

1

1.5

2

2.5

3

3.5

4

4.5

5

t

∞

( exp ( t )

spettroconv ( ω )

(k

exp ( k . t ) ) .

1)

exp ( i . ω . t ) dt

0

i

(ω )

spettroconv

ω ). ( k

(( i

i .ω ) )

spettroconv

1

(ω )

1

∞

U( ω )

t ) . exp (

exp (

i . ω . t ) dt

U( ω )

0

∞

exp ( ( k. t ) ) . exp ( i . ω . t ) dt

V( ω )

0

V(ω )

i

ω )

( i

1

(k

i .ω )

ω

2.

k

2

ω

2

1

U( ω )

ω

1

2

1

V(ω )

k

2

ω

2

1

UV ( ω )

1

2

2

ω . k

ω

2

Dividendo lo spettro del prodotto di convoluzione per lo spettro di uno dei due segnali è possibile ottenere lo spettro

dell'altro segnale e quindi, antitrasformando, il segnale incognito.

31

Questo procedimento, molto importante per lo studio dei sistemi e dei segnali, è noto come deconvoluzione ( unfolding ).

Spesso dal punto di vista sperimentale si procede eccitando un sistema con un segnale noto e si misura, acquisendo

dati relativi alla risposta del sistema, la funzione convoluzione dell'eccitazione e dell'operatore del sistema (incognito),

quindi si procede alla sua determinazione attraverso il metodo di deconvoluzione che viene eseguito numericamente per

mezzo della FFT (Fast Fourier Transform).

i

Y( ω )

((

ω ).( k

i

i .ω ) )

Y( ω )

i

(

1

i .ω )

(k

la cui antitrasformata è

ω )

i

∞

v( t)

1 .

2. π

1

ω

0 .. 3. 101

(k

i .ω )

. exp ( i . ω . t ) d ω

0

1

U( ω )

V( ω )

0.5

UV ( ω )

0

0

5

10

15

20

25

30

ω

Spettro di segnali non integrabili

Molte funzioni largamente usate nella teoria delle comunicazioni non soddisfano i requisiti di "

assoluta integrabilità " richiesta dalla trasformata. Comunque possiamo ancora parlare di spettro di

tali segnali se assumiamo che questi spettri possono essere descritti da funzioni generalizzate.

Spettro di una costante

Sia dato il segnale con il seguente modello matematico .u(t) = u0 = costante

Supponiamo che questo segnale possa essere rappresentato dalla sua antitrasformata:

1 +∞

i ωt

u0 =

∫ S (ω )e dω

2π − ∞

in cui S(ω) è sconosciuto. Invocando le proprietà della δ, si può vedere immediatamente che la S(ω

) deve essere: S(ω) = 2π u0δ(ω)

Infatti:

u0 =

+∞

1

2π ∫ u0δ (ω )eiωt dω

2π − ∞

Quindi lo " spettro " di una costante ha solo la componente a frequenza ω = 0.

Spettro di un esponenziale complesso

Sia s ( t ) = e

iω 0 t

il modello matematico del segnale con ω0 nota.

Si vede chiaramente che s(t) non gode della integrabilità assoluta in quanto per t → ±∞, essa non

tende a nessun limite finito. Ciononostante possiamo scrivere la sua antitrasformata:

32

1 +∞

iωt

∫ S (ω )e dω

2π −∞

L'identità è valida solo per S(ω) tale che: S(ω) =2πδ(ω-ω0)

eiω 0t =

+∞

1

iω t

e quindi si avrà: e 0 =

2π ∫ δ (ω − ω 0 )eiωt dω

2π − ∞

Nota:

1. Lo spettro è identicamente nullo ovunque tranne in ω = ω0 dove ha una singolarità.

2. Non è simmetrico rispetto a ω = 0 (ma giace o in ω > 0 oppure in ω < 0)

Spettro di una armonica

Sia s(t) = cosω0t il modello matematico del segnale che possiamo anche scrivere:

s (t ) =

(

eiω 0t + e −iω 0t 1 iω 0t

= e

+ e −iω 0t

2

2

)

data la linearità della trasformata di Fourier e visto che lo spettro di un esponenziale complesso è:

eiω0t ↔ 2πδ (ω − ω0 )

possiamo scrivere:

1 +∞

π ∫ δ (ω − ω 0 ) + δ (ω + ω 0 ) eiωt dω

cosω 0t =

2π −∞

cioè: cosω0t ↔ π[δ(ω-ω0)+δ(ω+ω0)]

[

]

analogamente per il seno avremo: sinω0t ↔ π[δ(ω-ω0)+δ(ω+ω0)]

Spettro di un segnale arbitrario periodico

Esso può essere rappresentato attraverso la serie di Fourier:

+∞

s (t ) = ∑ cneiω1nt

n = −∞

iω t

con ω1 = 2π/T. Data la linearità della trasformata e ricordando che: e 0 ↔ 2πδ (ω − ω0 )

possiamo scrivere lo spettro di s(t):

+∞

s (ω ) = 2π ∑ cnδ (ω − nω1)

n =−∞

che abbiamo già visto. Si tratta di impulsi di tipo δ nell'intervallo ±nω1.

Spettro della funzione di Heaviside σ(t)

1

0

Sia: σ (t ) =

t>0

il modello matematico che possiamo anche rappresentare come un

t<0

lim e −αt

t>0

esponenziale del tipo : σ (t ) = α →0

0

t<0

ricordando che la trasformata di un esponenziale vale e

−αt

↔

1

che con il passaggio al limite diventa:

α → 0 α + iω

σ (t ) ↔ lim

1

e quindi abbiamo:

α + iω

33

σ (t ) ↔

1

iω

che va bene per tutte le ω tranne che per ω = 0 dove c'è una singolarità.

Trattiamo separatamente questo caso. Separiamo la parte reale da quella immaginaria.

1

iω

α

=

−

2

2

2

α + iω α + ω

α +ω 2

Ricordando che:

lim

α

2

α →0 α + ω 2

= πδ (ω )

visto che:

+∞

+∞

α

+∞

ω

ω

dω = ∫

d ( ) = arc tan( )

=π

∫ 2

2

2 2

α −∞

−∞ α + ω

−∞ 1 + (ω α ) α

1

Allora lo spettro è " concentrato " in ω = 0. Quindi:

σ (t ) ↔

1

+ πδ (ω )

iω

la presenza della singolarità in zero indica la presenza di una costante del valore 1/2.

Spettro di un impulso " armonico"

Sia s(t) = uv cos(ω0t+ϕ0)

Supponiamo di conoscere la trasformata di uv: uv↔Sv(ω)

D'altronde la trasformata del cosω0t è già nota e vale :

[

cos(ω 0t + ϕ 0 ) ↔ π δ (ω − ω 0 )eiϕ 0 + δ (ω + ω 0 )e−iϕ 0

]

E poiché la trasformata del prodotto di due segnali è dato dalla

convoluzione dei rispettivi spettri:

S (ω ) =

[

]

1 +∞

π ∫ Sv (ω − ξ ) δ (ξ − ω 0 )eiϕ 0 + δ (ξ + ω 0 )e −iϕ 0 dξ

2π − ∞

che, dalla proprietà di filtro della δ,

1

1

Sv (ω − ω 0 )eiϕ 0 + Sv (ω + ω 0 )e−iϕ 0

2

2

Quindi mentre lo spettro di uv, Sv(ω) è centrato intorno allo zero, quello di s(t) ha due centri uno in

ω0 e l’altro in -ω0.

S (ω ) =

Vediamo ora lo spettro di un impulso rettangolare che " modula " un segnale armonico.

Il modello matematico è

ur (t ) = u[σ (t ) − σ (t − τ )] cos ω0t

ωτ

sin

2

Ricordando la trasformata di un impulso rettangolare di durata τ: S (ω ) = uτ

ωτ

2

si ha:

S r (ω ) =

uτ

2

sin[(ω − ω 0 )τ 2] sin[(ω + ω 0 )τ 2]

+

(ω + ω 0 )τ 2

(ω − ω 0 )τ 2

34

35

Cenni sulla teoria dei segnali casuali

Nelle telecomunicazioni i segnali si identificano molto spesso con il termine "rumore"- " noise" - "

disturbo ". L'origine fisica è il moto " casuale ", " caotico " degli elettroni sia nella materia che nel

vuoto.

Materia

Vuoto

→

→

componenti: resistori, diodi

onde elettromagnetiche

Nella teoria dell'informazione si usa un modello matematico dei segnali casuali per una

rappresentazione probabilistica delle relazioni esistenti nei messaggi sia in forma di testo che di

immagine. Uso di algoritmi di ricostruzione come il Filtro di Kalman largamente usato sia in

informatica, elettronica che in fisica sub nucleare ( ricostruzione delle tracce).

Nei moderni link ottici si parla similmente di segnali casuali e di " rumore quantistico " legato alla

natura probabilistica dell'emissione e dell'assorbimento.

-- Accoppiamento fibraottica-fotorivelatore -- Accoppiamento guida di luce-fotocatodo

Segnali casuali e loro caratteristiche

Un segnale casuale, per definizione, é tale in quanto non si può predire il suo valore istantaneo in

anticipo. Ciononostante alcune delle sue proprietà possono essere definite con sufficiente accuratezza

in senso probabilistico. Ad esempio, la tensione ai morsetti di un resistore è la sovrapposizione di un

livello medio e di rapide variazioni casuali dette "fluttuazioni". Le fluttuazioni sono tali che si

osserveranno molto più frequentemente piccole variazioni rispetto al valore medio, piuttosto che

grandi variazioni che avverranno raramente. Se conosciamo la probabilità delle fluttuazioni delle

diverse ampiezze, possiamo sviluppare un modello matematico, abbastanza accettabile sia in senso

teorico che pratico.

Una legge probabilistica si manifesta, dal punto di vista fisico, ogni qualvolta un sistema fisico che

genera un segnale casuale, è costituito da un gran numero di più piccoli sotto-sistemi che eseguono

una operazione più o meno indipendente l'uno dagli altri. Ad esempio una corrente elettrica generata

da una sorgente di f.e.m. costante deve la sua costanza all'enorme numero di elettroni (∼1016 per I∼

1.6 mA ) che attraversano la sezione del conduttore al secondo. Le fluttuazioni nella velocità degli

elettroni, tra loro, possono avere solo trascurabili effetti sul valore medio.

•

Probabilità

: Teoria assiomatica.

La base della teoria è il concetto di " popolazione di eventi casuali ".

Sia: Ω = {Ai} dove Ai rappresenta l'accadere di qualche evento casuale. A ciascun evento Ai∈Ω

è assegnato un numero reale P(Ai) detto probabilità2. Vediamo gli assiomi formulati da A.N.

Kolmogorov nel 1930.

1.

La probabilità è non negativa e non eccede l'unità 0 ≤ P(Ai) ≤ 1

L'unione di tutti gli eventi appartenenti a Ω è un evento certo.

2.

∑ P( A ) = 1

Ai ∈Ω

i

3. Se A è un evento complesso, la sua probabilità è la somma di tutte le probabilità

elementari. ∑ P ( Ai ) = P ( A)

Ai ∈A

2

La stima della probabilità è così definita: ps ( A) =

dove

n : numero di casi in cui accade l' evento

N : tentativi indipendenti

n

N

36

Funzioni di distribuzione e densità' di probabilità'

Sia X una variabile casuale che può assumere tutti i valori reali x tali che -∞ ≤ x ≤ +∞. Possiamo

descrivere esaustivamente le proprietà statistiche di X se conosciamo una funzione , F(x), non

casuale, di variabile reale x, tale che essa sia uguale alla probabilità, p, che la variabile casuale X

possa assumere qualsiasi valore x uguale o minore di un dato valore:

F(x) = P(X ≤ x)

F(x) è detta, allora, funzione di distribuzione di probabilità della variabile casuale X.

Se X può assumere qualsiasi valore, allora F(x) è una funzione " smooth " non decrescente con

valori tali che: 0 ≤ F(x) ≤ 1

con i limiti F(-∞) = 0

;

F(+∞) = 1

Si può allora definire la derivata di F(x):

dF ( x )

p( x) =

dx

che prende il nome di densità di probabilità della variabile casuale X.

Allora:p(x)dx = P(x < X ≤ x+dx ) è la probabilità che la variabile casuale X possa assumere

valori compresi tra x e x+dx.

Se X è una variabile casuale discreta che può assumere solo determinati valori:{x1, x2, ..., xn}

con probabilità relative:{p1, p2, ...,pn}, allora:

p( x) = ∑ p i δ ( x − x i )

i

In ogni caso sussistono le condizioni:

1.

p(x) ≥ 0

+∞

2.

+∞

dF ( x)

+∞

dx = ∫ dF ( x) = F ( x ) − ∞ = 1

dx

−∞

−∞

∫ p( x)dx = ∫

−∞

( non negatività)

+∞

( normalizzazione)

Momenti di una variabile casuale

Se ϕ(x) è una specificata funzione di x, allora, per definizione, il suo valore medio è dato da:

+∞

ϕ ( x) = ∫ p ( x )ϕ ( x )dx

−∞

In ogni teoria statistica si usano particolari valori numerici delle variabili casuali che caratterizzano

la distribuzione di probabilità: i momenti della variabile casuale X.

Il momento n-esimo di una variabile casuale è il valore medio dello n-esimo ordine della stessa

variabile:

+∞

n

n

x = ∫ x p ( x)dx

−∞

Il primo momento sarà perciò:

+∞

m1 = x = ∫ xp( x )dx

−∞

Questo è anche detto valore aspettato o medio della variabile casuale X. Esso è una stima per la

media ottenuta con un gran numero di tentativi.

Il secondo momento è:

+∞

m2 = x 2 = ∫ x 2 p ( x)dx

−∞

37

detto valore aspettato o medio dei quadrati della variabile casuale X.

Altri importanti valori caratteristici sono i momenti centrali di una variabile casuale, definiti come:

+∞

µ n = ( x − x )n = ∫ ( x − x )n p( x )dx

−∞

Il più importante è il secondo momento centrale :

+∞

µ 2 = ( x − x )2 = ∫ ( x − x )2 p ( x )dx = σ x2

−∞

detto varianza della variabile casuale che può essere espresso anche, in modo ovvio, come:

+∞

+∞

σ x2 = ∫ x 2 p ( x)dx − 2 ∫ xx p( x)dx + x = x 2 − x 2

−∞

−∞

dalla quale si ricava anche la deviazione standard:

σ x = σ x2

Densità di probabilità uniforme

Sia X una variabile casuale definita nell'intervallo chiuso x1 ≤ x ≤ x2 tale che essa abbia un uguale

probabilità di assumere valori compresi tra x e x+dx qualsiasi entro l'intervallo, allora:

0

p ( x ) = h

0

x < x1

x1 ≤ x ≤ x 2

x2

∫ p ( x)dx = 1

poiché:

x1

x2 < x

1

risulta: p( x) =

x 2 − x1

Perciò abbiamo:

x2

1

1

x2

x +x

m1 = ∫ xp ( x )dx = ∫

xdx =

= 2 1

x2 − x1 2

2

x1

x1 x2 − x1

x2

x2

x1

1

e m2 =

x2 − x1

x2

1 x3

x23 − x13

x22 + x1x2 + x12

x

dx

=

=

=

∫

x2 − x1 3

3( x2 − x1 )

3

x1

x2

2

x1

e quindi il secondo momento centrale:

x2 + x x + x2 x + x

(x − x )2

µ 2 = σ x2 = m2 − m12 = 2 1 2 1 − 2 1 = 2 1

3

12

2

2

da cui la deviazione standard:

σ x = σ x2 =

x 2 − x1

2 3

La funzione di distribuzione F(x) si ottiene attraverso un'operazione d'integrazione della

corrispondente densità di probabilità p(x).

•

Nell'intervallo x1 ≤ x ≤ x2 si ottiene:

1

x − x1

dx =

x2 − x1

x1 x2 − x1

Per x< x1 F(x) = 0

x

F ( x) = ∫

•

38

•

Per x > x2:

x2

1

dx = 1

x1 x2 − x1

F ( x > x1) = ∫

Densità di probabilità gaussiana

Sia:

p( x) =

1

e

σ 2π

−

( x − m )2

2σ 2

Per calcolare il primo momento conviene fare una sostituzione di variabile:

t= (x-m)/σ ; dt = dx/σ ; x= m+σt

allora:

t2

m1 =

t2

t2

−

1 +∞

1 +∞ − 2

1 +∞ − 2

2

(

m

+

σ

t

)

e

dt

=

m

e

dt

+

∫

∫

∫ σte dt

2π − ∞

2π − ∞

2π −∞

Poiché il secondo integrale è nullo perché è una funzione dispari e il primo, per definizione, è

uguale a uno, risulta allora:

m1 = x = m

cioè il parametro m della densità di probabilità gaussiana è proprio il valore aspettato della variabile

casuale x. La varianza o secondo momento centrale è:

( x − m )2

2 −

+

∞

(x − m ) e 2σ 2 dx

1

µ 2 = ( x − m )2 =

∫

2π −∞ σ