CORSO DI LAUREA IN STATISTICA

Statistica per le decisioni (Note didattiche)

Bruno Chiandotto

CAP. 4 – STIMA STATISTICA

4.1 Introduzione

Nel capitolo precedente sono state esaminate le distribuzioni di alcune funzioni

T(X1,X2,…,Xn) degli elementi campionari soffermando l’attenzione, in particolare, su

media e varianza campionarie e facendo specifico riferimento al campionamento da

popolazioni normali. Considerazioni analoghe possono essere svolte nei confronti di

funzioni T ( ⋅ ) diverse da quelle analizzate. La logica del procedimento da seguire resta

sostanzialmente immutata anche se, ovviamente, lo svolgimento analitico dipenderà

dalle specificità considerate. Rimane altresì immutata anche la natura della funzione

T ( ⋅ ) che, nella generalità dei casi, è quella di compattare l’informazione campionaria

in modo da consentire un’estensione delle conclusioni cui si perviene attraverso

l’elaborazione dei dati campionari all’intera popolazione dalla quale il campione stesso

è stato estratto.

Il nucleo centrale dell’inferenza statistica o statistica induttiva risiede, appunto,

nella fissazione di “criteri di ottimalità” e nella individuazione di regole che consentano

il loro soddisfacimento affinché il processo di induzione (dal campione alla

popolazione) sia il “migliore possibile”.

I criteri di ottimalità dipendono, ovviamente, dai problemi di induzione che si

vogliono risolvere e che, come già sottolineato, possono essere distinti e raggruppati in

problemi statistici di:

1.

stima (puntuale e per intervallo)

2.

verifica o test d’ipotesi.

Nel primo caso, i dati campionari vengono utilizzati per ottenere una misura (una

stima) di una entità incognita relativa alla popolazione (indici caratteristici e/o

parametri caratteristici e/o forma analitica del modello rappresentativo del fenomeno

che s’intende analizzare).

1

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Nel secondo caso, i dati campionari vengono utilizzati per procedere al rifiuto o

all’accettazione di una particolare ipotesi (congettura) formulata in merito ad entità

incognite relative alla popolazione di origine del campione.

La stima e il test delle ipotesi possono riguardare sia la forma funzionale del

modello rappresentativo della popolazione di interesse sia i parametri che lo

caratterizzano sia, più semplicemente, degli indici caratteristici; in questo caso si parla,

come già sottolineato, di inferenza statistica non parametrica o inferenza libera da

distribuzione (distribution free) in quanto non si presuppone nota la forma analitica del

modello rappresentativo della popolazione. Se invece la stima o il test delle ipotesi

riguardano i soli parametri caratteristici, in quanto si assume nota la forma analitica del

modello, si parla usualmente di inferenza statistica parametrica.

In questo capitolo si tratterà, in modo quasi esclusivo, di stima parametrica

limitatamente alla così detta impostazione classica dell’inferenza statistica, cioè,

dell’inferenza statistica che tratta di procedure di induzione basate sulla sola evidenza

campionaria (informazione oggettiva), a differenza dell’impostazione bayesiana che

prevede, invece, l’utilizzo simultaneo di informazioni campionarie e di informazioni a

priori che, nella generalità dei casi, hanno natura soggettiva.

4.2 Sufficienza

Per facilitare la comprensione delle argomentazioni che verranno svolte sulle

problematiche concernenti la stima statistica di entità incognite, conviene precisare

alcuni concetti già considerati ed introdurne di nuovi attraverso opportune definizioni.

Il primo nuovo concetto riguarda la cosiddetta famiglia esponenziale.

Definizione 1 (Famiglia esponenziale). Una v.c. caratterizzata da un solo parametro

f ( ⋅ ;θ ) appartiene alla famiglia esponenziale se può essere espressa nella

forma:

f ( x;θ ) = A(θ )B( x ) ⋅ e C (θ )D ( x ) per − ∞ ≤ x ≤ ∞

specificando opportunamente le funzioni A(θ ), B(θ ), C (θ ) e D(x ) .

2

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Una v.c. caratterizzata da r parametri

f ( x ;θ1 , θ 2 ,...., θ r ) = f ( x ;θ )

appartiene alla famiglia esponenziale se può essere espressa nella forma:

r

∑ Ci (θ )Di ( x )

f ( x;θ ) = A(θ )B( x ) ⋅ e i =1

per − ∞ ≤ x ≤ ∞

specificando opportunamente le funzioni

A(θ ), B( x ), C i (θ ) e Di ( x ) per

i=1, 2,….,r.

Appartengono alla famiglia esponenziale le v.c. binomiale (v.c. di Bernoulli,

come caso particolare della binomiale), multinomiale, binomiale negativa (v.c.

geometrica, come caso particolare della binomiale negativa), Poisson, normale, gamma

(v.c. χ 2 e esponenziale negativa, come casi particolari della gamma) e beta.

Definizione 2 (Statistica). Si dice statistica (dall’inglese statistic) qualunque funzione

T(X1,X2,…,Xn) degli elementi campionari che non contiene parametri

incogniti e che sia essa stessa variabile casuale come gli elementi Xi

(i = 1, 2,….,n) costituenti il campione.

.

Una statistica potrebbe, al limite, contenere tutte le informazioni campionarie,

rappresentare, cioè, un punto campionario nello spazio ad

n

dimensioni. Nella

generalità dei casi, come già evidenziato, la funzione T ( ⋅ ) compatta le informazioni,

riducendo lo spazio di riferimento da n dimensioni ad una sola dimensione.

Definizione 3 (Sufficienza). Se X = (X1,X2,…,Xn) costituisce un campione casuale

semplice bernoulliano estratto da una popolazione rappresentata dalla

variabile casuale, discreta o continua X , con funzione di massa o di

densità di probabilità f(x;θ) , una statistica T ( X ) = T(X1,X2,…,Xn) si

dice sufficiente per il modello f(x;θ) se e solo se la distribuzione del

campione condizionata da un qualunque valore assunto dalla statistica

T(.) , cioè f(x1,x2,…,xn/T=t), è la stessa per qualunque valore di θ , cioè,

se e solo se la distribuzione condizionata del punto campionario X =

(X1,X2,…,Xn) non varia al variare di θ (non dipende da θ ).

3

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Per comprendere il significato della definizione, si supponga per semplicità che T ( X )

sia una v.c. discreta e t un possibile valore di T ( X ) , allora

Pθ ( X = x T ( X ) = t ( x) ) =

Pθ ( X = x ∩ T ( X ) = t ( x) )

Pθ (T ( X ) = t ( x) )

ma

[X

= x ] ⊆ [T ( X ) = t ( x )] , quindi Pθ [X = x ∩ T ( X ) = t ( x )] = Pθ ( X = x )

per cui

Pθ ( X = x T ( X ) = t ( x) ) =

Pθ ( X = x )

p( x | θ )

=

Pθ (T ( X ) = t ( x) ) q (t ( x) | θ )

dove p( x | θ ) è la distribuzione di massa di probabilità congiunta del campione X e

q (t ( x ) | θ ) è la distribuzione di massa di probabilità di T ( X ) . Quindi, T ( X ) è una

statistica sufficiente per θ se, e solo se, per ogni x il rapporto precedente è una costante

non dipendente da θ.

Il risultato ottenuto in precedenza conduce alla formulazione del seguente teorema:

Teorema 1: Se p( x | θ ) è la distribuzione di massa di probabilità congiunta di X e q(t | θ )

è la distribuzione di massa di probabilità di T ( X ) , allora T ( X ) è una

statistica sufficiente per θ se, e solo se, ∀ x ∈ Ω il rapporto

p( x | θ )

q (T ( x) | θ )

è una

costante non dipendente da θ.

Esempio 1

Siano X 1 ,..., X n variabili casuali i.i.d. di Bernoulli con parametro p, 0 < p < 1. Allora

T ( X ) = X 1 + ... + X n

è sufficiente per p. Infatti, osservando che T ( X ) indica il numero di Xi

uguali ad 1 ed ha una distribuzione binomiale b(n, p) allora

4

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

p xi (1 − p )1− xi

⎛n⎞

p t (1 − p) n −t

p( x | p)

p ∑ xi (1 − p ) ∑ (1− xi )

∏

=

=

=

= ⎜⎜ ⎟⎟

t

q(T ( x) | p) ⎛ n ⎞ t

⎛n⎞ t

⎛n⎞ t

⎜⎜ ⎟⎟ p (1 − p ) n −t

⎜⎜ ⎟⎟ p (1 − p) n −t

⎜⎜ ⎟⎟ p (1 − p) n −t ⎝ ⎠

⎝t ⎠

⎝t⎠

⎝t⎠

−1

Esempio 2

Siano X 1 ,..., X n variabili casuali i.i.d. da una popolazione N (µ , σ 2 ) , con parametro σ2

noto. Allora la media campionaria T ( X ) = X è sufficiente per µ. Infatti, la distribuzione

di densità congiunta del campione X è:

(

f ( x µ ) = ∏ (2πσ 2 ) −1 / 2 exp − ( x i − µ ) 2 2σ 2

)

i

⎛

= (2πσ 2 ) − n / 2 exp⎜⎜ − ∑ ( x i − x + x − µ ) 2

⎝ i

(2σ )⎞⎟⎟

2

⎠

⎛ ⎛

⎞

= (2πσ 2 ) − n / 2 exp⎜ − ⎜⎜ ∑ ( x i − x ) 2 + n( x − µ ) 2 ⎟⎟

⎜

⎠

⎝ ⎝ i

(2σ )⎞⎟⎟

2

⎠

e, poiché X segue una distribuzione N ⎛⎜ µ , σ n ⎞⎟ , allora il rapporto

⎝

⎠

2

⎛ ⎛

⎞

(2πσ 2 ) − n / 2 exp⎜⎜ − ⎜ ∑ ( xi − x ) 2 + n( x − µ ) 2 ⎟

f (x µ)

⎠

⎝ ⎝ i

=

2

2

−1 / 2

2

q (t ( x) θ )

(2π σ n)

exp − n ( x − µ ) 2σ

(

⎛

= n −1 2 (2πσ 2 ) −( n −1) / 2 exp⎜ − ∑ ( xi − x ) 2

⎝ i

( ))

(2σ )⎞⎟

(2σ )⎞⎟⎟

2

⎠

2

⎠

non dipende da µ.

La definizione 2 ed il teorema 1 spesso non consentono una facile verifica della

proprietà di sufficienza, obiettivo questo che si può invece conseguire se si fa

riferimento ad un famoso teorema usualmente noto come criterio di fattorizzazione di

Neyman-Fisher.

Teorema 2 (Criterio di fattorizzazione di Neyman-Fisher): Dato un campione

casuale semplice X1,X2,…,Xn estratto da una popolazione X con funzione

di massa o di densità di probabilità f(x;θ) , dove θ rappresenta il parametro

incognito, una statistica T(X1,X2,…,Xn) è sufficiente per il modello f(x;θ) se

5

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

e solo se vale la relazione:

n

f ( x1 , x 2 ,..., x n ;θ ) = ∏ f ( xi ;θ ) = g [T ( x1 , x 2 ,..., x n ) ;θ ] ⋅ h( x1 , x 2 ,..., x n )

i =1

dove

h(x1,x2,…,xn)

è una funzione non negativa dei soli elementi

campionari e g [T ( x1 , x 2 ,..., x n ) ;θ ] è una funzione non negativa che dipende

da θ e dagli elementi campionari solo attraverso la funzione T ( ⋅ ) .

Dimostrazione (caso discreto).

Poiché T ( X ) è una statistica sufficiente la distribuzione condizionata di X dato

T ( X ) = t ( x ) non dipende da θ ma tenendo presente che:

X = x ⊆ T ( X ) = t ( x ) ⇒ Pθ ( X = x ) = Pθ [ X = x ∩ T ( X ) = t ( x )] =

si ha

f ( x | θ ) = Pθ ( X = x) = Pθ [X = x ∩ T ( X ) = t ( x)]

= Pθ [T ( X ) = t ( x)] ⋅ Pθ [X = x T ( X ) = t ( x)]

= ( per la sufficienza Pθ ( X = x T ( X ) = t ( x) ) = P( X = x T ( X ) = t ( x) ))

= g (T ( x) | θ ) ⋅ h( x).

Si supponga che f ( x | θ ) = g (T ( x) | θ ) ⋅ h( x) , ma

Pθ [T ( X ) = t ( x )] =

∑ f (x θ ) = g (x θ ) ⋅ (∑) h( ()x )

x:T ( X )=t ( x )

x:T X =t x

inoltre

se X = x e T ( X ) = t ( x ) , allora T(x ) = t ( x ) ma [X = x ] ⊆ [T ( X ) = t (x )] , quindi

Pθ [X = x T ( X ) = t (x )] =

=

g [t (x )θ ]⋅ h(x )

g [t ( x )θ ]⋅

∑ h( x )

x:T ( X )= t ( x )

=

Pθ [X = x ∩ T ( X ) = t ( x )]

Pθ ( X = x )

=

=

Pθ [T ( X ) = t (x )]

Pθ [T ( X ) = t ( x )]

h( x )

∑ h( x )

x:T ( X )=t ( x )

che non dipende da θ , quindi, T ( X ) è una statistica sufficiente.

Corollario – Una statistica T = T(X1,X2,…..,Xn) è sufficiente per θ se e solo se la

funzione di verosimiglianza associata al punto campionario assume le forma

6

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

L(θ ) = g [t ( x1 , x 2 ,....., x n ) ;θ ]

Esempio 2 (continua)

Per il modello normale, la funzione di densità può essere scomposta nei fattori

(

) ( )

2

⎞

⎛ n

f ( x µ ) = (2πσ 2 ) − n / 2 exp⎜ − ∑ xi − x / 2σ 2 ⎟ ⋅ exp − n( x − µ ) 2 (2σ 2 )

⎠

⎝ i =1

⎛

(

)

⎞

con h( x) = (2πσ 2 ) − n / 2 exp⎜⎜ − ∑ ( xi − x ) 2 (2σ 2 ) ⎟⎟ che non dipende dal parametro incognito µ

⎝

⎠

i

e g (t | µ ) = exp(− n( x − µ ) 2 (2σ 2 ) ) che, viceversa, dipende dal campione x solo attraverso

la funzione t ( x ) = x .

Per

i

modelli

probabilistici

appartenenti

alla

famiglia

esponenziale

l’individuazione di statistiche sufficienti è immediata se si fa riferimento al criterio di

fattorizzazione; infatti, se X 1 ,..., X n sono variabili casuali i.i.d. relative ad un campione

estratto da una distribuzione di massa o di densità di probabilità f ( x | θ ) che appartiene

alla famiglia esponenziale si ha:

f ( x;θ ) = A(θ )B( x ) ⋅ e C (θ )D ( x )

quindi

n

n

∏ f (x ;θ ) = A (θ )∏ B(x ) ⋅ e

n

i

i =1

i

n

∑ D ( xi )

C (θ )

i =1

i =1

allora T ( X ) = ∑ D( x i ) è una statistica sufficiente per θ.

n

i =1

La definizione di sufficienza e il criterio di fattorizzazione possono essere

facilmente estesi al caso in cui θ sia un vettore di parametri e/o T ( X ) un vettore di

statistiche (le dimensioni dei due vettori non necessariamente coincidono). In tal caso le

statistiche del vettore T ( X ) , prese insieme, si dicono congiuntamente sufficienti per

θ.

Relativamente al concetto di sufficienza valgono le seguenti proprietà:

7

B. Chiandotto

Statistica per le decisioni

Stima statistica

•

Versione 2006

se T(.) è una statistica sufficiente (o un vettore di statistiche sufficienti), si

dimostra che qualsiasi trasformazione biunivoca di tale statistica (o vettore di

statistiche) è anch’essa sufficiente;

•

nel criterio di fattorizzazione, se in luogo di f(x; θ) si considera il suo logaritmo

naturale ln f(x; θ), la scomposizione di tale funzione in due componenti funziona

in modo analogo, con la differenza che invece di moltiplicarsi si sommano.

Infatti

bf(x; θ) = log [g(T(x); θ) h(x)] = log g(T(x); θ) + log h(x) = g1(T(x); θ) + h1 (x).

La proprietà richiamata in quest’ultimo punto sta ad indicare che se T(x) è

sufficiente per θ se e solo se log f(x; θ) può essere scomposto nella somma di due

funzioni g1(T(x); θ) e h1(x), di cui: la prima dipende dal parametro e dal campione solo

attraverso la funzione T(.); la seconda dipende solo dagli elementi del campione.

Esempio 2 (continua)

Per il modello normale, qualora sia µ che σ2 risultino incogniti (cosicché il vettore dei

parametri risulti θ = ( µ , σ 2 ) ), ogni parte della densità campionaria congiunta che

dipende o da µ o σ2 deve essere inclusa, per il teorema di fattorizzazione, nella funzione

g. Da quanto visto nell’esempio 2 si ha che

⎛ ⎛

⎞

⎞

f ( x µ ) = (2πσ 2 ) − n / 2 exp⎜ − ⎜⎜ ∑ ( xi − x ) 2 + n( x − µ ) 2 ⎟⎟ (2σ 2 ) ⎟

⎜

⎟

⎠

⎝ ⎝ i

⎠

((

)

= (2πσ 2 ) − n / 2 exp − (n − 1)t 2 + n(t1 − µ ) 2 (2σ 2 )

)

2

= g (t1 , t 2 | µ , σ )h( x)

con t1 = x , t 2 = ∑ ( xi − x ) 2 (n − 1) e h( x) = 1 . Quindi T ( X ) = (T1 ( X ), T2 ( X )) = (X , S 2 )

i

sono statistiche congiuntamente sufficienti per ( µ , σ 2 ) .

Riguardo alle statistiche sufficienti si deve, infine, sottolineare che l’intero

campione X è per definizione esso stesso una statistica sufficiente (con T (x ) = x e h(x ) = 1

per ogni x). Da ciò segue che ogni funzione biunivoca di una statistica sufficiente è

ancora una statistica sufficiente. Infatti, sia T * (x ) = r (T (x )) , con T (x ) sufficiente e r

8

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

funzione biunivoca con inversa r –1. Allora, per il Teorema di fattorializzazione,

f ( x | θ ) = g (T ( x) | θ )h( x) = g (r −1 (T * ( x)) | θ )h( x ) = g * (T * ( x)) | θ )h( x).

e ciò a dimostrazione che T * ( x) è una statistica sufficiente.

La non unicità delle statistiche sufficienti solleva un problema di scelta tra le

alternative possibili; ovviamente la scelta ottimale ricadrà sulla statistica capace del più

alto livello di sintesi, senza dover rinunciare ad alcuna delle informazioni necessarie

alla conoscenza dei parametri incogniti; una tale statistica viene detta sufficiente

minimale

Esempio 2 (continua)

Si verifica facilmente che (X , S 2 ) è una statistica sufficiente minimale per ( µ , σ 2 ) se e

solo se x = y e s x2 = s 2y .

Una statistica sufficiente minimale non è unica, in quanto una qualunque sua

funzione biunivoca è ancora una statistica sufficiente minimale.

4.3 Stima puntuale

Se X è una variabile casuale discreta o continua, con funzione di massa o di densità di

probabilità f(x;θ), dove θ rappresenta il parametro caratteristico non noto , la stima

statistica puntuale di

θ si risolve nella ricerca di una funzione degli elementi

campionari , θ̂ = T ( X 1 , X 2 ,... X n ) , in modo tale da ottenere un valore θ̂ che sia ”il più

vicino possibile” all’entità incognita θ .

Come già sottolineato, attraverso l’introduzione della statistica T ( ⋅ ) si effettua,

generalmente, una compattazione delle informazioni passando, usualmente, dagli n

valori numerici x1,x2,…xn ad un solo valore numerico, ad es. x( =

1 n

∑ xi ) . Risulta

n i =1

evidente che tale operazione comporta una notevolissima perdita di informazioni;

aspetto questo che non deve assolutamente preoccupare, anzi, in molte situazioni

9

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

risulta vantaggioso, soprattutto quando le informazioni che si perdono sono del tutto

irrilevanti ai fini degli obiettivi che s’intendono perseguire.

L’ultima considerazione svolta, suggerisce una prima possibilità di qualificazione

della generica affermazione θ̂ deve essere “il più vicino possibile” a θ od anche, θ̂

deve essere “la migliore” stima di θ . Ad esempio, se si ha ragione di ritenere che una

certa variabile casuale X sia distribuita normalmente, ma non si conosce il valore

numerico dei due parametri che la caratterizzano, µ e σ2, si può decidere di estrarre un

campione di n elementi dalla distribuzione stessa e cercare poi di individuare due

funzioni che applicate ai valori campionari diano una misura, la “migliore”, dei due

parametri incogniti. Analogo ragionamento può essere fatto nei confronti del parametro

λ che caratterizza la distribuzione di Poisson, del parametro p che caratterizza la

distribuzione bernoulliana, ecc.

Più in generale, data una variabile casuale, discreta o continua, X con funzione di

massa o di densità di probabilità f(x;θ) , la stima puntuale del un parametro incognito θ

si ottiene applicando una specifica funzione T ( ⋅ ) ai valori campionari; essa varierà

quindi al variare del campione, secondo la legge di distribuzione della popolazione cui

il campione si riferisce, ed è necessario fare riferimento a tale distribuzione per riuscire

a giudicare la “bontà” di una qualunque stima θ̂ = T(x1, x2,...,xn). Infatti, non è possibile

affermare se un singolo valore numerico, cioè se una particolare stima θ̂ è “buona” o

“cattiva” poiché θ̂

è tanto più “buona” quanto più si approssima al vero valore del

parametro θ , ma, essendo tale valore incognito, il confronto non è possibile; risulta,

cioè, impossibile valutare la “bontà” di una singola stima.

Pertanto, è improprio parlare di stima “buona” o “cattiva”, si deve parlare invece

di stimatore “buono” o “cattivo”, intendendo, con ciò, fare riferimento al metodo di

stima impiegato le cui proprietà non sono valutabili facendo riferimento ad un singolo

campione ma all’universo di tutti i campioni possibili. Il confronto fra stimatori

dovrà, quindi, essere basato sul confronto tra le corrispondenti distribuzioni

campionarie; cosa questa ovviamente poco pratica, si preferisce allora effettuare il

confronto facendo riferimento a particolari indici caratteristici delle variabili casuali

stima.

10

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

4.3.1 Proprietà degli stimatori puntuali

Se con X si indica una variabile casuale, discreta o continua, con funzione di

massa o di densità di probabilità f(x;θ) , caratterizzata dal parametro incognito θ , il

problema della ricerca del ”miglior” stimatore del parametro stesso si sostanzia nella

individuazione della “migliore” funzione T ( ⋅ ) da applicare agli elementi campionari di

cui si dispone:

Definizione 4 (Stimatore). Se con X si indica una variabile casuale, discreta o

continua, con funzione di massa o di densità di probabilità

f(x;θ) ,

caratterizzata dal parametro incognito θ , e si indica con X1,X2,…,Xn un

campione casuale semplice riferito alla variabile stessa, si dice stimatore

qualunque statistica

T(X1,X2,…,Xn) , cioè qualunque variabile casuale,

funzione degli elementi campionari, le cui determinazioni vengono

utilizzate per ottenere una misura (stima puntuale) del parametro incognito

θ.

Le proprietà “ottimali” che verranno considerate in queste note sono la:

•

sufficienza;

•

concentrazione;

•

prossimità;

•

efficienza;

•

consistenza.

4.3.2 Sufficienza

Relativamente alle proprietà “ottimali” di uno stimatore si deve, innanzi tutto, tenere

presente che la funzione T ( ⋅ ) opera una compattazione delle informazioni; risulta,

pertanto, più che ragionevole richiedere ad uno stimatore θ̂ = T(X1,X2,…,Xn) di contenere

il massimo delle informazioni che il campione fornisce in merito al valore del

parametro incognito θ.

Nel caso in cui si riesce ad individuare uno stimatore θ̂ che contiene tutte le

informazioni su θ possedute dal campione di dati a disposizione, si dice che θ̂ è uno

11

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

stimatore sufficiente di θ. Appare subito evidente che nei casi in cui esistono stimatori

sufficienti, si dovrà restringere la ricerca della miglior stimatore entro tale classe

poiché, al di fuori di essa, ogni altro stimatore avrebbe come conseguenza una mancata

utilizzazione di informazioni utili contenute nel campione. Ovviamente, è sufficiente lo

stimatore basato su una statistica sufficiente.

4.3.3 Concentrazione e prossimità

Oltre alla sufficienza, risulta conveniente che le singole stime non si discostino troppo

dal valore incognito da stimare, che presentino, cioè, il minimo di variabilità intorno a

tale valore, variabilità che può essere misurata sia attraverso specifici indici sintetici,

come si avrà modo di verificare nelle righe successive, sia considerando direttamente la

distribuzione di probabilità.

Definizione 5 (Concentrazione). Lo stimatore θˆ * = T * ( X 1 , X 2 ,..., X n ) che soddisfa

la relazione:

(

) (

)

P θ − λ ≤ θˆ * ≤ θ + λ ≥ P θ − λ ≤ θˆ ≤ θ + λ per qualsiasi valore di λ > 0

è detto più concentrato dello stimatore θˆ = T ( X 1 , X 2 ,....., X n ) .

Quella specificata è una proprietà relativa, si effettua, cioè, il confronto

tra due particolari stimatori θˆ * e θˆ . Se la disuguaglianza vale per

qualunque stimatore θˆ alternativo a θˆ * si dirà che θˆ * è lo stimatore più

concentrato in assoluto.

Definizione 6 (Prossimità). Lo stimatore θˆ * = T * ( X 1 , X 2 ,..., X n ) che soddisfa la

relazione:

[

]

P θˆ * − θ < θˆ − θ ≥ 0,5 per qualsiasi valore di θ

è

detto

più

prossimo

(secondo

Pitman)

dello

stimatore

θˆ = T ( X 1 , X 2 ,....., X n ) .

Quella specificata è una proprietà relativa, si effettua, cioè, il confronto

tra due particolari stimatori θˆ * e θˆ . Se la disuguaglianza vale per

12

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

qualunque stimatore θˆ alternativo a θˆ * si dirà che θˆ * è lo stimatore che

presenta una migliore approssimazione in assoluto.

4.3.4 Efficienza

Le proprietà di concentrazione e di prossimità sono certamente del tutto auspicabili

purtroppo, però, sono veramente rare le situazioni nelle quali esistono stimatori che

godono di tali proprietà oltre alle difficoltà analitiche connesse alla loro derivazione. Si

dovrà, pertanto, fare riferimento non all’intera distribuzione di probabilità ma a specifici

indici sintetici di variabilità, procedendo, cioè, al computo di scostamenti appropriati tra

i valori assumibili dallo stimatore e il vero valore del parametro incognito (qualunque

esso sia) per poi addivenire ad una loro adeguata sintesi. L’entità aleatoria che si sta

trattando è la variabile casuale stimatore θ̂ = T(X1,X2,…,Xn) e la costante di riferimento è

il parametro incognito θ. Gli scostamenti tra tutti i valori che la variabile casuale stima

θ̂ assume, nell’universo dei campioni, e il valore incognito θ , possono essere espressi

(

)

2

dalla differenza in valore assoluto | θˆ − θ | od anche al quadrato θˆ − θ .

Definizione 7 (Efficienza nell’ESM). Lo stimatore

{

}

θˆ * = T * ( X 1 , X 2 ,..., X n )

{

che

}

soddisfa la relazione: E | θˆ * − θ | ≤ E | θˆ − θ | per qualunque θ ∈ Θ e

per qualunque stimatore θˆ alternativo allo stimatore θˆ * ; dove, dove, al

solito, E( ) sta ad indicare il valore atteso (valore medio) dell’entità

all’interno della parentesi, è detto il più efficiente nell’errore semplice

medio

{

}

ESM( θ̂ ) = E | θˆ − θ | .

Definizione 8 (Efficienza nell’EQM). Lo stimatore

{

soddisfa la relazione: E ( θˆ * − θ ) 2

θˆ * = T * ( X 1 , X 2 ,..., X n ) , che

} ≤ E{( θˆ − θ ) }

2

per qualunque

θ ∈ Θ e per qualunque stimatore θˆ alternativo allo stimatore θˆ * ,

è detto il più efficiente nell’errore quadratico medio

()

{(

EQM θˆ = E θˆ − θ

13

) }.

2

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Quello sopra introdotto è un concetto assoluto di efficienza che risulta

operativamente poco utile in quanto sono molto infrequenti le situazioni di ricerca in cui

si riesce ad individuare per via analitica lo stimatore più efficiente (nell’errore semplice

medio o nell’errore quadratico medio), sempre nell’ipotesi di esistenza di tale stimatore.

Analogamente a quanto detto a proposito delle proprietà di concentrazione e di

prossimità, oltre a considerare la proprietà di efficienza in senso assoluto si può

introdurre il concetto di efficienza in senso relativo confrontando due diversi stimatori

θ̂ 1 e θ̂ 2 di uno stesso parametro incognito θ .

Lo stimatore θ̂ 1 si dice più efficiente dello stimatore θ̂ 2 :

•

nell’errore semplice medio se ESM( θ̂ 1 ) < ESM( θ̂ 2 ) , per qualunque θ ∈ Θ ;

•

nell’errore quadratico medio se EQM( θ̂ 1 ) < EQM( θ̂ 2 ), per qualunque θ ∈ Θ .

L’efficienza relativa dello stimatore θ̂1 rispetto allo stimatore θ̂ 2 è definita dai

rapporti:

e ESM =

( )

( )

ESM θˆ1

ESM θˆ

e EQM =

2

( )

( )

EQM θˆ1

EQM θˆ

2

Comunque, il problema più rilevante nella ricerca dello stimatore più efficiente

non risiede tanto nelle difficoltà analitiche di computo quanto nell’inesistenza di un tale

stimatore ottimale; infatti, non sono affatto rare le situazioni nelle quali non esiste uno

stimatore che minimizza l’ESM o l’EQM per qualunque valore di θ . In tali situazioni si

dovrà abbandonare l’obiettivo della ricerca dell’ottimo, non esistendo un ottimo, per

procedere, eventualmente, alla ricerca di un sub-ottimo.

Si può, ad esempio, procedere alla ricerca di uno stimatore puntuale capace di

minimizzare l’ESM o l’EQM in una classe ristretta di stimatori (minimo vincolato)

essendo ragionevole ipotizzare l’esistenza di un ottimo in una classe ristretta; il vincolo

usualmente imposto è quello della correttezza o non distorsione dello stimatore.

Definizione

9

(Correttezza

o

non

14

distorsione).

Uno

stimatore

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

θˆ n = Tn ( X 1 , X 2 ,..., X n ) (di θ ) si dice corretto o non distorto se

E( θ̂ ) = θ.

per qualunque θ ∈ Θ .

Si consideri ora la relazione

[(

EQM( θˆ ) = E θˆ − θ

) ] =E[ (θˆ − E(θˆ ) + E(θˆ ) − θ ) ] = Var(θˆ ) + [ E (θˆ ) - θ ]

2

2

2

= σ θ2ˆ + d 2

()

dove d = θ − E θˆ viene detta distorsione. Se θˆ n = Tn ( X 1 , X 2 ,..., X n ) è uno stimatore

non distorto di θ si ha d2 = 0 e quindi:

{(

EQM ( θˆ ) = E θˆ − θ

) }= E{ [θ - E (θˆ )]

2

2

} = Var( θˆ )

cioè, se uno stimatore è corretto l’errore quadratico medio e la varianza

coincidono. Pertanto, nella classe ristretta degli stimatori corretti si può affermare che

lo stimatore più efficiente nell’EQM è lo stimatore di minima varianza. Quest’ultima

conclusione provoca spesso confusione inducendo a concludere che lo stimatore più

efficiente è lo stimatore di minima varianza; si tratta, ovviamente, di una conclusione

errata perché l’affermazione vale solo nell’ambito degli stimatori corretti.

Il vincolo di correttezza in molti testi non viene introdotto con una tale

connotazione, cioè come restrizione della classe degli stimatori, ma come proprietà

dello stimatore stesso. Nella logica espositiva qui seguita, dove la “bontà” di uno

stimatore è misurata facendo riferimento alla sua variabilità campionaria, una tale

interpretazione della correttezza non può essere accolta.

È stato più volte sottolineata la possibilità di non esistenza dello stimatore più

efficiente, sia nell’EQM che nell’ESM, possibilità questa molto più frequente invece

nella classe ristretta degli stimatori corretti; infatti, come si avrà modo di chiarire nelle

righe che seguono, per alcuni modelli è possibile dimostrare che esiste lo stimatore più

efficiente nell’EQM. In tale ottica un ruolo fondamentale è svolto dalla disuguaglianza

di Cramèr-Rao; si tratta di una disuguaglianza che individua il valore minimo

assumibile dalla varianza di uno stimatore corretto.

Teorema 3 (Limite di Cramèr-Rao); Sia X una v.c. con funzione di massa o di densità

f(x; θ), dove θ ∈ Θ è un parametro incognito, se sono soddisfatte le

condizioni di regolarità:

15

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

•

d

log f ( x;θ ) esiste per qualunque x e per qualunque θ ;

dθ

•

d

dθ

∫ ∫ ⋅ ⋅ ⋅ ⋅∫ ∏ f (xi ;θ ) dx1dx2 ⋅ ⋅ ⋅ ⋅dxn = ∫ ∫ ⋅ ⋅ ⋅ ⋅∫

d

dθ

∫ ∫ ⋅ ⋅ ⋅ ⋅∫ t (x1 , x2 ,⋅ ⋅ ⋅ ⋅ xn )∏ f (xi ;θ ) dx1dx2 ⋅ ⋅ ⋅ ⋅dxn =

•

•

n

i =1

d n

∏ f (xi ;θ ) dx1dx2 ⋅ ⋅ ⋅ ⋅dxn ;

dθ i=1

n

i =1

= ∫ ∫ ⋅ ⋅ ⋅ ⋅∫ t ( x1 , x 2 ,⋅ ⋅ ⋅ ⋅ x n )

d

dθ

n

∏ f (x ;θ ) dx dx

1

i

2

⋅ ⋅ ⋅ ⋅dx n ;

i =1

⎧⎡ d

⎤⎫

0 < E ⎨⎢

log f ( x;θ )⎥ ⎬ < ∞ per qualunque θ .

⎦⎭

⎩⎣ dθ

vale la relazione di disuguaglianza

()

Var θˆ ≥

1

n

⎧⎪⎡ d

⎤

E ⎨⎢ log ∏ f ( X i ;θ ) ⎥

i =1

⎪⎩⎣ dθ

⎦

16

2

⎫⎪

⎬

⎪⎭

=

1

2

⎧⎪⎡ d

⎤ ⎫⎪

nE ⎨⎢ log f (X; θ )⎥ ⎬

⎪⎩⎣ dθ

⎦ ⎪⎭

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Dimostrazione

d

d

θ=

dθ

dθ

1=

n

∫ ∫ ⋅ ⋅ ⋅ ⋅∫ t (x1 , x2 ,⋅ ⋅ ⋅ ⋅ xn )∏ f (xi ;θ ) dx1dx2 ⋅ ⋅ ⋅ ⋅dxn =

i =1

= ∫ ∫ ⋅ ⋅ ⋅ ⋅∫ t ( x1 , x 2 ,⋅ ⋅ ⋅ ⋅ x n )

− θ ∫ ∫ ⋅ ⋅ ⋅ ⋅∫

d

dθ

d

dθ

n

∏ f (x ;θ ) dx dx

i

1

2

⋅ ⋅ ⋅ ⋅dx n +

i =1

n

∏ f (x ;θ ) dx dx

i

1

2

⋅ ⋅ ⋅ ⋅dx n =

i =1

⎡d

= ∫ ∫ ⋅ ⋅ ⋅ ⋅∫ [t ( x1 , x 2 ,⋅ ⋅ ⋅ ⋅ x n ) − θ ] ⋅ ⎢

⎣ dθ

⎤

n

∏ f (x ;θ )⎥⎦

i

dx1 dx 2 ⋅ ⋅ ⋅ ⋅dx n =

i =1

n

⎡d

⎤

log ∏ f ( xi ;θ )⎥

= ∫ ∫ ⋅ ⋅ ⋅ ⋅∫ [t ( x1 , x 2 ,⋅ ⋅ ⋅ ⋅ x n ) − θ ] ⋅ ⎢

i =1

⎣ dθ

⎦

n

∏ f (x ;θ )dx dx

i

1

2

⋅ ⋅ ⋅ ⋅dx n =

i =1

⎧

⎡d n

⎤⎫

= E ⎨ [t ( x1 , x 2 ,⋅ ⋅ ⋅ ⋅ x n ) − θ ] ⋅ ⎢ ∏ f ( xi ;θ )⎥ ⎬

⎣ dθ i =1

⎦⎭

⎩

( per la disuguaglianza Cauchy - Schwarz )

2

n

⎡ ⎧

⎡d

⎤ ⎫⎤

log ∏ f ( xi ;θ )⎥ ⎬⎥ ≤

⎢ E ⎨ [t ( x1 , x 2 ,⋅ ⋅ ⋅ ⋅ x n ) − θ ] ⋅ ⎢

i =1

⎣ dθ

⎦ ⎭⎦⎥

⎣⎢ ⎩

≤E

2

n

⎧⎪ ⎡ d

⎤ ⎫⎪

log ∏ f ( xi ;θ )⎥ ⎬

⋅ E⎨ ⎢

i =1

⎪⎩ ⎣ dθ

⎦ ⎪⎭

{ [t (x , x ,⋅ ⋅ ⋅ ⋅ x ) − θ ] }

2

1

n

2

da cui

E

{ [t (x , x ,⋅ ⋅ ⋅ ⋅ x ) − θ ] } = Var (θˆ) ≥

1

2

1

2

n

2

n

⎧⎪ ⎡ d

⎤ ⎫⎪

E⎨ ⎢

log ∏ f ( xi ;θ )⎥ ⎬

i =1

⎪⎩ ⎣ dθ

⎦ ⎪⎭

ma

2

2

n

⎧⎪ ⎡ d

⎧⎪ ⎡ n d

⎤ ⎫⎪

⎤ ⎫⎪

E⎨ ⎢

log ∏ f ( xi ;θ )⎥ ⎬ = E ⎨ ⎢∑

log f ( xi ;θ )⎥ ⎬ =

⎪⎩ ⎣ i =1 dθ

⎦ ⎪⎭

i =1

⎪⎩ ⎣ dθ

⎦ ⎪⎭

2

d

⎧ d

⎫ n ⎧⎪⎡ d

⎤ ⎫⎪

E ⎨⎢

log f ( xi ;θ )⎥ ⎬ =

∑

∑ E ⎨ log f (xi ;θ ) ⋅ dθ log f (x j ;θ )⎬⎭ + ∑

⎪⎩⎣ dθ

⎦ ⎪⎭

i =1 j ( ≠ i ) =1 ⎩ dθ

i =1

n

n

( per l ' indipendenza delle v.c. X i )

2

⎧⎪⎡ d

d

⎧d

⎫

⎤ ⎫⎪

log f ( x;θ )⎥ ⎬ =

= ∑ ∑ ⎨ ⋅ E [ f ( xi ;θ )]

⋅ E [ f ( xi ;θ )]⎬ + n E ⎨⎢

dθ

⎪⎩⎣ dθ

⎭

⎦ ⎪⎭

i =1 j ( ≠ i ) =1 ⎩ dθ

n

n

⎧⎪⎡ d

⎤

= n E ⎨⎢

log f ( x;θ )⎥

⎪⎩⎣ dθ

⎦

2

⎫⎪

⎬

⎪⎭

17

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

La quantità

2

2

n

⎧⎪⎡ d

⎧⎪⎡ d

⎤ ⎫⎪

⎤ ⎫⎪

I (θ ) = E ⎨⎢ log ∏ f ( X i ;θ ) ⎥ ⎬ = n E ⎨⎢

log f ( x;θ )⎥ ⎬

⎪⎩⎣ dθ

⎦ ⎪⎭

i =1

⎪⎩⎣ dθ

⎦ ⎪⎭

usualmente detta informazione di Fisher, si indica con I(θ ) e fornisce una misura

dell’informazione contenuta nel campione. Da sottolineare che l’informazione I(θ) è la

varianza della variabile casuale che si ottiene derivando il logaritmo della funzione di

verosimiglianza; tale derivata è detta funzione score ed è espressa da:

d

L' (θ ) f ' (x1 , x 2 ,..., x n ;θ )

S (θ ) =

log L(θ ) =

=

dθ

L(θ )

f ( x1 , x 2 ,..., x n ;θ )

infatti

Var [S (θ )] = E

{ [S (θ )] } = I (θ )

2

poiché

E [S (θ )] = ∫∫ ⋅ ⋅ ⋅ ⋅ ∫

f ' ( x1 ,x 2 ,...,x n ;θ )

⋅ f (x1 ,x 2 ,...,x n ;θ ) ⋅ dx1 ⋅ dx 2 ⋅ ⋅ ⋅ ⋅dx n =

f ( x1 ,x 2 ,...,x n ;θ )

d

d

d

⋅ ⋅ ⋅ ⋅ ∫ ⋅ f ( x1 ,x 2 ,...,x n ;θ ) ⋅ dx1 ⋅ dx 2 ⋅ ⋅ ⋅ ⋅dx n =

⋅1 = 0

f (x;θ ) d x =

∫∫

∫

dθ

dθ x

dθ

L’informazione di Fisher può essere quindi espressa dall’uguaglianza:

{

I (θ ) = E [S (θ ) ]

2

}

ma

d

x dθ

0=∫

⎧d

⎫

⎨ [log f ( x,θ )] ⋅ f ( x, θ )⎬ d x =

⎩ dθ

⎭

2

⎧ d2

⎫

⎡d

⎤

= ∫ ⎨ 2 [log f ( x, θ )] ⋅⎬ f ( x, θ ) d x + ∫ ⎢ log f ( x, θ )⎥ ⋅ f ( x,θ ) d x =

x dθ

x dθ

⎣

⎦

⎩

⎭

⎡d

⎤

2

= E ⎢ S (θ )⎥ + E [S (θ ) ]

⎣ dθ

⎦

da cui

{

{

}

}

⎡d

⎤

2

E [S (θ ) ] = − E ⎢ S (θ )⎥ = I (θ )

⎣ dθ

⎦

Si noti che per definire la funzione score S(θ) e l’informazione di Fisher I(θ)

si è fatto riferimento all’universo dei campioni, cioè, nella funzione di verosimiglianza

18

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

al singolo punto campionario x1,x2,…,xn si è di nuovo sostituita la variabile casuale ad

n dimensioni X = (X1,X2,…,Xn).

La conclusione cui si perviene è che la varianza di uno stimatore corretto non

può scendere sotto il reciproco dell’informazione di Fisher, quindi, se Var( θˆ ) = 1/I(θ)

lo stimatore θˆ è il “migliore”, cioè, il più efficiente nell’ambito degli stimatori corretti.

Se risulta, invece, Var( θˆ ) > 1/I(θ), non è possibile pervenire ad alcuna conclusione nel

senso che potrebbe esistere o non esistere un altro stimatore corretto più efficiente.

Comunque, è stato dimostrato che il limite minimo della disuguaglianza viene raggiunto

se e solo se il modello (v.c. rappresentativa della popolazione di riferimento) dal quale

il campione è stato estratto appartiene alla famiglia esponenziale.

L’inserimento del vincolo di correttezza riduce, in pratica, lo spazio in cui

ricercare l’ottimo la cui esistenza è garantita per le v.c. che appartengono alla famiglia

esponenziale. Lo stimatore che minimizza l’errore quadratico medio nell’ambito

ristretto delle stime corrette, rappresenta, pertanto, la strategia dominante nella classe

ristretta degli stimatori corretti.

In molte situazioni operative non esiste un’alternativa dominante, neppure nella

classe ristretta degli stimatori corretti, ed anche quando una tale possibilità sussiste a

livello teorico può risultare molto difficile o addirittura impossibile procedere alla sua

derivazione analitica. Una possibile via da seguire per la ricerca dell’ottimo è

rappresentata dall’inserimento di ulteriori vincoli: il più semplice ed immediato, che

risolve anche le difficoltà di ordine analitico, è il vincolo di linearità.

4.3.5 Consistenza

Al crescere della dimensione del campione cresce anche l’ammontare del patrimonio

informativo a disposizione, è quindi ragionevole presumere che al crescere della

dimensione campionaria debba anche crescere la “bontà” dello stimatore.

Per ciò che concerne il comportamento di un qualunque stimatore puntuale al

crescere della dimensione del campione si riportano le due definizioni seguenti che

introducono una ulteriore augurabile proprietà degli stimatori: la consistenza.

Definizione 10 (Consistenza in senso debole). Uno stimatore θˆ n = Tn ( X 1 , X 2 ,..., X n )

19

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

(di θ ) si dice consistente in senso debole se

(

Lim P | θˆn − θ |

n → +∞

< ε

)

= 1

per qualunque θ ∈ Θ e per qualunque ε positivo piccolo a piacere.

Definizione 11 (Consistenza in senso forte). Uno stimatore θˆ n = Tn ( X 1 , X 2 ,..., X n )

(di θ ) si dice consistente in senso forte se

( )

lim EQM θˆn = 0

n→∞

o anche

( )

lim ESM θˆn = 0

n→∞

per qualunque θ ∈ Θ

Ovviamente, la consistenza forte implica la consistenza debole; infatti, per la

disuguaglianza di Cebicev

(

Lim P | θˆn − θ |

n → +∞

< ε

)

(

P | θˆn − θ |

(

<

)

2

E ⎡ θˆn − θ ⎤

⎢⎣

⎥⎦

ε ≥ 1−

ε

)

2

2

poiché Lim E ⎡ θˆn − θ ⎤ = 0, si ha

⎢⎣

⎥⎦

n → +∞

⎧ E ⎡ θˆ − θ 2 ⎤ ⎫

⎢ n

⎥⎦ ⎪

⎪

Lim P | θˆn − θ | < ε ≥ Lim ⎨1 − ⎣

⎬ =1

n → +∞

n → +∞

2

ε

⎪

⎪

⎩

⎭

(

(

)

)

4.4 Metodi di stima puntuale

Una volta elencate le proprietà che si ritiene debbano essere soddisfatte da uno

stimatore puntuale, si dovranno valutare i metodi di stima proposti in letteratura

verificando se, ed in quali condizioni operative, producono stimatori che soddisfano tali

proprietà.

In queste note verranno considerati, anche se in alcuni casi molto sommariamente,

i metodi di stima:

•

della minimizzazione dell'errore quadratico medio;

20

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

•

della massima verosimiglianza;

•

dei momenti;

•

del minimo chi-quadro (χ2);

•

della minima distanza;

4.4.1 Minimizzazione dell’errore quadratico medio

Un metodo di stima particolarmente rilevante e direttamente collegato alle proprietà

delle stime sopra elencate è quello basato sulla minimizzazione dell'errore quadratico

medio; si tratta, quindi, di un metodo che ha come obiettivo l’individuazione dello

stimatore più efficiente in assoluto.

Un inconveniente di questo metodo è rappresentato dal fatto che, come già

sottolineato, per molte distribuzioni non esiste uno stimatore di

θ̂

capace di

minimizzare l'errore quadratico medio rispetto a tutti i possibili valori di θ, succede cioè

che per alcuni valori di θ l'errore quadratico medio risulta minimizzato dallo stimatore

θ̂ 1 , mentre per altri valori di θ , al minimo si perviene attraverso una diverso stimatore

θ̂ 2 . In tali situazioni, essendo θ una quantità incognita, il problema non ammette

soluzione, o meglio, è il metodo della minimizzazione dell'errore quadratico medio che

non fornisce la soluzione. Comunque, nelle situazioni in cui si riesce ad individuare un

tale stimatore, si tratta dello stimatore più efficiente in senso assoluto ed uno degli

acronimi di più largo impiego per caratterizzare tale stimatore è B(E) (Best Estimator).

Poiché, come già detto, le stime che minimizzano l'errore quadratico medio non

sempre esistono, si preferisce sovente restringere la classe delle funzioni di stima a

quelle che rispettano certe condizioni; ad es. si può, come già sottolineato, restringere la

classe alle sole stime non distorte e ricercare tra queste la stima che minimizza l'errore

quadratico medio. In questo caso, il metodo della minimizzazione dell'errore quadratico

medio si riduce al metodo della minimizzazione della varianza; ma, in tali condizioni si

deve tenere presente che l’ottimo cui si può, eventualmente, pervenire è un ottimo

vincolato (un ottimo relativo e non un ottimo assoluto).

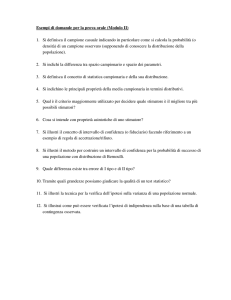

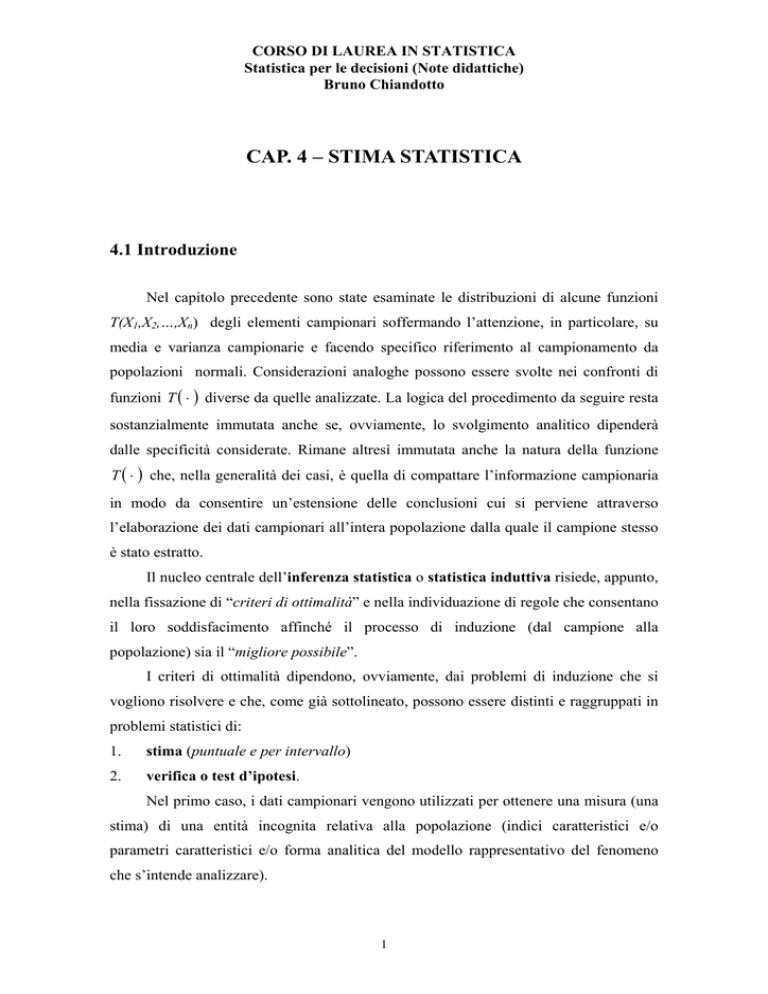

Si consideri ora la Fig. 1 dove sono stati riportati i grafici relativi alle

distribuzioni campionarie di tre diverse funzioni di stima di θ, due di queste, θ̂ 1 e θ̂ 2

21

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

,danno luogo a delle stime di θ corrette, mentre la terza, θ̂ 3 , dà luogo ad una stima

distorta di θ.

f ( θ 3 )

f ( θ 1 )

f ( θ 2 )

Fig. 1 -

θ

Grafico relativo alla distribuzione di tre diverse funzioni di stima

Dei tre stimatori considerati θ̂ 1 , θ̂ 2 e θ̂ 3 il secondo θ̂ 2 è senz'altro da scartare,

infatti tale stimatore pur essendo corretto presenta una variabilità nettamente superiore a

quella dell'altro stimatore corretto θ̂ 1 . La scelta tra le funzioni che danno luogo agli

stimatori θ̂ 1 e θ̂ 3 , presenta invece qualche difficoltà; infatti, in questo caso si tratta di

confrontare due stimatori, dei quali, quello che possiede la “proprietà” della correttezza

θ̂ 1 mostra una maggiore variabilità rispetto a θ . Risulta ragionevole nella situazione

prospettata scegliere lo stimatore θ̂ 3 ; infatti, come si può evincere dalla figura, valendo

la disuguaglianza

( )

( )

EQM θˆ3 < EQM θˆ1

la probabilità di ottenere valori prossimi a θ

risulta più elevata per lo stimatore θ̂ 3 rispetto allo stimatore θ̂ 1 .

L’inserimento del vincolo di correttezza riduce, in pratica, lo spazio in cui

ricercare l’ottimo; se si riuscisse ad individuare tale ottimo, lo stimatore che minimizza

l’errore quadratico medio nell’ambito ristretto delle stime corrette, si sarebbe

individuata la strategia dominante nella classe ristretta degli stimatori corretti. Un tale

stimatore viene usualmente indicato con l’acronimo BU(E) (Best Unbiased Estimator).

In molte situazioni operative non esiste un’alternativa dominante, neppure nella

22

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

classe ristretta degli stimatori corretti, ed anche quando una tale possibilità sussiste a

livello teorico può risultare molto difficile o addirittura impossibile procedere alla sua

derivazione analitica, in tali situazioni si può procedere all’inserimento del vincolo di

linearità

n

T ( X 1 , X 2 ,..., X n ) = α 0 + ∑ α i X i .

i =1

Nella classe ristretta degli stimatori lineari e corretti si riesce ad individuare gli

stimatori ottimali (cioè gli stimatori più efficienti) in molte situazioni rilevanti di

ricerca, tra queste, la più significativa è quella che riguarda i modelli statistici lineari,

in particolare il così detto modello classico di regressione lineare. In tale

contesto,come si avrà modo di chiarire successivamente, il metodo di stima statistica

puntuale che ne risulta viene , usualmente, detto metodo di stima dei minimi

quadrati. Per indicare lo stimatore che minimizza l’EQM nell’ambito degli stimatori

lineari e corretti si utilizza usualmente l’acronimo BLU(E) (Best Linear Unbiased

Estimator)

Il metodo di stima puntuale basato sulla minimizzazione dell’errore quadratico

medio può essere interpretato facilmente in termini decisionali. L’errore quadratico

medio assume, infatti, la veste di funzione di perdita e l’impossibilità di individuazione

dello stimatore più efficiente si risolve nella constatazione della non esistenza di

un’alternativa decisionale (azione) che risulti dominante rispetto a tutte le altre: la

migliore azione per qualunque stato di natura che, nella specifica circostanza, è

rappresentato dal valore assunto dal parametro incognito θ .

4.4.2 Massima verosimiglianza

Un secondo metodo di stima puntuale particolarmente rilevante è il metodo della

massima verosimiglianza.

Si ricorda che: data una variabile casuale, discreta o continua X, con funzione di

massa, o di densità di probabilità f(x; θ) e un campione casuale semplice di n

osservazioni su X , si è definita di verosimiglianza la funzione

n

L( θ ) = f ( θ ; x1 , x 2 ,...,x n ) = ∏ f ( θ ; xi )

i =1

Come già sottolineato, la funzione di verosimiglianza coincide in termini formali

23

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

con la funzione di massa o di densità di probabilità del campione: si tratta infatti di una

stessa espressione interpretata come funzione:

•

degli elementi campionari x1, x2,...,xn (funzione di densità o di massa di

probabilità) che variano nell'universo dei campioni;

del parametro θ (funzione di verosimiglianza) per un campione prefissato.

•

Nella prima interpretazione (a priori), si fa riferimento all’universo dei campioni e

le variabili che interessano sono, appunto, le variabili casuali campionarie X1,X2,…,Xn.

Nella seconda interpretazione (a posteriori), le variabili campionarie hanno assunto

particolari determinazioni x1,x2,…,xn e sono, pertanto, quantità costanti note; risulta,

allora, ragionevole interpretare l’espressione come funzione del parametro (o dei

parametri) θ che, pur essendo una costante, assume la veste di variabile essendo

incognito il suo valore.

Il metodo di stima della massima verosimiglianza consiste nello scegliere il valore

~

θ che massimizza la funzione L(θ). Se L(θ) è una funzione differenziabile, condizione

necessaria affinché essa abbia un massimo è che dL(θ)/d θ = 0 . Nella generalità dei

casi non occorre procedere ad ulteriori elaborazioni (computo delle derivate di ordine

superiore) essendo il punto di stazionarietà individuato un punto di massimo.

La derivazione della funzione di verosimiglianza L(θ) comporta, la derivata del

n

prodotto

∏ f(xi;

θ), operazione non immediata per le note caratteristiche della

i=1

derivazione di un prodotto. Per tale motivo, in genere si preferisce massimizzare non la

verosimiglianza L(θ) ma il logaritmo naturale della verosimiglianza

l(θ) = log L(θ) =

n

∑

log f(xi; θ)

i=1

detto log-verosimiglianza. Essendo il logaritmo naturale una funzione monotona, il

~

valore θ che massimizza la log-verosimiglianza l(θ) è identico a quello che

massimizza la verosimiglianza L(θ).

Si ricorda che la derivata prima della log-verosimiglianza è stata definita come

funzione score; di conseguenza, se la log-verosimiglianza è differenziabile allora

condizione necessaria affinché la funzione abbia un massimo è che il suo score sia 0:

24

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

S(θ) =

d

l (θ ) = 0.

dθ

~

Il valore θ che massimizza la verosimiglianza o la log-verosimiglianza è detto

stima di massima verosimiglianza del parametro incognito θ. Se nella soluzione si

sostituiscono alle determinazioni (x1, ..., xn) le corrispondenti variabili casuali (X1, ...,

Xn) si ottengono gli stimatori di massima verosimiglianza.

Ovviamente se la distribuzione della variabile casuale X, è caratterizzata da più

parametri θ1, ..., θk, per trovare il massimo occorrerà uguagliare a 0 ciascuna delle

derivate parziali rispetto ad ogni singolo parametro (lo score è quindi un vettore a k

componenti, una per ogni parametro incognito) e poi ricavare la stima dei parametri

risolvendo il sistema delle equazioni ottenute.

Si riporta nelle righe seguenti la derivazione delle stime di massima

verosimiglianza, elencandone proprietà e legge di distribuzione, per campioni relativi

ad alcune v.c. tra quelle esaminate nel Cap. 2; si tratta sempre di distribuzioni che

appartengono alla famiglia esponenziale per le quali è, quindi sempre possibile

individuare stimatori sufficienti e, a ragione della disuguaglianza di Cramèr-Rao,

ottimali nell’ambito degli stimatori corretti.

V.C. di Bernoulli

La log-verosimiglianza della v.c. di Bernoulli è data da

n

l(p) =

∑

i=1

n

log f(xi; p) =

∑

i=1

n

n

i=1

i=1

log ( p xi q1− xi ) = log p ∑ xi + log (1-p) (n – ∑ xi).

derivando l(p) rispetto a p per ottenere lo score ed uguagliando a 0 si ha

S(p) =

1

p

n

∑

xi –

i=1

n

1

(n – ∑ xi) = 0.

q

i=1

risolvendo l’equazione rispetto a p si ricava la stima di massima verosimiglianza di p

1

~

p =

n

n

∑

xi = x .

i=1

Lo stimatore di massima verosimiglianza di p è quindi la media campionaria

1

~

p = X =

n

25

n

∑

i=1

Xi,

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

n

Poiché ciascuna Xi è una v.c. di Bernoulli ne consegue che

∑

Xi è la somma

i=1

1

degli 1, nel campione (somma dei successi nelle n prove), e X =

n

n

∑

Xi è la

i=1

proporzione dei successi. L’immediata conclusione cui si perviene, ricordando quanto

n

esposto nel Cap.2, è che lo stimatore ∑ X i ha distribuzione binomiale con parametri n

i =1

e p, mentre la la media campionaria X è una binomiale relativa; questa distribuzione

per n sufficientemente grande può essere approssimata con la distribuzione Normale

avente la stessa media (p) e la stessa varianza (pq/n).

n

∑

Xi (e qualsiasi altra trasformazione biunivoca della stessa) è una statistica

i=1

sufficiente per p, quindi ~

p = X è uno stimatore sufficiente, essendo funzione di tale

statistica sufficiente, e corretto di p, inoltre, il suo EQM coincide con la varianza e

raggiunge il limite di Cramér-Rao; infatti:

n

⎡d

⎤

1 ⎛

⎞⎤ ⎪⎫

⎪⎧ d ⎡ 1 n

I ( p ) = − E ⎢ S ( p )⎥ = − E ⎨ ⎢ ∑ X i −

⎜ n − ∑ X i ⎟⎥ ⎬ =

1− p ⎝

⎪⎩ dp ⎣ p i =1

i =1

⎠⎦ ⎪⎭

⎣ dp

⎦

=−

1

d ⎡1

(n − np )⎤⎥ = np2 + n(1 − p2) = nq + np = n

np −

⎢

1− p

dp ⎣ p

pq

pq

(1 − p )

⎦ p

da cui

1

pq

=

I ( p) n

p=X

che è pari alla varianza di X ; pertanto, lo stimatore di massima verosimiglianza ~

è in assoluto lo stimatore migliore di p nella classe degli stimatori corretti.

Infine, ~

p = X è consistente in senso forte, dato che:

( )

( )

Lim EQM X n = Lim Var X n = Lim

n →∞

n →∞

n →∞

pq

=0

n

Poiché la consistenza forte implica quella debole, X è anche consistente in senso

debole.

V.C. di Poisson

26

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

La log-verosimiglianza della v.c. di Poisson è data da

l(λ) =

n

∑

log f(xi; λ) =

i=1

n

∑

log

λ xi e −λ

xi !

i=1

n

= log λ ∑ xi – nλ –

i=1

n

∑

log xi!

i=1

derivando rispetto a λ per ottenere lo score ed uguagliando a 0 si ha

S(λ) =

1

λ

n

∑

i=1

1

xi – n = 0 ⇒ λ =

n

~

n

∑

xi = x .

i=1

n

La distribuzione campionaria della v.c.

∑X , per la proprietà additiva della v.c.

i =1

i

di Poisson, è ancora una v.c. di Poisson con parametro nλ che coincide con la media e la

~

varianza della v.c. stessa; mentre di λ = X è una v.c. di Poisson relativa di media λ e

varianza λ/n. Tale distribuzione per n sufficientemente grande può essere approssimata

con la distribuzione normale avente la stessa media (λ) e la stessa varianza (λ/n) della

Poisson relativa.

n

∑

Xi (e qualsiasi altra trasformazione biunivoca della stessa) è una statistica

i=1

~

sufficiente per p, quindi λ = X è uno stimatore sufficiente, essendo funzione di tale

statistica sufficiente, e corretto di λ, quindi, il suo EQM coincide con la varianza e

raggiunge il limite di Cramér-Rao; infatti:

⎡ d ⎛1 n

⎞⎤

⎡d

⎤

I (λ ) = − E ⎢ S (λ )⎥ = − E ⎢ ⎜ ∑ X i − n ⎟⎥ =

⎣ dλ

⎦

⎠⎦

⎣ dλ ⎝ λ i =1

⎛ n

⎞ n

= − E ⎜ − ∑ X i / λ2 ⎟ =

⎝ i =1

⎠ λ

da cui

1

λ

=

I ( p) n

che è uguale alla varianza di X ; pertanto, lo stimatore di massima verosimiglianza

~

λ = X è in assoluto lo stimatore migliore di λ nella classe degli stimatori corretti.

~

Inoltre, λ = X è consistente in senso forte, dato che:

( )

( )

Lim EQM X n = Lim Var X n = Lim

n →∞

n →∞

27

n→∞

λ

n

= 0.

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Poiché la consistenza forte implica quella debole, X è anche consistente in senso

debole per λ.

V.C. Normale

La log-verosimiglianza della v.c. Normale è data da:

(

)

n

(

)

n

l µ , σ 2 = ∑ log f xi ; µ , σ 2 = ∑ log

i =1

i =1

n

n

1

= − log(2π ) − log σ 2 −

2

2

2σ 2

n

∑ (x

i =1

i

1

2πσ 2

− µ)

⋅e

−

1

2σ 2

( xi − µ )2

=

2

Poiché la log-verosimiglianza dipende da 2 parametri è possibile distinguere quattro

diverse situazioni di stima:

• stima di µ ;

• stima di σ 2 con µ noto ;

• stima di σ 2 con µ incognito ;

• stima simultanea di µ e σ 2 .

Stima di µ

Per quanto concerne la stima di µ non è stata specificata l’eventuale conoscenza del

parametro

σ 2 in quanto non influente; infatti, se si considera la funzione score, che

si ottiene come più volte specificato derivando ed eguagliando a

0

la log-

verosimiglianza rispetto al parametro d’interesse si ha:

S(µ) = –

1

2σ 2

n

∑

i=1

2(xi – µ)(–1) =

n

1

(

x – nµ) = 0 ⇒ µ~ =

2 ∑ i

n

σ i=1

1

n

∑

xi = x .

i=1

pertanto lo stimatore di massima verosimiglianza di µ è la media campionaria

µ~ = X =

1

n

n

∑

Xi.

i=1

Come si è già avuto modo di verificare µ~ = X , si distribuisce normalmente con

media µ e varianza σ2/n. X , è uno stimatore sufficiente, perché basato sulla statistica

28

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

n

sufficiente

∑X

i =1

i

, corretto ed il più efficiente nella classe degli stimatori corretti in

assoluto di µ; infatti, se si considera il limite della disuguaglianza di .Cramér-Rao

⎛ ds(µ ) ⎞

1

⎟⎟ = –E( 2 (– n)) = n/σ2,

I(µ) = –E ⎜⎜

σ

⎝ dµ ⎠

si ha

1/I(µ) = σ2/n

che è uguale alla varianza di µ~ = X .

Inoltre X è consistente in senso forte per µ ; poiché la consistenza forte implica

quella debole, X è anche consistente in senso debole per µ.

Stima di σ2 con µ nota

La funzione score è data da

S(σ2) = –

n

2σ

2

+

n

1

2σ

4

∑

i=1

1

(xi – µ)2 = 0 ⇒ σ~ 2 =

n

n

∑

i=1

(xi – µ)2 = s*2* .

Questo significa che lo stimatore di massima verosimiglianza di µ è

σ~ 2 = S*2* =

1

n

n

∑

(Xi – µ)2,

i=1

detta varianza campionaria con µ nota.

Come già visto nel Cap. 3 la distribuzione campionaria di

nσ~ 2

σ2

=

nS *2*

σ2

⎛X −µ⎞

= ∑⎜ i

⎟

σ ⎠

i =1 ⎝

n

2

( )

è di tipo Chi-quadrato con n gradi di libertà χ n2 la cui media e varianza sono

rispettivamente pari ad n e a 2n, cioè

⎛ nS 2 ⎞

E ⎜ *2* ⎟ = n

⎜σ ⎟

⎠

⎝

⎛ nS 2 ⎞

Var ⎜ *2* ⎟ = 2n,

⎜σ ⎟

⎠

⎝

da cui deriva:

E (σ~ 2 ) =E( S *2* ) = σ2

Var( σ~ 2 ) =Var( S *2* ) = 2σ4/n.

29

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Pertanto σ~ 2 = S *2* è uno stimatore corretto di σ2 e che, quindi, il suo EQM

coincide con la varianza. Si tratta, inoltre, di uno stimatore sufficiente perché basato

n

sulla statistica sufficiente ∑ ( X i − µ ) ed il più efficiente nell’ambito degli stimatori

2

i =1

corretti come si verifica facilmente attraverso il computo del limite fissato dalla

disuguaglianza Cramér-Rao.

⎛ dS (σ 2 ) ⎞

1

n

⎟ = –E(

I(σ2) = –E ⎜⎜

–

2 ⎟

2σ 4 2σ 6

⎝ dσ ⎠

n

∑

(xi – µ)2) = –

i=1

n

2σ 4

+

n

σ4

=

n

2σ 4

da cui

1/I(σ2) = 2σ4/n

che è uguale alla varianza di σ~ 2 .

σ~ 2 = S*2* è consistente in senso forte per σ2, dato che

2σ

= 0.

Lim EQM (σ~n2 ) = Lim Var (σ~no ) = Lim

n →∞

n →∞

n →∞

n

4

Poiché la consistenza forte implica quella debole, σ~ 2 = S *2* è anche consistente in

senso debole per σ2.

Stima di σ2 con µ incognito

Nel caso in cui si voglia stimare la varianza, ma non è noto il valore assunto da µ ,non

si può procedere come indicato al punto precedente in quanto nella formula della stima

1

della varianza σ~ 2 = S *2* =

n

n

∑

(Xi – µ)2 è presente tale elemento che, in quanto tale,

i=1

cioè non noto e non di interesse ai fini della stima, assume la natura di parametro di

disturbo. Disturbo che può essere facilmente eliminato procedendo ad una sua stima

che pur non interessando direttamente è strumentale all’obiettivo che si vuol perseguire

che è quello della stima di σ 2 . Piuttosto che trattare questo problema, facilmente

risolvibile se si considera quanto detto ai due punti precedenti, si procede alla

risoluzione del problema della stima congiunta di entrambi i parametri µ e σ 2 .

Stima di µ e σ2 entrambi incogniti

Le funzioni score eguagliate a zero per i due parametri incogniti µ e σ 2 sono quelle

30

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

viste in precedenza:

s(µ) =

s(σ2) = –

n

1

( ∑ xi – nµ) = 0,

σ2

n

2σ

2

i=1

+

n

1

2σ

4

∑

(xi – µ)2 = 0.

i=1

risolvendo il sistema rispetto ai due parametri incogniti si ottengono le stime:

1

µ~ = x =

n

n

∑

1

σ~ 2 =

n

xi

i=1

n

∑

i=1

(xi – x )2 = s*2 .

Gli stimatori di massima verosimiglianza di µ è di σ2 sono quindi

µ~ = X =

1

n

n

∑

σ~ 2 = S*2 =

Xi

i=1

1

n

n

∑

(Xi – X )2,

i=1

cioè la media campionaria e la varianza campionaria.

n

Le statistiche

∑

i=1

n

Xi e

∑ X i2

(e qualsiasi altra trasformazione biunivoca di tale

i=1

coppia) sono congiuntamente sufficienti per µ e σ2 (per verificare tale risultato basta

n

svolgere il quadrato nel termine

∑

(xi – µ)2 e operare le relative somme). Di

i=1

conseguenza µ~ = X e σ~ 2 = S *2 sono stimatori congiuntamente sufficienti, essendo

funzione di statistiche congiuntamente sufficienti.

Per quanto detto nel Cap. 3, risulta che le v.c. X e S *2 sono fra loro indipendenti,

che X è una stima corretta di µ mentre S *2 è una stima distorta di σ 2 ; inoltre, la

v.c.

nS*2

σ2

n

=

∑

i=1

⎛ Xi − X

⎜⎜

⎝ σ

⎞

⎟⎟

⎠

2

ha distribuzione del tipo chi-quadro con n-1 gradi di libertà (χ n2−1 ) .

Per le proprietà della v.c. Chi-quadrato

⎛ nS*2 ⎞

E⎜ 2 ⎟ = n – 1

⎜σ ⎟

⎠

⎝

⎛ nS*2 ⎞

V ⎜ 2 ⎟ = 2(n – 1)

⎜σ ⎟

⎠

⎝

31

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

da cui

E( S *2 ) =

n −1 2

σ

n

Var( S *2 ) = 2σ4

n −1

n2

.

Essendo S *2 uno stimatore distorto di σ2, il teorema di Cramér-Rao non si applica

perché viene a cadere una delle ipotesi fondamentali dello stesso. Comunque, poiché

EQM( S *2 ) = σ4(2n – 1)/n2 tende a 0 per n → ∞, S *2 è uno stimatore consistente in

senso forte. Dato poi che la consistenza forte implica quella debole, S *2 è anche

consistente in senso debole per σ2. Inoltre, per quanto esposto nel capitolo precedente,

è invece stimatore corretto di σ 2 la varianza campionaria corretta

1 n

S =

∑ (Xi – X ).

n − 1 i=1

2

Ed avendo la v.c.

(n − 1)S 2 = nS*2

σ2

σ2

n

=

∑

i=1

⎛ Xi − X

⎜⎜

⎝ σ

⎞

⎟⎟

⎠

2

distribuzione di tipo chi-quadro con n-1 gradi di libertà, la cui media e varianza sono:

⎛ (n − 1)S 2 ⎞

⎟=n–1

E⎜

⎜ σ2 ⎟

⎠

⎝

⎛ (n − 1)S 2 ⎞

⎟ = 2(n – 1),

Var ⎜

⎜ σ2 ⎟

⎠

⎝

ne risulta

E(S2) = σ2

Var(S2) = 2σ4/(n – 1).

Lo stimatore (non di massima verosimiglianza) S2 , è, quindi, uno stimatore

corretto e sufficiente di σ2 ma non il più efficiente nella classe degli stimatori corretti.

Infatti, il limite di Cramér-Rao sopra individuato 1/I(σ2) = 2σ4/n è inferioe alla varianza

dello stimatore xche è pari a 2σ4/(n-1). Quindi S2 non è in assoluto lo stimatore

migliore di σ2 nella classe degli stimatori corretti, anche se la differenza rispetto al

limite di Cramér-Rao è esigua e diminuisce rapidamente al crescere di n. Infine, risulta

facile verificare che S2 è uno stimatore consistente in senso forte, e, quindi, anche in

senso debole, di σ2.

32

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

V.C. Gamma

La log-verosimiglianza della v.c. Beta con parametri α e β è data da

l(α, β) =

n

∑

log f(xi; α, β) =

i=1

n

∑

i=1

x

− i ⎤

⎡

1

α −1

log ⎢

xi e β ⎥

α

⎣⎢ Γ(α ) ⋅ β

⎦⎥

che dopo alcune semplificazioni diviene

n

l (α , β ) = − nα log β − n log Γ(α ) − (α − 1)∑ log xi −

i =1

l(α, β) = -nα log β – n log Γ(α) – (α – 1)

n

∑

i=1

1

β

n

∑x

i =1

i

n

log xi – β ∑ xi.

i=1

Per ricavare le stime di massima verosimiglianza di α e β occorre derivare

rispetto ad entrambe le variabili, ottenendo le due componenti del vettore score, ed

uguagliarle a 0:

Γ' (α )

–

s(α) = -n log β – n

Γ(α )

s( β ) = –

nα

β

n

∑

log xi = 0,

i=1

n

– ∑ xi = 0.

i=1

Dalla seconda delle due espressioni è semplice ricavare β in funzione di α.

Tuttavia sostituendo tale risultato nella prima equazione, la funzione gamma ivi

coinvolta non consente la derivazione analitica della stima di α., il che significa che non

~

si possono derivare analiticamente le stime di massima verosimiglianza α~ e β anche

se, osservando la formula della log-verosimiglianza si conclude che le statistiche

n

∑

i=1

n

log xi e ∑ xi (e qualsiasi altra trasformazione biunivoca di tale coppia) sono

i=1

congiuntamente sufficienti per α e β. Di conseguenza anche se non si riesce a dare

~

l’espressione analitica di α~ e β tali stimatori esistono e sono stimatori congiuntamente

sufficienti.

Questa situazione, apparentemente strana e complicata, in realtà è (quasi) la

regola. Infatti solo pochi modelli statistici, fra i quali quelli visti in precedenza,

consentono di esplicitare la formula degli stimatori, di ricavarne l’esatta distribuzione

33

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

campionaria, di indicare l’esatto valore degli indici caratteristici quali valore atteso,

varianza e EQM.

Quando non è possibile derivare l’espressione analitica degli stimatori di massima

verosimiglianza si procede, usualmente, alla massimizzazione della verosimiglianza

tramite algoritmi iterativi, implementati su calcolatore, che trovano valore in

corrispondenza del massimo per approssimazioni successive iniziando da un punto di

partenza (starting point).

4.4.3 Proprietà degli stimatori di massima verosimiglianza

Da quanto visto ai punti precedenti, gli stimatori di massima verosimiglianza cui si è

pervenuti godono di buone proprietà, ci si deve ora domandare se in tutte le situazioni

(per tutti i modelli) è possibile pervenire agli stessi risultati, la risposta non è

affermativa: le proprietà degli stimatori di massima verosimiglianza, per campioni di

dimensione finita, vanno valutate caso per caso, anche se, nella generalità dei casi c, tali

stimatori godono di buone proprietà che vengono di seguito richiamate.

~

Invarianza: Si dimostra che se θ è lo stimatore di massima

~

verosimiglianza di θ allora g( θ ) è lo stimatore di massima

verosimiglianza di g(θ). In altri termini per stimare tramite massima

verosimiglianza una qualche trasformazione di un parametro già stimato

basta prendere la stima precedente e trasformare questa allo stesso modo.

Ad esempio: nel modello normale la stima di massima verosimiglianza di

σ è la radice quadrata di σ~ 2 ; oppure nel modello di Poisson la stima di

~

massima verosimiglianza di 1/λ è direttamente 1/ λ .

Sufficienza: Se esistono delle statistiche sufficienti allora gli stimatori di

massima verosimiglianza sono funzione di questi e pertanto sono

stimatori sufficienti. Questa proprietà è una conseguenza del criterio di

fattorizzazione; infatti se esistono stimatori sufficienti allora la logverosimiglianza è la somma di due componenti: una dipende solo dal

parametro e dalle statistiche sufficienti, l’altra solo dal campione

Efficienza “per campioni finiti”: Si dimostra che se esiste uno stimatore

corretto la cui varianza è pari al limite di Cramér-Rao, allora il metodo

34

B. Chiandotto

Statistica per le decisioni

Stima statistica

della

massima

Versione 2006

verosimiglianza

individua

“automaticamente”

tale

stimatore.

Efficienza asintotica: Si dimostra che sotto condizioni molto generali di

~

regolarità, lo stimatore di massima verosimiglianza θ è asintoticamente

(cioè per n → ∞) efficiente, cioè:

~

- è asintoticamente corretto lim E( θ n ) = θ;

n→∞

- la sua varianza tende al limite di Cramér-Rao che a sua volta tende a 0

~

lim V( θ n ) = 1/Ι(θ);

n→∞

- poiché di norma 1/Ι(θ) tende a 0 per n → ∞ ne deriva come conseguenza

la consistenza in senso forte e quindi anche in senso debole.

~

θ

Normalità asintotica: Si dimostra che, per n → ∞, n ha distribuzione

Normale con media il vero valore di

e varianza pari al limite inferiore di

Cramér-Rao. In simboli

~

θ n ≈ N[θ, 1/I(θ)].

Per caratterizzare le ultime due proprietà asintotiche è stato introdotto l’acronimo

BAN(E) (Best Asymptotically Normal Estimator).

4.4.4 Altri metodi di stima

Oltre al metodo di stima della minimizzazione dell’EQM e della massima

verosimiglianza, molti altri metodi di stima sono stati proposti in letteratura: il metodo

dei momenti, il metodo della minima distanza, il metodo del minimo χ2 ecc. In

seguito si parlerà diffusamente del solo metodo dei minimi quadrati (minimizzazione

dell’EQM nella classe ristretta degli stimatori lineari e corretti), nei punti seguenti si

procederà, invece, ad una sintetica illustrazione di altri metodi tra quelli di più frequente

impiego.

Metodo dei momenti

Se con µ r = E[ X r ] si indica il momento r-esimo di una v.c. X, la cui funzione di

densità o di massa di probabilità e f ( x;θ ) e θ = (θ1 ,θ 2 ,....,θ k ) , nella generalità dei casi

35

B. Chiandotto

Statistica per le decisioni

Stima statistica

µ r = E[ X r ]

Versione 2006

è funzione nota dei k parametri θ ( µ r = µ r (θ1 ,..., θ k ) ). Dato che il

1

corrispondente momento campionario risulta essere M r = ∑ X r , si impongono le k

n

relazioni di uguaglianza (momenti empirici = momenti teorici)

M j = µ r (θ1 ,...,θ k )

con j = 1,…, k

ne risulta, quindi, un sistema di k equazioni in k incognite che risolto (quando

θˆ1 ,...,θˆk dei

possibile) fornisce la stima dei momenti

k parametri incogniti

θ = (θ1 ,θ 2 ,....,θ k ) .

Esempio 3

Sia X 1 ,..., X n un campione casuale da una distribuzione con media µ e varianza σ2.

Siano (θ1 ,θ 2 ) = (µ , σ 2 ). Stimando i parametri con il metodo dei momenti le equazioni cui

si perviene sono:

( )

= µ (µ , σ ) = σ

M 1 = µ1 µ , σ 2 = µ

M2

2

2

2

+ µ2

e la soluzione è:

µˆ = X

σˆ 2 =

(

1 n

∑ xi − x

n i =1

)

2

Esempio 4

Sia X 1 ,..., X n un campione casuale da una distribuzione di Poisson con parametro λ.

Poiché un solo parametro caratterizza la distribuzione, allora il metodo dei momenti

suggerisce banalmente la seguente soluzione:

λ̂ = X

Il metodo dei momenti, seppur intuitivo, non è in generale un buon metodo per la

derivazione degli stimatori; infatti, se da questo metodo si ottenessero stimatori con

buone proprietà, allo stesso risultato si può pervenire attraverso l’impiego di un altro

metodo di stima.

36

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Metodo del minimo chi-quadro

Sia X 1 ,..., X n un campione casuale estratto da una densità f X ( x;θ ) , e sia S1 ,..., S k

una partizione del campo di variazione di X. La probabilità p j (θ ) che un’osservazione

appartenga all’intervallo S j della partizione è data da p j (θ ) = ∫ f X ( x; θ )dx . Si indichino

S

j

k

con Nj il numero di Xi che cadono nell’intervallo S j (ovviamente con n = ∑ N j ), e si

j =1

costruisca la sommatoria

k

χ2 = ∑

[n j − n ⋅ p j (θ )]2

j =1

n ⋅ p j (θ )

dove nj è il valore osservato di Nj. Il numeratore dei termini della sommatoria altro non

è che il quadrato dello scarto tra il numero osservato e quello atteso di determinazioni

che cadono nell’intervallo Sj. La stima del minimo quadrato di θ è il valore θˆ che

minimizza χ 2 . È, cioè, quel valore di Θ che, mediamente, rende il numero atteso di

osservazioni nell’intervallo S j “più vicino possibile ” al numero realmente osservato.

Si osservi che questo metodo introduce spesso un fattore di arbitrarietà dovuto

alla finezza della partizione S1 ,..., S k adottata.

Esempio 5

Sia X 1 ,..., X n un campione casuale da una distribuzione di Bernoulli di parametro p.

Poiché il campo di variazione di X consiste unicamente nei due valori 0 e 1

allora,

1

χ2 =∑

j =0

=

[ n j − n ⋅ p j ( p )] 2

n ⋅ p j ( p)

=

[ n 0 − n(1 − p )] 2 [n1 − np ] 2

+

n(1 − p )

np

[n − n1 − n(1 − p )] 2 [ n1 − n p ] 2 [n1 − n p ] 2

1

+

=

⋅

n(1 − p )

np

n

p (1 − p )

Dato che χ 2 ≥ 0 , in questo caso si può individuare il minimo in modo diretto osservando

che χ 2 = 0 se pˆ = n1 n . Si osservi che in questo esempio la partizione S1 ,..., S k poteva

essere scelta in un unico modo, e che lo stimatore trovato è lo stesso di quello che si

sarebbe ottenuto col metodo dei momenti o con quello della massima verosimiglianza.

37

B. Chiandotto

Statistica per le decisioni

Stima statistica

Versione 2006

Poiché può risultare difficile individuare il punto di minimo di χ 2 , si preferisce

talvolta sostituire il denominatore n ⋅ p j ( p ) direttamente con il valore, ottenendo il

cosiddetto chi-quadro modificato. La stima del minimo chi-quadro modificato è allora

quel θˆ che minimizza il χ 2 modificato.

Metodo della minima distanza

Sia X 1 ,..., X n un campione casuale estratto dalla distribuzione FX ( x;θ ) , e sia

d(F,G) una funzione che misura la distanza che intercorre tra due funzioni di

ripartizione F e G (ad esempio, d ( F , G ) = sup F ( x) − G ( x) misura la massima distanza

x

verticale tra F e G).

La stima di minima distanza di θ è quel valore tra tutti i possibili in Θ che

minimizza d ( F ( x), Fn ( x)) dove Fn (x) è la funzione di ripartizione campionaria o

empirica. Lo stimatore di minima distanza è intuitivamente attraente ma è spesso di

difficile derivazione essendo problematico minimizzare d ( F ( x), Fn ( x)) .

Esempio 6

Sia X 1 ,..., X n un campione casuale da una distribuzione di Bernoulli di parametro p.

Allora,

F ( x; p) = (1 − p) I [ 0,1) ( x) + I [1,∞ ) ( x)