CAPITOLO 3

SPAZI VETTORIALI EUCLIDEI

1. Struttura euclidea su uno spazio vettoriale reale

Sia V uno spazio vettoriale sul campo K. Si dice prodotto scalare di V ogni

applicazione s : V V K che sia:

a) bilineare, ossia:

1, 2 , 1, 2

K, v1,v 2 ,w1,w2

(

V:

)

s 1v1 + 2 v 2 , 1w1 + 2 w2 = 1 1 s ( v1 ,w1 ) +

+ 1 2 s( v1,w2 ) + 2 1 s( v 2 ,w1 ) + 2 2 s( v 2 ,w2 )

b) simmetrica, ossia:

v,w

V:

s( v,w) = s( w,v).

Un esempio di prodotto scalare è quello ordinario tra vettori numerici.

Supponiamo ora che K sia il campo reale R.

Un prodotto scalare s di V (R ) si dirà definito positivo se, oltre alle condizioni

a) e b), vale che:

c)

v V:

s( v,v) 0 e s( v,v) = 0 v = 0.

Ad esempio l'ordinario prodotto scalare tra vettori numerici reali è definito positivo.

D'ora in avanti parleremo di prodotto scalare per uno spazio vettoriale reale supponendo sempre che esso sia definito positivo, ossia che valga la condizione c),

senza ripeterlo ogni volta. Un tale prodotto scalare è anche detto prodotto scalare

euclideo, e uno spazio vettoriale reale munito di un prodotto scalare euclideo viene

60

Cap. 3

Spazi vettoriali euclidei

detto spazio vettoriale euclideo.

Lo studente si renda chiaramente conto del fatto che un prodotto scalare euclideo s definito in V determina, per restrizione, un prodotto scalare euclideo su ogni

sottospazio vettoriale V ' di V. V ', munito di tale prodotto scalare restrizione, si dirà

un sottospazio euclideo dello spazio euclideo V.

L'introduzione in V (R ) di un prodotto scalare consente di definire in esso due

nozioni fondamentali della geometria euclidea: la nozione di lunghezza di un vettore

e quella di angolo di due vettori.

La norma o lunghezza di un vettore v è definita come la radice non negativa del

prodotto scalare di v per se stesso:

v =

s(v, v)

Per la c), v è un numero reale, e si ha:

v = 0 v= 0

Dalla a) segue inoltre che:

R,

v = . v

v V :

Sia s un prodotto scalare di V (R ) . Vale la rela-

Proposizione 3.1

zione:

s ( v,w) v . w

v,w V :

detta diseguaglianza di Schwarz.

Dim.

Se uno dei due vettori, ad esempio v, è nullo, per la a) si ottiene:

s(0,w) = s( w w,w) = s( w,w) s (w,w) = 0

v = 0 =0

In questo caso quindi la diseguaglianza in oggetto vale con il segno di uguaglianza, essendo nulli entrambi i membri.

Supponiamo v e w non nulli. Per R consideriamo il vettore v + w . Si

ha:

v+ w

2

= s ( v + w, v + w) = 2 s ( v,v) + 2 s ( v,w) +

2

+ s (w,w) = v 2 + 2 s (v,w) + w

2

0

R

Pertanto il discriminante:

(s(v, w))

2

v

2

.

w

2

deve essere non positivo. Da ciò segue subito la diseguaglianza voluta:

(s(v, w))

2

v

2

.

w

2

Sez. 1

Struttura euclidea su uno spazio vettoriale reale

61

Supponiamo ora che v e w siano vettori non nulli. Dalla diseguaglianza di

Schwarz si ricava che:

s( v, w)

1 1

v

w

Esiste allora un unico numero reale cos =

[0, ] tale che

s(v, w)

v

w

è, per definizione, l'angolo dei vettori non nulli v e w. Lo indicheremo con il

simbolo v w .

Diremo poi che due vettori (sempre non nulli) sono ortogonali, e scriveremo

v w, se = 2 , ossia cos = 0. Si ha pertanto:

v 0, w 0, v w cos = 0 s( v, w) = 0

Osserviamo ora che il prodotto scalare s(v, w) è nullo anche se v = 0 oppure

w = 0. Ciò invita a porre, per definizione, che:

“il vettore nullo è ortogonale ad ogni altro vettore”.

Tale posizione consente di definire l'angolo v w per una coppia di vettori arbitrari di V e si avrà:

v,w V: v w s( v,w) = 0

Esercizio

Provare che la diseguaglianza di Schwarz vale con il segno di uguaglianza se, e

solo se, i vettori dati sono linearmente dipendenti.

Due vettori non nulli di uno spazio vettoriale euclideo si dicono concordi se

sono dipendenti l'uno dall'altro secondo uno scalare positivo.

Due vettori non nulli di uno spazio vettoriale euclideo si dicono discordi se

sono dipendenti l'uno dall'altro secondo uno scalare negativo.

Dalla definizione di angolo di vettori e dall'esercizio precedente si ricava la

seguente proposizione che lo studente proverà per esercizio:

Proposizione 3.2

Due vettori di uno spazio vettoriale euclideo sono

concordi se, e solo se, il loro angolo è zero, sono discordi se, e solo se, il loro angolo è .

62

Cap. 3

Spazi vettoriali euclidei

Tale proposizione giustifica il fatto che in uno spazio vettoriale euclideo due

vettori dipendenti vengono, a volte, detti paralleli, e si usa parlare di vettori paralleli

e concordi, o di vettori paralleli e discordi.

Proviamo ora insieme la seguente:

Proposizione 3.3

zione:

Sia V uno spazio vettoriale euclideo. Vale la rela v,w V :

v+ w v + w

detta diseguaglianza di Minkowski.

Dim.

Sia s il prodotto scalare euclideo assegnato in V. Si ha:

v+w

2

= s(v + w, v + w) = s( v, v) + 2s(v, w ) +

+ s( w, w) =

v

2

+ 2s (v, w) + w

2

D'altra parte si ha:

(

v + w

)2 =

2

v

+2 v

w + w

2

Dal confronto, tenendo presente la diseguaglianza di Schwarz, si ricava:

v+w

2

(

v + w

)2

e da questa risulta la diseguaglianza dell'enunciato, essendo entrambi i membri di

essa non negativi.

Osservazione

Facilmente, per induzione, si ricava che il risultato

della proposizione 3.3 si estende ad un qualunque numero finito di vettori, ossia:

v1 + v2 + ...+ v n v1 + v2 +...+ v n

Verificare per esercizio.

Esercizio

Dimostrare che la diseguaglianza di Minkowski vale con il segno di uguaglianza

se, e solo se, uno dei due vettori è nullo, oppure se essi sono paralleli e concordi.

Proposizione 3.4

In uno spazio vettoriale euclideo V un sistema (finito

o no) di vettori non nulli, a due a due ortogonali è linearmente indipendente.

Sez. 2

Prodotti scalari in spazi vettoriali reali di dimensione finita

63

Dim. Detto s il prodotto scalare assegnato in V, sia S = {vi }i un sistema

di vettori di V soddisfacente le ipotesi dell'enunciato.

Per provare l'asserto occorre dimostrare che ogni sottosistema finito S' di S è

linearmente indipendente. Sia S' = {v1 ,v2 ,...,vh } un tale sistema, e supponiamo

1v1 + 2 v2 + ...+ h v h = 0

Moltiplichiamo scalarmente entrambi i membri della precedente uguaglianza per

il vettore v1 e teniamo conto che s v j , v1 = 0 per j 1. Si avrà

(

)

h

h

0 = s(0, v1 ) = s j v j ,v1 = j s v j ,v1 = 1 s( v1 ,v1 )

1 j

1 j

(

)

Poiché v1 non è il vettore nullo, s(v1 ,v1 ) è non nullo, e pertanto si ha

0 = 1 s( v1 , v1 ) 1 = 0

Ripetendo il discorso di sopra successivamente per i vettori v 2 , v 3 ,..., v h , si

otterrà: 2 = 3 = ...= h = 0, e quindi in definitiva:

h

j j v j = 0 1 = 2 = ...= h = 0

1

Ciò equivale a dire, per definizione, che il sistema S' è linearmente indipendente.

Dall'arbitrarietà di S' segue che S è linearmente indipendente.

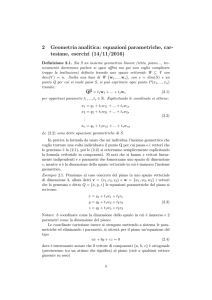

2. Prodotti scalari in spazi vettoriali reali di dimensione finita

Sia Vn uno spazio vettoriale sul campo reale di dimensione finita n. Sia s un

prodotto scalare di Vn ed = (e1 ,e 2 ,..., e n ) un riferimento.

Posto per ogni coppia di indici (i, j ) {1,2,...,n} {1,2,...,n}:

(

)

s e i , e j = si j ,

si può considerare la matrice:

( )

S (s, ) = si j ,

che si dirà matrice associata ad s in .

64

Cap. 3

Spazi vettoriali euclidei

Per la simmetria di s , la matrice reale S risulta simmetrica. Per la proprietà c) di

s , gli elementi della diagonale principale di S sono positivi (nulli no, perché nessuno degli e i può essere il vettore nullo). Inoltre se v è un vettore di componenti

(1 , 2 ,..., n ) in e w

(

)

è un vettore di componenti 1 , 2 ,..., n , dalla bilinea-

rità di s si ricava che:

n

s(v, w) = si j i j

ij

v

2

1

n

= si j i j

ij

1

(* )

(* *)

Per la proprietà c) il valore assunto da (* *) è sempre non negativo ed è nullo se,

e solo se, ogni variabile i è nulla.

n

L'espressione si j i j si dice forma quadratica associata al prodotto scaij

1

lare s , e la proprietà prima rilevata si esprime dicendo che la forma quadratica reale

associata ad un prodotto scalare (per cui valga c)) è definita positiva. Si usa anche

dire che la matrice simmetrica S è definita positiva.

Supponiamo ora, viceversa, che nello spazio vettoriale Vn (R ) sia fissato un riferimento e sia assegnata una matrice reale simmetrica S definita positiva. Con

ragionamenti di routine si vede che vale il

Teorema 3.5

Esiste uno, ed un solo, prodotto scalare s definito nello

spazio vettoriale Vn (R ) che abbia la matrice reale simmetrica definita positiva S

come matrice associata in un fissato riferimento .

Dim.

Suggerimento: se v è un vettore di componenti ( 1 , 2 ,..., n ) in , e

(

)

w è un vettore di componenti 1 , 2 ,..., n , porre:

n

s(v, w) = si j i j

ij

1

Completare la dimostrazione per esercizio, provando che per s valgono a), b), c),

che la matrice associata ad s in è la matrice S assegnata, e che s è l'unico prodotto scalare che soddisfi tale condizione.

Il teorema 3.5 riconduce il problema dell'esistenza di una struttura euclidea su

uno spazio vettoriale reale di dimensione finita a quello dell'esistenza di una matrice

reale simmetrica e definita positiva. Una matrice siffatta esiste: basta considerare, ad

esempio, la matrice identica. Pertanto si può affermare che

Sez. 3

Spazi vettoriali euclidei di dimensione finita

65

Teorema 3.6

Ogni spazio vettoriale sul campo reale di dimensione

finita si può dotare di una struttura euclidea.

Esercizio

Dimostrare che la matrice S associata ad un prodotto scalare euclideo di Vn in

un fissato riferimento soddisfa alla condizione di avere tutti i minori del tipo

S1,2,..., h ;1,2,..., h positivi.

3. Spazi vettoriali euclidei di dimensione finita

Sia Vn uno spazio vettoriale euclideo di dimensione finita n. Indichiamo con s

il prodotto scalare di cui è munito Vn .

Un vettore di Vn di norma 1 sarà detto versore.

Un sistema di vettori di Vn sarà detto ortonormale se è costituito da versori, a

due a due ortogonali.

In particolare potremo considerare basi ortonormali, ovvero riferimenti ortonormali.

Se un riferimento = (e1 ,e 2 ,..., e n ) di Vn è ortonormale avremo allora:

(

s ei , e j

)

e

= i

0

2

=1

i= j

i j

Banalmente quindi la matrice associata ad s in un riferimento ortonormale è

la matrice identica I n = i j , e l'espressione (* ) del paragrafo precedente diventa

pertanto:

( )

n

n

1

1

s(v, w) = i j i j = i i

ij

i

Esplicitamente vale la seguente

Proposizione 3.7

Il prodotto scalare di due vettori v e w di uno spazio

vettoriale euclideo di dimensione finita coincide con il prodotto scalare ordinario

dei due vettori numerici delle componenti di v e w in un riferimento ortonormale.

66

Cap. 3

Spazi vettoriali euclidei

Anche l'espressione della norma di un vettore in un riferimento ortonormale è

particolarmente semplice:

2

v

n

= 2i = 12 + 22 +...+ 2n

i

1

Da quanto sopra risulta evidente l'importanza, o meglio la comodità, di avere a

disposizione un riferimento ortonormale.

Ci proponiamo pertanto di provare l'esistenza di basi ortonormali.

Teorema 3.8

Sia v un vettore non nullo di uno spazio vettoriale euclideo V n . L'insieme dei vettori di V n ortogonali a v è un sottospazio di V n di

dimensione n 1.

Dim. Bisogna provare che l'insieme in questione, diciamolo H, è stabile

rispetto alle due operazioni di Vn .

v H, v,w H:

R

:

s ( v, v) = s ( v,v) = . 0 = 0 v H

s( v + w, v) = s( v, v) + s( w, v) = 0 + 0 = 0 v + w H

Dunque H è un sottospazio Vh' di Vn . Rimane da provare che è h = n 1.

Osserviamo intanto che ogni vettore di Vh' è ortogonale ad ogni vettore dello

spazio V1' generato da v . Infatti:

v Vh' s (v, v) = 0 R

s ( v, v) = 0

e v è il generico vettore di V1' . Inoltre si ha:

w Vh' V1' s( w,w) = 0 w = 0

Pertanto lo spazio intersezione di V1' e Vh' è quello costituito dal solo vettore

nullo. Proviamo che lo spazio congiungente è tutto Vn . Basta far vedere che ogni

vettore di Vn è somma di un vettore multiplo di v con un vettore ortogonale a v .

Per ogni vettore v Vn , potremo scrivere

v = v + w

con w = v v . Si avrà:

s( v,w) = s(v, v v ) = s( v,v ) v

Se allora scegliamo =

s( v,v )

v

2

Dunque è < V1' Vh' > = Vn .

2

, si avrà s( v,w) = 0, e quindi w Vh' .

Sez. 3

Spazi vettoriali euclidei di dimensione finita

67

Dalla relazione di Grassmann si ha allora:

1 + h = n + 0 h = n 1

Sulla falsariga della precedente dimostrazione, si provi per esercizio il

Teorema 3.9

{

}

Sia T = v1' ,v2' ,..., v 'p un sistema di vettori indipendenti

di uno spazio vettoriale euclideo V n . L'insieme dei vettori di V n ortogonali ad ogni

vettore di T, e quindi ad ogni vettore del sottospazio V p' da essi generato, è un

sottospazio di V n di dimensione n p.

Possiamo ora finalmente, e facilmente, dimostrare il seguente:

Teorema 3.10

Sia V n uno spazio vettoriale euclideo di dimensione finita.

Esistono in V n infinite basi ortonormali.

Dim.

L'asserto vale per n = 1. In questo caso occorre prendere semplicemenv

te un vettore di norma unitaria. Ora, per ogni v V1 , il vettore

ha norma uno.

v

Procediamo allora per induzione sulla dimensione. Supponiamo che l'asserto

' il sottovalga per n 1, e sia v un vettore non nullo di Vn (n 2 ). Sia poi Vn1

spazio dei vettori di Vn ortogonali al sottospazio V1' generato da v (cfr. teor. 3.8).

' sia {e1 , e2 ,..., e n1} una base ortonormale rispetto alla restrizione del proIn Vn1

v

' . Posto allora e n =

, il sistema:

dotto scalare s di Vn a V n1

v

B = {e1, e 2 ,..., e n }

è una base ortonormale di Vn .

L'esistenza di basi ortonormali in uno spazio vettoriale euclideo di dimensione

finita può anche essere provata, con una costruzione diretta, mediante il cosiddetto

procedimento di Gram - Schmidt.

La costruzione procede per passi, a partire da un qualunque riferimento

= (e1 , e 2 ,..., e n ). Ad ogni passo h viene costruito un versore uh ortogonale a

tutti quelli costruiti nei passi precedenti.

68

Cap. 3

Spazi vettoriali euclidei

Passo 1: costruzione di u1

e

Si ponga u1 = 1 . Si ottiene un versore.

e1

Passo 2: costruzione di u2

Si consideri il vettore u1 + e2 . Per ogni valore reale di tale vettore è non

nullo, perché e1 ed e 2 (e quindi u1 ed e 2 ) sono indipendenti, in quanto vettori di

una base. Si cerchi il valore di per cui il vettore suddetto è ortogonale ad u1 :

s( u1 + e 2 , u1 ) = 0 .1 + s(e 2 , u1 ) = 0 = s(e 2 , u1 )

Si ponga poi u2 =

s(e 2 , u1 ) u1 + e 2

s(e 2 , u1 ) u1 + e 2

. Si ottiene un versore ortogonale ad

u1 .

Passo 3: costruzione di u3

Si consideri il vettore u1 + µ u2 + e 3 . Per ogni coppia di valori reali di e µ

tale vettore è non nullo. Ciò si vede con un ragionamento analogo a quello fatto nel

passo 2. Si cerchino i valori di e µ per cui il vettore suddetto è ortogonale ad u1

e ad u2 . Si controlli che vanno bene i valori = s(e 3 , u1 ) , µ = s(e 3 , u2 ) . Si

ponga poi u3 =

(

)

s( e 3 , u1 ) u1 s(e 3 , u2 ) u2 + e 3

s e 3 , u1 u1 s(e 3 , u2 ) u2 + e 3

. Si ottiene un versore ortogo-

nale sia ad u1 che ad u2 .

Il procedimento si arresta dopo n passi, e rimane determinato un sistema di

vettori S = {u1 ,u2 ,...,un } ortonormale.

Tale sistema è indipendente per la proposizione 3.4.

Poiché l'ordine di S è n, uguale alla dimensione di V, S è una base.

Siano ora ed due riferimenti di Vn , S ed S le matrici associate ad s in

e in rispettivamente, B la matrice di passaggio da ad . Con facili calcoli

di matrici, si vede che vale la relazione:

S = B1 SB

Lo studente farà questi calcoli.

Se allora e sono entrambi ortonormali, le matrici S ed S coincidono

entrambe con la matrice identica, per cui si ha:

I n = B1 I n B = B1B

Sez. 4

Ortogonalità fra sottospazi di uno spazio vettoriale euclideo

69

Tale relazione comporta che la trasposta B1 di B coincide con l'inversa B 1, e

quindi si ha la seguente

Proposizione 3.11

La matrice di passaggio da un riferimento ortonormale ad un altro riferimento ortonormale è una matrice ortogonale.

4. Ortogonalità fra sottospazi di uno spazio vettoriale euclideo

Sia Vn uno spazio vettoriale euclideo di dimensione finita n. Indichiamo, al

solito, con s il prodotto scalare di cui è munito Vn .

Sia W un sottospazio non nullo di Vn . Dicesi complemento ortogonale di W

l'insieme dei vettori di Vn ortogonali ad ogni vettore di W. Per il teorema 3.9 tale

insieme è un sottospazio vettoriale di Vn , che sarà indicato con il simbolo W . Se

W ha dimensione r , sempre per il teor. 3.9, W ha dimensione n r .

Valgono le proprietà di facile verifica:

1.

(W )

2.

U W U W 3.

U W W U 4.

U W W U = W

DEFINIZIONE

Due sottospazi non nulli U e W di V n si dicono totalmente ortogonali, e si scrive U W, se ogni vettore di uno dei due è ortogonale a

tutti i vettori dell'altro. In formule:

U W (u ,w) U W : s(u,w) = 0

Dalla definizione di complemento ortogonale segue subito la definizione alternativa

DEFINIZIONE

Due sottospazi non nulli U e W di V n si dicono totalmente ortogonali, e si scrive U W, se ciascuno dei due è contenuto nel complemento ortogonale dell'altro. In formule, tenendo conto della proprietà 3. del

70

Cap. 3

Spazi vettoriali euclidei

complemento ortogonale:

U W U W

Osservazione

Supponiamo che U abbia dimensione r , e W di

mensione h. Allora W ha dimensione n h. Pertanto se è r > n h, è inutile

porsi il problema di vedere se U e W siano, o no, ortogonali. Non è possibile. La

somma delle dimensioni di due sottospazi totalmente ortogonali non può superare

la dimensione dello spazio ambiente.

DEFINIZIONE

Due sottospazi non nulli U e W di V n si dicono parzialmente ortogonali se esiste un sottospazio non nullo U ' di U totalmente ortogonale a W, ed esiste un sottospazio non nullo W ' di W totalmente ortogonale ad U,

ovvero se dim U W > 0 e dim W U > 0.

(

)

(

)

La definizione di ortogonalità totale è un caso particolare di quella parziale

e W ' = W ).

Osserviamo ora esplicitamente, perché ci farà risparmiare tempo in seguito, che

se uno dei due sottospazi della definizione precedente, ad esempio U, ha dimensione

n 1, il suo complemento ortogonale U ha dimensione 1, e quindi la condizione

dim W U > 0 comporta necessariamente W U. Per la proprietà 4. del

(U ' = U

(

)

complemento ortogonale quest'ultima relazione equivale a U W , e quindi com

porta che dim U W > 0. Si ha pertanto la seguente

(

)

Proposizione 3.12

Condizione necessaria e sufficiente affinché un sottospazio U di V n di dimensione n 1 sia parzialmente ortogonale ad un sottospazio

W è che esso contenga il complemento ortogonale di W.

Correntemente si usa parlare di sottospazi ortogonali, omettendo i termini

totalmente e parzialmente. E' sottinteso che, qualora sia possibile (somma delle

dimensioni non superiore ad n), si tratta di ortogonalità totale. Altrimenti si tratta di

ortogonalità parziale. Ad esempio, se per n = 5 diciamo che un sottospazio U3 è

ortogonale ad un sottospazio W1 , è sottinteso che si tratta di ortogonalità totale. Se

invece diciamo che U3 è ortogonale ad un sottospazio W 4 , deve necessariamente

trattarsi di un caso di ortogonalità parziale (3 + 4 > 5) .