UNITA’ -> oggetti a cui si interessa la ricerca. L’insieme delle unità costituisce la POPOLAZIONE / collettivo /

universo

Mediante la DEFINIZIONE OPERATIVA

o

o

Si passa dalle UNITA’ ai CASI

Si passa dalle PROPRIETA’ alle VARIABILI (i casi devono presentare almeno due stati delle proprieta)

Attraverso delle operazioni canoniche

Classificazione

Creazione di un determinato numero di classi di equivalenza nel rispetto delle

condizioni di esaustività e esclusività.

Ordinamento

Come la classificazione dà origine a una partizione del dominio di una proprietà, le

categorie individuate godono oltre che della relazione di equivalenza, della

relazione d’ordine, non è però possibile quantificare la distanza tra le categorie

Misurazione

Presuppone l’esistenza di una unità di misura alla quale rapportare l’ammontare di

proprietà posseduta da ciascun caso

Conteggio

Enumerazione degli oggetti posseduti, è possibile quando la proprietà è pensabile

come quantità discreta

A seconda delle operazione compiute vengono generati diversi tipi di variabili

CLASSIFICAZIONE DEI LIVELLI DI SCALA DI STEVENS

Una variabile o una scala di misura è un sistema che mette in corrispondenza gli stati di oggetti su

determinate proprietà e i numeri reali =>

< SE,f,SN>

SE è un sistema relazionale empirico, SN un sistema relazionale numerico e f è la funzione che fa

corrispondere a ogni elemento di SE uno e uno solo degli elementi di SN.

Per ogni SE possono esistere più rappresentazioni numeriche

Trasformazione ammissibile : se α è un SE rappresentato dal SN β; una trasformazione dei valori di scala

f’(a)= T[f(a)] è detta ammissibile se anche f’(a) è una rappresentazione del SE α attraverso SN β

(SCALA NOMINALE)

variabili categoriali

Un SE composto da elementi su cui è possibile definire solo relazioni di uguaglianze e

diseguaglianza, viene rappresentato da un SN attraverso una funzione di corrispondenza che

assegna lo stesso numero agli stati uguali e un numero diverso agli stati differenti (i numeri hanno

solo funzione di etichette)

Trasformazione ammissibile => transcodifica o corrispondenza biunivoca y’ = t(y)

tale che se yi = yj => y’i = y’j e se yi ≠ yj => y’i ≠ y’j

SCALA ORDINALE

variabili ordinali

Quando sul SE è definita la relazione di maggiore o minore, oltre a quella di uguaglianza, la scala

che ne deriva dalla sua rappresentazione numerica è detta scala ordinale.

Le distanze tra i “pioli” della scala non sono però costanti o quantificabili esattamente

Sono ammesse tutte le trasformazioni che non alterano l’ordine tra le modalità

Trasformazione ammissibile => trasformazioni isotoniche (monotone strettamente crescenti)

y’=m(y)

tale che se yi < yj => y’i < y’j e se yi = yj => y’i = y’j

SCALA DI INTERVALLI

variabili cardinali

Un SE sul quale è possibile definire una relazione di uguaglianza degli intervalli tra gli stati di una

proprietà dà origine a una scala di intervalli, entriamo nel mondo della misurazione propriamente

detta. Il nostro sistema di rilevazione è dotato di un’unità di misura (convenzionale), garantita dalla

costanza degli intervalli. Lo 0 della scala è però convenzionale

Poiché l’aggiunta di una costante non altera la differenza tra i valori della scala è anche ammessa

anche la traslazione ( non varia il rapporto tra gli intervalli)

Trasformazioni ammissibili => trasformazioni lineari (affini) y’= my+a con m > 0

SCALA DI RAPPORTI

variabili caridnali

Quando nel SE è definita oltre alla relazione di uguaglianza degli intervalli anche l’uguaglianza dei

rapporti, la sua rappresentazione numerica è detta scala di rapporti.

Esiste uno 0 assoluto, che sta a indicare l’assenza di proprietà

Trasformazioni ammissibili => trasformazioni di similarità

y’= my

con m > 0

I quattro tipi di scala individuati da Stevens stanno a una precisa gerarchia: la scala nominale rappresenta il

livello più basso, sono poche le relazioni matematiche definite nel SN; la scala di rapporti è invece il livello

più alto poiché a questo livello la variabile gode di tutte le proprietà dei numeri reali.

Rispetto alle trasformazioni ammissibili, più il livello di scala è basso più le funzioni sono generali, sono

minori cioè i vincoli per passare da una rappresentazione numerica a un’altra. Salendo la gerarchia delle

scala la natura delle funzioni si fa più restrittiva

Altri esempi di scale

Scale assolute

variabili cardinali

Non si hanno unità di misura, ma di conto (ad esempio libri, figli, reati,….)

Variabili di tipo Likert

Variabile che presenta solitamente cinque o sette modalità ordinate che esprimono gradi di

accordo con una certa affermazione

Scale auto ancoranti

La variabile presenta etichette verbali soltanto alle due modalità estreme

La scale di intervalli, di rapporti e assolute sono accomunate dalla presenza di un’unità di misura o di conto

e di conseguenza dal fatto che i valori numerici che esse assumono godono di tutte le proprietà dei numeri

cardinali. È consuetudini riferirsi a questa famiglia di variabili col nome di VARIABILI CARDINALI

Concetto di STATISTICA IDONEA

Una statistica è idonea per un determinato livello di scala se e soltanto se il suo risultato è invariante per il

tipo di trasformazione ammissibile per quel livello di scala. L’invarianza può essere di tre tipi:

1. Invarianza assoluta

Se f[t(y)] = f(y)

Il risultato della statistica è il medesimo sia sui dati di partenza, sia su quelli sottoposti a una

trasformazione ammissibile

2. Equivarianza (o invarianza di riferimento)

Se f[t(y)] = t[f(y)]

La funzione che consente il passaggio dalla statistica sui dati di partenza al risultato della medesima

sui dati trasformati è la trasformazione ammissibile t

3. Ortovarianza (o invarianza di confronto)

Se f[t(y)] = g[f(y),t]

La statistica sui dati trasformati è esprimibile attraverso una funzione g (diversa da t) che dipende

esclusivamente da f(y) e dai parametri della trasformazione (t)

Esempio: deviazione standard applicata a una scala di intervalli

MATRICI DI DATI

Possiamo distinguere le matrici in base a:

Il numero di vie, cioè il numero di entrate della matrice

Il numero di modi, cioè il numero di famiglie di entità distinte a cui il dato rimanda

Il condizionamento, una matrice a due vie è

o Unconditional se consente confronti tra celle sia per riga che per colonna

o Row conditional se autorizza soltanto confronti entro le righe

o Column conditional se consente confronti soltanto entro le colonne

MATRICE CxV (caso x variabile)-> matrice in cui le colonne rappresentano le variabili, le righe

rappresentano i casi

STATISTICA DESCRITTIVA MONOVARIATA

Insieme degli strumenti statistici che permettono di rispondere a domande relative a una singola variabile

DISTRIBUZIONE SEMPLICE DI FREQUENZE: modo di organizzare i dati di una matrice CxV che affianca a ogni

modalità della variabile in esame la frequenza con cui essa si è manifestata nel collettivo

=> compressione dei valori, da un insieme di N valori passiamo a un insieme di K valori (tanti quanti sono il

numero delle modalità della variabile)

Variabile categoriale

Variabile ordinale

Variabile cardinale

->

->

->

serie sconnessa di frequenze

serie ordinata di frequenze

seriazione di frequenze

Serie sconnessa di frequenze

Dato un collettivo di N unità e una variabile X che può assumere due modalità x1 e x2, possiamo organizzare

le nostre osservazioni in un vettore di una matrice CxV. Se contiamo quanti soggetti presentano la

modalità x1 e quanti la x2 e disponiamo i dati ottenuti in una tabella otteniamo una tabella di frequenze

semplici.

Frequenze relative -> n

I valori n1 e n2 rappresentano le frequenze assolute con cui compaiono rispettivamente le modalità x1 e x2.

La somma delle frequenze assolute delle modalità è uguale alla numerosità del collettivo, ovvero

𝐾

∑ 𝑛𝑘 = 𝑁

= n1 + n2 + … + nk = N

𝑘=1

dove k rappresenta una generica modalità e K indica il numero delle modalità della variabile

Frequenze relative -> f

per confrontare due variabili è necessario eliminare l’effetto dell’ampiezza del collettivo => è sufficiente

dividere ciascuna frequenza assoluta per il numero complessivo dei casi.

𝑛𝑘

𝑓𝑘 =

𝑁

𝐾

∑ 𝑓𝑘 = 1

𝑘=1

In termini formali le frequenze relative sono date dal rapporto tra le frequenze assolute di ciascuna

modalità (n) e la numerosità del collettivo

Frequenze percentuali -> q

È sufficiente moltiplicare per 100 le frequenze relative. Se indichiamo con qk la frequenze percentuale di

una generica modalità abbiamo

𝐾

𝑞𝑘 = 𝑓𝑘 ∗ 100

∑ 𝑞𝑘 = 100

𝑘=1

Rappresentazione grafica =>

o

o

Diagramma a barre:

rettangoli aventi tutti la stessa base e un’altezza proporzionale alla frequenza con xui la

modalità si è presentata nel collettivo

Diagramma a torta (preferibile):

vengono riportati tanti settori quante sono le modalità e l’area di ciascun settore è

proporzionale alla frequenza della modalità corrispondente [α= 360° nj/N]

Serie ordinata di frequenze

Oltre a tutti i tipi visti in precedenza per questo tipo di variabili possiamo avere anche le

Frequenze cumulate -> n’, f’, q’

Se a fianco di ogni modalità riportiamo il numero di soggetti che rientrano nella modalità stessa otteniamo

delle frequenze cumulate. Queste possono essere calcolate per le frequenze assolute, relative e percentuali

𝑛𝑘′ = 𝑛1 + 𝑛2 + … + 𝑛𝑘

𝑓𝑘′ = 𝑓1 + 𝑓2 + … + 𝑓𝑘

𝑞𝑘′ = 𝑞1 + 𝑞2 + … + 𝑞𝑘

Le frequenze retro cumulate si ottengono invece partendo dalla modalità più alta (indicate con n’’, f’’, q’’)

Rappresentazione grafica =>

o

o

Istogramma :

i rettangoli sono accostati uno all’altro per sottolineare la contiguità tra le categorie

Spezzata a gradini (per le frequenze cumulate):

sull’asse delle ascisse vengono riportate le diverse modalità, sull’asse delle ordinate le

frequenze cumulate

Seriazione di frequenze

È necessario raggruppare preliminarmente i dati in classi, in modo tale da avere poche modalità, ognuna

rappresentata da un certo numero di soggetti. Ogni classe è individuata attraverso il valore minimo e

massimo in essa inclusi, ossia attraverso i suoi limiti.

Per calcolare l’ampiezza della classe* è sufficiente fare la differenza tre il limite superiore e il limite

superiore e aggiungervi un’unità. I limiti veri delle classi si ottengono togliendo 0.5 al limite inferiore della

classe e aggiungendo 0.5 al limite superiore

Rappresentazione grafica =>

o

Istogramma:

la base dei rettangoli è proporzionale all’ampiezza della classe e l’altezza rappresenta la

densità di frequenza (dk)

𝑛𝑘

𝑑𝑘 =

𝑎𝑘

Dove ak rappresenta l’ampiezza* della k-esima classe (calcolo tramite i limi veri)

o

o

Quello che viene rappresentato sull’asse delle ordinate è così il numero di osservazioni per

ogni sottoclasse di ampiezza unitaria, mentre la frequenza della classe è rappresentata

dall’area del rettangolo

Quando tutte le classi hanno uguale ampiezza sulle ordinate è indifferente riportare le

densità di frequenza o direttamente le frequenze.

Poligonale di frequenze

Si ottiene partendo da un istogramma, congiungendo con una spezzata i valori centrali

delle basi superiori di ciascuna classe (utile quando si devono confrontare le distribuzioni di

due o più collettivi riferite alla medesima variabile)

Quando il collettivo è molto ampio e le classi hanno un’ampiezza molto piccola la

poligonale tende a assume l’aspetto di una curva continua => curva di Gauss

Ogiva (per le frequenze cumulate)

Poligonale usata per frequenze cumulate di variabili cardinali

OPERATORI MONOVARIATI

Dispositivi che sintetizzano la distribuzione di una variabile in uno scalare (un numero). Si possono

distinguere tre principali classi di operatori monovaratiati:

o

o

o

Operatori di tendenza centrale

Restituiscono uno scalare che esprime sinteticamente come si è manifestata la proprietà in

esame nel collettivo considerato; deve rispettare il criterio di internalità (valore compreso

tra quelli che la variabile può assumere)

Operatori di dispersione

Restituiscono uno scalare che informi circa la diversità esistente tra le osservazioni,

valutano quanto il valore di tendenza centrale è rappresentativo

Indici di forma

Utilizzabile per le variabili cardinali, si dividono in operatori che valutano la simmetria della

distribuzione e operatori che valutano quanto una distribuzione simmetrica e unimodale è

simile a una curva normale

Operatori di tendenza centrale e altri operatori di posizione

MODA

Quando una variabile è categoriale l’operatore di tendenza centrale adeguato a rappresentare la

distribuzione è la moda, ovvero la modalità più ricorrente nella variabile.

In una distribuzione possono essere presenti più mode (d. bimodale).

La moda può essere calcolata anche per variabili ordinali e cardinali (se la seriazione di frequenze riguarda

dati raggruppati in classi non della stessa ampiezza, per determinare la moda è necessario considerare la

densità di frequenza delle diverse classi e non la frequenza assoluta)

MEDIANA

Per le variabili ordinali si dispone di un ulteriore misura di tendenza centrale, la mediana.

Quando l’ampiezza del collettivo (N) è un numero dispari, la mediana è la modalità a cui appartiene quel

caso (= caso mediano -> CMdn) che divide esattamente a metà la distribuzione

𝐶𝑀𝑑𝑛 =

(𝑁+1)

2

possiamo indicare la mediana come:

𝑀𝑑𝑛 = 𝑥(𝑁+1)⁄2

Per calcolare la mediana è necessario: ordinare le modalità in ordine crescente, calcolare le frequenza

assolute cumulate (f’), osservare in quale modalità cade il soggetto mediano.

Quando N è un numero pari abbiamo due casi mediani, rispettivamente in (N/2)-esimo e il (N/2 +1)-esimo

Quando si hanno variabili cardinali la mediana è data da:

𝑥𝑁/2 + 𝑥𝑁⁄2+1

2

se N è par e da

𝑥𝑁+1

2

se è dispari

MEDIA

Data una variabile cardinale X contenente valori x1, x2, …. , xN la media aritmetica è:

𝑁

1

𝑥̅ =

∑ 𝑥𝑖

𝑁

𝑖=1

La media si ottiene quindi sommando tutti i valori di X (da 1 a N) e dividendo tale somma per il numero dei

casi. La media aritmetica gode di importanti proprietà:

la somma algebrica degli scarti dei valori xi dalla loro media aritmetica è uguale a 0

la somma algebrica dei quadrati degli scarti dai valori xi dalla loro media è minima

∑𝑁

𝑖=1(𝑥𝑖 − 𝑥̅ ) = 0

𝑁

∑𝑖=1(𝑥𝑖 − 𝑥̅ )2 = 𝑚𝑖𝑛

talvolta al posto della media aritmetica semplice si ricorre alla media aritmetica ponderata:

∑𝑁

𝑖=1 𝑥1 𝑤1

𝑥̅𝑝 =

𝑤1 + 𝑤2 + ⋯ + 𝑤𝑛

Dove xi rappresenta il valore assoluto dall’i-esimo caso e wi rappresenta il peso ad esso attribuito e N il

numero dei casi .

Per calcolare la media su dati raggruppati in classi:

𝐾

1

𝑥̅ = ∑ 𝑥𝑘 𝑛𝑘

𝑁

𝑘=1

Dato che nk/N = fk possiamo anche scrivere:

𝐾

𝑥̅ = ∑ 𝑥𝑘 𝑓𝑘

𝑘=1

Dove xk rappresenta il valore centrale della generica classe k e nk e fk rispettivamente la sua frequenza

assoluta (n) e relativa (f), mentre K è il numero di classi

Per capacità informativa di un operatore intendiamo la sua capacità di sfruttare tutte le proprietà dei

numeri cardinali possedute da una variabile almeno a livello di scala di intervalli. Media moda e mediano

possono essere poste in una precisa gerarchia rispetto alla loro capacità informativa: la mediana è più

informativa della moda poiché considera anche l’ordine tra le osservazioni, mentre le più informativa è la

media che considera anche la distanza tra le osservazioni.

Va tenuto presente che però la media è sensibile alla eventuale presenza di valori anomali (outliers).

Se chiamiamo robustezza la proprietà di essere poco sensibile ai valori anomali, possiamo affermare che la

media è la meno robusta delle tre. La mediana è più robusta della media e la moda è più robusta della

mediana. Per questo quando in una variabile cardinale si sospetta la presenza di valori anomali è preferibile

ricorrere alla mediana.

QUANTILI

È possibile suddividere una distribuzione in più parti uguali, originando quelli che vengono definiti quantili o

operatori di posizione.

I quantili vengono detti quartili quando suddividono la distribuzione in quattro parti uguali. Il I quartile è la

modalità della variabile che lascia alla sua sinistra il 25% dei casi e alla sua destra il 75%. Il secondo quartile

coincide con la mediana, il terzo quartile lascia alla sua sinistra il 75% dei cari e alla sua destra il 25%.

Calcolo dei quartili:

Q1= (N + 1) / 4

Q2 = 2(N + 1) / 4 = (N + 1) / 2

Q3 = 3 (N + 1) / 4

Operatori di dispersione

Consentono una quantificazione del grado di rappresentatività di un particolare operatore di tendenza

centrale.

Per le variabili categoriali si parla mutabilità per indicare la dispersione di una distribuzione (omogenea o

eterogenea). Per variabili ordinali e cardinali si parla invece di variabilità (variabilità non metrica per le

ordinali e metrica per le categoriali).

Per ciascun tipo di variabile è possibile distinguere tra operatori che restituiscono valori assoluti e che

restituiscono valori relativi.

MUTABILITA’

Per variabili categoriali. Data una variabile di K modalità, la massima omogeneità si ha nel caso in cui una

solo modalità ha frequenza assoluta pari a N; la massima eterogeneità quando ciascuna modalità ha la

stessa frequenza, pari a N/K

Si utilizza la mutabilità di Gini:

𝐾

𝐸1 = 1 − ∑ 𝑓𝑘2

𝑘=1

Ovvero la differenza tra l’intero e la somma di tutte le frequenze relative delle varie modalità della variabile

elevate al quadrato. Questa misura assume valore minimo uguale a 0 quando tutti i casi sono addensati in

una sola modalità, mentre assume valore massimo paria (K-1)/K quando i soggetti sono equamente

distribuiti nelle K modalità.

La mutabilità di Gini è una misura assoluta, per relativizzare una misura di eterogeneità occorre sottrarre

alla misura assoluta (E) il valore minimo che essa può assumere e dividere il risultato per il suo intervallo di

variazione; la nuova misura (e) assumerà valori compresi tra 0 e 1.

La misura relativa e1 si ottiene partendo dalla mutabilità di Gini

𝑒1 =

𝐸1 − 0

𝐸1

𝐾

=

=

𝐸

𝐾−1

𝐾−1

𝐾−1 1

𝐾

𝑘−0

MUTABILITA’ METRICA

Quando le variabili sono cardinali è possibile individuare due famiglie di operatori: gli intervalli di variazione

e gli scarti da un valore centrale

GLI INTERVALLI DI VARAIZIONE

Sono operatori che quantificano la variabilità misurando la diversità tra due particolari termini della

distribuzione. Il più semplice intervallo di variazione è dato dalla differenza tra il valore massimo e il valore

minimo della distribuzione. Esso viene denominato campo di variazione (gamma o range)

𝑊 = 𝑥𝑚𝑎𝑥 − 𝑥𝑚𝑖𝑛

Un secondo intervallo di variazione è la differenza interquartile che si ottiene semplicemente individuando i

quartili della distribuzione e calcolando la differenza

𝑊 ′ = 𝑄3 − 𝑄1

SCARTI DA UN VALORE CENTRALE

Sono gli operatori di dispersione per variabili cardinali più ricorrenti:

scostamento semplice medio

𝑠𝑚𝑒 =

∑𝑁

𝑖=1|𝑥𝑖 − 𝑥̅ |

𝑁

Dato dalla media aritmetica e dagli scarti assoluti dalla media

Varianza

𝑆2 =

2

∑𝑁

𝑖=1(𝑥𝑖 − 𝑥̅ )

𝑁

È la sommatoria degli scarti dalla media elevati al quadrato fratto la numerosità della variabile

La varianza ha lo svantaggio di essere una grandezza quadratica e quindi non direttamente confrontabile on

la media, per questo viene più frequentemente usata la sua radice, la deviazione standard

𝑆2 =

Esiste una formula che ne abbrevia notevolmente i calcoli

2

∑𝑁

𝑖=1(𝑥𝑖 − 𝑥̅ )

𝑁

= ̅̅̅

𝑥 2 − 𝑥̅ 2 ossia la

differenza tra la media dei quadrati e il quadrato della media

2

𝐷𝑒𝑣 = ∑𝑁

𝑖=1(𝑥𝑖 − 𝑥̅ )

Il numeratore della varianza prende il nome di devianza

Deviazione standard

∑𝑁 (𝑥𝑖 − 𝑥̅ )2

𝑆 = √ 𝑖=1

𝑁

Questo valore è direttamente confrontabile con la media

Le misure fin ora descritte sono assolute, il loro valore dipende dall’unità di misura delle variabili. Per poter

confrontare la variabilità di distribuzioni espresse con diverse unità di misura si può ricorrere al coefficiente

di variazione

𝐶𝑣 =

𝑆

𝑥̅

Si tratta di un numero puro (rapporto fra due grandezze espresse nella stessa unità di misura) e permette

confronti diretti tra qualsiasi distribuzione.

Il coefficiente di variazione può essere applicato soltanto a variabili a livello di scala di rapporti o scala

assoluta in quanto soltanto a questi livelli di scala è una statistica idonea

Esiste un concetto più generale del quale media, varianza e media dei quadrati sono casi specifici, ed è

quello di momento omogeneo. un momento omogeneo consiste nella media dei valori di una variabile

presa con esponente positivo. L’esponente determina l’ordine del momento. I momenti possono essere

divisi in centrali o non centrali. Sono momenti centrali (o rispetto alla media) quelli calcolati considerando

gli scarti dalla media; sono momenti non centrali (o rispetto all’origine) quelli calcolati sui dati di partenza.

Formula di una generico momento omogeneo:

𝑁

1

𝑀 = ∑ 𝑥𝑖𝑟

𝑁

𝑖=1

Dove X può essere una variabile grezza o uno scaro da una media e r è un intero positivo.

Il momento omogeneo non centrale di primo ordine (media) informa sulla

tendenza centrale di una distribuzione

μ1 : tendenza centrale (media)

Il momento omogeneo centrale di secondo ordine (varianza) informa sulla

dispersione

μ2: varianza

I momenti di terzo e quarto ordine danno informazioni relative alla simmetria e alla

curtosi di una distribuzione

μ3: simmetria

μ4: curtosi

Indici di forma

Indici di simmetria (o di Skeweness): γ1

si definisce distribuzione simmetrica una distribuzione in cui le modalità che sono equidistanti dalla

mediana hanno la stessa frequenza. In una distribuzione simmetrica media e mediana coincidono. Se la

distribuzione è unimodale anche la moda coincide con media e mediana

Se una distribuzione è asimmetrica positiva le osservazioni sono addensate sui valori bassi della variabile

con una lunga coda sui valori alti della variabile. La media è maggiore della moda e della mediana. (

media>mdn>mo)

Se una distribuzione è asimmetrica negativa le osservazioni sono addensate sui valori alti

della distribuzione con una lunga coda sui valori bassi della variabile. La media è minore

della mediana. (media<mdn)

Se la distribuzione è simmetrica i momenti centrali di ordine dispari sono uguali a 0, sono maggiori di 0 nel

caso di asimmetria positiva, sono minori di 0 nel caso di asimmetria negativa

𝛾1 =

𝜇̅ 3

3/2

𝜇̅1

1 𝑁

∑𝑖=1(𝑥𝑖 − 𝑥̅ )3

𝑁

=

1

2 3⁄2

[𝑁 ∑𝑁

𝑖=1(𝑥𝑖 − 𝑥̅ ) ]

1 𝑁

∑𝑖=1(𝑥𝑖 − 𝑥̅ )3

𝑁

=

𝑆3

Ossia il rapporto tra il momento centrale di 3° ordine e il cubo della deviazione standard

distribuzione simmetrica => μ3 = 0

distribuzione asimmetrica positiva => μ3 > 0

distribuzione asimmetrica negativa => μ3 < 0

μ3 costituisce una misura assoluta, dipende dall’unità di misura della distribuzione, per rendere la misura

indipendente dall’unità di misura viene fatto il rapporto con S3. γ1 è quindi una misura di simmetria relativa,

non dipende dall’unità di misura

se γ1 = 0 => curva simmetrica

se γ1 > 1 => curva ragionevolmente simmetrica

se γ1 > 2 => curva non ragionevolmente simmetrica

la curva normale è il più importante esempio di curva simmetrica

Curtosi

La curtosi è una misura di quanto la distribuzione è più appuntita di quella normale (viene detta

leptocurtica) o più piatta (viene detta platicurtica).

Il momento omogeneo centrale di quarto ordine 𝜇̅ 4 è una misura di curtosi. Anche in questo caso la misura

può essere relativizzata, dividendola per il quadrato della varianza

1 𝑁

∑𝑖=1(𝑥𝑖 − 𝑥̅ )4

𝜇̅ 4

𝑁

𝛾2 = 2 =

−3

1 𝑁

𝜇̅ 2

2

2

∑

[𝑁 𝑖=1(𝑥𝑖 − 𝑥̅ ) ]

1 𝑁

∑𝑖=1(𝑥𝑖 − 𝑥̅ )4

𝑁

=

−3

𝑆4

se γ2 = 0 => distribuzione mesocurtica (normale)

se γ2 > 0 => distribuzione leptocurtica

se γ1 < 0 => distribuzione platicurtica

STANDARDIZZAZIONE

Le distribuzioni standardizzate si caratterizzano per avere media paria 0 e varianza uguale a 1

Formula della standardizzazione

𝑧𝑖 =

(𝑥𝑖 − 𝑥̅ )

𝑠

Al numeratore quella che viene effettuata è un’operazione di centratura, originando una variabile che

contiene gli scarti dalla media, detta variabile scarto; che viene poi divisa per la deviazione standard della

variabile (operazione detta uniformazione). I valori che si ottengono vengono detti punteggi z e presentano

le seguenti proprietà:

∑𝑁

𝑖=1 𝑧𝑖 = 0

2

∑𝑁

𝑖=1 𝑧𝑖 = 𝑁

La scala dei punteggi z può essere ulteriormente trasformata in modo da assumere come media e varianza

valori, sempre prefissati dal ricercatore ma diversi da 0 e 1. La formula generale per effettuare questo

cambiamento di scala non è altro che una trasformazione lineare dei punti z : y= bz+a Dove y è il punteggio

della nuova scala, b rappresenta il valore che si vuol fare assumere alla deviazione standard della nuova

variabile e a il valore che si vuole far assumere alla media.

TEORIA DELLA PROBABILITA’

Evento aleatorio (o casuale) : dato un insieme di condizioni C, l’evento A può accadere oppure no. È

possibile associare a ogni evento aleatorio con numero p, che rappresenti il grado della sua probabilità di

realizzazione. Possiamo collocare gli eventi su un ipotetico continuum: a un estremo si collocano gli eventi

certi (p=1) e all’altro estremo gli eventi impossibili (p=0). A ciascuno degli eventi aleatori, a seconda della

posizione sul continuum, può essere associato un numero reale compreso tra 0 e 1

Sono state date differenti definizioni probabilità:

Concezione frequentista (Von Mises)

“la probabilità di Ei è uguale per definizione alla frequenza relativa limite di ni su n, per n che tende

a infinito.” In cui Ei rappresenta una classe di eventi ripetibili; n è il numero totale della volte in cui

la prova viene ripetuta a parità di condizioni e ni è il numero di volte in cui l’evento Ei si verifica. ni/n

è la frequenza relativa di Ei

𝑛𝑖

𝑃(𝐸𝑖 ) = lim

𝑛→ ∞ 𝑛

Si tratta di un tipo di probabilità calcolata a posteriori, dopo avere osservato il valore

effettivamente assunto da una frequenza in un numero molto grande di prove.

Definizione classica o simmetrica (Laplace)

La probabilità di un evento E viene definita come il rapporto tra il numero degli esiti che realizzano

l’evento E, e tutti gli esiti possibili in una certa prova, purché i diversi esiti siano tutti equiprobabili.

𝑛° 𝑐𝑎𝑠𝑖 𝑓𝑎𝑣𝑜𝑟𝑒𝑣𝑜𝑙𝑖

𝑃(𝐸) =

𝑛° 𝑐𝑎𝑠𝑖 𝑝𝑜𝑠𝑠𝑖𝑏𝑖𝑙𝑖

Più in generale se gli esiti elementari sono K e tutti egualmente probabili, la probabilità di uno di

essi sarà: 𝑃(𝐸𝑖 ) = 1⁄𝑘

Nella teoria classica abbiamo una probabilità calcolata a priori, sulla base di un ragionamento

logico, fondato su determinati assunti

Concezione soggettivista (Ramsey, DeFinetti)

La probabilità dell’evento E è la somma che un individuo coerente è disposto a scommettere in un

gioco equo nel quale al verificarsi di E egli riceve dal banco un importo unitario. L’equità si realizza

se in ogni momento giocatore e banco sono disposti a scambiarsi le parti.

La valutazione numerica della probabilità è connessa alle valutazioni personali di un soggetto circa

la verificabilità di un certo esito incerto.

Definizione assiomatica (Kolmogorov)

la teoria delle probabilità viene intesa come disciplina matematica; concetti come probabilità ed

evento sono considerati concetti primitivi che, in quanto tali, non necessitano di una definizione

esplicita: è sufficiente una definizione implicita, attraverso la definizione di alcune regole circa il

loro impiego coerente.

PROPRIETA’ ELEMENTARI DELLA PROBABILITA’

Gli eventi elementari che compongono un generico insieme Ω: [ω1, ω2, … ωi …. ωn] possono essere: un

numero finito (numero di facce di un dado); un numero infinito numerabile (l’insieme dei numeri razionali);

un numero infinito non numerabile (l’insieme dei numeri reali)

Definito lo spazio degli eventi elementari di Ω (tutti gli eventi elementari che compongono l’insieme), è

possibile individuare degli eventi più complessi, che si presentano come sottoinsieme di Ω

Se chiamiamo E un evento complesso , che è formato dall’associazione di eventi elementari, l’evento

complementare di e rispetto a Ω viene indicato col simbolo 𝐸̅ → [𝐸̅ = Ω − 𝐸]

Ω è l’evento certo (comprende tutti gli esiti possibili), mentre il suo complementare (∅) è l’evento

impossibile (l’insieme nullo)

Se Ω è un insieme finito o infinito non numerabile, si può identificare l’insieme delle parti ad esso associato

BΩ, che comprende tutti i sotto insiemi di Ω, compresi gli eventi ∅ e Ω stesso. Se Ω è un insieme infinito non

numerabile BΩ è scelto arbitrariamente tra tutti gli eventi di interesse associabili a Ω.

Dato un insieme Ω di cardinalità N (composto da n elementi) il suo insieme delle parti è dato da 2N

BΩ è una classe additiva, essa non è vuota ed è chiusa rispetto all’operazione di negazione e all’operazione

di unione; ossia i risultati di queste due operazioni su BΩ fanno ancora parte di BΩ

Fissato BΩ si associa a ogni evento uno scalare che rappresenta la probabilità per ciascun evento di

costituire l’esito di una prova aleatoria. L’assegnazione deve rispettare i seguenti assiomi:

1. Gli eventi, sottoinsiemi di uno spazio Ω, formano una classe additiva BΩ

2. A ogni evento Ei è assegnato un numero reale maggiore uguale a 0 → 𝑃(𝐸𝑖 ) ≥ 0

3. La probabilità di Ω è uguale a 1

→ 𝑃(Ω) = 1

La probabilità di un evento (uno dei possibili risultati elementari o una loro combinazione) viene indicata

con uno scalare compreso tra 0 e 1.

La terna {Ω, BΩ, P} è detta spazio probabilistico. Con: Ω= eventi che compongono l’insieme, BΩ = insieme

delle parti dell’insieme (comprende tutti i sotto insiemi possibili di Ω) e P = probabilità che si verifichi uno

degli eventi compresi nell’insieme.

4. La probabilità (P) di un evento ottenuto come l’unione di eventi incompatibili è uguale alla

somma delle probabilità dei singoli eventi. → Ei∩Ej=0, per ogni i ≠ j, allora P(Ei U Ej) =P(Ei)+P(Ej)

Il quarto assioma è noto anche come il principio delle probabilità totali (o principio della somma). Se

l’evento complesso E è dato dall’associazione di ω1 e ω2, dove i due eventi sono incompatibili allora

𝑃(𝐸) = 𝑃(𝜔1 ) + 𝑃(𝜔2 )

Eventi incompatibili: appartengono a due insiemi disgiunti se la loro intersezione restituisce insieme vuoto.

Eventi compatibili appartengono a due insiemi che hanno almeno un elemento in comune

Dai precedenti assiomi si assume anche che:

P(∅)=0

̅) = 1 − P(E)

Se 𝐸̅ è il complemento di E rispetto a Ω allora: 𝑃(E

Se Ei e Ej sono eventi compatibili → 𝑃(𝐸1 ∪ 𝐸2 ∪ 𝐸3 … ) = 𝑃(𝐸1 ) + 𝑃(𝐸2 ) + 𝑃(𝐸3 ) …

Se Ei e Ej sono eventi incompatibili → 𝑃(𝐸1 ∪ 𝐸2 ∪ 𝐸3 … ) = 𝑃(𝐸1 ) + 𝑃(𝐸2 ) + 𝑃(𝐸3 ) −

𝑃(𝐸1 ∩ 𝐸2 ) − 𝑃(𝐸1 ∩ 𝐸3 ) − 𝑃(𝐸2 ∩ 𝐸3 ) + 𝑃(𝐸1 ∩ 𝐸2 ∩ 𝐸3 )

Per calcolare la probabilità che due eventi si presentino congiuntamente [𝑃(𝐸1 ∩ 𝐸2 )] occorre prima

distinguere la situazione in cui gli eventi sono stocasticamente indipendenti da quella in cui non lo sono.

Un evento (Ei) è considerato condizionato quando si assume una qualche informazione su un altro evento

che indirettamente riguarda la probabilità dell’avverarsi dell’evento Ei. Il condizionamento viene indicato

col simbolo “|” => P(E1|E2) che si legge “probabilità di E1 posto che si sia verificato E2.

La probabilità condizionata viene calcolata con la formula:

𝑃(𝐸1 |𝐸2 ) =

𝑃(𝐸1 ∩ 𝐸2 )

𝑃(𝐸2 )

Siamo in presenza di due eventi stocasticamente indipendenti se la probabilità di un evento di BΩ si

verifiche non è influenzata dal fatto che un altro evento, anch’esso appartenente a BΩ si sia verificato.

L’indipendenza stocastica è espressa con la formula:

𝑃(𝐸1 |𝐸2 ) = 𝑃(𝐸1 ) 𝑒 𝑠𝑝𝑒𝑐𝑢𝑙𝑎𝑟𝑚𝑒𝑛𝑡𝑒 𝑃(𝐸2 |𝐸1 ) = 𝑃(𝐸2 )

Per calcolare una probabilità composta; consideriamo dapprima la combinazione la due eventi {E1} e {E2}

generati da due processi stocasticamente indipendenti; in questo caso abbiamo che:

𝑃(𝐸1 |𝐸2 ) =

𝑃(𝐸1 ∩ 𝐸2 )

= 𝑃(𝐸1 )

𝑃(𝐸2 )

Se invece i due eventi sono dipendenti

𝑃(𝐸1 |𝐸2 ) ≠ 𝑃(𝐸1 )

𝑑𝑎 𝑐𝑢𝑖 𝑠𝑖 𝑟𝑖𝑐𝑎𝑣𝑎 → 𝑃(𝐸1 ∩ 𝐸2 ) = 𝑃(𝐸1 ) ∗ 𝑃(𝐸2 )

𝑃(𝐸1 ∩ 𝐸2 ) = 𝑃(𝐸1 ) ∗ 𝑃(𝐸1 |𝐸2 )

E2 influenza E1, moltiplico la probabilità elementare di uno degli eventi per la probabilità

condizionata dell’altro. La probabilità condizionata {P(E1 ׀E2)} è comunque un evento elementare

(trattiamo sempre l’evento E1).

Se E2 si è verificato…..

ΩE1 non viene modificato => P(E1 ׀E2)= P(E1) => eventi indipendenti

ΩE1 viene modificato => eventi dipendenti

Nel primo caso abbiamo una prova aleatoria con reinserimento, nel secondo caso abbiamo una

prova senza reinserimento (quindi viene modificata la numerosità dello spazio campione)

Se ΩE1 viene modificato….

Il n° di casi favolevoli a E1 si modifica allo stesso modo => Il rapporto tra Ω e i casi favorevoli a

E1 non cambia => P(E1 ׀E2)= P(E1) => eventi indipendenti

Il n° di casi favolevoli a E1 si modifica in modo diverso => Il rapporto tra Ω e i casi favorevoli a

E1 cambia => P(E1 ׀E2) ≠ P(E1) => eventi dipendenti

VARIABILI ALEATORIE E INFERENZA STATISTICA

Il concetto di variabile aleatoria rinvia al fatto che esse è generata da un esperimento di cui non siamo in

grado di prevedere l’esito con certezza. Le variabili così descritte possono essere variabili aleatorie (v.a.)

discrete o continue; unidimensionali o multidimensionali.

Variabili aleatorie unidimensionali discrete

Dato uno spazio di eventi elementari Ω =[ω1, ω2, … ωn] finito o infinto numerabile in cui ognuno

degli eventi elementari è equiprobabile, si definisce BΩ l’insieme delle parti (l’insieme di tutti gli

eventi Ei costruibili con gli elementi presenti in Ω) e P la funzione di probabilità che assegna ad ogni

elemento Ei (ad ogni elemento dell’insieme delle parti) una probabilità P(Ei).

Agli eventi Ei viene assegnato in modo univoco un numero reale ovvero

𝑋(𝐸𝑖 ) = 𝑥𝑖

A ognuno di questi eventi Ei è assegnata una probabilità pi tale per cui

𝑛

𝑃(𝑥𝑛 ) = 𝑝𝑛

𝑐𝑜𝑛 𝑝𝑖 > 0 (𝑖 = 1,2, … . 𝑛)

→ ∑ 𝑝𝑖 = 1

𝑖=1

Chiamiamo v.a. discreta unidimensionale l’insieme di coppie xi e pi , dunque:

𝑋 = [(𝑥1 , 𝑝1 )(𝑥2 , 𝑝2 ) … . (𝑥𝑛 , 𝑝𝑛 )]

L’insieme dei valori (numeri reali) che una v.a. può assumere con probabilità positiva è detto

supporto della v.a.

Ogni elemento di Ω trova un’immagine di un punto di ascissa x della retta R (il supporto); d’altro

canto i punti della retta R così individuati hanno una contro immagine in Ω e in BΩ

Tutti gli elementi di Ω che si trovano sullo stesso punto x della retta R formano un sottoinsieme E di

eventi, che sono un elemento dell’insieme delle parti BΩ al quale è assegnata una stessa funzione di

probabilità

Possiamo definire un’altra importante funzione Φ(𝑥), detta funzione di ripartizione (phi)

Φ(𝑥) = 𝑃(𝑋 ≤ 𝑥) = ∑ 𝑃(𝑋 = 𝑥𝑖 ) 𝑃(𝑋 = 𝑥𝑖 )

𝑥𝑖 ≤𝑥

Che fornisce la probabilità che in un esperimento casuale la v.a. X assume un valore inferiore a x; si

tratta dunque di una funzione cumulativa

Variabili aleatorie unidimensionali continue

Definiamo una v.a. “continua” se gli elementi che formano Ω sono un insieme infinito non

numerabile. Una v.a. unidimensionale continua X è una quantità variabile che può assumere tutti i

valori reali di un intervallo dx, anche molto piccolo, a cui risulta associata una funzione f(x),

denominata funzione di densità di probabilità, in cui la probabilità è individuata dall’area sottesa

alla curva in un dato intervallo.

Variabili aleatorie multidimensionali

È possibile associare a ogni evento anche una coppia, tripla,…. n-pla ordinata di numeri reali, e

studiare la distribuzione di probabilità; si parla allora di v.a. multidimensionali, utili a valutare

connessioni, concordanze e rapporti tra variabili da un punto di vista inferenziale. Ogni dimensione

è a sua volta una v.a. unidimensionale, detta variabile componente. Anche in questo caso si

distingue tra variabili discrete e continue

VALORI CARATTERISTICI DI UNA DISTRIBUZIONE TEORICA DI PROBABILITA’

Come per una distribuzione di frequenze, anche per una distribuzione di probabilità possiamo definire vari

indici di tendenza centrale, di variabilità,…

Valore atteso [ μ o E(X) ]

𝑛

𝐸(𝑋) = ∑ 𝑥𝑖 𝑝(𝑥𝑖 )

𝑖=1

Ovvero il valore atteso di una v.a. si calcola con la sommatoria degli xi moltiplicato alla loro

probabilità.

E(X) gode delle seguenti proprietà:

o Data una costante c,

-> E(c)= c

o Data una costante c e una v.a. X

-> E(cX)= c E(X)

o Date n vv.aa. Xi con i=1,2,….n

-> E(ΣXi)= Σ E(Xi)

o Date n vv.aa. Xi indipendenti

-> E(ΠXi)= Π E(Xi)

Varianza [ σ2 oppure VAR(X) ]

𝑛

𝑉𝐴𝑅(𝑋) = ∑(𝑥𝑖 − 𝜇)2 𝑝(𝑥𝑖 )

𝑖=1

La varianza di una v.a. di calcola facendo la sommatoria degli scarti dal valore atteso (μ) elevati al

quadrato e moltiplicati per la probabilità degli xi

ESEMPI DI DISTRIBUZIONI TEORICHE DI PROBABILITA’ PER VV.AA. DISCRETE

VARIABILE ALEATORIA DI BERNOULLI

Sia E un evento che si può presentare (successo) in un esperimento aleatorio con probabilità p (0<p<1). Al

risultato dell’esperimento venga associata una v.a X[(X=1,p) (X=0,q)], dove X assume valore 0 per 𝐸̅

(insuccesso) e 1 per E (successo), e dove q=1-p.

Una variabile che assume esclusivamente i valori 1 e 0, rispettivamente con probabilità p e q prende il

nome di v.a. Bernoulliana.

Gli eventi generati da una prova possono essere dicotomizzati, al di là della natura del sistema fisico o

simbolico su cui la prova si basa.

Per riassumere:

Ha un supporto numerico dicotomico -> Ωr{0,1};

1 = xi associato all’evento successo -> (p);

0 = xi associato all’evento insuccesso -> (q)

p+q= 1

q= 1-p

P(0 o 1)= P(Ωr)=1

Funzione di probabilità per una bernoulliana:

1

𝑓(𝑥; 𝑝) = ( ) 𝑝 𝑥 (1 − 𝑝)1−𝑥

𝑥

[p= parametro che regola la variabile; X = valore che può assumere l’evento]

Se ne ricava che :

f(X=1)=

p1 (1-p)1-1 = p1* q0 = p

f(X=0) = p0 (1-p)1-0 = p0 * q1 = q

calcolo del valore atteso e della varianza

𝑛

1

1

𝐸(𝑋) = ∑ 𝑥𝑖 𝑝(𝑥𝑖 ) → (0) ( ) 𝑝0 (1 − 𝑝)1 + (1) ( ) 𝑝1 (1 − 𝑝)0 =

0

1

0∗𝑞+1∗𝑝 =0+𝑝=𝑝

𝑖=1

𝑛

1

1

𝑉𝐴𝑅(𝑋) = ∑(𝑥𝑖 − 𝜇)2 𝑝(𝑥𝑖 ) → (0 − 𝑝)2 ( ) 𝑝0 (1 − 𝑝)1 + (1 − 𝑝)2 ( ) 𝑝1 (1 − 𝑝)0 = 𝑝(1 − 𝑝)

0

1

𝑖=1

=𝑝∗𝑞

VARIABILE ALEATORIA BINOMIALE

Sia E l’evento come è stato definito nel caso della v.a. bernoulliana, e si consideri il risultato congiunto di n

prove indipendenti. A ciascuna prova può essere associata una v.a. di Bernoulli, secondo le modalità

precedentemente descritte (𝐸̅ = 0; 𝐸 = 1)

somma di N v.a Bernoulliane, sotto la condizione che esse siano i,i,d {identicamente. indipendentemente

distribuite}. ciascuna Bernoulliana è governata dallo stesso parametro (p)

funzione di probabilità binomiale:

𝑛

𝑓(𝑥; 𝑝; 𝑛) = 𝑃(𝑋 = 𝑥) = ( ) 𝑝 𝑥 𝑞𝑛−𝑥

𝑥

Dove con n intendiamo il numero di prove (quante bernoulliane compongono la binomiale); con p si

intendono le probabilità di successo e con x il numero di successi che assumiamo di ottenere

Calcolo del valore atteso e della varianza

𝑛

𝑛

𝐸(𝑋) = 𝐸(∑ 𝑋𝑖 ) = ∑ 𝐸(𝑋𝑖 ) = 𝑛𝑝

𝑖=1

𝑖=1

In una binomiale la media è uguale al numero di prove (n)* le probabilità di successo (p)

𝑛

𝑛

𝑉𝐴𝑅(𝑋) = 𝑉𝐴𝑅(∑ 𝑋𝑖 ) = ∑ 𝑉𝐴𝑅(𝑋𝑖 ) = 𝑛𝑝(1 − 𝑝) = 𝑛𝑝𝑞

𝑖=1

𝑖=1

In una binomiale la varianza è uguale al prodotto tra il numero di prove, la probabilità di successo e la

probabilità di insuccesso

Riassumendo le caratteristiche fondamentali di queste due variabili aleatorie discrete

V.A. BERNUOLLIANA

{0;1}

Ωr

Supporto numerico

1

f(x)

𝑓(𝑥; 𝑝) = ( ) 𝑝 𝑥 (1 − 𝑝)1−𝑥

𝑥

funzione di probabilità

Parametri che governano P (probabilità di successo)

la distribuzione

Valori caratteristici

E (x) = p

VAR (x)= p*q

V.A. BINOMIALE (bernoulliane i,i,d)

{0,1,2… n}

𝑛

𝑓(𝑥; 𝑝; 𝑛) = 𝑃(𝑋 = 𝑥) = ( ) 𝑝 𝑥 𝑞𝑛−𝑥

𝑥

p;

n (numero di prove)

E (x) = np

VAR (x) = np*q

ESEMPI DI DISTRIBUZIONI TEORICHE DI PROBABILITA’ PER VV.AA. CONTINUE

VARAIBILE ALEATORIA NORMALE

si caratterizza per avere un supporto numerico infinito non numerabile -> Ωr [ - ∞, + ∞}. La sua

distribuzione di probabilità assume una forma a campana (distribuzione normale o gaussiana). Sull’asse

delle ascisse vengono indicati i valori che assume il supporto numerico (Ωr); sull’asse delle ordinate è

indicata la densità di probabilità f(x)

Non è possibile associare a P un numero (Ωr è infinito e non numerabile) => siccome P(X=x)= 0 è necessario

che questa proporzione venga rispettata, cosa che non è possibile se P è associato a dei numeri reali =>

associamo delle P (probabilità) a degli intervalli piccoli a piacere di valori => le P sono delle aree sottese a

una curva.

+∞

per calcolare P dobbiamo calcolare degli integrali: ∫−∞ 𝑓(𝑥)𝑑(𝑥).

Dove f(x) è la funzione di densità della probabilità e d(x) è un intervallo piccolo a piacere. Si tratta di fare la

sommatoria di aree di rettangoli con una base infinitamente piccola e dove i rettangoli sono tantissimi

È accertato che le misure di una grandezza, ripetute un gran numero di volte si distribuiscono attorno a un

valore, in modo che al crescere del valore assoluto dell’errore diminuisce la sua frequenza. La frequenza di

ciascun errore positivo è uguale alla frequenza dell’errore negativo di pari valore assoluto (simmetria)

La distribuzione, sinteticamente indicata con 𝑋~𝑁 (𝜇, 𝜎 2 ), è definita su tutto l’asse reale con funzione di

densità di probabilità:

𝑓(𝑥; 𝜇; 𝜎 2 ) =

−∞ < 𝑥 < +∞,

1

𝜎√2𝜋

𝑒 −(𝑥−𝜇)

2 ⁄2𝜎 2

− ∞ < 𝜇 < +∞;

𝜎>0

Dove μ e σ2 sono rispettivamente la media e la varianza della distribuzione (parametri che la governano),

π = nota costante 3,14…

e = base dei logaritmi naturali (2,7183)

(x- μ)2= scarto dalla media della distribuzione elevato al quadrato

L'equazione della funzione di densità è costruita in modo tale che l'area sottesa alla curva rappresenti

la probabilità. Perciò, l'area totale è uguale a 1, quindi l’integrale della funzione da −∞ a +∞ è uguale

a1

+∞

∫

𝑥 = 𝑓(𝑥)𝑑(𝑥) = 𝜇

−∞

↓

↓

=𝜇

𝑝(𝑥)

∑𝑥

+∞

→ 𝑃(Ω𝑟 ) = 1

→ ∫

𝑥 = 𝑓(𝑥)𝑑(𝑥) = 1

−∞

integrale -> operazione che restituisce un’area:

𝜇

∫−∞ 𝑓(𝑥)𝑑(𝑥) = 0,5 (metà della distribuzione che va da − ∞ a μ)

+∞

∫𝜇

𝑓(𝑥)𝑑(𝑥) = 0,5 (metà della distribuzione che va da μ a + ∞ )

Graficamente una distribuzione normale si presenta come una curva a campana, unimodale e

perfettamente simmetrica rispetto al punto di ascissa x=μ, con due punti di flesso in 𝑥 = 𝜇 − 𝜎 e 𝑥 = 𝜇 +

𝜎. La moda coincide con la media e con la mediana della distribuzione. La normale è inoltre asintotica

rispetto all’asse delle ascisse. I punti in cui la curva da convessa diventa concava si trovano in

corrispondenza a ±1 deviazione standard dalla media;

I due parametri della variabile casuale normale, detti pure valori attesi, cioè μ e σ2, corrispondono alla

media E(X) e varianza Var(X) della distribuzione. Si dimostra infatti che:

+∞

1

2

2

𝐸(𝑋) = ∫ 𝑥

𝑒 −(𝑥−𝜇) ⁄2𝜎 𝑑𝑥 = 𝜇

−∞ 𝜎√2𝜋

+∞

𝑉𝐴𝑅(𝑋) = ∫

−∞

(𝑥 − 𝜇)2

1

𝜎√2𝜋

𝑒 −(𝑥−𝜇)

2 ⁄2𝜎 2

𝑑𝑥 = 𝜎 2

Ogni distribuzione normale è univocamente definita dalla media e dalla varianza.

Al variare della media e della varianza la curva subisce sia uno spostamento sull’asse dell’ascissa, sia un

appiattimento; mentre se si fa variare solo la varianza e si tiene costante la media, la curva si appiattisce

quando la varianza cresce e diventa più appuntita quando la varianza si riduce.

Per distinguere la distribuzione normale da altre distribuzioni che presentano forma simile occorre tenere

presente che la probabilità di X assume sempre, per ogni μ e σ2 i seguenti valori nei seguenti intervalli tipici:

𝜇+𝜎

(𝑥)𝑑𝑥 = 0,6826 → 68%

𝑃(𝜇 − 𝜎 ≤ 𝑥 ≤ 𝜇 + 𝜎) = ∫

𝜇−𝜎

𝜇+2𝜎

(𝑥)𝑑𝑥 = 0,9545 → 95%

𝑃(𝜇 − 2𝜎 ≤ 𝑥 ≤ 𝜇 + 2𝜎) = ∫

𝜇−2𝜎

𝜇+3𝜎

𝑃(𝜇 − 3𝜎 ≤ 𝑥 ≤ 𝜇 + 3𝜎) = ∫

𝜇−3𝜎

(𝑥)𝑑𝑥 = 0,9974 → 99%

Variabile aleatoria normale standardizzata

Trasformando i valori della variabile X in punteggi standardizzati (punti Z), otteniamo una v.a. normale

standardizzata, che ha parametri μ e σ rispettivamente pari a 0 e 1.

La distribuzione normale standardizzata si ottiene con la trasformazione lineare dei punti grezzi in

punti z:

𝑍=

𝑥−𝜇

𝜎

La funzione di densità di probabilità della distribuzione normale standardizzata è:

𝑓(𝑧) =

1

√2𝜋

𝑒 −𝑧

2 ⁄2

Con −∞ < 𝑧 < +∞

E(Z)= μ= 0

VAR(Z)= σ2=1

Mediante l’uso della relativa tavola di probabilità è possibile ricavare l’area sottostante ad ogni porzione

della curva, compresa tra la media e una certa ascissa (Z). Le probabilità corrispondenti alle superfici

racchiuse dalla curva normale possono essere calcolate. Queste probabilità sono state tabulate per la

normale standardizzata e vengono riportate in apposite tabelle. Ciò evita il calcolo di integrali per trovare le

probabilità che una v.a. X assuma valori compresi all’interno di intervalli della retta reale.

Le tavole di probabilità della normale standardizzata vengono utilizzate per calcolare l’area compresa tra

due determinati valori della variabile oggetto di studio.

Le tavole della distribuzione normale standardizzata riportano l’area compresa tra media e il valore di z

oppure l’area che si colloca oltre il punto z nella coda della distribuzione. Nella prima colonna abbiamo il

valore di z con il primo decimale e nella prima riga la seconda cifra decimale. Dall’intersezione della riga e

della colonna corrispondente al valore z calcolato, si individua il valore dell’area.

Dato che la distribuzione normale è simmetrica nelle tavole dei punti z i valori sono solo positivi, in quanto

la proporzione dei valori tra la media e un valore z=1.00 e tra la media e un valore z=-1.00 è uguale a

0.3413.

VARIABILE ALEATORIA CHI QUADRATO

L a v.a. chi quadrato è una funzione di variabile aleatorie. Si chiama 𝜒 2 la sommatoria dei quadrati di n

variabili indipendenti normali standardizzate

𝑁

2

𝜒 =

∑ 𝑍𝑖2

𝑖=1

𝑁

𝑋𝑖 − 𝜇𝑖 2

= ∑(

)

𝜎2

𝑖=1

La funzione di densità di probabilità 𝑓(𝜒 2 )è un caso parti calore della v.a. gamma generalizzata ed è

espressa come: 𝑓(𝜒 2 , 𝜈)

La funzione è definita per valori positivi 0 ≤ 𝜒 2 ≤ +∞, ed è caratterizzata dal parametro 𝜐 (nu) che

rappresenta i gradi di libertà della distribuzione, pari a 𝜐 = 𝑛

La distribuzione 𝜒 2 ha media e varianza pari a:

𝜐

𝐸(𝜒

2)

=

𝜈

𝐸 (∑ 𝑍𝑖2 )

𝑖=1

= 𝜈 → ∑ 𝐸(𝑍𝑖2 ) = 𝜈

𝑖=1

𝑉𝐴𝑅(𝜒 2 ) = 2𝜈

La funzione di densità della v.a. 𝜒 2 al variare dei gradi di libertà (gdl) assume forme diverse; per 𝜐 che tende

a infinito essa converge con la normale: l’approssimazione è considerata adeguata a partire da 𝜈 = 30

VARIABILE ALEATORIA T DI STUDENT

Possiede le stesse caratteristiche della distribuzione normale, ma ha una forma più schiacciata che esprime

una variabilità maggiore intorno alla media.

La variabilità della media e lo schiacciamento della curva dipendono dall’ampiezza campionaria, ovvero

tanto più i campioni sono piccoli, maggiore sarà la variabilità e tanto più schiacciata risulterà la curva.

Il valore di t dipende dalla numerosità campionaria, quindi non esiste una sola distribuzione t, ma ne

esistono tante in funzione dei gradi di libertà, dati dalla quantità n-1.

𝛺𝑟 {−∞ , + ∞}

𝜈 =𝑛−1

𝐸(𝑡) = 0

𝑉𝐴𝑅 (𝑡) = 𝑣/ (𝑣 − 2)

La sua f(x) è governata dai suoi gdl

Se v > 30 la distribuzione approssima una normale

VARIABILE ALEATORIA NORMALE BIVARIATA

Costituisce la generalizzazione a 𝑘 dimensioni della v.a. normale. (in questo caso K=2)

Rappresentando una funzione di densità di una v.a. bivariata,ricaveremo una sorta di cappello

rappresentato su tre dimensioni; la sezione parallela all’asse delle x o delle y rappresenta una distribuzione

normale. Se invece sezioniamo il cappello con un taglio parallelo al piano individuato da x e y, otterremo un

ellisse, tanto maggiore quanto il taglio si avvicina il piano xy. La forma dell’ellisse dipende dalla varianza

della X e Y e dalla loro covarianza. Considerando il caso che le due variabili siano standardizzate. In caso di

relazione positiva tre le due variabili, le ellissi saranno direzionate lungo la bisettrice del primo e del terzo

quadrante del piano cartesiano; in caso di associazione negativa lungo la bisettrice del secondo e quarto

quadrante.

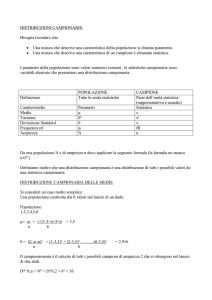

DISTRIBUZIONI CAMPIONARIE

Ogni statistica campionaria (indicata con lettere dell’alfabeto latino) è una v.a. che ha una sua distribuzione

di probabilità. Tali statistiche avranno un valore che varia intorno all’omologo parametro della popolazione

(sempre ignoto, indicato con lettere greche). In virtù di questa “attrazione” delle statistiche da parte del

parametro corrispondente, è ragionevole tentare una stima del parametro (che è fisso ma sconosciuto) a

partire dalla statistica osservata. Tale stima sarà inevitabilmente affetta da un certo margine di errore

accidentale, in quanto noi operiamo su uno solo dei campioni potenzialmente estraibili dalla popolazione.

Le vv.aa. sono distribuzioni teoriche, o leggi di probabilità, che intervengono nella statistica inferenziale

come strumento per rappresentare una distribuzione osservata mediante un modello matematico che

dipende da un ristretto numero di parametri.

Più precisamente una v.a. teorica entra in un processo ci inferenza in due modi:

Alcuni problemi di inferenza statistica per essere risolti richiedono particolari assunti sulla forma

della distribuzione che caratterizza l’universo

Altri problemi di inferenza invece, pur non richiedendo particolari assunti distribuzionali della

popolazione, sfruttano le caratteristiche di una distribuzione teorica partendo dal fatto che essa

caratterizza una distribuzione campionaria

Le distribuzioni teoriche vengono utilizzate innanzi tutto per rappresentare la distribuzioni campionarie

(una distribuzione campionaria può essere distribuita in modo normale, chi quadrato, …) vi sono poi alcune

distribuzioni che, oltre a coincidere con dispositivi procedurali, sono utilizzabili per rappresentare in forma

parsimoniosa, cioè come modello , il modo in cui le variabili sono distribuite nella popolazione.

Occorre classificare i principali modi in cui si impostano le procedure di inferenza statistica:

Test sulle ipotesi statistiche: concernono una congettura su una o più caratteristiche di una v.a.

assunta come modello interpretativo del fenomeno in esame; si tratta di procedure che portano il

ricercatore a trattenere o respingere un’ipotesi.

Rispetto all’uso di una v.a. come modello della popolazione possiamo individuare duegrandi

famiglie di test:

o TEST PARAMETRICI (funzionali)

Vengono applicati a ipotesi relative ai valori numerici dei parametri di una o più

popolazioni, che si assumono distribuite secondo una legge di probabilità nota

o TEST NON PARAMETRICI (distributio-free)

In questo caso le uniche informazioni sulla popolazione si traggono dal campione senza

ulteriori assunti

Procedure di stima: servono a identificare il valore incognito di certi parametri della legge di

probabilità assunta come modello, essi si articolano a loro volta in due classi di operatori:

o STIMA PUNTUALE

Consiste nell’ottenere un singolo valore che sia un buon rappresentante del parametro

(ignoto)

o STIMA INTERVALLARE

Consiste nell’individuare un intervallo entro il quale con una certa probabilità ricade il

parametro

INFERENZA SU UNA VARIABILE

Si definisce popolazione qualsiasi insieme di elementi simili tra loro per una o più caratteristiche che

rappresentano l’oggetto dello studio.

Può essere finita, ovvero costituita da un numero finito di unità (comunque molto grande) o infinita

trattiamo come popolazioni anche insiemi che non sono enumerabili e che si realizzeranno anche nel

futuro.

Si definisce campione un sottoinsieme della popolazione, ovvero una raccolta finita di elementi estratti da

una popolazione. Scopo dell’estrazione: ottenere informazioni sulla popolazione

Pertanto il campione deve essere rappresentativo della popolazione da cui viene estratto (‘non viziato’).

Per corrispondere a queste esigenze il campione viene individuato con un campionamento casuale.

Campionamento ed inferenza sono due processi simmetrici, l’inferenza permette di dire qualcosa sulla

popolazione a partire dai dati ottenuti sul campione.

Definiamo statistica campionaria la statistica calcolata per le osservazioni che compongono il

campione (T). In generale, le statistiche campionarie sono definite in modo tale da essere degli

stimatori non distorti dell’omologo parametro della popolazione (θ).

Una distribuzione campionaria è la distribuzione relativa ad una specifica statistica calcolata su più

campioni di dimensione n tutti estratti dalla stessa popolazione.

La funzione campionaria è una funzione di probabilità il cui dominio è costituito dai valori di una statistica

(es media) e il codominio è costituito dalle probabilità che i valori della statistica hanno di verificarsi.

Per costruire una distribuzione campionaria occorre:

1. Estrarre dalla stessa popolazione dei campioni con lo stesso numero di casi (n)

2. Le estrazioni devono essere casuali e indipendenti.

3. In questo modo, le determinazioni (osservazioni) campionarie (x1, x2, ..xn) sono variabili

indipendenti, ed hanno la stessa funzione di probabilità della popolazione di origine, ovvero sono

identicamente distribuite (variabili IID: indipendenti, identicamente distribuite)

4. Sui campioni così estratti si procede a calcolare la statistica della quale si vuole definire la

distribuzione campionaria

DISTRIBUZIONE DELLA V.A. MEDIA CAMPIONARIA

Siano 𝑋1 , 𝑋2 , … , 𝑋𝑛 delle prove indipendenti di un processo aleatorio con: valore atteso 𝐸(𝑋𝑖 ) = 𝜇; e

varianza 𝑉(𝑋𝑖 ) = 𝜎 2 . Si definisca la somma delle variabili aleatorie 𝑋𝑖 come: 𝑈 = 𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛

Dato che 𝑋1 , 𝑋2 , … , 𝑋𝑛 sono variabili aleatorie indipendenti, ciascuna delle quali definita con media 𝜇 e

varianza 𝜎 2 , il valore atteso e la varianza di U diventano:

𝐸(𝑈 ) = 𝐸(𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛 ) = 𝐸(𝑋1 ) + 𝐸(𝑋2 ) + ⋯ + 𝐸(𝑋𝑛 ) = 𝑛 𝜇

𝑉(𝑈 ) = 𝑉(𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛 ) = 𝑉(𝑋1 ) + 𝑉(𝑋2 ) + ⋯ + 𝑉(𝑋𝑛 ) = 𝑛 𝜎2

Definiamo ora la distribuzione della media campionaria, che è data da:

𝑋̅ =

𝑋1 + 𝑋2 + ⋯ + 𝑋𝑛

𝑈

=

𝑛

𝑛

Poiché ogni v.a. Xi ha una distribuzione identica a quella della popolazione di riferimento, è facile

dimostrare che la media della distribuzione campionaria 𝜇𝑋̅ è uguale alla media della popolazione

𝑈

1

1

𝜇𝑋̅ = 𝐸(𝑋̅) = 𝐸 ( ) = 𝐸(𝑈) = 𝑛𝜇 = 𝜇

𝑛

𝑛

𝑛

Anche la varianza della media campionaria, denotata da 𝜎𝑋2̅ , è in relazione con l’omologo parametro della

variabile nella popolazione

𝑈

1

1

𝜎2

𝜎𝑋2̅ = 𝑉𝐴𝑅(𝑋̅) = 𝑉𝐴𝑅 ( ) = 2 𝑉𝐴𝑅(𝑈) = 2 𝑛𝜎 2 =

𝑛

𝑛

𝑛

𝑛

Se il campionamento non è bernoulliano e la popolazione è finita, occorre moltiplicare per un fattore di

𝑁−𝑛

riduzione 𝑁−1 dove 𝑁 e 𝑛 sono rispettivamente la numerosità della popolazione e quella campionaria.

La varianza della media campionaria è inversamente proporzionale all’ampiezza del campione.

La forma assunta dalla distribuzione della media campionaria è normale quando la popolazione da cui

deriva è normale.

Alla distribuzione della media campionaria è possibile applicare il teorema del limite centrale: se si

estraggono ripetuti campioni casuali di dimensione n da un qualsiasi universo (qualunque sia la sua forma)

con media 𝜇 e varianza 𝜎 2 , all’aumentare della dimensione n del campione, la distribuzione della media

campionaria sarà normale e avrà come media 𝜇 e come varianza 𝜎 2 /𝑛

Quindi al crescere della grandezza del campione, la distribuzione campionaria della media tende ad una

distribuzione nomale.

La deviazione standard della media campionaria si definisce errore standard e rappresenta un indice di

precisione della media stimata su un campione.

𝐸𝑆𝑋̅ = 𝜎𝑋̅ =

𝜎

√𝑛

La stima fornita dal singolo campione è affetta da incertezza, a causa dell'errore casuale del

campionamento.

L’errore standard è una misura dell’incertezza di una statistica misurata su un campione (ad esempio la

media). L’errore standard rappresenta l’errore che noi commettiamo se consideriamo ad esempio la media

calcolata su un campione come la media vera della popolazione.

La variabilità delle medie campionarie (𝐸𝑆) è minore della variabilità della popolazione (𝜎), ed è tanto

minore, tanto maggiore è la numerosità campionaria.

NB: deviazione standard è diversa dall’errore standard:

La deviazione standard è una misura di variabilità fra individui

L’errore standard è una misura di incertezza della stima.

DISTRIBUZIONE DELLA V.A. VARIANZA CAMPIONARIA

Anche la statistica 𝑆 (deviazione standard o scarto quadratico medio) ha una sua distribuzione campionaria,

ovvero gli scarti quadratici medi dei campioni si distribuiscono attorno al vero scarto quadratico medio

della popolazione, proprio come le medie dei campioni si distribuiscono attorno alla media della

popolazione.

NB: 𝑆 2 è una stima sistematicamente errata di 𝜎 2 .

La media della distribuzione campionaria di 𝑆 2 per campioni casuali, non è 𝜎 2 ; non si verifica l’eguaglianza

perfetta tra valore atteso della varianza campionaria e il suo omologo nella popolazione: i due valori

risultano connessi come segue: 2

𝐸(𝑆 2 ) =

𝑛−1 2

𝜎

𝑛

Per questo motivo siamo portati a definire un’altra statistica, definita come varianza campionaria corretta:

∑𝑛𝑖=1(𝑥𝑖 − 𝑥̅ )2

𝑛−1 2

𝑆̂2 =

𝑆 =

𝑛

𝑛−1

In questo modo avremo che 𝐸(𝑆̂2 ) = 𝜎 2

Il valore atteso della varianza campionaria (calcolata con 𝑛 − 1) è la varianza della popolazione, in altre

parole la varianza campionaria (calcolata con 𝑛 − 1) è una stima non distorta della varianza della

popolazione.

Sovente non si conosce la deviazione standard della popolazione di riferimento, si usa allora la statistica S

del campione per ottenere l’errore standard stimato: 𝜎̂𝑥 = 𝑆⁄√𝑛 − 1

La distribuzione della varianza campionaria corretta ha una funzione di densità basata sul chi quadrato con

𝜎2

2

𝑛 − 1 gradi di libertà: 𝑛−1 𝜒(𝑛−1)

La varianza di una varianza è funzione dl momento centrale di quart’ordine del fenomeno x, della varianza

alla seconda e dell’ampiezza del campione 𝑉𝐴𝑅 (𝑆 2 ) = 𝑓𝑢𝑛𝑧𝑖𝑜𝑛𝑒 ( 𝜇4, 𝜎4, 𝑛)

In sintesi: La distribuzione campionaria delle medie permette di fare inferenza sulla media della

popolazione quando si conosce 1 solo campione di dimensioni n.

Ha le seguenti proprietà:

la media della distribuzione campionaria delle medie è uguale alla media μ della popolazione.

La deviazione standard della distribuzione campionaria delle medie è funzione della

numerosità n del campione e della deviazione standard (σ) della popolazione. Tale quantità si

chiama Errore standard (ES): 𝜎 /√𝑁 . Se non conosciamo σ della popolazione, può essere

stimato a partire dai dati del campione, e l’ES diventa: 𝑆/√𝑁 − 1

La distribuzione campionaria è approssimativamente normale, indipendentemente dalla

distribuzione della popolazione, posto che n sia sufficientemente grande (𝑛 ≥ 30).

CAMPIONE

𝑚𝑒𝑑𝑖𝑎

𝑣𝑎𝑟𝑖𝑎𝑛𝑧𝑎

𝑑𝑒𝑣. 𝑠𝑡𝑎𝑛𝑑𝑎𝑟𝑑

𝑥̅

𝑆2

𝑆

POPOLAZIONE

𝑚𝑒𝑑𝑖𝑎

𝑣𝑎𝑟𝑖𝑎𝑛𝑧𝑎

𝑑𝑒𝑣. 𝑠𝑡𝑎𝑛𝑑𝑎𝑟𝑑

𝜇

𝜎2

𝜎

DIST CAMPIONARIA DELLE MEDIE

𝑚𝑒𝑑𝑖𝑎

𝐸(𝑋̅) = 𝜇

𝑣𝑎𝑟𝑖𝑎𝑛𝑧𝑎

𝑉𝐴𝑅(𝑋̅) = 𝜎 2

𝑑𝑒𝑣. 𝑠𝑡𝑎𝑛𝑑𝑎𝑟𝑑 𝐸𝑆(𝑋̅) = 𝜎⁄√𝑁

DISTRIBUZIONI CAMPIONARIE E DISTRIBUZIONI DI PROBABILITÀ

Per associare una probabilità ad una media campionaria (𝑛 ≥ 30) se conosciamo δ della popolazione

facciamo riferimento alle tavole della normale standardizzata.

La standardizzazione sarà fatta usando i parametri di tale distribuzione campionaria:

𝑥̅ − 𝜇

𝑍𝑥̅ = 𝜎

⁄ 𝑛

√

Quando il campione è piccolo e/o non conosciamo la varianza della popolazione possiamo stimarla

attraverso quella del campione, ma per associare un valore di probabilità al risultato ottenuto in un

campione bisogna utilizzare la distribuzione t di Student al posto della normale standardizzata.

La distribuzione t di Student (William Gosset 1876-1937): possiede le stesse caratteristiche della

distribuzione normale, ma ha una forma più schiacciata che esprime una variabilità maggiore intorno alla

media.

La variabilità della media e lo schiacciamento della curva dipendono dall’ampiezza campionaria, ovvero

tanto più i campioni sono piccoli, maggiore sarà la variabilità e tanto più schiacciata risulterà la curva.

Il valore di t dipende dalla numerosità campionaria, quindi non esiste una sola distribuzione t, ma ne

esistono tante in funzione dei gradi di libertà, dati dalla quantità 𝑛 − 1.

Se i gdl sono quei valori liberi di variare, poste certe restrizioni, allora se abbiamo un campione di

numerosità n, i gdl saranno sempre un valore in meno rispetto ad n: 𝐺𝑑𝑙 = 𝑛 − 1

Il percorso dell’inferenza statistica si svolge seguendo le seguenti fasi:

1. estrazione di un campione della popolazione

2. calcolo delle statistiche campionarie, cioè dei valori corrispondenti ai dati contenuti nel

campione

3. stima dei parametri nella popolazione in base ai risultati forniti dal campione.

Distinguiamo tra

θ = (teta) PARAMETRO -> valore reale, fisso riferito a una popolazione che però non possiamo

conoscere, è ignoto; è uno dei valori che governa la variabile all’interno della popolazione

T = STIMATORE del parametro θ; (T)-> funzione delle determinazioni campionarie T= f(Xi) è anche detto

riassunto campionario

t = uno dei valori possibili di T, estratto dal campione selezionato

per indicare che il valore trovato (t) è una stima del parametro θ, si mette il simbolo ^ sopra il simbolo del

parametro

Proprietà degli stimatori:

Correttezza

uno stimatore si definisce corretto se il suo valore atteso corrisponde al valore del parametro nella

popolazione 𝐸(𝑇) = 𝜃 → 𝐸(𝑇) − 𝜃 = 0

Ad esempio 𝐸(𝑥̅ ) = 𝜇

La distorsione di uno stimatore B (Bias) si definisce: 𝐸(𝑇) − 𝜃 = 𝐵𝑖𝑎𝑠

Stimatore assolutamente corretto 𝐸(𝑇) − 𝜃 = 0

Stimatore asintoticamente corretto se la distorsione tende a zero quando n tende a infinito 𝑛 →

∞ ; 𝐵𝑖𝑎𝑠 → 0

Stimatore distorto 𝐵𝑖𝑎𝑠 ≠ 0

In termini di correttezza la mediana è uno stimatore corretto tanto quanto la media

La varianza campionaria è uno stimatore solo asintoticamente corretto, dal momento che al crescere di n la

varianza campionaria e la varianza campionaria corretta tendono a coincidere

Efficienza

uno stimatore si definisce efficiente se, a parità di altre condizioni, la sua varianza risulta minore. La

stima dell’errore standard (per popolazioni finite) è: 𝑆(𝑥̅ ) =

𝑆̂

√𝑛

𝑁−𝑛

( 𝑁−1 )

L’efficienza relativa di uno stimatore corretto 𝑇 rispetto a un altro stimatore corretto 𝑇′ è dato dal

rapporto tra le loro precisioni:

𝐸𝑓𝑓

𝑇 𝑉𝐴𝑅(𝑇′)

=

𝑇′ 𝑉𝐴𝑅(𝑇)

𝜎𝑇 è più efficiente di 𝜎𝑇′ se il loro rapporto è > 1:

La media è uno stimatore più efficiente della mediana.

1⁄𝜎𝑇

1⁄𝜎𝑇′

=

1

𝜎𝑇

∗

𝜎𝑇′

1

=

𝜎𝑇′

𝜎𝑇

>1

Quando uno stimatore risulta più efficiente di qualsiasi altro si parla di efficienza assoluta.

Precisione

Uno stimatore è tanto più preciso quanto minore è la dispersione della distribuzione campionaria.

Questa caratteristica ci fornisce una stima dell’accuratezza dello stimatore, e è misurata attraverso l’errore

standard (SE): 𝐸𝑆: 𝜎⁄√𝑛

Consistenza

Uno stimatore viene definito consistente se all’aumentare della numerosità campionaria aumenta anche la

probabilità che il valore della stima (T) sia uguale al valore del parametro nella popolazione (θ). Cioè che la

distorsione B (bias) e la varianza di T tendono entrambe a 0

Una misura della consistenza è l’errore quadratico medio (MSE):

𝑀𝑆𝐸 = 𝐸(𝑇 − 𝜃)2

dove T è un generico stimatore del parametro θ

L’MSE risulta scomponibile in due parti: la varianza dello stimatore dovuta all’errore casuale (imprecisione)

e il quadrato della distorsione: 𝜎 2 (𝑇) + 𝐵2 (𝑇).

Si dice che T è consistente se l’MSE tende a 0 quando n tende a infinito

L’individuazione della funzione dei dati campionari che permette di avere una stima dei parametri è detta

naturale => vi è un reciproco tra T calcolato sul campione e θ della popolazione di riferimento

Un esempio di un estimatore naturale è la media e la varianza 𝜇 = 𝑥̅ ; 𝜎 2 = 𝑆 2

STIMA PUNTUALE

se non è possibile individuare un estimatore diretto si utilizzano degli algoritimi detti “metodi di stima” per

calcolare la stima del parametro

due di questi metodi sono:

il metodo dei minimi quadrati (MMQ)

il metodo della massima verosimiglianza (ML)

Con il metodo dei minimi quadrati (MMQ) si stima il parametro mediante quel valore che rende minima la

somma delle distanze al quadrato tra le osservazioni e il parametro stesso.

Ad esempio: se vogliamo stimare la vera lunghezza di un oggetto, sulla base di n misurazioni ( 𝑥𝑖 ) affette da

errore casuale, la stima del parametro è quel valore che minimizza la seguente espressione:

𝑛

𝑛

2

∑(𝑥𝑖 − 𝑥̅ ) = min

𝑖=1

1

𝑥̅ = ∑ 𝑥𝑖

𝑛

𝑖=1

Massima verosimiglianza (ML) (Fisher) è legato all’idea che le reali caratteristiche della popolazione

generano con diversi livelli di probabilità distribuzioni campionarie diverse.

Il metodo di stima della massima verosimiglianza funziona al contrario: dato un certo campione si cerca di

stimare quei parametri che con un grado di probabilità più elevato possono aver generato il campione

osservato.

Vado a considerare come stima di μ il valore che rende massima la probabilità di osservare quel valore =>

probabilità di un evento composto indipendente

𝑃(𝑥1 , 𝑥2 , … , 𝑥𝑛 ) = 𝑃(𝑥1 ) ∗ 𝑃(𝑥2 ) … ∗ 𝑃(𝑥𝑛 )

Se 𝑥1 , 𝑥2 , … , 𝑥𝑛 sono osservazioni campionarie di un campione casuale con reinserimento. Ogni

osservazione assume un valore che è indipendente da quello delle altre e ha una funzione di

probabilità f(𝑥𝑖 ; Θ). La densità di probabilità congiunta dell’intero campione è data da:

𝑛

𝑓(𝑥1 , 𝑥2 , … , 𝑥𝑛 ; Θ) = 𝑓(𝑥1 ; Θ) ∗ 𝑓(𝑥2 ; Θ) … ∗ 𝑓(𝑥𝑛 ; Θ) = ∏ 𝑓(𝑥𝑖 ; Θ)

𝑖=1

Mentre la funzione di verosimiglianza è data da:

𝑛

𝐿(Θ) = 𝐿(Θ; 𝑥1 , 𝑥2 , … , 𝑥𝑛 ) = ∏ 𝑓(𝑥𝑖 ; Θ)

𝑖=1

Tra i diversi valori che un parametro può assumere cerchiamo quello che ha maggiore probabilità di

aver generato i dati campionari osservati.

Per ottenere questo valore bisogna calcolare il massimo della funzione L(θ).

NB: Oltre alla stima puntuale deve essere sempre anche indicato l’errore standard della stima σT (indica

quanto la stima si discosta dal parametro). Più l’errore standard è piccolo più la stima è buona

STIMA INTERVALLARE

Nella stima puntuale non possiamo aspettarci che la nostra stima T coincida con il parametro vero θ, ma è

più lecito chiedersi qual è il grado di approssimazione che possiamo aspettarci.

Negli anni 30 Neyman propose di fare una stima intervallare ovvero individuare un intervallo “I” entro il

quale il parametro ignoto si trova con un certo grado di probabilità. Non stimiamo più il valore esatto del

parametro, ma un intervallo di valori che, con un certo grado di probabilità o fiducia, conterrà il vero valore

della popolazione.

Pertanto spesso si preferisce stimare un intervallo di valori entro i quali si ritiene sia compreso il parametro

in esame con un certo grado di “confidenza”. Questo range di valori si chiama intervallo di confidenza o di

fiducia.

I limiti dell’ intervallo (L1 , L2 ) sono detti limiti di fiducia o di confidenza; più è ampio l’intervallo maggiore

sarà la probabilità che contenga il vero valore della popolazione. L’ampiezza dell’intervallo di confidenza

dipende dal livello di probabilità (o di confidenza) che è fissato a priori dal ricercatore.

A parità di livello si significatività la precisione della stima intervallare migliora al crescere della numerosità

del campione. Fissando a priori il livello di accuratezza desiderato calcoliamo quanto deve essere grande il

campione per ottenere una stima con quel livello di accuratezza.

La procedura di stima intervallare richiede che sia verificato almeno uno dei seguenti pre-requisiti:

La variabile si distribuisca normalmente

Il campione sia sufficientemente ampio (𝑛 ≥ 30) per cui grazie al tlc (teorema del limite centrale),

la forma della distribuzione della variabile nella popolazione è indifferente

Si definisce intervallo di confidenza un range di valori costruito intorno alla stima campionaria, all’interno

dei quale, con un certo grado di probabilità sarà contenuto il vero valore del parametro della popolazione.

L’ampiezza dell’intervallo viene determinata in base a un livello di probabilità che è fissato a priori dal

ricercatore.

Il livello di probabilità che viene fissato, è definito dall’espressione 1 − 𝛼 è detto livello di significatività. I

valori più usati di α sono 0,05 e 0,01 a cui corrispondono i coefficienti di fiducia 0,95 e 0,99

Quindi la stima di 𝜃̂ è dato da : 𝜃̂ = 𝑡 ± 𝑣𝑎𝑙𝑐 𝜎𝑇

valc : valore critico, dipende dal livello di confidenza (1-α) ; il valore critico dipende dal tipo di distribuzione

della variabile. Se si tratta di una distribuzione normale utilizziamo lo z critico

data una popolazione on distribuzione di probabilità caratterizzata dal parametro θ ed estratti numerosi

campioni casuali indipendenti, si verifica che ogni campione fornisce una stima diversa e quindi l’intervallo

di fiducia è posizionato in modo diverso rispetto a θ; nell’1-α di questi intervalli sarà contenuto il valore del

parametro ignoto (θ). In pratica il ricercatore estrae uno solo di questi campioni e osserva pertanto un solo

intervallo al quale attribuisce una probabilità 1-α di contenere il vero valore di θ

stima intervallare di una media

il caso più semplice di stima intervallare riguarda la media della distribuzione di una variabile nella

popolazione con campione grande (>30) e varianza nota

il procedimento di stima di μ avviene mediante la media campionaria Xmedio ; poiché questa di

distribuisce normalmente con media μ e errore standard 𝜎/√𝑛, la probabilità di ottenere un valore

Xmedio che non si discosti da μ ±zc volte l’errore standard è data dalla seguente relazione:

𝑃 (𝑥̅ − 𝑧𝑐

𝜎

√𝑛

≤ 𝜇 ≤ 𝑥̅ + 𝑧𝑐

𝜎

√𝑛

)=1−𝛼

Il valore si z critico è connesso al valore di α prescelto (vedi tabelle)

In una distribuzione normale standardizzata il 95% dei valori è compreso tra -1.96 e +1.96

−1.96 < 𝑍 < +1.96

Dunque un IC al 95% per la media (μ) è dato da: (𝑋𝑚𝑒𝑑𝑖𝑜 − 1.96 ∗ 𝜎/√𝑛 ; 𝑋𝑚𝑒𝑑𝑖𝑜 + 1.96 ∗ 𝜎/√𝑛)

Un intervallo di confidenza al 95% è un intervallo in cui in 95 casi su 100 cadrà il vero valore della

media della popolazione. Quindi: Siamo confidenti al 95% che la media μ della popolazione è

compresa.

Per associare una probabilità ad una media campionaria calcolata su un campione con n>30 facciamo

riferimento alle tavole della normale standardizzata, poiché la distribuzione campionaria delle medie è

normale per il tlc.

La standardizzazione della media sarà fatta in riferimento ai parametri di tale distribuzione campionaria che

possono essere calcolati conoscendo quelli della popolazione. Si ricava z attraverso la seguente formula:

𝑍𝑥̅ =

𝑋̅ − 𝜇

𝑋̅ − 𝜇

= 𝜎

𝜎

⁄ 𝑛

√

Se però (come spesso accade) la varianza della popolazione è ignota, occorre stimare σ2 con la varianza

campionaria corretta 𝑆̂2

𝑆̂2 =

𝜇̂ =

𝑥̅

Stima di μ è uguale alla media

del campione

∑(𝑥𝑖 − 𝑥̅ )2

𝑛

𝑆2 =

𝑛−1

𝑛−1

𝜎

⁄ 𝑛

√

𝜎𝑥̅ =

σ della media del campione di calcola

facendo il rapporto tra σ e la radice della

numerosità del campione

𝜎̂ =

La stima di σ:

è uguale a

𝑆̂⁄√𝑛 var corretta

𝑆⁄√𝑛 − 1 var non corretta

il fatto che 𝑆̂ sia una stima di σ fa sì che la sua distribuzione di probabilità non sia più normale, ma sia

una t di student 𝑡 = 𝑧⁄ 2

√𝜒 ⁄𝜐

Pur partendo da una distribuzione normale (z) la media standardizzata si distribuisce come un t di

student. I suoi gradi di libertà sono n-1

Il valore critico va cercato nelle tavole della t di student => si usa il t critico (tc)

𝜇̂ = 𝑥̅ ± 𝑡𝑐 𝜎̂𝑥̅

La t ha code più ampie di una distribuzione normale, ma per ν>30 => t ≈ NOR (0,1)

Per gradi di libertà superiori a 30 la t di student approssima una distribuzione normale standardizzata. t è

una distribuzione usata per campioni piccoli

Bisogna distinguere due situazioni:

Campione grande e varianza nota

Distribuzione normale standardizzata

Campione grande e varianza ignota

se non conosciamo la varianza della popolazione possiamo stimarla attraverso quella del campione,

ma per costruire gli IC bisogna utilizzare la distribuzione t di Student al posto della normale

standardizzata

Campione piccolo e varianza della popolazione nota

La procedura di stima è identica al caso in cui N>30: si usa comunque la distribuzione normale

standardizzata.

Campione piccolo e varianza della popolazione ignota

Quando il campione è piccolo e non conosciamo la varianza della popolazione possiamo stimarla

attraverso quella del campione, ma per costruire gli IC bisogna utilizzare la distribuzione t di

Student al posto della normale standardizzata

La distribuzione t di student possiede le stesse caratteristiche della distribuzione normale, ma ha una forma

più schiacciata che esprime una variabilità maggiore intorno alla media.

La variabilità della media e lo schiacciamento della curva dipendono dall’ampiezza campionaria, ovvero

tanto più i campioni sono piccoli, maggiore sarà la variabilità e tanto più schiacciata risulterà la curva.

Il valore di t dipende dalla numerosità campionaria, quindi non esiste una sola distribuzione t, ma ne

esistono tante in funzione dei gradi di libertà, dati dalla quantità n-1.