Scienza e Tecnica Rendono Sicuro il Lavoro, Bragatto & Monti (a cura di) 2009 ISPESL CNR, Genova

ISBN 978-88-904413-1

Riconoscimento di volti con tecniche 3D per controlli di sicurezza

Daniela Giorgi1; Marco Attene1; Giuseppe Patanè1; Simone Marini1; Corrado Pizzi1; Silvia Biasotti1;

Michela Spagnuolo1; Bianca Falcidieno1; Lisa Usai2.

1

Istituto di Matematica Applicata e Tecnologie Informatiche - CNR, Genova (Italia)

2

Elsag-Datamat, Genova (Italia)

Sommario

Il controllo degli accessi ad aeree riservate è fondamentale per garantire la sicurezza dei lavoratori e più in

generale dei cittadini, e motiva l'uso di sistemi avanzati di identificazione basati su tecniche biometriche. Uno

studio congiunto IMATI-Elsag-Datamat dimostra che le tecniche di riconoscimento facciale basate su immagini

2D possono risentire delle condizioni di acquisizione (sensory gap), mentre l’utilizzo di modelli 3D può

garantire risultati più affidabili. Proponiamo un metodo di riconoscimento facciale che analizza modelli 3D ed è

invariante per espressioni, testandolo su un database che comprende i volti di 8 soggetti in 9 pose differenti.

1. Introduzione

Il controllo degli accessi ad aeree riservate, in luoghi di lavoro come le banche o in luoghi pubblici

come gli aeroporti, è fondamentale per garantire la sicurezza dei lavoratori e più in generale dei

cittadini. Si rende necessario, quindi, il ricorso a sistemi avanzati di identificazione biometrica,

basata sull’analisi di caratteristiche fisiche (o comportamentali) degli individui, come impronte

digitali o caratteristiche del volto. Il riconoscimento del volto, in particolare, è la modalità

raccomandata dall’ICAO (International Civil Aviation Organization) per i controlli all’imbarco in

aeroporto. Inoltre, il riconoscimento facciale è non invasivo, non richiede contatto con dispositivi

fisici, è a prova di dimenticanza (facile dimenticare una tessera o una password, difficile scordare a

casa il volto).

Con il termine riconoscimento facciale si sottintendono due diversi scenari applicativi:

l’autenticazione e l’identificazione. In entrambi gli scenari, il cuore del processo è lo stesso e

prevede la descrizione e il confronto dei modelli dei volti con tecniche opportune. Si possono,

identificare due fasi comuni: la prima corrisponde alla creazione di un database formato da

immagini e/o modelli 3D, solitamente detto galleria, contenente volti di persone conosciute; nella

seconda fase i volti delle stesse o di altre persone (detti probes) sono confrontati con quelli nella

galleria.

L’autenticazione deve accertare se la persona che chiede di accedere a una certa aerea è tra le

persone autorizzate all'accesso a quella particolare area. In questo caso il confronto avviene “uno a

uno”, in quanto il probe viene confrontato con il volto della galleria corrispondente a un'identità

precisa; l’autenticazione avviene quando la somiglianza tra due i volti supera un valore soglia

fissato.

L'identificazione serve a verificare se una persona appartiene o meno ad un gruppo, ad esempio ad

una lista di sospetti. In questo scenario il confronto è “uno a molti”, nel senso che il probe è

confrontato con i volti nella galleria per individuare quello più simile.

Le tecniche più diffuse di riconoscimento, in ambito accademico e commerciale, si basano

sull’analisi del dato 2D, cioè dell’immagine del volto acquisita tramite telecamere. Sebbene in

condizioni controllate le prestazioni di tali sistemi siano giudicate molto buone, l’affidabilità della

risposta è fortemente compromessa da condizioni avverse di illuminazione, scostamenti del

soggetto dalla posa frontale, cambi di espressione, occlusioni che interessano i landmarks utilizzati

(ad esempio le pupille, in caso di occhi chiusi o socchiusi; Busch et al. 2008, Razdan et al. 2007).

Inoltre, sistemi basati sul riconoscimento di immagini possono essere facilmente ingannati da

malintenzionati, tramite l’utilizzo di foto o video (Busch et al. 2008).

Per queste ragioni, la nostra attenzione si è rivolta all’utilizzo di dati 3D che integrino

l’informazione 2D, in modo da realizzare sistemi di sorveglianza più affidabili e che non richiedano

la presenza di personale umano. I vantaggi di utilizzare modelli 3D risiedeno nella minore

sensibilità alle condizioni di illuminazione, nell’indipendenza dalla posa, e nella capacità di fornire

informazioni su caratteristiche fondamentali della superficie del volto, come ad esempio la

curvatura (Bowyer et al. 2006).

I primi lavori sul riconoscimento facciale da modelli 3D risalgono ai primi anni ’90, ma solo dopo il

2000 il numero di lavori scientifici sull'argomento aumenta considerevolmente, come pure

diventano significativi il numero e la varietà di volti usati per le verifiche sperimentali: da dataset

aventi meno 100 modelli si è passati al Face Recognition Grand Challenge benchmark, composto da

oltre 4000 modelli, corrispondenti a più di 400 persone in pose ed espressioni sostanzialmente

differenti.

La maggior parte delle tecniche di riconoscimento facciale 3D è basata sull’utilizzo di algoritmi ICP

(Iterative Closest Point) sui modelli geometrici che rappresentano le superfici dei volti; le tecniche

ICP sono applicate all’intero volto o a sottoparti, eventualmente sovrapposte.

Molti lavori in letteratura concordano sulle potenzialità di approcci multimodali che integrino

l’informazione 2D e 3D (Bowyer et al. 2006). La maggior parte delle proposte si limita a combinare

a posteriori il contributo delle due modalità, ad esempio realizzando la fusione score-level, ossia

sommando le distanze pesate ottenute confrontando, in due fasi distinte, le immagini 2D e i modelli

3D, oppure realizzando la fusione feature-level, definendo cioè un vettore di features in cui una

parte è relativa a caratteristiche 2D e una parte a caratteristiche 3D.

2. Obiettivi

In questo lavoro vengono presentate parte delle metodologie sviluppate e dei risultati ottenuti nel

corso di una collaborazione tra IMATI-CNR (sezione di Genova) ed Elsag-Datamat, all’interno del

progetto “Multi-Trust”. Lo scopo del lavoro era indagare le potenzialità del riconoscimento facciale

con tecniche 3D per il controllo degli accessi, in relazione alle prestazioni garantite da sistemi 2D.

Ulteriori dettagli si trovano in (Giorgi et al. 2009).

Gli obiettivi del lavoro possono essere riassunti in:

o individuazione e simulazione delle problematiche del riconoscimento facciale 2D e 3D;

o sviluppo di metodi di riconoscimento 3D affidabili e robusti;

o validazione dei metodi proposti, in confronto a soluzioni esistenti.

L’analisi e la simulazione degli scenari sono due passi fondamentali per individuare le difficoltà a

cui il sistema deve rispondere, e sviluppare quindi soluzioni affidabili e robuste. Il primo obiettivo

ha dunque richiesto l’analisi preliminare delle possibili situazioni corrispondenti a scenari

applicativi reali, come cambi di espressione o di posizione della testa nei soggetti controllati,

variazioni nelle condizioni di illuminazione dell’ambiente, effetti dovuti al trascorrere del tempo tra

la fase di acquisizione dei volti in galleria e l’effettivo confronto con il probe acquisito in fase di

controllo. È stato quindi creato un database di volti in grado di simulare le situazioni sopra descritte,

da utilizzare per la validazione delle tecniche proposte.

Il secondo obiettivo richiede un’analisi dello stato dell’arte, per individuare tecniche efficaci e

direzioni promettenti. Lo studio della letteratura ha rivelato che l’inconveniente principale di molti

dei metodi esistenti è presupporre che il volto umano sia un oggetto rigido, mentre questo è un

assunto generalmente falso: i cambi di espressione deformano il volto, che non risulta mai in una

posa perfettamente neutra. Siamo quindi partiti dal metodo in (Bronstein et al. 2005) per la

costruzione di modelli invarianti per isometrie (e quindi per cambi di espressione) e abbiamo

apportato delle modifiche per rendere il metodo più efficace ed efficiente.

Infine, abbiamo validato i risultati del metodo 3D da noi sviluppato confrontandoli con le

prestazioni di COGNITEC, noto sistema commerciale per il riconoscimento facciale.

2

3. Materiali e Metodi

3.1: Creazione del database

Un database di modelli 3D di volti umani è stato acquisito mediante l’impiego del “Non-contact 3D

digitizer VIVID 910” della Konica-Minolta, in dotazione all’IMATI-CNR di Genova. Si tratta di

uno scanner tridimensionale che usa come metodo di scansione uno specchio galvanometrico ad

alta precisione. E’ stata definita una configurazione standard dei parametri della macchina da

utilizzare per le acquisizioni, in modo da ottenere dati omogenei dal punto di vista della qualità e

della modalità di acquisizione, e da rispettare alcuni requisiti specifici. Si richiede infatti che

l'acquisizione dei dati avvenga mediante un'unica scansione; la distanza di scansione sia intorno ai

60 cm (tra 50 e 100 cm); l'output prodotto presenti almeno 100 punti/pixel per distanza

interpupillare; l'output offra la massima qualità possibile compatibile con le richieste precedenti.

Pertanto è stato deciso di utilizzare l'ottica MIDDLE (f=14mm) a una distanza di circa 80 cm dal

soggetto e di applicare come unico filtro sui dati il cosiddetto “Fill holes”.

La sperimentazione prevede l'analisi di modelli di volto con caratteristiche eterogenee dal punto di

vista dei problemi tipici del riconoscimento facciale. A questo scopo, i soggetti sono stati acquisiti

in differenti pose, espressioni e condizioni di illuminazione, e a distanza di intervalli di tempo, in

modo da simulare specifici scenari e testare i limiti ed i pregi dei metodi di analisi impiegati. Sono

state quindi effettuate varie sessioni di acquisizione, ed è stato costruito un database da utilizzare

nella fase di testing. Ciascuna scansione ha richiesto 2.5 secondi per soggetto, per ottenere

immagini 640x480; è prevista la collaborazione del soggetto.

In una prima sessione di scansioni, è stato costruito un set S1 che ha coinvolto 8 persone, per

ciascuna delle quali sono state considerate 4 diverse pose (per un totale di 32 modelli). Le pose

prevedono una rotazione della testa di 45 gradi. In particolare, per ciascun soggetto sono state

scansionate le seguenti 4 pose:

o posa frontale, espressione neutra;

o volto rivolto verso l'alto (max 15 gradi), espressione neutra;

o volto rivolto verso il basso (max 15 gradi), espressione neutra;

o volto rivolto verso destra (max 15 gradi), espressione neutra.

Questa prima sessione di scansioni fornisce un primo campione rappresentativo di situazioni che

possono verificarsi nello scenario applicativo di interesse, legato al controllo degli accessi in aree

riservate. Per simulare poi ulteriori situazioni che possono presentarsi in situazioni reali, abbiamo

costruito un secondo set di modelli S2, in cui intervengono condizioni avverse al riconoscimento, sia

con tecniche 2D che 3D. In particolare, abbiamo scansionato le stesse 8 persone del set S1, ma con 5

diverse pose che includono sia espressioni differenti (problema riconosciuto in letteratura per i

metodi 3D) sia condizioni di illuminazione estreme (che possono creare problemi a tecniche 2D).

Le caratteristiche del set S2 sono quindi le seguenti:

o posa frontale, espressione neutra, illuminazione centrale + laterale;

o posa frontale, occhi rivolti verso il basso, illuminazione centrale + laterale;

o posa frontale, sorriso, illuminazione centrale + laterale;

o posa frontale, espressione a scelta del soggetto (non neutra), illuminazione centrale +

laterale;

o posa frontale, espressione neutra, illuminazione fortemente laterale.

Il dataset S utilizzato per la sperimentazione finale è costituito dall'unione di S1 e S2, per un totale di

72 modelli (8 soggetti in 9 pose differenti). Oltre alle variabili discusse in precedenza (variazioni di

posa, espressione, illuminazione), l'aver acquisito modelli degli stessi soggetti in due diversi

momenti permette di simulare anche lo scenario in cui il riconoscimento deve avvenire a distanza di

tempo, cioè tra un volto appena acquisito e quello memorizzato in precedenza in un database.

Per ciascun soggetto in S sono stati memorizzati nel database sia l’immagine 2D sia il modello 3D.

Un esempio è mostrato in Figura 1.

3

Figura 1

I dati grezzi generati dallo scanner laser consistono in matrici di punti 640x480. Ad ogni punto

corrisponde una tripla di coordinate (x,y,z) ed un colore. In altre parole, la matrice consiste nella

fusione tra i dati spaziali e una tessitura. I dati grezzi generati dallo scanner (file di formato

proprietario cdm) sono stati quindi elaborati al fine di produrre una triangolazione rappresentante la

superficie del volto.

A questo scopo è stato implementato il software “cam2trimesh”. Cam2trimesh carica il file cdm e

costruisce una triangolazione di Delaunay nel piano dei punti validi dell'immagine, ossia dei pixel a

cui corrisponde una distanza rilevata con successo. Successivamente, i vertici della triangolazione

vengono riportati nelle loro posizioni originali e si genera pertanto un modello 2.5D. In questo

modo le regioni in cui non e' stato possibile acquisire dati validi (per luce riflessa, capelli, o

quant'altro) sono riempite con triangoli che interpolano linearmente i dati validi. Chiaramente,

questa soluzione produce dati artificiosi, qualora la posa del volto sia molto diversa da quella

frontale. Cam2trimesh permette anche di specificare una finestra di dati da utilizzare per la

creazione della triangolazione. Questa possibilità può essere sfruttata al fine di inquadrare il volto, e

quindi di tagliare fuori eventuali porzioni di busto o di parete.

Il riconoscimento 3D impone requisiti particolari relativamente alle superfici poligonali dei volti da

confrontare, ovvero continuità, bordo non frastagliato, posa frontale. E' stato perciò necessario

sviluppare un sistema per l'elaborazione delle triangolazioni grezze al fine di estrarre un modello

del volto “tipo maschera” con le caratteristiche sopra elencate. A questo scopo è stato adattato un

software chiamato "posenormalizer" (Ter Haar et al. 2007) sviluppato da Frank Ter Haar

dell'Università di Utrecht (Olanda) per la cosiddetta pose normalization dei volti 3D, ossia per il

calcolo di una matrice di trasformazione che porti il volto ad essere rivolto verso la direzione Z del

proprio sistema di coordinate. La matrice calcolata, inoltre, induce una traslazione del modello in

modo che la punta del naso sia posizionata nell'origine. Il calcolo della matrice è completamente

automatico ed è basato sul metodo “best-fitting” rispetto a un modello di volto universale (Blanz et

al. 2005) prodotto da Volker Blanz del Max Plank Institut fur Informatik (Germania).

Potendo assumere la posa frontale del soggetto, è stato possibile implementare un ulteriore software

chiamato “geocrop” per la conversione di triangolazioni grezze in maschere da utilizzare per il

confronto 3D-3D. Geocrop carica la triangolazione e la matrice di rototraslazione prodotta con il

software precedentemente descritto. Dopo aver trasformato la triangolazione in input in base alla

matrice, essa viene ritagliata attraverso una circonferenza geodetica centrata sulla punta del naso e

di raggio pari a 10 cm. Sulla superficie ritagliata viene effettuata una riduzione del rumore tramite

filtraggio Laplaciano.

Il software per la preparazione dei dati è stato realizzato su piattaforma MS Windows, in ambiente

Visual C++ 2005 Express Edition, facendo uso delle SDK rilasciate da Konica-Minolta per il

trattamento dei file generati dallo scanner e delle API JMeshLib (http://jmeshlib.sourceforge.net) e

trimesh2 (http://www.cs.princeton.edu/gfx/proj/trimesh2/) per il trattamento delle triangolazioni.

Le diverse fasi di preparazione dei dati sono illustrate in Figura 2: dalla nuvola di punti alla

triangolazione (1), al modello in posa frontale (2), alla maschera finale (3).

4

Figura 2

3.2: Descrizione e confronto di modelli di volti 3D

Il problema della descrizione e confronto di volti 3D soggetti a deformazioni per cambi di

espressione è affrontato in (Elbaz et al. 2003, Bronstein et al. 2005). L’idea alla base del metodo è

quella di generare, a partire da un modello facciale originale, un nuovo modello che sia invariante

rispetto alle espressioni. L’ipotesi è che la distanza geodetica (cioè la lunghezza del cammino più

breve tra due punti sulla superficie del volto) tra punti del viso rimane pressoché invariata nei cambi

di espressione. Il nuovo modello è quindi generato tramite un'immersione regolare isometrica della

superficie nello spazio euclideo, basata sul calcolo delle distanze geodetiche tra punti del volto e su

un algoritmo MDS (Multi-Dimensional Scaling).

In sintesi, gli algoritmi MDS prendono in input una matrice di distanze tra oggetti, e calcolano delle

nuove coordinate per gli oggetti in uno spazio euclideo, tali che le distanze euclidee tra i nuovi punti

approssimino in maniera ottimale le distanze originali tra gli oggetti. Nel nostro caso, a partire da

una matrice di distanze geodetiche fra punti del volto, si crea un nuovo modello nello spazio

euclideo tridimensionale (immersione regolare), tale che le distanze euclidee tra i punti

dell’immersione approssimano in maniera ottimale le distanze geodetiche tra i punti originali.

Poiché i cambi di espressione non modificano le distanze geodetiche, modelli dello stesso volto con

diverse espressioni forniranno pressoché lo stesso input all’algoritmo MDS, che quindi restituirà

immersioni pressoché uguali nello spazio euclideo. Questo permette di utilizzare metodi di

confronto pensati per oggetti rigidi per confrontare modelli soggetti a deformazioni come quelle

indotte dalle espressioni.

La Figura 3 mostra un volto con tre espressioni differenti e le immersioni corrispondenti.

Figura 3

La costruzione dell'immersione isometrica prevede quindi due passi principali:

o semplificazione uniforme del modello M in input a k punti, e calcolo della matrice kxk G

delle distanze geodetiche tra i k punti: G = (gij)i,j=1,…,k con gij la distanza geodetica tra i punti

pi, pj di M;

o calcolo dell’immersione E di M tramite MDS, partendo dalla coppia (M,G) e utilizzando uno

schema iterativo rapido.

Rispetto allo stato dell'arte ed implementazioni sia commerciali che freeware, il modulo da noi

proposto include come elementi distintivi:

o due metodi per il calcolo delle distanze geodetiche: algoritmo di Dijkstra (Dijkstra 1959) e

fast marching (Sethian 1996);

o il calcolo ottimale del MDS, dove le matrici impiegate e le relative fattorizzazioni sono

precalcolate formalmente una sola volta ed utilizzate per l'intero database di modelli;

supponendo di utilizzare k punti per il calcolo dell'immersione di ciascun modello, il modulo

utilizza O(k2) occupazioni di memoria per l'intero database, indipendentemente dal numero

dei suoi elementi, e O(k) per ciascun confronto.

5

A dispetto dell’accuratezza e del dettaglio delle fasi di acquisizione, processing e immersione, in

(Elbaz et al. 2003) la fase di confronto riceve scarsa attenzione: gli autori sostengono che qualsiasi

metodo di confronto tra oggetti rigidi possa funzionare, ad esempio i momenti geometrici in (Elad

et al. 2001). Questa scelta contrasta con l’idea che c’è in letteratura che i momenti geometrici siano

instabili e poco discriminanti; gli esperimenti da noi effettuati confermano questa ipotesi. La nostra

idea è che la parte valida e interessante del metodo basato su MDS sia appunto la costruzione

dell'immersione isometrica, che permette di gestire i cambiamenti del volto dovuti a cambi di

espressione più o meno visibili; al contrario la parte relativa al confronto di tali immersioni con

momenti geometrici non sembra essere particolarmente robusta, oltre che poco dettagliata.

La soluzione da noi trovata è quella di utilizzare le immersioni come input per il calcolo di un

descrittore più robusto: abbiamo quindi scelto le Spherical Harmonics (SH), da calcolare

direttamente sulle immersioni, in modo da combinare i vantaggi di entrambe le tecniche. Il calcolo

delle SH segue la descrizione originale in (Kazhdan et al. 2003) e utilizza l’implementazione

disponibile sul sito http://www.cs.jhu.edu/misha/. Il descrittore consiste in un vettore di

coefficienti, che corrispondono alle frequenze armoniche di funzioni sferiche definite sul modello.

In dettaglio, si considera un insieme di sfere concentriche centrate nel baricentro del modello, e su

ciascuna sfera si definisce una funzione reale. Ad ogni funzione viene associato un vettore di

numeri reali, che rappresentano i coefficienti della decomposizione in armoniche sferiche della

funzione. L’insieme dei vettori per ciascuna sfera dà luogo ad una matrice bi-dimensionale di

numeri reali, i cui elementi sono indicizzati dal raggio della sfera e dalla frequenza.

Il calcolo delle SH può essere riassunto nei seguenti punti:

o il baricentro del modello viene traslato nell'origine del sistema di riferimento del modello,

che viene scalato rispetto alla distanza media dei punti dal baricentro;

o il modello viene campionato inserendolo in una griglia tridimensionale; la griglia viene

decomposta in un insieme di sfere concentriche di raggio r variabile;

o ad ogni elemento della griglia viene associato il valore 1 se l'elemento interseca la superficie

del modello e 0 se l'elemento è vuoto;

o per ciascuna sfera, i valori associati alla griglia definiscono una funzione sferica fr; si ottiene

quindi un insieme di funzioni sferiche, indicizzate dal raggio r della sfera corrispondente;

o ogni funzione fr può essere decomposta in armoniche sferiche, cioè espressa come somma

di differenti frequenze; i coefficienti associati alle corrispondenti frequenze danno luogo ad

un vettore vr;

o l’insieme dei vettori vr associati ciascuna sfera dà luogo ad una matrice V.

La distanza tra due immersioni E1, E2 si calcola quindi come la norma L2 tra le matrici V1, V2

associate ai due modelli.

4. Risultati

In questa sezione vengono presentati i risultati ottenuti nell'ambito del riconoscimento facciale dal

metodo di confronto 3D descritto nella sezione precedente. Tali risultati sono confrontati con quelli

ottenuti dal software COGNITEC a disposizione di Elsag, impiegato in due diverse modalità: la

prima utilizza esclusivamente dati di tipo 2D, cioè le immagini dei volti, mentre la seconda impiega

sia il dato 2D sia il dato 3D ottenuto dalle scansioni. Il set S di dati utilizzato è composto da 72

facce (8 individui in 9 pose differenti), come descritto nella Sezione 3.1. Durante la fase

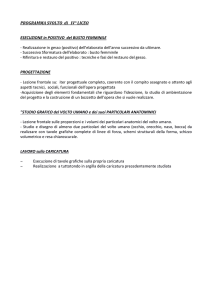

sperimentale è stato però osservato che il software COGNITEC non è riuscito a processare 4

immagini, mostrate in Figura 4, probabilmente poiché non è riuscito ad individuare le pupille dei

soggetti nella foto. Tali immagini sono quindi state rimosse dal database, insieme con i

corrispondenti dati 3D. I dati riportati in seguito si riferiscono quindi ad un database con un totale di

68 facce, in cui 4 degli 8 individui sono presenti con 9 diverse pose, mentre i restanti 4 con 8 pose.

6

Figura 4

Per ciascun metodo, è stata costruita una matrice di dissimilarità, in cui all'entrata (i,j) corrisponde

la valutazione della differenza tra la i-esima e la j-esima faccia. La valutazione della performance è

basata sull'analisi del grafico precision-recall, che mostra la precisione standard (riportata in

ordinata) rispetto alla funzione recall standard (riportata in ascissa). La precisione rappresenta la

percentuale di elementi rilevanti (veri positivi) tra gli elementi restituiti dal sistema, mentre la

funzione recall rappresenta la percentuale di elementi rilevanti (veri positivi) restituiti dal sistema

sul totale dei rilevanti. Questi parametri descrivono quindi l'abilità di un metodo nell'identificare i

modelli rilevanti (nel nostro caso le facce di uno stesso individuo in diverse pose o acquisizioni) e

allo stesso tempo ridurre i falsi positivi. Osserviamo che a performance migliori corrispondono

linee del grafico spostate verso l'alto e verso destra.

Il grafico in Figura 5 riporta i risultati ottenuti dal software COGNITEC nelle due modalità 2D e

2D+3D, e le curve relative alle SH calcolate sui modelli originali, sui modelli semplificati a 2000

vertici, e sulle immersioni ottenute tramite MDS.

Figura 5

Si può osservare che, sul database considerato, l'aggiunta dell'informazione 3D permette a

COGNITEC di ottenere risultati migliori rispetto all'utilizzo esclusivo dell'informazione 2D. La

sperimentazione delle SH su modelli con ordini di grandezza diversi per il numero dei vertici è

volta a verificare l'eventuale degrado delle performance al variare della risoluzione del modello, per

cercare il miglior compromesso possibile tra risultati e tempi di calcolo. Le prestazioni delle SH sui

modelli originali e sui modelli semplificati sono molto simili, a conferma della robustezza del

metodo rispetto alla risoluzione e al livello di dettaglio del modello. Il risultato migliore è ottenuto

calcolando le SH sulle immersioni isometriche. Tali immersioni sono infatti costruite per ottenere

invarianza rispetto a deformazioni del volto, dai piccoli movimenti dei muscoli facciali – è noto che

la posa del volto non è mai perfettamente neutra (Bronstein et al. 2005) – ai cambi di espressione

più evidenti. L'utilizzo combinato di un input invariante e di un metodo di confronto efficace

permette quindi di avere le prestazioni migliori. La Tabella 1 mostra il Verification Rate versus

0.1% Acceptance Rate.

7

Tabella 1

COGNITEC 2D

VR: 67.6%

COGNITEC 2D+3D

88.1%

SH embedded

91.6%

5. Conclusioni

Dall’analisi dei dati, emerge l’idea che il riconoscimento facciale 2D sia ormai maturo per garantire

ottimi risultati in condizioni controllate, ma abbia dei limiti intrinseci, legati alla perdita di

informazione nel passaggio da dati 3D a immagini 2D, ma soprattutto alle condizioni di

acquisizione delle immagini dei volti. Si è visto ad esempio che condizioni avverse di illuminazione

compromettono le performance di metodi basati su immagini, fino alla totale mancanza di una

risposta da parte del sistema.

L’analisi del dato 3D ha buone potenzialità per sopperire ai fallimenti dell’analisi 2D dovuti al gap

sensoriale, poiché dispone di informazioni più complete. Bisogna comunque notare che, se il

riconoscimento di volti da immagini ha una lunga storia e una vasta letteratura disponibile, è solo da

pochi anni che si è iniziato ad esplorare l’utilizzo di tecniche di riconoscimento 3D. Questo vuol

dire che c’è spazio per miglioramenti, legati sia all’efficienza che all’efficacia di tali tecniche.

In prospettiva, sistemi integrati 2D+3D promettono un sensibile miglioramento nelle procedure di

verifica automatica dell’identità per il controllo degli accessi. L’affidabilità sarà infatti maggiore in

caso di condizioni ambientali avverse al riconoscimento o in caso di utenti non collaborativi o

intenzionati ad ingannare i sistemi. L’impatto della ricerca sarà tanto maggiore quanto più le nuove

metodologie di riconoscimento saranno supportate da avanzamenti nei sistemi di acquisizione dei

dati, con sensori accurati, rapidi, e sicuri, e nei sistemi di protezione dei template biometrici.

Referenze

Blanz V.; Scherbaum K.; Seidel H.-P. Fitting a Morphable Model to 3D Scans of Faces. Proc. Int. Conf. on Computer

Vision ICCV, 2007.

Bowyer K.W.; Chang K.; Flynn P. A survey of approaches and challenges in 3D and multi-modal 3D+2D face

recognition. Computer Vision and Image Understanding, 2006 101(1) 1-15.

Bronstein A.M.; Bronstein M.M.; Kimmel.R. Three-dimensional face recognition. International Journal of Computer

Vision, 2005 64(1) 5-30.

Busch C.; Nouak A. 3D face recognition for unattended border control. Security and Management, 2008, 350-356,

CSREA Press.

Dijkstra E.W.. A note on two problems in connection with graphs. Numerical Mathematics, 1959 24(1) 269-271.

Elad M.; Tal A.; Ar S. Content based retrieval of VRML objects - An iterative and interactive approach. EG

Multimedia, 2001, 97-108.

Giorgi D.; Attene,M.; Patanè G.; Marini S.; Pizzi C.; Biasotti S.; Spagnuolo M; Falcidieno B.; Corvi M.; Usai L.;

Roncarolo L.; Garibotto G. A critical assessment of 2D and 3D face recognition algorithms. 6th IEEE International

Conference on Advanced Video and Signal Based Surveillance, 2009

Kazhdan M; Funkhouser T.; Rusinkiewicz S. Rotation invariant spherical harmonic representation of 3D shape

descriptors. Proc. EG Symposium on Geometry Processing, 2003,156–65.

Elbaz A.E.; Kimmel R. On bending invariant signatures for surfaces. IEEE Trans. on PAMI, 2003 25(10) 1285--1295

Razdan A.; Farin G.; Soo-Bae M.; Chaudhari M. State of 3D face biometrics for homeland security applications.

Handbooks in Information Systems, 2007, Vol. 2.

Sethian J.A. A Fast Marching Level Set Method for Monotonically Advancing Fronts. Proc. Nat. Acad. Sci., 1996 93(4)

1591—1595.

Ter Haar F.B.; Veltkamp R.C. A 3D Face Matching Framework. Technical Report UU-CS-2007-04.

Ringraziamenti: lavoro parzialmente supportato dal progetto EU FP7 FOCUS K3D e dal contratto di ricerca tra Elsag

e IMATI-CNR (Ge) su ”Multitrust: multi-biometry for applications to security”.

8