Università degli Studi di Sassari

Facoltà di Agraria

DIPARTIMENTO DI SCIENZE ZOOTECNICHE

Corso di laurea in Scienze Zootecniche

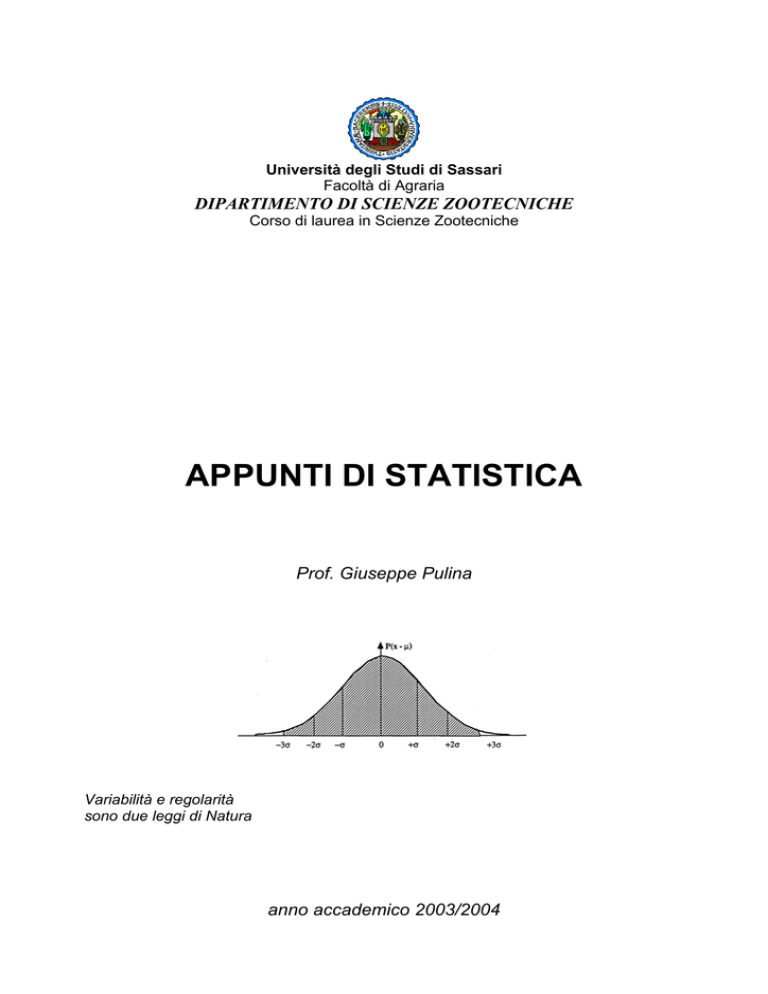

APPUNTI DI STATISTICA

Prof. Giuseppe Pulina

Variabilità e regolarità

sono due leggi di Natura

anno accademico 2003/2004

Caso e Necessità

La vita è breve

ma i conti possono essere

molto, molto lunghi.

J. Barrow

Una fredda mattina di marzo il signor Caso incontrò la signorina Necessità. Appena riconosciutola, egli si

esibì in un perfetto inchino, Buongiorno Signorina, che piacere incontrarla, squillò con un largo sorriso.

Buongiorno a lei, ribatté ella niente affatto sorpresa, A dirle la verità mi aspettavo questo incontro.

Eh, fece con fare ammiccante lui, Da quando la conosco lei ha sempre previsto i nostri incontri che per me

restano, mi lasci dire, così sorprendentemente aleatori. Scusi, aggiunse facendosi serio, Dove starebbe il

piacere della sorpresa nel vedere un conoscente se tutto fosse sempre rigidamente programmato?

La signorina tacque quasi rapita dall'abbigliamento disarmante del suo interlocutore. Per quanto si

sforzasse di ricordare, non l'aveva mai visto conciato con un minimo di raziocinio. Le scarpe spaiate

facevano letteralmente a botte con la cravatta indossata in barba ai più elementari principi di accostamento

dei colori e delle forme. Non solo quest'uomo non ha uno stile ben definito, pensò turbata, Ma

semplicemente non ha uno stile. Sinceramente, mi riuscirebbe difficile formulare gli accostamenti

strampalati che ogni volta gli ho visto indossare.

Da parte sua lei sembrava l'immagine della perfezione. Non un ciuffo fuori posto, non un filo negli abiti, non

un colore che non fosse perfettamente intonato con gli altri. Del modo di essere dell’uomo ciò che lei

sopportava meno era quel suo vizio di giocare perennemente con una monetina, lanciandola per aria e

costernandosi ogni volta per la faccia che questa mostrava nel ricadergli sul palmo della mano. E la smetta

un attimo! sbotto. Le ho detto tante volte che mi innervosisce... Scusi, davvero... rispose il signor Caso,

riponendo velocemente la moneta nelle ampie tasche del soprabito. Ma anche la sua manìa di giocare a

scacchi non appena si trova sotto mano una scacchiera non è meno fastidiosa. Tanto, sa, anche in un gioco

così rigorosamente determinato c’è un minimo di casualità. E quale sarebbe? ribatté piccata. Ma la scelta

del colore con cui giocare, naturalmente, esattamente come per la faccia della mia moneta. La differenza è

che io poi non perdo altro tempo per sapere come va a finire! concluse ridacchiando. La signorina

ammutolì. Era inutile continuare a discutere con costui o sarebbe andata come le altre volte, cioè male.

Due corvi schioccarono l’aria rincorrendosi fra i tetti. Necessità si scosse da questi pensieri e decise di

cambiare discorso, Cosa diceva a proposito dell’incontro? Non ci sarebbe gusto? Lei, nel suo sommo

disordine mentale e materiale che io paragono soltanto a quello di cui è capace suo cugino il signor Caos

che conosco bene, non capisce che questo mondo funziona soltanto perché siamo capaci di formulare

previsioni certe circa il futuro. Cosa succederebbe se dato un appuntamento ci si scordasse

sistematicamente ora e luogo da parte dei convenienti? Sarebbe il caos, appunto, concluse mentre scorgeva

un'ombra sinceramente interrogativa sul volto di lui. Ah, mi scusi, aggiunse, Dimenticavo che lei non

rispetta mai un appuntamento, ma si sa che lei è un gran smemorato...

Il silenzio si impadronì della strada, mentre un grappolo di nuvole nere frastagliava il cielo in sprazzi di

sole e di piovaschi. I due camminarono per un lungo tratto in silenzio riparandosi sotto i balconi per

sfuggire agli improvvisi scrosci di pioggia.

La signorina Necessità prese l'uomo sottobraccio, quasi per proteggersi dalle improvvise intemperie, e lui la

vide per la prima volta, bellissima nella sua perfezione e, quasi, si vergognò del suo aspetto vagamente

trasandato. Gli vennero in mente le parole della madre Alea, Figlio mio, tu hai bisogno di una donna

ordinata. Cercala subito, altrimenti finirai come tuo cugino che è tanto disordinato che non gli si avvicina

più nessuna ragazza per bene. Avrei bisogno di una donna, sussurrò quasi fra se, e lei, che lo aveva già

scelto, gli strinse l'avambraccio.

Finirono in un caffè, a raccontarsi due vite diversissime e a capire come potesse vivere uno senza aspettarsi

nulla dal futuro e l'altra sapendo esattamente quello che sarebbe successo comunque, ma l'amore unisce gli

impossibili e finirono per sposarsi, non senza che lei producesse uno sforzo straordinario anche per averlo

all'altare il giorno convenuto.

Ebbero una figlia bellissima, alla quale misero il nome di Statistica .

2

LEZIONE n. 1

LA STATISTICA

1. Cosa é la statistica e a cosa serve.

Uno degli aspetti più rilevanti di un corso di statistica di base é quello di definire in modo

comprensibile l’oggetto dello studio e l’utilizzo dello strumento che si va ad acquisire.

La mancata o imprecisa risposta a queste due domande porta ineluttabilmente da un lato a costruire

una disciplina su un terreno paludoso (la non comprensione dei fondamenti della statistica) e

dall’altro alla disaffezione degli studenti (la non finalizzazione dello studio).

In questo nostro corso dedicheremo molto spazio alla discussione su cosa sia e a cosa serva la

statistica. Innanzitutto cerchiamo di non confondere le due cose: non é sufficiente sapere a cosa

serve un oggetto per sapere che cosa é l’oggetto.

Per questo motivo iniziamo da capo (proprio da capo).

Gli oggetti fondamentali di cui si occupa la statistica sono le entità. Queste sono le cose che

popolano il mondo esterno e il mondo esterno é ciò che é fuori di noi e che possiamo osservare. Di

solito non facciamo distinzioni fra entità che popolano il mondo esterno e quello interno, ma le

entità della nostra mente di solito ci servono per riconoscere quelle del mondo esterno. Il concetto

di entità é appreso di solito nella prima infanzia quando organizziamo gli stimoli che entrano dal

mondo esterno nella nostra testa classificandoli in differenti tipi. Ad esempio, il bambino impara

molto precocemente a conoscere entità che hanno due occhi, un naso, una bocca, dei capelli e che le

entità “madre”, “padre”, “fratello” e altre simili hanno le stesse caratteristiche. Il bambino classifica

così tutte le entità simili per queste caratteristiche nel tipo “persone” e questa capacità di classificare

(riconoscere) entità con tali caratteristiche non lo abbandonerà per tutta la vita. Questo processo é

analogo per tutte le entità e rappresenta il livello più profondo della capacità di apprendimento

dell’uomo (e in parte anche degli animali superiori). Raggruppare le entità entro tipi, infatti,

semplifica enormemente la vita in quanto siamo capaci di riconoscere che tutte le entità

appartenenti allo stesso tipo hanno molte cose (proprietà) in comune.

Le entità non sono solo oggetti (o soggetti) materiali. Possono essere anche manifestazioni di

fenomeni (febbre, file di internet, tempo metereologico, ecc) oppure qualsiasi altra cosa a cui possa

essere attribuito un “nome”.

L’insieme delle entità classificate entro lo stesso “tipo” prende il nome di popolazione. Questo

termine é molto importante: la statistica infatti si occupa non della singola entità, ma dell’insieme

delle entità raggruppate per tipo, cioè della popolazione.

3

Ma come facciamo a classificare le entità entro le popolazioni?

A ciascuna entità é associato un insieme di proprietà. Ad esempio, a ciascuna persona sono

associate migliaia di proprietà, due delle quali sono “il peso” e “l’altezza”.

Per ogni particolare entità, ciascuna delle sue proprietà ha un valore. Ad esempio, all’entità

Giuseppe Pulina, della popolazione uomini italiani, sono, tra le molte, associati i valori di 176 cm

per la proprietà altezza e di 74 kg per la proprietà peso corporeo. Il valore di una proprietà può

essere espresso in numeri, in parole oppure in simboli. Ad esempio, l’entità succitata G.P. presenta i

valori delle seguenti proprietà: 43 per la misura di scarpe, Sardo per l’appartenenza regionale,

0RH+ per il gruppo sanguigno. Noi possiamo individuare una entità mediante i valori delle sue

proprietà: maggiore é la popolazione per ciascuna proprietà, maggiori sono le proprietà che

dovremo considerare nel processo di individualizzazione di una entità.

I valori delle proprietà delle entità di solito variano da una entità all’altra, ma a volte anche nella

stessa entità con il passare del tempo. Se una proprietà non presenta valori che variano (sono

costanti) essa non é di alcun aiuto nel processo di individualizzazione dell’entità.

Un esempio (semiserio): una monaca si reca a trovare un monaco in un monastero, ma non ricorda

il nome. Il padre portinaio le chiede di descrivere il soggetto per poterlo individuare. La monaca ci

pensa e risponde che veste una tonaca bruna, ma il padre replica che “tutti “ i monaci vestono una

tonaca bruna (proprietà costante)! Allora la monaca aggiunge che il monaco ha una cintura di

corda, ma anche in questo caso non é possibile individuarlo perché tutti i monaci portano cinture

di corda. Anche le altre proprietà via via riportate dalla monaca (capelli tagliati con la chierica,

breviario in mano, barbetta rada sotto il mento) non sono utili, in quanto tutto i monaci presentano

gli stessi valori di queste proprietà. Alla fine, spazientita, la monaca sbotta “ha 28 nei sulla

schiena!!”. A quel punto il padre portinaio si illumina: “Ma é padre Febbraio! Con 28 ce n’é uno,

tutti gli altri ne hanno 31!”.

Questa storiella dimostra che ai fini delle conoscenza (in tal caso anche biblica) é importante che le

proprietà delle entità oggetto di studio siano variabili.

La determinazione del valore delle proprietà viene eseguita mediante rilevazione empirica con gli

“strumenti di misura”. Se lo strumento funziona correttamente, esso ci darà una stima del valore

della proprietà di una determinata entità al tempo della misurazione. Ad esempio se noi volessimo

conoscere il (valore del) peso (proprietà) di una persona (entità), noi applichiamo alla persona uno

strumento di misura del peso (bilancia) e lo strumento ci restituisce il valore che (in kg) rappresenta

la stima del peso della persona. Anche nel caso di proprietà esprimibile come categorie (proprietà

categoriali) si applica uno strumento per ottenere una stima del valore. Ad esempio, nella

“misurazione” del genere di una persona, si applica lo strumento “vista” e, dall’insieme delle

4

caratteristiche osservabili, si ottiene la risposta “maschio” o “femmina”. Ma anche in questo caso vi

può essere un (seppure remoto) errore, come dimostra una sterminata aneddotica sui travestiti.

La conoscenza scientifica del mondo e la sua applicazione tecnologica, sono basate sulla ricerca

empirica.

La ricerca empirica é ciascuna attività in cui i valori delle proprietà delle entità oggetto di studio,

sono raccolti mediante l’esperienza (esperimento) e le cui conclusioni sono tratte esclusivamente

dai dati raccolti in quell’area di esperienza.

La ricerca empirica usa gli strumenti per determinare i valori delle proprietà. L’insieme dei valori

raccolti per ciascuna proprietà, chiamati anche dati (ossia ciò che é prima di qualsiasi

manipolazione), appartiene ad una variabile.

Una variabile é allora definibile come la

rappresentazione formale di una proprietà di entità.

Ad esempio, la proprietà “altezza” delle persone é una variabile detta appunto “variabile altezza”; la

proprietà “genere” di una parte degli esseri viventi é la “variabile genere” (anche se assume solo 2

valori, maschio o femmina); la proprietà “colore della facciata” delle case é la “variabile colore

della facciata delle case” che può assumere infiniti valori nominali (tanti quanti sono i colori e le

loro sfumature).

Le variabili sono costituite da valori: esse sono definite “continue” se possono assumere qualsiasi

valore nel campo della loro esistenza, discrete se possono assumere solo valori discontinui. Ad

esempio, la variabile “altezza di una persona adulta” può assumere qualsiasi valore nel campo della

sua esistenza (da 50 ai 250 cm), ma non il valore di 1000 cm! La variabile “appartenenza regionale

di un italiano” può assumere solo uno dei 20 valori corrispondenti alle regioni d’Italia, ma nessun

valore intermedio. Gli statistici amano denominare variante il “singolo valore” di una variabile: il

dato 176 cm di (misura della ) altezza (proprietà) di Giuseppe Pulina (entità) é una variante della

variabile “altezza”.

Ogni ricerca sperimentale produce dati. I dati possono essere utilizzabili se sono organizzati in

tabelle. Ciascuna riga della tabella é associata con una entità del tipo che stiamo studiando.

Ciascuna colonna della tabella é associata a una proprietà delle entità costituenti la popolazione.

Ad esempio, se stiamo studiando la produzione giornaliera di latte e il contenuto di grasso e

proteine allo scadere del terzo mese di lattazione delle pecore di compare Bastiano (ovini di razza

Sarda), possiamo programmare un esperimento in cui andiamo a rilevare la produzione individuale

di ciascuna mungitura (raccogliamo il latte di ciascuna pecora in un contenitore a tara nota e lo

pesiamo) e preleviamo un campione di latte su cui eseguiamo le analisi chimiche in laboratorio.

5

variabili = valori delle proprietà

della popolazione

Popolazione

di entità

Pecora

Latte g

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

1015

1105

1365

1085

840

960

1130

1185

1270

1385

1545

1475

1350

1145

1195

1185

1000

795

1105

1560

1340

1005

1260

1035

1300

Grasso %

Proteine %

6,54

5,18

7,44

5,75

7,62

5,69

8,55

5,42

7,57

5,77

5,81

5,26

8,34

5,78

7,11

6,09

6,46

5,16

6,59

5,23

7,53

5,24

6,97

5,34

5,98

4,82

6,39

5,3

7,49

6,04

7,4

5,24

7,16

6,11

7,41

6,24

8,56

5,69

7,76

5,73

6,41

5,45

8,05

5,04

6,43

5,03

6,99

5,66

7,17

5,46

Valori delle

proprietà

della entità n.

1

Possiamo facilmente notare che la popolazione di 25 pecore (il gregge di compare Bastiano) e

definita dalle proprietà produzione di latte, grasso e proteine in % al terzo mese di parto degli

animali.

La tabella ci da una prima visione del fenomeno, ma ci informa anche sul “piano sperimentale”

usato: il piano sperimentale, in questo caso, é consistito nel rilevare le produzioni di latte, grasso e

proteine di ciascuna pecora (vi sembrerà banale, ma vedremo in seguito che non lo é affatto).

A questo punto possiamo dare una risposta alla domanda “a che cosa serva la statistica?”

Lo scopo principale di una ricerca empirica é quello di predire e controllare il valore delle variabili

di determinate entità. Ad esempio, uno degli scopi dell’alimentazione animale é prevedere e

controllare l’ingestione alimentare di una determinata specie e categoria per poter formulare la più

idonea razione alimentare. Ora, l’ingestione, per ciascuna popolazione animale, riflette un insieme

di proprietà (variabili) zootecniche quali il peso corporeo dell’animale, il livello produttivo, la

qualità delle produzioni e altre misure dello stato degli animali. Se si capisce come prevedere e

controllare lo stato degli animali che influenza l’ingestione alimentare, allora possiamo anche

6

formulare razioni alimentari corrette (con risultati notevoli in termini di economia gestione

dell’allevamento e di benessere degli animali allevati).

Una volta giunti al controllo e alla possibilità di prevedere un fenomeno possiamo anche capirlo e

spiegarlo: il primo scopo é proprio della tecnologia, il secondo é proprio della scienza.

Ma, come recita la frase di Peter Van Soest (uno dei massimi esponenti dell’alimentazione animale)

riportata nel sito del nostro Dipartimento, utilizzare senza capire é un’eresia..

La statistica allora é uno strumento per capire, spiegare, controllare e prevedere un fenomeno.

In altri, e definitivi, termini, il principale scopo di una ricerca empirica é quello di scoprire come

prevedere e controllare (con la massima accuratezza possibile) i valori delle variabili (proprietà) di

entità di una popolazione ed essere in grado di spiegare e capire il fenomeno che esse

rappresentano.

2. La relazione fra variabili é la chiave per la previsione ed il controllo di un fenomeno.

Una volta stabilito che il principale scopo della ricerca empirica é quello di controllare e prevedere

il valore delle variabili, dobbiamo ora capire come fare ciò. La risposta é: noi possiamo controllare

e prevedere i valori delle variabili studiando le relazioni fra le variabili.

Nella relazione fra variabili una (detta variabile risposta) dipende da una o da più altre variabili

(dette variabili predittrici). Tutta la statistica “gira” intorno a questa semplice idea: trovare (se

esistono) le relazioni fra le variabili che stiamo studiando.

Ma cosa significa “relazione fra variabili?”. Una semplice risposta è: esiste una relazione se la

variabile dipendente si muove in accordo (cresce o decresce al crescere o decrescere) con la (le)

variabile(i) predittrice(i). La variabile predittrice é anche chiamata “variabile indipendente” mentre

quella risposta é anche detta variabile dipendente. In matematica la prima é anche contrassegnata

con la lettera y, e le seconde con la lettera x (x1, x2,x3, ecc..).

Riprendiamo l’esempio delle pecore di compare Bastiano. Esiste una relazione fra produzione di

latte e contenuto in grasso o in proteine del latte?

Per capirlo iniziamo a disporre i dati su un piano cartesiano. La variabile “grasso” e quella

“proteina” sono entrambi “risposta” e il latte é “predittrice”. In questo caso, ciascuna coppia di dati

(latte/grasso e latte/proteine) ha una coppia di valori associati a ciascuna entità. Ogni pecora, infatti

é identificata da due valori di tale coppia (la pecora 1, ad esempio, ha prodotto 1015 g/d di latte con

il 6,54% di grasso ed il 5,18% di proteine).

Vediamo ora i grafici che ne derivano.

7

Contenuto di grasso (%)

Relazione fra produzione e grasso delle pecore di

Bustiano

9

8,5

8

7,5

7

6,5

6

5,5

5

500

700

900

1100

1300

1500

1700

Produzione di latte (g/d)

Contenuto di proteine (%)

Relazione fra produzione e proteine delle pecore di

Bustiano

6,5

6

5,5

5

4,5

4

500

700

900

1100

1300

1500

1700

Produzione di latte (g/d)

Vediamo subito che per il grasso non c’é una “tendenza” evidente, mentre per le proteine possiamo

scorgere una leggera tendenza di queste a diminuire quando il latte aumenta.

Quando siamo interessati allo studio delle relazioni fra le variabili di solito non tendiamo a

sottoporre a misura tutte le entità della popolazione perché ciò può essere impossibile o comportare

8

enormi spese (ricordiamo SEMPRE che la rilevazione di un dato ha un costo e più dati raccogliamo

più spese sosteniamo). Per questo motivo i ricercatori sottopongono a studio una porzione della

popolazione chiamata campione che varia in entità da un minimo di 6 ad un massimo di 2000 unità.

Tuttavia, per quanto riguarda la variabile altezza della popolazione di italiani, esiste una notevole

eccezione. Infatti l’altezza dei maschi italiani é nota per (quasi) tutta la popolazione attraverso la

misurazione effettuata con la visita della leva militare, mentre per le donne questa variabile può

essere rilevata solo su un (per quanto ampio) campione. Lo scopo dei ricercatori é allora quello di

generalizzare quanto osservato sul campione alla popolazione a cui il campione appartiene

(popolazione target).

Affinché la generalizzazione sia valida, cioè perché il controllo e la predizione del comportamento

della variabile studiata possa essere esteso all’intera popolazione, il campione impiegato per

eseguire le misure deve essere rappresentativo della popolazione stessa.

Per assicurasi che il campione sia rappresentativo occorre tenere presenti due aspetti: esso deve

essere casuale (esso può potenzialmente contenere “ogni” entità della popolazione) e deve essere

numericamente consistente.

Esportare alla popolazione le conclusioni che traiamo su un campione é detto, in linguaggio

statistico, compiere una inferenza dal campione alla popolazione. Ad esempio, se tentassimo di

generalizzare le osservazioni compiute sulle pecore di compare Bastiano all’intera popolazione

delle pecore di razza Sarda (4 milioni di capi) dovremo tenere conto che si tratta innanzitutto di un

campione non casuale (nel campione non possono capitare per caso le pecore di zio Pasquale, o di

cugino Giacomo) e numericamente molto ridotto (solo 25 pecore).

Quando non sono osservate queste due condizioni, il campione é detto non rappresentativo e le

stime che si fanno su esso sono distorte, valgono cioè solo per il campione e non possono essere

estese, se non con molta cautela, alla popolazione. Le tecniche statistiche, se applicate

correttamente (cioé ad un campione “buono” della popolazione) ci rivelano con quale “fiducia”

possiamo estendere le stime ottenute sul campione (stime campionarie) alla popolazione a cui il

campione appartiene: questo aspetto é denominato dagli statistici accuratezza della stima e può

essere misurato. La gran parte del nostro corso sarà impiegata ai problemi della stima e della sua

accuratezza.

In definitiva, la statistica ci aiuta a studiare una variabile e i suoi rapporti con altre variabili in un

campione

di una popolazione al fine di estendere i risultati ottenuti dal campione (stime

campionarie) all’intera popolazione con un certo grado di accuratezza.

Arrivati a questo punto, tentiamo di riassumere: se qualche passaggio non vi é chiaro, tornate

indietro e cercate di capirlo prima di proseguire.

9

Dunque: la statistica si occupa di entità, in buona sostanza di tutto ciò le cui proprietà possono

essere misurabili in qualche modo. Le misure delle proprietà sono i valori i quali, se variano fra una

entità ed un’altra, costituiscono una variabile. La statistica studia le variabili per controllare e

predire il loro comportamento e per spiegare e capire il fenomeno rappresentato dalle entità

studiate. Lo scopo della ricerca empirica é ottenere delle informazioni da una variabile (stime) e

studiare le relazioni fra le variabili. Normalmente i dati sono raccolti su una parte della

popolazione che é detta campione. Le stime ottenute sul campione possono essere estese alla

popolazione con il procedimento dell’inferenza. Esse sono affidabili solo se il campione é

rappresentativo della popolazione target, altrimenti sono distorte.

Siamo giunti ,infine, a poter formulare una risposta alla seconda: cosa é la statistica?

La Statistica é un set di tecniche generali ottimali che aiutano i ricercatori empirici nello studio

delle variabili e delle relazioni fra variabili di campioni di entità, principalmente come mezzo per

prevedere accuratamente e controllare i valori delle variabili (proprietà) nelle entità delle

popolazioni (D. Macnaughton).

10

Lezione n. 2

PROBABILITA’

1. Perché ci interessa la probabilità

In ogni corso di statistica che si rispetti, ad un certo punto compare la probabilità. In molti casi é un

argomento che é trattato all’inizio del corso come propedeutico agli altri, in altri costituisce uno dei

capitoli principali di studio. Quale aspetto lega il calcolo delle probabilità con lo studio delle

variabili così come descritte nella lezione precedente?

Diamo subito una prima risposta: poiché una variabile (insieme di dati della proprietà di una

entità) può assumere diversi valori, tali valori possono essere raggruppati in classi di frequenza

relativa (le volte che i valori della variabile ricadono in quella classe) e la frequenza con cui una

determinata classe di valori compare nella variabile segnala la probabilità con cui posso trovare tale

valore nel campione (o nella popolazione) che ho in studio.

Il calcolo delle probabilità nacque circa tre secoli fa per analizzare certe situazioni inerenti al gioco

d’azzardo.

Attualmente è una delle discipline più diffuse negli insegnamenti universitari e trova molte

applicazioni nelle scienze biologiche, mediche, fisiche, sociali. Tra le applicazioni a noi più vicine

possiamo ricordare la valutazione dei risultati di esperimenti condotti su un campione di animali (

esperimenti di alimentazione, di tecnica di allevamento, ecc..); la previsione dell’andamento di un

fenomeno legato alla biologia degli animali quale la curva di lattazione o la curva di accrescimento,

lo studio delle relazioni fra i caratteri misurabili direttamente sugli animali (fenotipi) ed il loro

determinismo genetico (genotipi), lo studio delle modalità con cui si diffonde una infezione o una

parassitosi fra gli animali (epidemiologia).

In genere, il calcolo delle probabilità rappresenta lo strumento che consente di rendere razionale il

comportamento dell’uomo di fronte all’incertezza. Esso viene infatti applicato in tutte quelle

situazioni in cui gli sviluppi di un dato fenomeno non sono euristicamente prevedibili oppure

quando occorre prendere decisioni in base ad ipotesi riguardanti eventi futuri.

11

2. La definizione classica di probabilità

Se mescoliamo un mazzo da 52 carte e ne estraiamo 1, stiamo facendo una scelta casuale. Nessuna

delle 52 carte ha (teoricamente = secondo un ragionamento) una probabilità maggiore rispetto alle

altre di essere scelta. Un esperimento casuale dà origine a più risultati e quindi a più eventi casuali.

Un evento casuale può essere:

♦ Certo: è il caso dell’estrazione da un’urna piena di palline nere una pallina nera

♦ Impossibile: è il caso dell’estrazione da un’urna che contiene solo palline nere una pallina

bianca

♦ Possibile: è il caso dell’estrazione da un’urna piena di palline bianche e nere di una pallina

bianca.

Tutti gli eventi possibili costituiscono lo spazio campionario: nel lancio di un dado gli eventi

possibili sono 6, per cui lo spazio campionario è composto da 6 eventi.

La probabilità associata ad un evento esprime il grado di aspettativa circa il suo verificarsi e può

essere espresso da un numero compreso tra zero ed uno:

0 ≤ p ≤1

Ciò porta alla definizione classica di probabilità: la probabilità di un evento è il rapporto tra il

numero di eventi favorevoli e il numero di casi possibili all’evento, purchè tutti i casi siano

equamente possibili: p =

numero di casi favorevoli

numero di casi possibili

Nel caso del lancio di un dado, la probabilità che esca 4 è p =

1

perché in un lancio il 4 può uscire

6

solo una volta ed il numero di casi possibili sono 6.

Esempio: un’urna contiene due palline bianche, tre rosse e due nere. Qual è la probabilità di estrarre

al primo tentativo una pallina bianca?

I casi possibili sono 7 mentre quelli favorevoli sono 2. La probabilità sarà:

p=

2

≈ 0.28 cioè p ≈ 28%

7

12

3. La definizione frequentista di probabilità

Come é possibile osservare, nel caso della definizione classica, la probabilità é definita a priori (=

prima di aver eseguito gli esperimenti) come caso favorevoli sul totale dei casi possibili. Tale

definizione deriva dalla conoscenza delle modalità con cui lavora la machina del caso con cui

stiamo lavorando. Infatti, se utilizziamo come macchina del caso il “dado” e il dado non é truccato,

non vi é alcun motivo razionale per ritenere che ad un lancio una faccia “debba” prevalere sulle

altre: infatti, la definizione di dado truccato é proprio quella di un oggetto “dado” in cui dopo un

grande numero di lanci una faccia “esce” con maggiore frequenza delle altre! Ribadisco questo

concetto: nella probabilità classica gli eventi favorevoli sui totali sono conosciuti “a priori” e

derivano dalle modalità di costruzione della “macchina del caso”.

Tuttavia, nel campo delle scienze empiriche, questa definizione non é impiegabile in quanto non

abbiamo a disposizione una macchina del caso le cui modalità di estrazione siano conosciute a

priori. Possiamo conoscere i modi con cui la nostra macchina lavora se e solo se conduciamo una

serie di esperimenti, analizziamo i dati e associamo a ciascuna modalità di presentazione della

variabile una probabilità. Questa scelta (obbligata) é detta scelta “frequentista” nel senso che noi

associamo la probabilità di un evento alla frequenza con cui tale evento si verifica

sperimentalmente.

La nostra definizione “operativa” di probabilità é allora la seguente:

La probabilità di un evento A, P(A), è il numero di volte in cui si verifica l’evento A (nA) sul

numero totale di volte in cui l’esperimento é ripetuto (n) quando il numero totale tende all’infinito

n( A)

n→∞

n

P(A) = lim

Secondo la nostra definizione empirica allora, definita la frequenza di a f(A) il rapporto fra casi

positivi (A) e casi possibili (N), in un esperimento con un gran numero di casi, probabilità e

frequenza coincidono: in termini tecnici, probabilità e frequenza di un evento coincidono

asintoticamente.

Utilizziamo come esempio, il genere dei nati della specie bovina (é un esempio analogo a quello del

lancio della moneta). Noi sappiamo che la macchina del caso é costituita dalla meiosi che segrega

nelle cellule germinali maschili e demminili la metà del corredo cromosomico (diploide) posseduto

13

dai genitori. Poiché il sesso é determinato dalla presenza del cromosoma Y (in questo caso, il sesso

eterogametico é il maschio con YX, mentre la femmina é omeogametica XX), é la macchina del

caso costituita dalla meiosi paterna necessaria alla produzione dei nemaspermi che determina la

presenza del cromosoma Y. Poiché la separazione dei cromosomi sessuali é casuale, metà dei

nemaspermi possederà il cromosoma Y e metà quello X. Gli oociti materni possiedono solo il

cromosoma X e la loro fecondazione può avvenire indipendentemente con spermi che portano Y o

X. Essendoci numerosissimi spermi in gioco nella fecondazione (alcuni miliardi), la probabilità che

l’oocita sia fecondato con uno spermio portatore Y o X é del 50%, per cui il futuro nato potrà essere

maschio o femmina con una probabilità teorica del 50%. In effetti, se osserviamo la serie delle

nascite avvenute nella popolazione bovina in una annata possiamo verificare che questo

meccanismo effettivamente lavora così.

Prendiamo la carriera riproduttiva di 100 vacche.

vacca n.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

vitello 1 parto

f

f

m

m

m

m

m

m

m

f

f

m

f

m

m

f

f

m

f

m

m

f

m

f

f

m

f

m

f

m

m

f

vitello 2 parto

m

m

m

m

f

f

f

m

m

f

m

m

m

m

f

m

f

f

m

f

f

f

f

f

f

f

m

m

m

m

m

m

vitello 3 parto

m

m

f

f

f

m

f

f

m

f

m

m

m

m

m

f

m

f

m

m

m

m

f

m

m

m

f

m

m

f

m

f

14

vitello 4 parto femmine maschi

f

2

m

1

m

1

m

1

m

2

m

1

f

3

f

2

m

0

f

4

m

1

m

0

f

2

f

1

m

1

f

3

m

2

f

3

m

1

f

2

m

1

f

3

m

2

m

2

m

2

m

1

f

3

f

1

m

1

m

1

m

0

m

2

2

3

3

3

2

3

1

2

4

0

3

4

2

3

3

1

2

1

3

2

3

1

2

2

2

3

1

3

3

3

4

2

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

59

60

61

62

63

64

65

66

67

68

69

70

71

72

73

74

75

76

77

78

79

80

81

82

83

84

85

86

87

88

89

m

f

m

m

m

m

m

m

m

m

m

m

m

m

m

m

f

m

f

f

f

m

f

m

f

f

f

f

f

f

f

m

f

m

m

m

m

f

m

f

f

f

m

f

f

f

f

m

f

f

f

f

m

m

m

m

f

m

m

m

f

f

f

m

f

m

m

m

m

m

m

f

m

m

f

m

f

f

m

m

f

m

f

f

m

f

m

f

m

f

f

f

f

f

f

f

f

f

f

f

m

f

f

f

m

f

f

f

m

f

m

f

m

f

m

f

m

m

m

f

f

m

f

f

m

f

f

m

m

m

f

f

f

m

m

m

m

m

f

m

m

m

f

f

m

m

m

m

m

m

m

m

f

m

m

f

f

f

m

f

f

m

f

m

m

f

m

m

f

m

f

15

m

m

m

m

m

f

m

f

f

m

m

m

m

m

m

f

f

m

f

f

m

m

f

f

m

m

f

m

m

f

f

f

m

m

f

f

m

f

f

m

f

f

f

m

m

m

m

m

f

m

f

m

f

f

m

m

m

0

2

0

1

1

3

1

2

2

1

0

1

1

0

1

1

3

2

3

3

2

0

2

2

2

2

3

1

3

3

3

1

2

1

2

2

1

3

3

2

3

4

3

2

2

3

3

0

4

2

3

2

2

1

2

0

3

4

2

4

3

3

1

3

2

2

3

4

3

3

4

3

3

1

2

1

1

2

4

2

2

2

2

1

3

1

1

1

3

2

3

2

2

3

1

1

2

1

0

1

2

2

1

1

4

0

2

1

2

2

3

2

4

1

90

91

92

93

94

95

96

97

98

99

100

f

f

f

m

f

m

m

m

m

f

m

m

f

m

f

f

f

m

m

m

f

f

f

f

f

f

f

m

m

m

f

f

m

m

m

m

m

f

f

f

m

f

f

f

2

3

2

2

4

2

1

0

2

4

2

2

1

2

2

0

2

3

4

2

0

2

f=

m=

46

54

53

47

42

58

42

58

183

217

Per ciascun parto (1°, 2°, 3° e 4°) i maschi e le femmine sono risultati circa la metà. Anche nel

complesso il 45,7% del totale sono risultate femmine. Impareremo come testare l’ipotesi che il

valore “vero” del rapporto riproduttivo dei sessi alla nascita sia del 50% in una lezione successiva.

Per ora accontentiamoci di osservare che la frequenza osservata dell’evento “femmina” é

abbastanza vicina a quella teorica dovuta al funzionamento della macchina del caso “riproduzione”.

4. Alcune proprietà delle probabilità.

Abbiamo detto che la probabilità dei un evento é la frequenza con cui tale evento capita su tutti i

possibili. Ne deriva che la somma degli eventi possibili é il 100% per cui la somma delle probabilità

di eventi indipendenti appartenenti allo stesso spazio campionario è =1. Ad esempio, data la

probabilità che in un dado esca una faccia é 1/6, avendo il dado 6 facce (n. eventi possibili) la

somma delle probabilità è (1/6) + (1/6)+(1/6)+(1/6)+(1/6)+(1/6) = 1; in formula

P(A1) + P(A2) + P(A3))+....+ P(An) = 1

infatti, se:

P(A1) =

n( A1)

n ( A2 )

n( A3)

; P(A2) =

; P(A3)=

;

n( A1) + n( A2) + n( A3)

n( A1) + n( A2) + n( A3)

n( A1) + n( A2) + n( A3)

la somma delle probabilità é uguale a 1, anche se le singole probabilità sono diverse.

Da ciò deriva che, con eventi mutuamente escludenti, se P(A1) è la probabilità di A1, la probabilità

che A1 non si verifichi, P(non A1) é data dalla:

16

P(non A1) = 1- P(A1)

Probabilità di eventi indipendenti.

Due (o più) eventi sono detti indipendenti se il verificarsi di uno non influenza in nessun modo il

verificarsi dell’altro. Ad esempio, la successione dei parti nelle vacche della tabella precedente é

considerata un insieme di eventi indipendente in quanto il verificarsi del primo non incide in nessun

modo sul determinismo del secondo o del terzo, e così via. Quale é la probabilità che due eventi

indipendenti si manifestino assieme? Contiamo ad esempio quante volte si é verificato nei primi 2

parti l’evento maschio+maschio, maschio+femmina, femmina+femmina: il risultato é che abbiamo

osservato 27 m+m, 26 f+f e 47 m+f.

La probabilità che due eventi indipendenti non mutualmente escludenti si verifichino assieme é

data dal prodotto delle loro singole probabilità:

P(A eB) = P(A)*P(B)

Nel nostro esempio, la probabilità teorica che in due parti consecutivi abbia entrambi maschi (o

entrambi femmine) é data

0,5 * 0,5 = 0,25

Quella di avere un maschio e una femmina é dello 0,5 (in quanto non importa se sia nato prima il

maschio o la femmina, essendo per ciascuna successione m+f = 0,25; f+m = 0,25). In ogni caso le

probabilità cumulate hanno quale risultato 1. Nel caso pratico, le frequenze osservate non si

discostano da quelle teoriche: infatti abbiamo osservato che P(m+m) = 0,27, P(f+f) = 0,26 e P(m+f)

= 0,47 e la somma anche in questo caso fa 1.

Nel caso in cui volessi trovare una probabilità combinata di due eventi indipendenti che si

escludono mutualmente dovremo impiegare la somma delle singole probabilità. Ad esempio,

sappiamo che il mantello (= coloro esterno) della razza Frisona italiana é normalmente pezzato

nero, ma in casi limitati (= 5%) può anche essere pezzato rosso. Sono interessato a conoscere la

probabilità, su 100 parti, di avere o un maschio (primo evento indipendente) o una femmina pezzata

rossa. La probabilità di avere un maschio é dello 0,5, quello di avere una femmina pezzata rossa é

dello 0,5*0,05=0,025. La probabilità di ottenere un animale alla nascita delle caratteristiche

desiderate é pertanto 0,5 + 0,025 = 0,525. In generale, con eventi escludentisi mutuamente

17

P(A o B) = P(A) + P(B)

Nel caso in cui volessimo trovare invece la probabilità combinata di eventi non escludentisi

mutuamente dobbiamo tenere conto di un fatto. Riprendendo il nostro esempio, se fossi interessato

alla nascita di un animale maschio o a un animale pezzato rosso (compresi i maschi) se impiegassi

la formula sudetta conterei i maschi rossi 2 volte (la prima come maschi e la seconda come maschi

rossi). Allora dalla formula devo togliere i maschi rossi che hanno una frequenza uguale a quella

delle femmine rosse (0,025). In formula

P(A o B) = P(A) + P(B) – P(A)*P(B)

Questa é la formula da utilizzare sempre. Infatti, quella precedente si riduce a questa quando gli

eventi si escludono mutalmente (non c’é nessuna femmina rossa fra i maschi!) per cui il prodotto

delle probabilità è = 0 (la probabilità femmina rossa nei maschi = 0).

Diamo ora un ultimo accenno alla probabilità condizionata. Diciamo che esiste una probabilità

condizionata quando vogliamo sapere quale probabilità ha un evento congiunto di accadere

conosciuta la probabilità di uno degli eventi condizionanti. Ad esempio, vogliamo sapere, dato il

colore pezzato rosso del mantello di un nato, quanti maschi ci aspettiamo di ottenere. Allora, la

probabilità di ottenere un maschio pezzato rosso é 0,5*0,05 = 0,025. Ma la probabilità che un

animale sia rosso é dello 0,05. Allora 0,025/0,05 = 0,5 che é la probabilità di trovare un maschio

all’interno degli animali pezzati rossi.

In formula

P(A/B) =

P( A) * P( B)

P( B)

Vediamo ora un caso particolare della probabilità condizionata. Se la probabilità che si verifichi A

conoscendo B é la stessa che di verifichi A senza conoscere B, allora i due eventi sono detti

indipendenti. In formula, un evento A é detto indipendente da uno B se

18

P(A/B) = P(A)

Nel caso del sesso dei vitelli, l’evento sesso al secondo parto é indipendente da quello sesso al

primo parto (B) in quanto la probabilità che nasca un maschio al secondo parto non risente in alcun

modo del fatto che conosco il sesso del vitello del primo parto: infatti, 0,5*0,5/0,5= 0,5!

19

Appendice (lettura obbligatoria)

Statistica e modelli

Elaborare i dati secondo una determinata procedura significa applicare un modello matematico. Un

modello é la rappresentazione di qualche cosa, ma non é la cosa che rappresenta. La scelta di un

modello é sempre arbitraria e per molti versi pregiudiziale alla sua applicazione. Nel caso dei

modelli statistici, quando trattiamo un insieme di dati ai fini di assumere una decisione

(circoscriviamo un territorio per prevenire un contagio, riteniamo un apparecchio tarato per una

determinata analisi, orientiamo i corsi di aggiornamento in base alle preferenze espresse dai

colleghi, ecc..), siamo consapevoli che la scelta di un modello rispetto ad un altro non é indifferente

relativamente alla responsabilità conseguente agli esiti derivanti da tale scelta. Se le conseguenze di

una scelta possono avere esiti catastrofici (cioè provocare danni ingenti), il modello a cui mi affido

sarà molto conservativo (ad es. nel caso delle diffusione di una zoonosi, elaboro le informazioni a

disposizione in modo tale da rendere operativi comportamenti anche in casi altamente improbabili)

mentre nel caso opposto posso impiegare modelli ad alto rischio (se dispongo di una innovazione

tecnologica da proporre al mercato devo accettare probabilità di fallimento elevate se gli utili che

attendo da tele innovazione possono essere consistenti).

Le variabili statistiche

La statistica lavora con variabili casuali ossia con insiemi numerici o categoriali ordinati secondo

un criterio casuale. Henrì Poicaré (1908, Science e Methode), criticando il punto di vista

deterministico (esposto principalmente da Laplace) secondo cui il caso sarebbe semplicemente “un

nome per la nostra ignoranza”, distingue fra tutti i fenomeni le cui cause ci sono sconosciute, i

fenomeni fortuiti ai quali si applica il calcolo delle probabilità da quelli non fortuiti rispetto ai quali

non possiamo dire assolutamente nulla fin tanto che non conosciamo le leggi che li governano. In

particolare, egli afferma che esistono fenomeni in cui cause molto piccole oppure differenze

irrilevanti nelle condizioni iniziali (tanto piccole da non poter essere registrate) producono

differenze macroscopiche negli esiti finali e in tal caso la previsione diventa impossibile. In base a

questa posizione possiamo inizialmente definire come casuale un fenomeno per il quale non siamo

in grado di formulare previsioni. Questa impossibilità risiede, secondo Poicarè, nella complessità

dei fenomeni che costituisce l’elemento fondante la loro casualità e imprevedibilità. La “casualità

assoluta” o “casualità operazionale” é stata però l’oggetto dell’indagine di von Mises (1939,

Probability, Statistics and Truth) che ha definito una variabile casuale come un insieme numerico

infinito dotato della proprietà della “scelta di posto”. Quest’ultima é tale se é effettuata prima di

20

conoscere qualsiasi cosa circa il risultato della scelta medesima per cui il principio di casualità di

von Mises é l’indifferenza delle successioni probabilistiche a tutte le scelte di posto che possono

operarsi in esse. Questo principio é espresso anche sotto forma della “impossibilità di un sistema di

gioco”: negli ambienti degli statistici é nota la definizione secondo la quale il cretino é colui che

afferma di aver scoperto un sistema per vincere ad un gioco aleatorio.

Questa scelta operazionista di von Mises rende però praticamente impossibile generare variabili

casuali. Infatti, se la scelta di posto di un elemento é assolutamente indifferente rispetto a ciò che lo

precede e lo segue nella serie, non può esistere una “macchina perfetta del caso” in grado di

produrre un oggetto simile. Infatti, se fossimo in grado di generare insiemi numerici infiniti (ed é

pacifico che non lo siamo..), non saremo in grado comunque di generarli perfettamente casuali.

Ora occorre un passo indietro. Utilizziamo a scopo esemplificativo un esempio numerico ristretto ad

un piccolo insieme. Consideriamo una stringa di dati costituita, mettiamo, da 5 elementi. Diremo

che la stringa é casuale se non esiste alcuna altra possibilità di rappresentazione dei dati che non sia

la stringa stessa. La stringa 2-4-6-8-10 non é casuale perchè rappresenta i primi 5 numeri pari ed

essa può essere espansa all’infinito con l’algoritmo 2n, dove n é la serie dei numeri reali interi

positivi. Il processo per cui insiemi numerici (anche infiniti) possono essere contenuti in

rappresentazioni più “economiche” rispetto alla mera ripetizione della serie stessa é detto

comprimibilità algoritmica: una informazione limitata può espandersi in una più grande. Una

stringa numerica é casuale quando é incomprimibile algoritmicamente per cui per poter avere la

completa informazione in essa contenuta dobbiamo scriverla tutta.

Ritornando a von Mises, il suo concetto di casualità non consente la rappresentazione di variabili

“perfettamente casuali”. Non esiste uno strumento di calcolo o un apparato fisico in grado di

generare il caso perfetto: una macchina matematica del caso é sempre costruita dall’uomo ed

essendo conosciuta a priori rende possibile la ricostruzione della serie da essa generata; una

macchina fisica (rumore di fondo del computer, moto browinano, dado di Las Vegas ecc..) é anche

essa non perfettamente simmetrica rispetto alle frequenze di uscita dei singoli dati, per cui nelle

lunghe serie possono essere percepite delle increspature di regolarità che tolgono alla serie stessa il

suo carattere aleatorio. Per tali ragioni e per motivi pratico-applicativi, tutti, scienziati e filosofi,

ormai sono concordi nel ritenere che la statistica applicata lavora con serie pseudo-casuali il cui

comportamento é del tutto soddisfacente dal lato pratico. Oggi le serie pseudoaleatorie, costituite da

numeri da 0 a 9, sono generate al computer a partire da algoritmi basati, ad esempio, sullo scarto fra

due numeri primi o sui decimali successivi di numeri irrazionali oppure su oggetti matematici più

complicati. Le serie di numeri a 2, 3 o più cifre sono costruite a partire da 2, 3 o più serie elementari

accoppiate. Le serie semplici così generate sono poi sottoposte ala analisi di frequenza: sono

21

giudicate positivamente (cioé possono essere ritenute pseudo-casuali) se la frequenza con la quale

compare ciascuna cifra decimale é 1/10 (nei termini di approssimazione asintotica, cioè come limite

di frequenza relativa in una serie infinita). Le serie pseudo-casuali sono riportate nelle cosiddette

“tavole dei numeri casuali” o “tavole randomizzate” stampate a corredo dei manuali di statistica.

Questi strumenti, come vedremo, sono molto utili nella pratica del campionamento. Anche un

foglio di calcolo comunemente impiegato, quale Excell, può generare numeri casuali. La funzione

da evocare é CASUALE(); nella cella definita il programma genera un numero casuale fra 0 e 1. Per

fare ciò i software che dispongono di tale opzione utilizzano il cosiddetto "rumore bianco” del

computer.

Le variabili statistiche sono costituite da dati. Il dato é quanto é presente nella conoscenza prima

che essa vi applichi i suoi processi logici o di interpretazione. Dato si oppone di solito a costruito,

anche se alcuni costrutti possono essere a loro volta considerati dati da elaborare successivamente.

Nel caso delle scienze della vita, il dato rappresenta la misurazione fondamentale della realtà

fenomenica oggetto di studio. Qualora fossimo interessati ad una variabile che descrive una

proprietà dell’oggetto della nostra indagine (altezza, peso, età, numero di colonie batteriche, ecc..) il

dato é anche chiamato variante, per cui le variabili sono costituite da varianti.

Ciascuna unità sperimentale può essere definita da più proprietà simultaneamente e ciascuna

proprietà é codificabile con una variabile. Ciascuna variabile definisce una dimensione dello spazio

statistico, per cui, se descrivo l’individuo per tre proprietà (peso corporeo, altezza, età = tre

variabili) esso sarà definito nello spazio a 3 dimensioni da 3 coordinate I≡(p; a; e). Consideriamo 4

individui:

individuo

peso (kg)

altezza (cm)

età (anni)

1

56

160

25

2

62

172

41

3

15

100

6

4

78

173

47

il primo individuo avrà queste coordinate I1 ≡ (56; 160; 25) e sarà rappresentabile, assieme agli

altri, da punti nello spazio nel modo seguente.

22

peso

.

.

.

.

.

età

altezza

L’insieme degli individui può raggrupparsi in una o più cluster in dipendenza della loro

somiglianza. Se due delle tre variabili sono collegate fra loro (peso e altezza ad esempio lo sono) il

grappolo assume una gibbosità orientata nel senso degli assi delle due variabili. La forma assunta

dal grappolo rappresenta il legame fra le variabili che tanto é maggiore tanto genera una gibbosità

rilevante nella nuvola dei punti.

Le variabili che descrivono l’oggetto dello studio possono essere più di tre. In tal caso, pur non

essendo rappresentabili graficamente, esse generano spazi di 4, 5... n dimensioni chiamati iperspazi.

Ad esempio, se in una indagine per verificare la preferenza dei consumatori assumo sui singoli

intervistati 10 informazioni (età, scolarità, preferenze culturali, abitudini alimentari, ecc...) il mio

spazio statistico sarà definito da un iperspazio a 10 dimensioni, ciascuna rappresentante una delle

variabili che mi interessano ai fini della indagine.

23

Un aspetto pratico legato all’impiego dei dati nella elaborazione statistica é il problema della

precisione decimale. Se é evidente a tutti che la media dei nati per donna fertile italiana nel 2001

può essere di 1,21 senza significare con ciò che a ciascuna donna nascono 1,21 bambini, é

altrettanto vero che se la precisione di misurazione dell’altezza negli uomini é dell’ordine del cm,

ossia rileviamo i dati arrotondati al centimetro, l’espressione dell’altezza media con un

arrotondamento al secondo decimale di centimetro (decimo di millimetro) non ha significato e

rappresenta una finzione aritmetica. E’ buona norma pratica impiegare per la media lo stesso

arrotondamento utilizzato per la rilevazione della variabile o al massimo un ordine di grandezza

inferiore qualora sia ritenuto necessario per meglio esprimere le misure. Un altro aspetto pratico é

dato dalla risoluzione impiegata nella elaborazione. Se impiego valori numerici molto grandi devo

aspettarmi problemi di arrotondamento numerico dovuti al fatto che i software di elaborazione

impiegano algoritmi di calcolo matriciale in cui un passaggio obbligato é l’inversa di una matrice

data. Quando si inverte una matrice (se é invertibile ossia non singolare) valori molto grandi

possono originare valori molto piccoli e il computer taglia ad un predeterminato decimale

(normalmente il 16°) escludendo i successivi decimali necessari per rendere lo stimatore statistico

calcolato più “robusto”. In tal caso é consigliabile impiegare uno “scaling” appropriato. Ad

esempio, nel caso di produzione di latte per lattazione in pecore é meglio impiegare i kg al posto dei

grammi (213 kg vs 213.000 g) mentre per la produzione giornaliera é meglio utilizzare i grammi.

Con numeri grandi possono essere utilizzati i sistemi di notazione esponenziale: 123.456.789, può

essere espresso come 123,456789 x 106. In questo ultimo caso occorre che anche il software sia in

grado di riconoscere la notazione ed impiegarla per i calcoli dei quadrati. Approfondiremo questo

argomento in seguito.

24

Lezione n. 3

STATISTICA DESCRITTIVA

1. Prima di tutto, guardare i dati (EDA = exploratory data analysis)

Una volta raccolti i dati relativi alla variabile (o alle variabili) che abbiamo intenzione di studiare, la

prima azione da compiere é quella di guardare i dati. La tecnica che ci aiuta in questo

importantissimo passaggio, preliminare a tutte le altre analisi statistiche, é detta EDA (exploratory

data analysis) e si compie con l’ausilio di un computer. Infatti, anche l’occhio più esercitato

difficilmente riesce a cogliere le tendenze insite in serie numeriche di elevata consistenza; una

persona normale di solito non riesce a dominare con l’intuito più di 10-15 dati per volta.

L’EDA é una procedura di “classificazione” dei dati finalizzata ad una prima verifica della presenza

di un andamento nei dati stessi. I dati relativi ad una variabile campionaria (= del campione in

esame) possono essere sottoposti a EDA “da soli” (in tal caso si compie una EDA univariata =

relativa a una sola variabile), oppure in relazione ad un’altra variabile ( EDA bivariata = relativa a

due variabili). Se le variabili messe in relazione sono più di due, l’EDA é detta multivariata.

Approfondiamo per il momento sono l’EDA univariata e rimandiamo le altre due alla lezione

relativa alla regressione.

Prendiamo in esame una delle variabili riportate nella lezione n. 1: la produzione giornaliera di latte

di un campione di pecore Sarde:

25

Pecora

Latte g

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

1015

1105

1365

1085

840

960

1130

1185

1270

1385

1545

1475

1350

1145

1195

1185

1000

795

1105

1560

1340

1005

1260

1035

1300

Ripartiamo ora i dati in classi di ampiezza (= classifichiamo i dati). Prima di tutto dobbiamo

definire il numero di classi: in genere con 10-15 dati, usiamo 4-5 classi, ma con data-set (insiemi di

dati) molto numerosi, il numero di classi non eccede mai le 15-20.

Un metodo di calcolo per orientare il ricercatore sul numero di classi (C) é stato proposto da Sturges

e si basa sul n. di osservazioni (N)

C = 1+

10

⋅ log10 ( N )

3

Nel nostro caso N = 25, per cui C = 5,56 ≈ 6.

Una volta stabilito il numero delle classi, occorre calcolare l’intervallo di variabilità, dato dalla

differenza fra il valore minimo e quello massimo. Nel nostro caso il valore massimo é 1560 g,

quello minimo 796 g e l’intervallo di variabilità 765 g. L’intervallo di classe é dato allora da 765/ 6

= 127,5 g. Sommiamo questo valore al minimo (796 + 127,5) e poi di nuovo a quello ottenuto

26

(922,5 + 127,5) e così via fino ad ottenere le 6 classi volute (se il conto é corretto, dovremo avere

l’ultimo valore pari a quello massimo).

Con l’opzione “strumenti/analisi dati/ istogramma” di Excell, costruiamo prima la tabella e poi il

grafico:

Classe

922,5

1050

1177,5

1305

1432,5

1560

Altro

Frequenz

%

a

cumulativ

a

2

8,00%

5

28,00%

5

48,00%

6

72,00%

4

88,00%

3 100,00%

0 100,00%

Istogramma

7

120,00%

6

100,00%

Frequenza

5

80,00%

4

60,00%

3

40,00%

2

1

20,00%

0

,00%

922,5

1050

1177,5

1305

1432,5

1560

Altro

Classe

In ciascuna classe compare la frequenza assoluta (= numero di volte che il valore della variabile ha

un valore compreso fra il minimo e il massimo della classe) e quella relativa (frequenza assoluta

diviso il totale delle osservazioni). Tabella e grafico riportano anche la “frequenza relativa

cumulata” cioè la somma delle singole frequenze relative al crescere del valore delle classi. Nel

caso del grafico realizzato con Excell, il valore delle classi riportato nella figura va inteso come il

27

limite massimo di classe! Il software Minitab, invece, riporta la classificazione con il valore

centrale della classe:

Histogram of Latte g

5

Frequency

4

3

2

1

0

800

900

1000

1100

1200

1300

1400

1500

1600

Latte g

Minitab, inoltre, “decide” il numero di classi da impostare: in questo caso sono 9 (ma, come si vede,

la classe 900 é vuota!).

Questo tipo di istogramma é denominato “istogramma delle frequenze”.

Due considerazioni:

1) da quanto detto nella lezione 2, noi adottiamo un approccio frequentista alla probabilità, per cui

le frequenze relative rappresentano per noi la probabilità di trovare “per caso” un valore di

produzione incluso in quella classe;

2) la distribuzione presenta una forma. Se tutte le classi fossero state uguali, saremo di fronte ad un

fenomeno completamente casuale: tutti i valori hanno la stessa probabilità di essere estratti a

caso. Le classi centrali tendono ad essere più frequentate di quelle laterali. In altre parole, c’è

una tendenza del fenomeno ad aggregassi intorno al valore centrale, ossia più i valori di

avvicinano al centro della distribuzione, più sono probabili!

Vediamo ora cosa succede se, invece di 25 dati, osservo la distribuzione di 4500 produzioni

giornaliere di pecore della razza Valle del Belice.

28

Histogram of PG

Frequency

200

100

0

0

500

1000

1500

2000

2500

PG

Minitab suddivide il campione in mole più classi e la tendenza delle frequenze ad addensarsi attorno

ai valori centrali é molto più marcata. Questa distribuzione si approssima ad una curva continua,

denominata distribuzione normale della quale diamo una rappresentazione sovrapposta ad

diagramma precedente

29

Histogram of PG, with Normal Curve

Frequency

200

100

0

0

500

1000

1500

2000

2500

PG

Riprenderemo questo argomento in seguito.

Vediamo ora cosa succede nel caso di una variabile “categoriale” quale la serie testa/croce del

lancio contemporaneo di una serie di monete. Nel caso di due monete lanciate

contemporaneamente, abbiamo visto che le probabilità degli eventi TT, TC e CC, sono

rispettivamente del 0,25, 0,50 e 0,25.

Vediamo ora cosa succede se andiamo al lancio contemporaneo di 10 monete. Le probabilità di

ottenere gli 11 risultati possibili sono le seguenti:

10T

9T1C

8T2C

7T3C

6T4C

5T5C

4T6C

3T7C

2T8C

1T9C

10C

0,000977

0,009766

0,043945

0,117188

0,205078

0,246094

0,205078

0,117188

0,043945

0,009766

0,000977

30

Il diagramma delle frequenze é il seguente:

Distribuzione delle teste e croci in 10 lanci di 10 monete

0,3

0,25

frequenze

0,2

0,15

0,1

0,05

0

10T

9T1C

8T2C

7T3C

6T4C

5T5C

4T6C

3T7C

2T8C

1T9C

10C

eventi (T = testa; C = croce)

E’ possibile osservare che le maggiori frequenze sono addensate intorno alle classi centrali: anche

in questo caso con un numero di monete “molto alto” e con un numero di eventi “molto alto”, la

tendenza della curva é verso una curva normale.

La distribuzione vista in questo caso é detta “distribuzione binomiale” (= in quanto risulta dallo

sviluppo del binomio (p(a) + q(b))n), in qui p + q = 1.

Questo risultato deriva dall’applicazione della relazione vista nella precedente lezione:

P(A e B) = P(A)*P(B)

Esaminiamo il caso della serie di 4 parti nelle vacche da latte riportato in lezione 2.

Si tratta di eventi indipendenti, ciascuno dei quali ha una p = 0,5. Abbiamo ottenuto il seguente

risultato:

4 maschi 0 femmina 11 (0,11, come frequenza relativa)

3 maschi 1 femmina 27 (0,27)

2 maschi 2 femmine 34 (0,34)

1 maschio 3 femmine 23 (0,23)

0 maschi 4 femmine 5 (0,05)

Le frequenze teoriche si ricavano dallo sviluppo del binomio [p(M) + q(F)]2

31

Per trovare i coefficienti si impiega il triangolo di Tartaglia che qui sotto é sviluppato fino alla

potenza 10 del binomio

n

1

2

3

4

5

6

7

8

9

10

1

1

1

1

1

8

9

10

45

Coefficienti

1

1

1

2

1

1

3

3

1

1

4

6

4

1

1

5

10

10

5

1

6

15

20

15

6

7

21

35

35

21

7

28

56

70

56

28

36

84

126

126

84

36

120

210

252

210

120

1

1

8

1

9

45

1

10

1

I coefficienti di ogni riga derivano dalla somma di quelli a sinistra e a destra della riga precedente.

Nel nostro caso il binomio da sviluppare é:

[p(0,5) + q(0,5)]4

0,54 (MMMM) + 4*0,53*0,5 (MMMF) + 6*0,52*0,52(MMFF) + 4*0,5*0,53 (MFFF) + 0,54(FFFF)

che sviluppato ci da il risultato:

0,0625 MMMM oppure FFFF

0,25 MMMF oppure FFFM

0,35 MMFF

queste probabilità (teoriche) sono molto vicine alle frequenze osservate nella sperimentazione con

le vacche.

Con un esponente molto alto, la distribuzione binomiale tende anche essa alla curva normale.

I due tipi di distribuzione, la normale e la bionomiale, sono “simmetriche, nel senso che la parte

destra e sinistra della distribuzione sono speculari.

Esistono tantissimi altri tipi di distribuzione non simmetriche (cioè con una concentrazione delle

frequenze sbilanciata da una parte o dall’altra), ma noi ci soffermeremo soltanto su una di

particolare interesse nelle scienze zootecniche: la distribuzione asimmetrica.

Esaminiamo il fenomeno del contenuto in lattosio del latte: la distribuzione riportata di seguito é

fortemente asimmetrica, in quanto si ha un cumulo delle frequenze verso le classi di valore

massimo.

32

Histogram of lact.

140

120

Frequency

100

80

60

40

20

0

0

1

2

3

4

5

lact.

In questi casi la probabilità di estrarre un animale con lattosio “basso” è di molto inferiore a quella

di estrarre un animale con lattosio intorno al valore 4 (in realtà questo fatto ha senso, perché la

caduta della concentrazione del lattosio é sintomo di mastite; gli animali sani sono la stragrande

maggioranza del campione esaminato e della popolazione target).

Prendiamo ora in esame l’EDA bivariata. Esaminiamo il caso della relazione fra quantità di latte e

di proteine prodotte al giorno da un campione di vacche da latte Frisone:

Relazione fra produzione di latte e di proteine in vacche

Frisone

1600

Proteine (g/d)

1400

1200

1000

800

600

400

200

0

0

10

20

30

Latte (kg/d)

33

40

50

Il grafico mostra chiaramente che esiste una relazione stretta fra le due variabili esaminate:

all’aumentare della produzione di latte, aumenta anche la produzione di proteine per capo. Un

situazione in cui non esiste una relazione evidente é stata riportata nel grafico della lezione 1.

Utilizzeremo questa analisi preliminare nella lezione della analisi della regressione.

34

Lezione n. 4

MISURE DI POSIZINO E DI DISPERSIONE

1. Le misure di posizione di una distribuzione.

Con il termine misure di posizione di una distribuzione univariata si indicano quei particolari valori

che racchiudono una informazione sulla variabile in esame. Esse sono nell’ordine:

1) la media, che é la somma dei valori della variabile ponderata per la numerosità del campione (o

della popolazione) in esame;

2) la moda, che é il valore della classe di maggiore frequenza della distribuzione;

3) la mediana, che é il valore della classe che divide la distribuzione in due parti uguali (50% degli

eventi prima e 50% degli eventi ricadono dopo tale valore).

Le distribuzioni univariate presentano una sola media e una sola mediana, ma possono presentare

due (o raramente più) valori modali: in tal caso sono dette distribuzioni bimodali (o plurimodali).

0.5

0.45

0.4

0.35

0.3

0.25

0.2

0.15

0.1

0.05

0

-3.98

-1.98

0.02

3.38

Esempio di distribuzione bimodale

La media é la misura più importante. Questo valore costituisce il perno di tutta l’analisi statistica in

quanto di norma spiega una quota rilevante del fenomeno osservato. Ricordiamoci l’asserzione:

LA MEDIA SPIEGA

35

e così avremo chiaro il senso delle analisi che costituiscono il cuore della statistica.

L’informazione contenuta nella media é uguale a quella della somma dei valori della variabile.

Il suo calcolo é semplice, ma il suo potere informativo é grandissimo:

m=

∑x

i

n

in cui

m = media del campione

xi = i-simo valore della variabile

n= numero di osservazioni del campione.

Esistono altri tipi di media, impiegati in casi particolari; le ricordiamo per comodità:

la media geometrica e la media armonica.

La media geometrica è utilizzata quando le variabili non sono rappresentate da valori lineari, ma

ottenuti da prodotti o rapporti di valori lineari. Serve per il confronto di superfici o volumi, oppure

di tassi di accrescimento o di sopravvivenza, valori appunto che sono espressi da rapporti.

Per il calcolo della media geometrica, è condizione necessaria che le quantità siano tutte positive.

Se alcune fossero negative, si deve ricorrere al valore assoluto.

La media geometrica di n dati è uguale alla radice di ordine n (solo positiva) del prodotto degli n

dati: con simbologia matematica

m g = n x1 ⋅ x 2 ⋅ ... ⋅ x n

che può essere scritta anche come

mg = n

n

∏x

i

i =1

Una proprietà importante è che il logaritmo della media geometrica è uguale alla media aritmetica

dei logaritmi dei dati:

log m =

1 n

∑ log xi

n i =1

36

La media armonica è la stima più corretta della tendenza centrale, per distribuzioni di dati in cui

devono essere usati gli inversi. E’ utilizzata quando i valori di X sono espressi come rapporti di un

totale costante od in misure di tempi di reazione.

La media armonica è data da:

mh =

n

n

1

∑x

i =1

i

Prendiamo ora in esame il campione rappresentato dalle oltre 4500 osservazioni di produzione

giornaliera di latte di pecore Valle del Belice (vedi istogramma di frequenza).

Con una opzione di Excell (strumenti/analisi dati/statistiche descrittive) é possibile ottenere il

seguente otput

latte in grammi al giorno

Media

Errore standard

Mediana

Moda

Deviazione

standard

Varianza

campionaria

Curtosi

Asimmetria

Intervallo

Minimo

Massimo

Somma

Conteggio

1625

11

1530

1250

715

511705

1,247175589

0,89944541

4790

210

5000

7424379,608

4569

Come é possibile vedere, la media é di 1625, la mediana di 1530 e la moda di 1250 grammi di latte

per capo.

L’output ci fornisce anche altre informazioni circa la forma della curva. In particolare, la curtosi

esprime il grado di “schiacciamento” della distribuzione in esame rispetto ad una curva nomale

standard (vedremo in seguito il significato di questo termine). Se il valore della curtosi = 0 (o

vicino allo zero) la distribuzione é molto vicina a quella normale (normocurtica); se é inferiore allo

zero, é più schiacciata di quella normale standard (platicurtica) se superiore allo zero é più sfilata

(stretta) di quella normale standard (leptocurtica) come nel nostro caso

37

La asimmetria ci indica la posizione della moda rispetto alla media: se il valore é zero (o vicino)

moda e media sono molto vicine, se superiore allo zero, la moda é superiore alla media

(distribuzione asimmetrica destra) se inferiore allo zero la moda é inferiore alla media

(distribuzione asimmetrica a sinistra).

Altre misure di posizione utili sono i quartili, che rappresentano quei valori della variabile che

dividono in quarti la distribuzione. Entro il primo quartile sono compresi il 25% dei dati, entro il

secondo (che coincide con la mediana) il 50%, entro il terzo il 75%. Tutta la distribuzione

comprende il 100% dei dati, ed il valore massimo riscontrato é il quarto quartile. Nel caso del

campione di produzioni delle pecore Valle del Belice, il primo quartile é di 1108 grammi (il 25%

del campione produce di meno) ed il terzo quartile è di 2005 grammi (il 25% della popolazione

produce più). I quartili danno una rappresentazione immediata della mdalità con cui si distribuisce

la variabile.

2. . La misura della dispersione dei dati

Come abbiamo detto in precedenza, la media aritmetica rappresenta l’informazione più importante

che possiamo estrarre da una variabile. Ma non é la sola!.

Consideriamo 4 insiemi di dati:

A

B

C

D

5

3

1

0

5

4

3

2

5

5

5

5

5

6

7

8

5

7

9

10

Σxi

25

25

25

25

m

5

5

5

5

Questi insiemi sono isonumerici e isoquantitativi per cui hanno sommatoria e media uguali.

Se non disponessimo di altre

informazioni sulla distribuzione dei dati all’interno di ciascun

insieme, il più probabile valore di ciascun dato sarebbe 5 (la media é cioè il predittore più

affidabile). Questi insiemi non sono però costituiti da valori uguali, eccetto che nel gruppo A; la

38

media spiega tutto il fenomeno solo in questo insieme, ma il suo potere esplicativo va decrescendo

man mano che si passa dal gruppo A a quello D (aumenta cioè la dispersione dei dati attorno alla

media, esistendo valori molto diversi da questa).

I quattro gruppi sono diversi fra loro non nella somma (e nella media) ma per la dispersione

interna dei dati: i gruppi sono caratterizzati infatti da una differente variabilità.

La variabilità, ossia la modalità con cui i dati sono dispersi, rappresenta il secondo e più importante

oggetto di studio della statistica. Utilizzeremo un approccio intuitivo allo studio della variabilità di

una variabile statistica.

Poiché somma dei valori e media rappresenta la stessa informazione (infatti i gruppi di variabilità

differente hanno la stessa somma), verifichiamo se la somma dei quadrati dei dati può costituire un

indicatore della variabilità.. Nel nostro esempio si ha:

Σx2

D

A

B

25

9

1

0

25

16

9

4

25

25

25

25

25

36

49

64

25

49

81

100

125

135

165

193

C

Si può notare che, a parità di media e di numerosità del campione, man mano che aumenta la

variabilità aumenta anche la somma dei quadrati dei dati (Σx2 o SS, acronimo inglese che significa

“Sum of Squares”); possiamo allora dire che la SS è un parametro legato alla variabilità.

C’è però un problema: con la SS ho una (presunta) misura della variabilità anche in un insieme di

dati (il gruppo A) in cui non esiste variabilità. Dobbiamo allora esplorare la possibilità che esista

qualche altra relazione che esprima meglio il fenomeno: se togliamo dalla somma totale dei

quadrati, la somma dei quadrati della parte del fenomeno che é inviariante (la media) otteniamo una

misura idonea allo scopo. infatti, la vera misura della variabilità è la somma dei quadrati (variabilità

totale) meno la parte invariante (somma dei quadrati della media).

Nel nostro esempio si ha:

-

somma dei quadrati dei dati (SS)

A = 125; B = 135; C = 165; D= 193;

-

somma dei quadrati della media (uguale per tutti gruppi)

39

SSm = ny2 = 5 x 52 = 125

-

differenze SS – SSm