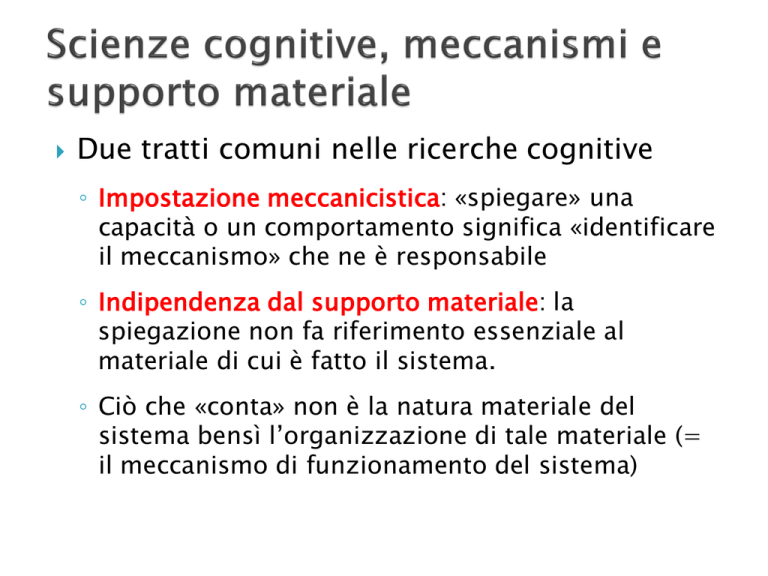

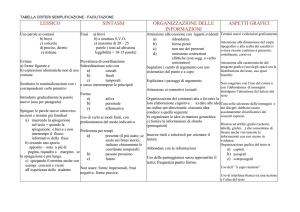

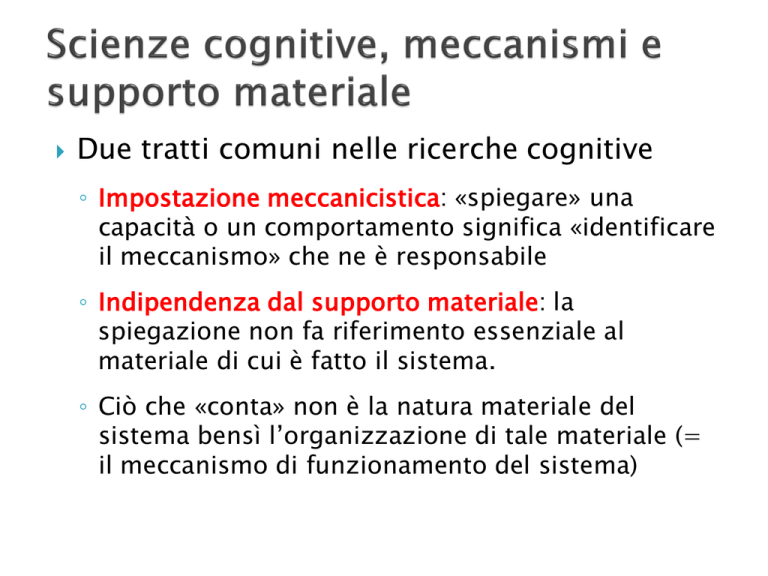

Due tratti comuni nelle ricerche cognitive

◦ Impostazione meccanicistica: «spiegare» una

capacità o un comportamento significa «identificare

il meccanismo» che ne è responsabile

◦ Indipendenza dal supporto materiale: la

spiegazione non fa riferimento essenziale al

materiale di cui è fatto il sistema.

◦ Ciò che «conta» non è la natura materiale del

sistema bensì l’organizzazione di tale materiale (=

il meccanismo di funzionamento del sistema)

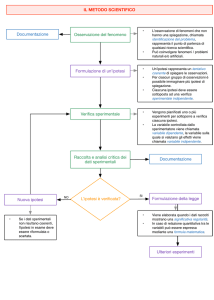

Meccanicismo + indipendenza dal supporto

materiale controllo di teorie sul

comportamento attraverso simulazioni

◦ Perché il sistema B genera il comportamento C?

◦ Ipotesi: il meccanismo che genera C è M

◦ Come controllare questa ipotesi?

◦ Si costruisce un altro sistema A (informatico o robotico)

che esegue, implementa, simula il meccanismo M e si

valuta se A riesce o meno a generare C

In caso affermativo si può corroborare l’ipotesi M

In caso contrario si può screditare M

Il comportamento degli animali non umani è

generato meccanicamente: automatico come un

«orologio composto solo di ruote e molle»

Non così quello degli esseri umani

«Si può senz’altro concepire una macchina

costruita in modo da proferire delle parole, e

addirittura da proferirne qualcuna a proposito di

azioni fisiche che determinino qualche

mutamento nei suoi organi: per esempio,

toccandola in un punto può domandare che cosa

gli si vuol dire; toccandola in un altro può gridare

che le si fa male, e via di seguito»

Secondo Cartesio le macchine, tuttavia, possono

reagire a un insieme limitato di circostanze

Gli esseri umani possiedono invece una ragione

universale, che permette loro di reagire

appropriatamente a qualsiasi circostanza si

ponga loro

«non si può concepire che [la macchina di cui

sopra] coordini le parole diversamente per

rispondere al senso di tutto ciò che si dirà in sua

presenza, come possono fare anche gli uomini

più ottusi»

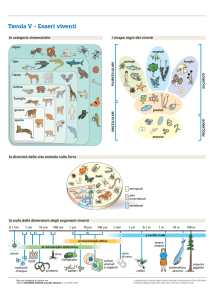

21 tipi diversi di tessuti

biologici, ognuno

caratterizzato da una

particolare “proprietà vitale”

La materia vivente si mantiene

tale nonostante le forze

fisiche che tendono a

distruggerla

In natura esistono forze non

fisiche, che Dio ha infuso nei

sistemi viventi

Xavier Bichat

(1771-1802)

Spiegazione del

comportamento dei sistemi

viventi nei termini di entelechia

– forza vitale non fisica, non

spaziale, qualitativa

Hans Driesch

(1867-1941)

Ineludibile

riferimento a una

qualche forma di

forza vitale per

spiegare il

comportamento

dei sistemi viventi

Il comportamento

dei sistemi viventi

può essere

spiegato in

termini

puramente

meccanici

Scoperte di natura concettuale: le macchine

possono manifestare capacità prima ritenute di

esclusiva pertinenza dei sistemi viventi

Le macchine possono generare

comportamenti imprevedibili

Le macchine possono apprendere

Le macchine possono avere scopi

Scoperte di natura concettuale: le macchine

possono manifestare capacità prima ritenute di

esclusiva pertinenza dei sistemi viventi

Le macchine possono generare

comportamenti imprevedibili

Le macchine possono apprendere

Le macchine possono avere scopi

+

+

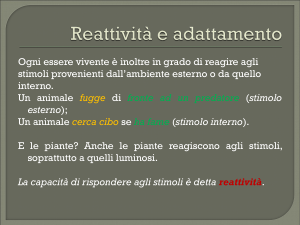

Tropismo positivo: il

sistema aumenta la

velocità del lato opposto

alla stimolazione

sensoriale, avvicinandosi

a esso

+

+

Tropismo negativo: il

sistema aumenta la

velocità del lato

corrispondente alla

stimolazione sensoriale,

allontanandosi da esso

Loeb (1900): spiegazione del

comportamento fototropico delle falene

Hammond and Meissner, 1912

«Mi sembra che l’effettiva costruzione di una

macchina eliotropica non fornisca sostegno

solo a una concezione meccanicistica delle

azioni volontarie e istintive degli animali, ma

anche alla mia teoria sull’eliotropismo, dato

che la teoria ha fornito le basi per la

costruzione della macchina.

(Loeb, 1918)

Possiamo sentirci a nostro agio nell’affermare

che non vi è maggior ragione di attribuire le

reazioni eliotropiche degli animali inferiori a

particolari forme di sensazione, per esempio

di intensità luminosa, di colore, di piacere, o

di curiosità, di quanta non ve ne sia di

attribuire le reazioni eliotropiche della

macchina del Sig. Hammond a sensazioni di

quel tipo»

(Loeb, 1918)

«L’instabilità delle forze vitali caratterizza

tutti i fenomeni vitali con un’irregolarità che li

distingue dai fenomeni fisici [che sono]

peculiari per la loro uniformità»

(Bichat, 1805)

William James, «Are we automata?» (1879):

opposizione tra automatismo e imprevedibilità

«Possiamo costruire [un sistema nervoso] che

reagirà in modo infallibile e certo, ma che sarà

per questo capace di reagire a un insieme molto

ristretto di cambiamenti ambientali.

D’altra parte possiamo costruire un sistema

nervoso potenzialmente adatto a rispondere a

una varietà infinita di minute caratteristiche della

situazione: ma la sua fallibilità sarà grande

quanto le sue capacità di elaborazione»

I veicoli di Braitenberg

Roberto Cordeschi, The Discovery of the Artificial.

Behavior, Mind and Machines Before and Beyond

Cybernetics, Kluwer Academic Publishers, Dordrecht

(2002)

“So a two-element synthetic animal is enough

to start with. The strange richness provided

by this particular sort of permutation

introduces right away one of the aspects of

animal behavior – and human psychology –

which M. speculatrix is designed to illustrate:

the uncertainty, randomness, free will or

independence so strikingly absent in most

well-designed machines.

Walter, W. G. (1950). An imitation of

life. Scientific American, 182(5), 42–45.

The fact that only a few richly interconnected

elements can provide practically infinite

modes of existence suggests that there is no

logical or experimental necessity to invoke

more than number to account for our

subjective conviction of freedom of will and

our objective awareness of personality in our

fellow men”

Walter, W. G. (1950). An imitation of

life. Scientific American, 182(5), 42–45.

L’imprevedibilità delle macchine «sta negli

occhi di chi guarda»:

◦ Il comportamento di semplici meccanismi che

reagiscono a cambiamenti ambientali può essere

imprevedibile se quei cambiamenti ambientali sono

imprevedibili

◦ Il comportamento di macchine dotate di molti

«tropismi» semplici sarà ancor più difficile da

prevedere

Scoperte di natura concettuale: le macchine

possono manifestare capacità prima ritenute di

esclusiva pertinenza dei sistemi viventi

Le macchine possono generare

comportamenti imprevedibili

Le macchine possono apprendere

Le macchine possono avere scopi

Secondo alcuni filosofi e fisiologi

del tempo, la reazione di una

macchina a certe condizioni

(ambientali o interne) è

determinata e immutabile

Le macchine non possono variare

nel tempo la loro risposta alle

stesse condizioni: non possono

apprendere

Anche gli animali più «semplici»

possono farlo, a vantaggio della

propria sopravvivenza

Il bambino non tocca per la seconda

volta il fuoco (James, 1890)

Come spiegare in termini

puramente meccanici la

capacità di

variare la risposta agli

stessi stimoli?

acquisire nuove

associazioni tra stimoli e

risposte?

Riflesso condizionato

Lo stimolo X (es: vista del cibo) evoca la risposta

R (es: salivazione)

Lo stimolo X è presentato più volte assieme allo

stimolo Y (es: suono di una campanella)

La presentazione di Y diventa progressivamente

in grado di evocare R anche senza la

presentazione di X

Apparente acquisizione di una nuova

associazione (tra Y e R): come spiegarla in

termini meccanici?

R

X

C1

C2

Y

nessuno stimolo nesssuna risposta

Z

R

X

stimolo X risposta R

C1

C2

Y

Z

R

X

+++

C1

---

Y

stimolo X risposta R

stimolo Y: C1 si carica elettricamente

C2

Z

R

X

+++

C1

---

Y

stimolo Y risposta R

C2

Z

R

X

C1

C2

Y

Z

C1 si scarica a ogni stimolo Y: il sistema «dimentica»

l’associazione tra Y e R

R

X

C1

C2

Y

Z

Cosa succederà se condizioniamo Z nello stesso modo

di Y?

Cosa succederà se a volte accompagniamo la

stimolazione Y (dopo il condizionamento) con la

stimolazione Z?

Scoperte di natura concettuale: le macchine

possono manifestare capacità prima ritenute di

esclusiva pertinenza dei sistemi viventi

Le macchine possono generare

comportamenti imprevedibili

Le macchine possono apprendere

Le macchine possono avere scopi

Una mosca sbatte per ore contro il vetro di una

finestra. Perché?

Interpretazione finalistica:

La «causa» sta nel raggiungimento di una certa

condizione futura (l’uscita dalla finestra, il

raggiungimento di fonti di luce, …)

Un evento futuro causerebbe dunque un

comportamento precedente a esso

Nessun meccanismo fisico può essere «mosso» da

eventi futuri

Quindi, le macchine non possono essere dirette a uno

scopo

Eppure la falena di Loeb e i robot di Grey

Walter tendono al raggiungimento di

condizioni future

◦ Sono «ostinati»: se li si allontana dall’obiettivo,

tenderanno ad avvicinarsi di nuovo a esso

◦ Se li facciamo partire da posizioni diverse,

tenderanno ad arrivare a destinazione seguendo

percorsi diversi

meccanismi a retroazione negativa: in grado

di ridurre continuamente la differenza tra lo

stato di cose corrente e uno stato desiderato

Esempi:

il regolatore di Watt

la macchina

fototropica di

Hammond e Miessner

i sistemi di

puntamento per le

armi contraeree della

II guerra mondiale

«Qualsiasi forma di comportamento rivolto a

uno scopo richiede retroazione negativa»

dall’obiettivo (es: fonte di luce) giunge al

sistema un segnale che ne determina

movimenti correttivi

Secondo RWB, se il sistema effettua

movimenti di correzione esagerati, ne

risulterà un comportamento oscillatorio

simile a quello dei pazienti con danno

cerebellare

«Abbiamo ristretto il senso dell’espressione

‘comportamento teleologico’ applicandola soltanto

alle reazioni orientate a uno scopo che sono

controllate dall’errore della reazione – ovvero, in ogni

momento, dalla differenza tra lo stato del sistema e

lo stato finale interpretato come obiettivo.

L’espressione ‘comportamento teleologico’ è dunque

sinonima dell’espressione ‘comportamento

controllato da retroazione negativa’, e attraverso una

connotazione sufficientemente ristretta ne guadagna

in precisione.

Sulla base di questa definizione limitata, la teleologia

non si oppone al determinismo bensì alla nonteleologia. Sia i sistemi teleologici sia quelli non

teleologici sono deterministici.

Principali obiezioni:

◦ I sistemi a retroazione negativa hanno sì un

obiettivo, ma è un obiettivo imposto dal progettista;

al contrario, i sistemi viventi sono in grado di

attribuirsi autonomamente obiettivi

◦ L’obiettivo è sensoriale. Un sistema di questo tipo

non è in grado di perseguire obiettivi di carattere

astratto o in assenza di segnali sensoriali.

Le macchine possono rappresentare

internamente aspetti dell’ambiente

Esempio ante litteram: il robot di Christopher

Longuet-Higgins (cit. in Johnson-Laird e in

Cordeschi 2002)

◦ Robot mobile su ruote

◦ Dispone al suo interno di una tavoletta delle stesse

proporzioni dell’ambiente in cui si muove - es: un tavolo

◦ Durante il movimento, grazie a un semplice dispositivo

meccanico, un cursore scorre sulla tavoletta interna in

una posizione corrispondente a quella del robot sul

tavolo

◦ Quando il cursore arriva al bordo della tavoletta il

sistema si ferma, evitando di cadere dal tavolo

La rappresentazione interna di una certa

caratteristica dell’ambiente può svolgere il

ruolo di segnale sensoriale interno

Il sistema può dunque reagire nel modo dei

sistemi a retroazione negativa anche in

assenza o in previsione di uno stimolo

sensoriale esterno, in qualche senso

«anticipandolo»

Es: il robot di Longuet-Higgins si ferma prima di cadere dal

tavolo sulla base di un segnale sensoriale interno

Le capacità di rappresentazione del robot di

Longuet-Higgins sono estremamente ridotte

Elementare circuito elettronico di memoria: il

flip-flop

Applicando un breve

stimolo a E1 il terminale

A2 si attiva,

e rimane attivato anche

dopo la fine dello

stimolo, finché non

viene stimolato E2

Il circuito «mantiene

memoria» dello stimolo

Una sequenza di flip-flop può fornire al

sistema la base per memorizzare numeri (in

numerazione binaria)

memoria degli odierni calcolatori digitali

stato del flip-flop 1

stato del flip-flop 2

stato del flip-flop 3

1

0

1

1

0

I valori di memoria (numeri) possono essere

interpretati come proposizioni, immagini, suoni,

...

I calcolatori odierni possono memorizzare testi

(dunque insiemi di proposizioni) rimanendo

essenzialmente sistemi numerici!

stato del flip-flop 1

stato del flip-flop 2

stato del flip-flop 3

1

0

1

1

0

Lo stimolo che attiva o

disattiva una certa cella di

memoria non deve

necessariamente provenire

da un sensore,

ma anche da altre parti

interne del sistema

meccanismi di

elaborazione di

rappresentazioni in

assenza di stimoli

sensoriali

apprendimento nei

calcolatori digitali

1

Riassumendo:

La memoria dei calcolatori digitali può

rappresentare «cose» di vario tipo: letture

sensoriali, proposizioni sul mondo esterno,

immagini, suoni rappresentare varie forme di

conoscenza

Gli stati della memoria del sistema possono

essere modificati automaticamente da altre parti

del sistema

Le rappresentazioni possono dunque essere

elaborate in modo automatico nei calcolatori

digitali

Esaminare “la congettura che ogni aspetto

dell’apprendimento o qualsiasi altra

caratteristica dell’intelligenza può in linea di

principio essere specificata con precisione

tale che diventi possibile costruire una

macchina che la simuli”

“Quello che propongo è … di partire da

attività più semplici, vale a dire da un

ambiente che non sia né ostile (ma solamente

indifferente) né complesso”, e di procedere

“attraverso passi non problematici” verso la

modellazione di “sistemi in grado di svolgere

le più avanzate attività umane – dimostrare

teoremi, comporre musica, o giocare a

scacchi”

Metodologia:

◦ trovare meccanismi per la risoluzione automatica di

problemi “semplici” in “ambienti non ostili”

◦ e provare ad applicarli a problemi meno semplici, e

in ambienti meno ostili

Metodi per la soluzione di rompicapi

“semplici” (la torre di Hanoi) e metodi per la

soluzione di rompicapi meno semplici

(giocare a scacchi, dimostrare teoremi,

interagire con l’ambiente)

La torre di Hanoi

Lupo-capra-cavolo

Manipolare rappresentazioni del problema

Raggiungere l’abitazione di un nostro amico

L’abitazione nostra e quella da raggiungere si

trovano entrambe in corrispondenza di un

incrocio

La città è fatta

a isolati

quadrati

Nord

Ovest

1

2

3

4

5

6

7

8

9

10

11

12

Sud

Est

Stato iniziale

Noi all’incrocio 12

Stato finale

Noi all’incrocio 2

Un NODO è una

rappresentazione

di uno stato di

cose

Noi all’incrocio 12

è possibile compiere al più quattro

operazioni: N, S, E, O

Per ognuna di queste operazioni

definiamo un operatore

Applicando l’operatore a uno stato di

cose, ne otteniamo un altro

◦ N sullo stato 12 8

S1

Noi allo

stato 12

N

S2

Noi allo stato 8

Consideriamo un insieme di stati S che

inizialmente corrisponde al solo stato

iniziale.

S = 12

12

Consideriamo un insieme di stati S che inizialmente

corrisponde al solo stato iniziale.

Generiamo e annotiamo tutti gli stati che risultano

dall’applicazione di tutte le operazioni ammissibili

a partire da ogni stato appartenente all’insieme S, e

chiediamoci se in questo insieme di stati risultanti

vi sia quello finale.

S = 12

N

8

12

O

11

Abbiamo trovato lo stato finale?

◦ No? Allora stabiliamo che l’insieme S costituisce non più

quello definito al passo 1, bensì l’insieme di tutti gli stati

generati al passo precedente; poi torniamo al punto 2.

◦ Sì? Allora annotiamo la sequenza di operazioni che, a partire

dallo stato iniziale, hanno permesso di raggiungere lo stato

finale. Questa sequenza di operazioni è la soluzione del

problema.

S = 12

S = {8, 11}

N

8

12

O

11

12

N

N

O

O

2

3

S

7

4

E

S

8

O

7

11

S

12

8

…

…

4

O

Soluzione = NNOO

N

O

O

2

3

S

7

4

E

S

12

N

8

O

7

11

S

12

8

…

…

4

O

Logic Theorist (Newell, Shaw, Simon 19551956)

General Problem Solver (Newell, Shaw, Simon

1957)

Programmi che eseguivano ricerche in alberi

di decisione per risolvere problemi di vario

tipo

◦ Dimostrazioni in logica proposizionale o predicativa

◦ Elaborazione del linguaggio naturale

◦ Esplorazione dell’ambiente

IA: intelligenza e cognizione come manipolazione

algoritmica di rappresentazioni

◦ Ricerche euristiche in alberi di decisione

◦ Ipotesi del sistema di simboli fisico (Newell e Simon)

Person: Pick up a big red block.

Computer: OK.

Person: Grasp the pyramid.

Computer: I don't understand which pyramid you mean.

Person (changing their mind): Find a block which is taller

than the one you are holding and put it into the box.

Computer: By "it", I assume you mean the block which is

taller than the one I am holding.

Computer: OK.

Person: What does the box contain?

Computer: The blue pyramid and the blue block.

Person: What is the pyramid supported by?

Computer: The box.

Person: How many blocks are not in the box?

Computer: Four of them.

Person: Is at least one of them narrower than the

one which I told you to pick up?

Computer: Yes, the red cube.

Turing (1950) considera la seguente tesi: “una

macchina non può mai fare qualcosa di

veramente nuovo”, ma solo ciò che le ordiniamo

di fare

Una variante migliore dell’obiezione dice che una

macchina non può mai ‘prenderci alla sprovvista’

Questa affermazione è una sfida più diretta e può

essere controbattuta direttamente. Le macchine

mi prendono alla sprovvista molto

frequentemente”

“Com’è comprensibile, abbiamo forti

reticenze ad attribuire la patente

d’intelligenza a una macchina che ci sembra

semplice. […]

Ci sono tuttavia delle situazioni in cui molte

delle nostre reticenze ad attribuire

intelligenza alle macchine vengono a cadere.

Di tanto in tanto, una macchina ci sembra più

capace e più efficace di quanto ci saremmo

aspettati in base a un esame superficiale delle

sue strutture.”

“Un simile evento ci stupisce e rimane impresso nella

nostra mente, e la sorpresa e l’impressione rimangono

in noi finché, mediante un’analisi o una ‘spiegazione’, il

senso di meraviglia poi non scompaia. […]

Allo stesso modo, i giudizi con i quali attribuiamo la

qualifica di intelligenza ad altri esseri umani dipendono

spesso da una nostra insufficienza analitica, e variano al

variare del nostro grado di comprensione.

Spesso scopriamo che un’attività che, svolta da altre

persone, ci pareva altamente intelligente, ci sembra

alquanto più banale quando noi stessi apprendiamo il

“trucco” che permette di praticarla”

Scoprire dimostrazioni di teoremi matematici,

comporre musica, progettare strutture

meccaniche e giocare a scacchi sarebbero

comunemente ritenute creative se il risultato

fosse originale e di alta qualità. …

… nessuno negherebbe che Whitehead e

Russell fossero creativi quando scrissero i

Principia Mathematica. Il loro libro è uno dei

prodotti intellettuali più significativi del

ventesimo secolo.”

“Se era creativo per Witehead e Russell scrivere

quei volumi, per il Logic Theorist può essere

creativo reinventarne larghe parti del secondo

capitolo, riscoprendo in molti casi proprio le

stesse dimostrazioni originariamente scoperte da

Whitehead e Russell. …

In almeno un caso, inoltre, il Logic Theorist ha

scoperto una dimostrazione di un teorema del

secondo capitolo che è più breve e più elegante

di quella pubblicata da Whitehead e Russell”

Supporto a una «concezione meccanicistica

della vita»

◦ macchina di Krueger

◦ robot di Grey Walter

Sostegno alla costruzione di teorie e al loro

controllo sperimentale

◦ Il cane fototropico di Hammond e Miessner vs. la

teoria di Loeb

◦ Newell e Simon

Sistema fisico B sul quale vengono condotti

esperimenti per controllare ipotesi

scientifiche a proposito di un altro sistema

fisico A

esperimenti su

Modello

conclusioni

teoriche su

Sistema

A

Simulazioni: macchine come modelli materiali

su cui svolgere esperimenti per trarre

conclusioni teoriche su un sistema vivente

esperimenti su

Macchina

conclusioni

teoriche su

Sistema

vivente

Sotto quali condizioni una macchina può

essere un «buon modello» per lo studio del

comportamento intelligente dei sistemi

viventi?

Simulazione: macchina il cui funzionamento è

fedelmente «basato» su una teoria

meccanicistica proposta per spiegare il

comportamento o una particolare capacità di

un sistema vivente

Il comportamento della macchina

(confrontato con quello del sistema vivente in

esame) fornisce basi empiriche per valutare la

plausibilità della teoria

sistema vivente V

formulazione

capacità CA

esibita da A nelle

condizioni EA

formulazione

confronto

spiegazione

descrizione di

meccanismo MA

capacità CV

esibita da V nelle

condizioni EV

spiegazione

controllo/scoperta

traduzione

descrizione di

meccanismo MV

istanziazione

istanziazione

sistema artificiale

A

La chemiotassi dell’aragosta

Le fonti di nutrimento degli

astici (es. molluschi)

rilasciano scie chimiche

nell’acqua

Gli astici sono in grado di

risalirle fino alla sorgente

In base a quale meccanismo?

“our efforts represent the first

study of chemo-orientation in

turbulence at the same spatial

scale and indeed in the same

exact task and conditions as

the model animal.”

Chemiotassi

dell’astice: capacità

CV di raggiungere la

sorgente chimica (=

nutrimento)

Se l’antenna destra

segnala maggior

concentrazione chimica di

quella sinistra, il crostaceo

compie una piccola

deviazione verso destra

Viceversa per il lato

sinistro.

Se invece entrambe le

antenne percepiscono

identica concentrazione,

allora l’animale prosegue

dritto davanti a sé.

sistema vivente V

formulazione

capacità CA

esibita da A nelle

condizioni EA

formulazione

confronto

spiegazione

capacità CV

esibita da V nelle

condizioni EV

spiegazione

descrizione di

meccanismo MA

descrizione di

meccanismo MV

traduzione

istanziazione

istanziazione

sistema artificiale

A

sistema vivente V

formulazione

capacità CA

esibita da A nelle

condizioni EA

formulazione

confronto

spiegazione

capacità CV

esibita da V nelle

condizioni EV

spiegazione

descrizione di

meccanismo MA

descrizione di

meccanismo MV

traduzione

istanziazione

istanziazione

sistema artificiale

A

RoboLobster

sistema vivente V

formulazione

capacità CA

esibita da A nelle

condizioni EA

formulazione

confronto

spiegazione

capacità CV

esibita da V nelle

condizioni EV

spiegazione

descrizione di

meccanismo MA

descrizione di

meccanismo MV

traduzione

istanziazione

istanziazione

sistema artificiale

A

destinazione

partenza

60 cm

Distanza tra il punto di

partenza e la sorgente

chimica:

OK

100 cm

no

60 cm

100 cm

Perchè RoboLobster non è riuscito a

raggiungere la sorgente chimica da una

distanza di 100 cm?

◦ A causa dell’orientazione iniziale?

no

◦ A causa della distanza tra i sensori?

no

Il gradiente di concentrazione

non fornisce informazioni

sufficienti per guidare il

comportamento dell’aragosta

Il comportamento dell’aragosta

non può essere spiegato sulla

base del meccanismo ipotizzato

sistema vivente V

formulazione

capacità CA

esibita da A nelle

condizioni EA

formulazione

confronto

spiegazione

capacità CV

esibita da V nelle

condizioni EV

spiegazione

descrizione di

meccanismo MA

descrizione di

meccanismo MV

traduzione

istanziazione

istanziazione

sistema artificiale

A

indipendenza dal supporto materiale:

nessuna ragione di principio per negare che

sistemi distinti (viventi/non viventi)

implementino lo stesso meccanismo

Quali criteri per valutare se due sistemi

particolari A e V implementano lo stesso

meccanismo?

Dettagli implementativi: caratteristiche del

sistema artificiale che non sono vincolate

dall’ipotesi teorica

… ma che ciò nonostante hanno un impatto

sul comportamento del sistema

Esempio: distanza tra le antenne di

RoboLobster

Quali sono le

caratteristiche di

una “buona

spiegazione” nelle

scienze cognitive?

capacità CV

esibita da V nelle

condizioni EV

spiegazione

descrizione di

meccanismo MV

Astrazione e circostanze al

contorno

◦ Ambientali

Altri stimoli chimici?

Turbolenza dell’acqua?

◦ Fisiologiche

Assunzione di modularità: sistema

“isolato” rispetto all’influsso di altre

parti del sistema nervoso

Astrazione e circostanze al contorno in

Intelligenza Artificiale

◦ “Quello che propongo è di partire da attività più

semplici, vale a dire da un ambiente che non sia

né ostile (ma solamente indifferente) né

complesso” (Dartmouth 1956)

Descrizioni di oggetti

◦ es: la descrizione del meccanismo neurale che

permette ai ratti di orientarsi nei labirinti

Ruolo prevalentemente esplicativo e

predittivo

I modelli incorporano quote di astrazione e

idealizzazione rispetto all’oggetto descritto

In che senso un modello teorico astratto

può contribuire a spiegare il

comportamento di un sistema “concreto”?

Astrazione e circostanze al contorno

ambientali, fisiologiche, …

Anche l’explanandum è idealizzato!

◦ Explanandum: “Perché gli astici riescono

così efficientemente a raggiungere la

sorgente della scia chimica?”

◦ Troppo “semplicistico”: nemmeno gli astici

veri riescono sempre a raggiungere le

sorgenti chimiche!

Explanans idealizzato per

explanandum idealizzato

Astrazione e scelta di un particolare

livello di analisi

◦ Ipotesi: relazione tra stimoli sensoriali e

risposte motorie

◦ Grana molto “larga”: nessun riferimento ai

componenti intermedi che assicurano il

collegamento tra stimolazioni sensoriali e

risposte motorie. Es:

Meccanismi di controllo delle zampe

dell’animale?

Meccanismi chimici che assicurano il buon

funzionamento dei circuiti neurali?