6

Introduzione al Value at Risk

per i rischi di mercato

6.1 Metodi convenzionali – 6.1.1 Introduzione al Value at Risk – 6.1.2 Il VaR

e l’approccio delta – 6.1.2.1 Il modello prezzo-rendimento – 6.1.2.2

L’intervallo di confidenza – 6.1.2.3 L’orizzonte temporale – 6.1.2.4 Previsione

della volatilità – 6.1.2.5 L’approccio delta-normal: mapping dei flussi e

criticità – 6.1.3 Il VaR in opzioni e l’approccio delta-gamma: cenni – 6.1.4

Simulazioni storiche – 6.1.5 Simulazione MonteCarlo – 6.1.6 L'analisi degli

scenari (stress test) – 6.1.7 I limiti dei metodi convenzionali - 6.1.8 La teoria

dei valori estremi: cenni – 6.2 Gli utilizzi della metodologia del Value-at-Risk

– 6.3 Utilizzo delle misure VaR: criticità – 6.4 I modelli interni ai fini della

vigilanza – 6.4.1 Introduzione – 6.4.2 Procedura di riconoscimento – 6.4.3

Requisiti patrimoniali nell’ottica di Vigilanza – 6.4.4 Per una vigilanza

incentive-compatible nello sviluppo dei modelli interni - 6.4.5 Prove di stress Appendici al capitolo cap. 6 – Appendice 6.A Value at Risk di un portafoglio

azionario - Appendice 6.B Requisiti a fronte dei rischi di posizione su titoli, di

cambio e di posizioni su merci – Appendice 6.C Requisiti qualitativi dei

modelli interni

6.1 Metodi convenzionali

6.1.1

Introduzione al Value at Risk

I Modelli Valore a rischio (VaR) rappresentano un tentativo di

misurare il rischio di mercato associato all’intero portafoglio di

attività di una istituzione finanziaria mediante un’unica misura

quantitativa.

A differenza dei sistemi di misurazione tradizionali (ad esempio

duration e convexity per i titoli a reddito fisso; le lettere greche per

le opzioni) che tendono a focalizzare l’attenzione sui rischi dei

singoli strumenti in maniera isolata, ignorando gli effetti della

correlazione, il VaR riassume tramite un singolo numero, che

esprime una misura monetaria, il rischio di mercato globale

288 Capitolo 6

dell’istituzione, tenendo in considerazione l’interdipendenza tra i

singoli tipi di rischio.

Il concetto alla base del modello consiste nel voler misurare

statisticamente il rischio di mercato associato ad una determinata

attività finanziaria. Si definisce, pertanto, il valore a rischio come la

massima perdita attesa che una certa posizione può subire a fronte

di movimenti avversi dei fattori di rischio rilevanti in un

determinato orizzonte temporale in corrispondenza di un certo

intervallo di confidenza.

Ciò comporta per le istituzioni finanziarie il passaggio da una

classificazione delle posizioni di bilancio per categorie di strumenti

finanziari (azioni, obbligazioni, opzioni, ecc.) a una classificazione

per categorie di rischio (tassi di interesse, tassi di cambio, prezzi o

indici azionari, ecc.).

Per ogni categoria di rischio è, pertanto, possibile quantificare

l’esposizione complessiva al rischio mediante la seguente relazione

basata sulle assunzioni di metodi parametrici:

VAR ( MM (r ))( ) t

[6.1]

dove MM esprime il valore delle posizioni, la sensibilità del

valore della posizione rispetto ad un fattore di rischio specifico, (r)

il suddetto fattore di rischio, la volatilità identificata come la

deviazione standard dei rendimenti rispetto al loro valore medio ed

è la costante che individua l’intervallo di confidenza (una coda)

di una distribuzione normale standardizzata e t l’holding period.

Per una maggiore comprensione della formula, supponiamo di

misurare il VaR giornaliero di un investimento in zero coupon

bond per un importo di 50 milioni di euro con vita residua 15 anni,

tasso di rendimento effettivo a scadenza 6,35%. Nella fattispecie il

è rappresentato dalla duration modificata ed è pari a 14 anni,

mentre la volatilità dei tassi è dello 0,30%. Il calcolo del VaR viene

implementato in due fasi: nella prima, si verifica la sensibilità

dell’esposizione dell’investimento al rischio di mercato attraverso

la ponderazione del market to market della posizione al fattore di

rischio r)); nella seconda, si focalizza l’attenzione sulla

variabilità, espressa in funzione delle previsioni di volatilità

giornaliera del tasso. Pertanto, ipotizzando una distribuzione

Introduzione al Value at Risk per i rischi di mercato 289

normale dei tassi di interesse ed un intervallo di confidenza di

2,33 la massima variazione del prezzo attesa in un giorno nel 99%

dei casi è:

VaR =(50*14,104*0,0635*2,33*0,30)= 3,130 mln di euro

Il che equivale ad affermare che le oscillazioni del prezzo

giornaliero si dovrebbero mantenere nell’area indicata dalla stima

del VaR nel 99% dei casi e solo nel 1% le perdite potranno risultare

superiori a 3,130 milioni di euro. Tale sistema di misurazione

consente, pertanto, non solo di riassumere attraverso un singolo

numero il rischio di una posizione ma di comparare i rischi di

mercato fra posizioni diverse all’interno della stessa banca e fra

banche diverse.

A titolo esemplificativo, supponiamo che la banca A presenti un

VaR giornaliero (ossia riferito a un holding period di un giorno) di

50 milioni di euro in corrispondenza di un intervallo di confidenza

del 95%, mentre la banca B rileva un VaR settimanale di analogo

importo per un eguale livello di confidenza del 95%. Quale

portafoglio delle due banche risulta essere più rischioso? La banca

A sarà soggetta ad una massima perdita probabile di 50 milioni di

euro ogni 20 giorni; la banca B presenta un profilo di rischio pari

ad una massima perdita probabile di 50 milioni di euro ogni 20

settimane, ciò significa che il rischio di mercato con riferimento a

periodi di osservazione rispettivamente di 20 giorni e di 20

settimane sottostima le perdite effettive non più di una volta (20 x

0,05). La banca A è, pertanto, esposta a perdite superiori ai 50

milioni di euro 12,5 volte in un anno (ossia 250/20, il che equivale

al 5% di 250 con manifestazione temporale ogni 20 giorni), mentre

la banca B 2,6 volte l’anno (52/20). Questo non significa, però, che

l’intermediario A rilevi una rischiosità 4,8 (12,5/2,6) volte

superiore a quella di B.

Ai fini di una efficace confronto dei valori forniti dal modello

VaR, la stima ottenuta dalle due banche dovranno essere proiettate

in un periodo di osservazione omogeneo, nel caso specifico un

anno. Per cui con t = 1 anno e = 95%, la perdita massima

probabile per A è di 793,7 milioni di euro in un anno, mentre per B

è di 360,55 milioni di euro. L’intermediario A dispone, pertanto, di

290 Capitolo 6

un portafoglio due volte circa più rischioso di quello di B. Dal

punto di vista metodologico, per la quantificazione dell’esposizione

al rischio occorre formulare alcune ipotesi:

sulla forma della distribuzione di probabilità;

sull’intervallo di confidenza;

sull’orizzonte temporale.

Per quanto concerne la forma della distribuzione di probabilità

dei rendimenti di periodo si assume o meno, a seconda dei modelli,

una forma della funzione di distribuzione dei movimenti attesi dei

rendimenti con possibilità di applicare soluzioni parametriche o di

valutare direttamente la distribuzione di frequenze dall’analisi dei

dati per la metodologia di calcolo del valore a rischio.

La scelta dell’intervallo di confidenza esprime il grado di

protezione desiderato nei confronti di movimenti avversi nei fattori

di mercato rilevanti, ossia la percentuale di copertura che si intende

garantire rispetto agli eventi indesiderati. Gradi di protezione

differenti riflettono livelli diversi d’avversione al rischio da parte di

un intermediario e costi diversi connessi alla probabilità di

variazione del prezzo superiore a quello stimato dal VaR.

Occorre, infine, definire l’orizzonte temporale lungo il quale

misurare la perdita1. A tale scopo, vengono presi in considerazione

fattori di tipo oggettivo, indipendenti dalle aspettative della banca o del

singolo operatore, come, ad esempio, lo spessore e la profondità del

mercato nel quale lo strumento viene negoziato. In altri termini, la

liquidabilità dello strumento stesso, definito come tempo

necessario ai fini di una normale transazione o ai fini di una

copertura della posizione. Un secondo fattore che può essere

E’ intuitivo come la scelta del periodo di osservazione influenzi direttamente la misura del

valore a rischio. Un breve orizzonte temporale riflette correttamente gli andamenti recenti del

mercato, ma proprio a causa di questa estrema fedeltà, o rispondenza, a ciò che è accaduto

nell’immediato passato il valore a rischio potrebbe venire determinato in modo scorretto, in

particolare se sul mercato imperversassero situazioni turbolente o fortemente volatili: in questo caso

la misura del valore a rischio sarebbe sovrastimata.

Al contrario, un periodo di osservazione più lungo, nel caso di squilibri negli andamenti dei

fondamentali, medierebbe la misurazione del rischio con i dati più lontani nel tempo, appartenenti a

momenti di normalità dei mercati, anche se in questo caso si tratterebbe di un modello meno sensibile

ai mutamenti dello scenario ambientale.

1

Introduzione al Value at Risk per i rischi di mercato 291

considerato nella determinazione dell'orizzonte temporale è invece

di tipo soggettivo, nel senso che scaturisce direttamente dagli

obiettivi del singolo operatore e/o dell'istituzione finanziaria. Si

tratta del periodo di detenzione (holding period) della singola

posizione. In tal senso, una posizione di trading, assunta con

un'ottica di tipo speculativo di brevissimo periodo, dovrebbe essere

valutata con un orizzonte temporale più breve rispetto a quello

relativo ad una posizione, sul medesimo strumento finanziario,

considerata di investimento (e, dunque, misurata su un orizzonte di

tempo più lungo).

6.1.2

Il VaR e l’approccio delta

Tra i diversi metodi di calcolo del VaR quello più applicato

presso le istituzioni finanziarie è il “metodo delle varianze e

covarianze”, a volte chiamato anche metodo analitico o

parametrico. Esso rappresenta la versione originale dei modelli

VaR ossia quella sviluppata per prima e, come tale, quella più

rapidamente diffusasi presso le banche anglosassoni.

I modelli appartenenti a questa categoria si caratterizzano per

due principali elementi. Anzitutto, il rischio viene misurato sulla

base della sensibilità della posizione (portafoglio di posizioni) a

variazioni dei fattori di mercato, e del grado di correlazione fra gli

stessi. La determinazione del livello di confidenza desiderato è

subordinata all’ipotesi di una distribuzione normale delle

variazione dei rendimenti della posizione o del portafoglio.

La diffusione del metodo parametrico nell’ambito dei sistemi di

Risk Management si riconduce al modello probabilistico Risk

Metrics, elaborato e messo a disposizione della comunità

finanziaria da J.P. Morgan2 per la valutazione e gestione del rischio

2

Nelle intenzioni di J.P. Morgan la metodologia di Risk Metrics è stata resa di pubblico

dominio per tre principali motivazioni:

Interesse a promuovere una maggiore trasparenza in materia di rischi di mercato;

Stabilire un benchmark, un indice di riferimento, un comune termine di paragone per

la misura dei rischi di mercato;

Rendere disponibili sofisticati strumenti di misurazione del rischio al altri potenziali

utenti, operatori del mercato, che non hanno le risorse e le capacità per sviluppare

propri sistemi di misurazione .

Cfr. J.P. Morgan, Technical Document (1996).

292 Capitolo 6

di mercato generato da portafogli composti da attività finanziarie a

reddito fisso, titoli azionari, tassi di cambio, merci e da tutti i

prodotti derivati collegati a queste attività. A tale modello si

ispirano i tanti prodotti sviluppati dalla software industry.

Si fa notare, che l’approccio varianze-covarianze si caratterizza

per una certa semplicità, relativa, non tanto al profilo concettuale,

quanto all’onerosità dei calcoli e dunque dei sistemi informativi di

supporto. A fronte di tali vantaggi, l’approccio in questione

presenta diverse critcità , principalmente legate all’impianto teorico

che sta alla base dell’intera metodologia di calcolo del VaR di una

posizione o di un portafoglio di posizioni. Tali ipotesi riguardano in

particolare due aspetti:

la distribuzione dei rendimenti dei fattori di mercato;

il grado di sensibilità delle posizioni di rischio al variare dei

fattori di mercato.

6.1.2.1 Il modello prezzo-rendimento

Un’ipotesi alla base del modello riguarda proprio i movimenti

dei prezzi; che si muovono in modo casuale e con una distribuzione

delle variazioni assimilabile a una funzione di tipo normale

standardizzata:

Per valutare analiticamente i movimenti potenziali dei prezzi, e

la loro incidenza sul valore delle posizioni in portafoglio, in modo

da ottenere una misura della massima perdita potenziale, si ipotizza

di misurare il rischio in termini di variazioni di prezzo, espresse

come rendimenti logaritmici.

Il rendimento di un singolo strumento3 viene pertanto definito

con la seguente espressione:

3

Per descrivere i cambiamenti nelle variabili di mercato, data una serie storica P t dei prezzi di

una attività finanziaria, il logaritmo del rapporto tra il prezzo al tempo t e il prezzo al tempo t-1, per

piccoli cambiamenti, si approssima alle variazioni percentuali del prezzo (P t-Pt-1)/Pt. Data, ad

esempio, una serie composta da 3 prezzi relativi ad un ipotetico titolo, (P 1 = 100, P2 = 108, P3 = 100),

le variazioni percentuali rispettivamente al tempo 2 e al tempo 3 risultano differenti, sebbene il valore

iniziale e quello finale siano coincidenti (P 2-P1)/P1= 8% e (P3-P2)/P2 = -7,4%. Esprimendo i

rendimenti alle epoche 2 e 3 con l’operatore logaritmico, si osserva che essi tendono ad assumere

valori che si approssimano essendo ln(108/100)=7,696 e ln(100/108)=-7,696.

Introduzione al Value at Risk per i rischi di mercato 293

rt ln

Pt

Pt 1

[6.2]

dove rt è il rendimento al tempo t e P è il prezzo di uno strumento

finanziario valutato rispettivamente in t e t-1: pertanto, il

rendimento di un portafoglio (rpt) composto da n strumenti

finanziari analiticamente è dato:

n

r pt w i r it

[6.3]

i 1

ove wi rappresenta il peso del rendimento logaritmico dell’i esima

attività.

Tale scelta è da attribuirsi alle proprietà statistiche della

distribuzione di r nel tempo che si configura come una

distribuzione di tipo normale.

Il prezzo di un’attività finanziaria risulta coerente con un

processo diffusivo continuo di tipo logaritmico qui di seguito

descritto:

r it i t i ,t i ,t t

[6.4]

ove i è il rendimento annuo atteso dell’attività iesima per una

unità di tempo; t è un intervallo di tempo; i,t è la volatilità del

prezzo dell’attività iesima al tempo t ed è una estrazione casuale di

una distribuzione normale standardizzata, ossia una distribuzione

normale con media nulla e deviazione standard pari a 1, del

rendimento dell’attività iesima. Si ha, quindi, che t è il tasso di

rendimento atteso e t rappresenta la componente stocastica

(ossia la variabilità del sentiero temporale seguito da rit ).

L’assunzione è che le variazioni del tasso di rendimento in un

breve periodo di tempo t siano le stesse, indipendentemente dal

livello dei prezzi dell’azione.

294 Capitolo 6

Per un portafoglio composto da tre titoli, per volatilità di tempo

più prolungate rispetto a quella giornaliera, la stima del VaR è

misurabile con il seguente metodo di calcolo4.

Dato la sequenza dei rendimenti dei tre titoli:

r 1, t 1 t 1,t 1,t t

r 2, t 2 t 2, t 2, t t

r 3, t 3 t 3, t 3, t t

[6.5]

il rendimento del portafoglio è dato

r p ,t w 1r 1,t w 2 r 2,t w 3 r 3,t

e la varianza

[6.6]

2 p , t w 2 1 2 1, t w 2 2 2 2, t w 2 3 2 3, t 2w 1w 2

12, t

2w 2 w 3

23, t

2w 1w 3

13, t

[6.7]

ove:

w 1 , w 2 , w 3 sono le quote di portafoglio investite nei tre titoli;

21 , 2 2 , 2 3 sono rispettivamente le varianze dei rendimenti dei

singoli titoli;

12 , 23 , 13 indicano le correlazione5 rispettivamente tra il

rendimento della posizione 1 con la 2, della posizione 2 con la 3 e,

infine, della posizione 1 con la 3.

4

Risk Metrics (1996), p. 72.

Il coefficiente di correlazione tra la variabile x e la variabile y applicato nei metodi parametrici

è dato dalla seguente formula:

5

Covarianza (x, y)

Varianza (x) * Varianza (y)

coeff. Corr.

La covarianza, espressione del movimento congiunto di due variabili, è data dalla seguente

espressione:

( xi x )( yi y )

Cov ( x, y )

i

n

dove:

xi = valore i-esimo assunto dalla variabile x

yi = valore i-esimo assunto dalla variabile y

x = valore medio della variabile x

y= valore medio della variabile y

n = numero delle osservazioni nel campione

Una covarianza positiva indica che le due variabili sono caratterizzate da variazioni di segno

uguale rispetto alla propria media (entrambe al rialzo o entrambe al ribasso).

Se le due variabili seguono percorsi inversi, invece, la covarianza assume valori negativi. Infine,

se le due variabili sono tra loro indipendenti, la covarianza è nulla. La covarianza tra due variabili x e

y può esprimersi anche con la formula seguente :

Introduzione al Value at Risk per i rischi di mercato 295

Nel caso di n titoli la volatilità del portafoglio è, pertanto,

espressa dalla varianza:

p

n

w

i 1

2

i

ˆ 2 i 2

w w ˆ ˆ ˆ

i

j

i

j

ij

[6.8]

ove

wi è la quota di portafoglio investita nell’attività i esima;

2 i è la Varianza del rendimento dell’attività iesima;

ij è il grado di correlazione tra il rendimento della posizione

iesima e di quella jesima6.

Il calcolo del valore a rischio di un portafoglio di più posizioni,

si fonda sulla teoria di portafoglio originariamente sviluppata da

Markowitz7, e comporta l’analisi dei coefficienti di correlazione fra

i rendimenti delle singole posizioni che compongono il portafoglio.

La determinazione del VaR di un portafoglio costituito da più

posizioni finanziarie è agevole quando il portafoglio si compone di

un numero limitato di attività finanziarie, mentre presenta delle

Cov ( x, y ) x y yx

dove xy indica il coefficiente di correlazione fra le due variabili. Esso assume valori compresi

tra –1 e +1.

Se xy = +1 le due variabili sono caratterizzate da correlazione perfetta positiva, ossia le

variazioni al rialzo di una variabile sono contestuali ad analoghe variazioni al rialzo dell’altra.

Se xy = -1 le due variabili sono caratterizzate da correlazione perfetta negativa, ossia le due

variabili seguono percorsi esattamente opposti.

Se xy = 0 le due variabili sono fra loro indipendenti.

Dalla formula sopraindicata si ha che il coefficiente di correlazione () è dato dalla seguente

espressione:

xy

Cov( x, y )

yx

x y

x y

6

Il grado di correlazione si desume dalla covarianza delle posizioni iesima e jesima con il prodotto

tra la deviazione standard della posizione iesima e quella della posizione j esima, cioè ij = ij/ij da cui

risulta che ij

7

I fondamenti dell’analisi moderna del rischio sono contenuti in un famoso lavoro del 1952 del

premio Nobel Harry Markowitz, dedicato ai principi per la selezione di portafoglio. Markowitz, in

tale lavoro, ha mostrato la rilevanza di una politica di diversificazione del portafoglio come

strumento per la riduzione del rischio e ha identificato i criteri sulla base dei quali un investitore

razionale dovrebbe compiere le proprie scelte di portafoglio.

296 Capitolo 6

complessità di calcolo quando esso risulta essere caratterizzato

dalla presenza di un numero considerevole di strumenti.

Nell’ipotesi di un portafoglio costituito da un numero elevato di

strumenti finanziari, si rende necessario ricorrere all’algebra

matriciale la quale richiede il calcolo di numerose correlazioni (in

numero pari a [n2-n]/2), che può risultare notevolmente oneroso.

In alternativa, selezionati alcuni fattori di rischio di mercato

(tassi di interesse, di cambio, prezzi azionari), è possibile misurare

la volatilità sulla base dei coefficienti di correlazione fra i

rendimenti dei diversi fattori di mercato caratterizzati da una

distribuzione normale congiunta.

In altri termini, selezionate n variabili di mercato, il prezzo di

ogni strumento contenuto nel portafoglio viene espresso come una

funzione lineare del fattore di rischio. Il valore del portafoglio è,

pertanto, la sommatoria del valore dei singoli strumenti :

Posta, quindi, l'ipotesi di normalità della distribuzione dei

rendimenti dei fattori di rischio (i) e di linearità delle relazioni fra

i prezzi delle posizioni e i fattori di mercato, si può assumere che

anche i rendimenti di un portafoglio siano distribuiti normalmente.

Ne consegue che le volatilità risultano proporzionali

i i

[6.9]

e le correlazioni invariate

i , j

[6.10]

Analiticamente la volatilità del portafoglio è uguale a:

p

n

i 1

2

i

i2 2

(

i

i)( j j) ij

[6.11]

ove i j rappresentano le singole sensibilità delle variazioni

delle posizioni a variazioni del fattori specifici di mercato.

In particolare, applicando tale formula al calcolo del VaR di un

portafoglio composto da diversi strumenti finanziari, avremo:

Introduzione al Value at Risk per i rischi di mercato 297

VAR p

VM VM

i

i

j

i

i

j

j j ij

1/ 2

[6.12]

cioè

VAR p VAR 12 VAR 22 .... 2VAR 1 VAR 2 12 .....

1/ 2

[6.13]

dove

VAR p Value at Risk del portafoglio

VARi Value at Risk della posizione iesima.

6.1.2.2

L’intervallo di confidenza

La scelta dell’intervallo di confidenza esprime la probabilità di

possibili variazioni sfavorevoli dei fattori di mercato; il livello del

grado di protezione scelto rappresenta, quindi, una misura dello

scenario pessimistico (worst case scenario). Ad elevati intervalli di

confidenza si associa una misura delle perdite che raramente

dovrebbero eccedere il valore a rischio stimato. L'ipotesi di

distribuzione normale dei rendimenti consente di tradurre il fattore

α prescelto nel grado di confidenza della misura di rischio ottenuta

e viceversa8.

Posto che la funzione matematica che descrive l’andamento dei

rendimenti giornalieri s’identifica in letteratura nella curva di tipo

normale, in cui i casi estremi sono i più rari e i valori centrali sono i

più frequenti, analiticamente si ha:

f (x)

1

2

2 x

1

e 2

2

[6.14]

8

Si precisa, che la possibilità di associare intervalli di confidenza a multipli della deviazione

standard non riguarda esclusivamente la distribuzione normale.

298 Capitolo 6

dove f(x) rappresenta la funzione di densità, e indicano

rispettivamente la media e la deviazione standard della variabile

casuale x9.

La funzione di densità f(x) può essere utilizzata per stimare la

probabilità che la variabile considerata (x) assuma un valore

compreso in un dato intervallo. A tal fine è sufficiente ricorrere al

calcolo dell'integrale della funzione in corrispondenza

dell'intervallo desiderato.

Per rendere più semplice il calcolo dell’integrale si procede ad

una standardizzazione della variabile casuale. La standardizzazione

di una variabile casuale consiste nell’esprimere gli scarti (x-) in

unità di:

x

[6.15]

tale che N (0,1)

per cui x

La media e la varianza della variabile casuale standardizzata

sono pertanto:

E ( x ) E ()

[6.16]

V ( x ) V ( ) 2 2

Si può, quindi, calcolare la probabilità che la variabile casuale

standardizzata (x) assuma valori compresi in un certo intervallo.

Risulta, infatti, che:

9

Gli altri termini della relazione risultano essere valori costanti, essendo =3,14 ed e exp 2,718;

il fattore 1 (2) è una costante che permette di rendere l’area totale sottesa alla funzione f(x) pari

all’unità, mentre il numero e, la base del logaritmo Neperiano o naturale descrive l’andamento

campanulare e simmetrico della curva. La funzione di densità è simmetrica rispetto alla retta x=

cresce da 0 a 1

(2) per x che passa da

a decresce da 1

(2) a zero per x che passa

da a ; ha due flessi, ascendente il primo e discendente il secondo, rispettivamente nei punti

e .

Introduzione al Value at Risk per i rischi di mercato 299

il 66% della distribuzione delle frequenze è compreso in

valori di = +1 ed

il95% è compreso in valori di = +2 ed = -2.

Ciò equivale a dire che la probabilità, che una variabile casuale

assuma valori ricompresi intorno alla sua media, più o meno la

deviazione standard presa una volta, è del 68%; ovvero, la

deviazione standard presa una volta ci fornisce la misura del raggio

intorno alla media nel quale è atteso il 68% degli eventi.

Figura 6.1

E’ possibile pertanto definire il numero delle deviazioni

standard per cui l’area sottostante alla coda destra o sinistra sia pari

a c10.

c Pr ob(X q) f ( x )dx

q

[6.17]

ove

10

Volendo stimare i movimenti attesi dei tassi di interesse con media 1% e volatilità 12%

compresi in un intervallo =+2 ed =-2, abbiamo

xmin=1%-2*12%=-23%

xmax=1%+2*12%=+25%

Ciò equivale a dire che per un dato intervallo di confidenza, ossia = -2; = +2, vi è una

probabilità del 95% che il valore atteso dei prezzi subisca una variazione minima del 23% e massima

del 25%, ed una probabilità del 5% che il prezzo possa assumere una variazione in valore assoluto

superiore alla percentuale stimata.

300 Capitolo 6

x = variabile casuale

q = probabilità sufficientemente piccola

Occorre a questo punto precisare che, pur considerando l'intera

gamma dei possibili rendimenti, se la finalità è quella di

determinare le perdite potenziali e dunque il valore a rischio della

posizione, va tenuto conto che ciascuna di questa è esposta

esclusivamente a metà degli eventi racchiusi nella distribuzione di

probabilità. E’ necessario, quindi, considerare rispettivamente la

sezione della coda destra, per le posizioni corte esposte al rischio di

un rialzo dei prezzi, e la sezione sinistra, per le posizioni lunghe

sensibili a una diminuzione dei prezzi. Ne consegue che il livello di

protezione associato a un certo multiplo della deviazione standard è

più elevato rispetto alle possibilità di considerare sia gli eventi

favorevoli che quelli sfavorevoli.

Scegliere di prendere 2 volte la deviazione standard significa

considerare il 95% degli eventi possibili intorno alla media. Poiché

il restante 5% si distribuisce equamente negli estremi della curva

solo nel 2,5% dei casi si manifestano eventi fortemente avversi.

I livelli di protezione corrispondenti ai diversi multipli di

deviazione standard sono riassunti nella tabella che segue.

Tabella 6.1

PERCENTILE

VALORE

99.99

99.9

99

97.72

97.5

95

90

-3.715

-3.090

-2.326

-2.000

-1.960

-1.645

-1.282

84.13

50

-1.000 0.000

La scelta dell’intervallo di confidenza 11 è funzione del grado di

avversione al rischio dell’investitore: una maggiore avversione

spinge a selezionare un multiplo della volatilità superiore in modo

da ottenere un maggior grado di protezione e, di converso, una

minore probabilità di realizzare una perdita superiore a quanto

11

In Risk Metrics viene utilizzato un intervallo di confidenza del 90% (1,282 volte la deviazione

standard) che lascia ai movimenti avversi una probabilità di verificarsi del 5%. Questa misura può

anche essere interpretata in un modo diverso ed attribuendogli un altro valore informativo: infatti, il

5% degli eventi non coperti implica che si dovrebbe verificare una forte perdita all’incirca ogni 20

giorni lavorativi; se si decidesse di coprire il 99% degli eventi probabili, bisognerebbe attendere in

media 100 giorni lavorativi per poter accertare la bontà della stima.

Introduzione al Value at Risk per i rischi di mercato 301

stimato con il VaR. Ne consegue che in mercati efficienti ciò si

riflette in un minor premio a rischio richiesto dagli investitori,

quindi, in una riduzione del costo dei mezzi propri.

6.1.2.3

L’orizzonte temporale

Per il calcolo del Valore a Rischio occorre definire l'orizzonte

temporale futuro lungo il quale si desidera misurare la perdita

potenziale.

Per la definizione dell’orizzonte temporale, occorre prendere in

considerazione, da un lato, i fattori che incidono sulla liquidabilità

dello strumento, ossia lo spessore, la profondità e la dimensione

del mercato nel quale lo strumento viene negoziato, dall’altro, le

strategie dell’operatore.

Il grado di liquidità di una posizione dipende dal tempo

necessario per una normale transazione, ossia dalla microstruttura

del mercato e dalla dimensione della transazione stessa, giacché

importi elevati rendono meno liquida la posizione. Posizioni

relativamente modeste in titoli benchmark sono facilmente

smobilizzabili; circostanze, invero, non replicabili qualora

l’importo della transazione assuma valori di gran lunga superiore ai

volumi medi giornalieri negoziati.

Per quanto riguarda le strategie, l’operatore può operare in

un’ottica speculativa e di investimento. Portafogli di trading

devono essere naturalmente valutati su un orizzonte giornaliero;

viceversa, per portafogli di investimento è necessario scegliere

holding period più lunghi.

Si discute se la scelta di un arco temporale prolungato soffra o

meno di una minore significatività di natura informativa dei dati.

L’ampiezza dell’arco temporale di previsione dipende dalla

frequenza con cui vengono aggiornate le stime. Orizzonti temporali

di tre mesi utilizzano stime della volatilità e della correlazione

storica di tre mesi da confrontare con la volatilità effettiva dei

successivi tre mesi.

Osservazioni prolungate nel tempo sono più efficaci ai fini delle

previsioni della volatilità. Si è dimostrato che la volatilità degli

strumenti finanziari, in particolare dei prezzi azionari, pur subendo

forti variazioni nel breve periodo, nel medio e lungo termine

302 Capitolo 6

tendono a ritornare al valore medio (mean reversion). Queste

affermazioni sono meno verificabili per i mercati dei tassi di

cambio e di interesse sui cui si riflettono le misure di politica

monetaria. Ne consegue che, assumendo campioni più ampi, le

stime risultano più corrette, contraddicendo affermazioni di natura

intuitiva, secondo le quali la maggiore ampiezza del campione

disperde le informazioni sui dati più recenti del mercato. D’altra

parte, è possibile ipotizzare orizzonti temporali di ampiezza diversa

del periodo di rilevazione del campione storico per ridurre l’errore

di campionamento.

Le valutazioni esposte devono trovare corretta applicazione al

mercato di riferimento, ossia non sono traslabili, ad esempio in

mercati come quello dei cambi ove assuma rilevanza preponderante

le condizioni più recenti ai fini di una previsione più efficace12.

E’ prassi comune che per posizioni aventi un unico fattore di

rischio riferiti ad orizzonti diversi, la volatilità per tempi più

prolungati venga ottenuta dalla volatilità giornaliera. Ciò e

possibile in relazione alle proprietà dei modelli di comportamento

del prezzo, secondo le quali, in un qualsiasi intervallo di lunghezza

T, la variazione del valore di una variabile che segue un processo di

Wiener, si distribuisce in modo normale con media nulla e

deviazione standard pari a T . La volatilità alla fine di un

intervallo T, è misurabile moltiplicando la volatilità giornaliera per

la T , ossia per il numero dei giorni compresi nell’holding period

selezionato.

T G T

6.1.2.4

[6.18]

Previsione della volatilità

Il modella delta, basato sulla sensibilità delle variazioni del

valore dello strumento finanziario al fattore di rischio di mercato,

presenta un vantaggio e al tempo stesso uno svantaggio: il primo, è

rappresentato dal fatto che i prezzi e i tassi storici sono facilmente

osservabili per tutti i mercati. Il secondo fa riferimento ai problemi

12

Sironi A. (1996), p. 168.

Introduzione al Value at Risk per i rischi di mercato 303

che si incontrano nel misurare le volatilità e le correlazioni sulla

base di andamenti passati, i quali potrebbero non rappresentare al

meglio i possibili andamenti futuri dei rendimenti, in particolare in

situazioni critiche di instabilità ed incertezza. Inoltre, utilizzando il

delta valuation method le posizioni in attività non lineari non

possono essere stimate se non introducendo nel modello fattori di

ordine superiore di correzione (delta, gamma, vega) e, comunque,

per piccoli movimenti dei tassi di cambiamento, quando le opzioni

sono lontane dalla scadenza o quando si trovano in posizioni out

the money.

In generale i modelli previsionali, compreso dunque il Risk

Metrics, presentano delle criticità per cui debbono essere affinati,

da un lato, e raffrontabili con metodologie diverse, dall'altro, al fine

di tener conto, anche di situazioni estremamente pessimistiche. Per

quanto concerne il primo aspetto la stima della volatilità è stata

effettuata in Risk Metrics introducendo il metodo delle medie

mobili esponenziali per attribuire alla volatilità dei fattori di

mercato una ponderazione non uniforme di .

Tradizionalmente, sono state impiegate medie mobili

caratterizzate dalla eguaglianza dei pesi, conseguendo risultati non

sempre soddisfacenti poiché tutti i punti della serie vengono

considerati con lo stesso fattore di ponderazione. Si osservano,

infatti, rapidi movimenti verso l’alto della media mobile quando

nella serie entrano valori molto elevati e allo stesso tempo rapide

discese, quando tali osservazioni escono dal calcolo della media;

gli adeguamenti, inoltre, della media mobile semplice alle

condizioni reali sono molto lenti e spesso distanti, in valore

assoluto, dai valori di osservazione

Per evitare questo problema si impiegano proprio le medie

mobili esponenziali nelle quali le ultime osservazioni della serie

storica (le più recenti) sono considerate, nel calcolo della medie

mobile, con un peso maggiore.

Le medie mobili esponenziali, ossia il metodo Exponentially

Weighted Moving Average (EWMA), forniscono due grandi

vantaggi: le stime della volatilità reagiscono più velocemente agli

shock del mercato (avendo gli ultimi dati più peso nella stima); le

stime decrescono, dopo una forte reazione di prezzo, gradualmente

304 Capitolo 6

al passare del tempo, seguendo la diminuzione di valore dei pesi di

ponderazione.

La media esponenziale, al contrario di quella semplice, non

rimane influenzata dai valori di picco per molto tempo e si adegua

molto velocemente.

Essa, infatti, attribuisce un peso maggiore alle osservazioni più

recenti; il peso assegnato ad ogni punto della serie storica dipende

da un valore chiamato decay factor o “discount coefficient”, il

quale indica il “grado di persistenza” delle osservazioni

campionarie passate. Essendo tale costante sempre compresa fra 0 e

1, si può affermare che (1-λ) indica la velocità di decadimento delle

osservazioni passate nella media. Maggiore è la costante λ,

maggiore è la ponderazione attribuita alle osservazioni passate e

dunque meno rapido è l’adeguamento della media alle condizioni

più recenti.

Ogni osservazione della serie storica (composta da n elementi)

che rientra nella media mobile esponenziale viene ponderata in

base alla seguente espressione:

w j j (1 ) con 0 1, e j che va da zero a n-1

nella quale gli w j rappresentano la serie dei pesi (la somma dei

quali tende all’unità al crescere dei punti della serie), e è il decay

factor. Nelle medie mobili semplici tutti gli w j sono eguali.

Il valore da attribuire a dovrà essere scelto in modo

opportuno13: la sua misura dipenderà da quanto velocemente si

13

RiskMetrics Tm assume un unico e costante fattore di decadimento da applicare all'intera

matrice di covarianza (pari a = 0,94 per la stima VaR giornaliera e = 0,97 per quella mensile).

Questa scelta appare un'arbitraria assunzione del modello, sebbene giustificabile in base alla mole di

dati sottostanti la gigantesca matrice di covarianza fornita, in quanto non vi sono le ragioni teoriche

per assumere che le varianze evolvano nel tempo nello stesso modo, in differenti paesi e su diverse

categorie di asset. L'ottimo (unico) della matrice di RiskMetrics Tm è trovato con una procedura che

utilizza il criterio di minimizzazione dell’errore quadratico medio (RMSE - Root Mean Squared

Prediction Error) connesso alla previsione della volatilità; nella formula che segue, il valore è

funzione del decay factor e il valore per una specifica serie di dati (per ogni fattore di rischio) viene

scelto come quello che rende minimo il RMSE:

RMSE=

1 T

2

rt 12 ˆ 2t 1/ t ()

T t 1

Introduzione al Value at Risk per i rischi di mercato 305

muove la serie storica, ovvero dalla sua variabilità. Più i dati della

serie saranno maggiore è la ponderazione attribuita alle

osservazioni più recenti: il valore di sarà allora più vicino allo

zero14.

E’ inoltre importante determinare la scelta del numero delle

osservazioni passate, per un dato valore del decay factor, affinchè

la somma dei w j tenda all’unità e, quindi, si possa utilizzare

correttamente il metodo esponenziale.

Per determinare questo valore di soglia (K) utilizziamo una

sommatoria dei valori dei pesi (tra K e infinito) e poniamola uguale

ad un fattore di tolleranza (FT) che dovrà essere sufficientemente

vicino allo zero, ovvero risolvendo per K:

FT (1 ) J (1 K ) K K 1 K 2 ....

JK

(1 ) 1 K

K

K 2

... FT

[6.19]

K FTeK log( FT ) / log( )

Per un dato valore di e di FT, il numero di giorni di cui si

necessita per il metodo E.W.M.A. è K. La relazione che lega il

fattore di tolleranza, il decay factor ed il numero di dati da

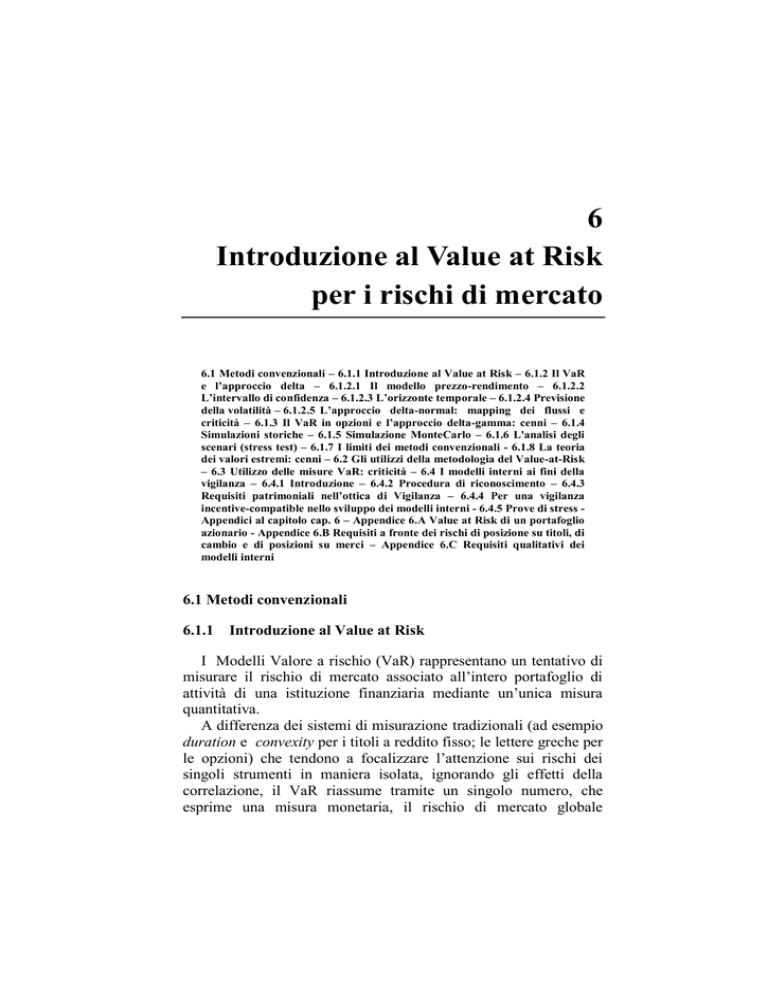

impiegare è mostrata nella seguente tabella.

Per esempio, fissando il fattore di tolleranza all’1% e stabilendo

un valore del decay factor pari a 0,92 il numero di dati storici

dove T è il numero di previsioni disponibile. Viene così individuato per ogni fattore di rischio i

del portafoglio un ottimo i; la somma dei i opportunamente pesati consente di ottenere il valore

uniforme da applicare a tutti i fattori di rischio della matrice di covarianza.

Vi è da dire che il documento tecnico di RiskMetrics Tm non fornisce la dimensione della precisa

riduzione dell'errore ottenuta utilizzando il criterio sopra descritto.

Uno dei motivi della scarsa performance dell'approccio RiskMetrics Tm è ascrivibile all'uso di un

unico fattore di decadimento per tutte le serie presenti nella matrice di covarianza. Il ottimo per

ogni fattore di rischio di mercato presente nella matrice di covarianza basato sul criterio RMSE è

infatti sensibilmente diverso sia all'interno delle categorie di asset (i stimati per gli indici azionari

delle principali 22 economie sembrano quelli con minore dispersione, con valori compresi tra 0,955 e

0,985 più dispersi, e quindi molto meno significativa la previsione ottenuta con il rappresentativo

dell'intera matrice, risultano invece i sulle valute e sui tassi ad un anno, con valori rispettivamente

compresi tra 0,92-0,99 e 0,85-0,99) sia tra categorie di asset.

14

Per valori piccoli di , i primi valori di

più grandi.

j

(quelli da assegnare ai dati più recenti) saranno

306 Capitolo 6

necessario al sistema E.W.M.A. per calcolare correttamente la

deviazione standard sarà pari a 55.

Tabella 6.2 Fattore di tolleranza

DECAY

FACTOR

0.00001

0.0001

0.001

0.01

0.85

71

57

43

28

0.86

76

61

46

31

0.87

83

66

50

33

0.88

90

72

54

36

0.89

99

79

59

40

0.90

109

87

66

44

0.91

122

98

73

49

0.92

138

110

83

63

0.93

159

127

95

63

0.94

186

149

112

74

0.95

224

180

135

90

0.96

282

226

169

113

0.97

378

302

227

151

0.98

570

456

342

228

0.99

1146

916

687

458

6.1.2.5 L’approccio delta-normal: mapping dei flussi e criticità

La mappatura dei flussi

Una volta definite le assunzioni distributive e quelle ad esse

correlate sulle funzioni di prezzo, un elemento critico per

l'implementazione dell'approccio delta-normal è individuabile

nell'esatta specificazione dei fattori di rischio sottostanti il

portafoglio. Infatti, accade sovente che le posizioni assunte da una

istituzione finanziaria abbiano un valore di mercato che risulta

funzione di più variabili di mercato. E’ necessario, allora, un

processo di mappatura dei fattori che influenzano il valore del

portafoglio, ovvero una scomposizione della posizione nelle

relative componenti elementari. Un esempio di mapping,

considerando

una

approssimazione

lineare

(approccio

delta-normaI), può essere fatto considerando un insieme di

posizioni in titoli a reddito fisso: la banca d'affari J.P.Morgan

Introduzione al Value at Risk per i rischi di mercato 307

adotta un sistema di buckets "disposti"15 su un numero di venti

scadenze la cui numerosità dipende dalla segmentazione e dal

grado di liquidità alle varie scadenze del mercato dei titoli. Il

criterio adottato per realizzare il mapping dipende dalla scelta del

fattore di rischio. Nel caso del rischio di interesse, i flussi del

portafoglio obbligazionario sono collocati su una griglia standard

di scadenze e, mediante interpolazione lineare o quadratica

vincolata a un set di condizioni, i flussi con scadenza non

coincidente con i vertici sono attribuiti tra due scadenze16

intermedie.

Il Value-at-Risk relativo alla scadenza j sarà: VaRj = k * (VMj *

MDj *rj * rj ), dove VMj è il valore di mercato del jesimo cash-flow,

MDj la relativa modified duration, rj il tasso d'interesse e rj la sua

volatilità. Il VaR del portafoglio sarà quindi il risultato

dell'interazione tra le volatilità di tasso relative alle varie scadenze

(rrj, rrk) e le correlazioni (jk) tra i tassi lungo i vertices della yield

curve, ossia:

VaR k *

m

n

(VM

j1 k 1

j

* MD j * rj * rj )(VM k * MDk * rk * rk ) * jk

[6.20]

Si può verificare dalla 6.20 che il VaR dipende non solo dalle

variabilità originate da ciascun cash flow (modified duration *

volatilità del tasso) singolarmente preso, ma anche dai coefficienti

di correlazione jk, che, in questo caso, misurano le correlazioni

esistenti tra le variazioni dei tassi riferite ai diversi vertices e

l'effetto di diversificazione generato dalla composizione del

portafoglio.

Il metodo analizzato, soddisfa le esigenze di misurazione del

rischio di un portafoglio in base ad una univoca e determinata

selezione dei fattori di rischio, nei mercati rilevanti in cui opera una

banca. Si vuole però mettere in evidenza come uno degli elementi

critici

alla

base

dell'implementazione

dell'approccio

varianze-covarianze sia proprio quello della identificazione e della

15

Coerentemente con le disposizioni di vigilanza.

I nodi selezionati, denominati vertici, sono 14 e vanno da 1 mese a 30 anni e per ognuno di

essi J.P. Morgan fornisce le volatilità e le correlazioni.

16

308 Capitolo 6

mappatura esatta dei fattori di rischio sottostanti il portafoglio, in

particolare, nel caso in cui gli intermediari finanziari abbiano

portafogli ampi e globalmente diversificati. All'uopo, le principali

banche d'investimento statunitensi17 hanno scelto di ricondurre la

rischiosità delle posizioni detenute ad un insieme di fattori di

mercato (fattori di rischio) quali i tassi di interesse relativi alle

diverse scadenze (con la metodologia, precedentemente analizzata,

di suddivisione dei flussi in bucket rappresentativi delle diverse

scadenze18), i tassi di cambio, gli indici azionari e delle

commodities. La mappatura del portafoglio non è facile da

implementare in quanto comporta necessariamente un trade-off: nel

caso dei tassi di interesse, ad esempio, una specificazione molto

accurata di tutta la struttura a termine può fornire una

rappresentazione del portafoglio migliore. Il numero di

informazioni diviene, però, estremamente elevato, per cui risulta

arduo stimare e controllare la stabilità delle volatilità e delle

correlazioni sottostanti.

Viceversa, utilizzare un livello di aggregazione troppo sintetico,

stabilendo solo pochi buckets per descrivere l'intera curva dei tassi,

potrebbe invece limitare fortemente l'attendibilità della stima del

rischio del portafoglio. La soluzione al problema di una adeguata

"mappatura", con l’identificazione dei fattori di rischio

effettivamente rilevanti per il portafoglio detenuto, non ha un

algoritmo preciso su cui basarsi. In generale, si dovrebbero

aggregare strumenti i cui flussi, per ogni potenziale bucket,

mostrino volatilità analoghe ed elevati livelli di correlazione. Il

numero di buckets da considerare dipende quindi da quanto la

volatilità varia lungo la struttura a termine e dalle correlazioni tra i

differenti tassi. Al riguardo, nel caso estremo in cui le volatilità

siano uguali tra le diverse scadenze ed i differenti tassi risultino

perfettamente correlati non vi sarà la necessità di effettuare una

mappatura, in quanto il rischio del portafoglio sarà funzione

unicamente della volatilità del tasso e della modified duration del

portafoglio.

17

J.P. Morgan, Goldman Sachs, Salomon Smith Barney.

Impostazione condivisa anche nelle regole di vigilanza internazionale inerenti l'utilizzo del

maturity method per il rischio di tasso d'interesse nell'ambito del ed. metodo standardizzato; anche

per i ed. modelli interni vi è la previsione dì un requisito minimo di modellizzazione della yield curve

pari ad almeno 6 segmenti di maturità, cfr. Comitato di Basilea.

18

Introduzione al Value at Risk per i rischi di mercato 309

I punti di forza e di debolezza del Delta-normal

I punti di forza di questo modello si possono individuare nel

fatto che esso è indipendente dall’oggetto cui è applicato, consente,

quindi, di misurare, confrontare ed aggregare il rischio di prodotti

diversi. Esso fornisce, quindi, uno strumento utile a misurare la

variabilità dei rendimenti delle attività finanziarie, nel periodo di

riferimento, permettendo una corretta allocazione del capitale nella

fascia rischio-rendimento desiderata.

Al contrario, i punti di debolezza risiedono nella utilizzazione di

informazioni passate; le serie storiche dei prezzi non sono sempre

rappresentative dei rischi futuri. Dubbi vengono sollevati sulla

scelta della distribuzione normale delle variazioni dei rendimenti.

Infatti, l’ipotesi di distribuzione normale dei rendimenti delle

attività finanziarie, sebbene abbia fatto registrare molto spesso

opinioni discordanti, è in realtà un punto in comune a molti dei

modelli di analisi finanziaria sviluppati negli ultimi decenni. Il

motivo dei dissensi, da parte della comunità finanziaria, è dovuto al

fatto che questa ipotesi non trova conferma nelle verifiche

empiriche condotte su varie categorie di strumenti finanziari. Le

critiche più ricorrenti, che hanno portato a ricercare soluzioni

alternative alla distribuzione normale, sono rappresentate proprio

dai risultati di questi studi.

In particolare:

la distribuzione dei rendimenti delle attività finanziarie

mostra generalmente code più spesse (fat tails) nella

estrema destra e sinistra della distribuzione, rispetto ad una

curva normale teorica, ovvero, vi sono numerosi valori

cosiddetti outliers. Variazioni di prezzo lontane dal valore

medio hanno, dunque, maggior probabilità di verificarsi

rispetto a quanto implicitamente previsto con una

distribuzione normale. Questa caratteristica prende il nome

di curtosi (una curtosi positiva indica la presenza di code

spesse);

il picco intorno alla media della distribuzione dei

rendimenti è generalmente più elevato di quello tipico di

310 Capitolo 6

6.1.3

una distribuzione normale: questa caratteristica viene

chiamata leptocurtosi;

la distribuzione dei rendimenti risulta esser generalmente

non simmetrica intorno alla media, ovvero si riscontrano

più osservazioni nella metà sinistra della curva (quelle

inferiori alla media) rispetto al numero di osservazioni

rilevate nella parte destra (negative skewness). Al contrario,

una skewness positiva è indice di una distribuzione

asimmetrica verso destra, con un numero maggiore di

osservazioni superiori alla media.

Il VaR in opzioni e l’approccio delta-gamma: cenni

Il modello descritto presuppone un'approssimazione del primo

ordine nella sensitività ai fattori di rischio: questa stima, nel caso di

opzioni, può realizzare un buon fitting “locale" nelle immediate

vicinanze del punto di valutazione, ossia per piccoli cambiamenti

nel valore del sottostante, ma risulta inadeguata per ampi

movimenti dei prezzi. Poiché la metodologia VaR si propone di

quantificare, con una attendibile stima, il rischio di perdite

connesse a questi ampi movimenti avversi, non tener conto della

curvatura dei profili di payoff degli strumenti del tipo embedded

(ma anche semplicemente di titoli obbligazionari ad elevata

convessità) può dar luogo ad una rappresentazione fortemente

inadeguata del reale rischio cui la posizione è esposta, tanto

maggiore quanto più la curvatura è pronunciata. A questo scopo è

stato proposto19 l'utilizzo di una approssimazione delta-gamma del

valore di mercato del book contenente opzioni valutabili con lettere

greche rispettivamente per ogni asset sottostante e per ogni coppia

di asset sottostanti.

Combinando tutti i delta e i gamma, la variazione totale del

valore del portafoglio avrà la seguente approssimazione:

19

Cfr. Wilson T. (1997), p.75. L’autore è stato il primo a proporre un metodo di

approssimazione delta-gamma per le variazioni di valore del portafoglio. Per un approfondimento

Fallon J. (1996).

Introduzione al Value at Risk per i rischi di mercato 311

n

P() j X j

j1

1 n

2 j1

n

k 1

jk

X jX k

[6.21]

dove, i j rappresentano le sensitività (delta) ai cambiamenti X j

nei fattori dì rischio, e jk i vari gamma dei portafoglio; per j = k il

gamma sarà la variazione relativa del jesimo delta rispetto ad un

cambiamento nel fattore di rischio Xj. Se il prezzo degli asset è

funzione unicamente di un fattore di rischio, si potrebbero ignorare

i termini gamma per j k (questa semplificazione è spesso

effettuata nella realtà operativa 20). Questo approccio non si

dimostra efficace in tutti i casi: ad esempio, per le opzioni molto

vicine alla scadenza e at-the-money il gamma tende ad essere

estremamente grande e quindi non significativo; un problema

simile si ha per le opzioni con barriera, quando l'asset sottostante è

prossimo alla barriera.

L'applicabilità

dell'approccio

delta-gamma

è

quindi

condizionato dalla data di scadenza dell'opzione rispetto

all'orizzonte temporale di calcolo del VaR: l'informazione fornita

dal delta-gamma sarà robusta quanto più l'orizzonte temporale è

minore del tempo a scadenza dell'opzione.

Il peso relativo dell'effetto gamma nello spiegare la variazione

del valore di mercato dello strumento è poi tanto maggiore quanto

più lungo è l'orizzonte temporale di riferimento. L'inclusione della

componente gamma nei calcoli comporta, inoltre, che la

distribuzione dei returns del portafoglio venga influenzata dai

quadrati di variabili random ipotizzate normali, i quali danno luogo

ad una asimmetria21 della distribuzione. In questo caso, l'ipotizzata

normalità condizionale e quindi la simmetria della distribuzione

viene meno, invalidando l'utilizzo dei quantili della distribuzione

normale standard. L’aggiunta di un secondo parametro per

correggere la non linearità del delta trasforma gli stessi momenti

dell'analisi statistica: ad esempio, la varianza dei returns di

20

Cfr. Wilson T. (1997),. Il prodotto dei termini gamma quando j k può essere importante per

prodotti strutturati fortemente dipendenti dalle correlazioni di mercato come i differential swaps, le

choosers options e dovrebbe essere inserito ne valutazioni in quanto questi prodotti hanno un valore

della derivata seconda "incrociata" elevato.

21

Posizione gamma negativa (opzione venduta) implicherà asimmetria negativa e viceversa

312 Capitolo 6

un'opzione differisce dalla varianza 2 del relativo strumento

sottostante per un fattore (2 + 0,522).

L'importanza di un appropriato trattamento del rischio di

mercato delle opzioni è oggi evidenziata anche da esplicite

indicazioni degli organismi di vigilanza bancari internazionali, i

quali prevedono una distinzione nelle capacità di monitoraggio e di

gestione delle posizioni in derivati: queste devono essere

commisurate alla dimensione e complessità dell'esposizione

sopportata. In particolare, nell'ambito del metodo cd.

standardizzato è previsto uno specifico onere di capitale da

mantenere a fronte del "gamma impact” calcolato con il secondo

membro dell'espansione in serie di Taylor come: 1/2**(X2), dove

X2 rappresenta la variazione predefinita dell'under1ying

dell'opzione, che secondo le stime della vigilanza, è pari all'8% per

le opzioni su singole azioni, indici azionari e tassi di cambio ed al

15% per le commodities. Per le opzioni sui tassi la variazione da

applicare si deve invece basare su di una griglia temporale di pesi

per il rischio variabili in funzione della scadenza. Nonostante

l'approccio delta-gamma sia, tra i metodi analizzati, il più adeguato

a descrivere la relazione di non linearità tra la variazione del fattore

di rischio22 cui l’opzione è esposta e la variazione del valore di

mercato dell'opzione, esso non coglie un aspetto rilevante della

rischiosità connessa ad opzioni complesse (ma anche a semplici

combinazioni di opzioni plain vanilla, call e put). In particolare,

trascura la caratteristica della non monotonicità della relazione tra

il prezzo dell'underlying e valore della posizione "strutturata" in

opzioni. Questa caratteristica fa si che l'analisi della massima

perdite potenziale svolta, considerando forti variazioni dei prezzi,

porti a risultati non consistenti rispetto al reale profilo di rischio

della posizione: la non monotonicità implica perciò che le perdite

maggiori non si verifichino in corrispondenza di forti shocks dei

prezzi del sottostante. Ad esempio, la massima perdita di una

posizione short in una butterfly23, si avrà in corrispondenza di un

22

Oltre al delta ed al gamma per una descrizione completa della sensibilità del prezzo di

un’opzione, si dovrebbero considerare anche gli altri coefficienti di sensibilità e di conseguenza i

fattori di rischio a questi corrispondenti: la volatilità attesa del prezzo dell'attività sottostante, il

livello di variazione del tasso di interesse a breve.

23

La butterfly ha una struttura sintetica ottenibile con diversi mix di call e put: ossia vendendo

due call con diversi strike e acquistando due call con identico strike intermedio tra i primi due.

Introduzione al Value at Risk per i rischi di mercato 313

prezzo determinato24 e non di variazioni estreme dei prezzi. Tale

limite non consente l’estensione dell'approccio delta-gamma per

tutte le posizioni, favorendo la diffusione dei metodi di valutazione

“piena" (full valuation), ossia dei metodi di simulazione, anche

chiamati modelli “non parametrici”. I modelli rientranti in questa

categoria sono definiti tali in quanto, non formulando alcuna

ipotesi relativa alla forma funzionale della distribuzione dei

rendimenti dei fattori di mercato, non richiedono di stimare i

parametri di tale distribuzione25. In pratica tali modelli calcolano il

VaR non come prodotto della sensibilità della posizione/portafoglio

per la volatilità della variabile di mercato rilevante, ma

ricalcolando, anzitutto, l'intero valore di mercato della

posizione/portafoglio in base alle nuove condizioni risultanti dalle

variazioni stimate delle variabili di mercato che influenzano tale

valore.

In particolare, fra i modelli non parametrici si possono

individuare due principali approcci per la stima del VaR di un

portafoglio:

le Simulazioni storiche;

le Simulazioni MonteCarlo.

Nonostante le rilevanti differenze fra queste due categorie di

approcci, è possibile individuare alcune caratteristiche che li

accomunano:

a) Full valuation: diversamente dall’approccio varianzecovarianze, il quale si fonda sui coefficienti di sensibilità, i

modelli di simulazione si basano su una logica di

valutazione piena. Il valore di mercato delle

posizioni/portafogli di cui si intende stimare il VaR viene

rivalutato, mediante opportune formule di pricing, sulla

24

Questo prezzo, nel caso in esame, corrisponde allo strike delle due call acquistate.

In realtà, ciò è vero unicamente per le simulazioni storiche, le quali non richiedono

effettivamente di formulare alcuna ipotesi analitica circa le distribuzioni dei rendimenti. Essa non

risulta invece adatta per le simulazioni MonteCarlo, le quali richiedono di selezionare una

distribuzione analitica multivariata per i rendimenti dei fattori di mercato e di stimare i parametri di

tale distribuzione quali medie, varianze e covarianze.

25

314 Capitolo 6

base delle condizioni simulate dei fattori di mercato. Il

meccanismo di full-valuation consente di superare il

problema della non-linearità delle relazioni di pricing che

legano tra di loro le variazioni di prezzo degli strumenti in

portafoglio alle variazioni dei fattori di mercato, restituendo

variazioni del valore del portafoglio vere e non

approssimate. Tale caratteristica è tanto più desiderabile

quanto maggiore é la componente opzionale del portafoglio

di cui bisogna calcolare il Valore a Rischio.

b) Logica del percentile: nei modelli di simulazione il VaR è

stimato tagliando la distribuzione empirica di probabilità

delle variazioni di valore del portafoglio al percentile di

confidenza desiderato. Ad esempio, date 10.000 simulazioni

MonteCarlo dei fattori di mercato che generano 10.000

variazioni del valore del portafoglio in esame, il VaR al

99% è calcolato prendendo la 100-esima peggiore

osservazione. Analogamente si procede per le Simulazioni

storiche.

c) Ipotesi distribuzione normale: l’ultimo tratto comune ai

modelli di simulazione è l’assenza dell’ipotesi di normalità

della distribuzione dei rendimenti di mercato. Tale

caratteristica è auspicabile poiché, come abbiamo già detto,

numerosi studi empirici hanno mostrato come la

distribuzione effettiva dei rendimenti dei fattori di mercato

sia in realtà caratterizzata da code spesse e da un livello di

curtosi superiore a quello di una distribuzione normale.

6.1.4

Simulazioni storiche

La valutazione di un portafoglio/posizione attraverso questa

procedura di calcolo risulta molto semplice e prescinde da

qualunque ipotesi sul tipo di funzione di densità dei rendimenti e,

se effettuata direttamente sui prezzi delle attività, non richiede la

stima dei coefficienti di sensibilità ai fattori di rischio. Il primo

passo da compiere, nel caso del calcolo diretto sui prezzi e, quindi

di full valuation, consiste nel costruire un database dei prezzi, per

ogni istante del periodo di osservazione prescelto. Il secondo,

consiste nel rivalutare il portafoglio/posizione mantenendo ferme le

Introduzione al Value at Risk per i rischi di mercato 315

quote investite, per ogni istante temporale, in modo da pervenire

ad una serie storica dei valori dello stesso. Applicando, quindi, la

distribuzione storica al portafoglio analizzato, si ottiene una serie di

profit and loss, P&L (VM1 = VM1 – VM0), che successivamente

ordinata dal peggiore al migliore risultato (ossia dalla massima

perdita al massimo profitto), consente di costruire una distribuzione

empirica delle variazioni di valore del portafoglio. Poiché in questo

caso non vi è alcuna ipotesi circa la natura della distribuzione della

variabile di mercato, l’individuazione dell'intervallo di confidenza

desiderato non avviene sulla base di un multiplo della volatilità

storica,come nei metodi parametrici, ma individuando direttamente

lo specifico percentile, nel senso che la distribuzione dei P&L

storici viene "tagliata" al percentile corrispondente al livello di

confidenza prescelto, cui corrisponderà un valore di P&L che

rappresenta il VaR del portafoglio.

I pregi di tale approccio sono piuttosto evidenti: non prevede la

stima di altri indicatori intermedi (correlazioni e volatilità) almeno

nella versione di calcolo direttamente dai prezzi, cattura la struttura

delle correlazioni riflessa nelle variazioni congiunte dei fattori di

mercato, permettendo di superare il problema di instabilità delle

correlazioni. Inoltre, non fissando a priori nessun modello

distributivo, consente di superare i limiti imposti dall’ipotesi di

normalità dei rendimenti. L'unica ipotesi implicita è che i

rendimenti estratti dalla distribuzione storica siano in realtà estratti

da una distribuzione futura. Ne segue che la corrispondenza

biunivoca fra intervallo di confidenza desiderato e variazioni dei

fattori di mercato non risente di eventuali asimmetrie o leptocurtosi

delle distribuzioni dei rendimenti dei fattori di mercato. Se i

rendimenti dei fattori di mercato non sono distribuiti normalmente,

ma hanno un comportamento probabilistico stabile nel tempo, il

modello delle Simulazioni storiche fornisce, dunque, indicazioni

più precise rispetto ai modelli parametrici.

Nondimeno, effettuando una valutazione piena del

portafoglio/posizione, il metodo delle Simulazioni Storiche

permette di “catturare” anche variazioni di ordine superiore al

primo, come l’effetto gamma per i prodotti derivati, e le

componenti di convessità caratteristici di alcuni titoli strutturati.

Inoltre, la logica sottostante a tale metodo di simulazione risulta

316 Capitolo 6

facilmente comprensibile e comunicabile fra le varie business unit

di una banca. A fronte di questi pregi, però, occorre rilevare alcuni

limiti del metodo in questione. In generale, se è vero che il metodo

delle Simulazioni storiche è in grado di cogliere la distribuzione

effettiva dei rendimenti, e dunque l’eventuale presenza di “code

spesse”, esso condurrà, in presenza di una distribuzione

leptocurtica, a misure di VaR più elevate di quelle che si

otterrebbero con il metodo varianze-covarianze. Le Simulazioni

Storiche, inoltre, ipotizzano implicitamente la stabilità temporale

della distribuzione storica dei fattori di mercato, quindi che i dati

della serie siano indipendenti ed identicamente distribuiti. Ma,

nella realtà dei fatti, si riscontra, sovente che la distribuzione

congiunta non osservabile dei rendimenti dei fattori di mercato

cambia nel tempo; è eteroschedastica. In tal caso, i risultati del

modello delle Simulazioni storiche, avranno uno scarso significato

sia concettuale che operativo. I risultati raggiunti, inoltre, con tale

metodo hanno una forte dipendenza dall’intervallo temporale

prescelto, il quale può modificare in maniera sensibile i risultati

stessi.

Un altro problema relativo alla stima del VaR con questo tipo di

approccio è legato all’intervallo di confidenza – il livello di

probabilità p di perdita fissato – se scelto molto alto e avendo pochi

dati per l’analisi, può portare ad una stima non corretta del VaR.

Per esempio, scegliendo come probabilità il valore di 0,99 e avendo

una finestra temporale di 100 dati, il quantile corrispondente

verrebbe posizionato al 99-esimo elemento con un solo valore del

portafoglio al di là di tale limite, quindi sarebbe statisticamente

poco significativo.

E’ opportuno, infine, sottolineare le difficoltà spesso

riscontrabili nel provvedere ad un’accurata raccolta dei dati che tale

approccio richiede. E’ necessario, infatti, poter disporre di un

archivio storico dei prezzi dell’attività presenti in portafoglio

quanto più dettagliato ed aggiornato. Nella realtà operativa, si

dispone sovente di numero limitato di osservazioni storiche, che si

traduce tipicamente in una scarsa definizione delle code della

distribuzione empirica di probabilità. Le uniche variazioni dei

fattori di mercato che il modello considera possibili sono infatti

quelle verificatesi in passato, nell’orizzonte storico preso a

Introduzione al Value at Risk per i rischi di mercato 317

riferimento. Esiste, però, una relazione di trade-off riguardo alla

lunghezza ottimale della serie storica di riferimento: incrementare il

più possibile la lunghezza della serie storica di riferimento,

allontanandosi troppo nel tempo, non è consigliabile, perché

diviene più probabile che sia violata l’ipotesi di stabilità della

distribuzione; si rischia di estrarre dei dati da una distribuzione

ormai “obsoleta”.

Una possibile risposta a tale problema è data dall’approccio

ibrido.

L’approccio ibrido combina i pregi delle Simulazioni Storiche

(assenza di ipotesi esplicite circa la forma funzionale della

distribuzione dei rendimenti dei fattori di mercato, valutazione

piena, preservazione della struttura delle correlazioni) con i

vantaggi propri della tecnica delle medie mobili esponenziali per la

stima della volatilità illustrata con riferimento all’approccio

varianze-covarianze (elevato contenuto informativo connesso

all’utilizzo di un ampio campione storico e aggiornamento dei dati

connesso alla tecnica delle ponderazioni decrescenti)26.

6.1.5

Simulazione MonteCarlo

Le Simulazioni MonteCarlo27 rappresentano una delle più

sofisticate ed accurate metodologie di stima del VaR, ma sono

anche le più complesse e costose da implementare. Le simulazioni

MonteCarlo sono state originariamente utilizzate in finanza per il

pricing di strumenti complessi, quali le opzioni esotiche, per i quali non

26

L’approccio Ibrido è stato proposto da Boudoukh, Richardson e Whitelaw (1998). Esso

consente di utilizzare una serie storica relativamente lunga ma attribuisce ad ogni osservazione

passata una ponderazione tanto maggiore quanto più questa è recente, secondo una logica simile a

quella propria delle medie mobili esponenziali utilizzate, sovente, nell’approccio varianzecovarianze per la stima della volatilità storica. In tal modo, ciascuna osservazione non contribuisce

alla determinazione del VaR unicamente in funzione della propria intensità, ma anche in base alla

propria ponderazione, ossia in base alla relativa lontana/vicinanza temporale rispetto al momento

della valutazione.

27

L’origine del termine MonteCarlo risale agli anni ‘40, quando con tale locuzione venne

designato un piano di simulazioni sviluppato durante la sperimentazione della prima bomba atomica.

Il ricorso a tali simulazioni si rese necessario perché i problemi affrontati dal gruppo di fisici e

matematici avevano raggiunto un livello di sostanziale intrattabilità analitica. Essi si ispirarono, nella

scelta del nome MonteCarlo, all’aleatorietà dei guadagni tipica della casa da gioco del principato

monegasco. Attraverso la generazione dei numeri casuali, essi, determinarono i parametri delle

equazioni che descrivevano la dinamica delle esplosioni nucleari. Il termine MonteCarlo Method

viene, infatti, utilizzato, come sinonimo di simulazione stocastica.

318 Capitolo 6

è possibile ottenere una soluzione attraverso una formula chiusa o quasi

chiusa di valutazione e, quindi si rende necessario ricorrere ad un metodo

numerico che permetta di ottenere una soluzione approssimata

28

accettabile .

Con le simulazioni MonteCarlo si generano un ampio numero di

scenari (nell'ordine di alcune migliaia) in maniera random

basandosi su di una assunta distribuzione di probabilità congiunta

dei fattori di rischio di mercato (in genere si ipotizza una

distribuzione normale): le caratteristiche statistiche dei fattori di

rischio (volatilità e correlazioni29) sono determinate utilizzando i

dati storici di mercato. Una volta specificata questa distribuzione

congiunta, sono usate delle tecniche30 per generare il set di scenari

in base a dei correlati numeri random: in questo modo gli scenari

generati rifletteranno le caratteristiche statistiche derivate dai dati

storici. L'insieme degli scenari ottenuti costituiscono una

simulazione; la simulazione viene ripetuta numerose volte 31,

utilizzando ogni volta un diverso set di scenari random. Da ognuna

di queste simulazioni si estrae il percentile desiderato, il quale

rappresenterà la massima perdita probabile32 stimata per il

portafoglio, in corrispondenza di quel predeterminato livello di

confidenza. La media aritmetica dei percentili darà la misura VaR

cercata, caratterizzata da una deviazione standard che fornisce la

dimensione dell'errore di convergenza delle simulazioni.

Quest'ultimo potrà essere ridotto semplicemente utilizzando più

28

L’utilizzo della simulazione MonteCarlo per la valutazione del prezzo di un’opzione consiste

nel determinare dei possibili sentieri (path) per il prezzo del bene sottostante per ricavare il valore

dell’opzione come media attualizzata dei payoff, ipotizzando che si operi in un ambiente neutrale al

rischio, in mercati completi, in cui non esistono opportunità di arbitraggio, costi di transazione, e le

attività sono infinitamente divisibile e vendibili allo scoperto.

29

Le volatilità e le correlazioni possono essere predisposte per rappresentare uno scenario

economico specifico rispetto al quale si può implementare una analisi di stress. Lo stress testing è

un'altra tecnica simulativa per analisi di sensitività di portafogli rispetto a ipotizzate variazioni

estreme avverse di mercato e sarà affrontata nella sezione successiva.

30

Ad esempio il documento tecnico RiskMetric 1996 utilizza la decomposizione di Cholesky

della matrice di covarianza tale che =A’ A; viene poi generato un vettore Z = A’Y di variabili

random i cui elementi avranno una distribuzione normale multivariata e covarianza , ed Y è un

vettore di variabili standardizzate N ~ (0, 1) con matrice di covarianza identica I, così che var(Z) = A'

E(YY’) A = A’IA = A'A = .

31

Generalmente i "simulation paths" sono circa 10.000.

32

Quella in considerazione è solo una delle tipologie di simulazioni di MonteCarlo possibili:

qui la focalizzazione è sulle code estreme della distribuzione del portafoglio; altri tipi di simulazione

sono ad es. dirette al pricing di strumenti finanziari individuando il valore medio futuro dell'insieme

di strumenti detenuti. Altre ancora fanno ipotesi diverse sul tipo di distribuzione sottostante il vettore

Y.

Introduzione al Value at Risk per i rischi di mercato 319

scenari33 in quanto il suo valore è inversamente proporzionale alla

radice quadrata del numero degli scenari utilizzati ( 1 / n ): ad

esempio34, un VaR calcolato come media aritmetica degli

appropriati percentili di 50 simulazioni, ognuna costituita da un

differente set di 1500 scenari, ha un errore di convergenza

(deviazione standard) del 4%; per ridurre l'errore al 2% bisognerà

utilizzare 6000 scenari per ogni simulazione.

Oltre alla velocità di convergenza, la selezione stessa degli

scenari può comportare altri tipi di problemi: la specificata

distribuzione assunta per i fattori di rischio (ad es. la lognormale)

può riflettere in maniera non adeguata la vera distribuzione q dei

fattori di rischio stessi; essendo stimate da un limitato set di dati

storici, le volatilítà e le correlazioni possono essere

significativamente differenti dalle reali volatilità e le correlazioni di

q (il cosiddetto sampling error); i dati storici, dai quali sono

desunte le volatilità e correlazioni, possono non riflettere

perfettamente le condizioni del mercato correnti, poiché queste

sono non stazionarie (variano nel tempo).

Aumentando la dimensione delle serie storiche dei dati si riduce

l'errore di convergenza, ma aumenta l'errore dovuto alla non

stazionarietà della serie; d’altro canto, basando la stima unicamente

sui dati più recenti si ipotizza un miglioramento sulle

rappresentazioni della effettiva distribuzione dei fattori di rischio.

Il metodo MonteCarlo, pur consentendo una valutazione piena35

di strumenti finanziari con caratteristiche di payoff anche

abbastanza complesse36, non produce stime stabili in quanto sono

condizionate ogni volta dal risultato delle simulazioni. Il numero

delle simulazioni effettuabili, e quindi la possibile riduzione

dell'errore di convergenza, è influenzato, tra l'altro, dal

33

Non c'è un limite teorico al numero degli scenari utilizzabili: i vincoli reali sono dovuti alle

velocità di calcolo offerte dai computer e dalla necessità di conoscere le stime VaR in tempi brevi.

34

L'esempio è tratto da Holton C. (1998), p. 61.

35

Le variazioni del portafoglio sono determinate, con riferimento agli scenari utilizzati per

descrivere le variazioni dei fattori di mercato, mediante riprezzamento in base ad opportune formule

di pricing degli strumenti che caratterizzano il portafoglio.

36

Come le opzioni con barriera (barrier option tipo knock-in etc.) il cui valore dipende dalla