Editoriale

Il calcolatore quantistico

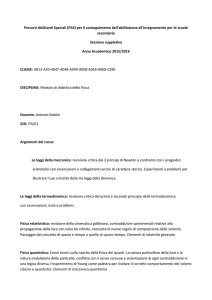

LHC: la particella di Dio ed altri misteri

Il colosseo a otto fuochi

La materia oscura

Un numero infinito

Dormiamo troppo? Perchè siamo giovani!

Anno 5 numero 5-Aprile 2010

Editoriale-Anno 5 numero 5/Aprile 2010

Galileo diceva

che è l'occhio della mente che vede, che è fondamentale per la

scienza l'elaborazione intellettuale del cervello, ma sapeva anche

come senza l'occhio della fronte la mente non potesse vedere. Un

assunto tanto logico, quanto scontato per chi fa scienza, perché

non può esserci scienza se non si toccano con mano i fenomeni,

ma questo aspetto risulta poco praticato ancora nella scuola italiana, dove purtroppo spesso le leggi della scienza e della fisica si

imparano in prevalenza sul libro, utilizzando ancora molto lo strumento cartaceo e poco puntando invece sulla curiosità di chi

apprende, desideroso e voglioso magari di scoprire il risultato

delle proprie osservazioni e delle proprie scoperte attraverso la

pratica. Di conseguenza appare quasi scontato che i risultati dei

nostri ragazzi italiani nelle materie scientifiche siano scadenti,

come dimostrano i dati OCSE-PISA, che non riusciamo a competere con altri paesi industrializzati e non, che occorra recuperare

al più presto questo gap e ridurre il tasso di insuccesso come previsto dagli obiettivi di Lisbona.

La scuola italiana deve invertire la tendenza negli assunti didattici,

promuovendo una cultura sperimentale, facendo degli alunni i veri

protagonisti del processo della conoscenza; e questa necessità è

ancora più forte per l'insegnamento delle discipline scientifiche.

Un recente documento della Commissione Europea (Comitato

Rocard) ha messo in luce che se i ragazzi non si appassionano

alle materie scientifiche, la causa è da ricercare nel modo e nel

metodo con cui queste si insegnano. La vera scommessa di una

scuola nuova, che possa promuovere vera conoscenza e competenze spendibili per il futuro dei nostri giovani, sta quindi nell'innovazione didattica, nella ricerca, nella sperimentazione. Una scuola

che sappia coniugare teoria e pratica, che sappia leggere ed

interpretare le nuove profonde tendenze della cultura giovanile e

la modernità dei loro bisogni culturali. A scuola questo è possibile

solo se avverrà una chiara opera di cambiamento dei contenuti

metodologici e delle strategie didattiche : flessibilità, didattica

laboratoriale, ricerca-azione, classe come laboratorio di idee

devono essere le nuove forme aperte per una scuola al passo

con la modernità e vicina alle esigenze e ai bisogni dei nostri giovani. Attraverso questi passaggi infatti la scuola può e deve stimolare la curiosità e la creatività e favorire il traguardo necessario

delle strutture razionali del pensiero, dei concetti e dell'astrazione.

Solo così riusciremo ad appassionare i nostri alunni e dare loro in

mano quella carta vincente che li metta alla pari degli altri giovani

dell'Europa e del mondo.

Per raggiungere questi risultati è necessario spendere ed impegnarsi nella formazione e nell'aggiornamento dei docenti, chiamati

ad un compito arduo, ma fortemente responsabile del futuro delle

nuove generazioni, docenti che devono riacquistare il loro ruolo

primario non più di soli trasmettitori di saperi, oggi peraltro veicolati anche in forme diverse e da altre agenzie educative, ma di

esperti privilegiati che sanno sperimentare attraverso la ricerca

didattica metodi didattici nuovi, esperienziali, che consentano il

raggiungimento di saperi e competenze funzionali alla società.

Anche questa rivista è un esempio tangibile ed evidente che la

cultura scientifica può essere veicolata in maniera strategica e

moderna attraverso nuovi strumenti, attraverso la ricerca ed il

laboratorio, attraverso quella metodologia che pone l'allievo al

centro del processo educativo in un laboratorio vivente fatto di

idee, di impegno, studio e fatica, di curiosità e creatività, di passione e di emozioni , che faranno del giovane studente l'uomo di

domani educato alla responsabilità ed alla cittadinanza.

Gabriella Chisari

Cari lettori,

eccoci giunti ad un nuovo numero della rivista di scienze del Liceo Scientifico

G.Galilei di Catania.

La Rivista esce dopo un periodo di silenzio, un silenzio che però non è stato

vuoto, ma pieno di eventi, di cambiamenti, di trasformazioni come ad esempio la nascita della nuova veste tipografica.

Come sapranno molti di voi, ma non tutti - mi rivolgo in particolare ai nuovi

lettori - la rivista si propone d'informare su temi della scienza in generale ma

anche sulle ultime scoperte e avvenimenti. È questo un modo per dare testimonianza del grande contributo che la scienza offre allo sviluppo del pensiero

dell'uomo, ma la rivista ha anche l'obiettivo di dare la possibilità di condividere idee, progetti e conoscenza, che sono alla base di un qualunque processo

formativo.

Ed ecco allora che nelle pagine successive troverete una cascata di "numeri"

che si avvicinano ad uno solo, e dopo esserci addentrati in questa sfida

all'immaginazione la nostra mente dovrà aprirsi alla vastità sconfinata

dell'Universo e tentare di afferrarne le armonie che avvicinano alla comprensione della materia e delle forze che la regolano. Per poi passare all'infinitamente piccolo dei fisici che con gli esperimenti dei grandi acceleratori di particelle studiano la materia nucleare e, alle energie più alte, cercano di riprodurre lo stato in cui questa si trova nelle stelle. Così il cerchio si chiude, é un'armonia naturale che trascina, incuriosisce ed entusiasma, dalle stelle ai nuclei

dai nuclei alle stelle senza però dimenticarci del passato, ed ecco la meraviglia. Scopriamo che i nostri architetti antichi avevano conoscenze sofisticate

nel campo delle costruzioni, ed in effetti i nostri monumenti sono ancora lì a

testimoniarlo, come il Colosseo, non un’ellisse come pensavamo, ma un cerchio con ben otto centri.

Come noterete tutta la redazione si è impegnata nel lavoro di progressiva

costruzione di questo progetto che è la rivista Feynman, raccogliendo anche

l'insegnamento di chi ci ha preceduti - ma tutto verso un comune obbiettivo,

redigere una rivista interessante che sia testimone del mondo della scienza.

E chi ha plasmato la rivista negli anni passati non si è dimenticato di noi ed

ha continuato a collaborare e per questo lo ringraziamo. Speriamo che siano

tanti quelli che continueranno a darci il loro contributo.

Un augurio di buona lettura.

Antonio Guarrera

Feynman 5-10-Editoriale

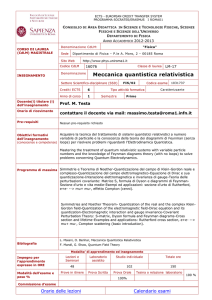

Il Calcolatore Quantistico

Dal 1981 ad oggi; evoluzione di una tecnologia rivoluzionaria

di Fabio Battaglia

Università di Catania, Facoltà di

Ingegneria Informatica

Veduta di uno degli stadi di filtraggio di

Orion, indispensabile per ridurre l'effetto

del rumore termico e risolvere i problemi

di decoerenza che affliggono il funzionamento dei processori quantistici

Molti ricercatori stanno vagliando le possibilità di costruire computer capaci di elaborare dati

usando particelle come fotoni, elettroni o atomi. Ogni particella porta con sé un bit d'informazione quantistica, o qubit (anche qbit), mentre le strani leggi della meccanica quantistica possono essere usate per fare calcoli a velocità molto superiori rispetto ai comuni calcolatori.A

differenza dei computer tradizionali quelli che utilizzano meccaniche quantistiche potrebbero

idealmente elaborare simultaneamente ogni possibile input attraverso una serie di switch

quantici connessi in parallelo. Secondo gli esperti sarebbe la migliore forma di elaborazione

parallela immaginabile, trattando le informazioni in un modo impossibile per le macchine convenzionali, le quali seguono la logica binaria dove ciascun bit di informazione può essere

acceso o spento, uno o zero, vero o falso. I computer odierni inoltre incatenano insieme combinazioni di uno e zero per rappresentare parti di informazione, laddove quelli quantici sfruttano particelle come elettroni o nuclei atomici. Ciascuna particella rappresenta un cosiddetto

quantum bit, o qubit. I qbit differiscono dai bit convenzionali in quanto un atomo (o nucleo)

può trovarsi in uno stato di "superposizione", agendo simultaneamente sia come un uno che

come uno zero. I computer quantici si avvantaggiano quindi del comportamento e delle proprietà degli atomi per offrire potenzialmente velocità di switching ed elaborazione milioni di

volte più rapide di quelle attuali. La materia è complessa ma proviami un po' a capire queste

frontiere della scienza e della tecnica ed iniziamo dal principio.

Feynman 5-10 2

Informatica

Il fisico statunitense Richard Feynman osservò , in un convegno sul

rapporto tra fisica e informazione, tenutosi nel 1981 al MIT

(Massachusetts Insitute of Technology), che un computer classico non

è in grado di simulare con efficienza un sistema governato dai principi della meccanica quantistica, ma in quella sede si limitò alla semplice osservazione. In seguito egli pubblicò un primo modello,

astratto, di calcolatore interamente basato sui principi fondamentali

della fisica quantistica. Nonostante l'idea di base avesse radici più

antiche, Feynman, insieme a David Deutsch, è da sempre considerato

uno dei pionieri di questa tecnologia.

Oggigiorno i computer 'classici' sono utilizzatissimi e hanno raggiunto

potenze di calcolo molto elevate: possono risolvere in brevissimo

tempo problemi che con grande probabilità nel 1981 avrebbero

richiesto ben altri tempi di calcolo e da macchine grandi quanto interi

scantinati.

Ma ancora non sono in grado, in linea di principio, di risolvere una

ben nota classe di problemi, i cosidetti “Problemi NP”, eseguibili solo

con la nuova architettura quantistica, né sono in grado di generare

numeri davvero casuali. Infatti un computer classico utilizza un preciso algoritmo per generare numeri “random”: scoperto tale meccanismo risulta evidente la possibilità di prevedere i numeri futuri.

Qui entra in gioco il Computer Quantistico. Questo tipo di macchina,

non nasce con l'idea di sostituire il computer 'standard', ma di affianLa Meccanica Quantistica

La meccanica quantistica si basa essenzialmente sui seguenti principi :

Principio di indeterminazione (Heinsenberg, 1927) : non si possono conoscere contemporaneamente posizione e velocità di un corpo con la precisione

che si desidera. Vi è un limite naturale invalicabile a questa precisione indicato

dalla costante di Planck (circa 10 alla -30).

Questo principio, dal contenuto "drammaticamente" negativo, afferma in altre

parole che all'uomo non è dato di "conoscere" la realtà fisica con la precisione

che desidera. Vi è un limite invalicabile insito nella natura stessa delle cose. In

altre parole, il disturbo apportato ad un sistema dai processi di misura è qualcosa di non completamente eliminabile.

Il principio di indeterminazione può essere anche formulato affermando che i

"corpi microscopici" non compiono traiettorie continue per cui, in meccanica

quantistica il concetto di traiettoria continua, che è alla base della meccanica

classica, decade : sul movimento dei corpi non si può fare nessuna affermazione deterministica. Al più si può conoscere la probabilità di trovare (facendo una

misura) una particella in un certo punto dello spazio.La meccanica quantistica è

quindi basata su una teoria probabilistica in cui si può al massimo determinare

(in modo comunque deterministico) la probabilità della posizione di. una particella. Né si deve pensare che le particelle seguano "nascostamente" la meccanica

classica finché non vengono "disturbate" da una misura. Se fosse così, per

esempio, l'atomo non potrebbe esistere perché i suoi elettroni, ruotando attorno

al nucleo e seguendo la meccanica classica, dovrebbero, per le sue stesse leggi

perdere energia sotto forma di radiazione elettromagnetica e cadere così nel

nucleo (cosa che naturalmente non accade!).

In meccanica quantistica si deve rinunciare definitivamente ad ogni nozione di

moto in termini di traiettoria continua!!! Al massimo si può pensare che la probabilità di trovare una particella “viaggia nello spazio”. E' essa (la probabilità) che

segue traiettorie classiche!!! Nella meccanica quantistica le particelle sono probabilistiche mentre le probabilità sono deterministiche.

E' ovvio che con il principio di indeterminazione non è possibile costruire nessuna fisica. Accanto a questo principio ve ne sono altri (riportati qui sotto) dal contenuto positivo con i quali è possibile costruire una teoria fisica.

Principio di corrispondenza : la meccanica quantistica non può esistere

senza la meccanica classica. Siccome non si può affermare nulla circa il moto dei

corpi quantistici (microscopici), per misurarne le proprietà dinamiche (posizione,

velocità, energia ecc.) dobbiamo farli interagire con oggetti classici (macroscopici) che seguono la meccanica classica e di cui, quindi, sappiamo "tutto".Tramite

le modificazione di questi oggetti classici (detti "strumenti di misura") siamo così

in grado di avere informazioni sugli oggetti quantistici.

Principio di sovrapposizione : un corpo (od un sistema di corpi) si può trovare contemporaneamente in più stati. Un corpo può cioè, per esempio, avere

diversi valori di energia. Solo attraverso il processo di misura si determina un

valore ben preciso. Più precisamente, un corpo potrebbe essere in uno stato corrispondente all'energia 1 ed dall'energia 2 con una probabilità per ciascuno dei

due valori. Potrebbe essere all'energia 1 al 30% ed all'energia 2 al 70 %. Ciò

significa che facendo molte misure, il corpo verrà trovato il 30% dei casi con

energia 1 ed il 70% dei casi con energia 2. Chiaramente la probabilità totale sarà

1, cioè il 100%, il corpo deve avere necessariamente una energia.

Questi principi sono in apparente antitesi con il "buon senso". La meccanica

quantistica è allora una grande dimostrazione di come il cosiddetto "buon senso"

sia erroneo e fuorviante, perché prodotto dall'esperienza di vita in un ambiente

di cui i nostri sensi ne avvertono solo alcuni aspetti.

La meccanica quantistica diventa la meccanica classica se si considera la

costante di Planck nulla, ovvero se si immagina di considerare grande a piacere

la precisione con cui misurare posizione e velocità dei corpi. Considerando che

la costante di Planck è molto piccola, la meccanica classica vale molto bene per

un enorme quantità di fenomeni. Solo quando ci spingiamo nell'infinitamente piccolo (nel mondo degli atomi e delle particelle) essa non vale più ed è allora che

diventa valida la meccanica quantistica.

Feynman 5-10 3

carlo nella risoluzione

di problemi matematici

e fisici complessi,

quali gli “NP”, e nella

gestione di chiavi d'accesso sicure al 100%,

generabili “davvero”

casualmente dal nuovo

calcolatore in quanto

macchina NON deterministica. Ricordiamo

che la maggior parte

delle nostre transazioni

bancarie vengono portate a termine tramite codici criptati ma facilmente identificabili una

volta scoperta la " formula" con la quale vengono generati.

Vediamo in dettaglio le principali differenze di architettura dei due

tipi di calcolatori. L'unità di informazione costitutiva, del modello

classico, è il bit: esso può assumere due valori, 0 e 1.

Ai fini della programmazione risulta conveniente raggruppare sequenze di bit in entità più vaste che possono assumere valori in intervalli

assai più ampi di quello consentito da un singolo bit. Questi raggruppamenti contengono generalmente un numero di stringhe binarie pari

ad una potenza binaria, pari cioè a 2n. Il più noto è il byte (chiamato

anche ottetto), corrispondente ad 8 bit, che costituisce l'unità di misura più utilizzata in campo informatico. Con n=8 possono essere rappresentati i 256 simboli che sono alla base dei nostri computer.

I computer quantistici, dal canto loro, assumono come unità fondamentale di informazione il qbit (quantum bit). (fig.1)

Il qbit può essere decodificato, ovvero individuato, usando un sistema a due livelli, ad esempio quello costituito dagli stati di spin di un

elettrone, dalle due polarizzazioni della luce, dai differenti stati elettronici di un atomo, dagli stati di flusso di dispositivi superconduttori,

ecc. La scelta ovviamente si basa sul tipo di architettura e sul problema da risolvere.

Il qbit come il bit classico ammette due stati, ma in virtù del principio

di sovrapposizione (Vedi riquadro), è possibile combinare linearmente questi due stati, ottenendone uno di sovrapposizione finale. Dal

punto di vista prettamente matematico è possibile pensare che basti

un qbit per memorizzare qualunque cosa. In realtà ciò è impossibile

dal momento che la misurazione può restituire come risultato soltanto una probabilità per ciascun stato e per il Teorema di Holevo è

possibile solamente ottenere la stessa quantità di informazione di un

bit classico. Ma ugualmente tale tecnlogia è alla base di un progresso

fondamentale, costituito dal fatto che i veri vantaggi del suo utilizzo

sono percettibili in presenza dell'utilizzo dei cosidetti “registri quantistici”, ossia di sistemi a più qbit interagenti tra loro. Facciamo un

esempio pratico: consideriamo un registro composto da tre bit. Un

qualsiasi registro classico di questo tipo può immagazzinare, ad un

certo tempo, solo una delle otto possibili configurazioni quali 000,

001, 010,011,100,101,110,111. Un registro quantistico, invece, immaPROBLEMI NP-COMPLETI

I problemi si possono dividere in tre categorie in base al loro

tempo di esecuzione:

- semplici che sono risolvibili in tempo polinomiale es. O(n²)

- difficili che non si possono risolvere in tempo polinomiale

es. O(2^n)

- indecidibili: non si può dire nulla.

I problemi con una complessità non riconducibile a un polinomio, ma con un andamento esponenziale vengono definiti

NON POLINOMIALI, e all'aumentare dei dati in ingresso il

tempo necessario ad eseguire l'algoritmo cresce esponenzialmente,.

La classe di complessità NP-COMPLETI è data dall'insieme

dei problemi di decisione per cui non è ancora stato trovato

un algoritmo che li risolva in tempo polinomiale. Tale classe è

definita anche con NPC. La maggior parte degli informatici

teorici credono che i problemi NP-COMPLETI appartengano

alla categoria dei problemi detti intrattabili.

fig.1

Il bit è un’unità classica di informazione.

Essa può stare solo in due stati discreti. Il

q-bit è una unità di informazione quantistica.

Esso può stare in una sovrapposizione di

più stati. E’ rappresentato come un vettore

in una sfera di Bloch.

gazzina tutti gli otto stati contemporaneamente perché lo stato complessivo contiene tutti gli stati di base possibili. I qbit differiscono,

pertanto, dai bit convenzionali in quanto un atomo (o nucleo) può

trovarsi in uno stato di "superposizione", agendo simultaneamente sia

come un uno che come uno zero. I computer quantici si avvantaggiano quindi del comportamento e delle proprietà degli atomi per offrire

potenzialmente velocità di switching ed elaborazione milioni di volte

più rapide di quelle odierne.Questo risultato straordinario è dovuto

ad un fenomeno quantistico noto come Entanglement. (Vedi riquadro)

I problemi maggiori al momento riguardano la realizzibilità fisica

della macchina in sé . Lo scoglio più impervio è costituito dal problema della “decoerenza quantistica”, ossia l'effetto di interscambio

tra il sistema quantistico e l'ambiente (le complesse e delicate dinamiche di queste macchine risentono di ogni minimo disturbo). Ma la tecnologia ha fatto passi da gigante, e in questi anni, grazie a ricerche

approfondite anche da parte di università italiane, sono stati ottenuti

risultati di rilievo.

Nel 2007 la D-Wave Systems è riuscita a dare una dimostrazione

pubblica del funzionamento di Orion, il primo computer quantistico

adiabatico a 16 qbit basato su sistemi ottici lineari. Nell'anno in corso

è stata aumentata di 1000 volte in media, la durata d'integrità dei

qbit.

David Weiss, Karl Nelson e Xiao Li dell'Università della

Pennsylvania sono riusciti a intrappolare gli atomi in un reticolo ottico, uno schema d'interferenza (fig2) che si crea quando due raggi

laser si scontrano.

Gli atomi vengono intrappolati tra le zone di luce e quelle d'ombra

come due palline da ping pong dentro a un uovo. Già in passato,

Entanglement

Fenomeno che si verifica a livello quantistico, che coinvolge

due o più particelle generate da uno stesso processo o che si

siano trovate in interazione reciproca per un certo periodo. Tali

particelle rimangono in qualche modo legate indissolubilmente

(entangled), nel senso che quello che accade a una di esse si

ripercuote immediatamente anche sull'altra, indipendentemente

dalla distanza che le separa.

Concludendo, si può dire che "l'entanglement” fa a pezzi tutte

quelle concezioni della realtà che ci siamo costruiti sulla base

della nostra abituale esperienza sensoriale. Queste nozioni di

realtà si sono così fortemente consolidate nella nostra psiche

che anche il maggior scienziato del XX secolo, Albert Einstein,

si è lasciato fuorviare da queste nozioni di senso comune,

tanto da ritenere che la meccanica quantistica fosse una teoria

"incompleta", a causa della sua incompatibilità con elementi

che credeva fossero parte della realtà. Einstein era convinto

che un evento che accade in un punto non possa mai essere

correlato in modo diretto e istantaneo con un evento che accade in un punto distante. Per capire, o anche semplicemente per

accettare l'entanglement e gli altri fenomeni quantistici a esso

associati, dobbiamo innanzitutto ammettere che le nostre concezioni della realtà nell'universo sono inadeguate.

L'entanglement ci insegna che la nostra esperienza quotidiana

non ci fornisce la capacità di capire la natura di ciò che accade

nel micromondo, di cui non possiamo avere esperienza diretta.

però , i ricercatori avevano utilizzato i reticoli ottici per sequestrare

milioni di atomi. "La differenza - spiega Weiss - è che oggi possiamo

individuare ogni singolo atomo all'interno dello schema tridimensionale". Fino ad oggi, infatti, gli unici reticolati in cui gli atomi erano

visibili erano quelli mono o bidimensionali che, però , contenevano

solo una manciata di particelle.

Nel nuovo studio, invece, gli scienziati hanno disposto i tre laser

secondo l'angolazione necessaria per creare un reticolato tridimensionale capace d'intrappolare ben 250 atomi di cesio. In seguito hanno

fotografato questi atomi strato su strato per provare che potevano

effettivamente vederli ad uno ad uno. "Se non li puoi vedere - rivela

Weiss - è molto difficile che tu li possa poi manipolare." Aggiunge

inoltre che, proprio perché sono in grado di ricreare singoli atomi, "è

chiaro che dovremmo diventare talmente abili da influenzarli individualmente".

fig.2 Schema interferometrico

Feynman 5-10 4

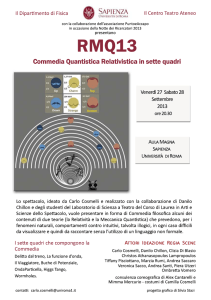

LHC: la particella di

Dio ed altri misteri.

di Valerio Mascolino

Quale grande stupore ci porterebbe l’immaginare che

Dio possa essere una particella fondamentale del Modello

Standard? Tralasciando questioni di aspetto teologico, il

bosone di Higgs ha acquistato nel corso degli anni, e degli

studi che lo hanno visto come protagonista, il titolo di "particella di Dio", conferitogli dal Nobel per la Fisica '93, Leon

Max Lederman. Tale particella sarebbe la responsabile delle

forze dell'omonimo campo di Higgs. Pare, infatti, che l'intero universo sia permeato da un campo (di Higgs appunto,

dal nome del famoso fisico) che dovrebbe conferirgli massa.

Conseguentemente, il ruolo che il bosone di Higgs riveste

all'interno del Modello Standard è proprio quello di "portatore" di massa. Il grande problema, però , che la teoria deve

affrontare è che tale particella esiste, ancora, solo ipoteticamente, cioè non ne è mai stata provata l'esistenza, nonostante su di essa si fondi la validità del Modello Standard

delle particelle. Fra i tanti obbiettivi del nuovo Large

Hadron Collider, costruito nel sottosuolo al confine tra

Francia e Svizzera, figura proprio l'individuazione della

"particella di Dio".

Il vastissimo acceleratore di particelle (entrato in funzione

nel 2008) è costituito da un enorme anello circolare (27km

di lunghezza) costituito prevalentemente da magneti super-

Simulated Higg's boson in CMS

Feynman 5-10/Fisica 5

Nato il 29 maggio 1029 Peter Higgs è professore emerito nella Università di Edimburgo dove ha per molti anni

insegnato Fisica Teorica. La sua notorietà è dovuta alla

proposta da lui formulata nel 1964 per spiegare la rottura di simmetria dell’interazione elettrodebole. La teoria

da lui sviluppata ipotizza che la massa delle particelle in

generale e quella dei bosoni W e Z0 in particolare sia

dovuta ad un campo di interazione (campo di Higgs)

che pervade tutto l’Universo. Al campo di Higgs – come

ad ogni altro campo quantistico - viene associato un

quanto (bosone di Higgs): l’analogo del fotone nel caso

del campo elettromagnetico. Il bosone di Higgs non è

stato ancora sperimentalmente scoperto ma è generalmente accettato come un complemento essenziale del

Modello Standar. Senza il campo di Higgs, le particelle

non avrebbero massa e viaggerebbero quindi alla velocità della luce. Nello sviluppo dell’Universo se non ci

fosse il campo di Higgs le particelle senza massa continuerebbero per sempre il loro viaggio e non ci sarebbe

la possibilità per gli atomi di formarsi.

conduttori e da 4 "stazioni", collegate tra loro e ognuna dedita

allo studio di un fenomeno particolare, attraverso l’utilizzo di

diverse tecnologie dei rilevatori. Possiamo certamente dirlo, il

CERN di Ginevra, ha fatto le cose in grande.

L'immenso complesso non è però finalizzato alla sola ricerca

del bosone di Higgs. Anzi. Altri misteri ed enormi punti interrogativi della Fisica cercano risposta tra i tunnel del sottosuolo

ginevrino. Lungo i

27 kilometri dell'acceleratore, infatti, le

4 stazioni presenti,

provviste delle ultime tecnologie in

campo di rilevatori,

si propongono come

fine lo studio di

diversi fenomeni.

Queste "stazioni"

hanno ognuna un

proprio nome: oltre

ad Atlas e CMS (le

più importanti, adite

allo studio parallelo

del bosone di Higgs)

abbiamo LHCb e

Alice.

materia può essere trasformata in antimateria (o viceversa)

solo in sede di laboratorio, o comunque apportando grandi

quantitativi di energia dall'esterno, agendo sulla composizione

delle particelle elementari. Un'abbondanza di tali particolari

antiparticelle avrebbe evitato infatti la totale annichilazione di

materia e antimateria, a favore della prima e a noi ben più nota

"materia". Particelle del genere (o meglio antiparticelle) sem-

Schema

del

laboratorio Cern,

a Ginevra in

Svizzera, dove

in un tunnel con

circonferenza di

27 km sotto alla

periferia della

città c’è l’acceleratore di particelle LHC.

L’acceleratore

LHC ospita gli

esperimenti

Atlas, Cms, Alice

e Lhc-b.

LHCb

Mai sentito parlare

di antimateria? LHC

beauty (o LHCb), è

il nome del rivelatore finalizzato alla

rilevazione di essa. "Bellezza" dell'LHC. Tale apparato, essenzialmente, si pone una grande domanda: "Dov'è l'antimateria"?. Se, infatti, come teorizzato nel Modello Standard, uguali

quantità di materia ed antimateria fossero state create nel

"momento zero", all'inizio dell'universo, esse avrebbero dovuto

annichilarsi, secondo le proprietà della loro natura, e produrre

semplicemente un enorme quantitativo di energia. Ma basta

guardarsi intorno per rendersi conto che la materia sia risultata

sicuramente sovrabbondante nel "conflitto" con l'antimateria,

ed uno scompenso deve esservi stato anche al momento del

Big Bang. La risposta all'interrogativo di LHCb pare possa

risiedere in alcune particolari antiparticelle (particelle elementari d'antimateria) che tendono a trasformarsi spontaneamente

nelle loro corrispettive particelle. Normalmente, infatti, la

Feynman 5-10 6

brano essere i kaoni: gli "antikaoni" tendono a

trasformarsi nella loro antiparticella (da materia ad antimateria) molto più frequentemente di quanto accada il contrario (da

antimateria a materia). E' evidente come i ricercatori del

CERN, tra particelle massive e squilibri di materia e antimateria, stiano cercando sempre più di scoprire il mistero ancora

non del tutto sondato della creazione dell'universo.

ALICE

Nella stessa ottica si inserisce Alice (A Large Ion Collider

Experiment, trad. Esperimento di un grande acceleratore ionico), nella sua ricerca del plasma quark-gluonico. Pare che per i

primi 20/30 millisecondi successivi al big-bang, la materia,

l'universo tutto, si trovassero in questo stato. Ma cos'è , dun-

Il Modello Standard

I fisici hanno elaborato una teoria, chiamata Modello Standard, che

vuole descrivere sia la materia che le forze che regolanol'Universo.

La bellezza di tale teoria risiede nella possibilità di descrivere tutta la

materia sulla base di poche particelle ed interazioni fondamentali tra

esse.Le idee chiave sono:

- Esistono delle particelle che sono i costituenti fondamentali della

materia.

Il Modello Standard sostiene che le particelle fondamentali si dividono

in 2 gruppi principali - i quark e i leptoni - e ogni gruppo è costituito da

6 elementi (detti anche sapori). Le particelle fondamentali costituenti

della materia sono i quark up e down (costituenti del protone e del neutrone) e il leptone-elettrone

- Esistono delle particelle che agiscono, invece, da “mediatrici di forza”.

Le interazioni tra le particelle fondamentali di materia avvengono tramite lo scambio di particelle mediatrici di forza

Il Modello Standard è una buona teoria. Gli esperimenti l'hanno verificato con una incredibile precisione, e quasi tutte le sue previsioni si sono

rivelate corrette.Tutte le particelle “predette” dal modello standard sono

state trovate. L'unica che manca all'appello è il bosone di Higgs. Questa

particella è di fondamentale importanza per svariate ragioni. La prima

è legata alla sua funzione nel modello standard, ovvera quella di dare

origine alle masse delle altre particelle. La seconda ragione è che, se

scoperta, sarebbe la prima particella elementare scalare (cioè priva di

spin, ovvero la proprietà di una particella di ruotare su se stessa, come

una trottola). Tuttavia il Modello Standard non riesce a spiegare tutto: ne

è un esempio la forza gravitazionale.

que, il plasma quark-gluonico? Si tratta di uno stato plasmatico

della materia, nel quale i quark (che, quali particelle aggregative, non possono esistere se non a gruppi di 2 o 3) sono deconfinati e liberi di muoversi, slegati da altre particelle di uguale

natura. Nel plasma quark-gluonico affianco ai quark appaiono i

gluoni, altre particelle elementari generatrici della cosiddetta

forza "nucleare forte", e che allo stato ordinario causano l'intensa interazione tra i quark.

Dove entra in gioco Alice? Ebbene, la collisione tra ioni

pesanti riesce a generare un'energia tale (parecchi TeV) da

ridurre la particelle elementari allo stato di plasma quark-gluonico. Con i suoi fasci di ioni di piombo, pesanti, e ricchi di

protoni e neutroni, Alice sembra proprio essere "la migliore

candidata" a sostenere la sfida.

ATLAS-CMS

Ma il sotterraneo esperimento del CERN è più comunemente

noto per la ricerca del bosone di Higgs, la particella che pare

costituire l’origine delle masse della materia.

In attesa dei dati dell'LHC possiamo per ora prendere in considerazione due alternative:

1) la particella di

Higgs viene scoperta:

questo confermerebbe in via definitiva il

modello standard

come la teoria che

interpreta correttamente le tre interazioni fondamentali

unificate per l'appunto dal modello standard, cioè le interazioni elettromagnetica, debole e forte; 2)

la particella di Higgs

non esiste: questo

richiederebbe una

revisione piuttosto

Feynman 5-10 7

radicale del modello standard;

Ma tornando all’apparato sperimentale le domande immediate

che dovremmo porci riguardano il numero di questi rilevatori:

perché due apparati (Atlas e CMS) e non uno, per l’analisi del

medesimo fenomeno? E dove stanno le differenze?

La risposta alla prima domanda, riguarda la precisione dei dati

ottenuti. Intuitivamente, infatti, se due osservazioni di un fenomeno, a parità di condizioni, forniscono dei risultati analoghi,

si può ragionevolmente supporre che lo studio di quel fenomeno possa essere più preciso che se fosse effettuato da un

solo apparato. Da qui ci si ricollega alla seconda domanda: se,

inoltre, le caratteristiche dei magneti superconduttori utilizzati

per l'isolamento magnetico dei fasci di protoni, variano da

apparato ad apparato (le caratteristiche geometriche e l'intensita del campo magnetico prodotte dai due sono profondamente

differenti) i risultati comuni ai due studi potremmo definirli,

con buona approssimazione, "corretti". Analoghe tra i due,

invece, risultano essere anche le tecnologie utilizzate per i rilevatori; sono tuttavia presenti alcune differenze, che possono

essere limitate, per

citare un esempio,

al fatto che i calorimetri elettromagnetici (che eseguono

l'attività rilevativa

attraverso la misurazione dell'energia di

elettroni, positroni e

fotoni), utilizzati per

entrambi, presentino

tecniche diverse

nella realizzazione e

differenze nella

risoluzione spaziale

(la precisione nell'individuare il

punto di impatto

una particella ed il

calorimetro) e tem-

porale (la capacità di distinguere due eventi molti vicini nel

tempo).

IL PUNTO DELLA SITUAZIONE

Nonostante l'importanza del progetto LHC, i capitali investiti e

la grande attenzione di centinaia di ricercatori da ogni parte del

mondo, sin dalla sua prima accensione nel 10 Settembre 2008,

gli studiosi ginevrini hanno dovuto cimentarsi nel superamento

di ostacoli di ogni tipo.

Il primo stallo al colossale lavoro dell'acceleratore sotterraneo

si è avuto a soli nove giorni dal primo passaggio di fasci di

protoni al suo interno: un guasto ad un superconduttore, che ha

causato l'interruzione dell'attività di ricerca per oltre un anno.

LHC ha infatti ripreso a "sparare" protoni soltanto il 21

novembre 2009. Per l’acceleratore, inoltre, è prevista una cessazione delle attività al termine del 2010, al fine di effettuare

dei lavori che lo portino a sviluppare un'energia di 14 TeV (si

consideri che il 10 Settembre fu portato a 2,36 TeV).

Il CERN ha anche dovuto affrontare delle controversie legali.

Per incredibile che possa sembrare, scienziati e ricercatori da

ogni parte del mondo hanno chiesto la cessazione del progetto:

pare infatti che secondo alcuni studi da essi condotti, l'acceleratore di particelle, ed in particolare le collisioni che ivi si verificano, potrebbero almeno in teoria dare vita a mini buchi neri,

che potrebbero "inghiottire" la Terra. Tra scienza e leggenda,

pare che perfino le profezie di Nostradamus abbiano previsto

un incidente del genere. D'altro canto i fisici dei laboratori del

CERN, pur non smentendo l'ipotesi della creazione dei buchi

neri, sostengono che essi non rappresentino una minaccia, dal

momento che essi evaporerebbero subito per via della radiazione di Hawking, prodotta per sua natura dallo stesso buco nero.

Il CERN, ad oggi, è uscito illeso da ogni accusa mossa a suo

carico. La comunità scientifica tutta, ed anche l'occhio curioso

del semplice pubblico, attende con trepidazione i risultati degli

studi di LHC. Le conoscenze che ne deriverebbero, sarebbero

di immane entità , tanto che il progetto è stato più volte

descritto come la più grande impresa scientifica della storia.

Ciò , permetterebbe all'uomo, di fare ancora un altro, piccolo,

timido passo avanti all'interno del misterioso dominio della

scienza. E dell'infinito.

Le immagini di questo articolo sono state ottenute durante la visita guidata

che la classe VA ha fattoal Cern di Ginevra nel Febbraio 2008. Durante questa visita gli studenti, accompagnati dal Prof.Guarrera, sono scesi in profondità, nell’anello Lhc, ed hanno potuto visionare uno dei rivelatori posti in esso.

Feynman 5-10 8

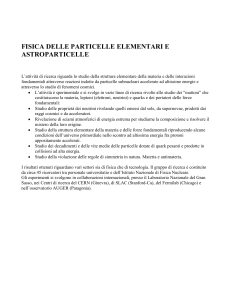

Il COLOSSEO A

OTTO CENTRI

di Guglielmo Bonarrigo

e Carla Marino

L'arena (e tutto il Colosseo) sono in genere

definiti ellittici, ma la curva di questa, che è

stata rilevata recentemente con un elevato

grado di precisione, non coincide con quella di

una ellisse. Così gli studiosi che hanno affrontato il problema hanno ipotizzato che tale

curva sia una curva policentrica, ovvero disegnata calcolando i diversi centri di varie curve

con un sistema geometrico.

Feynman 5-10 9

Architettura

L'Anfiteatro Flavio, meglio conosciuto col nome di

Colosseo, è uno dei monumenti di epoca romana più

famosi nel mondo. Questo grandioso monumento

esprime con chiarezza le concezioni architettoniche e

costruttive romane della prima età imperiale, basate

rispettivamente sulla linea curva e avvolgente offerta

dalla pianta ellittica e sulla complessità dei sistemi

costruttivi. È proprio sulla pianta ellittica che vogliamo soffermarci. In effetti più che un’ellisse si tratta di

un ovale a più centri. Diversi studi, nella fattispecie,

ponevano come forma del Colosseo un ovale a quattro

centri.

Lo studio geometrico delle linee del Colosseo, secondo Mark Wilson (Principles of Roman Architecture,

University of Bath), nasce dalla costruzione di un

ovale a 4 centri nel quale i semiassi si fondano sulle

misure del triangolo perfetto 3:4:5 (Terna Pitagorica)

quindi, all'aumentare o al diminuire di esse, si giungerebbe alla forma del nostro Colosseo. Da uno studio

dell'architetto Camillo Trevisan della Facoltà di

Architettura di Venezia (che ringraziamo per la sua

disponibilità ) sia sul Colosseo che sull'Anfiteatro di

Verona emerge però che, in entrambi i casi, gli ovali

a quattro centri interpolano solo a grandi linee le

strutture perimetrali, con scarti quadratici medi superiori ai 15 centimetri. È soprattutto la disposizione e la

conformazione degli scarti a rendere quasi impossibile

ritenere costruttive quelle curve: i punti rilevati, infatti, si dispongono, per sottoinsiemi e con simmetrica

Camillo Trevisan è docente di Disegno presso la

facoltà di Design e Arti (IUAV) di Venezia. Laureato

in Architettura con il massimo dei voti nel 1982,

presso l’IUAV. Ricercatore nell'area del Disegno è

attualmente professore associato.

La sua attività di ricerca riguarda principalmente la

rappresentazione eseguita con l'utilizzo di tecniche e

strumenti informatici e la predisposizione di software

specifici. E’ anche Presidente del comitato tecnico

scientifico del Laboratorio Multimedia FDA-DADI.

Attingendo a Il disegno degli ovali armonici di

Edoardo Dotto, possiamo descrivere come avviene la

costruzione di questo ovale(fig.1): innanzi tutto si

traccia un triangolo rettangolo di proporzioni 3:4:5

facendo coincidere il vertice contenente l'angolo

retto con l'origine degli assi cartesiani; successivamente si traccia un triangolo simmetrico rispetto

all'asse delle y. Ottenuto un nuovo triangolo isoscele

(con lati di misura 5, 5 e 6) si traccia nuovamente il

suo simmetrico, rispetto all'asse x, ottenendo quindi

un rombo con lato di misura 5. Si tracciano due circonferenze di raggio generico che hanno per centri i

due vertici, giacenti sull'asse x, del rombo, per poi

disegnare due archi di circonferenza usando come

centri i due vertici del rombo che stanno sull'asse y.

In questo modo avremo ottenuto il nostro ovale.

(la Figura 1 è stata realizzata con Geogebra

www.geogebra.it).

Fig.1

Feynman 5-10 10

"Il Colosseo, la più bella rovina di Roma,

termina il nobile recinto dove si manifesta tutta la

storia. Questo magnifico edificio, di cui esistono

solo le pietre spoglie dell'oro e de' marmi, servì di

arena ai gladiatori combattenti contro le bestie

feroci. Così si soleva divertire e ingannare il popolo romano, con emozioni forti, quando i sentimenti

naturali non potevano più avere slancio."

(Madame de Staël)

Fig.2

.2

regolarità , alternativamente all'interno o all'esterno

della curva interpolante (Fig. 2).

Dai dati elaborati dal prof. Trevisan, pare che gli

antichi Romani per disegnare e realizzare la forma

del Colosseo abbiano agito in due fasi: una progettuale ed una esecutiva. Nel progettare il Colosseo

avrebbero usato come linea un ovale a 4 centri, dato

che una curva di questo genere permette facilmente

di calcolare perimetro e area. Identificare il perimetro di un'ellisse o il perimetro e l'area di un ovale a

otto centri (praticamente una curva fatta da otto

archi di circonferenza) comporta, invece, calcoli

assai più complessi; ma d'altra parte è necessario

conoscere quei dati per progettare la capienza della

cavea e il numero e l'interasse degli archi esterni. E

dato che il perimetro di un ovale a quattro centri è

praticamente uguale a quello di un ovale a otto; si è

cercato di interpolare i dati topografici del Colosseo

con una linea di questo genere.

Confronto tra i punti topografici rilevati

e gli ovali a 4 centri che meglio li

interpolano (particolare del Colosseo).

Distinguiamo quindi due prospetti per il Colosseo:

uno progettuale basato sull'ovale a 4 centri e uno

costruttivo sull'ovale a 8 centri.

Gli scarti tra le rivelazioni topografiche del

Colosseo e la nostra curva indicano l'ovale a 4 centri come curva interpolante poco probabile - anche

per le posizioni che assumono gruppi omogenei di

punti di controllo rispetto alla curva stessa, come si

è già detto - mentre gli scarti delle ellissi, equidistanti tra loro sugli assi, e degli ovali a 8 centri sono

molto simili e verosimili. Tuttavia è da notare, nel

caso dell'ellisse, un forte aumento degli scarti passando dalla curva più esterna (4.6 cm) all'interna

(14.6 cm); mentre gli scarti per l'ovale a 8 centri si

mantengono più uniformi. Infatti, come già notato,

la differenza tra l'ellisse e l'ovale a 8 centri aumenta

sensibilmente con l'aumentare del rapporto tra gli

assi: un ulteriore indizio a favore dell'ovale a 8 centri come curva esecutiva.

Feynman 5-10 11

Prospetticamente quindi il Colosseo si avvicina all'ovale a 8 centri (Fig.3), anche se non è

possibile affermare se questo sia dovuto

all'adozione di tecniche di costruzione che

rimangono a noi ignote.

Il metodo seguito per il Colosseo è stato

applicato anche all’Arena di Verona.

Nell’Arena i calcoli portano di sicuro all’eclusione di un ovale a quattro centri come curva

costruttiva, mentre la differenza tra ovale ad

otto centri o ellisse è minima.

Link sul Web:

http://www.camillotrevisan.it/anfite/anfite1.htm

.3

Fig.3

Feynman 5-10 12

Colosseo. Interpolazione

contemporanea (ad esclusione della curva più interna)

dei vari insiemi di punti con

ovali a 8 centri.

LA MATERIA OSCURA

di Stefano Orlando

Se la si potesse vedere assomiglierebbe

a un'immensa ragnatela che da un capo

all'altro occuperebbe una porzione di cielo

di 270 milioni di anni luce. Ma da nessuno

fino adesso è stata vista, dal momento

che si tratta di "materia oscura", una

materia di cui si conosce l’esistenza, ma

non la composizione, perché risulta invisibile a ogni tipo di lunghezza d'onda. Gli

astronomi la cercano da anni, ne ipotizzano la composizione, ma nulla al momento

lascia trapelare di cosa sia realmente

fatta. E' per questo che la sua esistenza è

stata addirittura messa in dubbio...

Galassia a Testa di Cavallo

Feynman 5-10 13 Cosmologia

Un'ulteriore conferma della presenza di questo tipo di materia è stata

ottenuta recentemente attraverso il fenomeno delle lenti gravitazionali.

I fotoni, le particelle che compongono la luce, portano energia e quindi

risentono dell'attrazione gravitazionale dovuta alle altre forme di energia. Cos ì la luce, vicino a concentrazioni di materia, non viaggia in

linea retta ma curva, come in una lente. Tuttavia in alcuni casi è stata

registrata una distorsione

delle immagini troppo

accentuata per la quantità di

materia visibile presente:

esiste dunque un "qualcosa"

capace di esercitare un'influenza a livello gravitazionale e di sfuggire ai nostri

occhi e ai nostri strumenti.

Venne evidenziata da due studiosi, Zwicky, e Smith, rispettivamente nel 1933 e nel 1936 (anche se il primo ad ipotizzarne la

presenza fu Oort nel '32), i quali studiando grandi ammassi di

galassie notarono che la velocità delle stesse era superiore a

quella prevista e la materia visibile non poteva bastare a tenere

legato l'intero ammasso.

Lo stesso si verificava per le stelle periferiche di alcune galassie

che avevano velocità orbitali maggiori dei modelli teorici: era

come se il sistema gravitazionale fosse influenzato da una grande

quantità di materia invisibile (massa mancante). Ma da cosa è

fatta questa materia? Oggi sulla composizione di questa materia

oscura ci sono solo ipotesi, per alcuni si tratta di grandi pianeti,

piccole stelle compatte e poco luminose o addirittura di materia

all'interno di stelle o pianeti. Per altri si tratta di particelle elementari come i neutrini o di WIMPs (Weakly Interacting

Massive Particles), particelle che interagiscono difficilmente con

la materia ordinaria.

Il quadro si è complicato quando si è capito che ad influenzare

i modelli teorici ci doveva essere un'energia invisibile, in quanto

l'espansione dell'universo sembra essere accelerata e, se così

dovesse essere in eterno, non si contrarrà più scongiurando

eventi simili al Big Bang. Per spiegare quest'energia oscura gli

studiosi hanno formulato due ipotesi, una legata alla costante

cosmologica ed una alla quintessenza.

Allo stato attuale si pensa che l'universo sia composto circa per il

70% da energia oscura, per il 25% da materia oscura, per il 5%

dalla materia visibile che conosciamo.

Tuttavia ci sono ancora molti interrogativi e molte cose da scoprire. Infatti oggi stanno nascendo diversi telescopi per "cacciare"

i neutrini, costituiti da reticoli tridimensionali di rivelatori di

luce, detti fotomoltiplicatori, che misurano il tempo di arrivo dei

fotoni Cherenkov grazie ai quali si rivelano i muoni secondari

prodotti dai neutrini. Questi ultimi interagiscono pochissimo con

la materia ordinaria e il loro studio permetterà di comprendere

meglio anche i WIMPs che hanno una massa almeno 10 miliardi

di volte più grande di un normale neutrino.

I neutrini devono essere filtrati per rivelare solo quelli astrofisici

tralasciando quelli atmosferici (ciò si fa ponendo questi telescopi a grandi profondità marine o sotto i ghiacci polari, acqua e

ghiaccio fanno da schermo) e gli strumenti possono raggiungere

il chilometro cubo di dimensioni per contrastare la bassa probabilità di interazione.

Fra i principali progetti ricordiamo Antares, di fronte alla costa di

Marsiglia, Nemo, che prevede un rivelatore a largo di Capo

Passero, in Sicilia, e Nestor, che mira alla costruzione di un rivelatore vicino alle coste del Peloponneso.

Feynman 5-10 14

Un numero infinito

e=2.71828182845904523536028747135266249775724709

369995957496696762772407663035354759457138217852

516642742746639193200305992181741359662904357290

033429526059563073813232862794349076323382988075

31952510190115738341879307021540891499348841

e non finisce qui…….

di Rita Laureanti

E’ inafferrabile, perché è formato da una serie

infinita di cifre, ma onnipresente, perché le sue

proprietà lo rendono insostituibile per descrivere

i fenomeni più complessi. Storia di un numero

nato dall'economia e adottato da tutte le scienze.

Feynman 5-10 15 Matematica

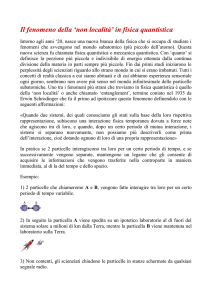

tab.1 La colonna di destra della tabella

mostra che, al crescere di n, il

valore numerico dell'espressione si

avvicina sempre più al valore di e

Grafico 1.

Il numero di Nepero, uno dei numeri incommensurabili, per tanto

tempo ha costituito una sfida per i matematici di tutto il mondo che da

decenni fanno a gara nel trovare nuove cifre per un'approssimazione

sempre più accurata, ma mai assolutamente perfetta: esso è infatti, un

numero irrazionale trascendente (cioè non ottenibile come risultato di

alcuna equazione polinomiale). Nonostante sia costituito da infinite

cifre, il numero di Nepero trova riscontro in numerosi ambiti della

realtà . Ad esempio si applica nel decadimento radioattivo o nella crescita esponenziale di una popolazione di batteri. Il decadimento radioattivo è il processo attraverso cui alcuni elementi si trasformano in

altri con numero atomico inferiore emettendo particelle (alfa, beta...).

La legge del decadimento radioattivo segue la funzione esponenziale:

se nell'istante iniziale abbiamo y0 grammi di polonio, dopo un tempo

t avremo una quantità di polonio pari a y = y0 e ^(- 0,005t). La crescita della popolazione di alcuni tipi di batteri segue un andamento

esponenziale del tipo

Nt = N0e-Kt

in cui N0 rappresenta il numero di individui nell'istante iniziale, mentre k è una costante che dipende dalle caratteristiche della specie in

osservazione.

Il numero di Nepero è così importante in matematica soprattutto

per il fatto che la derivata della funzione esponenziale è uguale alla

funzione esponenziale stessa.

l numero di Nepero è una costante di fondamentale importanza nel

campo dell'analisi matematica ed è la base dei logaritmi naturali. Il

primo riferimento alla costante

risale al 1618 in un lavoro sui

logaritmi di Nepero, ma la sua

definizione è stata trovata da

Bernouilli:

E cosa significa? Praticamente,

scegliamo un numero n molto grande; poi aggiungiamo 1 all'inverso

di n e, infine, eleviamo tutto ad una potenza pari proprio ad n. Ora

più n è grande e più ci si avvicina ad un certo numero che chiamiamo e.

e è un numero irrazionale ed è pari a 2.71828…

Detta così la cosa non entusiasma più di tanto. Ma, prestando bene

attenzione, c'è qualcosa di strano, qualcosa che sembra non quadrare.

Vediamo perché . Nelle proprietà delle potenze una cosa su tutte è

certa:

1. se a < 1, a^n tende a 0, per n tendente a infinito

2. se a = 1, a^n = 1, per ogni n

3. se a > 1, a^n tende a infinito, per n tendente a infinito

Allora come è possibile che un numero comunque maggiore di 1,

anche se di un infinitesimo, tenda ad un numero finito al crescere

dell'esponente?

In effetti e nasce in una sorta di misteriosa zona d'ombra tra il secondo e terzo caso: da una parte il termine 1/n tenderebbe a zero, dall'altra il binomio (1 + 1/n), sicuramente maggiore di 1 (terzo caso)

dovrebbe tendere ad infinito. Facciamo qualche prova, cercando il

valore di (1 + 1/n)^n al crescere di n (asse delle ascisse nel grafico).

Vedi anche Tab.1.

I due effetti si bilanciano, così al crescere di n, l'effetto dell'esponente estremamente grande è vanificato da una base sempre più prossima ad 1, sempre più neutra. All'inizio prevale l'effetto dell'esponente,

quando il termine 1/n non è poi così piccolo (ma per fortuna lo è

l'esponente!), poi si raggiunge un equilibrio che abbiamo chiamato

e.(Grafico 1)

Mi piace pensare ad e come il risultato di una serrata negoziazione tra due controparti: l'esponente, teso verso l'infinito e la base,

ancorata all'unità.

La Storia

La prima citazione della costante, sebbene sotto il nome di b, è presente in alcune lettere di Leibniz a Huygens; il primo ad usare il simbolo e fu Eulero, probabilmente non ispirandosi all'iniziale del suo

nome, ma rifacendosi al termine "esponenziale" (si ricordi che il logaritmo naturale in base e, lne, è l'inverso della funzione esponenziale

ex), oppure all'usanza di chiamare oggetti matematici con le lettere

dell'alfabeto, essendo la e la prima lettera non ancora diffusamente

usata e codificata.

Si pensa che e sia stata usata nell'antichità nella costruzione delle

Piramidi e del Partenone, in quanto i rapporti tra alcune misure in tali

opere coincidono approssimativamente con il suo valore. I Greci chiamavano tale rapporto costante armonica, la indicavano con epsilon e

le assegnavano il valore di 2,72.

Tale numero è , insieme a pi greco e alla sezione aurea, uno dei

numeri che più ha affascinato e affascina l'uomo, che, prigioniero dei

suoi limiti, tende sempre a raggiungere l'infinito.

"Tale è la nostra effettiva condizione. Essa ci rende incapaci sia di

conoscere con piena certezza come d'ignorare in maniera assoluta.

Noi voghiamo in un vasto mare, sospinti da un estremo all'altro, sempre incerti e fluttuanti, ogni termine al quale pensiamo di ormeggiarci

o di fissarci vacilla e ci lascia; e, se lo seguiamo, ci si sottrae, scorre

via e fugge in un'eterna fuga" (Blaise Pascal, Pensieri).

Feynman 5-10 16

Dormiamo troppo?

È perchè siamo giovani!

di Gabriele Costanzo, Mario Litrico

Diversi studi hanno dimostrato che il numero delle ore di sonno necessarie ad un individuo per mantenersi in una condizione di benessere ed efficienza fisica e mentale è relativo all'età dell'individuo.

Basti pensare che, in media, un neonato dedica al sonno 16-18 ore al giorno e un adolescente circa 89 ore. Questi valori vanno sempre più a diminuire con l'avanzare dell'età : il sonno di un anziano, di

fatto, si esaurisce il più delle volte in poco più di 6 ore, tra l'altro discontinue, ed è maggiormente

soggetto a disturbi esterni. Il motivo di tali differenze è dovuto a variazioni ormonali di significativa

importanza e nel caso della donna anche all'azione del ciclo mestruale. Con il diminuire, infatti, della

produzione di ormone GH, aumenta quella di cortisolo che, non più regolato con il passare degli

anni dall'ormone DHEA, sottopone il corpo ad un maggiore stress, causando l'insonnia. Un altro

ormone di significativa importanza è inoltre la melatonina, regolatore biologico umano che varia la

propria secrezione in corrispondenza dell'alternarsi di luce e buio, per poi diminuire con gli anni.

Tuttavia, come ben sappiamo, le ore di sonno sono puramente soggettive. In teoria basterebbero due

ore di sonno al giorno per vivere e molti individui si limitano a 4-5 ore di sonno senza presentare

segni di irascibilità e di perdita di concentrazione. Questo perchè ciò che viene definito sonno

essenziale, determinato da sonno profondo e sonno REM,(vedi box) varia da persona a persona e

costituisce, quindi, quella parte di sonno che riesce maggiormente a riposare l'individuo. Ciò che si

rimprovera, invece, agli adolescenti è il così ddetto abbiocco post-pranzo (il "sonnellino" pomeridiano) che spesso, più che riposo momentaneo, diventa a tutti gli effetti una vera e propria dormita

volta a recuperare le ore di sonno perse (si sa, i ragazzi d'oggi, iperattivi ed "instancabili", la notte

non tengono conto agli orari, per poi pagarne le conseguenze il mattino dopo). Questo modo di

ragionare, tuttavia, è totalmente errato: le ore di sonno perdute vanno automaticamente recuperate

dall'organismo durante il corso della giornata, e dormire per diverse ore durante quest'ultima porta il

più delle volte a una maggiore stanchezza mentale, al risveglio. Ciò avviene perchè , dopo circa

mezz'ora di riposo, si passa inevitabilmente al sonno profondo, dal quale è più difficile passare allo

stato di veglia. C'è però anche da dire come spesso i giovani siano sicuramente soggetti ad un maggiore dispendio di energie rispetto agli adulti. La frenetica vita di un adolescente è caratterizzata da

sport, uscite con gli amici e, si spera, anche studio. Perciò se abbiamo sonno, lasciateci dormire...

: Gli ormoni del sonno:

GH (o somatotropina): Dall'inglese Growth Hormone è il cosidetto ormone della crescita.

Secreto dell'ipofisi, ha una maggiore produzione durante le prime due ore di sonno, indipendentemente dall'età . Col passare degli anni tuttavia, il livello di GH diminuisce, in corrispondenza ad una riduzione della massa muscolare e della forza e ad un aumento della massa

grassa. La sua carenza durante la vecchiaia è uno dei fattori riconducibili ad una minore resistenza a infezioni e malesseri. Contrapposta alla sua secrezione vi è quella del cortisolo.

CORTISOLO: prodotto dalle ghiandole surrenali, oltre alla nota funzione anti-infiammatoria,

ha anche il compito di inibire la secrezione di molti altri ormoni, tra cui la sopracitata somatotropina. Gestore del metabolismo, è inoltre controllato dall'ormone DHEA, anch'esso prodotto dalle medesime ghiandole. Col passare degli anni tale controllo risulta sempre meno

marcato e diventa causa di stress.

MELATONINA: comune a quasi tutti gli esseri viventi, è un ormone prodotto dalla epifisi o

ghiandola pineale. Il suo compito principale è quello di fungere da regolatore biologico. Il

suo funzionamento segue il ciclo circadiano: presenta il proprio culmine nelle ore notturne e

va via via decrescendo durante quelle diurne. La sua produzione inoltre è massima nei primi

anni di vita e diminuisce col passare degli anni, per poi cessare del tutto. Si attiva quindi con

la presenza o assenza di luce e ha di conseguenza il dovere di preparare l'organismo al riposo.

È per tale motivo che è più difficile prendere sonno di giorno che di notte e che durante

giornate nuvolose e poco assolate si tende maggiormente a riposarsi.

Feynman 5-10 17- Fisiologia

REM (Fase): definito anche sonno

paradosso in quanto durante tale fase

il corpo sembrerebbe tutt'altro che

dormiente: questa fase di fatto è

caratterizzata da un'elevata attività

cerebrale e rapidi movimenti oculari

(Rapid Eye Movement), definiti

nistagmi. L'organismo la attraversa 4

o 5 volte a notte, e durante il sonno

REM si manifestano i sogni più

intensi.

Perchè Feynman

Grande comunicatore, anticonformista, Feynman è stato uno scienziato

che ha saputo rivolgersi ad ogni tipo di pubblico con memorabili lezioni universitarie e conferenze aperte a tutti. Pur operando nei ambiti più astratti della fisica teorica, ha agito fino all'ultimo guidato dal pragmatismo. Originalità, genialità, profondità di comprensione, strabilianti abilità matematiche si univano a una sorta di stupore da eterno bambino nel capire un fenomeno o nello scoprire l'assurdità del

mondo quantistico o magari l'assurdità del mondo reale rispetto al più "elementare"

mondo dei quanti.

Nato l' 11 Maggio 1918 a Far Rockaway, Queens, New York, fu un uomo

dalla personalità e genialità straordinaria. E' stato definito uno dei più grandi fisici

teorici del XX Secolo. Un insegnante dalle grandi qualità. Quello che ci sorprende

di Feynman è il suo approccio anticonformista alla vita e al suo lavoro.La sua più

grande scoperta è stata un nuovo modo per formulare la Meccanica Quantistica e

l'Elettrodinamica Quantistica attraverso i cosiddetti Integrali di Feynman (Path

Integrals). L'idea di fondo di Feynamn è stata di tradurre una interazione in un semplice schema, per permettere una facile comprensione del fenomeno descritto. I

suoi diagrammi sono composti da segni convenzionali, quali ad esempio linee rette

e ondulate, disposte secondo uno schema preciso e con un preciso significato (vedi

la nostra grafica).

Nel 1965 ottiene il premio Nobel per la Fisica, proprio per il lavoro svolto nell'ambito dell'Elettrodinamica Quantistica. Muore il 15 febbraio 1988 a Los Angeles,

California.

Sembra che l'educazione ricevuta dal padre commerciante, che non aveva compiuto per motivi economici gli studi universitari, sia stata decisiva per generare in lui

l'amore per la scienza e la considerazione particolare per l'insegnamento. Feynman

impara dal padre ad amare la scienza perché impara da lui un atteggiamento scientifico: nessun dogmatismo nei confronti dei fenomeni nella vita di tutti i giorni, cercare la spiegazione dei fatti senza accontentarsi delle parole che girano intorno a

concetti inesistenti.

Quando abbiamo posto le basi, le motivazioni profonde della nostra rivista, ecco, abbiamo pensato a tutto questo. Abbiamo pensato ad un luogo dove si

costruiscono i concetti e non solo dove si mettono insieme parole, un posto dove

far conoscere i fenomeni di cui si parla e sostituire le definizioni libresche con le

applicazioni. Ecco perché Feynman.

ANNO V n°5 Aprile 2010

Sede

Liceo Scientifico “Galileo Galilei”

Via Vescovo Maurizio - Catania

Dirigente Scolastico: Prof.ssa G. Chisari

Il comitato di redazione

Responsabile del progetto: Prof. A.Guarrera

Redattori: Valerio Mascolino, Rita Laureanti

Progetto Grafico: Gianluca Monaco

Hanno collaborato:

Stefano Orlando

Mario Litrico

Gabriele Costanzo

Carla Marino

Guglielmo Bonarrigo

Emilia Marra

Fabio Battaglia

Piattaforma e-learning usata: BSCW

Stampa: Litografia LFD - Catania

Via Canfora, 2/b - Tel. 095.444325

Il comitato di redazione. Monaco-Aprile 2010

Questo giornale di scienza non è pubblicato con periodicità regolare

Feynman 5-10 18

Anno 5 numero 5/Aprile 2010