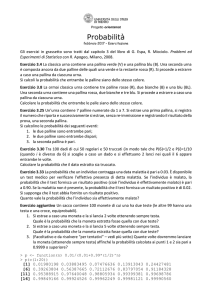

La probabilità

Calcolo combinatorio ed elementi di

probabilità

Origini e definizioni

Il calcolo delle probabilità è nato intorno ai giochi di azzardo. Oggi è una disciplina a sé

stante che può essere di ausilio per molte altre discipline e studi, come ad esempio, la

biologia, la fisica, l'economia, la tecnologia e, ovviamente, le scienze statistiche e

sociali.

Tutto deriva dal concetto di CASO: alcuni lo definiscono come il risultato dell'azione di

molte concause indipendenti tra loro e non note. In filosofia il caso è qualcosa che si

verifica senza che se ne possa identificare la causa. Un evento che si manifesta 'a caso'

è un evento accidentale, imprevedibile, all'opposto di evento certo, prevedibile, che

non accade 'a caso'. Sembra una contraddizione in termini, ma non si può parlare di

probabilità associata ad un evento, se questo evento non è imprevedibile.

Origini e definizioni

Nel gioco d'azzardo, dadi, roulette, lotto, si può parlare di probabilità che si verifichi un

certo risultato (un evento, appunto) se tutti gli eventi non sono condizionati nel loro

manifestarsi, da elementi prevedibili. La faccia di un dato dalla forma perfetta, lanciato

su una superficie senza alcuna perturbazione, si presenta una volta su 6, tante quante

sono le facce, perché ciascuna ha la stessa probabilità di presentarsi, non avendo

elementi per stabilire che una faccia abbia una probabilità maggiore delle altre di

presentarsi. Nella roulette o nel lotto, ogni numero ha la stessa probabilità degli altri di

presentarsi se non ci sono 'trucchi' che condizionano il risultato dell'estrazione.

Una persona colpita perché che si trova sulla traiettoria di una palla da golf si può dire molto sfortunata, perché

quell'evento è imprevedibile e, di certo, quella persona non lo aveva previsto. Questo esempio può considerarsi

come la somma di eventi indipendenti tra loro (il tiro della pallina non a scopo offensivo e la presenza di un

individuo sulla sua traiettoria), ma può anche vedersi come una concomitanza di cause che forse potrebbero

non essere del tutto ignote.

Origini e definizioni

Insomma, cosa sia esattamente l'incertezza è ancora ragione di molte discussioni e se

ne parla fin dal 500 a.C. Einstein in persona diceva di non poter ammettere che Dio

giochi a dadi, intendendo che quello che ci sembra casuale è solo frutto di

informazioni mancanti, che, se fossero note, permetterebbero di determinare ogni

evento.

Supponiamo di lanciare una moneta: possono verificarsi due eventi, testa o croce, che

indichiamo con T e C

Se invece la lanciamo due volte abbiamo le seguenti possibilità:

(T;T); (T;C); (C;T); (C;C);

L’insieme di tutti i lanci possibili definisce lo spazio di probabilità dell’evento lancio

della moneta, anche detto spazio campionario.

Origini e definizioni

Un evento casuale viene detto aleatorio

● Un evento aleatorio è possibile, se può verificarsi (l’estrazione di una pallina

bianca da un’urna di palline bianche e nere è possibile)

● Un evento aleatorio è impossibile se non può può verificarsi (l’estrazione di una

pallina bianca da un’urna di palline nere è impossibile)

● Un evento aleatorio certo se si verifica sicuramente ((l’estrazione di una pallina

bianca da un’urna di palline bianche certo)

Due eventi si dicono incompatibili se il verificarsi di uno esclude il verificarsi dell’altro

(l’uscita T nel lancio di una moneta è incompatibile con l’uscita C)

Due eventi sono necessari se uno dei due deve necessariamente verificarsi (nel lancio

di una moneta deve verifiarsi o T o C)

Due eventi sono complementari se uno si verifica quando non si verifica l’altro.

Origini e definizioni

Nel calcolo delle probabilità è molto importante il concetto di evento e di prova. Nel

lancio di una moneta la prova è il lancio vero e proprio; gli eventi possibili sono

due, l’uscita di T o l’uscita di C.

Nel lancio del dado la prova è ancora il lancio vero e proprio; gli eventi possibili sono 6,

i sei risultati possibili, 1, 2, 3, 4, 5 e 6.

Tutti i dati a cui si può associare una probabilità sono detti aleatori. I numeri aleatori o

le variabili aleatorie, sono dette anche variabili casuali o stocastiche.

Se ad una distribuzione di risultati si associano le probabilità si ottiene una

distribuzione di probabilità

Origini e definizioni

Definizione soggettivista di probabilità

La probabilità è il grado di aspettativa sul verificarsi di un evento ed è espressa con un

numero reale p compreso tra 0 e 1: 0 ≤ p ≤ 1

Esempio: Nel lancio di una moneta si dice che T ha probabilità del 50% di verificarsi, cioè è 0,5 e questa è la

nostra fiducia nell’evento T.

Definizione classica di probabilità

La probabilità di un evento è il rapporto tra il numero di casi favorevoli e il numero di

quelli possibili (se non si può escludere che tutti i casi siano ugualmente possibili)

Esempio: Nel lancio del dado la probabilità che esca il numero 2 è ⅙=0.17 perché in tutto ci sono 6 facce (casi

possibili) e quella che attendo che esca è una sola (casi favorevoli)

Nel lancio di una moneta la probabilità che esca T è ½=0.5, perché il numero di casi possibili è 2 mentre quello

dei casi favorevoli è 1

Origini e definizioni

Esempio: Ancora nel casi del lancio di una moneta la probabilità che esca o T o C è 1 perché il numero di casi

favorevoli (2) e quello dei casi possibili (2) coincide.

Esempio: Da un’urna contenente 7 palline di cui 2 bianche, tre rosse e due nere, si estrae una pallina. Qual’è la

probabilità che la pallina estratta sia rossa? p=3/7 perché ho 3 casi favorevoli e 7 possibili.

Esempio: Lanciando due volte una moneta, qual’è la probabilità che esca TT, cioè T al primo lancio e T al

secondo lancio? Contiamo i casi possibili e i casi favorevoli: il caso favorevole è uno solo; i casi possibili sono:

TT, TC, CT, CC, cioè 4. La probabilità che esca TT è allora ¼ =0.25.

Se la lanciamo 3 volte, qual’è la probabilità che esca TCC? Ancora una volta il caso favorevole è uno solo,

mentre i casi possibili sono 8: TTT, TTC, TCT, TCC, CTT, CTC, CCT, CCC.

Se invece voglio la probabilità che si abbiano due teste e una croce, indipendentemente dall’ordine con cui si

presentano, i casi favorevoli salgono a 2, mentre i casi possibili sono sempre 8: p=2/8=¼=0.25

Infine, se voglio calcolare la probabilità di avere almeno due teste, indipendentemente dal terzo risultato,

p=3/8

Origini e definizioni

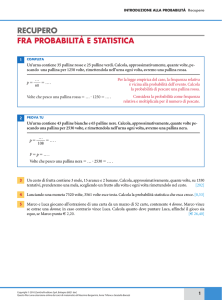

Definizione frequentista di probabilità -LEGGE EMPIRICA DEL CASO

La probabilità è il limite a cui tende la frequenza relativa dell’evento al tendere

all’infinito del numero di prove effettuate nelle stesse condizioni.

Questa definizione è impostata in modo più teorico delle due precedenti in quanto

nella pratica non è possibile ripetere all’infinito il numero di prove per determinare

esattamente la su probabilità. Essa però, operativamente, è utilizzata quando si ha a

disposizione una serie di prove di un evento e allora si stima come probabilità la

frequenza relativa con cui si presenta quell’evento. Tanto più numerose sono le prove,

quanto più accurata è la stima della probabilità ad esso associata è affidabile. Se si

considera come prove ripetute una serie temporale, può accadere che nelle varie

prove cambino le condizioni e la probabilità non sia effettivamente calcolabile.

Origini e definizioni

Vale a dire che se si ripete un esperimento (ad esempio lancio di dadi, lancio di

moneta, estrazione di palline da un urna) nelle stesse condizioni, a lungo andare la

frequenza relativa con cui un certo evento si manifesta tende a coincidere con la sua

probabilità.

Tale legge è anche detta ‘legge dei grandi numeri’ ed è quella a cui si appellano i

giocatori del lotto quando puntano sull’uscita dei numeri ritardatari. In realtà ad ogni

nuova estrazione le condizioni sono identiche alle precedenti estrazioni per cui ogni

numero ha la stessa probabilità di uscire e non probabilità maggiore perché non è

uscito da un certo numero di estrazioni.

Origini e definizioni

Esempio: Se voglio determinare la probabilità di rialzo di un titolo in borsa, la serie dei rialzi nel tempo può

essere indicativa, ma ad ogni rilevazione del valore del titolo sono cambiate le condizioni generali del mercato

quindi non è detto che la probabilità rilevata sia attendibile.

Se invece voglio determinare se lanciando una moneta la probabilità che esca C è 0,5, posso fare 1000 lanci

della moneta. Può capitare che si ottenga una probabilità di 0,6. In tal caso posso concludere che la moneta

non fosse perfettamente bilanciata e che quindi la probabilità delle due facce non fosse identica; oppure posso

pensare che 1000 lanci non fossero sufficienti perché troppo lontani dall’infinito della definizione di

probabilità; infine posso pensare che il lanci non fossero fatti tutti nelle stesse condizioni perché ad un certo

punto il lanciatore si è stancato ed è stato sostituito da un altro lanciatore.

Origini e definizioni

Definizione assiomatica di probabilità

La probabilità di un evento E è un numero p tale che 0 ≤ p(E) ≤ 1, se E è certo p(E) =1,

se E è impossibile p(E) =0, se E1 ed E2 sono incompatibili

p(E1 o E2)=p(E1) + p(E2)

Se due eventi sono indipendenti, p(E1 e E2)=p(E1)p(E2)

Se due eventi non sono indipendenti p(E1 e E2)=p(E1)p(E2|E1): la probabilità che si

verifichi sia E1 che E2 è pari alla probabilità di E1 moltiplicata per la probabilità di E2

condizionata al verificarsi di E1 (teorema delle probabilità composte)

Se due eventi non sono incompatibili (potrebbero verificarsi entrambi)

p(E1 o E2)=p(E1)+p(E1)+p(E1 e E2): la probabilità che si verifichi E1 o E2 è pari alla

somma delle probabilità di E1, E2 ed entrambi.

Calcolo combinatorio

E’ una branca della matematica che aiuta a contare i modi con cui si presentano gli

eventi ed è pertanto fondamentale nel calcolo delle probabilità. Richiamiamo allora

alcuni concetti utili.

Le permutazioni di N oggetti, rappresentano i modi in cui possiamo ordinare questi N

oggetti. Il primo oggetto può essere scelto tra N, il secondo tra N-1, ecc. Si può

dimostrare che PN=N(N-1)(N-2) … 3⋅2⋅1=N!

Inoltre 0!=1

Esempio: Le permutazioni di a, b, c, d sono 4!=4⋅3⋅2⋅1=24

abcd

bacd

cabd

dabc

abdc

acbd

bcda

cbad

dbac

acdb

adbc

bdac

cdab

dcab

adcb

badc

bcad

bdca

cadb

cbda

cdba

dacb

dbca

dcba

Calcolo combinatorio

Le disposizioni di N elementi presi k a k (anche detti di classe k), DN,k, rappresentano il

numero di gruppi di k elementi che si possono estrarre da N, dove elementi posti in

ordine diverso individuano gruppi diversi

DN,k=N(N-1)(N-2) … (N-k+1)

Esempio: Le disposizioni di 4 elementi a, b, c, d di classe 2 sono: D4,2=4⋅3=12 e precisamente:

ab

ba

ca

da

ac

bc

cb

db

ad

bd

cd

dc

Le disposizioni con ripetizione di N elementi di classe k, a differenza delle disposizioni

già viste, conteggiano anche gruppi in cui un elemento compare più di una volta. In

questo caso *DN,k=Nk in quanto ciascun elemento può essere scelto tra tutti gli N

elementi.

Esempio: Nell’esempio precedente le disposizioni con ripetizione di 4 elementi a, b, c, d di classe 2 sono:

D4,2=42=16 perché ai precedenti dobbiamo aggiungere i gruppi: aa bb cc dd

Calcolo combinatorio

Le combinazioni di N elementi di classe k, CN,k, rappresentano il numero di gruppi di k

elementi che si possono estrarre da N, indipendentemente dall’ordine degli elementi

nei gruppi

Esempio: Le combinazioni di 4 elementi a, b, c, d di classe 2 sono:

e precisamente ab bc cd ac bd ad

Le combinazioni con ripetizione di N elementi di classe k, conteggiano tutti i gruppi di

k elementi in cui ciascun elemento può comparire più di una volta.

Esempio: Le combinazioni con ripetizione di 4 elementi a, b, c, d di classe 2 sono: *C4,2=(5⋅4)/(2⋅1)=10 e basta

aggiungere a quelli visti prima i gruppi aa bb cc dd

Calcolo combinatorio

Esempi: calcoliamo la probabilità che lanciando due dadi contemporaneamente la somma dei punti che appare

sulla fascia superiore sia 2

Innanzi tutto dobbiamo contare i casi possibili e i casi favorevoli. I casi possibili sono tutte le coppie di numeri

con ripetizione presi tra 6 numeri. Quindi sono le disposizioni con ripetizione di 6 numeri di classe 2

*DN,k=Nk=62=36

I casi favorevoli sono solo 1 in quanto solo il caso in cui entrambi i dadi diano valore 1 può dare origine ad una

somma 2. Quindi la probabilità cercata è p(2)=1/36

Calcoliamo ora la probabilità che la somma delle facce superiori sia 3. Anche in questo caso i casi possibili sono

36, ma i casi favorevoli ora sono 2 perché la somma 3 si può ottenere con due possibili combinazioni: il primo

dado 1 e il secondo 2 o, viceversa, il primo 2 e il secondo 1. Quindi la probabilità cercata è p(3)=2/36

Analogamente p(4)=3/36; p(5)=4/36; p(6)=5/36; p(7)=6/36; p(8)=5/36; p(9)=4/36; p(10)=3/36; p(11)=2/36;

p(12)=1/36

La somma di queste probabilità è, ovviamente, 1 in quanto (1+2+3+4+5+6+5+4+3+2+1)/36=1

Teorema di Bayes

Nel calcolo di una probabilità, possiamo anche tenere conto degli eventi che possono

modificare la valutazione di un certo evento E. Per fare ciò ricordiamo che il teorema

delle probabilità composte, visto prima, diceva che

p(E e H)=p(E)p(H|E) ma è anche vero che p(H e E)=p(H)p(E|H)

Ma allora, dal momento che p(E e H)=p(H e E) anche p(E)p(H|E)=p(H)p(E|H)

da qui

cioè la probabilità di un evento E subordinatamente ad H è uguale alla probabilità di E

per la probabilità di H dato E diviso per la probabilità di H

p(E) è la probabilità a priori; p(E|H) è la probabilità a posteriori; p(H|E) è la

verosimiglianza

Teorema di Bayes

Esempio: Si hanno due urne A e B. L’urna A contiene nove palline bianche e una nera, l’urna B contiene 9

palline nere e una bianca. E’ stata estratta una pallina bianca da una delle due urne. Determiniamo la

probabilità che la pallina sia estratta dall’urna A.

Se non sapessimo che la pallina estratta è bianca, la probabilità sarebbe pari a ½ in quanto non si avrebbero

informazioni per determinare alcuna probabilità quindi daremmo metà probabilità a ciascuna urna. Sapere

però che la pallina estratta è bianca è una informazione importante.

Diciamo che E è l’evento ‘estrazione dall’urna A’, mentre H è l’evento estrazione di una pallina bianca. p(E)=½

(due casi possibili, uno favorevole); p(H)=½ (due casi possibili, uno favorevole)

p(E/H) è la probabilità di estrarre dall’urna A dato che la pallina estratta è bianca (incognita).

p(H/E)=9/10 è la probabilità di estrarre una pallina bianca dato che l’urna è A. Allora per la formula di Bayes:

Teorema di Bayes

Il teorema di Bayes è di tale importanza che, come conseguenza della sua assunzione,

è nata una vera e propria branca della statistica, denominata appunto statistica

bayesiana. Essa cerca di sfruttare un insieme di conoscenze che portano alla

formazione di convizioni non immediate e, talvolta, differenti da quelle a cui si arriva

con la statistica classica.

Secondo gli statistici bayesiani ogni fenomeno ha alla sua base una certa distribuzione

a priori di probabilità e la decisione che si prende rispetto a quel fenomeno è

condizionata da essa. Spesso tale probabilità è di tipo soggettivo e si fa molto uso di

informazioni rilevate in altre occasioni simili a quella in oggetto ma accadute in

passato o in altri contesti.

Teorema di Bayes

Esempio: Una compagnia di assicurazioni ritiene che gli assicurati possano essere suddivisi in due classi: a

rischio di incidente e non a rischio di incidente. Le loro statistiche mostrano che una persona a rischio avrà un

incidente di qualche tipo all'interno di un periodo fissato di un anno con probabilità 0,4, mentre tale probabilità

è pari a 0,2 per le persone non a rischio. Supponiamo che il 30% delle persone sia a rischio, qual è la probabilità

che un nuovo assicurato abbia un incidente nel primo anno di polizza? Supponiamo poi che un nuovo

assicurato abbia un incidente entro un anno dalla prima stipulazione della polizza. Qual è la probabilità che sia

a rischio?

Si considerino i seguenti eventi:

●

I = il nuovo assicurato ha un incidente entro il primo anno dalla stipulazione della polizza

●

R = la persona è a rischio

p(I)=0,30 * 0,40 + 0,70 * 0,20 = 0,26 (prob. di incidente nel primo anno di polizza)

Per il teorema di Bayes, la probabilità che l’automobilista sia a rischio dato che ha avuto un incidente nel primo

anno di polizza è:

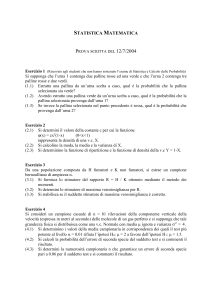

Distribuzioni di probabilità

Esistono diverse distribuzioni teoriche di probabilità (vedere slide 5 parte 1)

La più famosa e la più usata in statistica è la normale che ha le seguenti proprietà:

● è asintotica all’asse x nei valori

estremi del suo campo di definizione,

● è simmetrica rispetto al valore centrale

● cresce fino al valore centrale e poi

decresce fino allo zero

● moda, mediana e media aritmetica

coincidono

● ha due flessi, uno ascendente e uno

discendente, in corrispondenza di due valori che dipendono dalla media e dallo

scostamento quadratico medio.

Distribuzioni di probabilità

Un ruolo molto importante fra le infinite distribuzioni normali è svolto dalla

distribuzione normale standardizzata che ha media aritmetica uguale a 0 e

scostamento quadratico medio uguale a 1, ossia dalla distribuzione N(0;1)

Essa rappresenta la probabilità di un evento rilevato con una variabile standardizza.

L’area sotto la curva normale standardizzata fino ad un certo valore z è la frequenza

relativa delle unità che presentano valore del carattere fino al valore z. L’area tra due

valori, z’ e z’’, rappresenta la frequenza relativa, e quindi la probabilità, che si verifichi

un valore compreso tra z’ e z’’. L’altezza della curva in corrispondenza di un valore z è la

densità, ovvero la probabilità che si verifichi esattamente z.

Distribuzioni di probabilità

Il valore della funzione di ripartizione (area sotto la curva) e della densità (ordinata in

corrispondenza di z) si possono trovare con l’uso di tavole (vedi slide 5 parte 1)

Qualsiasi siano i parametri μ (media) e

σ (scarto quadratico medio), l’area della

porzione di curva delimitata dalla media

e un’ordinata espressa in termini di

deviazioni standard è costante

μ+σ= 34.13% della distribuzione

μ+2σ= 47.73% della distribuzione

μ+3σ= 49.86% della distribuzione