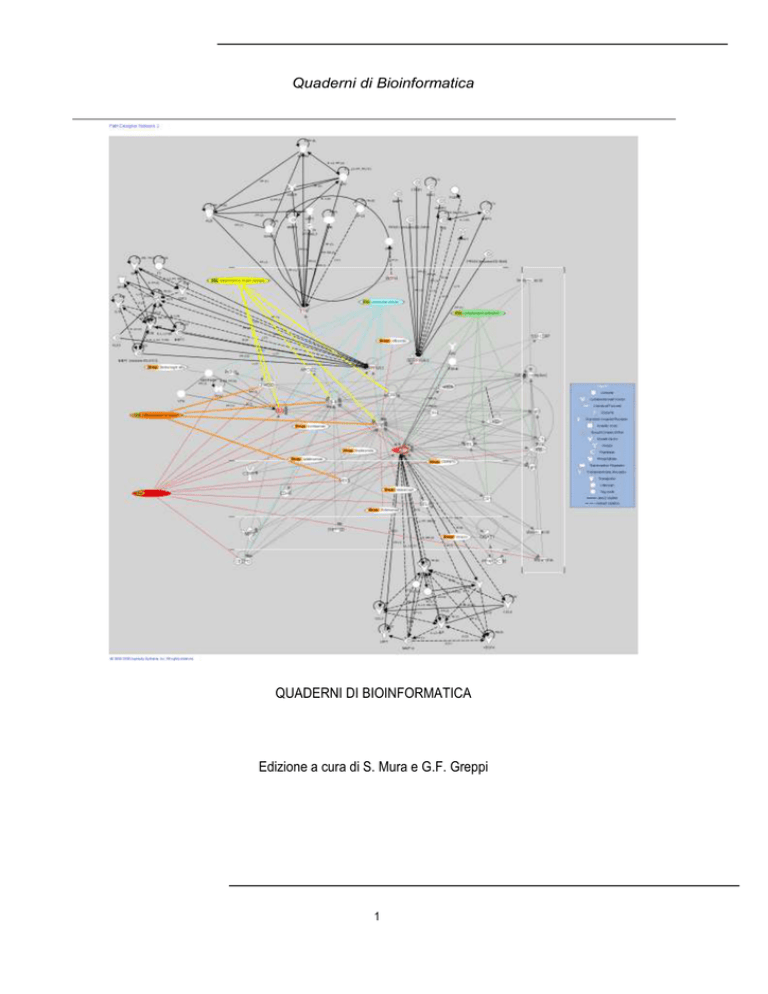

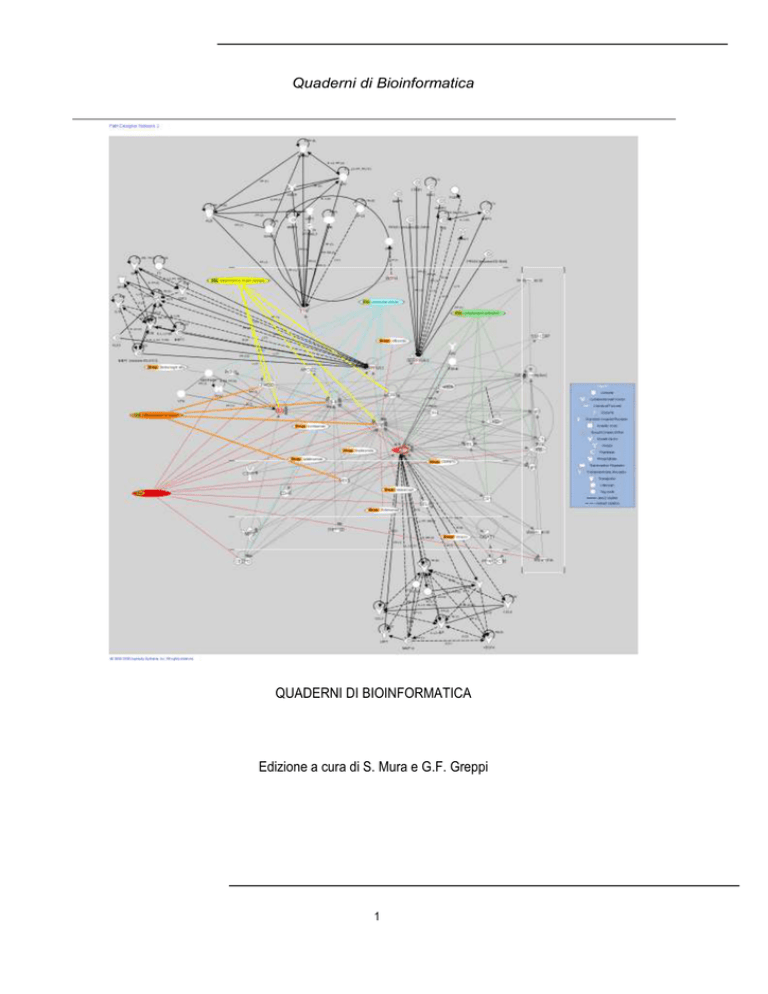

Quaderni di Bioinformatica

QUADERNI DI BIOINFORMATICA

Edizione a cura di S. Mura e G.F. Greppi

1

Quaderni di Bioinformatica

SCUOLA ESTIVA DI BIOINFORMATICA

II EDIZIONE (25 maggio -29 maggio 2009)

Biotecnologie agrarie e ambientali

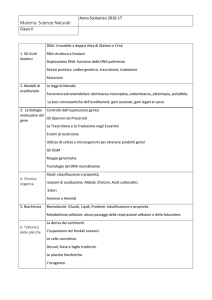

Il corso si propone di fornire le conoscenze e gli strumenti statistici fondamentali per l’analisi dei dati ottenuti da esperimenti

condotti con microarray. La piattaforma microarray di riferimento sarà quella dei cDNA microarray, ma tutte le analisi svolte

saranno comunque estendibili anche alle altre piattaforme. Il software statistico di riferimento sarà il principalmente il SAS in

quanto consente, a differenza dei software dedicati, di sviluppare l’analisi dei dati scrivendo ogni singola procedura

parallelamente ai concetti teorici necessari all’interpretazione dei dati. Il corso si svilupperà in tre fasi. La prima riguarderà la

progettazione di un esperimento con i microarray e i meccanismi di genetica molecolare di base su cui si fonda la tecnologia

microarray. Il corso è orientato alle piattaforme Affymetrix ed Illumina. La seconda, detta fase di training, riguarderà l’analisi di

dati provenienti da un esperimento simulato. Sarà ipotizzato un disegno sperimentale semplice e i geni differentemente espressi

saranno conosciuti a priori. Questo consentirà di motivare le scelte fatte tra le numerose tecniche di analisi statistica riscontrabili

in letteratura oltre che da un punto di vista sia teorico che strettamente biologico, anche in termini di efficienza nella

individuazione di geni differentemente espressi. La terza fase, individuata come fase applicativa, riguarderà l’analisi di dati reali

ricavati da un esperimento complesso con i microarray.

Docenti: Prof. Adriano Aguzzi, Prof Luigi Bonizzi, Prof. Corrado Dimauro, Dott. Andrea Galli, Prof. Gian Franco Greppi, Prof.

Nicolò Maciotta, Dott. Paolo Menesatti, Prof. Alessio Valentini,

La macro aree trattate:

-Basi molecolari della tecnologia microarray

-Generazione di microarray da banche dati di sequenze con annotazione automatica

-Disegno sperimentale con microarray

-Controllo di qualità degli spot

-Normalizzazione dei dati

-Statistica di base per l'analisi dei microarray

-Analisi delle fonti di variabilità dei dati preprocessing (normalizzazione dei dati ed approntamento del data-set finale).

- Image analysis in combinazione con la modellistica multivariata

-Dai dati prodotti dal software di analisi delle immagini, all’espressione differenziale dei geni e al data-summary.

-Introduzione all'uso dei linguaggi

-L’analisi statistica della espressione dei geni

-Modelli statistici per l’individuazione dei geni diversamente espressi

-Pattern e clusters di geni

-Esercitazioni con dati simulati

Le esercitazioni avverranno utilizzando i Prodotti Software di SAS Institute e manuali messi

gentilmente a disposizione.

Questa dispensa contiene alcuni testi di supporto didattico alle lezioni del corso, la stampa ed il materiale fornito nel CD è stato

realizzato grazie al contributo della Fondazione Iniziative Zooprofilattiche di Brescia.

2

Quaderni di Bioinformatica

ARRAY E MICROARRAY

QUALUNQUE TECNOLOGIA

SUFFICIENTEMENTE AVANZATA E'

INDISTINGUIBILE DALLA MAGIA

Gian Franco Greppi

Stefania Mura

CNBS (Centro NanoBiotecnologie Sardegna)

Dipartimento di Scienze Zootecniche,

Università di Sassari

Via De Nicola 9, 07100 Sassari

INTRODUZIONE

Storicamente le ricerche in genetica sono state focalizzate sullo studio di uno o pochi geni alla volta. Negli ultimi anni l'identificazione

di un enorme numero di geni ha portato alla necessità di sviluppare nuove tecniche più adeguate ad un'analisi su larga scala. Due

sono state le innovazioni sperimentali che hanno permesso l'analisi simultanea di decine di migliaia di geni. Una è l'utilizzo di supporti

rigidi non porosi come il vetro, molto più adatti alla miniaturizzazione ed all'utilizzo di marcatori fluorescenti. L'altra è la sintesi ad alta

densità spaziale di oligonucleotidi su vetrini sottilissimi con tecniche fotolitografiche. Si è giunti alla nascita di una nuova tecnologia di

analisi comunemente chiamata microarray o DNA chip dopo un percorso che è partito negli anni ’90 e di seguito brevemente

richiamato. La conoscenza di varianti genetiche è da tempo un elemento nella diagnostica e nella la cura di pazienti in biomedicina.

Per esempio, varianti genetiche portano ad incompatibilità tra tessuti ed organi inficiando il successo di un trapianto. Ma variazioni

nella sequenza genomica portano anche ad una diversa suscettibilità verso tutti i tipi di patologie, ad una differente età nella

insorgenza e di gravità di molte malattie genetiche, e causano anche una diversa efficacia nella cura. Gli studi di associazione non

coinvolgono l'analisi di genealogie di grandi famiglie ma confrontano la prevalenza di un particolare marcatore genetico, o di un

gruppo di marcatori, in soggetti affetti e non affetti dalla patologia. Una prevalenza di un marcatore nel gruppo di pazienti affetti viene

considerata evidenza di una associazione tra la malattia ed il marcatore. L'associazione non è un fenomeno specificatamente

genetico; è una deduzione statistica di coesistenza di alleli e/o fenotipi. L'allele A è associato con la patologia P se i soggetti che

presentano P hanno anche una frequenza dell'allele A significativamente maggiore di quella prevista dalle frequenze individuali di A e

P nella popolazione.

Marcatori molecolari

Con il termine di marcatore molecolare si intende un qualsiasi carattere polimorfico mendeliano che può essere impiegato per seguire

l'ereditarietà di un segmento cromosomico attraverso un albero genealogico.

Per le analisi di associazione è necessaria la presenza di meiosi informative, ovvero casi in cui è definibile quando un gamete è o

meno ricombinante. Per la maggior parte degli scopi l'eterozigosità media di un marcatore (la probabilità di un soggetto scelto a caso

di essere eterozigote) è utilizzata come misura di informatività del marcatore stesso.

I polimorfismi genetici sono variazioni nelle sequenze di DNA presenti in una popolazione con una frequenza maggiore dell'1% e

costituiscono strumenti fondamentali per gli studi di genetica.

Nei primi anni ottanta i polimorfismi genetici hanno formato, per la prima volta, un gruppo di marcatori sufficientemente numeroso ed

adeguatamente distribuito lungo tutto il genoma da permettere ricerche di associazione in tutto il DNA genomico.

I primi marcatori molecolari ad essere studiati furono gli RFLP, Restriction Fragment Length Polymorphisms (polimorfismi della

lunghezza dei frammenti di restrizione). Si tratta di una metodica complessa che può avere come scopo la formulazione di un

consiglio genetico. Permette di studiare la trasmissione di un gene in seno a una famiglia quando non è nota la sua sequenza ma

solo la sua localizzazione su di un cromosoma. La metodica si serve dell’analisi delle sequenze non codificanti di DNA contigue

al gene in esame e le utilizza come suoi markers indiretti. Prevede numerosi passaggi tra cui la digestione dell’acido nucleico da

parte di enzimi di restrizione, dell’elettroforesi per la separazione dei frammenti così ottenuti e del southern blotting per il loro

trasferimento su di un filtro di nitrocellulosa. Per potere individuare i siti di restrizione, la regione del genoma di interesse viene

amplificata tramite PCR ed i prodotti vengono incubati con l'enzima. Eseguendo quindi un'elettroforesi su gel di agarosio si è in

grado di determinare se il frammento amplificato è stato tagliato o meno, ovvero se la sequenza specifica riconosciuta dall'enzima è

presente inalterata oppure no. Uno svantaggio di questo tipo di marcatori è dato dalla loro bassa informatività. Infatti gli RFLP

presentano solo due alleli possibili: il sito di restrizione può essere intatto oppure no. L'impiego di questi marcatori per eseguire la

mappa genetica di patologie è però poco attuabile in quanto troppo spesso delle meiosi chiave in una famiglia risultano non

informative.

3

Quaderni di Bioinformatica

Un'altra categoria di marcatori comprende i minisatelliti VNTR (Variable Number of Tandem Repeat), detti anche ripetizioni a tandem

a numero variabile. Hanno sequenze ripetute lunghe una decina di nucleotidi. Tali marcatori sono multiallelici e presentano un alto

grado di eterozigosità. La maggior parte delle meiosi risulta informativa ma i VNTR presentano delle difficoltà relative alla

genotipizzazione in quanto vista la loro lunghezza tali marcatori vengono amplificati con difficoltà in una reazione di PCR. Inoltre non

sono uniformemente distribuiti lungo tutto il genoma. Un ulteriore tipo di marcatori sono i microsatelliti, detti anche ripetizioni a tandem

semplici. Sono ripetizioni lunghe da due a quattro nucleotidi. L'impiego di sequenze tri- o tetranucleotidiche sta gradualmente

soppiantando l'utilizzo di quelle dinucleotidiche, troppo soggette ad uno slittamento della lettura dell'enzima durante la PCR. Come i

precedenti, anche questi marcatori sono multiallelici dal momento che il numero di ripetizioni per ogni allele può variare. Tra i

marcatori molecolari più utilizzati vi sono gli SNP. Come suggerisce il nome, i Single Nucleotide Polymorphisms (polimorfismi a

singolo nucleotide) sono singole variazioni puntiformi del genoma. Tali polimorfismi includono i classici RFLP, ma anche altre

variazioni di sequenza che non creano o sopprimono siti di restrizione. Può sembrare paradossale tornare all'impiego di polimorfismi

biallelici dopo avere individuato dei marcatori pluriallelici, ma il grande vantaggio nell'utilizzare degli SNP è dato dall'elevato numero di

polimorfismi che possono essere genotipizzati e dalla loro elevata densità lungo tutto il genoma. A giugno del 2004 nell'uomo è stata

stimata una frequenza per gli SNP pari ad uno ogni 700pb. Un’elevata densità rende possibile individuare uno o più marcatori in ogni

gene e nelle sue immediate vicinanze. Per quanto concerne i cambi di base relativi agli SNP, si è osservato che le transizioni, ovvero

cambi purina-purina (A vs G) o pirimidina-pirimidina (C vs T), si ritrovano con frequenza maggiore delle trasversioni, ovvero cambi

purina-pirimidina e pirimidina-purina.

Oltre all'elevato numero di SNP conosciuti, il fatto più importante è che oggi si ha una conoscenza precisa di dove sono situati

all'interno del genoma. Il principale impiego di una mappa di SNP umana è dato dalla possibilità di discernere i contributi di diversi

geni in patologie multigeniche complesse.

Dato che siti di SNP sono presenti in tutto il genoma, confrontando lo schema e le frequenze di tali polimorfismi presenti in pazienti

affetti con quelli di soggetti sani di controllo, è possibile identificare quali SNP sono associati a quali malattie. Gli studi relativi

all'associazione tra SNP e malattie saranno più fruttuosi quando verranno risolti alcuni problemi ancora esistenti. Primo, sono poco

conosciute le distribuzioni degli SNP all'interno di diverse popolazioni. Altro fattore importante è che non tutti gli SNP sono eguali, e

sarà essenziale scoprire il più possibile riguardo al loro effetto da analisi computazionali prima di eseguire uno studio relativo al loro

coinvolgimento eventuale in una patologia. Per esempio, ogni SNP può essere classificato in base alla sua presenza in una zona

codificante o non. A loro volta quelli siti in zone codificanti possono essere divisi in base alla loro capacità di alterare o meno la

proteina prodotta dal gene alterato. Alterazioni alla proteina poi possono essere suddivise in base alla loro capacità di modificare la

struttura secondaria e terziara della proteina stessa. Gli SNP situati in zone non codificanti possono poi trovarsi in zone regolatrici.

Molte patologie complesse possono essere causate da variazioni nella quantità, più che nella qualità del prodotto genico coinvolto.

Vi sono numerosi approcci per l'identificazione di SNP, tra questi alcuni vengono anche impiegati per la genotipizzazione. I principali

sono basati sul confronto di sequenze relative ad un determinato locus, provenienti da diversi cromosomi. Tra questi, il più semplice

consiste nell'eseguire il sequenziamento diretto dei prodotti di PCR di regioni genomiche contenenti il gene di interesse in individui

diversi. Su larga scala però tale approccio è molto costoso richiedendo lo studio di primer specifici; inoltre limitato a regioni di cui è

nota la sequenza e, quando si presentano doppi picchi, come atteso negli eterozigoti, non è sempre facile discernere tra artefatti

dovuti al sequenziamento e polimorfismi reali. Diversi approcci basati sul confronto di sequenze ottenute da frammenti clonati

possono essere considerati per ottenere una mappa di SNP in un genoma. In questo caso qualsiasi picco doppio viene considerato

artefatto. Il confronto tra dati di sequenze prodotte in diversi progetti di EST, specialmente se le librerie costruite sono state ottenute

prelevando campioni da diversi individui, possono essere una buona fonte di SNP. Ad ogni modo il numero di SNP individuabili con

questo approccio è limitato dalla pressione selettiva subita dalle sequenze codificanti del genoma. Inoltre, in rari casi, gli SNP

individuati in questo modo potrebbero essere in realtà dovuti a modificazioni post-trascrizionali. Un approccio simile può essere

applicato per i genomi in fase di sequenziamento completo. In questo caso il confronto tra cloni BAC sovrapponibili è una buona fonte

di SNP. Lo svantaggio di tale approccio è dato dal fatto che l'individuazione degli SNP dipende dal numero di cloni BAC

sovrapponibili presenti nella genoteca e provenienti da cromosomi diversi. Recentemente un nuovo approccio chiamato Reduced

Representation Shot-gun (RRS) viene utilizzato per ottenere un elevato numero di SNP nell'uomo. In questo metodo, il DNA

proveniente da diversi individui è mescolato e vengono prodotte delle librerie plasmidiche composte da sottoinsiemi di frammenti di

restrizione purificati tramite elettroforesi su gel.

Viene quindi realizzato un sequenziamento di tipo shotgun su tali librerie e le sequenze che risultano sovrapponibili vengono allineate

andando ad evidenziare i polimorfismi. Quest'ultima fase ha beneficiato grandemente dello sviluppo di programmi come PHRED atti a

stimare la qualità con cui viene definita una base ed altri programmi come POLYPHRED o POLYBAYES che impiegano questo indice

di qualità per il rilevamento di polimorfismi.

Il termine Microarray, definito anche biochips" (comunemente conosciuto come gene chip, DNA chip, o biochip) è un insieme di

piccoli elementi, detti anche spots, sistemati su file orizzontali e colonne verticali; il termine è composto da "micro", che in greco

significa "piccolo" e dal francese "arayer", che significa "sistemare”, ed è sostanzialmente costituito da una collezione di

microscopiche sonde di DNA attaccate ad una superficie solida come vetro, plastica, o chip di silicio formanti quindi un array. Come

definito da Schena ed altri (Scienze 270, 467-470, 1995), un DNA microarray è "un allineamento ordinato degli acidi nucleici, di

4

Quaderni di Bioinformatica

piccole molecole, che permette l'analisi parallela dei campioni biochimici complessi". Con il completamento del progetto genoma

siamo entrati in possesso di un prezioso e ricco dizionario, con molti vocaboli ma pochissime definizioni. L’obiettivo della

postgenomica è stato quello di trovare le definizioni mancanti, utilizzare le informazioni di genomica strutturale per spiegare e

analizzare i processi biologici su scala genomica, e assegnare la corretta funzione ai diversi geni. Gli array vengono utilizzati per

esaminare il profilo d’espressione di un gene o per identificare la presenza di un gene o di una breve sequenza in miscela di migliaia

(spesso anche tutto il patrimonio genetico di un individuo umano o non). Un microarray è rappresentato da elementi microscopici su

una superficie piana su cui è possibile immobilizzare sia acidi nucleici che proteine capaci quindi di riconoscere e legarsi con

molecole complementari. La tecnologia permette di realizzare, pertanto, sia reazioni di ibridazione, quando si tratti di acidi nucleici, o

reazioni immunitarie, quando si tratti di antigeni o anticorpi. Un microarray può essere considerato un potente mezzo diagnostico se

presenta quattro caratteristiche standard ossia essere ordinato, microscopico, planare e specifico. Ordinato, significa che gli elementi

analitici, detti anche molecole probe o chip o spot, devono essere disposti in modo ordinato e preciso lungo file orizzontali diritte ed

incolonnati anche su file verticali perfettamente perpendicolari. I vari elementi devono essere, ovviamente, di grandezza uniforme e

separati da spazi uniformi. E' assolutamente necessario che tali elementi siano disposti in maniera ordinata, sia su linnee orizzontali

che verticali, perché questo ne facilita la produzione in automazione e, quindi a costi contenuti, ma, ancora più importante, ne facilita

e accelera l'esame e l'interpretazione dei risultati. Ogni elemento deve essere uniforme per non rendere ambigua la lettura. Non è

ammissibile la se pur minima sbavatura che rischierebbe di contaminare la lettura dell'elemento vicino. Elementi di forma diversa o di

diversa densità, anche se contenenti lo stesso numero di molecole, darebbero luogo ad un segnale di diversa intensità,

compromettendo la precisione del risultato. Inoltre, ovviamente ogni elemento deve avere una collocazione ben precisa, in base alle

sequenze desiderate, di modo che, automaticamente, si sappia che il dato che la macchina legge corrisponda ad un unico e ben

preciso probe o spot.

La necessità d'assegnare una funzione a ciascuna delle migliaia di geni identificati grazie alla genomica ha reso indispensabile

tecniche che permettano l'analisi simultanea di moltissimi campioni. I macro- e micro-array rispondono a questa esigenza. Le due

tecnologie, identiche nel principio, differiscono nel numero di geni simultaneamente analizzabili (da qualche centinaia a qualche

migliaia per i macro-array; da diverse migliaia a interi genomi per i micro-array) e nel tipo di supporto utilizzato (classiche membrane

di nitrocellulosa o nylon per i macro-array; supporti o "chip" in vetro o altro materiale inerte per i micro-array). Corti frammenti di acidi

nucleici ("oligonucleotidi" della lunghezza compresa fra poche decine e qualche centinaia di paia di basi) corrispondenti ad un

particolare tratto della sequenza dei geni presenti in un particolare tipo di cellula vengono immobilizzati in maniera ordinata e

sistematica in punti precisi (o "spot") del supporto prescelto. Il numero di geni rappresentati è quindi funzione della densità degli

"spot" genici sul supporto come riportato nella immagine.

La tecnologia dei microarray rappresenta un nuovo

potente strumento di ricerca. Il suo sviluppo è stato

possibile solo grazie all’integrazione di diverse

discipline, quali la biologia molecolare, la genetica,

più moderne nanotecnologie, la chimica degli acidi

nucleici, i nuovi software, la robotica e

l’automazione. Esistono infiniti campi di

applicazione per questa nuova tecnologia che

spaziano dall’analisi dell’espressione genica, DNA

RNA microarray, all’analisi delle differenti proteine

presenti in differenti tipi di campioni, protein

microarray, fino ad arrivare alle applicazioni citologiche ed immunoistochimiche dei Tissue microarray.

le

ed

Classificandoli in base alla metodologia costruttiva, esistono tre tipi principali di microarray:

microarray di cloni di DNA: microarray per uso specifico composti di oligonucleotidi oppure di cDNA (ovvero DNA complementare a

singola catena ottenuto per clonazione da un campione di mRNA precedentemente isolato);

microarray di oligonucleotidi prefabbricati: il posizionamento degli oligonucleotidi è fatto sfruttando l’attrazione elettrostatica

esercitata su di loro da parte di microelettrodi;

microarray di oligonucleotidi sintetizzati in situ: microarray ad alta densità contenenti oligonucleotidi sintetizzati usando tecniche

fotolitografiche o di tipo“ink-jet”.

I microarray di cloni sono i più usati e possono analizzare RNA proveniente da due diversi campioni su un singolo chip; le limitazioni

derivano dalla disponibilità di cloni e dalla qualità dei campioni di mRNA. Le altre due classi sono anche note come array

microindirizzabili e permettono l’analisi dell’espressione di un gran numero di geni contemporaneamente ma possono analizzare un

solo campione per chip, con costi considerevoli.

5

Quaderni di Bioinformatica

È possibile classificare i microarray, in base all’uso che ne viene fatto, in tre categorie:

1. cDNA microarray: per permettere l’analisi su larga scala di un gran quantitativo di mRNA come un indicatore

dell’espressione genetica;

2. microarray SNP (“Single Nucleotide Polymorphism”) e array di mutazione: per rilevare polimorfismi o mutazioni in una

popolazione usando array SNP o array progettati per rilevare mutazioni conosciute.

3. microarray CHG (“Comparative Hybridization Genomic”): per osservare perdite o guadagni genomici, o un cambiamento

nel numero di copie di un gene particolare coinvolto in una malattia.

Per quanto riguarda il campo della genomica funzionale i DNA microarray consentono il monitoraggio simultaneo dell’espressione di

migliaia di geni, fornendo un preziosissimo ed innovativo strumento ai ricercatori. Prima di analizzare in dettaglio è opportuno

ritornare al lavoro di Schena e Davis che nel 1999 hanno tracciato una serie di 12 regole che devono sempre essere tenute presenti,

quando si opera con i microarray per ottenere risultati corretti ed apprezzabili. Le riportiamo in sintesi:

1.

Le analisi dei geni devono essere sempre eseguite in parallelo. La valutazione dell'attività dei geni non può essere mai fatta

correttamente su supporti solidi ma non paralleli quali il nylon o la nitrocellulosa, che non hanno una superficie piana.

Occorre poter operare su una superficie perfettamente piana come quella del vetro o di altro materiale che abbia le stesse

caratteristiche. Infatti solo su una superficie perfettamente piana si possono allineare gli spots senza che si creino

inaccettabili convergenze che renderebbero impossibile la lettura in automazione o comunque altererebbero i risultati.

2. Le tecnologie di preparazione devono sempre rendere possibile la miniaturizzazione e l'automazione. Tutti i metodi di

produzione dei microarray, compresa la fotolitografia o le procedure a getto d'inchiostro, devono tendere a realizzare un

prodotto che, comunque, rientri in questi canoni, affinché possa soddisfare la clientela.

3. Ciascun ciclo di analisi dei geni ha cinque fasi evolutive. Come i cicli della vita si ripetono in un divenire sempre identico per

cui si ha prima la nascita, poi lo sviluppo, la crescita per finire con la morte, cosi, per l'analisi dei geni si deve procedere

attraverso cinque tappe: impostare il quesito biologico, preparare il campione, eseguire la reazione biochimica, raccogliere i

risultati, analizzarli per arrivare alla risposta finale.

4. La manipolazione del sistema biologico deve aderire esattamente al quesito biologico. Qualsiasi problema si affronti, sia

che riguardi batteri, lieviti, organismi geneticamente modificati, piante, animali bisogna sempre stare molto attenti alle

influenze dell'ambiente, alla temperatura, ai trattamenti che si fanno e quindi a tutte le tecnologie che si applicano per

evitare che si creino artefatti. Per esempio quando si lavora con le piante bisogna tener presente non solo che la

temperatura sia quella giusta, ma anche l'influenza dell'intensità luminosa e la concentrazione del CO2. Con qualsiasi tipo di

cellula in coltura, il terreno di crescita, il volume o il tipo di recipiente, l'agitazione e tanti altri fattori possono influenzare

l'espressione genica in modo anomalo compromettendo così il risultato finale dell'esperimento.

5. Il campione biochimico deve riflettere esattamente l'esemplare biologico. Bisogna fare in modo che l'isolamento, la

purificazione l'amplificazione, la marcatura e qualsiasi altro metodo o tecnologia si applichi non alterino il campione che si

desidera analizzare. Tener presente che, specialmente le molecole di RNA, sono suscettibili a rapidi cambiamenti fino alla

totale denaturazione da parte di ribonucleasi frequentemente presenti in alcuni ambienti. Anche la marcatura è una fase

che può creare problemi se non si sceglie un tipo di tecnica che sicuramente poi dia la esatta misura del campione.

6. Una presentazione parallela deve sempre essere associata a campioni precisi e correttamente dosati. Quindi non solo i

probes vanno disposti in piano e su linee parallele per rendere possibile la corretta misurazione dei targets, ma anche

essere omogenei e correttamente legati al substrato, altrimenti non vanno usati.

7. Il sistema di lettura deve poter acquisire dati precisi dal posizionamento dei campioni in parallelo. Sia che si tratti di

scanners che di imagers la lettura degli spots divenuti fluorescenti si deve poter svolgere in maniera corretta. Quindi

bisogna scegliere apparecchi con una buona sorgente luminosa, un 'ottica senza difetti e così per tutti i componenti del

sistema di lettura che deve essere in grado di ridurre al minimo sia il rumore di fondo che tutte le eventuali interferenze che

possano alterare in qualche modo il segnale.

8. I dati che provengono dal sistema di lettura devono essere manipolati ed elaborati con precise modalità. Occorre poter

operare con un potente apparecchio di bioinformatica, completato da un ottimo software, per arrivare a risultati che siano lo

specchio del campione biologico sotto esame. Devono essere apparecchi in grado di fornire non solo una serie di numeri

corrispondenti all'intensità della fluorescenza dei singoli spots ma anche un'immagine grafica dell'insieme. Solo così si

riesce ad avere un quadro completo dell'identità dei targets e delle sequenze depositate ed interpretare correttamente il

valore anche di segnali molto deboli.

9. La comparazione dei risultati di due o più esperimenti deve essere sempre soggetta alle limitazioni del caso. Almeno fino a

quando non si potrà disporre di standard di riferimento, certamente i dati di analisi genica che si riescono a raccogliere sul

singolo vetrino sono certamente più attendibili. I dati ottenibili su vetrini di diversa fabbricazione o l'uso di colori fluorescenti

diversi o tecniche diverse possono dare risultati che talvolta non sono facilmente comparabili.

10. Le conclusioni concernenti le relazioni fra i geni (spesso si tratta di grandi numeri) possono essere tratte solo se in un

singolo esperimento si prendono in esame tutte le variabili e si arrivi ad una elaborazione statistica adeguata dei risultati.

6

Quaderni di Bioinformatica

Questo significa che conclusioni riguardanti un determinato processo e concernenti un certo organismo o sistema possono

essere significative solo se, nello stesso esperimento, o meglio con un unico vetrino, si prendono in esame

contemporaneamente tutti i geni di quel genoma che concernono quel processo. Quindi anche un microarray con 10.000

geni, pur fornendo un enorme quantità di dati, può risultare insufficiente se si vuole approfondire un sistema alla cui

attuazione concorrono circa 15.000 geni.

11. L'impostazione analitica deve sempre comprendere tutti gli elementi e le variabili intrinseche ed estrinseche del sistema. Le

analisi eseguite con i microarray non devono mai restare in un contesto interpretativo isolato, ma vanno sempre inquadrate

in una visione globale del sistema che deve comprendere anche i dati molecolari, biochimici, chimici, fisici, enzimatici

nonché le proprietà strutturali sia del gene che i suoi prodotti. Quindi per ogni organismo che interessi, le valutazioni con i

microarray possono essere valutate meglio in un contesto globale di altre informazioni che comprendano anche i rapporti

gene-gene e proteine-proteine derivate.

12. L'analisi parallela di un organismo si può considerare completa solo quando in un contesto quadridimensionale sono

assemblate tutte le variabili del sistema. Un quadro completo dell'espressione genica di un determinato organismo, si può

dire di averlo solo se si conoscono tutte le variabili di ogni gene, in ogni cellula, in ogni fase della vita. Questo significa che

l'attività genica cambia continuamente e quindi va sempre studiata come un film in movimento.

Applicazioni della tecnologia microarray

La tecnologia dei DNA microarray è ancora agli esordi, e sta tutt’oggi crescendo. Le applicazioni di tale tecnologia sono comunque

molteplici, dallo studio dei geni coinvolti nell’insorgenza del cancro e di numerose patologie, alla caratterizzazione di pattern

metabolici.

Gli array sono un importante strumento anche per l’identificazione e la caratterizzazione di nuovi geni. I DNA chips sono stati utilizzati

nella diagnosi e nella prognosi delle malattie e nel design di nuovi farmaci [21, 22]. Le applicazioni in campo umano sono

innumerevoli soprattutto grazie al fatto che l’intero genoma è stato sequenziato. Una grande limitazione di questa tecnologia, oltre al

costo ancora troppo elevato, è infatti la necessità di disporre di sequenze geniche conosciute. Questo pone un enorme freno

all’utilizzo e all’applicazione di tali tecnologie in campo veterinario ed alimentare. Infatti il genoma degli animali di interesse zootecnico

è ancora per lo più sconosciuto.

Campi di utilizzo dei DNA microarray nella ricerca di base e applicata [19]. A differenza degli array oligonucleotidici ad alta densità, il

RICERCA APPLICATA

FUNZIONE DEI GENI

pathway metabolici

analisi di mutazioni

RICERCA DI NUOVI FARMACI

identificazione e validazione del target

ottimizzazione dell'efficacia

meccanismo d'azione

DIAGNOSI DI PATOLOGIE

prognosi e diagnosi

classificazione dellle patologie

strategie di trattamento

CARATTERIZZAZIONE DI SISTEMI COMPLESSI

organi e patologie specifiche

risposta allo stress

invecchiamento

VALUTAZIONE DELLA TOSSICITA'

tossici e farmaci

cibo

ambiente

basso costo e l’alta flessibilità degli gli array a cDNA rendono tale tecnologia molto più adatta alle istituzioni accademiche e alle

applicazioni pratiche della tecnologia. È infatti possibile produrre array home made contenenti un limitato numero di geni di interesse

al fine di effettuare studi molto mirati ed approfonditi, eliminando anche tutti gli irrisolti problemi di gestione dei dati degli array ad alta

densità. Conclusione: Le analisi con i microarray impiegano una miriade di tecnologie e metodi diversi ma sempre bisogna capire

bene di che cosa si tratti (What), del perché (Why) e come (How) l'obiettivo possa essere raggiunto nel modo migliore .

Storia dei DNA microarray

La prima intuizione di tale nuovo metodo di analisi si deve a Mark Schena dell’Università di Stanford, che ne ha fatto cenno ad

Amsterdam nel 1994 nel corso del quarto Congresso Internazionale di Biologia Molecolare delle Piante, ma la prima pubblicazione

riguardante questa nuova tecnica è dell'anno seguente (Schena et al. 1995). Presso l'Università di Stanford, che ha una lunga

tradizione negli studi sugli acidi nucleici, e presso i contigui Laboratori dell’Università di Davis, sono state infatti affrontate le prime

problematiche su come fissare sui vetrini microscopiche linee di sequenze di geni delle piante e su come studiarne l'espressione

utilizzando campioni di mRNA isolati dalle cellule e coniugati ad un enzima per poter evidenziare poi l'avvenuta reazione con la

comparsa di fluorescenza di intensità variabile e quindi misurabile. Quindi i microarray, come i microprocessori, sono nati nella Silicon

Valley. Parallelismo, miniaturizzazione ed automazione sono tre aspetti che mettono in luce una certa similarità fra le due tecnologie.

In realtà possiamo iniziare la storia dei microarray con il primo semplice esempio di array, denominato “dot blot” per arrivare allo

sviluppo dei microarray ad alta densità [1]. L'origine di tale nuova tecnologia va fatta risalire agli esperimenti di Southern che, nel

7

Quaderni di Bioinformatica

1975, dimostrò come fosse possibile fissare il DNA ad un supporto solido ed attrarre, in modo specifico, una catena complementare

sempre di DNA. Tale processo, poi largamente utilizzato per scopi diagnostici, è noto come “Southern blotting". Le tecniche standard

di laboratorio per il rilevamento di specifiche sequenze nucleotidiche utilizzano una sonda (probe) di DNA, costituita da un piccolo

frammento di acido nucleico marcato con un isotopo radioattivo o una sostanza fluorescente. La sonda, rappresentante la sequenza

complementare a quella del gene da individuare, viene posta in contatto con un supporto solido (ad esempio, un gel od un filtro

poroso) sulla cui superficie sono ancorati acidi nucleici provenienti da un dato genoma. Grazie alla peculiarità degli acidi nucleici di

riconoscere le sequenze ad essi complementari, la sonda può legarsi in maniera selettiva al frammento ancorato ad essa

complementare così che, semplicemente misurando la presenza e la quantità di marcatore legato al supporto solido, è possibile

quantificare se e quanto è stato espresso un determinato gene (Southern et al, 1975).

I principi fondamentali dei test di ligazione miniaturizzati di spot paralleli erano già stati descritti da più di un decennio. Roger Ekins e

colleghi avevano descritto le ragioni per cui i saggi effettuati utilizzando i microspot erano più sensibili di qualsiasi altro test di

ligazione [2-4]. Inizialmente l’elevata sensibilità e l’enorme potenziale delle tecnologie basate sui microspot sono stati dimostrati

utilizzando sistemi miniaturizzati per i test immunologici. Tuttavia l’interesse della tecnologia degli “spot” si è presto concentrata sulla

creazione dei “DNA chips”. La possibilità di eseguire centinaia di reazioni di ligazione in parallelo in un unico esperimento

corrisponde, infatti, alla necessità nella ricerca biologica di un approccio a livello genomico più ampio. Il sogno della sequenza

completa del DNA umano (o genoma) nacque praticamente il giorno seguente al quale Sanger scoprì come leggere il DNA. Fu poi

Fodor, che nel 1991, fabbricò i primi microarray, combinando il metodo fotolitografico, usato per i semiconduttori, per realizzarne i

primi fissando degli oligonucleotidi su superfici di vetro.

Avendo intuito l'importanza commerciale che tale

tecnologia avrebbe potuto avere, fondò l'Affymetrix che ha

avuto il merito di mettere sul mercato i GeneChip, che

sono stati i primi vetrini con DNA utilizzabili per tests

genetici. Nel 2002 questo sogno divenne parzialmente

realtà. Il genoma umano fu dichiarato completamente letto

fra squilli di tromba e grandi clamori. Più in piccolo, sotto i

titoli, si leggeva che, in fin dei conti, ci si era limitati a

leggere il 98% della sequenza eucromatinica, ma tanto

bastava. Tutte le regioni del DNA altamente ripetitive, quali

per esempio i telomeri (le code dei cromosomi) e i

contromeri (il nodo centrale dei cromosomi), non erano

assolutamente stati letti. Ciò era dovuto a difficoltà

tecniche, queste regioni sono infatti composte

essenzialmente da un’infinità di ripetizioni di una piccola

sequenza di DNA e contengono pochissimi geni. Spesa totale, circa due miliardi di euro. Molto a prima vista ma, in fin dei conti, con

quei soldi oggigiorno ci si comprano un paio di aerei da caccia militari ultimo modello, o un decimo di traforo alpino per i treni ad alta

velocità. Soldi ben spesi dopo tutto. Non si sa se gabbati dalle loro stesse parole o semplicemente naif, i ricercatori erano attesi al

varco da una brutta sorpresa. Leggere il DNA significa ottenere la sequenza, non riuscire a capirci qualcosa. Ciò che portò un

professore dell’onorevolissimo MIT a commentare “abbiamo speso due miliardi per un libro che non sappiamo leggere”. Si fece quindi

un serio sforzo per cercare di interpretare quell’immensa massa di dati (quasi 3,2 miliardi di lettere) che era stata generata dal

sequenziamento del genoma umano. Oggigiorno questo sforzo è ben lungi dall’essere terminato ma importantissimi passi avanti

furono celermente compiuti. Alla fine del 2002 si conosceva in effetti la sequenza di qualche gene. Un’analisi di tutte queste sequenze

permise allora di identificare quelli che potevano essere considerati come i caratteri comuni a tutti, o almeno molti, geni. Identificati

questi caratteri, furono creati dei programmi informatici (chiamati ab initio) capaci di passare in rassegna l’intero DNA alla ricerca di

altri geni. Iniziò allora il valzer delle cifre. Il genoma umano contiene… le ultime stime dicono meno di 25′000 geni. Si era cominciato

con più di 150′000… molti altri geni furono in seguito identificati grazie al sequenziamento di RNA. Infine, quando altri genomi furono

sequenziati, un confronto fra questi e quello umano permise l’identificazione di numerose regioni del DNA che erano rimaste invariate

nonostante il lungo tempo evolutivo che le separava. Molte di queste regioni corrispondevano a geni. Una prima breccia nella

comprensione del DNA era stata aperta. Badate bene, si era unicamente riusciti ad identificare i geni. La funzione di questi ultimi

restava (e in parte resta ancora oggigiorno) ancora un mistero. Une seconda breccia sarebbe potuta essere aperta se l’espressione

temporale e spaziale dei geni fosse stata conosciuta. Per esempio un gene che si esprime a livello del cervello embrionale,

probabilmente avrà un ruolo nella formazione di quest’organo durante lo sviluppo precoce.

Fu allora che qualcuno ebbe un’idea geniale. Un gene, per essere utilizzato dalla cellula, deve essere fotocopiato in RNA, il quale

sarà in seguito tradotto in proteine. Questa tecnica permette di misurare unicamente l’espressione di un gene alla volta, senza

garantire per altro una quantificazione precisa dell’espressione del gene studiato (analisi unicamente qualitativa). Riuscire a misurare

la quantità di RNA significava riuscire a quantificare l’utilizzo di un dato gene. Una tale tecnica già esisteva con il nome di Northern

8

Quaderni di Bioinformatica

Blot. Questa tecnica applicata per la prima volta da Ed Southern nel 1975, ha aperto di fatto la strada alla possibilità di analizzare i

profili di espressione genica di un intero organismo. Tuttavia, l’applicazione su larga scala di questa metodologia si è avuta solo di

recente grazie all’utilizzo di supporti solidi non porosi, come il vetro, e alla messa a punto di tecniche fotolitografiche per la sintesi di

frammenti oligonucleotidici ad alta densità spaziale. In particolare, i protocolli sviluppati dal gruppo di Pat Brown a Stanford, hanno

permesso di ancorare automaticamente migliaia di catene di cDNA su vetrini da microscopio e, grazie alla loro ibridazione con

campioni di mRNA marcati selettivamente con molecole fluorescenti, di studiare il profilo di espressione di colture cellulari in stati

fisiologici diversi (Brown e Botstein, 1999). Parallelamente, sono state messe a punto tecniche di mascheramento fotolitografico,

normalmente utilizzate nell’industria dei semiconduttori, per la produzione di microarray capaci di 400.000 sonde oligonucleotidiche

su una superficie di un pollice quadrato (Lipshutz et al, 1999).

L’idea geniale fu di cercare misurare in un sol colpo l’espressione di tutti i geni conosciuti. Si sapeva da mezzo secolo che il DNA è

una doppia elica. Le due eliche, se separate si riassociano spontaneamente riformando sempre le coppie A-T, G-C. Le due eliche, se

separate anche molte volte, si riassociano sempre nella stessa posizione. Quest’associazione necessità la presenza delle coppie

sopracitate (A-T. G-C) e, nelle giuste condizioni di temperatura, avverrà solo se le

due sequenze sono perfettamente complementari. Una corta sequenza di DNA, può

dunque essere utilizzata come “sonda” capace di cercare sequenze a lei

complementari. Sebbene non si riuscisse a sintetizzare lunghe catene di DNA senza

una matrice (una copia già fatta) era possibile sintetizzare brevi sequenze

unicamente per via chimica. L’idea fu dunque questa. Sintetizzare migliaia di copie

di un frammento di un gene su uno spazio piccolissimo, poi immediatamente a

fianco di queste sintetizzare migliaia di copie di un altro gene, fino a produrre un

fascio di sonde per ogni gene dell’organismo. Se la sequenza è abbastanza lunga

(20-25 lettere) la probabilità che un altro frammento di DNA sia identico è

abbastanza bassa.

Ad esempio se utilizzassi “nel mezzo del cammin di nostra” (25 lettere spazi esclusi)

ognuno di voi saprebbe di che opera letteraria stiamo parlando, senza

necessariamente doverla citare per intero.

Tornando all’RNA simili sonde furono sintetizzate in griglie finissime. In ogni

quadratino della griglia fu inserita una diversa sonda capace di catturare tutti i

frammenti di DNA corrispondenti a un dato gene. L’insieme della griglia (contenente circa 25′000 posizioni) è quindi capace di

leggere, in un sol colpo, l’intera espressione genica delle cellule studiate.

Come detto l’espressione dei geni necessita la trascrizione dei geni in RNA. Avrete magari notato che, quando si parlava delle

proprietà di riassociazione delle due eliche, si faceva riferimento al DNA. Perché il sistema sopra proposto funzioni, vi è dunque la

necessità di trasformare tutto l’RNA di una cellula in DNA.

Come al solito la biologia, quando messa alle strette, si permise un piccolo furto. Esisteva in effetti una proteina virale in grado di

copiare l’RNA in DNA. Siccome normalmente accade il contrario (il DNA è fotocopiato in RNA) si battezzò questo meccanismo

retrocopia. I virus che possiedono questa proteina sono detti retrovirus, il cui rappresentante più celebre è senz’altro il virus dell’HIV.

Riassumiamo quindi la situazione: il sequenziamento del DNA umano aveva messo a disposizioni immense quantità di dati non

interpretabili. Le sequenze geniche furono trovate grazie a programmi informatici (lavoro ancora in corso).

Misurare l’espressione di tutti i geni poneva però un serio problema.

- I geni sono molti. Problema risolto grazie alla griglia finissima. Le sonde capaci di leggere oltre 25′000 geni possono ora raccolte in

un centimetro quadrato.

- L’RNA pone dei problemi di manipolazione sperimentale. Problema aggirato grazie alla

retrocopia dell’RNA in DNA.

Restava da aggirare il problema della quantificazione dell’RNA retrocopiato. Ci si risolse a

marcare con dei prodotti fluorescenti il DNA retrocopiato.

Ecco dunque la procedura sperimentale. Produrre il microarray (il vetrino contenente le

sonde). Allo stesso tempo estrarre l’RNA dalle cellule studiate (ad esempio le cellule

muscolari). Retrocopiare l’RNA estratto in DNA, approfittare del passaggio per marcare il

DNA così prodotto con dei prodotti fluorescenti. Porre l’estratto di RNA retrocopiato sul

microarray e portare il tutto alle giuste condizioni di temperatura. Ogni RNA si assocerà quindi alla sua sonda (e se tutto va bene solo

alla sua sonda). Misurare la fluorescenza in ogni quadratino della griglia. La quantità di fluorescenza è proporzionale al numero di

RNA che si sono associati alle sonde. Confrontare i dati così prodotti con quelli di altri esperimenti per determinare i geni specifici di

ogni tessuto. Si noti che la quantificazione della fluorescenza è estremamente precisa, un valore numerico può quindi essere

associato ad ogni quantità di fluorescenza (misura quantitativa).

Abbiamo detto che la totalità dell’informazione genetica è chiamata genoma. Per analogia, la totalità dell’informazione della

trascrizione dei geni (RNA in un dato momento, in un dato tessuto) fu chiamata trascrittoma. Questa è dunque la definizione finale di

microarray: Una tecnica capace di misurare in un sol colpo l’intero trascrittoma.

9

Quaderni di Bioinformatica

Non sempre le migliori idee le hanno le università, non fu il caso dei microarray. Fu un’industria privata, Affymetrix, ad avere per

prima l’idea e, logicamente, a ricoprirla di brevetti. La piccola cronaca poi ci rivela che una sbadataggine aziendale fece in modo che i

brevetti sui microarray non fossero mai depositati in Islanda, paese in cui nacque Nimblegen, unica ditta oggi in grado di portare un

po’ di concorrenza sul mercato. I microarray trovarono immediatamente numerosissime applicazioni. Oggigiorno sono utilizzati non

solo per lo studio dell’espressione dei geni nei differenti tessuti ma anche per analizzare la risposta a diversi tipi di stress o la

malignità di un tumore (il sistema che permette la migliore valutazione della probabilità di metastasi).

Una seconda serie di applicazioni derivò da una peculiarità della tecnologia. Come detto la sonda (nelle buone condizioni) è capace

di associarsi alla sequenza complementare solo se la complementarietà è perfetta. Ora esistono numerose differenze genetiche fra

individui (gemelli esclusi) è quindi verosimile che alcune lettere del DNA (nucleotidi) siano differenti fra due individui. In questo caso

nessuna fluorescenza dovrebbe essere osservabile nel quadratino della griglia portante le sonde per un dato gene, anche se questo

gene è trascritto (a causa della mutazione). Visto che questi cambiamenti affliggono generalmente solo una lettera (nucleotide)

vengono detti Sigle Nucleotide Polymorphsm o SNP. L’idea fu la seguente: fabbricare per ogni posizione del DNA quattro sonde

identiche in tutto, tranne che per la posizione studiata in cui rispettivamente si inseriscono le quattro lettere del DNA (A, T, G, C).

Questo procedimento viene ripetuto per ogni posizione del DNA (3,2 miliardi in totale!).

Se questa volta, al posto dell’RNA, associamo alle sonde del DNA precedentemente frammentato e marcato con i colori fluorescenti,

ci aspetteremo di osservare per ogni gruppo di quattro sonde un segnale fluorescente proveniente da una o al massimo due sonde.

Se l’intero procedimento viene fatto sull’intero genoma è possibile “risequenziare” l’intero DNA di un individuo semplicemente

leggendo quale sonda (per gruppi di quattro) offre’ il miglior segnale. Il sistema non è ovviamente perfetto. Gli SNP microarray

(single nucleotide polymorphisms SNPs) sono particolari DNA microarray che sono usati per identificare i così detti tratti ipervariabili,

ovvero quelle sequenze che variano da individuo ad individuo nell’ambito della stessa specie o in sotto popolazioni isolate

geograficamente o socialmente Arrays di oligonucleotide corti sono usati per identificare il polimorfismo di un singolo oligo nucleotide,

che si pensano responsabili della variazione genetica e della suscettibilità individuale a manifestare determinate malattie. Se per

esempio una regione è estremamente variabile non si osserverà alcun segnale per nessuna della quattro sonde (perché altri SNP

sono troppo vicini). Inoltre il metodo non è perfetto, una cospicua percentuale della SNP non è visibile con questo approccio. Infine il

DNA si è rivelato più plastico del previsto con larghe regioni del genoma che possono essere duplicate o perse. Queste variazioni del

DNA di larga scala non sono ovviamente visibili con questo tipo di microarray (altri microarray sono per altro stati prodotti per mettere

in evidenza queste variazioni).

Anno

Evento

1987

Assegnato brevetto su sequenziamento tramite ibridizzazione (SBH)

R.Drmanac, Università di Belgrado Argonne National Laboratory HySeq

1988-1991

Diversi gruppi pubblicano reports sull’SBH

E.Southern, Oxford University (Oxford Gene Technolgy)

A.Mirzabekov, Engelhard Institute, Mosca Argonne National Laboratory

S.Fodor, Affymetrix

W.Bains, Bath University

1989

Assegnato brevetto europeo a Southern

“Oligonucleotidi arrays as a testing platform”

1993

Assegnato brevetto negli US sull’SHB alla HySeq

1997-1998

HySeq accusa Affimetrix per una violazione del brevetto

“non stiamo sequenziando, ma cercando mutazioni”

1998

Procedimenti legali tra Southern e diverse compagnie produttrici di chip.

(Affimetrix, HySeq, Hoffman-La Roche, Abbot, etc.)

1998

Brevetto US alla Incyte (Synteni) sulla tecnologia di printing di Microarray con densità superiore a

100 polinucleotidi per centimetro quadrato

1998-1999

Affimetrix ed Incute (ed altri) si accusano a vicenda di violazione di brevetti

2000-2004

Genoma umano intero su uno microarray

La battaglia dei brevetti sui gene chip [5]

Attualmente sono disponibili dei microarray per il genoma umano e quello dei principali organismi modello, animali e vegetali.

Moltissime tecniche derivate hanno a loro volta visto la luce (whole genome tiling path array, CHIP on Chip, ecc.). L’uso di microarray

per lo studio del profilo d’espressione genetica è stato pubblicato per la prima volta nel 1995 (Science) e il primo genoma eucariotico

completato con analisi di microarray fu quello del Saccharomyces cerevisiae nel 1997 (Science).

I primi articoli riguardanti la nuova tecnologia denominata DNA-microarray, in grado di consentire il monitoraggio quantitativo

dell’espressione di centinaia di geni simultaneamente, furono pubblicati a metà degli anni novanta da un team di studiosi di diverse

discipline della Stanford University [6]. La biologia molecolare, che fino ad allora aveva adottato un approccio riduzionista, ricomincia

10

Quaderni di Bioinformatica

ora a considerare ogni singolo gene come parte di un sistema più complesso di espressione, che grazie alla nuova tecnologia può

essere valutato nella sua interezza. Il rapido progresso nel sequenziamento dell’intero genoma [7, 8], e l’aumentata importanza degli

studi d’espressione, accoppiati alle nuove tecnologie di sintesi in vitro di oligonucleotidi, hanno permesso di generare con elevata

efficienza migliaia di sonde oligonucleotidiche.

TITOLARI

Università della California

Governo degli Stati Uniti

Sanofi Aventis

GlaxoSmithKlein

Incyte

Bayer

Chiron

Genentech

Amgen

Human Genome Sciences

Wyeth

Merck

Applera

Università del Texas

Novartis

Johns Hopkins University

Pfizer

Massachussetts General Hospital

Novo Nordisk

Harvard University

Stanford University

Lilly

Affymetrix

Cornell University

Salk Institute

Columbia University

University del Wisconsin

Massachussetts Institute of technology

NUMERO DI BREVETTI

1018

926

587

580

517

426

420

401

396

388

371

365

360

358

347

331

289

287

257

255

231

217

207

202

192

186

185

184

Le nuove tendenze tecnologiche nel campo della

microfluidica e delle nanotecnologie, i nuovi sistemi di

rilevamento e il perfezionamento nella tecnologia dei

computer e nella bioinformatica, sono state rapidamente

integrate nella tecnologia dei sistemi basati sulla

tecnologia microarray. Tutto questo ha portato negli

ultimi anni ad un enorme potenziamento di tutte le

tecnologie basate sugli array. L’industria elettronica, in

cui i microchip in silicio sono stati il soggetto ideale per la

miniaturizzazione, ha negli ultimi anni ideato strumenti

micro fabbricati che possono realizzare un insieme di

funzioni come per esempio preparazione del campione,

purificazione, separazioni…La necessità di manipolare

fluidi che si muovono in canali stretti (microfluidica) ha

aperto nuove aree di ricerca, ha sviluppato nuovi metodi

di fabbricazione per i sistemi fluidici, ha portato alla

costruzione di complessi sistemi microfluidici e allo

studio del moto di fluidi in canali di piccole dimensioni.

Inoltre l’introduzione di tecniche fotolitografiche per la

fabbricazione di microsistemi chimici e biochimici, ha

incrementato esponenzialmente il numero di applicazioni

in tale settore. Particolarmente interessante è la

tecnologia MEMS (la sigla MEMS sta per Micro ElectroMechanical Systems) che applica sullo stesso wafer

tecniche di lavorazione usate nella fabbricazione di

circuiti integrati per costruire strumenti microscopici

elettro-meccanici, come per esempio sensori.

Progetto “Lab-on-chip” monolitico della STMicroelectronics.

La tecnologia MEMS permette di applicare la stessa economia dovuta all’integrazione

su piccola scala della lavorazione dei wafer di silicio alla fabbricazione di strumenti

meccanici. Per esempio i sensori prodotti usando le tecnologie convenzionali sono

costruiti uno per volta, mentre usando la tecnologia MEMS, lo stesso sensore è

realizzato in centinaia o migliaia di copie, con prestazioni costanti e basso costo

unitario. Una delle applicazioni della tecnologia MEMS con fluidi in movimento è stata

la realizzazione di uno strumento in grado di realizzare la “Polymerase Chain

Reaction” (PCR) ottenendo uno strumento contenente canali in silicio per i reagenti e

il campione, elementi riscaldanti per modificare le temperature durante il ciclo di

amplificazione e sensori per il controllo della temperatura. Le piccole dimensioni dei

canali permettono l’uso di un minor quantitativo di reagenti e la bassa capacità termica del silicio riduce il tempo necessario per la

stabilizzazione delle temperature. Il risultato è che il tempo richiesto per realizzare l’amplificazione del campione con la PCR è ridotto

da ore a minuti. L’inconveniente è che, non essendo possibile pulire lo strumento, esso è monouso. Inoltre sono in fase di studio

progetti monolitici che consentono, oltre all’amplificazione, anche il riconoscimento delle sequenze di DNA. Una più recente tecnica,

che potrebbe rivelarsi assai promettente, adotta un approccio del tutto diverso per identificare le singole basi che compongono la

molecola di DNA. Questa metodica, chiamata “sequenziamento mediante nanopori”, sfrutta le differenze fisiche esistenti fra le quattro

basi che compongono il DNA, per produrre un segnale diverso. Come l’elettroforesi, questa tecnica trascina le molecole di DNA verso

una carica positiva. Per raggiungerla, le molecole devono attraversare una membrana transitando per un poro con un diametro

11

Quaderni di Bioinformatica

inferiore a 1,5 nanometri, per cui riescono a passare solo le molecole di DNA a filamento singolo. Quando il filamento transita

attraverso il poro, i nucleotidi bloccano temporaneamente il passaggio, alterando la conduttanza elettrica della membrana misurata in

picoampere. Le differenze fisiche fra le quattro basi generano blocchi di durata e grado diversi. Questa tecnologia dovrebbe portare

ad una notevole riduzione dei costi e a leggere un intero genoma umano in non più di 20 ore.

Negli ultimi anni, la tecnologia dei microarray, messa a punto per studiare gli acidi nucleici, si è andata espandendo per analizzare

meglio il proteoma delle cellule e le interazioni che avvengono fra le diverse proteine e fra queste e l'ambiente esterno, che sono

molto importanti nel determinismo delle malattie e le cui conoscenze certamente faciliteranno la messa a punto di nuovi farmaci. Le

proteine sono considerate le più importanti strutture cellulari per il continuo ed intenso lavoro che svolgono sia in stato di benessere

che in corso di malattia. Abbiamo visto che, fino a qualche anno fa si credeva che ogni gene codificasse un solo tipo di mRNA e

quindi, almeno teoricamente, una sola proteina ed attraverso di essa, impartisse istruzioni alle strutture cellulari e quindi al

metabolismo. Oggi sappiamo invece che la realtà è molto più complessa perché ogni gene, con le varianti, può codificare fra 3 e 20

proteine. Quindi per capire come i geni funzionano bisogna arrivare alle proteine che essi esprimono e capire anche come le varie

proteine interagiscono fra di loro. Ne deriva che se è stato molto importante studiare a fondo il genoma è ancora più importante

studiare il proteoma, ossia lo sconfinato mondo delle proteine che è molto più complesso, anche perché non statico ma

continuamente mutevole in un contesto di reti dinamiche per la continua serie di interazioni che avvengono fra di loro per effetto sia

dei processi metabolici sia come risposta agli stimoli ambientali. A differenza del genoma che è costituito da un numero fisso di geni,

il livello a cui le proteine cellulari operano è molto dinamico perché le proteine, direttamente sottoposte a tutti gli stimoli dell'ambiente

vanno incontro a continue variazioni di adattamento e risposta. Ecco perché è molto difficile determinarne accuratamente l'esatto

numero o le quantità presenti nelle cellule viventi. Inoltre le varie famiglie di proteine sono estremamente diverse fra loro sia per le

dimensioni delle molecole, sia per la struttura, che per le caratteristiche chimiche e le funzioni.

Comunque i microarray con proteine, oltre che in campo terapeutico, possono trovare sempre più ampia applicazione in campo

diagnostico specialmente per le malattie infettive di origine virale. Infatti attualmente i metodi più largamente usati per individuare

agenti patogeni virali in campioni biologici, sono quelli che si basano sull'immunoenzimatica eseguita in piastrine o su la PCR. Ma i

primi hanno una sensibilità che oscilla fra il 70 e 90% ed i secondi hanno un costo elevato che ne limita la diffusione su larga scala

specialmente in nazioni del terzo mondo che poi sarebbero quelle che ne avrebbero più necessità. Per la preparazione di microarray

dedicati specificamente, le proteine da usare come probe, che qualcuno preferisce chiamare " protein chip " o semplicemente " chip ",

possono essere derivate da estratti cellulari oppure sintetizzate mettendo insieme dei peptidi sintetici. Le proteine possono anche

essere prodotte in colture di batteri, lieviti, cellule ingegnerizzate di insetti. Tali proteine ricombinanti, sono poi purificate con tecniche

diverse e possono diventare un ottimo materiale da immobilizzare sui vetrini come molecole di cattura. I metodi per fissare le proteine

sui supporti sono fondamentalmente simili a quelli utilizzati per gli acidi nucleici. Come vedremo, però, produrre microarray con le

proteine offre qualche difficoltà in più. Infatti, come primo inconveniente c'è il problema che le proteine sono molto meno stabili degli

acidi nucleici perché vanno incontro spesso a processi di ossidazione e di denaturazione. Poi le proteine, quando sono rimosse dal

loro ambiente naturale, modificano la loro struttura nativa e quindi anche la forma, talvolta esponendo all'esterno aminoacidi diversi

da quelli della forma nativa. Ne deriva che, quando le si va a far reagire, questi aminoacidi esterni, che costituiscono gli epitopi più

esposti, possono pregiudicare il risultato della reazione.

Sono stati studiati diversi tipi di microarray per le proteine che Dev Kambhampati, nella sua monografia (2004), suddivide così:

Array con anticorpi: Sono stati utilizzati sia anticorpi policlonali che monoclonali per titolare proteine specifiche in campioni

biologici. Si possono considerare dei test immunologici in miniatura.

Array con antigeni: E' l'inverso del precedente, perché in questo caso è fissato un antigene sul supporto per titolare il

corrispondente anticorpo presente nel campione biologico.

Array funzionali: Proteine purificate sono fissate sul supporto per legare altre proteine o DNA o interagire con altre piccole

molecole.

Array di cattura: Molecole non proteiche ma capaci di legarsi alle proteine sono ancorate alla fase solida. Esempio il

Ciphergen Protein Chip.

Array in sospensione: E’ un caso particolare che utilizza come fase solida delle microparticelle fornite di qualcosa di simile

ad un codice a barre.

La tecnologia dei DNA microarray

Un tipico esperimento che utilizzi i microarray comprende cinque fasi principali:

1-deposizione degli oligonucleotidi sonda sul supporto rigido;

2-preparazione del materiale genetico da analizzare (compresa la marcatura con molecole fluorescenti);

3- ibridazione dei campioni fluorescenti sul microarray;

12

Quaderni di Bioinformatica

4. lettura dei valori di fluorescenza, effettuata tramite apposito scanner;

5. analisi statistica ed elaborazione dei dati ricavati dalle immagini prodotte.

I microarray rappresentano un sistema di analisi in parallelo, che velocizza considerevolmente l'esplorazione genomica: permettono,

infatti, di esaminare contemporaneamente l'espressione di migliaia di geni o un ampio numero di polimorfismi genetici. Un altro

vantaggio è dato dai costi relativamente contenuti se rapportati al numero di geni o polimorfismi analizzabili per esperimento.

I microarray a DNA possono essere definiti come un insieme miniaturizzato e ordinato di frammenti di acidi nucleici derivati da singoli

geni e fissati in posizioni prestabilite su un supporto solido, rendendo

possibile l’analisi simultanea tramite ibridazione specifica di centinaia

di geni [9].

In questi esperimenti, la complementarità delle sequenze porta alla

ibridizzazione di due molecole di acidi nucleici a singolo filamento,

una delle quali è immobilizzata su una matrice solida [10]. La scelta

di quali geni debbano essere rappresentati può variare dalla totalità

(interi genomi su un unico vetrino) allo specifico (particolari pathway

metabolici, etc.). Esistono di fatto due tecnologie per la produzione di

microarrays: la prima denominata a spotting e la seconda detta in

situ. Nella tecnologia spotting, le sonde da ancorare al supporto

solido, normalmente un vetrino da microscopia, sono sintetizzate a

parte e quindi depositate sul supporto. Tali sonde possono essere costituite da molecole di cDNA lunghe alcune migliaia di paia di

basi le cui sequenze possono essere ricavate da banche dati genomiche (GenBank, dbEST o UniGene) o da librerie proprietarie

costituite da cDNA non ancora completamente sequenziato. Nello studio dell’espressione di organismi eucarioti, le sequenze delle

sonde sono normalmente ricavate dalle cosiddette Express Sequence Tags (EST), ovvero dalle porzioni codificanti identificate dai

singoli progetti genoma. Tali banche dati contengono, assieme alle sequenze, anche tutta una serie di informazioni bibliografiche

necessarie, oltre che per la scelta delle porzioni di DNA da depositare sulla matrice, anche per la successiva valutazione dei profili di

espressione. Nel caso dei lieviti o di organismi procarioti le sonde sono generate per amplificazione diretta, con primers specifici, del

DNA genomico. Selezionate le sequenze da studiare, il cDNA relativo viene prodotto mediante PCR ottenendo così sonde della

dimensione da 600 a 2400 bps. Più recentemente, le sonde che vengono depositate sono rappresentate non tanto da frammenti di

materiale genomico ottenuto via PCR, quanto piuttosto da sequenze sintetiche di oligonucleotidi lunghe 50-70 paia di basi. Una volta

prodotte, le sonde vengono depositate sul supporto solido, in

genere costituito da un vetrino. La deposizione è effettuata da

sistemi robotizzati che mediante l’utilizzo di pennini prelevano

le sonde direttamente dalle piastre utilizzate per la PCR e le

depositano sul vetrino formando spots di circa 100-150 µm di

diametro, distanziati l’uno dall’altro 200-250 µm. Durante la

deposizione, il sistema di controllo del robot registra

automaticamente tutte le informazioni necessarie alla

caratterizzazione ed alla completa identificazione di ciascun

punto della matrice (identità del cDNA, coordinate sul

supporto, ecc.). Una volta sul vetrino, il probe viene legato

covalentemente ai gruppi amminici del supporto attraverso

una reazione innescata dall’irraggiamento con luce

ultravioletta, mentre il cDNA in eccesso viene rimosso con

semplici lavaggi dell’array. Infine, il cDNA sul supporto viene

reso a catena singola attraverso una denaturazione termica o chimica. L’altra tecnica utilizzata per la produzione di microarrays è

quella detta in situ che, sviluppata da Affimetrix, è frutto dell’interazione di due tecnologie particolari, la fotolitografia e la sintesi diretta

in fase solida di oligonucleotidi. La sintesi delle sonde avviene direttamente sulla superficie del supporto solido. In particolare, il

supporto costituito da un wafer di silicio viene funzionalizzato con piccole sequenze di oligonucleotidi (oligo-starter).

Questi oligo hanno la caratteristica di avere il gruppo reattivo protetto da gruppi fotosensibili e quindi, grazie ad una maschera

fotolitografica, è possibile indirizzare la luce in specifiche posizioni dell’array e liberare i siti necessari per la sintesi della sequenza.

Una volta deprotetti selettivamente i siti reattivi, è sufficiente incubare la superficie con desossiribonucleotidi protetti per allungare la

catena in fase di sintesi. Ripetendo il ciclo di deprotezione grazie all’applicazione di maschere fotolitografiche diverse e di incubazione

è quindi possibile aggiungere nucleotidi diversi in posizioni diverse e sintetizzare tutte le sonde necessarie per l’analisi di un dato

genoma.

13

Quaderni di Bioinformatica

Sono state sviluppate due differenti tecnologie per effettuare l’analisi dell’espressione genica [6, 11]: gli array a oligonucleotidi e gli

array a cDNA. Negli array a cDNA, i frammenti di acido nucleico sono spottati con un sistema automatizzato, utilizzando un protocollo

messo a punto inizialmente da un team dell’Università di Stanford (http://cmgm.stanford.edu/pbrown/mguide/). Il protocollo per

produrre questo tipo di microarray è stato inizialmente sviluppato dal Prof. Pat Brown e colleghi dell'Università di Stanford. La

costruzione di questo tipo di microarray consiste nel depositare determinati cloni di DNA o oligonucleotidi in precise zone della

superficie di un vetrino per microscopia secondo una griglia prestabilita. Il cDNA utilizzato per lo spot è generalmente derivato da un

amplificazione tramite PCR di librerie a cDNA. La tecnologia degli oligo-microarray consiste invece nel sintetizzare direttamente i

nucleotidi sulla superficie del vetrino [12]. Esistono due differenti tecnologie per la sintesi degli oligonucleotidi, la tecnologia

fotolitografica, che consente la sintesi di corti nucleotidi di 20-25 basi (Affimetrix, www.affimetrix.com) [13] e la tecnologia inkjet

(Agilent Technologies, [email protected]) che consente la sintesi di oligonucleotidi più lunghi, 60 basi [14].

Entrambe queste tecnologie sono state inizialmente sviluppate per l’industria dei computer e in seguito adattate alla fabbricazione dei

microarray. Esiste inoltre un terzo tipo di array, costituito dallo spot di oligonucleotidi presintetizzati, solitamente tali frammenti sono

più lunghi, circa 70 nucleotidi [15]. La lunghezza ottimale della sonda oligonucleotidica fissata al vetrino è tutt’oggi oggetto di dibattito.

È importante considerare che all’aumentare della lunghezza della sonda aumenta la specificità della reazione, mentre al suo

diminuire aumenta la sensibilità. È necessario effettuare diverse prove ad ogni esperimento al fine di determinare il giusto equilibrio

tra le due variabili.

In entrambe le tipologie di array gli acidi nucleici sono disposti

ordinatamente utilizzando un sistema automatizzato x-y-z

estremamente preciso, in migliaia di spot dal diametro di circa

vantaggio di array così densi, consiste nella richiesta di

piccolissimi volumi per l’ibridazione e quindi di pochissimo

materiale di partenza per l’analisi. I primi array contenevano meno di un centinaio di geni [6], ma si è presto passati ad array con

migliaia di geni [16, 17]. Oggi Affimetrix è in grado di posizionare su un singolo array un numero di sonde pari o superiore al numero

totale di geni presenti nel genoma umano e si propone entro pochi anni di creare array con circa 500.000 spot (il genoma umano è

costituito da circa 30.000 geni!)[13]

Rappresentazione schematica delle due differenti

tecnologie. microarray, a cDNA e oligonucleotidiche.

[Gibson, 2002 #17]

Lo studio dell’espressione genica tramite microarray è basata sul

principio dell’ibridazione competitiva di popolazioni di cDNA differentemente marcate. Marcatori fluorescenti, solitamente Cy3 e Cy5,

sono utilizzati per distinguere pool di DNA retrotrascritti da differenti campioni. Tali sonde sono posate sui microarray e sono quindi

sottoposte ad una reazioni di ligazione secondo i protocolli utilizzati per i Southern Blot. I microarray sfruttano una tecnica di

ibridazione inversa, che consiste nel fissare tutti i probe su un supporto e nel marcare invece l'acido nucleico target. È una tecnica

che è stata sviluppata negli anni '90, oggi permette l'analisi dell'espressione genica

monitorando in una sola volta gli RNA prodotti da migliaia di geni. Per studiare gli

mRNA, essi vengono prima estratti dalle cellule, convertiti in cDNA, con l’uso di un

enzima chiamato transcriptasi inversa e allo stesso momento marcati con una

sonda fluorescente. Quando si fa avvenire l'ibridazione fra la sonda presente sulla

matrice e il cDNA target, quest'ultimo rimarrà legato alla sonda e può essere

identificato semplicemente rilevando la posizione dove è rimasto legato. Il

segmento di DNA legato al supporto solido è noto come probe. Migliaia di probe

sono usati contemporaneamente in un array. Questa tecnologia è nata da una

tecnica più semplice nota come Southern blotting, dove frammenti di DNA attaccati

ad un substrato sono testati da sonde geniche aventi sequenze conosciute. I

microarray possono essere fabbricati usando diverse tecnologie, come la stampa di

micro solchi, con un particolare microspillo appuntito su una lastrina di vetro dove verrà attaccata covalentemente la sonda (probe) di

materiale genetico ottenuta per clonazione sfruttando la tecnica PCR; usando maschere preformate da ditte specializzate come ad

esempio da Greiner Bio-One.

14

Quaderni di Bioinformatica

La sintesi in situ di oligonucleotidi presenta un certo numero di vantaggi rispetto a quella precedentemente vista. I prodotti di questa

sintesi hanno caratteristiche di omogeneità e alta qualità su tutte le celle che compongono l’array su cui vengono sintetizzati, con

varie metodologie, oligonucleotidi diversi. Esistono differenti metodi di posizionamento delle sonde sulla superficie dell’array. Il

metodo più conosciuto combina tecniche fotolitografiche usate nell’industria dei semiconduttori a tecniche di sintesi in fase solida, per

ibridare direttamente su un wafer di quarzo le sonde oligonucleotidiche di lunghezza desiderata (di solito 25 nucleotidi). Questo tipo di

tecnologia è derivata direttamente dagli studi fatti da Foder che ha usato tecniche di fotolitografia per la sintesi chimica in situ di

materiale biochimico direttamente su silicio.

La fabbricazione ad esempio del Gene Chip Affimetrix parte da un wafer di quarzo di pochi centimetri quadrati. Poiché il quarzo è un

materiale idrossilato naturalmente, esso fornisce un eccellente substrato per l’attacco di elementi chimici. Su di esso sono quindi

posizionate molecole di collegamento sintetiche (molecole “linker”) modificate con gruppi di protezione rimovibili fotochimicamente

che serviranno successivamente per posizionare le sonde sull’array. La distanza fra queste molecole “linker” determina la densità di

riempimento delle sonde. Con questo metodo è possibile costruire array con più di 500 mila locazioni (o celle) per le sonde contenute

in 1.28 cm2. Ciascuna di queste locazioni contiene milioni di molecole identiche di DNA (diverse per ciascuna locazione). La parte

critica di questo processo è la fase di allineamento della maschera con il wafer prima di ciascun passo di sintesi. Per assicurare che

questo passo sia accuratamente completato, le tracce di cromo presenti sul wafer e sulla maschera devono essere perfettamente

allineate. Una volta che le locazioni sono state attivate, una soluzione contenente un singolo tipo di desossinucleotidi è gettata sulla

superficie del wafer e i nucleotidi si attaccano ai “linker” attivati con un accoppiamento chimico, dando inizio al processo di sintesi. Il

processo è efficiente anche se talvolta l’aggancio non è perfetto. In tal caso le sonde con il nucleotide mancante vengono

opportunamente “incappucciate” per bloccarne la crescita. Nel passo successivo di sintesi, un’altra maschera è posizionata sopra il

wafer per permettere un ulteriore ciclo di deprotezione e accoppiamento. Il processo è ripetuto fino a che le sonde non raggiungono la

lunghezza voluta. Sono stati creati opportuni algoritmi che permettono di minimizzare il numero di maschere utilizzate coordinando la

crescita delle sonde nelle diverse locazioni, individuando situazioni in cui più maschere possono essere utilizzate nello stesso tempo.

Una volta completata la sintesi, i wafer sono tagliati; in funzione del numero di locazioni delle sonde per array, da un singolo wafer, è

possibile produrre tra 49 e 400 array. I risultanti singoli array sono quindi inseriti in apposite cartucce in cui può circolare la matrice

biologica da analizzare, opportunamente marcata, si tratta sostanzialmente di un sistema chiuso.

Esistono anche strategie non proprietarie che consentono il posizionamento del clone nell'esatta locazione sul vetrino da un robot. Il

supporto dell’array, che inizialmente era costituito da membrane di nylon o nitrocellulosa, è realizzato quasi esclusivamente con

vetrini da microscopio. L’utilizzo del vetro presenta i seguenti vantaggi:

- i campioni di DNA possono essere legati covalentemente sulla sua superficie opportunamente trattata (con poly-L-lisina);

-è un materiale duraturo che sopporta alte temperature;

-è un materiale non poroso e quindi il volume di ibridazione può essere minimizzato consentendo un miglior ancoraggio delle sonde e

una minore diffusione del DNA depositato;

-come conseguenza della sua bassa fluorescenza intrinseca, esso non da contributi significativi al rumore di fondo durante la

rivelazione.

CHIMICA DELLE SUPERFICI

I primi tentativi di fissare biomolecole su membrane di nylon o cellulosa, eseguiti nel trascorso decennio, puntando all'adsorbimento

elettrostatico, hanno portato a risultati molto scadenti. Lo stesso è successo utilizzando superfici a base di poliacrilamide. I primi

risultati accettabili si sono avuti ricoprendo le superfici con del destrano carbossilmodificato, trattamenti chimici delle superfici più

usati per gli acidi nucleici sono a base di organosilani: sono composti che contengono atomi di silicio che si sono dimostrati molto

validi per legare molecole organiche a superfici di vetro. Le molecole utilizzate per fissare alle superfici gli acidi nucleici sono state

utilizzate con discreto successo anche per le proteine.

La qualità delle superfici ha un' importanza enorme nella produzione di microarray che possano essere usati per eseguire delle

analisi ed ottenere risultati riproducibili. Infatti le superfici dei vetrini che si adoperano giocano un ruolo importantissimo nel

determinare non solo come le molecole probe ci si attaccano ma anche per far si che le reazioni che ci si svolgono, possano evolvere

senza problemi o inconvenienti. Riteniamo pertanto utile elencare le qualità essenziali che microarray ideali dovrebbero avere per

poter operare bene:

Dimensione. L'ampiezza delle superfici operative dipendono ovviamente dalle dimensioni del supporto. Come già abbiamo

accennato, ora si preferisce operare su vetrini porta oggetto le cui dimensioni ottimali sono in larghezza, lunghezza e

spessore 25-76-0,94 mm. Tale dimensione standard facilita sia l'automazione della produzione che tutte le fasi operative di

utilizzazione che si concludono con la lettura dei risultati.

15

Quaderni di Bioinformatica

Liscia. La superficie di lettura deve essere omogenea e liscia. Non sono accettabili irregolarità in eccesso o in difetto superiori ai 10