POLITECNICO DI MILANO

Corso di Laurea in Ingegneria per l’Ambiente e il Territorio

Analisi dell'umidità al suolo ed

in quota: una applicazione sull'Europa

Relatore: prof. Antonio Ghezzi

Elaborato di laurea di:

Stefano Nardin

Matr. 755789

Giacomo Varisco

Matr.755899

Anno accademico 2012/2013

Dopo un percorso lungo e faticoso siamo giunti al punto in cui si

vede la meta.

Per questo dobbiamo ringraziare molte persone, che in modi

diversi ci sono state vicino, ci hanno sostenuto, ci hanno aiutato, ci

hanno dato la forza quando credevamo di averla esaurita.

Un ringraziamento particolare va al Professor Antonio Ghezzi,

senza il quale non saremmo mai riusciti a fare questo lavoro, che

ci ha dato consigli, ci ha permesso di imparare e di crescere

attraverso la sua professionalità.

Ringraziamo inoltre tutte le persone e le istituzioni che hanno

collaborato al lavoro di tesi.

Sentitamente grazie.

Stefano Nardin

Giacomo Varisco

Indice

1 INTRODUZIONE ……………………………………………………………………………… 1

2 L’UMIDITÀ ………………………………………………………………………….………. 4

2.1 L’umidità atmosferica …………………………………………………….…. 4

2.2 Umidità assoluta, specifica e relativa …………………………………. 4

2.3 La condensazione del vapore acqueo …………………………….....… 6

2.4 La formazione delle nubi ………………………………………………..…. 7

2.4.1 Cause meteorologiche della formazione

delle nubi ……………………………………………………..…. 9

2.4.1.1 Sollevamento convettivo ………………………. 10

2.4.1.2 Sollevamento ciclonico ………………………… 11

2.4.1.3 Sollevamento orografico o forzato ……….… 12

2.4.1.4 Sollevamento frontale ………………………..…. 13

2.4.2 Formazione delle gocce e dei cristalli

di ghiaccio nelle nubi …………………………………….… 13

2.4.3 Tipi di nubi ……………………………………………………..... 15

2.5 Meccanismo di formazione delle precipitazioni ………………... 18

2.5.1 Accrescimento per condensazione ………………………. 19

2.5.2 Accrescimento per coalescenza …………………………… 20

2.5.3 Accrescimento dei cristalli di ghiaccio:

processo di Bergeron – Findeisen……………………... 24

2.5.4 Tipologie di precipitazione ……………………………….….. 27

2.6 Termodinamica atmosferica ………………………………………..…... 29

2.6.1 Termodinamica dell’aria secca ………………………….… 29

i

2.6.1.1 I sistemi termodinamici e l’equazione

di stato dei gas perfetti ………………….…... 29

2.6.1.2 L’equazione di stato per l’aria secca …….… 32

2.6.1.3 Il primo principio della

termodinamica per l’aria secca …………..… 33

2.6.1.4 Il gradiente termico verticale

dell’atmosfera ………………………………….... 34

2.6.2 Termodinamica dell’aria umida ……………………….... 35

2.6.2.1 Trasformazioni adiabatiche

per l’aria umida ………………………………..… 35

2.6.2.2 L’equazione di stato per l’aria umida ……... 37

3 GLI STRUMENTI DI MISURA DELL’UMIDITÀ DELL’ARIA ……………... 41

3.1 Igrometri diretti ………………………………………………………….….. 43

3.1.1Igrometri meccanici ……………………………………....….. 43

3.1.2 Igrometri elettrici ………………………………………..….…. 45

3.1.3 Altri sensori diretti ……………………………………………. 52

3.2 Igrometri indiretti ………………………………………………………..…. 53

3.2.1 Igrometri a specchio condensante …………………….…. 53

3.2.2 Psicrometri ………………………………………………………… 57

3.2.3 Igrometri a sali saturi …………………………….…….…….. 61

3.2.4 Igrometri elettrolitici ……………………………..…….….. 63

3.2.5 Altri sensori indiretti ……………………………….……….... 64

3.3 Criteri di scelta degli strumenti di misura ……………………...….. 65

3.4 Il telerilevamento ……………………………………………………..……… 68

3.4.1 Uso dello spettro elettromagnetico

nel telerilevamento ………………………………………….….. 71

ii

3.4.2. Classificazione dei sensori …………………………..…… 73

4 IL CLIMA IN EUROPA …………………………………………………………………… 76

4.1 I climi e le macro regioni europee ………………………………....… 77

4.1.1 Clima e ambiente Atlantico ………………………………….. 82

4.12 Clima e ambiente Mediterraneo …………………………… 83

4.1.3 Clima e ambiente continentale …………………………….. 85

4.1.4 Clima e ambiente artico ……………………………………... 88

4.1.5 Clima dell'ambiente alpino ……………………………….... 89

5 L’APPLICAZIONE …………………….………………………………………………….… 91

5.1 Visualizzazione e preparazione dato ………………………..........… 95

5.2 Elaborazioni ……………………………………………………...………...… 97

6 DISTRIBUZIONI DI PROBABILITA’ ……………………………..……………... 104

6.1 La variabile casuale ………………………………………..………………... 104

6.2 Distribuzione normale o gaussiana ………………….………….......... 106

6.3 Distribuzione lognormale ……………………………….………………... 110

6.4 Distribuzione gamma …………………………………….……………….... 111

7 IL SOFTWARE R …………………………………………………………………..…… 113

7.1 Importazione dei dati in R ………………………………….……….. 113

7.2 Adattamento ad una distribuzione nota ………………………... 114

7.2.1 Test di Komogorov – Smirnov …………………….….. 116

7.2.1.1 Risultati test Komogorov – Smirnov …… 117

7.3 Analisi di omogeneità della varianza ………………...…….…… 121

iii

7.3.1 Risultati del test di omogeneità della varianza …..…. 121

8 CONCLUSIONI ……………………………………………………………………….…. 125

8.1 Sviluppi futuri ……………………………………………………………… 128

APPENDICE 1 ………………………………………………………………………………… 130

A1.1 NCAR …………………………………………………………………………… 130

APPENDICE 2 ………………………………………………………………………………… 133

A2.1 BIOMI ……………………………………………………………………….….. 133

APPENDICE 3 ……………………………………………………………………………….…140

A3.1 CLIMA DETTAGLIATO PER ALCUNI DEI PRINCIPALI PAESI

EUROPEI ……………………………………………………………………..….….… 140

APPENDICE 4 ………………………………………………………………………………… 145

A4.1 SOFTWARE R ………………………………………………………………. 145

iv

1

Introduzione

La ricerca di una possibile correlazione con la tematica del cambiamento

climatico, il legame con la nubi ed il loro ruolo di filtro verso le radiazioni , la

fondamentale influenza sulla conservazione di cibo ed oggetti, la capacità di

condizionare in modo sostanziale la qualità della vita in ambienti di

quotidiana frequentazione potendo determinare criticità per la salute ed il

benessere della persona; queste son solo alcune delle motivazioni che hanno

spinto e sostenuto il nostro lavoro e i nostri sforzi spingendoci ad investigare

e caratterizzare il comportamento dell’umidità al variare di alcune condizioni

al contorno.

L’obiettivo dichiarato della nostra analisi è svolgere una valutazione critica di

come, e se, i diversi regimi di umidità varino in funzione alcuni parametri

come latitudine, longitudine, quota e di come siano variati nel tempo, così da

poter

individuare

legami e corrispondenza tra fattori geografici e/o

temporali e la risposta atmosferica in termini di umidità.

Per queste trattazioni abbiamo utilizzato dati di umidità relativa circoscritti,

per motivi di onerosità delle trattazioni, ad una superficie europea, estesa a

sud a tutto il nord Africa desertico e ad ovest al primo tratto di oceano

atlantico.

L’umidità, parametro atmosferico complesso e continuo, è la misura della

quantità di vapore acqueo presente in atmosfera (o in generale in una massa

d'aria).

Uno studio critico ed esaustivo della sua distribuzione, spaziale ed in quota,

può sicuramente essere punto di partenza per migliorare e approfondire la

comprensione dei fenomeni di nuvolosità.

1

La presenza di vapore acqueo nell’atmosfera infatti, risulta determinante per

la formazione delle nubi stesse. Nubi che sappiamo essere elemento

fortemente condizionante rispetto al clima.

Esse svolgono infatti un’importante e duplice funzione: di filtro rispetto alle

radiazioni solari e di luogo formazione e sviluppo delle gocce destinate alle

precipitazioni.

Ciò conferma ulteriormente l’importanza dell’umidità quale fattore

meteorologico in grado di influenzare fortemente la climatologia e quindi la

vita quotidiana.

Il clima dipende infatti, oltre che da fattori geografici locali e morfologici,

anche dai movimenti delle masse d’aria sul territorio. Lo scontro di masse

d’aria con caratteri di umidità e temperatura distinti determina la formazione

di cicloni ed anticicloni, permanenti e stagionali che governano la

climatologia delle piogge in Europa come nel resto del mondo.

L’umidità, ha sempre condizionato l’uomo e la sua quotidianità sia per la

conservazione di oggetti che di alimenti.

Ciò ha fatto si che fin dall’antichità si sia cercato di capire e misurare questo

fenomeno.

I primi tentativi documentati di misura “strumentale” della umidità risalgono

al 1430 circa quando Nikolaus Chrypffs (Cusano) (1401-1464) inventa il

primo strumento meteorologico. Una sorta d’igrometro con il quale cercò di

determinare il grado di umidità dell’aria pesando delle palle di lana. Nel 1500

circa quindi, Leonardo Da Vinci (1452-1519) costruisce un anemoscopio e un

indicatore meccanico dell’umidità. Nel Codice Atlantico, una raccolta di 393

carte autografate da Leonardo e raccolte da Pompeo Leoni (1533-1608), ci

sono schematizzati questi strumenti.

Nonostante la precocità dell’interesse scientifico per questo tema, risulta

tuttora molto difficile trovare serie storiche di umidità complete e di

lunghezza considerevole, se non puntualmente per stazioni isolate.

2

Tuttavia l’umidità, essendo un parametro poco variabile, può giustificare, a

seconda delle finalità dell’analisi, un utilizzo di serie di lunghezza limitata,

cosa ingiustificata qualora si fosse trattato di un parametro caratterizzato da

forte discontinuità, come ad esempio le precipitazioni.

Per l’analisi da noi effettuata sono stati utilizzati dati globali dal 1979 al 2010.

Si è rivelato necessario avvalersi di considerazioni statistiche che ci

aiutassero e permettessero di descrivere e caratterizzare almeno in parte i

nostri campioni, verificandone l’adattabilità a distribuzioni note e

valutandone l’omogeneità, in riferimento ovviamente alle condizioni locali di

tipo morfologico e climatico.

3

2

L’umidità

2.1 L’umidità atmosferica

L'umidità atmosferica è determinata dalla quantità di vapore acqueo

presente nell'aria. Le radiazioni solari riscaldano l'acqua e la superficie

terrestre generando l'evaporazione dell'acqua sotto forma di vapore acqueo

che dà vita a diversi fenomeni atmosferici (nubi, nebbia, pioggia, ecc.). Il

vapore acqueo contribuisce alla formazione delle nubi, tramite il fenomeno

della condensazione, e al funzionamento del ciclo dell'acqua dalla fase iniziale

di evaporazione alla fase finale delle precipitazioni piovose.

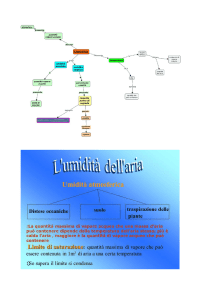

2.2 Umidità assoluta, specifica e relativa

Vari sono i parametri significativi quando si parla di umidità:

Umidità assoluta: è la quantità di vapore acqueo espressa in grammi

contenuta in un metro cubo d’aria. L'umidità assoluta aumenta

all'aumentare della temperatura, l'umidità di saturazione aumenta più

che proporzionalmente quindi l'umidità relativa tende a scendere.

Quando un abbassamento di temperatura porta a far coincidere

l'umidità assoluta con quella di saturazione si ha una condensazione

del vapore acqueo e il valore termico prende il nome di temperatura

di rugiada. In corrispondenza di questo valore se si ha una superficie

fredda si ha la rugiada (brina a valori sotto lo zero), se la

condensazione riguarda uno strato sopra il suolo si ha la nebbia.

È un valore poco apprezzabile e per questo si preferisce l'utilizzo

dell'umidità specifica. L'umidità assoluta può essere espressa in

4

termini di massa di acqua per volume di atmosfera o in pressione

parziale relativa del vapore rispetto agli altri componenti atmosferici

(kg/m³ o Pa).

Umidità specifica: è il rapporto della massa del vapore acqueo e la

massa d'aria umida; in letteratura si può trovare anche un'altra

definizione: rapporto tra la massa del vapore acqueo e la massa d'aria

secca. In termodinamica si preferisce questa seconda definizione

perché, rapportandosi alla massa d’ aria secca, questa non varierà mai

nei normali processi termodinamici (sopra la temperatura di 132 K),

al contrario della massa di aria umida (per esempio: con la

condensazione del vapore nell'aria umida, il fluido può essere

facilmente sottratto).

Umidità relativa: indica il rapporto percentuale tra la quantità di

vapore contenuto da una massa d'aria e la quantità massima (cioè a

saturazione) che il volume d'aria può contenere nelle stesse condizioni

di temperatura e pressione. Alla temperatura di rugiada l'umidità

relativa è per definizione del 100%. L'umidità relativa è un parametro

dato dal rapporto tra umidità assoluta e l'umidità di saturazione. È

svincolato dalla temperatura e dà l'idea del tasso di saturazione del

vapore

atmosferico,

e

delle

ripercussioni

sui

fenomeni

evapotraspirativi delle colture. Il deficit di saturazione è dato dalla

differenza tra umidità assoluta e umidità di saturazione.

Esempio: se una massa d'aria ha una temperatura propria, ad

esempio, di 15 °C con una quantità di umidità relativa pari al 50%,

affinché tale umidità possa raggiungere il 100% (saturazione) a

pressione costante, e, magari depositarsi (condensazione) sarà

necessario abbassare la temperatura della massa d'aria, ad esempio,

di 5 °C, portarla cioè da 15 °C a 10 °C.

L’aria si definisce satura quando ha raggiunto la quantità massima di vapore

che può contenere a quella temperatura. Quando è pura e non ci sono nuclei

5

di condensazione, può contenere una quantità di vapore superiore al limite di

saturazione condizione che si definisce soprassatura.

L’umidità, caratterizzata da una limitata variabilità, pur essendo una

grandezza tipicamente puntuale, può essere considerata una grandezza

estensiva.

Ciò permette di estendere concettualmente un valore puntuale ad un intorno

areale stabilito, consentendo di inquadrare l’umidità entro i confini della

teoria della meccanica del continuo.

Figura 2.1 Andamenti dell’ umidità relativa in funzione della

temperatura

2.3 La condensazione del vapore acqueo

Volendo trattando in modo rigoroso il tema dell’umidità non si può

prescindere dal considerare ed introdurre alcuni dei fenomeni meteorologici

maggiormente collegati ad essa: nubi e precipitazioni.

Le nubi sono infatti agglomerati visibili di particelle d’acqua allo stato liquido

(goccioline) o solido (cristalli di ghiaccio) in sospensione nell’atmosfera,

principalmente in troposfera.

6

Il loro aspetto è in continua evoluzione e trasformazione perché sono sempre

in perenne movimento e cambiamento di stato.

Una nube è un insieme di centinaia di microscopiche gocce per centimetro

cubo con un raggio all’incirca di 10 micron. Le dimensioni tipiche sono,

infatti, dell’ordine di 10-102 micron, mentre la concentrazione (numero di

gocce per litro d’aria) varia tra 103 e 107 in funzione delle dimensioni. Con

queste dimensioni e concentrazioni il conglomerato è otticamente opaco alle

lunghezze d’onda visibili per effetto della diffusione della luce e viene così,

per contrasto, riconosciuto come nube.

Le precipitazioni hanno luogo quando la nube diventa instabile, quando, cioè,

alcune gocce iniziano ad accrescersi a scapito delle altre.

In atmosfera, e principalmente nella troposfera, l’aria ha un contenuto di

vapore nella percentuale massima del 4% in volume, con importanti

variazioni sia nello spazio che nel tempo. Sebbene quindi la sua

concentrazione sia piuttosto modesta, il suo ruolo è fondamentale in

numerosi processi che avvengono in atmosfera.

La sua importanza è legata al fatto che è l’unico tra i gas atmosferici a subire

cambiamenti di fase nell’intervallo di pressioni e temperature che si

incontrano in atmosfera.

Inoltre, i calori latenti per i suoi cambiamenti di fase hanno valori molto

elevati, determinando importanti scambi di calore con l’aria e, di

conseguenza, sensibili variazioni di temperatura.

2.4 La formazione delle nubi

La formazione delle nubi è sempre legata a un processo di condensazione o di

sublimazione del vapore acqueo presente nell’atmosfera, che dà origine alle

goccioline o ai cristalli di ghiaccio.

Da un punto di vista termodinamico, perché si abbia condensazione o

sublimazione del vapore devono innanzitutto essere state raggiunte le

condizioni di saturazione. Se in una data massa d’aria in condizioni di

saturazione, l’umidità aumenta ulteriormente, quella in eccesso condensa

7

sotto forma di goccioline. Affinché il processo possa continuare con

formazione di quantità sufficienti di gocce o cristalli per la formazioni della

neve, e in modo che queste rimangano stabili (senza evaporare), le condizioni

di saturazione devono essere mantenute abbastanza a lungo.

La saturazione di una massa d’aria, e quindi la condensazione del vapore, può

essere raggiunta o mediante il raffreddamento dell’aria umida o attraverso

l’umidificazione della massa d’aria.

La maggior parte delle nubi sono causate da processi di raffreddamento.

Al diminuire della temperatura l’aria si avvicina alla saturazione essendo

minore la quantità di vapore che vi può essere contenuta.

Da un punto di vista termodinamico il raffreddamento di una massa d’aria

può essere ottenuto mediante i seguenti processi:

raffreddamento isobarico;

raffreddamento adiabatico o espansione adiabatica.

Nel raffreddamento isobarico la massa d’aria rimane alla stessa pressione e

viene raffreddata con processi diabatici, ovvero tramite perdita di calore

verso il sistema esterno (suolo o masse d’aria adiacenti). La temperatura, nel

diminuire, può arrivare ad eguagliare la temperatura di rugiada,

determinando così le condizioni di saturazione:

T Td => U 100%

Nel caso del raffreddamento adiabatico si suppone invece che non vi sia

scambio di calore fra la massa d’aria e l’ambiente circostante.

Affinché la temperatura della particella d’aria possa diminuire, senza che vi

sia apprezzabile scambio di calore con l’aria circostante, deve o diminuire la

pressione oppure aumentare il volume.

Di fatto il raffreddamento adiabatico è prodotto dal sollevamento della massa

d’aria: incontrando pressioni via via minori (la pressione atmosferica

8

diminuisce con la quota), essa subirà un processo di espansione adiabatica

con conseguente raffreddamento. Anche sollevamenti che durano ore

possono essere considerati adiabatici poiché l’aria è un cattivo conduttore di

calore. La saturazione interviene nel momento in cui la temperatura scende

fino a eguagliare la temperatura di rugiada.

L’apporto di umidità dall’ambiente esterno, in condizioni isotermiche è il

secondo processo che può portare alla saturazione.

Supponendo costante la temperatura, l’apporto di umidità fa aumentare il

valore di q, che può cosi raggiungere il suo valore massimo. Quando ciò

avviene la massa d’aria umida raggiunge il suo punto di saturazione.

L’aumento di umidità è un processo di scambio del vapore che può avvenire o

tra una superficie umida (ad esempio marina) e la massa d’aria sovrastante o

per rimescolamento di due masse d’aria con caratteristiche termodinamiche

differenti.

Nel primo caso, sono le leggi di trasporto turbolento nello stato limite a

governare lo scambio di vapore dalla superficie verso la massa d’aria. La

velocità di tele scambio è funzione sia del grado di umidità della massa d’aria

che dell’intensità del vento.

Nel caso del rimescolamento sono le condizioni termodinamiche delle due

masse d’aria che vengono a contatto a determinare il grado di umidità e il

possibile stato di saturazione della massa d’aria risultante.

2.4.1 Cause meteorologiche della formazione delle nubi

Diverse possono essere le condizioni meteorologiche che nella troposfera

danno luogo alle trasformazioni termodinamiche appena descritte.

Il raffreddamento isobarico è un fenomeno che avviene di frequente e che

porta sia alla formazione di nubi che di nebbie.

Nel caso della nebbia è la superficie terrestre (suolo o mare), che si suppone

più fredda (per irraggiamento o perché gelata nel primo caso, per la maggior

inerzia termica rispetto all’aria nel secondo), a sottrarre calore alla massa

9

d’aria sovrastante. E’ cosi che, in presenza di aria stagnante, cielo sereno e

calma di vento, si formano foschie e nebbie notturne. Se la saturazione viene

raggiunta soltanto nei primi 20-50 cm di aria adiacenti al suolo si ha la

formazione di rugiada (se T > 0°C) o di brina (T < 0°C).

Nel caso di formazione delle nubi il raffreddamento avviene per

irraggiamento dello strato d’aria umido verso strati superiori più secchi e

trasparenti alla radiazione termica. Anche in questo caso il processo può

durare poche ore e dar luogo a nuvolosità stratiforme.

Il raffreddamento adiabatico è prodotto dal sollevamento della massa d’aria.

Ricordiamo che una massa d’aria non satura e in movimento verticale verso

l’alto si raffredda di circa 1 grado ogni 100 metri.

Se l’aria è sufficientemente umida il raffreddamento dà luogo, a una certa

quota (base della nube), alla condensazione del vapore sotto forma di nubi, le

quali seguitano a svilupparsi verso l’alto fin dove persistono il moto verticale

e le condizioni di saturazione che l’hanno originata.

I moti verticali ascendenti possono insorgere per quattro distinte cause:

convezione;

convergenza e divergenza;

ostacolo orografici;

fonti.

2.4.1.1 Sollevamento convettivo

Il sollevamento convettivo si ha quando la massa d’aria viene sospinta verso

l’alto dalla forza di galleggiamento (forza di Archimede), determinata da

condizioni di inabilità termica rispetto all’ambiente circostante.

Dai terreni maggiormente riscaldati dal sole (un campo arato, una vasta area

edificata o un suolo roccioso) si staccano, nelle ore centrali della giornata,

“bolle” d’aria calda che, per via della loro minore densità rispetto

all’ambiente circostante, vengono sospinte verso l’alto. In questo modo si

10

originano delle correnti ascendenti (moti convettivi), le cui velocità verticali

sono in genere abbastanza intense (2-10 m/s).

Se la massa d’aria è sufficientemente umida. Raggiunto un certo livello

(livello di condensazione), essa condenserà dando inizio alla formazione

della nube.

A questo punto il processo di condensazione, liberando il calore latente di

evaporazione, contribuirà a riscaldare ulteriormente la massa d’aria, che

acquisterà così una maggior instabilità: il moto convettivo può, cosi, spingersi

fino a notevoli altezze (anche 10-12 km fino ai limiti della troposfera),

portando alla formazione di nuvole a forte sviluppo verticale quali cumuli e

cumulonembi. A distanza di molte centinaia di metri, l’aria calda riscende al

di sopra delle aree più fresche, quali ad esempio il boscoa adiacente al campo

arato o il prato che circonda il villaggio.

2.4.1.2 Sollevamento ciclonico

Nei grandi centri barici (cicloni, anticicloni, promontori, saccature) l’aria è

costantemente animata da lenti movimenti verticali (dell’ordine di pochi

centimetri al secondo) i quali sono ascendenti sulle aree di bassa pressione e

discendenti su quelle di alta.

La causa di innesco di un ciclone è la parziale fuoriuscita orizzontale di aria

(divergenza) in corrispondenza dei rami ascendenti (sud-occidentali) del

getto polare. La divergenza nell’atmosfera genera un calo di pressione al

suolo e un risucchio di aria verso l’alto per colmare il vuoto creatosi. La

diminuzione di pressione al suolo richiama sul luogo aria dalle zone

adiacenti: la convergenza dell’aria sul luogo di diminuzione della pressione

causa infine i moti verticali ascendenti.

Queste correnti verticali producono un raffreddamento sulle aree di bassa

pressione e un riscaldamento su quelle di alta pressione (fenomeno della

subsidenza).

Il raffreddamento associato alle depressioni raramente supera 1-2°C in 12

ore, però è quasi sempre accompagnato da condensazione del vapore acqueo.

11

2.4.1.3 Sollevamento orografico o forzato

Il sollevamento forzato si ha quando una massa d’aria in movimento

orizzontale è costretta a sollevarsi di fronte a un ostacolo orografico

(ascendenza orografica forzata).

Le velocità di sollevamento sono dell’ordine di 0,5-1 m/s, con una

diminuzione di temperatura nell’unità di tempo superiore a quella rilevata

nei grandi centri barici.

Il raffreddamento in genere causa la condensazione del vapore acqueo con

estese formazioni nuvolose e precipitazioni sul lato sopravento.

Se in partenza l’aria è non satura il suo iniziale moto di ascesa avviene lungo

un’adiabatica secca, raffreddandosi di 1°C ogni 100 metri, fino al livello in cui

tale raffreddamento non produce la condensazione: il calore liberato dalla

condensazione produce attenua il raffreddamento dell’aria in ascesa. Il

sollevamento prosegue ora secondo l’adiabatica satura con un gradiente

termico che dipende dai valori iniziali di temperatura, umidità specifica e

velocità ascensionale. Un valore realistico per tale gradiente termico è di

0,6°C ogni 100 metri. Il movimento ascendente dell’aria sul lato sopravento

di una catena montuosa (ad esempio le Alpi), con formazione di nubi e

precipitazioni, viene denominato Staü. In tale fase le abbondanti

precipitazioni essiccano la massa d’aria in ascesa. Quando poi questa

travalica sul versante sottovento, nel loro moto discendente, subisce un

riscaldamento per compressione adiabatica di 1°C ogni 100 metri.

Tale guadagno di calore, non dovendo essere utilizzato per far rievaporare le

nubi formatesi nella fase di ascesa (le masse d’aria sono ormai secche), viene

assorbito interamente dalla massa d’aria, che pertanto giunge al suolo più

calda e secca (venti fo Föhn) di quanto non fosse in origine.

12

2.4.1.4 Sollevamento frontale

Si parla di sollevamento frontale quando la componente verticale del moto ha

origine dallo scontro di masse d’aria di diversa provenienza e quindi con

caratteristiche termodinamiche differenti.

Una massa d’aria calda in movimento verso una zona occupata da aria più

fredda è costretta a scivolare sopra quest’ultima. Il fronte caldo è la linea

ideale che delimita al suolo l’invasione di aria calda verso aree prima

occupate da aria fredda.

Viceversa aria fredda in movimento verso regioni occupate da aria calda si

incunea sotto quest’ultima, sollevandola con violenza. Il fronte freddo è la

linea che delimita al suolo l’irruzione di aria fredda verso aree prima

occupate da aria più calda.

2.4.2 Formazione delle gocce e dei cristalli di ghiaccio nelle nubi

Il Raggiungimento delle condizioni di saturazione, attraverso i processi

termodinamici determinati dalle condizioni meteorologiche sopra descritte,

non è però sufficiente per la formazione delle goccioline e quindi delle nubi.

Ogni giorno dalla superficie terrestre evaporano nell’atmosfera 1000 miliardi

circa di tonnellate d’acqua.

Il vapore liberato da oceani, mari, laghi, fiumi e vegetazione viene trasportato

verso l’alto dalle correnti aeree ascendenti. Nell’ascesa l’aria si raffredda, per

espansione adiabatica, fino a raggiungere, prima o poi, la saturazione. A

questo punto sarebbe naturale attendersi che, qualora l’ascesa prosegua,

l’ulteriore raffreddamento determini l’unione delle molecole di vapore

eccedente generando in tal modo le goccioline della nube (droplet). In realtà

il processo non è così semplice e spontaneo, perché la neonata goccia tende a

disgregarsi per evaporazione tanto più rapidamente quanto più è piccola. In

particolare, in condizioni di saturazione, due molecole di vapore potrebbero

restare unite soltanto per un cento milionesimo di secondo; per la

formazione di una goccia di 3 molecole, la terza dovrebbe incontrare le altre

13

in tale brevissimo lasso di tempo e il terzetto risulterebbe poi 100 volte più

durevole, e così via.

Nelle nubi ogni goccia contiene in media 500 miliardi circa di molecole

d’acqua.

Come è stato possibile metterle tutte insieme? Si potrebbe supporre che là

dove si è generata la gocciolina vi siano stati, in tempi brevissimi, miliardi di

urti molecolari casuali. Ma si può dimostrare che un simile evento sarebbe

possibile soltanto se il numero di molecole di vapore fosse di gran lunga

superiore a quello che si riscontra abitualmente in natura in condizioni di

saturazione. In particolare, in 1 cm3 di aria, si formerebbe una goccia ogni

1000 anni se la concentrazione di vapore fosse il triplo di quella di

saturazione, una goccia al secondo per saturazioni 4 volte superiori e 1000

gocce per concentrazioni quintuple.

Bisogna inoltre ricordare che l’equazione di Clausius-Clapeyron, che definisce

le condizioni di saturazione in funzione della temperatura, vale per il vapore

contenuto in una massa d’aria a contatto con una superficie piana di acqua

pura. Se invece il vapore saturo è in equilibrio con le goccioline di una nube,

la pressione di vapore saturo E, a parità di temperatura, deve essere

maggiore rispetto alla pressione di vapor saturo in equilibrio con la

superficie piana liquida.

Infatti la forza di coesione che tiene insieme le molecole in una goccia(la

tensione superficiale) è minore di quella su una superficie piana liquida,

cosicché le molecole di vapore riescono a fuggire più facilmente da una goccia

sferica che da una superficie piana. Pertanto, in condizioni di saturazione, il

vapore nell’ambiente, per mettersi in equilibrio con le gocce sferiche di una

nube, deve esercitare una pressione E maggiore di quella in presenza di una

superficie piana, ovvero deve essere presente in concentrazioni molto

maggiori.

Teoricamente, si può arrivare a valori elevati di sovra saturazione (U = 200 –

500%), senza che si abbia la condensazione del vapore.

14

In realtà, in natura il vapore acqueo non raggiunge mai sovra saturazioni così

elevate, e allora occorre supporre che le gocce di nube si formino con qualche

altro processo.

La sovra saturazione è una condizione di instabilità: fattori esterni possono

rompere facilmente l’equilibrio e determinare la formazione di gocce.

La presenza in atmosfera di quantità sempre largamente sufficienti di

particelle con caratteristiche igroscopiche (nuclei Igroscopici) è il motivo per

cui non si osservano mai valori elevati di sovra saturazione e la

condensazione avviene in condizioni vicine al punto di saturazione.

Gran parte delle particelle di pulviscolo atmosferico, con dimensioni

comprese tra 0,1 e 4 micron, funge da nucleo di condensazione, ovvero

agevola il “coagulo” delle molecole di vapore acqueo in microscopiche

goccioline.

In assenza di nuclei igroscopici la condensazione avviene soltanto se si

raffredda la massa d’aria satura al di sotto do -40°C oppure in presenza di

sovra saturazioni dell’ordine dell’800%.

2.4.3 Tipi di nubi

Le nubi presentano una grande varietà di forme e dimensioni. La loro

classificazione è fatta in base a:

intervallo di quote generalmente occupate nel loro sviluppo verticale;

rapporto caratteristico tra dimensioni orizzontali e estensione

verticale.

Per convenzione internazionale è stato stabilito di suddividere verticalmente

la parte dell’atmosfera, in cui le nubi si presentano abitualmente, nelle

seguenti tre regioni, con riferimento alle zone temperate delle medie

latitudini:

regione superiore, cha va da 5 a 13 km;

15

regione media, cha va da 2 a 7 km;

regione inferiore, cha va dagli strati prossimi al suolo a 2 km.

Le nubi vengono suddivise in nubi alte, nubi medie e nubi basse a seconda

che occupino quote dell’alta , della media o della bassa troposfera.

Di norma alle medie latitudini le nubi alte sono costituite solo da aghi di

ghiaccio e quelle basse da goccioline liquide. Le nubi medie possono

presentare, a seconda della quota e della latitudine, l’uno o l’altro aspetto

oppure una coesistenza delle due fasi. In genere, le nubi formate da

goccioline d’acqua hanno contorni non ben delimitati e , se abbastanza

spesse, presentano ombre proprie nella parte inferiore, le nubi costituite da

cristalli di ghiaccio hanno invece una struttura sfilacciata e contorni non ben

definiti. Con le prime si formano aureole o corone lucenti intorno al sole o

alla luna, con le seconde, per effetto della rifrazione e della riflessione dei

raggi solari o lunari, si formano gli aloni.

In

relazione al rapporto tra dimensioni orizzontali e verticali, le nubi

vengono distinte in:

Nubi cumuliformi: sono caratterizzate da dimensioni orizzontali

paragonabili al loro sviluppo verticale. In genere si presentano come

formazioni isolate associate a moti convettivi . Quando questi moti

sono particolarmente intensi l’estensione verticale della nube può

superare quella orizzontale: è il caso delle nubi temporalesche

(cumulonembi) che possono estendersi dagli stati prossimi al suolo

fino a notevoli altezze, spesso oltre la troposfera. In generale le nubi

cumuliformi si formano per una rapida ascesa di aria umida

determinata dal riscaldamento degli strati d’aria prossimi al suolo

(convezione termica), dal sollevamento forzato da un a catena

montuosa o quando aria più calda viene violentemente sollevata da

aria più fredda in veloce movimento orizzontale (fronte freddo. Le

nubi cumuliformi possono essere late, medie o basse;

16

Nubi stratiformi: le dimensioni orizzontali sono nettamente prevalenti

rispetto allo spessore verticale. Il loro aspetto è abbastanza uniforme

come conseguenza della stratificazione termica dell’aria in cui si

formano e dell’assenza di moti convettivi. Le nubi stratiformi, molto

simili agli estesi banchi di nebbia che si osservano al suolo nelle

fredde giornate autunnali e invernali, si formano per raffreddamento

isobarico di uno strato d’aria al di sotto del punto di saturazione, per

trasporto orizzontale (avvezione) di aria più calda al di sopra di uno

strato d’aria più fredda o per una lenta risalita di aria dal suolo al di

sopra di una massa d’aria più fredda (scorrimento ascendente

caratteristico di un fronte caldo). Le nubi stratiformi possono essere

alte, medie o basse;

Nubi stratocumuliformi : presentano uno sviluppo orizzontale

predominante rispetto a quello verticale, ma manifestano una

irregolarità di spessore che richiama l’aspetto delle nubi cumuliformi,

evidenziando una debole convezione in un’atmosfera essenzialmente

stabile. Possono essere medie o basse.

In generale delle nubi stratiformi si hanno precipitazione di debole o

moderata intensità, diffuse e spesso persistenti, mentre a quelle cumuliformi

sono associate precipitazioni intense, a volte violente (grandine), localizzate

nello spazio e di breve durata.

17

Tenendo anche conto della loro morfologia, le nubi sono ulteriormente

suddivise in 10 generi, descritti in figura 2.2:

TIPO

NOME

cirri

Alte

cirrocumuli

SIMBOLO CARATTERISTICHE

CI

CC

a carattere stratiforme di aspetto sottile e

filiforme

a carattere cumuliforme di piccole dimensioni

apparenti e con massa tondeggiante

a carattere stratiforme, sottili, ondulati,

CS

cirrostrati

medie

basse

altocumuli

generalmente traslucidi, separati o in piccoli

gruppi

AC

a carattere cumuliforme di piccole medie

apparente

altostrati

AS

a carattere stratiforme, traslucidi od opachi

strtocumuli

SC

a carattere stratiforme irregolare

strati

cumuli

nembostrati

cumulonembi

ST

CU

NS

CB

a carattere stratiforme e continuo molto

regolare

a carattere cumuliforme, convessi o conici

a carattere stratiforme ma di considerevole

spessore

cumuli a forte sviluppo verticale, associati a

fenomeni temporaleschi

Figura 2.2 Tipologia delle nubi

2.5 Meccanismo di formazione delle precipitazioni

Un altro fenomeno legato a doppio filo al fenomeno dell’umidità è quello della

genesi delle precipitazioni, di qualsiasi natura le si intenda.

Alla formazione della precipitazione concorrono vari fenomeni i cui

meccanismi non sono ancora stati interamente chiariti. La teoria attualmente

ritenuta valida è quella proposta nel 1933 dal meteorologo svedese Tor

18

Bergeron. Le precipitazioni possono avvenire solo quando la forza peso delle

gocce sarà maggiore della resistenza offerta dal moto ascendente che ha

portato alla formazione della nube stessa e che tende a mantenere le gocce in

sospensione.

Sono necessarie centinaia di milioni di goccioline presenti nelle nubi, che

hanno diametri dell’ordine dei 10 –

che ha invece dimensioni molto maggiori, con un diametro variabile tra i 500

essenzialmente tre: accrescimento per condensazione, accrescimento per

coalescenza e accrescimento per cristalli di ghiaccio detto processo di Bergeron

– Findeisen.

2.5.1 Accrescimento per condensazione

Il primo meccanismo ipotizzato fu l’accrescimento per condensazione.

L’ascensione delle masse d’aria umida determina la condensazione del

vapore acqueo in agglomerati d’acqua detti gocce. La formazione di una

goccia è quindi un processo non continuo che dipende dalla temperatura e

della densità dell’aria e richiede uno stadio di supersaturazione. Per questa

caratteristica il processo è detto di nucleazione ed è favorito dalla presenza di

particelle solide nell’atmosfera. In ogni caso, anche in assenza di corpi

estranei, una volta oltrepassati determinati valori di densità e temperatura si

formano delle aggregazioni casuali di molecole d’acqua. Superata la soglia

dello stato di equilibrio tra accoppiamenti e scissioni alcune tra queste

aggregazioni riescono a raggiungere una dimensione che consente di formare

un nucleo di accestimento spontaneo. Questa serie di processi richiede uno

scambio di energia importante governato dal principio di minima energia

libera.

Il processo di formazione di nuclei allo stato solido con formazione di granuli

ghiacciati avviene invece per congelamento delle gocce liquide o, in caso di

temperature più basse, per sublimazione del vapore acqueo in granuli di

ghiaccio.

19

La crescita dei nuclei di aggregazione progressiva e le dimensioni finali

dipendono dalle condizioni ambientali in cui si trovano. La supersaturazione

in atmosfera non è molto alta e quindi non consente una crescita troppo

elevata delle gocce e dei cristalli di ghiaccio.

Tuttavia è stato dimostrato che questo fenomeno non può giustificare

completamente l’ingrandirsi delle gocce. Questo perché la condensazione

avviene in presenza di supersaturazione che rende attivi oltre ai nuclei

fortemente igroscopici e di grandi dimensioni, anche quelli piccoli. Quindi ne

consegue che il vapore acqueo non va ad ingrossare le gocce già formate ma

si distribuisce su un numero maggiore di nuclei.

2.5.2 Accrescimento per coalescenza

Questo meccanismo si verifica nelle nubi con temperatura superiore a 0°C e

dà luogo alle precipitazioni delle fasce intertropicali ed equatoriale. In queste

nubi sono presenti gocce molto grosse originatesi su nuclei fortemente

igroscopici – come quelli costituiti da cloruro di sodio – mescolate a

numerose gocce più piccole formatesi su nuclei di condensazione di altra

specie. Le gocce più grandi, spinte verso l’alto dalle correnti ascendenti,

collidono con quelle più piccole e le inglobano, aumentando ulteriormente le

loro dimensioni.

Fino a che le correnti ascensionali riescono a mantenere le gocce in

sospensione, queste ultime continueranno ad accrescersi per coalescenza.

Raggiunta la sommità della nube, dove le correnti sono più deboli e

divergono lateralmente, le gocce vengono trascinate verso il basso dalla forza

di gravità. Inizialmente le correnti ascendenti riescono ad arrestare la caduta

delle gocce e a spingerle nuovamente verso l’alto. Si creano così continui

saliscendi durante i quali le dimensioni ed il peso delle gocce continuano ad

aumentare.

20

Figura 2.3 Coalescenza di una goccia d’acqua

Durante la fase di caduta le gocce più grandi collidono con solo una parte

delle goccioline incontrate sul loro cammino perché alcune di esse vengono

allontanate dal flusso d’aria che si genera attorno alla goccia più grande.

Figura 2.4 Durante la caduta le gocce più grandi collidono con una piccola parte delle gocce più piccole incontrate

sul loro cammino perché alcune di queste ultime vengono deviate dal flusso d’aria presente attorno alla goccia più

grande.

21

In realtà, la semplice collisione non garantisce il verificarsi del fenomeno di

coalescenza.

Sono infatti possibili quattro modalità di interazioni tra gocce che collidono:

Urto elastico;

Unione;

Unione temporanea e successiva separazione, in modo che le gocce

conservino le proprie caratteristiche;

Unione temporanea e successiva suddivisione in più gocce di minori

dimensioni.

Figura 2.5 Possibili modalità di collisione tra le gocce.

Il verificarsi di una determinata modalità di interazione dipende dalle

dimensioni delle gocce, dalle loro traiettorie e dalle forze elettriche che le

caratterizzano e che le circondano. Inoltre, ogni interazione può essere

descritta attraverso due parametri:

22

Efficienza di collisione, probabilità che una goccia grande possa

collidere con una più piccola incontrata sul proprio cammino;

Efficienza di coalescenza, frazione di gocce che subisce il fenomeno

della coalescenza tra quelle che collidono.

Il prodotto matematico di questi due parametri – che entrambi dipendono

sensibilmente dalle dimensioni della goccia urtante – determina il tasso di

crescita della goccia e viene detto efficienza di collezione.

Figura 2.6 Accrescimento di una goccia per coalescenza, collisione e condensazione.

Esperimenti in laboratorio indicano che l’efficienza di coalescenza si avvicina

all’intero se le goccioline sono cariche elettricamente o se si è in presenza di

un campo elettrico.

Queste condizioni si verificano quasi sempre nelle nubi, in particolar modo in

quelle a sviluppo verticale, quindi spesso l’efficienza di collezione coincide

con quella di collisione.

È quindi necessario determinare la percentuale di collisione all’interno della

popolazione delle gocce per poter descrivere il meccanismo di formazione

della precipitazione.

23

Date due gocce di raggi fissati R ed r, esiste un valore critico del parametro di

impatto, definito come la distanza tra i centri delle due gocce, entro il quale la

collisione avviene quasi sicuramente e fuori dal quale la goccia più piccola

viene deflessa dal suo cammino senza che avvenga l’urto. Sperimentalmente

è stato osservato che la massima efficienza di collisione – e quindi di

collezione – si ha quando il rapporto tra i raggi è di circa 0.6.

È stato dimostrato che il fenomeno di crescita per coalescenza è

favorevolmente influenzato dalla presenza di moti turbolenti, che

permettono alle gocce di collidere e fondersi più rapidamente di quanto non

avvenga all’interno di un’atmosfera in quiete. I vortici d’aria fanno si che le

gocce si concentrino in gruppi più densi, aumentando così la frequenza delle

collisioni.

Inoltre le gocce più grandi subiscono un ulteriore accrescimento a spese delle

gocce più piccole, a causa della differenza di tensione di vapore. Infatti le

gocce a diametro maggiore perdono meno molecole per evaporazione di

quelle a raggio minore.

Si può infine notare che lo spettro di distribuzione delle dimensioni delle

gocce risulta molto più ampio nel caso di crescita per coalescenza rispetto a

quello di crescita per condensazione.

2.5.3 Accrescimento dei cristalli di ghiaccio: processo di Bergeron –

Findeisen

Questo meccanismo si verifica nelle nubi fredde, dove la temperatura è

inferiore a 0°C, o in nubi miste, dove sono presenti sia goccioline sopraffuse

che particelle di ghiaccio.

Quando la temperatura della nuvola è sufficientemente bassa il vapore

contenuto nell’aria circostante diventa saturo rispetto all’acqua e le

goccioline non mostrano alcuna tendenza né ad accrescere né ad evaporare.

Ma la presenza degli aghetti di ghiaccio destabilizza questa situazione di

equilibrio. Questo perché la tensione di vapore in corrispondenza di

saturazione è minore sul ghiaccio rispetto all’acqua e quindi le molecole

24

d’acqua, a parità di temperatura, abbattono più facilmente una superficie

piana liquida che una ghiacciata.

Definendo il rapporto di saturazione come rapporto tra la tensione di vapore

e e la tensione di vapore saturo E, il rapporto di saturazione Si rispetto al

ghiaccio risulta:

Si = e/Ei

da cui:

Si = e/E * E/Ei = S*E/Ei

con S rapporto di saturazione rispetto all’acqua.

Poiché:

E>Ei

Si ha che:

Si>S

Il vapore in atmosfera può trovarsi in condizioni non sature rispetto all’acqua

– goccioline – ma già in condizioni di sovrasaturazione rispetto al ghiaccio –

cristalli di ghiaccio. La coesistenza di queste due condizioni favorisce un

continuo passaggio delle molecole di vapore che dalle goccioline vanno a

depositarsi sui cristalli di ghiaccio. Questi ultimi si accrescono allora

progressivamente, fino a raggiungere anche i 100 μm. A causa del loro peso,

cadono con notevole velocità urtando all’interno della nube le gocce ed i

cristalli che hanno dimensioni e velocità di caduta minori; negli urti numerosi

cristalli di ghiaccio e gocce aderiscono al cristallo più grande, congelandosi al

suo contatto. Avviene quindi nuovamente un fenomeno di coalescenza, che

porta alla formazione di grossi cristalli dalla cui unione hanno poi origine i

25

fiocchi di neve. Questi cristalli arrivano al suolo come tali se la temperatura

degli strati più bassi dell’atmosfera rimane sotto zero, mentre si trasformano

in grosse gocce d’acqua se la temperatura è superiore.

Figura 2.7a - Accrescimento di un cristallo di ghiaccio all'interno di una nube attraverso il processo di Bergeron –

Findeisen. Viene inoltre indicata la tipologia di precipitazione che raggiunge il suolo.

oppure

Figura 12.7b

26

La forma dei cristalli di ghiaccio è molto variabile. Le modalità di

accrescimento del cristallo, e dunque la sua forma finale, dipendono

essenzialmente dalle condizioni di temperatura ed umidità e dal grado di

sovrasaturazione delle masse d’aria in cui avviene la crescita e non dalla sua

forma iniziale. Infatti, quest’ultima è sempre riconducibile ad un mattoncino

esagonale.

Figura 2.8 Morfologia dei cristalli in funzione delle condizioni ambientali: temperatura e sovrasaturazione rispetto al

ghiaccio.

2.5.4 Tipologie di precipitazione

La temperatura alla quale si verifica la condensazione del vapore acqueo

nelle masse d’aria determina la tipologia di precipitazione: pioggia, neve,

grandine, nebbia, rugiada e brina.

27

Per la formazione di pioggia e neve è necessaria la presenza di granelli di

polvere sospesi nell’aria che permettano l’agglomerazione delle molecole

d’acqua. Quando la loro condensazione avviene ad una temperatura

superiore agli 0°C e il diametro della goccia supera gli 0.5 mm si ha la pioggia.

Se invece la temperatura rimane al di sotto degli 0°C, le molecole d’acqua

cristallizzano e si trasformano in ghiaccio. Questi cristalli, attraversando

strati d’aria a temperature superiori agli 0°C, fondono e si aggregano

nuovamente formando fiocchi di neve che possono raggiungere anche

dimensioni notevoli.

Un altro tipo di precipitazione è la grandine. I chicchi di grandine hanno

forma sferica e dimensioni estremamente variabili tra i 5 ed i 125 mm. Sono

costituiti da un nucleo centrale formato da un granello di polvere ed avvolto

alternativamente da uno strato di ghiaccio trasparente e da uno strato di

ghiaccio opaco. La grandine si forma quando le gocce di pioggia sono spinte

da forti correnti verso l’alto, dove ghiacciano, e poi verso il basso, dove

fondono in parte. Ad ogni saliscendi si forma un nuovo strato di ghiaccio ed il

chicco aumenta di dimensione.

Quando invece la condensazione delle molecole d’acqua presenti nelle masse

d’aria si verifica vicino al suolo si ha la nebbia.

Nella stagione calda, durante la notte, quando il suolo si raffredda

maggiormente rispetto all’aria, la condensazione delle molecole d’acqua

forma la rugiada.

Infine, nelle notti invernali, quando la temperatura si abbassa notevolmente,

le molecole d’acqua sublimano direttamente allo stato solido formando la

brina, costituita da piccoli cristalli di ghiaccio.

28

2.6 Termodinamica atmosferica

2.6.1 Termodinamica dell’aria secca

Risulta

ora

necessario

proporre

un’introduzione

a

delle

leggi

termodinamiche che governano il fenomeno umidità..

La termodinamica è quella parte della fisica che si occupa degli scambi di

energia meccanica (lavoro) e termica (calore) tra i corpi e l’ambiente che li

circonda.

Le principali leggi della termodinamica sono basilari per la comprensione dei

fenomeni dell’atmosfera, da quelli più piccoli responsabili della formazione di

una gocciolina di nube e della dispersione di un pennacchio di fumo, a quelli a

grande scala collegati alla circolazione generale atmosferica.

Uno degli scenari più semplici di analisi di questi fenomeni è sicuramente

quello di masse d’aria lontane dalla saturazione (aria secca).

2.6.1.1 I sistemi termodinamici e l’equazione di stato dei gas perfetti

Lo stato termodinamico di un sistema gassoso come l’atmosfera è

determinato dai valori delle grandezze di pressione, volume e temperatura.

Si distinguono sistemi termodinamici :

isolati (il sistema non scambia né materia né energia con l’ambiente

esterno);

chiusi (il sistema scambia materia ma non energia con l’ambiente

esterno);

aperti (il sistema scambia sia materia che energia con l’ambiente

esterno).

Se in un sistema non avviene alcun cambiamento (cioè se pressione,

temperatura, volume, composizione chimica ecc. rimangono costanti), il

sistema si dice in equilibrio termodinamico. Un sistema termodinamico

29

subisce una trasformazione termodinamica quando scambia calore e/o

lavoro (in una parola, energia) con l’ambiente che lo circonda.

Si distinguono trasformazioni:

isoterme (a temperatura costante);

isobare (a pressione costante);

isocore (a volume costante);

adiabatiche (senza scambi di calore con l’ambiente).

Nelle trasformazioni è necessario fissare per convenzione un segno (+/-) da

dare alle due grandezze calore e lavoro, per distinguere se lo scambio avviene

tra il sistema e l’ambiente o viceversa.

Il calore si assume positivo se acquistato dal sistema e negativo se ceduto dal

sistema all’ambiente, all’opposto il lavoro si assume negativo se subito dal

sistema e positivo se fatto dal sistema sull’ambiente.

Si consideri ora come sistema termodinamico un gas il cui stato sia

determinato dai valori di pressione P, volume V e temperatura T.

Si definisce perfetto (o ideale) un gas che soddisfa le seguenti condizioni:

le particelle che costituiscono il gas sono puntiformi;

tra le particelle non esistono interazioni a distanza;

gli urti tra le particelle sono elastici (cioè avvengono senza perdita di

energia)

non si manifesta alcun tipo di fenomeno elettrico

Nessun gas reale, e l’aria non fa certo eccezione, possiede questi requisiti: si

tratta di un astrazione che però ha il vantaggio di rendere più semplice lo

studio dei sistemi termodinamici gassosi.

Un gas ideale infatti ubbidisce a leggi fisiche, la cui espressione matematica

risulta di facile comprensione ed utilizzo:

30

legge di Boyle (trasformazione a temperatura costante) P*V= costante

legge di Charles (trasformazione a pressione costante) VT = α*V0*T

legge di Gay-Lussac (trasformazione a volume costante) PT = α*P0*T

dove:

VT = volume del gas alla temperatura T;

V0 = volume del gas alla temperatuta di 0°C;

PT = pressione del gas alla temperatura T;

P0 = pressione del gas alla temperatura di 0°C;

α = valore costante pari a 1/(273,15 °C).

Nelle principali leggi della termodinamica l’unità di misura adottata per la

temperatura è gradi Kelvin (K) e non Celsius (°C).

Il passaggio da una scala all’altra è molto semplice e governato da questa

semplice relazione K=°C+273,15

Le tre leggi viste sopra sono tra loro collegate e con alcuni semplici passaggi

matematici sono riassumibili in un’unica relazione detta equazione di stato

dei gas perfetti :

P*V =n*R*T

dove:

n = numero di moli del gas (una mole è la quantità di gas in cui peso in

grammi è numericamente pari al peso atomico o molecolare del gas);

R = costante di stato dei gas perfetti pari a 8,314 J/(mole*K).

Questa relazione, per quanto relativa ai gas ideali, ha un importanza

fondamentale nello studio dei sistemi termodinamici gassosi, anche perché in

molti casi il comportamento di un gas reale risulta comunque approssimabile

a quello di un gas perfetto.

31

2.6.1.2 L’equazione di stato per l’aria secca

L’aria può essere considerata con buona approssimazione come un gas

perfetto di peso molecolare M=29.

Pertanto anche per l’aria secca l’equazione di stato applicata a un numero n

di moli è espressa da:

P*V=n*R*T

con R = 8,314 J/(mole*K) = 8314 J/(Kmole*K).

Ma, essendo n = m/M (m = massa dell’aria in chilogrammi), si ha:

P*V = (m/M)*R*T = m*(R/M)*T

La quantità R/M è una costante specifica dell’aria, di solito indicata con Ra (Ra

= 287 J/(Kg.K)).

Quindi l’equazione di stato per l’aria diviene:

P*V = m*Ra*T

o, se si considera una massa d’aria unitaria,

P*V = Ra*T.

Poiché m/V = ρ (densità dell’aria), l’equazione di stato diviene:

P = ρ*Ra*T

che è l’equazione di stato per l’aria secca.

Tale relazione è molto utile per ricavare l’espressione della densità dell’aria:

ρ = P/(Ra*T)

32

2.6.1.3 Il primo principio della termodinamica per l’aria secca

Lo studio dei sistemi termodinamici ha portato alla formulazione di una delle

più importanti leggi fisiche, nota con il nome di primo principio della

termodinamica.

L’energia, in natura, non si crea e non si distrugge ma può solo trasformarsi

da una forma a un’altra.

In particolare il lavoro, fatto o subito da un sistema, ed il calore, assorbito o

ceduto, si trasformano l’uno nell’altro, o al più contribuiscono al

cambiamento dell’energia interna del sistema.

Per energia interna di un gas si intende quella forma di energia che il sistema

possiede già di per sé a causa del movimento e della posizione delle singole

molecole che lo compongono (in fisica prendono il nome di energia cinetica e

potenziale molecolare). Nei gas perfetti l’energia interna dipende

esclusivamente dalla temperatura del gas.

Tenendo conto delle convenzioni sui segni di calore e lavoro viste, il primo

principio della termodinamica per i gas perfetti, e quindi anche per l’aria

secca, si esprime simbolicamente attraverso la relazione:

ΔU = ΔQ – ΔL

dove:

ΔU è l’energia interna del sistema;

ΔQ è il calore scambiato tra sistema e ambiente;

ΔL è il lavoro scambiato tra sistema e ambiente.

Conviene ricordare che da un punto di vista matematico, il simbolo Δ (delta)

rappresenta una variazione. Così l’espressione ΔU indica la variazione

dell’energia interna del sistema e non il suo valore assoluto.

A seconda del tipo di trasformazione termodinamica, il primo principio della

termodinamica assume ovviamente espressioni diverse.

33

Trasformazione isoterma: poiché lo stato energetico di un gas è determinato

esclusivamente dalla sua temperatura, se la temperatura è costante lo è

anche l’energia del gas e si ha:

ΔU = 0; ΔQ = ΔL

Trasformazione adiabatica:

ΔQ = 0; ΔU + ΔL = 0

Trasformazione isocora:

ΔL = 0; ΔU = ΔQ

2.6.1.4 Il gradiente termico verticale dell’atmosfera

L’andamento della temperatura con la quota prende il nome di gradiente

termico verticale dell’atmosfera e assume in meteorologia un’importanza

fondamentale.

La stessa stabilità atmosferica e cioè l’attitudine dell’atmosfera nel favorire,

impedire o comunque condizionare i movimenti verticali dell’aria, dipende

direttamente da tale gradiente.

Nella troposfera la temperatura diminuisce con la quota in media di 6,5°C

circa per chilometro (atmosfera in stato subadiabatico o atmosfera

subadiabatica). Lo stato subadiabatico è la norma a quote oltre gli 800-1000

metri, mentre in prossimità del suolo raramente il gradiente termico

verticale è di 6,5 °C per chilometro perché le prime centinaia di metri di

troposfera sono influenzate dagli scambi di calore con il suolo.

Di notte, ad esempio, il raffreddamento del suolo per irraggiamento può

creare inversioni termiche dello spessore anche di 200-300 metri.

Le inversioni termiche con base al suolo possono essere immaginate come un

caso esasperato di atmosfera subadiabatica e possono essere osservate anche

nelle masse d’aria calda provenienti da più basse latitudini, quando sorvolano

34

a lungo il mare, situazione abbastanza frequente quando sui nostri bacini

soffia lo Scirocco.

Viceversa nelle ore diurne il surriscaldamento del suolo si propaga anche alla

bassa troposfera, generando, nei primi 200-800 metri, una forte diminuzione

della temperatura con la quota, fino a 10°C per chilometro (atmosfera in stato

adiabatico) o anche di più (atmosfera in stato superadiabatico). Sul mare i

gradienti termici superadiabatici si osservano solo quando una massa d’aria

abbastanza fredda sorvola un mare più caldo, una situazione, anche questa,

abbastanza frequente sui nostri bacini, quando aria fredda nord-atlantica

sospinta da venti di Maestrale o di Libeccio, entra nel Mediterraneo, un mare

che a parità di latitudine è circa 4°C più caldo del vicino Atlantico.

2.6.2 Termodinamica dell’aria umida

Dopo

aver

esaminato

le

proprietà

termodinamiche

dell’atmosfera

nell’ipotesi,sostanzialmente astratta, di aria secca non contenente vapore

acqueo o comunque lontana da eventuali processi di condensazione, verrà

ora esaminata la condizione più realistica di aria umida, in grado di dar luogo,

sotto determinate condizioni, a processi di condensazione del vapore acqueo

in essa contenuto, caratterizzata dalla presenza di fenomeni elettrici.

2.6.2.1 Trasformazioni adiabatiche per l’aria umida

Si è già visto che una particella di aria secca, in movimento verticale, è

soggetta a espansione o compressione adiabatica, a seconda che il moto sia

diretto verso l’alto o verso il basso, con una conseguente variazione della

temperatura della particella nella misura di 10°C per chilometro (gradiente

termico adiabatico ad).

Si consideri ora invece il movimento verticale di una particella di aria satura.

In questo caso la variazione ΔT di temperatura che avviene al suo interno può

essere vista come somma di due distinti contributi:

35

una variazione Δa legata all’espansione o alla compressione adiabatica

della massa d’aria in movimento;

una variazione Δp determinata dalla condensazione del vapore saturo

in eccesso (nel caso in cui la particella sia in moto verso l’alto) o

dall’evaporazione delle goccioline d’acqua (nel caso in cui la particella

si muova verso il basso).

Ad esempio nel caso di una massa d’aria satura in ascesa la trasformazione

adiabatica complessiva, può essere immaginata così composta:

un primo tratto tra il livello iniziale della pressione (p + Δp) e quello

finale alla pressione p, durante il quale la particella, per espansione,

subisce un raffreddamento Δa;

un secondo tratto, a pressione p, durante il quale la massa d’aria

satura condensa l’eccesso di vapore determinato dal raffreddamento

Δa. Di conseguenza l’aria viene riscaldata, a pressione costante, di una

quantità Δp legata all’ immissione del calore latente di condensazione.

Il procedimento può essere ripetuto, passo dopo passo, fin quando, nel suo

movimento verso l’alto, la massa d’aria non abbia condensato tutto il vapore

acqueo presente.

Una volta che la massa d’aria è giunta alla saturazione e sono iniziati i

processi di condensazione, si possono verificare due situazioni differenti:

il vapore condensato rimane all’interno della massa d’aria satura (non

si ha precipitazione); se la stessa massa d’aria subisse ora un

riscaldamento adiabatico (ad esempio per effetto della compressione

in fase di caduta da un pendio), il vapore condensato rievaporerebbe e

la massa d’aria si riporterebbe nelle condizioni iniziali (processo

reversibile);

parte del vapore condensato precipita verso terra; in questo caso

riscaldando adiabaticamente la stessa massa d’aria, non si riuscirebbe

36

a tornare esattamente alle stesse condizioni di partenza poiché

mancherebbe il contributo dato al riscaldamento dalla rievaporazione

dell’acqua precipitata. La trasformazione è cioè irreversibile e prende il

nome di pseudo adiabatica.

In entrambi i casi, comunque, la variazione complessiva ΔT di temperatura

subita dalla massa d’aria satura per uno spostamento verticale ΔZ è minore

che nel caso di aria secca.

Infatti ora i due termini Δa e Δp sono di segno opposto sia nel caso di aria

satura in ascesa sia in quello di aria satura in discesa e pertanto tendono a

compensarsi. Tuttavia, siccome il temine Δa prevale in assoluto sul termine

Δp, si deduce che, anche nel caso di aria satura, la massa d’aria si raffredda se

è in ascesa e si riscalda se è in discesa. Ma ora il raffreddamento o il

riscaldamento subiti in uno spostamento ΔZ sono ovviamente inferiori al

corrispondente caso dell’aria secca.

2.6.2.2 L’equazione di stato per l’aria umida

Nell'aria è sempre presente una piccola quantità di vapore acqueo,

indicativamente circa 1% in massa, per cui si può correttamente parlare di

aria umida.

L'aria atmosferica “secca” di cui sopra, è, come noto, una miscela di ossigeno

ed azoto (O2 ≅ 23% e N2 ≅ 76% in massa).

La presenza di una quantità così ridotta di vapore acqueo nell’aria potrebbe

apparire, ad un primo esame, di scarsa importanza tecnica.

Ma in realtà anche piccole differenze nelle “modeste” quantità di vapore

presenti nell'aria possono comportare notevoli conseguenze pratiche: ad

esempio influenzare la sensazione di benessere termico delle persone o

influenzare, e in notevole misura, la conservazione di oggetti e manufatti, etc.

L'aria umida viene considerata nella pratica come una miscela di aria (gas) e

di

vapore

acqueo

(vapore

surriscaldato),

37

prescindendo

dalla

sua

composizione in ossigeno ed azoto. Si dice, quindi, che l'aria umida è una

miscela d’aria secca e di vapore acqueo.

Poiché lo stato del vapore può essere considerato “sufficientemente

rarefatto” il comportamento di questo e dell’aria secca, e cioè dell’aria umida,

può essere descritto con buona approssimazione mediante l’equazione di

stato dei gas perfetti. In particolare, indicando con Pt la complessiva

pressione della miscela aria-vapore e con nt il totale del numero di moli

presenti nel volume V, si può scrivere:

Pt*V = nt*R*T

dove nt = na + nv ed essendo na e nv rispettivamente il numero di moli di aria e

di vapore.

L’equazione dei gas perfetti può essere ora scritta anche per ciascun

componente nella forma:

Pa = na* R*T/V

Pv = nv*R*T/V

dove Pa e Pv assumono il significato di pressioni parziali di questi componenti

della miscela.

Si noti che le pressioni Pa e Pv vengono così a rappresentare la pressione che

ciascun componente (aria e vapore) eserciterebbe qualora occupasse da solo,

e alla stessa temperatura T, l'intero volume a disposizione V.

Esplicitando i numeri di moli si ottiene:

na = Pa*V/R*T

nv = Pv*V/R*T

nt = Pt*V/R*T

per cui, sostituendo nella relazione nt = na + nv, si ottiene la relazione tra la

pressione totale della miscela gassosa e le pressioni parziali dei componenti:

Pt = Pa + Pv

38

Questa relazione prende il nome di Legge di Dalton ed è valida per i soli gas

perfetti. Tenendo conto dei bassi valori di Pv nell’aria atmosferica (circa 1300

- 2000 [Pa]) la relazione risulta del tutto corretta.

Si consideri il diagramma (P,V) dell'acqua in figura 2.12: sul diagramma, lo

stato del vapore presente nell'aria sia rappresentato dal punto 1. In questo

stato (P1, V1) nell'aria sono presenti ρv1 = 1/V1 [kg/m3] di vapore. Se è nota la

pressione totale Pt della miscela e, ad esempio, la pressione atmosferica,

risulta anche determinata la composizione della miscela in moli nv/nt

potendosi scrivere:

Pv/Pt = nv/nt

S’immagini, ora, che la temperatura dell'aria atmosferica diminuisca a parità

però della pressione Pt. Durante questo processo la pressione parziale Pv si

mantiene costante, finché la composizione dell'aria umida, definita dal

rapporto nv/nt, rimane inalterata.

Figura 2.9 Diagramma (P,V) dell'acqua

39

La trasformazione 1→2 sul diagramma (P, V) è isobara (la temperatura

diminuisce fino al valore T2). Nello stato 2, il vapore è ormai saturo. Se la

temperatura diminuisce ulteriormente lo stato del vapore non potrà che

spostarsi a destra lungo la curva limite del vapore saturo verso più elevati

valori del volume specifico (minori densità). In corrispondenza, la pressione

Pv e il numero di moli di vapore presenti nella fase aeriforme nv

diminuiranno e si separerà l’acqua, nell'aria si formerà una minuta

dispersione di goccioline (nebbia).

La temperatura T2 è detta temperatura di rugiada dell’aria. L'appannamento

della superficie esterna di un bicchiere contenente una bibita gelata

(formazione di minutissime goccioline d’acqua sulla superficie esterna) è

dovuta proprio al raggiungimento della temperatura di rugiada dell’aria sulla

tale superficie.

Si supponga ora di considerare nuovamente lo stato rappresentato dal punto

1.

È possibile immaginare di raggiungere la saturazione anche muovendosi a

temperatura costante e cioè muovendosi sul diagramma verso sinistra, fino a

giungere al punto 3 (T3 = T1).

Ciò potrebbe essere realizzato mantenendo costante la temperatura dell'aria

in un ambiente e aggiungendo a poco a poco vapore fino a che la Pv,

aumentando progressivamente, non giunge al massimo valore consentito

cioè al valore della pressione di saturazione Ps (T1). In altre parole, la

saturazione del vapore può essere raggiunte sia raffreddando l'aria a Pt =

cost, sia immettendo vapore nell'ambiente a T = cost.

40

3

Gli strumenti di misura dell’umidità

dell’aria

Negli ultimi anni si è assistito ad un crescente interesse verso i sensori di

umidità per il monitoraggio ed il controllo dell’umidità dell’aria non solo in

settori di interesse tradizionali, quali quello del condizionamento ambientale

e meteorologico, ma anche in campo strettamente industriale. Si pensi ai

numerosi processi industriali di controllo nei sistemi di essiccazione, di

produzione e di stoccaggio, ma anche all’aumentato numero di applicazioni

agroalimentari, museali, aeronautiche. A tale scopo differenti tipi di sensori

sono stati sviluppati per soddisfare le diverse condizioni di operabilità

richieste in ciascun campo di applicazione.

Prima di descrivere i principi di misura dell’umidità ed i relativi sensori é

opportuno evidenziare che la misura di umidità é spesso ottenuta tramite

uno o più misure di parametri termoigrometrici differenti, quali: il

titolo w, l’umidità relativa φ, la temperatura di rugiada Tr, la temperatura

di bulbo umido Tu, etc., situazione, questa, meteorologicamente complessa

sia dal punto di vista delle prestazioni di misura che delle limitazioni

operative del sensore.

E' utile sottolineare che l'umidità, come qualsiasi altra grandezza di misura,

può essere misurata in modo "diretto", se il sensore fornisce il parametro di

interesse senza dover conoscerne esplicitamente altri, o in modo "indiretto",

valutando per calcolo il valore del parametro di interesse misurandone

altri ad esso collegati (UNI 4546).

É quindi possibile raggruppare i diversi principi di misura ed i relativi

sensori in due categorie:

igrometri diretti, che presentano una relazione funzionale

41

esistente tra l’umidità e una proprietà fisica (come ad esempio

gli igrometri a capello, gli igrometri capacitivi, ecc.)

igrometri

indiretti,

che

effettuano

una

trasformazione

termodinamica e misurano quindi l’umidità indirettamente

sulla

base

di

una

relazione termodinamica (come ad

esempio gli igrometri a specchio condensante in cui viene

effettuata una trasformazione di raffreddamento isobara e

isotitolo,

gli

psicrometri

in

cui

viene

effettuata

una

trasformazione di saturazione quasi adiabatica).

Una classificazione simile può essere effettuata sulla base del parametro

termoigrometrico misurato. In particolare, é possibile distinguere tra

"sensori relativi" e "sensori assoluti" a seconda che questi misurino un

parametro termoigrometrico relativo o assoluto.

Nell'ipotesi di un assegnato valore della pressione dell'aria umida

(generalmente costante e pari alla pressione di 101325 al livello del mare), è

sempre possibile risalire indirettamente da una misura di un parametro

relativo al valore di un parametro assoluto attraverso l'ulteriore misura della

temperatura dell’aria

Ta,

(o

di

un'altra

proprietà

termodinamica

indipendente). In tal caso, la misura indiretta sarà ovviamente affetta da

un’incertezza funzione delle singole incertezze di misura secondo le note

leggi della propagazione.

Nel seguito vengono trattate, tra le numerose metodologie di misura, solo

quelle normalmente utilizzate nelle applicazioni industriali. Sono stati,

inoltre, brevemente esaminati quei sensori ottenuti tramite miglioramenti

tecnologici di principi convenzionali che non hanno trovato ancora

estese

applicazioni industriali. Sono stati, invece, tralasciati quei sensori

basati su principi di misura che non hanno ancora avuto sostanziale

diffusione sul mercato, quali, ad esempio, gli igrometri spettroscopici, gli

igrometri ottici come quelli a ad infrarosso, ad ultravioletto (Lyman alpha) e

a fibre ottiche, gli igrometri acustici come quelli ad ultrasuoni e ad onde

superficiali, gli igrometri ad effetto corona. Sono stati volutamente tralasciati

42

i metodi di tipo primario, come quelli gravimetrici, ed i generatori

di

umidità a due temperature, a due pressioni e a miscelamento, utilizzati

esclusivamente in laboratorio per la taratura. Vanno infine menzionati gli

igrometri a viraggio di colore, che sebbene stiano riscuotendo un certo

interesse dal punto di vista industriale, possono essere considerati più che

degli strumenti di misura degli indicatori qualitativi dell’umidità dell’aria.

Per ognuna delle metodologie di misura esaminate sono state riportate, a

valle di una descrizione sintetica del principio di misura e delle tecnologie

utilizzate, le principali caratteristiche metrologiche in termini di campo di

misura, incertezza e tempo di risposta. Sono, inoltre, evidenziate le

principali caratteristiche operative e modalità di installazione.

3.1 Igrometri diretti

Gli igrometri diretti sono probabilmente i sensori tecnologicamente e

funzionalmente più semplici, pertanto presentano un costo relativamente

basso. Negli ultimi anni la ricerca di nuovi materiali ha portato ad un

sensibile incremento dell’affidabilità dei sensori igroscopici diretti, in

modo particolare quelli di tipo elettrico, consentendone un ampia

applicazione in ambito industriale e di laboratorio.

Gli igrometri diretti possono essere classificati in modo diverso a seconda

del principio di misura (meccanici, elettrici, a risonanza, ecc), delle

tecnologie di produzione (a film sottile, a film spesso, a stato solido, ecc.) o

ancora dei materiali utilizzati (polimerici, ceramici, ecc.). Nel seguito

vengono suddivisi i diversi sensori in funzione del principio di misura in

igrometri meccanici ed igrometri elettrici.

3.1.1 Igrometri meccanici

Il primo e più popolare dispositivo di misura dell'umidità di tipo meccanico

sembra essere stato realizzato per la prima volta dal De Sassure. Franchman

e Regnault misero ulteriormente a punto tale strumento basato sul

43

fenomeno, a tutti ben noto, dell'elongazione di capelli umani in funzione

dell'umidità. Successivamente tali dispositivi sono stati realizzati utilizzando

materiali diversi quali membrane, sia animali che sintetiche, carta, tessuti.

Nei dispositivi ad uscita elettrica, la

variazione dimensionale del materiale igroscopico in funzione del contenuto

di vapor d'acqua assorbito viene trasdotta nella variazione di resistenza

elettrica di un potenziometro o di un estensimetro.

Il campo di misura tipico di tali strumenti va dal 20% al 90%, per

temperature comprese tra 0 e 40°C con una incertezza di misura

raramente inferiore a ±5%. Il sensore, infatti, mostra un comportamento non

lineare ed una sensibilità ridotta agli estremi del campo di misura (ad

esempio per un igrometro a capelli la sensibilità varia da circa 0.5.mm/UR%

m al 15%, fino a circa 0.05 mm/UR% m all'85%).

Le scadenti prestazioni metrologiche, associate alla non trascurabile deriva

nel tempo, ai fenomeni di isteresi, ai fenomeni di contaminazione

superficiale, all’elevato tempo di risposta ed alla elevata sensibilità alle

vibrazioni, rendono utilizzabili tali dispositivi più per indicazioni qualitative

che per applicazioni strettamente metrologiche. D’altra parte la semplicità

costruttiva rende tali strumenti molto economici e comodi per l’assenza di

alimentazione elettrica.

Per tali motivi l'uso in ambiente domestico ne costituisce il principale

campo applicativo. Un impiego altrettanto frequente è quello di registratore

delle condizioni ambientali associato ad un sensore di temperatura ed ad un

sistema di registrazione a pennino. In tal caso il sistema prende il nome di

termoigrografo.

44

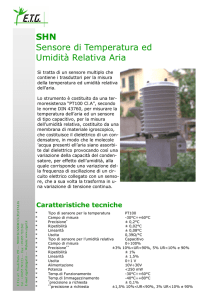

Figura 3.1 Sensori di umidità igroscopici a rilevazione meccanica: a) a capello b) a membrana

3.1.2 Igrometri elettrici

I sensori di umidità igroscopici elettrici sono basati sulla variazione delle

proprietà elettriche dell'elemento sensibile in funzione della quantità di

acqua adsorbita o absorbita dall'ambiente di misura. Il principio di