Università degli Studi di Genova

Facoltà di Scienze della Formazione

Corso di Laurea in Scienze della Comunicazione

Tesi triennale

METODI E STRUMENTI DI SUPPORTO AI PROCESSI

DI APPRENDIMENTO IN RETE

Candidato: Mario Vallarino

Relatore: Prof. Luigi Sarti

Anno Accademico 2006-2007

INDICE

INTRODUZIONE

2

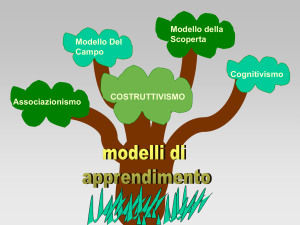

1. L’APPRENDIMENTO

1.1 Il comportamentismo

1.1.1 Il condizionamento classico

1.1.2 Connessionismo ed istruzione programmata

1.1.3 Apprendimento latente e ruolo delle variabili intermedie

1.2 Il cognitivismo

1.2.1 Le principali teorie ed autori cognitivisti

1.3 Il costruttivismo

1.3.1 Due significativi “precursori”: Piaget e Vygotskij

1.3.2 I concetti di base del costruttivismo

1.3.3 Gli sviluppi del costruttivismo

2. FORMAZIONE A DISTANZA ED E-LEARNING

2.1 Lo sviluppo della formazione a distanza

2.2 Dalla formazione a distanza all’apprendimento in rete

2.2.1 L’apprendimento individuale

2.2.2 L’apprendimento assistito

2.2.3 L’apprendimento reciproco

2.2.4 L’apprendimento collaborativo

2.3 Alcune parziali conclusioni sulla formazione a distanza

3

3. LA COMUNICAZIONE MEDIATA DA COMPUTER (CMC)

3.1 Le teorie della comunicazione

3.1.1 Il modello linguistico di Jakobson

3.1.2 Il modello psico-sociale di Anzieu e Martin ed i modelli interlocutori

3.2 Caratteristiche principali della CMC

3.3 Alcune teorie sulla CMC

4. L’APPRENDIMENTO COLLABORATIVO IN RETE

4.1 La prospettiva CSCL

4.2 Le comunità virtuali

4.3 Le comunità di pratica

4.4 Le comunità virtuali di apprendimento

5. GESTIRE LA DIDATTICA IN RETE

5.1 I Learning Management System (LMS)

5.1.1 Modello di formazione in autoapprendimento

5.1.2 Modello di formazione assistito

5.1.3 Modello di formazione collaborativo

5.1.4 Alcune considerazioni sulla scelta della piattaforma e-learning

5.2 Il riuso dei materiali didattici: i Learning Object (LO)

5.2.1 Alcuni esempi di LO

5.2.2 Indicizzazione e standardizzazione

5.2.3 I limiti dell’approccio oggettivista

5.2.4 I LO in chiave costruttivista: quali prospettive di standardizzazione?

4

INTRODUZIONE

Una delle applicazioni Internet che caratterizza l’attuale società postfordista è quella dell’e-learning,

che usando un linguaggio di senso comune può essere definito come “la formazione che avviene

tramite il web”. Questo tipo di formazione risponde alle esigenze della società contemporanea di

tenere continuamente aggiornati i saperi e le competenze dei propri membri, per non trovarsi in

condizioni di inferiorità sullo scenario dell’economia globalizzata. Come esempio dell’importanza

di questo tipo di formazione, si può dire che nel bilancio USA il totale della spesa destinata alla

formazione universitaria è uguale al totale della spesa investita nella formazione continua dei

cittadini [Banzato, 2003].

In Europa, ed in Italia, si riscontra un certo ritardo nell’adeguamento dell’offerta formativa alle

esigenze della formazione continua e dell’Information Communication Technology (ICT). Tra le

cause, si può annoverare una percezione diffusa dell’e-learning come un semplice trasferimento in

rete del modello di lezione in presenza [Calvani, 2005].

In realtà la formazione on-line assume varie sfaccettature, e accanto a modalità erogative dei corsi,

che si basano sul modello tradizionale di didattica incentrato sullo studio individuale e sui test di

valutazione, si assiste all’affermazione di modelli innovativi, nei quali la conoscenza individuale

viene considerata come il risultato di una costruzione collaborativa, frutto delle interazioni sociali

instaurate fra i partecipanti al processo formativo.

L’obiettivo di questo lavoro è quello di fornire una panoramica dell’attuale formazione in rete,

prendendone in esame i presupposti teorici, distinguendo fra i vari approcci metodologici,

5

esaminandone le criticità e le modalità di espressione, soffermandosi infine sugli aspetti pratici sui

quali verte l’odierna discussione.

Nel primo capitolo vengono dunque prese in esame le teorie dell’apprendimento, facenti capo alle

grandi scuole psicologiche del Novecento: si passa quindi dagli studi comportamentisti, che

associano l’apprendimento umano al processo stimolo-risposta che avviene negli animali, al

cognitivismo, che concepisce il funzionamento della mente umana come simile a quello dei

calcolatori, e vede l’apprendimento come un processo di elaborazione delle informazioni; infine si

parla del costruttivismo, che partendo dagli studi di Piaget e Vygotskij elabora una visione

dell’apprendimento considerato come costruzione di conoscenza, che si realizza attraverso

dinamiche collaborative ed è condizionata da fattori culturali.

Il secondo capitolo descrive lo sviluppo della formazione a distanza (FaD), che viene generalmente

suddiviso in tre generazioni [Trentin, 2000]. Viene quindi esaminata la tassonomia delle

applicazioni FaD che fanno uso di tecnologie di rete, dalle modalità in autoistruzione fino a quelle

che mettono in pratica i principi dell’apprendimento collaborativo, passando per le modalità

intermedie.

Nel terzo capitolo viene preso in esame l’aspetto probabilmente più critico dell’uso delle ICT nella

formazione in rete: la comunicazione. Viene descritto in primo luogo il Modello generale della

comunicazione elaborato da Roman Jakobson, per poi passare ad altri modelli e teorie che

affrontano il tema della Comunicazione Mediata da Computer (CMC).

Il quarto capitolo tratta le modalità più innovative della formazione in rete: la prospettiva di ricerca

del Computer Supported Collaborative Learning (CSCL), le comunità di pratica, le comunità di

apprendimento in rete.

Nel quinto e ultimo capitolo si considerano due questioni pratiche, cruciali nell’odierna formazione

in rete: i criteri di scelta della piattaforma e-learning da utilizzare per gestire il corso, con annesse

alcune riflessioni inerenti l’interrogativo, sempre presente quando si parla di software, se affidarsi a

soluzioni commerciali oppure open source; il riuso dei materiali didattici, un argomento che

comprende molteplici aspetti, come l’indicizzazione, la standardizzazione e l’ancora poco praticata

connotazione pedagogica dei materiali.

6

1. L’APPRENDIMENTO

L’apprendimento è stato definito dallo psicologo Hernest Hilgard come un processo intellettivo

attraverso cui l’individuo acquisisce conoscenze sul mondo che, successivamente, utilizza per

strutturare ed orientare il proprio comportamento in modo duraturo [citato in Coinu, 2006].

Nel corso del tempo la disciplina della psicologia si è interessata all’apprendimento, postulando

teorie che hanno contribuito agli avvicendamenti avvenuti fra i tre grandi paradigmi della

psicologia: comportamentismo, cognitivismo e costruttivismo.

1.1 Il comportamentismo

Fino all’Ottocento la psicologia veniva intesa come la “disciplina che ha per oggetto l’anima”, ma

con l’analisi basata sull’esperienza introspettiva praticata da Wilhelm Wundt la disciplina iniziò ad

assumere una connotazione scientifica, attraverso la sistematizzazione delle ricerche svolte fino ad

allora.

Gli sviluppi successivi superarono il metodo introspettivo, portando dallo studio della coscienza

allo studio del comportamento osservabile. La psiche viene qui scomposta nei suoi contenuti

elementari come: emozione, abitudine, apprendimento, personalità; le teorie su questi aspetti della

psiche vengono postulate attraverso lo studio dei comportamenti osservabili.

La prima formulazione teorica del comportamentismo viene attribuita a John B. Watson, che nel

1913 pubblica l’articolo La psicologia così come la vede il comportamentista, ma diversi autori

hanno dato importanti contributi allo sviluppo di questo paradigma.

7

1.1.1 Il condizionamento classico

Ivan Pavlov (1849-1936) può essere considerato il primo comportamentista che formula una teoria

dell’apprendimento.

Studiando la digestione nei cani, Pavlov nota come l’animale attivi il processo di salivazione prima

di avere il cibo in bocca. I successivi esperimenti sono celeberrimi, e si possono suddividere in

queste fasi:

1. alla presentazione di uno stimolo incondizionato (SI, ossia uno stimolo come il cibo, che attiva

nell’animale il riflesso innato della salivazione), il cane presenta una risposta incondizionata (RI,

si attiva nell’animale una salivazione abbondante);

2. contemporaneamente alla presentazione del cibo (SI) viene presentato uno stimolo neutro (SN,

l’accensione di una luce): come nel caso precedente, il cane saliva;

3. se si ripete per un numero sufficiente di volte la sequenza 2 e, successivamente, si elimina la

presentazione dello stimolo incondizionato (il cibo), il cane saliverà alla sola presentazione dello

stimolo neutro (cioè alla sola accensione della luce); la risposta del cane diviene qui una risposta

condizionata (RC), che si verifica grazie al condizionamento effettuato attraverso la

combinazione di stimoli incondizionati e neutri.

Avviene quindi un apprendimento, che viene perduto se non si presenta più all’animale la

combinazione di stimolo incondizionato e stimolo neutro.

Nella fase comportamentista delle teorie dell’apprendimento gli studi di Pavlov vengono

generalizzati anche al comportamento umano, basandosi sull’assunto che i processi di acquisizione

dei riflessi condizionati siano comuni alle specie animali e all’uomo.

1.1.2 Connessionismo ed istruzione programmata

Gli studi di Pavlov sul condizionamento classico sono utili alla comprensione dei meccanismi

dell’apprendimento, ma diventano di scarsa rilevanza applicativa quando l’obiettivo

dell’insegnamento è che l’essere vivente acquisisca la capacità di fare qualcosa che non aveva mai

fatto prima. Per esempio, nessun condizionamento di tipo pavloviano potrebbe indurre una foca a

tenere un pallone in equilibrio sul naso, che equivarrebbe a tenere un comportamento innaturale.

Contemporaneo di Pavlov, ma operante nel nordamerica, Edward Thorndike studia i processi di

apprendimento degli uomini e degli animali.

La situazione sperimentale ideata da Thorndike prevede un gatto affamato chiuso in una gabbia con,

al di fuori della gabbia, un pezzo di pesce: il gatto si muove casualmente nella gabbia, finché preme

il pedale che ne aziona l’apertura e può uscire a mangiare il pesce.

8

Rimesso nella gabbia più volte sempre affamato, il gatto tende ad impiegare sempre meno tempo

per trovare il pedale che apre la porta.

Thorndike ricava da questo esperimento la legge dell’effetto: fra tutte le risposte a caso fornite da un

organismo, vengono selezionate solo quelle che hanno conseguenze positive. L’apprendimento si

rivela in questa fase come un processo che avviene in seguito a prove ed errori.

Secondo Thorndike la base dell’apprendimento è costituita dal collegamento più o meno forte che si

stabilisce fra l’impressione sensoriale e l’azione: da qui il termine di connessionismo attribuito alla

sua concezione della psicologia.

Nel secolo scorso Burrhus Skinner (1904-1990), considerato l’esponente più noto del

comportamentismo, mette in atto una semplificazione degli esperimenti di Thorndike: in una gabbia

priva di arredamento viene rinchiuso un topo affamato che, nella sua attività esplorativa, preme

casualmente una leva che serve a far entrare nella gabbia una pallina di cibo. Il topo, dopo una serie

di pressioni casuali sulla leva, impara a premerla volontariamente per ottenere il cibo.

Questo tipo di comportamento viene chiamato da Skinner condizionamento operante, che consiste

in questo: la probabilità che una certa azione (o risposta) venga ripetuta dipende dalle sue

conseguenze. Skinner distingue fra:

• risposte suscitate da stimoli conosciuti (come negli studi di Pavlov): vengono chiamate

rispondenti;

• risposte che non hanno relazione con stimoli conosciuti: vengono chiamate operanti.

Di conseguenza, il condizionamento relativo al comportamento rispondente è di tipo S, in quanto

correlato agli stimoli; quello relativo al comportamento operante è di tipo R, e dipende dalla

risposta.

Skinner applica i principi del condizionamento operante all’apprendimento umano, e li presenta nel

suo famoso articolo del 1954 The science of learning and the art of teaching. In questo lavoro e in

quelli successivi Skinner presenta l’Istruzione programmata, una tecnologia dell’insegnamento che

punta a realizzare l’apprendimento degli studenti sottoponendo loro concetti via via sempre più

complessi, rinforzando esclusivamente i risultati positivi ottenuti fino ad arrivare all’apprendimento

compiuto.

Con questo metodo, i contenuti vengono somministrati agli studenti in brevi sequenze logiche

(frames), e vengono seguiti da un quesito: se lo studente fornisce la risposta esatta il rinforzo

consiste nel passaggio al frame successivo; se la risposta è sbagliata si ritorna alla fruizione del

frame o viene dato allo studente un feedback correttivo, in modo da permettergli, attraverso ulteriori

tentativi, di arrivare alla risposta esatta e passare alla fase successiva. Con l’istruzione programmata

nasce una nuova disciplina, chiamata Instructional System Design [Santilli, 2006].

9

1.1.3 Apprendimento latente e ruolo delle variabili intermedie

Parecchio tempo prima che Skinner pubblichi il suo famoso articolo, di stampo comportamentista

puro, sull’istruzione programmata, Edward Tolman (1886-1959) elabora teorie che possono essere

considerate di passaggio dal modello comportamentista a quello cognitivista.

Tolman studia il comportamento di tre gruppi di topi all’interno di un labirinto: il primo gruppo

riceve rinforzo immediato al completamento del labirinto; il secondo non ne riceve mai; il terzo lo

riceve solo a partire dal dodicesimo giorno di prove.

Tolman rileva che il gruppo senza rinforzo, alla fine della sperimentazione, non impara a percorrere

il labirinto senza sprecare tempo ed energie in percorsi inutili; ma si accorge anche che, alla

conclusione dell’esperimento, non vi è differenza di prestazioni nel completamento del labirinto da

parte degli altri due gruppi, quello a rinforzo immediato e quello a rinforzo posticipato.

L’unica differenza fra i due gruppi a cui viene somministrato il rinforzo è che il gruppo a rinforzo

posticipato inizia a percorrere efficientemente il labirinto solamente quando inizia a ricevere del

cibo.

Come spiegazione di questo fenomeno Tolman introduce il concetto di apprendimento latente, in

base al quale l’apprendimento avviene anche in mancanza di rinforzo, ma esso si manifesta in una

prestazione corretta esclusivamente in presenza del rinforzo stesso.

L’apprendimento qui si configura nei termini di raggiungimento di un obiettivo, e richiede

l’introduzione di concetti quali scopo, aspettativa, mappa cognitiva (la consapevolezza della

relazione esistente fra un certo tipo di ambiente e ciò che vi accade all’interno). Queste variabili

entrano in gioco nel determinare il comportamento e vengono definite da Tolman variabili

intermedie.

Gli studi di Tolman, pur rimanendo di impostazione comportamentista, si distaccano da tale visione

perché non riducono il comportamento solo ai modelli del condizionamento, ma ne basano

l’organizzazione sul ruolo delle variabili intermedie e dell’apprendimento latente, anticipando la

visione cognitivista.

1.2 Il cognitivismo

Gli studi sulle variabili intermedie di Tolman non furono gli unici a portare ad un cambio di

paradigma nelle teorie dell’apprendimento: diversi studiosi provenienti da discipline differenti

diedero fondamentali contributi in tale direzione.

Negli anni trenta del Novecento il matematico inglese Alan Turing inventa la macchina che porta il

suo nome, in grado di svolgere qualsiasi calcolo esprimibile in codice binario. Turing stesso si pone

10

il problema di fare confronti fra le prestazioni di tale macchina e quelle dell’essere umano, e lo fa in

questi termini: “ se un gruppo di giudici, cui vengono presentate delle prestazioni, come ad esempio

la soluzione di un problema, parte delle quali sono state prodotte da soggetti umani e parte dalla

macchina, non è in grado di discriminare quali prestazioni sono state prodotte dagli esseri umani e

quali dalla macchina, allora si può dire che la prestazione della macchina equivale alla prestazione

umana” [citato in Mecacci, 2001].

Nel 1943 il neurofisiologoWarren McCulloch e il matematico Walter Pitts osservano che l’attività

neurale può essere descritta con la stessa logica con cui funzionano i calcolatori: risulta quindi

appropriato vedere il cervello come un computer molto potente.

Questi sviluppi del sapere umano, assieme alle insufficienze teoriche del comportamentismo nello

spiegare il comportamento e l’apprendimento, inducono i ricercatori ad interessarsi di tematiche in

precedenza non considerate perché ritenute irrilevanti o metodologicamente fuorvianti.

Queste tematiche sono: il linguaggio, la motivazione, il pensiero, le emozioni e la percezione.

Molto importanti sono anche le ricerche del psico-fisiologo canadese Donald Hebb, il quale si

interessa delle variabili intervenienti, cioè tutti quei procedimenti mentali che, nell’individuo, si

interpongono fra lo stimolo e la risposta. Egli tenta inoltre di spiegare questi processi in termini

neurofisiologici, inaugurando la tradizione cognitivista di schematizzare l’attività del sistema

nervoso ricorrendo a modelli caratteristici di altre discipline, come l’informatica o le

telecomunicazioni.

1.2.1 Le principali teorie ed autori cognitivisti

La consacrazione della visione cognitivista avviene nel 1956, al Symposium on Information Theory

tenuto al Massachussets Institute of Technology, dove vengono presentate tre importanti relazioni,

che segnano il passaggio dal paradigma comportamentista a quello cognitivista: dallo studio del

comportamento che considera la mente come una black box -il cui funzionamento è irrilevante- si

passa allo studio del cervello umano come elaboratore di informazioni.

L’analogia fra l’elaborazione dell’informazione nei calcolatori e nell’uomo viene sviluppata da

George Miller, il quale nel 1960 pubblica Piani e struttura del comportamento. In questa ricerca

Miller, assieme ad altri due studiosi, sostiene che il comportamento umano ha origine nella

rappresentazione che la mente esegue del mondo esterno, organizzando dei piani che funzionano in

base ad un meccanismo di feedback chiamato TOTE (Test-Operate-Test-Exit), descrivibile in

quattro fasi:

1. Test: prima di compiere un’attività, si verifica che gli obiettivi posti siano congrui con la

situazione dell’ambiente in cui si va ad agire.

11

2. Operate: si agisce, o si modificano i propri obiettivi allineandoli alle caratteristiche dell’ambiente.

3. Test: si verifica se le azioni intraprese hanno avuto i risultati desiderati.

4. Exit: se i risultati sono soddisfacenti il processo si conclude, diversamente si ritorna alla fase

Operate.

Un altro importante studioso, Jerome Bruner, nel suo libro Il pensiero del 1956, vuole dimostrare

attraverso dati sperimentali che i soggetti non accoppiano meccanicamente determinate risposte ad

altrettanto determinati stimoli, ma invece tendono ad inferire quali siano i meccanismi di

risoluzione dei problemi e ad applicarli in contesti differenti.

Una sintesi dei risultati conseguiti dalla ricerca ispirata alla nuova prospettiva cognitivista si deve a

Ulric Neisser, che nel suo lavoro Psicologia cognitiva del 1967 sottolinea l’importanza della

metafora della mente come calcolatore e descrive come la mente elabora le informazioni

provenienti dall’ambiente esterno. Nel 1977 Peter Lindsay e Donald Norman pubblicano il primo

manuale di psicologia cognitivista intitolato Human information processing (H.I.P.).

Gli studi intrapresi dagli psicologi facenti capo alla teoria H.I.P. hanno portato alla realizzazione di

modelli, consistenti in reti semantiche, frames e regole di produzione, che hanno portato ad un

notevole sviluppo nella disciplina dell’ Intelligenza Artificiale [Varisco, 1995].

Dal punto di vista delle tecnologie didattiche il cognitivismo H.I.P. ha contribuito alla realizzazione

di sistemi intelligenti tesi a riprodurre, nel discente, conoscenze ed abilità esperte in domini

specifici, per mezzo dell’attivazione di strategie di dialogo fra lo studente ed il sistema artificiale,

che ha il compito di gestire l’interazione [ibidem].

1.3 Il costruttivismo

1.3.1 Due significativi “precursori”: Piaget e Vygotskij

Nel processo che ha portato alla visione costruttivista dell’apprendimento va inserita l’opera di due

psicologi che hanno dato contributi fondamentali: Jean Piaget (1896-1980) e Lev Vygotskij

(1896-1934).

Piaget si è occupato di cercare la natura della conoscenza, così come si forma nello sviluppo

dell’individuo, riconoscendo in essa la matrice biologica.

Secondo Piaget l’individuo è dotato di una organizzazione cognitiva che evolve la sua struttura

grazie all’adattamento che l’individuo opera verso l’ambiente in cui si trova inserito. L’adattamento

all’ambiente prevede non solo l’assimilazione dei nuovi stimoli allo schema cognitivo preesistente,

ma anche la riconfigurazione di quest’ultimo in adattamento ai nuovi stimoli. Piaget definisce tale

riconfigurazione con il termine accomodamento. L’intelligenza diventa con Piaget un processo

12

organizzativo autoregolantesi, nel quale l’impulso all’autoregolazione arriva dal conflitto che si crea

fra i nuovi stimoli e le strutture preesistenti.

Lo sviluppo cognitivo così concepito si configura come universale, logico, a-contestuale [Varisco,

2002]; va riconosciuto a Piaget il merito di aver messo in evidenza il ruolo attivo del soggetto nella

costruzione della sua organizzazione cognitiva, ed il limite di non tenere conto dei fattori culturali

nello sviluppo dell’individuo.

Vigotskij è stato il maggiore esponente della scuola psicologica socio-culturale sovietica,

sviluppatasi nel primo Novecento. Egli sistematizza gli studi di questa scuola nella sua opera Studi

sulla teoria del comportamento del 1930, nella quale vengono poste a confronto le funzioni

psichiche ed il comportamento di primati, bambini ed esseri umani adulti.

Vygotskij conclude che i processi fisiologici come i riflessi condizionati sono comuni sia alle specie

animali che all’uomo, con la differenza fondamentale che negli animali questi processi sono le unità

di base per il comportamento, mentre nell’uomo rappresentano soltanto i punti di partenza dei

processi di comportamento ed apprendimento. Inoltre, a differenza degli animali, nelle interazioni

con l’ambiente gli esseri umani si avvalgono di strumenti, che possono essere sia utensili che segni

linguistici.

In Pensiero e linguaggio del 1934 Vygotskij ha modo di chiarire la sua posizione nei confronti di

questi due oggetti di studio: essi hanno due origini genetiche differenti ed entrano in interazione

solamente dopo i due anni, quando il linguaggio inizia a diventare sia strumento di comunicazione

delle proprie idee che strumento di regolazione del proprio comportamento, a seguito

dell’elaborazione di regole e strategie. In questo processo, l’interazione con altri individui, e con gli

adulti in particolare, assume importanza decisiva, permettendo l’acquisizione di funzioni intellettive

che altrimenti non potrebbero svilupparsi. Qui Vygotskij introduce il concetto di zona di sviluppo

prossimale, ossia quell’area cognitiva di supporto esperto fornito dall’adulto nella quale il

bambino può spingersi oltre il suo livello di conoscenza attuale [Coinu, 2006] .

Come sottolinea Bianca Maria Varisco [2002] , il merito maggiore di Vygotskij è forse quello di

aver riconosciuto allo sviluppo filo-ontogenetico cognitivo umano non solo una matrice biologica,

ma soprattutto una specifica matrice storico-culturale. Egli considera quindi la relazione fra

soggetto ed ambiente come mediata dalla cultura e dai suoi sistemi simbolici, in polemica quindi

con Piaget, per il quale questa relazione è diretta e spontanea. Vygotskij sostiene inoltre che

l’istruzione efficace è quella che anticipa lo sviluppo, colmando la cosiddetta zona di sviluppo

prossimale: nel momento in cui l’individuo, attraverso l’aiuto degli altri, cerca di risolvere un

problema che non sarebbe in grado di affrontare da solo, egli si appropria di nuovi strumenti

13

cognitivi, che gli permetteranno in futuro di affrontare autonomamente i problemi che, fino a quel

momento, richiedevano l’assistenza altrui.

1.3.2 I concetti di base del costruttivismo

Piaget è stato forse il primo a parlare di una mente costruttrice di significati, ma molti sono gli

autori che hanno contribuito, e tuttora contribuiscono, allo sviluppo di questa prospettiva.

In generale si può affermare che la visione costruttivista non considera la realtà come qualcosa di

oggettivo, indipendente da chi ne fa esperienza, bensì è il soggetto stesso che la crea, partecipando

in maniera attiva alla sua costruzione. Viene messa in discussione l’esistenza di una conoscenza

oggettiva che rappresenti fedelmente il mondo esterno all’osservatore, anzi è proprio quest’ultimo,

alla luce delle sue esperienze, interazioni e conoscenze pregresse, che costruisce ciò che considera

reale. Questa visione è in linea con il pensiero del filosofo Giambattista Vico, che agli inizi del XVI

secolo mise in discussione il metodo scientifico di Descartes, facendo corrispondere la conoscenza

alla costruzione della mente che organizza l’esperienza. Vico espresse questi concetti nella famosa

affermazione verum ipsum factum (il vero è il fatto stesso).

Tornando ai giorni nostri, come ha sintetizzato ottimamente Bianca Maria Varisco, la concezione

costruttivista considera la conoscenza un prodotto socialmente, storicamente, temporalmente,

culturalmente, contestualmente costruito. Essa è una conoscenza complessa, multipla, particolare,

soggettiva, rappresentata “da” e “attraverso” persone situate in una particolare cultura, in un

determinato momento temporale, nell’interazione di un certo numero di giochi linguistici [Varisco,

1995].

Questa concezione relativista della realtà corre il rischio concreto dell’alienazione esistenziale, per

cui la psico-pedagogia costruttivista si è ridefinita nel costruttivismo socio interazionista.

Questa visione prevede che i significati vadano creati all’interno di comunità di interpreti, nelle

quali i discenti accedono al sapere attraverso la negoziazione e condivisione dei significati,

costruendo nuova conoscenza.

Facendo riferimento alle tecnologie dell’educazione, e alla disciplina dell’ Instructional System

Design in particolare, M.D. Merrill [citato in Varisco, 1995] elenca i seguenti presupposti del

costruttivismo:

• la conoscenza è costruita dall’esperienza;

• l’apprendimento è concepito come una personale interpretazione del mondo;

• l’apprendimento è attivo, in esso il significato si sviluppa sulla base dell’esperienza;

• l’apprendimento è collaborativo, in quanto il significato è negoziato da molteplici prospettive;

• l’apprendimento è situato (o ancorato) perché accade in settings realistici;

14

• la valutazione è integrata nel compito e non un’attività da esso separata.

1.3.3 Gli sviluppi del costruttivismo

Nel corso del tempo la visione costruttivista si è ramificata in alcuni filoni teorici, che hanno

integrato questo paradigma.

Seguendo la distinzione operata da Varisco [1995], si definisce costruttivismo interazionista

l’approccio teorico di Jean Piaget e quello di D. Ausubel.

In Piaget, di cui si è parlato in precedenza, il processo di adattamento ai nuovi stimoli prevede una

partecipazione attiva del soggetto interessato, e l’interazione sociale contribuisce a innescare il

conflitto che porta alla ristrutturazione dello schema cognitivo preesistente. Ausubel sottolinea

invece come l’apprendimento dipenda anche dalla significatività dei contenuti per il discente: essi

diventano significativi se possono essere ancorati alle conoscenze già acquisite, e se il soggetto ha

la motivazione sufficiente per cercare tali ancoraggi.

La dimensione culturale dell’apprendimento, trascurata da Piaget, è stata messa in evidenza da

Bruner, il quale sostiene che [...] la conoscenza di una «persona» non ha sede esclusivamente nella

sua mente, in forma «solistica», bensì anche negli appunti che prendiamo e consultiamo sui nostri

notes, nei libri con brani sottolineati che sono nei nostri scaffali, nei manuali che abbiamo

imparato a consultare, nelle fonti di informazione che abbiamo caricato sul computer, negli amici

che si possono rintracciare per chiedere un riferimento o un’informazione, e così via quasi

all’infinito. [...] Giungere a conoscere qualcosa in questo senso è un’azione sia situata sia

distribuita. Trascurare questa natura situazionale e distribuita della conoscenza e del conoscere

significa perdere di vista non soltanto la natura culturale della conoscenza, ma anche la natura

culturale del processo di acquisizione della conoscenza. [citato in Varisco, 1995]. Si parla in questo

caso di costruttivismo culturale.

La scuola psicologica sovietica, ed in particolare la teoria delle zone di sviluppo prossimale del già

citato Vygotskij, fornisce invece dei validi presupposti per l’elaborazione delle teorie

sull’apprendimento collaborativo: l’interazione sociale e la negoziazione nella costruzione delle

conoscenze caratterizza l’apprendimento come un’attività cognitiva modellata e distribuita sugli

scambi interpersonali, oltreché sugli strumenti ed artefatti -sia culturali che tecnologici- chiamati ad

intervenire nel processo. Questo modello di costruzione di conoscenza, nel quale quest’ultima si

configura come una attività condivisa, prende il nome di costruttivismo sociale.

Due psico-pedagogisti aderenti al paradigma del costruttivismo sociale, Anne Brown e Joseph

Campione, nello studio dell’apprendimento extrascolastico elaborano alcuni principi-guida per chi

voglia realizzare delle «comunità di studenti che apprendono» ( Communities of Learners o

15

Comunità di apprendimento ).Tali principi sono influenzati da approcci linguistici, sociologici ed

antropologici, ed incorporano alcuni elementi del costruttivismo culturale. La filosofia educativa di

questi due autori si può pertanto definire come costruttivismo socio-culturale, che si esprime in base

ai seguenti capisaldi:

• l’apprendimento viene considerato come un processo di natura attiva e strategica;

• riveste importanza fondamentale il concetto di metacognizione, ovvero la consapevolezza nel

soggetto dei propri processi cognitivi: questo favorisce l’apprendimento intenzionale, la continua

pratica riflessiva e il miglioramento delle proprie strategie cognitive;

• le zone di sviluppo prossimale diventano molteplici, arricchendo di conseguenza la comunità di

multipli expertises, ruoli, risorse che diventano oggetto di mutua appropriazione;

• si assiste ad un apprendimento con una forte base dialogica, in cui i discorsi che si creano

danno luogo a significati negoziati;

• attraverso le pratiche discorsive emergono le diverse identità individuali, in un contesto di

legittimazione delle differenze e di appartenenza alla stessa identità di comunità;

• si considera la comunità di apprendimento come una comunità di pratica (della quale si parlerà

più avanti), con le opportune distinzioni riguardanti le finalità;

• l’apprendimento è situato e contestualizzato, in un’ottica di consapevolezza di scopi, ruoli e

azioni [Varisco, 2002].

La Community of Learners così definita è caratterizzata quindi da soggetti eterogenei, i cui ruoli si

alternano a seconda delle problematiche affrontate, nell’ottica di coprire mutuamente le zone di

sviluppo prossimali appartenenti a ciascun soggetto in specifici domini. Questo processo viene

attuato mediante pratiche di apprendistato cognitivo, che consistono nel tentativo, da parte di chi si

trova ad apprendere, di imitare l’esperto nello svolgimento di un compito, mentre questi collabora

allenando ed assistendo l’apprendista, in un’ottica di partecipazione guidata.

Gli attori coinvolti si trovano a ricoprire ruoli molteplici e sovrapponibili, che possono essere

raggruppati in tre categorie: istruzione (spiegazione, consulenza), scaffolding cognitivo (guida,

rinforzo, critica all’operato), scaffolding affettivo (motivazione, empatia).

In sintesi, la CoL viene considerata dai suoi ideatori come una comunità di scienziati, i cui membri

sono studenti, insegnanti, tutor, esperti che mettono in campo la conoscenza già acquisita per

arrivare, attraverso le pratiche sopra descritte, a costruirne di nuova [Varisco, 2002].

Anche altri autori aderiscono alla prospettiva del costruttivismo socio-culturale. Tra questi c’è

David Jonassen, che concorda nell’individuare i concetti di costruzione, collaborazione e contesto

come direttive fondamentali dell’apprendimento all’interno del paradigma costruttivista socio-

16

culturale. Jonassen individua inoltre le sei qualità fondamentali che contraddistinguono questo tipo

di apprendimento. Esso deve essere:

• attivo, nel rendere l’allievo responsabile dei propri risultati;

• costruttivo, mediante il raggiungimento dell’equilibrio tra i processi di assimilazione ed

accomodamento (Piaget);

• collaborativo, per mezzo delle comunità di apprendimento (communities of learners),

l’insegnamento reciproco (reciprocal teaching) ed il sostegno (scaffolding) offerto

dall’insegnante;

• intenzionale, nel coinvolgimento attivo e consapevole dell’allievo nel perseguimento

degli obiettivi cognitivi;

• conversazionale, nel coinvolgimento dei processi sociali, in particolare quelli dialogicoargomentativi;

• contestualizzato, in quanto questo tipo di apprendimento comporta la pronta messa in pratica degli

insegnamenti in compiti riguardanti il mondo reale;

• riflessivo, perché l’allievo è indotto a riflettere sui processi attivati nella fase di

apprendimento [Varisco, 1995].

2. FORMAZIONE A DISTANZA ED E-LEARNING

2.1 Lo sviluppo della formazione a distanza

La sigla FaD (formazione a distanza) è un acronimo coniato recentemente nella storia umana, ma di

fatto questo particolare tipo di insegnamento affianca quello tradizionale almeno da quando furono

possibili i primi scambi epistolari.

La formazione a distanza si può definire come l’insieme dei sistemi di insegnamento che,

avvalendosi di particolari strumenti e tecnologie della comunicazione, integrano o sostituiscono la

formazione tradizionale erogata in compresenza di alunni e docenti. Storicamente la FaD veniva

tendenzialmente utilizzata in tutti quei casi in cui l’insegnamento in compresenza si presentasse

troppo difficoltoso o troppo costoso a causa della distanza fisica da coprire. Oggi, grazie alle

tecnologie telematiche ed informatiche, la FaD costituisce una risorsa che, oltre a limitare i disagi

della distanza fisica, arricchisce la didattica tradizionale di nuovi modelli di interazione,

insegnamento e apprendimento.

17

Lo sviluppo della FaD viene articolato in tre successive generazioni [ Trentin, 2000 ].

La prima generazione si sviluppa nell’ Ottocento, grazie al miglioramento tecnologico delle

tecniche di stampa e alla diffusione del trasporto ferroviario: questi fattori resero possibili la

produzione e la distribuzione a costi sostenibili di materiali didattici, destinati a studenti distribuiti

in vaste aree geografiche.

Si tratta dei famosi “corsi per corrispondenza”, dove il medium utilizzato è costituito da materiale

stampato, e l’interazione fra studente e docente è ridotta, distribuita attraverso lunghi archi di tempo

e costituita fondamentalmente dallo scambio di elaborati.

Con lo sviluppo dei media avvenuto nel Novecento, si afferma la seconda generazione, che può

utilizzare progressivamente, oltre alla carta stampata, anche la radio, la televisione, le audio e video

cassette. A partire dagli anni 90, con la diffusione su larga scala di personal computer in grado di

gestire materiali multimediali e grazie alla diffusione del supporto del CD-ROM, fanno la loro

comparsa i corsi che integrano testi scritti, audio e video, oltre alla possibilità di controllare in

autonomia i propri progressi grazie ad esercizi e quiz interattivi.

Dal punto di vista dei processi di apprendimento non si assiste fin qui a niente di nuovo: con lo

scorrere del tempo cambiano i media utilizzati, ma l’apprendimento viene sempre interpretato come

un processo di trasmissione della conoscenza dal docente verso il discente, in una logica

comunicativa unidirezionale di tipo uno-a-molti. La conoscenza viene qui considerata come una

verità oggettiva, rispecchiata da una mente razionale [Varisco, 1995]. Come si è visto nella prima

parte, questa visione oggettivista è stata rafforzata dall’affermazione delle teorie

dell’apprendimento comportamentiste, e supportata dallo sviluppo delle tecnologie informatiche,

che permettono una sempre maggiore ingegnerizzazione dei processi di apprendimento.

Con la terza generazione, che coincide con la diffusione di internet al grande pubblico e con lo

sviluppo delle teorie costruttiviste dell’apprendimento, la formazione a distanza diventa anche

formazione in rete, dove la parola rete assume una doppia accezione: essa diventa sia

l’infrastruttura materiale (Internet) su cui si basano gli scambi comunicativi dei partecipanti al

processo di formazione, sia lo schema delle relazioni che si instaurano fra i partecipanti, che

interagiscono fra loro applicando i principi costruttivisti dell’apprendimento collaborativo.

Con la terza generazione FaD si assiste quindi ad un cambio di paradigma pedagogico:

all’insegnamento concepito come trasmissione di saperi oggettivi si affianca la costruzione di

conoscenza negoziata mediante processi collaborativi, risultato di interazioni sociali che avvengono

all’interno di una determinata cultura, dando origine a saperi contestualizzati che non hanno pretesa

di oggettività.

18

2.2 Dalla formazione a distanza all’apprendimento in rete

La schematizzazione appena fornita non deve ovviamente essere concepita come una visione

totalizzante: i passaggi fra una generazione e l’altra sono graduali e non definitivi: l’avvento della

formazione a distanza praticata attraverso reti di computer non comporta necessariamente la fine dei

vecchi corsi per corrispondenza, né la scomparsa degli approcci didattici tradizionali. Piuttosto, si

assiste oggi ad una serie di ibridazioni fra paradigmi pedagogici e tecnologici vecchi e nuovi, che

compongono uno scenario della formazione a distanza complesso e variegato.

Lasciando da parte gli approcci alla FaD che non fanno uso della telematica, la cui trattazione esula

dagli obiettivi di questo lavoro, appare opportuno soffermarsi sulle varie tipologie di approccio

metodologico alla FaD che utilizzano tecnologie di rete (si parla, in questo caso, di e-learning). In

questo contesto, Guglielmo Trentin [2000] propone una tassonomia delle applicazioni FaD in

relazione agli approcci metodologici utilizzati per l’apprendimento. Si distingue così fra:

• apprendimento individuale;

• apprendimento assistito;

• apprendimento reciproco;

• apprendimento collaborativo.

2.2.1 L’apprendimento individuale

Questo tipo di apprendimento avviene in autoistruzione, e può concretizzarsi attraverso due

differenti modalità.

La prima consiste nella ricerca, da parte del discente, di materiali didattici sulla rete internet: questa

pratica assomiglia molto a quella di cercare in una biblioteca i testi adatti alle proprie necessità di

apprendimento, con la differenza che in rete, a causa della mole di informazioni disponibili, risulta

più complesso individuare i materiali didattici appropriati e verificarne l’attendibilità delle fonti.

La modalità appena descritta comporta la presenza nel discente di abilità specifiche nella selezione

e verifica dei materiali, il cui possesso non è cosa scontata. Inoltre il successo della ricerca e

dell’utilità didattica dei materiali reperiti non è garantito, per cui è sempre presente il rischio di

impiegare tempo ed energie per ottenere benefici molto modesti o addirittura nulli.

L’altra modalità di apprendimento individuale consiste nella fruizione di materiali didattici

preparati per essere scaricati dalla rete e quindi utilizzati. La rete diventa in questo caso una specie

di deposito di materiali, con l’importante differenza rispetto al caso precedente che ora si è in

presenza di un progetto didattico con degli obiettivi ben definiti, che comporta la disponibilità di

materiali strutturati appositamente per lo scopo desiderato.

19

2.2.2 L’apprendimento assistito

Anche in questo caso la formazione erogata è basata sullo studio individuale: tramite la rete

vengono erogati i materiali didattici, che vengono presentati strutturati in forma di corso.

Differentemente dal caso precedente è prevista l’assistenza a distanza di docenti o tutor, che hanno

il compito di facilitare il discente nella fruizione dei materiali, e di assisterlo a sviluppare

correttamente il percorso formativo previsto. In questo caso l’assistenza a distanza diventa un

elemento strutturale del processo di apprendimento, ed è per questo motivo che si parla di

apprendimento assistito.

2.2.3 L’apprendimento reciproco

Questo tipo di apprendimento è caratteristico delle cosiddette comunità di pratica, di cui si parlerà

diffusamente nel capitolo 4. Per ora, ai fini di questa tassonomia delle applicazioni FaD, è

sufficiente dire che le comunità di pratica che fanno uso di tecnologie di rete rientrano pienamente

nella modalità FaD della formazione in rete definita nel paragrafo 2.1.

Nelle comunità di pratica, infatti, in compresenza fisica o attraverso l’infrastruttura materiale della

rete internet, i partecipanti condividono conoscenza, esperienze e buone pratiche, arrivando

attraverso la collaborazione alla realizzazione di uno scopo comune e/o al miglioramento delle

proprie competenze.

Si tratta perlopiù di comunità formate da professionisti dotati di competenze eterogenee, il cui

funzionamento può essere così schematizzato: l’utente che, nella quotidianità del proprio lavoro, si

imbatte in un problema che non riesce a risolvere da solo, chiede aiuto agli altri partecipanti; se il

problema è già stato risolto da qualcuno in precedenza questi fornirà la soluzione ed avverrà

l’acquisizione di nuova conoscenza; se il problema è del tutto nuovo i partecipanti cercheranno

assieme una soluzione mettendo in campo le proprie specifiche competenze. In entrambi i casi

l’intero gruppo crescerà professionalmente, costruendo competenza attraverso dinamiche

collaborative.

2.2.4 L’apprendimento collaborativo

Anche questo approccio metodologico fa parte della formazione in rete, ed il suo funzionamento

assomiglia a quello delle comunità di pratica, con la differenza che in quest’ultimo caso si è in

presenza di un vero e proprio corso di formazione, dove studenti, docenti e tutor mettono in pratica i

principi costruttivisti dell’apprendimento collaborativo per favorire la crescita del gruppo.

20

Questa tipologia di approccio all’apprendimento prende il nome di comunità virtuale di

apprendimento, e porta in genere a risultati qualitativamente elevati [Trentin, 2000].

2.3 Alcune parziali conclusioni sulla formazione a distanza

Come mostra la trattazione svolta finora, il mondo della formazione a distanza si è evoluto assieme

ai mutamenti tecnologici succedutisi nelle vicende umane. Questo si è verificato soprattutto negli

ultimi cinquant’anni, con il rapidissimo progresso dei mezzi di comunicazione. La diffusione

dell’utilizzo del computer e della telematica al grande pubblico ha comportato però un mutamento

di paradigma, sia tecnologico che pedagogico: come si è visto nei paragrafi precedenti, l’utilizzo

delle tecnologie informatiche e telematiche nella FaD varia a seconda che si consideri la rete come

un deposito di materiali didattici, oppure come un ambiente virtuale che, attraverso approcci

collaborativi all’apprendimento, arricchisce la didattica tradizionale di nuovi modelli pedagogici.

Da notare inoltre che il livello di interattività fra i partecipanti al processo di apprendimento cresce

di pari passo con la complessità dell’approccio metodologico: si passa progressivamente dallo

studio individuale di materiali didattici, che comporta l’infrastruttura materiale minima di un sito

web da cui scaricare i contenuti da studiare, all’apprendimento collaborativo in comunità, che

coinvolge studenti, docenti e tutor in dinamiche di interazione realizzabili solo attraverso adeguate

piattaforme software.

Date queste conclusioni, è necessario a questo punto rivolgere l’attenzione alle dinamiche di

interazione che avvengono per mezzo del computer.

3. La comunicazione mediata da computer (CMC)

Quando l’interazione fra due o più soggetti non avviene in presenza, ma attraverso il mezzo

informatico, si parla di comunicazione mediata da computer (CMC), la quale costituisce una vasta

area di ricerca che interessa varie discipline, tra cui psicologia, sociologia, linguistica, ed

ovviamente informatica, i cui studi sono tuttora aperti a molteplici prospettive e soprattutto agli

scenari evolutivi della stessa CMC. In questo paragrafo, dopo aver descritto le teorie più affermate

sul funzionamento del processo comunicativo, si vogliono introdurre le principali caratteristiche

della CMC e presentare le teorie che ne descrivono il funzionamento.

21

3.1 Le teorie della comunicazione

Per comprendere meglio il funzionamento della CMC può essere utile fare riferimento alle

principali teorie della comunicazione succedutesi nel tempo.

I primi approcci teorici alla comunicazione sono di tipo ingegneristico e risalgono al periodo

immediatamente successivo alla Seconda Guerra Mondiale, ed avvengono in concomitanza con il

massiccio sviluppo delle telecomunicazioni, particolarmente quelle telefoniche. Il lavoro più

conosciuto in questo senso è La teoria matematica delle comunicazioni, di Shannon e Weaver,

pubblicata nel 1949, dove questi due autori elaborano uno schema generale dei processi

comunicativi.

3.1.1 Il modello linguistico di Jakobson

Maggiormente trattato, probabilmente anche grazie al tipo di approccio meno tecnicistico, è il

Modello generale della comunicazione del linguista russo Roman Jakobson, comparso nel 1960

nell’articolo Linguistica e poetica [1972]. In esso, rifacendosi agli schemi ingegneristici della

compagnia telefonica Bell, Jakobson elabora la sua versione del modello, il cui schema è riportato

di seguito:

Emittente

C

O

D

I

C

E

Canale

Messaggio

C

O

D

I

C

E

Ricevente

Realtà o Contesto

Il modello può essere descritto come segue:

1. EMITTENTE: la persona o l’apparecchio che invia il messaggio;

2. RICEVENTE: la persona o il dispositivo che riceve il messaggio;

3. MESSAGGIO: l’oggetto fisico (onde sonore, segni grafici, segnale elettromagnetico, eccetera)

che viene trasmesso dal punto di partenza a quello di arrivo;

4. CANALE: la via attraverso cui scorre il messaggio;

22

5. CODICE: la convenzione in base alla quale ad un certo messaggio viene attribuito un certo

significato.

6. REALTA’ o CONTESTO: tutto ciò che esiste al mondo, ovvero tutto ciò di cui si può parlare in

una comunicazione.

Jakobson si rende conto che il suo modello, per quanto valido come schema generale, non

contempla molti aspetti peculiari della comunicazione verbale umana. Egli perciò, in contrasto con

chi proponeva di espellere dalla linguistica tali aspetti, collega ad ogni elemento del suo modello

una specifica funzione, elaborando lo schema delle funzioni del linguaggio:

a. FUNZIONE EMOTIVO-ESPRESSIVA, collegata all’emittente: consiste nel segnalare, da parte

di chi parla, stati emotivi (vengono utilizzati a questo scopo intonazione, esclamazioni, volume

della voce, modi di intercalare);

b. FUNZIONE CONATIVA, collegata al ricevente: corrisponde alla pratica di indicare la persona a

cui è destinato il messaggio, facendogli capire che ci si rivolge proprio a lui ( sono utilizzati allo

scopo pronomi come tu, verbi come hai, ecc.);

c. FUNZIONE POETICA, collegata al messaggio: è la capacità di un messaggio di risultare

gradevole all’orecchio (questa funzione può essere realizzata con un ritmo regolare della frase e

con la ripetizione di alcune sillabe);

d. FUNZIONE FÀTICA, collegata al canale: consiste nel controllare che la trasmissione fisica del

messaggio stia avvenendo (il controllo viene esercitato attraverso l’emissione di particelle come

ehi, ah, si, ok, che hanno lo scopo di richiamare l’attenzione dell’interlocutore);

e. FUNZIONE METALINGUISTICA, collegata al codice: è l’atto di controllare che il codice

funzioni, ossia che la persona che ci ascolta, oltre a ricevere il messaggio, lo capisca ( la lingua

utilizzata è un esempio di codice; il ripetere ciò che si è detto con altre parole costituisce un

controllo metalinguistico);

f. FUNZIONE REFERENZIALE, collegata alla realtà o contesto: è la proprietà delle parole di

rinviare ad oggetti del mondo, ossia la capacità di avere significato.

Dall’esame del modello di Jakobson, che soprattutto nella parte riguardante le sei funzioni del

linguaggio si riferisce alla comunicazione verbale, risultano evidenti due elementi: la complessità di

un processo apparentemente semplice come quello della comunicazione; la difficoltà di applicare

tale modello alla comunicazione mediata da computer che, nel voler assomigliare il più possibile in

efficacia a quella verbale, è costretta, a causa delle caratteristiche del medium utilizzato, a fare a

meno (o ad utilizzare dei surrogati), di alcune delle funzioni del linguaggio descritte da Jakobson.

23

3.1.2 Il modello psico-sociale di Anzieu e Martin ed i modelli interlocutori

Con il modello di Anzieu e Martin la comunicazione, da fatto linguistico, inizia ad essere

considerata come rapporto psico-sociale. Gli attori coinvolti nel processo comunicativo vengono

definiti locutore ed interlocutore, ed il processo stesso viene visto come un rapporto tra due o più

personalità impegnate in una situazione comune e che discutono fra loro a proposito di significati

[Anzieu e Martin 1971, citati in Banzato 2003]. Il linguaggio non viene qui considerato come un

mezzo utilizzato per il trasferimento di informazione fra i partecipanti al processo, bensì come la

dimensione essenziale della cultura su cui si fondano gli scambi e le pratiche collettive. Ma la

comunicazione si fonda anche su elementi come postura, intonazione della voce, gestualità: gli

elementi non verbali, paraverbali e prossemici vengono integrati nel modello, e ad ogni elemento

del comportamento viene riconosciuto un valore comunicativo.

Nei modelli interlocutori si parte dalla considerazione che la comunicazione umana è, per sua

natura, dialogica ed interattiva. Nella relazione fra locutore ed interlocutore viene quindi incluso il

feedback che l’interlocutore indirizza al locutore: in base alle reazioni del suo interlocutore, il

locutore rimodula la sua comunicazione affinché giungano all’altro attore i significati che egli

intende veicolare. Inoltre il locutore esercita anche un auto-feedback quando, ascoltandosi, controlla

in ogni momento se ciò che sta dicendo corrisponde effettivamente con quello che è sua intenzione

esprimere.

La comunicazione diventa quindi concepibile solamente in base al rapporto con gli altri, e il lavoro

di cooperazione verbale individuato dai modelli interlocutori va a costituirne gran parte della sua

fenomenologia. La produzione di significati avviene attraverso una dinamica di reciprocità regolata

dall’interlocuzione, e l’atto di comunicare diventa un processo contrattuale, durante il quale i

partecipanti co-costruiscono una realtà con l’aiuto di sistemi di segni, accettando un certo numero

di principi che permettono lo scambio ed un certo numero di regole che lo garantiscono [Ghiglione

1986, citato in Banzato 2003].

3.2 Caratteristiche principali della CMC

Sintetizzando quanto detto finora, si può dire che per l’uomo la comunicazione non si limita al

transito del messaggio, ma costituisce un processo in cui i significati veicolati hanno forte

connotazione sociale, e vanno ben oltre il contenuto semantico dell’informazione trattata.

I contenuti veicolati costituiscono la comunicazione, ma altrettanta importanza hanno i messaggi

metacomunicativi di contorno alla comunicazione stessa, che assumono modalità diverse di

espressività (metalinguistica, posturale, prossemica ecc.), e che sono stati integrati con modalità

diverse nei modelli presentati nei paragrafi precedenti.

24

Tali metamessaggi descrivono il contesto all’interno del quale i contenuti vanno interpretati, e ci

permettono ad esempio di distinguere una battuta umoristica da una affermazione seria, oppure

un’espressione metaforica da una constatazione vera e propria [De Biasi, 2002]. Per dirla con il

sociologo Erving Goffman, la metacomunicazione consente agli attori del processo comunicativo di

inquadrarsi in un frame, cioè di condividere la medesima definizione della situazione, in modo tale

che la comunicazione/rappresentazione sociale a cui stanno partecipando abbia buona riuscita.

La comunicazione mediata da computer risulta in gran parte costituita da scambi di messaggi

testuali attraverso lo schermo di un computer, e deve rinunciare a buona parte dei messaggi

metacomunicativi caratteristici della comunicazione in compresenza fisica. Oltre a ciò richiede più

tempo rispetto ad una normale conversazione in presenza a causa dell’asincronicità dei tempi di

invio e risposta dei messaggi, ed è contraddistinta da una maggiore laboriosità dettata dall’uso del

mezzo informatico.

Come sottolinea Calvani [2005], questa riduzione di segnali extralinguistici caratteristica della

CMC porta in genere nella rete a comportamenti più disinibiti: si ha in tendenzialmente una

maggiore disinvoltura nell’esprimere il proprio pensiero, ma è presente anche il rischio di

comportamenti sgradevoli ed ostili, incentivati da un certo grado di impunità e di mascheramento

dell’identità che la rete consente. Inoltre, l’impossibilità di poter vedere il volto dell’interlocutore

può portare più facilmente a fraintendimenti e frustrazione causata da un feedback troppo ridotto.

Per ovviare a questi inconvenienti nel corso del tempo sono stati escogitati vari accorgimenti, fra i

quali l’uso di emoticons, icone disegnate o animate raffiguranti faccine che indicano vari stati

emotivi, e la netiquette, un insieme di regole di condotta che hanno lo scopo di migliorare

l’efficacia della comunicazione ed evitare comportamenti aggressivi.

3.3 Alcune teorie sulla CMC

Una delle prime teorie elaborate sulla CMC è quella della Reduced Social Cues (RSC), che si

sviluppa a partire dalla considerazione che la CMC avviene prevalentemente per via testuale,

conseguentemente risulta penalizzata dalla mancanza di molti elementi utili a riconoscere

l’interlocutore (social cues), come sesso, età, aspetto e molti altri disponibili nelle interazioni in

compresenza fisica. Sproull e Kiesler, gli autori di questa teoria, sostengono che questo tipo di

mancanza porti ad un “vuoto sociale” che induce a comportamenti disinibiti e a seguire meno le

tradizionali regole del comportamento.

In netta contrapposizione con Sproull e Kiesler, i ricercatori Spears e Lea elaborano la teoria SIDE

( Social Identity De-Individuation), la quale sostiene che, in taluni contesti, la scarsità di indicatori

sociali caratteristica della CMC non provoca un indebolimento delle norme, anzi le rafforza. Questo

25

accade perché l’anonimato visivo riduce la percezione delle differenze fra i membri di un gruppo

che comunica in rete, di conseguenza l’identità del gruppo nel suo insieme risulta rafforzata. Se

l’appartenenza ad un gruppo è importante per il singolo membro, allora l’identità del gruppo risulta

più forte di quella del singolo, di conseguenza il gruppo riuscirà facilmente ad imporre il suo potere

normativo sul singolo individuo.

Un altro approccio teorico è quello di Walther e Burgoon, denominato SIP (Social Information

Processing) e sviluppato ulteriormente da Walther nella teoria Hyperpersonal.

Secondo la teoria SIP la CMC non si differenzia dalle interazioni faccia a faccia per le indicazioni

di tipo sociale, bensì per l’uso del tempo: Walther e Burgoon sostengono che nella CMC lo scambio

di informazioni sociali avviene parimenti a quanto accade in presenza, ma con modalità diverse, e

con tempi più lunghi richiesti dall’utilizzo del mezzo informatico.

La contraddizione con il modello RSC è evidente, e viene spiegata dagli autori con l’utilizzo di un

diverso approccio sperimentale: nel primo caso la sperimentazione veniva condotta in laboratorio,

mentre in quest’ultimo direttamente sul campo, evitando così errori metodologici come la

limitazione del tempo a disposizione dei partecipanti e la loro collocazione all’interno della stessa

stanza.

In sintesi, la teoria SIP afferma che, qualunque sia il medium utilizzato, gli esseri umani sono

soggetti allo stesso bisogno di riduzione dell’incertezza rispetto all’identità e comportamento altrui:

essi tendono a soddisfare questo bisogno adattando le proprie strategie comunicative alle

caratteristiche del mezzo utilizzato. Nello sviluppo della teoria SIP denominato Hyperpersonal,

Walther sostiene che le caratteristiche della CMC fanno si che essa sia addirittura sovraccaricata di

contenuti sociali, diventando appunto iperpersonale.

Come si può dedurre dalla trattazione di questo paragrafo, la ricerca sulla CMC è ancora

apertissima, e sembra ben distante dal produrre teorie universalmente riconosciute come valide.

4. L’ APPRENDIMENTO COLLABORATIVO IN RETE

4.1 La prospettiva del computer supported collaborative learning (CSCL)

L’utilizzo di macchine nelle attività di insegnamento inizia negli anni 20 del Novecento, e prosegue

ispirandosi ai principi comportamentisti di istruzione programmata elaborati da Skinner. Con lo

sviluppo dell’informatica e l’avvento del cognitivismo il paradigma pedagogico è sempre di stampo

oggettivista, e la conoscenza continua ad essere concepita come qualcosa che si può travasare dalla

mente dell’insegnante a quella dell’allievo. Nello specifico, l’approccio H.I.P. del cognitismo diede

26

origine alla disciplina dell’Intelligenza Artificiale (IA), la quale poneva fra i suoi obiettivi primari

lo sviluppo di sistemi informatici in grado di simulare il comportamento di un buon docente.

Verso la fine degli ottanta però questo tipo di aspettative sull’IA viene ridimensionato di molto,

poiché ci si accorge che, fino a quel momento, risulta impresa troppo grande per le macchine

conferire un significato alle informazioni che si trovano a manipolare [G. Bonaiuti, in Calvani

2005].

Molti autori mettono in evidenza i limiti del computer inteso come “insegnante intelligente”, e si

inizia invece a scorgere in esso nuove potenzialità, sia come mezzo di comunicazione che come

strumento di sviluppo della collaborazione fra individui.

Inizialmente questa nuova filosofia nell’utilizzo dei computer viene utilizzata nel mondo delle

aziende, per la condivisione e lo sviluppo di risorse informative: l’area di ricerca che nasce in

questo campo viene chiamata CSCW, ossia Computer Supported Cooperative Work. In seguito

questo approccio viene applicato nel campo delle tecnologie per l’educazione, dove l’incontro con

le nascenti teorie costruttiviste dà luogo all’affermazione della prospettiva CSCL. Siamo all’inizio

degli anni novanta, e il CSCL si configura come una nuova area di ricerca focalizzata

sull’apprendimento collaborativo supportato da computer, che si propone di indagare come

l'apprendimento collaborativo assistito dalla tecnologia possa migliorare l'interazione tra pari e il

lavoro di gruppo, e facilitare la condivisione e la distribuzione di conoscenza ed esperienza [Sarti,

2004]. Il CSCL, almeno inizialmente, non si inserisce nel contesto della formazione a distanza: esso

si sviluppa nei laboratori delle scuole primarie nordamericane, e si pone l’obiettivo di sviluppare le

competenze cognitive degli allievi attraverso processi collaborativi di apprendimento, in accordo

con i principi costruttivisti di Brown e Campione.

Come riscontrato nel capitolo sulla CMC, la disponibilità di una rete telematica non implica

necessariamente l’instaurarsi di dinamiche collaborative, e la sola collaborazione, ammesso di

riuscire a crearla, non è sufficiente alla costruzione di conoscenza e di buone competenze cognitive.

Per fare in modo che l’approccio CSCL funzioni è indispensabile che gli aspetti didattici e

metodologici siano fortemente coordinati con le tecnologie utilizzate, attraverso lo sviluppo di

software adatti a favorire l’apprendimento collaborativo. Kolodner e Guzdial [1996, citati da

Bonaiuti in Calvani 2005] indicano quali funzioni specifiche devono essere assolte dagli strumenti

CSCL:

• promuovere l’investigazione e la costruzione del significato;

• facilitare la costruzione di conoscenza fornendo spazi per le discussioni collaborative, sollevare

problemi di apprendimento e raggiungere il consenso o nuova conoscenza;

• tenere traccia del lavoro svolto;

27

• permettere comunicazione con le persone remote;

• promuovere la riflessione relativamente alle prospettive, alle ipotesi, alle alternative e alle critiche;

• favorire la pianificazione e l’esecuzione, da parte dell’insegnante, delle attività di sostegno alla

collaborazione.

In particolare, il punto riguardante il tracciamento dei dati richiede un approfondimento. Una delle

caratteristiche salienti degli ambienti virtuali è quella della possibilità di conservare i dati derivanti

dall’utilizzo delle risorse. Questo tipo di informazioni risulta particolarmente prezioso nell’ambito

CSCL: il monitoraggio della quantità dei dati, e della quantità e qualità dei messaggi scambiati è

fondamentale per capire se l’ambiente virtuale di apprendimento predisposto funziona oppure no.

Su questo argomento si è sviluppata una specifica area di ricerca, che si pone l’obiettivo di stabilire

quali siano le più efficaci metodologie adatte a valutare gli scambi comunicativi e i processi

collaborativi che avvengono all’interno degli ambienti di apprendimento CSCL. Il dibattito si

concentra principalmente sulle modalità di utilizzo in itinere dei dati raccolti dalle piattaforme

software, dando luogo a due possibili risposte metodologiche: la prima è quella di rendere

disponibili i dati ad utenti ed insegnanti, in modo tale che possano interpretarli e decidere di

conseguenza quali azioni intraprendere per facilitare il processo collaborativo; la seconda è quella

di predisporre appositi software in grado di elaborare opportune diagnosi ed azioni sulle interazioni

esaminate.

Le ricerche CSCL degli ultimi anni si orientano più sulla seconda opzione, ritenendo opportuno lo

sviluppo di ambienti tecnologici capaci di adattarsi “ecologicamente” alle esigenze

dell’interazione umana [G. Bonaiuti, in Calvani 2005]. La differenza tecnologica fondamentale fra

le piattaforme CSCL e quelle e-learning generiche è nel tipo di approccio: le prime sono orientate a

facilitare le interazioni fra i partecipanti, e tendono a non offrire compatibilità con taluni standard

adatti alla gestione di contenuti didattici, né hanno a disposizione strumenti quali test o questionari

predisposti per la valutazione dell’apprendimento; questo è comprensibile dal momento che il

modello pedagogico CSCL punta ad ottenere la massima efficacia dei processi collaborativi messi

in atto, più che alla ritenzione delle conoscenze acquisite. Le piattaforme e-learning generiche,

invece, si basano per lo più sul modello oggettivista di apprendimento basato sul trasferimento di

conoscenze e, pur supportando vari standard e test di valutazione, sono in genere poco adatte

all’instaurarsi di dinamiche collaborative. Grazie alla vivacità del mondo del software open source,

e a vari progetti universitari di ricerca, negli ultimi tempi il contesto delle piattaforme e-learning si

sta evolvendo verso la possibilità di gestire interazioni collaborative fra gli utenti.

28

4.2 Le comunità virtuali

Con la diffusione di Internet avvenuta negli anni novanta nascono anche le comunità virtuali, che si

possono definire come gruppi di persone disponibili a condividere qualcosa in rete, aggregate da

uno o più interessi comuni.

Secondo Preece [2001, citato in Calvani 2005] una comunità virtuale è formata dai seguenti

elementi:

• individui che interagiscono socialmente mentre cercano di soddisfare le proprie esigenze o

svolgere particolari ruoli, come quello di leader o moderatore;

• uno scopo comune come un interesse, un’esigenza, uno scambio di informazioni o un servizio che

giustifichi l’esistenza della comunità;

• politiche, sotto forma di taciti presupposti, rituali, protocolli, regole e leggi che guidino le

interazioni fra gli individui;

• sistemi informatici che supportino e medino le interazioni sociali, e trasmettano un senso di

appartenenza.

Nell’ambito delle ricerche sul Computer Supported Cooperative Work, gli studi di Whittaker, Issacs

e O’Day [1997, citati in Banzato 2002] indicano i seguenti attributi fondamentali per le comunità

virtuali:

• i membri hanno un obiettivo, un interesse, un’esigenza o un’attività comune che fornisce una

prima

giustificazione per l’appartenenza alla comunità;

• i membri partecipano in modo attivo e frequente, e spesso fra i partecipanti nascono interazioni

intense, forti legami e attività condivise;

• i membri hanno accesso a risorse condivise e tale aspetto è regolato dalle politiche adottate;

• è importante la reciprocità delle informazioni, di supporto e di sevizio fra i membri;

• esiste un contesto comune di lingua, protocolli e convenzioni sociali.

Come sottolinea Calvani [2005], il concetto di comunità virtuale implica una definizione di

comunità resa libera dalla geografia e dai vicinati fisici, fondata invece su “che cosa facciamo con

gli altri”, “quanto e con chi interagiamo”, “che cosa scambiamo”.

Con il tempo il fenomeno delle comunità virtuali non è sfuggito all’attenzione dei grandi gruppi

commerciali, i quali tentano di attirare utenti nelle comunità da loro create per espandere il gruppo

di potenziali clienti. Il risultato, nella maggior parte dei casi, è quello di ambienti di interazione

malfunzionanti e di aspetto artificioso, tappezzati da invadenti e spesso demenziali banners, che

promettono, nello spazio di pochi pixel, paradisi terrestri a chi comprerà quel particolare prodotto o

servizio. La risposta dell’utente delle comunità virtuali è stata quella di prediligere, in rete, una vita

29

sociale nomade [Banzato, 2002], adottando più identità da gestire in altrettanti ambienti virtuali di

interazione, frequentati in base alle necessità del momento. L’attuale frequentatore di comunità

virtuali esplora e valuta criticamente gli ambienti che incontra, ed impara a interagire con gli altri

anche adattando il proprio modo di comunicare agli ambienti virtuali commerciali, selezionandoli in

base all’aspettativa di trovare quello che sta cercando.

4.3 Le comunità di pratica

Il paragrafo precedente, anche se non strettamente attinente all’apprendimento in rete appositamente

strutturato, rende l’idea della spontaneità che talora caratterizza i fatti che accadono in Internet.

Tale spontaneità caratterizza in parte anche le comunità di pratica: esse nascono spontaneamente in

un contesto di compresenza fisica, fra partecipanti dotati di competenze eterogenee, i quali danno

vita ad un fenomeno collaborativo orientato alla risoluzione di quei problemi pratici che possono

presentarsi nella vita lavorativa di ogni giorno. L’utilizzo di tecnologie di rete nelle comunità di

pratica, quando avviene, ha lo scopo di facilitare le interazioni fra partecipanti che sono fisicamente

distanti fra loro, o che interagiscono in maniera asincrona.

Per descrivere una comunità di pratica si possono utilizzare le parole di Etienne Wenger [1996,

citato in Trentin 2000], considerato il massimo teorico in questo campo: Le comunità di pratica

sottendono una teoria dell’apprendimento che parte dalla seguente assunzione: l’impegno in una

pratica sociale è il processo fondamentale attraverso il quale noi apprendiamo e in tal modo

diveniamo chi siamo. Il primo elemento di analisi non è né l’individuo né le istituzioni sociali

quanto piuttosto l’informale “comunità di pratica” che le persone creano per condividere nel

tempo le loro esperienze. Per denotare la caratteristica sociale dell’apprendimento, la teoria

esplora in modo sistematico l’intersezione fra aspetti concettuali che riguardano la comunità, la

pratica sociale, il significato e l’identità personale. Ciò che ne deriva è un ampio quadro di

riferimento concettuale che individua nell’apprendimento un processo di partecipazione sociale.

Riprendendo l’analisi di Wenger, Vittorio Midoro [2002] identifica i tre elementi che caratterizzano

una comunità di pratica:

• un insieme di individui mutuamente impegnati;

• un repertorio condiviso;

• un’impresa comune.

Il mutuo impegno che si crea fra i partecipanti è determinato dalla consapevolezza di essere

associati in una impresa comune. Midoro riprende Wenger nell’identificazione degli elementi

importanti che determinano il mutuo impegno:

• lavoro cooperativo, cioè lo svolgimento di una attività finalizzata all’assolvimento di una

30

funzione, come lo svolgimento di un lavoro o la risoluzione di un problema;

• diversità e parzialità, cioè una ripartizione della pratica da svolgere in base alle competenze di

ognuno (diversità), che assolve una parte specifica (parzialità) del lavoro.

• mutue relazioni, cioè le relazioni funzionali che si instaurano fra i membri della comunità.

Il repertorio condiviso dai partecipanti è costituito dall’insieme di oggetti e procedure di dominio

comune ai membri della comunità: per esempio, in uno studio legale, faranno parte del repertorio

condiviso tanto il libro del Codice Civile, quanto gli orari di apertura del tribunale.

L’impresa comune è costituita dalla realizzazione dell’obiettivo che si pongono i partecipanti, i

quali devono essere consapevoli dell’importanza del proprio ruolo, essere coinvolti nell’impresa ed

essere consapevoli della rilevanza dei ruoli altrui.

Ancora Wenger precisa che la comunità, nello svolgimento della pratica, coinvolge tre attività

principali:

• negoziazione del significato;

• partecipazione;

• reificazione.

La negoziazione del significato è il senso, socialmente costruito, che viene attribuito al lavoro

realizzato per mezzo della comunità di pratica. Tale negoziazione implica le altre due attività della

comunità: la partecipazione dei membri ai processi che portano alla realizzazione del lavoro, e

quindi alla condivisione dei significati; la reificazione, ossia la trasformazione dei processi

collaborativi che avvengono nella comunità in artefatti, materiali e non.

Queste attività consentono la realizzazione dell’impresa comune, ma non solo. Con la

partecipazione ai processi della comunità:

• il repertorio condiviso si arricchisce;

• il singolo partecipante arricchisce la propria conoscenza, ma anche modifica la propria identità,

attraverso l’acquisizione di abilità e competenze attivate dalle interazioni dialogiche e

collaborative derivanti dalla partecipazione.

4.4 Le comunità virtuali di apprendimento (VLC)

Il fenomeno delle comunità di pratica, sia in compresenza fisica che on-line, ha attirato l’attenzione

della ricerca applicata ai processi di apprendimento e alle tecnologie didattiche [Manca e Sarti,

2002]. In questa prospettiva, la comunità di pratica si configura come un ambiente di

apprendimento in cui i processi avvengono in modo spontaneo, in base a regole che non vengono

imposte dall’alto, ma piuttosto generate dai modelli di interazione dei partecipanti; si può quindi

dire che la comunità di pratica costituisce una entità naturale [Midoro, 2002].

31

Tenendo presente il modello pedagogico costruttivista delle comunità di apprendimento, la ricerca

si pone l’interrogativo di come fare a creare, in rete, processi di formazione caratterizzati da

dinamiche di funzionamento analoghe a quelle “naturali” delle comunità di pratica.

Nel cercare risposte occorre anzitutto tenere presente la distinzione principale fra i due tipi di

comunità: le comunità di pratica sono caratterizzate, nel loro funzionamento, da forme di autoorganizzazione spontanea; le comunità virtuali di apprendimento (o VLC: virtual learning

communities) invece vengono attivate da una progettazione esplicita [Manca e Sarti, 2002].

In una VLC assumono importanza fondamentale le caratteristiche della piattaforma telematica

utilizzata. Non si tratta solamente di realizzare software che permettano l’interazione fra i

partecipanti attraverso le modalità della CMC, ma piuttosto di mettere a punto una tecnologia che

offra un vero supporto alla collaborazione via rete. La tecnologia collaborativa messa a punto deve

permettere la mutua produzione di nuove pratiche, e per far questo deve essere concepita in modo

tale da non orientare le attività degli utenti secondo modelli predefiniti.

Andando oltre l’aspetto tecnologico, che rimane comunque fondamentale, Calvani [2005]elabora

una definizione di VLC: essa può essere definita come un gruppo di persone che sono indotte a

generare insieme conoscenza supportandosi reciprocamente; le dimensioni essenziali per una

comunità di apprendimento diventano: identità di gruppo, interazione sociale, identità individuale,

partecipazione, integrazione, orientamento al futuro, generazione di conoscenza, tecnologia.

Alla luce degli argomenti trattati finora, la definizione appare abbastanza chiara; da precisare che,

nel concetto di “identità di gruppo”, Calvani integra la mutualità, ossia quel rapporto di

interdipendenza e reciprocità fra i membri senza il quale non potrebbe esistere comunità.

Sono molti gli autori che si sono occupati di elaborare suggerimenti operativi orientati alla

costruzione di VLC efficaci; qui si riportano quelli di Palloff e Pratt [1999, citati in Calvani 2005]:

• definire chiaramente lo scopo del gruppo;

• creare un distintivo spazio di raccolta per il gruppo;

• promuovere efficace leadership dall’interno;

• definire norme e un chiaro codice di condotta;

• consentire un rango di ruoli per i membri;

• consentire e facilitare sottogruppi;

• consentire ai membri di risolvere i propri conflitti.

32

5. GESTIRE LA DIDATTICA IN RETE

5.1 I Learning Management system (LMS)

Più volte, nel corso della trattazione dei capitoli precedenti, si è accennato alle piattaforme software

dedicate alla progettazione e gestione di attività formative in rete. Esse vengono spesso chiamate