Ultima modifica: 27/2/2006

Anno accademico 2005/2006

Corso per gli allievi ordinari della Scuola Superiore Sant’Anna:

Metodologia delle Scienze Sociali.

Docente: Alessio Moneta1

I LEZIONE:

INTRODUZIONE ALLA METODOLOGIA DELL’ECONOMIA

Riflessione sul metodo. Metodologia vs. Metodologie. Metodologia normativa vs. metodologia

descrittiva. Continuità tra scienza e filosofia della scienza. Scienze sociali vs. scienze naturali.

Verstehen vs. erklären. Ragioni vs. cause.

“L’analisi dei metodi e delle possibilità conoscitive della scienza economica risulta tanto vecchia

quanto l’economia stessa, poiché l’origine e lo sviluppo di una disciplina scientifica sono da sempre

accompagnati da riflessioni metodologiche” (Barrotta e Raffaelli, p. 3). Esempi: riflessioni di Smith

di filosofia della scienza e riflessioni di Ricardo. Tuttavia le prima vere opere di “metodologia

dell’economia” sono considerate quelle di Senior e J.S. Mill.

•

•

•

•

•

•

•

N.W. Senior (1827) Introductory Lecture on Political Economy

J.S. Mill (1844) On the Definition of Political Economy

J.N. Keynes (1891) Scope and Method of Political Economy

….

L. Robbins (1932) The Nature and Significance of Economic Science

T. Hutchinson (1938) The Significance and Basic Postulates of Economic Theory

M. Friedman (1953), “The methodology of positive economics”.

Dagli anni ’70 l’interesse verso la metodologia dell’economia è cresciuta notevolmente. La

metodologia dell’economia è così diventata una disciplina autonoma dell’economia (o della

filosofia della scienza, a seconda dei punti di vista), con riviste e istituzioni specializzate.

Ciò è dovuto in parte al crollo dell’economia Keynesiana, in parte a nuovi sviluppi della filosofia

della scienza, dopo la pubblicazione del libro di Kuhn (1962), The Structure of Scientific

Revolutions e Lakatos (1970) Falsification and the Methodology of Scientific Research

Programmes. Nuova enfasi sulla dinamica storica dell’impresa scientifica.

Discipline empiriche vs. discipline non empiriche.

Sviluppo dell’econometria a partire dagli anni ’40 con la Cowles Commission.

Crisi dell’econometria della Cowles negli anni ’70 in seguito alla stagflation.

Bibliografia

(in * le letture più importanti, bibliosssup significa che il libro si trova nella biblioteca della Scuola)

Backhouse, R.E. (ed.) 1994, New Directions in Economic Methodology, London and New York,

Routledge, ch. 1.

*Barrotta, P. e Raffaelli, T. 1998, Epistemologia ed Economia, Torino, UTET, capitolo primo.

*Blaug, M. 1980, The methodology of economics, Cambridge University Press, part I-II. [bibliosssup]

1

Si prega di segnalare errori, suggerimenti o richieste di chiarimenti: [email protected].

1

Hausman, D. 1989, “Economic Methodology in a Nutshell”, Journal of Economic Perspectives, 3,

2,115-127.

*Hoover , K. 2001, The Methodology of Empirical Macroeconomics, Cambridge University Press,

ch. 1.

II LEZIONE:

IL PROBLEMA DELL’INDUZIONE

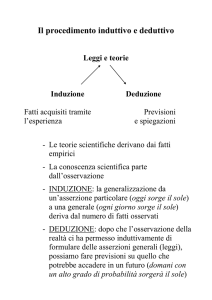

Seguendo una tradizione consolidata, le inferenze2 utilizzate nelle scienze empiriche possono essere

venire distinte in due categorie:

1. inferenze deduttive;

2. inferenze induttive.

1. Inferenze deduttive:

(i) tutte le informazioni veicolate dalla conclusione sono già incluse, più o meno esplicitamente,

nelle premesse (la conclusione non dice nulla di più – e nulla di nuovo – rispetto alle premesse);

(ii) la conclusione deriva necessariamente dalle premesse (l’inferenza è salva veritate; premesse =>

conclusione; le premesse sono condizioni sufficiente per la conclusione).

Esempio:

Premesse

Tutti i corvi sono neri;

Tutti gli uccelli viventi in quest’isola sono corvi.

Conclusione Tutti gli uccelli viventi in quest’isola sono neri.

Nota: non tutte le inferenze induttive sono “dall’universale al particolare”.

2. Inferenze induttive:

(i) la conclusione è estensiva – dice qualcosa di più – rispetto alle premesse;

(ii) l’inferenza non è salva veritate.

Esempio (1):

Premesse

Il primo corvo osservato è nero;

Il secondo corvo osservato è nero;

…

Il millesimo corvo osservato è nero.

Conclusione Tutti i corvi sono neri.

2

Inferenza: processo logico per il quale, data una o più premesse, è possibile trarre una conclusione.

2

Nota: in questo esempio si tratta di un’inferenza “dal particolare all’universale”, ma come il

prossimo esempio mostra, non tutte le inferenze induttive sono di questo tipo. In questo esempio,

inoltre, la conclusione implica necessariamente le premesse (le premesse sono condizioni

necessarie per la conclusione; premesse <= conclusione), ma neppure questa è una caratteristica

necessaria per le inferenze induttive, come mostra il prossimo esempio.

Esempio (2):

Premesse

Il primo corvo osservato è nero;

Il secondo corvo osservato è nero;

…

Il millesimo corvo osservato è nero.

Conclusione Il milleunoesimo corvo osservato è nero.

Differenza tra la cosiddetta induzione matematica e l’induzione definita in questo senso.

Cenni storici sull’induzione:

•

•

•

•

•

•

Francis Bacon (1620), Novum Organum. Le tre tavole, induzione per eliminazione ed

esperimenti cruciali.

David Hume (1739-40) Trattato sulla Natura Umana. Causalità e sfida scettica.

J.S. Mill (1843) System of Logic. I cinque canoni dell’induzione. E’interessante confrontare

l’induttivismo in filosofia della scienza di Mill con il suo deduttivismo in economia.

Empirismo logico e principio di verificazione. Dalla verifica alla conferma delle ipotesi.

J.M. Keynes (1921) A Treatise on Probability. Caratterizzazione dell’induzione all’interno

di una teoria matematica della probabilità, in cui la probabilità era interpretata come “grado

di credenza”.

R. Carnap (1962) Fondamenti logici della probabilità. Approccio probabilistico alla logica

induttiva.

Il problema dell’induzione:

Modus ponens (inferenza logicamente corretta) :

A→B

A

B

Modus tollens (inferenza logicamente corretta) :

A→B

~B

~A

L’inferenza induttiva cade facilmente nella fallacia dell’affermare il conseguente. Sia H un’ipotesi

che vogliamo confermare e A un insieme di condizioni iniziali o ipotesi ausiliarie.

3

(H & A) → O

O

(H & A)

Il problema dell’induzione si può ricondurre a tre questioni principali:

(i) Perché, in alcuni contesti, è ragionevole accettare la conclusione delle inferenze induttive, anche

quando la conclusione non segue logicamente dalle premesse?

(ii) Quali sono i criteri per decidere se, date certe premesse, una conclusione induttiva è preferibile

ad un’altra conclusione induttiva?

(iii) Quali sono i criteri per decidere se una regola induttiva è superiore ad un’altra?

I punti (ii) e (iii) hanno avuto un notevole sviluppo con l’applicazione della probabilità

all’induzione. Al punto (i) è stato risposto:

(A) Il problema dell’induzione è insormontabile. La scienza deve basarsi su inferenze deduttive,

non induttive. Per esempio, Popper ritiene che la scienza dovrebbe concentrarsi sui ragionamenti

deduttivi, ovvero, sulla falsificazione piuttosto che sulla conferma. La falsificazione, infatti, segue

inferenze deduttivamente certe come il modus tollens:

(H & A) → O

~O

~ (H & A)

(Le cose non sono, purtroppo, così semplici. Infatti non sempre è facile distinguere se stiamo

negando H o una delle ipotesi ausiliarie incorporate in A. Vedi il problema di Duhem-Quine. Per

questo Popper è costretto a parlare di gradi di corroborazione).

(B) L’induzione ha una giustificazione induttiva. Detto così, già non stiamo dando molto credito

a questo argomento, perché la sua circolarità è evidente. Però la storia e la filosofia della scienza è

piena di argomenti che giustificano l’induzione utilizzando giustificazioni più o meno

esplicitamente induttive, quali “il successo della scienza sarebbe un miracolo se i ragionamenti che

utilizza nella scoperta e giustificazione delle sue teorie fossero fallaci; i metodi della scienza

includono molti ragionamenti induttivi; i metodi induttivi funzionano e funzioneranno anche nel

futuro”.

(C) L’induzione ha una giustificazione deduttiva. Vi sono stati due modi di giustificare in

maniera deduttiva l’induzione.

1) Si è andati in cerca di prinicipi a priori sottointesi come premesse alle inferenze induttive

affinché queste potessero essere giustificate. Una potrebbe essere: “il futuro somiglia al passato”.

Essa è stata proposta da Hume, con lo scopo, non di rendere logicamente valido il ragionamento

induttivo, ma di giustificarlo. Mill propone il principio che ogni evento ha una causa sufficiente

(principio della causalità universale) e suggerisce rigorose regole metodologiche per la ricerca dei

nessi causali (i cinque canoni dell’induzione: metodo della concordanza, metodo della differenza,

metodo dell’accordo e della differenza; metodo dei residui; metodo delle variazioni concomitanti).

Keynes propone per giustificare l’induzione il principio della varietà limitata indipendente, per cui

gli oggetti del nostro campo di ricerca “non hanno un numero infinito di qualità indipendenti; in

altre parole le loro caratteristiche, per quanto numerose, si riuniscono in gruppi di connessione

invariabile che sono di numero finito”. Ai principi di Mill e Keynes si può obiettare che sono a loro

volta stabiliti induttivamente.

4

2) Utilizzando la teoria della probabilità, i ragionamenti induttivi vengono ridotti ad inferenze

deduttive:

(H & A) → O

O

La probabilità di (H & A) aumenta di un certo grado.

(Ritorneremo ai gradi di conferma di Carnap).

(C) L’induzione ha una giustificazione pragmatica.

C.S. Peirce distingueva tra deduzione, induzione e abduzione.

Esempio:

Si consideri questa semplice inferenza induttiva (da particolari ad universale):

Il reddito medio delle famiglie è aumentato in India

La percentuale di reddito della famiglia media speso in generi alimentari è diminuito in India.

In tutte le famiglie del mondo, quando il reddito aumenta la percentuale di reddito spesa in generi

alimentari diminuisce (Legge di Engel).

Rovesciando premesse e conclusioni, si ottiene la seguente inferenza deduttiva:

In tutte le famiglie del mondo, quando il reddito aumenta la percentuale di reddito spesa in generi

alimentari diminuisce (Legge di Engel).

Il reddito medio delle famiglie è aumentato in India

La percentuale di reddito della famiglia media speso in generi alimentari è diminuito in India.

L’abduzione consiste nel rovesciare il sillogismo induttivo in questo modo:

In tutte le famiglie del mondo, quando il reddito aumenta la percentuale di reddito spesa in generi

alimentari diminuisce (Legge di Engel).

La percentuale di reddito della famiglia media speso in generi alimentari è diminuito in India.

Il reddito medio delle famiglie è aumentato in India

L’abduzione è invece un’inferenza induttiva se adottiamo il criterio di distinzione tra

deduzione ed induzione esposto all’inizio di questa lezione. L’abduzione è vista spesso come

la logica della scoperta scientifica. L’idea è che tutte le credenze sono considerate fallibili,

ma particolari credenze sono considerate provvisoriamente indubitabili durante l’indagine

scientifica. La logica della giustificazione è invece guidata dalla deduzione + induzione

(analogo al metodo ipotetico deduttivo, v. sotto). Secondo Peirce se i tre metodi (abduttivo,

deduttivo ed induttivo) sono usati insieme si ottiene una procedura autocorrettiva che

dovrebbe assicurare alla comunità scientifica la scoperta della verità.

Bibliografia

*Festa, R. 1994, “Induzione, probabilità e verisimilitudine”, in G. Giorello, Introduzione alla

filosofia della scienza, Milano, Bompiani, 283-317 (paragrafo 2). [bibliosssup]

*Pizzi, C. 1983, Teorie della probabilità e teorie della causa, Bologna, CLUEB, capitolo 3.

5

III LEZIONE

LA CONFERMA DELLE IPOTESI

Metodo ipotetico-deduttivo:

1. Formulare qualche ipotesi o teoria H;

2. Dedurre, da H più altre proposizioni, qualche predizione o asserzione riguardante dati

dell’esperienza O;

3. Sottoporre a test O;

4. Confermare o non confermare H.

(H & A) → O

O

(H & A) è confermata

Nota: la premessa maggiore ((H & A) → O) riassume un’inferenza deduttiva, ma l’inferenza nel suo

complesso è induttiva.

I paradossi della conferma.

1. Paradosso di Hempel (1945)

PG (Principio di generalizzazione)

Una generalizzazione è confermata da ciascuno dei suoi esempi positivi.

PE (Principio di equivalenza)

Se due ipotesi sono logicamente equivalenti, allora ogni dato che conferma l’una conferma anche

l’altra.

Utilizzando PG e PE possiamo fare la seguente deduzione:

L’ipotesi “tutti i corvi sono neri” è confermata dall’osservazione di un corvo nero.

L’ipotesi “tutti i corvi sono neri” è equivalente all’ipotesi “tutte le cose non-nere sono non-corvi”.

L’ipotesi “tutti i corvi sono neri” è confermata dall’osservazione di una cosa non-nera che non è un

corvo (p.es. un canarino giallo).

Una possibile soluzione del paradosso rimanda all’applicazione della teoria della probabilità e

dell’inferernza statistica (vedi Giere 1970).

2. Paradosso di Goodman (1954)

L’ipotesi “tutti gli smeraldi sono verdi” è confermata dall’osservazione di un certo numero di

smeraldi verdi.

Supponiamo adesso di definire due nuovi predicati:

6

1. “x è verdlù sse soddisfa almeno una delle seguenti condizioni:

(i) x è verde ed è stato osservato prima del 2010; oppure

(ii) x è blu ed è stato osservato dopo il 2010.”

2. “x è blerde sse soddisfa almeno una delle seguenti condizioni:

(i) x è blu ed è stato osservato prima del 2010; oppure

(ii) x è verde ed è stato osservato dopo il 2010.”

Supponiamo di aver osservato che nel 2005 un certo numero di smeraldi sono verdi ed aver

confermato l’ipotesi che tutti gli smeraldi sono verdi. Ma gli smeraldi che abbiamo osservato sono

anche verdlù e quindi abbiamo anche confermato l’ipotesi che tutti gli smeraldi sono verdlù. Ne

consegue che dopo il 2010 tutti gli smeraldi saranno blu.

A chi risponde a questo paradosso proponendo di eliminare dai predicati che formano le ipotesi

riferimenti a tempi determinati, Goodman osserva che anche “verde” potrebbe essere definito con

riferimenti a tempi determinati:

“x è verde sse soddisfa almeno una delle seguenti condizioni:

(i) x è verdlù ed è stato osservato prima del 2010; oppure

(ii) x è blerde ed è stato osservato dopo il 2010.”

Il problema messo in luce dal paradosso è collegato al problema di distinguere tra generalizzazioni

legiforme e generalizzazioni accidentali, problema di cui non abbiamo soluzioni convincenti,

secondo Goodman. Quello che questo paradosso dimostra è che la distinzione tra generalizzazioni

legiformi e generalizzazioni accidentali non può basarsi su motivi puramente sintattici.

Analogamente, la forma di un’inferenza induttiva non può dirci se essa è valida oppure no, al

contrario di quanto avviene con le inferenze deduttive.

Soluzione del paradosso data da Goodman: “verde” è, a differenza di “verdlù”, un predicato che è

“trinceato” (entrenched) nel nostro linguaggio. L’entrenchment dipende dalla frequenza con cui, nel

passato, abbiamo induttivamente proiettato un predicato. In altre parole la soluzione di Goodman è

in linea con il pragmatismo: ciò che è più importante è l’accordo con l’uso concreto che si fa del

linguaggio.

Importanza di questo paradosso per le scienze sociali.

Si veda la Lucas Critique in Economia e l’importanza del concetto di stabilità od autonomia in

econometria.

Bibliografia

*Festa, R. 1994, “Induzione, probabilità e verisimilitudine”, in G. Giorello, Introduzione alla

filosofia della scienza, Milano, Bompiani, 283-317 (paragrafo 3). [bibliosssup]

*Pizzi, C. 1983, Teorie della probabilità e teorie della causa, Bologna, CLUEB, capitolo 3.

Giere, R.N. 1970, “An Orthodox Statistical Resolution of the Paradox of Confirmation”, Philosophy

of Science, 37, 354-362.

Goodman 1983, Fact, Fiction and Forecast, Cambridge MA, Harvard University Press (ch. III, IV).

[bibliosssup]

7

IV LEZIONE

LA PROBABILITA’

Che cos’è la probabilità?

Da sempre la probabilità si presenta come concetto duale. Da una parte la probabilità si riferisce alla

frequenza di un determinato evento, legata a proprietà fisiche od oggettive (p.es. di un dado),

dall’altra al grado di attesa o di credenza soggettiva che avvenga un certo evento (p.es. che domani

piove). Si può distinguere tra le seguenti concezioni della probabilità:

1.

2.

3.

4.

5.

Concezione classica;

Frequentismo;

Logicismo;

Soggettivismo;

Assiomatica.

Il calcolo delle probabilità di Kolmogorov

Partiamo proprio dall’ultima, che, di solito, non è vista come una concezione autonoma della

probabilità, ma di una formalizzazione del concetto di probabilità, a cui, di solito, si fornisce

un’interpretazione seguendo una qualsiasi tra le concezioni moderne 2,3,4. Si potrebbe però

considerare l’atteggiamento filosofico di fornire un sistema di assiomi per un concetto e di ridurre

questo concetto a nient’altro che le proprietà formali definite dagli assiomi come una concezione

indipendente dalle particolari interpretazioni. In modo analogo, Hilbert aveva fornito un sistema di

assiomi per la geometria e la logica. Tuttavia occorre tenere presente che le concezioni moderne

della probabilità 2,3,4 soddisfano tutte gli insiemi di assiomi forniti da Kolmogorov e che quindi

definire la probabilità come tutto ciò che soddisfa l’insieme di assiomi di Kolmogorov non basta.

Andrej Nikolaevich Kolmogorov (Grundbegriffe der Wahrscheinlichkeitsrechnung, 1933) ha

formalizzato la teoria della probabilità in un sistema di assiomi basati sulla teoria degli insiemi e

sulla teoria della misura. Siano A e B due proposizioni qualsiasi, appartenenti ad un insieme F di

proposizioni chiuso rispetto a negazione, disgiunzione e congiunzione (in altri termini, se A e B

sono elementi di F, anche A & B è un elemento di F, e ancora A v B, ~A e ~B sono elementi di F)3

Basandoci su Howson (2000), possiamo riformulare i principi basi della probabilità in questo modo:

1. 0 ≤ P(A) ≤ 1.

2. P(A v B) = P(A) + P(B), dove A e B sono mutuamente esclusivi.

3. P(A) = 1 se A è necessariamente vera.

4. P(A) = 0 se A è necessariamente falsa.

5. P(A) = 1 - P(~A).

6. se A implica necessariamente B, allora P(A) ≤ P (B).

7. se A è logicamente equivalente a B, allora P(A) = P(B).

8. P(A|B) = P(A & B) / P(B), con P(B) ≠ 0.

9. P(A|B) = 1 se B implica necessariamente A.

10. P(A|B) = 0 se B implica necessariamente ~ A.

3

~ A equivale a non A; A v B equivale a A oppure B (dal latino vel).

8

Normalmente la teoria della probabilità è definita riferendosi ad uno spazio di eventi, ma in questo

contesto (dato che vogliamo parlare di probabilità come strumento di conferma) è più comodo qui

parlare di proposizioni. Tuttavia, il passaggio da un algebra delle proposizioni ad un algebra degli

eventi non è difficile; basta considerare A e B come insieme di eventi e sostituire operazioni tra

proposizioni con operazioni tra insiemi nel seguente modo: & diventa ∩ (intersezione), v diventa U

(unione), ~ diventa l’operazione di complemento.

Inoltre occorre notare che quelli che sono stati qui elencati non coincidono con gli assiomi di

Kolmogorov, e non potrebbero neppure essere assiomi perché non sono indipendenti tra loro: (1),

(2), (3) e (8) implicano il resto. Gli assiomi di Kolmogorov, insieme a definizioni aggiuntive sulla

probabilità condizionale, implicano comunque (1)-(8).

Concezione classica della probabilità

La concezione classica è legata soprattutto al nome di Pierre Simon de Laplace (1749-1827),

matematico, fisico ed astronomo francese. Nel 1814 viene pubblicato l’Essai philosophique sur les

probabilités. Laplace vedeva il sistema della meccanica di Newton come il pilastro su cui costruire

l’intero edificio della conoscenza. Esso veniva interpretato alla luce di un determinismo assoluto:

ogni evento è determinato dalle sue cause. Se non riusciamo a prevedere gli eventi futuri ciò è

dovuto alla limitatezza della mente umana. In questo contesto, la probabilità è per Laplace la

“misura della nostra ignoranza”, nel senso che la probabilità dipende dalla parziale ignoranza delle

condizioni e cause dell’evento in questione.

Definizione classica di probabilità:

P(e) =

casi favorevoli ad e

casi egualmente possibili

Il problema di questa definizione è che “egualmente possibile” è difficilmente distinguibile da

“egualmente probabile”, per cui il pericolo di circolarità è evidente.

Il principio di ragione insufficiente o principio di indifferenza introdotto da Laplace ha il fine di

sfuggire a questa circolarità: “le alternative sono egualmente possibili quando non ci sono ragioni

per aspettarsi il verificarsi di una piuttosto che di un’altra”.

Tuttavia rimane il problema di cosa ritenere come alternative (p.es. supponiamo di non conoscere il

colore di un certo oggetto. Le alternative egualmente possibili sono “rosso e non rosso” o “rosso,

nero o verde”, o etc...?) . Questo problema è evidente nel paradosso della riparametrizzazione, di

cui esistono numerose versioni: si veda ad es. Festa (1994, p. 306). Supponiamo che non sappia

nulla della lunghezza di uno spigolo di un cubo, eccetto il fatto che misura al massimo 10 cm. Il

principio d’indifferenza mi suggerisce di considerare intervalli di lunghezza uguale come

equiprobabili, distribuendo la probabilità in modo uniforme (probabilità 0.1 che lo spigolo sia lungo

1 cm, probabilità 0.2 che lo spigolo sia 2 cm, probabilità 0.3 che lo spigolo sia 3 cm, etc.). Ma

allora, se assegno le probabilità nel modo appena descritto, sto assegnando implicitamente

probabilità 0.1 che il volume del cubo sia 1 cm3, probabilità 0.2 che il volume sia 8 cm3, probabilità

0.3 che il volume sia 9 cm3 etc. Tuttavia ho ragione di ritenere – non sapendo affatto il volume del

cubo eccetto il fatto che è al massimo 1000 cm3 – che l’ipotesi secondo la quale il volume del cubo

è di 8 cm3 è 8 volte (e non 2 volte!) più probabile dell’ipotesi secondo la quale il volume del cubo è

di 1 cm3.

9

Frequentismo

La concezione frequentista della probabilità è legata soprattutto ai nomi di John Venn (logico

inglese; The logic of chance, 1886), di Richard von Mises (matematico austriaco, fratello

dell’economista Ludwig; Wahrscheinlichkeit, Statistik und Wahrheit,1928) e di Hans Reichenbach

(fisico e filosofo tedesco; Wahrscheinlichkeitlehre, 1935). Essa muove dal rifiuto del principio

laplaciano di ragione insufficiente e, più in generale, dal rifiuto dell’idea che si possano assegnare

delle probabilità a priori, prescindendo cioè dall’esperienza.

La probabilità, secondo questa concezione, è legata all’osservazione di una serie di eventi (ad es. i

risultati di una serie di lanci di una moneta) ed equivale al limite in probabilità a cui tende la

frequenza relativa (la proporzione) dell’evento quando tende all’infinito il numero di elementi della

successione.

Ad es. supponiamo lanciare ripetutamente una moneta:

L1

L2

L3

L4

L5

L6

L7

L8

ottenendo i risultati:

T

C

T

T

C

C

T

C

Misuriamo ad ogni lancio la proporzione del risultato T:

1

½

2/3

¾

3/5

½

4/7

½

L9

L10

L11

L12 ….

T

C

C

C ….

5/9

½

5/11

5/12…

La legge dei grandi numeri di Jakob Bernoulli (1713) ci dice che se p è la vera probabilità di

ottenere T ad ogni lancio, se f è la frequenza relativa di T misurata ad ogni lancio, e se lanciamo la

moneta n volte:

f → p in probabilità, per n → ∞, ovvero:

P ( p - ε ≤ f ≤ p + ε) → 1 per n → ∞

Il teorema di Bernoulli sembra dare fondamenti rigorosi all’operazione frequentista di assegnare

probabilità a posteriori in base all’osservazione dell’esperienza.

Problemi del frequentismo:

1. Il limite per una frequenza relativa esiste solo in probabilità.

2. Niente ci garantisce che il limite esiste per sequenze di variabili aleatorie di cui non

sappiamo se sono distribuite identicamente.

3. Non è possibile assegnare probabilità ad eventi singoli non ripetibili.

E’ interessante notare che Von Mises negava che la concezione frequentista fosse applicabile alle

scienze morali, mancando l’uniformità necessaria dei fenomeni.

Logicismo

La concezione logicista della probabilità è legata soprattutto ai nomi di John Maynard Keynes (A

Treatise on Probability, 1921) e di Rudolph Carnap (Logical Foundations of Probability, 1950).

10

Keynes e Carnap interpretano il concetto di probabilità come una generalizzazione del concetto di

conseguenza logica. Essi sostengono che si può definire una funzione di probabilità pL che

specifica, per ogni coppia di proposizioni p e q, il grado in cui p “probabilizza” q; i casi limite sono

1, quando p implica logicamente q, e 0, quando p implica logicamente ~q.

La particolarità di questa concezione è che la probabilità viene considerata una relazione numerica

che vale tra proposizioni.

La logica della probabilità viene fatta coincidere con la logica induttiva: “tutti i ragionamenti

induttivi, nell’ampio senso di ragionamenti non deduttivi e non dimostrativi, sono ragionamenti

probabilistici” (Carnap 1950, p. v). La relazione logica su cui è basato il concetto della probabilità è

il grado di conferma di un’ipotesi (o conclusione) sulla base di qualche evidenza data (o premesse).

Pertanto la probabilità logica fornisce un diretto e rigoroso approccio al problema della valutazione

delle teorie.

I maggiori problemi della concezione logicista sono collegati al fatto che essa è basata, come la

concezione classica, sul problematico principio di indifferenza. Inoltre i tentativi di dare una

caratterizzazione formale dell’induzione (in modo che dalla forma dell’inferenza, analogamente a

quanto succede con la logica deduttiva, siamo in grado di decidere se l’inferenza è valida o meno)

sono destinati a scontrarsi con il paradosso di Goodman.

Soggettivismo

Gli esponenti principali della concezione soggettivista sono Frank Plumpton Ramsey (1903-1930;

Foundations of Mathematics and Other Essays 1926) , Bruno de Finetti (1906-1985; La prévision:

ses lois logiques, ses sources subjectives 1937) e Leonard Savage (The Foundations of Statistics

1954).

La probabilità di un evento non è nient’altro che il grado di credenza soggettiva che l’evento si

verifichi effettivamente. Questo grado di convinzione è rappresentabile numericamente ed è reso

inter-soggettivo per mezzo di alcune condizioni di coerenza che vengono imposte. Una strada,

seguita da Ramsey e Savage, è quella di arrivare a stipulare le condizioni di coerenza tramite la

teoria dell’utilità, un’altra strada, seguita dallo stesso Ramsey e soprattutto da De Finetti, è quella di

far coincidere i principi di razionalità con le restrizioni che il giocatore razionale pone sui quozienti

di scommessa. Incominciamo dalla seconda.

Scommesse e gradi di credenza (Ramsey 1926 e De Finetti 1937)

Il grado di convinzione di un soggetto può essere misurato con la disposizione a scommettere. Una

scommessa su A (es. A= “domani piove”) è un contratto in cui una parte (lo scommettitore a favore)

ottiene da un’altra parte (lo scommettitore contro) Q euro (p.es.) se A risulta vera, mentre deve ad

un’altra parte R euro se A risulta falsa. Il rapporto R/Q si chiama la quota su A; il rapporto p =

R/(R+Q) si chiama il quoziente di scommessa su A; e S=R+Q è la posta in gioco.

Il tuo grado di credenza in A (= probabilità di A) è identificato con il quoziente di scommessa in A

che tu saresti disposto ad assegnare ad una scommessa in cui il tuo avversario prende sia la

decisione riguardo all’entità della posta, sia la decisione se tu sei lo scommettitore a favore o lo

scommettitore contro.

11

La nozione di coerenza (razionale) è fondamentale per la concezione soggettivista della probabilità.

Sono pertanto esclusi sistemi di scommesse come il Dutch Book (p. es. scommessa 1: R=3€, Q=2€

su A; sommessa 2: R=3€, Q=2€ su ~A) che fanno sì che uno dei due scommettitori perda con

probabilità 1. Si può dimostrare che in un sistema di scommesse i cui quozienti di scommessa

soddisfano gli assiomi di Kolmogorov (in particolare l’assioma di probabilità finitamente additiva,

v. sopra assioma 2) non si può fare alcun Dutch Book.

Utilità e probabilità (Ramsey 1926 e Savage 1954)

La variante utilitarista del soggettivismo assume come primitive le preferenze rispetto alle

probabilità. L’idea è che le preferenze di una persona razionale possano essere governate da un

certo insieme di assiomi.

Supponiamo che tu preferisca l’evento X (es. “fare una passeggiata”) all’evento Y (es. “andare al

cinema”), ma che tu sia indifferente rispetto alle due seguenti opzioni:

1. X se A (es. “lancio la moneta ed esce testa”), Y se ~A (“esce croce”);

2. Y se A (“esce testa”), X se ~A (“esce croce”).

Ciò significa che la proposizione A ha un grado di credenza pari a ½.

L’utilità attesa dell’opzione 1 è rappresentata da U(X) P(A) + U(Y) P(~A).

Più in generale se sei indifferente tra X e l’opzione “Y se A, Z se ~A” allora il tuo grado di

credenza in A è definito dal seguente rapporto:

P(A) = (u(X) - u(Z)) / (u(Y) - u(Z))

Pertanto la probabilità può essere definita in termini di quote basate sull’utilità. Si noti che,

manipolando algebricamente l’equazione, l’utilità attesa dell’opzione “Y se A, Z se ~A”

corrisponde a u(X) = p(A) u(Y) + (1 – P(A)) u(Z).

Si può dimostrare che la probabilità così definita soddisfa gli assiomi di Kolmogorov.

Teorema di Bayes

I soggettivisti vengono anche chiamati Bayesiani per il ruolo fondamentale che svolge il teorema di

Bayes nell’aggiornare i gradi di credenza soggettivi (cioè le probabilità) ogni volta che accade un

nuovo evento.

Il reverendo inglese Thomas Bayes (1701-1761) formulò un metodo per assegnare la probabilità

inversa o la probabilità da assegnare ad un’ipotesi sulla base dell’evidenza disponibile. Nonostante

l’importanza del teorema di Bayes per la scuola soggettivista, non si trovano negli scritti di Bayes

motivi validi per considerarlo un soggettivista ante litteram.

Il teorema di Bayes segue comunque facilmente dalla definizione di probabilità condizionale (v.

assioma 8 sopra).

Infatti:

P(A|B) = P(A & B) / P(B), con P(B) ≠ 0 (assioma 8) e

P(B|A) = P(A & B) / P(A), con P(A) ≠ 0 (assioma 8), da cui segue

P(A & B) = P(B|A) P(A)

Sostituendo la terza riga nella prima riga otteniamo il teorema di Bayes:

P(A|B) = P(B|A) P(A) / P(B)

Nel contesto soggettivista (così come nella statistica bayesiana) P(A) denota la probabilità a priori

dell’evento A, P(A|B) la probabilità a posteriori dell’evento A data l’evidenza B, P(B|A) la

12

verosimiglianza di A (rispetto a B), ovvero il grado di credenza che il soggetto avrebbe nel

verificarsi di B nel caso che egli sapesse che A è vera. Dunque la probabilità finale di un’ipotesi

P(A|B) è direttamente proporzionale alla sua probabilità iniziale P(A) e alla sua verosimiglianza

P(B|A), mentre è inversamente proporzionale alla probabilità iniziale P(B) dell’evidenza B (ma

direttamente proporzionale al grado di sorpresa che ha l’evidenza B, espresso da 1/P(B)) . In questo

contesto, il teorema di Bayes svolge il ruolo di aggiornare le probabilità di eventi o ipotesi sulla

base della nuova evidenza. Le probabilità finali di oggi costituiscono le probabilità iniziali di

domani. Quanto più l’evidenza empirica è condivisa dagli agenti (o scienziati se parliamo di

probabilità di ipotesi scientifiche) tanto più diminuisce il peso delle assegnazioni soggettive di

probabilità. Così l’apprendimento bayesiano è visto dai soggettivisti come un meccanismo intersoggettivo che secondo loro riesce a far entrare un certo grado di obiettività nell’assegnazione delle

probabilità a posteriori.

Difficoltà del soggettivismo

Le principali critiche a cui sono andate incontro la concezione soggettivista della probabilità

concernono le condizioni di coerenza o di razionalità imposte alle probabilità personali. Queste

condizioni, mentre hanno il vantaggio di rendere le probabilità personali calcolabili in quanto

consistenti con gli assiomi di Kolmogorov, hanno lo svantaggio di sembrare in molti casi reali delle

vere e proprie forzature. Ecco alcuni esempi.

1. Nella definizione di probabilità come quoziente di scommessa prescinde dal fatto che una

persona reale difficilmente esprime gradi di credenza indifferentemente dalla posta in gioco.

2. La strada seguita da Ramsey (prendere la nozione di preferenza come primitiva) si scontra

con l’osservazione che per avere un’attitudine di indifferenza o preferenza è già necessario

possedere una valutazione di probabilità.

3. Gli assiomi proposti da Savage per descrivere la struttura delle preferenze coerenti generano

conclusioni paradossali (si vedano i paradossi di Allais ed Ellsberg).

4. Studi di psicologia cognitiva ed economia sperimentale hanno accertato che le misure

soggettive attribuite ad eventi incompatibili che esauriscono lo spazio campionario

(l’insieme degli eventi possibili) spesso non hanno somma uguale a 1.

5. Simili studi hanno dimostrato che gli individui non seguono schemi di razionalità

assimilabili al teorema di Bayes nell’apprendimento, ma piuttosto routines e regole del

pollice (molto interessanti gli studi di Herbert Simon a proposito).

Probabilità e conferma

Inferenza statistica di stampo frequentista

1. La teoria statistica di Fisher.

R.A. Fisher (1890-1962) è stato uno dei fondatori della moderna teoria statistica, introducendo

concetti fondamentali quali correttezza, efficienza, (massima) verosimiglianza, sufficienza di una

statistica. Qui ci interessa per l’invenzione del concetto di test di significatività. Nel caso più tipico,

si tratta di sottoporre a test il grado di corrispondenza (goodness of fit) tra una certa statistica g,

rappresentante un’ipotesi che vogliamo sottoporre a test, e una certa distribuzione χ2 (test del χ2).

Una fondamentale nozione è quella del P-value (introdotto da Karl Pearson), che corrisponde

all’area della coda della distribuzione χ2 per un certo valore di g. Se il valore della statistica g

13

corrisponde ad un χ2 maggiore di un certo valore soglia (livello di significatività), allora il P-value

viene detto significativamente basso e l’ipotesi viene rifiutata.

Principali caratteristiche metodologiche della teoria di Fisher (anni ’20 e ’30):

(i) ciò che si sottopone a test sono ipotesi statistiche, non deterministiche. Le seconde sono del tipo:

“tutti i corvi sono neri”, le prime sono del tipo “esce testa con probabilità p”;

(ii) frequentismo di fondo: il parametro sottoposto a test si trova in un intervallo di confidenza, che

corrisponde alla frequenza con cui un intervallo aleatorio contiene il vero parametro;

(iii) falsificazionismo à la Popper: l’ipotesi che viene sottoposta al test (l’ipotesi nulla) non è mai

provata o stabilita, ma solo eventualmente rifiutata.

Debolezza principale di questo approccio: arbitrarietà con cui viene scelto il livello di significanza

(normalmente vengono utilizzati i livelli suggeriti da Fisher, e cioè 1% e 5%, mentre gli statistici

bayesiani fanno notare che il livello di significanza dovrebbe dipendere dalla numerosità del

campione utilizzato).

2. L’approccio di Neyman-Pearson ai test di ipotesi.

L’inferenza statistica ortodossa (in econometria in modo particolare) è un misto tra la concezione di

Fisher e quella sviluppata dallo statistico polacco J. Neyman insieme a Egon Pearson (figlio di Karl

Pearson) negli anni ’30 del secolo scorso. Il fine della teoria di Neyman-Pearson è quello di

permettere una decisione tra due ipotesi alternative: è quindi una teoria di comportamento induttivo

piuttosto che di inferenza induttiva. L’idea della teoria di Neyman-Pearson è di stabilire un criterio

rigoroso per minimizzare le possibilità di due tipi di errori che possono occorrere quando si decide

se accettare o rifiutare un’ipotesi sulla base di un test. Se H0 è l’ipotesi sottoposta al test i due

possibili errori sono i seguenti:

(i) errore di tipo 1: H0 viene rifiutata ma H0 è vera;

(ii) errore di tipo 2: H0 viene accettata ma H0 è falsa.

La probabilità di fare un errore di tipo 1 denota il livello di significatività α del test (normalmente

1% o 5% di Fisher). La misura del test è definita come P(1-P(errore di tipo 1)) = P(1-α). Il potere di

un test è definito come P(1-P(errore di tipo 2)).

L’idea è quello di fissare α e di trovare il test più potente (Uniformly Most Powerful), cioè il test che

minimizza la probabilità di un errore di tipo 2. Il Lemma di Neyman-Pearson ci garantisce

l’esistenza di test UMP per le distribuzioni statistiche standard.

Normalmente si sceglie l’ipotesi H0 in modo che l’errore di tipo 1 sia l’errore che più vorremmo

controllare (per es. H0 = X è innocente).

Il frequentismo di fondo si manifesta nel considerare l’errore come la frequenza, se il test venisse

ripetuto ogni volta con un nuovo campione, con la quale incorreremmo in errore. Come per

l’approccio di Fisher, anche qui l’arbitrarietà con cui può essere scelto α è un punto debole.

Statistica bayesiana

A differenza dell’inferenza statistica di stampo frequentista, la statistica bayesiana non mira alla

conferma o falsificazione di un’ipotesi tout court, ma all’assegnazione di una probabilità ad

un’ipotesi sulla base dell’esperienza. In altre parole, una nuova evidenza empirica e può far

aumentare o diminuire la probabilità di una certa ipotesi H. Per questo il bayesanesimo è

considerato una teoria probabilistica della conferma, mentre la teoria di Fisher e la teoria di

Neyman-Pearson sono considerate teorie non probabilistiche della conferma (si veda Howson

2000).

14

1. Bayesanesimo soggettivo.

Il criterio di conferma in termini di aumento della probabilità di un’ipotesi è relativo alle

distribuzioni di probabilità individuali iniziali. Alcuni bayesiani cercano di sminuire il ruolo delle

probabilità a priori indicando l’esistenza di teoremi matematici che dimostrano come

asintoticamente la distribuzione delle probabilità a posteriori su una classe di ipotesi alternative tra

loro è indipendente dalla distribuzione a priori. Alcuni hanno anche fatto notare che la possibilità di

avere probabilità iniziali non vincolate è una forza dell’approccio bayesiano anziché una debolezza,

in quanto la storia della scienza è caratterizzata da una frequente mancanza di accordo tra gli

scienziati, pur avendo accesso alle stesse informazioni, circa i meriti d’ipotesi rivali. Insomma, nella

scienza c’è anche un certo grado di indeterminatezza e soggettività e i bayesiani soggettivi cercano

di darne conto. Occorre però notare che questa apertura alla soggettività è controbilanciata da rigidi

criteri di coerenza sull’apprendimento da probabilità iniziali.

2. Bayesanesimo oggettivo.

I cosiddetti bayesiani oggettivi trovano inaccettabile l’assenza di vincoli sull’assegnazione delle

probabilità iniziali (priors) e cercano di imporre nuove regole che possano determinare le

probabilità a priori in maniera unica nei casi appropriati. Esempi di tali regole sono:

- priors non informativi;

- principio di massima entropia;

- principio di semplicità.

Probabilità e paradossi della conferma

Le teorie probabilistiche della conferma offrono buone soluzioni sia al paradosso di Hempel sia al

paradosso di Goodman.

Per quanto riguarda il paradosso di Hempel occorre notare che:

(i) il principio di generalizzazione (una generalizzazione è confermata da ciascuno dei suoi esempi

positivi) non vale in una teoria probabilistica della conferma. Un esempio positivo di H può far

aumentare, diminuire o rimanere uguale la probabilità di H. L’assioma 6 ci dice che se A implica

necessariamente B, allora P(A) ≤ P (B). In questo caso, dall’assioma 7 segue che P(A|B) > P(A).

Tuttavia, dall’ipotesi H: “tutti i corvi sono neri” non segue necessariamente che e: “x è un corvo ed

un nero”. Pertanto e (l’osservazione di un corvo nero) non fa aumentare necessariamente la

probabilità di H (tutti i corvi sono neri).

(ii) l’osservazione e’ di un x non corvo e non nero, posto che x sia stato scelto da un campione

casuale delle cose non nere (x non può essere una scarpa gialla osservata in ufficio, come

suggerisce Goodman, perché in questo caso x è un non-corvo con probabilità 1), può effettivamente

fare aumentare la probabilità P(H|e’ ), ma in un modo del tutto trascurabile, se osserviamo il

teorema di Bayes. Infatti P(e’) sarà presumibilmente molto vicino ad 1, dato che non ci si aspetta di

trovare un corvo tra le cose non nere (il grado di sorpresa è quasi nullo). Si noti che se, al contrario,

in casi molto particolari, ci aspettassimo di trovare un corvo tra le cose non nere (p.es. x è preso da

un gruppo di volatili bianchi che sembrano del tutto simili a corvi) e’ effettivamente confermerebbe

H.

Per quanto riguarda invece il paradosso di Goodman occorre notare la seguente conseguenza del

teorema di Bayes. Se sia H che H’ implicano logicamente e, ne segue che P(H|e) / P(H’ |e) =

15

P(H)/P(H’ ). Quindi basta che l’ipotesi H abbia una più grande probabilità a priori rispetto a H’

perché H abbia una più grande probabilità a posteriori P(H|e) rispetto ad H’. Ed infatti è molto

facile che ciò avvenga per quanto riguarda le ipotesi alternative che troviamo nel paradosso di

Goodman. Anzi, chiunque assegnerebbe una probabilità a priori vicino ad 1 all’ipotesi H: “tutti gli

smeraldi sono verdi” ed una probabilità a priori vicino a zero all’ipotesi H’: “tutti gli smeraldi sono

verdlù”. Così uno smeraldo verde osservato prima del 2010 confermerebbe l’ipotesi H e non

l’ipotesi H’.

Le teorie di Fisher e Neyman-Pearson hanno pure buoni argomenti contro il paradosso di Hempel.

In realtà il paradosso di Hempel non reca in principio alcuna minaccia alla teoria di Fisher (così

come quella di Popper), poiché il principio di generalizzazione (una generalizzazione è confermata

da ciascuno dei suoi esempi positivi) è rifiutato a priori, e le ipotesi non sono mai provate o stabilite

dal test statistico, ma solo eventualmente rifiutate.

Il paradosso di Hempel è facilmente risolvibile anche all’interno della teoria di Neyman-Pearson (si

veda Giere 1970): se si impone che l’esempio x di una cosa non nera e non corvo sia scelto da un

campione casuale di cose non nere (come accennato sopra) non si ottengono soluzioni paradossali.

Il paradosso di Goodman non sembra invece facilmente risolvibile in ambito frequentista, a meno

che non si dica che per l’ipotesi H’: “tutti gli smeraldi sono verdlù” non abbiamo un campione

casuale significativo, ma a ciò forse si potrebbe obbiettare che non ce l’abbiamo neppure per H.

Bibliografia

*Festa, R. 1994, “Induzione, probabilità e verisimilitudine”, in G. Giorello, Introduzione alla

filosofia della scienza, Milano, Bompiani, 283-317 (paragrafi 4-5-6). [bibliosssup]

Galavotti, M.C. 2005, Philosophical Introduction to Probability, CSLI Lecture Notes (versione

inglese ampliata e riveduta della Probabilità, Nuova Italia Scientifica, Firenze, 2000).

Giere, R.N. 1970, “An Orthodox Statistical Resolution of the Paradox of Confirmation”, Philosophy

of Science, 37, 354-362.

Hájek, A. 2003, “Interpretations of Probabilities”, Stanford Encyclopedia of Philosophy,

http://plato.stanford.edu/entries/probability-interpret/#3.1

*Howson, C. 2000, “Evidence and Confirmation”, in W.H. Newton-Smith, A Companion to the

Philosophy of Science, Blackwell Publishers, Malden MA, pp. 108-116.

Howson, C. 1995, “Theories of Probability”, British Journal of the Philosophy of Science, 46, 1-32.

Keuzenkamp, H.A. 2000, Probability, Econometrics and Truth. The Methodology of Econometrics,

Cambridge: Cambridge University Press (ch. 1-4).

*Pizzi, C. 1983, Teorie della probabilità e teorie della causa, Bologna, CLUEB, capitolo 3.

16

V LEZIONE

LA CAUSALITA’

Introduzione

Il problema della causalità ha una lunghissima tradizione in filosofia, che ovviamente non

ripercorreremo qui. Basti accennare al fatto che, come è noto, mentre la formulazione di Aristotele

ha avuto un’influenza centrale per il pensiero antico e medievale, il pensiero di Hume è stato un

punto di riferimento costante per le riflessioni della filosofia contemporanea sul significato della

relazione causa-effetto. Dei quattro tipi di cause che Aristotele distingue nella Fisica (B, 194b, 2932) – lo ricordiamo in modo schematico: causa materiale (ciò di cui qualcosa è fatto), causa formale

(la forma o l’essenza di qualcosa), causa efficiente (ciò o colui che produce qualcosa) e causa finale

(il fine per cui qualcosa viene prodotto) – solo la causa efficiente è oggetto di interesse per il

pensiero scientifico moderno. La discussione sul concetto di causa (efficiente) è centrale nel

pensiero di Hume, secondo il quale gli eventi causali sono interamente riducibili, dal punto di vista

ontologico, a eventi non causali, e le relazioni di causa-effetto non sono direttamente osservabili,

ma possono essere conosciute attraverso l’esperienza di «congiunzioni costanti» (cfr. Hume 173940, libro i, parte iii, sez. 2-6, 14, 15; Hume 1748, sez. 7). La riflessione di Hume è stata

particolarmente influente sullo sviluppo non solo delle contemporanee riflessioni sulla causalità in

filosofia della scienza, ma anche sul pensiero economico contemporaneo.

Nelle scienze sociali e nell’economia contemporanea il linguaggio causale è estremamente diffuso.

Sono diversi i tipi di domande causali in economia, essendo possibili diversi punti di vista:

1. Cause generali vs. cause particolari. Le relazioni causali possono essere tra variabili (per

esempio, inflazione, reddito, tassi di interesse, etc.): gli shock alla produttività è causa delle

fluttuazioni del reddito? Oppure possono essere tra eventi: il calo della crescita in Italia del

2002 è stata causata dagli attentati dell’11 settembre 2001?

2. Cause come controllo vs. cause come spiegazione. Il primo è il punto di vista del policymaker, il secondo è il punto di vista dello scienziato sociale.

3. Cause come spiegazione vs. cause come previsione. Il secondo è il punto di vista dell’agente

operante in borsa, per esempio.

4. Cause efficienti vs. cause finali. In genere la causalità in economia, come in ogni scienza

moderna, è concepita come causa efficiente. Tuttavia non mancano tentativi di spiegazioni

teleologiche in economia e in genere nelle scienze sociali.

5. Cause micro-economiche vs. cause macro-economiche.

Svalutazione e rivalutazione del concetto di causa nel XX secolo:

Tra la fine del XIX secolo e i primi decenni del XX secolo, in concomitanza con lo svilupparsi del

positivismo e poi soprattutto del neopositivismo logico, diversi scienziati e filosofi giunsero alla

conclusione che il concetto di causalità fosse un residuo della metafisica e che andasse bandito

dall’indagine scientifica. Ernst Mach (scienziato e filosofo austriaco) propone di sostituire al

concetto di causalità il concetto di funzione (matematica).

Celebre è il giudizio sarcastico che Russel dà della causalità:

«La parola “causa” è legata tanto inestricabilmente a idee equivoche da rendere auspicabile la sua

totale espulsione dal vocabolario filosofico (…). La legge di causalità, come molte delle cose che

passano tra i filosofi, è un relitto di un’età tramontata, e sopravvive, come la monarchia, soltanto

perché si suppone erroneamente che non rechi alcun danno».

17

A partire dagli anni ’50 il concetto di causalità subisce un’evoluzione e viene nello stesso tempo

rivalutato sia in filosofia della scienza sia nelle scienze speciali. Negli ultimi anni il tema della

causalità è diventato uno dei temi più dibattuti in filosofia della scienza.

L’evoluzione del concetto di causalità, così come la sua rivalutazione è legato allo sviluppo di

alcuni nuovi strumenti logici:

(i) Calcolo delle probabilità;

(ii) Logica modale e logica dei controfattuali (David Lewis 1973 – Robert Stalnaker 1968);

(iii) Logica computazionale, sviluppo del calcolatore e nascita dei modelli di simulazione.

Inoltre, la rivalutazione del concetto di causalità è anche connessa allo svilupparsi di discipline

applicate che non avevano ricevuto fino ad allora una grande attenzione da parte della filosofia della

scienza. I filosofi della scienza – specie quelli legati al neo-positivismo logico – avevano rivolto la

loro attenzione prevalentemente alla fisica, in cui, grazie alla formalizzazione matematica, era

effettivamente possibile fare a meno di nozioni causali e prediligere il concetto di funzione. Ma in

settori disciplinari quali economia politica, sociologia, diritto, medicina, ingegneria l’esigenza di

utilizzare nozioni causali si rafforza con il loro sviluppo, sia perché alcune di queste discipline sono

meno strutturate dal punto di vista matematico (e quindi più refrattarie al concetto di funzione), sia

perché in queste discipline la nozione di intervento (legata indissolubilmente alla nozione di causa)

è centrale. Insomma, “il rinnovato interesse per la causalità deriva in parte dall’attenzione ad ambiti

disciplinari trascurati dalle correnti filosofiche prevalenti” (Dessì 1999, p. 200).

Ad es. uno dei primi segnali del nuovo interesse per la causalità negli anni ’50 è la pubblicazione di

un libro di filosofia del diritto:

H.L.A. Hart e A.M. Honoré, Causation in the Law, (1959, Oxford University Press).

Nozioni di causalità in Filosofia della Scienza:

1. Causalità probabilistica

Sviluppi della fisica nella prima metà del secolo scorso (si pensi alla fisica quantistica) hanno messo

in crisi la visione determinista del mondo alla Laplace. Alcuni filosofi della scienza (H.

Reichenbach, I. Good and P. Suppes) hanno suggerito, tra gli anni ’50 e ’70, che l’analisi di concetti

causali dovesse basarsi su nozioni probabilistiche. L’idea centrale delle teorie probabilistiche della

causalità è che la causa deve, in qualche maniera, rendere l’effetto più probabile.

Questa idea viene formalizzata da Suppes (1970) nel seguente modo: un evento A causa prima facie

un evento B se e solo se:

(i) A occorre prima di B;

(ii) P(A|B) > P(A)

Difficoltà:

(i) Difficoltà a distinguere relazioni causali spurie da quelle genuine (o, in altri termini, relazioni

causali da correlazioni): le previsioni del tempo causano il tempo?

(ii) Si basa il concetto di causalità su un concetto, quello di probabilità che è, come si è visto nella

scorsa lezione, problematico o perlomeno suscettibile di diverse interpretazioni.

18

Come vedremo sotto il concetto di causalità secondo Granger presenta molti punti in comune con la

causalità probabilistica.

2. Cause e condizioni

Vi è una lunga tradizione (J.S. Mill p.es.) che esamina la causalità in termini di condizioni

necessarie o sufficienti4:

(i) A causa B se e solo se A e B sono reali e A è ceteris paribus sufficiente per B;

(ii) A causa B se e solo se A e B sono reali e A è ceteris paribus necessaria per B;

(iii) A causa B se e solo se A e B sono reali e A è ceteris paribus necessaria e sufficiente per B.

E’ facile notare l’inapplicabilità di nozioni della causalità così definite, non solo in un mondo

probabilistico, ma anche in un mondo determinisitico (e nelle scienze sociali). Ad es.: la lunghezza

delle gambe del tavolo è ceteris paribus necessaria e sufficiente per la posizione di un asse di un

tavolo rispetto al pavimento, ma non diremmo mai che uno degli eventi è causa dell’altro.

Per quanto riguarda il caso (ii) vi è anche il problema della sovradeterminazione: se due pallottole

colpiscono simultaneamente (ad es. in un plotone di esecuzione) il cuore di un uomo e ne causano

la sua morte, nessuna delle due è condizione necessaria per la morte.

J. Mackie (1974) rifiuta le definizioni (i)-(iii) e propone di utilizzare le condizioni necessarie e

sufficienti in modo più sofisticato:

(iv) Se A causa B allora A è una condizione INUS (Insufficient Necessary Unecessary Sufficient),

cioè A è una parte insufficiente, ma necessaria, di una condizione complessa che a sua volta è

sufficiente, ma non necessaria.

Esempio: supponiamo che c’è stato un incendio causato da un corto circuito. Il corto circuito di per

sé non è sufficiente a provocare un incendio (occorre anche materiale combustibile e presenza di

ossigeno). Però la condizione complessa corto circuito + presenza di ossigeno + materiale

infiammabile vicino al luogo del corto circuito è sufficiente a provocare un incendio, mentre non è

necessaria perché altre condizioni avrebbero potuto causare l’incendio (es. benzina + fiammifero

acceso + ossigeno). Il corto circuito è una parte necessaria di quella condizione (senza corto circuito

e soltanto con materiale infiammabile ed ossigeno non sarebbe scoppiato l’incendio), ma da sola

non sufficiente per l’incendio.

Si noti però che nell’esempio preso in considerazione anche presenza di ossigeno e materiale

infiammabile sono condizioni INUS dell’incendio. Tuttavia di solito non vengono considerate come

cause e quindi la causa viene scelta da un insieme di condizioni. Solo il contesto e gli scopi che

vogliamo ottenere possono guidarci nella scelta della causa.

3. Cause e controfattuali

Alcuni filosofi contemporanei, tra i quali D. Lewis, pensano che si possa definire la causalità in

termini di controfattuali.

I controfattuali sono condizionali soggiuntivi (in contrapposizione con indicativo) in cui

l’antecedente è contrario ai fatti.

4

A è condizione sufficiente per B se la conoscenza di A ci garantisce la conoscenza di B, mentre A è condizione

necessaria per B se è indispensabile conoscere A per conoscere B. Si noti che se A è condizione sufficiente per B allora

B è condizione necessaria per A e viceversa.

19

Es. di condizionale indicativo:

(a) Se Oswald non uccise Kennedy, fu qualcun altro ad ucciderlo.

Es. di condizionale soggiuntivo-controfattuale:

(b) Se Oswald non avesse ucciso Kennedy, qualcun altro lo avrebbe fatto.

Se Oswald effettivamente uccise Kenney (a) è sicuramente vera, mentre di (b) non possiamo dire

niente. I controfattuali, pertanto, seguono una logica diversa dalla logica degli indicativi.

Lewis propone un sistema di assiomi e delle regole di inferenza per i condizionali soggiuntivi e

definisce la relazione causale come una relazione di dipendenza controfattuale. A causa B se c’è una

catena di eventi dipendenti da controfattuali che lega A e B. Questa definizione di causa richiama

quella data da Hume (1748): “possiamo definire una causa come un oggetto seguito da un altro, tale

per cui se il primo oggetto non ci fosse stato, il secondo non sarebbe mai esistito”.

La principale debolezza di questo approccio è che la nozione di controfattuale risulta avere basi

ancora più incerte della nozione di causalità.

4. Cause ed interventi

Secondo una nozione azionista della causalità, la causa è ciò che produce, o genera, qualcos’altro

(l’effetto) che è una nuova sostanza o il cambiamento in qualcosa che già sussiste. Diversi filosofi

contemporanei hanno sostenuto questa teoria (es. G. H. von Wright), che però soffre di un grosso

problema di circolarità e di antropomorfismo (la causa è basata su una nozione, l’azione, che

sembra già presupporre un significato causale e l’azione umana è al centro di questa nozione).

Tuttavia, recentemente J. Woodward (2003) ha rielaborato una teoria della causalità basata sul

concetto di manipolazione (o intervento) che supera la circolarità delle formulazioni precedenti.

L’idea è che la relazione causale è sempre relativa ad una struttura invariante in un insieme di

interventi.

Importanza del concetto di invarianza per le scienze sociali e l’economia.

Nozioni di causalità in Economia:

1. Equazioni strutturali

La nozione di causalità dominante in econometria fino agli anni ’70 è legata alla tradizione della

Cowles Commission e al lavoro di T. Haavelmo, “The Probability Approach in Econometrics”

(1944).

L’idea è che le variazioni che occorrono in modo naturale nei fattori economicamente più

importanti possano fare da surrogato al controllo sperimentale mancante. Se un’equazione di

regressione è propriamente specificata:

y = α + β x + u,

20

allora i residui u seguono una ben definita distribuzione di probabilità.

Tuttavia è la teoria economica che ci dice se x causa y oppure è y a causare x. Infatti un valore

stimato di β diverso da zero è consistente sia con x causa y sia con y causa x (problema di

identificazione). Il problema di identificazione corrisponde a quello che in filosofia della scienza è

stato chiamato il problema della sottodeterminazione della teoria da parte dei dati, problema sul

quale ha insistito in modo particolare il filosofo americano W.V. Quine.

In sintesi, l’approccio Cowles-Haavelmo affida alla teoria economica (tipicamente la

macroeconomia di stampo keynesiano) il compito di identificare le equazioni strutturali, ovvero le

equazioni che rappresentano relazioni causa-effetto, mentre affida alla statistica il compito di

misurarle. Alla relazione causa-effetto si dà un’interpretazione legata alla nozione di intervento e

invarianza: A causa B se intervenendo in A possiamo modificare B e se la relazione non muta al

variare di un certo insieme di condizioni.

2. La causalità secondo Granger

Da un lato Granger assegna un compito più ambizioso alla statistica: quello di scoprire le cause,

dall’altro lato il concetto di causa che ha in mente Granger è più debole: causalità non coincide con

intervento ma piuttosto con una certa capacità di migliorare la previsione.

Granger (1969), richiamandosi a N.Wiener (1956), centra l’attenzione sulla prevedibilità (da un

punto di vista statistico) di una serie temporale5 Xt: “se qualche altra serie temporale Yt contiene

un’informazione nei termini passati che aiuta nella previsione di Xt e se questa informazione non è

contenuta in nessuna altra serie usata per prevedere Yt, allora si dice che Yt causa Xt”. E’ invalso

l’uso, tra gli econometrici, di dire “Granger-causa” invece di semplicemente “causa”, probabilmente

per sottolineare che i due termini non sempre coincidono.

Definizione formale di Granger-causalità. Siano Xt e Yt due serie temporali, sia Ωt l’insieme delle

informazioni rilevanti che sono a disposizione al tempo t, e sia F la distribuzione condizionale di

probabilità di Xt:

Yt è una Granger-causa di Xt+1 sse:

F (Xt+1 | Ωt ) ≠ F (Xt+1 | Ωt - Yt), dove per Ωt - Yt si intende l’insieme Ωt escluso la serie storica Yt.

La definizione di Granger-causalità presenta notevoli analogie con la definizione di Suppes, anzi

essa può essere vista come un’applicazione della concezione probabilistica della causalità.

Condivide tutte le difficoltà della teoria di Suppes.

Pregi di una definizione operativa (alla P.W. Bridgman), ma rimangono molte ambiguità su come

definire Ωt.

Influsso che hanno esercitato i test di causalità secondo Granger nello sviluppo della

Macroeconomica Neoclassica.

Vicinanza tra Granger-causalità e il programma dei vettori autoregressivi (VAR) di Sims (1980).

5

Vettore di variabili aleatorie, finito o infinito.

21

3. Variabili strumentali

Un metodo per risolvere il problema dell’identificazione e dell’endogeneità (il fatto che in una

regressione la variabile indipendente o esplicativa è correlata ai residui) è il ricorso alle variabili

strumentali.

Supponiamo di voler stimare la seguente equazione:

yt = α + β zt + ut,

ma che z è correlato a u. Una variabile strumentale z è una variabile aleatoria che è correlata a x ma

non è correlata a u.

Esempio (Angrist 1990):

Studio sull’influenza del servizio militare sul reddito ai tempi della guerra del Vietnam negli Stati

Uniti:

yt : reddito

zt: servizio militare

xt (variabile strumentale): data di nascita. Infatti negli Stati Uniti durante la guerra del Vietnam era

stato stabilito di reclutare uomini, da aggiungersi ai soldati volontari, estraendo a sorte delle date di

nascita. Così le date di nascita erano correlate al servizio militare ma non allo shock sul reddito ut.

4. Causalità e modelli di simulazione

Si tratta di costruire al calcolatore economie artificiali e studiare le relazioni causali in queste

economie.

“One of the functions of theoretical economics is to provide fully articulated, artificial

economic systems that can serve as laboratories in which policies that would be

prohibitively expensive to experiment with in actual economies can be tested out at

much lower cost…. [I]nsistence on the ‘realism’ of an economic model subverts its

potential usefulness in thinking about reality. Any model that is well articulated to give

clear answers to the questions we put to it will necessarily be artificial, abstract, patently

‘unreal’” (Lucas, “Methods and Problems in Business Cycle Theory,” 1980, reprinted in

R. Lucas Studies in Business-Cycle Theory, 1981, Oxford: Basil Blackwell).

Importanza della “calibrazione” nella tradizione della Macroeconomia Neoclassica.

Simile approccio alla causalità (con notevoli differenze nelle assunzioni economiche) si trova nella

fiorente letteratura degli Agent-Based Models.

Bibliografia

*Crane, T. 1995, “Causation”, in A.C. Grayling (ed.), Philosophy 1, a guide through the subject,

Oxford University Press. [bibliosssup]

*Dessì, P. 1999, “Causalità e Filosofia”, Sistemi Intelligenti, a. XI, n. 2, agosto. [bibliosssup]

22

*Pizzi, C. 1983, Teorie della probabilità e teorie della causa, Bologna, CLUEB, capitolo 6 e 8.

*Hoover, K.D. 1998, “Causality,” in J.B. Davis, D. Wade Hands, and U. Mäki (eds.), The

Handbook of Economic Methodology, Cheltenham, UK: Edward Elgar.

Per gli studenti di economia:

Hoover, K.D. 2001, Causality in Macroeconomics, Cambridge University Press (cap. 1 e 7).

Per gli studenti di giurisprudenza:

Hart, H.L.A. and A.M. Honoré 1959, Causation in the Law, Oxford.

Stella, F. 1975, Leggi scientifiche e spiegazione causale in diritto penale, Milano, Giuffré.

VI LEZIONE

LA SPIEGAZIONE SCIENTIFICA

Richiedere la spiegazione di un evento (o di una legge) significa chiedersi il perché di quell’evento

(o legge). Nella concezione moderna della scienza non tutte le “domande-perché” sono scientifiche,

ma solo quelle la cui risposta si accorda a certi criteri logici ed empirici. Sono stati pertanto fatti

diversi tentativi di rendere espliciti questi criteri.

Modello nomologico-deduttivo

Formulato da Hempel-Oppenheim (1948), il modello N-D costituisce l’opinione ricevuta (received

view) da cui partono i contemporanee dibattiti sulla spiegazione in filosofia della scienza.

1. L1, …, Ln

2. C1, …, Cn

___________

3. E

(leggi generali)

(condizioni iniziali)

(evento – o legge – da spiegare)

1 e 2: explanans

3: explanandum

Condizioni che devono essere soddisfatte da ogni spiegazione che voglia essere considerata una

spiegazione scientificamente valida:

(a) criteri di adeguatezza logica:

(i) l’explanandum deve essere conseguenza logica dell’explanans;

(ii) l’explanans deve contenere almeno una legge di copertura (covering law);

(iii) l’explanans deve essere controllabile indipendentemente dall’explanandum (no

spiegazioni ad hoc);

(b) criterio di adeguatezza empirica:

(iv) l’explanans deve essere vero.

Esempio:

1. Legge di copertura

Ogni grave cade sulla terra con un moto accelerato uniforme di 9.8 m/s2

Velocità = accelerazione × tempo

2. Condizioni iniziali

23

Una sfera di piombo è stata lanciata 10 secondi fa e non ha ancora raggiunto il suolo.

La resistenza dell’aria sulla sfera di piombo è trascurabile.

___________________________________________________________________________

3. E

La sfera di piombo sta cadendo in questo momento ad una velocità di 98 m/s

Problema nel distinguere spiegazioni causali da spiegazioni non causali (esempio dell’ombra che

spiega l’altezza della torre).

Si presuppone qui una simmetria tra spiegazione e previsione non sempre giustificabile (specie

nelle scienze sociali).

Problema nel definire una legge di natura.

La spiegazione statistico-deduttiva

Esempio:

1. Legge di copertura (di cui almeno una statistica)

In ogni lancio casuale di un dado non truccato l’uscita di una faccia

ha probabilità 1/6; i risultati dei lanci sono probabilisticamente indipendenti.

2. Condizioni iniziali

Il dado che si lancia non è truccato; per n volte è uscito consecutivamente il sei.

____________________________________________________________________________

3. E

La probabilità dell’uscita del sei al lancio n+1 è ancora 1/6

Il modello di spiegazione S-D può essere visto come un caso speciale del modello di spiegazione ND e condivide con questo le sue debolezze.

La spiegazione statistico-induttiva

Esempio:

1. Legge di copertura (di cui almeno una statistica)

Vi è un’alta probabilità di guarire da un’infezione da streptococchi usando penicillina

2. Condizioni iniziali

Il sig. Rossi ha un’infezione da streptococchi e si cura con penicillina

___________________________________________________________________________[0.99]

3. E

Il sig. Rossi guarisce dall’infezione da streptococchi.

Problema della dipendenza dal contesto nei ragionamenti induttivi (a differenza delle inferenze

deduttive).

Problema nel definire la rilevanza statistica.

24

Spiegazioni teleologiche

Sembra esserci nelle scienze (specialmente in biologia e nelle scienze sociali) un insieme di

spiegazioni in cui l’explanans non causa (né costituisce) l’explanandum. Esse sono le spiegazioni,

già prese in considerazione da Aristotele, funzionali, o teleologiche in cui è il fine (télos in greco)

che spiega l’evento.

Esempio:

1. “Le piante contengono clorofilla affinché possano realizzare la fotosintesi”

2. “Gli orsi polari sono bianchi per mimetizzarsi con l’ambiente circostante”

3. “I consumi del sig. Rossi sono aumentati perché egli prevede un reddito più alto per l’anno

prossimo”

4. “L’impresa X mette in vendita il prodotto Y al prezzo p in modo da massimizzare i propri

profitti”

Molti filosofi della scienza contemporanei hanno argomentato che le spiegazioni teleologiche non

sono altro che spiegazioni causali camuffate e che il riferimento ad effetti futuri è solo apparente.

Gli esempi 1 e 2 possono essere riformulati facendo riferimento a cause passate, le quali sono le

traiettorie evolutive che hanno portato alla selezione naturale delle caratteristiche in questione. Gli

esempi 3 e 4 vengono spiegati, nell’economia neoclassica, facendo riferimento a forti criteri di

razionalità, ma le ambiguità non sono del tutto risolte.

Bibliografia

*Papineau, D. 1995, “Methodology: The elements of the Philosophy of Science”, in A.C. Grayling

(ed.), Philosophy 1, a guide through the subject, Oxford University Press, section V: “Explanation”,

pp. 171-179. [bibliosssup]

VII LEZIONE

LEGGI NELLE SCIENZE SOCIALI

Il problema delle leggi di natura

Una legge di natura ha in genere una struttura logica di tipo condizionale universale:

per ogni x (A(x) → B(x))

Esempio: ogni grave cade sulla terra (in assenza di attrito) con un moto accelerato uniforme di 9.8

m/s2.

Tuttavia questa struttura è posseduta anche dalle cosiddette generalizzazioni accidentali:

Esempio di generalizzazione accidentale: ogni volta che vado a vedere la Juventus, la partita finisce

0-0.

25

Come distinguere le leggi di natura dalle generalizzazioni accidentali?

1) Alcuni filosofi hanno tentato di dimostrare che le leggi di natura, a differenza delle

generalizzazioni accidentali, hanno la prerogativa di reggere controfattuali. Per esempio, una legge

del tipo: “a zero gradi l’acqua ghiaccia” regge il controfattuale “se la temperatura fosse zero gradi,

questa pozza d’acqua sarebbe ghiacciata”. Mentre una generalità del tipo “ogni volta che vado a

vedere la Juventus la partita finisce 0-0”, anche se vera, intuitivamente, non regge il controfattuale:

“se fossi andato a vedere la partita della Juventus, la partita sarebbe finita 0-0”.

Tuttavia, si apre il problema di come stabilire la verità di un cotrofattuale. Se si tenta di valutare la

verità del controfattuale in base alle leggi, si entra in un circolo vizioso perché l’idea di partenza era

proprio di servirsi dei controfattuali per discriminare tra leggi e generalizzazioni accidentali.

Causalità, legge e controfattuale risultano pertanto tre concetti interrelati, dei quali nessuno dei tre

possiede fondamenti certi in grado di sorreggere gli altri.

2) Non è la logica a distinguere tra leggi e generalizzazioni accidentali, ma la pragmatica.

Goodman suggerisce che riusciamo a distinguere tra predicati proiettabili come verde e non

proiettabili come verdlù (v. lezione III), poiché i primi sono “trincerati” nel linguaggio, cioè finora

accettati da una data comunità di parlanti. Allo stesso modo, un controfattuale è valido se comporta

una proiezione trincerata. I controfattuali validi per queste ragioni pragmatiche riescono a

distinguere tra leggi e generalizzazioni accidentali. Che cos’è una legge è quindi più una questione

d’uso, che una forma logica. Ciò ovviamente non risolve tutti i problemi, perché le scienze

sembrano far uso anche di predicati completamente nuovi e non trincerati nel linguaggio.

Leggi nelle scienze sociali

Ci sono leggi in economia?

Hoover (2001, p. 25) presenta una lista delle generalizzazioni che gli economisti chiamano leggi:

•

•

•

•

•

•

•

•

•

la legge della domanda;

la legge di Engel;

la legge di Okun;

la legge di Gresham;

la legge del prezzo unico;

la legge delle rendite decrescenti;

la legge di Walras;

la legge di Say;

e forse qualcun’altra…6

Queste leggi economiche sono un miscuglio di proposizioni molto diverse tra loro: alcune sono

assiomi, alcune verità analitiche, alcune regole euristiche. Ma almeno le prime quattro sono

generalizzazioni empiriche robuste di una forma molto imprecisa. Per esempio, la “legge della

domanda” asserisce che quando il prezzo di un certo bene cresce, la domanda cala. Però la legge

non ci dice di quanto cala la domanda per ogni dato incremento di prezzo. E sappiamo che ci sono

alcune eccezioni (benché relativamente rare) a questa legge.

Le leggi delle scienze sociali e dell’economia sembrano valere solo ceteris paribus.

6

La legge di Gibrat, per esempio.

26

Ma questo non avviene anche nella fisica? Dopotutto, se vogliamo calcolare la velocità di un grave

dobbiamo astrarre dall’attrito dell’aria. Si pensi alle difficoltà a calcolare la traiettoria di caduta di

un foglio di carta da una torre.

Alcuni filosofi (per esempio J. Woodward) rifiutano la dicotomia tra leggi e generalizzazioni

accidentali e ritengono che ci sia un continuum di generalizzazioni tra quelle empiriche e quelle

nomologiche. La nozione cruciale, in questa visione, non è però quella di legge, ma di stabilità.

Sono le relazioni causali stabili (v. lezione V), relative ad un certo intervento e al variare di un certo

numero di parametri, che ci permettono di intervenire e di spiegare. Abbiamo pertanto a che fare

uno spettro di generalizzazioni in cui in un estremo si trovano le generalizzazioni puramente

accidentali instabili al variare delle condizioni e in un altro estremo le generalizzazioni necessarie.

Alcune leggi della fisica si trovano abbastanza vicine all’estremo delle generalizzazioni necessarie,

in quanto da esse è possibile basare interventi causali che rimangono stabili al variare di un numero

molto ampio e ben definito di condizioni. Le leggi delle scienze sociali e dell’economia, si

situerebbero circa a metà di questo spettro. Infatti da esse è possibile derivare relazioni causa-effetto

stabili, ma lo spazio dei parametri in cui queste relazioni sono stabili è più piccolo e più difficile e

complesso da definire.

Bibliografia

*Hoover , K. 2001, The Methodology of Empirical Macroeconomics, Cambridge University Press,

ch. 2.

*Papineau, D. 1995, “Methodology: The elements of the Philosophy of Science”, in A.C. Grayling

(ed.), Philosophy 1, a guide through the subject, Oxford University Press, section V:

“Explanation”, pp. 139-147. [bibliosssup]

VIII LEZIONE

REALISMO E STRUMENTALISMO

Realismo e strumentalismo in filosofia della scienza

Il termine realismo scientifico è connesso a molteplici prospettive e non sempre strettamente

connesse tra loro. Cerchiamo di individuare alcune caratteristiche fondamentali:

(i) i realisti (o almeno una parte di essi) ritengono che le teorie scientifiche parlano (o dovrebbero

palare) di caratteristiche reali del mondo, le quali esistono indipendentemente dalle nostre

rappresentazioni: è quindi possibile avere teorie oggettivamente vere;

(ii) i realisti (o almeno una parte di essi) ritengono che le entità (e non necessariamente le relazioni

tra queste) di cui le teorie scientifiche parlano (o dovrebbero parlare) esistono nella realtà

indipendentemente dalle nostre rappresentazioni;

(iii) le teorie che parlano di fatti o entità inosservabili (si pensi ad es. alle particelle sub-atomiche)

vanno interpretate alla lettera: esse sono una rappresentazione fedele del mondo inosservabile.

Gli strumentalisti tendono invece a negare (i)-(iii) e ritengono che le teorie scientifiche sono utili

strumenti il cui fine non è quello di fornire una vera descrizione del mondo, ma soltanto quella di

fornire previsioni. Lo strumentalismo si accorda spesso con posizioni filosofiche (come quelle del

neopositivismo logico) che negano ogni scopo ontologico alle teorie scientifiche.

27

Occorre considerare però che realismo e strumentalismo non sono posizioni filosofiche o

scientifiche fisse, sono piuttosto direzioni verso cui gli approcci scientifici possono o meno tendere.

Così è capitato spesso nella storia della scienza che alcuni scienziati avessero approcci

strumentalistici per teorie appena formulate (es. teoria copernicana, teorie quantistiche, etc…) o in

certi ambiti di ricerca (es. cosmologia, fisica delle particelle), mentre in altri ambiti di ricerca (es.

chimica) il realismo è più difendibile.

Argomenti utilizzati a favore del realismo:

Inferenza alla migliore spiegazione (o l’argomento del “miracolo”): se le entità teoriche impiegate

dalle teorie scientifiche non esistessero o se le teorie stesse non fossero almeno

approssimativamente vere, l’evidente successo della scienza (in termini di previsioni e applicazioni)