Davide Pesare

Natural Shaders

Tesi di Laurea – corso di laurea specialistica in Realtà Virtuale e Multimedialità

Università degli studi di Torino – Facoltà di Scienze M.F.N.

Anno accademico 2003-2004 – sessione di Luglio

Relatore: prof. Albert Werbrouck

Controrelatore: prof. Nello Balossino

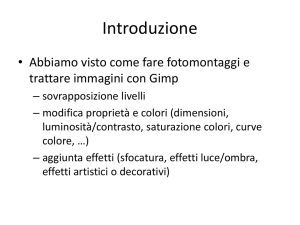

Introduzione

Al termine di un piano di studi prettamente interdisciplinare quale è il corso di

laurea specialistica in “realtà virtuale e multimedialità”, presento in questa sessione

una tesi caratterizzata dalla stessa interdisciplinarità. Si tratteranno argomenti

fondamentalmente informatici, che però hanno subìto una profonda influenza da parte

degli studi tecnici ed artistici che ho affrontato in ambito accademico e professionale.

In particolare lavorare come artista 3d in una software house di videogiochi, ed in

seguito come technical director in una casa discografica mi ha chiaramente mostrato

quali possano essere le esigenze di chi non è un informatico, nell’uso di strumenti

avanzati quali i pacchetti 3d in commercio.

La mia prima tesi, al termine della laurea triennale, trattava di tecniche di

modellazione, animazione e texturing 3D. Nella sua conclusione avevo annunciato

che avrei proseguito gli studi nello stesso campo ed approfondito le tematiche della

programmazione 3D, non limitandomi come allora a linguaggi di scripting, ma

2

affidandomi a più potenti e complessi strumenti, quali le API di windows e di

3dsMax.

Il risultato di tale approfondimento è questa tesi, dedicata alla teoria del

rendering, dei materiali e delle mappe procedurali, e soprattutto della scrittura degli

shader.

La concretizzazione di questa teoria è stata in questi mesi lo sviluppo, sulla

piattaforma 3dsMax, ma per diversi renderizzatori, di materiali (detti comunemente

shader) fotorealistici che rispondessero ai requisiti di:

• facilità d’uso ed immediatezza per gli artisti meno esperti

• alta flessibilità e personalizzabilità per gli “shading TD” più esperti

• alta qualità e realismo nel rendering, a qualsiasi livello di dettaglio

• massima integrazione nell’ambiente del pacchetto software usato

• prestazioni in termini di tempo migliori rispetto a risultati paragonabili,

ottenibili con gli strumenti di base di Max

Si tratta di una plug-in, perfettamente integrata nel celebre pacchetto 3d, che si

chiama Natural:shaders, e comprende sei materiali studiati per rappresentare

altrettanti fenomeni naturali, e rientra in un disegno più grande, denominato

SHADarts che comprende altri tre pacchetti: Industrial:shaders ed Artistic:shaders.

I sei materiali sono:

1. natural:Sand. Per la ricostruzione di spiagge e deserti

2. natural:Snow. Per la simulazione di paesaggi innevati

3. natural:Rock. Per riprodurre alcuni tipi di rocce e minerali

4. natural:Sea. Per rappresentare il mare e gli oceani

5. natural:Magma. Per modellare colate laviche in via di raffreddamento

6. natural:Ice. Per ricostruire l’aspetto di iceberg nel mare e di pareti di ghiaccio

3

In questa trattazione si toccheranno molti argomenti chiave. Si vedrà la

pipeline di lavorazione e produzione 3d, in particolare per le produzioni non

interattive, quali il cinema e la pubblicità. Si vedrà dove si collocano le varie

professionalità, tra cui quella dello shaderwriting, al centro di questa tesi. Si passerà

poi ad un breve riassunto sulla teoria e sulla evoluzione nella storia del rendering.

Sarà spiegato cosa è un renderer, e perché è oggi disgiunto dagli shader stessi. Si

vedranno le texture procedurali, una frontiera ancora aperta alla ricerca di matematici,

fisici e informatici. Si vedrà poi la implementazione attuale dei materiali su 3dsMax,

e le sue differenze rispetto ad altri pacchetti software. Verranno visti in dettaglio tutti

gli shader componenti Natural:Shaders, le loro problematiche e le loro qualità. Ci

sarà una attenzione particolare alle interfacce utente, diverse in approccio rispetto a

quelle di 3dsMax. Si vedrà brevemente il meccanismo di licenza della plugin,

integrato anch’esso in 3dsMax senza disturbarne il funzionamento. Infine ci sarà una

breve illustrazione sul futuro delle produzioni in computer grafica e della scrittura di

shaders.

Il progetto è stato sviluppato in C++, utilizzando le API di 3dsMax e della

piattaforma Windows. Il sistema di licenza ha avuto bisogno di alcune utility

disgiunte, sviluppate in Visual Basic ed in MaxScript (linguaggio di scripting

integrato in 3dsMax).

Per la licenza, la request utility è stata sviluppata da Alessandro Cangelosi.

Parte dello sviluppo di Natural:ice è stato integrato da Davide De Conti. Le bozze

delle shading network da cui è partito lo sviluppo sono state curate, oltre che da me,

da Alessandro Cangelosi e da Filippo Pierdicca.

4

1. La pipeline di lavorazione 3d nei Visual FX

In questo capitolo si tratta la pipeline di lavorazione di prodotti in computer

grafica prettamente 3d, ad alta qualità e non interattiva. Quindi non si tratta di realtà

virtuale. Il campo di applicazione di questi prodotti spazia dalla pubblicità al cinema

alle produzioni multimediali scientifiche o di intrattenimento.

Per prima cosa va sottolineato che difficilmente si troveranno due case di

produzione con la stessa pipeline lavorativa. Questo è dovuto ai gusti dei dirigenti,

alle competenze presenti nelle risorse umane, al tipo di tecnologie di cui si dispone,

fino anche alla organizzazione fisica e geografica della azienda.

Per questa ragione la pipeline che spiegherò non è da vedere come l’unico

modello valido, ma uno dei modelli in uso. In particolare ho fatto riferimento alla

pipeline in uso presso la Weta Workshop e la Weta Digital per “Il Ritorno del Re” ed

a quella della Square Pictures, usata “Final Fantasy”.

5

Si noti che delle fasi elencate nessuna è disgiunta dalle altre. A produzione

avanzata si può cambiare un personaggio con un altro, e cambiare perfino lo

storyboard, così come le esigenze di illuminazione di un elemento nella scena ne

potrebbero richedere la sua rimodellazione.

Figura 1.1. Storyboarding

La prima fase è quella di definire un tema ed una storia. A questo ci pensano il

regista, l’autore ed i loro assistenti. Appena si hanno in piedi un po’ di idee si

mettono al lavoro numerosi artisti “tradizionali”: fumettisti, disegnatori, concept

artists. A loro si affida il look dei personaggi, delle ambientazioni, secondo i dettami

del regista. A loro si fa preparare lo storyboard. Uno storyboard è un modo per

pianificare una storia digitale in due dimensioni. La prima dimensione è il tempo:

cosa succede prima, e cosa succede dopo. La seconda dimensione è l’interazione:

come interagisce la storia con le immagini? Come aiutano le transizioni visive e gli

effetti a legare le immagini? Ogni elemento può interagire con ogni altro, e lo

storyboard è il luogo per pianificare l’impatto che si vuole avere sul pubblico.

6

Figura 1.2. Animatic

Subito dopo si ha la creazione di un animatic, o storyboard in 3d che ha il

vantaggio di contenere già le tempistiche ed i movimenti di camera abbozzati per

avere una idea più chiara di come realizzare gli shot. Attualmente ci sono aziende di

effetti speciali che si dedicano alla produzione di animatic, tramite lo sviluppo di

software di previsualizzazione. Un esempio è la Pixel Liberation Front, che oltre a

produrre effetti speciali, ha un reparto dedicato alla previsualizzazione, che viene

usato anche per dare consulenza ad altre case di produzione.

Figura 1.3. Modellazione

7

Contemporaneamente il reparto di modellazione inizia i lavori, realizzando

ogni parte richiesta nella produzione. Gli artisti sono divisi in gruppi a seconda della

loro specializzazione: personaggi, scenari, accessori. Ogni produzione affronta il

problema a modo suo. Se per la Square Pictures tutti i modelli sono stati prodotti

direttamente in 3D, alla Weta sono stati costruiti prima in creta o in plastilina, e poi in

silicone, per poi modellarli in 3d su Maya (Alias) prima e rifinirli su ZBrush

(Pixologic) dopo. Infine alla BlueSky studios, sopra i modelli in creta sono state

direttamente disegnate le linee del wireframe e, una volta scannerizzati, i modelli

erano già pronti per gli ultimi ritocchi. Non è raro ricorrere alla modellazione

procedurale o a quella basata su immagini quando il lavoro è tanto e il tempo poco. In

certe situazioni si preferisce perfino ricorrere alle tecniche tradizionali: modelli in

scala fatti di plastilina, dipinti a mano da artisti dedicati e poi ripresi da cineprese,

pronti per essere composti con gli effetti speciali. E’ questo il caso della città di

“Minas Tyrith” in “Il ritorno del re”.

Figura 1.4 Rigging

Accanto ai modellatori, i character TDs (technical directors) preparano il

rigging dei personaggi e degli oggetti per facilitare e aumentare le possibilità

espressive degli animatori. Il character setup (o rigging) è una fase cruciale, in quanto

8

crea tutti gli strumenti che l’animatore avrà a disposizione. Se gli strumenti sono

inadeguati i personaggi risulteranno difficili da animare come se fossero di legno, o

di plastica. Un buon rigging per contro permetterà di dare dell’espressività

eccezionale. Questo è di particolare importanza nelle produzioni non fotorealistiche,

dove i personaggi digitali hanno un design “cartoon” e hanno bisogno di esagerare le

proprie espressioni oltre i tipici limiti umani.

Normalmente prima di iniziare una produzione in Computer Grafica si sceglie

e si acquista o si sviluppa un motore di rendering adatto alle necessità. Lo sviluppo

degli shader, o shaderwriting, si basa infatti sul linguaggio accettato dal particolare

motore di rendering. Questa è una fase cruciale. Chi scrive gli shader (shaderwriter o

shading TD) deve avere notevoli competenze informatiche, ma anche nei campi più

vari di ottica, estetica, fisica, ecc… Il “look” di un film si deve in gran parte al talento

impalpabile di chi ha scritto il software che gestisce e genera i materiali e le texture.

Per scrivere un singolo shader può essere necessaria una settimana come poche ore.

L’italiano Guido Quaroni, R&D Shading Group Lead alla Pixar, racconta di quanto

uno shader di base, usato per la produzione di tutti gli altri, possa effettivamente dare

una impronta ad un film, come ha fatto con “Finding Nemo”.

Figura 1.5 Esempio di shader in "Alla Ricerca di Nemo"

9

Non bisogna confondere gli shaderwriter con chi disegna poi le texture, ovvero

i Texture Artist. Questi sono gli artisti che con tavolette grafiche o strumenti ancora

più avanzati, usando programmi appositi di disegno 2D, come Photoshop (Adobe)

producono le texture usate dai materiali preparati dagli shaderwriter, per creare dei

materiali completi, fotorealistici o surreali, a scelta del regista. Gli stessi strumenti

vengono usati anche dai Matte Artist, che invece di produrre texture producono

sfondi, spesso riccamente miscelati con elementi 3d renderizzati e poi ritoccati.

A lavorare al fianco degli shaderwriter c’è lo staff dei Lighting TD. A loro

spetta dapprima illuminare le scene al massimo per vedere gli errori di modellazione.

In seguito cercano di creare l’illuminazione più adatta al singolo shot o alla singola

scena. Sebbene le tecnologie di illuminazione globale fotorealistica e fisicamente

corretta progrediscano rapidamente, spesso i lighting TD preferiscono affidarsi ad un

approccio più tradizionale. Cioè posizionano e regolano tutte le luci a mano e

disattivano i fenomeni di radiosità. Questo approccio, se è meno corretto fisicamente,

permette di ottenere illuminazioni più espressive, che sottolineino o nascondano gli

aspetti che vuole il regista. A volte le leggi fisiche vengono del tutto stravolte. Le

traiettorie dei fotoni si piegano, le riflessioni convesse funzionano come fossero

concave. Le ombre sono del tutto inventate. Ma questo non è un problema fino a

quando il pubblico non se ne accorge, e fino a quando questi trucchi servono ai fini

della narrazione. Altre volte questi trucchi sono utilizzati solo per accelerare i tempi

di calcolo. Una delle sfide più grandi è l’illuminazione dell’incarnato dei personaggi,

per fare in modo che appaia realistico. I personaggi sono di gran lunga la cosa più

ardua da illuminare. Il metallo e la plastica sono molto più semplici dell’incarnato,

perché esso possiede grandi proprietà di traslucenza e semitrasparenza come del resto

anche i capelli. Si deve lavorare molto da vicino col dipartimento dei personaggi che

fornisce gli shader per le superfici. Ci potrebbero essere aggiustamenti ad hoc per

ciascuna ripresa.

Dopo una prima sessione di doppiaggio da voci reali, viene la fase più lunga e

laboriosa: l’animazione. Basandosi sugli animatic (anche essi prodotti da talentuosi

10

colleghi) e sulle voci registrate, gli animatori producono gli shot, uno a uno,

utilizzando i rigging preparato per loro, e cercando di adeguarsi quando si deve

miscelare l’animazione in computer grafica con scene riprese dal vivo. Talvolta per

migliorare il realismo dei personaggi la prima fase di animazione è realizzata in

Motion Capture. Questa tecnica, che da sola meriterebbe molto più di questa tesi per

parlarne esaurientemente, permette di “catturare” i movimenti degli attori e di

trasferirli sui personaggi. A partire da questi movimenti, gli animatori arricchiscono

le animazioni correggendo i dati catturati ed aggiungendo i movimenti che non

possono essere catturati adeguatamente (le piccole ossa come le dita o le espressioni

facciali) con gli strumenti attuali.

Figura 1.6 Motion Capturing

Esiste poi tutta una sezione composta da varie figure professionali (TD,

animatori, sviluppatori…) che si occupa degli effetti speciali propriamente detti:

esplosioni, illusioni, scontri, e tutto ciò che rende spettacolare una pellicola e che non

si può – o non conviene – riprendere dal vivo. Spesso si riconduce a questo staff

anche l’animazione di masse di “comparse” digitali, cui si dedicano i programmatori

per creare le cosiddette animazioni procedurali, che si basano su nozioni di fisica e di

intelligenza artificiale.

Si ha poi la fase di rendering. Questa fase viene eseguita interamente dai

computer, ma le scene vengono pianificate e suddivise in layer prima di essere

11

mandate in rendering. Viene quindi la fase di compositing, che secondo molti

professionisti è in grado di salvare o distruggere un film intero. I singoli layer

renderizzati vengono passati separatamente ai compositor. Il layer di fondo spesso

non è una immagine 3D. Gli scenari più lontani sono dipinti “manualmente” su

computer, cioè si usano i Matte Painting descritti in precedenza.

Spesso mettere insieme tutte le caratteristiche CG richiede più potenza artistica

di quanta sia necessaria per un film dal vivo. Quando si lavora ad un film dal vivo, si

prende la pellicola e si sa di ogni cosa quale colore necessita dal momento che risulta

essere stato definito dal dipartimento di illuminazione.. Si sa che il cielo è blu, l’erba

verde e così via. Ma in un mondo fantastico e virtuale, la prima volta che il layer e

l’effetto finale vengono realmente messi insieme, è nella fase di compositing. Per cui

è necessario che l’addetto al compositing concettualizzi ed immagini l’intera

sequenza per poter prendere diverse decisioni artistiche. Gli addetti al compositing

sono anche responsabili dell’eliminazione di errori non evidenti fino a tale stadio

finale. Realizzano di tutto, dalla sistemazione della CG all’inserimento di key-light,

alla creazione di elementi. Tirano fuori capelli dal mento del personaggio o da

qualunque altro posto dove non era prevista la loro presenza. Correggono anche gli

errori di ombre e adeguano il bilanciamento della pelle contro altre caratteristiche dei

visi. Scovano punti nei personaggi dove risulta che l’interno delle narici od il bianco

degli occhi appaia troppo brillante; mescolano il colore con quanto presente dietro

facendo in modo che si adatti al meglio.

Le sequenze composte vengono infine messe insieme in shot, quindi

assemblate in sequenze più lunghe dal regista e dal tecnico del montaggio. Infine

vengono le sessioni di registrazione della colonna sonora e dei suoni, ed il secondo

doppiaggio, quello finale.

Come si vede, le fasi descritte non sono compartimenti stagni e interagiscono

pesantemente fra loro. Sono tutte vitali per il successo di una pellicola o di una

produzione CG in generale. Ci concentreremo in questa tesi sulla figura dello

shaderwriter.

12

2. Teoria del rendering.

2.1. Geometria

Uno shaderwriter deve avere le idee molto chiare su come funziona la

geometria e la matematica utilizzate nel processo di rendering. In questi paragrafi si

farà un breve ripasso della teoria sottostante.

2.1.1. Equazioni primitive

Le curve e le superfici che sono usate in computer grafica sono tutte derivate

da vari tipi di equazioni matematiche. Inserendo valori nelle variabili delle equazioni,

esse identificano quali punti sono sull’oggetto e quali no. Ci sono tre tipi di equazioni

13

che forniscono la base della maggior parte delle primitive in computer grafica:

esplicite, implicite e parametriche.

Una equazione esplicita è una equazione che valuta una coordinata della

posizione dal valore delle altre coordinate. Per esempio, z = 2x + y è l’equazione

esplicita di un piano. Una delle caratteristiche dell’equazione esplicita, è che

matematicamente è una funzione, il che significa che ha un solo risultato per ogni

insieme di coordinate di input. Questo significa che non può ripiegare su se stessa,

come fa per esempio una circonferenza.

In un’equazione implicita certi valori di input soddisfano una equazione del

tipo: surface(x,y,z) = 0; I punti che soddisfano l’equazione sono sulla primitiva,

mentre gli altri non lo sono. Per esempio x2 + y2 + z2 – 1 = 0 è l’equazione implicita

di una sfera. Il punto (0.6,0,0.8) è sulla sfera perché soddisfa l’equazione, mentre il

punto (0.4,0.8,0.2) non lo è. I punti che sono generati da equazioni implicite

complesse non sono sempre connessi – ci possono essere piccole regioni isolate che

soddisfino l’equazione. Questo rende difficoltoso trovarli tutti.

Una superficie parametrica è una superficie generata da una equazione con due

variabili: P=surface(u,v). Per esempio, una sfera può essere generata dalle equazioni

parametriche

x = cos(alpha)cos(beta)

y = sin(alpha)cos(beta)

z = sin(beta)

Altre preziose superfici parametriche comprendono i piani, tutte le superfici

quadratiche, bilineari e bicubiche, e le NURBS.

In generale, non si è interessati in superfici parametriche infinite, ma in loro

sottoinsiemi, che sono generati ponendo dei limiti ai parametri, tipicamente tra 0.0 e

1.0. Si noti che è semplice riparametrizzare le equazioni con altri limiti parametrici,

con una semplice sostituzione di variabili, così che questa scelta non causa nessuna

14

restrizione reale. Per esempio, invece di avere la sfera nelle precedenti equazioni

parametrizzate per alpha tra 0 e 2Pi e beta tra –Pi/2 e Pi/2, possiamo cambiare le

equazioni in questo modo: x = cos(2Pi u) cos(Pi v – Pi/2), per valori di u e v tra 0 e 1.

Alcune superfici, come le sfere, possono essere definite sia implicitamente sia

parametricamente, ma la maggior parte delle equazioni parametriche non sono

facilmente “implicitizzabili”.

Le superfici parametriche hanno due proprietà interessanti che le rendono utili

nella computer grafica. Primo, poiché l’equazione parametrica può essere calcolata

direttamente, si può computare qualsiasi punto sull’oggetto assegnando dei valori ai

parametri. E’ facile generare alcuni punti che sono sulla superficie e poi approssimare

il resto della superficie con approssimazione lineare. Questa tecnica si chiama

tassellazione. Secondo, poiché si ha un’equazione che mappa una coppia 2D di

coordinate parametriche nel 3D, la superficie ha un sistema di coordinate 2D

naturale. Questo rende facile mappare altri dati 2D sulla superficie. Il più ovvio di

questi dati è una texture.

2.1.2. Tangenti e Normali

Avere delle equazioni matematiche per le nostre primitive geometriche ci

permette di usare i meccanismi della geometria analitica e l’analisi matematica per

calcolare proprietà importanti delle equazioni, che a loro volta sono proprietà

importanti delle primitive geometriche. Due delle più importanti di queste sono le

tangenti e le normali.

La tangente di un punto su un oggetto è un “oggetto piatto” che semplicemente

tocca l’oggetto in quel punto ma non lo interseca né lo penetra, almeno non nelle

immediate vicinanze di quel punto. In due dimensioni, la tangente a una curva è una

linea ed è unica. Generalmente non si è interessati nella tangente di per se, ma in un

vettore direzione che ha la stessa direzione. Questo vettore si definisce vettore

15

tangente. Il valore della direzione è calcolato valutando la derivata della curva in quel

punto, una operazione generalmente semplice se abbiamo una equazione parametrica

della curva.

In tre dimensioni, la tangente a una superficie è un piano ed è unico. Ogni

vettore che giace sul piano tangente è tangente alla superficie, perciò ci sono infiniti

vettori tangenti, uscenti dal punto a tutte le direzioni del piano. Generalmente, è

abbastanza facile trovare due vettori tangenti: si prendono le derivate parziali della

superficie rispetto ai due parametri.

Un altro concetto importante (che è probabilmente ovvio se ci si pensa su un

attimo) è che c’è una unica direzione che è perpendicolare, o normale, a un piano.

Questo vettore unico è detto vettore normale del piano. Di particolare interesse è il

vettore normale al piano tangente ad un punto particolare sulla superficie. Questo

vettore sarà detto normale del punto, e sarà denotato con N.

Questa relazione tra piani e normali significa che si può derivare l’uno

dall’altro. Ogni vettore perpendicolare alla normale deve essere nel piano tangente,

mentre la normale è perpendicolare a tutto i vettori nel piano tangente. Ci vogliono

due vettori per definire un piano (per esempio le derivate parziali che definiscono il

piano tangente), così l’unico vettore perpendicolare ad entrambi i vettori deve essere

la normale al piano. Vale a dire il prodotto vettoriale delle due derivate. Viceversa, se

si ha un vettore normale ad un punto, si sa immediatamente il piano tangente in quel

punto.

2.1.3. Curvatura

Il concetto successivo oltre la tangente ad un punto è la curvatura. Come la

tangente misura la direzione di una linea che tocca l’oggetto senza intersecarlo

localmente, la curvatura misura il raggio di una circonferenza che tocca l’oggetto

senza intersecarlo. Se la circonferenza è molto piccola, la superficie ha una alta

16

curvatura; se viceversa è molto grande, la superficie ha piccola curvatura. Come ci si

può aspettare, la curvatura è calcolata usando le derivate seconde della superficie nel

punto considerato. Si noti che la curvatura è una quantità con segno. Una curvatura

positiva indica che la superficie curva verso la normale, a forma di coppa. Una

curvatura negativa significa che la superficie si allontana dalla normale, come un

ombrello aperto dalla sua punta. Una curvatura nulla indica una superficie piatta.

Così come ci sono infiniti vettori tangenti ad un punto su una superficie, così ci

sono infinite curvature, corrispondenti a tutte le circonferenze orientate a diversi

angoli intorno al punto. Di queste, alcune in particolare sono degne di nota. Su una

superficie parametrica le curvature nelle due direzioni parametriche sono interessanti

perché facili da calcolare. Comunque, questi valori non sono necessariamente i “più

curvati” della superficie nel punto. Se si vogliono ottenere questi, dobbiamo calcolare

le curvature principali k-max e k-min. Nella maggior parte delle superfici, i due

valori hanno lo stesso segno, oppure uno di loro è nullo. Se i segni sono differenti le

superfici si dicono a “sella”.

2.1.4. Continuità

Quando due primitive con diverse equazioni sono posizionate a contatto fra

loro, concettualmente unite per essere parte dello stesso oggetto, si è spesso toccati

dal problema della continuità della giunzione. Il tipo di continuità che esiste alla

giunzione determina se la giunzione si può dire “morbida” o “smooth”.

Ci sono quattro tipi di continuità che sono di interesse:

• C0: la superficie è connessa ma potrebbe avere degli angoli.

• C1: la prima derivata non ha discontinuità. Ma potrebbe avere dei cambi

bruschi di curvatura.

• C2: la derivata seconda, o curvatura, non ha discontinuità. La superficie appare

“smooth”

17

• C∞: nessuna derivata ha discontinuità. La superficie è matematicamente

continua.

Per esempio, quando due poligoni hanno in comune un bordo ma c’è un angolo

fra loro, la giunzione ha un angolo, e perciò la superficie è C1 continua al bordo ma

non è C2 continua.

2.2. Fisica ed Ottica

Molti algoritmi nella computer grafica, in particolare quelli di shading, si

affidano alla simulazione di vari aspetti della fisica dei materiali e della luce per

ottenere il loro realismo. Talvolta le proprietà fisiche sono duplicate esattamente,

talvolta sono approssimate, spesso però sono ignorate interamente e rimpiazzate da

regole inventate ad hoc.

2.2.1. Lo spettro luminoso

La luce visibile è un’onda di energia elettromagnetica dentro un certo

intervallo di lunghezze d’onda (dai 380 nanometri ai 750 nanometri, ovvero dai 790

ai 400 teraHertz). Infatti, la maggior parte delle forme di luce visibile contengono un

continuum di frequenze, ciascuna a differenti intensità. Questa funzione di intensità a

varie frequenze è detta “spettro” della luce. Ogni lunghezza d’onda corrisponde a un

colore nell’arcobaleno, e i raggi di luce che sono dominati da un colore particolare

appaiono alla vista di quel colore. I raggi di luce che hanno uno spettro simile a

quello della luce solare, sostanzialmente piatti su un ampio intervallo di colori ma in

qualche modo dominati dai colori vicini ai 530 nm (verde), appaiono bianchi alla

vista, e sono detti “luce bianca”.

18

La maggior parte delle interazioni tra la luce ed i materiali sono dipendenti

dalla lunghezza d’onda, il che significa che hanno diversi effetti su luci di diversa

lunghezza d’onda. Per esempio, la rifrazione attraverso un prisma separa la luce in un

arcobaleno di colori perché la direzione della rifrazione della luce dipende dalla

lunghezza d’onda del raggio stesso. Le lunghezze d’onda blu sono rifratte più di

quelle rosse.

Quando si guarda ad un oggetto, si vede lo spettro della luce che è riflessa da

quell’oggetto. Il colore della superficie dell’oggetto è dovuto al fatto che ogni

materiale assorbe più luce a certe lunghezze d’onda e riflette più luce ad altre

lunghezze d’onda. Questo processo, dove il colore è determinato dalla luce risultante,

dopo che certe porzioni dello spettro sono state rimosse, si chiama colore sottrattivo.

Il filtraggio della luce trasmessa è un altro esempio di un processo sottrattivo. Il

colore di un filtro come un pezzo di vetro colorato, è principalmente basato sullo

spettro che rimane, dopo che la luce passata attraverso è stata filtrata. Un filtro rosso

è quel filtro che assorbe la maggior parte di tutto lo spettro, tranne il rosso.

Il processo complementare, dove la luce è determinata sommando insieme i

contributi di diverse sorgenti luminose colorate, è detto colore additivo. I monitor e le

televisioni sono un esempio di processo additivo. Il colore su un monitor è la somma

degli spettri che il fosforo emette (in realtà, questa è una situazione piuttosto

complessa, dovuta a una sottile interazione con il nostro sistema di visione).

2.2.2. Riflessione e Rifrazione

Quando la luce viene riflessa da una superficie specchiante, la direzione del

raggio riflesso è facilmente calcolabile grazie alla ben nota massima che “l’angolo di

riflessione è uguale all’angolo di incidenza”. Questa relazione è mostrata nella figura

2.1. Distillando questa relazione in una equazione, si approfitta del fatto che il vettore

normale descrive il piano riflettente.

19

Figura 2.1 Calcolo dei vettori di riflessione

Guardando alle relazioni dei vettori nella figura, è piuttosto facile da dire, solo

guardando, che il vettore di riflessione può essere calcolato con R = I+2(αN) per

qualche costante α. Richiamando un po’ di trigonometria, ed assumendo i vettori N e

I normalizzati, si vede che cos(θ) = α/1.0. Ma ricordando la regola del prodotto

scalare, si può affermare che α = (-I · N). Con un po’ di algebra, si conclude che R = I

-2(I ·N)N. Si scopre che l’equazione è la stessa anche se I non è normalizzato, mentre

è un po’ più complessa se N non lo è.

Quando la luce si rifrange attraverso una superficie trasparente, la direzione del

vettore rifratto è computata usando l’equazione ben nota, detta Legge di Snell. Questa

legge specifica come la luce è piegata usando gli indici di rifrazione del materiale che

la luce sta abbandonando e del materiale in cui la luce sta entrando. L’indice di

rifrazione di un materiale, normalmente denotato con η (eta), è una costante fisica del

materiale e può essere cercata in libri di riferimento di fisica. Per i materiali più

comuni, l’indice di rifrazione è compreso tra 1 e circa 2.4. In parole semplici, quando

la luce entra in un materiale che è più denso, è piegata verso la normale della

superficie; mentre quando entra in un materiale meno denso, è piegata via dalla

normale. L’equazione corretta è: ηleavesin(θleave) = ηentersin(θenter), dove θ è l’angolo tra

la normale alla superficie ed il raggio di luce su quel lato.

20

Ci sono diverse importanti sottigliezze a proposito della rifrazione che uno

shaderwriter deve conoscere. Primo, l’indice di rifrazione del materiale è in realtà

dipendente dalla lunghezza d’onda. Questo significa che mentre la luce viaggia

attraverso il materiale, alcuni colori vengono deviati più di altri. Per alcuni materiali

questo effetto è trascurabile, ma per altri è piuttosto evidente. I prismi infatti lavorano

in questo modo.

Figura 2.2 Vettori di rifrazione

Secondo, quando la luce colpisce un oggetto, non importa quanto possa essere

pulito, non tutta entra interamente nel materiale. Un po’ di luce è assorbita,

naturalmente, ma un po’ è anche riflessa. L’equazione di Fresnel ci dice l’intensità

della luce che passerà attraverso, e l’intensità che verrà riflessa dalla superficie.

L’equazione di Fresnel dipende pesantemente dall’angolazione della luce in entrata,

perché la luce che colpisce perpendicolarmente la superficie verrà fortemente

trasmessa, mentre la luce che colpisce molto di sbieco, verrà fortemente riflessa.

Terzo, è interessante considerare la seguente situazione. La luce è dentro il

materiale denso, e si avvicina al confine ad un angolo molto vicino al parallelismo

con il confine stesso. Poiché la rifrazione piega la luce perfino più di quanto sia già

distante dalla normale alla superficie, l’equazione di Snell implica che l’angolo di

rifrazione potrebbe superare i 90 gradi. Questo significa che il vettore di luce rifratta

21

rimarrebbe dentro l’oggetto più denso. Questa non sarebbe rifrazione, naturalmente,

così la luce rifiuta di andare in quella direzione. La rifrazione semplicemente non

avviene, e la luce è invece interamente riflessa. Questa situazione è nota come

“riflessione interna totale”, e le fibre ottiche la sfruttano per minimizzare la

dispersione di energia sulle lunghe distanze.

E’ anche utile notare che se la luce passa attraverso un solido piatto con i

confini paralleli (ad esempio un pannello di vetro), la direzione finale della luce sul

lato lontano sarà la stessa di quella originale. La luce viene deviata di lato e dopo

viene deviata esattamente come prima, e l’unica differenza è che i raggi risultano

spostati lateralmente.

2.2.3. Interazione della luce con le superfici

Quando la luce colpisce la superficie di un oggetto, una qualche porzione della

luce è assorbita dall’oggetto, e una altra porzione è riflessa in varie direzioni. Lo

spettro che viene riflesso con più forza è visto come il colore dell’oggetto. Le

direzioni ed i colori esatti della riflessione dipendono da molti fattori, come la

direzione della luce in entrata, la struttura chimica ed elettrica del materiale, la

geometria macroscopica e microscopica della superficie, e perfino gli effetti fisici,

come la diffrazione e l’interferenza. I materiali che appaiono lisci tendono a riflettere

la luce principalmente nella direzione del vettore di riflessione, ed a non rifletterne

nelle altre direzioni. I materiali che appaiono più opachi o ruvidi tendono a riflettere

luce in un ampio intervallo di direzioni. I materiali trasparenti, come la plastica ed il

vetro, rifrangono un po’ di luce basandosi sulle equazioni di Fresnel. I materiali

iridescenti riflettono colori diversi a diversi angoli di incidenza, a causa della

interferenza distruttiva nella riflessione.

Infatti, queste proprietà di riflessione della luce sono di fatto componenti di

una caratteristica più comprensiva del materiale conosciuta come funzione di

22

distribuzione della riflessione bidirezionale, o BRDF. Il BRDF determina l’intensità

di riflessione in ogni direzione ad ogni lunghezza d’onda, basandosi sulla direzione

della luce. Non ci sono tecniche buone in generale per predire con esattezza il BRDF

di un materiale basandosi sulla composizione chimica e sul processo di costruzione,

così la tavola di BRDF per un materiale è quasi sempre creata dall’analisi attenta di

un campione del materiale stesso.

Capita spesso che a livello microscopico, la superficie di un materiale sia in

realtà un complesso composto di diversi tipi di materiali mischiati insieme o

sovrapposti l’uno sull’altro, ciascuno dei quali ha un diverso BRDF. Per esempio, la

plastica comune è un miscuglio di un materiale di base bianco e trasparente con

sospese all’interno delle piccole schegge di colore opaco. La pelle umana, d’altra

parte, è una complessa sovrapposizione di cellule traslucenti, alcune vive altre morte,

alcune brune altre rosse, coperte da sottili livelli di sebo e sudore, che nel complesso

ha una complicatissima interazione con la luce che la colpisce.

2.2.4. Camera e Profondità di Campo

Le macchine fotografiche hanno tre parti importanti: un sistema di lenti, un

diaframma con un’apertura variabile, ed una pellicola per registrare l’immagine. Il

sistema di lenti nelle fotocamere moderne e di solito piuttosto complicato –

ingrandisce, è tipicamente regolabile in diversi modi, compensa per certi tipi di

distorsione ottica, ecc… Comunque, ad ogni dato zoom e impostazione di fuoco, il

sistema composto di lenti diventa effettivamente equivalente ad una singola lente

perfetta. Il sistema di lenti focalizza la luce sulla pellicola, che si stende su un piano

sul retro della camera, dietro l’occlusore. A causa del modo in cui lavorano le lenti,

l’immagine sulla pellicola risulta invertita. Stringere l’apertura impedisce a parte

della luce di raggiungere la pellicola, e perciò scurisce l’immagine.

23

La caratteristica primaria di una lente è la sua lunghezza focale, che è la

distanza dal centro della lente al punto dove la luce proveniente da un oggetto posto

all’infinito sarà messa a fuoco. La lunghezza focale di una lente semplice è

determinata semplicemente da come è fatta, dal materiale, e dalla curvatura della

lente, per cui è costante. Comunque la luce che non viene da un punto posto

all’infinito sarà focalizzata ad una distanza diversa, come determinato dall’equazione

della lente sottile (thin lens equation):

1/(distanza oggetto) + 1/(distanza immagine a fuoco) = 1/(lunghezza focale)

Si noti da questa equazione che come un oggetto si avvicina alla camera,

l’immagine si mette a fuoco più lontano dietro alla lente. Una camera focalizza sugli

oggetti più vicini muovendo avanti e indietro la lente così che la distanza dalla

pellicola coincida con la distanza dall’immagine a fuoco di quell’oggetto.

Quando il piano della pellicola non è correttamente impostato per un dato

oggetto, questo risulterà fuori fuoco. La luce in movimento verso il fuoco ha la forma

di un cono, e un piano della pellicola non allineato taglia il cono in una più o meno

grande area circolare. Questa area si chiama cerchio di confusione, e la sua

dimensione dipende da due cose: la quantità di disallineamento tra il piano della

pellicola ed il punto focale, e dal diametro della lente. Si noti che una lente più

piccola avrebbe un cono di luce più piccolo, in modo che tutti i cerchi di confusione

risulterebbero minori.

La caratteristica interessante del cerchio di confusione è che se è minore di una

certa dimensione – per esempio della grana della pellicola o del potere di risoluzione

dell’occhio umano – non lo si nota, e l’oggetto appare ancora a fuoco. Per questa

ragione, anche se c’è solo una unica distanza alla quale la lente mette esattamente a

fuoco, c’è un intervallo di distanze per le quali gli oggetti sono così poco sfuocati che

il cerchio di confusione non è rilevabile. Questo intervallo di distanze è noto come

profondità di campo della camera.

24

Si noti che modificare l’apertura del diaframma ha l’effetto di cambiare il

diametro della lente senza intervenire sulle sue altre caratteristiche fisiche.

Diminuendo l’apertura, si tagliano i lati dei coni di fuoco, il che ha il doppio effetto

di scurire l’immagine e di stringerne i cerchi di confusione. Avere cerchi più piccoli

implica che ci sono più oggetti a fuoco, e quindi che la profondità di campo è

aumentata. Se l’apertura fosse stretta fino a quasi zero, niente avrebbe un cerchio di

confusione rilevante, e tutto risulterebbe a fuoco. Per questo le camere puntiformi

hanno profondità di campo infinita.

2.3. Computer Grafica

Nei trent’anni in cui la computer grafica è stata studiata, sono stati inventati

molti algoritmi, tecniche, e trucchi del mestiere. Negli anni, molti sono stati raffinati,

messi su una forte base teorica, e studiati estensivamente. Altri hanno dei trucchi,

usati perché hanno un bell’aspetto. Spesso non è facile determinare (o ricordare) cosa

è che cosa. Ma avere una ferma base di queste tecniche è vitale per scrivere degli

shader.

2.3.1. Antialiasing

L’Aliasing è forse il più fastidioso artefatto che infesta le immagini

computerizzate. Anche noto come “salto di scala” o “jaggies”, l’alias è un termine

che viene dalla teoria della sintesi dei segnali per descrivere artefatti che vengono dal

campionamento inadeguato della scena (o funzione) sottostante.

Una scena è continua, il che significa che la descrizione della scena fornisce

sufficiente informazione perché ci sia un colore ad ogni punto infinitesimale del

25

piano dell’immagine. I pixel di una immagine invece sono campioni di colore della

scena spaziati regolarmente. Quei pixel discreti che si decide di mettere nel frame

buffer sono perciò solo rappresentativi dei colori, continuamente cangianti,

sottostanti. Se si dovesse disegnare un grafico dei colori continui (in una o in due

dimensioni), si avrebbe un segnale oscillatorio. Simili segnali, che rappresentino

battiti cardiaci o suoni o colori, hanno tutti diverse frequenze in essi; i segnali che

variano velocemente hanno frequenze più alte di quelli che variano più lentamente.

Uno dei teoremi più importanti nell’elaborazione dei segnali, conosciuto come

Teorema di Nyquist, afferma che rappresentare un segnale con accuratezza richiede

un campionamento al doppio della massima frequenza presente nel segnale.

Raramente le immagini computerizzate hanno una simile risoluzione. Senza

sufficienti campioni si ottiene l’aliasing. L’informazione ad alta frequenza è persa ed

è sostituita da una informazione inconsistente e visivamente fastidiosa a bassa

frequenza, che non era parte della scena.

Ci sono due modi per aggirare l’ostacolo. Primo, i campioni possono non

essere discreti. Significa che possono rappresentare non uno specifico colore nella

scena, ma una qualche media su una regione della scena. Il supercampionamento,

dove ogni pixel è la media pesata di molti campioni che sono vicini tra loro, ed il

campionamento ad area, dove ogni pixel è la media pesata delle regioni di colore in

qualche area coperta da quel pixel, sono entrambe tecniche che possono essere usate

per ridurre l’aliasing. Se queste tecniche sono usate bene, i dati ad alta frequenza

saranno persi in ogni modo, ma non saranno aggiunti alias a bassa frequenza, e

l’immagine apparirà leggermente sfocata. In realtà il supercampionamento alza

soltanto la soglia di tolleranza, non elimina completamente il problema. Potrebbero

esserci frequenze ancora superiori al tasso di supercampionamento, che creeranno

alias anche con questa tecnica.

26

Figura 2.3. Aliasing

La seconda tecnica è campionare in modo irregolare, una tecnica nota anche

come campionamento stocastico. Sono di nuovo usati i supercampioni, ma il fatto

che non siano spaziati regolarmente crea un effetto interessante. Usando questa

tecnica, i dati ad alta frequenza sono comunque persi, ma sono rimpiazzati da un

rumore bianco costante e di bassa intensità che rende l’immagine un po’ granulosa.

Non è quantitativamente meglio dell’aliasing ottenuto con il supercampionamento

semplice, ma a causa di certe caratteristiche percettive del sistema di visione umano,

questo rumore bianco risulta spesso meno fastidioso rispetto all’aliasing. Questo

processo ha senso solo quando sono disponibili molti supercampioni per costruire il

pixel finale.

Una volta che abbiamo i campioni richiesti del segnale dell’immagine, la

seconda fase critica del processo di antialiasing è ricostruire il segnale. Questo è il

27

processo in cui i supercampioni sono miscelati assieme per creare i pixel finali. I pesi

che si applicano ad ogni campione nella “media pesata” di cui sopra, vengono dal

filtro di ricostruzione. Più precisamente, la ricostruzione crea un nuovo segnale

continuo che si suppone essere la migliore rappresentazione del vero segnale, dati i

campioni che si hanno. Si deducono i campioni finali (i pixel) da questo segnale

ricostruito. La ricostruzione procede con la convoluzione del filtro con i campioni

noti. Diversi filtri danno diversi risultati, introducendo altri artefatti nell’immagini,

noti come blurring (sfocatura) e ringing (quando i bordi più duri creano delle onde

nell’output).

In realtà c’è un terzo modo per ridurre l’aliasing, che è costruire la scena in

modo che i dati ad alta frequenza non esistano fin dall’inizio, e quindi non hanno mai

bisogno di essere rimossi. Questa tecnica è nota come prefiltering della scena ed è

facilmente realizzabile in situazioni dove il segnale è costruito da funzioni di altri

segnali.

Sarebbe un errore pensare che i renderizzatori si preoccupino solo dell’alias

spaziale o geometrico. L’alias può avere luogo in ogni processo di renderizzazione

dove si ha campionamento. Per esempio, renderizzare una scena in movimento in un

momento del tempo causa l’aliasing temporale. Renderizzare i colori spettrali solo

con tre campioni RGB causa l’alias di colore. L’alias può avere luogo in una grande

varietà di dimensioni, e le tecniche per ridurre o migliorare gli effetti dell’alias sono

simili in tutte queste dimensioni.

2.3.2. Quantizzazione e Gamma

Le equazioni fisiche del trasporto della luce, e le approssimazioni che sono

usate in computer grafica, calcolano l’intensità della luce ed i valori di colore con

numeri reali. Tuttavia, la maggior parte dei dispositivi di output sono controllati da

valori di pixel interi. Il processo di conversione da reale a virgola mobile ad intero è

28

detto quantizzazione. Ci sono tre dettagli speciali che devono essere considerati

durante la quantizzazione: la profondità in bit, la correzione gamma, ed il dithering.

La quantizzazione converte valori di intensità a virgola mobile in valori interi

appropriati per il sistema di visualizzazione, sulla base della sua profondità in bit. Per

esempio, la maggior parte dei monitor dei computer possono riprodurre solo 256

livelli di intensità per canale, laddove le pellicole sono molto più sensibili e possono

riprodurre diverse migliaia di livelli di colore. Il risultato è che le immagini che sono

calcolate per essere mostrate su monitor standard saranno tipicamente convertite in 8

bit per canale, mentre quelle calcolate per il cinema saranno convertite in 10 fino a 14

bit per canale. I numeri originali in virgola mobile sono scalati in modo da convertire

1.0, che richiede la massima intensità che il dispositivo può ottenere, nel valore intero

più grande che il formato permette (tipicamente 2nbit – 1).

Figura 2.4. Esempio di curva gamma

Il sistema di visione umana non è lineare, cioè ad aumenti costanti di intensità

di luce non corrispondono costanti aumenti della sua percezione. Tutti i sistemi di

visualizzazione, allo stesso modo, siano essi pellicole, stampanti, o monitor, hanno

29

una risposta non lineare all’intensità dell’input. Piccoli incrementi nei valori del pixel

nelle regioni scure creano un cambiamento minore in intensità di output rispetto allo

stesso incremento in valori di pixel nelle aree più luminose. Un effetto di questo è che

quando un apparecchio riceve un valore di pixel di 0.5, il risultato che l’apparecchio

ritornerà, non sembrerà avere intensità 0.5, ma qualcosa di meno.

Tuttavia queste due scale logaritmiche non sono mai allineate. Per questo,

quando i valori interi dei pixel sono mostrati sul dispositivo, spesso hanno ricevuto

una correzione-gamma seguendo la formula out = in1/γ. Tipicamente un monitor per

computer avrà un gamma compreso tra 1.8 e 2.4. La correzione gamma ripristina la

linearità apparente dell’immagine sull’intensità emessa dal dispositivo.

Un effetto collaterale della correzione gamma è che i dispositivi di output

hanno più valori disponibili nelle zone scure. Passando i dati attraverso una curva di

correzione gamma si perderanno un buon numero di questi valori e si possono spesso

vedere i salti di livello. Per compensare questo problema, alcune immagini sono

memorizzate una risoluzione in bit superiore, in modo che c’è della precisione

aggiuntiva nell’uso dei colori scuri.

E’ comunque importante notare che la γ appropriata è una funzione del

dispositivo sul quale l’immagine viene mostrata. L’immagine avrà bisogno di essere

ricorretta se dovesse essere visualizzata su di un altro dispositivo. Inoltre, i calcoli

tipici dell’elaborazione di immagini che potrebbero essere applicati ad un’immagine,

come la sfocatura, il ridimensionamento, o la composizione, lavorano al meglio se il

dato è “lineare”, vale a dire, non ha una correzione gamma già di per se. Per questa

ragione è di solito meglio che le immagini ad alta qualità vengano memorizzate senza

correzione gamma, e che la correzione sia applicata solo al momento della

visualizzazione.

Ci sono tre modi per convertire un reale in intero: troncamento,

arrotondamento e dithering. Il troncamento è il più facile, basta usare la funzione

floor per scartare i bit frazionari dopo la scalatura. Comunque è facile vedere che

30

questo farà scendere l’intera intensità dell’immagine di una piccola quantità, quindi

forse l’arrotondamento è migliore. Arrotondare significa usare floor se la frazione è

inferiore a 0.5 e ceiling se la frazione supera tale soglia. Comunque anche

l’arrotondamento ha un effetto fastidioso sull’aspetto dell’immagine perché le aree

dove i pixel in formato reale sono molto simili avranno una grande blocco di colore

costante, dopo la quantizzazione. Al confine di questa regione il colore cambierà di

colpo di un livello di pixel e prenderà l’aspetto del “salto di scala” laddove la regione

dovrebbe avere un gradiente continuo. Questo effetto si può eliminare con il

dithering.

Il termine dithering è usato confusionalmente in computer grafica per

significare diversi algoritmi che hanno una cosa in comune: alzare o abbassare il

valore dei pixel in una regione costante di colore per simulare più profondità di bit in

un dispositivo che non ha sufficienti livelli di output. Il dither di quantizzazione è un

piccolo valore casuale che viene aggiunto al valore del pixel ancora in formato reale,

appena prima che venga troncato. In un certo senso, randomizza la scelta tra l’uso di

floor e di ceiling per fare la conversione. L’effetto è la rottura di queste aree colorate

in modo costante, rendendole meno regolari e quasi “fuzzy”, così che in media i pixel

nella regione abbiano l’intensità in virgola mobile voluta. Un altro algoritmo che

raggiunge lo stesso obiettivo è il dither a diffusione di errore, che calcola la

differenza tra il valore reale e la sua versione intera, e si assicura che tutta l’intensità

dell’immagine ne tenga conto.

2.3.3. Le Bande di Mach

L’occhio umano è estremamente sensibile ai bordi ed ai confini. La nostra

visione accentua questi confini – un trucco percettivo che li rende più visibili. Infatti,

ogni volta che ci sono delle aree costanti chiare e scure adiacenti, la visione umana

percepisce l’area scura ancora più scura, e ancora più chiara la parte chiara vicino al

confine, in modo da aumentare il contrasto tra i colori adiacenti. Questo effetto è

31

spesso così forte che di fatto sembra di vedere delle bande che percorrono i lati del

bordo, di colore diverso dal vero colore dell’area. Queste bande sono dette di Mach,

dopo che lo psicofisico Ernst Mach le studiò per primo nel tardo diciannovesimo

secolo.

Sfortunatamente, nelle immagini in computer grafica i confini tra regioni

ampie di colori costanti, o poco mutevoli, sono piuttosto comuni, e le risultanti bande

di Mach sono artefatti rilevanti (anche se, oggettivamente, non ci sono!). Le bande di

Mach sono visibili anche quando la direzione (in qualsiasi dimensione) di un

gradiente di colore cambia improvvisamente lungo un bordo. In altre parole, se c’è

una discontinuità nella derivata del colore.

2.3.4. Il sistema di coordinate

I sistemi di coordinate tridimensionali si dividono in due tipi: destrorsi e

sinistrorsi. La differenza tra queste due varietà è basata sui versi degli assi coordinati,

gli uni relativamente agli altri. Per esempio, se l’asse delle x punta a destra, e l’asse

delle y punta in alto allora ci sono due possibilità per l’asse delle z: puntare in dentro

oppure in fuori. Per esempio si ponga una delle mani, con pollice e indice aperti a

forma di L maiuscola. Il pollice rappresenta l’asse delle x e l’indice quello delle y. Il

medio sia esteso in modo da essere perpendicolare ad entrambe le dita. La direzione

ed il verso del medio indica la direzione ed il verso dell’asse z. Nel caso della mano

sinistra sarà il verso di un sistema sinistrorso, ed analogamente con la destra si avrà

un sistema destrorso.

Le trasformazioni che cambiano un sistema destrorso in uno sinistrorso e

viceversa si dicono “mirror” o riflessioni. Anche una scalatura negativa su una

dimensione o su tutte le tre dimensioni, o lo scambio di due qualsiasi delle

dimensioni hanno l’effetto di invertire il tipo di sistema di riferimento.

32

2.3.5. Composizione e Alpha

Spesso, in sintesi di immagini, l’immagine finale è costruita con una

combinazione di svariate immagini, ciascuna contenente una parte dei dati. Per

esempio, l’immagine potrebbe essere renderizzata a livelli, con gli oggetti più vicini

alla camera renderizzati in una immagine, e con lo sfondo generato separatamente.

Nella fotografia per gli effetti speciali convenzionali, combinare otticamente le

immagini è una tecnica nota come “matte” o “fotografia composta”, ed è realizzato

tramite una apparecchiatura detta “stampante ottica”. Comunque, su una stampante

ottica sono possibili solo tre operazioni: la correzione dell’esposizione o della

sfocatura di una immagine, la moltiplicazione di due immagini (usata spesso per

ritagliare via un pezzo di immagine), e l’esposizione multipla (aggiunta di due

immagini). Creare un effetto multilivello richiede diversi passaggi attraverso la

stampante, con perdita di qualità ad ogni passo.

La composizione di immagini digitali, invece, può fare qualsiasi cosa che si

possa programmare, ad un numero qualsiasi di immagini, e senza perdita di qualità.

L’operazione più comune è sovrapporre due immagini una sull’altra, con l’immagine

di sfondo visibile solo dove l’immagine in primo piano è “vuota” – un’operazione

detta over. Determinare dove l’immagine contenga dei dati e dove è vacante è un

problema complesso nelle scene riprese dal vivo, e coinvolge diverse combinazioni di

estrazioni blu/green-screen e di rotoscopìa, ma per le sequenze generate a computer è

piuttosto facile. Il renderizzatore fornisce l’informazione, salvandola su un canale

separato detto canale alpha (α). Nel 1984 Porter e Duff descrissero un’algebra per

combinare le immagini usando il canale α di ciascuna immagine.

I pacchetti di disegno moderni spesso includono i concetti di canali di

trasparenza, ma α è una versione molto specifica. Primo, le trasparenze disegnate

(matte) hanno spesso la profondità di un bit, che identifica se il pixel è dentro o fuori.

Per essere utile in un mondo dove i pixel hanno bisogno di essere ben filtrati con

antialiasing, solitamente il canale α invece ha tanti bit quanti gli altri canali di colore.

33

Secondo, le trasparenze disegnate con più bit (dette trasparenze fuzzy) sono salvate

senza modificare il colore vero. Estrarre l’immagine voluta richiede che il

programma moltiplichi il colore per il valore di trasparenza usando tutto il colore

quando il pixel è opaco, una frazione quando è parzialmente trasparente, e

scartandolo del tutto quando è trasparente. α invece, salva il colore premoltiplicato

con il canale di trasparenza. Ci sono diversi vantaggi nella renderizzazione e nella

composizione, che rendono questo schema di premoltiplicazione superiore per la

codifica di immagini generate a computer.

Generalmente le immagini sono ora memorizzate in quattro canali – rosso,

verte, blu ed alpha, o RGBA. Naturalmente avere un quarto canale A non garantisce

che contenga α, dato che qualche software potrebbe memorizzare un valore di

trasparenza semplice in quel canale. In alcuni testi, l’alpha premoltiplicato è detto

alpha associato, per distinguerlo dalla trasparenza semplice o da altri dati arbitrari

che potrebbero essere memorizzati nel quarto canale di un’immagine.

2.3.6. Modelli di colore

La luce è un fenomeno continuo che può essere rappresentato con precisione

solo con uno spettro completo. Il colore invece è un concetto psicofisico, perché si

riferisce al modo in cui percepiamo la luce. Negli anni, gli esperti nei disparati campi

della colorimetria, fisiologia, ingegneria elettronica, computer grafica, e arte hanno

sviluppato una varietà di maniere di rappresentare i colori. Con rare eccezioni, queste

rappresentazioni hanno tutte tre valori numerici. L’occhio umano ha solo tre tipi di

sensori al colore, detti coni. La luce stimola i coni secondo la loro sensibilità allo

spettro di frequenze della luce stessa. Di fatto questo converte la rappresentazione

spettrale continua della luce in tre campioni indipendenti, detti “valori tristimulus”,

che il cervello percepisce come colore della luce. Siccome si percepisce la luce in

questo spazio di colori tridimensionale, non sorprende che anche la maggior parte

34

degli altri spazi di colori richiedano tre dimensioni per coprire l’intero intervallo dei

colori visibili.

E’ interessante, anche se forse non sorprendente, che ci siano tante sottigliezze

e tanti dettagli, nello studio psicofisico della percezione dei colori. Per esempio,

spesso ci sono molti diversi spettri di luce che stimolano i coni con la stessa intensità,

e pertanto sono percepiti come lo stesso colore. Questi spettri sono detti metameri, e

senza di essi sarebbe impossibile ricreare l’aspetto di un colore su un display

televisivo. Le televisioni (i monitor, i display al laser, ecc…) generano i colori

usando tre cannoncini con caratteristiche spettrali molto specifiche, e a volte molto

ristrette. Questi cannoncini sono fatti in modo da sembrare di riprodurre una grande

varietà di colori, perché creano metameri per ogni spettro che il dispositivo di

visualizzazione debba rappresentare.

La rappresentazione più comune del colore nella computer grafica è RGB:

rosso, verde e blu. Questo schema di colori è semplicemente il controllo diretto dei

tubi catodici della televisione o del monitor. I canali di colore variano su un intervallo

da 0.0 (cannoncino spento) a 1.0 (cannoncino al massimo). Ci sono molti altri

modelli di colore che non sono altro che trasformazioni lineari del modello RGB.

Alcuni di questi modelli, come per esempio HSL (tinta, saturazione, luminosità) e

HSV (tinta, saturazione, intensità), sono stati creati per il fatto che le triple sono più

intuitive per gli artisti rispetto ai valori tristimulus RGB. Alti modelli, come YUV e

YIQ, sono stati creati perché modellizzano il colore per uno specifico dispositivo

oppure per una codifica analogica del segnale. In ciascun caso, una semplice

equazione lineare o una semplice procedura converte ogni valore in un modello in un

valore in un altro modello.

Questi modelli, comunque, non specificano colori esatti. Semplicemente

descrivono l’intensità alla quale i tubi catodici (o altri dispositivi) debbano operare.

Se i cannoncini su un apparecchio dovessero generare un “colore di base” diverso

rispetto a quelli di un altro apparecchio – cosa peraltro abbastanza comune – allora i

colori risultanti appariranno diversi nei due apparecchi. Ci sono dei modelli di colore

35

che cercano di risolvere questo problema legando certi colori del modello a certi

spettri specifici. Per esempio CIE, una organizzazione internazionale di

standardizzazione il cui proposito è quantificare il colore, ha creato diversi specifici

modelli di colore che fissano i colori con esattezza. Il più usato di questi è CIE XYZ

1931. NTSC RGB 1953 cercò di risolvere lo stesso problema per la televisione

specificando i valori esatti CIE dei “fosfori standard”. Sfortunatamente, come le

tecnologie si sono evolute, questi valori divennero rapidamente obsoleti.

I processi di stampa, che richiedono colori primari in uno spazio di colori

sottrattivo, spesso specificano i colori dell’inchiostro nel sistema CMY (ciano,

magenta, giallo). Le descrizioni di CMY spesso si appellano all’idea che il ciano sia

assenza di rosso, e perciò CMY = (1,1,1)-RGB. In effetti, la stampa è un processo

troppo sottile per essere catturato da una formula tanto semplicistica, e delle buone

trasformazioni da RGB a CMY (o al modello CMYK, che è CMY aumentato di un

canale per l’inchiostro nero) sono segreti del mestiere delle compagnie di stampa.

Altri modelli di colore risolvono un problema diverso. Siccome l’occhio

umano è più sensibile alla variazione dei colori in alcune parti dello spettro rispetto

ad altre, la maggior parte dei modelli di colore non hanno la proprietà che un

cambiamento costante nel valore di un canale abbia un cambiamento costante nel

colore apparente. I modelli che prendono in considerazione questa non linearità della

percezione dei colori sono detti spazi di colori percettivi. Gli artisti amano questi

modelli, come quello di Munsell, perché rende più facile creare delle gradazioni di

colore morbide. I modelli CIE Luv e CIE Lab cercano di realizzare la stessa funzione

in una maniera matematicamente più rigorosa, con trasformazioni non lineari delle

coordinate standard CIE. Recentemente, gli ingegneri della compressione delle

immagini hanno iniziato a studiare questi modelli perché aiutano a determinare quali

siano i bit importanti da salvare e quali bit non saranno nemmeno notati dal pubblico.

Il gamut di un dispositivo si riferisce all’intervallo di colori che può riprodurre.

Per esempio ci sono molti colori visibili su un monitor, che l’inchiostro sulla carta

non può riprodurre. Si dice che l’inchiostro ha un gamut minore rispetto ai monitor.

36

Chi volesse riprodurre fedelmente un’immagine da un medium all’altro dovrà essere

cosciente delle limitazioni dei gamut dei due media ed avere una strategia per

approssimare i colori che sono fuori dal nuovo gamut.

Figura 2.5 Confronto tra i gamut CIE, RGB e CMYK

2.3.7. Modelli di Geometria Gerarchica

Quando si costruiscono modelli geometrici di oggetti complicati, succede

spesso che una parte del modello sia connessa con un’altra parte attraverso qualche

tipo di giuntura o altro meccanismo. Per esempio, la spalla, il gomito ed il polso

connettono sezioni rigide del corpo con giunture che limitano il movimento a

rotazioni particolari. Questo conduce al movimento gerarchico delle parti del corpo,

dove ruotare la giuntura della spalla causa la rotazione unisona dell’intero braccio e

della mano, mentre ruotare il gomito fa ruotare insieme solo l’avambraccio e la mano,

e muovere il polso influisce solo sulla mano. La posizione di ogni parte del corpo è

sempre relativa alle posizioni delle parti del corpo superiori.

Invece che modellare ogni parte del corpo separatamente, e fare calcoli

complessi per riottenere la posizione della mano ogni volta che qualcuna delle

giunture del braccio si muova, è molto più semplice codificare la gerarchia di

37

movimento del modello direttamente in una struttura ad albero detta Modello di

geometria gerarchica. Ogni parte del corpo è situata in un nodo nella gerarchia, e le

trasformazioni memorizzate nel nodo sono relative al genitore immediato, invece che

al sistema di coordinate del mondo. Per questo, un cambiamento alla trasformazione

di un nodo particolare, modifica automaticamente tutte le geometrie legate ai nodi

sotto quello in esame nell’albero, senza dover modificare nessuna delle loro

trasformazioni. Questo facilita grandemente la modellazione di oggetti complessi.

Questo concetto di parti con sottoparti che sono in generale la stessa cosa, ma

che sono legate ai nodi al di sopra di esse, si può estendere per includere più

caratteristiche che meramente le trasformazioni che controllano la loro posizione ed

orientamento. E’ abbastanza comune che siano altrettanto utili delle gerarchie negli

attributi dei materiali. Per esempio, il colore della vernice di una piccola parte di una

macchina sarà di solito lo stesso della struttura al di sopra di essa. Un altro modo di

vedere questo schema è che i nodi sotto una gerarchia normalmente ereditano gli

attributi di base dei genitori, ma che possano modificarli secondo le necessità.

La struttura dati ovvia per manipolare gli alberi gerarchici è una pila. Ad ogni

nodo dell’albero, lo stato della gerarchia è aggiunto in cima alla pila. Il nodo ha la

possibilità di fare qualsiasi modifica che sia richiesta per realizzare il suo scopo e per

fornire lo stato appropriato ai suoi propri nodi figli. Quando il nodo è completato, la

cima della pila viene rimossa, e perciò lo stato del genitore è ripristinato. I sottonodi

fratelli possono quindi iniziare le operazioni con lo stesso stato iniziale che aveva il

primo sottonodo.

Un modello geometrico può avere una varietà di diverse utili gerarchie –

gerarchie di trasformazioni, di attributi, di illuminazione, di dinamiche, perfino

gerarchie di autori e di costo. Comunque, spesso le complesse relazioni che si

formano, creano strutture più complicate di semplici gerarchie ad albero, e comunque

i sistemi di renderizzazione sono interessati soltanto ad un piccolo sottoinsieme di

questa lista.

38

2.3.8. Modelli di Ombreggiatura

Il processo che un renderizzatore utilizza per determinare i colori degli oggetti

nella scena è noto come shading (ombreggiatura). Come si è visto, il BRDF di un

oggetto, e di conseguenza il colore dell’oggetto visto da un qualsiasi punto di vista, è

una complessa interazione della luce con la struttura microscopica del materiale in

superficie (ed a volte anche sotto la superficie) dell’oggetto. Per fortuna, non è di

solito necessario modellare questa interazione con esatta correttezza fisica per

ottenere nelle immagini un aspetto credibile o esteticamente piacevole. Infatti,

un’ampia varietà di materiali può essere simulata con un po’ di approssimazioni, che

sono state sviluppate negli anni. Le approssimazioni più popolari per i BRDF sono

tipicamente modelli empirici (basati su esperimenti e osservazioni, senza basarsi su

teorie scientifiche), anche se esistono molti modelli leggermente più complicati che

hanno basi più solide nella fisica dei materiali.

Due modelli empirici di riflessione luminosa fra i più usati e venerati nella

computer grafica sono l’ombreggiatura diffusa di Lambert e quella speculare di

Phong/Blinn.

L’ombreggiatura di Lambert cattura l’idea di un riflettore diffuso ideale, una

superficie estremamente ruvida e opaca. Un simile oggetto appare riflettere la luce in

maniera uguale in ogni direzione. La sola differenza risultante nell’aspetto di un

oggetto siffatto è in relazione con l’angolazione che ha con la sorgente di luce.

Questa differenza è catturata dalla funzione coseno dell’angolo di illuminazione, che

può essere calcolato con il prodotto scalare della normale alla superficie e la

direzione della sorgente di luce, N·L.

L’illuminazione di Phong simula l’aspetto dei punti più chiari che sono visibili

sugli oggetti luminosi. Queste piccole aree sono create quando oggetti lisci riflettono

la luce con preferenza in una direzione vicina alla direzione di riflessione, e sono noti

39

come punti di riflessione speculare (specular highlights). Phong notò che lo specular

highlight di molti oggetti che esaminava appariva essere cerchio coi bordi sfumati,

più luminoso al centro e meno sui bordi. Riconobbe che questa forma era simile al

coseno elevato ad una potenza, e creò la famosa formula cos(R·L)roughness. Altri

modelli sono stato proposti negli anni, alcuni fisicamente più motivati, altri

puramente fenomenologici. Uno dei più importanti progressi fu l’osservazione che la

principale differenza tra i materiali metallici e quelli plastici era il colore degli

highlight (Cook e Torrance, 1981), uguale a quello diffuso nei metalli, bianco nei

materiali plastici.

Figura 2.6 Lambert, Phong ed entrambi combinati

Lo shading è quasi sempre fatto nello spazio di colori RGB, anche se è chiaro

che la maggior parte dei calcoli di riflessioni dovrebbero essere dipendenti dalla

lunghezza d’onda, e quindi dovrebbero essere fatti più propriamente nello spazio

continuo degli spettri. Tuttavia, esperimenti con calcoli su ombreggiatura spettrale,

con 9 o 20 campioni per colore, hanno raramente mostrato migliorie significative

nella qualità dell’immagine, tranne che negli esempi particolari che usavano prismi o

materiali iridescenti. Per questa ragione, raramente ci si preoccupa che i calcoli

dipendenti dalla lunghezza d’onda siano ignorati, e si usa qualche forma di filtraggio

dei colori come approssimazione in ogni situazione dove la differenza risulterebbe

evidente.

40

2.3.9. Ray Tracing

Uno dei metodi più comuni per spiegare il processo di rendering è di

richiamarsi all’intuizione sul processo fisico della fotografia: i raggi di luce sono

emessi da sorgenti luminose, rimbalzano nella scena, riflessi da oggetti e da essi

colorati, ed infine colpiscono la pellicola nella fotocamera. Questo paradigma di

seguire i percorsi dei fotoni mentre attraversano una scena è detto ray tracing. In

pratica, i renderizzatori in ray tracing non seguono i raggi in avanti, a partire dalla

luce, nella speranza che alcuni di essi infine giungeranno alla camera. La

maggioranza dei raggi non lo fanno, e ci vorrebbe moltissimo tempo per renderizzare

una immagine. Al contrario, i raytracer seguono i raggi all’indietro, dalla camera,

finché non raggiungono infine una luce. Curiosamente, gli antichi Greci credevano

che il fenomeno della vista funzionasse proprio così, che cioè ciò che si vedeva

dipendesse da dove fossero atterrati i raggi visivi partiti dai loro occhi. I fisici

moderni confermano che la simulazione risulta essere la stessa, dato che il percorso

di una luce è reversibile – la luce può andare ugualmente bene in entrambi i versi di

un percorso, e segue lo stesso percorso in entrambi i versi.

Siccome il ray tracing simula la propagazione della luce, è capace di creare

immagini realistiche con molti effetti interessanti e sottili. Per esempio, le riflessioni

di uno specchio e le rifrazioni attraverso un vetro sono semplici perché richiedono

solo minimi cambiamenti al percorso del raggio che sono calcolabili con le leggi di

riflessione e rifrazione viste prima. Sono state sviluppate tecniche per simulare una

varietà di effetti ottici, come riflessioni “fuzzy” (riflessioni su superfici ruvide dove

l’immagine risulta sfumata perché i raggi riflessi non vanno tutti nella stessa

direzione) ed effetti volumetrici (la luce interagisce con il materiale nel quale sta

passando). Uno dei più interessanti fenomeni è quello delle caustiche, il fenomeno

della luce che viene focalizzata da oggetti riflessivi o rifrattivi nella scena, che causa

aree più luminose o più scure sugli oggetti circostanti, come quelle su un tavolo sotto

un bicchiere di vino.

41

L’operazione

fondamentale

dell’algoritmo

di

ray

tracing

è

trovare

l’intersezione di una linea con un oggetto geometrico. Questa semiretta rappresenta il

raggio di luce. Si usa una semiretta in quanto si è interessati solo in quella regione di

spazio di fronte all’origine della luce, non a quella dietro. Se diversi oggetti

intersecano il raggio, l’intersezione voluta è solo quella più vicina all’origine del

raggio. A seconda del tipo di primitiva geometrica (sfera, poligono, NURBS, …),

potrebbe essere necessaria qualsiasi cosa, a partire da una semplice equazione

matematica fino a complessi algoritmi di approssimazione geometrica, per calcolare

l’intersezione del raggio con quel tipo di primitiva. I ray tracer reali hanno algoritmi

elaborati per scartare gli oggetti che non sono per nulla vicini al raggio, per fare

economia sui complessi calcoli di intersezione. Il processo di intersecare un singolo

raggio con un insieme di primitive geometriche è propriamente noto come ray

casting. Il ray tracing propriamente detto si riferisce alla tecnica di calcolare

ricorsivamente la riflessione e la rifrazione e tutti gli altri raggi secondari partiti dal

punto di intersezione del raggio originale, per seguire il cammino della luce che

rimbalza nella scena.

Non è raro che un renderizzatore che non usi il ray tracing come algoritmo di

base, richieda occasionalmente il calcolo dell’intersezione di un raggio con un

oggetto geometrico. Nell’uso comune si dicono frasi come “tracciare un raggio” o

“lanciare un raggio” per descrivere questo tipo di calcoli.

2.3.10. Altri Algoritmi

Siccome il ray tracing è intuitivo e cattura un’ampia varietà di effetti ottici

interessanti, è una delle maniere più comuni per scrivere un renderizzatore. In alcuni

ambienti i termini ray tracing e rendering sono ingenuamente usati come sinonimi.

Tuttavia, il ray tracing è un processo computazionalmente costoso, e ci sono altri

algoritmi per la sintesi di immagini che prendono scorciatoie computazionali per

ridurre il tempo di calcolo complessivo.

42

Una delle principali operazioni che un renderizzatore effettua è determinare

quali oggetti sono visibili nella scena e quali sono nascosti dietro altri oggetti. Questa

operazione è detta eliminazione delle superfici nascoste. Esistono molti algoritmi che

esaminano gli oggetti nella scena e determina quali siano visibili da un singolo punto

nella scena – la posizione della camera. Gli algoritmi scanline, z-buffer e Reyes sono

esempi di questo tipo. Gli oggetti sono tipicamente ordinati in tre dimensioni: la loro

posizione x e y quando sono proiettati sul piano di vista della camera, e la distanza z

dalla camera. Le differenze tra i molti algoritmi sono basate su fattori come il tipo di

ordinamento, le strutture dati usate per mantenere il database geometrico, i tipi di

primitive che possono essere manipolati, ed il modo in cui l’algoritmo di rimozione

superfici nascoste e interfogliato con altri calcoli che il renderizzatore debba

effettuare (come l’ombreggiatura) per creare l’immagine finale.

Il vantaggio computazionale principale di questi algoritmi è che manipolano

solo una volta ogni oggetto nella scena. Se è visibile dalla camera, è solo visibile in

una posizione dello schermo e solo da quella angolazione. Non può apparire in altre

parti dello schermo con diverse angolazioni o diversi ingrandimenti. Una volta che un

oggetto è stato renderizzato, può essere scartato. Se non è visibile dalla camera in

maniera diretta, lo si può scartare direttamente in quanto non c’è altro modo di

vederlo. I ray tracer invece devono tenere traccia di tutti gli oggetti nella scena per

l’intero rendering, siccome specchi o arrangiamenti complessi di lenti nell’immagine

possono far si che qualsiasi oggetto possa apparire più volte nella scena da diverse

angolazioni e diversi ingrandimenti.

Si noti comunque, che siccome questi algoritmi di superfici nascosta calcolano

la visibilità da un singolo punto di vista, non è in generale possibile calcolare

informazioni su quali altri punti nella scena si possano vedere, come sarebbe

necessario per calcolare vere riflessioni e rifrazioni. Si perde la capacità di simulare

questi effetti ottici. Il ray tracing invece, mantiene le strutture dati necessarie per

generare informazioni di visibilità tra due punti qualsiasi nella scena. Per questo

motivo si dice che il ray tracing è un algoritmo di visibilità globale, e i calcoli di

43

illuminazione che usano queste utilità del renderizzatore sono detti calcoli di

illuminazione globale. I renderizzatori senza illuminazione globale devono simularla

con dei trucchi, come texture che contengano immagini della scena vista da altre

angolazioni.

Ci sono altri algoritmi e tecniche ancora più recenti per simulare

l’illuminazione globale. Si tratta dell’Ambient Occlusion e soprattutto dell’Image

Based Lighting, presentati al Siggraph dal prof. Paul Debevec nel 2000.

L’image based lighting (IBL) è il processo di illuminare le scene e gli oggetti

(reali o sintetici) con immagini di luce dal mondo reale. E’ l’evoluzione naturale della