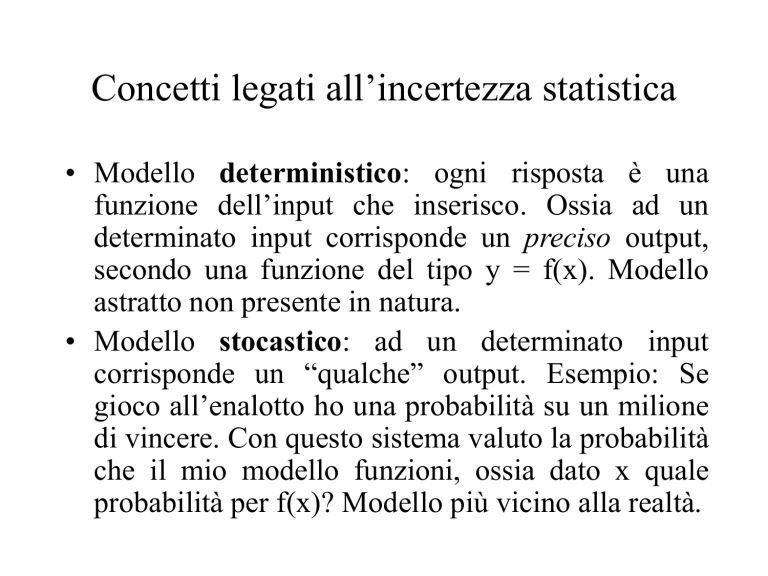

Concetti legati all’incertezza statistica

• Modello deterministico: ogni risposta è una

funzione dell’input che inserisco. Ossia ad un

determinato input corrisponde un preciso output,

secondo una funzione del tipo y = f(x). Modello

astratto non presente in natura.

• Modello stocastico: ad un determinato input

corrisponde un “qualche” output. Esempio: Se

gioco all’enalotto ho una probabilità su un milione

di vincere. Con questo sistema valuto la probabilità

che il mio modello funzioni, ossia dato x quale

probabilità per f(x)? Modello più vicino alla realtà.

Concetti legati all’incertezza statistica

• Variabile aleatoria: una variabile w assume un

insieme di valori wi. In un modello stocastico noi

possiamo conoscere la probabilità di avere un

determinato valore di w.

• Gli indici di dispersione (range, scarto medio

assoluto, varianza, deviazione standard) ci danno

un’idea dell’incertezza di come si distribuisce una

certa variabile aleatoria.

La probabilità

La probabilità è un modo per valutare il grado

di incertezza di un determinato risultato

La probabilità si esprime su una scala da 0 a 1

p = 0 (il risultato è impossibile)

p=0,5 (il risultato si avverrà nel 50% dei casi)

p=1 (il risultato è sicuro)

Quale definizione per probabilità?

Il calcolo delle probabilità nasce dallo studio dei “giochi di sorte”.

In questo caso il numero di casi possibili è comunque finito e i casi in condizioni regolari (senza

trucchi) sono equiprobabili (condizione di simmetria). Da questo tipo di approccio nasce

la definizione matematica o a priori e di probabilità

Condizioni:

1)

Casi in numero finito o comunque ridotto - limitato

2)

Casi equiprobabili (implica la conoscenza a priori della probabilità di un determinato evento)

Ossia la definizione classica di probabilità:

P(E) = n°casi favorevoli / n°dei casi possibili

Esempi:

a)

Probabilità Testa o Croce

b)

Probabilità Dado

c)

Probabilità di estrarre una determinata carta

d)

il 13 nella ruota di Venezia

Vale la regola: 0 ≤ P(E) ≤ 1

P(E) = 0 Evento impossibile

P(E) = 1 Evento certo

Quale definizione per probabilità?

Però se, ad esempio, il 13 non esce sulla ruota di Venezia da un po’ di tempo, si tende ad affermare che

la probabilità della sua uscita è più elevata. Su cosa si basa questa nostra affermazione?

Definizione delle probabilità a posteriori o frequentista

Nel caso in cui si parli di probabilità frequentista, vengono meno le condizioni della definizione a priori

della probabilità, ossia il numero dei casi non è più finito e non esistono più le condizioni di

equiprobabilità! Si passa dallo studio delle probabilità nei giochi a sorte in quello demografico, sociale,

biologico…

Frequenza relativa di un fenomeno:

fr(E) = k/n

Ossia un evento E si presenta k volte in n prove (nelle stesse condizioni). La sua frequenza relativa varia

tra 0 e 1.

Si parla anche della Stabilità della frequenza relativa ossia per un insieme molto numeroso di

osservazioni empiriche di prove effettuate in modo indipendente, sotto condizioni identiche la frequenza

relativa presenta una sorta di quasi stabilità.

Esempio: Avere i capelli neri è equiprobabile ad avere i capelli rossi? Le mie informazioni si basano

sulla mia esperienza passata e attuale.

Quale definizione per probabilità?

Evidentemente con un numero basso di prove la frequenza relativa mal si adegua, variando in

modo molto sensibile.

Definizione frequentista di probabilità o di probabilità a posteriori: “Il limite della frequenza

relativa quando n (n prove), tende ad infinito (o comunque è molto grande) si chiama probabilità a

posteriori dell’evento considerato”.

PROBABILITA’

Esempio:

Lancio moneta 40.000 volte e la testa si presenta 20.520 volte.

P*(E) = 20.520/40.000 = 0.513 P(E) =1/2 =0.5

N° EVENTI

Quale definizione per probabilità?

1.

2.

3.

Definizione classica (Bernoulli, 1713): la probabilità,

P(E), di un evento E è il rapporto tra il numero di casi

favorevoli (al manifestarsi di E) e il numero di casi

possibili, giudicati ugualmente possibili.

Definizione frequentista (Von Mises, 1928): la

probabilità di une evento è il limite cui tende la

frequenza relativa di successo, su un numero di prove

giudicato sufficientemente elevato.

Definizione soggettiva (De Finetti, inizio 1900): la

probabilità di un evento E, secondo l’opinione di un dato

individuo, è il prezzo p che egli stima equo attribuire ad

un importo unitario esigibile al verificarsi di E.

Quale definizione per probabilità?

Definizione soggettiva: la quota di scommessa che un

individuo, in base alle sue informazioni e opinioni, giudica

equo pagare (farsi pagare) per riscuotere (pagare) l’importo

unitario se si verifica E e nulla se si verifica non E.

Esempio: Scommesse sui cavalli.

Statistica Bayesana e l’implementazione delle informazioni

personali!

Statistica inferenziale

Probabilità

Campione

Popolazione

Statistica inferenziale

Campionamento

La generazione di inferenze valide richiede

l’utilizzo di un campione casuale:

– Dove ogni individuo appartenente alla

popolazione ha la stessa probabilità di selezione

– La probabilità di selezionare un determinato

individuo è uguale per ogni fase del

campionamento

• Campionamento con sostituzione

• Irrilevante per popolazioni grandi

Probabilità e distribuzioni di frequenza

f

QI

65

75

85

95

105

115

125

135

La distribuzione di frequenza di

una popolazione descrive tutti i

possibili esiti di un processo di

campionamento casuale.

3

2,75

2,5

2,25

N. studenti

Dalla distribuzione di frequenza è

possibile calcolare la probabilità di

selezionare

un

individuo

caratterizzato da un determinato

valore.

1

1

1

2

3

1

1

0

2

1,75

1,5

1,25

1

0,75

p(X=95) = 2/11

0,5

0,25

0

65

75

85

95

105

Q.I.

115

125

135

Campionamento

Probabilità e distribuzioni di frequenza

f

QI

1

1

1

2

3

1

1

0

3

2,75

2,5

2,25

N. studenti

Con lo stesso metodo è

possibile calcolare la

probabilità di selezionare

un individuo con X

superiore (o inferiore) ad

un valore soglia

65

75

85

95

105

115

125

135

2

1,75

1,5

1,25

1

p(X>125)

0,75

0,5

0,25

0

65

75

85

95

105

Q.I.

115

125

135

Principali distribuzioni di probabilità

–

–

–

–

–

–

–

–

–

–

–

–

Distribuzione binomiale (cenni)

Distribuzione di Poisson

Distribuzione uniforme

Distribuzione geometrica

Distribuzione ipergeometrica

Distribuzione normale

Distribuzione normale standardizzata

Distribuzione rettangolare

Distribuzione esponenziale

Distribuzione F di Scenedecor

Distribuzione t di Student

Distribuzione di chi-quadro

Distribuzioni di probabilità

Poiché la somma delle probabilità di tutti gli

eventi alternativi (e possibili) è (e deve essere)

pari a 1 e poiché la probabilità di ciascun

evento è maggiore di zero [P(E) > 0, escluso

l’evento nullo che ha P(E)=0], possiamo

considerare queste probabilità come valori di

una distribuzione di dati e costruire la

distribuzione di probabilità di quel fenomeno.

PROBABILITA’

La distribuzione normale

-σ

+σ

M = media

σ = Deviazione St.

VALORI ASSUNTI DALLA VARIABILE ALEATORIA

La distribuzione normale o distribuzione

Gaussiana è la distribuzione di probabilità più

importante. Ha un andamento campanulare

simmetrico.

La distribuzione normale

(misurazione delle altezze)

f

0

0

0

3

4

4

2

1

0

Distribuzione frequenza altezza

4,5

4

3,5

3

N. studenti

Altezza (cm)

140-145

146-150

151-155

156-160

161-165

166-170

171-175

176-180

181-185

s

186-190

2,5

f

2

1,5

1

0,5

0

140- 146- 151- 156- 161- 166- 171- 176- 181- 186145 150 155 160 165 170 175 180 185 190

Altezza

La distribuzione normale

1.

2.

3.

4.

5.

6.

Molti fenomeni naturali/sociali sono caratterizzati da una

distribuzione normale

Fenomeni determinati da gran numero di concause

Ogni concausa contribuisce (in modo diverso e

indipendente) ai valori osservati

Altamente improbabile che tutte le concause diano il

massimo possibile contributo

Altamente improbabile che tutte le concause diano il

minimo possibile contributo

Di conseguenza i valori si concentrano lontani dagli

estremi

La Distribuzione Normale Standardizzata

Il fatto che la distribuzione normale contenga le due variabile

m e 2 rendono scomoda e praticamente impossibile la sua

tabulazione. Per questo si ricorre alla distribuzione normale o

standardizzata che non contiene nessun parametro.

Concetto di variabile standardizzata: sostituiamo alle nostre

variabili x1, x2, x3, x4,…, xn, delle nuove variabili che

chiameremo standardizzate u1, u2, u3, u4,…, un che avranno la

caratteristica di avere la media pari a zero e la Varianza

unitaria.

La Distribuzione Normale Standardizzata

La

curva

normale

standardizzata è unica ossia

è rappresentata da una sola

curva, mentre la funzione

normale “generale” descrive

una famiglia infinita di

curve (in funzione del

valore medio e della

varianza).

Proprio

per

questo la normale non è

tabulabile,

mentre

la

normale standardizzata si.

Tavola della Distribuzione Normale Standardizzata

Tavola della Distribuzione

Normale Standardizzata: ci

fornisce

l’informazione

areale della probabilità totale

compresa tra due limiti

qualunque u1 e u2. In

generale vista la simmetria

della distribuzione la tavola

contiene solamente i valori

delle probabilità comprese

tra lo zero e l’ascissa +u.

Tavola della Distribuzione Normale Standardizzata

Tavola della Distribuzione Normale Standardizzata

Avendo a disposizione

una tavola relativa alla

probabilità

totale

compresa tra due limiti

qualunque u1 e u2

(corrispondente

alla

aree) ed essendo la

curva simmetrica, posso

calcolare agevolmente

la probabilità che una

misura cada tra due

valori qualunque.

Tavola della Distribuzione Normale Standardizzata

z e la distribuzione normale

• In una distribuzione normale

esiste

un

rapporto

ben

determinato fra il valore di z e il

numero di osservazioni con X

entro una determinata distanza

dalla media

• Tabella dei valori

• Utilizzando la distribuzione

normale è possibile calcolare la

probabilità che un’osservazione

abbia un valore superiore (o

inferiore) ad una determinata

soglia.

34,13%

13,59%

-2

+2

-1

2,28%

+1

INFERENZA STATISTICA

L’inferenza statistica: dal campione quali

considerazioni posso fare sulla popolazione di

provenienza? Si chiama inferenza statistica

quel processo che sulla base di informazioni

contenute in un campione, permette di

giungere a conclusioni relative alla

popolazione dalla quale proviene il campione.

Campioni e Popolazione

TEOREMA DEL LIMITE CENTRALE

Il Teorema del Limite Centrale afferma che:

1.

2.

3.

La distribuzione di MC (Medie Campionarie) sarà

approssimabile alla Distribuzione Normale.

La Media di MC è uguale alla media della popolazione

d’origine:

MCm = m

La Deviazione Standard di MC è l’Errore Standard calcolato

sulla popolazione (funzione sia della Deviazione Standard della

popolazione sia della numerosità del campione):

X

n

Il teorema del limite centrale

L’errore di campionamento diminuisce in rapporto

alla radice quadrata di n.

Esempio: Una certa popolazione finita ha come σ(x)=100. La

distribuzione delle medie dei campioni costituita da n unità ha allora come

σ (x) (deviazione standard della media; x segnato) i seguenti valori:

n:

4

9

16

…

100

….

10.000

σ (x): 50

33.3

25

…

10

….

1.

Quando n è molto grande σ (x) è molto piccolo e al limite, per:

n che tende ad infinito, σ (x) tende a zero

L’errore standard come

misura di affidabilità

• Nella maggior parte degli studi si utilizza un

solo campione

• La dove l’errore standard è elevato è

probabile che diversi campioni produrranno

risultati diversi

– Simulazione: ripetizione degli esperimenti

• Lo studio dell’errore standard consente di

determinare l’affidabilità del campione

L’ ERRORE STANDARD

• L’errore standard ci offre da una parte

la possibilità di STIMARE la media

della popolazione, dall’altra ci

consente

di

determinare

l’AFFIDABILITA’ del campione.

Inferenza statistica e Teoria della Stima

Alla base della Statistica c’è la stima. Sulla base dei

risultati tratti da un campione, si effettua una stima

della variabile oggetto di studio o meglio una stima

della statistica che rappresenta quella variabile (ad

esempio media).

La stima fatta sulla base di un campione viene

validata con i metodi di Statistica inferenziale.

Stima puntuale VS Stima intervallare

Stima puntuale

Estraiamo un campione casuale di n osservazioni x1, x2, ..., xn e

stimiamo m con la media aritmetica delle n osservazioni.

Stima dell’intervallo (Neyman, 1935)

Determinare l’intervallo entro il quale ricade un valore e con quale

probabilità. Ad esempio: l’altezza dei residenti nella regione FriuliVenezia Giulia è compresa tra 1,70 e 1,85 con una probabilità del 75%.

Teoria della Stima intervallare

Si deve determinare un intervallo di xc che contenga con una certa

probabilità il valore incognito. Proprio per questo si introduce il concetto di

limiti di confidenza o limiti fiduciari: la probabilità che un valore cada

dentro un certo intervallo deve essere molto grande (per essere sicuri che il

valore vi ricada), per cui si definisce il coefficiente di confidenza:

Coefficiente di confidenza = 1 -

Dove sia molto piccolo. Gli statistici usano per convenzione quasi universale

1 = 0.05 = 5%

(2 = 0.01 = 1%)

per cui i limiti di confidenza

1 - 1 = 95%

(1- 2 = 99%)

Stima dell’intervallo di confidenza per la media

in popolazioni normali

Alcune considerazioni sull’intervallo che contiene u (la media standardizzata) con

una probabilità pari al 95%.

Pr [-u(α/2) < u < +u(α/2)] = 95%

Area compresa sotto la curva deve essere 95% ossia 0,95. Per individuare il valore

di u devo dividerla a metà (0,95/2= 0,475) e trovare sulla tabella il valore di u

corrispondente, che è 1,96.

Pr [-1,96 < u < +1,96] = 95%

Stima dell’intervallo di confidenza per la media

in popolazioni normali

Se vogliamo stimare l’intervallo di confidenza per la media in

popolazioni normali, il problema può essere posto nei

seguenti termini:

1. Da una popolazione distribuita in modo normale avente

come deviazione standard (noto) si estrae un campione

casuale, costituito da n unità la cui media è MC (media

campionaria).

2. Si vuole determinare un intervallo attorno ad MC il quale

contenga, con una certa probabilità, la media ignota della

popolazione, m .

ESERCIZIO

Un campione casuale di n=100 osservazioni ha come media M = 50 e

proviene da una popolazione normalmente distribuita con deviazione

standard = 10. Calcolare i limiti entro i quali è contenuta la media della

popolazione m al livello del 95%.

Al livello del 99%.