Resoconto della lezione del 1/12/2005

“Concetti, definizioni e finalità dell’analisi statistica. Le fasi dell’indagine”

Prof. Malizia.

A cura di Giordano Simoncini

Le scienze sperimentali, ovverosia tutte quelle scienze che progrediscono mediante l’ applicazione

del metodo sperimentale, poggiano nella loro quasi totalità sul metodo induttivo – cioè

sull’estrapolazione di leggi universali dal ripetuto controllo di casi particolari. Il metodo statistico è stato

definito il metodo induttivo per eccellenza; esso è adoperato dalle scienze sperimentali tanto ai fini della

formulazione di leggi universali quanto ai fini del controllo di queste ultime.

L’ origine della statistica come strumento di supporto alle scienze sperimentali va fatto risalire al

XVII sec., quando vennero a svilupparsi due specifici indirizzi scientifici, vale a dire la Scuola degli

Aritmetici Politici (in Inghilterra) e la scuola della Statistica universitaria (in Germania). Nella prima

scuola, che si curava di applicare la statistica ai fenomeni demografici, va individuata l’origine di quella

che sarebbe poi divenuta la statistica inferenziale; alla seconda, che adoperava il metodo statistico per

descrivere i fatti di interesse politico, va attribuita l’ideazione della statistica descrittiva.

Nell’ una o nell’altra branca della scienza statistica, l’uso della matematica è costante: ciò accade

poiché i fenomeni che la statistica investiga sono variabili, così come sono variabili i risultati cui tali

fenomeni danno luogo. Più specificamente, i fenomeni che la statistica prende in esame sono fenomeni

collettivi e non individuali, ovvero fatti riferiti a insiemi di unità. Tali insiemi di unità sono collettivi

statistici; ciascun elemento di tale insieme è una unità statistica di studio.

È possibile descrivere un insieme di unità statistiche secondo uno o più caratteri scelti in funzione

della ricerca che l’indagine statistica vuole portare avanti: se l’ insieme N di unità statistiche è costituito

da individui di specie umana, ad esempio, lo si può descrivere secondo i caratteri del sesso, della statura,

della professione, della natalità / mortalità, del peso e via dicendo. Questi caratteri, assieme agli infiniti

altri possibili, sono i cd. caratteri statistici. Ne deriva che ogni unità statistica è “portatrice” di uno o

più caratteri statistici in una certa modalità, la quale, a propria volta, può essere quantitativa (ad es.,

l’altezza espressa in cm) o qualitativa (ad es., il colore dei capelli).

La modalità di un carattere statistico è detta caso statistico;

1

un insieme di casi statistici omogenei, vale a dire accomunabili all’ interno di una stessa

classe, rappresenta il dato statistico;

La formazione del dato statistico è di essenziale importanza ai fini della verifica

sperimentale di una ipotesi e passa attraverso questi momenti successivi:

la formazione dei casi statistici;

la rilevazione;

lo spoglio;

la formazione delle tabelle.

Unità statistiche di rilevazione, diverse da quelle di studio, sono particolari specificazioni degli

enti utilizzate per enumerare le unità statistiche di studio: in questo senso, in una indagine sulla

condizione occupazionale dei cittadini di un paese, gli individui saranno le unità statistiche di studio, le

famiglie selezionate per lo studio statistico saranno le unità di rilevazione. In merito ai tipi di

rilevazione, poi, è possibile distinguere tra rilevazioni totali o parziali.

◦ Le rilevazioni totali sono quelle in cui vengono misurati (o enumerati) tutti gli elementi delle unità

statistiche che compongono l’ universo oggetto di rilevazione;

◦ le rilevazioni parziali sono invece quelle in cui viene rilevata solo una parte degli elementi che

compongono l’ universo. È questo il caso delle indagini per campioni; questi ultimi, ovviamente,

devono essere costruiti in maniera adeguata, vale a dire casuale, perché si possa poi utilizzare, ad

esempio, il calcolo delle probabilità.

La corretta programmazione di un campione è la prima e la più importante operazione

preliminare di una rilevazione statistica. In relazione alla tecnica adottata, poi, i campionamenti possono

essere distinti in semplici e stratificati – lì dove stratificare significa suddividere l’ universo in

2

sottoinsiemi all’ interno dei quali la variabilità è molto più bassa della variabilità generale che si

riscontrerebbe nell’ intero universo. Inoltre, posto che la teoria dei campioni ha dei canoni ben precisi,

è opportuno specificare che non tutte le rilevazioni parziali sono necessariamente campionarie: se ad

una indagine statistica che prevede una rilevazione totale non rispondessero tutte le unità, come invece

era auspicato dalla strutturazione dello studio, la rilevazione rimarrebbe comunque parziale pur non

essendo – ovviamente – campionaria.

Una volta programmati i campioni, si può procedere con le ulteriori operazioni preliminari alla

rilevazione, concernenti tanto l’ ampiezza quanto le modalità tecniche della rilevazione stessa: la

costruzione di una tabellazione dei risultati che si vogliono ottenere e l’approntamento del modello di

rilevazione (ad es. un questionario, che può contenere domande aperte o chiuse – e se aperte, di

opinione o valutazione, e se chiuse, mono o multiresponse ecc.). Una volta effettuata la rilevazione, si

procede allo spoglio, che passa attraverso le fasi del controllo e della revisione (volte a scovare

eventuali errori nelle risposte, che inficerebbero la validità dello studio).

Ultimi passi nel procedimento di formazione di un dato statistico sono la tabellazione e la

pubblicazione dei dati (seguita da una eventuale interpretazione degli stessi).

La distribuzione delle informazioni rilevate all’interno di una tabella varia a seconda che i casi

statistici siano rappresentati da modalità quantitative o qualitative di determinati caratteri. Nel primo

caso si avrà una seriazione, nel secondo una serie.

Vi possono essere seriazioni di caratteri statistici continui o discreti. Per organizzare le seriazioni

di caratteri continui, è necessario raggruppare i valori in classi. Il raggruppamento in classi esige una

particolare attenzione nel momento in cui si decide dove “chiudere” la classe, includendo o escludendo

in tal modo il valore massimo o il minimo dal modulo (cioè dall’ ampiezza della classe stessa). Inoltre,

va tenuto ben presente che tanto più ampie si costruiscono le classi, tanta più informazione si perde; è

dunque quanto mai opportuno trovare un compromesso tra l’esigenza sintetica e quella di ridurre la

perdita di informazione. In questo senso, la regola generale è che l’ampiezza di una classe debba essere

tanto più piccola quanto più piccole sono le frequenze.

Le serie, dal canto loro, possono essere suddivise in territoriali (quando il carattere a cui si

riferiscono le frequenze è rappresentato dal territorio) o storiche (quando il carattere a cui si

riferiscono le frequenze è rappresentato dal tempo), ed ancora cicliche (quando non vi è un criterio per

individuare il primo termine di una serie, ma è comunque stabilito l’ ordine di successione dei valori),

sconnesse (quando l’ ordine in cui si succedono le modalità è assolutamente arbitrario) o rettilinee

(quando l’ ordine in cui si presentano le modalità è intrinsecamente individuato dalla natura del

carattere).

3

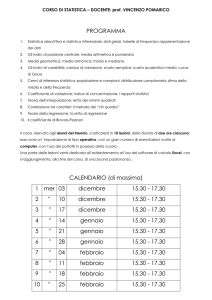

Strumenti statistici propedeutici alla valutazione (Dott. Malizia)

lezione del 6 Dicembre 2005

A cura di Rossana Tiani

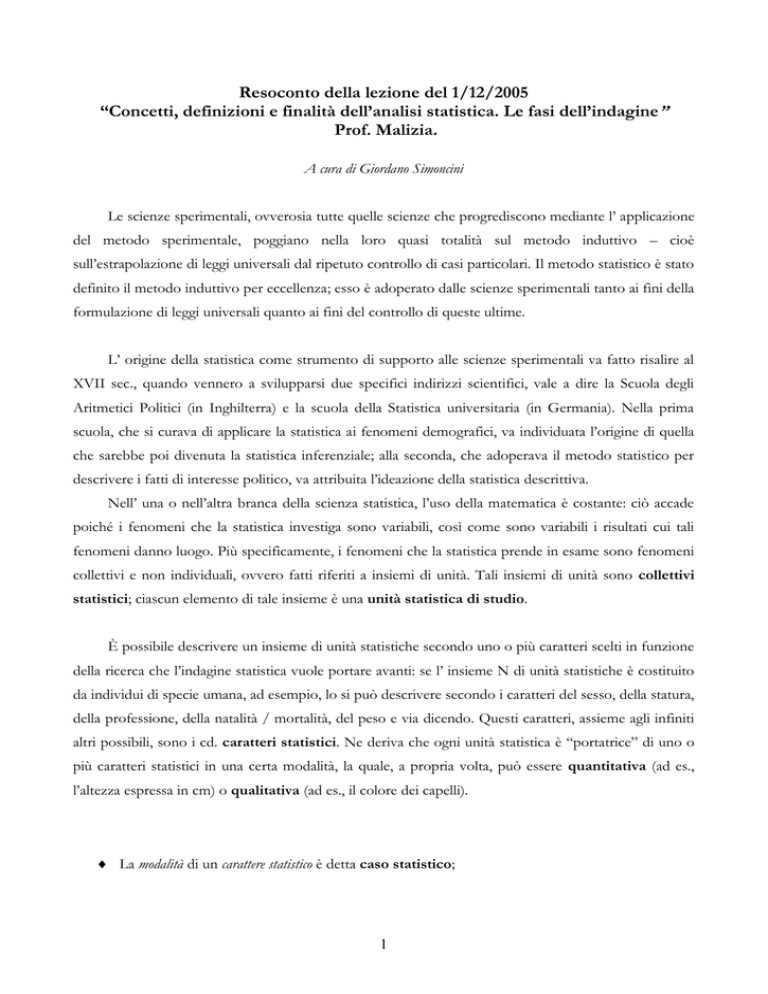

Rappresentazioni grafiche

La trasformazione delle informazioni da forma tabellare a immagine grafica ha senso se tale operazione

riesce a rendere più evidenti le caratteristiche della variabile sul collettivo preso in esame; tali

rappresentazioni, dunque, hanno una importante valenza descrittiva. Il giudizio su una rappresentazione

grafica può essere basato essenzialmente su cinque aspetti: l’accuratezza, che si riferisce alla precisione

dei dettagli con cui viene rappresentata una distribuzione; una omissione dei dettagli potrebbe indurre

ad interpretazioni distorte. La semplicità si riferisce all’uso essenziale di elementi grafici senza

l’aggiunta di particolari simboli superflui all’interpretazione; bisogna massimizzare l’informazione da

comunicare nei limiti della semplicità e della concisione. La chiarezza di una rappresentazione grafica è

data dalla capacità di comunicare senza ambiguità ed in modo immediato le caratteristiche salienti del

fenomeno. A tale scopo contribuisce anche l’aspetto estetico che dovrà essere quanto più possibile

armonioso. La struttura, infine, deve essere ben definita, cioè tutti gli elementi grafici devono essere fra

loro interdipendenti e devono esser posti in maniera gerarchica in modo tale che, quanto più è

significativo un elemento tanto più questo deve risultare in rilievo rispetto agli altri. Per evidenziare la

gerarchia degli elementi grafici si possono utilizzare dimensioni, colori o forme diverse. Vi sono,

ovviamente, numerosi tipi di grafici quali quelli per rappresentare le distribuzioni semplici (grafico a

barre, a nastri, a torta, a stella) secondo un carattere di qualsiasi tipo ma che, a causa della loro

generalità, non forniscono tutte le possibili informazioni se la distribuzione riguarda un carattere

quantitativo. Queste ultime distribuzioni, per esempio, si possono rappresentare più adeguatamente

attraverso gli istogrammi.

L’istogramma è un grafico costituito da barre che possiedono un’area proporzionale alla corrispondente

frequenza o quantità (rappresentata sull’asse delle ordinate di un piano cartesiano). Per un carattere

quantitativo, discreto o continuo, la distribuzione di frequenza può essere costruita suddividendo il

carattere in classi di stessa o diversa ampiezza. Nel grafico 1 delle dispense, il carattere quantitativo

continuo1 della statura viene rappresentato attraverso una distribuzione con classi di uguale

ampiezza. In tal caso siamo in presenza di un istogramma a canne d’organo, in cui possiamo

rappresentare le varie modalità del carattere come segmenti di uguale dimensione disposti su una retta

Si parla di carattere continuo quando l’insieme delle modalità assumibili dal carattere può essere messo in corrispondenza

biunivoca con un sottoinsieme dei numeri reali.

1

4

(asse delle ascisse) e ogni frequenza come un rettangolo, distanziato dagli altri, avente per base il

segmento rappresentante la modalità e come altezza un segmento proporzionale alla frequenza o

intensità, cioè proporzionale alle stature degli individui. In tale grafico si rileva che la popolazione si

concentra nelle classi di statura centrali; le frequenze sono basse per i valori iniziali della variabile ma

crescono gradualmente fino a raggiungere il massimo valore intorno alle modalità centrali per poi

scendere verso i minimi. Da ciò è possibile desumere che la distribuzione possa essere rappresentabile

attraverso la curva di Gauss e se consideriamo anche i valori assunti da un altro carattere continuo, il

peso di ogni individuo, si potrebbe ipotizzare che questo dipende dalla statura. Di qui, attraverso un

diagramma in coordinate cartesiane, si può rappresentare una relazione, approssimativamente

lineare, tra i valori del peso e quelli della statura (graf. 2). Se poi il carattere quantitativo oggetto di

studio è discontinuo2 (come ad esempio, il numero delle stanze, il numero dei figli…), si può costruire

un istogramma a colonne in cui ai valori della variabile indipendente vengono fatti corrispondere

rettangoli di altezza proporzionale alle frequenze ma, in questo caso, con i rettangoli non distanziati tra

di loro (graf. 3). Non è possibile, inoltre, unire i vertici delle ordinate poiché altrimenti si ammetterebbe

l’esistenza di valori intermedi fra quelli oggetto di analisi (ciò, come già detto, si può fare solo se il

carattere è continuo). In quest’ultimo caso è possibile sostituire i rettangoli con un poligono di

frequenza in cui ridurre l’ampiezza delle classi, per esempio, da 3 cm (graf. 4) ad 1 cm (graf. 5). Esso

viene chiuso considerando una classe precedente la prima di eguale ampiezza e frequenza nulla ed una

classe successiva all’ultima di eguale ampiezza e frequenza nulla. Si traccia una poligonale che unisce i

punti centrali delle basi superiori dei rettangoli dell’istogramma. Tale grafico ha il vantaggio di

consentire la rappresentazione in uno stesso grafico di più distribuzioni e quindi il loro confronto. C’è

di più. Se l’ampiezza delle classi tende a zero il poligono di frequenza tende alla curva di frequenza così

come rappresentato nel graf. 6 mediante un diagramma a punti (scatter o diagramma a

dispersione), particolarmente conveniente per confrontare più fenomeni (per esempio, due variabili

come il consumo e il PIL).

Per scopi descrittivi può risultare utile impiegare figure geometriche per rappresentare le serie di

frequenza e mettere in evidenza l’importanza delle singole modalità rispetto al totale. Ne sono esempi: i

grafici ad aree (graf. 7) che sono grafici a barre suddivise in cui valori centrali delle basi sono uniti da

una spezzata così da determinare delle aree corrispondenti ognuna a una modalità del carattere. Vi

sono, infine, i grafici a torta (grafici 8a e 8b) che sono particolarmente utili quando si vuole

rappresentare la composizione di un aggregato (sia in termini di valori assoluti che relativi o

percentuali).

Si parla di carattere discontinuo quando l’insieme delle modalità assumibili dal carattere può essere messo in corrispondenza

biunivoca con un sottoinsieme dei numeri interi.

2

5

Rapporti statistici

Mediante i rapporti statistici si possono ricavare delle informazioni fruibili che ci consentono di

analizzare più profondamente una determinata questione e di misurare un fenomeno in circostanze

storiche e spaziali diverse. Nel rapporto tra due quantità A e B se almeno una di esse è un dato

statistico, il rapporto viene definito statistico. Ad esempio mentre non è un rapporto statistico quello

fra la circonferenza e il diametro del cerchio (π), poiché è un rapporto matematico, è un rapporto

statistico, per esempio, quello tra consumi e reddito nazionali, dal momento che non si tratta di una

relazione matematica e riguarda un interesse collettivo. Il rapporto statistico, inoltre, non dipende né

dall’unità di misura e né dall’ordine di grandezza.

Abbiamo diversi tipi di rapporti statistici, ognuno con le proprie caratteristiche e con i propri criteri per

il raggiungimento dei differenti fini. Essi sono:

Rapporti di derivazione: si calcolano rapportando un fenomeno con un altro che ne è il presupposto

logico, ossia si considera il denominatore di tale rapporto quale presupposto del numeratore. Si delinea,

in tal modo, una relazione di causa-effetto tra le due quantità. Un esempio è costituito dal tasso di

natalità che si calcola rapportando il numero dei nati vivi alla popolazione.

Rapporti di coesistenza: in essi si rapportano un fenomeno con un altro senza che si possa stabilire

fra loro una logica relazione di causa-effetto. Ad esempio, il rapporto tra la popolazione residente in

dato territorio e la superficie dello stesso territorio (rapporto di densità).

Rapporti di composizione: si calcolano rapportando un fenomeno con un altro di cui il primo ne

rappresenta un parte; di solito assumono i valori compresi tra 0 ed 1 (o tra 0 e 100 se parliamo in

termini percentuali). È il caso della forza lavoro (che si calcola sommando il numero dei disoccupati a

quello dei lavoratori). Il tasso di disoccupazione, infatti, si calcola rapportando una parte (ossia il

numero dei disoccupati) al tutto (la forza lavoro). Dal momento che si tratta di un rapporto in cui ambo

le grandezze sono dati statistici, se esso viene calcolato sulle frequenze, tale rapporto può anche essere

letto in termini di probabilità.

Rapporti antropometrici: sono rapporti tra due misure di carattere fisico, corporeo misurate su una

collettività (ad esempio, il rapporto tra la media delle stature e quella dei pesi di un gruppo di individui).

Rapporti indice (o numeri indice). L’osservazione sistematica nel tempo di un fenomeno permette di

costruire una serie storica. In genere quando si è interessati a misurare l’entità dei mutamenti in una

serie storica, si possono effettuare dei rapporti (numeri) indice tra due o più valori della serie. I valori

così ottenuti sono detti numeri indice. Essi si riferiscono in genere alla variazione dei prezzi o di

quantità, e più precisamente, quando la serie storica si riferisce a una variabile economica il suo

andamento è certamente influenzato da quello dei prezzi. Gli indici dei prezzi, infatti, si riferiscono ad

una pluralità di merci e la sintesi degli indici elementari viene effettuata mediante una media ponderata

6

in base ai valori delle merci acquistate. In tale contesto una serie di numeri indice a base fissa esprime

il prezzo del bene o servizio in ogni periodo di tempo come una quota del prezzo del bene o servizio in

un periodo di riferimento detto base. Essi assumono la forma : a1 / ao, a2 / ao, …an / ao. Grazie a

tali rapporti otterremo un’informazione sulla variazione del fenomeno nel corso del tempo. In una serie

di numeri indici a base mobile, invece, si rapporta ciascun dato statistico al precedente, ottenendo

delle variazioni congiunturali, cioè valutate rispetto al periodo precedente. A seconda del periodo cui si

riferiscono i valori assunti come pesi3, si ottengono le formule di Laspeyres e di Paasche, dove Po, Px,

Qo, Qx indicano i prezzi e le quantità dei singoli beni e servizi scambiati al tempo base 0 ed al tempo

corrente x.

Laspeyres ha proposto di prendere come pesi, come quantità di riferimento quelle relative al periodo di

base, cioè Qo. Il numero indice dei prezzi di Laspeyres è definito come il rapporto tra una spesa

teorica (ossia la spesa che si avrebbe nell’anno x qualora le quantità acquistate fossero quelle dell’anno

0) ed una spesa effettiva (quella dell’anno base 0).

∑ Px/Po*PoQo

________________

∑ Px*Qo (Spesa teorica che si avrebbe nell’anno corrente x

=

∑ Po*Qo

____________se le quantità acquistate fossero quelle dell’anno 0)

∑ Po*Qo (Spesa effettiva sostenuta nell’anno base 0)

Paasche ha, invece, proposto di considerare come pesi le quantità relative a ogni dato periodo. In tale

indice il sistema dei pesi non rimane costante e di conseguenza l’unico confronto lecito è quello tra i

vari periodi ed il periodo di base. Mediante tale indice oltre ai prezzi cambiano anche le quantità,

cosicché la variazione osservata sarà dovuta alla variazione congiunta dei prezzi e delle quantità.

∑ Px/Po*PoQx

∑ PxQx (Spesa effettiva sostenuta nell’anno corrente x)

________________ =

________________

∑ PoQx

∑ PoQx

(Spesa teorica che si avrebbe nell’anno base se le

quantità acquistate fossero quelle dell’anno corrente x)

I risultati a cui si perviene utilizzando questi due indici sono differenti; e ciò per alcuni motivi.

Si attribuisce un “peso” ad ogni indice per giungere a costruire un indice sintetico. Ciò consiste nel fare la media ponderata di tutti

gli indici calcolati.

3

7

Differente è il significato che i due indici considerano delle spese teoriche: il primo, quella

dell’anno corrente ma con le quantità dell’anno base, il secondo, quella dell’anno base ma con le

quantità dell’anno corrente.

L’indice di Laspeyres mette in evidenza che ciò che varia sono solo i prezzi che abbiamo

ponderato, non anche le quantità; tende, dunque, a sopravvalutare le variazioni dei prezzi, ossia

l’inflazione. Ciò perché attraverso il primo indice i prezzi relativi ai prodotti che sono aumentati

sono pesati con una spesa in cui le quantità non sono diminuite ma sono le medesime dell’anno

base, dunque, maggiore è l’impatto sull’indice sintetico complessivo dei prezzi. I prezzi dei

prodotti che sono aumentati di meno sono sottopesati poiché le quantità effettivamente

consumate dovrebbero essere aumentate, mentre nell’indice mantengono il peso dell’anno base.

Il contrario avviene nell’indice di Paasche. Infatti, il primo indice tende a essere superiore al

secondo indice se i prezzi aumentano, mentre tende a essere inferiore se i prezzi diminuiscono.

In conclusione si può dire che in periodi di alta inflazione o di rapida diminuzione dei prezzi è bene

effettuare un ribasamento degli indici ravvicinato, ossia l’anno base non deve essere molto lontano nel

tempo.

Un numero indice complesso che consente di considerare contemporaneamente l’informazione fornita

dai due indici dei prezzi è quello che si ottiene dalla formula proposta da Fisher che prevede l’uso della

media geometrica dei due indici dei prezzi.

Indice di Fisher = √ Indice Laspeyres * Indice Paasche

Il valore di tale indice, essendo una media, è sempre intermedio ai valori dei due indici precedentemente

analizzati.

8

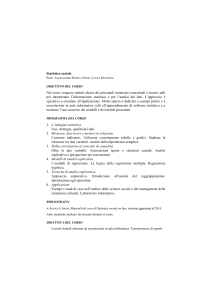

Strumenti statistici propedeutici alla valutazione

Prof. Raffaele Malizia

15-12-2005

a cura di Teti Maria Licursi

La media è uno strumento che consente di sintetizzare quantitativamente un fenomeno

collettivo. In base alla definizione di Gini è “il risultato di un’operazione che assume un valore

non superiore né inferiore agli altri” cioè è un valore compreso tra i due estremi.

Le medie si dividono in medie non analitiche o medie di posizione e medie analitiche. Le

prime vengono elaborate sulla base di alcuni casi statistici ritenuti significativi a causa della loro

posizione nella distribuzione. Le medie analitiche, al contrario, vengono elaborate applicando un

operatore matematico alla totalità dei casi statistici della distribuzione.

Le medie non analitiche sono la moda e la mediana.

La moda è la modalità del carattere che si presenta più frequentemente. Si calcola per caratteri

discontinui, mentre in caso di continuità o se il carattere è raggruppato in classi si potrà ricavare la

classe modale, vale a dire quella classe con maggiore densità di frequenza.

La mediana invece è la modalità centrale nelle serie di osservazioni. Essa perciò divide la

distribuzione di frequenze in due parti uguali. Se il numero di osservazioni è dispari si avrà una

sola mediana [(n + 1)/2)]; se il numero è pari si otterranno due mediane(n/2 e n/2 + 1). Per

trovare la mediana vanno ordinati i caratteri e poi calcolate le frequenze cumulate.

Esistono anche altre medie simili alla mediana: quartili, decili, centili che, in generale, vengono

definiti quantili. Il quartile divide la distribuzione in quattro parti uguali: a sinistra del primo

quartile si trova ¼ delle frequenze, a destra i restanti ¾.

Le medie analitiche invece, che prescindono dalla posizione del carattere, si dividono in media

aritmetica, la media quadratica, la media cubica e la media geometrica, che variano tra loro

in base al valore assunto da K, cioè dell’indice della radice. K è sempre un numero reale diverso

da 0.

9

Misure di Variabilità e Concentrazione

Prof. Malizia, lezione del 12/01/06

a cura di Filippo Salone

La Variabilità

Definizione

→ La variabilità misura la dispersione di un fenomeno statistico all’interno di una

distribuzione.

Misure di variabilità

a) Indici di variabilità che operano in base alle differenze fra le singole modalità della

distribuzione e tutte le altre modalità (vengono utilizzati soprattutto con riferimento a quei

caratteri che presentano modalità molto diverse tra loro e poco ripetute).

→ Campo di variazione (K = xn – x1)

è la differenza tra l’osservazione più grande della distribuzione e quella più piccola. In

presenza di classi questo tipo di indice a rigore non è utilizzabile. Inoltre il campo di

variazione è un indice tendenzialmente non molto affidabile perché risente della presenza

di valori anomali, o particolarmente alti o particolarmente bassi.

→ Differenza interquartile (Q3 – Q1)

è la differenza calcolata fra il terzo ed il primo quartine. Se si dimezza il risultato si avrà la

distanza semi-interquartilica.

NB: ambedue gli indici sono piuttosto grossolani, in quanto insensibili al modo in cui si

dispongono gli altri elementi della distribuzione. Ancora i due indici sono comunque

incapaci di cogliere gli effetti della forma della distribuzione, cioè ignorano gran parte

dell’informazione che contribuisce a determinare tale forma.

10

→ Differenza semplice media senza ripetizione (Δ)

è la sommatoria delle differenze tra le singole osservazioni escludendo la differenze nulle

fra ogni osservazione e se stessa.

n (n-1)

∑ | di |

i=1

in formula diventa:

Δ=

n (n-1)

→ Differenza semplice media con ripetizione (ΔR)

è la sommatoria delle differenze tra le singole osservazioni che include le differenze nulle

fra ogni termine e se stesso.

n²

∑ | di |

i=1

in formula diventa: ΔR =

n²

b) indici di variabilità che operano in base alle differenze (scarti o scostamenti) tra le

singole osservazioni ed una loro determinata media.

→ Scostamento semplice medio dalla media aritmetica (SM1)

è la media aritmetica dei valori assoluti degli scarti tra ogni singola osservazione e la loro

media aritmetica

n

∑ | xi-M1 | yì

i=1

in caso di seriazione:

S M1 =

∑ yi

i=1

n

∑ | xi-M1 |

i=1

in caso di serie:

SM1 =

11

n

Alcune caratteristiche di questo tipo di indice:

-

in caso di assenza di variabilità l’indice assume valore zero , e ciò accade quando tutte

le osservazioni sono uguali tra loro e quindi uguali alla media aritmetica (caso di

un'unica modalità che viene osservata più volte.)

-

in caso do presenza di variabilità l’indice assume sempre valore positivo (al

numeratore operano i valori assoluti delle differenze) ed è crescente al crescere della

variabilità. Se quindi compariamo due distribuzioni di uno stesso fenomeno ma

relative a due diverse circostanze di tempo o di luogo il confronto tra gli indici può

consentire di giudicare, in termini maggiore/minore, la loro diversa variabilità (caso

di due distribuzioni di reddito relative allo stesso campione ma misurato in due

epoche differenti).

→ Scostamento semplice medio dalla mediana (SMe)

è la media aritmetica dei valori assoluti degli scarti tra ogni singola osservazione e la loro

mediana

n

∑ | xi-Me | yì

i=1

in caso di seriazione:

S Me =

∑ yi

i=1

n

∑ | xi-Me |

i=1

in caso di serie:

S Me =

n

→ Scostamento quadratico medio dalla media o “deviazione standard” (S)

è la media quadratica degli scarti tra ogni singola osservazione e la loro media aritmetica

12

∑i (xi –M1)² * yi

2

S=

in caso di seriazione:

∑i yi

∑i (xi –M1)²

2

in caso di serie:

S=

n

→ Varianza (S²)

è il quadrato della deviazione standard

∑i (xi –M1)² * yi

in caso di seriazione:

S² =

∑i yi

∑i (xi –M1)²

in caso di serie:

S² =

n

Confronto fra variabilità

Una volta misurata la variabilità di un fenomeno, come procediamo per spiegare la

misura ottenuta rispetto alla presenza di poca o tanta variabilità? (difficoltà a comparare

valori che variano da 0 ad infinito e difficoltà a confrontare diverse unità di misura)

La risposta a questa domanda è relativizzare l’indice di variabilità, ovvero rapportare

tale indice ad una media della distribuzione. Mediante questo procedimento si ottengono

gli indici di variabilità relativa che variano in un range compreso tra 0 ed 1 e rendono

possibili il confronto fra variabilità di fenomeni di diversa dimensione in quanto espressi

in unità di media.

13

→ coefficiente di variazione (S/M1)

è l’indice di variabilità relativa più frequentemente utilizzato ed è dato dal rapporto fra

lo scostamento quadratico medio e la media aritmetica

Perché studiare la variabilità

Nel campo dei fenomeni sociali ed economici lo studio della variabilità risulta

particolarmente importante. La variabilità assume infatti i contorni di una caratteristica

ad essi inscindibilmente legata, un vero proprio elemento costitutivo.

Pensiamo ad esempio ad una variabile quale il reddito percepito da un gruppo di

individui. Se calcoliamo il reddito medio pro-capite la prima cosa importante è analizzare

se tale reddito differisca fra i percettori in misura significativa oppure no. Nella prima

alternativa si rende necessario corredare l’informazione sul reddito medio di notizie circa

la sua diversa distribuzione fra gli individui, quindi circa la variabilità della stessa.

L’esempio considerato, più redditieri e livello di reddito distribuito in maniera

disomogenea tra loro, mette in evidenza il fatto che per avere informazioni di sintesi su

un fenomeno collettivo, se la media è uno strumento indispensabile non è possibile non

tener conto della variabilità altrimenti l’informazione fornita dalla media potrebbe essere

fuorviante, comunque insufficiente.

Indipendentemente però da questa funzione integrativa della media, lo studio della

variabilità assume grande importanza in sé per comprendere quale grado di

disuguaglianza economica caratterizza i redditieri considerati.

La variabilità è dunque una caratteristica intrinseca ai fenomeni naturali, economici e

sociali. Essa consiste nella differenziazione che connota le modalità dei caratteri rilevate

in una distribuzione statistica.

La Concentrazione

Definizione

→ La concentrazione è una particolare configurazione della variabilità che si verifica

quando il carattere (es. reddito) viene rilevato in quantità maggiore presso una

determinata parte della distribuzione. Perché si possa registrare concentrazione quindi le

14

modalità devono essere ordinate in modo crescente ed assumere valori maggiori nella

seconda parte della distribuzione rispetto alla prima.

Se assumiamo con “m” la parte della distribuzione su cui si vuole verificare la

concentrazione, se effettivamente c’è concentrazione deve valere:

n

∑

xi

m

i = n-m+1

>

—

n

n

∑ xi

i=1

Cioè il rapporto fra la somma delle osservazioni disposte nella parte “m” della

distribuzione e l’ammontare totale delle osservazioni è superiore al rapporto fra il

numero delle osservazioni della parte “m” e il numero totale delle osservazioni.

L’espressione di cui sopra può anche essere riscritta nel seguente modo:

n

n

∑

xi

∑

i = n-m+1

xi

i =1

>

m

n

Cioè, quando il fenomeno presenta concentrazione, la media aritmetica della parte “m”

di osservazioni è superiore alla media aritmetica di tutte le osservazioni rilevate.

Misure di concentrazione

→ Rapporto di concentrazione (R)

15

Si basa sulla differenza tra i redditi effettivi e i redditi teorici, laddove per redditi

teorici si intendono i redditi considerati come se ci fosse equidistribuzione (assenza di

concentrazione) e quindi tutti i redditieri con reddito medio (xì= M1).

Se poi si considerano la generiche distribuzioni cumulate Sì, si può notare che la

differenza con la generica media iM1 (cioè iM1– Si) risulta essere la misura di quanto le

diverse osservazioni della distribuzione differiscano tra di loro.

Tale differenza viene rappresentata graficamente dalla “curva di concentrazione”

disegnata in un sistema di assi cartesiani che presenta alle ascisse i valori di “i” (cioè il

numero delle osservazioni sommate tra loro in sequenza) e sull’asse delle ordinate i valori

di iM1 e Si.

nM1 Sn

retta di equidistribuzione

iM1

area di concentrazione

3M1

Sì

2M1

1M1

S3

S1

curva di concentrazione

S2

Valori di i

Dalla figura di cui sopra possiamo osservare:

a) retta di equidistribuzione:

è una linea retta formata dai punti di intersezione dei valori generici iM1 e rappresenta

il caso in cui il carattere presenta concentrazione nulla

b) curva di concentrazione o “curva di Lorenz”:

16

è la curva che collega i punti di ordinata Si e se non sovrapposta alla retta di

equidistribuzione denota la presenza di concentrazione.

c) area di concentrazione:

è l’area delimitata dalla retta di equidistribuzione e dalla curva di Loenz. Quanto più

piccola è detta area rispetto a quella sottesa alla retta di equidistribuzione, tanto minore

è la concentrazione (se l’area di concentrazione si riduce a zero, cioè la curva di Lorenz

si sovrappone alla retta di equidistribuzione, la concentrazione è nulla, cioè il carattere

è perfettamente equidistribuito).

Se rapportiamo un’approssimazione della misura della detta area di concentrazione,

data dalla sommatoria delle differenze iM1–Si, al massimo che essa può assumere (cioè

a

n-1

) otterremo la formula che esprime il rapporto di concentrazione R.

M1∑ i

I =1

n-1

∑ ( i M1−Si)

i =1

R=

n-1

M1 ∑ i

Ì =1

NB: L’indice di concentrazione R è sempre compreso fra 0 e 1 e assume valore minimo in

caso di assenza di concentrazione e valore massimo in caso di massima concentrazione.

17

Resoconto lezione del 19/01/2006

“Tecniche di campionamento e probabilità”

Prof. Malizia

A cura di Andrea Cardinale

Rilevazioni totalitarie o censuarie, rilevazioni parziali o campionarie

Si chiamano rilevazioni totalitarie o censuarie quelle rilevazioni che si effettuano sulla totalità delle unità

statistiche che interessa investigare ovvero sull’universo; si chiamano rilevazioni parziali o campionarie

quelle rilevazioni che si effettuano su una parte, campione, dell’universo.

Supponiamo di avere un’urna contenente palline di colore diverso e di voler sapere quante sono di un

colore e quante dell’altro. Abbiamo due strade da seguire:

A) esaminare l’intero contenuto dell’urna, osservare le palline una ad una e classificarle in base al colore

B) estrarre una parte delle palline, classificarle secondo il colore e calcolare la percentuale delle palline di

diverso colore sul totale.

Nel primo caso abbiamo fatto una rilevazione censuaria, nel secondo una rilevazione campionaria. Ma

mentre nel primo caso abbiamo la certezza circa le caratteristiche delle unità in interesse, nel secondo

possiamo solo inferire approssimativamente qual è la proporzione esistente nell’universo delle palline

di un colore rispetto a quelle di un altro colore. L’approssimazione è tanto più limitata e tanto più

interpretabile in termini probabilistici quanto più la scelta delle palline non è influenzata da fattori

sistematici ma è effettuata rigorosamente a caso.

In tale circostanza, infatti, anche se non potremo mai essere sicuri della vera proporzione delle palline

di un colore presenti nell’universo, avremo la possibilità di sapere con quale probabilità tale vera

proporzione cade entro certi limiti da noi determinati.

Rilevazioni campionarie: definizioni e tecniche di campionamento

Nelle rilevazioni parziali si fa riferimento al concetto di campione: la conoscenza di certe caratteristiche

del campione (media, variabilità ecc.) non è mai fine a se stessa, ma è strumentale alla conoscenza delle

stesse nell’universo.

Il processo che porta alla stima delle caratteristiche dell’universo a partire dalle corrispondenti

caratteristiche osservate nel campione è detto inferenza statistica ed è basato sul calcolo delle

probabilità.

18

Si distingue fra grandi e piccoli campioni in base alla loro numerosità.

Statistica è una quantità (media, rapporto, varianza ecc.) ricavata dal campione, parametro la

corrispondente quantità ignota dell’universo

Poiché i risultati campionari possono variare da campione a campione prelevato da un unico universo,

mentre i parametri sono delle quantità determinate (anche se ignote) le corrispondenti statistiche sono

variabili casuali

Per marcare la differenza fra tali variabili, le statistiche sono indicate con lettere latine (ad esempio la

media con m) i parametri con lettere greche (la media con μ).

L’inferenza statistica può avere ad oggetto:

a) la stima di un ignoto valore di un parametro (stima puntuale)

b) la stima di un intervallo entro cui cade, con data probabilità, il parametro ignoto

c) la verifica di un’ipotesi (ad esempio che μ sia uguale a μ0)

Comunque siano organizzati, è essenziale che i campioni siano casuali. La casualità può essere assicurata

con tecniche diverse.

Ad esempio se le unità dell’universo sono raccolte in elenchi (ad esempio le liste anagrafiche per una

rilevazione riferita a caratteri afferenti le persone fisiche) la scelta delle unità campionarie può avvenire

prendendo una unità ogni k unità dell’universo (ad esempio una ogni 1000). Il rapporto N/n = k è

detto frazione di campionamento.

L’esempio appena fatto è quello di campione semplice.

Una tecnica molto in uso per diminuire la numerosità del campione a parità di attendibilità dei risultati e

quella di disegnare dei campioni stratificati. Infatti la numerosità di un campione non dipende tanto

dalla ampiezza dell’universo, quanto dalla variabilità del carattere oggetto di indagine. Infatti, se per

ipotesi il carattere avesse variabilità nulla (ad esempio tutte le famiglie dell’universo percepissero lo

stesso reddito) se volessimo conoscere il reddito medio delle famiglie basterebbe rilevarne una sola.

Quanto più, invece, il carattere è variabile, tanto più è necessario aumentare il numero delle unità

campionarie per poter fare una buona inferenza. E’ quindi in molti casi utile raggruppare le unità

dell’universo in gruppi quanto più possibile omogenei fra loro (gli strati) rispetto ai caratteri considerati.

Ad esempio, nel caso delle famiglie per classi di reddito converrà suddividere quelle dell’universo per

aree di residenza e per gruppi socioeconomici.

Probabilità

I problemi delle rilevazioni campionarie si risolvono in termini di probabilità.

Definizioni di probabilità (segue)

19

1) Definizione empirica4o statistica di probabilità: la probabilità è (intesa come) la frequenza

relativa di un dato evento,

lim f/n = p

n

Es.: nel lancio di un dado, gli eventi possibili sono che compaia uno dei numeri 1, 2, 3, 4, 5 e 6. Se

ripetiamo n volte l’esperimento un dato evento, ad esempio l’uscita del numero 5, si presenterà con

una frequenza f. Il rapporto f/n rappresenta la frequenza relativa dell’evento “5” nell’esperimento

di lancio del dado.

In base all’esperienza si può con sicurezza affermare che se n è piccolo il rapporto f/n presenta

oscillazioni in serie successive di n prove; esso invece tende a stabilizzarsi al crescere di n intorno ad

un valore che è per l’appunto la sua probabilità di verificarsi.

2) Definizione classica di probabilità: la probabilità di verificarsi di un dato evento è uguale al

rapporto fra il numero dei casi favorevoli f’ al verificarsi di tale evento ed il numero totale n’ dei casi

possibili

P = f’/n’

ES.: se l’evento A è l’uscita del numero 5 quando si lancia il dado perfetto in condizioni di assenza

di qualunque causa perturbatrice esterna, la probabilità che esso si verifichi è data dal rapporto 1/6

(essendo 1 il caso favorevole e 6 quelli possibili).

Per applicare la definizione classica di probabilità è necessario determinare il numero di casi

possibili e quello dei casi favorevoli al verificarsi dell’evento. Mentre in esempi semplici (come il

lancio di un dado) tale determinazione è agevole, in casi più complessi è più complicata. Soccorre a

tale proposito il calcolo combinatorio.

Ad esempio qual è la probabilità che esca un terno al lotto in una data ruota? Essa è data dal

rapporto fra tutti i possibili terni che si possono formare con i 5 numeri estratti e quello dei terni

che si possono formare con i 90 numeri di possibile estrazione.

Le seguenti proposizioni desunte dal calcolo combinatorio ci aiutano a definire tali probabilità.

4

Perché presuppone l’esecuzione di un esperimento causale.

20

A) PERMUTAZIONI DI M ELEMENTI

Sono i gruppi che si possono formare scambiando gli elementi in tutti i modi possibili.

Pertanto ogni gruppo contiene tutti gli elementi in ordine diverso.

Si ha che

Pm = m! = m * (m-1) * (m-2) * …* 2 * 1

Dove m! si legge “m fattoriale”

Se esistono elementi uguali fra loro per cui si possono formare dei sottoinsiemi

(m1, m2,

…,

mn) di elementi uguali, il numero delle permutazioni si riduce nel

seguente modo:

____m!________

m!

mm1!1*!*m

m2!2*!*…*m

… *mnn!!

B) DISPOSIZIONI DI M ELEMENTI DISTINGUIBILI PRESI n AD n (CON n<m)

Sono tutti i possibili gruppi di n elementi formati in modo che ciascuno di essi differisca dall’altro

per gli elementi compresi o per l’ordine con cui gli elementi sono disposti nel gruppo. Si ha che:

Dm,n = m * (m-1) * (m-2) * ….* (m-n+1)

Cioè le disposizioni di m elementi presi n ad n sono pari al prodotto di n numeri interi

consecutivi decrescenti a partire da m.

Vale la seguente relazione:

Dm,n = m! / (m-n)!

C) COMBINAZIONI DI M ELEMENTI DISTINGUIBILI presi n AD n (CON n<m)

Sono tutti i possibili gruppi di n elementi formati in modo che ciascun gruppo differisca dall’altro

per gli elementi compresi senza riguardo all’ordine in cui sono disposti

Cm, n =

m* (m-1)*…..*(m-n+1)

n!

21

Cioè il numero delle combinazioni di m elementi presi n ad n è dato dal rapporto fra il numero di

disposizioni di m elementi presi n ad n e il numero di permutazioni di n elementi. Le

combinazioni Cm,n si indicano anche con l’espressione

Cm,n = (m)

n

che si legge “m su n”.

Inoltre, come si può ricavare dall’espressione di cui alla pagina precedente, si ha che

Cm,n =

m!

n! (m-n)!

Siamo ora in grado di stabilire qual è il numero dei terni che si possono formare con 5 numeri

estratti su una ruota. Esso è dato da

C5,3 = 5*4*3 / 3*2 = 10

Invece il numero dei possibili terni che si può formare con 90 numeri (possibili estratti) su una

data ruota è

C90,3 = 90*89*88 / 3*2 = 117.480

Pertanto la probabilità di vincere un terno al lotto è data dal rapporto fra 10 (numero dei casi

favorevoli) e 117.480 (numero dei casi possibili), ed è pari a circa 0,000085

22

RESOCONTO DELLA LEZIONE DI STATISTICA DEL 26 GENNAIO 2006

(PROF. MALIZIA)

A cura di Laura Miglio

“IL CAMPIONE E L’UNIVERSO”

Le rilevazioni censuarie divergono concettualmente dalle rilevazioni parziali (o campionarie);

quest’ultime, e lo dice la parola stessa, implicano un’indagine parziale, ovvero limitata al campione che

si considera, mentre le altre presuppongono un’analisi universale delle unità statistiche su cui si è

chiamati ad investigare.

In termini probabilistici, questa differenza ha, chiaramente, delle conseguenze.

Esempio: vogliamo sapere quante sono, in un’urna contenente palline di colore diverso, le palline di un

colore e quante sono le palline dell’altro. Due sono i possibili metodi di investigazione:

1) svuotare l’urna e contare tutte le palline dividendole per colore;

2) estrarre solo una parte delle palline, suddividere questa parte in base al colore e calcolare, in

percentuale, basandosi solo su quelle estratte, quante sono, nell’urna, le palline di un colore e quante

dell’altro.

Nel primo caso otteniamo una rilevazione censuaria (censimento); nel secondo una rilevazione

campionaria. La prima è più attendibile e certa, la seconda risulta, invece, vicina alla realtà solo

approssimativamente (perché l’approssimazione sia il più possibile limitata è necessario che la scelta

delle palline avvenga rigorosamente a caso); non conosciamo l’esatta proporzione che lega i due diversi

colori delle palline, ma possiamo sapere con quale probabilità, posti certi limiti, questa proporzione si

realizza.

Un’indagine statistica, ad esempio sulla distribuzione delle famiglie per classi di reddito, per la quale,

data la vastità delle unità presenti nell’universo considerato, non è possibile ricorrere a rilevazioni

censuarie, parte da certi assunti propri delle rilevazioni campionarie.

Si analizzano alcune caratteristiche proprie di un universo, partendo dalla considerazione di

corrispondenti caratteristiche rilevate, però, sulla base del campione esaminato, utilizzando il calcolo

delle probabilità col metodo dell’inferenza statistica.

Il concetto di probabilità, tuttavia, può essere definito sia ricorrendo alla definizione tradizionale5,

ovvero in modo empirico (o statistico); a quest’ultimo si fa riferimento quando il concetto di probabilità

è esteso ad eventi economici e sociali6.

5

La definizione di probabilità classica prevede che la probabilità che si presenti un determinato evento A è

uguale al rapporto fra il numero dei casi favorevoli al verificarsi di tale evento ed il numeto totale dei casi

possibili .

23

Per utilizzare la definizione classica di probabilità, è necessario determinare il numero di casi possibili

e quello dei casi favorevoli al verificarsi dell’evento. Se di fronte a casi semplici (come il lancio di un

dado) tale determinazione non è complicata, in casi più complessi lo può certamente diventare; a tal

fine si utilizza il calcolo combinatorio.

Due sono i teoremi sulle probabilità considerati: il teorema delle probabilità composte e il teorema

delle probabilità totali; entrambi muovono dalla comune premessa per cui “due eventi si dicono

incompatibili quando non possono verificarsi insieme in un esperimento casuale, necessari se almeno

uno dei due deve verificarsi”.

Secondo il teorema delle probabilità totali, se un esperimento casuale E da luogo a più eventi A1, A2,…An

fra loro incompatibili che hanno probabilità p(A1), p(A2),…p(An) di verificarsi, la probabilità che si

verifichi uno qualunque (non uno qualunque ma un insieme di essi) di tali eventi è data dalla somma

delle rispettive probabilità.

Vediamo perché.

Dati due eventi possibili A e B, consideriamo l’evento composto dato dal verificarsi di A o di B,

ovvero del verificarsi di A insieme a B (evento A + B); il verificarsi di ambedue gli eventi è, invece,

definito AB.

Consideriamo, ad esempio, una distribuzione di individui secondo la combinazione di due caratteri: il

peso e l’altezza.

Ipotizziamo che il loro raggruppamento avvenga sulla base di due sole modalità: per il peso si

distinguono quelli di peso inferiore e quelli di peso superiore alla soglia di 70 kg; per quanto riguarda,

invece, l’altezza, gli individui in questione sono distinti a seconda che siano più o meno alti di 1.75 cm.

Per evento A, poi, si considera quello consistente nel verificarsi di un’altezza inferiore a 1.75 cm e per

l’evento A’ quello relativo ad un’altezza superiore; B identifica un peso inferiore a 70 kg e B’ un peso

superiore a 70 kg.

Vediamo i dati riportati nella tabella 1):

Pertanto, se l’evento A è l’uscita del numero 1, quando si lancia il dado, presupponendone la perfezione

nonché l’assenza di qualunque causa di disturbo, la probabilità che esso si verifichi è data dal rapporto 1/6

(essendo 1 il caso favorevole e 6 quelli possibili).

6

Questo concetto presuppone l’esecuzione di un esperimento casuale, come ad esempio il lancio di un dado.

Gli eventicche possono verificarsi è che compaia uno dei numeri da uno a sei; ripetendo un numero n di volte

l’esperimento del lancio , l’uscita, ad esempio, del numero 1 avverrà con una data frequenza F. il rapporto f/n

rappresenta la frequenza relativa dell’evento “1” nell’esperimento el lancio del dado. La probabilità intesa

come frequenza relativa di un dato evento A in un esperimento casuale E rappresenta il concetto empirico di

probabilità.

24

Dis t ribuz ione di un gruppo di 100 individui s ec ondo

la s t at ura ed il pes o

St at ura

.

. Pes o

150 - 175

A

175 - 200

A'

TOTALE

45 - 70

B

f(AB)

50

f(A'B)

10

f(B)

60

70 - 95

B'

f(AB')

20

f(A)

70

f(A'B')

20

f(A')

30

f(B')

40

n

100

TOTALE

L’esperimento della tabella 1) è stato, quindi, ripetuto 100 volte; le frequenze assolute dell’evento A

sono 70 (che corrisponde al numero delle volte in cui, in seguito a misurazione, gli individui non

raggiungono un’altezza superiore a 1.75 cm ) e dell’evento A’ risultano essere 30 (che corrisponde al

numero di volte in cui la misurazione degli individui ha registrato altezze superiori a 1.75 cm). L’evento

B si verifica, invece, 60 volte e il B’ 40.

Fra le frequenze assolute esistono le seguenti relazioni:

f (A+B) = f (A) + f (B) – f (AB)

f (A+B)= n – f (A’B’)

Se dividiamo le frequenze assolute per il totale n (100) otteniamo le frequenze relative, ovvero una

stima delle probabilità del verificarsi dei singoli eventi; applichiamo alle probabilità le stesse relazioni

che valgono per le frequenze assolute (le quali, abbiamo visto, si applicano anche alle frequenze

relative); per cui:

p ( A+B)= p (A)+p (B)-p (AB)

Volendo applicare la formula all’esempio precedente, ovvero ad un soggetto scelto a caso fra quelli

appartenenti al gruppo, alto non più di 1.75 cm con un peso inferiore a 70 kg, abbiamo: 0,6+0,70,5=0,8. Lo stesso risultato si ottiene qualora si applichi la seconda delle formule: 1-0,2=0,8.

Se si tratta di eventi incompatibili, la formula da applicare diventa, invece:

25

p (A+B)=p (A)+p (B) dato che p (AB)=0.

Se si lancia, quindi, per esempio, un dado, la probabilità che esca il numero uno o il numero due è 1/3

essendo 1/6 la probabilità dei singoli eventi che sono fra loro incompatibili.

Il secondo dei teoremi affrontati è il teorema delle probabilità composte.

Osserviamo nuovamente la tabella 1).

I dati dell’ultima riga e dell’ultima colonna della tabella, relativi alle distribuzioni congiunte delle

altezze e dei pesi, rappresentano le frequenze marginali. Queste si identificano con le due distribuzioni

semplici, ovvero con le frequenze delle due classi di peso a prescindere dall’altezza ( f (B) e f (B’)) e con

le frequenze delle due classi di statura a prescindere dal peso( f (A) e f (A’)). Le cifre della seconda

colonna rappresentano, invece, la distribuzione condizionata, secondo il peso, dei soggetti che hanno

altezza inferiore a 1.75 cm; la terza colonna evidenzia la distribuzione condizionata, secondo il peso, dei

soggetti che hanno altezza superiore a 1.75 cm.

Le frequenze, dunque, sono:

f (AB)/f (A); f ( AB’)/f (A); f (AB)/f (B); f (A’B)/f (B)…e così via.

Estendendo il discorso ad n eventi, otteniamo il teorema delle probabilità composte secondo il quale,

se un esperimento casuale E da luogo a più eventi A1, A2…An indipendenti tra loro ed aventi la

probabilità di verificarsi p (A1), p (A2)….p (An), la probabilità che tutti si verifichino è uguale al

prodotto delle singole probabilità.

Tornando all’ipotesi del lancio di un dado, la probabilità che in due lanci successivi si ripeta il numero

uno è pari a 1/36 (= 1/6*1/6).

Se due eventi sono dipendenti la probabilità composta è data dal prodotto della p. dell’evento

indipendente per la p. dell’evento condizionato:

P(AB) = P(A)*P(B/A)

Nell’ambito delle probabilità, troviamo anche le variabili casuali, che, per definizione, si identificano

con quella quantità, discreta, che un numero finito di valori (x1, x2 … xn) può assumere in relazione ai

diversi risultati di un esperimento casuale E con probabilità p1, p2 … pn tali che ™pi=1.

26

La variabile casuale può essere continua, se assume un’infinità continua di valori ed ha una densità

delle frequenze fornita da una funzione continua; a questa possiamo applicare i procedimenti di calcolo

propri delle variabili statistiche

Tornando ai due esempi precedenti, siamo di fronte a due distribuzioni di frequenza;

possiamo rappresentare la distribuzione delle frequenze mediante un istogramma su coordinate

cartesiane:

numero individui

Graf. 6 - Distribuzione di un insieme di individui secondo la statura

stature (cm.)

Se la funzione è definita in modo tale che S f(x)dx=1, la probabilità che la variabile continua X assuma

un valore compreso nell’intervallo infinitesimo da x a x+dx è f(x)dx, e la probabilità P{x 1< X <x2) che

essa assuma i valori compresi tra x1 e x2 è data dall’integrale S f(x)dx esteso da x1 a x2.

Si dice funzione di densità, la funzione definita in modo tale che S f(x)dx=1.

Si parla, ad esempio, di densità gaussiana.

Quando l’integrale non è uguale all’unità, si può moltiplicare la funzione per un valore tale che questa

condizione si verifichi.

Vediamo il grafico (segue):

27

frequenze

funzione di densità

130

140

150

160

170

stature

28

180

190

200

210

Resoconto della lezione del Prof.Malizia del 02/02/2006

“Distribuzioni di probabilità”

A cura di Sara Ceccarelli

La distribuzione di probabilità è una funzione che rappresenta la relazione tra la variabile casuale e la

sua probabilità di verificarsi.

Le distribuzioni di probabilità possono assumere infinite configurazioni.

Lo schema probabilistico fondamentale è quello di Bernoulli. Esso rappresenta una distribuzione

binomiale, fondata su una variabile dicotomica, cioè su una variabile che può assumere solo due valori.

Se consideriamo, ad esempio, l’evento “estrazione di pallina” da un’urna contenente per metà palline

bianche e per metà palline nere, l’evento può avere solo due esiti: estrazione di pallina bianca o

estrazione di pallina nera.

Se chiamiamo p la probabilità di estrarre pallina bianca e q quella di estrarre pallina nera,

p+q=1

quindi p = 1- q

e

q = 1- p

Effettuiamo diverse estrazioni e le consideriamo come eventi indipendenti tra loro (reinseriamo la

pallina estratta nell’urna). Applichiamo, quindi, il teorema delle probabilità composte.

In base a tale teorema, la probabilità di estrarre una pallina bianca è uguale al prodotto delle probabilità

dei singoli eventi dello stesso tipo.

In n eventi di estrazione tale probabilità è: ppp….p (n volte) = pn

Allo stesso modo, la probabilità che venga estratta una pallina nera in un numero n di estrazioni è

uguale al prodotto delle probabilità p, relative alle n-1 estrazioni di pallina bianca per la probabilità q, di

estrazione della pallina nera

ppp….pq = pn-1 q1

Se ipotizziamo che l’ordine di estrazione sia ininfluente ai fini del risultato, dobbiamo tener conto delle

permutazioni degli n elementi, dei quali n-1 sono uguali tra loro.

Le permutazioni entrano nel calcolo delle probabilità attraverso il fattore proveniente dal calcolo

combinatorio:

n!

n 1!*1!

La probabilità di estrarre, in un ordine qualunque, pallina bianca n-1 volte e pallina nera 1 volta è

29

n!

pn-1q

n 1!1!

Sinteticamente

n n-1

p q

np

Allo stesso modo, la probabilità di estrarre pallina bianca n-2 volte e la nera 2 volte è:

n!

pn-2 q2 =

n 2!2!

n

n-2 2

p q

n 2

Generalizzando, indicando con x il numero di volte in cui viene estratta la pallina bianca, esprimiamo

così le probabilità che esca, in qualsiasi ordine, la pallina bianca:

n

Pn, x = px qn-x

x

La distribuzione di probabilità espressa in questa forma è detta binomiale.

Calcoliamo, adesso, media e varianza della variabile casuale “estrazione di pallina bianca”.

La media può essere scritta come la somma della media della stessa variabile casuale, calcolata per ogni

singola estrazione:

M(xi1) = 1*p + 0*q = p

essendo 1 l’esito “pallina bianca estratta” e 0 “pallina bianca non estratta”.

Per la totalità delle estrazioni:

n

M(x) = M(x1) + M(x2) +….M(xn) =

M(xi) = np

i 1

La varianza è la media aritmetica dei quadrati degli scarti dalla media.

Gli scarti possibili in ogni estrazione sono: 1-p e 0-p. I quadrati (1-p)2 e (0-p)2.

La varianza è così determinata:

s2= ∑(xi –M(x))2pi

(1-p)2p + (0-p)2q = q2p + p2q = pq(p+q) =pq

Per tutte le n estrazioni: σ2 = npq

30

Quando p=q la distribuzione binomiale è simmetrica.

Al crescere del numero di estrazioni, la distribuzione binomiale (nel caso in cui sia simmetrica e dunque

p=q) tende a configurarsi come una distribuzione normale.

Nel determinare la distribuzione binomiale, un’informazione importante è data dalla combinazione

tipica, cioè da quei valori della variabile casuale x, cui corrisponde la massima probabilità.

Si può dimostrare che il valore di x è compreso nell’ intervallo: np-q≤ x≤ np+p

La combinazione tipica coincide con np, cioè con il valore medio della variabile casuale, quando esso è

un valore intero. Se non lo è, np approssima comunque la combinazione tipica con un errore che

diminuisce all’aumentare di n.

La probabilità associata alla combinazione tipica è approssimata dalla formula:

1

Pn, np

2npq

Maggiore è n, migliore è il grado di approssimazione.

Definiamo, a questo punto, l’espressione della distribuzione normale.

In primo luogo, dobbiamo calcolare la probabilità associata ad uno scarto x (compreso tra + e - )

rispetto a np (valore della combinazione tipica, ovvero della distribuzione binomiale):

n

np+x n-np-x

p

Pn, np+x =

q

np x

Questa espressione può essere ridotta alla forma approssimata:

Pn, np +x

1

2npq

e

x2

2 npq

ed npq, per le relazioni viste in precedenza, può essere sostituito con σ2

Pn, np +x

1

2 2

e

x2

2 2

Quanto più n è grande, tanto più questa espressione si sposta verso l’uguaglianza.

Possiamo rappresentare la distribuzione di Gauss in tre diverse forme.

La prima è definita in funzione della media μ e della varianza σ2.

La seconda è definita dalla varianza σ2 ed ha media nulla.

La terza ha media nulla e varianza unitaria ed è definita dalla variabile casuale normalizzata (u) rispetto

allo scarto quadratico medio

u = x/σ = (α-μ)/σ

31

Le tre funzioni assumono questa forma:

1. f(a) =

1

1

2

1

2

( a )2

2 2

e

2

2. f(x) =

3. f(u) =

e

e

x2

2 2

u2

2

Di seguito gli andamenti delle tre funzioni.

32

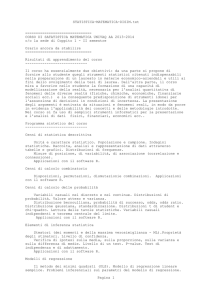

IL METODO DEI MINIMI QUADRATI PER LA STIMA DEI

PARAMETRI

(Resoconto della lezione di Statistica del 09 Febbraio 2006, Prof. Malizia)

a cura di Ilaria Screpante

Il metodo dei minimi quadrati è uno degli strumenti più utilizzati per la determinazione della tendenza

dei dati nel tempo. Viene utilizzato soprattutto per la determinazione di specifici parametri nel

procedimento di interpolazione e di regressione.

Per una descrizione più analitica del metodo dei minimi quadrati sarà utile porre attenzione

dapprima al processo di interpolazione, sottolineando che statisticamente tale procedimento ha lo scopo di

identificare specifiche leggi o regolarità che si pongono alla base della manifestazione dei fenomeni

oggetto di analisi. Attraverso l’interpolazione, quindi, è possibile stimare valori che il carattere dovrebbe

assumere in assenza di fattori accidentali. Questi ultimi, infatti, in alcuni casi possono influenzare in

modo significativo il fenomeno analizzato, rendendo così difficile la stima della legge sottostante che

regola il fenomeno in analisi7.

In generale, il fine dell’interpolazione viene raggiunto determinando una funzione

y = f (x), in cui il fenomeno y è dipendente dal fenomeno x. In questo senso, la funzione y = f (x) è detta

funzione interpolatrice o curva interpolatrice. Di conseguenza, proprio in riferimento allo scopo che tale

funzione si pone – determinare i valori che il carattere dovrebbe assumere – i valori stimati vengono

definiti valori teorici, per distinguerli da quelli che invece derivano direttamente dall’osservazione del

fenomeno, ossia i valori osservati o empirici.

In altre parole, il procedimento di interpolazione ci consente di identificare la relazione principale

esistente tra diversi fenomeni.

Graficamente, dopo aver rilevato i casi statistici che scaturiscono dalle osservazioni fatte, la curva

interpolatrice potrebbe essere così rappresentata:

In senso stretto, in statistica e in matematica l’interpolazione indica un procedimento mediante il quale, dati alcuni

valori di una variabile x, di cui a sia il minore e b il maggiore, e in corrispondenza altrettanti valori di una variabile y

dipendente da x, si determinano valori della y per valori della x dell’intervallo [a b] che siano diversi dalle x date. Cfr.

G. Leti, Statistica descrittiva, Il Mulino, Bologna, 1983, p. 631.

7

33

Spesa per beni alimentari in funzione del reddito

y

0

x

Dal grafico precedente osserviamo che i punti giacenti sulla curva (e quindi la curva stessa)

rappresentano i cosiddetti valori teorici, mentre i valori osservati empiricamente sono rappresentati dai

punti vicini alla curva ma non sovrapposti ad essa.

Dal grafico, inoltre, è possibile osservare che i valori teorici e quelli osservati non coincidono

esattamente. La distanza che separa i valori assoluti e quelli teorici (giacenti sulla curva) rappresenta

l’effetto di perturbazione.

Nel procedimento di interpolazione, però, è necessario determinare – oltre il tipo di funzione8 –

anche i parametri dell’espressione matematica della funzione stessa.

Ai fini della determinazione del valore di questi parametri si possono adottare diversi metodi, e il

più utilizzato è il metodo dei minimi quadrati.

In base a tale metodo, si impone la condizione che la somma dei quadrati degli scarti tra i valori

empiricamente osservati e quelli teorici sia un minimo.

Poniamo ora attenzione su due distinti casi possibili di funzione di interpolazione:

1. La funzione interpolatrice è ŷ = a

2. La funzione interpolatrice è ŷ = a + bx

Nel primo caso i valori teorici – espressi dalla funzione ŷ = a – sono una costante, ossia non variano

al variare di x. Essi, quindi, sono indipendenti dal valore che assume la variabile x. In questo primo caso

ponendo la condizione sopra descritta (la somma dei quadrati degli scarti tra i valori empirici e quelli

teorici sia un minimo) si avrà quindi :

(3)

f(a) = ∑ (yi – a)2 = minimo

8

Per una trattazione analitica della distinzione dei tipi di funzione e dei criteri per la scelta dei medesimi cfr. G. Leti,

cit., p. 635 ss.

34

calcolando la derivata prima della (3) e ricordando che questa è pari a 0 nel punto di minimo, con alcuni

passaggi algebrici, si ottiene che :

a

(4)

y

i

n

ovvero la media aritmetica, confermando così una delle sue proprietà9 .

Nel secondo caso, invece, si considera la funzione interpolatrice y = a + bx. Ciò significa che la

variabile y dipende dalla variabile x sulla base di una relazione lineare (con intercetta a e coefficiente

angolare b).

Anche in questo caso imponendo la condizione già citata, si ha che:

f(a, b) = ∑ (yi – a – bxi)2 = minimo

(5)

In questo caso nel punto di minimo la derivata prima delle due derivate parziali (rispetto ad a e b)

fornisce il seguente sistema di equazioni :

na + b∑xi = ∑yi

(6)

a∑xi + b∑xi2 = ∑yi xi

La (6) può essere risolta utilizzando la regola di Kramer, attraverso la quale otteniamo i rispettivi

valori dei parametri a e b:

∑yi ∑xi2 – ∑xi ∑yi xi

(7)

a=

n∑xi2 – (∑xi)2

(8)

n∑yi xi – ∑xi ∑xi yi

b=

n∑xi2 – (∑xi)2

9

La somma dei quadrati degli scarti fra i singoli termini e la media aritmetica è minimo.

35

In conclusione, mediante la conoscenza dei valori di a e b – secondo i diversi procedimenti in base

al tipo di funzione – è possibile individuare i valori della variabile dipendente y, arrivando così a

individuare la relazione che lega fra loro diversi fenomeni, di cui uno e dipendente dagli altri.

36

Strumenti statistici propedeutici alla valutazione (Dott. Malizia)

lezione del 16 febbraio 2006

A cura di Rossana Tiani

Interpolazione e regressione

Quando si analizzano caratteri quantitativi si può cercare di individuare una funzione che descriva in

modo sintetico le caratteristiche del loro legame. Se una variabile è considerata dipendente dall’altra (o

dalle altre) secondo una determinata legge o funzione, si parlerà di regressione. Quando i caratteri

sono quantitativi, perciò, oltre a misurare con un indice statistico la loro associazione, si può cercare di

descrivere con maggiore dettaglio la relazione che li unisce. Ciò avviene generalmente attraverso

l’individuazione di una funzione matematica che esprime i valori assunti da un carattere come funzione

dei valori assunti dagli altri caratteri. Si vuole, in tal modo, analizzare la dipendenza di una variabile

(detta variabile dipendente) da una o più variabili (chiamate variabili indipendenti o esplicative).

Nella teoria dell’inferenza statistica l’espressione y = f(x) definisce il modello di regressione lineare

semplice.

Nella statistica descrittiva l’attenzione è rivolta esclusivamente all’individuazione della funzione f(x) che

fornisce i valori teorici più vicini ai valori osservati della variabile dipendente Y. La “vicinanza” tra i

valori teorici ed i valori osservati viene definita in termini geometrici per cui si preferisce parlare di

interpolazione piuttosto che di regressione. L’interpolazione descrive le relazioni di casualità tra due

(bivariata) o più fenomeni (multivariata). Essa, difatti, ci consente di stimare i valori teorici che il

carattere dovrebbe assumere in assenza di cause perturbatrici di diversa natura e di numerosi fattori

accidentali che potrebbero influire sulle osservazioni effettivamente rilevate e rendere meno evidente la

legge che governa il fenomeno. Il nostro scopo, perciò, è quello di scoprire la funzione matematica che

governa la relazione tra due o più fenomeni, ossia di determinare il tipo di funzione ed i parametri della

sua espressione matematica10. La curva interpolante individua proprio i valori teorici che si sarebbero

osservati in assenza di cause perturbatrici; la distanza tra i valori osservati e quelli che giacciono sulla

curva descritta dalla funzione interpolante rappresenta, infatti, l’effetto dei fattori accidentali.

L’obiettivo è quello di trovare la procedura per identificare l’equazione y = f(x) che ha generato i dati

rilevati sulla variabile y in relazione ad x. Nel nostro esempio, dal momento che c’è una relazione di tipo

crescente tra x ed y, si può supporre che la spesa per consumi dipenda dal reddito; ne consegue che il

10

Come nel caso in cui su un collettivo di famiglie viene osservata, per esempio, la spesa per consumi (Y) e il reddito

familiare (X). Se supponiamo che la spesa per consumi dipenda dal reddito, dunque che y = f(x), per prima cosa

dobbiamo verificare tale ipotesi per poi procedere, in caso di esito positivo, all’identificazione della funzione che

descriva tale relazione. In tal caso il reddito è la variabile indipendente della spesa per i consumi ma esistono anche altri

fattori che ne determinano l’andamento: le aspettative, la composizione dei nuclei familiari, le preferenze dei

consumatori e così via.

37

primo problema che si pone è quello della individuazione della funzione più adatta a descrivere tale

relazione lineare.

Si assume, pertanto come funzione un polinomio di primo grado:

f(x) = a + bx

Tale espressione individua una “famiglia” di rette in cui il parametro a individua l’intercetta della

retta11, mentre b individua il coefficiente angolare12. È bene individuare, nella famiglia delle rette, una

particolare retta che rappresenti al meglio la nuvola dei punti osservati. Individuare una retta vuol dire

determinare il valore dell’intercetta e del coefficiente di regressione. Il metodo che si utilizza per trovare

il valore di questi due parametri è il metodo di interpolazione dei minimi quadrati. Ne deriva che la

retta individuata con tale metodo viene chiamata retta di regressione ed il suo coefficiente angolare

coefficiente di regressione.

In base a tale metodo si minimizza la somma dei quadrati delle differenze tra il valore osservato,

empirico (y) ed il valore teorico (yˆ); più semplicemente, la somma del quadrato degli scarti tra questi

due tipi di valori è un minimo, ossia i valori teorici ottenuti a calcolo sono tali per cui non esiste

nessuna altra funzione lineare che mi dia un risultato inferiore.

∑ (yi - yˆ)2 = minimo

Se supponiamo che la funzione interpolatrice sia: yˆ = a ossia che i valori teorici espressi dalla

funzione interpolatrice sono una costante, e poniamo la condizione iniziale, ne deriva che:

f(a) = ∑ (yi - a)2 = minimo

Dal momento che nel punto di minimo, la derivata prima della funzione si annulla, avremo:

f ’(a) = -2 ∑ (yi - a) = 0

da cui

∑ yi – na = 0

a = ∑ yi / n = My (media aritmetica)

Di qui:

∑ yi

yˆ = a =

n

= My

ossia ricaviamo un risultato atteso dal momento che una delle proprietà

della media aritmetica è che la somma dei quadrati degli scarti fra i singoli termini e la media aritmetica

è un minimo.

Si supponga ora che la funzione interpolatrice sia: yˆ = a + bx

in cui poniamo la condizione

che la somma dei quadrati degli scarti tra i valori osservati e quelli teorici sia un minimo:

f (a, b) = ∑ (yi – a - bxi)2 = minimo

Per la determinazione del minimo della funzione si devono calcolare le derivate parziali prime rispetto

ad a e b, uguagliarle a zero (dato che nel punto di minimo le derivate parziali prime della funzione si

11

12

Ci si riferisce al punto in cui la retta intercetta l’asse delle ordinate.

Il coefficiente angolare, invece, indica il livello di inclinazione, positivo o negativo, della retta.

38

annullano) e risolvere il sistema in due equazioni e due incognite13. Si ottiene, perciò, il seguente

sistema normale14:

a

- 2 ∑ (yi – a - bxi) = 0

b

- 2 ∑ (yi – a - bxi) xi = 0

Ed eliminando la costante (- 2), si può sviluppare il sistema normale nel seguente modo:

a

∑ (yi – a - bxi) = 0

b

∑ (yi – a - bxi) xi = 0

Determiniamo ora il valore del parametro a che identifica

l’intercetta della retta interpolante sull’asse delle ordinate.

∑ (yi – a - bxi) = 0

∑ yi – ∑a - b∑ xi = 0

∑ yi – na - b∑ xi

n

∑ yi – na - b∑ xi = 0 dividiamo il tutto per n:

∑ yi

=0

laddove

n

∑ xi

è la media aritmetica My, mentre

n

è Mx. Perciò

scriviamo:

My – a – bMx = 0 da cui si ricava

a = My - bMx

Esplicitando il valore di a e sostituendolo nella seconda equazione, siamo in grado di determinare il

valore del parametro b (che misura l’inclinazione della retta15) mediante due procedimenti:

1. ∑ (yi – a - bxi) xi = 0 in cui vi sostituisco il valore di a

∑ (yi – My – bMx – bxi)xi = 0 Distribuiamo la sommatoria:

∑ (yi - My)xi - b∑ (xi - Mx)xi = 0

∑ (yi – My)xi = b∑ (xi – Mx)xi da cui ricavo:

In realtà è bene sottolineare che tale procedimento è solo una condizione necessaria ma non sufficiente per l’esistenza

di un punto di minimo. Tuttavia, poiché la funzione in esame non può assumere valori più piccoli di 0 mentre può

crescere fino a +

(dal momento che è possibile trovare rette via via sempre più distanti dai punti osservati), l’unico

punto stazionario determinato deve essere un minimo globale.

14

Si noti che il valore dei due parametri può essere determinato anche effettuando i calcoli sui valori effettivamente

osservati. Il sistema, perciò, può essere risolto mediante la regola di Cramer, attraverso la quale otterremo:

13

∑ yi ∑ xi2 - ∑ xi ∑ yi xi

a=

n ∑ yi xi - ∑ xi ∑ yi

b=

n∑

xi2 –

( ∑ xi)2

n ∑ xi2 – ( ∑ xi)2

Si ricordi che se b = 1 la retta ha un’inclinazione di 45º; se è inferiore ad 1, l’inclinazione è minore di 45º; altrimenti

se è superiore ad 1, l’inclinazione sarà maggiore di 45º; se b = 0, ci troviamo in assenza di legame lineare, la pendenza

è nulla e la retta di regressione è parallela all’asse delle X. Infine se il parametro b è positivo la retta è crescente,

altrimenti se è negativo essa è decrescente.

15

39

∑ (yi- My)xi

b=

coefficiente di regressione

∑ (xi - Mx)xi

Come già detto, possiamo calcolare il valore di b mediante un secondo procedimento:

2. Consideriamo il numeratore e lo distribuiamo rispetto a (xi - Mx):

∑ (yi - My)(xi - Mx) = ∑ (yi - My)xi - ∑ (yi - My)Mx laddove sappiamo che la somma degli scarti dalla

media, ossia ∑ (yi - My) , è uguale a zero. Di qui ne consegue che: ∑ (yi - My)(xi - Mx).

Ora distribuiamo il denominatore sempre rispetto a (xi - Mx):

∑ (xi - Mx) (xi - Mx) da cui ∑ (xi - Mx)xi - ∑ (xi - Mx)Mx laddove ∑ (xi - Mx) = 0 si avrà:

∑ (xi - Mx) (xi - Mx) = ∑ (xi - Mx)2 dunque:

∑ (yi - My)(xi - Mx) codevianza

b=

∑ (xi - Mx)2 devianza

16

In tal caso abbiamo determinato il valore dei due

parametri effettuando, non i calcoli sui valori effettivamente osservati,

(così come si è visto nella regola di Kramer), ma a partire dagli scarti dei valori dalla loro media. I

risultati, ovviamente sono i medesimi.

In ultima analisi, dopo aver stimato i parametri a e b, è possibile determinare la funzione interpolatrice

sostituendo semplicemente i valori ottenuti in precedenza. Più semplicemente, a partire dai dati

osservati siamo in grado di identificare la retta di regressione che meglio si adatta ad essi, ossia:

f(x) = a + bx

f(x) = My – ∑ (yi - My)(xi - Mx)

Mx +

∑ (yi - My)(xi - Mx)

∑ (xi - Mx)2

∑ (xi - Mx)2

a

b

X

Un’ultima precisazione. La somma dei quadrati degli scarti tra i valori osservati e quelli teorici17 è uguale

sia nel caso si risolva il sistema di equazioni con la regola di Cramer e sia se si considerano gli scarti

16

Si faccia un breve richiamo a ciò che è stato affrontato in precedenza. Se dividiamo il numeratore e il denominatore

del rapporto tra codevianza e devianza per n, avremo: σxy / σ2x ossia ricaviamo il rapporto tra covarianza e varianza

delle X.

17

Ciò dal momento che la condizione iniziale che abbiamo posto attraverso il metodo dei minimi quadrati è:

∑ (yi - yˆ)2 = minimo.

40

dalla media. Ciò perché nel calcolare gli scarti dalla media abbiamo traslato gli assi cartesiani facendo

coincidere l’origine con le medie dei due caratteri, per cui la disposizione sul piano cartesiano dei punti,

e perciò la relazione tra i due caratteri, non muta.

Analisi dei residui

Dopo aver trovato, mediante il metodo dei minimi quadrati, la retta di regressione che meglio interpola

i valori osservati, è opportuno valutare se l’ipotesi di una relazione lineare semplice tra i due caratteri sia

effettivamente ragionevole o, invece, non sia meglio realizzare un altro tipo di relazione. Una tecnica

che permette un’analisi puntuale dell’adattamento della retta di regressione è l’analisi dei residui. Il