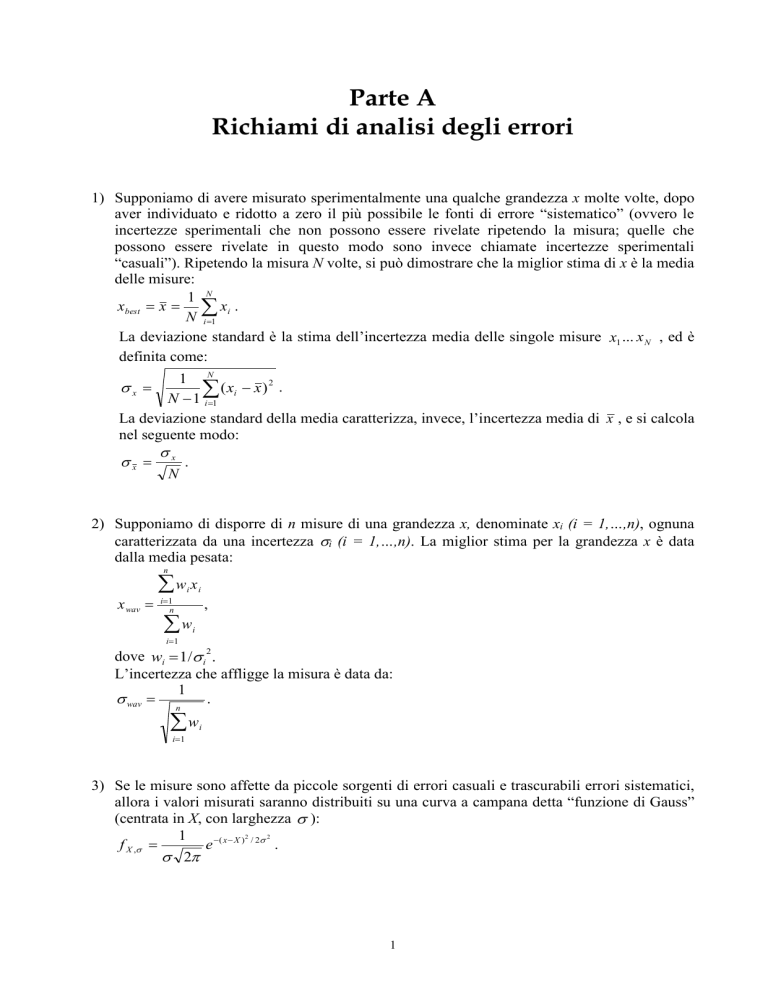

Parte A

Richiami di analisi degli errori

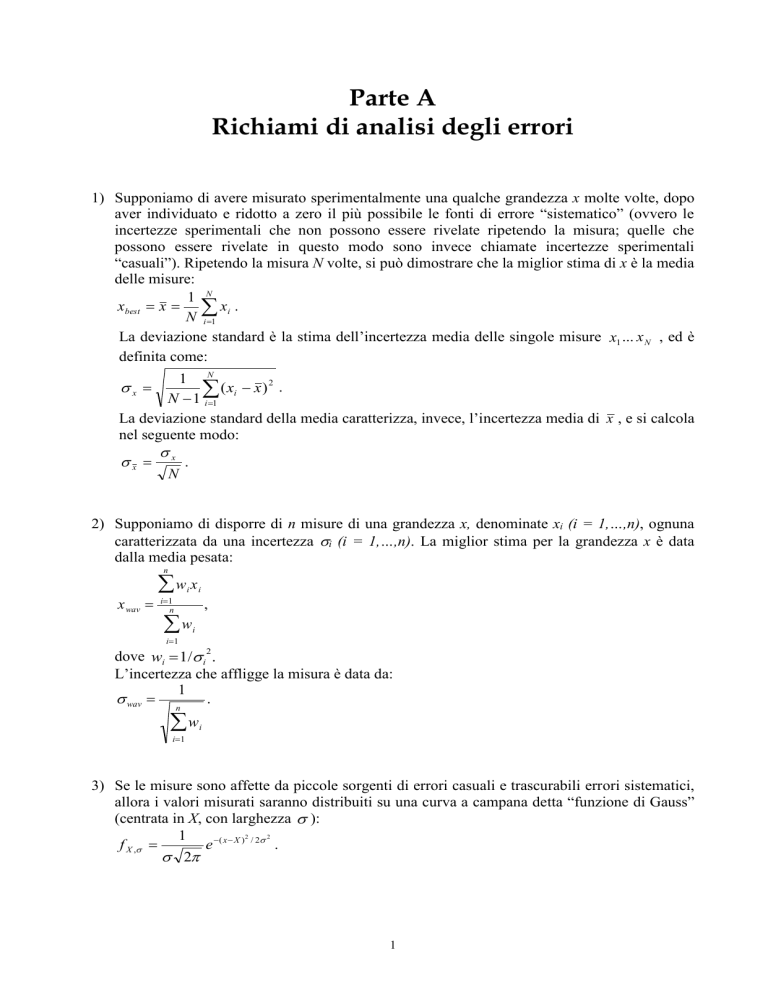

1) Supponiamo di avere misurato sperimentalmente una qualche grandezza x molte volte, dopo

aver individuato e ridotto a zero il più possibile le fonti di errore “sistematico” (ovvero le

incertezze sperimentali che non possono essere rivelate ripetendo la misura; quelle che

possono essere rivelate in questo modo sono invece chiamate incertezze sperimentali

“casuali”). Ripetendo la misura N volte, si può dimostrare che la miglior stima di x è la media

delle misure:

1 N

xbest x xi .

N i 1

La deviazione standard è la stima dell’incertezza media delle singole misure x1 ... x N , ed è

definita come:

1 N

x

( xi x ) 2 .

N 1 i 1

La deviazione standard della media caratterizza, invece, l’incertezza media di x , e si calcola

nel seguente modo:

x x .

N

2) Supponiamo di disporre di n misure di una grandezza x, denominate xi (i = 1,…,n), ognuna

caratterizzata da una incertezza i (i = 1,…,n). La miglior stima per la grandezza x è data

dalla media pesata:

n

w x

i

x wav

i

i1

n

w

,

i

i1

dove wi 1/ i .

L’incertezza che affligge la misura è data da:

1

wav

.

2

n

w

i

i1

3) Se le misure sono affette da piccole sorgenti di errori casuali e trascurabili errori sistematici,

allora i valori misurati saranno distribuiti su una curva a campana detta “funzione di Gauss”

(centrata in X, con larghezza ):

2

2

1

f X ,

e ( x X ) / 2 .

2

1

4) Per verificare che i valori ricavati xbest e x siano valori ragionevoli rispetto al valore

conosciuto della grandezza x vero si può calcolarne il livello di confidenza. Definiamo

innanzitutto il numero di deviazioni standard per cui xbest differisce da x vero :

t x best x vero / x .

La probabilità, date le ipotesi fatte, di ottenere un risultato che differisca da x vero per t o più

deviazioni standard è:

P(al di fuori di t ) = 1 - P(entro t ).

Dove (vedere Allegati pag. I, C300):

t

2

1

t

P(entro t )=

e z / 2 dz erf

.

2 t

2

A questo punto P(al di fuori di t ) prende il nome di livello di confidenza (CL).

5) Una stima dell’accordo tra un insieme n di punti sperimentali yi e una funzione f ( xi ) si

può ottenere misurando 2 , definito come:

( y k f ( x k )) 2

.

2 ( yk )

k 1

Se si confronta una distribuzione di eventi con una distribuzione di probabilità non

normalizzata, ad esempio una gaussiana, la formula del 2 diventa:

n

2

(Ok E k ) 2

,

Ek

k 1

dove è stato diviso l’intervallo dei possibili valori di x in n intervalli, per cui Ok rappresenta

il numero di osservazioni che cadono nell’intervallo k-esimo e Ek il numero atteso delle

n

2

misure dell’intervallo k-esimo. 2 è un indicatore ragionevole dell’accordo tra la

distribuzione osservata e quella attesa. Se 2 = 0 l’accordo è perfetto, cosa molto

improbabile. In generale ci si aspetta che ogni termine della somma sia dell’ordine di 1. Il

chi quadrato ridotto si definisce, invece, nel modo seguente:

~ 2 2 / N DF ,

essendo N DF il numero di gradi di libertà, e N DF N N PAR N V dove N è il numero di

intervalli significativi e N PAR è il numero di parametri, N V il numero di vincoli.

6) Supponiamo ora di aver misurato una o più grandezze x, y,… e calcolato gli errori

corrispondenti x , y , …, e di dover calcolare la funzione z = f(x,y,…). La miglior stima del

valore della funzione sarà:

z best z f ( x , y,...) .

Per stimare l’incertezza di questo risultato si applica la propagazione degli errori delle

misure x, y, quindi:

2

f f

f

f

z x y ... 2 xy

.

x y

x y

In particolare, nel caso in cui z kxa y b e se gli errori su x ed y sono indipendenti e

casuali, il calcolo della deviazione standard si riduce a:

2

2

y

a x b

z

x y

z

2

2

.

7) Supponiamo di avere una serie di misure ( xi , yi ) i=1...N con gli xi tutti esatti e gli yi tutti

ugualmente incerti, quindi assumiamo che le misure degli yi siano governate da

distribuzioni normali con larghezza 0 . Se le variabili x e y sono legate da una relazione

lineare della forma (con A e B come incognite):

y A Bx ,

si può trovare la retta che meglio approssima la serie di misure, minimizzando la funzione:

N

(y A Bx i ) 2

2

i

.

02

i1

Differenziando rispetto ad A e B ed uguagliando a zero si ottiene:

N

N

N

N

x y x x y

A

B

2

i

i 1

i 1

i

i 1

i

i

i 1

i

,

N

N

i 1

i 1

N xi y i xi

N

y

i 1

i

,

dove:

N 2

N x i x i .

i1

i1

N

2

Le

incertezze

B y

sui

parametri

calcolati

sono

le

seguenti:

A y

x

2

e

N

.

Essendo: y

1

N DF

N

i 1

( yi A Bx i ) 2 , con N DF N N PAR il numero di gradi di

libertà (in questo caso N PAR 2 ).

La covarianza A, B e la relativa correlazione A, B

calcolabili come:

y2 xi

,

A, B

xi

.

( A, B)

N xi2

3

A, B

sono facilmente

A B

8) Supponiamo ora, invece, che per ogni xi il corrispondente valor vero di yi è dato dalla

polinomiale della variabile x (con A e C come incognite):

y A C x2 .

Assumendo ancora che le misure degli yi siano governate da distribuzioni normali con

larghezza 0 , si può trovare la miglior stima delle costanti A e C minimizzando la funzione:

N

(y A Cx i 2 ) 2

2 i

.

02

i1

Differenziando rispetto ad A e C ed uguagliando a zero si ottiene:

y x 4 x 2 y x 2

,

A

p

C

N x 2 y y x 2

p

,

p N x4 x2 .

Da qui si ricavano le migliori stime per A e C.

Attraverso la propagazione degli errori si possono ricavare le rispettive deviazioni standard:

A y

x

2

4

e

p

C y

N

,

p

essendo:

y

1

N DF

N

i 1

( yi A Cxi ) 2

2

( N DF N N PAR N 2 ).

L’equazione y A C x 2 viene così denominata adattamento polinomiale dei minimi

quadrati, o regressione lineare delle misure date. Analogamente al caso della retta, la

A, B

covarianza A, B e la relativa correlazione A, B

sono facilmente

A B

calcolabili come:

y2 xi2

,

A, B

x 2i

( A, B )

.

N xi4

4