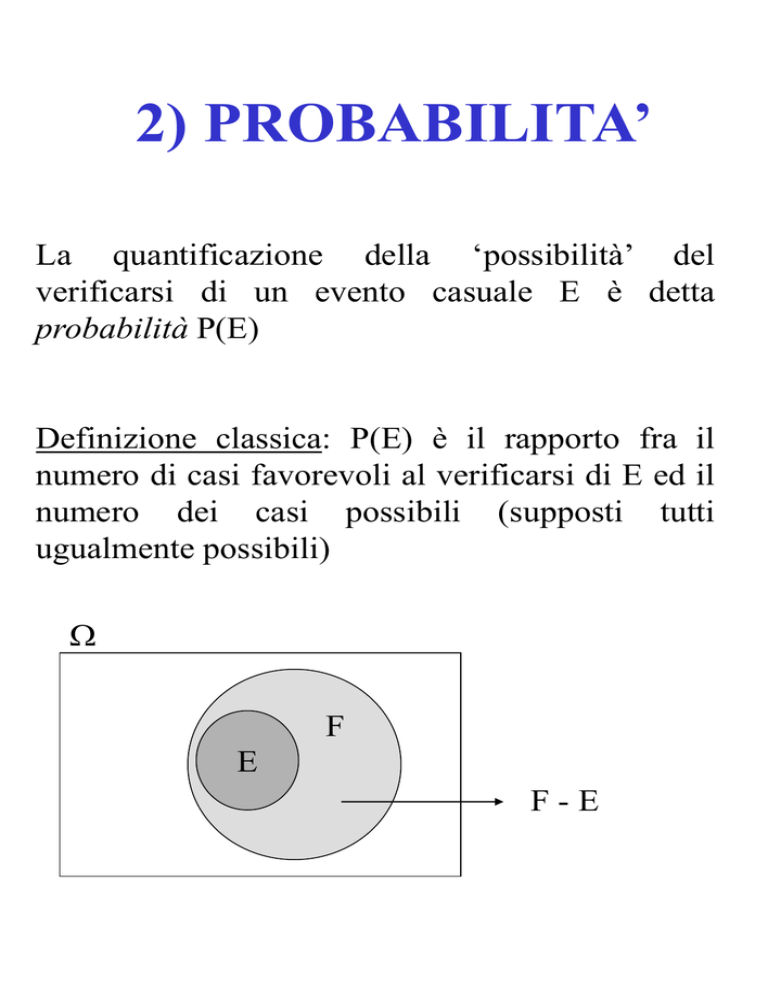

2) PROBABILITA’

La quantificazione della ‘possibilità’ del

verificarsi di un evento casuale E è detta

probabilità P(E)

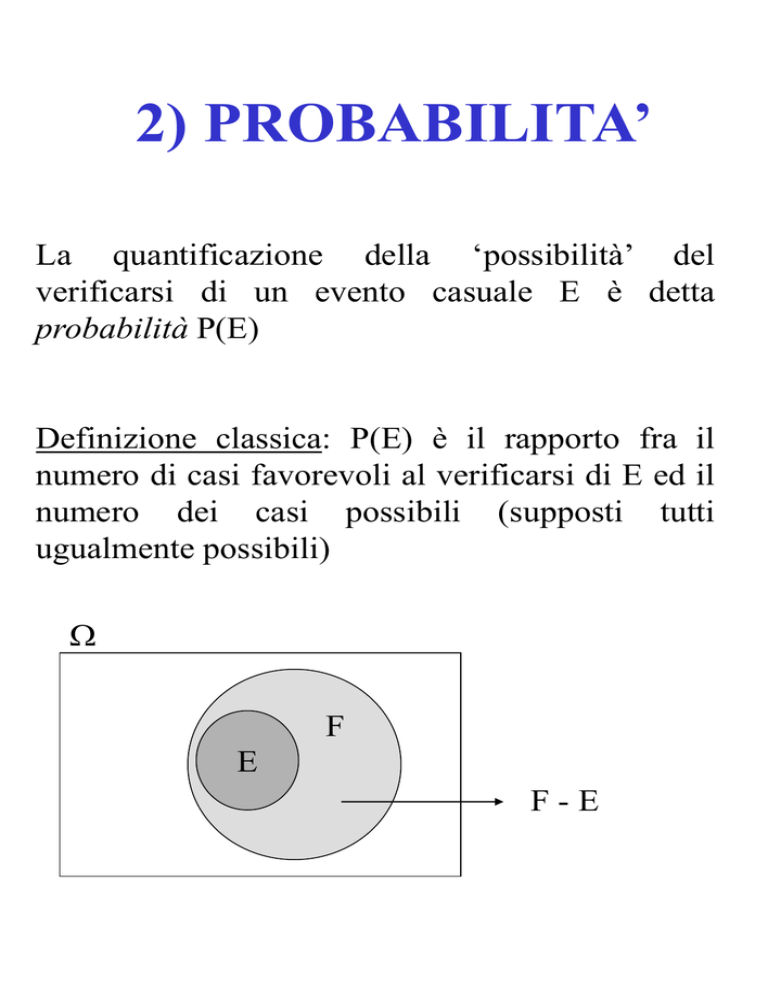

Definizione classica: P(E) è il rapporto fra il

numero di casi favorevoli al verificarsi di E ed il

numero dei casi possibili (supposti tutti

ugualmente possibili)

F

E

F-E

Si tratta ora di definire come si dovrà procedere in

pratica per identificare il numero P(E).

Due sono le principali definizioni di probabilità;

• la prima è basata sul concetto di “equiprobabilità” e

viene chiamata “classica”, essendo la definizione

adottata dai matematici che nel secolo XVII

cominciarono ad occuparsi sistematicamente della

teoria delle probabilità;

• la seconda è detta “statistica” in quanto definisce la

probabilità di un evento come approssimazione della

frequenza relativa constatata in una serie di prove o di

osservazioni a proposito dell’evento medesimo.

L’equiprobabilità è un concetto che viene inteso come

espressione di una proprietà oggettiva attribuibile, per la

presenza di qualche “simmetria”, agli elementi che

formano lo spazio .

La conseguenza è che la definizione classica può trovare

applicazione solo nel caso in cui lo spazio degli eventi

elementari sia articolato in un numero finito di punti.

Quindi se E è un generico evento di B , la definizione

classica prevede che se l’evento E è l’unione di m

qualunque degli n eventi elementari equiprobabili che

formano , la probabilità P(E) dell’evento in questione

è rappresentata dal rapporto:

m

P( E ) ,

n

(0 m n).

In altri termini, la probabilità dell’evento E è

identificata dalla frazione che ha al denominatore il

numero n degli eventi (elementari) “possibili” con uno

dei quali deve concludersi l’esperimento casuale ed al

numeratore il numero m degli eventi (elementari)

“favorevoli” ad E.

La definizione “statistica” di probabilità, invece, trova il

suo supporto nella particolarità di comportamento

riscontrata in un gran numero di fenomeni naturali.

Infatti, vi sono fenomeni che, se osservati un gran

numero di volte nelle loro manifestazioni xi, (i = 1,…,k),

rivelano come le corrispondenti frequenze relative fi(n)/n

- essendo fi(n) il numero di volte in cui nelle n

osservazioni effettuate, il fenomeno condsiderato ha

presentato la modalità xi - al crescere di n danno la

sensazione di volersi ancorare ad una qualche costante.

casi favorevoli

P( E )

casi possibili

oppure:

numerosità di E

P(E )

numerosità di

Osservazione:

La definizione classica di probabilità può essere

utilizzata per calcolare P(E)

solo qualora sia possibile determinare la

numerosità di E e di , cioè solo nel caso

in cui sia insieme finito e sia possibile

“contare” gli eventi elementari che

compongono E.

Definizione Frequentista o

Statistica:

P(E) coincide con la frequenza

relativa del verificarsi di E

calcolata su “un gran numero di

prove” condotte tutte nelle

medesime condizioni

2.1) Assiomi delle

probabilità

Il sistema dei 3 assiomi delle probabilità prescinde

dal calcolo di P(E) e consente la deduzione logica

di una serie di teoremi e proposizioni che

costituiscono la “ Teoria della Probabilità”.

Tali assiomi sono:

1)

P(E) 0

2)

P() =1

3)

Siano E1,E2,………,En n eventi inclusi in

a coppie incompatibili. Allora:

P Ei P( Ei )

i 1 i 1

n

n

Principio

Probabilità

Totale

2.2) Alcuni teoremi

sulle probabilità

Discendono direttamente dal sistema dei 3 assiomi.

1.Probabilità dell’evento complementare

P(E) 1 - P(E)

Dimostrazione: E ed E sono per definizione

incompatibili cioè

EE

Inoltre:

EE

Ricorrendo ai tre assiomi:

P(EĒ) = P(E) + P(Ē) = P() =1

da cui:

P(Ē) = 1 - P(E)

2.

0P(E) 1

P() = 1 = P(E) + P(Ē)

P(E) 0

P(Ē) 0

0P(E) 1

3. Probabilità dell’evento impossibile

P() = 0

dimostrazione: l’evento impossibile è il

complementare dell’evento certo . Pertanto:

P() = 1 - P() = 1 - 1 = 0

4. Probabilità dell’evento unione

P(E1E2) = P(E1) + P(E2) - P(E1E2)

E1

E2

Sommando le probabilità di E1 e di E2 si

finisce per considerare due volte la

probabilità della parte comune che va,

pertanto, sottratta.

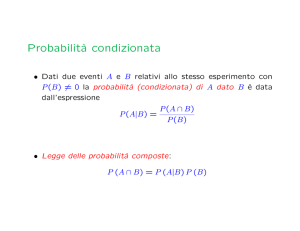

2.3) Probabilità

condizionata

Siano E1 ed E2 due eventi inclusi nel medesimo

spazio campionario: E1 e E2 .

Si definisce evento condizionato E1|E2 l’evento

E1 condizionato dal fatto che E2 si è verificato.

E2 è detto ‘evento condizionante’.

PROBABILITA’ CONDIZIONATA: è il

rapporto tra la probabilità dell’evento

intersezione e la probabilità dell’evento

condizionante

P( E1 E2 ) P n P

P( E1 | E2 )

P ( E2 )

S n S

Ovviamente la probabilità dell’evento

condizionante non può essere nulla.

Esempio: sia E1 = “esce un numero pari”

ed E2 = “esce un numero 4”.

Posto che sia uscito un numero 4, qual

è la probabilità che tale numero sia pari?

P( E1 | E2 )

P( E1 E2 )

P(2 4)

2/6

0.5

P ( E2 )

P(1 2 3 4) 4 / 6

P(E F) : P' (E F) P(F) : 1

Si può ore osservare che se nell’uguaglianza:

P(E F)

P' (E F)

P(E | F)

P(F)

P(E F)

P(E | F)

P(F)

Tuttavia, se la classe B’ viene considerata

prescindendo dalla classe B, è evidente che F=’

assume la funzione di evento certo cui deve

competere non già probabilità P(E)<1 ma

probabilità pari a 1.

Nella nuova prospettiva anche ogni elemento EF

di B’ non ha più associata probabilità P(E F)

ma la probabilità P’(E F) risultando:

Principio delle probabilità composte: serve

per determinare la probabilità dell’evento

intersezione. Segue dalla definizione di

probabilità condizionata:

P( E1 E2 ) P( E1 | E2 ) P( E2 ) P( E2 | E1 ) P( E1 )

OSSERVAZIONE: se P( E1 | E2 ) P( E1 )

allora il fatto che l’evento E2 si sia

verificato non ha influenza sull’evento E1

poiché non ne altera la probabilità.

Due eventi si dicono pertanto indipendenti se:

P( E1 | E2 ) P( E1 )

Oppure (equivalentemente):

P( E2 | E1 ) P( E2 )

In questo caso si ha:

P( E1 E2 ) P( E1 ) P( E2 )

Se due eventi sono indipendenti, allora lo

sono anche i complementari:

P( E1 E2 ) P( E1 ) P( E2 )

OSSERVAZIONE: se P( E1 | E2 ) 0 e P( E1 ) 0

allora il fatto che l’evento E2 si sia

verificato comporta che l’evento E1 non

possa più verificarsi.

Probabilità dell’evento intersezione:può

essere calcolato in quattro differenti modi:

1. Se è nota la probabilità condizionata si può

ricorrere al principio delle probabilità

composte;

2. Se è nota la probabilità dell’evento unione:

P( E1 E2 ) P( E1 ) P( E2 ) P( E1 E2 )

P( E1 E2 ) P( E1 ) P( E2 ) P( E1 E2 )

3. Se è noto che E1 ed E2 sono indipendenti,

si ottiene per prodotto;

4. Se è noto che E1 ed E2 sono incompatibili,

è nulla. Infatti:

P(E1 | E2 ) P(E2 | E1 ) 0

poiché

P(E1 E2 ) P( ) 0