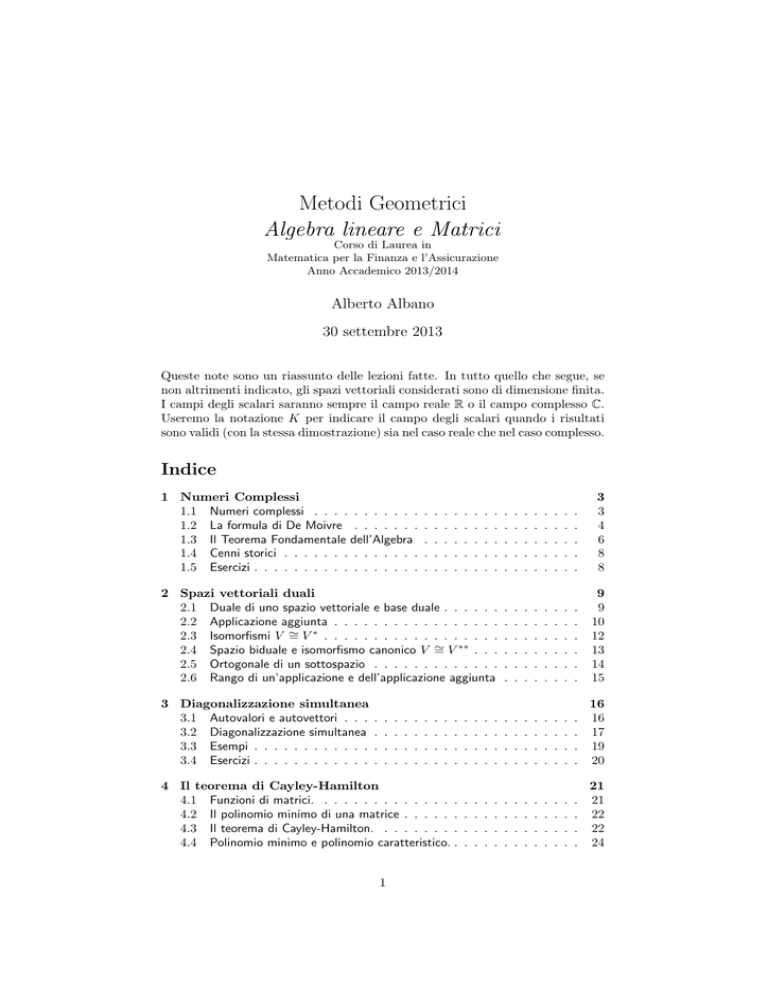

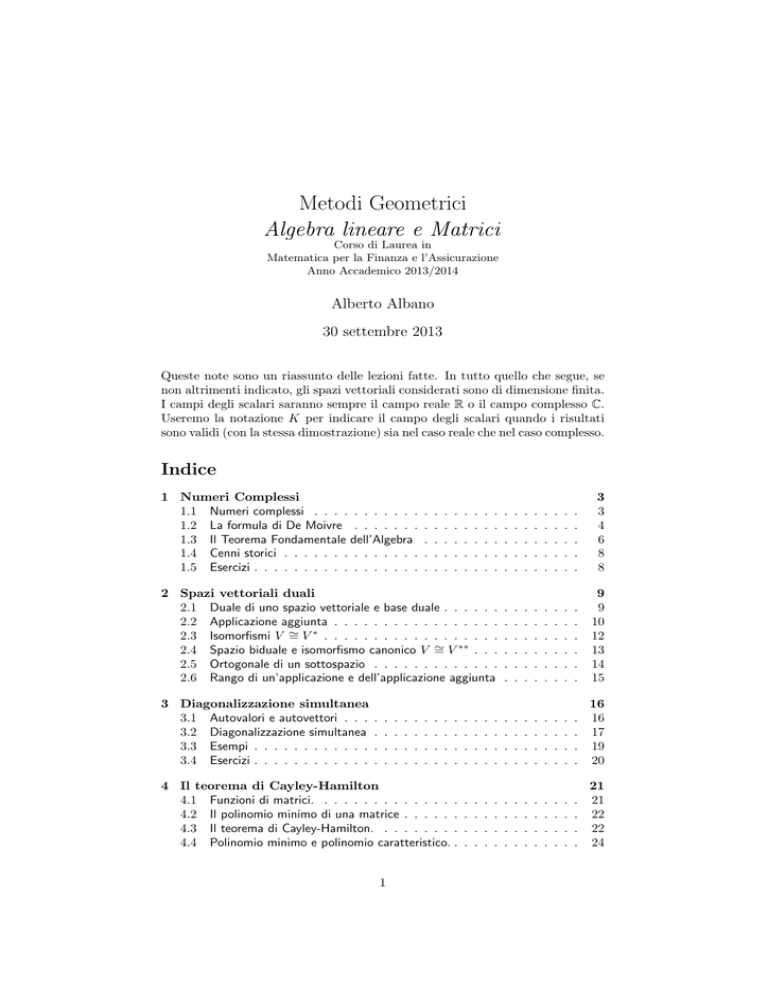

Metodi Geometrici

Algebra lineare e Matrici

Corso di Laurea in

Matematica per la Finanza e l’Assicurazione

Anno Accademico 2013/2014

Alberto Albano

30 settembre 2013

Queste note sono un riassunto delle lezioni fatte. In tutto quello che segue, se

non altrimenti indicato, gli spazi vettoriali considerati sono di dimensione finita.

I campi degli scalari saranno sempre il campo reale R o il campo complesso C.

Useremo la notazione K per indicare il campo degli scalari quando i risultati

sono validi (con la stessa dimostrazione) sia nel caso reale che nel caso complesso.

Indice

1 Numeri Complessi

1.1 Numeri complessi . . . . . . . . . . .

1.2 La formula di De Moivre . . . . . . .

1.3 Il Teorema Fondamentale dell’Algebra

1.4 Cenni storici . . . . . . . . . . . . . .

1.5 Esercizi . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

3

3

4

6

8

8

2 Spazi vettoriali duali

2.1 Duale di uno spazio vettoriale e base duale . . . . . .

2.2 Applicazione aggiunta . . . . . . . . . . . . . . . . .

2.3 Isomorfismi V ª

=V§ . . . . . . . . . . . . . . . . . .

2.4 Spazio biduale e isomorfismo canonico V ª

= V §§ . . .

2.5 Ortogonale di un sottospazio . . . . . . . . . . . . .

2.6 Rango di un’applicazione e dell’applicazione aggiunta

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

9

9

10

12

13

14

15

3 Diagonalizzazione simultanea

3.1 Autovalori e autovettori . . .

3.2 Diagonalizzazione simultanea

3.3 Esempi . . . . . . . . . . . .

3.4 Esercizi . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

16

16

17

19

20

4 Il teorema di Cayley-Hamilton

4.1 Funzioni di matrici. . . . . . . . . . . . . . .

4.2 Il polinomio minimo di una matrice . . . . . .

4.3 Il teorema di Cayley-Hamilton. . . . . . . . .

4.4 Polinomio minimo e polinomio caratteristico. .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

21

21

22

22

24

.

.

.

.

.

.

.

.

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2

INDICE

4.5

Esercizi. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

25

5 La forma canonica di Jordan

5.1 La forma canonica di Jordan. . . . . . . . .

5.2 Funzione esponenziale sui numeri complessi.

5.3 Esponenziale di una matrice. . . . . . . . .

5.4 Calcolo di eA mediante la forma di Jordan.

5.5 Dimostrazione del Teorema 5.3 . . . . . . .

5.6 Esercizi . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

26

26

29

30

31

33

36

6 Polinomio minimo e diagonalizzazione

6.1 Le radici del polinomio minimo . . . . .

6.2 Il grado dei fattori del polinomio minimo

6.3 Polinomio minimo e diagonalizzabilità II

6.4 Esercizi . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

37

37

38

39

41

.

.

.

.

.

.

.

.

7 La forma di Jordan reale

41

7.1 Matrici simili su R e su C. . . . . . . . . . . . . . . . . . . . . . . 41

7.2 Forma di Jordan reale. . . . . . . . . . . . . . . . . . . . . . . . . . 42

8 Decomposizione di matrici

8.1 Prodotti scalari e isomorfismo canonico V ª

=V§

8.2 Prodotti Hermitiani . . . . . . . . . . . . . . .

8.3 Ortogonalizzazione di Gram-Schmidt. . . . . . .

8.4 Matrici Hermitiane, unitarie, normali. . . . . . .

8.5 Decomposizione di Schur . . . . . . . . . . . .

8.6 Esercizi . . . . . . . . . . . . . . . . . . . . . .

8.7 Autovalori di una matrice Hermitiana. . . . . .

8.8 Diagonalizzazione di matrici simmetriche reali. .

8.9 Decomposizione polare di una matrice . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

44

44

45

45

46

49

51

51

51

51

9 Operatori normali

54

9.1 Condizioni equivalenti. . . . . . . . . . . . . . . . . . . . . . . . . . 54

9.2 Proprietà degli operatori normali. . . . . . . . . . . . . . . . . . . . 55

3

1 NUMERI COMPLESSI

1

Numeri Complessi

1.1

Numeri complessi

Ricordiamo la definizione del campo dei numeri complessi C. Come insieme,

C = R2 , l’insieme delle coppie di numeri reali. Fra gli elementi di C sono

definite due operazioni, la somma e il prodotto.

R2 è uno spazio vettoriale reale di dimensione 2, con base {(1, 0), (0, 1)}.

Due numeri complessi vengono sommati come elementi di R2 : se z1 = (x1 , y1 )

e z2 = (x2 , y2 ), si ha

z1 + z2 = (x1 + x2 , y1 + y2 )

Rispetto alla somma C è come R2 e cioè un gruppo commutativo: la somma

è associativa, commutativa, esiste l’elemento neutro z = (0, 0) (che scriviamo

semplicemente z = 0) e ogni elemento z ha un (unico) opposto w, cioè un

elemento tale che z + w = 0. È immediato osservare che se z = (x, y) allora

l’opposto è w = (°x, °y), che scriviamo semplicemente w = °z.

La moltiplicazione è definita come segue: se z1 = (x1 , y1 ) e z2 = (x2 , y2 ),

allora

z1 z2 = (x1 x2 ° y1 y2 , x1 y2 + x2 y1 )

Se consideriamo il sottoinsieme dei numeri complessi della forma z = (x, 0),

vediamo che (x1 , 0) + (x2 , 0) = (x1 + x2 , 0) e (x1 , 0)(x2 , 0) = (x1 x2 , 0) e cioè

questi numeri si comportano rispetto alle operazioni come gli ordinari numeri

reali. Quindi C contiene un sottoinsieme isomorfo ad R. Gli elementi di questo

sottoinsieme vengono chiamati numeri reali.

Osserviamo che i vettori della base hanno proprietà speciali rispetto alla

moltiplicazione:

1. (1, 0)z = z per ogni z 2 C. Quindi (1, 0) è l’elemento neutro della

moltiplicazione, e scriveremo semplicemente 1 = (1, 0)

2. (0, 1)2 = (°1, 0) = °1 e quindi C contiene un elemento il cui quadrato

è un numero reale negativo. Possiamo anche dire che (0, 1) è una radice

quadrata di °1. Poniamo i = (0, 1), e i viene detto unità immaginaria.

Con le convenzioni appena fatte, ogni numero complesso può essere scritto

come z = x + iy, con x, y 2 R. In questa situazione x viene detta parte reale di

z e y viene detta parte immaginaria di z (notare che la parte immaginaria è un

numero reale). Si usa anche scrivere

z = x + iy,

x = Re z,

y = Im z

La regola della moltiplicazione si può ricordare facilmente moltiplicando le

espressioni (x1 + iy1 ) e (x2 + iy2 ) con le usuali regole del calcolo letterale e

sostituendo i2 = °1.

La moltiplicazione ha le seguenti proprietà la cui verifica a partire dalla

definizione è un semplice (ma utile) esercizio:

1. z1 z2 = z2 z1 (la moltiplicazione è commutativa)

2. (z1 z2 )z3 = z1 (z2 z3 ) (la moltiplicazione è associativa)

3. 1z = z, dove 1 = (1, 0) (esiste l’elemento neutro)

4

1 NUMERI COMPLESSI

x

y

°i 2

. Allora zw = 1.

x2 + y 2

x + y2

(ogni elemento non nullo ha inverso)

4. se z = x + iy 6= 0, poniamo w =

5. z(v + w) = zv + zw (vale la proprietà distributiva)

6. se z è reale, cioè se z = x + i0, allora la moltiplicazione per z è come la

moltiplicazione scalare.

Vediamo dunque che le operazioni su C hanno le stesse proprietà algebriche

di quelle su R (numeri reali) o su Q (numeri razionali). Un insieme con due

operazioni con queste proprietà viene detto un campo, e chiameremo C il campo

dei numeri complessi.

Se z = x + iy, il suo coniugato è il numero z̄ = x ° iy. La coniugazione è la

funzione æ : C ! C definita da æ(z) = z̄ e si ha æ(z) = z se e solo se z è reale.

Le seguenti proprietà della coniugazione sono di verifica immediata:

1. z̄¯ = z

2. z1 + z2 = z̄1 + z̄2

3. z1 z2 = z̄1 z̄2

Osserviamo che z z̄ = x2 + y 2 è una quantità reale sempre maggiore o uguale

a 0. Il valore assoluto o norma di un numero complesso è il numero reale positivo

o nullo

p

p

|z| = x2 + y 2 = z z̄

e cioè la lunghezza di z pensato come vettore di R2 . Si hanno quindi le proprietà

1. |z| = 0 se e solo se z = 0

2. |z1 + z2 | ∑ |z1 | + |z2 |

3. |z1 z2 | = |z1 ||z2 |

e |z| è l’usuale valore assoluto per z reale. Notiamo che la proprietà 2. è la

diseguaglianza triangolare.

Osserviamo anche che se z = x + iy 6= 0, il suo inverso si può scrivere

z °1 =

1

z̄

=

z

z z̄

dove l’ultima formula si può interpretare come la divisione del numero complesso z̄ per il numero reale non nullo z z̄ = |z|2 .

1.2

La formula di De Moivre

Sia z = x + iy 6= 0 e sia P = (x, y) 2 R2 . Se poniamo q = |z| e ' = angolo

orientato che ha per lati il semiasse positivo delle ascisse e la semiretta OP , si

ha

x = q cos ', y = q sin '

e quindi si può scrivere

z = q(cos ' + i sin ')

5

1 NUMERI COMPLESSI

che si chiama forma trigonometrica del numero complesso non nullo z. L’angolo ' viene detto argomento di z. Osserviamo che se z = 0 la rappresentazione

trigonometrica esiste ancora ma non è unica, in quanto il suo modulo q = 0 e

quindi si può scegliere ' arbitrariamente.

Consideriamo z1 = q1 (cos '1 + i sin '1 ), z2 = q2 (cos '2 + i sin '2 ). Moltiplicando e usando le formule di addizione del seno e del coseno si ottiene:

z1 z2 = q1 q2 (cos('1 + '2 ) + i sin('1 + '2 ))

e cioè in forma trigonometrica il prodotto di due numeri complessi si calcola

moltiplicando i moduli e sommando gli argomenti.

La formula mostra anche che l’inverso di z = q(cos ' + i sin ') è

z °1 = q °1 (cos(°') + i sin(°'))

Una semplice induzione mostra che il risultato precedente vale per il prodotto

di un qualunque numero di numeri complessi e in particolare per le potenze di

un numero complesso. Si ottiene in questo modo la formula di De Moivre

n

z n = (q(cos ' + i sin ')) = q n (cos(n') + i sin(n'))

Della formula di De Moivre si possono ottenere delle espressioni per cos(n')

e sin(n') in termini di cos ' e sin '. Ponendo infatti q = 1 si ottiene

n µ ∂

X

n

n

cos(n') + i sin(n') = (cos ' + i sin ') =

(cos ')n°k (i sin ')k

k

k=0

Per n = 2 si hanno le note formule di duplicazione. Per n = 3 si ha

cos(3') + i sin(3') = (cos ')3 + 3(cos ')2 (i sin ') + 3(cos ')(i sin ')2 + (i sin ')3

e separando le parti reale e immaginaria si ottiene

cos(3') = cos3 ' ° 3 cos ' sin2 ',

sin(3') = 3 cos2 ' sin ' ° sin3 '

La formula di De Moivre permette di calcolare facilmente le radici di un

numero complesso.

Si dice che z è una radice n-esima di w se z n = w. Se w = q(cos ' + i sin ')

e z = p(cos µ + i sin µ) sono le forma trigonometriche di z e w, dalla formula di

De Moivre si ha

pn = q,

cos(nµ) = cos('), sin(nµ) = sin(')

p

Da ciò si deduce che p = n q (cioè p è l’unico numero reale positivo la cui

potenza n-esima è q) e nµ = ' + 2kº, e dunque il numero complesso w 6= 0 ha

esattamente n radici n-esime distinte, date da

µ

∂

' + 2kº

' + 2kº

zk = p cos

+ i sin

,

k = 0, 1, . . . , n ° 1

n

n

(se w = 0, l’unica sua radice n-esima è 0 oppure possiamo dire che le sue n

radici n-esime sono tutte coincidenti).

I punti {z0 , z1 , . . . , zn°1 } rappresentati nel piano R2 sono i vertici p

di un

poligono regolare di n lati inscritto nel cerchio di centro l’origine e raggio n |w|.

In particolare, si dicono radici n-esime dell’unità i numeri

ek = cos

2kº

2kº

+ i sin

,

n

n

k = 0, 1, . . . , n ° 1

6

1 NUMERI COMPLESSI

1.3

Il Teorema Fondamentale dell’Algebra

L’importanza del campo complesso sta nel seguente

Teorema 1.1 (Teorema Fondamentale dell’Algebra). Sia p(z) un polinomio

a coe±cienti complessi di grado n ∏ 1. Allora p(z) ha (almeno) una radice

complessa, cioè esiste (almeno) un numero complesso z tale che p(z) = 0.

Nonostante il suo nome, il teorema fondamentale dell’algebra è un teorema

di analisi e la sua dimostrazione richiede alcuni preliminari. Scriviamo

p(z) = a0 + a1 z + · · · + an z n ,

an 6= 0

L’idea della dimostrazione è di considerare la funzione (continua) a valori

reali |p(z)| e di studiarne i minimi. In particolare, nel Lemma 1.3 dimostreremo

l’esistenza del minimo assoluto e poi dimostreremo che il minimo assoluto deve

valere 0. In questo modo otteniamo che il punto (o i punti) di minimo assoluto

è una radice del polinomio.

Cominciamo con il dimostrare che al crescere di z in modulo, anche il modulo

di p(z) cresce.

Lemma 1.2.

lim

|z|!+1

|p(z)| = +1

Dimostrazione. Per z 6= 0 possiamo scrivere

n

X an°k

p(z)

= an +

n

z

zk

k=1

Passando ai valori assoluti e usando la diseguaglianza triangolare si ha

n

X |an°k |

|p(z)|

∏ |an | °

n

|z|

|z|k

k=1

(ricordiamo che |a| = |(a + b) + (°b)| ∑ |a + b| + |b| e quindi |a + b| ∏ |a| ° |b|).

Poiché lim|z|!+1 |z|k = +1 per k = 1, . . . , n la sommatoria tende a 0 e

quindi esiste L > 0 tale che per |z| > L si ha

n

X

|an°k |

k=1

e quindi per |z| > L si ha

|z|k

∑

1

|an |

2

|p(z)|

1

∏ |an | > 0

n

|z|

2

e moltiplicando per |z|n si ottiene

|p(z)| ∏

1

|an ||z|n

2

da cui segue la tesi passando al limite per |z| ! +1 e usando il teorema del

confronto.

7

1 NUMERI COMPLESSI

Lemma 1.3. |p(z)| assume un valore minimo (assoluto).

Dimostrazione. Per ogni k > 0 definiamo l’insieme compatto (chiuso e limitato)

Dk = {z 2 C | |z| ∑ k}

Per il teorema di Wierstrass ogni funzione continua ammette minimo (e

massimo) su un insieme chiuso e limitato e sia vk = |p(zk )| il minimo della

funzione continua |p(z)| su Dk . Per il Lemma 1.2 esiste k > 0 tale che

|p(z)| ∏ v1

per |z| ∏ k

Possiamo supporre k ∏ 1 (Se k ∑ 1, abbiamo già trovato il minimo perché

|p(z)| ∏ v1 per k ∑ 1). Poiché D1 µ Dk si ha v1 ∏ vk (su un dominio più

grande, il minimo può solo diminuire).

Allora il minimo è vk . Infatti per |z| ∑ k si ha |p(z)| ∏ vk per definizione, e

per |z| ∏ k si ha |p(z) ∏ v1 ∏ vk .

Dunque la funzione |p(z)| assume il minimo (assoluto) vk in zk .

Dimostrazione del teorema fondamentale dell’algebra. Sia p(z) un polinomio di

grado n (maggiore o uguale a 1). Dal lemma precedente sappiamo che |p(z)|

ammette minimo, e sia z0 il punto di minimo. Consideriamo

q(z) = p(z + z0 )

q(z) è ancora un polinomio (dello stesso grado di p(z)) e assume gli stessi valori

di p(z) e quindi basta dimostrare che q(z) ha una radice. Per costruzione |q(z)|

assume il suo minimo in z = 0. Quindi possiamo supporre, scrivendo p(z) al

posto di q(z):

il valore minimo di |p(z)| è |p(0)| = |a0 |

Scriviamo il polinomio p(z) come

p(z) = a0 + ak z k + z k+1 r(z),

ak 6= 0, k ∏ 1

dove r(z) è un polinomio di grado n ° k ° 1 se k < n e r(z) = 0 se k =

n. Quindi z k è la minima potenza di z (maggiore o uguale a 1) presente nel

polinomio. Vogliamo far vedere che se |a0 | > 0 è possibile trovare un numero

complesso per cui il valore di |p(z)| è minore di |a0 |, contraddicendo cosı̀ l’ipotesi

che |a0 | sia il minimo.

Scegliamo un numero w tale che

a0 + ak wk = 0

cioè w è una radice k-esima del numero complesso °a0 /ak . Per t 2 R, 0 < t < 1

scriviamo

p(tw) = (1 ° tk )a0 + tk (a0 + ak wk ) + (tw)k+1 r(tw)

= (1 ° tk )a0 + (tw)k+1 r(tw)

per la scelta fatta di w. Passando ai valori assoluti, si ha

|p(tw)| ∑ |1 ° tk | · |a0 | + |tw|k+1 · |r(tw)|

= (1 ° tk )|a0 | + tk+1 (|w|k+1 · |r(tw)|)

µ

∂

k

k+1

= |a0 | ° t |a0 | ° t|w|

· |r(tw)|

8

1 NUMERI COMPLESSI

Ma

lim t|w|k+1 · |r(tw)| = 0,

t!0

e quindi, se |a0 | > 0, si avrebbe |a0 |°t|w|k+1 ·|r(tw)| > 0 (per t su±cientemente

piccolo) e quindi |p(tw)| < |a0 |, contro l’ipotesi che il valore minimo fosse |a0 |.

Dunque deve essere a0 = 0 e cioè p(0) = 0 e z = 0 è una radice di p(z).

Il teorema fondamentale dell’algebra ha importanti conseguenze. La prima

è che, insieme al teorema di Ru±ni, permette di dimostrare che

Teorema 1.4. Sia p(z) un polinomio a coe±cienti complessi di grado n. Allora

p(z) si fattorizza nel prodotto di n fattori di primo grado, non necessariamente

distinti

p(z) = an (z ° z1 )(z ° z2 ) · · · (z ° zn )

I numeri z1 , z2 , . . . , zn sono le radici di p(z) che ha quindi n radici (non

necessariamente distinte).

Un immediato corollario è

Teorema 1.5. Sia A una matrice quadrata di ordine n, a elementi complessi.

Allora A ha esattamente n autovalori (contati con la loro molteplicità).

Dimostrazione. Gli autovalori sono le radici del polinomio caratteristico, che ha

grado n.

1.4

Cenni storici

Per una storia dettagliata dei tentativi di dimostrazione del teorema fondamentale dell’algebra e per molte altre notizie storiche riguardanti la matematica,

consultare il sito

http://www-history.mcs.st-and.ac.uk/

La pagina specifica sul teorema fondamentale dell’algebra è all’indirizzo

http://www-history.mcs.st-and.ac.uk/HistTopics/Fund theorem of algebra.html

1.5

Esercizi

1. Determinare gli x 2 R per cui è reale il numero complesso z =

2. Se z ha argomento ', qual è l’argomento di z̄?

3. Se |z| = 1, provare che

4. Calcolare (1 + i)6 ,

x ° 2 + ix

x ° 3 ° 5i

1

= z̄.

z

5

,

°3 + 4i

µ

2+i

3 ° 2i

∂2

,

(1 + i)n + (1 ° i)n

5. Se z = x + iy (con x, y reali), trovare la parte reale e immaginaria dei

numeri

1

z°1

1

z4,

,

,

z

z+1

z2

9

2 SPAZI VETTORIALI DUALI

6. Risolvere l’equazione z 2 = °5 + 12i

7. Risolvere l’equazione z 3 = i

8. Sia w 6= 0 e siano z0 , z1 , . . . , zn°1 le radici n-esime di w. Dimostrare che

z0 + z1 + · · · + zn°1 = 0

(Suggerimento: z0 , z1 , . . . , zn°1 sono le soluzioni di z n ° w = 0)

µ

∂

Æ Ø

9. Sia A l’insieme delle matrici 2 £ 2 della forma

con Æ, Ø 2 R.

°Ø Æ

Dimostrare che la funzione f : C ! A definita da

µ

∂

x y

f (z) =

(dove z = x + iy)

°y x

è un isomorfismo, cioè è biiettiva e conserva le operazioni. Abbiamo quindi

un modello dei numeri complessi realizzato come matrici reali di forma

particolare.

2

2.1

Spazi vettoriali duali

Duale di uno spazio vettoriale e base duale

Sia V uno spazio vettoriale (anche di dimensione infinita) sul campo K. Il duale

di V , indicato con V § è

V § = {f : V ! K | f lineare },

l’insieme di tutte le applicazioni lineari da V in K. Queste applicazioni sono

anche chiamate funzionali lineari. È immediato dimostrare che V § è uno spazio

vettoriale su K con le operazioni di somma e prodotto per scalari definite da:

(f + g)(v) = f (v) + g(v),

(Æ · f )(v) = Æ · f (v),

8f, g 2 V § , 8v 2 V

8f 2 V § , 8Æ 2 K, 8v 2 V

Sia ora V di dimensione finita. Per ogni base di V si può determinare una

base di V § , detta la base duale. Sia dunque dim V = n e B = {v1 , v2 , . . . , vn }

una base di V . Definiamo, per i = 1, . . . , n, il funzionale lineare fi : V ! K

come

fi (vj ) = ±ij

dove ±ij è il delta di Kronecker che vale 1 per i = j e 0 per i 6= j.

Le funzioni fi sono ben definite perché sono assegnate sui vettori di una

base. Si ha

Proposizione 2.1. B§ = {f1 , . . . , fn } è una base di V § .

Dimostrazione. Dobbiamo dimostrare che f1 , . . . , fn sono generatori e che sono

linearmente indipendenti.

Sia f 2 V § . Per i = 1, . . . , n, poniamo ∏i = f (vi ). Verifichiamo che:

f (v) = ∏1 f1 (v) + · · · + ∏n fn (v),

8v 2 V.

10

2 SPAZI VETTORIALI DUALI

Per i vettori v1 , . . . , vn della base si ha:

∏1 f1 (vi ) + · · · + ∏n fn (vi ) = ∏i = f (vi ),

i = 1, 2, . . . , n

e quindi le applicazioni lineari f e ∏1 f1 + . . . ∏n fn coincidono sui vettori di una

base e quindi sono la stessa applicazione lineare in V § . Dunque ogni f 2 V § è

combinazione lineare degli fi che quindi sono generatori.

Sia ora Æ1 f1 + · · · + Æn fn = 0 2 V § . Allora per ogni v 2 V si ha

Æ1 f1 (v) + · · · + Æn fn (v) = 0.

Poiché in particolare

Æ1 f1 (vi ) + · · · + Æn fn (vi ) = Æi ,

i = 1, 2, . . . , n

otteniamo Æ1 = · · · = Æn = 0 e quindi f1 , . . . , fn sono linearmente indipendenti.

Poiché abbiamo trovato una base di V § con n elementi (n = dim V ) abbiamo

che dim V § = n. Dunque V e V § hanno la stessa dimensione e sono quindi

isomorfi. Un isomorfismo è dato, per esempio, facendo corrispondere gli elementi

di una base di V con gli elementi della base duale di V § .

Osserviamo che se V ha dimensione infinita, la proposizione precedente non

vale. Una base di V è costituita da infiniti elementi, e si possono definire i

funzionali fi come prima. Essi risultano ancora linearmente indipendenti (stessa

dimostrazione) ma la dimostrazione che sono generatori non vale più perché

dovremmo fare una somma infinita. Dunque otteniamo solo che dim V ∑ dim V §

e si può dimostrare che la diseguaglianza è sempre stretta. Si ottiene perciò che

se V ha dimensione infinita, V e V § non sono mai isomorfi.

2.2

Applicazione aggiunta

Siano V e W due spazi vettoriali, e sia g : V ! W un’applicazione lineare.

g induce un’applicazione lineare da W § a V § , detta applicazione aggiunta (o

trasposta) e indicata con g t oppure g § , nel modo seguente: per f 2 W § , poniamo

g t (f ) = f ± g : V ! K.

Dobbiamo verificare alcune cose: prima di tutto, g t (f ) appartiene veramente

a V § in quanto è composizione di applicazioni lineari e quindi è lineare. Per

dimostrare che g t è lineare, dobbiamo verificare che:

g t (f1 + f2 ) = g t (f1 ) + g t (f2 ),

g t (Æ · f ) = Æ · g t (f ),

8f1 , f2 2 W §

8f 2 W § , 8Æ 2 K

Poiché per ogni v 2 V , si ha:

[g t (f1 + f2 )](v) = [(f1 + f2 ) ± g](v)

= (f1 + f2 )(g(v))

= f1 (g(v)) + f2 (g(v))

= g t (f1 )(v) + g t (f2 )(v)

= [g t (f1 ) + g t (f2 )](v)

11

2 SPAZI VETTORIALI DUALI

la prima proprietà è dimostrata. La seconda si prova analogamente.

Poiché g t è lineare, se fissiamo delle basi in W § e V § sarà rappresentata da

una matrice. Vale il seguente

Teorema 2.2. Sia g : V ! W un’applicazione lineare, B = {v1 , v2 , . . . , vn }

una base di V , C = {w1 , w2 , . . . , wm } una base di W e sia A la matrice che

rappresenta g rispetto a queste basi. Allora la matrice che rappresenta g t rispetto

alle basi duali C § e B§ è At , la matrice trasposta di A.

Dimostrazione. Denotiamo con B § = {f1 , . . . , fn } e C § = {h1 , . . . , hm } le basi

duali di V § e W § rispettivamente. Indichiamo anche con aij gli elementi della

matrice A.

La matrice di g t si ottiene calcolando le coordinate nella base B § delle

immagini dei vettori della base C § . Si ha:

g t (hj ) = hj ± g = ∏1j f1 + . . . ∏nj fn 2 V §

dove, come prima, si ha

∏ij = hj (g(vi )).

Gli elementi ∏ij sono gli elementi sulla j-esima colonna della matrice di g t . Per

definizione della matrice A si ha:

g(vi ) = a1i w1 + · · · + ami wm =

e dunque

hj (g(vi )) = hj

√

m

X

k=1

Abbiamo quindi

aki wk

!

=

m

X

m

X

aki wk

k=1

aki hj (wk ) = aji

k=1

∏ij = aji

e cioè la matrice di g è la trasposta della matrice A che rappresenta g.

t

Notiamo ancora una proprietà della trasposta. Se f : V ! W e g : W ! U

sono due applicazioni lineari possiamo considerare le due funzioni lineari f t ± g t

e (g ± f )t , entrambe da U § a V § . Si ha:

Proposizione 2.3.

(g ± f )t = f t ± g t

Dimostrazione. Sia h 2 U § , cioè h è una funzione lineare h : U ! K. Allora

(g ± f )t (h) = h ± (g ± f ) = (h ± g) ± f = f t (h ± g) = f t (g t (h)) = (f t ± g t )(h)

Da questa uguaglianza si ottiene la ben nota proprietà delle matrici riguardo

alla trasposta di un prodotto. Se A è la matrice di g e B la matrice di f (rispetto

a basi opportune. Quali?) si ha

(AB)t = B t At

12

2 SPAZI VETTORIALI DUALI

2.3

Isomorfismi V ª

= V§

Sia V uno spazio vettoriale e siano B = {e1 , . . . , en } e C = {≤1 , . . . , ≤n } due basi.

Nello spazio V § sono determinate le due basi duali che indichiamo con B§ =

{e§1 , . . . , e§n } e C § = {≤§1 , . . . , ≤§n }, e sono definiti due isomorfismi, ' : V ! V § e

√ : V ! V § dati dall’identificare una base con la sua base duale, e cioè definiti

dalle formule '(ei ) = e§i e √(≤i ) = ≤§i .

Ci chiediamo sotto quali condizioni si abbia ' = √, cioè che relazione deve

intercorrere fra le due basi a±nché gli isomorfismi indotti siano lo stesso.

Sia A la matrice di passaggio fra le basi B e C, e cioè la matrice i cui elementi

sono determinati dalle equazioni:

≤j =

n

X

aij ei

i=1

e analogamente per la matrice B di passaggio fra le basi duali

≤§j =

n

X

bij e§i

i=1

Lemma 2.4. Con le notazioni precedenti si ha

B · At = I

Dimostrazione. A è la matrice dell’identità idV : V ! V , espressa usando la

base C in partenza e B in arrivo. Indichiamo questo fatto con la notazione

A

idV : VC °

! VB

Analogamente,

B

idV § : VC§§ °

! VB§§

L’aggiunta dell’identità idV : V ! V è l’identità idV § : V § ! V § , e la sua

matrice è la matrice trasposta, e si ha:

At

id§V = idV § : VB§§ °°! VC§§

Componendo queste due ultime applicazioni, e cioè due volte l’identità di V § ,

At

B

VB§§ °°! VC§§ °

! VB§§

si ha ancora l’identità di V § , però questa volta espressa usando la stessa base

in partenza e in arrivo e quindi la matrice sarà la matrice identica. Poiché la

matrice di una composizione è il prodotto delle matrici si ha:

B · At = I

come richiesto.

Dimostriamo ora la

Proposizione 2.5. Con le notazioni precedenti, ' = √ se e solo se A è una

matrice ortogonale, e cioè A · At = I.

13

2 SPAZI VETTORIALI DUALI

Dimostrazione. Per il Lemma appena dimostrato basta dimostrare che

' = √ () A = B

Le due funzioni sono lineari e perciò sono uguali se e solo se coincidono sugli

elementi di una base e cioè se e solo se '(≤j ) = √(≤j ) per j = 1, . . . , n.

Calcolando si ha:

√ n

!

n

n

X

X

X

'(≤j ) = '

aij ei =

aij '(ei ) =

aij e§i

i=1

i=1

e

√(≤j ) = ≤§j =

i=1

n

X

bij e§i

i=1

e quindi ' = √ se e solo se le matrici A e B sono uguali.

La dimostrazione può essere ricordata meglio ricorrendo al diagramma seguente:

VC

idV

A

/ VB

idV §

≤

'

√

≤

VC§§

B

/ VB§§

Le matrici di ' e √ nelle basi indicate sono entrambe la matrice unità. Inoltre il

percorso “lato superiore – lato destro” dà la funzione ' con matrice A, mentre il

percorso “lato sinistro - lato inferiore” dà la funzione √ con matrice B. Dunque

' = √ se e solo se A = B (d’altra parte, il calcolo esplicito nella dimostrazione

precedente è esattamente il calcolo di queste funzioni composte).

2.4

Spazio biduale e isomorfismo canonico V ª

= V §§

Come abbiamo visto, non c’è un isomorfismo canonico fra V e V § . Invece esiste

un isomorfismo canonico fra uno spazio vettoriale V e il suo doppio duale V §§ =

(V § )§ . L’isomorfismo si ottiene considerando la funzione

h , i: V§£V !K

(f, v) ! hf, vi = f (v)

(la notazione è scelta per ricordare il prodotto scalare. Vedremo in seguito il

perché). Questa funzione è bilineare (verifica per esercizio) e allora si ha una

funzione

' : V ! V §§

v ! 'v

dove la funzione 'v : V § ! K è definita dalla formula 'v (f ) = f (v). La linearità

nella prima variabile della funzione bilineare h , i implica che per ogni v 2 V

la funzione 'v è lineare e quindi 'v 2 V §§ , mentre la linearità nella seconda

variabile implica che la funzione ' è lineare. La funzione ' è iniettiva: sia infatti

14

2 SPAZI VETTORIALI DUALI

v 2 V tale che '(v) = 0, cioè 'v è la funzione nulla. Allora per ogni f 2 V § si

ha f (v) = 'v (f ) = 0 e l’unico vettore per cui sono nulle tutte le funzioni lineari

è il vettore nullo. Dunque ker ' = {0} e cioè ' è iniettiva.

Poiché uno spazio vettoriale e il suo duale hanno la stessa dimensione,

dim V = dim V § = dim V §§ e quindi ', essendo iniettiva fra spazi vettoriali

della stessa dimensione, è anche suriettiva e dunque un isomorfismo.

Tramite questo isomorfismo possiamo identificare uno spazio vettoriale con il

suo doppio duale. Se consideriamo un’applicazione lineare f : V ! W , abbiamo

l’aggiunta f t : W § ! V § e l’aggiunta dell’aggiunta (f t )t : V §§ ! W §§ .

Proposizione 2.6. Mediante le identificazioni precedenti, si ha f = (f t )t .

Dimostrazione. Dobbiamo dimostrare che il diagramma

V

f

/W

'

'

≤

V §§

≤

(f t )t

/ W §§

è commutativo, cioè che per ogni v 2 V si ha 'f (v) = (f t )t ('v ). L’uguaglianza

scritta è fra elementi di W §§ , e cioè fra funzioni definite su W § e a valori in K.

Dunque dobbiamo verificare che, per ogni g 2 W § si ha

°

¢

'f (v) (g) = (f t )t ('v ) (g)

Per definizione, 'f (v) (g) = g(f (v)).

Per il secondo membro ricordiamo che l’applicazione aggiunta si calcola

componendo a destra e quindi

° t t

¢

°

¢

(f ) ('v ) (g) = 'v ± f t (g) = 'v (f t (g)) = 'v (g ± f ) = g(f (v))

2.5

Ortogonale di un sottospazio

Anche se non c’è un isomorfismo canonico fra uno spazio vettoriale V e il suo

duale V § c’è un modo canonico di associare ad un sottospazio W µ V un

sottospazio di V § , chiamato l’ortogonale di W , e denotato con W ? .

Definizione 2.7. Sia W µ V un sottospazio. Definiamo

W ? = {f 2 V § | f (w) = 0, 8w 2 W }

È facile determinare la dimensione di W ? , in eÆetti è facile trovarne una

base a partire da una base di W e di V .

Proposizione 2.8. Sia {e1 , . . . , ek , ek+1 , . . . , en } una base di V tale che i primi

k vettori siano una base del sottospazio W . Allora {e§k+1 , . . . , e§n } è una base

di W ? . In particolare, dim W ? = dim V ° dim W .

15

2 SPAZI VETTORIALI DUALI

Dimostrazione. Poiché per definizione di base duale e§j (ei ) = ±ij , è immediato

che e§j 2 W ? per j ∏ k + 1. Inoltre questi vettori sono linearmente indipendenti

in quanto parte di una base (la base duale).

Dobbiamo solo più dimostrare che sono generatori di W ? . Sia f 2 W ? .

Possiamo scrivere

f = ∏1 e§1 + · · · + ∏n e§n

dove ∏i = f (ei ). Dunque ∏1 = · · · = ∏k = 0 e quindi f è combinazione lineare

di e§k+1 , . . . , e§n come aÆermato.

2.6

Rango di un’applicazione e dell’applicazione aggiunta

Per un’applicazione lineare f : V ! W , poniamo rank f = dim Im f , il rango

di f . C’è una semplice relazione fra il rango di f e il rango della sua aggiunta f t .

Per determinarla cominciamo a provare il

Teorema 2.9. Sia f : V ! W un’applicazione lineare. Si ha:

?

ker f t = (Im f ) ,

?

Im f t = (ker f )

Dimostrazione. Dimostriamo solo la prima uguaglianza, la seconda si può provare usando il doppio duale oppure con una dimostrazione diretta, ed è lasciata

per esercizio. Sia h 2 ker f t , cioè f t (h) = 0 2 V § . Poiché l’elemento nullo di V §

è la funzione nulla si ha:

h 2 ker f t () 8v 2 V f t (h)(v) = 0

() 8v 2 V h(f (v)) = 0

() 8w 2 Im f h(w) = 0

() h 2 (Im f )

?

Corollario 2.10. rank f = rank f t

Dimostrazione. Ricordiamo che f : V ! W e f t : W § ! V § . Si ha:

rank f = dim Im f = dim W ° dim(Im f )? = dim W § ° dim ker f t

= dim Im f t = rank f t

Se A è una matrice, possiamo pensare A come la matrice di un’applicazione

lineare, e l’immagine di questa applicazione è generata dalle colonne di A. Poniamo quindi rank A = massimo numero di colonne linearmente indipendenti.

Poiché la matrice trasposta di A è la matrice dell’applicazione aggiunta, si ha

rank A = rank At e cioè il numero massimo di colonne linearmente indipendenti

di una matrice è uguale al numero massimo di righe linearmente indipendenti.

Osserviamo che questo risultato si può ottenere anche usando la caratterezzazione del rango di una matrice mediante i determinanti dei minori e il fatto

che il determinante di una matrice è uguale al determinante della sua trasposta.

La dimostrazione data qui evita ogni riferimento ai determinanti.