UNIVERSITÀ DEGLI STUDI DI MILANO - BICOCCA

Dipartimento di Informatica Sistemistica e Comunicazione

Facoltà di Scienze Matematiche, Fisiche e Naturali

Corso di Laurea in Informatica

Analisi di Metriche e Algoritmi

per la Qualità dei Dati.

Progettazione e Realizzazione di un Framework

per l’Assessment della Qualità.

Supervisori:

Chiar.mo Prof. Carlo BATINI

Dott. Daniele BARONE

Relazione della prova finale di:

Carmine Carella

Matricola: 055465

Anno Accademico 2005-2006

Ai miei genitori

e alle mie sorelle Brunilde e Milena.

A Danilo, Maurizio e Marzio,

compagni di avventura di questi ultimi tre anni.

Ai miei cari ed eterni amici materani

Vittorio, Giuseppe, Angelo e Giuseppe.

A Valeria, per il suo aiuto e

per ogni momento condiviso con me.

Un ringraziamento particolare al Prof. Batini per avermi dato questa

opportunitá, al Dott. Barone per avermi pazientemente seguito ed aiutato

in questi mesi di stage.

Indice

1 Introduzione

1.1 L’importanza della Qualità dei Dati . . . . . . . . . . . . . .

1.2 Definizione di dato e sue proprietà . . . . . . . . . . . . . . .

1.3 Valutazione Quantitativa di Dato . . . . . . . . . . . . . . . .

5

5

8

9

2 Qualità dei Dati e Dimensione

2.1 Il Concetto di Qualità dei Dati . . . . . . . . .

2.2 Tipi di Dati . . . . . . . . . . . . . . . . . . . .

2.3 Il Concetto di Dimensione . . . . . . . . . . . .

2.3.1 Qualità nel Modello Concettuale . . . .

2.3.2 Qualità nella Rappresentazione dei Dati

2.3.3 Qualità dei Valori dei Dati . . . . . . .

2.4 TradeOffs tra Dimensioni . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

13

13

15

16

16

20

21

26

3 Analisi delle Metriche

3.1 Tabella Dimensioni - Metriche - Algoritmi .

3.2 Dimensioni della Qualità dei Dati: Metriche

3.2.1 Syntactic Accuracy . . . . . . . . . .

3.2.2 Semantic Accuracy . . . . . . . . . .

3.2.3 Duplication . . . . . . . . . . . . . .

3.2.4 Completeness . . . . . . . . . . . . .

3.2.5 Currency . . . . . . . . . . . . . . .

3.2.6 Volatility . . . . . . . . . . . . . . .

3.2.7 Timeliness . . . . . . . . . . . . . . .

3.2.8 Consistency . . . . . . . . . . . . . .

3.2.9 Concise Representation . . . . . . .

3.2.10 Relevancy . . . . . . . . . . . . . . .

3.2.11 Ease of manipulation . . . . . . . . .

3.2.12 Believability . . . . . . . . . . . . . .

3.2.13 Appropriate amount of data . . . . .

3.2.14 Accessibility . . . . . . . . . . . . . .

3.2.15 Objectivity . . . . . . . . . . . . . .

3.2.16 Reputation . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

27

29

30

32

34

35

36

37

39

39

40

41

41

41

42

42

43

43

44

3

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

4

INDICE

3.2.17

3.2.18

3.2.19

3.2.20

Security . . . . . . . . .

Ease of Understanding .

Variety of Data Sources

Usefulness . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

44

44

45

45

4 Realizzazione del Framework

4.1 Obiettivi . . . . . . . . . . . . . . . . . . . . . .

4.2 Strumenti Utilizzati . . . . . . . . . . . . . . .

4.3 Funzioni e Struttura . . . . . . . . . . . . . . .

4.3.1 Funzioni . . . . . . . . . . . . . . . . . .

4.3.2 Struttura . . . . . . . . . . . . . . . . .

4.4 Analisi Metriche Implementate nel Framework

4.4.1 Completezza . . . . . . . . . . . . . . .

4.4.2 Accuratezza Sintattica . . . . . . . . . .

4.4.3 Currency . . . . . . . . . . . . . . . . .

4.4.4 Consistenza . . . . . . . . . . . . . . . .

4.5 Localizzazione e Correzione di Errori . . . . . .

4.5.1 Il Framework: Attività di Localizzazione

.

.

.

.

.

.

.

.

.

.

.

e

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

. . . . . . .

Correzione

46

46

46

47

47

48

49

50

53

60

63

64

64

5 Caso di Studio

69

5.1 Descrizione del Caso di Studio . . . . . . . . . . . . . . . . . 70

5.2 Analisi dei Risultati . . . . . . . . . . . . . . . . . . . . . . . 71

A Descrizione del Metamodello

A.1 Descrizione dei Dati e Metadati . . . .

A.1.1 Dati-Metadati in Input . . . .

A.1.2 Dati-Metadati in Output . . .

A.2 XML . . . . . . . . . . . . . . . . . . .

A.2.1 Vantaggi Derivanti dall’Utilizzo

A.2.2 Cenni ad XML . . . . . . . . .

A.3 Metamodello del Framework . . . . . .

A.3.1 Metadati Misurazione . . . . .

A.3.2 Metadati Dimensione . . . . .

B Funzioni di Similarità

B.1 Principali Funzioni di Similarità

Bibliografia

. . . . .

. . . . .

. . . . .

. . . . .

di XML

. . . . .

. . . . .

. . . . .

. . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

79

81

81

82

82

82

83

84

84

86

91

. . . . . . . . . . . . . . . . 91

94

Capitolo 1

Introduzione

1.1

L’importanza della Qualità dei Dati

In molte organizzazioni la situazione del data asset, ovvero del patrimonio

informativo è critica per cause differenti. E’ fuori dubbio che il successo delle

aziende sia sempre più legato alla raccolta e all’ utilizzo di grandi quantità

di informazioni. Le decisioni a tutti i livelli sono guidate inevitabilmente

dai dati acquisiti da un numero sempre maggiore di fonti e fruiti attraverso

svariate tipologie di sistemi (datawarehouse, CRM, ERP) per i quali gli

investimenti rappresentano una quota significativa del budget aziendale.

Questa situazione critica porta a considerare la problematica della qualità dei dati (d’ora in avanti si utilizzerà l’acronimo DQ che indica

Data Quality) nei sistemi informativi.

La scarsa DQ, problema solo in parte percepito come affrontabile e gestibile, determina danni in termini di extra costi, mancati ricavi e demotivazione all’interno dell’azienda. La DQ è un aspetto che pochissime aziende

percepiscono determinante per i loro livelli di servizio, i loro ricavi e i loro

costi. Ai dati normalmente non viene assegnato alcun valore economico;

molte esperienze dimostrano però che una scarsa qualità dei dati ha degli

impatti economici sull’organizzazione.

Molto spesso l’insufficiente DQ viene confusa con un problema di scorretto funzionamento del software che gestisce i dati e molte aziende intervengono acquistando nuovi sistemi software. Il problema però è nei dati

veri e propri, quindi la soluzione potrebbe essere invece quella di definire ed

attuare una strategia di controllo della DQ. Ci si rende conto quando i dati

continuano ad essere inesatti anche con il nuovo sistema sofware.

Ma perchè la DQ è cosi importante? La risposta si può sintetizzare in

due punti essenziali, come detto in [2]:

• La scarsa DQ è pervasiva: Spieghiamo il concetto con un esempio.

Questo esempio tratto da [2] è, pur nella sua banalità, estremamente

significativo sul ruolo che una strategia per il controllo della DQ può

5

CAPITOLO 1. INTRODUZIONE

6

avere in una azienda. Le ripercussioni in termini di costi e di mancati

ricavi generate dalla scarsa attenzione ai dati possono essere veramente

gravi.

Ci rivolgiamo ad un’ agenzia turistica per organizzare un viaggio che

prevede l’utilizzo, una volta arrivati sul luogo di destinazione, di un’auto a noleggio per recarsi dall’aeroporto fino al luogo in cui abbiamo

deciso di trascorrere le nostre vacanze. Arrivati all’aeroporto, ci rechiamo presso lo sportello dell’azienda che deve fornirci l’auto e scopriamo

che la nostra auto non è disponibile e che, come sempre avviene nei

periodi di alta stagione, non ve ne sono altre disponibili prima delle

prossime 48 ore. Il motivo è che la prenotazione dell’auto non risulta

nel database. La persona preposta alla consegna delle auto non sa spiegarsi l’accaduto e telefona all’agenzia che aveva organizzato il viaggio

cercando informazioni sulla nostra prenotazione. Dopo vari minuti di

telefonata, l’agenzia si rende conto che per un errore, la prenotazione

dell’auto non era stata inserita nei dati del viaggio e che, quindi, l’azienda di noleggio auto, non poteva averla ricevuta. A questo punto

si scatena una serie di eventi:

1. Noi telefoniamo irritati all’agenzia.

2. La persona dell’agenzia che risponde è mortificata per l’accaduto

e promette che ci troverà un’altra auto nel giro di un’ora.

3. Inoltre, l’agenzia ci offre di pagare l’auto per scusarsi dello spiacevole accaduto.

4. Nonostante l’auto messa a disposizione gratuitamente, continuiamo ad essere seccati per quanto è successo e non esitiamo a

raccontare il tutto ad amici e conoscenti.

5. Decidiamo di non rivolgerci mai più a quella agenzia di viaggi.

Un banale errore di immissione dati in un database ha quindi determinato per l’agenzia:

1. Lo sconforto dell’impiegato.

2. Il costo da sostenere per pagare l’auto a noleggio che ci è stata

data gratuitamente.

3. La perdita sicura di un cliente.

4. Un numero imprecisato di mancati clienti (i nostri conoscenti

e amici ai quali abbiamo raccontato l’accaduto). Quindi, una

quantità imprecisata di mancati ricavi.

• La scarsa DQ è costosa: Il dato fornito dal Datawarehousing Institute [28] parla di una spesa, negli Stati Uniti, di 600 miliardi di dollari

CAPITOLO 1. INTRODUZIONE

7

all’anno determinata dalla non gestione dei dati. Introdurre in azienda processi di gestione della qualità dei dati viene percepito come un

costo che spesso scoraggia i decisori. Il motivo è che manca la percezione dei costi indotti dalla scarsa qualità dei dati. Molti di tali costi,

infatti, sono in qualche modo nascosti, nel senso che non sempre vengono associati alla insufficiente qualità dei dati: basti pensare al costo

di un depliant pubblicitario che verrà inviato ad un indirizzo inesatto

e che andrà, quindi, inevitabilmente perso. Oppure si pensi al tempo

che il personale addetto ad un Call Center impiega per discutere con

un cliente insoddisfatto. Gli esempi sono molteplici. E poi cosa più

importante, il costo di una decisione per l’azienda presa sulla base di

informazioni errate.

Altri motivi per cui la DQ è importante sono:

• La qualità dei dati degrada con il tempo: Oggi quasi tutti i dati

sono dinamici: indirizzi, numeri di telefono, professioni, indirizzi email, dati di mercato, giacenze di magazzino e cosı̀ via. Questo implica

che bisogna seguire l’alta frequenza di cambiamento per evitare che i

dati diventino obsoleti.

• La qualità dei dati può costituire un forte vantaggio competitivo: La scarsa qualità dei dati, come detto in precedenza, ha degli

impatti sull’economia dell’azienda, in particolare costi aggiuntivi che

hanno delle conseguenze nell’ambito delle decisioni di marketing.

Effetti della scarsa qualità dei dati

Noto che il problema del DQ esiste, abbiamo già detto che i suoi effetti non

sono da sottovalutare. Anche se abbiamo già citato alcune conseguenze che

l’insufficiente DQ può arrecare, riassumiamone le principali:

• Diminuizione della soddisfazione del cliente.

• Sostenimento di costi alti e superflui.

• Influenza sui processi decisionali: Implementare sistemi di data warehouse o data mining su dati di scarsa qualità è molto rischioso.

• Impossibilità di pianificare una strategia a lungo termine.

CAPITOLO 1. INTRODUZIONE

1.2

8

Definizione di dato e sue proprietà

I dati sono un insieme di fatti ovvero rappresentazioni di eventi appartenenti

al mondo reale; sono frutto di misurazioni e sono la materia prima per la

costruzione dell’informazione, infatti costituiscono l’input di un processo che

genera informazioni.

Il mondo reale viene rappresentato con un modello. Il modello è composto da

entità, che rappresentano i concetti equivalenti del mondo reale. Ogni entità

è caratterizzata da attributi. Ogni attributo ha un dominio dei possibili

valori. Si definisce un datum (data item) una tripla < e, a, v > dove v è il

valore selezionato dal dominio dell’attributo a per l’entità e. Data (in lingua

inglese) indica una qualsiasi collezione di data item. Una data rapresentation

è un insieme di regole per registrare le triple su un mezzo fisico. Il data

recording (record) è l’istanza fisica che rappresenta l’insieme di data item

secondo le regole della rappresentazione. I vantaggi di questa definizione

sono nella separazione tra l’attività di modellazione e di rappresentazione.

I dati hanno proprietà particolari che li distinguono dalle altre risorse e che

hanno un impatto sulla definizione di DQ.

Le proprietà sono:

1. Consumability e Depreciability: i dati non si consumano né si usurano.

2. Dipendenza dal Contesto: i dati hanno significato solo in un determinato contesto che è fondamentale per interpretarli e ricavare informazione.

3. Copyability: i dati possono essere copiati in modo economico, a differenza di altre risorse/prodotti per le quali il costo per fare una copia

è paragonabile al costo di produzione di un nuovo prodotto.

4. Costo di Ottenimento e Conservazione: è molto basso.

5. Fungibility: significa che un’unità di risorsa può essere scambiata con

un’altra, esempio i soldi godono di tale proprietà; i dati no.

6. Lag Time: quanto impiegano i dati ad essere trasmessi e rispecchiare

la realtà.

7. Shareability: i dati sono condivisibili.

8. Supply: Un organizzazione può facilmente rifornirsi di dati (a volte ne

hanno anche troppi).

CAPITOLO 1. INTRODUZIONE

1.3

9

Valutazione Quantitativa di Dato

L’analisi della DQ è vincolata all’analisi dei processi in cui i dati vengono

utilizzati; per migliorare la DQ, è necessario analizzare il processo di origine

e individuare le attività che introducono errori o influenzano la DQ. Inoltre

è necessario capire bene cosa significhi DQ e come essa viene valutata. Il

concetto di dato e di informazione sono correlati. Una valutazione quantitativa della qualità per entrambi, dipende dal contesto di utilizzo. Quindi la

DQ dipende dal progetto del sistema informativo e dal contesto di utilizzo.

In letteratura esistono diversi approcci per valutare i concetti di dato e

di informazione in modo quantitativo.

Due approcci per la valutazione quantitativa del concetto di informazione:

1. Il primo basato sulla communication theory di Shannon.

2. Il secondo basato sull’information economics.

Due approcci per la valutazione quantitativa del concetto di dato:

• Data Centric, legato alla struttura progettuale ed implementativa del

sistema informativo e dei database, considera concetti quali entità,

attributo e valore.

• Il secondo considera come il ruolo di un sistema informativo sia quello

di fornire una rappresentazione di un dominio applicativo (il sistema

mondo reale, Real World System) cosi come percepita dall’utente. Le

deficienze nella qualità sono dovute allora alla difformità tra la vista

del real world system che può essere inferita dal sistema informativo

che lo rappresenta e la vista che può essere ottenuta dall’osservazione

diretta.

Di seguito, viene proposto un modello astratto del ciclo di vita dei dati

per mettere in evidenza le attività che hanno maggiore impatto sui dati,

perchè come si è detto precedentemente per misurare e migliorare la DQ è

necessario agire sui processi o per dir meglio sulle attività di tali processi. Il

modello considera come attività centrale la memorizzazione dei dati ( Data

Storage ) e i sistemi vengono classificati in base al ruolo ricoperto da questa

attività.

Tre tipologie di sistemi:

1. Sistema d’Acquisizione. La Data Storage è l’obiettivo finale del sistema.

2. Sistema d’Utilizzazione. Il sistema accede a dati memorizzati precedentemente da qualche altro sistema.

3. Sistema Combinato. Il sistema memorizza ed utilizza i dati. Esistono

due sottocategorie:

CAPITOLO 1. INTRODUZIONE

10

Figura 1.1: Cause della scarsa DQ: mondo reale vs. sistema informativo

(a) Il sistema rigido (Store And Forward): in cui la fase di acquisizione e quella di utilizzo si devono obbligatoriamente alternare.

(b) Il sistema flessibile: in cui le due fasi possono susseguirsi senza rispettare pattern prestabiliti; i moderni sistemi informativi basati

su DBMS sono flessibili.

Le attività che manipolano i dati sono ripetitive quindi è preferibile parlare di cicli di acquisizione ed utilizzazione; i sistemi reali sono una combinazione di questi cicli. Le principali attività incluse nel ciclo di acquisizione

sono le seguenti:

• Definire la view dei dati: una view è composta dalle parti del mondo

reale che devono essere memorizzate. Devono essere specificate una o

più entità con gli attributi relativi.

• Implementazione: dopo aver definito gli elementi che devono essere

memorizzati, si devono tenere conto restrizioni e/o limitazioni imposte

dal mezzo di memorizzazione e dal DBMS. Viene definito lo schema

dei dati.

• Ottenere i valori: si acquisiscono i valori degli attributi delle singole

istanze delle entità definite.

CAPITOLO 1. INTRODUZIONE

11

Figura 1.2: Tipologie di sistemi

• Aggiornare record: i dati sono memorizzati in uno o più database. Il termine aggiornare include l’inserimento di un nuovo record,

cancellazione e modifica dei record esistenti.

Le principali attività incluse nel ciclo di utilizzo sono le seguenti:

• Definire una subview: tipicamente un processo di utilizzo userà solo

una piccola parte dei dati disponibili. Si definisce il sottoinsieme di

dati da utilizzare.

• Recupero: i dati precedente memorizzati vengono recuperati.

• Manipolazione: i dati recuperati vengono utilizzati come input in

un processo di trasformazione che deve generare come output i dati

soddisfacenti la richiesta di un utente.

• Presentazione risultati: i risultati devono essere presentati all’utente

finale con una rappresentazione appropriata che dipende da molti fattori: la natura del risultato, il mezzo di visualizzazione, e le preferenze

dell’utente.

• Utilizzo dei dati: l’utilizzatore del dato potrà giudicare la qualità dello

stesso.

Per migliorare la DQ bisogna però inserire le seguenti attività:

CAPITOLO 1. INTRODUZIONE

12

• Valutazione (Assessment): in questa fase si valuta la qualità dei dati

ottenuti. E’ necessario valutare le dimensioni legate ai valori dei dati:

consistenza, accuratezza, currency, e completezza che verranno approfondite nel capitolo successivo. Se i dati sono di qualità accettabile

sono memorizzati, altrimenti sono intraprese attività di miglioramento

della DQ.

• Analisi: in questa fase vengono individuate le ragioni della bassa

qualità dei dati riscontrata nella fase di valutazione.

• Correzione: in molti casi, i dati insoddisfacenti possono essere corretti

o migliorati.

• Scarto: se un dato giudicato di bassa qualità non può essere corretto,

dovrebbe essere scartato.

Da quanto esposto precedentemente si nota che la gestione della DQ è una

parte molto importante del processo di creazione e utilizzo dei dati; la qualità dei dati viene analizzata e l’analisi va condotta tramite quattro fasi:

definizione delle dimensioni di qualità, analisi dei dati, misurazione delle

dimensioni di qualità, miglioramento della qualità dei dati. Un concetto

fondamentale della DQ è quello di dimensione, che vedremo meglio nel capitolo 2. Un metodo standard, per esempio, per l’analisi delle dimensioni di

qualità è l’IP-MAP (Information Product Map) [11] e [12], un meccanismo

di data tracking, un modello grafico progettato per aiutare a comprendere, valutare e descrivere il modo in cui un’informazione viene assemblata.

IPMAP consente di visualizzare le fasi più importanti della lavorazione di

un prodotto informativo e di identificarne i percorsi critici in relazione alla

qualità. Sulla base di tale identificazione, azioni di miglioramento possono essere intraprese. Consente di identificare le unità informative (business

unit) e i limiti del sistema informativo/informatico (system boundaries). E’

basato su una notazione grafica, sulla considerazione di dato come prodotto,

sull’analisi dei processi e su passi metodologici. La costruzione e l’utilizzo

di IP-MAP si compone di cinque fasi:

• Catalogare i prodotti informativi.

• Identificare i prodotti informativi critici.

• Definire i requisiti di qualità per i prodotti informativi critici.

• Costruire l’IP-map e il repository di metadati.

• Valutare e migliorare la qualità del prodotto informativo.

Capitolo 2

Qualità dei Dati e

Dimensione

Abbiamo già parlato dell’importanza della DQ, delle cause e delle conseguenze di una scarsa qualità dei dati. In questo capitolo vedremo cosa significa

Data Quality e definiremo il concetto di dimensione, presentandone alcune

tra le più importanti.

2.1

Il Concetto di Qualità dei Dati

La Data Quality è un tema di ricerca in molti domini applicativi come

statistica, management e informatica. Nel 1960, gli statistici sono stati

i primi ad interessarsi ad alcuni problemi di DQ, proponendo una teoria

matematica per studiare la duplicazione dei dati statistici [3]. Negli anni 80

i primi passi furono mossi nel campo del management e poi solo agli inizi

degli anni 90 gli informatici iniziarono a considerare il problema di definire,

misurare e migliorare la qualità dei dati digitali, memorizzati nei database

e nei data warehouse. Nella DQ vengono affrontati diversi aspetti, illustrati

in figura 2.1, essi sono:

Le Dimensioni, la scelta di esse per misurare il livello di DQ è l’inizio

di ogni attività relativa alla DQ. Le dimensioni sono applicate in modo

differente in base al modello, alle tecniche, tools e frameworks.

I Modelli sono utilizzati nei database per rappresentare i dati e gli schemi

dei dati.

Le Tecniche corrispondono agli algoritmi, euristiche, conoscenze che

forniscono una soluzione allo specifico problema di DQ.

Le tecniche necessitano del supporto di tools, come ad esempio procedure automatizzate con interfacce grafiche che sollevano l’utente dal compito

di eseguire manualmente alcune tecniche. Quando un insieme di tools coordinati sono integrati per fornire un insieme di servizi di DQ, utiliziamo il

termine Frameworks.

13

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

14

Infine, le Metodologie forniscono linee guida per la scelta, partendo da

tecniche e tools disponibili, dei processi di misurazione e miglioramento più

efficienti per uno specifico sistema informativo.

Figura 2.1: Principali aree di ricerca in DQ

E’ molto difficile dare una definizione di DQ, è un concetto molto complesso. Una prima, ma non completa definizione è quella che deriva dalla

constatazione che un qualsiasi database non è altro che una rappresentazione

di un qualche aspetto del mondo reale. In altre parole, un database modella

una realtà; il problema è fare in modo che la modellazione risulti, nel tempo,

il più fedele possibile. Quindi la DQ potrebbe essere considerata il livello di

rispondenza delle basi informative alle realtà modellate. Quando si pensa al

concetto di DQ, molto spesso si associa essa alla definizione di accuratezza

dei dati. Il fatto di associare la DQ ad una sola delle dimensioni di qualità,

l’accuratezza, è piuttosto normale visto che tale dimensione è quella che più

si avvicina alla definizione di qualità, nella sua accezione più generale. Ma

la DQ è più di un semplice problema di accuratezza. Per definire cos’è la

DQ non si può non considerare il concetto di dimensione di qualità, ma è

proprio questo concetto che caratterizza la definizione di DQ. Altre dimensioni oltre all’accuratezza, sono la completezza, la currency e la consistenza.

Introduciamole con un esempio, nei paragrafi successivi verranno definite

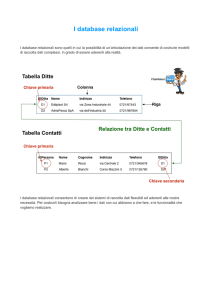

più precisamente. Consideriamo la relazione in tabella 2.1:

Dalla relazione, è possibile notare problemi di accuratezza: il title del movie

3 è Rman invece di Roman, Director del movie 1 e movie 2 sono scambiati

(Curtiz è director del movie 1 e Weir del movie 2). Problemi di completezza:

15

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

ID

1

2

3

4

Title

Casablanca

Dead Poets Society

Rman Holiday

Sabrina

Director

Weir

Curtiz

Wylder

NULL

Year

1942

1989

1953

1964

#Remakes

3

0

0

0

LastRemakeYear

1940

NULL

NULL

1985

Tabella 2.1: Una relazione Movies con problemi di data quality

un valore mancante del director del movie 4 e un valore zero per l’attributo

#Remake sempre del movie 4. Considerando sempre il movie 4, vediamo

che un remake è stato fatto nel 1985, quindi il valore zero di #Remakes può

essere considerato un problema di currency, il remake non è stato ancora

registrato nel database. Infine, due problemi di consistenza: il primo per il

movie 1 dove il valore di LastRemakeYear non può essere minore di Year ; il

secondo per il movie 4 dove il valore di LastRemakeYear e #Remakes sono

inconsistenti, o #Remakes non è zero o LastRemakeYear è NULL.

Dall’esempio sopra riportato, è possibile dedurre che la Data Quality è un

concetto complesso e multi-dimensionale, alla propria definizione concorrono

differenti dimensioni di qualità. Le quattro dimensioni finora esposte sono

solo alcune di un grande insieme di dimensioni presente nella letteratura,

sono le più importanti ma ne esistono altre che si differenziano in base alla

struttura del dato (strutturato, semistrutturato, non strutturato) e al modo

di misurarle (misura qualitativa o quantitativa).

2.2

Tipi di Dati

L’esempio visto precedentemente, riguardava problemi di DQ di un tabella

relazionale, di un singolo database, ma la DQ si differenzia in base al tipo di

dato e sistema informativo presi in considerazione. Come detto nel capitolo

1, i dati sono rappresentazioni del mondo reale, in un formato che può essere

memorizzato, letto, elaborato da un software e comunicato tramite una rete.

Esistono, in letteratura, diverse proposte di classificazione dei dati, ma

prendiamo in considerazione quella che classifica i dati in base alla loro

struttura, esistono tre tipi di dati:

1. Strutturati: i dati strutturati sono quelli distinti in parti elementari, e

ciascuna di loro è rappresentata con un formato che può essere descritto da una grammatica. Le tabelle relazionali sono i dati strutturati

per eccellenza.

2. Semi strutturati: sono quei dati la cui struttura ha qualche grado di

flessibilità. XML è un linguaggio di markup utilizzato per rappresentare dati semi-strutturati. Questi dati non hanno una definizione

formale, ma alcune caratteristiche:

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

16

(a) i dati possono avere campi non predefiniti in fase di progetto, ad

esempio, quando un file XML non ha uno schema XML o DTD

associato.

(b) lo stesso tipo di dato può essere rappresentato in modi diversi,

basti pensare al formato che una data può assumere e in quanti

modi può essere rappresentata.

3. Non strutturati: quando i dati sono espressi in linguaggio naturale

e non hanno una struttura specifica o un dominio di possibili valori

associato.

2.3

Il Concetto di Dimensione

Abbiamo parlato finora della DQ, accennando solo al concetto di dimensione.

Inoltre, abbiamo visto che le dimensioni concorrono alla definizione di DQ.

Approfondiamo in questo paragrafo il concetto di DQ, dal punto di vista

delle molte dimensioni ad essa associate.

Una Dimensione non è altro che un punto di vista da cui osservare e

valutare la qualità dei dati. Cattura uno specifico aspetto della DQ.

Le Dimensioni sono definite in modo qualitativo e le definizioni stesse

non forniscono alcun elemento per assegnare valori alle dimensioni, ovvero

misure quantitative, quindi una o più metriche devono essere associate alle

dimensioni come proprietà separate. Per ciascuna metrica, devono essere

forniti uno o più metodi di misura (o frameworks), costituiti da:

1. definizione della fonte su cui si fa la misura.

2. quali dati sono coinvolti.

3. strumento di misura.

4. la scala utilizzata per riportare il risultato.

Le dimensioni di qualità possono riferirsi allo schema o modello concettuale, alla rappresentazione dei dati e ai valori dei dati. Per ogni categoria

esiste un insieme di dimensioni, ce ne sono diversi ma presentiamo quello

tratto da [2] e mostrato in tabella 2.2.

2.3.1

Qualità nel Modello Concettuale

La qualità del modello concettuale è importante nella fase di progettazione

di un database, infatti sono un risultato della prima fase dello sviluppo di un

sistema informativo e errori concettuali nello schema hanno un forte impatto

sullo processo di sviluppo del sistema. Nel modello concettuale la qualità

è essenziale in quanto il modello rappresenta la porzione di mondo reale

catturata, e quindi è il contesto all’interno del quale valutare l’utilità del

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

Categoria

Modello Concettuale

Rappresentazione dati

Valore dei dati

17

Dimensioni

Contenuto

Composizione

Copertura

Consistenza

Livello di dettaglio

Reazione al cambiamento

Appropriatezza

Flessibilità del formato

Interpretabilità

Abilità rappr. valori nulli

Portabilità

Uso efficiente memoria

Precisione del formato

Accuratezza

Currency

Completezza

Consistenza

Tabella 2.2: Insieme di Dimensioni e Categorie

dato. Le dimensioni legate al modello concettuale sono una misura della

qualità del processo di progettazione del database e di modellazione.

Contenuto

• Rilevanza: il modello deve fornire i dati rilevanti per l’applicazione.

Questa caratteristica pone in evidenza l’importanza della fase di raccolta dei requisisti, in quanto spesso gli utenti non sono in grado di

esprimere chiaramente quali dati sono interessanti e come verranno

utilizzati. Un aspetto da considerare è l’utilizzo di surrogati al posto

di dati desiderati e difficilmente ottenibili: questa pratica è giustificata solamente quando esistono delle correlazioni e dei modelli empirici

provati.

• Ottenibilità: i valori devono essere facilmente ottenibili. Questa caratteristica è legata alla precedente (nel caso in cui i dati non sono

disponibili è meglio utilizzare dei surrogati, piuttosto che non possedere nessun tipo di informazione) e sempre più spesso a problemi di

riservatezza e rispetto della privacy.

• Chiarezza della definizione: ogni termine nella definizione del modello

deve essere chiaramente definito. Le metodologie di progettazione dei

database pongono sempre in primo piano l’importanza del glossario

degli elementi del modello utilizzato.

Copertura

E’ definito come il grado con cui il modello comprende abbastanza dati per

soddisfare le necessità delle applicazioni, e non comprende dati in eccesso.

Idealmente il database dovrebbe contenere tutti e soli i dati necessari e niente

di più.

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

18

• Comprensività: ogni dato necessario deve essere compreso nel modello. E’ necessario considerare tutti i possibili utenti e come le rispettive

necessità si sovrappongono; inoltre può essere necessario considerare, oltre alle applicazioni attuali, anche eventuali applicazioni future,

estendendo quindi lo scope del modello.

• Essenzialità: nessun dato non necessario deve essere compreso; infatti

dati non necessari distolgono dalla “cura adeguata” dei dati effettivamente necessari e aumentano i costi della gestione dei dati stessi.

Livello di Dettaglio

E’ la quantità di dati da includere e quanto precisi essi debbano essere.

• Granularità degli attributi: numero e copertura degli attributi utilizzati per rappresentare un singolo concetto. Ad esempio, per rappresentare il concetto di Indirizzo, in un’applicazione può essere sufficiente definire un solo attributo Address, mentre in un’altra è necessario

definire gli attributi Apartment, Street, State, Country. La granularità degli attributi deve essere progettata tenendo conto di differenti

trade-off: dettaglio vs. maggiori costi per ottenere e memorizzare i valori, possibilità di controlli di consistenza vs. minore flessibilità, maggiore applicabilità vs. la considerazione che troppi dettagli possono

“annoiare”l’utente.

• Precisione dei domini: è il livello di dettaglio nelle misure (o nello

schema di classificazione) che definiscono il dominio. In generale maggiore è il numero di valori nel dominio, maggiore è la precisione. Ad

esempio un dominio definito su un tipo enumerato con 20 valori è più

preciso dello stesso definito su 5 valori, cosı̀ come utilizzare i millimetri

per misurare l’altezza di una persona implica una precisione maggiore che utilizzare i centimetri. Ovviamente deve essere valutato se la

precisione è effettivamente necessaria ed utile (ad esempio in molte

applicazioni non serve conoscere l’altezza al millimetro; in altre addirittura può bastare un tipo enumerato a due valori: bassa, quando

l’altezza è minore/uguale di 160 cm ed alta).

Composizione

è la strutturazione interna della view. Si compone delle seguenti caratteristiche:

• Naturalezza: ogni elemento del modello deve avere una controparte “naturale”nel mondo reale. Questo spinge a limitare al minimo

l’utilizzo di attributi multifatto, viceversa il dominio di ogni attributo dovrebbe specificare l’informazione in modo naturale: domini

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

19

non naturali spesso nascono dalla necessità di incorporare, per motivi

implementativi, informazioni secondarie nell’attributo.

• Identificabilità: ogni entità deve essere univocamente identificabile

rispetto alle altre (utilizzo della primary key).

• Omogeneità: i tipi delle entità dovrebbero essere definiti in modo da

minimizzare l’occorrenza di attributi non necessari/non applicabili.

Per promuovere l’omogeneità è utile ricorrere alle generalizzazioni (supertipi e sottotipi). Ad esempio in un database devono essere memorizzate informazioni sugli impiegati, che possono essere pagati mensilmente o giornalmente. Un modello potrebbe prevedere Employee =

<Name, Classification, MonthlySalary, DailySalary > ed in questo caso,

per ogni entità, uno degli ultimi due attributi è non applicabile (mancanza di omogeneità). Invece un modello che prevede: DailyEmployee

= <Name, Classification, DailySalary >, MonthlyEmployee = <Name, Classification, MonthlySalary > promuove l’omogeneità attraverso

l’uso del costrutto gen/spec.

• Ridondanza minima necessaria: la ridondanza deve essere sempre attentamente vagliata ed accuratamente giustificata, altrimenti va eliminata; questo perchè aumenta i costi e la gestione della sua coerenza

distoglie da dati maggiormente importanti.

Consistenza della Vista

• Consistenza semantica: il modello deve essere non ambiguo e consistente. Bisogna prestare attenzione ai cicli di relazioni 1:1 ed 1:N, cosı̀

come alla definizione dei vincoli di molteplicità nelle associazioni.

• Consistenza strutturale: i tipi delle entità e degli attributi devono

avere sempre la stessa struttura di base. Ad esempio tutte le date

devono essere in un formato comune, anche se sono attributi di entità diverse; la stessa considerazione vale per i nomi o le informazioni

toponomastiche.

Reazione al Cambiamento

Ognuna delle precedenti cinque dimensioni viene valutata rispetto all’insieme attuale delle applicazioni. Con il passare del tempo le necessità applicative si modificano, e di pari passo dovrebbe evolvere anche il modello dei

dati sottostante. Quest’ultima dimensione considera appunto la capacità del

modello di soddisfare le necessità in continua evoluzione.

• Robustezza: è la capacità del modello di sopportare cambiamenti nei

requisisti e/o nel mondo reale senza forti impatti sulla struttura di

base.

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

20

• Flessibilità: è la capacità del modello di soddisfare nuove interrogazioni.

In conclusione, va notato che le quindici caratteristiche non sono indipendenti tra di loro, ma ci sono correlazioni positive (migliorare una caratteristica migliora anche l’altra) e negative (migliorare una peggiora l’altra)

tra di esse; solo per citare alcuni esempi, godono di correlazione positiva la

terna comprensività, granularità degli attributi e precisione del dominio, la

coppia ottenibilità e naturalezza, la tripla consistenza semantica, chiarezza

della definizione e identificabilità, la coppia essenzialità ed omogeneità, la

coppia robustezza e flessibilità. Godono di correlazione negativa la coppia

costo e rilevanza, la coppia rilevanza e naturalezza, la tripla comprensività,

ridondanza e precisione dei domini. Quanto detto rientra nel problema del

Trade Off tra dimensioni, che approfondiremo nei paragrafi successivi.

2.3.2

Qualità nella Rappresentazione dei Dati

La registrazione di un dato è composta da un formato e da una o più istanze

fisiche dei valori. Un formato è un mapping dal dominio ad un insieme di

simboli; sia V il dominio concettuale e S un insieme di rappresentazioni

simboliche, allora il formato è una funzione

θ:V→S

Questa qualità è quella riferita allo schema logico, che è alla base dell’implementazione di qualunque database. Le dimensioni legate al formato

sono:

• Appropriatezza: Un formato è più appropriato di un altro se è più

adatto a soddisfare le esigenze dell’utente. Dipende dall’utente e dal

mezzo utilizzato.

• Interpretabilità: Un buon formato aiuta l’utente ad interpretare i dati

correttamente. Ad esempio, si consideri un dato che ha un dominio di tipo categoria, e come differiscono, secondo l’interpretabilità,

il formato con valori (1,2,3) e quello con valori (insufficiente, buono,

ottimo).

• Precisione del Formato: Un formato è preciso se permette di distinguere elementi del dominio che devono essere distinti dall’utente. Questa

dimensione è importante, ad esempio, nel caso di valori numerici reali, e nel caso di etichette in cui la dimensione della stringa è limitata

(troncamenti non permettono di distinguere valori differenti).

• Flessibilità del Formato: è la facilità di cambiamento del data item in

corrispondenza al cambiamento delle esigenze dell’utente od al cambiamento della piattaforma di supporto alla memorizzazione del data

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

21

item. Ad esempio, una rappresentazione di un data item anno a due

cifre è stata sufficiente fino a quando non si è raggiunto l’anno 2000.

• Capacità a Rappresentare Valori Nulli: è relativa all’insieme di rappresentazione e rappresenta il grado con cui è possibile distinguere gli

elementi di tale insieme rispetto alle esigenze dell’utente. Rappresentazioni precise devono anche garantire la possibilità di rappresentare

valori nulli. Ad esempio, si hanno diversi livelli di precisione a seconda

che i valori numerici siano rappresentati con un formato integer oppure

real.

• Uso Efficiente della Memoria Fisica: spieghiamo il concetto con un

esempio. Memorizzare due icone corrispondenti a maschio e femmina

è meno efficiente che memorizzare (0,1); questo esempio mostra anche

come alcuni requisiti possano essere in conflitto; infatti la memorizzazione di (0,1), pur essendo positiva per l’efficienza di memorizzazione,

inficia la interpretabilità. E’ dunque, in alcuni casi, necessario gestire

un tradeoffs tra le varie dimensioni.

L’efficienza nell’impiego dei supporti di memorizzazione è spesso in contrasto

con le altre dimensioni, in particolare con appropriatezza ed interpretabilità.

Per quanto riguarda un approfondimento degli aspetti di appropriatezza

ed interpretabilità, si possono considerare alcuni testi sulle problematiche

dell’Interazione Uomo-Computer (HCI Human-Computer Interaction) e di

Usabilità come [6] e [7].

L’unica dimensione legata alle istanze fisiche è la Consistenza del Formato, definita come l’assenza di conflitti tra il formato e l’istanza fisica.

2.3.3

Qualità dei Valori dei Dati

La definizione di metodi e tecniche per valutare e migliorare gli schemi concettuali e gli schemi logici in differenti domini applicativi è ancora una fertile

area di ricerca. La qualità dei valori dei dati, è l’area dove si è sperimentato

di più. Descriviamo in dettaglio quattro dimensioni di qualità dei valori, più

precisamente, l’accuratezza, la completezza, la currency e la consistenza.

Accuratezza

L’accuratezza è definita come la vicinanza tra un valore v e un valore v’,

considerato la corretta rappresentazione dell’evento del mondo reale che v

vuole rappresentare. Per esempio se il nome di una persona è John, il

valore v’ =John è corretto, invece il valore v =Jhn non è corretto. Esistono

due tipi di accuratezza chiamati rispettivamente, accuratezza sintattica e

accuratezza semantica.

L’accuratezza sintattica è la vicinanza di un valore v agli elementi del

corrispondente dominio di definizione D. Nell’accuratezza sintattica non si

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

22

è interessati a confrontare v con il vero valore v’ ; piuttosto, si è interessati

a controllare se v è uno dei valori in D. Ad esempio, se v =Jack, anche se

v’ =John, v è considerato sintatticamente corretto e Jack è un valore ammissibile nel dominio dei nomi di persona. Nel capitolo 3 vengono approfonditi

i metodi per misurare l’accuratezza sintattica, ma diamo uno sguardo generale alle possibili misurazioni; si possono utilizzare delle funzioni di distanza

che valutano la distanza tra v e i valori in D, i vari tipi di funzioni sono

descritte in dettaglio nell’appendice. Consideriamo la tabella 2.1 introdotta

precedentemente che descrive una relazione Movies, il valore Rman Holiday

del Title del movie 3 è sintatticamente inaccurato, in quanto non corrisponde a nessun titolo di movie. Roman Holiday è il titolo di movie più vicino a

Rman Holiday.

L’accuratezza semantica è la vicinanza del valore v al vero valore v’.

Consideriamo nuovamente la relazione Movies mostrata in tabella 2.1. Lo

scambio di director per le tuple 1 e 2 è un esempio di errore di accuratezza

semantica. Per quanto riguarda la misurazione, mentre per l’accuratezza

sintattica è ragionevole utilizzare funzioni di confronto, per l’accuratezza

semantica è più accettabile un dominio come <corretto, non corretto> per

la sua misurazione. A differenza dell’accuratezza sintattica, la misurazione

di quella semantica di un valore v necessita che il vero valore di v sia noto.

L’accuratezza semantica è di solito più complessa da misurare.

L’accuratezza, in generale, può essere misurata a differenti livelli di granularità del modello dei dati, facendo riferimento al modello relazionale l’accuratezza può riguardare: i singoli valori di un attributo di una relazione,

il singolo attributo, la relazione e perfino l’intero database. Quando viene

considerata l’accuratezza di un insieme di valori, si può introdurre un tipo di

accuratezza chiamata Duplicazione. La Duplicazione si manifesta quando,

un’entità del mondo reale viene memorizzata due o più volte in una sorgente dati. Al momento del popolamento del database, se viene effettuato un

controllo di consistenza sulla chiave primaria il problema della duplicazione

è escluso a priori.

Completezza

Esistono tre tipi di completezza. La completezza dello schema è definita

come il grado con il quale i concetti e le loro proprietà sono presenti nello

schema. La completezza dell’ attributo è definita come una misura dei valori

mancanti per uno specifico attributo di una relazione. La completezza della

popolazione valuta i valori mancanti rispetto ad una popolazione di riferimento. Focalizziamoci su un particolare modello di dati, più precisamente

sul modello relazionale e vediamo cosa significa completezza in questo caso.

La completezza di una relazione può esser definita come il grado con il

quale la relazione rappresenta la corrispondente parte del mondo reale. Nel

modello relazionale, la completezza è definita in base a:

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

23

1. la presenza/assenza e significato dei valori nulli.

2. la validità di una delle due assunzioni chiamate rispettivamente open

world assumption e closed world assumption

In un modello con valori nulli, la presenza di un valore nullo ha il significato generale di valore mancante, ma è importante capire perchè tale valore

non è presente. I significati che si possono dare sono:

• il valore non è presente perchè esiste nel mondo reale ma non è conosciuto.

• il valore non è presente perchè non esiste in generale.

• il valore non è presente perchè potrebbe esistere ma attualmente non

si è a conoscenza del fatto che esista oppure no.

Nei modelli logici come quello relazionale, ci sono due assunzioni per

la completezza dei dati di una istanza r di relazione. La closed world assumption (CWA) indica che solo i valori attualmente presenti in una tabella

relazionale r e nessun altro valore rappresentano i fatti veri del mondo reale.

Nella open world assumption (OWA) non possimo indicare ne la verità ne

la falsità dei fatti non rappresentati nelle tuple di r.

Dalle quattro possibili combinazioni, considerare/non considerare i valori

nulli e OWA/CWA vengono fuori due casi:

1. modello senza valori nulli che rispetta OWA.

2. modello con valori nulli che rispetta CWA.

Nel modello con valori nulli che rispetta CWA, la completezza può esser

definita considerando la granularità degli elementi del modello: valore, tupla,

attributo e relazione come mostrato in figura 2.2. E’ possibile definire:

• Completezza del Valore: rileva la presenza di valori nulli per alcuni

campi di una tupla.

• Completezza della Tupla: definita per una tupla, in base ai valori di

tutti i suoi campi.

• Completezza dell’Attributo: misura il numero di valori nulli di un

particolare attributo in una relazione.

• Completezza della Relazione: rileva la presenza di valori nulli in una

relazione.

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

24

Figura 2.2: Completezza di differenti elementi del modello relazionale

Dimensioni Temporali: Currency, Timeliness e Volatility

La Currency riguarda quanto tempestivamente i dati sono aggiornati. Può

esser considerata una accuratezza temporale. Riprendendo l’esempio della

relazione Movies mostrata in tabella 2.1, si può notare che l’attributo #Remakes del movie 4 ha una bassa currency, in quanto un remake del movie

4 è stato fatto, ma questa informazine non risulta nell’aumento del valore

del numero di remake. Altro esempio è quello dell’indirizzo, se un indirizzo

di residenza di una persona è aggiornatso, quindi corrisponde all’indirizzo

dove attualmente vive, la currency è alta.

La Volatility riguarda la frequenza in base alla quale i dati cambiano nel

tempo. Per esempio, dati stabili come le date di nascita hanno volatilità

pari a zero, invece il numero di scorte di un magazzino ha un alto grado di

volatilità, in quanto cambia frequentemente.

La Timeliness esprime quanto è aggiornato il dato per il compito preso in considerazione. Esistono casi in cui i dati sono aggiornati, ma non

sono attualmente utili perchè in ritardo rispetto ad uno specifico utilizzo.

Per esempio, consideriamo la tabella degli orari dei corsi universitari, essa

può essere aggiornata con i valori più recenti, ma è possibile che non sia

disponibile in tempo, ad esempio dopo l’inizio dei corsi.

Consistenza

La dimensione consistenza rileva le violazioni di regole semantiche definite

su un insieme di dati. Con riferimento alla teoria del modello relazionale, i

vincoli di integrità sono un istanza di queste regole semantiche. Diamo una

panoramica dei vincoli di integrità del modello relazionale che permettono

di comprendere il concetto di consistenza.

I vincoli di integrità sono proprietà che devono essere soddisfatte da

tutte le istanze di uno schema di basi di dati. Sono normalmente definiti

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

25

sugli schemi ma possono essere controllati su una singola istanza di uno

schema. Ogni vincolo può essere visto come un predicato che associa ad

ogni istanza, il valore vero o falso. Se il predicato assume il valore vero

diciamo che l’istanza soddisfa il vincolo. In generale ad uno schema di basi

di dati si associano un insieme di vincoli e si considerano corrette le istanze

che soddisfano tutti i vincoli.

Si possono distinguere due principali categorie di vincoli di integrità, in

base agli elementi di un database che sono coinvolti: vincoli intra-relazionali

e vincoli inter-relazionali. I vincoli intra-relazionali possono riguardare i

singoli attributi o più attributi di una singola relazione. Questi vincoli hanno

due casi particolari, vincolo di tupla: è un vincolo che può essere valutato su

ciascuna tupla indipendentemente dalle altre, e vincolo sui valori o vincolo

di dominio: che impone restrizioni sul dominio dell’attributo. I vincoli

inter-relazionali coinvolgono gli attributi di più relazioni.

I vincoli di integrità principali sono le Dipendenze.

• Dipendenza di chiave: è il più semplice tipo di dipendenza. Data una

istanza r di relazione con un insieme di attributi, per un sottoinsieme

K degli attributi una dipendenza di chiave è definita, se non ci sono

tuple di r che hanno gli stessi valori per il sottoinsieme K.

• Dipendenza di inclusione: detta anche vincolo referenziale, su un’istanza di relazione r dichiara che alcune colonne di r sono contenute

in altre colonne di r o in altre istanze relazionali s. Un vincolo di

chiave esterna è un esempio di dipendenza di inclusione.

• Dipendenza Funzionale: data un’istanza di relazione r, siano X e Y

due insiemi non vuoti di attributi in r. r soddisfa la dipendenza

funzionale

X→Y

se per ogni coppia di tuple t1 e t2 in r vale:

If t1.X =t2.X, then t1.Y =t2.Y

dove la notazione t1.X significa la proiezione delle tuple t1 sugli attributi in X.

CAPITOLO 2. QUALITÀ DEI DATI E DIMENSIONE

2.4

26

TradeOffs tra Dimensioni

Le dimensioni di qualità non sono indipendenti, ma correlate tra loro. Se

una dimensione viene considerata più importante delle altre per una specifica

applicazione, la scelta di favorire tale dimensione potrebbe avere conseguenze

negative per le altre. Stabilire i tradeoffs tra dimensioni è un problema da

non sottovalutare. Facciamo alcuni esempi.

Primo, tradeoffs tra timeliness e una tra le dimensioni accuratezza, completezza e consistenza. Avere dati accurati (o completi o consistenti) potrebbe richiedere tempo, avendo un effetto negativo sulla timeliness. Al

contrario, avere dati tempestivi potrebbe causare una bassa accuratezza (o

completezza o consistenza). Un esempio di questo caso, sono le applicazioni web. Considerando i vincoli di tempo che sono spesso molto stretti

per disponibilità di dati sul web, è possibile che tali dati abbiamo qualche

problema rispetto alle altre dimensioni di qualità. Per esempio, una lista

di corsi pubblicata su un sito web di un’università deve essere tempestiva,

sebbene potrebbe contenere errori di accuratezza o consistenza e alcuni campi potrebbero non essere presenti. Se consideriamo, invece, un’applicazione

di e-banking l’accuratezza, la consistenza e la completezza sono molto più

importanti della timeliness.

Un caso di tradeoffs interessante è quello tra consistenza e completezza. La domanda che ci si pone è la seguente: è meglio avere pochi dati

ma consistenti, o avere più dati ma inconsistenti ? In base al dominio applicativo la scelta cambia. Nel campo statistico, l’analisi dei dati richiede

una gran quantità di dati e l’approccio è favorire la completezza tollerando

l’inconsistenza o adottando tecniche per risolverla. Invece, se consideriamo

un’applicazione che calcola i salari degli impiegati di una compagnia è più

importante la consistenza della completezza.

Le dipendenze tra le dimensioni di DQ, sebbene non siano analizzate in

modo consistente nell’area di ricerca dell’information quality, rappresentano

un problema di importanza primaria. La conoscenza delle dipendenze può

aiutare gli analisti di DQ nel trovare errori e può essere utile per valutare

il livello di qualità di un insieme di dati. In [10] viene proposto un approccio data-driven per l’analisi delle dipendenze tra le dimensioni di qualità.

L’analytical framework proposto fornisce modelli di dipendenze e formule

analitiche basate sull’entropia di Shannon. Quest’ultima caratterizza ogni

modello e propone misure di correlazione tra le dimensioni. L’identificazione automatica di modelli di dipendenze per un particolare insieme di dati è

possibile grazie al framework implementato.

Capitolo 3

Analisi delle Metriche

Questo capitolo analizza le metriche presenti in letteratura, relative ad alcune dimensioni di DQ. Per alcune delle dimensioni esistenti viene fatta una

panoramica delle possibili metriche. Le dimensioni prese in considerazione

sono relative alla qualità dei dati, in quanto la valutazione e l’implementazione delle metriche è meno complessa delle dimensioni del modello concettuale

e della rappresentazione dei dati.

Per ogni dimensione viene fornito il Nome e la Definizione, i Tipi

di Dati : il tipo di dato (strutturato, semistrutturato, non strutturato) sul

quale è possibile valutare la dimensione. Per ogni metrica viene fornita la

Descrizione, il Tipo: se essa è diretta, ovvero calcolabile direttamente

sui dati strutturati (dati del database) o indiretta se necessita di altri dati/informazioni, Informazioni : se necessita di informazioni esterne ai dati

da valutare , ovvero di metadati, il Contesto: se può essere applicata su

qualunque contesto di dati (generale) oppure su contesti particolari (finanziario, scientifico, statistico, etc.) (particolare), la Granularità: il livello di

granularità sul quale può essere applicata (database, relazione, tupla, attributo, valore), la Scala dei Risultati : la scala sul quale vengono riportati

i risultati della metrica (intervallo [0, 1], insieme N+ , R+ , etc.).

Nel paragrafo 3.1, viene presentata una tabella che elenca per alcune dimensioni di qualità, la presenza o assenza di metriche e la relativa creazione

dell’algoritmo di implementazione. Spieghiamo il significato della tabella e

dei valori. Sono presenti tre colonne, il nome della dimensione, la metrica di valutazione e la creazione dell’algoritmo. Tralasciando il nome della

dimensione, la colonna metrica di valutazione vuole indicare per quella particolare dimensione l’esistenza (Presente) o la non esistenza (Assente) di

almeno una metrica nella letteratura presente o se non è presente un metodo di misura esplicito, almeno un’euristica o conoscenza che fornisca una

soluzione al problema di DQ. La colonna creazione algoritmo, vuole indicare la possibilità di creare un algoritmo, un implementazione delle metriche

esistenti, se appunto sono presenti (in base al relativo valore nella colonna

27

CAPITOLO 3. ANALISI DELLE METRICHE

28

metrica di valutazione). I valori di questa colonna non si basano su esperimenti reali e pratici, ma su valutazioni teoriche, nel senso che per quella

particolare metrica si è cercato di “farsi un’idea” di come implementarla con

gli strumenti a disposizione. Infatti, il valore Non Possibile indica che la

creazione non è possibile perchè non sono presenti metriche di valutazione,

il valore Possibile indica che la creazione è possibile perchè la metrica non

richiede particolari metodi di misura, come dati coinvolti non troppo particolari o strumenti di misura non troppo specifici e il valore Difficile indica

che la creazione è molto complessa in quanto la metrica richiede strumenti

particolari (tecniche di Intelligenza Artificiale, questionari su un insieme di

utenti) o informazioni aggiuntive non disponibili. Facciamo due esempi, il

primo di metrica presente e creazione algoritmo possibile, il secondo di metrica presente e creazione algoritmo difficile. Il primo esempio è relativo alla

dimensione duplication per la quale la metrica si basa sul calcolo del numero di duplicati (record duplicati), la metrica potrebbe essere implementata

con tecniche di record matching quindi la creazione dell’algoritmo è possibile. Il secondo esempio è relativo alla dimensione relevancy, ovvero al grado

con cui i dati sono adatti e utili per uno specifico scopo, la metrica si basa

sulla forma funzionale simple ratio con un rapporto tra i dati considerati

“pertinenti” e il numero totale di dati. La creazione dell’algoritmo è molto

difficile, in quanto prima di effettuare il semplice rapporto (il numero totale

di dati è facilmente calcolabile), l’algoritmo dovrebbe risolvere il vero problema: determinare il significato di “pertinente allo scopo” e successivamente

dividere i dati in base alla loro utilità rispetto all’obiettivo. Con algoritmi

tradizionali questo è molto difficile e si rendono utili, ad esempio tecniche di

intelligenza artificiale.

29

CAPITOLO 3. ANALISI DELLE METRICHE

3.1

Tabella Dimensioni - Metriche - Algoritmi

Nome Dimensione

Metrica di Valutazione

Creazione Algoritmo

Accessibility

Accuracy Syntactic

Accuracy Semantic

Appropriate amount of data

Believability

Completeness

Concise Representation

Consistency

Currency

Detail

Duplication

Ease of Manipulation

Objectivity

Relevancy

Reputation

Security

Timeliness

Ease of Understanding

Variety of Data Sources

Value-Added (Usefulness)

Volatility

Presente

Presente

Presente

Presente

Presente

Presente

Presente

Presente

Presente

Assente

Presente

Presente

Presente

Presente

Presente

Presente

Presente

Presente

Assente

Presente

Presente

Possibile

Possibile

Possibile

Difficile

Difficile

Possibile

Difficile

Possibile

Possibile

Non Possibile

Possibile

Difficile

Difficile

Difficile

Difficile

Possibile

Possibile

Difficile

Non Possibile

Difficile

Possibile

Tabella 3.1: Tabella Dimensioni-Metriche-Algoritmi

CAPITOLO 3. ANALISI DELLE METRICHE

3.2

30

Dimensioni della Qualità dei Dati: Metriche

Presentiamo di seguito, uno schema che mette in relazione il concetto di

dimensione, metrica e algoritmo con alcune particolarità per il concetto di

metrica.

Figura 3.1: Schema relazione tra dimensione, metrica e algoritmo

Approfondiamo i concetti dello schema:

• Dimensione: La dimensione, definita in modo preciso nel Capitolo 2,

è l’aspetto della qualità che si vuole analizzare e valutare.

• Metrica: La metrica è il metodo con il quale deve essere effettuata la

valutazione (quantitativa) della dimensione.

• Algoritmo: L’algoritmo è l’implementazione della metrica.

• Contesto di Utilizzo: Esistono metriche che possono essere utilizzate in contesti generali, su qualunque database senza informazioni

riguardanti il contesto di utilizzo; altre metriche invece dipendono dal

contesto d’uso; ad esempio, delle metriche possono essere applicate su

database che contengono qualunque tipo di dato, come quelle relative

alla completezza, altre invece sono legate ai dati contenuti nel database (finanziari, scientifici, etc.) perchè necessitano di informazioni sui

dati che provengono dal contesto, come nel caso della currency, che

necessita del metadato frequenza media di aggiornamento del dato; la

frequenza varia notevolmente in base al tipo di dato. La frequenza dei

CAPITOLO 3. ANALISI DELLE METRICHE

31

dati finanziari è molto più alta dei dati scientifici, basti pensare alle

quotazioni in borsa dei titoli azionari che variano minuto dopo minuto.

• Informazioni Aggiuntive: Alcune metriche per poter funzionare

hanno bisogno di informazioni in più rispetto ai soli valori del database. Alcuni esempi sono le lookup table ovvero tabelle che contengono

tutti i valori corretti di un determinato dominio (nomi, indirizzi, etc.),

oppure relazioni uguali a quelle che si sta analizzando, ma complete e

con valori accurati.

• Granularità: La granularità è il livello di dettaglio di applicazione

della metrica, ad esempio una metrica può essere applicata ad una

relazione, ad un attributo, ad una tupla o al singolo valore.

CAPITOLO 3. ANALISI DELLE METRICHE

3.2.1

32

Syntactic Accuracy

Nome

Definizione

Tipi di Dati

Syntactic Accuracy / Free of Error

Vicinanza tra il valore v con gli elementi del relativo dominio D

di definizione

Strutturati

Prima metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Funzioni di Distanza : valutano la distanza tra v e i valori di D

Diretta

Necessita di lookup table

Generale

Valore

Insiemi N+ , R+

Alcune delle possibili funzioni di distanza sono:

• Distanza di edit

• Distanza pesata

• Soundex

• Distanza pesata basata sulle frequenze

Le funzioni di distanza vengono approfondite attraverso una panoramica di

quelle esistenti nell’Appendice B.

Seconda metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Simple Ratio

Diretta

Necessita di lookup table

Generale

Basi di Dati, Relazioni, Attributi

Intervallo [0,1]

E’ definita come il rapporto tra il numero di valori accurati e il numero

di valori totali, sottratto a 1

CAPITOLO 3. ANALISI DELLE METRICHE

33

Terza metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Metriche per gli errori di accuratezza che influiscono sul confronto

tra tuple

Indiretta

Necessita di lookup table

Generale

Tuple

Intervallo [0,1]

Il confronto è basato sulle tuple della sorgente dati sotto esame rispetto

alle tuple di un altra sorgente che si suppone contenga le stesse ma corrette

tuple. In questo processo gli errori di accuratezza dei valori degli attributi

possono non influenzare il confronto tra tuple oppure possono influenzarlo in

maniera tale da non permetterlo. Consideriamo alcune metriche in questo

contesto.

Consideriamo uno schema relazionale R costituito da K attributi e un’istanza r di relazione composta da N tuple. Sia yij = (i = 1..K, J = 1..N )

una variabile booleana definita in corrispondenza dei valori qij delle celle

tale che yij è uguale a zero se qij è sintatticamente accurato, altrimenti è

uguale a uno.

Per identificare se gli errori di accuratezza influenzano o meno il confronto di una tabella relazionale r con una tabella di riferimento r’ contenente

i valori corretti introduciamo una variabile booleana sj che è uguale a zero se la tupla tj corrisponde a una tupla in r’, altrimenti è uguale a uno.

Introduciamo tre metriche.

La prima metrica è chiamata weak accuracy error ed è definita come:

j=N

X

j=1

V

β((qj > 0) (sj = 0))

N

dove β(·) è una variabile booleanaPuguale a uno se la condizione in parentesi

j=N

è vera, altrimenti zero, e qj =

j=1 qij . Tale metrica considera il caso

in cui per una tupla tj si verificano errori di accuratezza (qj > 0) ma non

influenzano l’identificazione (sj = 0).

La seconda metrica è chiamata strong accuracy error ed è definita come:

j=N

X

j=1

V

β((qj > 0) (sj = 1))

N

dove β(.) è una variabile booleana

uguale a uno se la condizione in parentesi

Pj=N

è vera, altrimenti zero, e qj = j=1

qij . Tale metrica considera il caso in cui

per una tupla tj si verificano errori di accuratezza (qj > 0) che influenzano

l’identificazione (sj = 1).

CAPITOLO 3. ANALISI DELLE METRICHE

34

La terza metrica determina la percentuale di tuple accurate rispetto alla

tabella di riferimento. E’ definita come:

j=N

X β((qj = 0) V(sj = 0))

N

j=1

considerando la frazione di accurate (qj = 0) e corrispondenti (sj = 0) tuple.

3.2.2

Semantic Accuracy

Nome

Definizione

Tipi di Dati

Semantic Accuracy / Correctness

Vicinanza tra il valore v e il valore v’ semanticamente corretto

corrispondente a v

Strutturati

La semantic accuracy è più complessa da misurare rispetto alla syntactic

accuracy. La complessità deriva dal fatto che il corrispondente valore v’ di v

semanticamente corretto deve essere conosciuto. Le metriche per la semantic

accuracy utilizzano una scala di risultati del tipo <corretto, non corretto>

Prima metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Sostituzione con syntactic accuracy

Indiretta

Necessita di lookup table

Generale

Valore

<corretto,non corretto>

Il problema di misurare la semantic accuracy viene sostituito molto spesso la misura della syntactic accuracy, soprattutto quando si conosce a priori

che il grado di errori dei valori presenti nella relazione è molto basso.

Seconda metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Funzioni di Distanza

Indiretta

Necessita di lookup table

Generale

Valore

<corretto,non corretto>

Con le funzioni di distanza si valuta il valore di una cella della relazione

con il valore della cella corrispondente di un’altra relazione (o più di una

relazione) identica e considerata semanticamente corretta. Questo tipo di

metrica richiede la soluzione all’ object identification problem ovvero il problema di capire se due tuple si riferiscono alla stessa entità del mondo reale

CAPITOLO 3. ANALISI DELLE METRICHE

35

oppure no.

Per fare questo bisogna risolvere altri due sottoproblemi:

• Identificazione: le tuple in relazioni diverse di solito hanno identificatori diversi e si deve effettuare un confronto tra chiavi per mettere

in corrispondenza le stesse tuple in differenti relazioni.

• Strategia di Decisione: dopo che le tuple sono state collegate si

verifica che corrispondano alla stessa entità oppure no.

Terza metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Simple Ratio

Diretta

Necessita di lookup table

Generale

Basi di Dati, Relazioni, Attributi

<corretto,non corretto>

Utilizzando la metrica per la misura della semantic accuracy sui singoli valori, si può calcolare un indice che esprima quanti valori sono semanticamente

corretti, rispetto al totale dei valori. Si effettua il rapporto tra il numero di

valori accurati rispetto al numero totale di valori, sottratto a 1.

3.2.3

Duplication

Nome

Definizione

Tipi di Dati

Duplication / Uniqueness Accuracy per insiemi di valori

Un entità del mondo reale è memorizzata due o più volte nella

base di dati

Strutturati

Metrica

Consideriamo l’ipotesi che sulla relazione non venga eseguito nel momento

del popolamento della tabella un controllo di consistenza sulla chiave primaria, nel caso contrario il problema della duplicazione non si verificherebbe.

Descrizione

Calcolo del numero di duplicati

Tipo

Diretta

Informazioni

Nessuna Informazione

Contesto

Generale

Granularità

Basi di Dati, Relazioni

Scala Risultati Insieme N+ oppure %

La metrica calcola il numero di duplicati presenti in una base di dati o

ancora meglio in una relazione, confrontando principalmente i valori della

chiave primaria che si suppone non siano consistenti.

CAPITOLO 3. ANALISI DELLE METRICHE

3.2.4

36

Completeness

Nome

Definizione

Tipi di Dati

Completeness

Grado in cui i valori previsti in uno schema sono presenti

nell’istanza dello schema

Strutturati e Semistrutturati

Prima metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Modello Completezza

Reference Relation

Diretta

Necessita di una Reference Relation

Generale

Relazione

Intervallo [0,1]

Modello senza valori nulli con assunzione OWA

Introduciamo il concetto di Refence Relation; data una relazione r la reference relation di r detta ref (r) è la relazione contenente tutte le tuple che

soddisfano lo schema relazionale di r. Ad esempio se ho una relazione DIP

che rappresenta gli impiegati di uno specifico dipartimento e un particolare

impiegato non è presente come una tupla di DIP, la tupla in questione è presente in ref (DIP) e quindi le due relazioni differisco esattamente per quella

tupla. Molte volte la reference relation non è disponibile, è più probabile

che sia presente la sua cardinalità. In base a queste considerazioni la completezza di una relazione r è misurata con il rapporto tra il numero di tuple

attualmente presenti nella relazione r e il numero di tuple della reference

relation di r. In formula:

|r|

C(r) =

|ref (r)|

Seconda metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Modello Completezza

Attribute Completeness - Simple Ratio

Diretta

Nessuna Informazione

Generale

Attributi

Intervallo [0,1] oppure %

Modello con valori nulli con assunzione CWA

La metrica misura la presenza di valori nulli per un particolare attributo

di una relazione. Si considera il rapporto tra il numero di tuple che hanno

per quell’attributo un valore nullo rispetto al numero totale di tuple presenti

nella relazione, sottratto a 1.

CAPITOLO 3. ANALISI DELLE METRICHE

37

Terza metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Modello Completezza

Tuple completeness - Simple Ratio

Diretta

Nessuna Informazione

Generale

Tuple

Intervallo [0,1] oppure %

Modello con valori nulli con assunzione CWA

La metrica misura la presenza di valori nulli per una particolare tupla di

una relazione. Si considera il rapporto tra il numero di valori nulli presenti

nella tupla ovvero il numero di attributi con valori nulli per la tupla rispetto

al numero totale di attributi della tupla stessa, sottratto a 1.

Quarta metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Modello Completezza

Relation completeness - Simple Ratio

Diretta

Nessuna Informazione

Generale

Relazione

Intervallo [0,1] oppure %

Modello con valori nulli con assunzione CWA

La metrica misura la presenza di valori nulli in una relazione. Si considera il rapporto tra il numero di valori nulli presenti nella relazione ovvero

il numero di celle con valori nulli rispetto al numero totale di celle della

relazione.

3.2.5

Currency

Nome

Definizione

Tipi di Dati

Currency

Grado di aggiornamento dei dati

Strutturati, Semistrutturati, non strutturati

Prima metrica

Descrizione

Tipo

Informazioni

Contesto

Granularità

Scala Risultati

Differenza rispetto al metadato

Diretta

Necessita del metadato / frequenza di aggiornamento

Particolare

Attributo, Valore

<current,not current>