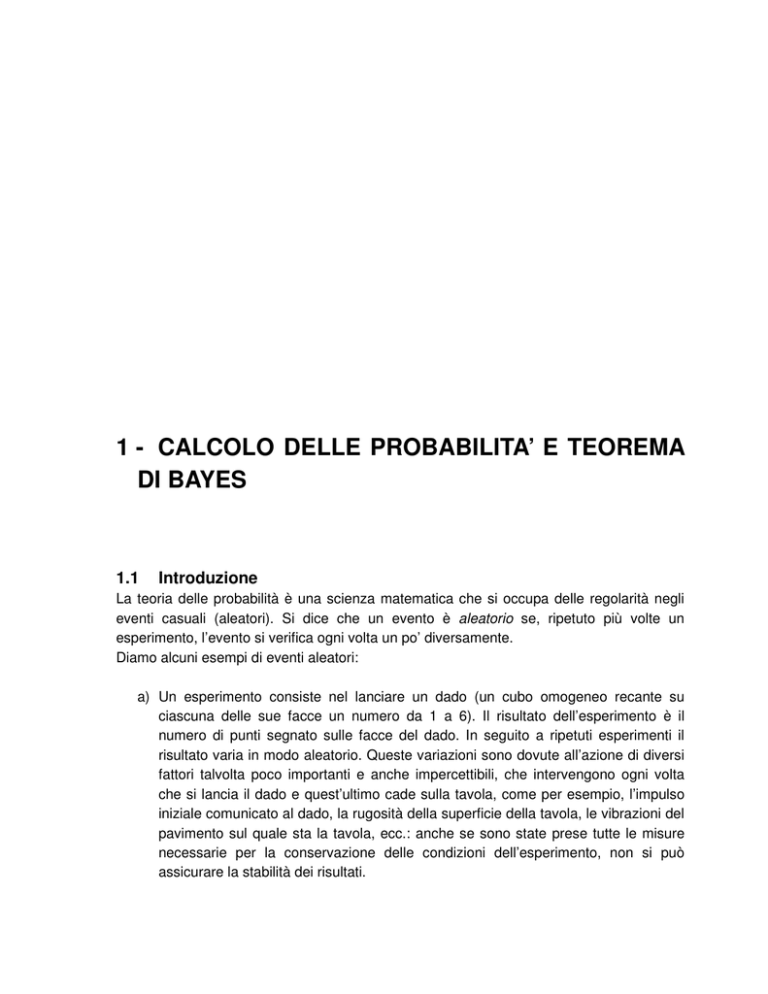

1 - CALCOLO DELLE PROBABILITA’ E TEOREMA

DI BAYES

1.1

Introduzione

La teoria delle probabilità è una scienza matematica che si occupa delle regolarità negli

eventi casuali (aleatori). Si dice che un evento è aleatorio se, ripetuto più volte un

esperimento, l’evento si verifica ogni volta un po’ diversamente.

Diamo alcuni esempi di eventi aleatori:

a) Un esperimento consiste nel lanciare un dado (un cubo omogeneo recante su

ciascuna delle sue facce un numero da 1 a 6). Il risultato dell’esperimento è il

numero di punti segnato sulle facce del dado. In seguito a ripetuti esperimenti il

risultato varia in modo aleatorio. Queste variazioni sono dovute all’azione di diversi

fattori talvolta poco importanti e anche impercettibili, che intervengono ogni volta

che si lancia il dado e quest’ultimo cade sulla tavola, come per esempio, l’impulso

iniziale comunicato al dado, la rugosità della superficie della tavola, le vibrazioni del

pavimento sul quale sta la tavola, ecc.: anche se sono state prese tutte le misure

necessarie per la conservazione delle condizioni dell’esperimento, non si può

assicurare la stabilità dei risultati.

1 – Calcolo delle probabilità e teorema di Bayes

________________________________________________________________________________________________

b) Un esperimento consiste nel fatto che la cassa automatica di un autobus viene

riempita di monete durante la giornata. Questa cassa si vuota alla fine della

giornata e si conta l’incasso (risultato della prova). È chiaro che questo risultato

varia da un giorno all’altro e oscilla attorno ad un valore medio, entro certi limiti.

Queste variazioni sono dovute a fattori aleatori: il numero dei passeggeri saliti

sull’autobus, il numero di passeggeri con o senza abbonamento, ecc.

c) Un esperimento consiste nel pesare un corpo, con la bilancia automatica, un certo

numero di volte. I risultati di esperimenti ripetuti non sono rigorosamente costanti.

Le fluttuazioni sono dovute all’azione di numerosi fattori, come per esempio, la

posizione del corpo sul piatto della bilancia, le vibrazioni aleatorie della tavola, gli

errori della stima delle indicazioni dell’apparecchio, ecc.

d) Si spara con un cannone disposto sotto un angolo θ0 rispetto all’orizzonte, alla

velocità iniziale v0, avendo i proiettili le medesime caratteristiche balistiche (peso,

forma). La traiettoria teorica è interamente determinata da queste condizioni, la

traiettoria sperimentale subisce variazioni a causa degli effetti secondari: errori di

fabbricazione del proiettile, scarto del peso dal suo valore nominale, errore di

messa a punto del proiettile, condizioni meteorologiche, ecc. Se sono sparati molti

colpi in condizioni a prima vista simili, si ottiene non una sola curva teorica, bensì

tutto un fascio di traiettorie, che riflette la dispersione dei proiettili.

Tutti gli esempi menzionati sopra sono considerati dallo stesso punto di vista: sono

sottolineate le variazioni aleatorie, i risultati diversi in una serie di esperimenti, le cui

condizioni essenziali sono mantenute costanti. Tutte queste variazioni sono sempre legate

alla presenza di fattori secondari, che influiscono sul risultato dell’esperimento, ma non

figurano tra le condizioni essenziali. Le condizioni essenziali dell’esperimento,

determinando grosso modo il suo verificarsi, restano invariate; le condizioni secondarie

variano da un esperimento all’altro e fanno apparire delle variazioni aleatorie nei risultati.

È evidente che non esistono in natura effetti fisici che non abbiano elementi casuali. Per

quanto esatte e identiche siano le condizioni dell’esperimento, è impossibile raggiungere

risultati completamente e esattamente coincidenti al ripetersi dell’esperimento.

Ogni fenomeno deterministico è inevitabilmente accompagnato da scarti aleatori. Tuttavia

in certe applicazioni pratiche si possono trascurare questi elementi aleatori sostituendo un

fenomeno reale con uno schema semplificato, un suo modello, supponendo che nelle

condizioni date dall’esperimento esso si realizzi in modo ben determinato.

Per la risoluzione di un certo numero di problemi, il metodo classico delle scienze esatte

sembra, tuttavia, poco adatto. Esistono dei problemi in cui il risultato di un esperimento

dipende da un numero di fattori così grande che non è praticamente possibile registrarli

tutti e tenerne conto. Questo è il caso dei problemi in cui i fattori aleatori secondari,

intimamente legati gli uni agli altri, giocano un ruolo importante, per di più, il loro numero è

talmente grande e la loro influenza è così complicata che non è giustificato l’impiego dei

metodi classici.

2

1 – Calcolo delle probabilità e teorema di Bayes

___________________________________________________________________________________________________________

I primi studi che portarono successivamente a concetti legati alla probabilità possono

essere trovati a metà del XVI secolo nel Liber de ludo aleæ di Cardano (del 1526, ma

pubblicato solo un secolo e mezzo dopo, nel 1663) e in Sulla scoperta dei dadi di Galileo

Galilei (pubblicato nel 1656), nei quali i due autori ottengono degli elenchi di numeri

facendo ricorso alle permutazioni.

Il problema della ripartizione della posta in gioco nel caso che un gioco d'azzardo debba

essere interrotto, venne affrontato da Fra Luca dal Borgo (detto Paccioli) in Summa de

arithmetica, geometria, proportioni et proportionalita (pubblicato nel 1494) e

successivamente da Tartaglia, per poi essere risolto da Pascal e Fermat.

La nascita del concetto moderno di probabilità viene attribuita a due grandi scienziati quali

Blaise Pascal (1623-1662) e Pierre de Fermat (1601-1665), in particolar modo nella

corrispondenza che si scambiavano discutendo di un problema legato al gioco d'azzardo:

Se si lanciano più volte due dadi, quanti lanci sono necessari affinché si possa

scommettere con vantaggio che esce il doppio sei?

Nello stesso periodo Christiaan Huyghens (1629-1695) scrive De ratiociniis in aleæ ludo

nel quale utilizza il concetto di valore atteso e il campionamento statistico con e senza

riposizionamento. I suoi lavori influenzano tra l'altro Pierre de Montmort (1678-1719) che

scrive nel 1708 Essai d'analyse sur le jeux de hasard, ma anche Jakob Bernoulli e

Abraham de Moivre.

Nel 1654 Pascal annuncia all'Accademia di Parigi che sta lavorando sul problema della

riparitizione della messa in gioco. In una lettera del 29 luglio dello stesso anno a Fermat

propone la soluzione del problema, affrontato con il metodo per ricorrenza, mentre Fermat

utilizzava metodi basati sulle combinazioni.

Nel 1713 Jakob Bernoulli formula in Ars conjectandi il primo teorema limite, ovvero la

legge dei grandi numeri.

Ancora prima di Bernoulli fu notata una particolarità dei fenomeni aleatori, che si può

chiamare “stabilità delle frequenze per un gran numero di prove” e che si manifesta nel

fatto che per un gran numero di prove, aventi ciascuna un risultato aleatorio, la frequenza

relativa di comparsa di ciascuno dei risultati tende a stabilizzarsi, convergendo a un certo

numero, cioè alla probabilità di questo risultato. Per esempio, quando si lancia un gran

numero di volte una moneta, la frequenza relativa di comparsa della testa tende a 1/2;

quando si lancia un gran numero di volte un dado a sei facce, la frequenza di comparsa

del cinque tende a 1/6, ecc.

Bernoulli fu però il primo a dare il fondamento teorico di questo fatto empirico. Il teorema di

Bernoulli, la forma più semplice della legge dei grandi numeri, stabilisce una relazione tra

la probabilità di un evento e la frequenza della sua comparsa; quando il numero di prove è

sufficientemente grande, ci si può aspettare, con una certezza elevata, che la frequenza

coincida a piacere con la probabilità.

Un altro periodo importante nello sviluppo della teoria delle probabilità è legato al nome di

Moivre (1667-1754). Fu lui ad introdurre e a dimostrare, nel caso più semplice, una legge

particolare osservata spesso nei fenomeni aleatori: la cosiddetta legge normale (o legge di

Gauss). La legge normale gioca un ruolo particolarmente importante nei fenomeni aleatori.

3

1 – Calcolo delle probabilità e teorema di Bayes

________________________________________________________________________________________________

Il gruppo di teoremi che danno un fondamento a questa legge per differenti condizioni

porta il nome generale di teorema limite centrale.

Un ruolo particolare nello sviluppo della teoria delle probabilità l’ha avuto Laplace (17491827), che ha dato un’esposizione concisa e sistematica dei fondamenti della teoria delle

probabilità, ha dimostrato una delle forme del teorema limite centrale (teorema di MoivreLaplace) e ha sviluppato numerose applicazioni della teoria delle probabilità a questioni

pratiche, in particolare, all’analisi degli errori nell’osservazione e nella misura.

Un altro passo in avanti nello sviluppo della teoria delle probabilità appartiene a Gauss

(1777-1855), che ha dato un fondamento ancora più generale alla legge normale e ha

elaborato un metodo per trattare i dati sperimentali, noto con il nome di metodo dei minimi

quadrati. Notevoli sono i lavori di Poisson (1781-1840) che ha dimostrato la legge dei

grandi numeri in una forma più generale di quella di Bernoulli e per primo ha applicato la

teoria delle probabilità ai problemi di tiro. Una delle leggi di distribuzione che gioca un

ruolo particolarmente importante nella teoria delle probabilità e delle sue applicazioni,

porta il nome di Poisson.

All’inizio del XIX secolo, in Russia, appare la celebre scuola matematica di S. Pietroburgo

che ha dato alla teoria delle probabilità il suo fondamento logico e teorico e ne ha fatto uno

strumento sicuro, esatto ed efficace di conoscenza. A P. Čebyšev (1821-1894), eminente

matematico russo, sono dovuti lo sviluppo e la generalizzazione della legge dei grandi

numeri; inoltre, egli ha introdotto nella teoria delle probabilità il potente ed efficace metodo

dei momenti.

A. Markov (1856-1922), allievo di Čebyšev, ha ugualmente arricchito la teoria delle

probabilità di scoperte e di metodi molto importanti. Markov ha esteso il dominio di

applicazione della legge dei grandi numeri e del teorema limite centrale da esperimenti

indipendenti a dipendenti. Il merito essenziale di Markov consiste nell’aver posto le basi di

una branca nuova della teoria delle probabilità, cioè la teoria dei processi aleatori o

stocastici.

Un gran numero di lavori fondamentali nei diversi campi della teoria delle probabilità e

della statistica matematica appartiene a A. Kolmogorov. È stato lui a dare una costruzione

assiomatica della teoria delle probabilità, collegandola con un settore importante

dell’analisi, sviluppando la sua teoria nel 1933.

Si torni indietro: nel 1763 fu pubblicato in Inghilterra un articolo del reverendo Thomas

Bayes, che divenne famoso per le sue implicazioni. Secondo l’articolo, fare delle previsioni

su un fenomeno dipende non solo dalle osservazioni che lo scienziato ottiene dai suoi

esperimenti, ma anche da ciò che egli stesso pensa e ha compreso del fenomeno

studiato, ancor prima di procedere all’esperimento stesso. Tali premesse furono sviluppate

nel 1900 da illustri studiosi, quali B. de Finetti (La prévision: ses lois logiques, ses sources

subjectives, 1937), Savage (The foundation of statistics, 1959) e altri ancora.

4

1 – Calcolo delle probabilità e teorema di Bayes

___________________________________________________________________________________________________________

1.2

Le definizioni della probabilità

1.2.1

Probabilità classica

La definizione classica di probabilità risale al XVII secolo ed è dovuta a Laplace. Tale

definizione, poi ripresa da C.F. Circe nel 1910, si può enunciare nel modo seguente: la

probabilità, p( A ) , di un evento A è il rapporto tra il numero m di casi "favorevoli" (cioè il

manifestarsi di A ) e il numero totale n di risultati ugualmente possibili e mutuamente

escludentisi:

m

p(A ) = .

(1.1)

n

Questa probabilità è talvolta detta probabilità a priori: il motivo dell'appellativo "a priori"

deriva dal fatto che è possibile stimare la probabilità di un evento a partire dalla simmetria

del problema.

Ad esempio, nel caso di un dado regolare si sa che la probabilità di avere un numero

qualsiasi dei sei presenti sulle facce è 1/6 e infatti, nel caso dell'uscita di un 3, si ha:

un 3

1

p(3) =

= .

una faccia qualsiasi del dado 6

Analogamente, nel caso di una puntata sul colore rosso alla roulette la probabilità di

vincere è pari a 18 , cioè circa il 49% (infatti i numeri rossi sono 18 su un totale di 37,

37

essendoci oltre ai 18 numeri neri, anche lo zero che è verde).

L'estensione al caso di eventi con risultati continui si attua attraverso una

rappresentazione geometrica in cui la probabilità di un evento casuale è data dal rapporto

tra l'area favorevole all'evento e l'area totale degli eventi possibili.

Si consideri un esempio. Si supponga che un bambino lanci dei sassi contro una parete

forata senza prendere la mira. Siano i fori sulla parete distribuiti a caso e per semplicità

assumiamo che le dimensioni dei sassi siano molto piccole rispetto a quelle dei fori. Ci si

chiede qual è la probabilità p che un sasso passi dall'altra parte.

Se A è l'area della parete e a l'area di ciascuno dei k fori, la probabilità che un sasso passi

è data dall'area "favorevole" divisa l'area totale

p=

ka

.

A

La quantità 1

può essere considerata come una densità di probabilità. Essa è infatti la

A

probabilità che ha un sasso di colpire una particolare superficie unitaria del muro:

moltiplicando questa densità per l'area favorevole si ottiene direttamente la probabilità.

5

1 – Calcolo delle probabilità e teorema di Bayes

________________________________________________________________________________________________

Si noti bene che questa definizione oggettiva di probabilità diventa di difficile applicazione

nelle numerose situazioni in cui la densità di probabilità non può più essere considerata

uniforme, ovvero quando vengono meno le condizioni di simmetria. Ad esempio nel caso

del bambino che lancia i sassi contro il muro può verificarsi che le dimensioni dei fori

varino dal centro verso i bordi del muro e il bambino cerchi di mirare al centro.

1.2.2

Probabilità empirica

La definizione di probabilità empirica è dovuta largamente a R. Von Mises ed è la

definizione sperimentale di probabilità come limite della frequenza misurabile in una serie

di esperimenti. Essa ricalca lo schema della definizione classica, introducendo però

un'importante variazione: sostituisce al rapporto numero casi favorevoli / numero di casi

possibili il rapporto numero di esperimenti effettuati con esito favorevole / numero

complessivo di esperimenti effettuati. Il vantaggio di questa modifica è che questa

definizione si applica senza difficoltà anche ai casi in cui la densità di probabilità non è

uniforme, ovvero, per quanto riguarda esperimenti con risultati discreti, non è necessario

specificare che i risultati debbano essere ugualmente possibili e mutuamente escludentisi.

Vediamo allora come viene definita la probabilità empirica o probabilità a posteriori: la

probabilità di un evento è il limite cui tende la frequenza relativa di successo all'aumentare

del numero di prove. In pratica, se abbiamo un esperimento ripetuto n volte ed un certo

risultato A che accade m volte, la probabilità di A è data dal limite della frequenza ( m )

n

quando n tende all'infinito:

m

p( A ) = lim .

(1.2)

n →∞ n

Gli n tentativi possono essere effettuati sia ripetendo in sequenza m volte lo stesso

esperimento sia misurando simultaneamente m esperimenti identici.

Esistono alcune delicate questioni riguardo l'esistenza e il significato del limite presente

nella definizione di probabilità empirica:

• la probabilità così definita non è una proprietà solo dell'esperimento, ma è anche

funzione del particolare gruppo su cui viene calcolata. Ad esempio la probabilità di

sopravvivenza ad una certa età, calcolata su diversi campioni di popolazione a cui

una stessa persona appartiene (maschi, femmine, fumatori, non fumatori,

deltaplanisti, ecc.), risulta diversa;

• la probabilità empirica si può rigorosamente applicare soltanto agli esperimenti

ripetibili, per i quali il limite per m tendente all'infinito ha significato. Si deduce

quindi che molte situazioni della vita quotidiana, non sono soggette all'uso di questa

definizione di probabilità: rappresentano esempi di questo tipo il risultato di una

partita di calcio, quello di una roulette russa o il tempo atmosferico di domani.

6

1 – Calcolo delle probabilità e teorema di Bayes

___________________________________________________________________________________________________________

Inoltre, per venire incontro ad una necessità di "operatività", quasi tutti sono concordi nel

definire la probabilità come il valore della frequenza relativa di successo su un numero di

prove non necessariamente tendente all'infinito, ma giudicato sufficientemente grande.

Ad esempio, se si lancia una moneta non truccata, la frequenza di croci dopo numerosi

lanci si assesterà in generale sul 50%; tuttavia, anche se estremamente improbabile,

esiste la possibilità che ci sia una sequenza di tutte croci: è questo il difetto logico della

definizione frequentista.

1.2.3

Probabilità assiomatica

La definizione della probabilità matematica è dovuta a A.N. Kolmogorov.

Sia S un insieme di possibili risultati (A i ) di un esperimento S = {A 1, A 2 , A 3 ,...} .

Se tali eventi sono mutuamente escludentisi allora per ognuno di essi esiste una

probabilità p(A ) rappresentata da un numero reale soddisfacente gli assiomi di

probabilità:

I. p(A ) ≥ 0 ;

II. se, come ipotizzato, A 1 e A 2 sono eventi mutuamente escludentisi, allora deve

valere: p(A 1oppureA 2 ) = p( A 1 ) + p( A 2 ) dove p( A 1oppureA 2 ) è la probabilità di

avere il risultato A 1 o il risultato A 2 ;

III. ∑ p( A i ) = 1 , dove la sommatoria è estesa su tutti gli eventi mutuamente

i

escludentisi.

Le conseguenze dei tre assiomi sono:

−

p( A i ) = p(nonA i ) = 1 − p( A i ) , cioè la probabilità di non ottenere l'evento A i è uguale

−

ad uno meno la probabilità di ottenerlo;

p( A i ) ≤ 1 , cioè la probabilità è un numero reale appartenente all'intervallo [0,1]; in

pratica: 0 ≤ p( A i ) ≤ 1 dove 1 rappresenta la certezza di ottenere l'evento A i e 0

quella di non ottenerlo.

Di seguito alcune osservazioni:

• la definizione di probabilità matematica può essere estesa senza problemi alle

variabili continue;

• gli assiomi illustrati e le loro conseguenze sono sufficienti a fare qualsiasi conto,

anche complicato, con le probabilità e ad ottenere un risultato numerico corretto.

D'altra parte essi non dicono niente su cosa sia la probabilità e quale sia la sua

natura: per questo si vedano le definizioni di probabilità classica, probabilità

empirica e probabilità soggettiva;

7

1 – Calcolo delle probabilità e teorema di Bayes

________________________________________________________________________________________________

•

tutte le definizioni di probabilità soddisfano le condizioni espresse da questi

assiomi.

1.2.4

Probabilità soggettiva

La concezione soggettivista della probabilità porta ad una definizione che si potrebbe

formulare nel modo seguente: la probabilità di un evento A è la misura del grado di

fiducia che un individuo coerente attribuisce, secondo le sue informazioni e opinioni,

all'avverarsi di A .

Il campo di applicabilità di questa definizione è molto vasto; occorre aggiungere che la

"coerenza" significa la corretta applicazione delle norme di calcolo e che la misura del

grado di fiducia, cioè la valutazione di probabilità, viene fatta sull'intervallo (0,1)

attribuendo la probabilità 0 all'evento impossibile e 1 a quello certo. Circa il fatto che la

valutazione sia qui un atto soggettivo, molto si potrebbe dire; interessa osservare che

soggettivo non significa arbitrario. Di fatto, appena vi siano premesse sufficienti, le

valutazioni individuali concordano per quanti siano interessati al medesimo problema.

Si consideri un esempio: Alessio è disposto a scommettere 1 contro 20 sul fatto che nel

pomeriggio arrivi finalmente l'idraulico a riparare il rubinetto che perde da una settimana:

attribuisce cioè a tale evento una probabilità pari ad 1 (meno del 5%). E’ come se ci si

21

trovasse ad effettuare un sorteggio da un'urna con 1 pallina rossa (evento positivo = arrivo

dell'idraulico) e 20 palline nere (eventi negativi = assenza dell'idraulico).

Ricapitolando: Alessio sta implicitamente dando una valutazione di probabilità, e tale

valutazione attribuisce una probabilità 1

al realizzarsi dell'evento positivo = arrivo

21

dell'idraulico. La frazione che esprime la probabilità ha numeratore uguale ad 1, che

corrisponde a quanto Alessio è disposto a puntare, e denominatore pari a 21

corrispondente alla puntata di Alessio sommata alla puntata di un ipotetico sfidante.

Per quanto il dominio della probabilità soggettiva appaia ad alcuni incerto e arbitrario, vale

la pena di osservare che proprio questa è la definizione di probabilità a cui più spesso si

ricorre nelle considerazioni quotidiane ("domani pioverà, "questa volta passerò l'esame",

ecc.).

1.3

Teoremi fondamentali del calcolo delle probabilità

Di seguito sono riportati alcuni teoremi che riguardano la combinazione di eventi, senza

alcuna pretesa di esaustività.

Si segnalano altresì alcune definizioni.

I risultati mutuamente escludentisi di un esperimento aleatorio (come il lancio di un paio di

dadi) sono detti eventi elementari. L’insieme di tutti gli eventi associati con un dato

esperimento, è detto spazio degli eventi elementari.

Due eventi A e B sono detti mutuamente esclusivi ovvero incompatibili se non possono

accadere contemporaneamente; l’unione di due eventi A ∪ B è intesa come l’avverarsi di

8

1 – Calcolo delle probabilità e teorema di Bayes

___________________________________________________________________________________________________________

almeno uno dei due; l’intersezione di due eventi A ∩ B è invece l’avverarsi di entrambi gli

eventi. Inoltre, la differenza A − B tra due eventi indica l’avverarsi di A, ma non di B e,

infine, si indica con A il complementare di A, che rappresenta il fatto che A non avviene.

1.3.1

Teorema dell’addizione delle probabilità

Nel caso di eventi mutuamente escludentisi si ha:

p( A ∪ B) = p( A ) + p(B)

(1.3a)

Nel caso che due eventi non siano mutuamente escludentisi, il teorema di addizione delle

probabilità afferma che:

(1.3b)

p( A ∪ B) = p( A ) + p(B) − p( A ∩ B)

che equivale alla seguente formula:

p( A + B) = p( A ) + p(B) − p( A × B) .

(1.4)

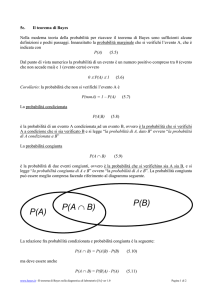

La dimostrazione del teorema si ricava osservando la figura 1: se i due insiemi

rappresentano rispettivamente la probabilità di successo dell'evento A e dell'evento B

allora la probabilità che si verifichi almeno uno dei due è uguale alla somma delle aree dei

due insiemi.

Però nel momento in cui si

considera l'unione dei due

insiemi bisogna togliere la

A

quantità relativa alla loro

intersezione in quanto viene

considerata due volte: una volta

B

A ∩B

per ciascun insieme.

Se si considera A formato da

(A-B)

e

( A ∩ B ),

allora,

necessariamente, per avere la

superficie interessata bisogna

sommare ad A la superficie di

B, da cui sia esclusa ( A ∩ B ).

Figura 1

Il teorema dell'addizione delle probabilità è facilmente estendibile a più di due eventi,

sempre operando le stesse considerazioni fatte per i due eventi A e B .

1.3.2

Probabilità condizionata

Si dice che l'evento A è dipendente dall'evento B se la probabilità dell'evento A dipende

dal fatto che l'evento B si sia verificato o meno. Mentre si dice che l'evento A è

indipendente dall'evento B se la probabilità del verificarsi dell'evento A non dipende dal

fatto che l'evento B si sia verificato o no.

9

1 – Calcolo delle probabilità e teorema di Bayes

________________________________________________________________________________________________

Alcuni esempi:

-

-

si consideri l’esperimento costituito dal lancio di due monete.

Siano:

evento A = l’apparizione di testa al lancio della prima moneta,

evento B = l’apparizione di testa al lancio della seconda moneta.

La possibilità del verificarsi di A non dipende dal fatto che B si sia verificato o

meno, sicché l’evento A può dirsi indipendente dall’evento B .

un’urna contiene due palline bianche ed una nera. Due persone estraggono

ciascuna una pallina dall’urna. Si considerino i seguenti eventi:

evento A = la prima persona estrae una pallina bianca,

evento B = la seconda persona estrae una pallina bianca.

La probabilità che si verifichi l’evento A in assenza di informazioni su B è 2 ; se

3

invece è noto che l’evento B si è verificato, la possibilità che si verifichi l’evento A

diventa 1 . Da ciò si conclude che l’evento A è dipendente dall’evento B .

2

La probabilità dell’evento A , calcolata a condizione che l’evento B si sia verificato, si dice

probabilità condizionata di A e si denota nella seguente modalità:

p(A B ).

Nel caso del secondo esempio citato si ha quindi: p( A ) = 2

(1.5)

3

e p( A B) = 1 .

2

La condizione di indipendenza dell’evento A dall’evento B si può scrivere:

p( A B) = p( A ) ,

(1.6)

mentre la condizione di dipendenza diventa:

p( A B) ≠ p( A ) .

1.3.3

(1.7)

Teorema del prodotto delle probabilità

In generale, per prodotto delle probabilità di due eventi si intende il verificarsi di entrambi

simultaneamente. Ad esempio, se l'evento A consiste nell'estrazione di un due da un

mazzo di carte e l'evento B nell'estrazione di una carta di picche, allora l'evento C = A × B

consiste nell'apparizione di un due di picche.

Il teorema si può quindi scrivere nella seguente forma:

p( A ∩ B) = p( A ) + p(B) − p( A ∪ B)

10

(1.8)

1 – Calcolo delle probabilità e teorema di Bayes

___________________________________________________________________________________________________________

che equivale a:

p( A × B) = p( A ) + p(B) − p( A + B) .

(1.9)

La dimostrazione del teorema è facilmente intuibile sempre dall'osservazione della Figura

1, dove la quantità p( A ∩ B) corrisponde alla zona bianca di intersezione tra i due insiemi.

Tale zona, nel caso della somma dei due insiemi viene ricoperta due volte, quindi,

togliendo la grandezza p( A ∪ B) si eliminano le parti non comuni dei due insiemi e in più

si sottrae anche una volta la superficie p( A ∩ B) , proprio come si voleva.

Il teorema del prodotto delle probabilità, come nel caso dell'addizione, è facilmente

estendibile al caso di più variabili, applicando le stesse considerazioni fatte nel caso di due

variabili.

Esiste anche un'altra formulazione di questo teorema, che va sotto il nome di teorema

delle probabilità composte.

1.3.4

Teorema delle probabilità composte

Un altro modo per esprimere il teorema di moltiplicazione delle probabilità è rappresentato

dal teorema delle probabilità composte.

Tale teorema può essere enunciato nel modo seguente: la probabilità del prodotto di due

eventi è uguale al prodotto della probabilità di uno degli eventi per la probabilità

condizionata dell'altro cioè, come si è visto, la probabilità del secondo evento, calcolata a

condizione che il primo abbia luogo:

p( A ∩ B) = p( A ) ⋅ p(B A ) = p(B) ⋅ p( A B) .

(1.10)

Si dimostra questo teorema per gli eventi che si riducono a uno schema di casi. Si

supponga che i risultati possibili della prova si riducano a n casi indicati con n punti:

k ∈B

m∈A

…………….

l ∈ AB

n

Si supponga che m casi siano favorevoli all’evento A e k casi all’evento B ; non essendo

A e B supposti incompatibili, si ammette che esistano, in generale, dei casi favorevoli

all’evento A e all’evento B simultaneamente.

11

1 – Calcolo delle probabilità e teorema di Bayes

________________________________________________________________________________________________

Sia l il numero di tali casi. Allora:

l

n

m

p(A ) = .

n

p(AB ) =

(1.11)

Si calcola p(B A ), vale a dire la probabilità dell’evento B , a patto che A sia verificato. Se è

noto che l’evento A ha avuto luogo, degli n casi possibili all’inizio della prova rimangono

possibili solo quegli m casi che sono favorevoli all’evento A , essendo l di questi m casi

favorevoli all’evento B . Di conseguenza:

l

p(B A ) = .

(1.12)

m

Sostituendo le espressioni di p(AB ), p( A ) e p(B A ) nella formula (1.10), si ottiene

un’identità. Il teorema è dimostrato.

È evidente che applicando il teorema di moltiplicazione, l’ordine del susseguirsi degli

eventi A e B non ha nessuna importanza e si può scrivere questo teorema come segue:

p(AB ) = p(B ) p(A B ) .

(1.13)

Si noti che se gli eventi A e B sono mutuamente escludentisi, la probabilità condizionata

si annulla per definizione, mentre se gli eventi sono indipendenti si ha che p(B A ) = p(B) e

analogamente p( A B) = p( A ) ; da questo ultimo caso discende un 1° corollario molto

importante: la probabilità del prodotto di due eventi indipendenti è uguale al prodotto delle

probabilità di questi eventi:

(1.14)

p( A ∩ B) = p( A ) ⋅ p(B) .

Come visto, il corollario segue immediatamente dalla definizione di eventi indipendenti.

Inoltre: se l’evento A è indipendente dall’evento B , anche l’evento B è indipendente da

A . Questo 2°corollario può essere così dimostrato.

È noto che l’evento A non dipende da B , cioè:

p(A ) = p(A B ) .

(1.15)

Si richiede di dimostrare che l’evento B è indipendente anch’esso da A , cioè:

p(B ) = p(B A ) .

12

(1.16)

1 – Calcolo delle probabilità e teorema di Bayes

___________________________________________________________________________________________________________

Per la dimostrazione si supponga p(A ) ≠ 0 .

Si scrive il teorema di moltiplicazione nelle due forme:

p(AB ) = p(A ) p(B A )

p(AB ) = p(B ) p(A B )

(1.17)

da cui:

p(A ) p(B A ) = p(B ) p(A B )

(1.18)

o, in accordo con la condizione (1.15):

p(A ) p(B A ) = p(B ) p(A ) .

(1.19)

dividendo ambedue i membri dell’uguaglianza (1.19) per p(A ) , si ottiene:

p(B A ) = p(B ) ,

(1.20)

ciò che volevasi dimostrare.

Da questo corollario segue che la dipendenza o l’indipendenza degli eventi sono sempre

reciproche. Ciò premesso si può dare una nuova definizione di eventi indipendenti: due

eventi si dicono indipendenti se il verificarsi di uno dei due non altera la probabilità di

realizzazione dell’altro.

La nozione di indipendenza di eventi può essere estesa a un numero qualsiasi di eventi.

Più eventi sono detti mutuamente indipendenti se nessuno di essi dipende da tutto

l’insieme degli altri.

Il teorema può essere generalizzato al caso di un numero qualsiasi di eventi. Nella forma

generale esso si enuncia nel modo seguente: la probabilità del prodotto di più eventi è

uguale al prodotto delle probabilità di questi eventi, essendo calcolata la probabilità di

ciascun i-esimo evento, a condizione che tutti gli i-1 eventi si siano verificati:

(

)

p A 1A 2 ...A n = p(A 1 ) p(A 2 A 1 ) p(A 3 A 1A 2 )...p(A n A 1A 2 ...A n−1 ) .

(1.21)

Questa formula può essere dimostrata con lo stesso metodo di induzione adottato in

precedenza.

Per gli eventi indipendenti il teorema si semplifica e assume la forma:

p(A 1A 2 ...A n ) = p(A 1 ) p(A 2 )...p(A n ) ,

(1.22)

cioè: la probabilità del prodotto di eventi indipendenti è uguale al prodotto delle probabilità

di questi eventi.

13

1 – Calcolo delle probabilità e teorema di Bayes

________________________________________________________________________________________________

Usando il segno del prodotto, si può scrivere questo teorema come segue:

n

n

p ∏ A i = ∏ p(A i ).

i =1 i =1

Consideriamo alcuni esempi di applicazione del teorema.

Esempio 1

Un'urna contiene 2 palline bianche e 3 palline rosse. Si estraggono due

palline dall'urna. Trovare la probabilità che le due palline estratte siano

entrambe bianche.

Si denoti con A l'evento “apparizione di due palline bianche”. L'evento A è il

prodotto di due eventi elementari:

A = A1A 2

dove A 1 rappresenta l'apparizione della pallina bianca alla prima estrazione

e A 2 è la probabilità di ottenere la pallina bianca alla seconda estrazione.

In virtù del teorema delle probabilità composte si ha:

p( A ) = p( A 1 ) p( A 2 A 1 ) = ( 2 ) × ( 1 ) = 0.1

5

4

Si consideri la stessa situazione in cui dopo la prima estrazione, la pallina

estratta viene rimessa nell'urna (si parla allora di estrazione con

reintroduzione); in questo caso gli eventi A 1 e A 2 sono indipendenti e, per il

corollario, si ha:

p( A ) = p( A 1 ) p( A 2 ) = ( 2 ) × ( 2 ) = 0.16 .

5

5

Esempio 2

Nelle applicazioni pratiche, in generale, l’evento la cui probabilità si

determina, viene rappresentato come una somma di più eventi incompatibili

(varianti dell’evento in esame), ciascuno di essi essendo, a sua volta, un

prodotto di eventi.

Tre colpi siano sparati successivamente su un bersaglio. La probabilità di

colpire il bersaglio al primo, al secondo e al terzo colpo è uguale,

rispettivamente, a p1 = 0.4 , p 2 = 0.5 e p 3 = 0.7 . Determinare la probabilità

che di questi tre colpi uno vada esattamente a centro.

14

(1.23)

1 – Calcolo delle probabilità e teorema di Bayes

___________________________________________________________________________________________________________

Si consideri un evento A “esattamente un colpo va a centro”. Questo evento

può verificarsi in modi diversi, cioè si decompone in più varianti incompatibili.

Si denotino con A1, A 2 , A 3 gli eventi che consistono nel colpire il bersaglio,

rispettivamente, al primo, al secondo e al terzo colpo e A 1 , A 2 ,A 3 gli eventi

che consistono nel mancare il bersaglio rispettivamente al primo, secondo e

terzo colpo. Di conseguenza:

A = A 1 A 2 A 3 + A 1A 2 A 3 + A 1 A 2 A 3 .

Usando i teoremi di addizione e moltiplicazione degli eventi e tenendo conto

delle proprietà degli eventi contrari si trova:

p( A ) = p( A 1 A 2 A 3 ) + p( A 1A 2 A 3 ) + p( A 1 A 2 A 3 ) =

= 0.4 ⋅ 0.5 ⋅ 0.3 + 0.6 ⋅ 0.5 ⋅ 0.3 + 0.6 ⋅ 0.5 ⋅ 0.7 = 0.36.

Esempio 3

Nelle condizioni dell’esempio precedente si trovi la probabilità che almeno un

colpo vada a centro.

Si consideri l’evento B “almeno un colpo va a centro”.

Usando il procedimento e le notazioni dell’esempio precedente si può

rappresentare l’evento B come una somma di varianti incompatibili:

B = A 1 A 2 A 3 + A 1A 2 A 3 + A 1 A 2 A 3 + A 1A 2 A 3 + A 1 A 2 A 3 + A 1A 2 A 3 + A 1 A 2 A 3

Occorre dunque trovare mediante il teorema di moltiplicazione la probabilità

di ciascuna delle varianti e sommarle. Tuttavia questo procedimento è troppo

complicato; qui è più opportuno passare dall’evento B al suo contrario B ,

“nessun colpo va a centro”.

É evidente che:

B = A1 A 2 A 3 .

Per il teorema di moltiplicazione:

p(B) = p( A 1 A 2 A 3 ) = 0.6 ⋅ 0.5 ⋅ 0.3 = 0.09

da cui:

p(B) = 1 − p(B) = 1 − 0.09 = 0.91 .

15

1 – Calcolo delle probabilità e teorema di Bayes

________________________________________________________________________________________________

L’ultimo esempio è un’illustrazione dell’opportunità di applicare gli eventi

contrari in teoria delle probabilità, che si enuncia nel modo seguente: se

l’evento contrario A si decompone in un numero più piccolo di varianti

dell’evento A , è opportuno, calcolando le probabilità, passare all’evento

contrario.

1.4.4 Teorema di Bayes

Esso si ricava semplicemente a partire dai teoremi finora illustrati; si osservi infatti che,

dati due eventi A e B qualsiasi, è possibile esprimere A come:

(

A = (A ∩ B ) ∪ A ∩ B

)

(1.24)

per cui:

(

)

( ) ()

( )

p(A ) = p(A ∩ B ) + p A ∩ B = p(A B ) p(B ) + p A B p B = p(A B ) p(B ) + p A B [1 − p(B )]

(1.25)

Si ricorre ad un esempio per chiarire il concetto: si suppone che una popolazione sia

predisposta ad essere attaccata da un virus per il 30%, mentre ovviamente il restante 70%

è più forte dal punto di vista immunitario. Si sa da indagini statistiche che tra gli individui

predisposti se ne ammalano annualmente il 50%, mentre tra quelli più forti il 20%. Qual è

la probabilità che un individuo qualsiasi si ammali?

Sia A l’evento “un individuo si ammala” e B l’evento “un individuo è predisposto”. Si ha:

( )( )

( )

p(A ) = p(A B )p(B ) + p A B p B = p(A B )p(B ) + p A B [1 − p(B )] = 0.5 * 0.3 + 0.2 * 0.7 = 0.29

che è la probabilità che un individuo qualsiasi si ammali.

Si riscrive l’espressione della probabilità condizionata, tenendo conto della definizione

data in precedenza e dell’espressione (1.25):

p(B A ) =

p(A B ) p(B )

p(B ∩ A )

=

p(A )

p(A B ) p(B ) + p A B p B

( ) ()

(1.26)

Come esempio, si immagini che un’analisi sia affidabile al 95%, cioè dia risultati positivi se

un individuo è malato per il 95% e ugualmente risultati positivi se l’individuo è sano per il

restante 5%. E’ noto che la malattia è diffusa tra la popolazione al 1%. Si calcoli la

probabilità che il soggetto sia malato a condizione che il risultato sia positivo.

Sia A l’evento “risultato positivo dell’analisi” e sia B l’evento “individuo effettivamente

malato”.

16

1 – Calcolo delle probabilità e teorema di Bayes

___________________________________________________________________________________________________________

Si ha:

p(B A ) =

p(A B )p(B )

( )( )

p(A B )p(B ) + p A B p B

=

0.95 * 0.01

= 0.16 .

0.95 * 0.01 + 0.05 * 0.99

La formula può essere generalizzata e si ottiene quello che comunemente viene chiamato

Teorema di Bayes:

(

p(A B ) p(B )

) p(Bpj(A∩)A ) = n j j .

∑ p(A B i ) p(B i )

p Bj A =

1

17

(1.27)