MEDIA CONDIZIONATA

E. DI NARDO

1. Media condizionata da un evento

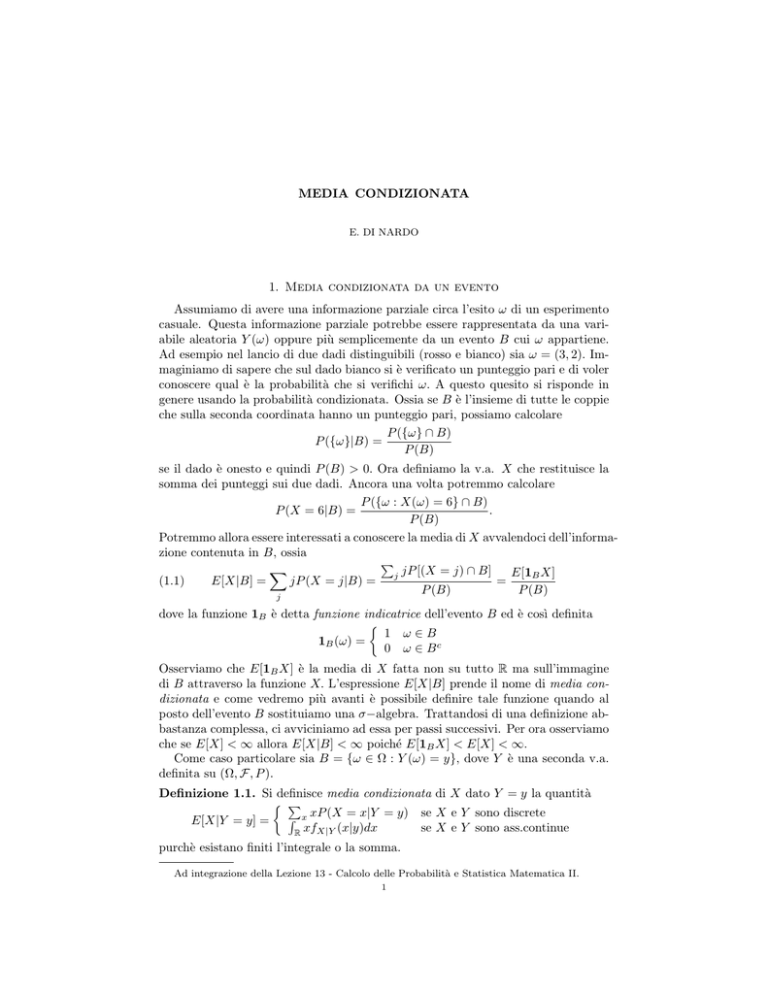

Assumiamo di avere una informazione parziale circa l’esito ω di un esperimento

casuale. Questa informazione parziale potrebbe essere rappresentata da una variabile aleatoria Y (ω) oppure più semplicemente da un evento B cui ω appartiene.

Ad esempio nel lancio di due dadi distinguibili (rosso e bianco) sia ω = (3, 2). Immaginiamo di sapere che sul dado bianco si è verificato un punteggio pari e di voler

conoscere qual è la probabilità che si verifichi ω. A questo quesito si risponde in

genere usando la probabilità condizionata. Ossia se B è l’insieme di tutte le coppie

che sulla seconda coordinata hanno un punteggio pari, possiamo calcolare

P ({ω} ∩ B)

P ({ω}|B) =

P (B)

se il dado è onesto e quindi P (B) > 0. Ora definiamo la v.a. X che restituisce la

somma dei punteggi sui due dadi. Ancora una volta potremmo calcolare

P ({ω : X(ω) = 6} ∩ B)

P (X = 6|B) =

.

P (B)

Potremmo allora essere interessati a conoscere la media di X avvalendoci dell’informazione contenuta in B, ossia

P

X

E[1B X]

j jP [(X = j) ∩ B]

=

(1.1)

E[X|B] =

jP (X = j|B) =

P (B)

P (B)

j

dove la funzione 1B è detta funzione indicatrice dell’evento B ed è cosı̀ definita

1 ω∈B

1B (ω) =

0 ω ∈ Bc

Osserviamo che E[1B X] è la media di X fatta non su tutto R ma sull’immagine

di B attraverso la funzione X. L’espressione E[X|B] prende il nome di media condizionata e come vedremo più avanti è possibile definire tale funzione quando al

posto dell’evento B sostituiamo una σ−algebra. Trattandosi di una definizione abbastanza complessa, ci avviciniamo ad essa per passi successivi. Per ora osserviamo

che se E[X] < ∞ allora E[X|B] < ∞ poiché E[1B X] < E[X] < ∞.

Come caso particolare sia B = {ω ∈ Ω : Y (ω) = y}, dove Y è una seconda v.a.

definita su (Ω, F, P ).

Definizione 1.1. Si definisce media condizionata di X dato Y = y la quantità

P

R x xP (X = x|Y = y) se X e Y sono discrete

E[X|Y = y] =

xfX|Y (x|y)dx

se X e Y sono ass.continue

R

purchè esistano finiti l’integrale o la somma.

Ad integrazione della Lezione 13 - Calcolo delle Probabilità e Statistica Matematica II.

1

2

E. DI NARDO

Se X è un vettore casuale, si pone per definizione

E[X|Y = y] ≡ (E[X1 |Y = y], E[X2 |Y = y], . . . , E[Xn |Y = y]).

1.1. Proprietà. Il valor medio condizionato E[X|Y = y] gode di una serie di

proprietà che ora andremo ad illustrare. Dimostreremo queste proprietà nel caso

le v.a. sono assolutamente continue. In maniera analoga si può dimostrare che

valgono per v.a. discrete. Nel seguito faremo riferimento ad una funzione g : R → R

Borel-misurabile.

i) indipendenza Se X e Y sono indipendenti allora E[X|Y = y] = E[X].

Infatti

Z

Z

E[X|Y = y] =

xfX|Y (x|y)dx =

xfX (x)dx = E[X].

R

R

Se Z è indipendente da (X, Y ) allora E[ZX|Y = y] = E[Z]E[X|Y = y].

Infatti

E[ZX|Y = y] =

Z

Z

fXY Z (x, y, z)

dxdz

=

zxfZ,X|Y (z, x|y)dxdz =

zx

fY (y)

R2

R2

Z

Z

Z

fXY (x, y)fZ (z)

fXY (x, y)

=

zx

dxdz =

zfZ (z)dz x

dx

fY (y)

fY (y)

R2

R

R

Z

= E[Z] xfX|Y (x|y)dx

R

ii) stabilità E[g(Y ) X|Y = y] = g(y)E[X|Y = y].

Infatti

Z

Z

E[g(Y ) X|Y = y] =

g(y)xfX|Y (x|y)dx = g(y) xfX|Y (x|y)dx.

R

R

In particolare risulta E[g(Y )|Y = y] = g(y).

iii) costanti E[c|Y = y] = c, c ∈ R.

Infatti

Z

Z

E[c|Y = y] =

cfX|Y (x|y)dx = c fX|Y (x|y)dx = c.

R

R

iv) linearità E[cX + dZ|Y = y] = cE[X|Y = y] + dE[Z|Y = y] dove X, Y e

Z sono v.a. congiuntamente distribuite e c e d sono costanti reali.

=

=

=

=

E[cX + dZ|Y = y] =

Z

(cx + dz)fX,Z|Y (x, z|y)dxdz

R2

Z

Z

c

xfX,Z|Y (x, z|y)dxdz + d

zfX,Z|Y (x, z|y)dxdz

2

R2

ZR

Z

Z

Z

c xdx fX,Z|Y (x, z|y)dz + d zdz fX,Z|Y (x, z|y)dx

R

R

R

ZR

Z

c xfX|Y (x|y)dx + d zfZ|Y (z|y)dz

R

R

avendo fatto uso delle relazioni

Z

Z

fXY Z (x, y, z)

fY,Z (y, z)

dx =

= fZ|Y (z|y)

fX,Z|Y (x, z|y)dx =

f

(y)

fY (y)

Y

R

R

MEDIA CONDIZIONATA

Z

Z

fX,Z|Y (x, z|y)dz =

R

R

3

fXY Z (x, y, z)

fX,Y (x, y)

dz =

= fX|Y (x|y).

fY (y)

fY (y)

2. Media condizionata da una variabile aleatoria

Al variare di y nell’insieme dei valori assunti da Y, la media condizionata E[X|Y =

y] può essere riguardata come una funzione della v.a. Y. Quando ci si riferisce a

questo caso, si scrive E[X|Y ]. Per tale funzione sussiste il problema di capire se

è F−misurabile e di determinare le proprietà di cui gode. A questo scopo, introdurremo prima il concetto di media condizionata da una σ−algebra e poi faremo

vedere come E[X|Y ] possa essere ricondotta a questa nozione.

2.1. Media condizionata da una σ−algebra finitamente generata. Si consideri una partizione dello spazio campione Ω negli eventi B1 , B2 , . . . , Bn e sia G la

σ−algebra generata da tali eventi, ossia

G = {∪i∈I Bi : I ⊆ {1, 2, . . . , n}} .

Si ha G ⊆ F. Sia X una v.a. che possiede media finita. Definiamo una nuova v.a.

al seguente modo

(2.1)

E[X|G](ω) =

n

X

E[X|Bi ]1Bi (ω).

i=1

Per comprendere la formula precedente, pensiamo ad un punto campionario ω selezionato a caso in Ω in accordo alla misura di probabilità P. Lo sperimentatore

non conosce esattamente il valore di ω ma solo come è fatto l’insieme Bi nel quale ω

può cadere. Pertanto calcola il valore medio di X in accordo a questa informazione

parziale. Il punto fondamentale è che la v.a. E[X|G] gode della seguente proprietà:

E[1A X] = E[1A E[X|G]] ∀A ∈ G.

(2.2)

Non solo, ma E[X|G] è l’unica funzione G−misurabile che ha questa proprietà o

meglio, qualsiasi altra funzione che gode di questa proprietà, è q.c. uguale a E[X|G]

e viene chiamata versione della media condizionata. Per comprendere il significato

della (2.2), riscriviamola usando la proprietà di linearità dell’operatore media:

E[1A (X − E[X|G])] = 0 ∀A ∈ G;

se all’osservatore, in possesso delle informazioni contenute in Bi , è data l’opportunità

di scommettere sull’evento A, pagando una somma iniziale pari a E[X|G] e vincendo

una somma pari a d X, la proprietà dice che il gioco è equo. In realtà questa proprietà ha anche un altro significato in teoria della misura, ma lo vedremo più avanti,

quando complicheremo la struttura di G. Verifichiamo la (2.2),Possia mostriamo che

n

la v.a. costruita in (2.1) gode della proprietà (2.2). Sia Z = i=1 E[X|Bi ]1Bi (ω).

Z è G−misurabile (somma finita di funzioni misurabili). Se A ∈ G esiste k ≤ n e

j1 , j2 , . . . , jk ∈ {1, 2, . . . , n} tali che A = ∪kt=1 Bjt e quindi

" k

#

" k

#

X

X E[1Bj X]

t

1B j t

E[1A Z] = E

E[X|Bjt ]1Bjt = E

P (Bjt )

t=1

t=1

=

k

X

E[1Bjt X]

E[1Bjt ] = E[1A X]

P (Bjt )

t=1

4

E. DI NARDO

Pk

poiché E[1Bjt ] = 1P (Bjt ) + 0P (Bjct ) e t=1 1Bjt = 1A . Si assuma ora che Z 0 sia

una funzione G−misurabile tale che E[1A X] = E[1A Z 0 ]. Essendo G−misurabile

può assumere solo un numero finito di valori (se ne assumesse infiniti, l’unione

delle

a G che è finita), ossia Z 0 =

Pn controimmagini di tali valori non apparterrebbe

0

i=1 ci 1Bi . Scegliendo in E[1A X] = E[1A Z ] l’evento A = Bi segue che

E[1Bi X] = ci E[1Bi ] = ci P (Bi )

ma

E[1Bi Z] = E[X|Bi ]P (Bi )

da cui ci = E[X|Bi ] per ogni Bi e quindi P (Z = Z 0 ) = 1. L’ipotesi E[X] < ∞ è

evidentemente sufficiente affinchè E[X|G] < ∞ poichè se E[X] < ∞ allora E[X|Bi ],

come rapporto di due quantità finite, è finita.

Osservazione 2.1. Se G = {∅, Ω} allora E[X|G](ω) = E[X|Ω]1Ω (ω) = E[X].

Osservazione 2.2. Se F = G e X(ω) = xi per ω ∈ Bi allora per ω ∈ Bi

E[X|G](ω) = E[X|Bi ]1Bi (ω) =

E[1Bi X]

xi E[1Bi ]

=

= xi

P (Bi )

P (Bi )

q.c.

e dunque E[X|G] = X.

Teorema 2.3. Si ha E[E[X|G]] = E[X].

Proof. Infatti

E[E[X|G]] =

n

X

E[X|Bi ]E[1Bi (ω)] =

n

X

E[X1Bi ] = E[X1Ω ].

i=1

i=1

Questa proprietà viene anche detta proprietà della media.

Osservazione 2.4. Se scegliamo come v.a. X = 1A , dove A ∈ F, allora

E[1A |G](ω) =

n

X

E[1A 1Bi ]

1Bi (ω)

P (Bi )

i=1

ed essendo E[1A 1Bi ] = 1P (A ∩ Bi ) + 0P (A ∩ Bic ) segue che

(2.3)

E[1A |G](ω) =

n

X

P (A ∩ Bi )

i=1

P (Bi )

1Bi (ω) =

n

X

P (A|Bi )1Bi (ω)

i=1

dove l’ultima espressione viene detta probabilità condizionata dell’evento A dalla

σ−algebra G e indicata con il simbolo P (A|G). In particolare si ha

E[P (A|G)] = P (A)

una sorta di analogo del teorema delle probabilità totali, come mostrato nel seguito.

Basta infatti applicare l’operatore E al primo e secondo membro della (2.3)

E(P [A|G]) =

n

X

i=1

P (A|Bi )E[1Bi ] =

n

X

i=1

P (A|Bi )P (Bi ) = P (A).

MEDIA CONDIZIONATA

5

Osservazione

P 2.5. Assumiamo che Y sia una v.a. tale che Y (ω) = yi per ω ∈ Bi ,

ossia Y = i yi 1Bi . Consideriamo la σ−algebra generata da Y, ossia

σ(Y ) = {Y −1 (B) : B ∈ B(R)}.

In tal caso σ(Y ) = G, poichè le controimmagini di un borelliano sono tutte e sole

le unioni di elementi in B1 , . . . , Bn . In tal caso si scrive

E[X|G] = E[X|σ(Y )] = E[X|Y ].

Nel paragrafo successivo, complicheremo la struttura di G in modo che sia possibile dare significato a E[X|Y ] attraverso l’uso di E[X|σ(Y )], qualsiasi sia σ(Y ) e

quindi qualsiasi sia Y.

Osservazione 2.6. Analoghi risultati possono essere formulati quando la σ−algebra

è generata da una partizione numerabile di Ω. In termini di v.a., questo equivale

a considerare il caso in cui la v.a. Y assume una infinità numerabile di valori. Si

tratta di sostituire il simbolo di somma con quello di serie nella (2.1):

(2.4)

E[X|G](ω) =

∞

X

E[X|Bi ]1Bi (ω).

i=1

3. Media condizionata da una sigma-algebra generale

(Prima di leggere questo paragrafo, è necessario leggere l’appendice del capitolo

sul teorema di Radon-Nykodim). Per poter dare la definizione di media condizionata da una sigma-algebra qualsiasi, effettuiamo la seguente osservazione. Dallo

spazio di probabilità (Ω, F, P ), la σ−algebra G ⊂ F eredita una misura, la misura

P ristretta a G. Definiamo ora una nuova misura M su G al seguente modo:

Z

M(A) =

X dP = E[1A X].

A

Affinché valga la proprietà (2.2) anche quango G ha una struttura più generale di

quella vista nel paragrafo precedente, deve accadere che

Z

M(A) = E[1A X] =

E[X|G] dP = E[1A E[X|G]]

A

ossia M ammette derivata di Radon-Nikodym rispetto a P e tale derivata è proprio E[X|G]. Che M ammetta derivata di Radon-Nikodym rispetto a P è una

conseguenza del teorema di Radon-Nikodym poiché M è una misura di densità

X rispetto a P e quindi M P. Inoltre il teorema di Radon-Nikodym assicura

l’unicità di tale derivata a meno di insiemi di misura nulla rispetto a P.

Per semplicità indicheremo la misura M con il simbolo E[1• X].

Definizione 3.1. Sia X una v.a. a media finita sullo spazio di probabilità (Ω, F, P )

e sia G una σ−algebra contenuta in F. La media condizionata di X dato G, che

verrà indicata con E[X|G], è la derivata di Radon-Nykodym della misura di densità

X rispetto a P, ossia

dE[1• X]

.

dP

Tutto sommato, dal punto di vista simbolico, questa definizione non si discosta

molto da quella da cui siamo partiti (1.1).

(3.1)

E[X|G] =

6

E. DI NARDO

Osservazione 3.2. Viene da chiedersi quale sia la necessità di ricorrere ad uno strumento cosı̀ sofisticato come E[X|G] per avere informazioni sulla X: in fondo E[X|G]

restituisce il comportamento medio di X su G, ma se si conoscono le controimmagini

attraverso la X in F a maggior ragione si conoscono le controimmagini attraverso

la X in G. In realtà è proprio questo il punto delicato: in molti esperimenti casuali, può essere difficile caratterizzare la legge di probabilità della v.a. X, mentre

è molto più facile avere a disposizione delle informazioni parziali sull’esperimento,

rappresentabili mediante una sotto σ−algebra.

Se A ∈ F, la probabilità condizionata di A dato G è definita come

P (A|G) = E[1A |G]

in accordo a quanto si era già osservato nel paragrafo precedente. In particolare

scegliendo A = Ω dalla proprietà (2.2) segue

E[X] = E[E[X|G]]

e P (A) = E[P (A|G)], essendo

E[P (A|G)] = E {E[1A |G]} = E[1A ] = P (A).

Il seguente lemma è una riformulazione dell’esistenza ed unicità della derivata di

Radon-Nykodim.

Lemma 3.3. Sia X una v.a. a media finita e G una sotto σ-algebra di F. Se Z è

una v.a. che soddisfa le seguenti proprietà

(1) Z è G-misurabile;

(2) E[1A X] = E[1A Z] per ogni A ∈ G

q.c.

allora Z = E[X|G].

q.c.

Osservazione 3.4. Dal lemma 3.3 segue che se G = F allora E[X|F] = X.

È interessante osservare che nel caso in cui G sia finitamente generata, la definizione (3.1) coincide con

P (2.1). Nel paragrafo precedente abbiamo infatti dimostrato

che la v.a. Z =

i E[X|Bi ]1Bi è G-misurabile e verifica la (2) del lemma 3.3,

pertanto è una versione di E[X|G].

Osservazione 3.5. È ora possibile dare significato alla scrittura E[X|Y ] = E[X|σ(Y )]

qualsiasi sia la struttura di σ(Y ) e quindi qualsiasi sia la v.a. Y. Non resta che

chiarire il legame tra E[X|Y ] e E[X|Y = y]. Supponiamo che (X, Y ) ammetta

densità congiunta e scriviamo

cX (y) = E[X|Y = y].

Allora cX [Y (ω)] è una versione di E[X|Y ](ω) come si può facilmente dimostrare

usando il lemma 3.3. Basta infatti dimostrare che per la v.a. cX (Y ) valgono

le ipotesi del lemma. Preso in fatti A ∈ σ(Y ) esiste un borelliano U tale che

1A = 1U (Y ). Pertanto

Z

E[cX (Y )1A ] = E[cX (Y )1U (Y )] =

cX (y)1U (y)fY (y)dy

R

Z

Z

f (x, y)

fY (y)dy

=

1U (y)

x

fY (y)

ZR Z

=

x1U (y)f (x, y)dxdy = E[X1U (Y )] = E[X1A ].

MEDIA CONDIZIONATA

7

L’ipotesi che (X, Y ) ammette densità congiunta si può comunque indebolire.

Quella che segue è detta proprietà della torre della media condizionata 1.

Teorema 3.6. Sia X una v.a. a media finita e siano G ed A due sotto σ−algebre

tali che G ⊂ A. Allora E[E[X|A]|G] = E[X|G].

Proof. Sia B un evento arbitrario scelto in G. Poiché G è contenuto in A allora B appartiene anche ad A pertanto si ha E[1B E[X|A]] = E[1B X] ed anche

E[1B E[X|G]] = E[1B X], ossia

E[1B E[X|G]] = E[1B E[X|A]].

Allora E[X|G] soddisfa la condizione (2) del lemma 3.3, con X rimpiazzato da

E[X|A]. Poiché E[X|G] è G−misurabile, segue l’asserto.

Questa proprietà è molto utile quando A rappresenta un raffinamento di G.

Supponiamo infatti che G sia una σ−algebra generata da una partizione finita di

Ω ed A sia sia una σ−algebra generata da una partizione finita di Ω piú fine della

precedente. In tal caso E[X|G] viene calcolato effettuando una media sugli insiemi

della partizione che generano G. Poiché un insieme della partizione che genera G è

unione di insiemi della partizione che genera A, il teorema dice che calcolare E[X|A]

su un insieme della partizione che genera G equivale alla media di X effettuata su

questo insieme.

Proposizione 3.7. Risulta

q.c.

i) Se X = a con a ∈ R allora E[X|G] = a;

ii) E[aX + bY |G] = aE[X|G] + bE[Y |G];

iii) se G è indipendente da X allora E[X|G] = E[X].

Proof. La funzione identicamente uguale ad a soddisfa le condizioni (1) e (2) del

lemma 3.3 da cui l’asserto i). L’asserto ii) segue dalle proprietà di linearità dell’integrale di Stieltjies. L’ultimo asserto segue dalla osservazione che se X è indipendente

da G, per ogni A ∈ G si ha E[X1A ] = E[X]E[1A ] = E[1A E[X]]. Poiché E[X] è G

misurabile dal lemma 3.3 segue l’asserto.

4. Applicazioni

Le medie condizionnate sono molto importanti in analisi della regressione. Date

due v.a. X e Y la funzione cX (Y ) = E[X|Y ] è detta funzione di regressione di X

su Y. La funzione cX (Y ) è una stima di X usando le informazioni disponibili su Y.

Quanto buona è questa stima? Il teorema che segue (senza dim.) dice che E[X|Y ]

minimizza l’errore quadratico medio.

Teorema 4.1. Sia X una v.a. con varianza finita e sia G una sotto σ−algebra.

Allora

E (X − E[X|G])2 = inf E[(X − Z)2 ], Z v.a. a varianza finita su (Ω, F, P ) .

1Non daremo tutte le proprietà di cui gode la media condizionata perché le relative dimostrazioni necessitano di nozioni di Analisi V, che non avete inserito nel vostro piano di studi.

Chi fosse interessato ad approfondimenti può comunque consultare Probability and Measure di P.

Billinsley (1995).

8

E. DI NARDO

Altro campo di applicazione della media condizionata è la teoria delle martingale.

Sia X1 , X2 , . . . una successione di v.a. definite sullo stesso spazio di probabilità

a media finita. Sia F1 , F2 , . . . una successione di sotto σ−algebre di F tali che

Fn ⊂ Fn+1 (in tal caso si dice che la successione costituisce una filtrazione).

Definizione 4.2. La successione {Xn } si dice una martingala se Xn è Fn -misurabile

ed inoltre E[Xn+1 |Fn ] = Xn .

La teoria delle martingale ha una prima immediata applicazione nella teoria dei

giochi. Se Xn rappresenta il capitale in possesso del giocatore e Fn rappresenta

l’informazione in possesso del giocatore alla giocata n−esima, allora l’essere Xn

una martingala assicura che il gioco è equo. Un classico esempio di martingala è la

somma di v.a. indipendenti a media nulla.

5. Appendice: Teorema di Radon-Nikodym

Supponiamo di avere uno spazio di misura (Ω, F, µ) e una funzione f non negativa definita su tale spazio. Quando

P f è una funzione semplice non-negativa,

ossia può rappresentarsi come f = i ci 1Ei dove E1 , E2 , · · · , En costituisce una

partizione di Ω, allora

Z

X

def

f dµ =

ci µ(A ∩ Ei ).

A

i

In caso contrario, si pone

Z

Z

def

f dµ = sup

g∈G

A

g dµ

A

dove G = {g funzioni semplici e non negative tali che g ≤ f }. Si può dimostrare

che

Z

(5.1)

ν(A) =

f dµ, A ∈ F

A

definisce un’altra misura su F. Quando una misura è definita mediante la (5.1) si

usa dire che ν ha densità f rispetto a µ.

Dalla (5.1) segue che, per ogni A ∈ F per il quale risulta µ(A) = 0, si ha

ν(A) = 0. Ebbene il teorema di Radon-Nikodym prova che, se è vera questa ultima

condizione, allora ν ha una densità rispetto a µ, che viene denominata derivata di

Radon-Nikodym di ν rispetto a µ.

Più precisamente sia µ una misura positiva su uno spazio misurabile (Ω, F). Sia

ν una misura segnata, ossia una misura che assume valori reali più ∞ oppure −∞.

La misura ν si dice assolutamente continua rispetto a µ, e si scrive ν µ, se

ν(A) = 0 quando µ(A) = 0. Il teorema di Radon-Nikodym dice che tutte le misure

assolutamente continue rispetto a µ posseggono una densità rispetto a µ

Teorema 5.1 (Teorema di Radon-Nikodym). Sia µ una misura positiva su (Ω, F)

e σ−finita (ossia tale che esiste un ricoprimento numerabile di sottoinsiemi di Ω

appartenenti ad F, ciascuno di misura finita rispetto a µ.) Sia ν una misura assolutamente continua rispetto a µ. Allora esiste una funzione f (F−misurabile) tale

che

Z

ν(A) =

f dµ ∀A ∈ F.

A

Tale funzione è unica a meno di insiemi di misura nulla rispetto a µ, ossia ogni altra

funzione g, risultante densità di ν rispetto a µ, è tale che µ({ω : f (ω) = g(ω)}) = 0.