Appunti dalle lezioni

di

Trasmissioni numeriche II

Teoria del ricevitore ottimo

(Ing. A. Fasano)

1

1. Il problema della decisione

Il problema della rivelazione ottima di segnali numerici immersi in rumore può essere ascritto al

più generale problema della decisione statistica. Ciò in ragione del fatto che dei contributi di

rumore, inevitabilmente presenti, si ha in genere una sola descrizione di tipo statistico

(probabilistico). Il ricevitore in questo senso opera una decisione attuando quella che viene detta

una regola di decisione, cioè una procedura (soddisfacente preassegnati criteri) che sulla base del

segnale ricevuto stabilisce quale tra M possibili segnali distinti è stato trasmesso. Nell’ambito delle

trasmissioni numeriche il criterio che appare (ragionevolmente) più opportuno è quello che conduce

ad una regola di decisione che minimizza la probabilità di errore.

Trattandosi di un criterio applicabile in molti ambiti diversi (non limitato quindi alle sole

trasmissioni numeriche) vogliamo ora derivare la regola di decisione a cui conduce, analizzando il

problema sotto condizioni molto generali.

Sistema Σ

x

r

sk

decisore

sˆ = d (r )

n

disturbi

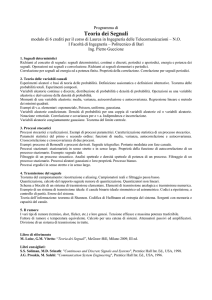

Schema di principio per un problema di decisione

Si supponga di avere un sistema Σ (il nostro trasmettitore ad esempio) che possa trovarsi in uno

(il possibile segnale trasmesso) di M distinti stati s k (k = 1,…, M ) che rappresentano le M possibili

ipotesi H k che possono farsi sul sistema Σ ( H k stato(Σ) = s k ) . Il sistema produce un’uscita x

(funzione del suo stato) non direttamente accessibile e, dopo essersi combinata in vario modo con

possibili disturbi presenti n , produce la grandezza osservabile r che assumiamo essere un vettore

con valori in uno spazio Ω ( Ω ⊆ ℝ N ) detto spazio di osservazione.

Si presume inoltre che sia nota (perché data o calcolabile dal problema) la densità di probabilità

condizionata in avanti pR|S (r | s k ) . Si ammette infine di conoscere le probabilità a priori delle M

ipotesi H k , cioè Pk = Pr { H k } = Pr {stato(Σ) = s k } .

2

Il

decisore

attua

la

cosiddetta

regola

di

decisione

definita

come

la

funzione

d : Ω → {s1 , s 2 ,⋯, s M } che ad ogni vettore osservato r associa la decisione sˆ = d (r ) . Ogni regola

di decisione d (⋅) individua una partizione dello spazio di osservazione Ω in regioni di decisione

Ri ≐ {r ∈ Ω | d (r ) = si } Ri ∩ R j = ∅ per i ≠ j e

M

∪R

i

i =1

= Ω . Viceversa, una partizione di Ω in

regioni Rɶ j ( j = 1,…, M ) definisce una regola di decisione dɶ (⋅) . È quindi evidente che individuare

la regola di decisione d (⋅) è equivalente a determinare le regioni di decisione Ri ( i = 1,… , M ), che

costituiscono una partizione di Ω .

La regola, a sua volta, è individuata una volta specificato il criterio di ottimalità che si decide di

seguire. Nel caso in esame il criterio è la minimizzazione della probabilità media di errore nella

decisione, indicata con Pe . Poiché inoltre Pe = 1 − Pc , dove Pc è la probabilità media di decisione

corretta, il criterio può equivalentemente essere visto in termini di massimizzazione della

probabilità di corretta decisione.

Seguendo questo criterio andiamo ora a determinare le regioni Ri che individuano la

corrispondente regola di decisione.

M

Pc = ∑ Pr {sˆ = si & stato(Σ) = si }

i =1

M

= ∑ Pr {sˆ = si | stato(Σ) = si } Pr {stato(Σ) = si }

i =1

M

= ∑ ∫ [ pR|S (r | si ) ⋅ Pi ]dr

i =1 Ri

M

≤∑

dove f (r ) = max ( pR|S (r | s k ) ⋅ Pk )

∫ f (r)dr

k =1,…, M

i =1 Ri

M

essendo

Ri = Ω e Ri ∩ R j = ∅ i ≠

∪

i =1

= ∫ f (r )dr = cost

Ω

j

Da ciò segue che Pc ≤ ∫ f (r )dr ed il valore costante dell’integrale a secondo membro può essere

Ω

raggiunto se le regioni Ri sono scelte in modo che si abbia

r ∈ Ri

⇒

Pi ⋅ pR|S (r | si ) = f (r ) ≐ max Pk ⋅ pR|S (r | s k )

k =1,…, M

cioè ∀r ∈ Ω assegnando r alla regione Ri per cui è massimo il prodotto Pi ⋅ pR|S (r | si ) . In realtà il

decisore non deve realmente calcolare le regioni Ri ma limitarsi a calcolare per ogni r ricevuto le

3

quantità Pk ⋅ pR|S (r | s k ) per k = 1,… , M e decidere in favore dell’indice k che produce il valore

massimo, cioè

sˆ = d (r ) = arg max Pk ⋅ pR|S (r | s k )

(1)

sk

dove l’operatore “arg max” ritorna l’argomento che massimizza la funzione a cui è applicato (ad

esempio arg max 2 − ( x − 1)2 = 1 )

x∈ℝ

Alla (1) è possibile dare un’altra forma osservando che la massimizzazione è condotta rispetto a

s k ed eventuali fattori non dipendenti da questo sono ininfluenti. Si ha:

sˆ = arg max Pk ⋅ pR|S (r | s k )

sk

P ⋅ p (r | sk )

= arg max k R|S

pR (r )

sk

= arg max PS|R (s k | r )

( pR (r) non dipende da s k )

( teorema di Bayes )

sk

Applicare la regola di decisione (1) equivale quindi a cercare il particolare s k che presenta la

massima probabilità a posteriori PS|R (s k | r ) per fissata osservazione r . Per questa ragione la regola

(1) è nota come decisione a massima probabilità a posteriori o decisione MPA (maximum a

posteriori o MAP in letteratura anglosassone) e con analoga terminologia ci si riferisce al

corrispondente decisore.

Quando le probabilità a priori sono uguali Pk =

1

( ⇔ le ipotesi H k sono equiprobabili) nella

M

(1) si può eliminare Pk (costante rispetto a k) e la regola di decisione diviene

sˆ = arg max pR|S (r | s k )

(ipotesi equiprobabili)

sk

che in generale costituisce una procedura distinta da quella MPA ed alla quale si da il nome di

decisione a massima verosimiglianza o decisione MV (maximum likelihood o ML in letteratura

anglosassone) poiché la densità di probabilità condizionata in avanti pR|S (r | s k ) , vista come

funzione di s k per r fissato, è detta verosimiglianza.

In conclusione la politica di decisione che garantisce la minima probabilità di errore è quella a

massima probabilità a posteriori (è anche detta procedura dell’osservatore ideale) e corrisponde

alla seguente regola

4

sˆ MPA = arg max Pk ⋅ pR|S (r | s k )

(decisione MPA)

sk

Oltre a questa esiste la procedura a massima verosimiglianza che, non facendo uso

dell’informazione a priori sulle ipotesi, in generale non gode di particolari proprietà di ottimo ed è

caratterizzata dalla seguente regola

sˆ MV = arg max pR|S (r | s k )

(decisione MV)

sk

Questa coincide con la decisione MPA nella sola circostanza in cui le ipotesi siano

equiprobabili. Cioè

Ipotesi equiprobabili ⇒ sˆ MV ≡ sˆ MPA

Vale la pena mettere l’accento sul fatto che la decisione MV garantisce la minima probabilità di

errore solo quando coincide con la decisione MPA e questo accade, come detto sopra, quando le

probabilità a priori sono uguali. Quest’ultima tuttavia è un’assunzione frequente nel caso delle

trasmissioni numeriche.

ο

5

2. Cenni sulla rappresentazione discreta di segnali continui

In questo paragrafo daremo brevissimi cenni riguardo alla possibilità di associare a segnali

continui di energia una rappresentazione discreta in termini di una sequenza numerica, con un

numero di termini eventualmente finito o infinito ma al più numerabile. Tale tipo di

rappresentazione poggia le basi sulla teoria degli spazi vettoriali e consente di interpretare o

risolvere geometricamente problemi che coinvolgono segnali.

La classe dei segnali di energia presenta una struttura di spazio vettoriale rispetto alle usuali

operazioni di somma tra segnali e moltiplicazione per uno scalare. Ciò significa che ogni segnale

può essere riguardato alla stregua di un vettore in relazione alle proprietà di cui godono le

operazioni di composizione tra segnali (somma e moltiplicazione per uno scalare) che sono

analoghe, mutatis mutandis, alle corrispondenti proprietà delle operazioni tra vettori di ℝ3 .

L’analogia è in realtà molto stretta nel senso che, come per i vettori di ℝ3 , anche per i segnali è

possibile introdurre il concetto di prodotto scalare che risulta definito come segue

x(t ), y (t ) = ∫

+∞

−∞

x(t ) y (t )dt

(1)

e gode delle stesse proprietà di cui gode il prodotto scalare tra vettori di ℝ3 . In particolar modo due

segnali si diranno ortogonali se risulta x(t ), y (t ) = 0 .

Un aspetto fondamentale dei vettori di ℝ3 è la possibilità, fissati tre versori, di poter

rappresentare qualunque generico vettore in termini delle sue componenti. Nello specifico dette

componenti sono ottenute facendo il prodotto scalare (proiezione) tra il vettore ed il generico

versore .

Volendo estendere tale caratteristica anche allo spazio vettoriale dei segnali di energia nasce

spontaneo considerare quelli che sono possibili candidati ad essere versori e cioè sistemi di segnali

ortonormali. Un insieme di segnali

{ϕ1 (t ),ϕ2 (t ),⋯,ϕ N (t )}

dove N ≤ ∞ è detto un sistema

ortonormale se i suoi componenti hanno energia unitaria e risultano mutuamente ortogonali, cioè

1, k = j

0 , k ≠ j

ϕ k (t ),ϕ j (t ) =

( k , j = 1,2,…) .

(2)

Scelto ora un generico segnale (vettore) di energia x(t ) si calcolino le componenti rispetto a

ciascuno dei possibili “versori” ϕ k (t ) utilizzando il prodotto scalare

xk = x(t ),ϕ k (t ) .

(3)

6

A questo punto è lecito domandarsi se, analogamente a quanto avviene per i vettori di ℝ3 , è

possibile scrivere la seguente uguaglianza (il punto interrogativo evidenzia il quesito)

N

?

x(t ) = ∑ xk ϕk (t ) .

(4)

k =1

Sfortunatamente la risposta è in generale negativa anche prendendo N = ∞ e la ragione di ciò

risiede nel fatto che lo spazio dei segnali di energia ha dimensione non finita. Esistono tuttavia

sistemi ortonormali particolari per cui nella (4) vale l’uguaglianza. In tale circostanza si dice che il

sistema ortonormale è completo per il segnale x(t ) o equivalentemente che è una base completa

per x(t ) e il segnale stesso può essere rappresentato dall’insieme dei suoi coefficienti

{ x1 , x2 ,⋯, xN }

o equivalentemente dal vettore x = [ x1 x2 ⋯ xN ] ∈ ℝ N .

T

L’utilità di tale rappresentazione risulta evidente quando si osserva che è possibile effettuare

operazioni tra segnali per il tramite delle loro rappresentazioni vettoriali.

Si considerino infatti due segnali di energia x(t ) e y (t ) e sia {ψ 1 (t ),ψ 2 (t ),⋯,ψ N (t )} una base

completa per entrambi. Ciò significa che valgono le relazioni

N

∞

x(t ) = ∑ xkψ k (t )

con xk = ∫ x(t )ψ k (t )dt ;

(5)

−∞

k =1

N

∞

y (t ) = ∑ ykψ k (t )

con yk = ∫ y (t )ψ k (t )dt ;

−∞

k =1

indicando inoltre con x = [ x1 x2 ⋯ xN ]

T

e y = [ y1 y2 ⋯ yN ]

T

(6)

i corrispondenti vettori di ℝ N

rappresentativi dei due segnali, si verifica immediatamente che valgono le seguenti relazioni

Ex = ∫

+∞

−∞

Exy = ∫

[ x(t )]

+∞

−∞

2

dt = xT x = x

2

x(t ) y (t )dt = xT y

(7)

(8)

Dimostriamo la (8) visto che la (7) si ottiene da questa ponendo y (t ) = x(t ) .

Si ha infatti

Exy = ∫

+∞

N

N

x

ψ

(

t

)

y jψ j (t ) dt

∑

∑

k

k

−∞

j =1

k =1

−∞

x(t ) y (t )dt = ∫

N

N

+∞

+∞

= ∑∑ xk y j ∫ ψ j (t )ψ k (t )dt

k =1 j =1

N

N

−∞

= ∑∑ xk y jδ k , j

k =1 j =1

1, k = j

δk, j =

0 , k ≠ j

7

N

Exy = ∑ xk yk = xT y .

(9)

k =1

Specializziamo ora quanto detto alla situazione che incontreremo nei paragrafi successivi. Si

immagini di avere un insieme di M ( M < ∞ ) segnali di energia {s1 (t ), s2 (t ),⋯, sM (t )} che assumono

valori non nulli (solo) nell’intervallo [0, T ] . Si è interessati a determinare, ammesso che esista, una

base completa {ψ 1 (t ),ψ 2 (t ),⋯,ψ N (t )} per detto insieme che abbia un numero finito (possibilmente

il minimo) di funzioni.

È possibile provare che detta base esiste sempre ed è caratterizzata da un numero di funzioni

N ≤ M . La si ottiene applicando la procedura di ortogonalizzazione di Gram-Schmidt all’insieme

dei segnali {s1 (t ), s2 (t ),⋯, sM (t )} ed è formata dal minimo numero possibile di funzioni della base.

Se gli M segnali sk (t ) ( k = 1,… , M ) sono linearmente indipendenti risulta N = M , se invece

risultano linearmente dipendenti si avrà N < M . Il parametro N acquista quindi il significato di

dimensione dello spazio di segnali {s1 (t ), s2 (t ),⋯, sM (t )} .

Indicando con {ψ 1 (t ),ψ 2 (t ),⋯,ψ N (t )} la base completa ottenuta dalla procedura di GramSchmidt, si verifica facilmente che a meno di un differente ordinamento dei segnali le funzioni della

base sono date dalle seguenti espressioni

ψ 1 (t ) =

ψ 2 (t ) =

ψ 3 (t ) =

s1 (t )

;

s1 (t )

(10)

s2 (t ) − s2 (t ),ψ 1 (t )

s2 (t ) − s2 (t ),ψ 1 (t )

;

(11)

s3 (t ) − s3 (t ),ψ 2 (t ) − s3 (t ),ψ 1 (t )

s3 (t ) − s3 (t ),ψ 2 (t ) − s3 (t ),ψ 1 (t )

;

(12)

⋮ ⋮ ⋮

N −1

ψ N (t ) =

sN (t ) − ∑ sN (t ),ψ k (t )

k =1

N −1

.

(13)

sN (t ) − ∑ sN (t ),ψ k (t )

k =1

Individuata quindi la base completa tramite la procedura sopra descritta ad ogni segnale sk (t )

( k = 1,… , M ) risulta associato un vettore s k = [ sk(1) sk(2) ⋯ sk( N ) ]T appartenente allo spazio euclideo

ℝ N , le cui componenti sono calcolate come segue

8

T

sk( j ) = sk (t ),ψ j (t ) = ∫ sk (t )ψ j (t )dt

(14)

0

Ciascun vettore s k può essere inoltre interpretato come punto di ℝ N e l’insieme degli M punti

nello spazio ad N dimensioni prende il nome di costellazione di segnale e fornisce un utile

strumento geometrico per analizzare le tecniche di modulazione. Si rammenta in conclusione che

un’applicazione della (7) e della (8) alla circostanza in esame porta a scrivere senza difficoltà le

seguenti relazioni

Ek = ∫ [ sk (t ) ] dt = s k

T

2

0

2

= s Tk s k ,

T

Ekj = ∫ sk (t ) s j (t )dt = s Tk s j ,

0

∫

T

0

2

sk (t ) − s j (t ) dt = s k − s j

2

= sk

2

+ sj

2

− 2s Tk s j ,

( k = 1,… , M );

(15)

( k = 1,… , M );

(16)

( k ≠ j ).

(17)

ο

9

3. Demodulatore coerente

Si supponga che il modulatore dal lato trasmettitore generi nell’intervallo [0, T ] (intervallo di

segnalazione) una tra M possibili segnali reali ad energia finita sk (t ) , k = 1,… , M . Si ammette

inoltre che i segnali siano equiprobabili e che il demodulatore dal lato ricevitore veda nel medesimo

intervallo [0, T ] una copia del segnale trasmesso più rumore additivo n(t ) che si assume essere una

realizzazione di un processo gaussiano a valore atteso nullo, stazionario ed ergodico con spettro di

densità di potenza (bilatero) uniforme1 PN ( f ) =

N0

statisticamente indipendente dal segnale

2

trasmesso.

Il segnale ricevuto nell’intervallo di segnalazione risulta quindi

r (t ) = sk (t ) + n(t )

t ∈ [0, T ]

(1)

Il modello di canale descritto dalla (1) è non distorcente ( sk (t ) non viene alterato) e l’unico

effetto che ha è l’aggiunta di rumore gaussiano bianco (cioè con PN ( f ) =

N0

); per questa ragione è

2

noto in letteratura come canale AWGN (Additive White Gaussian Noise).

Deriveremo ora la struttura del ricevitore ottimo nell’ipotesi che gli M segnali siano

perfettamente noti al ricevitore. Questa ipotesi qualifica il ricevitore come coerente.

Per quanto visto nei paragrafi precedenti, il ricevitore ottimo è quello che attua la decisione MPA

che, stante l’ipotesi fatta di segnali trasmessi equiprobabili, coincide con la decisione MV.

Nasce un primo problema legato al fatto che nel paragrafo 1 la regola di decisione ottima (MPA)

è stata ricavata supponendo di osservare un vettore di valori. In questo caso invece l’osservazione è

costituita dal segnale r (t ) osservato per t ∈ [0, T ] . Il problema può essere risolto o cercando di

derivare la corrispondente regola di decisione ottima quando l’osservazione è continua (approccio

complesso e che non muta nella sostanza il risultato a cui si perviene) oppure cercando di ricavare

dal modello di osservazione, che coinvolge i segnali nel tempo, un corrispondente

modello

vettoriale che risulti equivalente dal punto di vista della decisione. Seguiremo appunto quest’ultima

strada ricorrendo alla rappresentazione del segnale ricevuto in un’opportuna base ortonormale. La

scelta di quest’ultima deve essere fatta in modo tale che la rappresentazione tramite i coefficienti

dello sviluppo non perda informazione in merito alla porzione di segnale utile ( sk (t ) ).

1

La corrispondente funzione di autocorrelazione è RN (τ ) = E {n(t )n(t + τ )} =

N0

δ (τ ) .

2

10

Relativamente al rumore una perdita può essere tollerata a patto che questa risulti irrilevante ai fini

della successiva decisione statistica. Quanto detto euristicamente trova supporto teorico nel fatto,

dimostrabile, che:

“Nelle ipotesi di rumore bianco additivo una qualunque base ortonormale completa per

l’insieme dei possibili segnali trasmessi ( {s1 (t ), s2 (t ), ⋯ , sM (t )} ) dà origine ad un vettore r che

risulta equivalente, ai fini della decisione statistica, all’intera osservazione r (t ) per t ∈ [0, T ] ”.

Il vettore r così ottenuto è detto rilevante ed in termini tecnici questo significa che costituisce

una statistica sufficiente nei riguardi del problema di decisione. Per quanto detto sopra risulta

inoltre che la struttura del ricevitore è indipendente dalla particolare base scelta, purché completa

per la parte di segnale utile ( sk (t ) , k = 1,… , M ). In particolare la base ortonormale

{ψ 1 (t ), ψ 2 (t ), ⋯ , ψ N (t )} che porta ad un vettore r rilevante con il minimo numero di componenti N

è quella che si ottiene applicando la procedura di ortogonalizzazione di Gram-Schmidt all’insieme

dei possibili M segnali trasmessi {s1 (t ), s2 (t ), ⋯ , sM (t )} (per quanto detto nel paragrafo 2 risulta

ovviamente N ≤ M ).

Scelta quindi la base ortonormale {ψ 1 (t ), ψ 2 (t ), ⋯ , ψ N (t )} , completa per l’insieme dei possibili

segnali trasmessi

{s1 (t ), s2 (t ), ⋯ , sM (t )} ,

si proietti in essa il segnale ricevuto r (t ) , ottenendo i

seguenti coefficienti dello sviluppo

T

T

T

0

0

0

r ( j ) = ∫ r (t )ψ j (t )dt = ∫ sk (t )ψ j (t )dt + ∫ n(t )ψ j (t )dt = sk( j ) + n( j ) ,

j = 1,…, N

(2)

che raccolti nei vettori

r (1)

(2)

r

r=

,

⋮

(N)

r

sk(1)

(2)

s

sk = k ,

⋮

(N )

sk

n(1)

(2)

n

n=

,

⋮

(N )

n

(3)

portano al seguente modello vettoriale di osservazione equivalente a (1) dal punto di vista della

decisione statistica

r = sk + n .

(4)

Vale la pena osservare che si ha

N

sk (t ) = ∑ sk( j )ψ j (t )

j =1

( dove s

( j)

k

T

= ∫ sk (t )ψ j (t )dt

0

)

t ∈ [0, T ]

(5)

11

essendo la base completa per i segnali sk (t ) ( k = 1,… , M ), mentre in generale

N

n(t ) ≠ ∑ n( j )ψ j (t )

t ∈ [0, T ]

(6)

j =1

ma per quanto detto prima ciò non comporta alcuna perdita ai fini della decisione.

A questo punto avendo a disposizione un’osservazione vettoriale possiamo applicare la teoria

sviluppata nel paragrafo 1 e concludere che il ricevitore ottimo (nell’ipotesi di segnali sk (t )

equiprobabili) è quello che attua la seguente regola di decisione a massima verosimiglianza

sˆ MV = arg max pRS| (r | s k )

( s k equiprobabili)

sk

(7)

Il calcolo della pRS| (r | s k ) si effettua a partire dalla descrizione statistica del vettore di rumore n.

Questo è ottenuto per trasformazione lineare di un processo gaussiano e quindi risulta a sua volta

un vettore gaussiano. Rimane da caratterizzarne il vettore dei valori attesi e la matrice di

covarianza. Relativamente al primo si osserva

E {n (1) }

E {n (2) }

mn = E {n} =

=0

⋮

(N )

E {n }

(8)

dove 0 è il vettore nullo di dimensione N, poiché

E {n( j ) } = E

{∫ n(t )ψ (t )dt} = ∫ E{n(t)}ψ (t)dt = 0 .

T

0

T

j

j

0

(9)

In merito alla seconda si ha

K n = E {nn T } = σ ij

i , j =1,… N

=

N0

I

2

(10)

dove I è la matrice identità di dimensioni N×N, risultando

σ ij = E {n(i ) n( j ) } = E

=∫

T

0

{∫ n(t)ψ (t)dt ⋅ ∫ n(τ )ψ (τ )dτ }

T

T

i

0

0

T

∫ E {n(t )n(τ )}ψ (t )ψ

0

i

j

(τ )dtdτ

N0

δ ( t − τ )ψ i (t )ψ j (τ )dtdτ

0 0 2

N0

i= j

N0 T

=

(

t

)

(

t

)

dt

=

ψ

ψ

2

i

j

2 ∫0

i≠ j

0

=∫

T

∫

j

T

(11)

Le componenti di n (vettore gaussiano) essendo incorrelate risultano anche statisticamente

indipendenti. In conclusione si ha che

12

N

n ∼ 0, 0 I .

2

(12)

Da ciò segue facilmente che, essendo rumore e segnale trasmesso indipendenti, il vettore r

condizionatamente a s k (in simboli r | ) ha ancora distribuzione gaussiana, ma con vettore dei

sk

valori attesi s k e matrice di covarianza quella del rumore. In sintesi

N

r | ∼ sk , 0 I

sk

2

(13)

da cui segue immediatamente che

1

pR|S (r | s k ) =

(π N 0 )

N

e

( r −s k ) T ( r −s k )

N0

r −sk

1

=

(π N 0 )

e

N

2

N0

.

(14)

Tenendo poi conto del fatto che

arg max

sk

1

(π N 0 )

N

e

( r − s k )T ( r − s k )

N0

= arg min r − s k

2

= arg min r − s k ,

sk

(15)

sk

il ricevitore ottimo attua la seguente regola di decisione

sˆ MV = arg min r − s k .

(16)

sk

Essendo r − s k

la distanza euclidea tra i vettori r e s k si ha il notevole risultato che, nelle

ipotesi in cui si è analizzato il problema, cioè di segnali trasmessi equiprobabili osservati in rumore

additivo gaussiano bianco, il ricevitore ottimo coincide con il ricevitore a minima distanza euclidea.

Un primo schema realizzativo dello stesso che proietta il segnale ricevuto nella base

{ψ 1 (t ),ψ 2 (t ),⋯,ψ N (t )} , è quindi il seguente

T

∫

r − s1

r (1)

0

r (t )

ψ 1 (t )

M

Calcolo

delle

distanze

di r da

s1,s2,..,sM

T

∫

r(N )

I

sˆ MV

N

r − sM

0

ψ N (t )

13

È possibile tuttavia derivare strutture alternative del ricevitore in dipendenza delle diverse forme

(equivalenti) in cui è possibile scrivere la (16). Sviluppando la norma ivi presente (o meglio il suo

quadrato) si ottiene

sˆ MV = arg min r − s k

sk

{

2

2

= arg min r + s k

sk

2

− 2r T s k

}

1

2

= arg min −2 r T s k − s k

2

sk

1

2

= arg max r T s k − s k .

2

sk

(

essendo r

2

costante rispetto a s k

(17)

)

Esprimendo ora i prodotti scalari che compaiono nella (17) in termini dei corrispondenti integrali

tra le funzioni del tempo (vedi paragrafo 2) è facile verificare che si ha

T

r T s k = ∫ r (t ) sk (t )dt ,

0

sk

2

= s T s k = ∫ [ sk (t ) ] dt = Ek ,

T

2

0

( k = 1,…, M ) ;

(18)

( k = 1,…, M ) ;

(19)

essendo Ek l’energia del k-esimo possibile segnale trasmesso. Sulla base delle (18) e (19) si ottiene

una prima forma equivalente della (16)

1

T

sˆ MV = arg max ∫ r (t ) sk (t )dt − Ek

2

sk

0

(20)

a cui corrisponde la seguente struttura di demodulatore cosiddetto a correlazione, per via della

circostanza che il primo termine tra parentesi graffe nella (20) è un integrale di correlazione tra il

segnale ricevuto r (t ) ed il generico possibile segnale trasmesso sk (t ) ( k = 1,…, M ) .

T

∫

crs1

0

r (t )

1

E1

2

s1 (t )

M

A

sˆ MV

X

T

∫

crsM

0

sM (t )

1

EM

2

14

Un ulteriore schema si ottiene osservando che il generico integrale di correlazione presente nella

(20) può calcolarsi equivalentemente facendo transitare il segnale ricevuto r (t ) in un filtro (causale)

avente risposta impulsiva hk (t ) = sk (T − t ) e campionando la corrispondente uscita all’istante t = T ,

infatti

r (t ) ∗ hk (t )

|

= r (t ) ∗ sk (T − t )

t =T

=

|

t =T

+∞

∫ r (τ ) s (T − t + τ )dτ |

(21)

k

t =T

−∞

T

= ∫ r (τ ) sk (τ )dτ

0

che consente di riscrivere la (16)

sˆ MV = arg max r (t ) ∗ hk (t )

sk

|

t =T

1

− Ek

2

(22)

da cui segue senza difficoltà il seguente schema del demodulatore cosiddetto a filtro adattato, in

quanto ciascuno dei filtri hk (t ) è adattato al corrispondente segnale sk (t ) .

t =T

h1 (t ) = s1 (T − t )

crs1

1

E1

2

r (t )

M

A

t =T

hM (t ) = sM (T − t )

sˆ MV

X

crsM

1

EM

2

In sintesi la regola di decisone attuata dal ricevitore ottimo può porsi nelle forme seguenti

sˆ MV = arg min r − s k

sk

1

T

= arg max ∫ r (t ) sk (t )dt − Ek

2

sk

0

1

= arg max r (t ) ∗ hk (t )

− Ek

2

sk

t =T

|

( demodulatore a correlazione )

( demodulatore a filtro adattato )

cui corrispondono rispettivamente gli schemi (tutti equivalenti) riportati nelle ultime tre figure.

15

A conclusione vale la pena osservare che la struttura di decisione che conduce alla minima

distanza euclidea dipende fortemente dalle ipotesi fatte. In particolare il fatto che il rumore sia

gaussiano e bianco garantisce che la massimizzazione della densità di probabilità in avanti sia

equivalente alla minimizzazione della forma quadratica presente ad esponente nella gaussiana (la

bianchezza in particolare implica che detta forma quadratica sia proprio una distanza euclidea). In

ultimo si sottolinea l’assunta ipotesi di equiprobabilità dei segnali trasmessi; è infatti possibile

dimostrare che quando questa non è verificata il ricevitore ottimo, che sarà necessariamente del tipo

a massima probabilità a posteriori, non è in generale a minima distanza euclidea.

ο

16

4. Prestazioni del ricevitore ottimo coerente

Le prestazioni del ricevitore ottimo coerente sono valutate in termini dello stesso parametro che

esso minimizza e cioè della probabilità di errore sul simbolo. Tenendo conto del fatto che il

modulatore associa in maniera biunivoca ad ognuno degli M distinti simboli che la sorgente emette

un diverso segnale sk (t ) ( k = 1,… , M ), la probabilità di errore sul simbolo è definita (utilizzando la

rappresentazione tramite vettori) come segue

P(e) = Pr {sˆ MV ≠ s}

(1)

dove s ed sˆ MV rappresentano rispettivamente il segnale trasmesso e quello per il quale si è deciso.

Tenendo conto del fatto che la probabilità di errore è il complemento ad 1 della probabilità di

corretta decisione P(c) = Pr {sˆ = s} ed inoltre che i segnali trasmessi sono assunti equiprobabili la

(1) può porsi equivalentemente nella forma

P(e) = 1 − P(c) = 1 − Pr {sˆ MV = s}

M

= 1 − ∑ Pr {sˆ MV = s k , s = s k }

k =1

(2)

M

= 1 − ∑ Pr {sˆ MV = s k | s = s k } Pr {s = s k }

k =1

= 1−

1

M

M

∑ Pr {sˆ

MV

= sk | s = sk } .

k =1

Il calcolo esplicito della (2) può essere condotto tenendo presente quanto detto nel paragrafo 1

riguardo al fatto che applicare una regola di decisione equivale a partizionare lo spazio di

osservazione in regioni di accettazione R j ( r ∈ R j ⇒ sˆ MV = s j ). Nel caso specifico del ricevitore

coerente lo spazio di osservazione è lo spazio euclideo ℝ N i cui punti sono possibili vettori ricevuti.

Le regioni R j ( j = 1,…, M ) sono facilmente ricavabili come luogo geometrico dei punti di ℝ N a

distanza minima dagli M punti di costellazione associati ai segnali trasmessi s j ( j = 1,…, M ). Tali

regioni sono dette regioni di decisione a massima verosimiglianza o regioni di Voronoi e sono

definite formalmente come segue

{

R j = r ∈ ℝ N | r − s j ≤ r − s k , k ∈ {1,2,⋯, M }

{ j}}

j −1

∪ Ri .

i=1

(3)

Da notare che nella definizione della generica R j sono stati rimossi i punti appartenenti alle

regioni Rk con k < j . Ciò si rende necessario per far si che le M regioni R j costituiscano una

17

partizione di ℝ N . Ciascuna regione R j ammette come frontiera punti che sono equidistanti da due

punti di costellazione prossimi. L’attribuzione di detti punti di frontiera ad una regione piuttosto che

ad un’altra è del tutto arbitraria non avendo alcuna influenza sulle prestazioni, cioè sulla probabilità

di

errore.

{ r −s

k

La

= r −sj

Sulla

ragione

di

ciò

è

legata

al

} ≡ {il vettore ricevuto r è equidistante da s

base

di

quanto

detto

k

sopra

fatto

che

eventi

del

tipo

e da s j } hanno probabilità nulla.

risulta

quindi

evidente

che

Pr {sˆ MV = s k | s = s k } = Pr {r ∈ Rk | s = s k } e quindi la (2) può scriversi come

P ( e) = 1 −

1

M

1

= 1−

M

M

∑ Pr {sˆ = s

k

| s = sk }

k =1

(4)

M

∑∫

k =1

Rk

pR|S (r | s k )dr ;

ricordando poi i risultati del paragrafo precedente si giunge facilmente alla seguente espressione

generale per il calcolo della probabilità di errore media sul simbolo

1

P (e ) = 1 −

M

M

∑∫

k =1

r −s k

1

Rk

(π N 0 )

N

e

N0

2

dr .

(5)

Una volta noti i punti della costellazione s k ( k = 1,… , M ) le regioni Rk si ricavano facilmente

per mezzo della (3) o più semplicemente tramite considerazioni geometriche e la (5) fornisce il

ricercato indice prestazionale.

Vale la pena fare alcune considerazioni in merito alla (5). La funzione integranda risulta essere a

simmetria circolare rispetto a s k (cioè in punti equidistanti da s k assume lo stesso valore). Questo

porta a concludere che ciascuno degli integrali nella (5) dipende solo dalla forma e dall’estensione

della corrispondente regione di decisione Rk e non dalla sua posizione nello spazio di osservazione.

Da ciò segue che qualunque trasformazione che altera la costellazione, lasciando invariate forma e

dimensioni delle regioni Rk non muta la probabilità di errore. In particolare questo è vero per

traslazioni, rotazioni e riflessioni.

Ad esempio le costellazioni di seguito riportate, fanno riferimento ad un sistema di M = 4

segnali rappresentabili in una base ortonormale di dimensione N = 2 .

ψ2

ψ2

ψ2

R1

R1

Rɶ1

ψ1

ψ1

ψ1

18

A tratteggio sono indicate le frontiere delle regioni di decisione (nella prima figura coincidono

con gli assi). Risultando dette regioni, uguali per forma ed estensione (ad esempio R1 , Rɶ1 ed R1

differiscono solo per la loro posizione nel piano (ψ 1 ,ψ 2 ) ), le tre diverse costellazioni presentano la

medesima probabilità di errore. Questo non significa tuttavia che possano ritenersi equivalenti sotto

tutti gli altri punti di vista, in particolar modo quello energetico. L’obiettivo che si cerca di

raggiungere infatti è la riduzione dell’energia impiegata nella trasmissione a parità di probabilità di

errore.

L’energia media richiesta per la trasmissione di M segnali equiprobabili è data da

E=

1

M

M

∑ Ek =

k =1

1

M

M

∑s

2

k

(6)

k =1

da cui si deduce immediatamente la terza configurazione di figura richiede in media più energia

delle altre due avendo i punti della costellazione più distanti dall’origine. È interessante rilevare che

il valore minimo della (6) si ottiene quando i punti della costellazione presentano valor medio nullo,

cioè quando

M

∑s

k

=0 .

(7)

k =1

La prova di quanto detto si basa sull’osservazione che la (6) può essere interpretata come il

momento d’inerzia rispetto all’origine del sistema di punti descritti dai vettori s k ( k = 1,… , M ) ed

aventi massa

1

. È noto che il momento d’inerzia è minimo se calcolato rispetto al centro di

M

massa. La costellazione a minima energia media è quindi quella che ha il centro di massa

nell’origine, cioè

1

M

M

∑s

k

= 0 , da cui la (7).

k =1

Relativamente al calcolo della (5) si fa notare che a dispetto del fatto che le regioni Rk sono

facilmente individuabili, risulta in generale piuttosto complicato calcolare gli integrali e, salvo casi

particolari in cui esiste un’espressione in forma chiusa, la valutazione va condotta per via numerica.

Nasce quindi la necessità di individuare limiti superiori alla probabilità di errore che consentano

da una parte di fornire stime alla (5) e dall’altra di mettere in evidenza i parametri chiave utili in

sede di sintesi della costellazione. Con questo obiettivo in mente richiamiamo alcuni risultati, noti

da altri corsi, che serviranno per gli sviluppi successivi.

Nel caso di trasmissione binaria ( M = 2 ) è noto che la probabilità di errore media sul simbolo

binario coincide con le probabilità di errore condizionate ( P(e | s1 ) e P(e | s 2 ) ) ed assume la

seguente espressione

19

il vettore ricevuto r è più vicino a s 2 che a s1 ,

P(e) = P(e | s1 ) ≡ Pr

posto che sia stato trasmesso s1

il vettore ricevuto r è più vicino a s1 che a s 2 ,

= P(e | s 2 ) ≡ Pr

posto che sia stato trasmesso s 2

d2

1

12

= erfc

2

4 N0

(8)

dove il parametro d122 è l’energia del segnale differenza tra i due possibili segnali trasmessi s1 (t ) e

s2 (t ) o equivalentemente la distanza al quadrato tra gli stessi

d122 = ∫ [ s1 (t ) − s2 (t ) ] dt = s1 − s 2

T

2

2

0

;

(9)

poiché inoltre si ha

d122 = s1 − s 2

2

2

2

= s1 + s 2

− 2s1T s 2

(10)

= E1 + E2 − 2 ρ E1 E2

essendo ρ =

s1T s 2

E1 E2

=

∫

T

0

s1 (t ) s2 (t )dt

∫ [ s (t )] dt ∫ [ s (t )]

T

T

2

0

2

E + E − 2ρ E E

1

2

1 2

P(e) = erfc 1

2

4 N0

.

0

1

il coefficiente di correlazione tra i due segnali, la

2

dt

(8) diviene

(11)

È noto che nel caso in cui le energie siano vincolate a non superare un prefissato valore E, la

miglior configurazione di segnali (quella cioè che garantisce la minima probabilità di errore) è

quella per cui E1 = E2 = E e ρ = −1 cioè segnali antipodali

( s1 (t ) = − s2 (t ) )

e la (11) diviene

E

1

erfc

. Questa costituisce quindi la miglior configurazione nel caso di trasmissione binaria

2

N0

(con vincolo sull’energia) e demodulazione coerente. Si noti che in questo caso le prestazioni non

dipendono dalla forma del segnale ma solo dalla sua energia.

Svilupperemo ora un limite superiore alla (5) sfruttando i risultati sopra richiamati.

Partendo dalla definizione di probabilità di errore media sul simbolo, valgono i seguenti sviluppi

20

P(e) = Pr {sˆ MV ≠ s}

M

= ∑ Pr {sˆ MV ≠ s k , s = s k }

k =1

M

= ∑ Pr {sˆ MV ≠ s k | s = s k } Pr {s = s k }

(12)

k =1

=

1

M

M

∑ Pr {sˆ

MV

≠ sk | s = sk }

k =1

Per individuare una maggiorazione dei termini ad argomento della sommatoria è utile richiamare

il seguente risultato, noto nell’ambito della teoria della probabilità come limite dell’unione (union

bound):

Siano A1 , A2 , ⋯, AL generici eventi aventi probabilità rispettivamente Pr { A1 } , Pr { A2 } ,

⋯ , Pr { AL } , allora per la probabilità dell’evento unione vale la seguente maggiorazione

L L

Pr ∪ Ak ≤ ∑ Pr { Ak }

k =1 k =1

(13)

dove l’uguaglianza si ha se gli eventi sono disgiunti ( Ai ∩ Aj = ∅ , i ≠ j ).

Prendendo in considerazione il generico termine della sommatoria nella (12) si osservi che

l’evento

{sˆ MV

il vettore ricevuto r non è più vicino a s k ,

≠ sk | s = sk } ≡

posto che sia stato trasmesso s k

il vettore ricevuto r è più vicino a s1 oppure a s 2 oppure .... oppure a s k −1

≡

oppure a s k +1 .... oppure a s M −1 oppure a s M , posto che sia stato trasmesso s k

può essere scritto come unione dei seguenti eventi (non disgiunti) indicati con il simbolo Ek → j

il vettore ricevuto r è più vicino a s j che a s k ,

Ek → j =

posto che sia stato trasmesso s k

M

cioè {sˆ MV ≠ s | s = s k } = ∪ Ek → j , per cui si può concludere che

j =1

j ≠k

M

ˆ

Pr {s MV ≠ s k | s = s k } = Pr ∪ Ek → j

jj =≠1k

( applicando il limite dell'unione (13) )

(14)

M

≤ ∑ Pr { Ek → j }

j =1

j≠k

21

Confrontando ora la definizione degli eventi Ek → j con quanto riportato nella (8) si conclude che

il generico termine Pr { Ek → j } rappresenta la probabilità di errore di un sistema di trasmissione

binario in cui gli unici segnali trasmessi sono s k e s j . Indicando con d k j = s k − s j la distanza tra i

due segnali, dalla (8) segue quindi che

dk j

1

Pr { Ek → j } = erfc

2 N

2

0

(15)

che sostituito nella (14) e poi nella (12) porta alla seguente maggiorazione per la probabilità di

errore

P ( e) ≤

1

2M

M

M

dk j

,

N

0

∑∑ erfc 2

k =1 j =1

j ≠k

(16)

nota in letteratura come limite superiore dell’unione (union upper bound). Per il suo calcolo è

sufficiente conoscere le distanze tra i possibili segnali generati dal modulatore o equivalentemente

tra i punti della costellazione. È importante far notare che il limite nella (16) diviene sempre più

stretto al diminuire del livello di rumore N 0 e per N 0 → 0 è asintoticamente esatto. Risulta quindi

una buona approssimazione di P(e) per alti SNR.

Dalla (16) è possibile derivare un altro limite superiore più semplice ma più lasco. Basandosi

infatti sulla circostanza che la funzione erfc( x) è decrescente, indicando con

d min = min d k j

k≠ j

la minima distanza esistente tra i punti della costellazione, si ha ovviamente

dk j

erfc

2 N

0

d

≤ erfc min

2 N

0

(17)

da cui segue

P ( e) ≤

1

2M

dk j

erfc

∑∑

2 N

k =1 j =1

0

j ≠k

≤

1

2M

d min

erfc

∑∑

2 N

k =1 j =1

0

j ≠k

=

d

1

M ( M − 1)erfc min

2 N

2M

0

M

M

M

M

(18)

e quindi in definitiva

22

P ( e) ≤

d

M −1

erfc min

2 N

2

0

(19)

che costituisce il limite superiore dell’unione semplificato. In merito a quest’ultimo vale la pena

osservare che per il calcolo e sufficiente conoscere la sola distanza minima tra i punti della

costellazione. L’importanza della (18) è inoltre legata al fatto che mette in luce il parametro da

ottimizzare per migliorare le prestazioni. Almeno nel caso di basso livello di rumore dalla (18) si

evince infatti che la distanza minima d min rappresenta il parametro dominante ai fini delle

prestazioni di un insieme di segnali e la sua massimizzazione è infatti un criterio comunemente

seguito nella sintesi della costellazione. Vale la pena tuttavia sottolineare che per valori non piccoli

della probabilità di errore (cioè livello di rumore non basso) è necessario tener conto di altri aspetti

per conseguire un miglioramento delle prestazioni.

ο

23

5. Demodulatore incoerente

Il modello del segnale ricevuto può esprimersi come segue:

{

r (t ) = s j (t ;θ ) + n(t ) = Re s j (t )e

j( 2π f ot +θ )

} + n(t )

t ∈ [ 0, T ]

(1)

dove s j (t ) è l’inviluppo complesso di s j (t ) rispetto alla frequenza f o .

Anche in questo caso si procede nel ricercare il modello vettoriale equivalente espandendo il

segnale ricevuto r (t ) in una base di sviluppo ortonormale che sia, al solito, completa per la

componente di segnale utile s j (t ;θ ) ( con j = 1,⋯ , M e θ ∈ [ 0, 2π ) ) . Si fa notare che in questo caso

la base ortonormale è in generale “più ricca” rispetto alla corrispondente base impiegata nel caso di

ricevitore coerente; ciò in ragione della necessità di dover tenere conto del termine di fase θ . È

possibile dimostrare che a parità di segnali s j (t ) con j = 1,⋯ , M , la base che consente di avere il

minimo numero di coefficienti per lo sviluppo ha dimensione doppia rispetto alla corrispondente nel

caso coerente.

Indicando con {ψ 1 (t ),ψ 2 (t ),⋯,ψ N (t )} la suddetta base ed introducendo, come solito i vettori:

r (1)

(2)

r

r=

⋮

(N )

r

s (1)

j (θ )

(2)

s (θ )

s j (θ ) = j

⋮

(N )

s j (θ )

n(1)

(2)

n

n=

⋮

(N )

n

T

con r ( k ) = ∫ r (t )ψ k (t )dt ;

0

T

con s (θ ) = ∫ s j (t ;θ )ψ k (t )dt ;

(k )

j

0

T

con n( k ) = ∫ n(t )ψ k (t )dt ;

0

il modello vettoriale equivalente della (1) è

24

r = s j (θ ) + n .

(2)

Sulla base di quanto detto nei paragrafi precedenti il ricevitore ottimo, nell’ipotesi che gli M

segnali trasmessi siano equiprobabili, si concretizza in un sistema che realizza la seguente decisione

a massima verosimiglianza

sˆ = arg max pR S ( r s k ) .

(3)

sk

La presenza del termine di fase aleatoria θ rende più articolato il calcolo della densità di

probabilità “in avanti” pR S ( r s k ) . Quest’ultima tuttavia può essere espressa in termini di grandezze

facilmente ricavabili dal modello di osservazione (sulla base delle ipotesi fatte) mediante i seguenti

passaggi:

pR S ( r s k ) =

+∞

∫p

R ,Θ S

( r,θ s ) dθ

( ddp marginale ottenuta per saturazione della ddp congiunta )

k

−∞

+∞

=

∫p

R Θ ,S

( r θ , s ) p (θ s ) dθ

ΘS

k

k

−∞

+∞

=

∫p

R Θ ,S

(r θ , s ) p

Θ

k

(θ )dθ

ricorda che p ( x, y | z ) =

p( x | y, z ) p( y, z )

=

p( z )

p( x | y, z ) p( y | z )

( indipendenza tra fase aleatoria Θ e segnale trasmesso S )

−∞

1

=

2π

2π

∫p

R Θ ,S

( r θ , s ) dθ

( fase aleatoria a distribuzione uniforme in [ 0, 2π ) )

k

(4)

0

A questo punto pR Θ ,S ( r θ , s k ) si ricava immediatamente dal modello di osservazione poiché

l’assunta indipendenza tra rumore, segnali trasmessi e fase aleatoria porta a concludere che il

vettore (aleatorio) di osservazione r, condizionatamente al segnale trasmesso s k ed alla fase θ

(indicato con r

r

θ , sk

) ha la seguente distribuzione

N

∼ s k (θ ), 0 I

θ , sk

2

(dove I è la matrice identità di dimensione N)

da cui segue

pR Θ,S ( r θ , s k ) =

=

(π N 0 )

N

(π N 0 )

N

N0

2

N0

e

s k (θ )

2

N0

e

r

1

= A(r ) e

r −sk (θ )

−

1

2

e

s k (θ )

N0

2 T

+

r sk (θ )

N0

2

+

2 T

r s k (θ )

N0

(5)

A(r ) =

r

1

(π N 0 )

N

e

2

N0

25

dove si è enucleato il termine che non dipende dall’indice k e che quindi risulterà ininfluente ai fini

della successiva decisione.

Sostituendo la (5) nella (4) si ottiene

1

pR S ( r s k ) = A(r )

2π

2π

∫e

s k (θ )

N0

2

+

2 T

r sk (θ )

N0

dθ .

(6)

0

Al fine di semplificare ulteriormente tale espressione è opportuno considerare i termini che

2

compaiono ad esponente nell’integrando. Per quanto riguarda s k (θ ) , questo rappresenta l’energia

della componente utile (alterata nella fase) del segnale ricevuto ed è facile convincersi che questa

coincide con l’energia del segnale trasmesso sk (t ) poiché la presenza di un termine di fase costante

non comporta variazioni dell’energia. Si ha quindi

T

T

s k (θ ) = ∫ [ sk (t ;θ )] dt = ∫ [ sk (t )] dt = Ek

2

2

2

0

(7)

0

che ne evidenzia la conseguente indipendenza da θ .

Il termine r Ts k (θ ) rappresenta invece l’intercorrelazione tra il segnale ricevuto r (t ) e la

componente utile dello stesso (alterata nella fase) sk (t ;θ ) . Può quindi esprimersi in termini del

corrispondente integrale tra le funzioni del tempo

T

T

0

0

{

}

r s k (θ ) = ∫ r (t ) sk (t ;θ )dt = ∫ r (t ) Re s k(t )e jθ e j 2π fot dt

T

jθ T

= Re e ∫ r (t ) s k(t )e j 2π fot dt

0

T

j 2π f t

definendo zk ≐ ∫ r (t ) s k(t )e o dt

0

= zk cos(θ + ϕ k ) .

( avendo scritto z

= Re {e jθ zk }

k

= zk e jϕk , poiché zk ∈ ℂ

(8)

)

T

La procedura di valutazione di zk ≐ ∫ r (t ) s k(t )e j 2π fot dt sarà analizzata in dettaglio più avanti.

0

Andando ora a sostituire la (7) e la (8) nella (6) si ottiene

pR S ( r s k ) = A(r ) e

Ek

N0

1

2π

2π

∫e

2 zk

cos(θ +ϕ k )

N0

dθ ;

(9)

0

l’integrale nella (9) presenta una struttura particolare potendo infatti essere scritto in termini della

funzione speciale I 0 ( x) nota come funzione di Bessel modificata di prima specie di ordine zero e

definita come segue

26

Io ( x) ≜

1π

π

x cos θ

∫ e dθ =

0

2π

1

2π

∫e

x cos(θ +ϕ )

dθ

∀ϕ ∈ ℝ

(10)

0

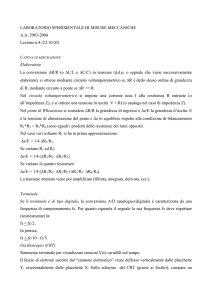

ed il cui grafico è rappresentato in figura. Vale la pena osservare che I 0 ( x) risulta essere una

funzione crescente per argomenti non negativi.

Io(x)

1

x

0

Grafico della I 0 ( x)

A questo punto è immediato riconoscere che la (9) assume la seguente forma finale

pR S ( r s k ) = A(r ) e

Ek

N0

2 z

I0 k .

N0

(11)

Tenendo conto infine del fatto che il termine A(r ) non dipende dall’indice k e che quindi è

ininfluente ai fini della decisione rispetto a s k il ricevitore incoerente ottimo è quello che realizza la

seguente regola di decisione

sˆ = arg max e

sk

Ek

N0

z

I0 k

N0

,

T

≐

dove

z

r (t ) s k(t )e j 2π fot dt ,

k

∫

0

(12)

Esso opera quindi nella seguente modalità. Sulla base del segnale ricevuto r (t ) nell’intervallo di

segnalazione [ 0,T ] , calcola le M statistiche zk ( k = 1,… , M ) e quindi decide in favore del segnale

che rende massima l’espressione e

Ek

N0

z

I0 k

N0

. Vale la pena osservare che il ricevitore, oltre a

dover conoscere i possibili segnali trasmessi sk (t ) ( k = 1,… , M ), deve avere anche informazioni in

merito al livello di rumore N 0 .

Nell’ipotesi in cui i segnali sk (t ) abbiano la stessa energia, circostanza tipica nei sistemi in cui

si utilizza rivelazione incoerente, la regola di decisione si semplifica notevolmente

27

sˆ = arg max e

k =1,…, M

Ek

N0

z

I0 k

N0

z

= arg max I 0 k

k =1,…, M

N 0

( Ek = cost )

= arg max zk .

( essendo I 0 ( x) crescente per x ≥ 0 )

k =1,…, M

(13)

Da notare che in questo caso ( Ek = cost ) il ricevitore non necessita della conoscenza del livello

di rumore ed inoltre la decisione si basa semplicemente sulla ricerca dell’indice k a cui corrisponde

il massimo valore per zk .

Vediamo ora, limitatamente alla circostanza considerata di segnali equienergia, la struttura a

blocchi del ricevitore. Per la derivazione è necessario calcolare le statistiche zk

T

zk = ∫ r (t ) sk (t )e j 2π fot dt

(14)

0

in cui sk (t ) è l’inviluppo complesso del segnale sk (t ) rispetto alla frequenza f o .

Lo studente attento avrà riconosciuto che il prodotto sk (t )e j 2π fot è proporzionale al segnale

analitico sk+ (t ) associato a sk (t ) . Ricordando la definizione di quest’ultimo si giunge facilmente

alla seguente catena di uguaglianze

sk (t )e j 2π fot = 2 sk+ (t ) = sk (t ) + jsˆk (t )

dove sˆk (t ) = { (t )} è la trasformata di Hilbert di sk (t ) .

Ne consegue che zk si ottiene calcolando

T

T

0

0

zk = ∫ r (t ) sk (t )dt + j ∫ r (t ) sˆk (t )dt .

(15)

Il ricevitore dovrà quindi essere in grado di generare localmente sia i segnali sk (t ) che le loro

trasformate di Hilbert. Trattandosi tuttavia di segnali in banda traslata il calcolo della trasformata di

Hilbert risulta grandemente semplificato poiché si riduce ad un’operazione di sfasamento. Vale

infatti la seguente notevole proprietà (dimostrare per esercizio).

Proprietà. Sia x(t ) un segnale reale e sia x (t ) il suo inviluppo complesso rispetto alla frequenza

{

}

f o , per cui x(t ) = Re x (t )e j 2π fot . Allora la trasformata di Hilbert di x(t ) assume la forma

28

j (2π f ot

xˆ (t ) = { x(t )} = Re x (t )e

π

2

)

.

Sfruttando la proprietà indicata e tenendo inoltre conto del fatto che

sˆ = arg max zk = arg max zk

k =1,…,M

2

(16)

k =1,…,M

si giunge allo schema del ricevitore incoerente a correlazione per segnali equienergia.

T

∫

( )

2

0

z1

s1 (t )

2

π/2

T

∫

( )

2

0

M

ŝ

r (t )

A

X

T

∫

( )

2

0

zM

sM (t )

2

π/2

T

∫

( )

2

0

Da notare che rispetto al caso di ricevitore coerente qui sono richieste due correlazioni per

ciascun segnale sk (t ) . Limitatamente a questo aspetto la complessità è aumentata, per contro il

ricevitore incoerente non richiede dispositivi per la stima e l’inseguimento della fase del segnale

ricevuto e questa è la fondamentale ragione della sua maggior semplicità realizzativa. Quest’ultima

è ancor più evidente quando si va a considerare l’altra forma comune del demodulatore incoerente

(usata in particolare per le modulazioni FSK) cosiddetta a filtro adattato in banda traslata

(bandpass matched filter in letteratura anglosassone).

È infatti possibile provare che la statistica zk

( k = 1,… , M ) può essere equivalentemente

29

ricavata facendo transitare r (t ) in un filtro adattato a sk (t ) (che appunto è in banda traslata),

estraendo l’inviluppo[2] dell’uscita e campionando all’istante t = T .

Lo schema del ricevitore incoerente a filtro adattato per segnali equienergia è il seguente

h1 (t ) = s1 (T − t )

t =T

w1 (t )

Rivelatore

d’inviluppo

z1

M

ŝ

r (t )

A

hM (t ) = sM (T − t )

t =T

wM (t )

Rivelatore

d’inviluppo

X

zM

Lo studente interessato potrà trovare nei seguenti passaggi la giustificazione teorica allo schema

sopra sviluppato

T

T

T

0

0

0

zk = ∫ r (t ) sk (t )e j 2π fot dt = ∫ r (t ) sk (t )dt + j ∫ r (t ) sˆk (t )dt

= r (t ) ∗ sk (T − t ) |

t =T

+ jr (t ) ∗ sˆk (T − t ) |

t =T

1

ma sˆk (T − t ) = − sk (T − t ) ∗

πt

zk = r (t ) ∗ sk (T − t ) − jr (t ) ∗ sk (T − t ) ∗

( posto

1

πt

t =T

w(t ) = r (t ) ∗ sk (T − t ) )

zk = w(t ) − jwˆ (t ) t =T = w(t ) t =T

essendo w(t ) = 2 w+ (t )e − j 2π fot = 2 w+ (t ) = w(t ) + jwˆ (t ) = w(t ) − jwˆ (t ) .

2

Ricorda che l’inviluppo di un segnale

x(t ) è il modulo del suo inviluppo complesso

x (t ) . Quindi

Inviluppo [ x(t ) ] = x (t ) = xc2 (t ) + xs2 (t ) .

30

Cenni sulle prestazioni

Ci limitiamo a considerare solo il caso di trasmissione binaria. È possibile provare che avendo

un vincolo sull’energia massima (E), quando l’informazione sulla fase del segnale ricevuto non è

nota, la migliore configurazione (quella cioè che garantisce la minima probabilità di errore) è quella

di segnali ortogonali con la stessa energia.

T

∫ s1 (t )s2 (t )dt = 0

0

e

T

T

0

0

2

2

∫ s1 (t )dt = ∫ s2 (t )dt = E

In questo caso si dimostra che la probabilità di errore è data da

E

1 −

Pe = e 2 N0

2

ο

31