Architetture di elaborazione neuromorfa

Cambiamo l'approccio allo studio di un modulo percettivo Finora abbiamo visto il sistema visivo

inteso come una black-box. Ora ci addentreremo nella struttura e la caratterizzeremo come connessione di blocchi semplici. Compariranno tanti sottoinsiemi che saranno interallacciati. Mentre

prima era suÆciente la relazione di ingresso e uscita, adesso abbiamo bisogno di una architettura

di sistema intesa come struttura. Dobbiamo percio denire:

ingresso, uscite e variabili di stato.

equazioni

! usso del segnale ! relazione di elaborazione

relazioni tra le parti componenti il sistema.

Quello che abbiamo pensato nora e il modello gerarchico, un modello multistrato in cui le unita

fondamentali possono essere accomunate secondo alcune caratteristiche. Di queste citiamo:

a) stesse proprieta di selettivita

b) stesse locazioni siche su vari strati

1

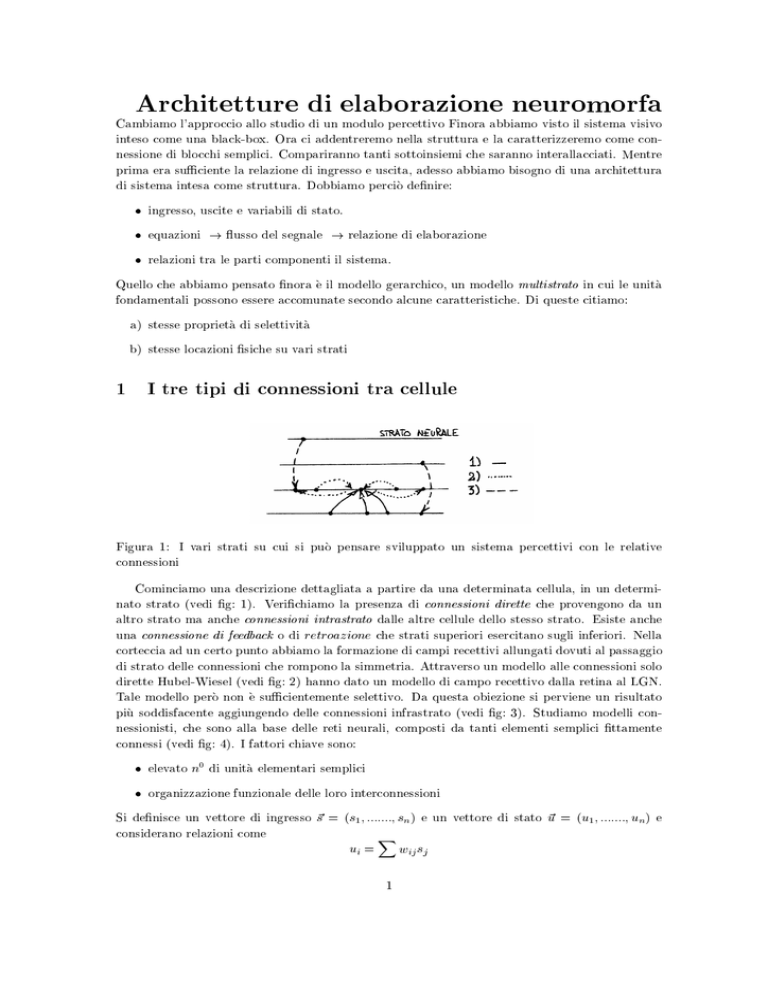

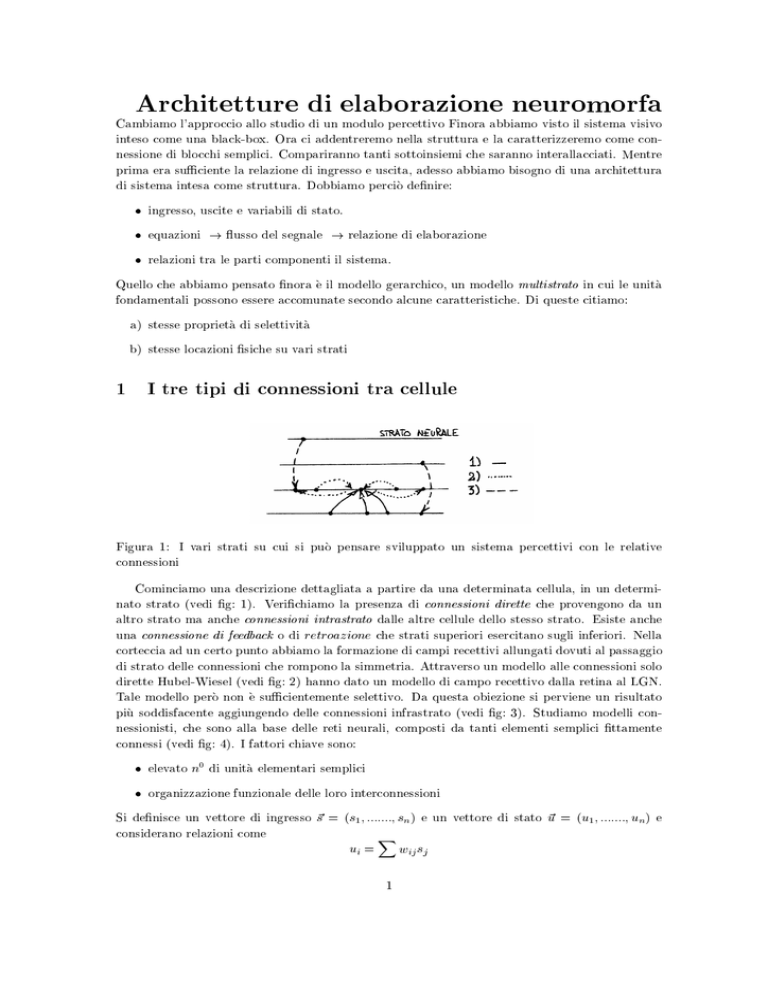

I tre tipi di connessioni tra cellule

Figura 1: I vari strati su cui si puo pensare sviluppato un sistema percettivi con le relative

connessioni

Cominciamo una descrizione dettagliata a partire da una determinata cellula, in un determinato strato (vedi g: 1). Verichiamo la presenza di connessioni dirette che provengono da un

altro strato ma anche connessioni intrastrato dalle altre cellule dello stesso strato. Esiste anche

una connessione di feedback o di retroazione che strati superiori esercitano sugli inferiori. Nella

corteccia ad un certo punto abbiamo la formazione di campi recettivi allungati dovuti al passaggio

di strato delle connessioni che rompono la simmetria. Attraverso un modello alle connessioni solo

dirette Hubel-Wiesel (vedi g: 2) hanno dato un modello di campo recettivo dalla retina al LGN.

Tale modello pero non e suÆcientemente selettivo. Da questa obiezione si perviene un risultato

piu soddisfacente aggiungendo delle connessioni infrastrato (vedi g: 3). Studiamo modelli connessionisti, che sono alla base delle reti neurali, composti da tanti elementi semplici ttamente

connessi (vedi g: 4). I fattori chiave sono:

elevato n0 di unita elementari semplici

organizzazione funzionale delle loro interconnessioni

Si denisce un vettore di ingresso ~s = (s1 ; :::::::; sn ) e un vettore di stato ~u = (u1 ; :::::::; un ) e

considerano relazioni come

X

ui = wij sj

1

Figura 2: Esempio di campo recettivo desumibile dall'esperienza di Hubel-Wiesel

(a)

(b)

Figura 3: Incremento di selettivita all-orientamento rispetto al modello di Hubel-Wiesel: (a)

eccitazione e (b) inibizione

gli elementi wij rappresentano una matrice delle connessioni denita

0 w :::: w 1

11

1M

A

W = @ ::::::

wN 1 :::: wNM

Mentre la teoria delle connessioni puo riguardare zone variamente estese nello spazio noi

consideriamo solo zone limitate di connessioni che privilegiano dunque la localita.

2

Riduzione architetturale di un modulo percettivo

Abbiamo gia visto una descrizione di sistema percettivo comportamentale ma ne esiste anche una

architetturale. Di qui i primi due modelli.

2.0.1 Modello comportamentale

Il riferimento e la struttura gerarchica del modello percettivo visivo (vedi g: 5.a). Tale modello

ha il vantaggio della semplicita ma lo svantaggio della rigidita (tutte le connessioni non sono

modicabili)

2.0.2 Modello completamente connessionista

Costituisce l'alternativa al modello precedente (vedi g: 5.b) con il vantaggio dell'aderenza al

modello biologico e una migliore adattabilita (calcolo parallelo). Per contro, manca ancora

2

Figura 4: Modello che prevede solo connessioni dirette

(a)

(b)

(c)

Figura 5: Varie alternative per rappresentare un sistema percettivo: a) modello comportamentale;

b) modello completamente connessionista; c) modello misto

una suÆciente conoscenza del percorso visivo e sussiste un alto costo computazionale a causa

dell'esorbitante numero di connessioni.

2.0.3 Modello misto

Una via di mezzo alle soluzioni precedenti e rappresentata dalla congurazione di gura 5.c.

Suppongo di ssare un certo livello e immagino di "congelare" le proprieta di questo livello con un

modello comportamentale. Per gli strati superiori considero un modello connessionista a piu strati

per migliorare la selettivita. In tal modo si ottiene una progressiva scomposizione della scatola

nera tipo black-box che puo tendere a un modello completamente connessionista. Tale soluzione

ha il pregio di essere semplice e adattabile e riassume in tono minore gli svantaggi dei modelli

precedenti.

3

Primitive architetturali

Passiamo da una visione organizzativa ad uno studio dei componenti basilari. Questi sono

rappresentati da :

neuroni (i pallini)

le interconnessioni (tratti di unione)

Il modello generico di neurone cui possiamo far riferimento e costituito da un blocco sommatore

3

Figura 6: Modello del neurone come sommatore seguito da una non-linearita

Figura 7: Rappresentazione di neurone eccitatorio e inibitorio

seguito da un blocco non lineare (vedi g: 6). I neuroni possono essere di tipo eccitatorio o

inibitorio (vedi g: 7).

Per quanto riguarda le connessioni, queste sono anche dette sinapsi (talvolta si considera il peso

w con tale termine). Se consideriamo connessioni di somma, vale il principio di sovrapposizione,

mentre per connessioni non lineari diciamo di avere a che fare con modulazini (cioe moltiplicazioni

o divisioni). Chiariamo quali sono i tre tipi di variabili che entrano in gioco nella determinazione

del modello:

1. Variabili di stato: comprendono

ingresso

eccitazione

uscita

! s(x; t)

! e(x; t)

! u(x; t)

2. Variabili fisiologiche: saranno caratterizzate da una funzione da una funzione di trasferimento f (e) da tempi di ritardo T per la propagazione dell'attivita oltre che da un tempo di integrazione sinaptica e un coeÆciente di guadagno nel senso che si presenta u = f (e).

Variabili anatomiche: distribuzione (organizzazione delle connessioni delle intensita.

Tenuto conto di queste variabili, una equazione che descrive il sistema si puo presentare nella

forma

X

e(ik) = wij s(jk)

j

ovvero l'eccitazione e una combinazione lineare degli ingressi ,

u(ik) = i(k) f (e(ik) )

l'uscita e una funzione non lineare dell'eccitazione. Se aggiungo il ritardo nel tempo

e(ik) (t) =

X (k) (k)

wij sj (t Tj(k) )

j

Quando considero anche il tempo di membrana ottengo l'equazione dinamica dell'eccitazione

strati

X X (n) (n)

de(k)

wij f [ej (t Tj(n))]

i = e(ik) (t) +

dt

n j

4

3.0.4 Congurazione topologiche elementari di neuroni

Figura 8: Congurazioni topologiche fondamentali: a)convergenza, b)divergenza, c)seriale,

d)parallela , e)auotretroazione e f)feedback

Possiamo pensarle come modalita di collegamento di neuroni o nodi (vedi g: 8), ne esistono

sei tipi diversi:

convergenza

divergenza

seriale

parallela

autoretroazione

feedback; ne esistono di tre tipi: positivo eccitatorio, positivo inibitorio e negativo.

Distinguiamo le connessioni fra anatomiche e funzionali a seconda che siano semplicemente di

osservazione oppure diano luogo a inter-attivazioni o a co-attivazioni.

4

Campi neurali

Arontiamo una trattazione delle connessioni nel caso di campi continui. In generale la descrizione

del sistema e aÆdata ad alcune equazioni gia presentate. Citiamo

ej =

X

ij sj

il passaggio alla trattazione continua produce

e(x) =

Z

w(x; x0 )s(x0 )dx0 =)

nel caso sia spazio invariante dove il passaggio e i; j

Z

w(x x0 )s(x0 )dx

! (x; x0 )

con x; x0

2 <. Dal punto di vista

Figura 9: Il neurone con le distribuzioni pre e post sinaptiche

5

della topologia (vedi g: 9), deniamo due distribuzioni: la postsinaptica (Æ ) e la presinaptica

(). Formalmente queste due riconducono a

w(x; x0 ) =

Z

Æ(x; z )(z; x0 )dz

Dati due neuroni p e q gracamente possiamo rappresentare i collegamenti come in g: 11. E`

Figura 10: Rappresentazione funzionale delle terminazioni del neurone

Figura 11: Esempio di interattivazione fra neuroni

molto importante l'ordine degli indici. Possiamo introdurre un'altra variabile anatomica: la densita

cellulare che esprimiamo con la funzione f~(x) che e la densit

a di uno strato. Per quanto riguarda

l'elaborazione dell'informazione diamo uno sguardo alla trasformazione topograca applicata a due

strati neurali adiacenti. La localita e grosso modo conservata dalla trasformazione R : <2 ! <2

nel passaggio da x a x0 (intesi come strati, g: 12). Considerando interazioni tra piu strati neurali

Figura 12: Corrispondenza topograca tra diversi piani neurali

possiamo scrivere l'equazione di integrazione sinaptica come

Q

X

d

ep (x; t) = ep (x; t) +

dt

q=1

Z

sq (x0 ; t)Æpq (x x0 )dx0

dove la sommatoria riguarda tutti gli strati. Lo stato iniziale l'immagino ep (x; 0) nullo.

Consideriamo una operazione puntuale data dalla trasformazione

up (x; t) = f (e(x; t))f~(x)

Una terza equazione e data dalla propagazione assonica nella forma

sq (x; t) =

P Z

X

up (x; t)qp (x Rqp (x0 ))dx0

p=1

6

Se vale la linearita, cioe u = e, allora posso sostituire

Q

X

d

ep (x; t) = ep () +

dt

q

ovvero anche

QX

P

X

d

ep () = ep () +

dt

q p

!

Z Z X

P

0

0

ep ()qp (x x )dx Æpq (x x")dx"

p

Z

ep (x0 ; t)

Z

|

qp (x0

x")Æpq (x x")dx" dx0

{z

wpq (x x )

}

0

qui wpq rappresenta la forza di accoppiamento delle nuvole di interazione.

(a)

(b)

(c)

Figura 13: I vari insiemi neurali tipici: (a) K0; (b) KI; (c) KII.

Figura 14: Versione semplicata dell'insieme KII

4.0.5 Insiemi neurali tipici

Spesso si possono voler denire dei macroblocchi, che costituiscono i sistemi descritti a livello

continuo, in presenza di proprieta comuni. Come notazione facciamo riferimento a Walter Freeman:

egli deniva insiemi di ordine superiore denominati K di complessita crescente K 0, K 1 e KII .

Vediamoli nel dettaglio nella g. 13. Esiste anche una versione semplicata di KII (vedi g:14).

7