Il nuovo

data center

“business oriented”

L’erogazione di servizi It

utili allo sviluppo del business

deve sottostare a una serie

di parametri di tempo, costo, utilizzo,

che solo un’infrastruttura con risorse

virtualizzate e pensata in una logica

di “business value” può garantire.

Analizziamo le aree fondamentali,

le soluzioni e le architetture per il buon

funzionamento dell’It

I.P.

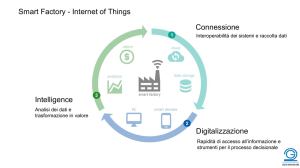

SCENARIO

architetture e sistemi

per servizi

di valore

Fare di più con meno e meglio

di prima. Questa è la sfida dell’It

per la quale serve un profondo

ripensamento, di come le risorse

infrastrutturali sono organizzate,

utilizzate e gestite per fare ciò che

si chiede loro: erogare servizi It

in modo ottimale. Considerando

anche l’utilizzo di nuovi modelli

di fruizione come il cloud.

L’importante è dare servizi It più

flessibili, tempestivi e al costo

migliore. Coinvolgendo anche

gli utenti

per l’economia si fa sempre più forte. Fare

di più con meno e meglio di prima, questo

è l’imperativo. Si può fare? Si deve fare.

Bisogna trovare la strada. E una delle strade

possibili sta nella ridefinizione, per non dire

nel completo ripensamento, di come le risorse

Non sappiamo dire se per le

infrastrutturali sono organizzate, utilizzate e

persone che in un’impresa, o in un’organiz-

gestite per fare ciò che si chiede loro, che è

zazione qualsiasi, sono a capo dei Sistemi

appunto quello di erogare servizi It in modo

Informativi vi siano mai stati dei tempi felici.

ottimale, che oggi significa dare servizi più

Ma se mai ci sono stati, gli “happy days”

flessibili, più tempestivi e al costo migliore.

sono finiti da un pezzo, e se oggi (per modo

Che non è quello più basso, ma quello che

di dire, perché parliamo di un ‘oggi’ che

vede la spesa It rendere di più.

dura da tempo) il Cio non porta più il camice

Se guardiamo all’evoluzione del data

bianco e ha raggiunto uno status che lo

center pensando all’insieme dell’infrastruttura

pone a livello del board, è anche oggetto di

come a una piramide, vediamo che negli

pressioni che rendono la sua poltrona una

ultimi dieci anni si è avuto un progressivo

delle più scomode dell’azienda. Ai respon-

spostamento da un’infrastruttura scalabile

sabili It si chiede infatti di risolvere problemi

verso il vertice a una scalabile verso la base.

prioritari e contrastanti. Mentre i dirigenti

Vogliamo dire che si è passati da un aumento

delle linee di business chiedono risposte

della capacità di elaborazione ottenuta con-

rapide alle loro necessità, e ne hanno diritto

centrandola su mainframe o sistemi Legacy

perché nemmeno la loro vita è facile, i re-

sempre più potenti ad uno ottenuta distribuen-

sponsabili finanziari, per i quali l’It è sempre

dola su server industry standard sempre più

e comunque un costo, chiedono di ridurre

numerosi. Se questo ha portato alle aziende

le spese con una voce che in tempi difficili

utenti indubbi vantaggi economici, sia per

SCENARIO

maggior costo derivante dalla gestione dei

singoli server, e il risultato è il successo

che stanno incontrando le soluzioni

di virtualizzazione.

Costi operativi – Lo

squilibrio fra quanto viene

Ma se la virtualizzazione

mente recente, spinta dal rapido aumento

permette di aumentare

sia dei consumi sia dei costi dell’energia.

l’effettivo utilizzo delle

Oggi si può dire che l’alimentazione e il

macchine, riducendo lo

raffreddamento (si consuma più energia per

spreco in hardware, crea anche

raffreddare che non per alimentare i sistemi)

dei nuovi problemi. Diventa infatti

difficile per i system administrator impo-

siano ai primi posti nell’agenda dei data

center manager. In molti casi il consumo

speso per lo sviluppo di nuove

stare e gestire il gran numero di connessioni

è un fattore limitante primario al potenzia-

il minor investimento richiesto dall’acquisto

soluzioni e quanto viene speso sem-

che consegue all’aumento delle macchine

mento della capacità di calcolo di un data

delle macchine x86, basate su componenti

plicemente per far funzionare il data center è

virtuali e crescono anche i tempi (e costi) dello

center del quale non si possano rinnovare

standard, sia per il fatto di poter adeguare

noto: il day-by-day assorbe i tre quarti delle

staff. Questi ultimi sono dovuti alla quantità

gli impianti per il controllo dell’ambiente.

tale investimento allo sviluppo del business,

risorse. E sotto la spinta del crescente numero

di processi che vanno eseguiti manualmente

L’aumento dei consumi è strettamente inerente

comprando nuove macchine mano a mano

di server installati, i costi del personale dedi-

e al fatto di dover lavorare sulle differenti

al passaggio verso gli ambienti It distribuiti,

che se ne presenta il bisogno, ciò ha peraltro

cato alla gestione e manutenzione ordinaria,

configurazioni dei server necessarie per gestire

dato che l’energia necessaria ad alimentare

creato alla funzione It, e di conseguenza alla

cui si aggiungono quelli per l’alimentazione e

le diverse applicazioni che fanno parte di

una serie di piccoli sistemi è molto superiore

stessa impresa, non pochi problemi. Infatti,

il raffreddamento di macchine sottoutilizzate,

un processo di business. Non solo: i system

(con crescita esponenziale al numero dei

mettendo assieme decine o, nelle grandi

sono cresciuti tanto da superare gli investi-

administrator sono chiamati anche a gestire le

dispositivi alimentati) a quella richiesta da

realtà, centinaia di server fisicamente legati

menti in nuovo equipaggiamento It. Per porre

complesse integrazioni tra server, rete e sistemi

un singolo grande sistema avente la stessa

tra loro da fasci di cavi di ogni genere e

un freno a questa tendenza si cerca di ridurre

storage esterni. È chiaro come a fronte di tutto

capacità di calcolo.

funzione (per l’alimentazione, l’input/output,

i costi operativi semplificando e standardiz-

questo aumenti la domanda di soluzioni che

la connessione alle unità storage, alle periferi-

zando per quanto possibile l’infrastruttura e

permettano allo staff di automatizzare per

interventi sull’infrastruttura era rivolto al poten-

che e quant’altro ancora) si è venuto a creare

migliorando i processi di gestione. Una sfida

quanto possibile l’esecuzione dei compiti più

ziamento delle prestazioni e al miglioramento

un ambiente tanto complesso nella struttura

che l’attuale contesto economico, che vede

di routine, accelerando i processi operativi e

della disponibilità dei sistemi. I consumi

quanto rigido nelle funzionalità.

le imprese impegnate ad emergere da una

riducendone il tasso di errore, in modo che il

correlati erano visti come un problema se-

crisi i cui effetti perdurano, rende più difficile:

tempo dello staff possa essere dedicato a pro-

condario, o addirittura come una delle spese

i responsabili It non possono infatti proporre

getti innovativi e a maggior valore aggiunto.

generali, come l’illuminazione o le pulizie,

UN MODELLO

CHE FRENA L’IMPRESA

Il tempo e le risorse economiche, intese

anche come costo del lavoro, assorbite dalla

gestione dei data center così come sono

Consumo energetico – L’attenzione a

questo aspetto dell’infrastruttura è relativa-

In passato, l’obiettivo primario degli

oggi grandi piani d’investimento e devono

che ogni azienda deve mettere in conto per il

focalizzarsi su soluzioni che presentino un

solo fatto di essere in attività. Oggi l’atteggia-

ritorno nel breve termine.

mento è cambiato e i responsabili It vedono

Tempi di lavoro – La diffusione degli

Per trarre dall’infrastruttura

nell’adozione di sistemi capaci di ridurre il

il massimo valore

consumo di energia per l’alimentazione e il

strutturati nella maggioranza delle aziende,

ambienti distribuiti e scalati verso il basso di

ostacolano l’impegno dell’It verso lo sviluppo

cui si è detto, ha comportato una tendenza,

di nuovi servizi applicativi che sarebbero

facilitata anche dal sensibile miglioramen-

necessari al business, finendo quindi per

to del rapporto prezzo-prestazioni delle

manager devono poterne

frenare lo sviluppo dell’impresa, e colpiscono

macchine x86, verso infrastrutture sovradi-

utilizzare le risorse,

gestita come una business unit, o dell’intera

direttamente la stessa organizzazione It in

mensionate, in grado di garantire la capacità

elaborativa necessaria a rispondere ai picchi

di elaborazione come

organizzazione.

quattro aree fondamentali per il suo buon

funzionamento: costi operativi, tempi di lavo-

della domanda. Il modello tipico è stato, fino

ro, consumo energetico e flessibilità, intesa

a poco fa, quello di un’applicazione per

(flessibilità), ma anche

come capacità di rispondere rapidamente ai

server, con server dimensionati in funzione

a livelli differenti

altra esige un’opera di miglioramento. Non

cambiamenti. Vediamo qual è la situazione

del picco di domanda dell’applicazione

(scalabilità)

staremo qui a ripetere i motivi per cui, sotto

in tali aree e cosa si sta facendo per porvi

ospitata. La dispersione di risorse insita

la spinta dei consumatori, dei concorrenti e

rimedio.

in questo modello è intuibile, così come il

dei mercati i modelli e i processi di business

di business, i data center

di storage, in modi differenti

raffreddamento un investimento capace di

dare un ritorno immediato in termini economici, a vantaggio della funzione It, qualora sia

Flessibilità – Abbiamo lasciato per

ultima la più importante delle aree funzionali

di un data center e quella che più di ogni

SCENARIO

L’ORCHESTRAZIONE

DELLE INFRASTRUTTURE

sate per dare vantaggi in una più lunga prospettiva. Vi sono tool capaci di raccogliere

Tramite appositi strumenti software, gli

e analizzare dati relativi al livello di utilizzo

amministratori di sistema possono creare

della potenza delle Cpu, della capacità dello

diversi modelli di infrastruttura (service

storage e della larghezza di banda della

template) che descrivono i server, lo storage

rete. Tramite tali strumenti si ha una chiara

e le connessioni di rete necessarie a fornire

visione di come funziona l’infrastruttura, quali

sappiamo, sono

sono i suoi colli di bottiglia o, al contrario, le

formati da un

zone sottoutilizzate. Questo permette un’ot-

telaio che ospita un certo

timizzazione continua dell’uso delle risorse,

numero di schede, le ‘lame’ appunto,

migliorando nel tempo l’efficienza operativa

ciascuna delle quali è un vero e proprio

del data center e anche il suo rendimento

server, completo degli elementi necessari allo

economico.

svolgimento delle funzioni essenziali di elabo-

un determinato servizio It. Questo permette

di estrarre dal pool delle risorse disponibili

solo quelle volta a volta realmente

occorrenti, realizzando un coordinamento

delle risorse che ottimizza l’utilizzo

dell’intero data center. Il feedback dato dai

tool di analisi permette poi d’intervenire

nel provisioning modificandolo in funzione

delle effettive richieste applicative rilevate

RISORSE VIRTUALIZZATE

E SERVIZI CONDIVISI

Un ulteriore passo verso il nuovo data

Questi, come

Un ulteriore passo

verso il nuovo data

center consiste

razione, gestione input/output e accesso alla

nel realizzare

memoria di massa locale e a quelle esterne.

un modello di

Il numero e la disposizione degli elementi

provisioning

(processori, Ram, controller di rete e porte di

che possiamo

center consiste nel realizzare un modello di

I/O) sulla scheda può variare, ed esistono

provisioning che possiamo definire di “servizi

schede storage che si possono combinare

definire di “servizi

cambiano a un passo sempre più veloce in

nenti (server piuttosto che storage) ma estesa

del momento, andando così ad inficiare uno

condivisi” che consolida le risorse server,

con quelle server in modo da avere, in un

condivisi” che

ogni settore d’industria. Quello che conta

all’intero ambiente operativo. Ciò richiede un

degli scopi principali del consolidamento,

storage e di rete, in “bacini” (pool) di risorse

solo telaio, un sistema completo variamente

è che l’It deve rispondere con la massima

approccio al problema che presuppone una

cioè l’impiego ottimale ed economico delle

virtualizzate gestibili in modo da fornire i

configurabile.

consolida le risorse

prontezza a tali cambiamenti; addirittura,

nuova visione dell’infrastruttura e delle sue

risorse fisiche.

servizi infrastrutturali richiesti. Questi ultimi

se possibile, anticipandoli. Ciò riguarda,

funzioni.

come ovvio, anche l’infrastruttura perché non

serve sviluppare un servizio innovativo se

poi non si riesce ad erogarlo come si deve.

LE TECNOLOGIE ABILITANTI

L’approccio tradizionale alle componenti

Questa architettura realizza un sistema

server, storage e

possono essere descritti da schemi (templates)

ad alta densità e ad alta efficienza. Infatti,

di rete, in “bacini”

stesso data center coesistano ambienti fisici e

disegnati in funzione delle applicazioni busi-

mentre le blades contengono quello che

(pool) di risorse

virtuali separati, con architetture ben diverse.

ness, il che facilita un’erogazione tempestiva

serve all’elaborazione, e solo quello, è il

L’ambiente virtuale comprende un gruppo di

dei servizi nonché il migliore coordinamento

telaio a fornire alimentazione e raffreddamen-

virtualizzate

Si verifica di frequente il caso che in uno

gestibili in modo

Per trarre dall’infrastruttura il massimo valore

infrastrutturali considera sovente i server, lo

server fisici che vengono utilizzati esclusiva-

delle risorse fisiche ad essi sottostanti. Il dia-

to, nonché, a seconda dell’impiego e delle

di business, i data center manager devono

storage, i dispositivi di rete e talvolta anche i

mente per ospitare macchine virtuali, mentre

gramma di figura 1 mostra il ciclo operativo

scelte dell’utente, capacità storage esterna,

poterne utilizzare le risorse, di elaborazione

sistemi di alimentazione come entità separa-

l’ambiente fisico comprende un gruppo di ser-

di tale orchestrazione, con l’accesso dei

switch per connessioni di rete e, importante,

infrastrutturali

come di storage, in modi differenti (flessibili-

te. Sebbene questi elementi siano destinati a

ver (ovviamente anch’essi fisici) ciascuno dei

templates al pool delle risorse e il relativo

l’interfaccia per gli strumenti di gestione

richiesti.

tà), ma anche a livelli differenti (scalabilità).

funzionare insieme, sono acquistati, messi in

quali è configurato per ospitare una singola

feedback fornito dai tool di analisi di cui si è

dell’intero sistema così configurato.

Non appena una nuova applicazione viene

opera e gestiti attraverso diverse procedure e

applicazione. È chiaro come una situazione

detto verso l’amministratore di sistema.

sviluppata e testata e può andare il linea,

spesso anche da diverse persone. Questo è

del genere, che spesso è giustificata come

diventa indispensabile che l’infrastruttura

una causa di lentezza ed inefficienza nell’ero-

conseguente ad una scelta prudente d’intro-

gazione dei servizi It al business, e non è

duzione progressiva della virtualizzazione

raro che la messa in produzione di un nuovo

server richieda settimane di lavoro.

possa supportarla a crescenti livelli ad

un costo minimo. In un ambiente

non virtualizzato, dove

le configurazioni di server, storage e rete siano a

livello hardware, la cosa è

difficile e comunque costosa,

per tutti i problemi di cui si è

detto a proposito dei tempi e

costi di lavoro. La risposta è quindi

ancora la virtualizzazione, che non

deve però essere limitata a compo-

server ‘blade’.

Nel caso delle soluzioni di virtualizza-

La realizzazione di questo modello di

da fornire i servizi

L’alta densità rappresenta un evidente

vantaggio perché riduce lo spazio fisico

e dal fatto che tutti i componenti del telaio

nuovo data center, dalla virtualizzazione

necessario al data center, con conseguente

sono ridondati, e infine quella che potremmo

integrata, dalla gestione unificata e centra-

riduzione dei costi per i sistemi di condizio-

chiamare “predisposizione alla flessibilità”. A

(di solito limitata agli ambienti di sviluppo e

lizzata e dalla componentistica standardiz-

namento e antincendio dell’ambiente e per

differenza di un server tradizionale, un blade

testing) porti ad aumentare la complessità

zata e orientata alla massima efficienza in

la sicurezza degli accessi e dei locali. Ma il

può caricare sistema operativo e applica-

dell’intera infrastruttura. Si evidenzia quindi

rapporto al costo d’investimento e ai costi di

guadagno di spazio è solo uno dei punti di

zioni anche dall’esterno. Ciò ne aumenta

zione, la cui adozione è oramai largamente

l’importanza di avere strumenti capaci di

gestione, si basa, come ovvio, oltre che sulle

forza dell’architettura. Gli altri sono l’efficien-

l’availability, eliminando il rischio di un crash

diffusa, si rischia di ripetere lo stesso approc-

gestire entrambi gli ambienti da un’unica

soluzioni software di virtualizzazione e system

za energetica derivante dalla densità (costa

del disco fisso, e rende più facile installare

cio. In mancanza di una precisa politica

console.

management, su tutta una serie di tecnologie

meno raffreddare un punto piccolo e molto

un software di virtualizzazione in grado di

che definisca i requisiti e l’allocazione delle

hardware che investono, come vedremo in

caldo che uno meno caldo ma più grande), il

caricare sulle diverse blade macchine virtuali

macchine virtuali in funzione delle applica-

l’attenzione degli It manager sia rivolta, come

Ancora in tema di gestione, per quanto

dettaglio nelle pagine a seguire, sia le Cpu

minor costo delle componenti accessorie (un

aventi diversi sistemi e diverse applicazioni.

zioni e dei processi di business è probabile

si è detto, a soluzioni capaci di dare un

sia l’architettura di sistema. Quest’ultima in

alimentatore grosso costa meno e rende di

Come tutte queste capacità, ed altre ancora

che queste finiscano per proliferare in modo

ritorno economico immediato, è comunque

particolare ha fatto un salto generazionale

più di tanti alimentatori piccoli), l’affidabilità

possano essere declinate in un’unica soluzio-

incontrollato e casuale, secondo le necessità

necessario investire anche in soluzioni pen-

con l’introduzione, qualche anno fa dei

generale, data dalla riduzione dei cablaggi

ne vedremo tra breve.

Private cloud

PRIVATE CLOUD:

BEN CAPITO

DALLE IMPRESE

L’aumento dell’interesse verso la creazione di un corporate cloud

e della relativa infrastruttura è dovuto alla maggiore comprensione

che in questi due anni i responsabili It hanno potuto farsi

del modello cloud e della sua applicazione in azienda

ca una rete chiusa. Erogando quindi servizi It

sul modello del cloud computing a un limitato

numero di utenti all’interno di un perimetro

definito e protetto da firewall e secondo livelli

data center aziendali. Ed è probabile, se-

di prestazioni e availability definiti.

Di cloud computing si Ciò si può fare in due modi: chiedendo

condo Gartner, che gli investimenti in private

parla da circa un paio d’anni, che

verso infrastrutture di cloud privato sia almeno

agli eventuali service provider un accesso

cloud possano superare nei prossimi anni la

nel metabolismo accelerato con il quale vive

pari a quello verso l’acquisto di servizi cloud

su rete privata (Vpn) o implementando il

spesa per l’acquisto di servizi da parte dei

il mondo dell’It è un periodo di tempo più

esterni, se non maggiore.

modello cloud sulla intranet dell’azienda. Nel

cloud services provider. Come è possibile

primo caso si ha in sostanza, dal punto di

che alcune aziende, dopo aver creato la loro

che sufficiente a digerire concetti e parole

parte del mercato fa ritenere che l’interesse

Questa evoluzione, cioè l’aumento del-

per trasformarli in attività e business. E così

l’interesse verso la creazione di un corporate

vista dell’utente, una forma di outsourcing.

è stato: nel giugno del 2008 Gartner lanciò

cloud e della relativa infrastruttura, è dovuto

Questa si può declinare in diverse modalità

cloud’ riguarda il provider, la sua struttura,

on-demand; accesso da portale e in modalità

fornendo servizi a clienti e partner e facendo

alcune previsioni su un fenomeno del quale,

alla maggiore comprensione che in questi

a seconda che i servizi forniti riguardino

organizzazione e modello di business, ma

self-service; interfacce utente unificate e

così fruttare al meglio il loro investimento.

allora, si stava ancora cercando di dare una

due anni i responsabili It hanno potuto farsi

soluzioni software (SaaS) o si estendano alla

non l’utente, che ha tutto il diritto, come in un

browser-like. Alla base di tutto ciò sta

definizione dichiarando che entro il 2012

del modello cloud e della sua applicazione

piattaforma (Paas) o all’infrastruttura (IaaS). Il

qualsiasi contratto di outsourcing, a ricevere

un’infrastruttura altamente virtualizzata in ogni

privato non è un problema solo tecnologico.

otto su dieci delle ‘Fortune 1000’ avrebbero

in azienda. Da una parte ci si è resi conto

fatto che si possa parlare o meno di ‘servizi

un servizio in forma completamente dedicata

suo componente: server, storage e rete, la cui

Il private cloud cambia infatti la gestione dei

usufruito di servizi di cloud computing a

che i livelli di prestazioni, di disponibilità

e nel rispetto di Sla stabiliti. Nel secondo

realizzazione è il punto di partenza per ogni

processi aziendali, quando non i processi

pagamento, una su tre avrebbe realizzato

e soprattutto di sicurezza (come accessi e

caso invece l’impresa diventa nello stesso

progetto del genere.

stessi (si pensi all’effetto dirompente che può

una propria infrastruttura per il cloud e che il

come controllo sui dati aziendali), richiesti

tempo fornitrice e utente dei servizi It, ed è

peso di tali iniziative nelle strategie aziendali

per l’esecuzione delle applicazioni business

il ‘private cloud’, o ‘corporate cloud’ di cui

sarebbe stato pari a quello dell’e-business.

sono, almeno ancora allo stato attuale,

Oggi, giunti alla metà dell’arco di tempo

difficilmente compatibili con il modello, per

preconizzato, crediamo di poter dire che se

così dire, originario del cloud computing, che

queste previsioni avranno un margine d’er-

parla (come definito appunto da Gartner due

rore, questo sarà in difetto. Complice anche

anni fa) di “capacità It largamente scalabili

la crisi economica, i servizi cloud, con la

fornite come servizio attraverso l’internet a più

loro promessa di risparmio immediato, sono

utenti esterni”. Dall’altra parte, in compenso,

in accelerazione e interessano quasi tutte le

si è capito che i vantaggi di scalabilità,

imprese, e non solo le maggiori. E anche se

economicità e flessibilità d’uso insiti in tale

use; ca-

si tratta di un fenomeno più difficile da mi-

modello si potevano coniugare alle esigenze

pacità di

maggior

surare, il feedback che i vendor It hanno da

di cui si è detto sostituendo all’internet pubbli-

delivery

parte dei

La costruzione di

un ambiente cloud privato

non è un problema solo

tecnologico. Il private cloud

cloud privata, decidano di aprirla all’esterno

parliamo.

Perché un private cloud sia tale deve

avere le stesse caratteristiche del cloud

pubblico. Ossia: capacità di allo-

cambia infatti la gestione

cazione dinamica dei servizi;

dei processi aziendali,

sistema di billing (cioè

quando non i processi stessi

di attribuzione di

costi) pay-per-

Le tecnologie di virtualizzazione,

applicate a sistemi di elaborazione e storage

di intrinseca flessibilità come quelli ba-

La costruzione di un ambiente cloud

avere l’accesso self-service o l’attribuzione

dei costi in funzione dell’uso), interferendo

quindi sull’organizzazione del lavoro e delle

sati sulle architetture blade e serviti

persone. Si dovranno fare studi di fattibilità

dai processori di più recente

e adottare best practices che in buona parte

generazione, permettono

già ora d’implementare

infrastrutture adatte al

delivery di servizi

sono ancora da trovare. Dotarsi dell’infrastruttura è un problema relativamente più

semplice. Ma proprio per questo conviene

probabilmente partire proprio da lì.

cloud privati

presso la

TECNOLOGIA MATRIX

L’architettura di Matrix

HP BladeSystem Matrix

Figura 1

HP Converged Infrastructure

Pool di risorse server, storage

e di rete, con servizi condivisi

per rispondere alla flessibilità

del business. La risposta HP

con la Converged Infrastructure

e il BladeSystem Matrix

Matrix può essere facilmente incorporato

dell’infrastruttura di cui

nell’ambiente di data center management

è dotato abilitano il provisioning

dell’utente tramite i moduli Virtual Connect di

del pool delle risorse condivise

cui i telai BladeSystem sono dotati, che ne

in funzione delle richieste

permettono la connessione a qualsiasi rete

del business

Ethernet o a un cablaggio Fibre Channel

abilitato NPIV (N_Port ID Virtualization). La

piattaforma, infine, è compatibile con numerosi sistemi operativi e hypervisor.

IL PROVISIONING

DELLE RISORSE

L’architettura di Matrix e le funzionalità di

cosa importante, la flessibilità operativa ine-

gestione dell’infrastruttura di cui è dotato abili-

rente a questo modello viene ottenuta senza

tano, come si è detto all’inizio, il provisioning

rinunciare a un controllo centralizzato sull’am-

del pool delle risorse condivise in funzione

ministrazione degli asset (server, storage e

delle richieste del business. Questo avviene

rete) e dei servizi generali del data center.

costruendo, con l’ausilio di uno strumento

Il modello degli shared services viene

Se guardiamo all’evoluzione

grafico, diversi modelli di infrastruttura, com-

abilitato da HP attraverso la soluzione di

prendenti i server fisici e virtuali, lo storage,

punta della HP Converged Infrastructure

la rete e le relative connessioni. Tipicamente,

(figura 1), e cioè il BladeSystem Matrix, che

ogni modello (service template) rappresenta

permette all’It di erogare servizi infrastrutturali

tutte le risorse infrastrutturali occorrenti per

a utenti e business unit in modo programma-

gestire un dato servizio applicativo, come

bile, veloce ed efficiente a un costo ridotto.

può essere un Ucc basato su Exchange,

Vediamo com’è fatto e come funziona.

una soluzione Erp o anche un’applicazione

delle infrastrutture It dal punto di vista

L’ARCHITETTURA GENERALE

della tecnologia dei sistemi osserviamo che

Sebbene utilizzi componenti modulari

custom. I service template realizzati dagli It

designer sono quindi raccolti in una library

e presentati agli utenti aziendali. Tramite un

gli sforzi si sono fino ad oggi concentrati

industry-standard, l’HP BladeSystem Matrix

essenzialmente sulle prestazioni e sulla cosid-

integra in un’unica piattaforma Converged

provisioning, all’ottimizzazione e alla prote-

detta ‘availability’, ossia sul fatto che, grazie

Infrastructure un insieme di tecnologie proprie-

zione dell’infrastruttura. Ogni soluzione Matrix

alla qualità, al dimensionamento e alla even-

tarie che fanno parte sia dell’offerta enterpri-

viene fornita factory-integrated, cioè predispo-

se HP, con soluzioni di provata efficacia in

sta e pronta all’uso, e comprende servizi di

ambito data center, sia dell’offerta di partner

implementazione e di training on-site da parte

sfruttata da altri utenti.

portale self-service questi avanzano la richie-

tuale ridondanza dei componenti, un sistema

termini di tempo e risorse umane riconfigurarli

sia sempre disponibile a svolgere i compiti

di volta in volta per compiti diversi da quelli

necessari alla delivery dei servizi. Relati-

cui sono destinati. La prima risposta a tale

re un modello di servizi condivisi (shared

che nei loro campi di competenza (storage,

di HP. Matrix supporta tutta la gamma dei

vamente poco è stato fatto per rendere il siste-

problema sta, ovviamente, nel consolidamen-

services), che permetta di consolidare gli

networking, management e business applica-

blade server HP ProLiant e Integrity, a piena e

ma stesso flessibile riguardo lo svolgimento di

to e nella virtualizzazione dei sistemi, cosa

asset server, storage e di rete, sia fisici sia

tions) sono nomi di riferimento. Ciò permette

a mezza altezza, ed è scalabile fino a oltre

tali compiti, la cui natura cambia in funzione

che infatti quasi tutte le imprese stanno ormai

virtuali, in più insiemi di risorse virtualizzate.

di affrontare i carichi di lavoro di tutte le più

1.500 sistemi gestiti, tra macchine virtuali e

dei servizi It richiesti dal business. Il risultato

attuando. Ciò però riduce ma non elimina

Questi pool di risorse possono essere gestiti

diffuse applicazioni inserendosi perfettamente

istanze a macchine fisiche. Per lo storage, è

di tale rigidità funzionale è il proliferare, nei

del tutto il problema dell’over-provisioning,

in modo da poter servire più set di servizi

nei diversi ambienti degli utenti.

consigliato lo StorageWorks 4400 Enterprise

data center, di più sistemi dedicati ai diversi

cioè del dover predisporre più risorse It di

infrastrutturali, tipicamente mappati sui servizi

compiti; sistemi destinati inevitabilmente ad

quante occorrano, destinando a specifiche

applicativi. Lo staff It può quindi erogare in

Matrix) comprende (vedi figura 2) uno o più

ma Matrix può essere connesso a ogni HP

essere spesso sottoutilizzati (non c’è business

applicazioni, o business unit, risorse la cui

modo flessibile i servizi richiesti e ottimizzarne

telai BladeSystem c7000, con blade server e

StorageWorks, nuovo o che l’utente abbia

dove la richiesta dei servizi It non segua dei

eventuale capacità in eccesso rispetto ai

le sottostanti risorse in modo da garantire

storage condiviso dimensionati sui require-

già in casa, nonché a San Fibre Channel di

cicli temporali), essendo antieconomico in

compiti (che restano variabili) non può essere

prestazioni, efficienza e disponibilità. Inoltre,

ment dell’utente, più il software necessario al

terze parti. La console di gestione, costruita

La vera soluzione sta nell’implementa-

su HP Inside Dynamics, combina provisioning

automatizzato, capacity planning e disaster

recovery.

e le funzionalità di gestione

garantire

SERVIZI IT

“business value“

10

Il sistema

HP BladeSystem Matrix

Un BladeSystem Matrix (o semplicemente

Virtual Array, che viene integrato in fabbrica,

11

TECNOLOGIA MATRIX

Figura 2

Architettura dell’HP BladeSystem Matrix

INTERVISTA

convergeD

INFRASTRUCTURE,

soluzione che garantisce, tramite un

insieme di funzioni di rilevamento

e controllo chiamato “Thermal

Logic”, un raffreddamento efficace senza inutili sprechi

energetici ottimizzando,

TECNOLOGIA

AL LAVORO

di conseguenza, lo

stato termico e

la richiesta di

energia dell’intero

sistema. Tramite le “Active

Cool”, ventole ridondate e ad

alta efficienza termica controllate

Infrastrutture flessibili per rispondere

alle variabili di business garantendo

prestazioni ottimali

dall’Onboard Administrator, la capacità

di raffreddamento viene alzata o abbassata

automaticamente in funzione delle richieste

sta del servizio loro occorrente e il sistema

architettura sono tre: il sistema di gestione

del sistema. Lo stesso vale per gli alimentato-

business. Nella ‘Converged’, invece, viene

(assistito da funzioni di capacity planning)

incorporato, il sistema di alimentazione

ri, che vengono allocati secondo le richieste

soprattutto evidenziata una nuova tendenza

provvede al provisioning automatico delle

e raffreddamento condiviso, il sistema di

di potenza relative a ogni blade.

evolutiva, che viene ad aggiungersi a quelle

risorse infrastrutturali previste dal relativo

virtualizzazione della connettività. Vediamoli

service template estrandole dal pool delle

in breve.

risorse disponibili.

considerate in precedenza e che è prettamen-

HP Virtual Connect è un elemento fondante

di Matrix, potendo virtualizzare l’I/O dei

te tecnologica.

“I concetti sui quali si è svilup-

“Ci si è accorti – prosegue Tognon

serie di controller (Onboard Administrator

server in modo da convogliare tramite una

pata la visione della Converged

– che una serie di silos tecnologici che fino

prevede il coordinamento tra più gruppi

management) posti a livello di telaio e di pro-

stessa porta fisica connessioni a reti Ethernet

Infrastructure, che HP ha presentato

ad oggi si sviluppavano in modo parallelo,

distinti all’interno del data center o della

cessori di gestione (iLO, per Integrated Lights

o Fibre Channel. Le reti Lan e San prevedono

funzione It e richiede tipicamente settimane di

Out) posti su ogni scheda server. I controller

normalmente un indirizzamento biunivoco

lavoro, il processo di provisioning di Matrix

dell’Administrator comunicano con gli iLO

delle risorse. Se un server (o uno storage, nel

permette di dare al business le infrastrutture

rilevando i parametri relativi all’alimentazione

caso delle San) viene aggiunto, eliminato

concetto di Adaptive Infrastructure

di cui ha bisogno nel giro di poche ore o

e allo stato termico del server e alla configu-

o sostituito, cambiano gli indirizzi associati

che era stato ripreso da HP

addirittura di minuti.

razione del sistema e della rete. In pratica

e le reti connesse a quella risorsa vanno

gli iLO offrono all’Administrator una visione

riconfigurate. Il disaccoppiamento tra server

remota e virtuale di ogni singolo server

e reti introdotto da Virtual Connect permette

che permette ai controller di monitorarne le

invece di spostare volta per volta, con un clic

condizioni e intervenire sui parametri rilevati,

del mouse, ogni singola risorsa alla rete cui

ci”. Come spiega Tognon, nella ‘Adaptive’

quindi proporre anche un aspetto di fusione

sulla quale si basa Matrix, è concepita per

gestendoli in modo coordinato. L’Onboard

dev’essere connessa per assolvere ai compiti

si sottolineava soprattutto la capacità di

delle tecnologie che, per quanto non sia

rispondere in modo specifico alle esigenze

Administrator semplifica il setup del telaio e la

assegnati. E stante le funzioni di automazione

mettere a disposizione degli utenti soluzioni

ancora raggiunta sotto ogni fronte, è sempre

di gestione dei data center, incorporando

configurazione della relativa rete, attuabili da

di cui la console Matrix è dotata il risultato

infrastrutturali il più possibile standardizzate,

più vicina ad essere realizzata, grazie anche

risorse modulari di elaborazione, storage e

remoto tramite un’interfaccia grafica.

finale è la possibilità di spostare dinami-

in modo che fossero facilmente adattabili ad

alla razionalizzazione di alcuni protocolli”.

camente i carichi di lavoro da una all’altra

impieghi diversi per soddisfare sempre più

Un esempio sintomatico di questo approccio

Rispetto a un processo tradizionale, che

LA TECNOLOGIA

ABILITANTE

L’architettura dei BladeSystems classe c,

rete che realizzano una infrastruttura reattiva

12

Gestione di sistema – Si compone di una

Connettività virtuale – La tecnologia

Alimentazione e raffreddamento

l’anno scorso – esordisce Fabio Tognon,

come le architetture server, quelle storage e

HP BladeSystem Product Manager

le soluzioni software, tendevano sempre più

– rappresentano l’evoluzione del

nel periodo precedente. La

differenza tra i due modelli sta

sostanzialmente in una nuova prospettiva che ne riguarda gli aspetti tecnologi-

ad avvicinarsi”, cioè tendevano a essere integrate e integrabili tra di loro nelle funzionalità

e tecnologie di base. “Ci si è impegnati

pertanto - prosegue Tognon - a rendere i relativi prodotti sempre più integrati, portandoli

talvolta a collaborare in modo stretto tra loro.

Con la Converged Infrastructure intendiamo

ai cambiamenti imposti all’It dai bisogni del

– Alimentatori e ventole dei server sono gestiti

risorsa, senza intervento o coordinamento

critiche esigenze sul fronte del dinamismo e

è dato dalle realizzazioni in cui l’architettura

business. I componenti fondamentali di tale

in modo condiviso a livello di telaio da una

umano.

della flessibilità di risposta ai problemi del

storage va a fondersi con l’architettura server

13

INTERVISTA

Un aspetto centrale della tecnologia

intel,

il cloud

blade e quindi anche della Converged

Infrastructure è poi la gestione dell’energia

per l’alimentazione e soprattutto per il

raffreddamento delle macchine. “Questo

problema – osserva Tognon – fino a due anni

fa interessava soltanto pochi utenti ed era

indirizzato quindi da prodotti specifici. Oggi

risparmiare energia è un’esigenza di tutti e

tutto l’hardware di nuova generazione, parlo

delle Cpu come dei moduli di memoria,

realizzando soluzioni che collaborano tra

viene progettato per poter essere gestito in

loro all’interno di una stessa infrastruttura

modo da ridurre in date condizioni l’energia

come mai prima. Se in precedenza era com-

assorbita e il calore da dissipare”. Il software

pito del network far lavorare assieme queste

di gestione dei sistemi fornisce quindi un

due componenti, ora ciò avviene senza

monitoraggio istantaneo dei consumi e può

dover ricorrere ai servizi della rete.

intervenire sull’hardware in modo da ridurre

Questa evoluzione è stata facilitata

di tutta l’infrastruttura in modo da contenerlo

assegna al telaio (o ‘enclosure’) il compito di

entro margini prestabiliti a fronte degli Sla

fornire servizi tecnologici comuni alle diverse

relativi alle prestazioni.

blade (tra questi ‘in primis’ alimentazione e

Ma come è recepito dagli utenti il con-

raffreddamento) e di ospitare un networking

cetto di Converged Infrastructure?

Fabio Tognon, HP BladeSystem Product Manager

Come osserva Tognon, l’elenco dei dispositivi

realizzati in struttura e formato blade per poter essere inseriti nel telaio e fruirne i servizi è

maggior efficienza ma anche protezione

dell’investimento”.

Un importante passo avanti su questa

strada è stato fatto un anno fa con l’introduzione dei processori Xeon 5500, che tramite

“Il Cloud computing – esordisce

Andrea Toigo, Enterprise Technology Spe-

grandi imprese”.

Nella visione Intel, il cloud aziendale,

soluzioni di virtualizzazione incorporate nel

processore e in altre componenti del sistema

“C’è un’evidente sensibilizzazione

cialist di Intel – è un nome nuovo che

o cloud privato, è il risultato dell’evolu-

superano alcuni colli di bottiglia legati

– prosegue Tognon – ad alcuni temi, tra i

definisce dei concetti che non sono

zione della virtualizzazione. Questa, che

all’I/O e riducono l’overhead prestazionale

quali appunto il risparmio di energia, cui

nuovi“. In effetti, la fornitura via internet

inizialmente era soltanto uno strumento per

dovuto al software di virtualizzazione. Gli

dell’I/O facilita

oggi sia le grandi imprese sia le Pmi sono

di servizi fruibili accedendo a infrastrutture

sfruttare con maggiore efficienza infrastrutture

Xeon 5500 danno ottimi risultati: “Sosti-

molto attente”. Poi c’è molta attesa per la

remote non è una novità, ma negli ultimi anni

hardware sottoutilizzate riducendone i costi

convergenza del networking. Le aziende

il modello ha beneficiato di progressi tali,

di ownership, oggi diventa una soluzione che

hanno infatti maturato skill importanti nelle

grazie a nuove tecnologie e nuove applica-

permette di gestire in maniera dinamica tut-

notevolmente, oltre alla

tuendo macchine single-core di quattro

o cinque anni fa con server basati

enormemente cresciuto negli ultimi tempi. Da

gestione delle risorse

un paio d’anni in qua la collaborazione tra i

storage di cui si è detto,

reti Ethernet e Fibre Channel, che sono

zioni, per cui, sia per le dimensioni raggiunte

to l’ambiente delegato all’erogazione

anche lo spostamento

spesso gestite da team dedicati. Convergere

sia per le opportunità che presenta in chiave

dei servizi It al business. E, come

su un network unico e virtualizzato semplifica

di business, il cloud computing è diventato un

intuibile, l’attenzione di Intel

i problemi, ma significa anche affrontare dei

tema di primo piano nell’agenda degli utenti

si rivolge proprio alle

to ridotto a soli otto

cambiamenti organizzativi nella gestione

come dei fornitori It.

tecnologie hardware

mesi”. La nuova

dispositivi, e in particolare tra blade server e

storage, è facilitata da Virtual Connect, una

tecnologia esclusiva di HP che virtualizza

dinamico sulle macchine

l’accesso allo storage rendendo disponibile

fisiche dei carichi di

al server dispositivi aventi caratteristiche diver-

lavoro svolti dalle

se in modo da estendere la flessibilità d’uso

applicazioni risiedenti

dell’intero sistema. ““La piu’ recente versione

di Virtual Connect, associata al software HP

sulle macchine virtuali

Insight Dynamics – aggiunge Tognon –, vir-

delle risorse umane.

“Possiamo fondamentalmente identificare

– prosegue Toigo – tre tipi di cloud. Un primo

zazione delle infrastrutture It:

tipo rientra nel modello classico dell’outsour-

“Lavoriamo – spiega Toigo – per

mentare rapidamente nuovi servizi al business

cing: l’azienda commissiona all’esterno dei

far sì che l’evoluzione della virtua-

senza problemi di compatibilità e di riconfigu-

servizi e purché questi siano regolarmente

Un terzo punto d’interesse riguarda

razione delle risorse hardware. “E HP, con

forniti non importa come ciò avvenga. Un

dell’I/O infatti facilita notevolmente, oltre alla

Matrix – osserva Tognon – va a rispondere

secondo tipo, del quale oggi si parla molto,

parte dell’utente del server fisico (uno degli

gestione delle risorse storage di cui si è detto,

proprio a questo tipo di esigenza, mettendo

è il software-as-a-service: accedo al sito di un

elementi chiave della soluzione HP BladeSy-

anche lo spostamento dinamico sulle mac-

a disposizione un’infrastruttura flessibile con

dato fornitore ed uso le soluzioni che questo

stem Matrix). Ciò sposa bene il paradigma

chine fisiche dei carichi di lavoro svolti dalle

pool di risorse destinabili, tramite il software

rende disponibili, a me come ad altri, con

della virtualizzazione, che è uno dei punti

applicazioni risiedenti sulle macchine virtuali.

di Orchestration, all’erogazione di nuovi

tutte le garanzie di sicurezza del caso. Un

fondamentali della Converged Infrastructure e

Una possibilità di cui traggono vantaggio i

servizi in tempi molto più brevi che lavoran-

terzo tipo, infine è il cloud aziendale. Ed è

nei confronti della quale possiamo parlare di

fornitori dei software di virtualizzazione per

do sul ‘bare metal’, cioè su macchine da

questo terzo modello quello che secondo noi

una tecnologia abilitante”. La virtualizzazione

ottimizzare le prestazioni dei loro prodotti.

inizializzare”.

è più interessante, soprattutto per le medie e

sul nuovo chip si può arrivare a

un rapporto di consolidamento

di nove a uno, con un

payback dell’investimen-

che facilitano la virtualiz-

infine, come è intuibile, la possibilità d’imple-

rende sempre più lontana l’individuazione da

tualizza l’I/O delle macchine a un livello che

14

lizzazione all’interno dell’azienda garantisca

La virtualizzazione

tra le blade server e quelle storage. Che non

sono peraltro nemmeno le uniche ospitate.

Soltanto con processori e architetture

di livello è possibile dare al cloud

quella robustezza e qualità di servizio

che le aziende ricercano

sprechi e dispersioni, ottimizzando il consumo

e accelerata dall’architettura blade, che

che fa da vero e proprio tessuto connettivo

nel PROCESSORE

15

SOLUZIONI

facilmente intuire, essendo il guadagno di efficienza globale di un’infrastruttura il prodotto,

più che la somma, dei guadagni sui singoli

componenti, i vantaggi in termini di efficienza

famiglia Xeon 7500 estende le

sono maggiormente percepibili nelle realtà

“Un’osservazione che vorrei fare in tema

prestazioni di questa architettura a

di grandi dimensioni. Che non a caso sono

generale di cloud computing – aggiunge

processori che possono arrivare

appunto quelle che per prime hanno avviato

infatti Toigo – è che questo modello è sicura-

progetti di consolidamento e virtualizzazione

mente di grande impatto anche nelle medie

mette di realizzare macchine

e che vengono viste dagli analisti come il

e piccole imprese. Mi riferisco in questo

di fascia alta in grado di

primo e più naturale bacino di utenza del

caso non al cloud privato, ma a quello di

offrire una maggiore espandibilità

private cloud. Ma non è affatto detto che

fino a otto ‘core’. Questo per-

e supportare un maggior volume di

memoria. Potendo indirizzare fino a un

virtualizzazione e private cloud non

portino sensibili vantaggi anche

Terabyte di Ram all’interno di una singola

applicate a realtà di minori

macchina, si può virtualizzare, o come dice

dimensioni.

fonte esterna (non importa se in forma di

outsourcing piuttosto che di servizi forniti

INFRASTRUTTURE

“INTEL INSIDE”

Efficienza energetica, virtualizzazione, prestazione e gestione.

Tutti aspetti che investono le infrastrutture cloud oriented. Con un “cuore” Intel

via internet), tramite il quale un’azienda può migliorare la propria

efficienza informatica, e non

solo, senza dover necessariamente fare investimenti

in infrastruttura e,

cosa più importante,

senza doversi procurare

competenze tecnologiche difficili

da trovare. In altre parole, il cloud

computing permette a una Pmi di focalizzarsi sulle competenze che sono al cuore del

suo business e nello stesso tempo di fruire di

tutti i vantaggi che l’innovazione tecnologica

le può dare”.

Occorre però superare problemi di

conoscenza e cultura: “Tanto per cominciare

– dice Toigo – bisognerebbe chiarire, in

Toigo con un’efficace immagine “portare nel

Andrea Toigo, Enterprise Technology Specialist di Intel

cloud”, l’intero database di un’azienda o un

completo ambiente Erp.

L’innovazione portata dalla virtualizzazione e dal cloud interno, che ne è la

il cloud aziendale,

ri: in primo luogo nello sviluppo di processori

Sul fronte dell’efficienza energetica, della

meno superfluo: da sempre protagoni-

in grado di rispondere al meglio ai requisiti

virtualizzazione e delle prestazioni delle Cpu,

bisognerebbe che fossero recepiti i legami

sta nell’evoluzione dell’It, la società ha una

di efficienza energetica e capacità di virtua-

la grande svolta si è avuta nel marzo 2009

tra il servizio offerto e la tecnologia, anche

posizione primaria non solo nel campo dei

lizzazione richiesti dalle infrastrutture cloud; in

con l’introduzione della prima famiglia di pro-

hardware, sottostante. Se questa è traspa-

microprocessori e dei semiconduttori in gene-

secondo luogo per lo sviluppo di soluzioni di

cessori basati sull’architettura Nehalem (dal

rente al fruitore del servizio, non lo è affatto,

re, ma con altre grandi aziende tecnologiche

ottimizzazione a livello di piattaforme e data

nome in codice del progetto che Intel aveva

come ovvio, per il fornitore, e la fattibilità

e consorzi industriali, anche nel campo degli

center in grado di potenziarne l’efficienza

in via di sviluppo sin dal 2001), cioè la serie

di un progetto di cloud privato passa per il

standard e dei modelli d’impiego di tecnolo-

nell’erogare servizi cloud e di ridurne il

Xeon 5500, che oggi equipaggia quasi tutta

rinnovamento ed efficientamento del data

gie rivolte al mondo consumer come a quello

costo di ownership totale, comprensivo cioè

l’offerta server x86 ‘quad core’ e alla quale

conseguenza e lo sviluppo, si esplica in vari

o cloud privato, è il

aspetti, ma soprattutto, secondo Toigo, nella

risultato dell’evoluzione

center. Di ciò le aziende diventano consa-

enterprise. L’attenzione di Intel per il cloud

dell’ammortamento del capitale investito e dei

si è recentemente aggiunta la serie 5600 (sei

della virtualizzazione.

pevoli quando, in fase di virtualizzazione,

computing si focalizza in due aree particola-

costi delle operazioni.

‘core) di cui diremo più avanti.

direzione di una maggiore efficienza generale dei servizi It e quindi dell’azienda stessa:

“Prima di tutto perché ho un unico metodo

Questa inizialmente era

Le serie Xeon 5500 e 5600 indirizzano

si tratta di far convivere macchine fisiche di

diversa generazione. “Noi diamo un aiuto in

il mercato dei server dual socket general-

di gestione delle macchine, e poi perché

soltanto uno strumento

avendo macchine virtuali posso aggiungere

per sfruttare con

gration, una tecnologia incorporata nei nostri

L’attività di Intel sulle tecnologie abilitanti

molto facilmente nuove risorse quando ne ho

maggiore efficienza

processori che permette la migrazione di una

il cloud computing si estende oltre lo sviluppo

mondo tecnico-scientifico. Un settore ampio

infrastrutture hardware

macchina virtuale da un server fisico a un

dei processori, indirizzando l’ottimizzazione

e differenziato, per affrontare il quale sono

bisogno. Allo stesso modo posso ottimizzare

i consumi di energia, riducendo il numero

delle macchine in uso quando non ho grandi

esigenze di elaborazione”. Come si può

16

Nella visione Intel,

Presentare Intel è quanto

generale, cosa si intende per cloud”. E poi

sottoutilizzate...

tal senso – conclude Toigo – tramite Flex Mi-

altro e consente quindi l’impiego di hardware

prodotto dal 2001 a oggi”. Dando nuovo

valore agli investimenti pregressi.

di piattaforme e data center con soluzioni che

comprendono prodotti hardware e software

purpose, dei sistemi HPc (High Performance Computing) e delle workstation per il

offerti numerosi processori ottimizzati per

diversi impieghi e applicazioni. Le soluzioni

che caratterizzano questi processori di nuova

17

gestire le macchine virtuali con un aumento

di più del doppio delle prestazioni e una

riduzione del 40% il tempo di latenza rispetto

ai precedenti Xeon 5400, mentre una quarta,

VT FlexMigration, abilita l’estensione del pool

delle risorse fisiche disponibili alle macchigenerazione sono le tecnologie Turbo Boost

ne virtuali ai server Intel-based di vecchia

e Hyper-Threading, che ne gestiscono la

generazione.

potenza; il sistema Power Gate, che ne

Recentemente la famiglia dei processori

controlla il consumo, e le varie funzioni che

Xeon è stata oggetto di due importanti an-

ne potenziano le prestazioni negli ambienti

nunci. Il primo in ordine di tempo, e al quale

virtuali. Turbo Boost innalza temporaneamen-

abbiamo già accennato, è il lancio della

te il clock dei processori sia agendo su tutti i

serie 5600, che affianca alla serie 5500

Recentemente la famiglia dei processori Xeon è stata

oggetto di due importanti annunci: questi, oltre

ad essere i primi costruiti con la tecnologia di processo

a 32 nanometri, supportano fino a sei core per

processore e offrono nuove caratteristiche di sicurezza

‘core’ sia su una parte di

di cui si è detto un gruppo di nuovi chip

accelerandone drasticamente l’accesso e

essi; è quindi una tec-

presentati un mese fa. Questi, oltre ad essere

l’uso da parte delle macchine virtuali ospitate

nologia in grado

i primi costruiti con la tecnologia di processo

sul server così equipaggiato.

di sopperire in

modo flessibile a picchi

Come si è detto, l’attività di Intel sulle

per processore e offrono nuove caratteristiche

tecnologie abilitanti il cloud computing si

di sicurezza: Intel AES-NI e Intel TXT, che

estende oltre lo sviluppo dei processori,

elaborativi. L’Hyper-

velocizzano le operazioni di crittografia e di

indirizzando l’ottimizzazione di piattaforme e

Threading abilita invece

decrittazione, aumentando la sicurezza delle

data center con soluzioni che comprendono

transazioni senza penalizzare le prestazio-

prodotti hardware e software. Per esempio,

ni. Il secondo, e più importante annuncio,

Intel ha investito nel perfezionamento delle

avvenuto pochi giorni fa, riguarda il lancio di

tecnologie di programmazione parallela,

Quanto al Power Gate, agisce su entrambi i

un’intera nuova serie la 7500. La serie 7500

sviluppando software e firmware che permet-

processori di un server dual-socket riducendo

rappresenta l’ultima evoluzione dell’archi-

tono ai cloud services provider di sfruttare al

a valori minimi il consumo degli ‘idle core’,

tettura Nehalem e viene presentata come il

meglio le capacità multi-core e multi-threading

quelli che non stanno lavorando, e agisce

maggior salto prestazionale nella storia dei

delle sue nuove famiglie di Cpu. Un altro

inoltre su memoria e I/O controller, riducen-

processori Xeon. È stata innovata l’architettura

importante campo di applicazione riguarda il

done il consumo al minimo compatibile con il

dei processori e della piattaforma e sono

consumo energetico a livello data center. Qui

carico di lavoro in atto. Nel complesso, può

stati introdotti nuovi sottosistemi di gestione

Intel ha sviluppato soluzioni come il Dynamic

ridurre del 50% il consumo d’energia rispetto

della memoria e dell’I/O e nuove funzioni di

Power Node Manager e il Dynamic Power

a un server con chip di precedente genera-

sicurezza e recovery. Il risultato è una fami-

Data Center Manager, che controllano,

zione. Molto interessanti infine, per quanto

glia di nuovi processori a otto core in grado

rispettivamente, l’alimentazione dei sistemi

riguarda le infrastrutture a supporto del cloud

di erogare prestazioni fino a quasi 4 volte

in modo da ridurre, a parità di prestazioni,

l’esecuzione simultanea di due

thread per core potenziando l’elaborazione parallela in ambiente HPC.

18

a 32 nanometri, supportano fino a sei core

computing, sono le soluzioni di virtualizza-

superiori rispetto alla precedente generazione

l’assorbimento di energia, e l’applicazione

zione. Tre, Intel VT-x, VT-c e VT-d, agendo sui

e, soprattutto, di gestire una grande quantità

delle policy di gestione energetica generali

processori, sulla connettività e sulla gestione

di memoria: fino a un Terabyte di Ram ciascu-

ai singoli server.

dell’I/O rispettivamente permettono (secondo

no. Questo permette di caricare in memoria

benchmark VMmark e misure interne Intel) di

interi database o ambienti transazionali,

testi a cura di

Giampiero Carli Ballola

Next Editore srl

Corso Vercelli, 51

20144 Milano

www.zerounoweb.it

progetto grafico

Blu GraphicDesign

blugraphicdesign.com

stampa

Tipolitografia Pagani srl

Lumezzane (BS)

19

HAPPY PROLIANT

20 ANNI DI

INNOVAZIONE

Negli ultimi venti anni la tecnologia è diventata parte integrante della vita quotidiana di ognuno di noi,

cambiando in modo radicale il nostro modo di lavorare, comunicare e accedere alle informazioni.

È in questo contesto dinamico e grazie alle continue innovazioni e agli investimenti che la famiglia server

HP ProLiant è cresciuta, si è evoluta e si è adattata, diventando il prodotto di riferimento del mercato x86.

Oggi, dopo venti anni, la tradizione di innovazione, afdabilità e convenienza continua con il server HP ProLiant DL380 G6,

con processore Intel® Xeon® serie 5500.

SERVER HP PROLIANT DL380 G6

•

•

•

•

processore Intel® Xeon® serie 5500

fino a 192GB di memoria DDR3

Serial Attached SCSI (SAS)

controller RAID Smart Array P410i integrati

Per maggiori informazioni contatta il tuo rivenditore HP o visita il sito hp.com/it/happyproliant

© Copyright 2010 Hewlett-Packard Development Company, L.P. Intel e Xeon sono marchi o marchi registrati di Intel Corporation o di società controllate a Intel negli Stati Uniti e in altri paesi.