Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Il concetto di probabilità viene frequentemente impiegato nella vita quotidiana da persone la cui

attività hanno ben poco a che fare con la teoria delle probabilità e con la statistica.

Due discipline studiano i fenomeni casuali o aleatori: la teoria delle

probabilità e la statistica.

La teoria delle probabilità:

•

•

Approfondisce il significato filosofico ed espistemiologico che viene attribuito al concetto di probabilità

Costruisce dei modelli matematici per lo studio dei fenomeni aleatori o casuali e sviluppa le conseguenze logicodeduttive che derivano dall’applicazione dei modelli.

Statistica

I risultati e gli schemi interpretativi proposti dalla teoria delle probabilità vengono utilizzati dall’inferenza statistica che

basandosi su di essa, va oltre integrandola e perfezionandola.

Infatti quando ci si trova di fronte a dati reali, a risultati empirici, si utilizza la teoria statistica per giungere ad una

scelta tra i modelli matematici alternativi che possono aver generato quei dati.

Quindi mentre la teoria delle probabilità stabilisce i risultati che si posso attendere dall’esecuzione di un esperimento

l’inferenza statistica si serve dei risultati dell’esperimento per cercare di costruire o interpretare la legge che sta dietro

ai risultati sperimentali ottenuti.

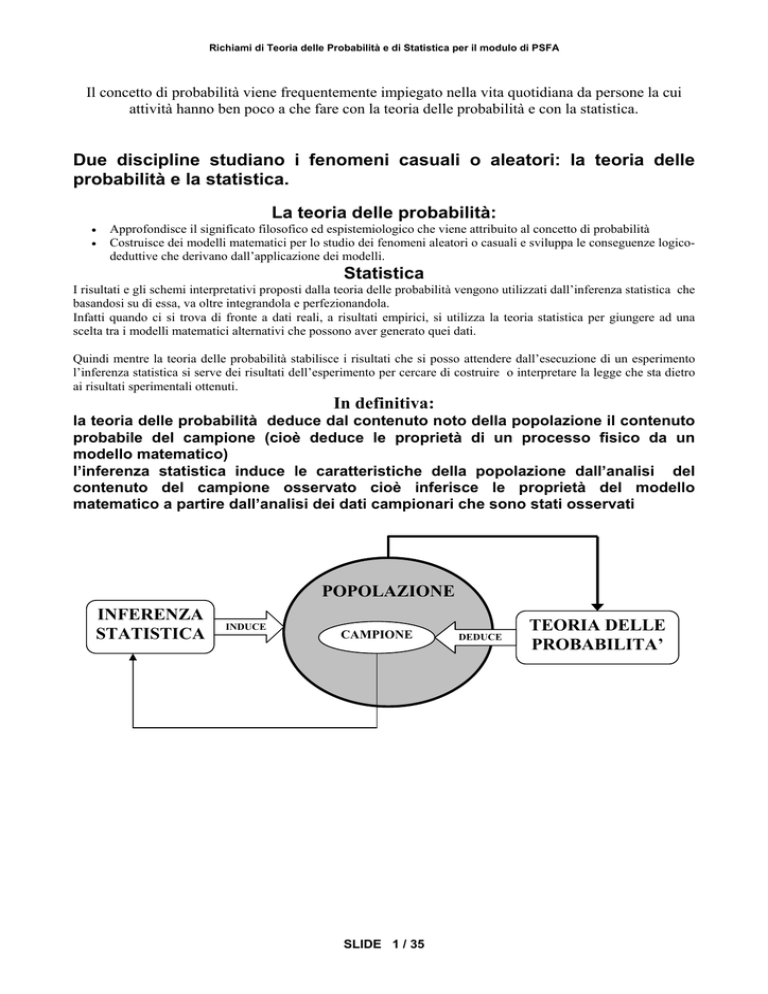

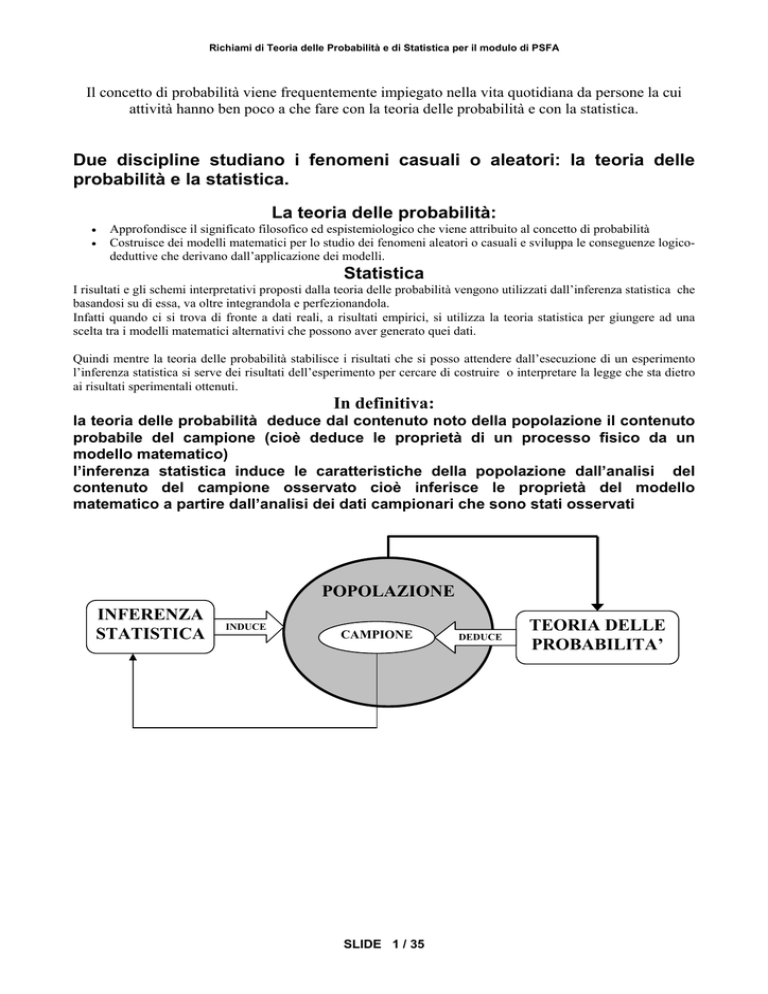

In definitiva:

la teoria delle probabilità deduce dal contenuto noto della popolazione il contenuto

probabile del campione (cioè deduce le proprietà di un processo fisico da un

modello matematico)

l’inferenza statistica induce le caratteristiche della popolazione dall’analisi del

contenuto del campione osservato cioè inferisce le proprietà del modello

matematico a partire dall’analisi dei dati campionari che sono stati osservati

POPOLAZIONE

INFERENZA

STATISTICA

INDUCE

CAMPIONE

SLIDE 1 / 35

DEDUCE

TEORIA DELLE

PROBABILITA’

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

DEFINIZIONE DI PROBABILITA’

È difficile dare una interpretazione e quindi una definizione, di probabilità che sia

completamente soddisfacente ed esente da critiche. Due sono gli approcci più

frequentemente impiegati.

DEFINIZIONE OGGETTIVISTA O FREQUENTISTA DI PROBABILITÀ

Basata sul concetto che “sebbene non sia prevedibile ciò che accadrà in una singola

prova, in quanto il risultato può essere uno qualunque tra i valori possibili di un insieme di

risultati, si è però in grado di conoscere ciò che accadrà in un numero elevato di prove”

Probabilità è un modo formale di esprimere la proporzione di volte che un determinato

evento può avere luogo in un numero elevato di prove o esperimenti. Le frequenze relative

osservate in un numero molto elevato di prove possono così essere considerate come

un’approssimazione della probabilità.

La caratteristica di tale interpretazione è che in essa le probabilità vengono determinate

empiricamente.

Le critiche che si muovono a questa impostazione risiedono nella dipendenza delle

probabilità dalle osservazioni e nella non sempre possibile ripetibilità di un esperimento

nelle stesse identiche condizioni.

DEFINIZIONE SOGGETTIVISTA O PERSONALE

In base a tale interpretazione la probabilità viene definita come una misura del grado di

fiducia che una persona ripone sul verificarsi di un dato fenomeno, avendo a disposizione

determinate informazioni sul fenomeno stesso (la probabilità rappresenta ciò che si è

disposti a scommettere contro o a favore della realizzazione di un certo evento.

Il calcolo delle probabilità da una parte e la statistica dall’altra hanno a che fare con le

accidentalità e le regolarità dei processi che presentano elementi aleatori o casuali.

Spesso si ha a che fare con tale variabilità ma spesso non si hanno dati e informazioni che

permettono un’analisi rigorosa. Per accumulare dati, e quindi una migliore conoscenza del

processo che genera il fenomeno oggetto di studio, vengono effettuati degli esperimenti.

Definizione di esperimento

Un esperimento è ogni operazione il cui risultato non può essere previsto con

certezza

Definizione di evento

Ogni risultato possibile di un esperimento è un evento

Un evento può essere costituito da uno solo tra tutti i possibili risultati “punto

campionario” o da un insieme di risultati omogenei rispetto ad una caratteristica

Definizione di spazio campionario Ω di un esperimento o

spazio degli eventi

Lo spazio campionario è l’insieme di tutti i risultati per l’esperimento stesso

Attenzione lo stesso esperimento può dar luogo a spazi campionari diversi in

funzione dei risultati che interessano

SLIDE 2 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Lo spazio campionario Ω , o spazio fondamentale, è l’insieme di tutti i risultati

dell’esperimento stesso

Se per un esperimento si dispone di:

a) l’insieme dei risultati possibili

b) la probabilità della realizzazione dei risultati ottenibili con l’esperimento

Si dispone si dispone del modello probabilistico per l’esperimento

Al fine di poter meglio sviluppare il concetto di evento e di spazio campionario qui di

seguito vengono richiamati alcuni elementi di teoria degli insiemi (stretta relazione fra

teoria degli insiemi e algebra degli eventi – analogia tra eventi e insiemi)

Rappresentazione

∅

A ∪ B (A o B) eventi)

A ∩ B (A e B)

A∩B=∅

TEORIA DEGLI INSIEMI

ALGEBRA DEGLI EVENTI

Evento impossibile

Insieme nullo

somma logica o unione di la somma logica di due

due insiemi A e B

eventi A e B è l’evento che si

verifica quando si verificano

uno almeno degli eventi

prodotto

logico

o il prodotto logico di due

intersezione di due insiemi A eventi A e B è l’evento che si

eB

verifica se e solamente se si

verificano entrambi i fattori

del prodotto

INSIEMI DISGIUNTI

EVENTI INCOMPATIBILI

due insiemi A e B sono disgiunti

quando non hanno nessun

elemento in comune, cioè la loro

intersezione è vuota

due eventi A e B sono incompatibili

se non è possibile che si

verifichino entrambi ossia l’evento

A ∩ B è impossibile

Due eventi A e B sono esaustivi quando è impossibile che non se ne verifichi nessuno.

AxB =

prodotto cartesiano di A e B è l’insieme di tutte le possibile coppie (ai, bi)

dove ai∈A e bi∈B cioè AxB={(ai , bi ) : ai∈A e bi∈B }

SLIDE 3 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

TEORIA GENERALE DELLE PROBABILITÀ

La formalizzazione è avvenuta solo recentemente

Impostazione assiomatica

Nel 1933 A. N. Kolmogorov ha presentato un’impostazione della teoria delle probabilità

strettamente connessa alla teoria delle funzioni matematiche e alla teoria degli insiemi.

Si considera un insieme Ω di eventi Ei , elementari o primitivi, e si precisa sotto quale

aspetto si utilizza l’esperimento casuale. Si individuano perciò degli eventi di interesse,

che altro non sono che sottoinsiemi di Ω. Si definisce quindi una classe α di eventi

generati a partire da sottoinsiemi di Ω e si richiede che tale classe sia sufficientemente

ampia da permettere di effettuare le operazioni elementari sugli eventi casuali e che i

risultati che si ottengono siano ancora elementi della classe α .

Si richiede che gli eventi abbiano una struttura algebrica: la classe α deve essere

un’algebra di sottoinsiemi di Ω

⇓

1) Ω ⊆ α α contiene Ω come uno dei suoi elementi

2) Se E ∈ α allora anche E ∈α è chiusa rispetto alla complementarità

3) Se E1∈ α , E2∈ α , ………. ,En∈ α allora anche

n

U E ∈α

i

- è chiusa rispetto

i =1

all’unione finità (additività finita)

La validità delle 1) , 2) e 3) si deduce che l’unione e l’intersezione di eventi di a non

portano oltre i limiti della classe a e cioè a costituisce un’algebra di eventi

Nell’applicazione della teoria delle probabilità è però necessario andare oltre un’algebra di

eventi richiedendo l’additività completa cioè che la proprietà 3) sia valida per un’infinità

numerabile di eventi:

4) Se E1∈ α , E2∈ α , ………. ,En∈ α allora anche

∞

U E ∈α

i

- è chiusa rispetto

i =1

all’unione infinità (additività completa)

OGNI FAMIGLIA α NON VUOTA DI SOTTOINSIEMI DI Ω CHE SODDISFA LE

PROPRIETÀ 1) , 2), 3) E 4) VIENE DEFINITÀ UNA SIGMA-ALGEBRA E LA COPPIA

( α , Ω ) DEFINISCE UNO SPAZIO MISURABILE

SLIDE 4 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

ASSIOMI DELLA PROBABILITÀ

Una probabilità su una σ-algebra α di sottoinsiemi di Ω è un’applicazione di α in [0, 1]:

P: α→ [0, 1]

Che soddisfa i seguenti assiomi

ASSIOMA DI POSITIVITÀ

LA PROBABILITA’ DI UN QUALSIASI EVENTO APPARTENENTE

NEGATIVA

AD

E’

UNICA E NON

0 ≤ P( E ) ≤ 1

ASSIOMA DI CERTEZZA

LA PROBABILITA’ DELL’INTERO SPAZIO CAMPIONARIO Ω È UGUALE ALL’UNITÀ

P( Ω) = 1

ASSIOMA DI UNIONE

SE E1 E E2 SONO DUE EVENTI DI

ALLORA:

E1 ∩ E 2 = ∅

Ω CHE SI ESCLUDONO A VICENDA (EVENTI INCOMPATIBILI)

P ( E1 ∪ E 2 ) = P ( E1 ) + P ( E 2 )

Esteso ad n eventi

E1∈ α , E2∈ α , ………. ,En tali che Ei∩ Ej = ∅ per ogni i ≠j

⎛ n ⎞ n

P⎜⎜ U Ei ⎟⎟ = ∑ P(Ei )

⎝ i =1 ⎠ i =1

GLI ASSIOMI NON PERMETTONO DI ATTRIBUIRE UN UNICO VALORE ALLA

PROBABILITÀ DI UN EVENTO MA PIUTTOSTO ESPRIMONO UN INSIEME DI REGOLE

FORMALI SULLA BASE DELLE QUALI È POSSIBILE ATTRIBUIRE IN MODO DEL

TUTTO COERENTE DELLE PROBABILITÀ A DEGLI EVENTI

La definizione di probabilità basata sulla frequenza relativa è solamente uno dei modi possibili

di attribuire la probabilità

P ( A) = lim ( frequenza) = lim

n →∞

n →∞

NA

n

dove NA è il numero di volte in cui si è verificato

l’evento A in n ripetizioni dell’esperimento

SLIDE 5 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

PROPRIETÀ DELLA PROBABILITÀ

LE CONSEGUENZE PRINCIPALI DEGLI ASSIOMI UTILIZZATI PER DEFINIRE LA

PROBABILITÀ VENGONO RIPORTATE SOTTO FORMA DI PROPRIETÀ

Proprietà 1

()

P(E ) = 1 − P E

Per ogni evento E ⊂ Ω si ha che

(

)

()

Infatti Ω = E ∪ E ed inoltre E ∩ E = ∅ da cui P E ∪ E = P(E ) + P E = P(Ω ) = 1

Proprietà 2

P(∅)=0

(infatti se E = ∅ dalla 1 si ha

()

P (E ) = 1 − P E = 1 − 1 = 0 )

Proprietà 3

Se l’evento A implica l’evento B, cioè A ⊆ B allora :

P(A) ≤ P(B)

Infatti dalla teoria degli insiemi si può scrivere

(

B = A∪ A∩ B

)

Poiché gli insiemi alla destra del segno di uguale sono disgiunti poiché

(

P ( B ) = P ( A) + P A ∩ B

l’assioma 3) si ha:

(

)

)

(

)

A ∩ A ∩ B = ∅ applicando

e quindi P(B) ≥ P(A) poiché per l’assioma 1) è

P A∩ B ≥ 0

Proprietà 4 (regola additiva delle probabilità)

L’assioma 3) può essere generalizzato ad eventi che non sono incompatibili

P ( A ∪ B ) = P ( A ) + P (B ) − P ( A ∩ B )

Infatti A ∩ B ≠ ∅ si può scrivere

(

( A ∩ B ) ∩ (A ∩ B ) = ∅

disgiunti

(

)

)

B = ( A ∩ B ) ∪ A ∩ B i due insiemi alla destra del segno uguale sono

(

)

per

cui

per

l’assioma

3)

si

ha

P (B ) = P ( A ∩ B ) + P A ∩ B ⇒ P A ∩ B = P ( B ) − P ( A ∩ B )

Inoltre

A ∪ B = A ∪ A ∩ B i due insiemi alla destra del segno uguale sono disgiunti A ∩ A ∩ B = ∅ per cui per

(

)

(

)

l’assioma 3) si ha P ( A ∪ B ) = P ( A ) + P A ∩ B

Sostituendo in quest’ultima l’espressione precedente si ha:

(

)

P ( A ∪ B ) = P ( A ) + P A ∩ B = P ( A ) + P (B ) − P ( A ∩ B )

SLIDE 6 / 35

(

)

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

PROBABILITÀ CONDIZIONATA

La probabilità di un evento può dipendere dalle circostanze sotto le quali la prova , o l’esperimento, vengono

condotti. Queste circostanze sono esse stesse degli eventi e sono chiamate elementi condizionanti.

Si consideri lo spazio campionario Ω e i due eventi A e B tra loro compatibili. Se si

suppone che B sia l’evento condizionante ne segue che tutti gli altri punti di Ω, che non

sono anche punti di B, non interessano; ciò equivale a fare riferimento a un nuovo spazio

campionario, ridotto rispetto ad Ω , che è uguale esattamente a B. Si indica questo nuovo

spazio campionario con Ω∗ e la parte di A appartenente ad Ω∗ con A*.

La nozione usata per indicare la probabilità dell’evento A condizionata dall’evento B

è P(A⏐B) che si legge “probabilità di A dato B”

Affinché l’assioma 2) sia rispettato la probabilità di Ω∗ dovranno essere pari a 1 quindi le

probabilità definite su Ω e su Ω∗ saranno tra loro diverse).

P(B)=P(B⏐Ω) ≤ P(B⏐Ω*) = P(B⏐B) = 1

Per soddisfare questa condizione è necessario maggiorare le probabilità dei punti

campionari che compongono B in Ω , indicate con pi moltiplicandole per la costante

1/P(B) . In tal caso le probabilità dei punti campionari di B in Ω∗ saranno date da :

pi*= pi x (1/P(B))

(

)

P B Ω * = ∑ p i* =

Infatti

i∈B

P (B )

1

∑ p i = P (B ) = 1

P(B ) i∈B

Per avere la probabilità di un qualunque evento in Ω∗ , cioè la probabilità condizionata da B, basterà

sommare le probabilità pi* dei punti campionari dello spazio Ω∗ che appartengono all’evento stesso. Nel

caso di un evento A i punti di A compresi in

Ω∗ sono quelli che costituiscono l’evento (A∩ B), quindi :

1

P( A ∩ B )

P(A B ) = ∑ p =

pi =

∑

P(B )i∈( A∩ B )

P (B )

i∈( A∩ B )

*

i

con P(B) ≠ 0

Definizione

La probabilità di A dato B, indicata con P(A⏐B) , è uguale alla probabilità congiunta

A e B divisa per la probabilità dell’evento B

Proprietà 5 (regola additiva delle probabilità)

Il teorema delle probabilità composte, o regola moltiplicativa della probabilità

P(A∩B)=P(A⏐B)*P(B)=P(A)*P(B⏐A)

Proprietà 6 (regola additiva delle probabilità)

Se A e C sono due eventi tra loro incompatibili allora:

P(A ∪ C⏐B) =P(A⏐B)+P(C⏐B)

Infatti applicando la definizione di probabilità condizionata ed applicando la proprietà distributiva:

P(A ∪ C B ) =

P[( A ∪ C ) ∩ B ] P[( A ∩ B ) ∪ (C ∩ B )]

=

P( B)

P( B)

Poiché A ∩ C = ∅ allora anche (A ∩ C) ∩ (C ∩ B) = ∅ da cui segue applicando l’assioma 3):

P[( A ∩ B ) ∪ (C ∩ B )] P( A ∩ B ) P(C ∩ B )

=

+

= P( A B ) + P(C B )

P( B)

P (B )

P (B )

SLIDE 7 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

DEFINIZIONE DI INDIPENDENZA

Non sempre il fatto di sapere che si è verificato un certo evento modifica le circostanze sotto le quali se ne verifica un

altro. Quando ciò non si verifica gli eventi sono tra loro indipendenti in probabilità o stocasticamente indipendenti.

CB

Gli eventi A e B entrambi appartenenti ad sono stocasticamente indipendenti ciè A

P(A∩B) = P(A) * P(B)

se:

Infatti

n

P( A) = ∑ P(ai ) e

i =1

n

P(B ) = ∑ P(bi )

i =1

n

m

i =1

i =1

P ( A ∩ B ) = ∑∑ P (ai ∩ b j ) = ∑ P (ai ) ⋅∑ P (b j ) = P( A) ⋅ P (B )

n

m

i =1 j =1

La condizione di indipendenza stocastica tra due eventi A e B equivale al realizzarsi delle relazioni:

P(A⏐B)=P(A) e P(B⏐A) = P(B)

TEOREMA DI BAYES

È una diretta applicazione della probabilità condizionata.

Si suppone che gli eventi (Ei) , con i=1,2, ….., n formino un sistema completo di eventi, cioè un

n

insieme di eventi incompatibili tali che

UE

i

= Ω e quindi una partizione finita. In tal caso la

i =1

probabilità di un qualunque evento A ⊂ Ω può essere definita facendo riferimento alle probabilità

dei singoli eventi Ei cioè:

P( A) = ∑ [P( A) ∩ P(Ei )] = ∑ P(Ei ) ⋅ P( A Ei )

n

n

i =1

i =1

L’interpretazione più immediata e interessante di questa struttura consiste nel considerare gli

eventi Ei come cause che determinano l’evento A . Sorge così il problema di trovare una relazione

che permetta di calcolare la probabilità che sia stato l’evento Ei a determinare A, dato che si è certi

che l’evento A si è verificato.

Applicando la formula della probabilità condizionata è possibile scrivere:

P (Ei A) =

P ( Ei ∩ A)

P( A)

P ( Ei ∩ A ) = P ( Ei ) ⋅ P ( A E i )

con P(A)≠ 0 da cui

è quindi immediato scrivere la formula nota come teorema di Bayes

P (Ei A) =

P (Ei ) ⋅ P ( A Ei )

∑ P (E ) ⋅ P ( A E )

n

i

i

i =1

Gli n eventi E1, …., En sono le n cause fra loro diverse che possono generare l’evento A. Le probabilità di

queste cause P(E1),….P(En) sono considerate le “probabilità a priori” di ogni causa Ei . (con i=1,….,n) ;

esse non dipendono dal risultato empirico dell’evento A e riflettono il grado di conoscenza “soggettiva” sulle

singole cause. Le probabilità condizionate P( A⏐Ei ) sono le “probabilità probative o verosimiglianze” e

rappresentano la probabilità con cui le singole cause

E1, …., En generano l’evento A. Le probabilità

P( Ei⏐A ) (con i=1, 2, ….., n) sono le “probabilità a posteriori “ delle cause Ei cioè sapendo che l’evento A

si è verificato esse dicono con quale probabilità l’evento Ei ha agito nel determinare A.

SLIDE 8 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

ESEMPIO DI APPLICAZIONE DEL TEOREMA DI BAYES - Test sul tasso di alcolismo

Il test ha fornito come risultato che il 2% degli automobilisti guida in stato di ebbrezza.

Esperimenti effettuati hanno appurato che nel 95% dei casi il test da esito positivo quando la persona è

effettivamente ubriaca così come nel 95% dei casi il test da esito negativo con persone non ubriache.

Qual è la probabilità che una persona sia realmente in stato di ebbrezza se l’alcool test da risultato positivo?

Se E è l’evento ubriaco e

P(E)=0.02

()

P E = 0.98

E è l’evento non ubriaco ed A evento test positivo e B evento test negativo

( )

( )

P (A E ) = 0.95 P (B E ) = 0.05 P A E = 0.05 P B E = 0.95

Applicando il teorema di Bayes si ha:

P (E A) =

P (E ) ⋅ P ( A E )

() ( )

P (E ) ⋅ P ( A E ) + P E ⋅ P A E

=

0.95 ⋅ 0.02

= 0.28

0.02 ⋅ 0.95 + 0.98 ⋅ 0.05

Il risultato non è certo soddisfacente e dipende dalla bassa probabilità a priori che una

persona risulti ubriaca P(E). Per migliorare la bontà del test bisognerebbe aumentare la

performance del test se P(B E ) = 0.99 si avrebbe:

P (E A) =

0.95 ⋅ 0.02

= 0.66

0.02 ⋅ 0.95 + 0.98 ⋅ 0.01

SLIDE 9 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

VARIABILE ALEATORIA

Per trattare gli venti con strumenti matematici e costruire modelli suscettibili di

applicazioni pratiche è necessario associare a ogni evento semplice di uno spazio

delle prove un numero mediante una particolare legge.

L’operazione che fa corrispondere a ciascun punto dello spazio delle prove

probabilizzato un numero è analoga a quella con cui si costruisce una funzione.

Definire una variabile aleatoria (o casuale) significa quindi trovare una regola in

base alla quale associare un numero reale ad ogni risultato di un esperimento e

quindi ad ogni elemento dello spazio campionario Ω.

Definizione: Una v.a. X è una variabile che assume valori nello spazio

dei numeri reali secondo una funzione di probabilità

X è una v.a. discreta se assume un numero finito di valori o un’infinità numerabile

di valori con probabilità p(x)

X è una v.a. continua se assume un numero infinito di valori compresi entro un

intervallo di ampiezza finita o infinita.

1

Ω

P[X(E)]

E

X(E)

v.c.

discreta

0

⏐R

(differenza tra variabile matematica e variabile aleatoria è che la prima può

assumere un qualsiasi valore dell’insieme di definizione mentre la seconda assume

i valori con una certa probabilità)

FUNZIONI DI PROBABILITÀ

FUNZIONE DI PROBABILITÀ’ = RELAZIONE TRA VARIABILE ALEATORIA E

PROBABILITÀ CORRISPONDENTE

Può presentarsi sotto diverse forme:

− Funzione di distribuzione

− Funzione di Probabilità

− Funzione densità di probabilità

SLIDE 10 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

FUNZIONE DI DISTRIBUZIONE

La funzione di distribuzione FX(x) della variabile aleatoria X è una funzione della

variabile reale t definita nell’intervallo ]- ∝ , + ∝ [ la quale fornisce la probabilità

cumulata che la v.a. X assuma un qualsiasi valore minore o uguale di t:

FX (t ) = P ( X ≤ t )

− Assume valori nell’intervallo [0, 1];

− Tende a 0 per t→ - ∝ e a 1 per t→ + ∝

− Per a≤b risulta FX (a ) ≤ FX (b ) funzione monotona non decrescente

FX (b ) − FX (a ) = P (a ≤ X ≤ b )

Ha una forma a scalini per v.a. discrete mentre e continua e derivabile per v.a.

continue

FUNZIONE DI PROBABILITÀ

La funzione di probabilità pX(xi) di una v.a. discreta X è la funzione di una variabile

reale che assume valori diversi da zero solo in corrispondenza dei valori assunti

dalla v.a. ed è uguale a zero in tutti gli altri punti :

p X ( xi ) = P( X = xi )

Proprietà

0 ≤ p X ( xi ) ≤ 1

∑ p (x ) = 1

F (t ) = ∑ p (x )

∀i

X

X

i

xi ≤t

i

FUNZIONE DENSITÀ DI PROBABILITÀ

La funzione di probabilità di una v.a.

funzione di distribuzione FX(x)

continua X

f X (t ) =

“ fX(x) “

è la derivata della

dFX ( x )

dx

Proprietà

f X (x ) ≥ 0

∫

+∞

−∞

f X ( x )dt = 1

FX ( xi ) = ∫ f X ( x )dx

xi

−∞

P(a ≤ X ≤ b ) = FX (b ) − FX (a ) = ∫ f X ( x )dx

b

a

Per il teorema della media

P( x ≤ X ≤ x + ∆x ) = f X ( x )∆x

Data una v.a. X distribuita con una legge densità di probabilità fX(x), la v.a. Y=H(x)

(funzione della v.a.X) avrà una funzione densità di probabilità data da:

dx

fY ( y ) = f X ( x ) ⋅

dy

SLIDE 11 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

VALORI CARATTERISTICI DELLE VARIABILI ALEATORIE

SPERANZA MATEMATICA O MEDIA

Si definisce speranza matematica o media E[X] (spesso indicata con µx) di una

v.a.:

⎧∑ x i ⋅ p X ( x i )

⎪⎪ ∀i

E[ X ] = µ X = ⎨+∞

⎪ ∫ x ⋅ f X ( x )dx

⎪⎩−∞

Se Y=g(X) è una funzione deterministica della v.a. X , Y è a sua volta una v.a. – la

cui speranza matematica è:

⎧∑ g ( x i ) ⋅ p X ( xi )

⎪⎪ ∀i

E[ g ( X )] = ⎨+∞

⎪ ∫ g ( x ) ⋅ f X ( x )dx

⎪⎩−∞

MOMENTI DI UNA VARIABILE ALEATORIA

Si definisce momento k-esimo (k=1, 2, …..) della v.a. X rispetto all’origine (x=0) la

speranza matematica della sua potenza k-esima:

⎧∑ xik ⋅ p X ( xi )

⎪⎪ ∀i

mk = E[ X k ] = ⎨+ ∞

⎪ ∫ x k ⋅ f X ( x )dx

⎪⎩−∞

Il momento di ordine 1 coincide con la media.

VARIANZA E DEVIAZIONE STANDARD DI UNA VARIABILE ALEATORIA

La varianza V(X) (indicata spesso con σ X2 ) della v.a. X è la speranza matematica

della funzione (x-µx)2 :

Var(X)=σx2 =E[(x-µx)2 ]=E[x2 ] – 2 E[X] µx + µx2 = E[x2 ] – 2 µx2 + µx2 =

= E[x2 ] – µx2

Deviazione standard

σ X = σ X2

Dissimetria o Skewness

µx3 = E[(x-µx)3 ]

Coefficiente di variazione

Cx = σx / µx (numero puro ma non invariante assoluto i.e. varia al variare della scala e dell’origine)

Indice relativo di dissimetria

δx3 = µx3 / σx3 (invariante assoluto)

Indice di Curtosi o Disnormalità

α X 4 = µx4

σ X4

(pari a 3 per la distribuzione normale , αX4<3 distribuzioni iponormali ,

αX4>3 distribuzioni ipernormali)

SLIDE 12 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

VARIABILI ALEATORIE CONGIUNTE

Nella maggior parte dei casi, la rappresentazione numerica degli eventi, come

risultato di una prova, avviene in termini di due o più variabili aleatorie (più v.a.

possono essere associate ai risultati di uno stesso esperimento)

Più variabili aleatorie definite sullo stesso spazio delle prove si dicono congiunte (o

congiuntamente distribuite)

p.e. variabili bivariate X e Y

FUNZIONE DI PROBABILITÀ CONGIUNTA

p X ,Y (xi , y j ) = P (X = xi , Y = y j )

Proprietà

0 ≤ p X ,Y (xi , y j ) ≤ 1

∑∑ p (x , y ) = 1

∀x ∀y

X ,Y

i

j

FUNZIONE DENSITÀ DI PROBABILITÀ CONGIUNTA

La funzione di probabilità di una v.a. discreta fX(t)

derivata della funzione di distribuzione FX(t)

di una v.a. continua X è la

P[x ≤ X ≤ x + ∆x, y ≤ Y ≤ y + ∆y ]

∆x→0

∆x∆y

∆y →0

f X ,Y ( x, y ) = lim

FUNZIONE DI DISTRIBUZIONE CONGIUNTA

[

FX ,Y (xi , y j ) = P X ≤ xi , Y ≤ y j

FX ,Y ( xk , y h ) =

∑ ∑ p (x , y )

xi ≤ xk y j ≤ yh

X ,Y

i

i

]

FX ,Y ( xk , y h ) = ∫

xk

∫

yh

− ∞ −∞

f X ,Y ( x, y ) ⋅ dxdy

FUNZIONE DI PROBABILITÀ MARGINALE

p X ( xi ) = P[ X = xi ] = ∑ p X ,Y (xi , y j )

∀y

f X (x ) =

∫ f (x, y )dy

X ,Y

RY

MEDIA E VARIANZA DI VARIABILI ALEATORIE CONGIUNTE

E [H ( X , Y )] = ∑∑ H ( xi , yi ) ⋅ p X ,Y ( xi , yi )

E [H ( X , Y )] =

∀xi ∀yi

∫ ∫ H (x, y )⋅ f (x, y )⋅ dx ⋅ dy

X ,Y

R X RY

MOMENTO MISTO di ordine h k

E X h , Y k = ∑∑ xih ⋅ y kj ⋅ p X ,Y (xi , y j )

[

[

]

∀xi ∀y j

] ∫ ∫x

E X h ,Y k =

h

i

⋅ y kj ⋅ f X ,Y (xi , y j )⋅ dx ⋅ dy

R X RY

SLIDE 13 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

COVARIANZA

È la speranza matematica della funzione H(X, Y) = (X - µX )*(Y - µY )

σXY = E[(X - µX )*(Y - µY )] = E[X Y] - µX µY

COEFFICIENTE DI CORRELAZIONE

ρ XY =

σ XY

σ X ⋅σ Y

(assume valori compresi tra –1 e +1 - valore –1 o +1 se c’e un legame

funzionale)

PROBABILITÀ CONDIZIONATA E VARIABILI ALEATORIE INDIPENDENTI

Funzioni di probabilità e densità di probabilità condizionata

p ( x, y )

f ( x, y )

pY X ( y x ) = X ,Y

f Y X ( y x ) = X ,Y

p X (x )

f X (x )

Variabili indipendenti

pY X ( y x ) = pY ( y )

fY

X

( y x ) = fY ( y )

⇒ v.a. indipendenti

Dette H(X) e G(Y) due funzioni deterministiche delle v.a. indipendenti X e Y

E[H(X)*G(Y)]= E[H(X)] * E[G(Y)]

E[X*Y)]= E[X] * E[Y]

E[Xi*Yj)]= E[Xi] * E[Yj]

Da cui

σXY = E[X Y] - µX µY = 0 (se X e Y sono v.a. indipendenti la covarianza e nulla)

PROPRIETA’ DELLA MEDIA E DELLA VARIANZA

E[ax + b] = ∑ (ax + b ) ⋅ p(xi ) = a ∑ xi ⋅ p( xi ) + b∑ p( xi ) = a ⋅ E [ X ] + b

i

i

i

MEDIA DELLA SOMMA DI 2 o PIU’ v.a.

E[ x + Y ] = ∑∑ (xi + y j )⋅ p (xi , y j ) = ∑ xi ⋅ ∑ p (xi , y j ) + ∑ y j ⋅ ∑ p (xi , y j ) =

i

j

i

= ∑ xi ⋅ p( xi ) + ∑ y j ⋅ p( y j ) =E [X ] + E [Y ]

i

j

j

i

j

Se X è una v.a. e a e b sono costanti:

Var(a X +b) = a2 Var (X)

Infatti Var(a X +b) = E[ (a X +b) –E[(a X +b)]2 = E[a X +b – a µx -b]2 = E[a X– a µx]2 = E[a2 (X– µx)2]= a2 E[(X– µx)2]= a2 Var (X)

VARIANZA DELLA SOMMA DI 2 v.a.

Se X e Y sono due v.a. la varianza della loro somma è:

Var (X + Y)=Var(X) + Var (Y) + σXY

Infatti

Var (X + Y)=E[(X+Y) - E[X+Y]]2= E[(X-E[X])+(Y-E[Y])]2 =

= E[(X-E[X])]2 + E[(Y-E[Y])]2 +2 E[(X-E[X])*(Y-E[Y])] = σX2 + σY2 + 2 * σXY

(SE X e Y sono v.a. indipendenti : Var (X + Y) = σX2 + σY2 )

SLIDE 14 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

REGRESSIONI

Date due v.a. X e Y si definisce regressione di Y su X la media della distribuzione

condizionata di Y data X:

[ X ] = ∑ y ⋅ p ⎛⎜⎝ y x ⎞⎟⎠ per v.a. discrete

E [Y ] = ∫ y ⋅ f ⎛⎜ y ⎞⎟dy per v.a. continue

X

⎝ x⎠

EY

Y

∀y

Y

RY

X

X

La regressione E[Y/X] è evidentemente una funzione della v.a. X. Si verifica immediatamente che la media

(rispetto a X) della regressione E[Y/X] coincide con la media (incondizionata) di Y:

EX[E[(Y/X)]=E[Y]

REGRESSIONI LINEARI

Nel caso in cui E[Y/X] sia una funzione lineare di X :

ay =

Si dimostra che:

σ XY

σ Y2

E[Y/X]=ay *X + by

by = µY − µ X

e

σ XY

σ Y2

Dove µx e µy sono le medie (incondizionate) di X e Y.

In modo perfettamente analogo è possibile definire la regressione di X su Y.

Indipendentemente dalla forma funzionale della regressione di una v.a. Y su X la varianza

della distribuzione incondizionata di Y è data da:

σ Y2 = E (Y − E [Y / X ])2 + E (E [Y / X ] − µY )2

[

] [

]

dove (con riferimento al caso di variabili aleatorie continue):

[

] ∫ ∫ {y − E[Y

E (Y − E [Y X ]) =

2

X ]} f X ,Y ( x, y ) ⋅ dx ⋅ dy

2

R X RY

è denominata varianza di Y rispetto alla regressione, mentre,

[

] ∫ {E[Y

E (E [Y X ] − µ Y ) =

2

X ] − µ Y } f X ( x ) ⋅ dx = Var (E [Y X ])

2

RX

è la varianza della regressione rispetto alla media.

Si definisce rapporto di correlazione ηy il rapporto fra la varianza Var(E[Y/X]) della regressione e la varianza di Y

(σ2Y):

ηY =

Var (E [Y X ])

σ Y2

Se risulta ηy = 1 , sarà Var(E[Y/X]) = σ2Y, di conseguenza è nulla la varianza rispetto alla regressione e quindi in

corrispondenza di ogni valore X la Y assume un unico valore uguale a E[Y/X] , cioè tra le due variabili esiste un

legame funzionale. Quando la regressione è lineare si ha :

2

η X = ηY = ρ XY

cioè il rapporto di correlazione coincide con il quadrato del coefficiente di correlazione.

SLIDE 15 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

VARIABILI CASUALI DI IMPIEGO FREQUENTE

NELL’INGEGNERIA STRADALE

Variabile aleatoria BERNULLIANA

ESPERIMENTI BERNULLIANI

Due eventi S e I v.a S=1 I=0 p(1)=p P(0)= q = 1- p

mk= p

⇒

E [XB]= 1*p + 0 * q = p

Var( XB ) = m2 – p2 = p- p2 = p*(1-p) =p * q

Variabile aleatoria BINOMIALE

Esperimento ripetere n volte un esperimento bernulliano

Evento semplice = disposizione con ripetizione di due elementi su n posti

Spazio delle prove è formato da 2n eventi semplici.

Ipotizziamo che i successivi esperimenti mantengano inalterate le loro caratteristiche nel

tempo e che gli eventi siano indipendenti

P[ I, S,I, ……,] = pk * q(n-k)

Consideriamo gli n+1 eventi composti ciascuno dall’unione di degli eventi semplici

contenenti rispettivamente 0, 1, …, n successi

Gli eventi sono disgiunti e la loro unione è lo spazio delle prove

Il generico evento caratterizzato da k successi è formato da un numero di eventi semplici

⎛n⎞

n!

uguale al numero di combinazioni senza ripetizione ⎜⎜ ⎟⎟ =

, pertanto considerata

⎝ k ⎠ k!⋅(n − k )!

la probabilità di un evento con k successi e che la probabilità di un evento è dato dalla

somma degli eventi semplici in esso contenuti:

⎛ n ⎞ k (n−k )

n!

⎜⎜ ⎟⎟ p ⋅ q

=

p k ⋅ q (n−k )

k!⋅(n − k )!

⎝k ⎠

Gli n+1 eventi composti possono essere considerati come eventi semplici di un nuovo

esperimento, associando a ciascuno di questi eventi il valore di una v.a. uguale al numero

di successi abbiamo costruito la variabile aleatoria BINOMIALE XB (assume valori

compresi tra 0 e n)

n!

p X B (k ) =

p k ⋅ q (n−k )

k!⋅(n − k )!

Media e varianza

E[Xb]= n * p

Var(Xb)=n * p*q

Infatti ricordando che media e varianza della variabile bernulliano sono:

E[ XB ] = p Var( XB ) = p (1-p)

Visto che:

⎡ n

⎤ n

E [ X b ] = E ⎢∑ X B ⎥ = ∑ E [ X B ] = n ⋅ p

⎣ i =1

⎦ i =1

n

⎛

⎞ n

Var ( X b ) = Var ⎜ ∑ X B ⎟ = ∑Var ( X B ) = n ⋅ p ⋅ q

⎝ i =1

⎠ i =1

SLIDE 16 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Variabile aleatoria DI POISSON

Molte operazioni della vita reale sono riconducibili ad esperimenti Bernulliani ripetuti.

Per esempio passaggi di veicoli in una sezione stradale in un intervallo di tempo di tempo

T. Dividiamo T in n intervallino ∆t=T/n ripetiamo per più intervalli T e valutiamo la media

dei passaggi (successo in ∆t ) si ha che una stima della probabilità p è:

p=m/n

Poiché è logico pensare che aumentando n (e quindi diminuendo l’ampiezza

dell’intervallino) p diminuisca, si può ipotizzare che al crescere indefinito di n il prodotto

np=cost. Assumendo T=1 si ha:

np=λ ∆t=1/n

p=λ/n=λ *∆t

(la probabilità di successo è proporzionale all’ampiezza ∆t secondo la costante λ)

La forma limite della variabile Binomiale al tendere di n →∝ è:

λk ⋅ e − λ

p P (k ) =

k!

Infatti osservato che

n ⋅ n ⋅ 1 − 1 ⋅ ........ ⋅ ⎛⎜1 − (k − 1) ⎞⎟

n

n⎠

n!

n ⋅ (n − 1) ⋅ ........ ⋅ (n − k + 1)

⎝

=

=

k!(n − k )!

k!

k!

(

visto che p=λ/n

n!

n−k

lim

p k (1 − p ) = lim

n →∞ k!(n − k )!

n →∞

(

)

(

)

)

k

n−k

n ⋅ n ⋅ 1 − 1 ⋅ ........ ⋅ n⎛⎜1 − (k − 1) ⎞⎟

n

n ⎠⎛λ ⎞ ⎛ λ ⎞

⎝

⎜ ⎟ ⎜1 − ⎟ =

k!

⎝n⎠ ⎝ n⎠

(

)

k

n−k

n−k

1 − 1 ⋅ ........ ⋅ ⎛⎜1 − (k − 1) ⎞⎟

n k ⋅ 1 − 1 ⋅ ........ ⋅ ⎛⎜1 − (k − 1) ⎞⎟

n

n

n

n⎠ k ⎛ λ⎞

λ

λ

⎛

⎞

⎛

⎞

⎝

⎝

⎠

λ ⋅ ⎜1 − ⎟ =

= lim

⎜ ⎟ ⎜1 − ⎟ = lim

n →∞

n →∞

k!

k!

⎝ n⎠

⎝n⎠ ⎝ n⎠

=

1 k

⎛ λ⎞

λ ⋅ lim⎜1 − ⎟

n

→

∞

k!

⎝ n⎠

n−k

=

1 k −λ

λ ⋅e

k!

x

y⎞

⎛

y

⎟ =e

x →∞

⎝ x⎠

Fornisce la probabilità di k passaggi in un intervallo T=1 se T=t si ha

(

λ ⋅ t )k ⋅ e − λ ⋅t

p P (k ) =

k!

si ricorda infatti che lim⎜1 +

∞

E[X P ] = ∑ x

x=0

[ ]

∞

∞

e − λt (λ ⋅ t )

e − λt (λ ⋅ t )

e − λt (λ ⋅ t )

=∑

=(λ ⋅ t )∑

(x − 1)!

(x − 1)!

x!

x =1

x =0

∞

E X P2 = ∑ x 2

x =0

( x −1)

x

x

∞

(λ ⋅ t ) =(λ ⋅ t ) ⋅ e −λt e λt = λ ⋅ t

e − λt (λ ⋅ t )

=(λ ⋅ t ) ⋅ e −λt ∑

x

x!

!

x =0

x =0

∞

=(λ ⋅ t )∑

x

x

∞

∞

∞

e − λ ⋅t ⋅ (λ ⋅ t )

e − λ ⋅t ⋅ (λ ⋅ t )

e − λ ⋅t ⋅ (λ ⋅ t )

e − λ⋅t ⋅ (λ ⋅ t )

=∑ x

=(λ ⋅ t )∑ x

=(λ ⋅ t )∑ ( x + 1)

=

(x − 1)!

(x − 1)!

x!

x!

x =0

x =1

x =0

x

x

x

⎡ ∞ e −λ ⋅t ⋅ (λ ⋅ t )x ∞ e −λ ⋅t ⋅ (λ ⋅ t )x ⎤

2

= (λ ⋅ t ) ⋅ ⎢∑ x

+∑

⎥ = (λ ⋅ t ) ⋅ [(λ ⋅ t ) + 1] = (λ ⋅ t ) + (λ ⋅ t )

x!

x!

x =0

⎣ x =0

⎦

2

2

2

2

Var ( X P ) = E X P − (E [ X P ]) = (λ ⋅ t ) + (λ ⋅ t ) − (λ ⋅ t ) = (λ ⋅ t )

[ ]

SLIDE 17 / 35

x

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Variabile aleatoria ESPONENZIALE

Dalla espressione della funzione di probabilità della variabile di Poisson si ricava la

probabilità che non passi alcun veicolo in un intervallo t:

(

λ ⋅ t )k ⋅ e − λ ⋅t

(

)

pP k =

⇒ P[0] = e − λt = P[τ≥t]

k!

da cui

dF

Fτ (t ) = P[τ ≤ t ] = 1 − e − λt

e

fτ (t ) = τ = λ ⋅ e −λt

dt

∞

∞

∞

∞

∞

1

⎡ 1

⎤

E [t ] = ∫ t ⋅ λ ⋅ e −λt dt = − t ⋅ e −λt o + ∫ e −λt dt = ∫ e −λt dt = ⎢− e −λt ⎥ =

0

0

0

⎣ λ

⎦0 λ

∞

∞

∞

∞

2 ∞

2

2 1 2

E t 2 = ∫ t 2 ⋅ λ ⋅ e −λt dt = − t 2 ⋅ e −λt o + 2 ∫ t ⋅ e −λt dt = 2 ∫ t ⋅ e −λt dt = ∫ t ⋅ λ ⋅ e −λt dt = ⋅ E [t ] = ⋅ = 2

0

0

0

0

λ

λ

λ λ λ

2

1

1

2

Var (t ) = E t 2 − (E [t ]) = 2 − 2 = 2

[

[ ]

]

[

[ ]

]

λ

λ

λ

Variabile aleatoria di ERLANG

L’intervallo temporale che intercorre fino al verificarsi del k-esimo evento (successo in una

serie infinita di esperimenti Bernulliani ripetuti) può essere considerata come una v.a. τk

compresa tra 0 ed ∝. La funzione di distribuzione di tale v.a. può essere ricavata a partire

dall’espressione della v.a. di Poisson, infatti:

(λt )k ⋅ e −λt

Fτ k (t k ) = 1 −

k!

dFτ k

λ

(λt )k −1 e −λt

=

fτ (t ) =

(k − 1)!

dt

Si può dimostrare che la sua media e varianza valgono:

E[tk]=k/λ Var(tk)=k/λ2

Variabile aleatoria GAMMA

Consideriamo la funzione della variabile reale x :

∞

Γ( x ) = ∫ y ( x −1)e − y dy Funzione gamma

0

Applicando la regola di integrazione per parti:

∞

Γ( x ) = ∫ y

( x −1)

0

∞

e dy = ∫ − y

−y

0

( x −1)

( )⋅ dy = [− y

de

−y

( x −1)

e

∞

] − ∫ − (x − 1)y (

−y ∞

0

e dy = 0 + ( x − 1) ⋅ Γ( x − 1)

x −2 ) − y

0

Tale espressione consente di calcolare Γ(x) per qualsiasi valore di x>2 una volta noti i

valori di Γ(x) nell’intervallo [1, 2], in particolare per x intero si ottiene che dato che

Γ(1)=1:

Γ(x) =(x-1)!

Se sostituiamo nell’espressione della funzione di probabilità di Erlang la funzione Γ(k) al

posto di (k-1)! otteniamo la funzione densità di probabilità della v.a. gamma:

fτ (t ) =

λ

(λt )k −1 e −λt

Γ(k )

Nella quale il parametro k può assumere un qualsiasi valore reale (ha media e varianza

pari a E[tk]=k/λ Var(tk)=k/λ2

SLIDE 18 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

χ2 (chi-quadro)

Variabile aleatoria

È una distribuzione gamma con k= ν/2 e λ=1/2

fτ (t ) =

λ

Γ(k )

(λt )

k −1

e

− λt

=

λk

Γ(k )

(t )

k −1

e

− λt

( )=

⇒ f χ

1

2

υ

⎛υ ⎞

2 2 ⋅ Γ⎜ ⎟

⎝2⎠

υ −2

(χ )

2

2

e

−

χ2

2

Con 0< χ2 < ∞ e n = 1, 2, 3,….

è facile dimostrare che per le proprietà della funzione gamma si ha :

E[χ2]=k/λ=2∗ ν/2 =ν

Var(χ2)=k/λ2=(ν/2)*4= 2* ν

Variabile aleatoria di Gumbel

Deriva dalla v.a. esponenziale

Sia ZM=a-b ln(λ*x) una v.a. detta di “Gumbel dei valori massimi” (o Zm=a+b ln(λ*x) detta

di “Gumbel dei valori minimi” ) dove X è una v.a. esponenziale di parametro λ . La

funzione di distribuzione di ZM e di Zm saranno rispettivamente:

FZ M ( z ) = e

−e

−

z −a

b

e

FZ m (z ) = 1 − e −e

con -∞<a , z <∞ ; b>0

Variabile aleatoria di Weibull

La seguente trasformazione della v.a. di Gumbel dei valori minimi Zm :

W = eZ m

Definisce la v.a. di Weibull la cui funzione di distribuzione risulta essere:

FW (w) = 1 − e

⎛ w⎞

−⎜ ⎟

⎝a⎠

β

con -∞< w <∞ ; β>0

SLIDE 19 / 35

−

z −a

b

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

VARIABILE ALEATORIA NORMALE

È la più importante distribuzione di probabilità infatti:

− se Z è la somma di n v.a. indipendenti e identicamente distribuite al crescere di n la

v.a. Z tende a una v.a. Normale (teorema del limite centrale);

− se W è la somma di n v.a. qualsiasi tra loro indipendenti tali che la varianza di ciascuna

di esse sia trascurabile rispetto alla varianza di W al crescere di n la legge di

probabilità di W tende a quella di una v.a. Normale avente come parametri la media e

la deviazione standard di W.

Se il risultato di un esperimento è quindi dovuto ad un grande numero di cause

indipendenti fra loro (p.e. errori di misura) e tali che il contributo di ciascuna sia piccolo,

l’esperimento da luogo ad una variabile aleatoria normale.

La distribuzione Normale è nota anche come legge degli errori infatti Gauss la introdusse

per descrivere gli errori. Sia Z=f(u) la funzione di densità di probabilità degli errori (u è

l’errore). Se si effettuano più misurazioni di una stessa grandezza tutte degne della stessa

fiducia, il valore più probabile della grandezza è la media aritmetica delle misurazioni. La

curva degli errori deve quindi:

1)

Ammettere un massimo in corrispondenza dell’errore nullo:

dz

d 2z

=0

<0

du u =0

du 2 u =0

2)

La probabilità di commettere un certo errore in valore assoluto è funzione

decrescente dell’errore stesso:

dz

u<0

>0

du

per

dz

<0

u>0

du

3)

Solo asintoticamente per u→ -∝ e u→ +∝ sarà z→0 non potendosi porre limiti

all’operare puramente accidentale del caso

L’equazione differenziale più semplice che soddisfa i postulati prima illustrati è:

dz

= − z ⋅ u con (z ≥ 0 , - ∞ < u < +∞)

du

dz

= −u ⋅ du

z

⇒

dz

∫ z = ∫ − u ⋅ du

⇒

log e z = −

u2

+c

2

continua v.a. Normale

⎛ u2

⎞

⎛ u2 ⎞

⎜

⎟

z = f (u ) = exp⎜ − + c ⎟ = k exp⎜⎜ − ⎟⎟

⎝ 2

⎠

⎝ 2 ⎠

Affinché sia soddisfatto il secondo postulato della probabilità

k=

1

2π

SLIDE 20 / 35

+∞

∫ f (u )du = 1 deve essere :

−∞

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Infatti

+∞

+∞

−∞

−∞

∫ f (u )du = ∫

u2

−

1

1

⋅ e 2 du =

2π

2π

∫

+∞

−∞

e

−

u2

2

2

du =

2π

∫

+∞

0

e

−

u2

2

du

2

⎛ u ⎞

posto ⎜

⎟ =v

⎝ 2⎠

si ha

u = 2 ⋅ v1 2

da cui

quindi du =

⎛1

2 −12

⋅ v ⋅ dv

2

⎞

2

2 ∞ −v − 1 2

1 ∞ −v ⎜⎝ 2 −1⎟⎠

1 ⎛1⎞

1

(

)

=

⋅

⋅

=

⋅ dv =

Γ⎜ ⎟ =

f

u

du

e

v

dv

e ⋅v

∫−∞

∫

∫

0

0

π

π ⎝2⎠

π

2π 2

La legge di probabilità normale si può generalizzare:

+∞

f (u ) =

Per media E[Xu]=µ

1

⋅e

σ 2π

⎛ u−µ ⎞

⎜

⎟

⎝σ⋅ 2 ⎠

π =1

2

e Var(Xu)= σ2

Spesso si fa riferimento alla v.a. Normale Standard che ha media nulla e varianza pari a 1.

È possibile passare da una variabile aleatoria Normale X ad una Normale Standard Z attraverso

un cambiamento di origine e di scala, basta porre z= (x - µ)/ σ

Variabile Aleatoria Log Normale

Può considerasi un caso particolare della v.a. Normale, rappresenta infatti il caso di una

v.a. X il cui logaritmo naturale è distribuito con una legge di probabilità normale (la v.a.

Z=ln(x) è distribuita come una v.a. Normale). Ricordando che:

dz

f X (x ) = f Z (z ) ⋅

dx

Si ha che:

⎡ 1 ⎛ ln ( x ) − λ ⎞2 ⎤

1

⎟⎟ ⎥

f ( x) =

exp ⎢− ⋅ ⎜⎜

ξ

x ⋅ 2π ⋅ ξ

⎢⎣ 2 ⎝

⎠ ⎥⎦

dove

λ

è la media della v.a. Z = ln(x)

⎛

⎜

µ

λ = ln⎜

⎜

σ2

⎜ 1+ µ 2

⎝

ξ

⎞

⎟

⎟

⎟

⎟

⎠

è la deviazione standard della v.a. Z= ln(x)

⎛ σ2 ⎞

ξ 2 = ln⎜⎜1 + 2 ⎟⎟

µ

⎝

µ

σ

⎠

è la media della v.a. x

è la deviazione standard della v.a. x

SLIDE 21 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Variabile aleatoria di T di Student

Viene utilizzata nel test delle ipotesi relativo al confronto tra le medie di campioni casuali

estratti da una popolazione Gaussiana.

Tale variabile si ottiene come rapporto tra una v.a. Normale e la radice quadrata di una

v.a. χ2 divisa per i gradi di libertà ν.

U

T=

χ2

υ

Si può dimostrare che la sua media e varianza valgono:

⎧

⎫

⎫

⎧

⎪ 1 ⎪

⎪

⎪ U

E [T ] = E ⎨

⎬ = E [U ]⋅ E ⎨ 2 ⎬ = 0

2

χ

⎪ χ

⎪

⎪

⎪

υ⎭

⎩

υ ⎭

⎩

⎧ U2 ⎫

⎡ 1 ⎤

⎡1 ⎤

υ

2

2

per ν>2

Var (T ) = E T − {E [T ]} = E ⎨ 2 ⎬ = E U 2 ⋅ E ⎢ 2 ⎥ = υ ⋅ E ⎢ 2 ⎥ =

⎣ χ ⎦ (υ − 2 )

⎣ (χ υ )⎦

⎩χ υ ⎭

[ ]

[ ]

SLIDE 22 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

STATISTICA

La statistica si può definire come l’applicazione dei metodi scientifici alla programmazione

della raccolta di dati derivanti da osservazioni sperimentali, di natura essenzialmente

quantitativa, alla loro rilevazione, spoglio, elaborazione, classificazione, analisi , sintesi e

presentazione, per trarre inferenze attendibili da essi, sulle quali basare , in ultima istanza,

decisioni di ordine scientifico o pratico.

Distinguiamo nella statistica diversi livelli di analisi o fasi:

− fase

descrittiva

(elaborazione,

classificazione,

presentazione dei dati);

− fase induttiva (derivazione di inferenze attendibili);

− una fase decisoria

sintesi

e

Definiamo:

− mutabile un fenomeno che può assumere diverse modalità qualitative;

− variabile un fenomeno che può assumere diverse modalità quantitative.

STATISTICA DESCRITTIVA

La successione dei dati statistici che si ottiene classificando un fenomeno secondo una

variabile prende il nome di “seriazione statistica”

Le seriazioni si dicono di “frequenza” quando indicano la frequenza secondo cui si

manifestano le diverse modalità.

Consideriamo un fenomeno di massa che varia di intensità al variare delle modalità

quantitative continue del carattere di un altro fenomeno, detto variabile continua (p.e.

velocità dei veicoli durante un’osservazione di durata T).

Per trattare i dati:

1) si raggruppano in classi;

2) si individuano le unità statistiche “ fi “ che vengono a trovarsi in ogni classe

(frequenza assoluta della classe);

f

3) si valutano le frequenze relative f i ' = k i

∑ fi

i =1

4) Si costruisce una rappresentazione grafica tramite istogramma

Se la variabile è discreta, essa può assumere solo un numero finito di valori discreti, per

trattare i dati si procede pertanto come di seguito illustrato:

1) si individuano le unità statistiche “ fi “ di ciascun valore (frequenza assoluta );

f

2) si valutano le frequenze relative f i ' = k i

∑ fi

i =1

3) Si costruisce una rappresentazione grafica tramite diagramma a segmenti

Abbiamo costruito una distribuzione di frequenza che è certamente più maneggevole dei

dati iniziali, ma si può procedere oltre la classificazione in distribuzioni di frequenza,

sintetizzando a loro volta le distribuzioni con indici descrittivi:

indici di localizzazione valori medi x , mediana e moda o norma;

indici di variabilità

varianza s2, scarto quadratico medio s e coeff. di variazione

indici di dissimetria

d = m3 / S3

indice di curtosi o disnormalità m4 / S4

SLIDE 23 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Media

n

∑x f

M (x ) = x =

i =1

n

i

∑f

i =1

i

i

La media gode della proprietà che la somma algebrica dei prodotti degli scostamenti dalla

media aritmetica stessa per la frequenza corrispondente è nulla:

n

∑ (x − x )f = ∑ x f

n

i =1

n

i

i

i =1

i

i

n

n

i =1

i =1

∑x f

− x ⋅ ∑ f i = ∑ xi f i −

i

i =1

n

∑f

i =1

i

n

n

i =1

i =1

⋅ ∑ f i = ∑ xi f i = 0

i

Mediana

La mediana è il centro di simmetria, nel caso di una distribuzione di frequenza è quindi il

valore tale che la frequenza dei valori ad esso maggiori è uguale alla frequenza dei valori

ad esso minori (la somma dei valori assoluti degli scostamenti dalla mediana è un minimo

rispetto alla somma dei valori assoluti degli scostamenti da un qualsiasi altro valore)

Se xm è la mediana della distribuzione deve risultare:

∑ f i ' =∑ f i ' =0.5

i≤m

i≥m

Moda o Norma

Si chiama moda o norma di una distribuzione il valore della variabile cui corrisponde un

massimo relativo della densità di frequenza.

Se xn è la moda della distribuzione deve risultare

f n' ≥ f i '

∀i

Varianza

∑ (x

n

S 2 = Var ( x ) =

( )

i =1

)

i

n

∑f

i =1

∑ (x

n

2

− x ⋅ fi

=

i =1

2

( )

)

2

+ x − 2 ⋅ x ⋅ xi ⋅ f i

n

∑f

i

= M X 2 + x − 2x ⋅ x = M X 2 − x

2

i

i =1

∑ (x )⋅ f

n

=

2

i

i =1

∑f

i =1

i

+

i =1

n

∑f

i

i =1

i

n

i

−2

x ⋅ ∑ ( xi ) ⋅ f i

i =1

n

∑f

i =1

=

i

2

Scarto Quadratico Medio (SQM)

S= + Var ( x )

Coefficiente di variazione c =

σ

s

(per la popolazione sarà γ = )

µ

x

∑ (x

n

Indice di dissimetria

n

2

n

i

(x )∑ f

Dis ( x ) =

i =1

)

3

i

− x fi

n

∑f

i =1

i

Spesso si utilizza la radice cubica dell’indice 3 Dis (x ) in quanto è espresso nella stessa

unità di misura del fenomeno. (Dis(x)>0 dissimetria positiva = distribuzione spostata verso destra)

INDICI SINTETICI DI VARIABILITÀ RELATIVA

∑ (x

n

Curtosi o disnormalità

m4

1

= 4

4

S

S

i =1

− x fi

n

∑f

i =1

SLIDE 24 / 35

)

4

i

i

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

STATISTICA INDUTTIVA

Tipici problemi della statistica induttiva sorgono quando si osservano v.c. le cui

distribuzioni sono note in maniera incompleta (p.e. si conoscono le caratteristiche di un

campione) e si vuole risalire alle caratteristiche incognite della popolazione.

Nella statistica induttiva possiamo distinguere le seguenti parti principali:

1) Stima puntuale di un singolo parametro (la stima è un singolo valore numerico il

più prossimo possibile al valore incognito del parametro);

2) Stima di intervallo di un parametro (consiste in un intervallo entro cui si ritiene

cada con alta frequenza relativa il parametro incognito);

3) Criteri di verifica di ipotesi (si deve scegliere tra diverse linee d’azione sulla

scorta del valore osservato di una v.c. la cui distribuzione dipende da un parametro

che se fosse noto indicherebbe la linea d’azione più appropriata);

4) Analisi della varianza (tecnica particolare per verificare ipotesi complesse)

5) Programmazione degli esperimenti (scelta la tecnica più appropriata di stima, resta da

decidere quale numerosità deve avere il campione: se deve essere casuale semplice o

stratificato o a più stadi o di altro tipo);

6) Regressione lineare per lo studio delle relazioni tra variabili casuali e per la stima

di parametri di tali relazioni in base a dati campionari

Stima puntuale di parametri

La stima T di un parametro θ è una v.c. la cui distribuzione dipende da θ . La stima T è

accettabile se si discosta poco dal valore effettivo di θ: ma T è una v.c. onde non si può

essere certi a priori che essa si discosti poco da θ. Possiamo però far si che vi sia un’alta

probabilità che essa si discosti poco da θ. Perché ciò si verifichi occorre siano soddisfatte

due condizioni:

− La distribuzione di T deve essere localizzata in θ cioè deve avere il valore medio

M(T)=θ, nel qual caso la stima si dice non affetta da errore sistematico;

− La distribuzione di T sia poco dispersa, cioè sia piccola la Var(T) in modo che anche

osservando il singolo valore di T del campione osservato, e non il valore medio M(T)

esso si discosti poco da θ .

Campionamento da una popolazione

Sia N il numero di elementi della popolazione e la quantità che interessa, cioè la v.c. X,

assuma il valore xi nell’i-esimo elemento della popolazione. La media aritmetica e la

varianza di tali valori nella popolazione sono allora pari a:

N

µ = E[X ] =

N

∑ (x

∑ xi

− µ)

2

i

σ 2 = Var ( X ) = i =1

N

N

Estraiamo ora un campione casuale di numerosità n dalla popolazione ed indichiamo con

Xj il valore j-esimo elemento estratto nel campione (j=1, 2, …., n). Siccome in una data

estrazione ognuno degli N elementi della popolazione ha la stessa probabilità di essere

estratto ne discende che le v.c. X1, X2 , …. ,Xn hanno tutte la medesima distribuzione

con lo stesso valore medio della popolazione e la stessa varianza della popolazione:

M(X1)=M(X2)=……=M(Xn)=µ

Var(X1)=Var(X2)=……=Var(Xn)=σ2

Si definisce campione casuale, nel caso di popolazioni infinita (o di estrazione con

ripetizione) una determinazione ( x1, x2 , …. ,xn) della n-pla di v.c. X1, X2 , …. ,Xn tra loro

indipendenti, e con la medesima distribuzione della v.c. X nella popolazione.

i =1

SLIDE 25 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Si definisce invece campione casuale, nel caso di popolazioni finita (o estrazione in

blocco), una determinazione ( x1, x2 , …. ,xn) della n-pla di v.c. X1, X2 , …. ,Xn tra loro

dipendenti, tale che ogni determinazione ha la stessa probabilità di presentarsi. Se la

popolazione ha numerosità N tale probabilità costante sarà:

1

1

=

(numero delle disposizioni di N elementi presi a n a n)

DN ,n ⎛ N ⎞

⎜⎜ ⎟⎟

⎝n ⎠

Vogliamo stimare la media µ in base al campione.

È naturale ricorrere alla stima data dalla v.c. (media aritmetica):

n

X=

∑X

j =1

j

n

Per la regola del valore medio si ha (sia per v.c. indipendenti che dipendenti):

⎞

⎛ n

⎜∑Xj ⎟

n

j =1

⎟ = 1 M (X ) = 1 nµ = µ

M X = M ⎜⎜

∑

j

n ⎟ n j =1

n

⎟⎟

⎜⎜

⎠

⎝

onde X è una stima non affetta da errore sistematico.

La varianza della stima dipende da metodo di estrazione (con ripetizione ⇒ variabili

indipendenti , senza ripetizione ⇒ variabili dipendenti).

Nel primo caso (estrazione con ripetizione) si ha:

⎞

⎛ n

⎜∑X j ⎟

n

1

σ2

j =1

⎟= 1

2

(

)

σ

=

=

Var X = Var ⎜⎜

Var

X

n

∑

j

n ⎟ n 2 j =1

n2

n

⎟⎟

⎜⎜

⎠

⎝

Nel secondo caso (estrazione senza ripetizione) si ha (ricordando che la varianza della

somma di v.a. è pari alla somma delle varianze più il doppio della covarianza):

( )

( )

⎛ n

⎜∑Xj

j =1

Var X = Var ⎜⎜

n

⎜⎜

⎝

( )

⎞

⎟

n

⎤ 1 ⎡ n

⎛ n ⎞ ⎤ σ 2 n −1

⎟ = 1 ⎡ Var (X ) + 2

⎜⎜ ⎟⎟σ ij ⎥ =

(

)

(

)

=

+

γ

cov

,

2

+

X

X

Var

X

⎢

⎥

⎢

∑

∑∑

∑

j

j

i

j

⎟ n 2 j =1

2⎠ ⎦ n

n 2 ⎣ j =1

n

i< j

⎝

⎣

⎦

⎟⎟

⎠

Nel caso di n=N si ha X = µ onde

σ 2 N −1

σ2

Var (µ ) =

+

γ =0⇒γ = −

N

N

N −1

Quindi

( )

Var X =

σ2

n

−

n −1 σ 2

σ 2 ⎛ N −1 − n + 1⎞ σ 2 ⎛ N − n ⎞

=

⎜

⎟=

⎜

⎟

n N −1 n ⎝

N −1 ⎠ n ⎝ N −1 ⎠

La varianza dipende da σ che è pure incognito per ricavare la numerosità del campione

che soddisfi un certo grado di accuratezza bisogna prima avere informazioni preventive

mediante un campione pilota (o l’esperienza passata).

Analogamente a come si è proceduto per la stima della del parametro media si può

procedere alla stima della varianza. Anche qui si può inizialmente pensare di stimare la

varianza in base allo scarto quadratico del campione:

SLIDE 26 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

∑ (X

n

S2 =

j =1

j

−X

)

2

n

Ma sia nel caso di estrazione senza ripetizione che di estrazione con ripetizione tale stima

è affetta da un errore sistematico:

estrazione con ripetizione

∑ (X

n

S2 =

j =1

j

− X +µ−µ

) ∑ (X

n

2

n

=

j =1

− µ)

(

)

2

− X −µ −

n

∑ (X

n

2

j

(

(

)

2

X − µ ⋅ ∑ (X j − µ ) =

n

j =1

)

n

j =1

− µ)

2

j

n

(

− X −µ

)

( )

2

2

n −1

1 n

1

1

σ2

2

2

2

(

)

−

µ

−

−

µ

=

σ

−

=

σ

−

=σ 2

≠σ 2

M

X

M

X

n

Var

X

n

∑

j

n j =1

n

n

n

n

estrazione senza ripetizione

2

1 n

1

1

n(N − 1) − ( N − n )

σ2 N −n

2

M (S 2 ) = ∑ M (X j − µ ) −M X − µ = nσ 2 − Var X = nσ 2 −

⋅

=σ 2

=

n j =1

n

n

n N −1

n ⋅ ( N − 1)

da cui

M (S 2 ) =

(

=σ 2

)

( )

nN − n − N + n

N (n − 1)

=σ 2

≠σ 2

n ⋅ ( N − 1)

n ⋅ (N − 1)

Perciò se si stima

n

S*2 = S 2

nel caso di estrazione con ripetizione (variabili indipendenti)

n −1

N −1 n

S*2* = S 2

nel caso di estrazione senza ripetizione (variabili non indipendenti)

N n −1

queste sono stime di σ2 non affette da errore sistematico

Ma sono anche stime accurate, si può dimostrare che:

σ 4 ⎛ µ4 n −3⎞

⎜

⎟

Var (S ) =

−

n ⎜⎝ σ 4 n − 1 ⎟⎠

2

*

Se la distribuzione della popolazione è normale si sa che:

m4

σ 4 ⎛ m4 n − 3 ⎞ σ 4 ⎛ 3(n − 1) − n + 3 ⎞ σ 4 ⎛ 2n ⎞ 2 ⋅ σ 4

2

(

)

=

−

Var

S

=

3

(curtosi)

⇒

⎟=

⎜

⎜

⎟=

⎜

⎟=

*

n −1

n ⎝ σ 4 n −1 ⎠ n ⎝

σ4

⎠ n ⎝ n −1 ⎠ n −1

Allora il coefficiente di variazione è:

2

σ2

2

Var S*

2

n −1 =

=

≤∆

2

2

M S*

σ

n −1

Posto ∆=0.20 si ha:

n ≥ 51

( )

( )

Nel caso di v.a. Normali si può fissare la numerosità del campione al fine di ottenere uno scarto

quadratico medio che sia una certa percentuale del valore medio (p.e. 20%).

SLIDE 27 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Criteri di verifica delle ipotesi

Si intende per ipotesi statistica un’ipotesi riguardo alla distribuzione, o ad i parametri della

distribuzione, di una v.c. X, che si verifica sulla scorta dei valori osservati della v.c. stessa.

In generale, anche se l’ipotesi è vera, esiste una probabilità positiva di tutti i valori della

v.c. X, così che qualsiasi valore si osservi, può essersi verificato sotto l’ipotesi considerata,

che non potrà mai essere scartata con certezza. Ma certi valori di X possono essere

talmente rari nel caso l’ipotesi sia vera, da far ritenere ragionevole il rifiuto.

L’ipotesi I da verificare è detta generalmente “ ipotesi nulla “ perché spesso consiste

nell’assumere che non c’è nulla a favore delle ipotesi contrarie.

Se l’ipotesi I deve essere rifiutata quando X assume valori estremi, poco probabili, bisogna

decidere dove tracciare la linea di demarcazione tra accettazione e rifiuto di I. Se si rifiuta

l’ipotesi quando X≥c e si accetta quando X<c allora “c” è detto valore critico.

Se I: p=p0 la probabilità di falso rifiuto nel caso di valore critico c è: Pp0 ( X ≥ c ) = α

dove Pp0 indica la probabilità calcolata sotto l’assunzione che l’ipotesi nulla I sia vera; α

è detto livello di significatività del criterio di verifica dell’ipotesi.

ALCUNI TEST DELLE IPOTESI

CRITERI DI VERIFICA UNILATERALE E BILATERALE DI IPOTESI SU VARIABILI

IPOTESI SULLE MEDIE

Nel caso si voglia verificare l’ipotesi nulla:

I : µ = µ0

Si estrae dalla popolazione un campione abbastanza grande (i.e. n>50)

Detta X la media del campione e σ lo s.q.m. (supposto noto) della popolazione, se

l’ipotesi è vera:

UN =

X − µ0

σ

n

è distribuito approssimativamente come la variabile aleatoria Normale standardizzata.

Pertanto si rifiuta l’ipotesi se:

UN ≥ uα

se l’ipotesi contraria è µ > µ0

UN < - uα

se l’ipotesi contraria è µ < µ0

⏐UN⏐ ≥ uα/2 se l’ipotesi contraria è µ ≠ µ0

σ

σ

n

n

≅

è incognito ma viene spesso stimato come:

S

n −1

SLIDE 28 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

IPOTESI SULLA VARIANZA

Nel caso si voglia verificare l’ipotesi nulla:

I : σ 2 = σ 02

In una popolazione normale

Detta S2 la varianza di un campione di n elementi si calcola la variabile:

n⋅S2

X χ2 =

2

σ0

tale variabile deve avere distribuzione χ2 con ν=n-1 gradi di libertà.

Pertanto si rifiuta l’ipotesi se:

X χ 2 ≥ χ α2

se l’ipotesi contraria è σ2 ≥ σ02

X χ 2 < χ12−α

se l’ipotesi contraria è σ2 < σ02

X χ 2 ≥ χ α2 o X χ 2 ≤ χ 2 α

2

1−

se l’ipotesi contraria è σ2 ≠ σ02

2

dove α è il livello di significatività o probabilità di falso rifiuto

CRITERIO DI VERIFICA DELL’IPOTESI DI BONTA’ DELL’ACCOSTAMENTO DI

DISTRIBUZIONI EMPIRICHE CON DISTRIBUZIONI TEORICHE DI PROBABILITA’

Consideriamo n osservazioni tratte da una popolazione che si può ritenere distribuita

secondo una legge di probabilità che fornisce una probabilità incognita πi che

un’osservazione cada nella classe i-esima (i=1, 2, ….., k). Nel campione le osservazioni

che cadono nella classe i-esima sono ni dove:

k

∑n

i =1

i

=n

Si vuole verificare, sulla scorta degli n valori osservati nel campione l’ipotesi nulla:

I: πi = pi

cioè che le probabilità incognite πi sono uguali alla probabilità pi che una v.c. di tipo

“NOTO” assuma il valore xi (la legge sarà caratterizzata dai arametri A1, A2,..,Ah .

Si vuole in definitiva verificare l’ipotesi della bontà dell’accostamento della distribuzione

empirica con quella teorica di probabilità.

È intuitivo che tanto più è accettabile l’ipotesi nulla quanto più prossime a zero sono le

differenze p’i- pi dove p’i=ni/n

cioè le differenze ni- n*pi

Si dimostra che se l’ipotesi nulla è vera:

k

(n − npi )2

Χχ2 = ∑ i

npi

i =1

ha approssimativamente una distribuzione χ2 con ν=k-h-1 gradi di libertà ove k è il

numero delle classi e h è il numero dei parametri della distribuzione teorica.

Pertanto se:

X χ 2 ≥ χ α2

per i dati gradi di libertà, si rifiuta l’ipotesi nulla al livello di significatività α (probabilità di

falso rifiuto)

SLIDE 29 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

RELAZIONI TRA VARIABILI

ACCOSTAMENTO AD UNA RETTA CON IL METODO DEI MINIMI QUADRATI

Iniziamo ad illustrare l’accostamento di una seriazione mediante una retta, e a tal fine

consideriamo delle coppie di misurazioni (xi , yi) per i=1, 2 ,…., n (n>2), che individuano n

punti di coordinate (x, y) nel piano; la coppia (xi , yi) indica che nella i-esima osservazione

la variabile X ha assunto il valore xi e la variabile Y ha assunto il valore yi.

Chiamata ⎯x media aritmetica degli xi, cioè:

n

x=

∑x

i =1

i

n

risulta opportuno scrivere l’equazione della retta nella forma y = a + m (x - ⎯x ), ove m è il

coefficiente angolare mentre k = a – m ⎯x è l’ordinata all’origine, cioè1:

y=k+mx

Per misurare l’accostamento della retta ad un punto, usiamo gli scostamenti verticali, cioè

lo scostamento di verticale del punto di coordinate (xi , yi) dalla retta, che è dato da:

di = yi - [a + m (xi - ⎯x )].

Per la scelta della retta più appropriata si minimizza la somma dei quadrati degli

scostamenti (metodo dei minimi quadrati) fornita dalla seguente relazione:

n

n

i =1

i =1

[

(

S = ∑ d i2 = ∑ ( y i − a ) − m ⋅ xi − x

)]

2

Derivando rispetto ad a e m, ed eguagliando a zero le derivate si ha:

n

∂S

= −2 ⋅ ∑ y i + 2 ⋅ a ⋅ n = 0

∂a

i =1

(

)

(

n

n

∂S

= −2 ⋅ ∑ y i xi − x + 2 ⋅ m ⋅ ∑ xi − x

∂m

i =1

i =1

)

2

=0

da cui il sistema di due equazioni lineari nelle due incognite a e m 2:

n

⎧

⎪∑ y i = an

⎪ i =1

⎨n

n

⎪ y x − x =m

xi − x

∑

i

i

⎪⎩∑

i =1

i =1

aˆ =

n

(

)

(

i =1

i

=y

n

∑ y (x

n

che ha come soluzioni

)

∑y

2

mˆ =

i =1

n

i

∑ (x

i =1

i

i

−x

−x

)

)

2

Si tratta di un minimo, in quanto, come è facile verificare, sono soddisfatte le condizioni

alle derivate seconde.

Osservando inoltre che:

n

(

)

n

(

)(

)

n

∑ yi xi − x =∑ yi − y xi − x =∑ x ⋅ yi − n⋅ x ⋅ y

i =1

1

2

i =1

i =1

Si effettua un cambiamento di riferimento cartesiano, traslando l’origine degli assi dal punto (0,0) al punto (⎯x , 0).

L’apice “ ˆ “ sta a contrassegnare i valori stimati delle grandezze.

SLIDE 30 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

si può scrivere:

n

mˆ =

∑x

i =1

i

⋅ yi − n ⋅ x ⋅ y

∑ (x

n

i =1

i

−x

)

2

da cui dividendo numeratore e denominatore per n si ha:

Cov( x, y )

mˆ =

Var ( x )

È opportuno osservare che i simboli di Cov e Var non hanno in questo caso un significato

statistico ma devono essere intesi come indici descrittivi, non avendo per il momento

considerato le grandezze come variabili aleatorie.

In definitiva la retta accostata con il metodo dei minimi quadrati è (dove con ŷ si indicano

(

yˆ = y + m x − x

i valori accostati):

)

È possibile osservare che la retta passa per il punto di coordinate (⎯x, ⎯y) detto centroide

dell’insieme dei punti (xi , yi) , condizione peraltro attesa, in quanto, quando la x assume il

valore medio ⎯x , anche la y dovrebbe assumere il suo valore medio⎯y. La retta accostata

con il metodo dei minimi quadrati ha anche la proprietà che le deviazioni verticali di da

essa hanno somma nulla:

yˆ i = y + mˆ ⋅ xi − x

⇒

dˆi = y i − yˆ i = y i − y − mˆ xi − x

( )

∑ dˆ = ∑ (y − y ) − mˆ ∑ (x

n

da cui si ha 3

i =1

n

i

i =1

(

n

i

i =1

i

) (

)

)

−x =0

Inoltre la retta accostata con il metodo dei minimi quadrati presenta l’importante proprietà

n

n

i =1

i =1

2

che la somma (minima) dei quadrati degli scarti Sˆ = ∑ dˆi2 = ∑ ( y i − yˆ i ) divisa per n è la

Sˆ

.

n

Tale varianza sd2 (o lo scarto quadratico medio sd) è una misura della bontà

dell’accostamento della retta ai punti, assumendo valore nullo quando tutti i punti

giacciono sulla retta, ovvero quando l’accostamento è perfetto. È facile verificare che il

minimo della somma dei quadrati degli scarti è:

varianza sd2 degli scostamenti verticali dalla retta accostata, cioè s d2 =

n

Sˆ = ∑

i =1

(

⎛ n

⎞

⎜ ∑ xi ⋅ y i − n ⋅ x ⋅ y ⎟

2

⎠

y i − y − ⎝ i =1 n

2

∑ xi − x

)

i =1

(

2

)

Pertanto

∑ (y

n

s =

2

d

i =1

i

n

−y

)

2

⎞

⎛ n

⎜ ∑ xi ⋅ y i − n ⋅ x ⋅ y ⎟

⎠

− ⎝ i =1

∑(

n

2

)

2

⋅

xi − x che la somma algebrica degli scostamenti dalla media aritmetica stessa

La media aritmetica godendella

proprietà

(differenze tra i valori e la mediai =1aritmetica) è nulla.

3

SLIDE 31 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Introduciamo la varianza degli xi e quella degli yi definite come:

∑ (x

n

Var (x ) = s x2 =

i =1

i

−x

)

∑ (y

n

2

Var ( y ) = s y2 =

n

i =1

i

−y

)

2

n

Mentre la covarianza di tra gli xi e yi è data da :

∑ (x − x )(y − y ) ∑ x ⋅ y

n

Cov ( x, y ) = s xy =

i =1

n

2

i

i

=

n

i =1

i

n

i

− x⋅ y

Il coefficiente di correlazione lineare tra gli yi e xi

n

s xy

Cov ( x, y )

r=

=

=

Var ( x ) ⋅ Var ( y ) s x ⋅ s y

∑x y

i =1

i

i

è definito dall’invariante assoluto :

− n⋅x⋅ y

n ⋅ sx ⋅ s y

Dalla relazioni precedentemente introdotte si ottiene:

2

⎛ n

⎞

⎜ ∑ xi y i − n ⋅ x ⋅ y ⎟

⎠ = s2 − r 2s2 = s2 ⋅ 1 − r 2

s d2 = s y2 − ⎝ i =1

y

y

y

2

2

n ⋅ sx

(

)

La misura in cui sd2 è minore di sy2 è indice (almeno per n grande) dell’accostamento

effettuato mediante la retta.

Si consideri inoltre il rapporto:

s d2

= 1− r2

2

sy

È possibile osservare che

r2 misura la frazione di sy2

(

)

rimossa dalla varianza

degli

scostamenti verticali accostando la retta yˆ = aˆ + mˆ ⋅ x − x , e pertanto si usa anche dire

che r2 è la frazione della varianza originaria sy2 spiegata dalla retta.

È facile vedere che -1≤ r ≤ 1 , infatti dalla si ha che 0 ≤ sd2 ≤ sy2 da cui dividendo per

sy2 si ha:

s2

0 ≤ d2 ≤ 1

ovvero 0 ≤ 1- r2 ≤ 1 cioè -1 ≤ - r2 ≤ 0 e quindi 0 ≤ r2 ≤ 1 (c.v.d.).

sy

Per capire meglio il significato di r osserviamo che:

s xy

s y ⋅ sx

sy

mˆ = 2 = r ⋅ 2 = r ⋅

sx

sx

sx

SLIDE 32 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

REGRESSIONI LINEARI SEMPLICI

Supponiamo di osservare un fenomeno in cui una variabile casuale z dipenda da un’altra

variabile matematica x (variabile indipendente) sotto controllo dell’investigatore, che può

cioè prefissarne il valore (p.e. gli anni dalla costruzione, ecc). Sia inoltre:

(

z =a+m x−x

)

n

dove x è la media aritmetica dei valori di x predeterminati (x1, x2, ……, xn), cioè: x =

∑x

i =1

i

n

Si vuole determinare la dipendenza di z da x, ma il valore osservato z include un errore

casuale, dovuto all’errore insito nella misura sperimentale (con riferimento a quantogià

illustrato, si vuole in sostanza determinare la regressione della v.a. Z su X , dove X non è

però una v.a. ma una variabile matematica).

Siano pertanto Yi le v.c. che rappresentano il valore osservato corrispondente ad xi , e

siano Ui le v.c. che rappresentano l’errore di osservazione (o misurazione). Allora se si

sono effettuate n specifiche misurazioni, o osservazioni, corrispondenti ai predeterminati

valori di x, ottenendo i risultati (x1 , Y1), (x2 , Y2),……, (xn , Yn), si ha :

(

)

Yi = a + m xi − x + U i

cioè

Yi = k + m ⋅ xi + U i

avendo posto k = a − m x (che rappresenta la regressione di Y su X ).

Si assume generalmente che la popolazione sia infinità e che gli errori Ui siano v.c.

normali indipendenti con valore medio nullo M(Ui)=0 e varianza costante comune

Var(Ui)=σ2. Il fatto che le Ui siano variabili indipendenti comporta che la Cov(Ui , Uj) =0 per

i≠j ; inoltre è evidente che Cov(Ui , xi) =0 essendo xi una varibile matematica. Pertanto si

ha :

M (Y ) = a + m x − x = ~

y

(

i

i

)

i

Immaginiamo ora di aver fissato gli xi e di osservare i valori Yi = yi che si realizzano,

ovvero di disporre di un campione di n coppie di misurazioni (xi, yi) per i=1, 2, ….., n.

Poniamo

n

Y=

∑Y

i =1

i

n

media delle variabili casuali Yi (i=1, 2, ….n) , cosa ben diversa da M(Yi) che rappresenta il

valore medio della singola v.c. Yi. Se nel campione singolo di n coppie di misurazioni è

risultato Yi = yi, la v.c. Y assume il valore :

n

y=

∑y

i =1

i

n

SLIDE 33 / 35

Richiami di Teoria delle Probabilità e di Statistica per il modulo di PSFA

Stimiamo i coefficienti a e m con l’ausilio del metodo dei minimi quadrati. Per il teorema di

Gauss e Markov tali stime sono anche di massima verosimiglianza, e sono quindi anche

stime lineari non affette da errore sistematico di minima varianza. Si ha allora che aˆ = y

è il valore della variabile casuale Aˆ = Y stima di a calcolata sul singolo campione. Allo

stesso tempo:

∑ Y (x

n

Mˆ =

i

i =1

n

∑ (x

i =1

i

−x

i

−x

)

)

2

è il valore della v.c. M̂ stima di m, calcolata sul medesimo singolo campione; cioè:

∑ (y

n

m=

i =1

) ∑ x y − n ⋅ x ⋅ y ∑ y (x − x )

=

=

∑ (x − x )

∑ (x − x )

∑ (x − x )

i

)(

n

− y xi − x

n

n

i

i =1

n

2

i

i =1

i

2

i

i =1

i

i =1

n

i

2

i

i =1

La stima di Y è allora:

(

Yˆi = Aˆ + Mˆ xi − x

(

)

yˆ i = aˆ + mˆ xi − x

cioè nel singolo campione

)

È facile verificare che

Â

e M̂ sono stime non affette da errore sistematico

rispettivamente di a e m, infatti:

1 n

1 n