'

Elementi

$

di

Calcolo Tensoriale

su

&

Spazi Vettoriali

Sergio Benenti

20 giugno 2012

%

Indice

Palinsesto . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1 Spazi vettoriali puri

iii

1

1.1 Richiami e notazioni . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1

1.2 Forme lineari e spazi duali . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4

1.3 Forme bilineari . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6

1.4 Forme bilineari simmetriche . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

1.5 Forme quadratiche . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

1.6 Endomorfismi lineari . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 12

1.7 Determinante e traccia di un endomorfismo . . . . . . . . . . . . . . . . . . 14

1.8 Polinomio caratteristico di un endomorfismo . . . . . . . . . . . . . . . . . . 16

1.9 Autovalori e autovettori di un endomorfismo . . . . . . . . . . . . . . . . . . 18

1.10 Il teorema di Hamilton-Cayley . . . . . . . . . . . . . . . . . . . . . . . . . 21

1.11 Tensori

. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 22

1.12 Somma tensoriale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 24

1.13 Prodotto tensoriale . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

1.14 Basi tensoriali . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 27

1.15 Contrazione o saturazione di due indici . . . . . . . . . . . . . . . . . . . . . 28

1.16 Tensori antisimmetrici . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 29

1.17 Antisimmetrizzazione . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 30

1.18 Prodotto esterno . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 31

1.19 Algebra esterna . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 33

1.20 Il simbolo di Levi-Civita . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 35

2 Spazi vettoriali con struttura

39

2.1 Spazi vettoriali euclidei . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 39

2.2 Endomorfismi in spazi euclidei . . . . . . . . . . . . . . . . . . . . . . . . . 44

i

ii

2.3 Endomorfismi ortogonali . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 51

2.3.1

Rappresentazione mediante simmetrie . . . . . . . . . . . . . . . . . 52

2.3.2

Decomposizione simmetrica delle isometrie . . . . . . . . . . . . . . 53

2.3.3

Rappresentazione esponenziale . . . . . . . . . . . . . . . . . . . . . 53

2.3.4

Rappresentazione di Cayley . . . . . . . . . . . . . . . . . . . . . . . 54

2.3.5

Rappresentazione quaternionale . . . . . . . . . . . . . . . . . . . . . 55

2.4 Lo spazio vettoriale euclideo tridimensionale . . . . . . . . . . . . . . . . . . 56

2.4.1

La forma volume . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56

2.4.2

Aggiunzione . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 59

2.4.3

Prodotto vettoriale . . . . . . . . . . . . . . . . . . . . . . . . . . . . 61

2.4.4

Endomorfismi assiali . . . . . . . . . . . . . . . . . . . . . . . . . . . 64

2.4.5

Rotazioni . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 65

2.5 Spazi vettoriali iperbolici . . . . . . . . . . . . . . . . . . . . . . . . . . . . 70

iii

Palinsesto

Argomenti trattati in questa dispensa.

Puri, senza strutture addizionali

euclidea

Su spazi vettoriali

pseudo-euclidea, iperbolica

Con struttura

simplettica

altre

puri

euclidei (1)

Su spazi affini

Calcolo

semi-euclidei (2)

tensoriale

pseudo-euclidei (3)

Pure

con connessione

riemanniana (4)

Su varietà differenziabili

Con struttura pseudo-riemanniana (5)

simplettica (6)

altre

Applicazioni:

(1) Meccanica razionale.

(2) Spazio-tempo newtoniano.

(3) Spazio-tempo di Minkowski: relatività ristretta.

(4) Meccanica lagrangiana.

(5) Relatività generale.

(6) Meccanica hamiltoniana.

Capitolo 1

Spazi vettoriali puri

1.1

Richiami e notazioni

Un insieme E è uno spazio vettoriale o spazio lineare sopra un corpo commutativo K

se:

1. è definita un’operazione binaria interna su E, + : E × E → E, detta somma, soddisfacente agli assiomi di gruppo commutativo:

u + v = v + u,

∀ u, v ∈ E,

(u + v) + w = u + (v + w),

∀ u, v, w ∈ E,

∃ 0 ∈ E | u + 0 = u, ∀ u ∈ E,

∀ u ∈ E, ∃ v ∈ E | u + v = 0.

2. è definita un’operazione K × E → E, detta prodotto per uno scalare, tale da

soddisfare alle seguenti condizioni:

a (u + v) = a u + a v,

∀ a ∈ K, u ∈ E, v ∈ E,

(a + b)u = a u + b u,

∀ a, b ∈ K, u ∈ E,

(ab) u = a(b u),

∀ a, b ∈ K, u ∈ E,

1 u = u,

1 = unità in K, ∀u ∈ E.

Gli elementi di E si dicono vettori, gli elementi di K scalari. Denotiamo i vettori, salvo

l’elemento neutro 0 ∈ E (zero o vettore nullo), con lettere grassetto (quasi sempre

minuscole). Con lo stesso simbolo 0 denotiamo anche lo zero del campo K. Per ogni

vettore u si ha 0u = 0. Si denota con − u il vettore opposto a u, cioè il vettore per

cui u + (−u) = 0. Scriviamo v − u al posto di v + (−u). Il vettore nullo e l’opposto di

un qualunque vettore sono unici (perché unici sono, in un qualunque gruppo, l’elemento

neutro e il reciproco di un qualunque elemento).

1

2

Capitolo 1. Spazi vettoriali puri

Tra gli spazi vettoriali sopra un assegnato campo K ritroviamo il campo stesso e tutte le

sue potenze cartesiane Kn , cioè l’insieme delle n-ple di elementi del campo.

Un sottoinsieme S ⊂ E è un sottospazio se le proprietà (i) e (ii) valide in E valgono

anche per tutti gli elementi di S. Se K e L sono due sottospazi, denotiamo con K + L

la loro somma, cioè l’insieme dei vettori di E costituito da tutte le possibili somme di

elementi di K e di L. La somma K + L e l’intersezione K ∩ L di due sottospazi vettoriali

sono a loro volta dei sottospazi. Denotiamo con E ⊕ F la somma diretta di due spazi

vettoriali (sul medesimo corpo K): è il prodotto cartesiano E × F dotato della naturale

struttura di spazio vettoriale definita dalle operazioni (u, w) + (u0 , w0 ) = (u + u0 , w + w 0 )

e a(u, w) = (au, aw). Denoteremo anche con u ⊕ w un generico elemento di E ⊕ F . Si

dice anche che uno spazio vettoriale E è la somma diretta di due suoi sottospazi K e

L se E = K + L e se K ∩ L = {0}. In tal caso ogni vettore è la somma di due vettori

univocamente determinati di K e L. E risulta pertanto identificabile con K ⊕ L.

Una scrittura del tipo

1

2

k

a v 2 + a v 2 + . . . + a vk =

k

X

ai vi

i=1

prende il nome di combinazione lineare dei vettori v i con coefficienti ai ∈ K. Due o

più vettori si dicono indipendenti se la sola combinazione lineare che fornisce il vettore

nullo è quella a coefficienti tutti nulli:

k

X

ai vi = 0

=⇒

ai = 0.

i=1

Uno spazio vettoriale è detto a dimensione finita se ammette una base costituita da

un numero finito n di vettori, cioè un insieme di n vettori indipendenti che generano

tutto E tramite tutte le loro possibili combinazioni lineari. Il numero n coincide col

massimo numero di vettori indipendenti in un qualunque insieme di vettori. Esso prende

il nome di dimensione dello spazio. Scriveremo En oppure dim(E) = n per indicare che

la dimensione dello spazio vettoriale E è n. Una generica base di E sarà denotata con

(e1 , e2 , . . . , en ) o brevemente con (ei ), dove l’indice i sarà inteso variare da 1 a n. La

scrittura

n

X

1

2

n

v = v e2 + v e2 + . . . + v en =

v i ei

i=1

è la rappresentazione di un generico vettore v ∈ E secondo la base (ei ). I coefficienti

di questa combinazione lineare sono le componenti del vettore v. Le componenti di un

vettore, fissata la base, sono univocamente determinate. Si noti la diversa posizione degli

indici riservata alle componenti (v i ), in alto anziché in basso. Si conviene tuttavia di

omettere il simbolo di sommatoria per indici ripetuti in alto e in basso (convenzione di

Einstein). Allora la rappresentazione precedente si scrive più semplicemente

v = v i ei .

3

1.1. Richiami e notazioni

Si noti che non ha importanza la scelta dell’indice, purché la lettera usata appartenga

ad un insieme precedentemente convenuto (per esempio, lettere latine minuscole, lettere

greche, lettere latine maiuscole dopo la I, e cosı̀ via). Se per esempio conveniamo che le

lettere latine minuscole a partire dalla h varino da 1 a n, la precedente scrittura è del tutto

equivalente alle seguenti:

v = v h eh ,

v = v j ej ,

v = v k ek ,

...

La diversa collocazione degli indici e la sommatoria sottintesa per indici ripetuti in alto

e in basso sono convenzioni tipiche del calcolo tensoriale, i cui primi elementi saranno

illustrati in questo capitolo. Il formalismo che ne deriva è agevole e sintetico.

Le formule riguardanti il calcolo vettoriale o tensoriale sono in genere di tre tipi. Una formula è di tipo intrinseco o assoluto se essa coinvolge vettori o tensori ed operazioni definite

su questi senza l’intervento di basi. Ad una formula di tipo intrinseco corrisponde sempre

una formula con indici o in componenti, conseguente alla scelta di una base generica. Vi

sono infine formule, con indici, valide soltanto per una base particolare o per una classe

particolare di basi. Per sottolineare questa circostanza useremo sovente un’uguaglianza

∗

con asterisco: =.

Per quel che riguarda il concetto di dimensione è opportuno ricordare che per due sottospazi di uno spazio vettoriale E vale la formula di Grassmann (Hermann Günther

Grassmann, 1809-1877)

dim(K + L) + dim(K ∩ L) = dim(K) + dim(L).

Un’applicazione A : E → F da uno spazio vettoriale E ad uno spazio vettoriale F si dice

lineare se

A(a u + b v) = a A(u) + b A(v)

(∀u, v ∈ E, ∀a, b ∈ K).

Si dice anche che A è un omomorfismo lineare. Denoteremo in genere gli omomorfismi

lineari con lettere maiuscole in grassetto. Denoteremo con

Hom(E; F )

o semplicemente con

L(E; F )

l’insieme delle applicazioni lineari da E a F . Quest’insieme ha una naturale struttura di

spazio vettoriale, con la somma A + B e il prodotto a A per un elemento a ∈ K definiti

da

(A + B)(v) = A(v) + B(v),

(a A)(v) = a A(v).

Più in generale, se (E1 , E2 , . . ., Ep, F ) sono spazi vettoriali, un’applicazione

A : E1 × E2 × . . . × Ep → F

4

Capitolo 1. Spazi vettoriali puri

è detta p-lineare (genericamente multilineare) se è lineare su ogni argomento. Ad

esempio l’applicazione R2 → R : (x, y) 7→ xy è bilineare (l’insieme dei numeri reali R ha

un’ovvia struttura di spazio vettoriale su se stesso, di dimensione 1). Denoteremo con

L(E1, E2 , . . . , Ep; F )

l’insieme delle applicazioni multilineari da E1 × E2 × . . . × Ep a F . Anch’esso è dotato di

una struttura naturale di spazio vettoriale.

In queste lezioni ci limiteremo a considerare solo spazi vettoriali reali (cioè sul campo dei

reali, K = R) e a dimensione finita.

Eesamineremo i seguenti spazi di applicazioni:

L(E; F ) = Hom(E, F )

L(E; R) = E

∗

applicazioni lineari

spazio duale di E

L(E; E) = End(E)

endomorfismi lineari su E

L(E, E; R) = T2 (E)

forme bilineari su E

L(E ∗, . . . , E ∗, E, . . ., E ; R) = Tqp (E)

| {z } | {z }

p volte

1.2

tensori di tipo (p, q).

q volte

Forme lineari e spazi duali

Un’applicazione lineare α : E → R da uno spazio vettorale E allo spazio R dei numeri

reali è detta forma lineare su E o covettore. Lo spazio L(E; R) delle forme lineari è

più semplicemente denotato con E ∗ ed è chiamato spazio duale di E.

Al posto di α(v) useremo il simbolo

hv, αi

per denotare il valore del covettore α sul vettore v. Diremo che hv, αi è la valutazione

di α su v o, viceversa, di v su α. Ponendo F = R in quanto si è detto nel paragrafo

precedente, si vede in particolare che

dim(E ∗ ) = dim(E).

Esiste un’isomorfismo canonico ι : E → E ∗∗ tra lo spazio biduale E ∗∗ = L(E ∗ ; R) e lo

spazio E stesso, definito dall’uguaglianza

hα, ι(v)i = hv, αi.

(1.1)

Gli elementi di E ∗∗ saranno di seguito sempre identificati con i vettori di E.

Ad ogni sottospazio K ⊂ E associamo un sottospazio K ◦ ⊂ E ∗ , detto polare di K,

costituito da tutti i covettori che annullano tutti gli elementi di K:

K ◦ = {α ∈ E ∗ | hu, αi = 0, ∀u ∈ K}.

(1.2)

5

1.2. Forme lineari e spazi duali

Sussistono le seguenti proprietà, qualunque siano i sottospazi K e L di E:

dim(K) + dim(K ◦ ) = dim(E),

K ◦◦ = K,

K ◦ ⊂ L◦ ⇐⇒ L ⊂ K,

(K + L)◦ = K ◦ ∩ L◦ ,

◦

K + L◦ = (K ∩ L)◦ .

(1.3)

La loro dimostrazione è lasciata come esercizio. Si noti che la seconda di queste uguaglianze

sottintende l’intervento dell’isomorfismo canonico tra lo spazio e il suo biduale e che inoltre,

in virtù di questo isomorfismo, le ultime due uguaglianze (1.3) esprimono la medesima

proprietà.

Ad ogni base (ei ) di E corrisponde un base duale in E ∗ , che denotiamo con (εi ), definita

implicitamente dall’uguaglianza:

hej , εi i = δji

(1.4)

dove δji è il simbolo di Kronecker (Leopold Kronecker, 1823-1851):

δji

=

(

1

se

i=j

0

se

i 6= j

Per ogni v ∈ E e α ∈ E ∗ valgono le relazioni:

v = v i ei

⇐⇒

v i = hv, εi i

(1.5)

α = αi εi

⇐⇒

αi = hei , αi

(1.6)

hv, αi = αi v i

(1.7)

La loro dimostrazione è lasciata come esercizio. Si osservi la diversa posizione degli indici

delle componenti di un covettore (in basso, anziché in alto come per le componenti dei

vettori) e la simmetria formale di queste uguaglianze. L’equivalenza (1.5) mostra che

le componenti di un vettore sono ottenute valutando sul vettore gli elementi della base

duale. Analogamente la (1.6) mostra che le componenti di un covettore coincidono con le

valutazioni di questo sugli elementi della base di E. Infine la (1.7) mostra che la valutazione

tra un vettore ed un covettore è data dalla somma dei prodotti delle componenti omologhe.

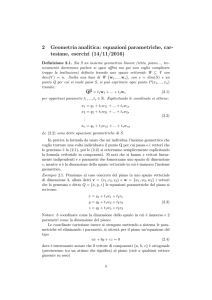

Osservazione 1.2.1 – Rappresentazione geometrica dei covettori. Ad ogni covettore α ∈

E ∗ si possono far corrispondere due sottoinsiemi di E:

A0 = {x ∈ E |hx, αi = 0},

A1 = {x ∈ E |hx, αi = 1}.

6

Capitolo 1. Spazi vettoriali puri

A0 è un sottospazio di codimensione 1, A1 è un suo laterale. La conoscenza di questi due

sottoinsiemi (in effetti basterebbe la conoscenza del secondo) determina completamente α.

Infatti, dato un vettore v ∈ E, o è v ∈ A0 , e allora poniamo hv, αi = 0, oppure è v = λ x

con x ∈ A1 , e allora poniamo hv, αi = λ. Si osservi che, denotate con (xi ) le componenti

di un generico vettore x, i due sottoinsiemi A0 e A1 sono rispettivamente definiti dalle

equazioni

αi xi = 0,

αi xi = 1.

Si tratta di una coppia di iperpiani paralleli, il primo passante per l’origine. •

Rappresentazione geometrica dei

covettori.

1.3

Forme bilineari

Una forma bilineare su di uno spazio vettoriale E è un’applicazione bilineare di E × E

in R. Lo spazio delle forme bilineari1 è denotato con L(E, E; R).

Assegnata una base (ei ) di E, i numeri

ϕij = ϕ(ei , ej )

(1.8)

si chiamano componenti della forma bilineare secondo la base. Per ogni coppia di vettori

di E si ha:

ϕ(u, v) = ϕij ui v j

(1.9)

Le componenti [ϕij ] formano una matrice quadrata n × n. Conveniamo che il primo indice

sia indice di riga, il secondo di colonna. Si chiama rango della forma ϕ il rango della

matrice [ϕij ].2

1

In accordo con quanto detto all’inizio di questo capitolo.

Naturalmente, affinché questa definizione abbia senso, occorre dimostrare che il rango della matrice

delle componenti non dipende dalla scelta della base di E.

2

7

1.3. Forme bilineari

Una forma bilineare si dice regolare o non degenere se vale la condizione

ϕ(u, v) = 0, ∀v ∈ E

=⇒

u=0

(1.10)

=⇒

v = 0.

(1.11)

oppure la condizione equivalente

ϕ(u, v) = 0, ∀u ∈ E

Entrambe sono equivalenti alla condizione

det[ϕij ] 6= 0.

(1.12)

Dunque una forma bilineare è regolare se e solo se ha rango massimo (= n).

Che la (1.12) sia equivalente alla (1.10) segue dal fatto che, in componenti, l’implicazione

(1.11) si scrive:

ϕij ui v j = 0, ∀(v i ) ∈ Rn =⇒ ui = 0.

Questa si semplifica in

ϕij ui = 0

=⇒

ui = 0,

ed esprime la circostanza che il sistema lineare omogeneo (di n equazioni in n incognite)

ϕij ui = 0 ammette solo la soluzione nulla.

Definizione 1.3.1 – La trasposta di una forma bilineare ϕ è la forma bilineare ϕT

definita da

ϕT (u, v) = ϕ(v, u)

•

(1.13)

Si ha ovviamente ϕTT = ϕ.

Definizione 1.3.2 – Una forma bilineare si dice simmetrica (rispettivamente, antisimmetrica) se

ϕT = ϕ

(risp. ϕT = − ϕ),

(1.14)

cioè se

ϕ(u, v) = ϕ(v, u),

(risp. ϕ(u, v) = − ϕ(v, u)).

•

(1.15)

Questa condizione si esprime, qualunque sia la base scelta, nella simmetria (risp. nella

antisimmetria) della matrice delle componenti (basta porre (u, v) = (ei , ej ) nella (1.13)):

ϕij = ϕji ,

(risp. ϕij = − ϕji ).

(1.16)

Una forma bilineare ϕ è decomponibile nella somma della sua parte simmetrica ϕS e

della sua parte antisimmetrica ϕA . Vale cioè l’uguaglianza

ϕ = ϕS + ϕA

posto

ϕS = 12 (ϕ + ϕT ),

ϕA = 12 (ϕ − ϕT )

(1.17)

8

Capitolo 1. Spazi vettoriali puri

Osservazione 1.3.1 – Un esempio elementare ma importante di forma bilineare è dato dal prodotto tensoriale α ⊗ β di due forme lineari α, β ∈ E ∗ . Esso è definito

dall’uguaglianza

(α ⊗ β) (u, v) = hu, αihv, βi

(1.18)

Se (εi ) è la base duale di una base (ei ) di E allora gli n2 prodotti εi ⊗ εj formano una base

di L(E, E; R). Cosı̀ una qualunque forma bilineare ϕ può esprimersi come combinazione

lineare di questi:3

ϕ = ϕij εi ⊗ εj

(1.19)

dove le ϕij sono proprio le componenti definite dalla (1.8). •

1.4

Forme bilineari simmetriche

Sia ϕ una forma bilineare simmetrica. Due vettori si dicono coniugati (o anche ortogonali) rispetto a ϕ se ϕ(u, v) = 0. In particolare un vettore si dice isotropo se è coniugato

con se stesso, ϕ(u, u) = 0, unitario se invece ϕ(u, u) = ±1.

Due sono i concetti fondamentali associati ad una forma bilineare simmetrica: quello di

base canonica e quello di segnatura.

Una base (ei ) di E si dice canonica (sempre rispetto a ϕ) se tutti i suoi vettori sono

unitari o isotropi e fra loro coniugati, cioè se, dopo un eventuale riordinamento della base,

la matrice della componenti assume la forma:

1p

0

0

(1.20)

[ϕij ] =

0 −1q 0

0

0

0

dove 1p e 1q denotano le matrici unitarie di ordine p e q rispettivamente. In una base

canonica si ha quindi (si confronti con la (1.9):

ϕ(u, v) =

p

X

a=1

a

a

u v −

p+q

X

ub v b .

(1.21)

b=p+1

Si dimostra4 che esistono basi canoniche e inoltre che in ogni base canonica la matrice

delle componenti è sempre del tipo (1.20), vale a dire che gli interi p e q sono invarianti

rispetto alla scelta di basi canoniche. Questa notevole proprietà è nota come teorema

di Sylvester o legge di inerzia delle forme quadratiche (James Joseph Sylvester,

1814-1897). Alla coppia di interi non negativi (p, q) si dà il nome di segnatura della

forma bilineare simmetrica ϕ.

3

4

Sul prodotto ⊗ torneremo più avanti.

La dimostrazione è in appendice al paragrafo.

9

1.5. Forme quadratiche

Si osserva dalla (1.20) che la somma p + q è uguale al rango di ϕ.

Per calcolare la segnatura di una forma bilineare simmetrica ϕ basterebbe determinare

una base canonica (o almeno una base di vettori fra loro ortogonali) (ei ) e valutare quindi

i segni dei numeri ϕ(ei , ei ), la qual cosa può rivelarsi in pratica piuttosto difficoltosa. Si

può allora fare ricorso ad un metodo assai rapido, illustrato nel seguente teorema:5

Teorema 1.4.1 – Sia [ϕij ] la matrice delle componenti di una forma bilineare simmetrica

ϕ relativa ad una base qualsiasi. Si consideri una qualunque successione di sottomatrici

quadrate principali, di ordine crescente da 1 a n, ciascuna contenuta nella successiva:

M1 ,

M2 ,

...

, Mn = [ϕij ].

Allora l’intero q della segnatura (p, q) è uguale al numero delle variazioni di segno della

successione di numeri

1,

M1 ,

det M2 ,

...

det Mn = det[ϕij ],

dalla quale siano stati eliminati gli eventuali zeri.

Calcolato l’intero q, l’intero p viene poi calcolato conoscendo il rango r della matrice:

p = r − q. Si noti bene che questo metodo per il calcolo della segnatura lascia piena libertà

di scelta della base e delle sottomatrici della successione.

1.5

Forme quadratiche

Data un’applicazione Φ : E → R, si dice sua polarizzazione l’applicazione

δΦ : E × E → R

definita da

δΦ(u, v) =

1

2

h

i

Φ(u + v) − Φ(u) − Φ(v)

(1.22)

Una forma quadratica su di uno spazio vettoriale E è un’applicazione Φ : E → R la cui

polarizzazione δΦ è una forma bilineare (ovviamente simmetrica).

Pertanto, per la sua stessa definizione, ad una forma quadratica corrisponde una forma

bilineare simmetrica. Viceversa, se ϕ è una forma bilineare simmetrica allora l’applicazione

Φ : E → R definita da

Φ(u) = ϕ(u, u) = ϕij ui uj

5

(1.23)

Una dimostrazione si trova in F.G. Tricomi, Lezioni di Analisi Matematica I (CEDAM, Padova).

10

Capitolo 1. Spazi vettoriali puri

è una forma quadratica tale che δΦ = ϕ. Infatti:

δΦ(u, v) =

=

=

1

2

1

2

1

2

Φ(u + v) − Φ(u) − Φ(v)

ϕ(u + v, u + v) − ϕ(u, u) − ϕ(v, v)

ϕ(u, u) + ϕ(v, v) + 2 ϕ(u, v) − ϕ(u, u) − ϕ(v, v)

= ϕ(u, v).

Vi è dunque una corrispondenza biunivoca fra forme quadratiche e forme bilineari simmetriche. Stante questa corrispondenza tutte le definizioni e le proprietà stabilite per le

forme bilineari si trasferiscono alle forme quadratiche, e viceversa.

Esempio 1.5.1 – Consideriamo E = R2 e la funzione

Φ : R2 → R : (x, y) 7→ x y.

Calcoliamone la polarizzazione seguendo la definizione (1.22) con u = (x1 , y1 ) e v =

(x2 , y2 ):

h

i

δΦ ((x1 , y1 ), (x2 , y2 )) = 12 (x1 + x2 )(y1 + y2 ) − x1 y1 − x2 y2

=

=

1

2

1

2

(x1 y1 + x1 y2 + x2 y1 + x2 y2 − x1 y1 − x2 y2 )

(x1 y2 + x2 y1 ) .

Se si fissa il vettore v = (x2 , y2 ), quest’ultima espressione è un binomio lineare in (x1 , y1 );

similmente, se si fissa il vettore u = (x1 , y1 ), essa è lineare in (x2 , y2 ). Pertanto la mappa

δΦ : R2 × R2 → R : ((x1 , y1 ), (x2 , y2 )) 7→

1

2

(x1 y2 + x2 y1 )

è bilineare e quindi Φ: R2 → R : (x, y) 7→ x y è una forma quadratica. •

Definizione 1.5.1 – Una forma quadratica Φ si dice semi-definita positiva (rispettivamente, semi-definita negativa) se

Φ(u) ≥ 0

(risp. Φ(u) ≤ 0)

∀u ∈ E.

In particolare si dice definita positiva (risp. definita negativa) se essa si annulla solo

sul vettore nullo, cioè se oltre alla condizione precedente vale l’implicazione

Φ(u) = 0

⇒

u = 0.

Si dice non definita o indefinita in tutti gli altri casi. •

In una base canonica si ha (si veda la (1.21))

Φ(u) =

p

p+q

X

X

(ua )2 −

(ub )2 .

a=1

b=p+1

(1.24)

11

1.5. Forme quadratiche

Di qui si osserva che: (a) una forma quadratica è semidefinita positiva se q = 0; (b) è

definita positiva se p = n. Analogamente per il caso negativo.

Per una forma bilineare simmetrica semi-definita positiva (o negativa) vale la disuguaglianza di Schwarz (Hermann Schwarz, 1843-1921)

ϕ(u, v)

2

≤ Φ(u)Φ(v),

∀ u, v ∈ E

(1.25)

Se in particolare ϕ è definita positiva (o negativa), allora si ha l’uguaglianza se e solo se

u e v sono dipendenti.

***

Dimostrazione dell’esistenza di basi canoniche. Basta dimostrare l’esistenza di basi ortogonali, per cui cioè ϕ(ei , ej ) = 0 per i 6= j. Se ϕ = 0 ogni base è ortogonale. Supponiamo

ϕ 6= 0 e procediamo per induzione sull’intero n = dim(E). Per n = 1 ogni vettore non nullo e ∈ E è una base ortogonale per qualunque forma bilineare simmetrica su E. Sia allora

n > 1 e si supponga che ogni forma bilineare simmetrica su di uno spazio di dimensione

< n ammetta una base ortogonale. Posto che ϕ 6= 0, esiste almeno un vettore u ∈ E per

cui ϕ(u, u) = Φ(u) 6= 0. Si consideri allora il sottospazio U = {v ∈ E | ϕ(u, v) = 0} dei

vettori ortogonali a u. Siccome u ∈

/ U , abbiamo m = dim(U ) ≤ n − 1. Per la restrizione

a U × U di ϕ esiste allora una base ortogonale (e1 , . . . , em ). D’altra parte, posto per ogni

v∈E

ϕ(u, v)

,

vn =

ϕ(u, u)

si vede che ϕ(u, v − v n u) = 0. Dunque v − v n u ∈ U e quindi

n

v =v u+

m

X

v i ei .

i=1

Ciò mostra che i vettori indipendenti (e1 , . . . , em , u) formano una base ortogonale di E (e

quindi anche che m = n − 1). 2

***

Dimostrazione del Teorema di Sylvester. Siano (ei ) e (ei0 ) due basi canoniche per la forma

bilineare simmetrica ϕ. Per la (1.24) si ha, per ogni u ∈ E, l’uguaglianza

Φ(u) =

p

X

a=1

a 2

(u ) −

p+q

X

b=p+1

0

b 2

(u ) =

p

X

a0 =1

a0 2

(u ) −

0 +q 0

pX

0

(ub )2 .

(1.26)

b0 =p0 +1

Si ha certamente p0 + q 0 = p + q = rank(ϕ). Occorre dimostrare che p0 = p. Si supponga

0

per assurdo p0 > p (e quindi q 0 < q). Considerata la relazione lineare ei = Eii ei0 tra le

due basi, si scriva il sistema lineare omogeneo

p+q

X

b=p+1

0

Ebb xb = 0,

b0 = p0 + 1, . . . , p0 + q 0 .

(1.27)

12

Capitolo 1. Spazi vettoriali puri

Si tratta di q 0 equazioni nelle q incognite (xp+1 , . . . , xp+q ). Siccome q 0 < q, questo sistema

ammette certamente una soluzione non nulla (up+1 , . . . , up+q ). Sia u ∈ E il vettore che

ha tutte le altre componenti nulle: u1 = . . . = up = up+q+1 = . . . = un = 0. Per la prima

parte della (1.26) si ha sicuramente Φ(u) < 0. Con una tale scelta si ha d’altra parte

0

0

ub = Eib ui =

p+q

X

0

Ebb ub = 0

b=p+1

perché (up+1 , . . . , up+q ) è una soluzione del sistema (1.27). Dalla seconda della (1.26) segue

allora Φ(u) ≥ 0: assurdo. Per simmetria l’ipotesi p0 < p conduce pure ad un assurdo.

Dunque p0 = p. 2

Dimostrazione della disuguaglianza di Schwarz. Fissati i vettori u e v, qualunque sia

x ∈ R, si ha Φ(u + x v) ≥ 0 perché Φ è semidefinita positiva. Questa disuguaglianza si

traduce in

T (x) ≡ x2 Φ(v) + 2 x ϕ(u, v) + Φ(u) ≥ 0,

(1.28)

2

dove Φ(v) ≥ 0. Se Φ(v) > 0, il discriminante ∆ = ϕ(u, v) − Φ(u)Φ(v) del trinomio

T (x) non può essere positivo, altrimenti T (x) avrebbe due radici reali e distinte e la (1.28)

sarebbe violata. Da ∆ ≤ 0 segue la disuguaglianza (1.25). Se Φ(v) = 0, perché la (1.28) sia

sempre soddisfatta deve essere necessariamente ϕ(u, v) = 0. La (1.25) è allora soddisfatta

come uguaglianza. Se u è proporzionale a v (in particolare nullo), si verifica subito che

vale l’uguaglianza nella (1.25). Viceversa, se vale l’uguaglianza risulta ∆ = 0 e pertanto

il trinomio T (x) ammette una radice doppia x0 tale che Φ(u + x0 v) = 0. Se Φ è definita

positiva deve necessariamente essere u + x0 v = 0. 2

Osservazione 1.5.1 – Le considerazioni qui svolte sulle forme quadratiche trovano applicazione nella teoria dei massimi e minimi di una funzione a più variabili e nella classificazione delle coniche, quadriche e iperquadriche. •

1.6

Endomorfismi lineari

Denotiamo con End(E) lo spazio delle applicazioni lineari L(E; E) di uno spazio vettoriale

E in se stesso, cioè lo spazio degli endomorfismi lineari di E. Denotiamo semplicemente

con BA la composizione di due endomorfismi B ◦ A. L’operazione di composizione degli

endomorfismi conferisce allo spazio End(E) la struttura di algebra associativa con unità;

l’unità è l’applicazione identica di E in se stesso, che denotiamo con idE o con 1E o

semplicemente con 1. Denotiamo con 0 : E → E l’applicazione che manda tutti i vettori

di E nello zero.

Gli endomorfismi invertibili sono detti automorfismi o trasformazioni lineari di E.

Formano un gruppo che denotiamo con Aut(E). Si denota con A−1 l’inverso di un

automorfismo A.

Scelta una base (ei ) dello spazio E, ad ogni endomorfismo A ∈ End(E) risulta associata

una matrice quadrata [Aji ]n×n , detta matrice delle componenti di A nella base (ei )

13

1.6. Endomorfismi lineari

e definita dall’uguaglianza

A(ei ) = Aji ej

(1.29)

Di conseguenza, l’uguaglianza v = A(u) si traduce, in componenti, nell’uguaglianza

v j = Aji ui

(1.30)

Infatti, posto che u = ui ei e v = v i ei , per la linearità di A e per la definizione (1.29),

si ha successivamente:

A(u) = A(ui ei ) = ui A(ei ) = ui Aji ej

da cui segue che ui Aji coincide con la componente v j di v.

Osservazione 1.6.1 – La matrice delle componenti dell’identità 1 è, qualunque sia la

base scelta, la matrice unitaria. Vale a dire:

(1)ij = δji . •

Osservazione 1.6.2 – Applicando ad entrambi i membri della definizione (1.29) un covettore εk della base duale di (ei ) si trova l’uguaglianza

Aki = hA(ei ), εk i

(1.31)

che fornisce le componenti di A in maniera ‘esplicita’.6 •

Osservazione 1.6.3 – La matrice delle componenti di un prodotto di endomorfismi è il

prodotto delle due rispettive matrici:

(AB)ji = Ajk Bik

(1.32)

Si ha infatti, applicando la (1.31) e la (1.29):

j

(AB)i

= hA(B(ei )), εj i = hA(Bik ek ), εj i

= Bik hA(ek ), εj i = Bik Ajk .

Si noti che se si conviene che l’indice in basso sia indice di colonna, il prodotto matriciale

nella (1.32) è righe per colonne: righe della prima matrice (Bik ) per le colonne della seconda

matrice (Ajk ). Si noti bene però che la scrittura Ajk Bik a secondo membro della (1.32) è

del tutto equivalente a Bik Ajk . •

6

La (1.29) le fornisce in maniera ‘implicita’.

14

Capitolo 1. Spazi vettoriali puri

Osservazione 1.6.4 – Gli automorfismi sono caratterizzati dalla risolubilità del sistema

lineare (1.30) rispetto alle (uj ), quindi dalla condizione

det[Aij ] 6= 0.

La matrice delle componenti di A−1 è l’inversa della matrice [Aij ]. •

***

Commutatore di due endomorfismi. Le due operazioni binarie interne fondamentali nello spazio degli endomorfismi End(E), consentono di definire una terza operazione binaria interna, il commutatore. Il commutatore di due endomorfismi A e B è

l’endomorfismo

[A, B] = AB − BA.

(1.33)

Si ha [A, B] = 0 se e solo se i due endomorfismi commutano. Il commutatore [·, ·] gode

delle seguenti proprietà:

[A, B] = − [B, A] ,

[aA + bB, C] = a [A, C] + b [B, C] ,

(1.34)

[A, [B, C]] + [B, [C, A]] + [C, [A, B]] = 0.

Le prime due, di verifica immediata, mostrano che il commutatore è antisimmetrico e bilineare. La terza, la cui verifica richiede un semplice calcolo, prende il nome di identità

di Jacobi (Carl Gustav Jacob Jacobi, 1804-1851). Uno spazio vettoriale dotato di un’operazione binaria interna soddisfacente a queste tre proprietà prende il nome di algebra

di Lie (Marius Sophus Lie, 1842-1899). Dunque End(E) è un algebra di Lie. Vedremo

nel corso di queste lezioni altri esempi di algebre di Lie.

Nelle (1.34) la prima proprietà, cioè la proprietà anticommutativa, può essere sostituita

da

[A, A] = 0.

(1.35)

è infatti ovvio che la (1.34)1 implica la (1.35). Viceversa, se vale la (1.35) si ha successivamente:

0 = [A + B, A + B] = [A, A] + [B, B] + [A, B] + [B, A]

= [A, B] + [B, A] .

Di qui la (1.34)1.

1.7

Determinante e traccia di un endomorfismo

Sebbene la matrice delle componenti di un endomorfismo cambi al cambiare della base –

fanno eccezione l’endomorfismo nullo e quello identico – vi sono delle grandezze ad essa

15

1.7. Determinante e traccia di un endomorfismo

associate che invece non risentono di questo cambiamento. Queste grandezze si chiamano

invarianti dell’endomorfismo: pur essendo calcolate attraverso le componenti, non dipendono dalla scelta della base e sono quindi intrinsecamente legate all’endomorfismo. Il

seguente teorema mette in evidenza i primi due invarianti fondamentali.7

Teorema 1.7.1 – Il determinante det[Aij ] e la traccia Aii (cioè la somma degli elementi della diagonale principale) della matrice delle componenti di un endomorfismo non

dipendono dalla scelta della base.

Dimostrazione. Siano (ei ) e (ei0 ) due basi di E. Sussistono i legami8

0

ei = Eii ei0

ei0 = Eii0 ei

⇐⇒

(1.36)

0

dove (Eii ) e (Eii0 ) sono matrici regolari una inversa dell’altra, cioè tali che

0

Eii Eij0 = δij ,

0

Eii0 Eij = δij0 .

0

(1.37)

0

Siano (Aji ) e (Aji0 ) le matrici delle componenti di un endomorfismo A rispetto alle due

basi date. Secondo la definizione (1.29) abbiamo

j

A(ei ) = Ai ej ,

j0

A(ei0 ) = Ai0 ej 0 .

Facendo intervenire le relazioni (1.36) si ha successivamente:

0 0

0

0

0

0

Aji ej = A(ei ) = A Eii ei0 = Eii A (ei0 ) = Eii Aji0 ej 0 = Eii Aji0 Ejj0 ej

Si ottiene quindi l’uguaglianza

0

Aji = Eii Aji0 Ejj0

0

(1.38)

che esprime la legge di trasformazione delle componenti di un endomorfismo al

variare della base. La (1.38), essendo presenti a secondo membro le sommatorie sugli

0

j

j0

indici ripetuti i0 e j 0 , mostra che la matrice [Ai ] è il prodotto delle tre matrici [Eii ], [Ai0 ]

e [Ejj0 ]. Siccome il determinante del prodotto di matrici è uguale ai prodotti dei rispettivi

determinanti, risulta

0

0

det[Aji ] = det[Eii ] det[Aji0 ] det[Ejj0 ]

Ma

det[Eii ] det[Ejj0 ] = 1

0

7

8

Presto ne definiremo altri.

0

Se (εi ) e (εi ) sono le corrispondenti basi duali, allora sussistono i legami

0

0

εi = Eii εi

⇐⇒

0

εi = Eii0 εi

16

Capitolo 1. Spazi vettoriali puri

perché le due matrici coinvolte sono l’una inversa dell’altra. Segue

0

det[Aji ] = det[Aji0 ]

e la prima tesi del teorema è dimostrata. Ritorno ora alla (1.38) e vi pongo j = i

sottintendendo al solito la somma sull’indice ripetuto i:

0

Aii = Eii Aji0 Eji0 .

0

A primo membro ho la traccia della matrice [Aji ]. A secondo membro tengo ancora conto

della sommatoria su i e osservo che

0

0

Eii Eji0 = δji 0

essendo le due matrici coinvolte una inversa dell’altra. Ottengo dunque, per la proprietà

di δ,

0

j0 0

Aii = Ai0 δji 0 = Aii0 .

Anche la seconda parte della tesi è dimostrata. 2

Dopo questo teorema è lecito introdurre la seguente definizione:

Definizione 1.7.1 – Il determinante e la traccia di un endomorfismo A ∈ End(E)

sono i numeri

det A = det[Aij ],

trA = Aii ,

dove [Aij ] è la matrice delle componenti di A rispetto ad una qualunque base di E. •

Osservazione 1.7.1 – Si dimostra che per la traccia ed il determinante di un endomorfismo valgono le seguenti proprietà:

tr(A + B) = tr(A) + tr(B),

tr(a A) = a tr(A),

tr(AB) = tr(BA),

tr(1) = n,

(1.39)

det(AB) = det(A) det(B),

det(a A) = an det(A),

det(1) = 1. •

1.8

Polinomio caratteristico di un endomorfismo

Introduciamo ora un altro concetto fondamentale nella teoria degli endomorfismi lineari,

che come prima cosa ci consentirà di definire ulteriori invarianti.

17

1.8. Polinomio caratteristico di un endomorfismo

Definizione 1.8.1 – Dicesi polinomio caratteristico di un endomorfismo A ∈ End(E)

il polinomio di grado n = dim(E) nell’indeterminata x definito da:

P (A, x) = (−1)n det(A − x 1).

•

(1.40)

Essendo definito da un determinante, il polinomio caratteristico è un invariante, non

dipende cioè dalla scelta della base. Si ha pertanto, comunque si scelga la base

P (A, x) = (−1)n det(Aij − x δji )

n

= (−1) det

A11 − x

A12

A21

...

An1

A22 − x . . .

An2

..

.

..

.

A1n

A2n

..

.

..

.

. . . Ann − x

(1.41)

Il segnante (−1)n che interviene in questa definizione ha il compito di rendere uguale

a 1 il coefficiente di xn . Infatti, guardando il determinante nella formula precedente si

vede che la potenza massima (n-esima) di x viene fuori dall prodotto degli elementi della

diagonale principale, e risulta essere (−x)n cioè (−1)n xn . Moltiplicando quindi il suddetto

determinante per (−1)n , come indicato nella (1.41), il coefficiente di xn si riduce a 1, come

asserito.

Ciò detto, è conveniente scrivere per esteso il polinomio caratteristico nella forma seguente:

P (A, x) =

Pn

k=0 (−1)

k I (A) xn−k

k

(1.42)

= xn − I1 (A) xn−1 + I2 (A) xn−2 − . . . + (−1)n In (A).

Siccome questo polinomio è invariante, sono invarianti tutti i suoi n coefficienti Ik (A)

(k = 1, . . ., n). Essi prendono il nome di invarianti principali di A.

Osservo subito che per x = 0 dalla (1.41) ottengo P (A, 0) = (−1)n det A, e dalla (1.42)

P (A, 0) = (−1)n In (A). Quindi, sempre grazie all presenza del segnate, trovo che

In (A) = det A

(1.43)

cioè che l’n-esimo invariante principale di A è proprio uguale al determinante di A.

Per quel riguarda gli altri invarianti, sviluppando il determinante nella (1.41) si arriva

a dimostrare il teorema seguente:

Teorema 1.8.1 – L’invariante principale Ik (A) è dato dalla somma dei minori principali

di ordine k della matrice [Aij ].

18

Capitolo 1. Spazi vettoriali puri

Ricordiamo che un minore principale è il determinante di una sottomatrice quadrata principale e che una sottomatrice quadrata si dice principale se la sua diagonale

principale è formata da elementi della diagonale principale della matrice che la contiene.

Applicando questo teorema per k = n si ritrova In (A) = det A, mentre per k = 1 si trova

I1 (A) = trA

(1.44)

Dunque tra gli invarianti principali ritroviamo non solo il determinante ma anche la traccia.

1.9

Autovalori e autovettori di un endomorfismo

Un sottospazio S ⊂ E si dice invariante rispetto ad un endomorfismo A se A(S) ⊂ S.

Un vettore v ∈ E non nullo si dice autovettore di A se esiste un numero reale λ tale da

aversi

A(v) = λ v.

(1.45)

Un autovettore genera un sottospazio di autovettori (se si include lo zero), di dimensione

1 e invariante, che prende il nome di autodirezione.

L’equazione (1.45) può anche scriversi

(A − λ 1)(v) = 0.

(1.46)

Scelta comunque una base di E, la (1.46) si traduce in un sistema di n equazioni lineari

omogenee nelle incognite (v i), componenti dell’autovettore v:

(Aji − λ δij ) v i = 0.

(1.47)

Tale sistema ammette soluzioni non banali se e solo se λ annulla il determinante della

matrice dei coefficienti, cioè, vista la definizione (1.40), se e solo se λ è radice del polinomio

caratteristico di A. Le radici del polinomio caratteristico, cioè le soluzioni dell’equazione

caratteristica, algebrica di grado n,

P (A, x) = 0,

prendono il nome di autovalori di A. Il loro insieme {λ1 , λ2, . . . , λn} prende il nome di

spettro di A.

Gli autovalori sono invarianti, nel senso sopra detto. Vista la forma (1.41) con cui si scrive

il polinomio caratteristico, dai noti teoremi sulle radici delle equazioni algebriche segue

che l’invariante principale Ik (A) è la somma di tutti i possibili prodotti di k autovalori.

Risulta in particolare:

I1 (A) = tr A = λ1 + λ2 + . . . + λn ,

(1.48)

In (A) = det A = λ1 λ2 . . . λn .

19

1.9. Autovalori e autovettori di un endomorfismo

Chiamiamo molteplicità algebrica di un autovalore λ, e la denotiamo con ma(λ), la sua

molteplicità come radice del polinomio caratteristico.

Gli autovalori possono essere reali o complessi.

Consideriamo il caso reale.

Ad ogni autovalore reale λ corrisponde un sottospazio Kλ ⊂ E di autovettori ad esso

associati, soluzioni cioè dell’equazione (1.45). Chiamiamo molteplicità geometrica di

λ la dimensione del sottospazio invariante associato Kλ , e la denotiamo con mg(λ). Si

dimostra (la dimostrazione è in appendice al paragrafo) che è sempre

ma(λ) ≥ mg(λ)

(1.49)

Tuttavia, per alcuni tipi di endomorfismi vale sempre l’uguaglianza, per esempio per gli

endomorfismi simmetrici in spazi strettamente euclidei, che esamineremo più avanti. Osserviamo che sottospazi invarianti Kλ1 e Kλ2 corrispondenti ad autovalori distinti hanno

intersezione nulla:

λ1 6= λ2

=⇒

Kλ1 ∩ Kλ2 = 0

(1.50)

***

Dimostrazione della disuguaglianza (1.49). Sia λ un autovalore reale di un endomorfismo

A. L’equazione caratteristica di A può ovviamente anche scriversi

h

i

det (A − λ1) − (x − λ) 1 = 0,

cioè

(x − λ)n − I1 (A − λ1)(x − λ)n−1 + . . . + (−1)n In (A − λ1) = 0, ¶[†

facendo intervenire gli invarianti principali dell’endomorfismo A − λ1. Osserviamo ora che

lo spazio invariante Kλ degli autovettori associati a λ è il nucleo di questo endomorfismo,

e quindi

mg(λ) = n − rank(A − λ 1) = n − r.

Il rango r dell’endomorfismo (A − λ 1) coincide con il rango della matrice (Aji − λ δij ),

comunque si scelga la base. Segue che gli invarianti

In (A − λ 1), . . . , Ir+1 (A − λ 1),

sono tutti nulli perché somma di minori principali di ordine maggiore di r della matrice

[Aji − λ δij ]. Pertanto l’equazione caratteristica † si riduce in effetti all’equazione

(x − λ)n − I1 (A − λ 1)(x − λ)n−1 + . . . + (−1)r Ir (A − λ 1)(x − λ)n−r = 0.

Di qui si vede che λ è una radice di ordine n − r almeno, perché, pur essendo per ipotesi i

minori di ordine r non tutti nulli, non si può escludere che la somma di quelli principali,

20

Capitolo 1. Spazi vettoriali puri

vale a dire l’invariante Ir (A − λ1), non si annulli. Dunque: ma(λ) ≥ n − r. Questa dimostrazione vale anche nel caso in cui λ è complesso, perché anche in questo caso

mg(λ) = n − r dove r è il rango della matrice (Aji − λ δij ). 2

***

Se λ è un autovalore complesso allora gli autovettori associati sono complessi: il sistema

(1.46) fornisce soluzioni complesse v i = ui + i w i.

Si è cosı̀ condotti a considerare la complessificazione dello spazio E, cioè lo spazio C(E)

delle combinazioni v = u + i w, con u, w ∈ E, per le quali si definiscono le due operazioni

di somma e di prodotto per un numero complesso in maniera formalmente analoga a quella

della somma e del prodotto di numeri complessi.

Poiché l’equazione caratteristica ha coefficienti reali, ad ogni autovalore complesso λ =

a + ib corrisponde un autovalore coniugato λ̄ = a − ib avente la stessa molteplicità. Si

osserva inoltre che se v = u + i w è autovettore associato a λ, allora il vettore coniugato

v̄ = u − i w è autovettore associato a λ̄, e che ogni altro vettore complesso ottenuto

moltiplicando v per un numero complesso qualunque è ancora autovettore associato a λ.

Osservazione 1.9.1 – Se v = u + i w è un autovettore associato ad un autovalore strettamente complesso λ = a + ib (cioè tale che b 6= 0), allora i vettori reali componenti (u, w)

sono indipendenti. In caso contrario infatti, da una relazione del tipo u = cw seguirebbe

v = (c + i)w e quindi dalla (1.45), dividendo per c + i, A(w) = λ w con λ solo elemento complesso: assurdo. Decomposta allora la (1.45) nella sua parte reale e immaginaria,

risulta

A(u) = au − bw,

A(w) = aw + bu.

(1.51)

Di qui si osserva che il sottospazio generato dai vettori indipendenti (u, w) è invariante

in A. Sia Π questo sottospazio (bidimensionale) e si Π0 il sottospazio invariante corrispondente ad un secondo vettore complesso v0 = u0 + iw0 sempre associato a λ. Non può

che essere Π = Π0 oppure Π ∩ Π0 = 0. Infatti, se un vettore non nullo x appartenesse

all’intersezione, con opportuna moltiplicazione degli autovettori per un numero complesso,

ci si può ricondurre al caso in cui u = u0 = x. Dalla prima delle (1.51) seguirebbe

A(x) = ax − bw,

A(x) = aw + bx,

da cui b(w − w 0 ) = 0, quindi w = w0 . Ciò significa che v = v0 e quindi che Π = Π0 .

Da queste proprietà si deduce che ogni autovalore complesso λ individua un sottospazio

invariante Kλ che è somma diretta di sottospazi invarianti bidimensionali. La sua dimensione è quindi pari e inoltre Kλ = Kλ̄ . In questo caso per molteplicità geometrica di λ

s’intende la metà della dimensione di Kλ . Vale ancora la disuguaglianza (??), mentre la

(1.50) va sostituita dalla più generale

λ1 6= λ2 , λ1 6= λ̄2

=⇒

Kλ1 ∩ Kλ2 = 0

•

(1.52)

21

1.10. Il teorema di Hamilton-Cayley

1.10

Il teorema di Hamilton-Cayley

Dato un endomorfismo A, se ne possono considerare le potenze:

A0 = 1,

A1 = A,

A2 = A A,

...

Ak = A

. . . A},

| A{z

...

k volte

Quindi ad ogni polinomio di grado k

Pk (x) = a0 xk + a1 xk−1 + . . . + ak

si può associare l’endomorfismo

Pk (A) = a0 Ak + a1 Ak−1 + . . . + ak 1.

Un polinomio Pk (x) si dice annichilante di A se Pk (A) si annulla identicamente.

Sussiste a questo proposito il notevole teorema di Hamilton-Cayley (William Rowan

Hamilton, 1805-1865; Arthur Cayley, 1821-1895):

Teorema 1.10.1 – Il polinomio caratteristico di un endomorfismo è annichilante:

An − I1 (A) An−1 + I2 (A) An−2 − . . . + (−1)n In (A) 1 = 0.

Una prima importante conseguenza di questo teorema è che la potenza n-sima di un

endomorfismo risulta essere una combinazione lineare delle precedenti, inclusa A0 = 1.

Cosı̀ dicasi delle potenze An+1 e successive. Pertanto: tutte le potenze di un endomorfismo

A formano un sottospazio di End(E) al più di dimensione n, generato dall’identità 1 e

dalle prime n − 1 potenze di A.9

***

Dimostrazione del teorema di Hamilton-Cayley. Basiamo la dimostrazione sull’osservazione seguente. Se sussite un’uguaglianza del tipo

C(x) (A − x 1) = Pk (x) 1

(1.53)

dove Pk (x) è un polinomio di grado k e dove C(x) è un polinomio di grado k − 1 in x a

coefficienti in End(E), cioè del tipo

C(x) = xk−1 C 1 + xk−2 C 2 + . . . + x C k−1 + C k ,

allora Pk (A) = 0 cioè Pk (x) è annichilante di A. Infatti, esplicitata questa uguaglianza

xk−1 C 1 + xn−2 C 2 + . . . + x C n−1 + C n A − x 1

9

= a0 xk + a1 xk−1 + . . . + ak 1

Al più, perché non è escluso che l’identità 1 e le prime n − 1 potenze di A siano linearmente dipendenti.

22

Capitolo 1. Spazi vettoriali puri

ed uguagliati i coefficienti delle varie potenze di x, si trova che

− C 1 = a0 1,

C A − C 2 = a2 1,

1

···

C k−1 A − C k = ak−1 1,

C k A = ak 1.

Moltiplicando a destra rispettivamente per Ak , Ak−1 , . . . , A le prime k di queste uguaglianze, e sommando poi membro a membro si trova 0 = Pk (A), come asserito. Ciò posto,

si tiene conto del fatto, dimostrato più avanti (§ 1.19), che per ogni endomorfismo B esiste

e l’endomorfismo complementare, per cui

sempre un endomorfismo B,

e B = det(B) 1.

B

Se ora si prende l’endomorfismo B = A − x 1, con indeterminata x, per la definizione di

polinomio caratteristico l’uguaglianza precedente diventa

e (A − x 1) = P (A, x) 1.

(−1)n B

e perché l’endomorfismo

Questa è del tipo (1.53), con k = n e C(x) = (−1)n B,

e

complementare B ha come componenti dei determinanti di ordine n − 1 della matrice

[Bji ] = [Aij − x δji ], ed è quindi un polinomio di grado n − 1 in x. Pertanto P (A, A) = 0. 2

1.11

Tensori

La nozione di “tensore” ha avuto origine dalla teoria dell’elasticità. Si è successivamente

sviluppata nell’ambito dell’algebra lineare e della geometria differenziale, trovando notevoli

applicazioni in vari rami della fisica-matematica.

Per arrivare a comprendere questa nozione partiamo da questa osservazione: abbiamo già

esaminato la nozione di forma bilineare e di endomorfismo su di uno spazio vettoriale E.

Assegnata una base di E le componenti di una forma bilineare e di un endomomorfismo

formano due matrici quadrate n × n, dove n = dim E:

[ϕij ]

e [Aji ].

Quindi l’analisi e l’applicazione di queste due nozioni deve ricorrere al calcolo delle matrici

(quadrate). Questo è una circostanza che le accomuna, pur essendo due nozioni ben distinte. Ma, come vedremo, un altro fatto le accomuna: le forme bilineari e gli endomorfismi

possono essere visti come “tensori”.

Una generale definizione di tensore è la seguente:

23

1.11. Tensori

Definizione 1.11.1 – Un tensore di tipo (p, q) sopra uno spazio vettoriale E è un’applicazione multilineare del prodotto

(E ∗)p × E q = |E ∗ × E ∗ {z

× . . . × E}∗ × |E × E ×

{z. . . × E}

p volte

q volte

in R. Un tensore di tipo (0, 0) è per definizione un numero reale. Denotiamo con Tqp(E)

lo spazio tensoriale di tipo (p, q) su E, cioè lo spazio

Tqp (E) = L(E ∗ , E ∗, . . . , E ∗, E, E, . . ., E ; R),

|

{z

} |

{z

}

p volte

q volte

ponendo inoltre, per (p, q) = (0, 0),

T00 (E) = R.

•

p

Vediamo che cosa è lo spazio Tq (E) per i primi valori della coppia di interi (p, q) non

entambi nulli. Innanzitutto:

T01 (E) = L(E ∗; R) = E ∗∗ = E,

T10 (E) = L(E; R) = E ∗ ,

T20 (E) = L(E, E; R) (forme bilineari su E),

(1.54)

T02 (E) = L(E ∗, E ∗; R) (forme bilineari su E ∗ ).

Poi:

T11 (E) = L(E ∗, E; R) = End(E)

(1.55)

Quest’ultima uguaglianza segue dall’esistenza di un isomorfismo canonico tra lo spazio

L(E ∗ , E; R) e lo spazio degli endomorfismi su E, definito dall’uguaglianza

A(α, v) = hA(v), αi,

∀α ∈ E ∗, v ∈ E.

(1.56)

A sinistra A è interpretato come elemento di L(E ∗, E; R), a destra come endomorfismo

lineare. In componenti abbiamo:

A(α, v) = Aji αj v i .

Definizione 1.11.2 – Sia (ei ) una base di E e (εi ) la sua duale in E ∗ . Diciamo

componenti di un tensore K ∈ Tqp (E) secondo la base (ei ) gli np+q numeri

i ...i

Kj11...jpq = K(εi1 , . . . , εip , ej1 , . . . ejq )

•

(1.57)

24

Capitolo 1. Spazi vettoriali puri

Per esempio, le componenti di untensore K ∈ T21 (E) sono gli n3 numeri10

i

Kjh

= K(εi , ej , eh ).

(1.58)

Si osservi la corrispondenza nella posizione degli indici a primo e a secondo membro di

queste uguaglianze.

Le componenti servono, innanzitutto, a calcolare il valore del tensore sui vettori e covettori.

Prendendo ad esempio il caso precedente, risulta:

i

K(α, u, v) = Kjh

αi uj v h .

(1.59)

Inoltre, al variare della base secondo le formule (1.36) e in analogia alla (1.38), le componenti di un tensore di tipo (1,2) variano secondo la legge

i

Kji0 h0 = Eii Ejj0 Ehh0 Kjh

.

0

0

(1.60)

Questa formula si deduce direttamente dalla definizione (1.58) scritta per la base “accentata”, tenendo conto quindi delle relazioni fra le basi, ed è facilmente estendibile al caso di

un tensore di tipo qualunque, tenendo conto del formalismo degli indici ripetuti in alto e in

basso. A questo proposito osserviamo che per passare dalla base (ei ) alla base “accentata”

(ei0 ) viene usata la matrice (Eii0 ), con l’accento in basso. Gli indici in basso non accentati

delle componenti vengono trasformati in indici accentati (sempre in basso) con la stessa

matrice. Per questo gli indici in basso delle componenti vengono detti indici covarianti.

Quelli in alto, invece, vengono detti indici contravarianti, perché nel trasformarsi fanno

intervenire la matrice inversa. Pertanto, un tensore di tipo (p, q) viene anche detto tensore

a p indici di contravarianza e q indici di covarianza. Un tensore di tipo (p, 0) viene detto tensore contravariante di ordine p, un tensore di tipo (0, q) tensore covariante

di ordine q. Denoteremo gli spazi tensoriali T0p (E) e Tq0 (E) semplicemente con T p (E) e

Tq (E).

1.12

Somma tensoriale

Sui tensori possono definirsi varie operazioni che nel loro insieme costituiscono il cosiddetto

calcolo tensoriale.

Innanzitutto vediamo la somma di due tensori. Essa può eseguirsi, a prima vista, solo fra tensori dello stesso tipo. Tuttavia in molte circostanze, come questa, torna utile

considerare la somma diretta di tutti gli spazi tensoriali, di tutti i tipi, ordinati come

segue:

T (E) = T00 (E) ⊕ T01 (E) ⊕ T10 (E) ⊕ T02 (E) ⊕ T11 (E) ⊕ T20 (E) ⊕ T03 (E) ⊕ . . .

= R ⊕ E ⊕ E ∗ ⊕ T02 (E) ⊕ T11 (E) ⊕ T20 (E) ⊕ T03 (E) ⊕ . . .

10

(1.61)

Se si vuole, si può dire che le componenti di un tensore di questo tipo formano una “matrice cubica”

di lato n.

25

1.13. Prodotto tensoriale

Questo è lo spazio tensoriale su E.11 Un tensore K di tipo (p, q) può essere inteso come

elemento di T (E): lo si identifica con la successione costituita da tutti zeri e con K al

posto (p, q). Per esempio, se A ∈ T11 (E), allora si può intendere

A = 0⊕0⊕0⊕0⊕A⊕0⊕···

dove a secondo membro A è al quinto posto nella successione (1.61). Un siffatto elemento

di T (E) viene detto omogeneo. Pertanto ogni spazio tensoriale di tipo (p, q) può essere

inteso come sottospazio di T (E).

Su T (E) si introduce l’operazione di somma diretta ⊕, definita sommando le singole

componenti omogenee.

1.13

Prodotto tensoriale

Dati due tensori, di tipo qualsiasi, K ∈ Tqp(E) e L ∈ Tsr (E), il loro prodotto tensoriale12

K ⊗L

p+r

è per definizione un tensore di tipo (p + r, q + s): K ⊗ L ∈ Tq+s

. Dunque, secondo la

definizione generale di tensore, è innanzitutto un’applicazione multilineare

∗

∗

K ⊗ L: E

× . . . × E }∗ × |E × E ×

| × E {z

{z. . . × E} → R.

p+r volte

q+r volte

Quando K ⊗ L viene applicato ad una successione di p + r covettori

α1 , α2 , . . ., αp , β1 , β2 , . . . , βr ,

(1.62)

a1 , a2 , . . . , aq , b1 , b2 , . . . , bs ,

(1.63)

e di q + s vettori,

il primo fattore K si prende i primi p covettori ed i primi q vettori e fornisce il numero

K(α1 , α2 , . . ., αp ; a1 , a2 , . . . , aq ).

Il secondo fattore L prende quel che resta e fornisce il numero

L(β1 , β2 , . . . , βr ; b1 , b2 , . . . , bs ).

Allora, il valore di K ⊗ L sulle due successioni (1.62) e (1.63) è per definizione il prodotto

di questi due numeri.

Per esempio, se K ∈ T21 (E) e L ∈ T11 (E), K ⊗ L è il tensore di tipo (2, 3) tale che

(K ⊗ L)(α, β, u, v, w) = K(α, u, v) · L(β, w),

per ogni α, β ∈ E ∗ , u, v, w ∈ E.

11

12

è uno spazio vettoriale di dimensione infinita.

Si legge K tensore L.

(1.64)

26

Capitolo 1. Spazi vettoriali puri

Osservazione 1.13.1 – Il prodotto tensoriale non è commutativo: K ⊗ L è in generale

diverso da L ⊗ K. Due tensori possono commutare in casi speciali, per esempio se K è

un tensore covariante e L un tensore contravariante. •

Osservazione 1.13.2 – Il prodotto tensoriale di due tensori si estende per linearità agli

elementi non omogenei della somma diretta T (E). Il prodotto tensoriale è associativo:

K ⊗ (L ⊗ M ) = (K ⊗ L) ⊗ M .

Se uno dei due tensori è di tipo (0, 0), cioè un numero reale, il prodotto tensoriale è

l’ordinario prodotto per uno scalare a ∈ R:

a ⊗ K = K ⊗ a = a K.

(1.65)

Con le due operazioni di somma ⊕ e prodotto ⊗ lo spazio T (E) assume la struttura di

algebra associativa: è l’algebra tensoriale su E. •

Osservazione 1.13.3 – La comprensione del concetto di prodotto tensoriale è facilitata

dal fatto che, come si riconosce facilmente, le componenti del prodotto tensoriale K ⊗ L

sono il prodotto delle componenti di K e L rispettivamente. Per esempio, se K ∈ T21 (E)

e L ∈ T11 (E), allora

j

i

(K ⊗ L)ij

(1.66)

hkl = Khk Ll . •

Vediamo ora alcuni casi particolari ma fondamentali di prodotto tensoriale.

1 Prodotto tensoriale a ⊗ b di due vettori a, b ∈ E. È l’applicazione bilineare

a ⊗ b: E ∗ × E ∗ → R

definita da

(a ⊗ b) (α, β) = ha, αi hb, βi.

(1.67)

2 Prodotto tensoriale α ⊗ β di due covettori α, β ∈ E ∗ è l’applicazione bilineare

α ⊗ β: E × E → R

definita da

(α ⊗ β) (a, b) = ha, αi hb, βi.

(1.68)

3 Prodotto tensoriale a ⊗ α di un vettore per un covettore: è l’applicazione

bilineare

a ⊗ α : E∗ × E → R

tale che

(a ⊗ α) (β, b) = ha, βi hb, αi.

In questo caso il prodotto è commutativo: a ⊗ α = α ⊗ a.

(1.69)

27

1.14. Basi tensoriali

1.14

Basi tensoriali

L’assegnazione di una base (ei ) dello spazio vettoriale E genera automaticamente una base

per ogni spazio tensoriale Tqp (E). Sia εi ) la base duale su E ∗ . Partiamo, come al solito,

dai casi più semplici.

1 I prodotti ei ⊗ ej formano una base di T20 (E), cioè delle forme bilineari su E ∗ , sicché

per ogni forma bilineare

K : E∗ × E∗ → R

(1.70)

vale la rappresentazione13

K = K ij ei ⊗ ej

(1.71)

K ij = K(εi , εj )

(1.72)

con le componenti K ij definite da

Infatti per ogni coppia di covettori α, β ∈ E ∗ per la (1.70) e per la definizione di prodotto

tensoriale si ha

K(α, β) = K ij ei ⊗ ej (α, β) = K ij αi βj .

D’altra parte, per la (1.71) e per la bilinearità risulta

K ij αi βj = K(εi , εj ) αi βj = K(αi εi , βj εj ) = K(α, β),

ed il ciclo si chiude.

2 I prodotti εi ⊗ εj formano una base di T02 (E), cioè delle forme bilineari su E

K : E × E → R,

(1.73)

e valgono contemporaneamente le formule, analoghe alle (1.71) e (1.72),

K = Kij εi ⊗ εj

(1.74)

Kij = K(ei , ej )

(1.75)

3 I prodotti tensoriali ei ⊗ εj formano una base dello spazio tensoriale

T11 (E) = L(E ∗, E; R) = End(E)

degli endomorfismi lineari su E. Per ogni endomorfismo K valgono le formule

K = Kij ej ⊗ εi

13

Si sottintende sempre la somma sugli indici ripetuti in alto e in basso.

(1.76)

28

Capitolo 1. Spazi vettoriali puri

con le componendi Aji definite come nella formula (1.31):

Kij = hK(ei ), εj i

(1.77)

Da questi esempi traiamo la regola generale: i prodotti tensoriali

ei1 ⊗ ei2 ⊗ . . . ⊗ eip ⊗ εj1 ⊗ εj2 ⊗ . . . ⊗ εjq

(1.78)

costituiscono una base di Tqp(E) e per ogni K ∈ Tqp (E) vale la rappresentazione

i i ...i

K = Kj11j22 ...jpq ei1 ⊗ ei2 ⊗ . . . ⊗ eip ⊗ εj1 ⊗ εj2 ⊗ . . . ⊗ εjq

(1.79)

i i ...i

dove le componenti Kj11j22 ...jpq sono definite come nella (1.57).

Gli elementi della base (1.78) sono in numero pari alle disposizioni con ripetizione di p + q

oggetti, cioè np+q . Pertanto,

dim(Tqp(E)) = np+q .

(1.80)

1.15

Contrazione o saturazione di due indici

Vi è una terza operazione importante eseguibile su di un tensore. Dato un tensore K di

tipo qualsiasi (p, q), purché con p e q non entrambi nulli, di componenti

i i ...i

p

Kj11,j22 ,...,j

q

si può prendere uno degli indici contravarianti (in alto) e porlo uguale ad uno degli indici

covarianti (in basso) ed intendere di eseguire la sommatoria su questi, secondo la convenzione degli indici ripetuti. Si dimostra che, cosı̀ facendo, si ottiene un tensore di tipo

(p − 1, q − 1).14 Una tale operazione prende il nome di contrazione o saturazione.

i , ho due possibilità di saturazione:

Per esempio, se K ∈ T21 (E) ha componenti Khj

i

Uj = Kij

,

i

Vh = Khi

.

In entrambi i casi si ottiene un covettore. Questi però sono in generale diversi. Altri due

esempi:

1. Se A ∈ T11 (E) = End(E), con componenti Aij , allora la saturazione dei suoi due indici

fornisce la traccia dell’endomorfismo A: Aii = tr(A).

2. Il vettore u = A(v), immagine del vettore v secondo un endomorfismo A, può essere

anche interpretato come contrazione del prodotto tensoriale A ⊗ v, perché quest’ultimo

j

j

ha componenti Ai v k e le componenti di u sono uj = Ai v i.

14

La dimostrazione si basa sull’equazione di trasformazione delle componenti di un tensore al variare

della base.

29

1.16. Tensori antisimmetrici

1.16

Tensori antisimmetrici

Definizione 1.16.1 – Un tensore A ∈ Tp0 (E) si dice antisimmetrico se per ogni scambio di due suoi qualunque argomenti il suo valore cambia di segno:

A(. . . , u, . . . , v, . . .) = − A(. . . , v, . . . , u, . . .).

Cosı̀ dicasi per un tensore A ∈ T0p (E). I vettori, i covettori e gli scalari, che sono di

tipo (0, 1), (1, 0) e (0, 0) rispettivamente, sono per definizione antisimmetrici. L’intero p

prende il nome di grado del tensore antisimmetrico. •

I tensori antisimmetrici svolgono un ruolo importante nelle applicazioni del calcolo tensoriale. Si dimostra che i tensori antisimmetrici contenuti in Tp0 (E) (rispettivamente, in

T0p (E)) ne formano un sottospazio che denotiamo con Φp(E) (rispettivamente, con V p (E)).

Il teorema seguente fornisce una definizione equivalente di antisimmetria:

Teorema 1.16.1 – Un tensore A ∈ Tp0 (E) è antisimmetrico se e solo se esso si annulla

quando due dei suoi argomenti coincidono. Lo stesso dicasi per A ∈ T0p (E).

Dimostrazione. È sufficiente dimostrare questo teorema nel caso p = 2. Da A(u, v) =

− A(v, u) segue ovviamente A(u, u) = 0. Viceversa se A(v, v) = 0 per ogni v, allora si

ha, ponendo v = v 1 + v2 ,

0 = A(v1 + v2 , v1 + v 2 )

= A(v1 , v1 ) + A(v1 , v2 ) + A(v2 , v1 ) + A(v2 , v2 )

= A(v1 , v2 ) + A(v2 , v1 ),

vale a dire

A(v1 , v2 ) = − A(v2 , v1 ). 2

Due implicazioni notevoli:

Teorema 1.16.2 – 1. Un tensore antisimmetrico si annulla quando i suoi argomenti

sono linearmente dipendenti. 2. Un tensore antisimmetrico con p > n è nullo.

Dimostrazione. 1. Se A ∈ Φp(E) e se uno dei suoi argomenti (v1 , v2 , . . . , vp ), per

esempio v1 è combinazione lineare dei rimanenti, allora A(v1 , v2 , . . . , vp) si decompone

nella combinazione lineare di numeri del tipo A(v∗ , v2 , . . . , vp ) dove v∗ è via via uguale

a v 2 , . . ., v p , i quali numeri, per via del Teorema 1.16.1, sono tutti nulli. 2. Se p > n i

vettori (v1 , v2 , . . . , vp) sono sempre dipendenti. 2

Osservazione 1.16.1 – Di conseguenza, gli spazi V p (E) e Φp (E) per p > n si riducono

ad un solo elemento: lo zero. •

30

Capitolo 1. Spazi vettoriali puri

Esempio 1.16.1 – Sia E lo spazio vettoriale euclideo tridimensionale. Ponendo

η(u, v, w) = u · v × w

(prodotto misto).

si definisce un tensore covariante antisimmetrico η di ordine 3 detto forma volume.15 •

Esempio 1.16.2 – Sia E = Rn : un vettore è una n-pla di numeri reali v = (v 1 , v 2, . . . , v n).

Una n-pla di vettori (vi ) = (vi1 , vi2, . . . , vin) dà luogo ad una matrice quadrata [vij ]n×n .

Ponendo

A(v1 , v2 , . . . , vn ) = det[vij ]

si definisce un tensore covariante antisimmetrico di ordine n sopra Rn . •

Dal Teorema 1.16.1 si può dedurre un’ulteriore caratterizzazione (o definizione equivalente)

di antisimmetria.

Per ogni intero p > 1 denotiamo con Gp il gruppo delle permutazioni di

p elementi, detto gruppo simmetrico di ordine p. Denotiamo con εσ il

segno di una permutazione σ ∈ Gp: uguale a +1 o −1 a seconda che σ

sia pari o dispari, vale a dire composta da un numero pari o dispari di

scambi. Ricordiamo che Gp è costituito da p! elementi.

Teorema 1.16.3 – Un tensore covariante A ∈ Tp0 (E) è antisimmetrico se e solo vale

l’uguaglianza

A(v1 , . . . , vp ) = εσ A σ(v1 , . . . , vp ) ,

∀ v 1 , . . . , vp ∈ E,

(1.81)

ovvero

A = εσ A ◦ σ,

(1.82)

per ogni σ ∈ Gp . Analogamente per un tensore contravariante A ∈

1.17

T0p(E).

Antisimmetrizzazione

Per studiare meglio i tensori antisimmetrici è opportuno introdurre il concetto di “antismmetrizzazione”.

Definizione 1.17.1 – Per ogni p > 1 si introduce l’applicazione lineare

A : Tp0 (E) → Φp (E) : T 7→ A(T )

chiamata operatore di antisimmetrizzazione e definita da

A(T ) =

15

Vedi § 2.4.1.

1 P

σ∈Gp εσ T

p!

◦

σ

(1.83)

31

1.18. Prodotto esterno

cioè da

A(T )(v1 , . . . , vp) =

per ogni v 1 , . . . , vp ∈ E. •

1 P

σ∈Gp εσ T σ(v1 , . . . , v p )

p!

(1.84)

Per rendere effettiva questa definizione dobbiamo verificare che il tensore T A è antisimmetrico. Volendo applicare il Teorema 1.16.3, osserviamo che per qualunque τ ∈ Gp si ha

successivamente:

ετ A(T ) ◦ τ

1 P

σ∈Gp ετ εσ T ◦ σ ◦ τ

p!

1 P

=

σ∈Gp εσ·τ T ◦ σ ◦ τ

p!

1 P

=

σ·τ ∈Gp εσ·τ T ◦ (σ ◦ τ ) = A(T ),

p!

=

tenuto conto che εσ·τ = ετ εσ e inoltre che, mentre σ varia in tutto Gp , anche σ ◦ τ varia

in tutto Gp.

Tutto quanto precede si riferisce a tensori covarianti (indici in basso) ma si può ripetere

per i tensori contravarianti (indici in alto), per i quali l’operatore di antisimmetrizzazione

è l’applicazione lineare

A : T0p (E) → V p (E) : T 7→ A(T )

definita come nella (1.83).

1.18

Prodotto esterno

Definizione 1.18.1 – Il prodotto esterno di due covettori α e β, denotato con α∧β,

è il tensore antisimmetrico covariante di grado 2 definito da

α∧β =

ovvero da

(α ∧ β) (v1 , v2 ) =

1

2

1

2

(α ⊗ β − β ⊗ α)

(1.85)

hv1 , αi hv2 , βi − hv1 , βi hv2 , αi

(1.86)

Analogamente, il prodotto esterno di due vettori a e b, denotato con a ∧ b, è il tensore

antisimmetrico contravariante di grado 2 definito da

a∧b=

ovvero da

(a ∧ b) (α1 , α2 ) =

1

2

1

2

(a ⊗ b − b ⊗ a)

ha, α1 i hb, α2 i − ha, α2 i hb, α1 i

(1.87)

•

(1.88)

32

Capitolo 1. Spazi vettoriali puri

Osserviamo che facendo intervenire l’operatore di antisimmetrizzazione si hanno le definizioni equivalenti:

α ∧ β = A(α ⊗ β)

(1.89)

a ∧ b = A(a ⊗ b)

(1.90)

Infatti, se applichiamo la definizione (1.84), osservato che in questo caso p = 2 e che G2 è

costituito da soli due elementi, l’identità e lo scambio, troviamo

P

A(α ⊗ β)(v1 , v2 ) = 12

ε

(α

⊗

β)

σ(v

,

v

)

σ

1

2

σ∈G2

=

1

2

(α ⊗ β) (v1 , v2 ) −

1

2

(α ⊗ β) (v2 , v1 )

=

1

2

(α ⊗ β) (v1 , v2 ) −

1

2

(β ⊗ α) (v1 , v2 )

=

1

2

(α ⊗ β − β ⊗ α) (v1 , v2 ).

Analogamente per il caso a ∧ b.

Le formule (1.89) e (1.90) suggeriscono una naturale estensione del prodotto esterno al

caso di più di due vettori o covettori:

Definizione 1.18.2 – Il prodotto esterno di p covettori α1 , . . . , αp e di p vettori

a1 , . . . , ap è definito dalle formule

α1 ∧ . . . ∧ αp = A(α1 ⊗ . . . ⊗ αp)

(1.91)

a1 ∧ . . . ∧ ap = A(a1 ⊗ . . . ⊗ ap )

(1.92)

ovvero, vista la (1.84), dalle formule

(α1 ∧ . . . ∧ αp ) (v1 , . . . , vp) =

1 P

σ∈Gp εσ (α1 ⊗ . . . ⊗ αp ) σ(v 1 , . . . , vp )

p!

(a1 ∧ . . . ∧ ap ) (α1 , . . . , αp) =

1 P

σ∈Gp εσ (a1 ⊗ . . . ⊗ ap ) σ(α1 , . . . , αp )

p!

•

(1.93)

(1.94)

Per esempio, per p = 3 dalla definizione (1.83) risulta:

α1 ∧ α2 ∧ α3 =

1

6

h

α1 ⊗ α2 ⊗ α3 + α2 ⊗ α3 ⊗ α1 + α3 ⊗ α1 ⊗ α2

i

− α2 ⊗ α1 ⊗ α3 + α1 ⊗ α3 ⊗ α2 + α3 ⊗ α2 ⊗ α1

(1.95)

33

1.19. Algebra esterna

Nella prima riga abbiamo le permutazioni cicliche, quindi pari, dei tre indici (1, 2, 3). Nella

seconda riga, col segno −, abbiamo quelle dispari.

Analogamente per il prodotto esterno di tre vettori.

Osservazione 1.18.1 – Il prodotto esterno di p covettori (o vettori) cambia di segno

quando si scambiano fra loro due elementi. Per esempio:

α2 ∧ α1 ∧ α3 = − α1 ∧ α2 ∧ α3 ,

α3 ∧ α2 ∧ α1 = − α1 ∧ α2 ∧ α3 . •

1.19

Algebra esterna

Il prodotto esterno che abbiamo definito nel paragrafo precedente è alla

base di un tipo di calcolo che trova svariate utili applicazioni: l’algebra

esterna.

Questo calcolo si basa sulle seguenti circostanze.

1 Per ogni intero p > 0 i prodotti esterni

α1 ∧ . . . ∧ αp ,

α∗ ∈ E ∗

(1.96)

a1 ∧ . . . ∧ ap ,

a∗ ∈ E

(1.97)

prendono rispettivamente il nome di p-forme elementari e p-vettori elementari. le

loro combinazioni lineari generano rispettivamente lo spazio Φp (E) delle p-forme e lo

spazio V p (E) dei p-vettori.

2 Date due forme elementari α = α1 ∧ . . . ∧ αp e β = β1 ∧ . . . ∧ β q , di grado p e q

rispettivamente, il loro prodotto esterno α∧β è definito semplicemente dalla frapposizione

del simbolo ∧ fra α e β:

α ∧ β = α1 ∧ . . . ∧ αp ∧ β 1 ∧ . . . ∧ β q .

Il risultato è pertanto una (p + q)-forma elementare. Il prodotto esterno cosı̀ definito è

anticommutativo graduato, nel senso che

α ∧ β = (−1)pq β ∧ α

Osserviamo infatti che nel passare da

α ∧ β = α1 ∧ . . . ∧ αp ∧ β 1 ∧ . . . ∧ βq

(1.98)

34

Capitolo 1. Spazi vettoriali puri

a

β ∧ α = β 1 ∧ . . . ∧ βq ∧ α1 ∧ . . . ∧ αp

si devono eseguire un numero di scambi pari a pq, il che comporta pq cambiamenti di

segno. Nel caso in cui una delle due forme elementari sia di grado 0, sia cioè uno scalare, il

prodotto ∧ si identifica con l’ordinario prodotto di un tensore per un numero. Per esempio,

se p = 0 cioè se α ∈ Φ0 (E) = R, allora

α ∧ β = α β1 ∧ . . . ∧ β q .

3 Il prodotto esterno è bilineare:

(a1 α1 + a2 α2 ) ∧ β = a1 α1 ∧ β + a2 α2 ∧ β

(1.99)

α ∧ (b1 β 1 + b2 β 2 ) = b1 α ∧ β1 + b2 α ∧ β 2

(1.100)

4 Siccome il prodotto esterno fra forme elementari è bilineare e siccome una p-forma,cioè

un elemento di Φp(E) è combinazione lineare di p-forme elementari, il prodotto esterno si

estende per linearità a forme di grado qualsiasi. Vale ancora l’anticommutatività graduata

(1.98). Per questa via il prodotto esterno si estende anche a più di due forme. Vale la

proprietà associativa:

α ∧ β ∧ γ = (α ∧ β) ∧ γ = α ∧ (β ∧ γ)

(1.101)

5 Consideriamo infine la somma diretta di tutti gli spazi Φp (E),

Φ(E) =

+∞

M

Φp (E).

p=0

Sappiamo che per p > n = dim(E) gli spazi Φp (E) si riducono allo zero. Sappiamo inoltre

che Φ0 (E) = R e Φ1 (E) = E ∗. Di conseguenza la somma diretta Φ(E) risulta essere

Φ(E) = R ⊕ E ∗ ⊕ Φ2 (E) ⊕ . . . ⊕ Φn (E) ⊕ 0 ⊕ 0 ⊕ . . .

(1.102)

Questo è uno spazio vettoriale, detto spazio delle forme esterne su E, rispetto all’ordinaria somma + tra tensori. Il prodotto esterno, definito per due forme “omogeneee”, si

estende per linearità a due qualunque elementi di questa somma diretta. Il risultato è che

Φ(E), con le due operazioni + e ∧ diventa un’algebra, detta appunto algebra esterna

su E.

Si dimostra che

e

n

n!

dim Φp(E) =

=

p

p! (n − p)!

(1.103)

dim Φ(E) = 2n .

(1.104)

1.20. Il simbolo di Levi-Civita

Tutto quanto sin qui visto si ripete pari pari per gli spazi

dei p-vettori

V p (E)

35

e si conclude con la costruzione della somma diretta

V (E) = R ⊕ E ⊕ V 2 (E) ⊕ . . . ⊕ V n (E) ⊕ 0 ⊕ 0 ⊕ . . .

che assume anch’essa la struttura di algebra.

1.20

Il simbolo di Levi-Civita

Il simbolo di Levi-Civita (Tullio Levi-Civita, 1873-1941) con n indici variabili da 1

a n,

εi1 i2 ...in

vale +1 o −1 a seconda che la successione degli indici (i1 , i2 , . . . , in) sia una permutazione

pari o dispari della succesione fondamentale (1, 2, . . ., n); vale zero in tutti gli altri casi,

cioè quando almeno due indici coincidono. Il simbolo di Levi-Civita è antisimmetrico:

scambiando fra loro due indici, cambia di segno.

Il simbolo di Levi-Civita, che può comparire anche con gli indici in alto,16

εi1 i2 ...in ,

consente di esprimere in forma sintetica svariate formule di calcolo delle matrici e di calcolo

tensoriale. Vediamo alcuni esempi.

1 L’ordinaria definizione di determinante di una matrice quadrata [Aij ]n×n può porsi nella

forma sintetica

det[Aij ] = εi1 i2 ...in Ai11 Ai22 . . . Ainn

(1.105)

sottintendendo sempre la sommatoria sugli indici ripetuti in alto e in basso. Verifichiamolo

nel caso n = 3:

εhij Ah1 Ai2 Aj3 = ε1ij A11 Ai2 Aj3 + ε2ij A21 Ai2 Aj3 + ε3ij A31 Ai2 Aj3 = . . .

Ho eseguito la somma sul primo indice h; nell’eseguire la somma sull’indice i tengo conto

che con un indice ripetuto il simbolo si annulla, dunque:

. . . = ε12j A11 A22 Aj3 + ε13j A11 A32 Aj3

+ε21j A21 A12 Aj3 + ε23j A21 A32 Aj3

+ε31j A31 A12 Aj3 + ε32j A31 A22 Aj3 = . . .

16

La definizione è la medesima.

36

Capitolo 1. Spazi vettoriali puri

Sommando infine sull’indice j rimangono soltanto sei termini:

. . . = ε123 A11 A22 A33 + ε132 A11 A32 A23

+ε213 A21 A12 A33 + ε231 A21 A32 A13

+ε312 A31 A12 A23 + ε321 A31 A22 A13 = . . .

Adesso traduco i simboli in +1 e −1 a seconda della parità della permutazione degli indici

rispetto alla permutazione fondamentale (1, 2, 3),

. . . = A11 A22 A33 − A11 A32 A23

−A21 A12 A33 + A21 A32 A13

+A31 A12 A23 − A31 A22 A13

e ritrovo lo sviluppo del determinante di ordine 3.

2 Dati n vettori (ei ) di E, n = dim(E), anche non indipendenti, per la proprietà

anticommutativa del prodotto esterno vale l’uguaglianza

ei1 ∧ ei2 ∧ . . . ∧ ein = εi1 i2 ...in e1 ∧ e2 ∧ . . . ∧ en

(1.106)

e1 ∧ e2 ∧ . . . ∧ en = εi1 i2 ...in ei1 ∧ ei2 ∧ . . . ∧ ein

(1.107)

o, inversamente,

qualunque sia la permutazione degli indici (i1 , i2 , . . . , in). Si noti bene che a secondo

membro di quest’ultima formula non è intesa la sommatoria sugli indici, che sono ripetuti

ma entambi in basso. Analoghe formule valgono ovviamente per una qualunque n-pla (εi )

di covettori in E ∗ .

3 Il determinante di un endomorfismo A può essere definito come quel numero det(A)

per cui vale l’uguaglianza

A(v1 ) ∧ A(v 2 ) ∧ . . . ∧ A(vn ) = det(A) v 1 ∧ v2 ∧ . . . ∧ vn

(1.108)

per qualunque n-pla di vettori v i ∈ E. Per riconoscerlo, nella (1.108), al posto dei vettori

v ∗ si sostituiscano i vettori di una base (ei ) qualsiasi di E. Si ottiene

A(e1 ) ∧ A(e2 ) ∧ . . . ∧ A(en ) = Ai11 Ai22 . . . Ainn ei1 ∧ ei2 ∧ . . . ∧ ein

= Ai11 Ai22 . . . Ainn εi1 i2 ...in e1 ∧ e2 ∧ . . . ∧ e3