Università degli Studi di Roma

“Tor Vergata”

Dispense per il corso di

GRAFI E RETI DI FLUSSO

Antonio Iovanella

Ottobre 2006

I

Indirizzo dell’autore:

Antonio Iovanella

Dipartimento di Ingegneria dell’Impresa,

Università di Roma “Tor Vergata”

Via del Politecnico 1, 00133 Roma - Italia

Email: [email protected]

Web Page: http://www.disp.uniroma2.it/Users/iovanella/

Home page della didattica: http://www.uniroma2.it/didattica/grfbis

Indice

1 Introduzione

1.1

1.2

1.3

1

Definizioni . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

3

1.1.1

Sottografi, ordine, dimensione e densità di un grafo . . . . . . . . .

4

1.1.2

Vicinati, gradi e regolarità . . . . . . . . . . . . . . . . . . . . . . .

7

1.1.3

k-Fattorizzazioni . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

Grafi e modelli . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

1.2.1

Relazioni e sottografi . . . . . . . . . . . . . . . . . . . . . . . . . .

9

1.2.2

Assegnamento di lavori . . . . . . . . . . . . . . . . . . . . . . . . .

10

1.2.3

Scheduling di team in una azienda

. . . . . . . . . . . . . . . . . .

11

1.2.4

Percorsi su rete . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13

Esercizi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

15

2 Algoritmi

17

2.1

Breve tassonomia dei problemi decisionali

. . . . . . . . . . . . . . . . . .

17

2.2

Algoritmi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

18

2.2.1

Algoritmi di ricerca . . . . . . . . . . . . . . . . . . . . . . . . . . .

20

Crescita di funzioni . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

22

2.3.1

Notazione Big-O . . . . . . . . . . . . . . . . . . . . . . . . . . . .

23

2.3.2

Crescita di combinazioni di funzioni . . . . . . . . . . . . . . . . . .

24

2.4

Complessità degli algoritmi . . . . . . . . . . . . . . . . . . . . . . . . . . .

26

2.5

Esercizi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

30

2.3

II

INDICE

III

3 Proprietà e strutture dei grafi

32

3.1

Strutture dati per la rappresentazione di grafi . . . . . . . . . . . . . . . .

32

3.2

Isomorfismo tra grafi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

36

3.3

Connessione, cicli e grafi bipartiti . . . . . . . . . . . . . . . . . . . . . . .

39

3.4

Alberi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

3.5

Cammini Euleriani . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

45

3.6

Cammini Hamiltoniani . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

47

3.7

Esercizi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

47

4 Grafi Planari

50

4.1

Grafi sul piano . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

51

4.2

Grafi duali . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

53

4.2.1

Proprietà dei grafi planari e Formula di Eulero . . . . . . . . . . . .

54

4.2.2

Caratterizzazione dei grafi planari . . . . . . . . . . . . . . . . . . .

58

Esercizi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

58

4.3

5 Algoritmi di ricerca su grafo

60

5.1

Algoritmi di ricerca su grafo . . . . . . . . . . . . . . . . . . . . . . . . . .

60

5.2

Algoritmo di ordinamento topologico . . . . . . . . . . . . . . . . . . . . .

66

5.3

Algoritmi di ricerca di alberi ricoprenti minimi . . . . . . . . . . . . . . . .

69

5.3.1

Algoritmo di Kruskal . . . . . . . . . . . . . . . . . . . . . . . . . .

73

5.3.2

Algoritmo di Prim . . . . . . . . . . . . . . . . . . . . . . . . . . .

75

Esercizi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

78

5.4

6 Problemi di flusso su grafo

6.1

6.2

6.3

79

Algoritmi di ricerca del cammino minimo su di un grafo . . . . . . . . . . .

80

6.1.1

L’algoritmo di Dijkstra . . . . . . . . . . . . . . . . . . . . . . . . .

83

Problemi di massimo flusso su grafo . . . . . . . . . . . . . . . . . . . . . .

88

6.2.1

93

L’algoritmo di Ford e Fulkerson . . . . . . . . . . . . . . . . . . . .

Esercizi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 100

Elenco delle figure

1.1

L’attuale mappa dell’area dei ponti del problema di Könisberg [1]. . . . . .

2

1.2

Grafo corrispondente al Problema di Könisberg. . . . . . . . . . . . . . . .

2

1.3

Grafo dell’Esempio 1.1.2 . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5

1.4

Un sottografo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5

1.5

Un sottografo indotto . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5

1.6

Un sottografo ricoprente . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5

1.7

Esempi di grafi 3-regolari . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8

1.8

Le fattorizzazioni di K4 . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9

1.9

Grafo rappresentante le relazioni di conoscenza tra i cinque membri del gruppo 10

1.10 Grafo rappresentante le relazioni di non conoscenza tra i cinque membri del

gruppo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

10

1.11 Grafo bipartito . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

1.12 Una istanza del problema dei team . . . . . . . . . . . . . . . . . . . . . .

12

1.13 Un cammino . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

14

1.14 Un ciclo . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

14

1.15 Alcuni esempi di path e cicli . . . . . . . . . . . . . . . . . . . . . . . . . .

14

1.16 Grafo per l’Esempio 1.2.1

. . . . . . . . . . . . . . . . . . . . . . . . . . .

15

2.1

Grafico delle funzioni più comunemente usate nella stima Big-O . . . . . .

26

3.1

Grafo non orientato . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

33

3.2

Grafo orientato . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

33

3.3

Lista di adiacenza per il grafo di Figura 3.2. . . . . . . . . . . . . . . . . .

36

IV

V

ELENCO DELLE FIGURE

3.4

Esempio di due grafi isomorfi . . . . . . . . . . . . . . . . . . . . . . . . .

37

3.5

Due grafi isomorfi . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

38

3.6

I grafi bipartiti completi K2,3 e K3,3 . . . . . . . . . . . . . . . . . . . . . .

39

3.7

Un grafo con quattro componenti connesse. . . . . . . . . . . . . . . . . . .

40

3.8

Componente connessa di x . . . . . . . . . . . . . . . . . . . . . . . . . . .

41

3.9

Un circuito con un nodo ripetuto. . . . . . . . . . . . . . . . . . . . . . . .

41

3.10 Una foresta . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

3.11 Un albero . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

44

3.12 Come spostare i quattro cavalli. . . . . . . . . . . . . . . . . . . . . . . . .

47

4.1

Il problema dei tre nemici. . . . . . . . . . . . . . . . . . . . . . . . . . . .

50

4.2

Connessioni per il problema dei tre nemici. . . . . . . . . . . . . . . . . . .

51

4.3

K5 e K3,3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

52

4.4

La facce di un grafo planare. . . . . . . . . . . . . . . . . . . . . . . . . . .

53

4.5

Costruzione del duale. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

54

4.6

Un esempio di grafo G e del suo duale G∗ . . . . . . . . . . . . . . . . . . .

54

4.7

Esempio di due embedding planari con duali non isomorfi. . . . . . . . . .

55

4.8

Il ciclo C evidenziato per la dimostrazione del teorema. . . . . . . . . . . .

57

4.9

Contrazione dell’arco e. . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

57

5.1

L’algoritmo di ricerca su grafo.

. . . . . . . . . . . . . . . . . . . . . . . .

62

5.2

Grafo per gli Esempi 5.1.1 e 5.1.2. . . . . . . . . . . . . . . . . . . . . . .

63

5.3

Albero dei cammini e valori dei vettori pred(i) e ordine(i) nel caso FIFO. .

64

5.4

Albero dei cammini e valori dei vettori pred(i) e ordine(i) nel caso LIFO. .

66

5.5

L’algoritmo di ordinamento topologico. . . . . . . . . . . . . . . . . . . . .

67

5.6

Grafo per l’Esempio 5.2.1

. . . . . . . . . . . . . . . . . . . . . . . . . . .

68

5.7

Contenuto del vettore ordine(i) dopo l’ordinamento topologico. . . . . . .

69

5.8

Tagli e path per le condizioni di ottimalità. . . . . . . . . . . . . . . . . . .

70

5.9

Grafo per l’Esempio 5.3.1. . . . . . . . . . . . . . . . . . . . . . . . . . . .

74

5.10 Evoluzione dell’algoritmo di Kruskal sul grafo di Figura 5.9. . . . . . . . .

75

VI

ELENCO DELLE FIGURE

5.11 Evoluzione dell’algoritmo di Prim sul grafo di Figura 5.9. . . . . . . . . . .

77

6.1

Cammini da s a k. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

82

6.2

L’algoritmo di Dijkstra . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

84

6.3

Grafo per l’Esempio 6.1.1 e corrispondente tabella degli archi. . . . . . . .

85

6.4

Evoluzione delle etichette dei nodi e lista di adiacenza per il grafo di Figura 6.3. 87

6.5

Disegno per la correttezza di Dijkstra . . . . . . . . . . . . . . . . . . . . .

88

6.6

Costruzione del grafo residuo. . . . . . . . . . . . . . . . . . . . . . . . . .

90

6.7

Un grafo G con un flusso assegnato x ed il corrispondente grafo residuo G(x). 91

6.8

Un taglio s-t per il grafo di Figura 6.7. . . . . . . . . . . . . . . . . . . . .

91

6.9

L’algoritmo di Ford e Fulkerson . . . . . . . . . . . . . . . . . . . . . . . .

95

6.10 Grafo per l’Esempio 6.2.1. . . . . . . . . . . . . . . . . . . . . . . . . . . .

96

6.11 Il grafo residuo dopo la prima iterazione. . . . . . . . . . . . . . . . . . . .

96

6.12 Il grafo residuo dopo la seconda iterazione. . . . . . . . . . . . . . . . . . .

97

6.13 Il grafo residuo dopo la terza iterazione. . . . . . . . . . . . . . . . . . . .

97

6.14 Il grafo residuo dopo la quarta iterazione. . . . . . . . . . . . . . . . . . . .

98

6.15 Il taglio minimo del grafo di Figura 6.10. . . . . . . . . . . . . . . . . . . .

98

6.16 Istanza patologica per l’algoritmo di Ford e Fulkerson.

99

. . . . . . . . . . .

PREFAZIONE

VII

Prefazione

Queste dispense nascono per essere affiancate ai testi adottati per i corsi di Grafi e Reti di

Flusso, previsti per gli studenti di Ingegneria Gestionale e per quelli di Ingegneria Online

della Facoltà di Ingegneria dell’Università di Roma Tor Vergata. Esse costituiscono inoltre

un utile strumento di approfondimento per gli studenti del corso di Teoria dei Grafi e Reti

di Flusso del Master di II livello in Ingegneria dei Sistemi a Rete della Facoltà di Ingegneria

dell’Università di Roma Tor Vergata.

Essendo questa la primissima versione delle dispense, conterrà sicuramente degli errori. Inoltre i miei sforzi non saranno stati di certo sufficienti a creare uno strumento

chiaro e completo. Per questo confido nella collaborazione dei lettori nel segnalarmi ogni

imprecisione che rileveranno e le parti poco chiare o incomplete.

In queste pagine sono presenti tutti gli argomenti che saranno trattati nei moduli didattici. I testi originali dai quali ho tratto ispirazione per la redazione di queste note sono

raccolti nella bibliografia, e pertanto invito tutti gli studenti a tenerli in considerazione

come riferimento ufficiale in caso di dubbi o imprecisioni.

Gli argomenti trattati in queste dispense seguono fedelmente quelli svolti in aula. In

dettaglio, nel Capitolo 1 verranno introdotti i concetti e le definizioni di base della teoria

dei grafi che possono essere approfonditi su [9], [2], [4], [7] e [14]; nel Capitolo 2

verrà introdotto il concetto di algoritmo e vedremo i metodi di misura della loro efficienza,

argomenti che possono essere studiati su [8], [11] e [12]. I testi [10], [2], [7] e [14]

possono essere usati come riferimento per il Capitolo 3 nel quale verranno illustrate alcune

importanti caratteristiche dei grafi come l’isomorfismo e l’eulerianità, mentre [14], [7],

[11] sono stati usati per il Capitolo 4 dove tratteremo i grafi planari. I testi [10], [7]

e [3] sono invece alla base dei Capitoli 5 e 6 dove verranno illustrati rispettivamente gli

algoritmi di ricerca su grafo e gli algoritmi di flusso.

Ottobre 2006

Capitolo 1

Introduzione

Ognuno di noi su questo pianeta è separato dagli altri solo da sei persone.

Sei gradi di separazione fra noi e tutti gli altri su questo pianeta: il presidente

degli Stati Uniti, un gondoliere veneziano... Non solo nomi importanti, chiunque:

un indigeno australiano, uno della Terra del Fuoco, un eschimese.

Io sono legato a chiunque sul pianeta da una catena di sei persone.

E’ un pensiero profondo... ognuno di noi è una porta spalancata su altri mondi.

John Guare

Per definire il concetto di grafo si fa spesso ricorso ad un episodio che viene associato

alla nascita stessa della Teoria dei Grafi, ovvero alla formulazione del famoso Problema dei

Ponti di Könisberg da parte di Eulero in un suo lavoro del 1736.

Nella città di Könisberg (all’epoca appartenente alla Prussia, attualmente situata in

Russia con il nome di Kaliningrad) ci sono, oggi come allora, delle aree abitative insediate

su alcune isole del fiume Pregel ed altre che sorgono lungo le sue rive, per un totale di

quattro aree. Queste zone sono unite tra di loro da sette ponti, cosı̀ come si può vedere

nell’attuale mappa della zona, riportata in Figura 1.1. Il problema posto da Eulero si può

formulare nel seguente modo: è possibile trovare un percorso chiuso che, a partire da una

qualunque area, permetta di attraversare i ponti una ed una sola volta e ritornare al punto

di partenza?

La zona presa in esame può essere schematizzata come in Figura 1.2 dove i punti in

grassetto rappresentano le aree (le due isole, indicate con le lettere a e d e le due rive

1

2

Introduzione

Figura 1.1: L’attuale mappa dell’area dei ponti del problema di Könisberg [1].

del fiume, indicate con le lettere b e c) e gli archi rappresentano i ponti tra le diverse

aree. Cercando di risolvere il problema ci si convince abbastanza presto che questo non

ha soluzione e che non ha soluzione anche se vogliamo passare per ogni ponte una ed una

sola volta, ma accettiamo di non ritornare esattamente nella stessa area. Eulero dimostrò

che la forma delle suddette aree non ha alcuna influenza, ma che la soluzione dipende solo

dalle proprietà di connessione. La soluzione a questo problema sarà data nel Capitolo 3.

b

a5

a1

a4

a3

a

d

a6

a2

a7

c

Figura 1.2: Grafo corrispondente al Problema di Könisberg.

Introduzione

1.1

3

Definizioni

In questa sezione verranno esposte le definizioni di base della Teoria dei Grafi. Il lettore

deve però essere allertato del fatto che non esiste una notazione universalmente accettata,

ma che spesso per gli stessi concetti possono trovarsi in letteratura notevoli differenze1 .

Per quanto possibile, verrà data segnalazione lungo le pagine di queste note.

Definizione 1.1.1 Un grafo G è una tripla costituita da un insieme di vertici V (G) (detti anche nodi), un insieme di archi E(G) e una relazione, detta relazione di incidenza,

che associa con un arco una coppia di vertici, detti estremi.

Un grafo può essere rappresentato graficamente mediante dei punti per indicare i nodi

e da linee e curve per gli archi.

Esempio 1.1.1 In Figura 1.2 è disegnato il grafo G rappresentante il Problema di Könisberg, dove l’insieme dei vertici è V (G) = {a, b, c, d} (le quattro regioni) e l’insieme degli

archi è E(G) = {a1 , a2 , a3 , a4 , a5 , a6 , a7 } (i ponti). L’insieme degli archi può rappresentarsi

anche come E(G) = {ab, ac, ad, bd, db, cd, dc} ed in questo modo risulta esplicitata maggiormente la relazione di incidenza. Notare che i nodi b e d (e anche c e d) hanno più di

un arco in comune.

Gli esempi di problemi che possono essere descritti come un grafo sono molteplici. Per

esempio è possibile descrivere la rete stradale come un grafo dove i nodi sono gli incroci e

gli archi sono le strade che li congiungono; analogamente, un circuito elettrico può essere

visto come un grafo i cui nodi sono le connessioni e gli archi i componenti del circuito

stesso.

Definizione 1.1.2 Un loop (o laccio) è un arco i cui estremi coincidono. Si chiamano

archi multipli gli archi i cui estremi sono gli stessi.

Definizione 1.1.3 Si definisce grafo semplice un grafo privo di loop ed archi multipli.

1

Nel luglio del 2006, Douglas West ha proposto un sondaggio su Internet rivolto alla comunità di coloro

che si occupano di Teoria dei Grafi per cercare di uniformare almeno alcune notazioni principali. Per

quanto possibile, l’esito di tale sondaggio è stato preso in considerazione in queste note

Introduzione

4

Individueremo un grafo semplice mediante i suoi insiemi di nodi e di archi, considerando

l’insieme degli archi come un insieme di coppie non ordinate di vertici e scrivendo e = ab

(o egualmente e = ba) per un arco con estremi a e b.

Si possono dare ulteriori definizioni sui nodi e sugli archi:

Definizione 1.1.4 Se ab ∈ E(G) allora a e b si dicono adiacenti e si indica con a ∼ b.

I vertici a e b si dicono incidenti sull’arco ab.

Due archi si dicono adiacenti se hanno un vertice in comune.

Definizione 1.1.5 Un grafo G si dice finito se gli insiemi V (G) ed E(G) sono finiti.

In gran parte delle applicazioni i grafi sono finiti e privi di loop ed archi multipli. Di

conseguenza, in seguito faremo riferimento quasi esclusivamente a grafi semplici e sempre

a grafi finiti. Per evitare confusione, inoltre, non considereremo il grafo nullo, ovvero il

grafo con l’insieme dei vertici e degli archi vuoti.

Per semplicità di notazione, nel seguito indicheremo con V o N l’insieme dei vertici

V (G) e con E l’insieme degli archi E(G).

1.1.1

Sottografi, ordine, dimensione e densità di un grafo

Definizione 1.1.6 Dato un grafo G = (V, E), G′ = (V ′ , E ′ ) è un sottografo di G se

V ′ ⊂ V ed E ′ ⊂ E e posso scrivere G′ ⊂ G. Se il sottografo G′ contiene tutti gli archi di G

che congiungono due vertici in G′ , allora G′ è chiamato sottografo indotto e si indica

con G[V ′ ]. Se il sottografo G′ ha V ′ ≡ V , allora G′ è chiamato sottografo ricoprente.

Per indicare un sottografo scriveremo genericamente G′ ⊆ G e diremo che G contiene G′ .

Esempio 1.1.2 Si consideri il grafo G = ({1, 2, 3, 4, 5, 6}, {12, 14, 16, 25, 34, 36, 45, 56}),

rappresentato in Figura 1.3. In Figura 1.4 è rappresentato un suo generico sottografo con G′ = ({1, 2, 3, 4, 6}, {12, 14, 16, 36}), in Figura 1.5 il sottografo indotto G′ =

({1, 2, 3, 4, 6}, {12, 14, 16, 34, 36}) ed infine in Figura 1.6 il sottografo ricoprente G′ =

({1, 2, 3, 4, 5, 6}, {12, 14, 16, 36, 56}).

5

Introduzione

1

1

2

6

2

3

5

3

6

4

4

Figura 1.3: Grafo dell’Esempio 1.1.2

1

Figura 1.4: Un sottografo

1

2

6

3

2

6

3

5

4

4

Figura 1.5: Un sottografo indotto

Figura 1.6: Un sottografo ricoprente

Spesso è possibile costruire nuovi grafi a partire da un grafo assegnato G cancellando

oppure aggiungendo vertici ed archi. Se V ′ ⊂ V , allora G − V ′ = G[V \V ′ ] è il sottografo di

G ottenuto cancellando tutti i vertici V ′ e tutti gli archi su di loro incidenti. Analogamente,

se E ′ ⊂ E, allora G − E ′ = (V, E\E ′ ). Se V ′ = {v} oppure E ′ = {xy}, allora la notazione

si semplifica in G − v e G − xy. Infine, se x ed y sono due vertici non adiacenti di G, allora

G + xy è ottenuto congiungendo x ed y con un arco.

Definizione 1.1.7 Si definisce ordine di un grafo G il numero dei suoi vertici, ovvero

|G| = |V (G)|; si definisce dimensione di un grafo il numero dei sui archi, ovvero e(G) =

|E(G)|.

6

Introduzione

Per indicare l’ordine di un grafo arbitrario si può utilizzare inoltre la notazione Gn mentre attraverso la notazione G(n, m) si indica un grafo arbitrario di ordine n ed dimensione

m. Nell’esempio 1.1.2 il grafo ha ordine 6 e dimensione 8 e potremo indicarlo per esempio

come G(6, 8).

Dato un grafo semplice arbitrario di ordine n, ci chiediamo in quale campo di valori

possa variare il numero di archi m. Chiaramente, tali valori possono variare tra 0 (in

corrispondenza del grafo nullo) e tra il numero corrispondente al caso in cui tutti i nodi

sono mutualmente adiacenti, numero pari a tutte le possibili combinazioni di n oggetti

presi due a due. Quindi:

n(n − 1)

n

0≤m≤

=

2

2

(1.1)

Nel caso specifico il coefficiente binomiale si scrive attraverso la formula che compare

nell’ultimo membro della Formula 1.1. Quindi un grafo d’ordine 6 potrà, per esempio,

avere dimensione compresa tra 0 e 15.

Spesso il numero di archi di un grafo viene espresso in modo proporzionale rispetto al

massimo numero di archi possibile. A tale misura viene data il nome di densità di un

grafo e si calcola come:

D(G) =

m

n(n − 1)/2

(1.2)

chiaramente, tale misura varia da 0 a 1. In generale, diremo sparso un grafo che abbia

un numero di archi molto basso, ovvero una densità bassa (per esempio D(G) ≈ 0, 1÷0, 3);

viceversa, diremo che é denso un grafo che ha un alto numero di archi, quindi una densità

alta (per esempio D(G) ≈ 0, 7 ÷ 0, 9).

I grafi che hanno tutti i nodi mutualmente adiacenti rivestono una importanza particolare e sono chiamati grafi completi (o clique) e sono indicati con Kn , dove n indica la

sua cardinalità. Dato che un grafo può contenere sottografi completi, possiamo dare la

definizione più generale:

Definizione 1.1.8 Un grafo completo (o clique) in un grafo G è un insieme di nodi

7

Introduzione

mutualmente adiacenti. Dato l’insieme di tutte le clique di G, la cardinalità della clique

massima viene chiamata numero di clique ed è indicato con ω(G).

1.1.2

Vicinati, gradi e regolarità

Passiamo ora a dare altre definizioni sui grafi.

Definizione 1.1.9 L’insieme dei vertici adiacenti ad un assegnato vertice x ∈ G è

chiamato vicinato di x e si indica con Γ(x).

Con il simbolo Γ(x) spesso ci si riferisce al vicinato aperto, mentre per indicare il vicinato

chiuso si usa scrivere Γ(x) ∪ {x}. Notare che se y ∈ Γ(x) e x ∈ Γ(y), allora significa che

x ∼ y e y ∼ x, ovvero xy è un arco del grafo.

Definizione 1.1.10 Si definisce grado d(x) di un nodo x ∈ G la cardinalità del suo

vicinato, ovvero, d(x) = |Γ(x)|. Se un vertice ha d(x) = 0, allora si definisce vertice

isolato.

Anche in questo caso il simbolismo non è univocamente definito, perchè possiamo trovare indicato il vicinato ed il grado rispettivamente con ΓG (x) e dG (x), in modo da non

sottintendere il grafo G.

Dato un grafo G, si usa indicare il suo grado minimo con δ(G) ed il suo grado massimo

con ∆(G)

L’introduzione del concetto di grado di un vertice ci permette di introdurre un primo

importante risultato generale, che viene chiamato spesso Lemma Handshaking 2 :

Lemma 1.1.1 In ogni grafo, il numero di vertici di grado dispari è pari.

Dimostrazione: Sommando i gradi di ogni vertice, ogni arco è contato esattamente due

volte (una volta per ogni vertice). Quindi avremo che:

X

d(i) = 2m

(1.3)

∀i∈V

2

La ragione del nome del lemma deriva dal fatto che in un ricevimento, se tutti gli invitati si salutano

tra loro allora la somma totale delle strette di mano (in inglese, handshaking) è sempre pari.

8

Introduzione

Dato che il secondo membro è positivo, anche il primo deve esserlo; quest’ultimo è

composto da due contributi, la somma dei gradi pari e la somma dei gradi dispari. È

quindi chiaro che il contributo dei vertici di grado dispari deve essere pari e questo accade

solo se sono in numero pari.

Definizione 1.1.11 Dato un grafo G, se δ(G) = ∆(g) = k allora G si dice k-regolare.

Un grafo G si dice regolare se è k-regolare per un certo k.

Figura 1.7: Esempi di grafi 3-regolari

Per esempio, tutte le clique Kn sono (n − 1)-regolari; ancora, se k = 3 si ha un grafo

3-regolare (vedi Figura 1.7), detto anche cubico.

1.1.3

k-Fattorizzazioni

Definizione 1.1.12 Un k-fattore è un sottografo ricoprente k-regolare.

Se l’insieme degli archi può essere diviso in k-fattori ho una decomposizione che prende

il nome di k-fattorizzazione. Se ho una decomposizione in 1-fattori allora la decomposizione prende il nome di fattorizzazione ed ha ovviamente senso solo se il grafo ha un

numero pari di nodi. In Figura 1.8 sono rappresentate (con gli archi in grassetto) le tre

possibili fattorizzazioni di K4 .

9

Introduzione

1

2

1

2

1

2

3

4

3

4

3

4

Figura 1.8: Le fattorizzazioni di K4

1.2

Grafi e modelli

In questa sezione verranno mostrate alcune applicazioni pratiche che possono essere rappresentate mediante dei grafi. Gli esempi illustrati ci serviranno soprattutto per introdurre

nuove definizioni e termini della teoria dei grafi.

1.2.1

Relazioni e sottografi

Supponiamo sia assegnato un gruppo di cinque persone; come è possibile rappresentare

le relazioni di conoscenza tra i membri del gruppo? Se indichiamo con le prime cinque

lettere dell’alfabeto i cinque membri del gruppo, possiamo costruire un grafo nel quale i

nodi rappresentano i membri, ed un arco esiste se due membri si conoscono. Supponiamo

sia assegnata un’istanza di tale problema come in Figura 1.9.

Supponiamo di voler studiare ora il problema complementare: dato ancora lo stesso

gruppo di persone, come rappresentare le relazioni di non conoscenza tra i membri?

Definizione 1.2.1 Il grafo complemento Ḡ di un grafo semplice G è un grafo semplice

avente insieme dei nodi V (Ḡ) ≡ V (G) ed insieme degli archi tale che un arco ab esiste in

Ḡ se e solo se ab ∈

/ E(G).

Definizione 1.2.2 Un insieme indipendente (o insieme stabile) W in un grafo è un

insieme di vertici mutuamente non adiacenti, ovvero se e soltanto se il sottografo indotto

G[W ] = ∅.

10

Introduzione

b

b

a

c

e

a

d

Figura 1.9: Grafo rappresentante le

relazioni di conoscenza tra i cinque

membri del gruppo

c

e

d

Figura 1.10: Grafo rappresentante le

relazioni di non conoscenza tra i cinque

membri del gruppo

La definizione di complementarietà ci permette di legare tra di loro i due problemi

introdotti e di ottenere il grafo rappresentante il secondo attraverso tale definizione, come

si può vedere in Figura 1.10. Possiamo notare inoltre che nel grafo G, il sottografo {a, b, c}

è una clique di ordine 3 e {c, e} è un insieme indipendente di cardinalità 2. Corrispondentemente, nel grafo G, i nodi {a, b, c} sono un insieme indipendente di cardinalità 3 e {c, e}

è una clique di ordine 2. Quindi gli insiemi indipendenti di un grafo diventano clique nel

suo grafo complementare cosı̀ come le clique in un grafo diventano insiemi indipendenti nel

suo grafo complemento.

L’insieme indipendente, oltre che alla clique, è legato ad un altro concetto, ovvero quello

del vertex covering:

Definizione 1.2.3 Un vertex covering di un grafo G è un sottoinsieme V ′ di V tale

che ogni arco di G è incidente con almeno un vertice in V ′ .

Si può dimostrare [14] che, se α è il valore della cardinalità del massimo insieme indipendente di G e β la cardinalità del più piccolo V ′ tale che sia un vertex covering di G,

allora α + β = n, dove n è l’ordine di G. Infatti, ogni insieme indipendente di cardinalità

massima è il complemento di un vertex cover minimo.

1.2.2

Assegnamento di lavori

Si supponga che un’azienda debba effettuare n compiti diversi, da assegnare ognuno ad

m dipendenti, che però non sono interscambiabili perchè ognuno di essi possiede delle

11

Introduzione

specializzazioni. In che modo assegnare i compiti ai dipendenti?

Per risolvere questo problema possiamo costruire un grafo nel quale i vertici sono gli

n compiti e gli m dipendenti, mentre un arco ij esiste se il compito i può essere svolto

dal dipendente j. In Figura 1.11 è disegnato un grafo corrispondente al caso in cui n =

m = 4 e si può notare come in realtà l’insieme dei nodi sia partizionato in due sottoinsiemi

(indipendenti) V1 (corrispondenti ai compiti) e V2 (corrispondenti ai dipendenti).

V1

V2

Figura 1.11: Grafo bipartito

Per questa particolare categoria di grafi possiamo dare la seguente definizione:

Definizione 1.2.4 Un grafo G si dice bipartito se l’insieme dei suoi nodi V (G) è l’unione

di due insiemi indipendenti disgiunti V1 e V2 chiamati insiemi partizione ed ogni suo arco

va da V1 a V2 .

Un grafo bipartito è anche chiamato 2-partito, perchè può essere visto come un particolare caso dei grafi r-partiti, ovvero di quei grafi nei quali l’insieme dei nodi è costituito

dall’unione di r insiemi partizione e gli archi vanno da una delle partizioni verso una

qualunque delle altre.

1.2.3

Scheduling di team in una azienda

Una azienda ha la necessità di schedulare3 un certo numero di riunioni dei vari team, ma

ha il vincolo che alcuni manager appartengono a team differenti e quindi non è possibile

indire due riunioni contemporaneamente se hanno un manager in comune.

3

Il termine inglese scheduling indica un problema decisionale che considera l’allocazione di risorse scarse ad attività, con l’obiettivo di ottimizzare una o più misure di prestazione. Siccome tale parola è

intraducibile in italiano, viene di solito adattata, ottenendo i termini schedulare, schedulato, ecc.

12

Introduzione

1

2

1

a

b

e

1

3

c

d

Figura 1.12: Una istanza del problema dei team

Per rappresentare tale problema posso disegnare un grafo nel quale i nodi sono i team,

ed esiste un arco se i due team hanno un membro in comune, come in Figura 1.12. Per

risolverlo, invece, posso usare un algoritmo che, partendo da un nodo, assegni ad ognuno

di essi una etichetta (colore) in modo che due nodi adiacenti non abbiano stessa etichetta. Associando l’etichetta ad un istante temporale, e considerando che nodi che hanno

stessa etichetta non hanno membri in comune, ne consegue che per risolvere il problema

è sufficiente schedulare i team nell’ordine dato dalle etichette. Per esempio, considerando

le etichette assegnate al grafo in Figura 1.12 una possibile sequenza è {a, c, e}, {b} e {d}

(notare come l’ordine delle etichette corrisponda agli istanti di attuazione).

Generalizzando il problema, ci si può chiedere quale sia, tra tutte le etichettature

ammissibili, quella che implica il minor numero di etichette possibili.

Definizione 1.2.5 Si definisce numero cromatico di un grafo G e si indica con χ(G),

il minimo numero di colori necessari per etichettare i vertici in modo che vertici adiacenti

ricevano colori diversi.

Il termine colore deriva dal famoso Problema dei quattro colori, posto da Francis e

Frederick Guthrie nel 1852 e da A. Cayley nel 1878, nel quale si ci si chiedeva quale fosse il

minimo numero di colori necessari per colorare una mappa geografica politica. Nel 1890 P.

J. Heawood congetturò che bastassero quattro colori, ma tale congettura è stata dimostrata

definitivamente solo nel 1976 da K. Appel e W. Haken. Per altri aspetti storici sul problema

dei quattro colori rimandiamo il lettore a [9].

Introduzione

1.2.4

13

Percorsi su rete

Uno dei campi nel quale la teoria dei grafi trova grande applicazione è quello della rappresentazione delle reti stradali. Infatti, possiamo associare un vertice del grafo ad ogni

incrocio stradale ed unire tra di loro tali vertici con un arco in corrispondenza del tratto di

strada che unisce i due incroci. Inoltre possiamo iniziare ad introdurre dei nuovi elementi

che possiamo associare agli archi ed ai nodi, ovvero dei pesi; in questo caso, un peso associato agli archi può rappresentare la lunghezza del tratto stradale, oppure la sua capacità

in termini di auto per ora, ecc.

Questa rappresentazione fa nascere alcuni quesiti, per esempio, dati due vertici qualunque a e b, è possibile individuare sulla rete il cammino più breve tra questi due punti?

Oppure, se i vertici rappresentano delle città e gli archi la rete autostradale, è possibile

individuare un percorso che partendo da una generica città visiti tutte le restanti con un

percorso di distanza minima?

Vedremo nel seguito come risolvere il primo problema (vedi Capitolo 6) mentre per il

secondo rimandiamo alla bibliografia, invitando il lettore ad approfondire gli argomenti

riguardanti il cosiddetto Problema del commesso viaggiatore o TSP, Travelling Salesman

Problem per esempio in [7] o [14].

Definizione 1.2.6 Un cammino (o anche path) è un grafo semplice i cui vertici possono

essere ordinati in una lista in modo che due vertici sono consecutivi se e soltanto se sono

consecutivi nella lista medesima.

Quindi, P = (V (P ) = {x0 , x1 , . . . xl }, E(P ) = {x0 x1 , x1 x2 . . . xl−1 xl }) è un cammino

che indicheremo con x0 x1 . . . xl . Chiameremo i vertici x0 e xl terminali del cammino.

P

Inoltre, se indichiamo con di la lunghezza associata ad ogni arco, allora l = ∀xi xj ∈E(P ) di

è la lunghezza del cammino.

Definizione 1.2.7 Un ciclo è un cammino con egual numero di vertici ed archi e con i

terminali coincidenti.

A titolo di esempio, in Figura 1.13 è rappresentato il cammino x0 x1 x3 x2 x4 x5 , mentre

in Figura 1.14 è rappresentato il ciclo x0 x1 x3 x2 x4 x5 x0 .

14

Introduzione

x2

x1

x0

x2

x1

x0

x3

x4

x5

x3

x4

x5

Figura 1.13: Un cammino

Figura 1.14: Un ciclo

P3

C4

P4

C5

Figura 1.15: Alcuni esempi di path e cicli

Per indicare path e cicli arbitrari si usa aggiungere alla nomenclatura un pedice che

indica il numero di archi di cui sono composti. Quindi, per esempio, P4 indica un path

di lunghezza 4, mentre C5 indica un ciclo di lunghezza 5 (alcuni esempi sono dati in

Figura 1.15). Inoltre, un path con terminali x e y viene spesso indicato come “{x, y}-path”.

Un cammino od un ciclo possono essere identificati come sottografi in un grafo arbitrario

e questo ci porta a generalizzare le definizioni appena date.

Definizione 1.2.8 Dato un grafo arbitrario G = (V, E), allora:

• un walk W in un grafo è una sequenza alternata di vertici ed archi, x0 e1 x1 e2 . . . el xl ,

con ei = xi−1 xi e 0 < i ≤ l;

• un trail T è un walk con tutti gli archi distinti;

• un path P è un trail con tutti i vertici distinti;

• un trail chiuso (o anche circuito) è un trail con x0 ≡ xl ;

15

Introduzione

• un ciclo C è un walk composto da più di tre archi, ha x0 ≡ xl ed ogni vertice distinto.

Definizione 1.2.9 Dato un grafo G, un insieme di cammini {P 1 , P 2 , . . . P k } si dice indipendente (o internamente disgiunto) se per ogni coppia di cammini, gli unici vertici

in comune sono i terminali, ovvero sono dei {x, y}-path se V (P i )∩V (P j ) = {x, y}, ∀i 6= j.

Esempio 1.2.1 Dato il grafo in Figura 1.16, un walk è {abcebc}, un trail è {abcebf }, un

trail chiuso è {abcebf ea}, un path è {abcdef } ed, infine, un ciclo è {abcdef a}.

b

a

c

d

f

e

Figura 1.16: Grafo per l’Esempio 1.2.1

Il concetto di cammino in un grafo ci permette di introdurre un’importante proprietà

dei grafi, ovvero la connessione.

Definizione 1.2.10 Un grafo G è connesso se ogni coppia di suoi vertici appartiene ad

un cammino e sconnesso altrimenti.

Riprenderemo questo concetto nelle prossime sezioni.

1.3

Esercizi

Es. 1.3.1 Dire se è possibile disegnare un grafo in cui i gradi dei vertici siano i seguenti:

d(1) = 1; d(2) = 2; d(3) = 3; d(4) = 4; d(5) = 5.

Introduzione

16

Es. 1.3.2 E’ possibile disegnare un grafo 3-regolare con 9 vertici? Se si disegnarlo. E con

8 vertici? Se si disegnarlo.

Es. 1.3.3 Dato K6 , quanti cammini ricoprenti posso fare partendo da un vertice assegnato

a?

Es. 1.3.4 Dato K4,4 , quanti cammini ricoprenti posso fare partendo da un dato vertice a?

Es. 1.3.5 Si disegni una 2-fattorizzazione di K5 .

Es. 1.3.6 Si mostri se è possibile disegnare una 2-fattorizzazione di K6 .

Es. 1.3.7 (Difficile) Determinare il numero di 1-fattori in K2n .

Es. 1.3.8 (Difficile) Determinare il numero di 2-fattori in K2n,2n .

Capitolo 2

Algoritmi

I progressi ottenuti nel campo dell’elaborazione elettronica hanno permesso lo sviluppo e

l’applicazione dei metodi matematici per la modellizzazione e la risoluzione di una grande varietà di problemi decisionali, anche di dimensioni ragguardevoli. Tutto l’insieme di

metodologie che hanno in comune l’uso del metodo matematico, come per esempio l’ottimizzazione, la programmazione matematica, la teoria dei grafi, la teoria delle code, la

teoria delle decisioni, la simulazione, ecc, sono raccolte in una disciplina che prende il nome

di Ricerca Operativa. Data la natura applicativa della Ricerca Operativa, lo studio teorico

del problema matematico posto viene normalmente affiancato allo studio delle tecniche

necessarie per ottenere una soluzione in modo efficiente.

2.1

Breve tassonomia dei problemi decisionali

In generale, nella modellazione di un problema decisionale, ci dobbiamo preoccupare di

tre componenti fondamentali: il grado di incertezza, il numero di obiettivi ed il numero di

decisori.

Il grado di incertezza indica se ci si trova in condizioni di informazione completa, come

nei problemi deterministici, oppure in condizioni di conoscenza parziale, come nei problemi stocastici. Il numero di obiettivi è un’altra componente da conoscere e, in generale,

potremo riconoscere problemi a singolo obiettivo, oppure multiobiettivo. Analogamente,

17

Algoritmi

18

per il numero dei decisori avremo una divisione in due classi, quella dei problemi a singolo

decisore e quella dei problemi multidecisore.

Continuando con questi accenni di tassonomia dei problemi decisionali, potremo considerare problemi lineari oppure problemi non lineari, a seconda della nostra funzione

obiettivo. Inoltre, sulla base dei valori che possono assumere le variabili, avremo problemi

continui se i valori apparterranno allo spazio dei numeri reali R, problemi discreti (o combinatori) se i valori apparterranno allo spazio dei numeri interi Z ed infine, problemi misti

se le variabili possono assumere valori sia reali che interi.

Utilizzando lo schema appena descritto, nella trattazione della teoria dei grafi ci limiteremo in seguito al solo studio dei problemi deterministici, singolo obiettivo, singolo

decisore, lineari e discreti. Al lettore è lasciato immaginare la quantità di problemi decisionali che si possono osservare nella realtà al presentarsi ed al combinarsi delle diverse

ipotesi sopra dette e, di conseguenza, come la loro analisi sia fondamentale per individuare

le tecniche più adeguate per risolverli.

2.2

Algoritmi

Per la soluzione di un problema, occorre individuare un metodo generale (procedura) in

grado di risolvere ogni generica istanza, fornendoci la soluzione desiderata in un certo

numero di passi. Il termine generale usato per definire tali procedure è algoritmo 1 .

Definizione 2.2.1 Un algoritmo è una procedura definita usata per risolvere un problema

usando un numero finito di passi.

Gli algoritmi ricopriranno una grande importanza nel nostro studio della Teoria dei

Grafi e, quindi, dedicheremo le prossime pagine alla descrizione di alcuni strumenti per la

loro analisi.

Esempio 2.2.1 Descrivere un algoritmo per trovare l’elemento più grande in una sequenza

(lista) di interi.

1

Il termine algoritmo deriva dal nome del matematico persiano Abu Ja’far Mohammed ibn Musa alKhowarizmi, vissuto nel IX secolo d.C..

19

Algoritmi

Per specificare la procedura di risoluzione di questo semplice problema possiamo utilizzare

molti metodi, ma uno dei più semplici è quello di utilizzare il linguaggio naturale per

descrivere i singoli passi della procedura. Per risolvere il problema devono essere eseguiti

i seguenti passi:

Step 1: Poni il massimo temporaneo uguale al primo intero della sequenza;

Step 2: Compara il prossimo intero nella sequenza.

Se è più grande, poni il massimo

temporaneo pari a tale valore;

Step 3: Ripetere il passo precedente per ogni altro elemento della lista;

Step 4: Stop se non ci sono altri interi. Il valore cercato è contenuto nel massimo temporaneo

(che diventa definitivo).

Per descrivere più efficacemente un algoritmo si può utilizzare una descrizione mediante pseudocodice, basata su una sintassi molto simile al linguaggio di programmazione PASCAL, di facile comprensione per chiunque abbia dei rudimenti di Fondamenti di Informatica. Essa inoltre ci permette di evitare le specificità di un linguaggio di

programmazione.

Utilizzando lo pseudocodice, il nostro algoritmo diventa:

procedure MAX(a1 , . . . , an ; integers)

max := a1

for i := 2 to n

if max < ai then max := ai

max contiene il massimo

Come è facile notare, l’algoritmo in pseudocodice segue fedelmente i passi sopra descritti.

Per poter fornire una soluzione significativa, gli algoritmi devono rispettare alcune

proprietà:

Proprietà 2.2.1 Un algoritmo deve soddisfare le seguenti proprietà:

20

Algoritmi

• Input - L’algoritmo deve avere un input contenuto in un insieme definito I.

• Output - Da ogni insieme di valori in input, l’algoritmo produce un insieme di valori

in uscita che comprende la soluzione.

• Determinatezza - I passi dell’algoritmo devono essere definiti precisamente.

• Finitezza - Un algoritmo deve produrre la soluzione in un numero di passi finito

(eventualmente molto grande) per ogni possibile input definito su I.

• Efficacia - Deve essere possibile effettuare ogni passo dell’algoritmo esattamente ed

in un tempo finito.

• Generalità - L’algoritmo deve essere valido per ogni insieme di dati contenuti in I

e non solo per alcuni.

Oltre a queste proprietà, un algoritmo deve essere efficiente, ovvero, dato un input di

dimensione fissata, deve fornire una soluzione in un tempo ragionevole ed inoltre deve occupare una quantità limitata di memoria di un computer. Problematiche di questo tipo sono

trattate dall’analisi della complessità computazionale degli algoritmi; in particolare,

se l’oggetto dello studio è il tempo di elaborazione, parleremo di complessità temporale, mentre se l’oggetto è l’occupazione della memoria, allora parleremo di complessità

spaziale.

È chiaro quindi che nell’analisi di un algoritmo è di fondamentale importanza sapere se

risolverà il nostro problema in un microsecondo, in un ora o in un secolo. Analogamente,

è importante sapere se l’occupazione di memoria possa eccedere le capacità disponibili.

L’analisi della complessità spaziale coinvolge principalmente l’analisi delle strutture dati

e, quindi, esula dagli scopi di queste note. Viceversa, l’analisi della complessità temporale

è molto importante per gli algoritmi su grafo e sarà approfondita nella Sezione 2.4.

2.2.1

Algoritmi di ricerca

In questa sezione vedremo alcuni esempi di algoritmi ed in particolare ci concentriamo sugli

algoritmi di ricerca su stringa che abbiamo già introdotto nell’Esempio 2.2.1.

Algoritmi

21

Gli algoritmi di ricerca rivestono un particolare interesse nella pratica; basti pensare

alla necessità di trovare una parola in un dizionario, un dato in un database o anche alla

ricerca di pagine web attraverso i motori di ricerca. In quest’ultimo caso, l’algoritmo di

ricerca presenta, ovviamente, complessità ben diverse.

Il primo algoritmo che introduciamo è l’algoritmo di ricerca lineare (o sequenziale): data una lista di elementi distinti a1 , a2 . . . , an , localizzare l’elemento x o affermare

che non c’è.

procedure LINEAR SEARCH (x, integer; a1 , . . . , an , distinct integers)

i := 1

while (i ≤ n AND x 6= ai )

i := i + 1

if i ≤ n then

posizione := i

else

posizione := 0

L’algoritmo inizia confrontando x con a1 . Se l’elemento non è stato individuato, si

incrementa il contatore i e quindi si continua fino a che una delle due condizioni risulta

falsa (cioè o sono arrivato alla fine della lista, o ho trovato l’elemento) ed il ciclo while

termina. L’istruzione condizionale if ha il compito di inserire nella variabile di output il

valore della posizione o il valore 0 se tale valore non è nella lista.

Il secondo algoritmo di ricerca che descriviamo è l’algoritmo di ricerca binaria:

data una lista di elementi distinti a1 , a2 . . . , an , ordinati in modo che a1 ≤ a2 ≤ . . . ≤ an ,

localizzare l’elemento x o affermare che non c’è.

La differenza in questo caso è che la sequenza è ordinata in modo crescente, come

per esempio può accadere in un vocabolario se il criterio adottato è quello lessicografico.

Supponiamo allora che sia assegnata la sequenza {1, 2, 4, 5, 6, 9, 10, 12, 15, 18, 20, 24} e che

si voglia trovare se il numero 18 appartiene a tale lista.

L’idea che sta alla base dell’algoritmo è quella di dividere ad ogni passo la lista in due

parti (nel nostro caso {1, 2, 4, 5, 6, 9} e {10, 12, 15, 18, 20, 24}) e confrontare l’elemento da

cercare rispettivamente con l’ultimo elemento della prima metà e con il primo elemento

della seconda metà. Nel nostro caso l’elemento è più grande del primo elemento della

Algoritmi

22

seconda metà e quindi possiamo concentrarci solo in tale stringa per la ricerca. L’algoritmo

continua dividendo tale stringa ulteriormente, ottenendo pertanto {10, 12, 15} e {18, 20, 24}

ed eseguendo di nuovo i confronti. Cosı̀ facendo l’algoritmo genera ancora le stringhe {18}

e {20, 24} arrestandosi al valore cercato oppure affermando che non appartiene a tale lista.

Lo pseudocodice dell’algoritmo proposto è il seguente:

procedure BINARY SEARCH (x, integer; a1 , . . . , an , increasing integers)

i := 1

j := n

while (i < j )

begin

⌋

m := ⌊ i+j

2

if x > am then

i := m + 1

else

j := m

end

if x = ai then

posizione := i

else

posizione := 0

L’apparente complessità dell’algoritmo di ricerca binaria, rispetto a quello lineare,

nasconde dei benefici che saranno mostrati nel paragrafo 2.4.

2.3

Crescita di funzioni

Nell’analisi di un algoritmo è di particolare interesse comprendere la sua applicabilità pratica e, principalmente, capire il tempo necessario per ottenere un risultato utile, ovvero la

sua efficienza. Osservando gli algoritmi presentati nella sezione precedente, si può notare

come l’input sia sempre legato al numero n di oggetti in ingresso sui quali eseguire l’elaborazione. Ci potremmo quindi chiedere quanto cresce il tempo di elaborazione al crescere di

n e se è possibile trovare una funzione f (n) che sia in grado di trasferire questa informazione. Inoltre, sarebbe utile disporre di un criterio in grado di paragonare due algoritmi

confrontando la crescita delle rispettive funzioni dell’input.

23

Algoritmi

2.3.1

Notazione Big-O

Per analizzare il comportamento degli algoritmi dobbiamo prima introdurre la notazione

Big-O, necessaria per lo studio della crescita di una funzione generica, di cui segue la

definizione:

Definizione 2.3.1 Siano f e g due funzioni tali che f, g : N → R (o anche f, g : R → R).

Diremo che f (n) = O(g(n)) se esistono due costanti, C e k, tali che ∀n > k si ha:

f (n) ≤ C|g(n)|

(2.1)

La 2.1 si legge come “f (n) è un big o di g(n)”.

È importante notare che basta trovare una sola coppia C, k tale che sia vera la 2.1. In

realtà, una coppia che soddisfa la definizione data non è mai unica, anzi, basta prendere

una qualunque coppia C ′ , k ′ tale che C < C ′ e k < k ′ per soddisfare la definizione e questo

ci porta a dire che se una coppia esiste, allora ne esistono infinite.

Esempio 2.3.1 Mostrare che f (n) = n2 + 2n + 1 è un O(n2 ).

Per risolvere questo esercizio basta osservare che 0 ≤ n2 + 2n + 1 ≤ n2 + 2n2 + n2 = 4n2 ,

avendo considerato C = 4 e k = 1. Notare che in questo caso si ha che f (n) ≤ C|g(n)| e

g(n) ≤ C|f (n)|. Quando ciò accade diremo che le funzioni sono dello stesso ordine.

Occorre notare che il segno di uguale nella 2.1 non è realmente un uguale, ma, piuttosto,

indica che in questa notazione, quando si hanno dei valori di n sufficientemente grandi nei

dominii di f e g, la disuguaglianza è verificata.

Se f (n) ≤ C|g(n)| e h(n) è una ulteriore funzione che assume valori assoluti maggiori

di g(n) a partire da valori di n sufficientemente grandi, allora si ha ovviamente che f (n) ≤

C|h(n)|. Di norma, però, si sceglie la funzione g più piccola possibile; quindi nell’esempio

precedente è corretto, ma privo di senso, dire che f (n) = O(n3 ).

Esempio 2.3.2 Dare una stima Big-O della somma dei primi numeri n interi positivi.

24

Algoritmi

Dato che 1 + 2 + . . . + n ≤ n + n + . . . + n = n2 , allora 1 + 2 + . . . + n = O(n2 ), con C = 1

e k = 1.

Esempio 2.3.3 Dare una stima Big-O di f (n) = log n!.

Per quanto riguarda il fattoriale si ha che 1 · 2 · . . . · n ≤ n · n · . . . · n = nn . Quindi

log n! ≤ log nn = n log n, che implica log n! = O(n log n).

2.3.2

Crescita di combinazioni di funzioni

Gli algoritmi sono tipicamente composti da diverse operazioni concatenate ed annidate in

sottoprocedure, quindi la notazione introdotta nel paragrafo precedente deve essere estesa

in modo da tenere conto del peso delle singole sottoprocedure.

Supponiamo allora di avere assegnate due funzioni f1 (n) = O(g1 (n)) e f2 (n) = O(g2 (n)).

Per la definizione data nel paragrafo precedente sappiamo che esistono delle costanti C1 ,

C2 , k1 e k2 tali che f1 (n) ≤ C1 |g1 (n)|, ∀n > k1 e f2 (n) ≤ C2 |g2 (n)|, ∀n > k2 .

Teorema 2.3.1 Si supponga che f1 (n) = O(g1 (n)) e f2 (n) = O(g2 (n)). Allora la somma

delle due funzioni è:

(f1 + f2 )(n) = O(max{g1 (n), g2 (n)})

(2.2)

Dimostrazione: Si noti che |(f1 +f2 )(n)| = |f1 (n)+f2 (n)| ≤ |f1 (n)|+|f2 (n)| (quest’ultima

relazione è vera per la disuguaglianza triangolare, |x + y| ≤ |x| + |y|).

Se si considera g(n) = max{g1 (n), g2 (n)} e C = C1 + C2 , allora |f1 (n)| + |f2 (n)| ≤

C1 |g1 (n)| + C2 |g2 (n)| ≤ C|g(n)|.

Corollario 2.3.2 Se entrambe le funzioni f1 (n) e f2 (n) sono entrambe O(g(n)), allora

(f1 + f2 )(n) = O(g(n)).

Per quanto riguarda il prodotto di funzioni, vale il seguente teorema:

25

Algoritmi

Teorema 2.3.3 Si supponga che f1 (n) = O(g1 (n)) e f2 (n) = O(g2 (n)). Allora il prodotto

delle due funzioni è:

(f1 · f2 )(n) = O(g1 (n) · g2 (n))

(2.3)

Dimostrazione: Considerando C = C1 · C2 , allora (f1 · f2 )(n) = |f1 (n)| · |f2 (n)| ≤

C1 |g1 (n)| · C2 |g2 (n)| ≤ C|(g1 · g2 )(n)|.

Esempio 2.3.4 Dare una stima Big-O della funzione f (n) = 3n log(n!) + (n2 + 3) log n.

Considerando ogni termine singolarmente abbiamo:

f (n) =

3n

→

n

log n!

→

n log n

→

log n

+(n2 + 3) → n2 + 3 ≤ 4n2

log n

Quindi f (n) = O(n2 log n).

L’ultimo risultato di questa sezione riguarda la crescita di funzioni polinomiali (in x,

per comodità di notazione):

Teorema 2.3.4 Sia f (x) = an xn + an−1 xn−1 + . . . + a0 , con an , an−1 . . . , a0 numeri reali.

Allora f (x) = O(xn ).

Dimostrazione: Utilizzando la disuguaglianza triangolare, e per x > 1,

|f (x)| = |an xn + an−1 xn−1 + . . . + a0 |

≤ |an |xn + |an−1 |xn−1 + . . . + |a0 |

= xn (|an | +

|a0 |

|an−1 |

+ ... + n )

x

x

≤ xn (|an | + |an−1 | + . . . + |a0 |)

Questo dimostra che |f (x)| < Cxn , dove C = |an | + |an−1 | + . . . + |a0 |, se x > 1. Quindi

f (x) = O(xn ).

26

Algoritmi

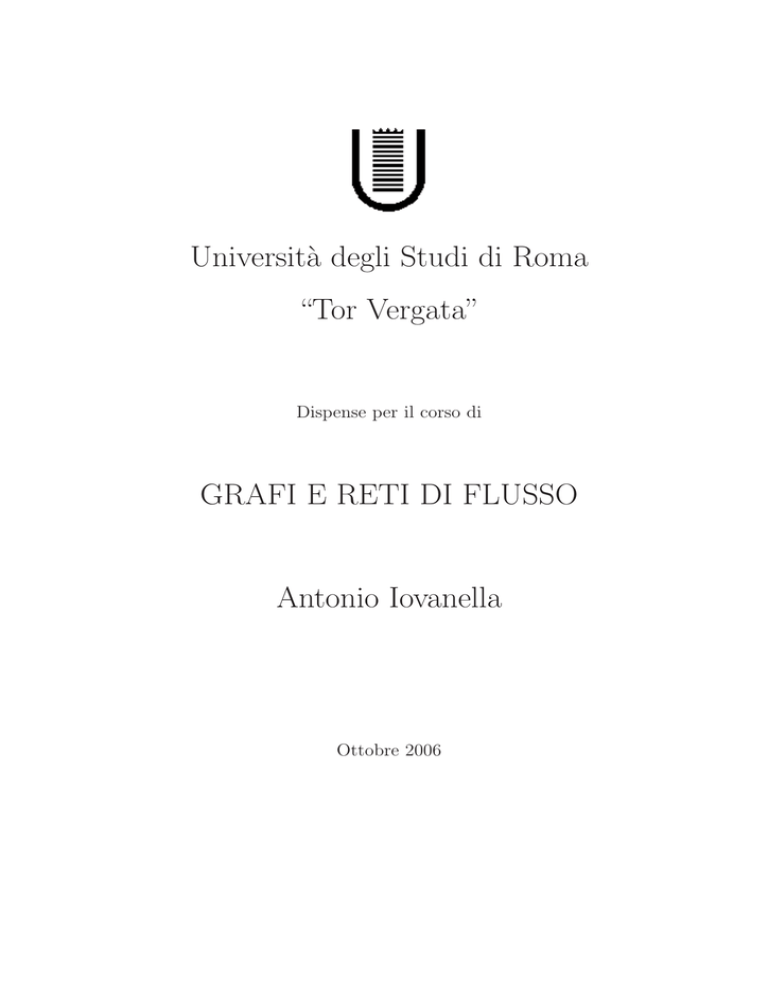

Come abbiamo detto, la notazione Big-O viene usata per la stima del numero di operazioni necessarie affinchè un algoritmo risolva un dato problema. Le funzioni che normalmente si usano sono 1, log n, n, n log n, n2 , 2n , n!. La sequenza presentata non è casuale, ma

rispetta l’ordinamento tale per cui la funzione successiva è sempre più grande di quella che

la precede. In Figura 2.1 sono riportati i grafici delle funzioni indicate, dove n sia l’ascisse

e in ordinata siano i valori della funzione, in scala esponenzialmente crescente.

2048

n!

1024

2n

512

256

128

n2

64

32

16

8

n log n

n

4

log n

2

1

1

2

3

4

5

6

7

8

Figura 2.1: Grafico delle funzioni più comunemente usate nella stima Big-O

2.4

Complessità degli algoritmi

L’analisi della complessità temporale degli algoritmi può essere espressa in termini di numero di operazioni eseguite dallo specifico algoritmo quando l’input ha un data dimensione.

Questo tipo di analisi risulta essere più efficiente della semplice misura del tempo impiegato da un computer per completare la sua elaborazione, perché, nel caso, la velocità di

elaborazione può variare molto da computer a computer ed è inoltre difficile da misurare

e valutare.

Algoritmi

27

Per illustrare come analizzare la complessità di un algoritmo, consideriamo il primo

esempio della Sezione 2.2 per trovare l’elemento più grande in una lista. Le operazioni

che sono eseguite sono i due confronti all’interno del ciclo for, uno per verificare se si è

giunti alla fine della lista, l’altro per aggiornare, eventualmente, il massimo temporaneo.

Dato che i due confronti vengono ripetuti dal passo due al passo n ed è poi eseguito

un’ulteriore confronto per uscire dal ciclo quando il contatore i = n + 1, si ha che sono

eseguiti esattamente 2(n − 1) + 1 = 2n − 1 confronti. Quindi, dato un input di lunghezza

n, se si misura la complessità in termini di confronti, si ha che l’algoritmo trova il massimo

in una lista di lunghezza n in O(n) passi.

Questo ragionamento ci ha portato ad usare la notazione Big-O introdotta nella sezione

precedente per dare una misura della complessità computazionale temporale dell’algoritmo.

Questa procedura può essere generalizzata allo studio dell’efficienza di qualunque algoritmo

e, negli esempi che seguono, mostreremo come usare tale misura e come sia possibile servirsi

della composizione delle funzioni per valutare la complessità generata da più procedure o

da procedure annidate.

Prendendo ad esempio l’algoritmo di ricerca lineare, all’interno del ciclo while vengono

effettuati due confronti: uno per verificare se si è arrivati alla fine della lista e l’altro per

confrontare x con un termine della lista. Successivamente viene eseguito un confronto fuori

dal ciclo. Considerando il caso peggiore, ovvero quello in cui l’elemento non è contenuto

nella lista, sono eseguiti 2n + 2 confronti e quindi la ricerca lineare richiede almeno O(n)

confronti.

Il tipo di analisi eseguita sull’algoritmo di ricerca lineare è del tipo worst case, ovvero

viene contato il massimo numero di operazioni necessarie per risolvere il nostro problema

dato un input fissato. Ovviamente, quest’analisi mostra quante operazioni sono necessarie

all’algoritmo, nel caso peggiore, per garantire che verrà prodotta una soluzione, ma nella

realtà possono esserne effettuate molte di meno. A titolo di esempio, si può notare che

l’algoritmo di ricerca lineare ha complessità proporzionale a n, ma se l’elemento da ricercare

è tra i primi nella lista, l’algoritmo termina con un numero di passi minore.

Analizziamo ora l’algoritmo di ricerca binaria e, per semplicità, supponiamo che la lista

28

Algoritmi

Complessità

O(1)

O(log n)

O(n)

O(n log n)

O(na )

O(an ), con a > 1

O(n!)

Terminologia

Complessità costante

Complessità logaritmica

Complessità lineare

Complessità n log n

Complessità polinomiale

Complessità esponenziale

Complessità fattoriale

Tabella 2.1: Terminologia comunemente usata per indicare la complessità degli algoritmi

sia composta da n = 2k elementi (e, quindi, k = log n). Notare che con questa ipotesi non

c’è perdita di generalità, perchè potremmo considerare la nostra lista originale come parte

di una lista più grande di 2k+1 elementi, dove 2k ≤ n ≤ 2k+1 . Ad ogni passo dell’algoritmo,

le variabili i e j sono confrontate per vedere se la lista ristretta ha più di un termine e, se

i < j, viene eseguito un confronto per determinare se x è maggiore del termine mediano

della lista in considerazione. Al primo passo, la ricerca è limitata a 2k−1 termini e vengono

effettuati due confronti; ad ogni passo successivo vengono eseguiti due confronti su di una

lista che è grande la metà di quella del passo precedente. Alla fine del ciclo while vengono

eseguiti due ulteriori confronti e quindi complessivamente saranno stati eseguiti al più 2k+2

confronti, ovvero 2 ⌊log n⌋ + 2 confronti. Quindi, l’algoritmo di ricerca binaria richiede al

più O(log n) confronti, e da ciò segue che tale algoritmo, a parità di input, è molto più

efficiente dell’algoritmo di ricerca lineare.

In Tabella 2.1 è riportata la terminologia comunemente usata per indicare la complessità

temporale degli algoritmi. La stima Big-O permette di valutare come il tempo necessario

per risolvere un problema cambi in funzione della dimensione dell’input. Tale stima però

non fornisce indicazioni sul tempo realmente necessario ad un computer per completare

l’elaborazione perchè non possiamo individuare un valore limite senza aver ricavato le

costanti C e k nell’equazione 2.1 ed inoltre perchè è difficile stimare il tempo richiesto per

completare una singola operazione. Comunque, possiamo tentare di fornire una misura

riconducendoci a delle stime sui tempi di operazione sui bit2 . Cosı̀ facendo, possiamo

2

Nel nostro caso si è assunto che il tempo di elaborazione di una operazione base su bit, eseguita su un

computer ad alte prestazioni, sia di 10−9 secondi.

29

Algoritmi

Dimensione

del problema

n

10

102

103

104

105

106

Numero di operazioni su bit eseguite

log n

3 · 10−9 sec

7 · 10−9 sec

1 · 10−8 sec

1.3 · 10−8 sec

1.7 · 10−8 sec

7 · 10−8 sec

n

10

10−7

10−6

10−5

10−4

10−3

−8

sec

sec

sec

sec

sec

sec

n log n

3 · 10−8 sec

7 · 10−7 sec

1 · 10−5 sec

1 · 10−4 sec

2 · 10−2 sec

3 · 10−2 sec

n2

2n

10 sec

10−5 sec

10−3 sec

10−1 sec

10 sec

17 min

10 sec

4 · 1013 anni

∗

∗

∗

∗

−7

−6

n!

3 · 10−3 sec

∗

∗

∗

∗

∗

Tabella 2.2: Tempo di calcolo usato dagli algoritmi

ottenere la Tabella 2.2 che riporta i tempi computazionali necessari a problemi con diverse

dimensioni di input, fornendo inoltre una indicazione sul numero di operazioni su bit. Gli

asterischi indicano tempi maggiori di 10100 anni.

La tabella riporta tempi computazionali che possono risultare impraticabili anche per

istanze piccole. Ci si potrebbe chiedere quale vantaggio si avrebbe con l’aumento delle prestazioni degli elaboratori. Dall’esempio seguente è facile convincersi che questa possibilità

non ha riscontro nella realtà.

Supponiamo di considerare due algoritmi, uno di complessità polinomiale O(n2 ) e l’altro

di complessità esponenziale O(2n ). Consideriamo ora un elaboratore che abbia velocità v1

e che ci permetta di risolvere in una data unità di tempo una istanza di dimensione n1 .

Immaginiamo ora di poter disporre di un elaboratore 100 volte più veloce (v2 = 100 · v1 );

considerando la complessità dell’algoritmo, si può affermare che esiste una proporzionalità

pari a n22 /n21 = v2 /v1 = 100 e quindi, con un rapido conto, si ottiene che è possibile risolvere

nello stesso tempo istanze con n2 = 10 · n1 , cioè 10 volte più grandi.

Applicando lo stesso ragionamento per l’algoritmo di complessità O(2n ), si ottiene,

con un elaboratore 100 volte più veloce, che 2n2 /2n1 = v2 /v1 = 100, ovvero che n2 =

n1 + log 100 ≈ n1 + 7, cioè posso risolvere istanze con solo 7 nodi in più!

Questo esempio ci mostra come il miglioramento delle capacità di elaborazione ha

purtroppo solo un impatto marginale nella efficienza degli algoritmi con complessità

esponenziale.

30

Algoritmi

2.5

Esercizi

Es. 2.5.1 Mostrare che l’algoritmo dell’Esempio 2.2.1 rispetta le Proprietà 2.2.1

Es. 2.5.2 Fornire una stima Big-O della seguente funzione: f (n) = n2 +

n

log n

log n!.

Es. 2.5.3 Fornire una stima Big-O della seguente funzione: f (n) = 13 + 23 + . . . + n3 .

Es. 2.5.4 Fornire una stima Big-O della seguente funzione: f (n) =

√

1+

√

2+...+

√

n.

Es. 2.5.5 Fornire una stima Big-O della seguente funzione: f (n) = log 2 + log 3 + . . . +

log n.

Es. 2.5.6 Dare una stima Big-O per f (n) = n2 (n log(n!) + n log n).

Es. 2.5.7 Dare una stima Big-O per f (n) = (log n)2 + log(n2 ).

Es. 2.5.8 Determinare la complessità computazionale associabile al seguente segmento di

codice (n << m):

while (j < m) do

begin

for i := 1 to m do

if a[i] < j then a[i] = j;

for i := 1 to n do

if a[i] < j then a[i] = j;

j = j + 1;

end

Es. 2.5.9 Determinare la complessità computazionale associabile al seguente segmento di

codice (m << n):

for i := 1 to m do

begin

Algoritmi

if a[i] < j then a[i] = j;

for i := 1 to n do

if a[i] < j then a[i] = j;

j = j + 1;

end

Es. 2.5.10

31

Capitolo 3

Proprietà e strutture dei grafi

3.1

Strutture dati per la rappresentazione di grafi

La performance di un algoritmo su grafo dipende non solo dall’algoritmo stesso, cosı̀ come

è stato descritto nella sezione precedente, ma anche dal modo con il quale il grafo viene

memorizzato e da come vengono gestiti gli aggiornamenti ed i risultati parziali.

Tipicamente, nella rappresentazione di un grafo occorre memorizzare due tipi di informazioni: la topologia dei nodi e degli archi, quindi eventuali grandezze da associare ai nodi

e agli archi stessi(queste informazioni saranno necessarie soprattutto per gli algoritmi che

approfondiremo nelle prossime sezioni).

Prima di introdurre le diverse tipologie di rappresentazione, si vuole estendere e generalizzare il concetto di grafo finora esposto al caso in cui gli archi siano orientati. La

definizione è simile alla Definizione 1.1.1:

Definizione 3.1.1 Un grafo orientato G è una tripla costituita da un insieme di vertici V (G) (detti anche nodi), un insieme di archi orientati E(G) e una relazione, detta

relazione di incidenza, che associa un vertice ad un altro.

Risulta chiaro allora che nel caso di grafi orientati non è più corretto affermare che

e = ab è la stessa cosa di scrivere e = ba, perché la relazione di incidenza è vera solo

in un verso. In ogni caso però, tutte le definizioni di walk, trail, path, ecc che abbiamo

32

33

Proprietà e strutture dei grafi

dato nel Capitolo 1, si estendono immediatamente al caso dei grafi orientati avendo cura

di considerare in modo stringente l’orientamento nelle varie tipologie di cammini (e cicli).

2

2

4

d

a

a

c

1

4

d

g

e

h

b

c

1

g

e

h

b

3

f

5

Figura 3.1: Grafo non orientato

3

f

5

Figura 3.2: Grafo orientato

Le rappresentazioni dei grafi che studieremo sono la matrice di incidenza, la matrice di

adiacenza e la lista di adiacenza.

Matrice di incidenza

La rappresentazione attraverso la matrice di incidenza di un grafo non orientato G di n

nodi ed m archi avviene attraverso una matrice A di dimensione n × m che contiene una

riga per ogni nodo del grafo ed una colonna per ogni arco. La colonna corrispondente

all’arco (i, j) ha soltanto due elementi diversi da zero in corrispondenza dei nodi i e j.

Prendendo il grafo disegnato in Figura 3.1, la sua matrice di incidenza corrispondente è:

1

1

A = 0

0

0

1 0 0 0 0 0 0

0 1 1 0 0 0 0

1 1 0 1 1 0 0

0 0 1 1 0 1 1

0 0 0 0 1 1 1

La matrice di incidenza ha una struttura tipica per cui solo 2m componenti, delle n×m,

sono diverse da zero ed uguali ad uno. È da notare che la somma degli elementi diversi da

zero in una riga eguaglia il grado del nodo corrispondente, ovvero:

34

Proprietà e strutture dei grafi

d(vi ) =

m

X

aij

j=1

dove chiaramente aij è l’elemento della riga i-esima e colonna j-esima.

Nel caso di un grafo orientato la matrice di incidenza si modifica considerando che per

l’h-esimo arco (i, j), nella colonna h corrispondente, l’elemento aih è uguale ad 1 mentre

l’elemento ajh è uguale a −1. Di conseguenza, per il grafo in Figura 3.2 la matrice è:

1

1

0

0

0

0

0

0

−1 0 −1 1

0

0

0

0

A = 0 −1 1

0

1

1

0

0

0

0

0 −1 −1 0 −1 1

0

0

0

0

0 −1 1 −1

La rappresentazione di un grafo tramite la matrice di incidenza è chiaramente non

efficiente a causa dello spazio necessario per la sua memorizzazione su un elaboratore, soprattutto al crescere di n e della densità. Nonostante ciò, questa rappresentazione è di

grande importanza perchè come vedremo nelle prossime sezioni, oltre a possedere interessanti proprietà teoriche, essa coincide con la matrice dei coefficienti della formulazione dei

problemi di flusso a costo minimo.

Matrice di adiacenza

La rappresentazione attraverso la matrice di adiacenza di un grafo non orientato G di n

nodi ed m archi avviene attraverso una matrice A di dimensione n × n dove ogni riga

ed ogni colonna corrispondono ai nodi e gli elementi della matrice aij sono o 0, se non

esiste l’arco (i, j) corrispondente, oppure sono uguali alla somma del numero di archi che

uniscono i nodi (i, j). Quindi, se riprendiamo l’esempio in Figura 3.1, la sua matrice di

adiacenza è:

35

Proprietà e strutture dei grafi

0

1

A = 1

0

0

1 1 0

0 1 1

1 0 1

1 1 0

0 1 2

0

0

1

2

0

La matrice di adiacenza per i grafi non orientati è simmetrica ed ha n2 elementi. Conseguentemente, questa rappresentazione è efficiente solo se il grafo è significativamente denso,

mentre per grafi sparsi si ha un notevole spreco di memoria.

Analizzando la matrice di adiacenza, si può contare il numero di archi incidenti sul

nodo i semplicemente sommando gli elementi della riga i-esima (quindi d(v5 ) = 3, pari alla

somma del contributo dell’arco adiacente al nodo 3 e dei due archi adiacenti al nodo 4).

Analogamente, il numero di archi incidenti su un nodo j si ottiene sommando gli elementi

della colonna j-esima. Da questo ne consegue che la somma di tutti gli elementi diversi da

zero della matrice di adiacenza è uguale a 2m.

Nel caso di grafi orientati, invece, la matrice di adiacenza perdela sua caratteristica di

simmetria e, per il grafo in Figura 3.2, diventa:

0

0

A = 0

0

0

1 1 0

0 0 1

1 0 1

0 0 0

0 0 1

0

0

1

1

0

Nella matrice di adiacenza nel caso di grafi orientati è possibile contare il numero di

archi uscenti da un nodo i (tale insieme è chiamato anche stella uscente) sommando gli

elementi della riga corrispondente, mentre il numero di archi entranti in un nodo i (tale

insieme è chiamato anche stella entrante) si ottiene sommando gli elementi della colonna

corrispondente. Da questo ne consegue che gli elementi diversi da zero sono uguali a m.

Proprietà e strutture dei grafi

36

Lista di adiacenza

La lista di adiacenza dei nodi A(i) di un grafo G con n nodi, è un vettore di dimensione n nel

quale ogni cella i punta una lista che contiene l’insieme dei nodi j tali per cui (i, j) ∈ E(G).

In Figura 3.3 è rappresentata la lista di adiacenza del grafo in Figura 3.2.

La lista di adiacenza di un grafo è molto utile quando, agli archi ed ai nodi, assoceremo dei numeri che ne rappresenteranno il costo, la lunghezza, ecc, come illustreremo

nei prossimi Capitoli. Infatti, mediante questa rappresentazione vedremo che sarà sufficiente aumentare, per ogni cella puntata dal nodo, i campi della lista corrispondente per

memorizzare tutte le informazioni necessarie.

Figura 3.3: Lista di adiacenza per il grafo di Figura 3.2.

3.2

Isomorfismo tra grafi

Osservando la matrice di adiacenza per i grafi non orientati, si può notare come si introduca

implicitamente un ordinamento dei vertici per riga. In realtà, quello che si vuole è ottenere

delle proprietà che non siano funzione di tale ordinamento. Intuitivamente, si può dire che

si vorrebbero trovare due diverse rappresentazioni matriciali del grafo G tali per cui siano

preservate le relazioni di adiacenza.

Definizione 3.2.1 Due grafi G = (V, E) e G′ = (V ′ , E ′ ) si dicono isomorfi, e si scrive

G∼

= G′ , se esiste una corrispondenza biunivoca tra i due insiemi di vertici, cioè se esiste

una biiezione Φ : V → V ′ tale che xy ∈ E ⇔ φ(x)φ(y) ∈ E ′ .

37

Proprietà e strutture dei grafi

Per esempio, se prendiamo le matrici di adiacenza dei due grafi G e G′ , rappresentati

in Figura 3.4, possiamo notare che è facile individuare una funzione biiettiva che mette in

corrispondenza i vertici dei due grafi e che le due matrici si trasformano l’una nell’altra

mediante permutazioni delle righe e delle colonne. Al lettore è lasciato per esercizio di

trascrivere le due matrici e di trovare la funzione Φ che permette di passare da una matrice

all’altra.

a

1

2

3

4

G′

G

d

b

c

Figura 3.4: Esempio di due grafi isomorfi

Dati due grafi generici G e H ci possiamo chiedere ora come verificare che siano tra

di loro isomorfi. Alcune condizioni necessarie possono essere facilmente individuate; per

esempio i due grafi devono avere stessi ordine e dimensione, oppure l’immagine di un vertice

i ∈ G deve avere in H lo stesso grado dell’immagine i ∈ H in G.

In generale però lo studio esaustivo delle permutazioni delle matrici di adiacenza di due

grafi di ordine n non costituisce un algoritmo molto efficiente, perchè questo avrebbe una

complessità computazionale di O(n!). Dato il grande interesse che il problema dell’isomorfismo tra grafi riveste nelle applicazioni pratiche, sono stati proposti molti algoritmi per

tentare di risolverlo, ma esso rimane ancora aperto, nel senso che non è ancora stato proposto un algoritmo efficiente ne si è riuscito a dimostrare che tale algoritmo possa esistere

oppure no [6].

Esempio 3.2.1 Siano assegnati i due grafi in Figura 3.5. Dimostrare che sono tra loro

isomorfi.

Sia definita la funzione Φ : V (G) → V (H) tale che φ(w) = a, φ(x) = c, φ(y) = b

e φ(z) = d. Per mostrare che Φ è un isomorfismo occorre analizzare se tali funzioni

38

Proprietà e strutture dei grafi

w

z

G

c

d

b

a

H

x

y

Figura 3.5: Due grafi isomorfi

preservino le adiacenze, e questo può essere testato riscrivendo la matrice A(G) in modo

che permutando righe e colonne si ottenga la matrice A(H).

Nel nostro caso si può notare come, permutando tra di loro la seconda e la terza colonna

di A(G) e poi la terza e la quarta (e la stessa cosa si fa per le righe), si ottiene la matrice

del grafo H, dimostrando quindi l’isomorfismo tra i due grafi. Per esteso:

0 1 0 0

0

1 0 1 0

0

A(G) =

→

0 1 0 1

0

0 0 1 0

1

0 0 1

0

0

0 1 1

→

0

1 0 0

1 0 0

1

0 0 1

0 1 1

= A(H)

1 0 0

1 0 0

Classi di isomorfismo

Il concetto di isomorfismo visto come “G e H sono isomorfi” ha un valore limitato se non

lo estendiamo all’applicazione su insiemi di grafi che siano tra loro isomorfi.

Ricordando che una relazione su un insieme I è una collezione di coppie ordinate

di suoi elementi e una relazione di equivalenza è una relazione riflessiva (a ∼

= a),

simmetrica (a ∼

=b⇔b∼

= a) e transitiva (a ∼

= b, b ∼

= c, ⇒ a ∼

= c), possiamo affermare che:

Proposizione 3.2.1 La relazione di isomorfismo è una relazione di equivalenza.

Dimostrazione: Lasciata per esercizio al lettore.

39

Proprietà e strutture dei grafi

Una relazione di equivalenza partiziona un insieme in classi di equivalenza e quindi

due elementi appartengono alla stessa classe se e solo se ricadono nella stessa classe di

equivalenza.

Definizione 3.2.2 Una classe di isomorfismo di grafi è una classe di equivalenza di grafi

sotto una relazione di isomorfismo.

Per esempio, i grafi completi Kn costituiscono delle classi di isomorfismo di grafi perchè,

prese due a due, rispettano le proprietà delle relazioni di equivalenza. Un’altra importante

classe di isomorfismo è costituita dai grafi bipartiti completi , ovvero quei grafi semplici

bipartiti tali che due vertici sono adiacenti se e soltanto se appartengono a partizioni

diverse. Se gli insiemi partizioni hanno dimensione p e q, il grafo bipartito completo è

indicato come Kp,q .

K2,3

K3,3

Figura 3.6: I grafi bipartiti completi K2,3 e K3,3 .

3.3

Connessione, cicli e grafi bipartiti

Nelle prossime definizioni ci dirigeremo verso le classi di equivalenza delle relazioni di