Anova e regressione

Andrea Onofri

Dipartimento di Scienze Agrarie ed Ambientali

Universitá degli Studi di Perugia

22 marzo 2011

Nella sperimentazione agronomica e biologica in genere è normale organizzare prove sperimentali replicate, anche per studiare l’effetto di una fattore

quantitativo su una variabile dipendente, anch’essa quantitativa.

In questa situazione, l’impiego di metodiche di confronto multiplo, se

non del tutto errato, è comunque da considerare ’improprio’. Infatti, l’inclusione di alcuni particolari livelli della variabile indipendente è frutto solo

delle esigenze organizzative, senza alcune interesse particolare per lo sperimentatore, che è invece interessato a capire come cresce/decresce/varia la

Y (variabile dipendente nel suo complesso) in funzione della X (variabile

indipendente) lla risposta della variabile dipendente nel suo complesso. In

sostanza lo sperimentatore è interessato a definire una funzione di risposta e

non a confronbtare tra loro la risposta a due particolari livelli di X.

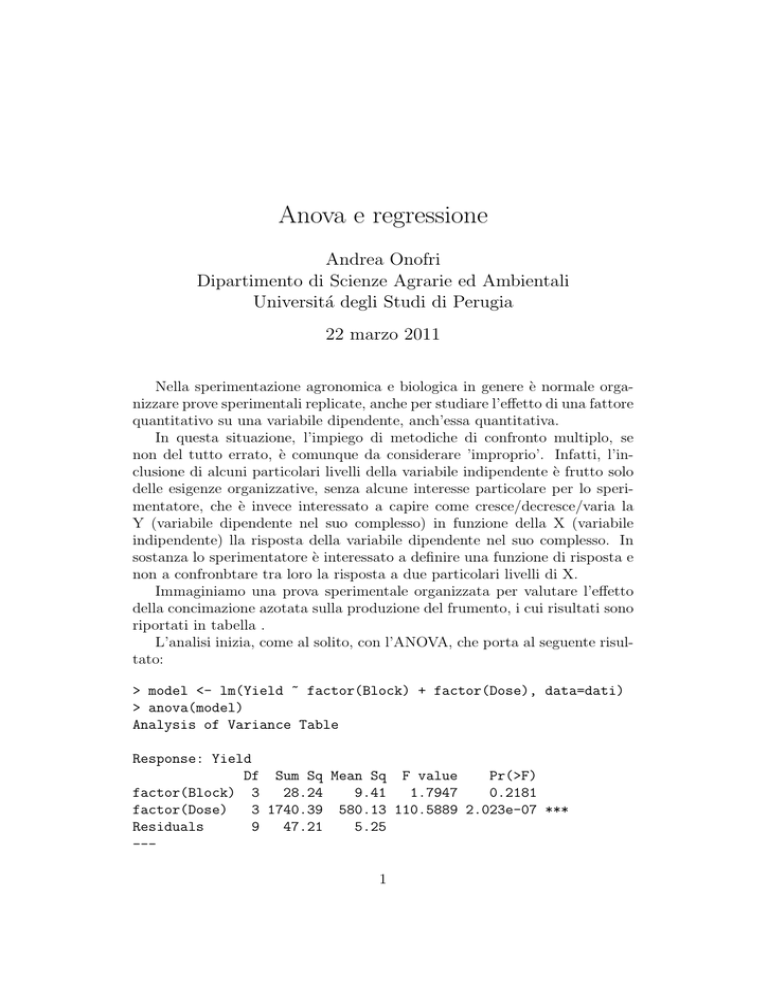

Immaginiamo una prova sperimentale organizzata per valutare l’effetto

della concimazione azotata sulla produzione del frumento, i cui risultati sono

riportati in tabella .

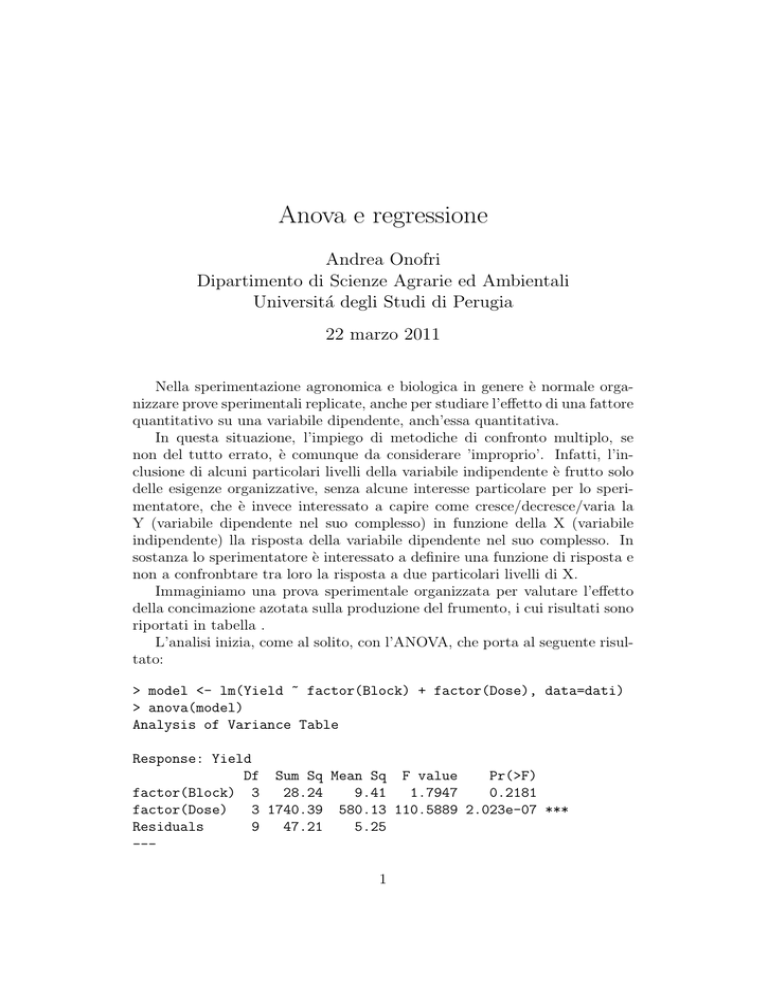

L’analisi inizia, come al solito, con l’ANOVA, che porta al seguente risultato:

> model <- lm(Yield ~ factor(Block) + factor(Dose), data=dati)

> anova(model)

Analysis of Variance Table

Response: Yield

Df Sum Sq Mean Sq F value

Pr(>F)

factor(Block) 3

28.24

9.41

1.7947

0.2181

factor(Dose)

3 1740.39 580.13 110.5889 2.023e-07 ***

Residuals

9

47.21

5.25

--1

2

>

Osserviamo che l’effetto del trattamento è significativo e il SEM è pari a

1.15. Prima di proseguire, verifichiamo che non ci sono problemi relativi alle

assunzioni parametriche di base e che, quindi, la trasformazione dei dati non

è necessaria.

N.

N.

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

Tabella 1: prova

Dose

Produzione

di azoto

frumento

180.00

53.62

180.00

55.78

180.00

51.55

180.00

52.64

120.00

42.30

120.00

42.88

120.00

44.53

120.00

37.84

60.00

34.46

60.00

34.09

60.00

31.84

60.00

34.51

0.00

25.46

0.00

26.47

0.00

28.35

0.00

20.22

Da questo momento in avanti, l’analisi non prosegue con un test di confronto multiplo (infatti quale senso avrebbe confrontare tra loro le risposte a

N0, N60, N120 e cosı̀ via?), ma con una analisi di regressione lineare, dalla

quale otteniamo le stime:

> model2 <- lm(Yield ~ Dose, data=dati)

> summary(model2)

Call:

lm(formula = Yield ~ Dose, data = dati)

Residuals:

Min

1Q

Median

3Q

Max

3

-5.3427 -0.8948

0.3903

1.1913

3.7633

Coefficients:

Estimate Std. Error t value Pr(>|t|)

(Intercept) 24.586750

1.041575

23.61 1.12e-12 ***

Dose

0.154967

0.009279

16.70 1.22e-10 ***

--Residual standard error: 2.49 on 14 degrees of freedom

Multiple R-squared: 0.9522,

Adjusted R-squared: 0.9488

F-statistic: 278.9 on 1 and 14 DF, p-value: 1.219e-10

In entrambi i casi, le stime sono buone, con bassi errori standard e

significativamente diverse da zero (test di t).

Figura 1: Risultati dell’analisi di regressione lineare

4

L’analisi di regressione appena eseguita (Fig. 1) mostra che una parte

dell’effetto del trattamento (ma solo una parte) è attribuibile alla dipendenza

lineare della Y (produzione) sulla X (dose). In effetti, se osserviamo l’ANOVA

della regressione vediamo che:

> model.regr anova(model.regr)

Analysis of Variance Table

Response: yield

Df Sum Sq Mean Sq F value

Pr(>F)

dose

1 1729.50 1729.50 278.73 1.225e-10 ***

Residuals 14

86.87

6.20

--Signif. codes: 0 ’***’ 0.001 ’**’ 0.01 ’*’ 0.05 ’.’ 0.1 ’ ’ 1

>

Se dal residuo della regressione togliamo l’effetto del blocco (che la regressione non considera esplicitamente) otteniamo 58.63 (86.87 - 28.24), con

11 gradi di libertà), che rappresenta l’errore della regressione.

Possiamo notare che l’errore della regressione è più alto di quello dell’analisi della varianza, dato che il residuo dell’ANOVA contiene solo la misura

dello scostamento di ogni dato rispetto alla media del suo gruppo, che si può

considerare ’errore puro’, mentre il residuo della regressione, oltre all’errore

puro, contiene anche una componente aggiuntiva detta appunto ’mancanza

di adattamento’ e legata al fatto che la regressione lineare è solo un’approssimazione della reale relazione biologica tra la concimazione e il suo effetto

sulla produzione del frumento. Se infatti la regressione fosse perfetta, le medie osservate giacerebbero sulla retta di regressione e la devianza spiegata

dalla regressione sarebbe identica a quella spiegata dall’ANOVA.

La quota di devianza attribuibile alla mancanza d’adattamento può essere

quindi ottenuta per differenza tra il residuo della regressione e il residuo

dell’ANOVA (58.63 - 47.21 = 11.42). Questa devianza ha un numero di gradi

di libertà pari ancora alla differenza tra quelli del residuo della regressione e

quelli del residuo dell’ANOVA (11 - 9 = 2).

Una volta calcolata la varianza legata alla mancanza d’adattamento (11.42/2

= 5.71), questa può essere confrontata con l’errore puro (appunto dato dalla

varianza del residuo dell’ANOVA) tramite test F (5.71/5.25 = 1.09); dato che

il test non è significativo, non vi è mancanza d’ adattamento e la regressione

fornisce una descrizione adeguata dei dati sperimentali.

In caso contrario (test F significativo) il modello non è adeguato e non

rappresenta quindi i dati sperimentali. Inoltre la devianza residua della regressione è una stima distorta della devianza d’ errore, perché contiene sia la

5

componente random (errore sperimentale) che quella sistematica (deviazione

dalla regressione).

In conclusione, organizzare prove replicate anche in caso di analisi di

regressione è positivo, in quanto ci consente un’ulteriore test per verificare la

bontà dell’adattamento, cioè il test F per la mancanza d’adattamento. Da

un punto di vista pratico, è sufficiente eseguire separatamente l’ANOVA per

calcolare l’errore sperimentale puro e poi l’analisi di regressione, ottenendo

per differenza la quota di devianza attribuibile alla mancanza d’adattamento,

e la relativa varianza, da confrontare poi con la varianza dell’errore puro

nell’ANOVA