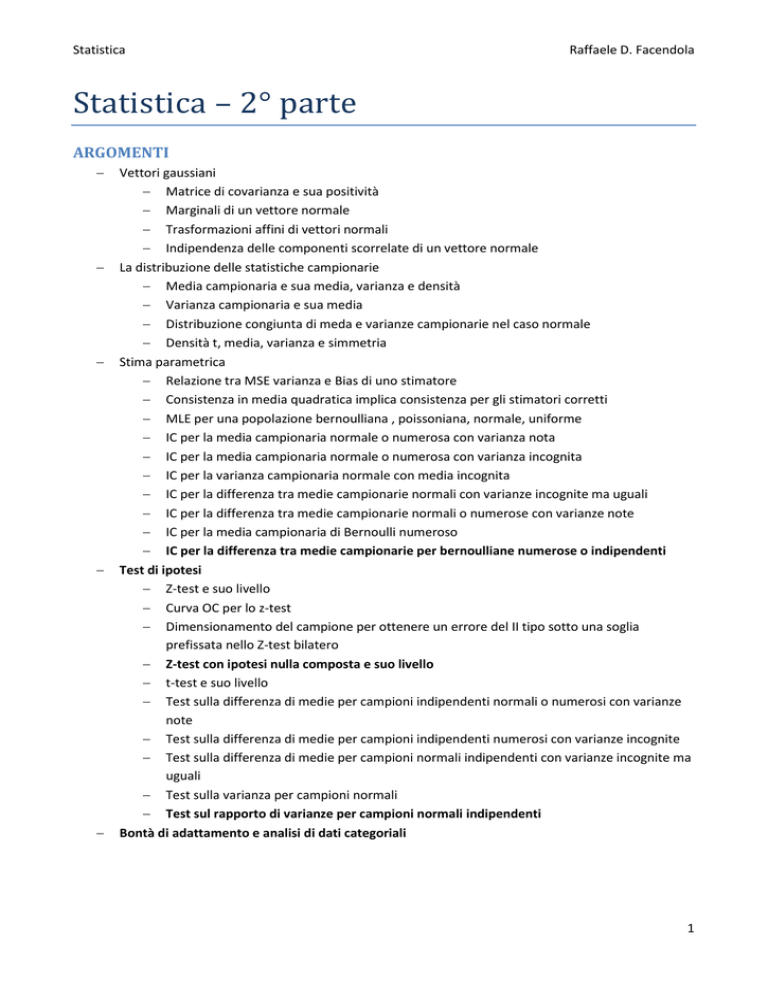

Statistica

Raffaele D. Facendola

Statistica – 2° parte

ARGOMENTI

Vettori gaussiani

Matrice di covarianza e sua positività

Marginali di un vettore normale

Trasformazioni affini di vettori normali

Indipendenza delle componenti scorrelate di un vettore normale

La distribuzione delle statistiche campionarie

Media campionaria e sua media, varianza e densità

Varianza campionaria e sua media

Distribuzione congiunta di meda e varianze campionarie nel caso normale

Densità t, media, varianza e simmetria

Stima parametrica

Relazione tra MSE varianza e Bias di uno stimatore

Consistenza in media quadratica implica consistenza per gli stimatori corretti

MLE per una popolazione bernoulliana , poissoniana, normale, uniforme

IC per la media campionaria normale o numerosa con varianza nota

IC per la media campionaria normale o numerosa con varianza incognita

IC per la varianza campionaria normale con media incognita

IC per la differenza tra medie campionarie normali con varianze incognite ma uguali

IC per la differenza tra medie campionarie normali o numerose con varianze note

IC per la media campionaria di Bernoulli numeroso

IC per la differenza tra medie campionarie per bernoulliane numerose o indipendenti

Test di ipotesi

Z-test e suo livello

Curva OC per lo z-test

Dimensionamento del campione per ottenere un errore del II tipo sotto una soglia

prefissata nello Z-test bilatero

Z-test con ipotesi nulla composta e suo livello

t-test e suo livello

Test sulla differenza di medie per campioni indipendenti normali o numerosi con varianze

note

Test sulla differenza di medie per campioni indipendenti numerosi con varianze incognite

Test sulla differenza di medie per campioni normali indipendenti con varianze incognite ma

uguali

Test sulla varianza per campioni normali

Test sul rapporto di varianze per campioni normali indipendenti

Bontà di adattamento e analisi di dati categoriali

1

Statistica

Raffaele D. Facendola

Vettori gaussiani

Si definisce vettore gaussiano standard n-dimensionale (o n-variato) un vettore costituito da n elementi in

cui i singoli elementi sono variabili aleatorie gaussiane standard indipendenti:

La densità di probabilità di tale vettore è definita come:

∑

Il vettore delle medie è pari al vettore nullo, mentre la matrice di covarianza (in virtù dell’indipendenza

delle singole variabili aleatorie) è data dalla matrice identità di ordine n.

Consideriamo un vettore aleatorio gaussiano X funzione lineare di Z:

X è vettore gaussiano se la funzione lineare in Z è definita come:

Con A matrice (n x m),

e Z vettore gaussiano standard m-dimensionale.

Il valore atteso di X è , questo perchè quello di Z è proprio 0, mentre la matrice di covarianza di X è

.

Matrice di covarianza e sua positività

Un vettore gaussiano defito come sopra ha densità su

non è singolare (ha determinante diverso da 0).

se e solo se la matrice di covarianza

In queso caso la densità di tale vettore è data da:

√

Se, inoltre, C risulta simmetrica e definita positiva allora la densità di Z sarà pari a:

√

Marginali di un vettore normale

Se

(cella di coordinate (i; i)) allora la componente i-esima

, se

, invece,

La dimostrazione è ovvia in quanto ogni può essere espressa come combinazione lineare di variabili

aleatorie gaussiane indipendenti più una certa costante.

2

Statistica

Raffaele D. Facendola

Trasformazioni affini di vettori normali

Sia G una matrice (k x n) e

, è possibile definire una nuovo vettore gaussiano

vettore delle medie

e matrice di covarianza pari a

.

La dimostrazione è immediata, basta considerare

La media è il vettore

con

.

, mentre sfruttando la definzione di covarianza otteniamo che la covarianza è

.

Indipendenza delle componenti scorrelate di un vettore normale

Se

scorrelate allora esse sono anche indipendenti.

Se

sono scorrelate allora la matrice di covarianza di X è matrice diagonale in cui l’elemento

uguale alle varianze

relative al vettore e pertanto la densità è:

è

√

∑

(

)

√

(

∏

)

√

∏

E ciò dimostra, pertanto, che esse sono anche indipendenti.

3

Statistica

Raffaele D. Facendola

La distribuzione delle statistiche campionarie

Dicesi campione o campione aleatorio un insieme di n variabili indipendenti tutte con la stessa

distribuzione F.

Media campionaria e sua media, varianza e densità

Definiamo media campionaria:

Con

variabile aleatoria di media

e varianza

.

Il suo valore atteso è pari a :

[ ]

La sua varianza sarà pari a

( )

[

]

[

]

[

]

:

(

*

Se n è un numero abbastanza grande vale la seguente approssimazione:

√

Dove

e

è la funzione di ripartizione della normale standard.

NB: Partendo dalla definizione di media campionaria e ponendo in evidenza otteniamo che:

∑

Consideriamo che il prodotto di una costante per una V.A. normale è ancora normale, pertanto si può

concludere che

è approssimativamente gaussiana da cui si ha che:

√

4

Statistica

Raffaele D. Facendola

Varianza campionaria e sua media

Sia

un campione aleatorio di una distibuzione di media

campionaria:

e varianza

e sia

la sua media

Definiamo varianza campionaria la seguente statistica:

∑(

)

La sua radice, ovvero S, prende il nome di deviazione standard campionaria.

Il valore atteso della varianza campionaria è pari a:

[

]

Dimostrazione:

Consideriamo che per una n-upla di numeri

∑

(dove

vale la seguente proprietà:

∑

è la media del campione)

Applicando la proprietà alla varianza campionaria otteniamo che:

∑

[

[

]

]

[∑

[

]

(la media è uguale per ogni V.A)

(applicando la definizione di varianza [

[ ]

[

]

]

( )

]

[ ] )

[ ]

Da cui

[

]

5

Statistica

Raffaele D. Facendola

Distribuzione congiunta di meda e varianze campionarie nel caso normale

Sia

un campione di una distibuzione normale di media

indipendenti.

e varianza

, allora

e

sonoV.A.

Inoltre vale la seguente proprietà:

Densità t, media, varianza e simmetria

Si consideri il campione precedente in cui però la distribuzione risulta gaussiana.

Per le condizioni di cui sopra vale:

√

6

Statistica

Raffaele D. Facendola

Stima parametrica

Si dice stimatore di una qualsiasi statistica (variabile aleatoria) in grado di dire qualcosa (fare inferenza)

circa un parametro incognito (la media, la varianza, ecc.). Il valore deterministico di uno stimatore

indicato con ̂ si dice invece stima di .

Stimatori di massima verosimiglianza

Sia dato un campione di n variabili aleatorie

e definiamo una funzione di massa o densità

congiunta

dipendente dal parametro incognito .

La strategia in questo caso consiste nell’individuare quel valore di che rende massima la funzione sopra

definita quando i dati osservati sono

. La funzione è detta funzione di likelihood

(verosomiglianza ndr).

Spesso si ricorre alla funzione di log-likelihood definita come

questo perchè, essendo il

logaritmo naturale funzione strettamente crescente, la funzione di likelihood e quella di log-likelihood

assumono il massimo per lo stesso valore di .

Uno stimatore individuato con la strategia di cui sopra si chiama stimatore di massima verosimiglianza o

MLE (maximum likelihood estimator).

MLE per una popolazione bernoulliana , poissoniana, normale, uniforme

-MLE della media di una bernoulliana

Supponiamo di realizzare n prove indipendenti ciascuna delle queli ha una probabilità p di successo.

Consideriamo che nel caso di popolazioni bernoulliane la funzione di massa è

La likelihood del campione è data da:

Sfruttando la funzione di log likelihood e alcune proprietà dei logaritmo otteniamo:

(

)

∑

∑

Per massimizzare la suddetta funzione basta derivare rispetto a p:

(

)

∑

∑

Poniamo il primo termine pari a zero e portiamo il termine negativo dall’altra parte; risolvendo rispetto a p

otteniamo:

∑

∑

∑

Il che è lo stimatore di massima verosimiglianza di una distribuzione di Bernoulli in cui la media è incognita.

7

Statistica

Raffaele D. Facendola

-MLE del parametro di una poissoniana

Siano

variabili aleatorie di Poisson indipendenti, ciascuna della queli con valore atteso .

La funzione di likelihood è data da:

La funzione di log-likelihood è, invece, pari a :

(

∑

)

⏟

Derivando rispetto a otteniamo:

(

∑

)

Massimizzando la funzione otteniamo pertanto la MLE del parametro :

∑

-MLE per una distribuzione normale

Siano

variabili aleatoria normali ed indipendenti, con media

e varianza

incognite.

La funzione di likelihood è:

∏

(

√

* (

∑

*

La log-likelihood è:

(

)

( )

∑

Per individuare contemporaneamente le stime della media e della varianza che massimizzano la loglikelihood occorre porre le due derivate parziali pari a zero e mettere il tutto a sistema:

8

Statistica

Raffaele D. Facendola

(

{

∑

)

(

∑

)

∑

∑

∑

{

∑

{

-MLE per la media di una distribuzione uniforme

Sia

un campione proveniente da una distribuzione uniforme sull’intervallo

incognito.

con

parametro

La densità congiunta è data da:

{

La funzione di cui sopra viene massimizzata scegliendo un valore di quanto più piccolo è possibile,

tuttavia siccome deve essere più grande di tutti i valori osservati ne segue che è

.

Il MLE della sua media è dato da

.

Relazione tra MSE varianza e Bias di uno stimatore

Sia X un campione casuale estratto da una popolazione con parametri noti eccetto un parametro incognito

e sia

uno stimatore di .

Definiamo errore quadratico medio o MSE (mean square error) il seguente:

[

]

Definiamo distorsione di d o bias il seguente indicatore:

[

]

Se il bias è nullo allora lo stimatore d è corretto o non distorto. Se il bias si annulla per n molto grande

allora diremo che lo stimatore d è asintitocamente corretto.

Se

è uno stimatore corretto allora il suo MSE è:

[

]

[

[ ] ]

Da cui si ricava la seguente relazione tra MSE, varianza e Bias:

[

]

[

[

[

[ ]

[ ]

[ ] ]

[

[ ]

[ ]

[ ]

]

]

[ ]

[

[ ]]

[ ]

]

[ [ ]

]

9

Statistica

Raffaele D. Facendola

Consistenza in media quadratica implica consistenza per gli stimatori corretti

Sia

uno stimatore di

parametro incognito. Diremo che

è consistente in media quadratica se

.

è consistente se

Se lo stimatore

è corretto e consistente in media quadratica allora esso è anche consistente.

Intervallo di confidenza (IC)

Con riferimento agli stimatori puntuali trattati in precedenza bisogna precisare che il valore ottenuto con il

metodo della massima verosimiglianza non indica il valore preciso assunto dal parametro, ma, bensì, un

valore vicino a quello reale. Rispetto ad uno stimatore puntuale un intervallo di confidenza ci fornisce un

intervallo di valori per il quale sappiamo che il parametro incognito vi appartiene con un certo grado di

fiducia (o confidenza).

IC per la media campionaria normale o numerosa con varianza nota

Sia

varianza

un campione di una popolazione condistribuzione normale di cui la media

sia nota.

sia incognita e la

Ricordiamo che:

√

Da cui:

(

)

√

(

(

√

√

√

√

L’intervallo che garantisce un livello di confidenza pari a

[

√

)

)

su

√

è pertanto:

]

10

Statistica

Raffaele D. Facendola

IC per la media campionaria normale o numerosa con varianza incognita

Sia

un campione di una popolazione

i cui parametri sono entrambi ignoti. La richiesta è

quella di costruire un intervallo di confidenza per ad un livello di

(vogliamo cioè sapere qual’è

l’intervallo di valori che garantisce con una confidenza

che il valore cada vi appartenga).

Prendendo in considerazione il paragrafo “Densità t, media, varianza e simmetria” del capitolo “La

distribuzione delle statistiche campionarie” consideriamo che:

√

Visto che la densità delle distribuzioni è simmetrica rispetto a 0 per

(

sappiamo che:

)

√

Da cui

(

L’intervallo trovato [

√

√

√

√

*

] è l’intervallo che soddisfa con un livello di confidenza

la richiesta di cui sopra.

IC per la varianza campionaria normale con media incognita

Sia

un campione proveniente da una distribuzione normale con parametri

e

incogniti.

Consideriamo che

Da cui, per le considerazioni del paragrafo precedente, si ha che:

(

)

(

L’intervallo appena trovato rappresenta l’intervallo di confidenza (bilaterale) per

confidenza di

.

)

ad un livello di

11

Statistica

Raffaele D. Facendola

IC per la differenza tra medie campionarie normali con varianze incognite ma

uguali

Siano

entrambe .

e

due campioni indipendenti in cui le varianze sono incognite ma uguali e valgono

Sappiamo che:

Inoltre sappiamo che visto che i due campioni sono indipendenti, anche le chi-quadro precedenti sono

indipendenti, così come la loro somma:

Ricordiamo che:

√

e che il rapporto tra una normale standard e una √

è per definizione una distribuzione di tipo t con

k gradi di libertà.

Sia definita

come:

Dividiamo la (1) per la (2) sostituendo al posto di

(√

al fine di ottenere una t di Student:

)

√

√

Da ciò possiamo determinare gli intervalli di confidenza per

, infatti:

√

E quindi

√

12

Statistica

Raffaele D. Facendola

IC per la differenza tra medie campionarie normali o numerose con varianze

note

Siano

e

due campioni indipendenti in cui le varianze sono note ma la media no.

Possiamo mutuare la tecnica illustrata nel paragrafo precedente considerando che non abbiamo bisogno,

però, della varianza campionaria in quanto sappiamo già qual’è il suo valore reale (ovvero

.

L’intervallo che ci garantisce un livello di confidenza su

di

è pertanto:

√

[

√

]

IC per la media campionaria di Bernoulli numeroso

Consideriamo una popolazione in cui ogni elemento possiede certi requisiti indipendentemente dagli altri

con una probabilità incognità p.

Se X è una variabile aleatoria che descrive quanti oggetti sugli n testati soddisfano i requisiti di interesse e

nel caso in cui n sia un numero elevato, potremo dire che X approssima una normale con media

e

varianza

e pertanto:

√

Perso un qualsiasi valore

allora sappiamo che:

(

)

√

Tuttavia l’approssimazione di cui sopra non è un vero intervallo di confidenza.

Imponiamo che sia ̂

la frazione degli oggetti che soddisfano i requisiti (in questo caso si tratta proprio

del MLE di p) e da ciò ricaviamo che √ ̂

̂ è circa uguale a √

. Alla luce di queste

considerazioni e dell’approssimazione poco sopra possiamo concludere che:

̂

√

̂

̂

̂

√

̂

̂

IC per la differenza tra medie campionarie per bernoulliane numerose o

indipendenti

13

Statistica

Raffaele D. Facendola

Test di ipotesi

Supponiamo di disporre di un campione aleatorio proveniente da una distribuzione nota a meno di alcuni

parametri incogniti. Il nuovo obiettivo non è quello di stimare i parametri incogniti ma, bensì, quello di

verificare se la distribuzione soddisfa una certa ipotesi sulla base dei soli dati provenienti dal campione.

Si parla di ipotesi in quanto non c’è modo di sapere se essa sia vera o falsa.

Supponiamo di voler verificare qualche ipotesi

(chiamata ipotesi nulla) su un certo campione circa un

parametro incognito : se l’ipotesi caratterizza completamente la distribuzione (un’ipotesi potrebbe essere

che valga esattamente 1) allora essa verrà chiamata ipotesi semplice, in caso contrario ( è compreso in

un certo intervallo, è minore o maggiore di una soglia, e via dicendo) diremo che l’ipotesi è composta.

Chiamiamo regione critica la regione di spazio n-dimensionale (con n numero degli elementi del campione)

per il quale l’ipotesi nulla è falsa al verificarsi di certe condizioni per il campione.

A prescindere dalla metodologia applicata va necessariamente ricordato che è possibile sbagliare il risultato

del test secondo due diverse modalità: la prima ci porta a rifiutare l’ipotesi che in realtà è corretta (errore

di I specie), mentre la seconda ci porta ad accettare l’ipotesi che in realtà è errata (errore di II specie).

Definiamo livello di significatività il valore percentuale

specie sia inferiore ad esso.

tale che la probabilità di effettuare un errore di I

14

Statistica

Raffaele D. Facendola

Z-test e suo livello

Sia

un campione aleatorio proveniente da una distribuzione normale con

Vogliamo verificare l’ipotesi nulla:

incognito e

contro l’ipotesi alternativa

noto.

.

La regione critica è:

con media campionaria (lo stimatore naturale della

|

|

media e c costante. In questo caso la strategia è quella di scartare l’ipotesi qualora la differenza tra la media

campionaria ed il valore testato sia superiore ad una certa costante c.

Utilizzando la definizione di livello di significatività

sappiamo pertanto che

|

|

Sappiamo che:

√

Da cui:

|

|

√

√

(

)

√

(

√

)

√

Si dedice pertanto che

√

, ovvero

√

.

sarà accettata se |

Alla luce di quanto detto sopra concluderemo dicendo che l’ipotesi

|

,

√

mentre sarà rifiutata in caso contraio.

Curva OC per lo z-test

Definiamo curva operativa caratteristica (OC) per il test di una distribuzione di tipo Z la funzione

definita come:

(|

|

)

√

√

Ques’ultima rappresenta la probabilità di accettare l’ipotesi nulla quando la media reale vale .

(

)

√

(

)

√

√

(

)

√

√

√

(

√

)

√

(

)

√

15

Statistica

Raffaele D. Facendola

Dimensionamento del campione per ottenere un errore del II tipo sotto una

soglia prefissata nello Z-test bilatero

La funzione

è chiamata funzione di potenza del test ed indica la probabilità di rifiutare

(correttamente) l’ipotesi nulla quando è il valore reale.

La curva di OC ci permette di determinare qual’è la dimensione ottimale del campione affinchè la

probabilità di ottenere un errore del II tipo sia inferiore ad una certa soglia.

Supponiamo di voler individuare qual’è il valore di n per il quale la probabilità di accettare

quando in realtà il valore reale è sia circa uguale ad un valore prefissato, vogliamo cioè n tale che

(

Usando la definizione di curva di OC otteniamo:

)

√

(

)

. (1)

√

La risoluzione rispetto a n è piuttosto complessa, tuttavia una buona approssimazione è data da:

(

*

[

]

NB: Tale approssimazione è valida in quanto o il primo termine o il secondo termine della sottrazione delle

funzioni tendono a zero rispettivamente se

o se

.

Z-test con ipotesi nulla composta e suo livello

16

Statistica

Raffaele D. Facendola

t-test e suo livello

Sia

un campione aleatorio proveniente da una distribuzione normale con

Vogliamo verificare l’ipotesi nulla:

contro l’ipotesi alternativa

e

incogniti.

.

Facendo riferimento allo z-test possiamo pensare di rifiutare ragionevolmente l’ipotesi qualora valga la

seguente: |

|

.

√

La disequazione di cui sopra non può aiutarci però in quanto non conosciamo il valore , tuttavia possiamo

pensare di sostituirla con il suo stimatore, ovvero la deviazione standard campionaria S:

√

∑(

Da cui deduciamo che l’ipotesi nulla va rifiutata per |

)

| troppo grande.

√

Sappiamo che

√

A questo punto poniamo le condizioni di base del livello di significatività del test:

Concludiamo perciò che l’ipotesi

verrà accettata se |

|

e rifiutata in caso contrario.

√

17

Statistica

Raffaele D. Facendola

Test sulla differenza di medie per campioni indipendenti normali o numerosi

con varianze note

Supponiamo che

e

differenti di medie incognite

e

siano campioni indipendenti provenienti da due popolazioni

e varianze note

e .

Vogliamo verificare l’ipotesi:

contro

.

Giacchè le medie campionarie sono stimatori naturali per le rispettive medie delle distribuzioni, è naturale

concludere che la differenza delle medie campionarie sia stimatore della differenza delle medie.

Riscrivendo l’ipotesi

opportuno di c.

si accetta

se

e si rifiuta in caso contrario per un valore

√

Se

è vera la differenza delle medie è zero e pertanto si ha:

(

Conveniamo alla conclusione che

√

)

viene rifiutata se

, accettata in caso contrario.

√

Test sulla differenza di medie per campioni indipendenti numerosi con varianze

incognite

Le ipotesi di questo genere di test sono le stesse del paragrafo precedente, tuttavia questa volta le varianze

non sono note. E’ possibile usare lo stesso modus operandi adottato in precedenza sostituendo al valore

preciso delle varianze il valore del loro stimatore ottenendo che

viene rifiutata se

, accettata

√

in caso contrario.

18

Statistica

Raffaele D. Facendola

Test sulla differenza di medie per campioni normali indipendenti con varianze

incognite ma uguali

Supponiamo che

differenti normali

varianze sono uguali.

e

siano campioni indipendenti provenienti da due popolazioni

delle quali non si conoscono i parametri ma si sa che le due

e

Vogliamo verificare che

contro

Ricordiamo che

√

Dove

è lo stimatore pooled di

:

Quando l’ipotesi è vera allora la statistica

allora

√

e quindi possiamo concludere che se

può essere rifiutato, altrimenti può essere accettato in caso contrario.

Test sulla varianza per campioni normali

Sia

un campione proveniente da una distribuzione normale con media incognita e varianza

incognita

e supponiamo di voler verificare l’ipotesi nulla

contro

per un valore

di

fissato.

Ricordiamo che:

Da cui:

(

Concludiamo accettando

qualora

)

e rifiutandola in tutti gli altri.

Test sul rapporto di varianze per campioni normali indipendenti

19

Statistica

Raffaele D. Facendola

Bontà di adattamento e analisi di dati categoriali

20