Distribuzioni di probabilità

Introduzione

• Fino ad ora abbiamo studiato una specifica funzione densità di probabilità,

la funzione di Gauss, che descrive variabili date dalla somma di molti termini

indipendenti (es. una misura affetta da errori casuali).

Abbiamo fatto anche l’esempio di una funzione densità di probabilità

uniforme in un intervallo.

• Ora vediamo due funzioni densità di probabilità (rispettivamente dette di

Bernoulli e di Poisson) che descrivono fenomeni i cui risultati sono di tipo

discreto (come opposto a continuo) e pertanto vengono dette distribuzioni di

probabiltà (invece che funzioni). La loro rappresentazione grafica è un

insieme di punti o un istogramma (invece che una curva continua).

• Per ricavare la forma specifica di ciascuna distribuzione useremo le leggi

della probabilità studiate nella lezione 3: la legge della probabilità totale e la

legge della probabilità composta.

Marta Calvi 2010

Lezione 10, pag. 1

Distribuzione di probabilità Binomiale ( o di Bernoulli)

Definizione

La distribuzione binomiale descrive i processi caratterizzati da:

un numero di prove identiche fissato e finito ( n ),

ciascuna prova ha due soli possibili risultati (successo o insuccesso),

il successo ha probabilità costante di verificarsi ( p ).

La distrubuzione binomiale fornisce quindi la probabilità di ottenere v

successi su n prove identiche, nota la probabilità p di successo ad ogni

prova: Bn,p( ) con 0 ≤ v ≤ n.

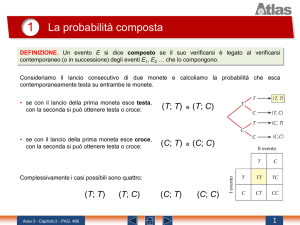

Partiamo con un esempio: si cerca la probabilità di ottenere un certo numero

di teste nel lancio di 4 monete.

Marta Calvi 2010

Lezione 10, pag. 2

Esempio: Cerchiamo la probabilità di ottenere 0,1,2,3,4 teste su 4 monete.

Probabilità di ottenere testa pt= 0.5

Probabilità di ottenere croce pc= 1- pt = 0.5

I possibili risultati sono:

0 teste (quindi 4 croci)

Poiché gli eventi sono statisticamente indipendenti, la probabilità composta

è data dal prodotto delle probabilità: P(0)= pc·pc·pc·pc = 0.54 = 0.0625

1 testa (quindi 3 croci)

Questo evento può verificarsi in diverse modalità, in ciascun caso la

probabilità composta è data dal prodotto delle probabilità:

(testa)(croce)(croce)(croce)

(croce)(testa)(croce)(croce)

(croce)(croce)(testa)(croce)

(croce)(croce)(croce)(testa)

pt·pc·pc·pc = 0.54

pc·pt·pc·pc = 0.54

pc·pc·pt·pc = 0.54

pc·pc·pc·pt = 0.54

La probabilità totale si ottiene come somma delle probabilità di ciascuna

modalità (essendo queste mutuamente esclusive), pertanto:

P(1)= 0.54+0.54+0.54+0.54 = 0.25

Marta Calvi 2010

Lezione 10, pag. 3

2 teste (quindi 2 croci)

Si vede facilmente che questo evento può verificarsi in sei diverse modalità,

pertanto: P(2)= 0.54 + 0.54 + 0.54 + 0.54 + 0.54 + 0.54 = 0.375

3 teste (quindi 1 croce)

Poichè pt= pc il risultato è lo stesso che nel caso di 1 testa e 3 croci:

P(3)= 4x 0.54 = 0.25

4 teste (quindi 0 croci)

Come per 0 teste e 4 croci:

P(4)= 0.54 = 0.0625

Abbiamo costruito la distribuzione di probabilità per il numero di teste

ottenute nel lancio di 4 monete. Possiamo disegnare un istogramma:

P( )

Osserviamo che

P(0)+P(1)+P(2)+P(3)+P(4) = 1

0 1 2 3 4

Marta Calvi 2010

Lezione 10, pag. 4

Ricaviamo ora la forma generale della distribuzione di

probabilità Binomiale

• Consideriamo un evento casuale E ripetibile, che abbia probabilità di

verificarsi (successo) ad ogni prova p costante ( indipendente dal verificarsi

o meno di E nella prova precedente o successiva).

• La probabilità che si verifichi l’evento complementare (insuccesso) E è

p = q.

• Voglio calcolare la probabilità dell’ evento complesso costituito dal

verificarsi E esattamente volte su n prove (0 ≤ v ≤ n).

L’evento complementare E si verificherà quindi n

volte.

Essendo le prove statisticamente indipendenti, la probabilità composta è

data dal prodotto delle probabilità di ciascuna prova: p ·(

p)n

Marta Calvi 2010

Lezione 10, pag. 5

•Tale evento complesso può verificarsi in diversi modi, mutuamente esclusivi,

corrispondenti a tutte le diverse sequenze possibili di successi ed insuccessi

(E,E,E …) . Per avere la probabilità totale devo quindi sommare le probabilità

di ciascuno di questi modi.

Essendo tali probabilità tutte uguali, basta moltiplicare la probabilità trovata

per il numero di modi. Questo è dato dal numero di combinazioni di oggetti

scelti tra n, che è:

n

n!

!(n

)!

In definitiva la probabilità cercata risultata data da:

Bn, p ( )

n

p (1 p)

n

n!

p (1 p) n

!(n )!

probabilità di ottenere n

probabilità di ottenere

insuccessi

successi

numero di modi in cui successi

e insuccessi possono presentarsi

Marta Calvi 2010

Lezione 10, pag. 6

Proprietà della distribuzione binomiale

n

Bn , p ( ) 1

1. Normalizzazione

0

n

n

Bn , p ( )

0

0

n!

p (1 p ) n

!( n

)!

[ p (1 p )] n

n

Essendo lo sviluppo di un binomio proprio: [ p q ]

n

0

1

n!

p qn

!( n

)!

2. Valore medio di

n

n

Bn, p ( )

0

0

n

np

1

(

(n 1)!

p

1)!(n )!

np( p 1 p) n

np

Marta Calvi 2010

n

n!

p (1 p) n

!(n )!

np

1

n

1

(1 p)

n

np

0

'

n'

n!

p (1 p) n

!(n )!

n!

!( n

' n

)!

n'

p (1 p) n

n

Lezione 10, pag. 7

3. Deviazione standard (dispersione attorno il valor medio)

n

2

) 2 Bn , p ( )

(

np(1 p )

0

Per dimostrarlo utilizziamo l’uguaglianza:

2

2

2

(

2

)

2

2

n

n

(

2

n

) Bn , p ( )

(

0

1) Bn , p ( )

2

n

pnp(n 1)

(

1)

2

n

2

p n(n 1)

2

n

2

p n(n 1)

0

(

p 2 n(n 1)( p 1 p ) n

Marta Calvi 2010

2

(n 2)!

p

!(n )!

(n 2)!

p

2)!(n )!

n!

!( n

)!

(

2

2

n!

p (1 p ) n

!(n )!

(1 p ) n

(1 p ) n

p (1 p ) n

1)

'

n' n

n' ' n

p 2 n(n 1)

Lezione 10, pag. 8

2

(

2

2

)

p 2 n(n 1) np (np) 2

p 2n2

p 2 n np n 2 p 2

np(1 p)

np(1 p)

npq

4. Per p =½ la distribuzione binomiale è simmetrica rispetto

B

1

n,

2

( )

B

1

n,

2

(n

np

)

Deriva dall’uguaglianza:

n

n

2

n

n

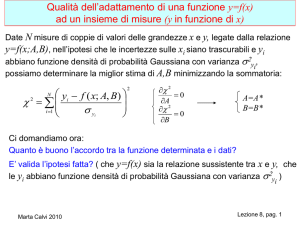

5. Per n

e np grande, la distribuzione binomiale è ben approssimata da

una gaussiana avente stesso valor medio e stessa deviazione standard:

x

np

x

np(1 p)

L’approssimazione è buona se n

Marta Calvi 2010

20, oppure se entrambi np

5, nq

5.

Lezione 10, pag. 9

Distribuzioni binomiali

p=0.5

p=0.1

p=0.8

Marta Calvi 2010

Lezione 10, pag. 10

Torniamo all’esempio precedente: la probabilità di ottenere 0,1,2,3,4 teste nel

lancio di 4 monete.

n = 4, p =½

B 1 (0)

4,

2

B 1 (1)

4,

2

B 1 (2)

4,

B

4,

B

4,

2

4!

1 1

( )1 ( ) 4

1!(4 1)! 2 2

0.25

( 4)

0.0625

0

4,

2

2

4! 1 4

( )

4! 2

4! 1 4

( )

3! 2

1

4!

1 1

( )2 ( )4

2!(4 2)! 2 2

(3)

1

2

1

2

4!

1 1

( )0 ( )4

0!(4 0)! 2 2

B 1( )

4!

1 1 4

( ) ( )

!(4 )! 2 2

0.0625

4 3! 1 4

( )

3! 2

4! 1 4

( )

2!2! 2

0.25

4 3 2! 1 4

( )

2!2! 2

0.375

B(0)+ B(1)+ B(2)+ B(3)+ B(4) = 1

1

np 4

2

2

1

1

np(1 p)

4 1

1

2

2

B( )

0 1 2 3 4

Marta Calvi 2010

Lezione 10, pag. 11