caricato da

sabadiego96

Regolarizzazione in Machine Learning: Introduzione

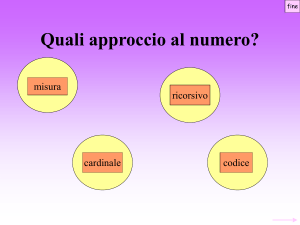

1 Introduzione alla Regolarizzazione Gian Antonio Susto Apprendimento Automatico - Machine Learning (ML) • Area di ricerca che fornisce algoritmi che possono imparare e fare predizioni da dataset storici • Applicazioni di ML in quasi ogni campo del sapere • Temi applicative di ML sviluppati presso il gruppo di Automatica all’Università di Padova – – – – – – Manifatturiero Riconoscimento Gesti ed Attività Image Processing Robotica Biomedia ... 3 Un problema di Machine Learning nei Controlli Automatici • G(s) è il sistema da controllare • La funzione G(s) non sempre sarà sempre disponibile • Con ingressi sinuoisodali è possibile eccitare il sistema ed ottenere il valore di guadagno e fase a certe frequenze 4 Un problema di Machine Learning nei Controlli Automatici • Il numero di misure empiriche sarà di dimensione finita • Le misure saranno affette da rumore • Cerchiamo di costruire un modello (statico) del diagramma di Bode del modulo a partire dalle misure disponibili 5 Classi di problemi di Machine Learning Regressione Supervisionati Problemi di Modellizzazione Classificazione Nonsupervisionati • Due classi di problemi che dipendono dal tipo di dato disponibile – Supervisionati se sono disponibili dati etichettati (Z = [X Y] X input, Y output) – Non-supervisionati se si hanno a disposizione dati nonetichettati (Z = X) 6 Classi di problemi di Machine Learning Regressione Supervisionati Problemi di Modellizzazione Classificazione Nonsupervisionati • Nel caso supervisionato, dipendentemente dal tipo di uscita si hanno problemi di – Regressione se Y è continua – Classificazione se Y è discreta/categorica 7 Classi di problemi di Machine Learning Regressione Supervisionati Problemi di Modellizzazione Classificazione Nonsupervisionati • Problema di Regressione: – Dati etichettati (frequenze in ingresso, valori di modulo e fase in uscita) – Uscita da stimare continua 8 Ordinary Least Squares • Approccio più semplice alla modellizzazione multivariata 1800 • Least squares regression: since Gauss and Legendre, finding the ‘best’ linear approximation of the input-output relationship Obbiettivo: minimizzazione dell’errore di predizione su dataset di training 9 Ordinary Least Squares • Approccio più semplice alla modellizzazione multivariata 1800 • Least squares regression: since Gauss and Legendre, finding the ‘best’ linear approximation of the input-output relationship Obbiettivo: minimizzazione dell’errore di predizione su Soluzione in forma chiusa dataset di training 10 Ordinary Least Squares • Minimizzare l’errore di stima nel dataset di training non è un criterio affidabile per costruire un modello • Esempio unidimensionale: (X = valore frequenze w, Y = valore in db del modulo di G(jw)) 11 Ordinary Least Squares • OLS - assegno coefficienti lineari alla variabile X e al valore costante: Y = a+bX 12 Ordinary Least Squares • Estensione della base al secondo ordine: Y = a+bX+cX2 13 Ordinary Least Squares • Estensione della base al terzo ordine: Y = a+bX+cX2 +dX3 14 Ordinary Least Squares • Estensione della base al 8-o ordine Y = a+bX+cX2+ ... +hX8 15 Ridge Regression (L1) • Modelli OLS solutions con dataset di grandi dimensioni sono spesso mal condizionati: la predizione può cambiare drasticamente con piccole perturbazioni degli ingressi Ridge (or Tikhonov) regression: in order to improve the least squares method, stable (“easier”) solutions are encouraged by penalizing coefficients through the parameter λ 1943 16 Ridge Regression (L1) • Modelli OLS solutions con dataset di grandi dimensioni sono spesso mal condizionati: la predizione può cambiare drasticamente con piccole perturbazioni degli ingressi Ridge (or Tikhonov) regression: in order to improve the least squares method, stable (“easier”) solutions are encouraged by penalizing coefficients through the parameter λ 1943 Penalty sulla complessità del modello 17 Ridge Regression (L1) • Modelli OLS solutions con dataset di grandi dimensioni sono spesso mal condizionati: la predizione può cambiare drasticamente con piccole perturbazioni degli ingressi Ridge (or Tikhonov) regression: in order to improve the least squares method, stable (“easier”) solutions are encouraged by penalizing coefficients through the parameter λ 1943 Parametro di Regolarizzazione 18 Ridge Regression (L1) e LASSO (L2) • Ridge Regression (RR) è una tecnica di regolarizzazione: introducendo complessità sul modello si risolvono problemi mal-condizionati e over-fitting. • Altra tecnica regolarizzazione: LASSO 1996 • Least Absolute Shrinkage and Selection Operator (LASSO): by constraining the solution to belong to an hyper-octahedron, sparse models can be obtained (variable selection). Funzione obbiettivo: Non ha una forma chiusa, ma è comunque estremamente popolare 19 Ridge Regression (L1) e LASSO (L2) Essentially, all models are wrong, but some are useful - George E.P. Box • • Al di là dell’accuratezza, la sparsità è fondamentale per provedere modelli interpretabili e di conseguenza o Intuizione sul problema in esame o Root Cause Analysis Algoritmi efficienti per la risoluzione del LASSO 2010 ‘Regularization paths for generalized linear models via coordinate descent’ Friedman, Hastie, Tibshirani 20 Ridge Regression (L1) e LASSO (L2) • Un penalty sulla complessità del modello solitamente aumenta le performance • Diversi comportamenti: il LASSO dà soluzioni sparse Ridge Regression e LASSO • Non c’è garanzia a-priori su quale metodo garantisca maggior accuratezza • RR funziona solitamente meglio del LASSO quando: • - P>n - Se ci sono elevate collinearità fra i predittori Elastic Nets combina le 2 tecniche From Chris Thornton, U. Sussex • Kernel Methods soluzioni non-lineari in un framework lineare – 22 Cross-Validazione • La taratura del parametro di regolarizzazione può essere fatta tramite crossvalidazione • In modellizzazione dividiamo i dati in 2: – Training e Validazione per calcolo modello – Test per stimare le performance • Dipendentemente dalla scelta dello split le performance possono cambiare parecchio Y t 23 Cross-Validazione • La taratura del parametro di regolarizzazione può essere fatta tramite crossvalidazione • In modellizzazione dividiamo i dati in 2: – Training e Validazione per calcolo modello – Test per stimare le performance • Dipendentemente dalla scelta dello split le performance possono cambiare parecchio Y t 24 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold Test Data Training and Validation Data 25 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold 1MSE Test Data Training and Validation Data 26 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold 1MSE 2MSE Test Data Training and Validation Data 27 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold 1MSE 2MSE 3MSE Test Data Training and Validation Data 28 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold 1MSE 2MSE 3MSE 4MSE Test Data Training and Validation Data 29 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold 1MSE 2MSE 3MSE 4MSE 5MSE Test Data Training and Validation Data 30 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold 1MSE 2MSE 3MSE 4MSE 5MSE AVERAGED MSE Test Data Training and Validation Data 31 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold 1MSE - Monte Carlo Test Data Training and Validation Data 32 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold 1MSE 2MSE - Monte Carlo Test Data Training and Validation Data 33 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold kMSE 1MSE 2MSE - Monte Carlo Test Data Training and Validation Data 34 Cross-Validazione • Per evitare bias nella valutazione delle performance si utilizza cross-validazione • Approcci - K-fold - Monte Carlo kMSE 1MSE 2MSE AVERAGED MSE Test Data Training and Validation Data 35 LASSO (L1) • A valle della taratura dell’iper-parametro di regolarizzazione, si identifica che la soluzione ottima ha solo bisogno di 2 coefficienti non nulli