Quale Modello per le Neuroscienze

di Claudio Messori

ABSTRACT

Con uno sguardo rivolto alle premesse cosmologiche e geologiche che fanno da sfondo all’origine

del fenomeno biologico, vengono ripercorse le fasi storiche essenziali che dal Paleolitico Superiore

attraverso l’Età dei Metalli e l’Età dei Lumi hanno traghettato l’Occidente verso la forma mentis

della scienza contemporanea.

La dimensione tensoriale (Tensione-dynamis) viene indicata come il territorio a cui appartiene il

fenomeno mentale e come la dimensione fisica fondamentale e irriducibile che precede, produce e

coesiste con la dimensione energetica. La transizione dalla dimensione tensoriale alla dimensione

energetica viene spiegata in termini di rottura di simmetria di riflessione (mirror symmetry

breaking). Allo spin-internal motion viene riconosciuto un ruolo centrale nella genesi della trama

energetica e della geometria spaziotemporale. L’energia viene definita come la capacità di

generare interferenza e il quanto d’azione fondamentale h come la frazione minima ammissibile

della capacità di generare interferenza. Viene avanzata una spiegazione del fenomeno biologico,

neurologico e mentale in chiave quantistico-relativistica. Alla rottura di simmetria chirale viene

riconosciuto un ruolo centrale nella genesi del fenomeno biologico. Adottando la visione

introdotta dalla QFT e dalla QED nella spiegazione della strutturazione della materia, viene

avanzata l'ipotesi che dalla formazione di specifici Dominii di Supercoerenza Oscillatoria

dell'acqua prebiotica allo stato liquido, abbia preso avvio il processo di nucleazione e di

accrescimento del protoambiente biotico che ha portato alla formazione dei precursori delle

protocellule. Le dinamiche che qualificano rispettivamente l'attività cellulare, neuronale e mentale

vengono incluse tra le dinamiche dei sistemi transienti non-lineari di tipo caotico e vengono

spiegate alla luce dell’azione sintropica esercitata da un Attrattore Strano Olografico

(Holographic Strange Attractor). A conclusione vengono esposte le basi paradigmatiche per un

approccio non computazionale al problema mente-cervello.

Keywords: dimensione tensoriale, Twisted-Pinched Hysteresis Loop, rottura di simmetria di

riflessione, eventi tensoriali indifferenziati, eventi tensoriali differenziati, Attrattore Strano

Olografico, dimensione energetica, spin-internal motion, rottura di simmetria di spin, spinmomento angolare, chiralità, enantioselettività, autopoiesi, Dominii di Supercoerenza

Oscillatoria dell'acqua, origine del fenomeno biologico, relazione neurodipendente

Corresponding author: Claudio Messori - Independent Researcher

Address: Str. Villaggio Prinzera 1, Fraz. Boschi di Bardone, Terenzo 43040, Italy

Phone: +393282876077

e-mail: [email protected]

1. Il fenomeno biologico terrestre: premesse cosmologiche e geologiche

L’Uomo moderno non si rende conto che

la realtà è anche per lui una creazione

della sua psiche, una proiezione dei suoi

impulsi profondi che, essendo una ben misera cosa,

determinano la formazione di una ben misera

realtà: quella del mercante.

Luca Valerio Fabj1

Il reperto fossile più antico in assoluto risale a 13 miliardi e 5oo milioni di anni fa circa, è la

radiazione cosmica di fondo (cosmic microwave background radiation) [1]. L'esistenza di una

radiazione cosmica di fondo alla temperatura di 3 gradi Kelvin (K), osservata a partire dal 1965,

fornisce un indizio sperimentale sul possibile stato dell’Universo intorno ai 14 miliardi di anni fa,

uno stato energetico mass-free ad altissima densità e altissima temperatura (calcolabile in 15

miliardi di gradi K) che è andato incontro ad un lento e progressivo processo di raffreddamento e

forse anche di espansione [2]. Per un tempo durato milioni di anni, l'energia radiante (l’energia

associata ad un’onda elettromagnetica) ha rappresentato la quasi totalità della realtà fisica. Le

particelle elementari dotate di massa come gli elettroni, i neutroni e i protoni si sono potute

formare quando la temperatura raggiunse i 5 miliardi di gradi K. A livello di una temperatura di

300 milioni di gradi K si sono potuti formare, per aggregazione delle particelle, i primi nuclei

atomici, mentre a livello di 40 milioni di gradi K, si sono potute formare strutture più complesse.

Le galassie si formarono successivamente forse per condensazione di nubi composte da energia e

particelle. Esse, in seguito ad ulteriore condensazione, hanno determinato la formazione delle

singole stelle raggruppate in galassie (si stima che nella sola Via Lattea vi siano tra 100 e 300

miliardi di stelle, e che il numero di galassie nell’Universo sia incalcolabile). Le galassie,

raffreddandosi progressivamente hanno dato, in qualche caso, origine ai pianeti.

Il nostro Sistema Solare e il pianeta che abitiamo si sarebbero formati come conseguenza del

processo di aggregazione di un ammasso galattico gassoso, nel corso di un periodo di tempo

compreso tra circa 4 miliardi e 600 milioni e 3 miliardi e 800 milioni di anni fa 2 (una datazione

quasi esatta della nascita della Terra si ottiene con il calcolo della velocità di trasformazione degli

elementi radioattivi nelle sue rocce), un periodo di tempo chiamato Adeano o epoca pregeologica,

il primo periodo dell’Era Precambriana, iniziata con la formazione del pianeta e terminata 540

milioni di anni fa circa, quando ebbe inizio l’Era Cambriana (l’Era Precambriana occupa l’88%

della storia del pianeta).

1

L. V. Fabj, Fondamenti di Psicopatologia generale come scienza autonoma, Paolo Emilio Persiani Editore,

2013, pag. 344

2

The oldest materials that formed in the Solar System are inclusions rich in calcium and aluminum found

within carbonaceous chondrite meteorites. Nicknamed CAIs (for Calcium-Aluminum-rich Inclusions), these

objects are thought to have been some of the first solids to form after the cloud of gas and dust began to heat

up. CAIs have ages of 4.566 billion years. On the basis of measurements of several isotopes, the Earth and

Moon formed about 50 to 100 million years later. [G. Jeffrey Taylor, Origin of the Earth and Moon, NASA,

last updated 2012, https://solarsystem.nasa.gov/scitech/display.cfm?ST_ID=446 ]

Durante l'epoca pregeologica (Adeano) la Terra era una massa incandescente la cui superficie

assomigliava ad un oceano di magma, dove galleggiavano una sorta di zattere roventi ma

semisolide. L'abbassamento della temperatura al di sotto dei 1000 gradi Celsius portò al

consolidamento delle zone con temperature più basse che, divenute più stabili, avviarono la

costruzione della futura crosta terrestre. L'ulteriore abbassamento della temperatura portò alla

costituzione di una crosta terrestre primitiva di roccia vulcanica scura simile al basalto (il

consolidamento della crosta terrestre sarebbe avvenuto circa 3 miliardi e 600 milioni di anni fa).

Dalle rocce incandescenti e dalla crosta terrestre primitiva si sprigionava, soprattutto per opera

dell'attività vulcanica, una fitta nebbia di sostanze gassose come ammoniaca, idrogeno, biossido di

carbonio, metano, vapore acqueo ed altri elementi che, nell’arco di 100 milioni di anni,

gradualmente formarono l'atmosfera primordiale terrestre (riducente, cioè priva di ossigeno

gassoso).

La Terra primitiva rimase a lungo avvolta dalle tenebre, sotto una spessa cappa di dense nubi

ardenti formate dal vapore acqueo continuamente riversato nell'atmosfera dalle esalazioni

vulcaniche.

Quando la temperatura scese abbastanza, le nubi cominciarono a liquefarsi in pioggia, e

l'atmosfera primordiale diede vita a tempeste di proporzioni apocalittiche.

In un primo tempo, abbattendosi sulle rocce incandescenti, la pioggia svaporava, ma con il

graduale raffreddamento della crosta solida l'evaporazione andò diminuendo finché l'acqua poté

condensare nelle zone più depresse della superficie terrestre, formando i primi oceani, mentre

dagli altopiani rocciosi prese avvio la formazione dei continenti.

A poco a poco il nostro pianeta assunse un aspetto a noi più familiare, con una zona fluida gassosa

ricca di nubi detta atmosfera (riducente), una zona fluida liquida con oceani (la formazione delle

masse oceaniche con una dislocazione simile all'attuale è databile intorno ai 3,2 miliardi di anni

fa), laghi e fiumi, detta idrosfera, ed una zona solida indicata con il nome di litosfera, con i primi

abbozzi di quelli che diventeranno i futuri continenti.

Al termine di questa fase pregeologica (3 miliardi e 800 milioni di anni fa circa) ha inizio il periodo

Archeano dell’Era Precambriana, ed è durante questo periodo che si sviluppa il fenomeno

biologico terrestre.

Da questo remoto passato in avanti, il pianeta Terra potrà dirsi a tutti gli effetti abitabile (CHZ,

Circumstellar Habitable Zone) e di fatto abitato da forme di vita che dipendono dalla presenza di

acqua allo stato liquido o, per essere più precisi, dalla presenza di una pressione atmosferica

capace di mantenere l’acqua sulla superficie del pianeta allo stato liquido. Uno tra altri 11 miliardi

di pianeti, nella sola Via Lattea, considerati abitabili, stando ai dati raccolti dalla missione spaziale

Keplero, da forme di vita dipendenti dall’acqua allo stato liquido.

1.1 Il fenomeno biologico: dai precursori delle cellule al Cambriano

Quello che è avvenuto sulla Terra in un remoto passato e quali possano essere state le condizioni

(uniche e irripetibili?) che hanno innescato il fenomeno biologico, è un concetto di cui possiamo

parlare, ma si tratta di eventi che non possiamo conoscere per diretta esperienza. Qualunque

ipotesi facciamo, non possiamo in linea di principio verificarla per diretto confronto con ciò che è

avvenuto. Tutto ciò che possiamo fare è costruire una ipotesi che renda coerentemente connessi tra

loro tutti i dati in nostro possesso, eliminando ogni apparente contraddizione, senza timore di

dover tornare sui nostri passi, se la prospettiva di indagine adottata dovesse dimostrarsi fallace.

In base allo stato attuale delle conoscenze, il fenomeno biologico ebbe inizio in ambiente acquatico

(che era incompatibile con la sopravvivenza del 99% delle forme di vita attuali) tra i 4 e i 3.8

miliardi di anni fa, quando l’intero habitat terrestre, così come la distribuzione delle terre emerse,

era completamente diverso da quello attuale (l'atmosfera era probabilmente composta per il 75% di

azoto e per il 15% di anidride carbonica, la luminosità solare era l'80% del livello attuale).

Il passaggio dall’organico al biologico sarebbe avvenuto, come si dirà meglio nel Paragrafo 5.3, con

la formazione dei precursori (vescicole colloidali liofile di acqua prebiotica mantenuta in un

regime di supercoerenza oscillatoria da un campo elettromagnetico endogeno di idonea intensità

e frequenza, delimitate da una pompa elettronica selettiva costituita da una pellicola semicristallina di acqua, e contenenti macromolecole come proteine e amminoacidi, sintetizzate su base

enantioselettiva) delle prime forme di vita unicellulare, le cellule procariote (cellule prive di

nucleo, microrganismi unicellulari autotrofi anaerobi foto, magneto e chemio-sintetici). Dopo un

lento processo non-lineare di trasmutazione biologica (orientato da una precisa e universale

relazione causale: 1) la funzione genera la struttura e 2) i processi biofisici precedono i processi

biochimici), durato circa 2-1,5 miliardi di anni (periodo di transizione da una atmosfera riducente,

cioè priva di ossigeno gassoso, ad una ossidante), parte dei microrganismi unicellulari autotrofi

esistenti (cellule procariote) andarono incontro ad un processo di nucleazione trasformandosi in

cellule eucariote (cellule dotate di nucleo), di cui sono costituiti tutti gli organismi pluricellulari (i

più antichi ibridi di organismi pluricellulari furono metazoi, funghi e spugne marine, che si

formarono tra 800 e 700 milioni di anni fa circa).

Circa 570-540 milioni di anni fa, 3,5-3 miliardi di anni dopo la formazione delle cellule procariote,

al Precambriano succede il Cambriano (da Cambria, nome latino dato al Galles, dove venne

rinvenuta la prima roccia risalente a questo periodo). Nell’arco di poche decine di milioni di anni

l’ecosistema biotico, fino ad allora composto da organismi procarioti, organismi eucarioti e dagli

ibridi degli organismi pluricellulari, andò incontro ad un rapido processo di diversificazione delle

forma di approvvigionamento energetico che portò alla comparsa degli organismi eucarioti

pluricellulari, come Alghe, Artropodi, Molluschi, Meduse, Crostacei (→organismi dotati di guscio,

predatori, scavatori di tane profonde). Con esso ebbe inizio, 570-540 milioni di anni fa circa, l'Era

Primaria, o Paleozoico, che durerà circa 300 milioni di anni e che comprende l'Ordoviciano,

periodo nel quale compaiono i Vertebrati agnati, e il Siluriano, nel corso del quale compaiono i

Pesci. Seguono, sempre nell'Era Primaria, il Devoniano, con i primi campioni di flora e di fauna

terrestri, e il Carbonifero, caratterizzato da un grande sviluppo della flora con grandi foreste che

ricoprirono tutti i continenti, seguito dal Permiano, con la comparsa dei Rettili, i primi vertebrati

esclusivamente terrestri. L'Era Secondaria, o Mesozoico, si apre 250 milioni di anni fa circa con il

Triassico, nel quale la vita si arricchisce per la comparsa dei primi organismi che anziché deporre

le uova partorivano, gli animali placentati (precursori dei Mammiferi). Gli Uccelli compaiono nel

successivo Giurassico, mentre nel Cretaceo si affermano e dilagano sulle terre emerse i Sauri. E' di

questo periodo la specializzazione dei grandi Rettili nelle varie nicchie ecologiche: sono stati

ritrovati fossili di Ittiosauri, Dinosauri e Pterosauri, adattati alla vita rispettivamente nelle acque e

sulla terraferma e al volo nell'aria. Il declino e la scomparsa dei vari gruppi di Sauri si realizza

totalmente prima della fine del Cretaceo (→estinzione di massa). Altre forme di vita vegetale e

animale compaiono nell'Era Terziaria, o Cenozoico, che inizia 65 milioni di anni fa circa e viene

suddivisa nei periodi Paleocene, Eocene, Oligocene, Miocene e Pliocene, che marcano soprattutto

l'affermarsi dei Mammiferi.

Nell'Età Quaternaria, il cui inizio è da porsi tra 3 e 1,8 milioni di anni fa, e precisamente nel

periodo chiamato Pleistocene, la storia della vita presenta i primi fossili del genere Homo (Homo

Abilis). La comparsa dell'uomo attuale (Homo Sapiens) è databile intorno ai 200.000 anni fa.

La comparsa d'un numero elevato e diversificato di specie animali marine (invertebrati) durante il

periodo di transizione tra Cambriano e Ordoviciano fu accompagnata da una diversificazione delle

modalità nel procacciamento del cibo (approvvigionamento energetico), tra le quali figurano quelle

basate sulla foto-autotrofia, sulla chemio-autotrofia e sulla eterotrofia e dallo sviluppo delle prime

comunità complesse di animali legate tra loro da catene alimentari.

La fotoautotrofia implica una relazione simbiotica con microscopiche alghe fotosintetiche. Dato

che si trovano all'interno dei tessuti dell'animale che le ospita, le alghe sono protette dagli

organismi che potrebbero cibarsene. In cambio, le alghe fotosintetiche sintetizzano e cedono

sostanze nutritive all'ospite e ne eliminano i prodotti di rifiuto (molti coralli di scogliera attuali e

alcuni bivalvi tropicali possiedono nei loro tessuti alghe fotosintetiche). Grazie alla

chemioautotrofia, invece, gli animali captano le sostanze nutritive dall'acqua marina in modo sia

diretto che indiretto. In questo secondo caso si assiste a un tipo di simbiosi interna, grazie alla

quale l'animale ospita batteri chemiosintetici che, in cambio di protezione, sintetizzano e cedono

sostanze nutritive all'ospite (questo tipo di fisiologia è comune tra gli attuali animali che vivono

presso le sorgenti idrotermali che si aprono nelle profondità oceaniche).

Così, in acque povere di sostanze nutritive, la relazione ospite-simbionte risultò particolarmente

vantaggiosa: l'ospite può nutrirsi efficacemente per interposizione del simbionte e quindi riciclare i

suoi prodotti di rifiuto direttamente tramite il simbionte anzichè liberarli nell'ambiente.

Un ambiente ricco di sostanze nutritive, al contrario, non avrebbe favorito solo la nutrizione basata

su relazioni simbiotiche, ma avrebbe favorito anche altre modalità di alimentazione, aumentando il

numero di animali detrivori (che si nutrono di detriti organici) e necrofagi (che si nutrono di

organismi in decomposizione), determinando al tempo stesso un aumento nel numero e nella

varietà degli animali eterotrofi.

L'eterotrofia (ossia il consumo per ingestione di altri organismi, sia animali sia vegetali) divenne

sempre più importante a partire dal tardo Cambriano.

Per il loro nutrimento questi animali digeriscono il cibo in una cavità interna e accumulano

sostanze di riserva in forma di glicogeno o grasso. Generalmente si muovono per l'azione di cellule

specializzate (cellule contrattili e cellule muscolari), tendono a delegare il controllo e

l'organizzazione della loro attività a particolari sostanze (gli ormoni) o cellule (neuroni), la loro

riproduzione è generalmente sessuata (spermatozoo maschile e uovo femminile) e gli adulti, a

differenza delle piante, generalmente mantengono dimensioni e forma fisse.

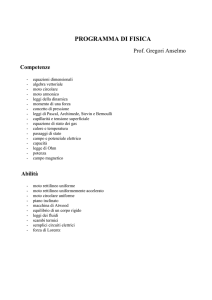

Fig. 1

Posizione degli antichi continenti durante il Cambriano, circa 550 milioni di anni fa.

(Fonte immagine wikipedia.org)

1.2 Le estinzioni di massa

Nel corso dei circa 3,8 miliardi di anni che ci separano dai precursori delle cellule procariote, sul

pianeta si sono avvicendate varie e importanti estinzioni di massa, innescate da diversi fattori, tra

cui fattori abiotici (ad es., clima) e biotici (ad es., malattie), eventi graduali (ad es., riduzione o

aumento della concentrazione di ossigeno, aridità generata da cambiamenti climatici, cambiamenti

delle correnti oceaniche e variazioni dei livelli del mare, variazioni nella distribuzione delle terre

emerse) ed eventi catastrofici (ad es., impatti meteoritici, aumento dell'attività vulcanica, rilascio

di clatrato di metano dal mare e dai fondali oceanici).

Una serie di eventi graduali e catastrofici che annulla la sostenibilità in chiave darwinista, di una

discendenza filogenetica spontaneamente/ casualmente consequenziale (vedi Paragrafo 3.1).

Le principali estinzioni di massa furono (dalla più antica alla più recente):

→ tra i 2400 e i 2000 milioni di anni fa (maf): Grande Evento Ossidativo, la prima e più

grande estinzione di massa, chiamata anche la Catastrofe dell'Ossigeno, la massiccia e prolungata

immissione in atmosfera dell'ossigeno gassoso prodotto dai procarioti anaerobi fotoautotrofi

(cianobatteri), determinò il passaggio da un'atmosfera riducente a una ossidante, con conseguenze

letali per gran parte degli organismi procarioti anaerobici (che sono avvelenati dall'ossigeno

gassoso) [3], costretti a rifugiarsi nei fondali oceanici;

→ 650 maf: estinzione di massa del 70% delle piante marine, dovuta a una glaciazione globale

(ipotesi della Snowball Earth);

→ 443 maf: Glaciazione di Gondwana, estinzione di massa di molti invertebrati marini,

scomparve circa il 49% dei generi di fauna esistente;

→ 374 maf: estinzione di massa di circa il 70% delle specie marine, in realtà si tratta di una serie

prolungata di estinzioni, durata per più di 20 milioni di anni, dedotta dalla presenza di segni

evidenti di anossia delle acque nelle profondità oceaniche, e di un raffreddamento globale che

causò l'abbassamento della temperatura di superficie da circa 34° Celsius a circa 26° C.;

→ 251 maf: estinzione di massa del Permiano-Triassico, segni di un possibile cratere di origine

meteoritica, largo circa 480 km, nella regione di Wilkes Land in Antartide; periodo di grande

vulcanismo in Siberia che causa il rilascio di grandi quantità di gas (CO2, CH4 e H2S) in atmosfera,

il livello di ossigeno (O2) scese dal 30% al 12%, il livello di anidride carbonica (CO2) era di circa

2000 ppm (parti per milione), fu la peggiore estinzione di massa post-precambriana, che comportò

l’eliminazione del 90% delle forme di vita oceaniche, e del 70% di quelle terrestri (fauna e flora);

→ 201 maf: estinzione di massa causata da un evento anossico oceanico, che comportò

l’eliminazione del 20% di tutte le forme di vita marine;

→ 65,5 maf: un impatto meteoritico provoca un cratere largo 170 km a Chicxulub, nello Yucatan,

in Messico, estinzione di massa dell’80-90% delle specie marine e dell’85% delle specie terrestri,

compresi i dinosauri;

→ 12,900 anni fa: l’esplosione di una cometa sul Canada provoca l'estinzione della megafauna

americana come il Mammut e il Sabretooth Cat (Smilodon), così come la fine della cultura Clovis.

Fig. 2

Evolution timeline

2. Dalla tecnologia di Homo Sapiens et Faber alla metafisica applicata

per scopi pratici

Certamente fin dall’inizio non tutto

gli déi svelarono ai mortali

ma nel corso del tempo quelli che ricercano

trovano ciò che è meglio

Senofane di Colofone (circa 580-485 a.C.)

Frammento 18

La centralità della tecnologia3, ovvero del saper fare inteso come ideazione, produzione e

applicazione intenzionale di tecniche (procedure) manuali e/o strumentali finalizzate alla

soddisfazione di scopi antropici, è un fatto relativamente recente nella storia delle comunità

umane [Messori 2013].

Le più antiche testimonianze del saper fare antropico risalgono al Paleolitico Inferiore e Medio,

sotto forma di manufatti litici (choppers, bifacciali, raschiatoi, asce e punte), resti di imbarcazioni

“Il termine tecnologia è una parola composta che deriva dalla parola greca τεχνολογία (tékhne-loghìa),

letteralmente “discorso (o ragionamento) sull’arte”, dove con arte si intendeva sino al secolo XVIII

il saper fare, quello che oggi indichiamo con la tecnica.” (Daniele Dallorto)

3

rudimentali [Strasser, 2010]4, incisioni su pietra (petroglifi) e pittogrammi parietali, statuette

(Veneri), ma si tratta di produzioni che indicano un ricorso a prassie e abilità manuali

caratterizzato dalla assenza di intenzionalità: un saper fare che si fa nell’incontro tra

l’ambiente e la disponibilità di requisiti e di competenze filogeneticamente acquisite, così come la

stazione eretta e il saper camminare non sono frutto di intenzionalità nè di apprendimento ma si

fanno nell’incontro tra ambiente e competenze antigravitarie pronte all’uso.

Sarà solo a decorrere dal periodo di transizione tra il tardo Paleolitico Medio e gli inizi del

Paleolitico Superiore (tra circa 70 e 30 mila anni fa) che le comunità umane inizieranno a integrare

il loro saper fare filogenetico con un saper fare epigenetico contraddistinto dalla intenzionalità e

impiegato per scopi adattivi e sovradattivi.

Nell’arco di questo periodo di tempo infatti, la relazione di continuità [Messori 2012] sino ad

allora intrattenuta dall’animale homo (come da qualsiasi altro animale) con l’ambiente, venne

fecondata dalla nascita psicologica della individualità umana e dalla costituzione di quella

identità psichica relativamente autonoma e indipendente (pre-razionale e pre-verbale) che

chiamiamo funzione epigenetica del reale, o autocoscienza umana, dando avvio alla

sedimentazione di una relazione di contiguità con il Mondo, e al conseguente processo di

produzione culturale, che gradualmente e irreversibilmente porterà una parte delle comunità

umane a fare un uso sempre più intensivo e specialistico della tecnologia.

All’interno di questo gap tra l’ambiente inconscio del sapere filogenetico e l’ambiente conscio del

sapere epigenetico, scavato dalla nascita psicologica, si inseriscono tutte le dinamiche relazionali e

comportamentali che da questo momento in poi verranno sperimentate dalle comunità umane nel

loro confronto culturale con l’esistere. Dinamiche relazionali che traggono tutte origine dalla triade

archetipica associata alla stazione eretta dell’essere umano, secondo la quale il suo posto nel

Mondo, il suo ruolo elettivo, è di collegamento tra ciò che sta sopra, in alto, il Cielo, e ciò che sta

sotto, in basso, la Terra.

Il primo passo importante, verso un uso sempre più intensivo e specialistico della tecnologia,

venne fatto nel corso del Neolitico con l’ideazione e l’applicazione delle prime tecniche e l’uso dei

primi attrezzi da lavoro nella coltivazione cerealicola, allevamento di bestiame, filatura, tessitura,

nella costruzione di abitati e nella lavorazione della ceramica.

Nel corso degli oltre quindicimila anni che separano il Neolitico dall’Illuminismo inglese del XVIII

sec. d.C., la tecnologia è sempre stata considerata un mezzo, a cui fare ricorso per soddisfare i fini

dettati dalla produzione culturale e sociale, in particolare quelli rivolti alla sopravvivenza,

all’addomesticamento della Natura (approvvigionamento di risorse alimentari, regimentazione

rudimentale delle acque fluviali, etc.). Aristocratici, Sacerdoti e Guerrieri, così come le comunità di

individui che essi rappresentavano, hanno continuato a servirsi della disponibilità di risorse

tecnologiche considerandole sempre come un mezzo e mai come un fine, anche quando due

straordinarie acquisizioni tecnologiche come l'addomesticamento del fuoco per la lavorazione dei

metalli (Età dei Metalli, VIII-I millennio a.C.) e l’invenzione della scrittura, cambiarono il corso

della storia5.

4

Reported by M. Marshall, Neanderthals were ancient mariners, 2012:

www.newscientist.com/article/mg21328544.800-neanderthals-were-ancient-mariners.html

5

Ciò che non ha una sua essenza, ma che è un complesso tessuto di contingenze, è la Storia. Ciò che si veste

sempre di nuove forme, adattandosi alle realtà contingenti ed esprimendosi attraverso il linguaggio dei

tempi, pur restando sempre uguale nella sua essenza, è la Tradizione. La Storia è l’aspetto modale

(processuale) della Tradizione e la Tradizione è la parte sostanziale della Storia. I valori e gli ideali sono

articolati dalla Tradizione ed il risultato della loro attuazione o concretizzazione nella realtà è un fatto

storico.

Nell’area euro-mediterranea, tuttavia, l’intreccio maturato nel corso del I millennio a.C. tra gli

elementi paradigmatici mesopotamici, ellenistici e romani posti a fondamento della gestione delle

faccende terrene (→ Cilindro di Nabonidus6 e Cilindro di Ciro7 → Polis → Senato), e la

lungimirante elaborazione teologica della casta sacerdotale semitica (tra il VII e VI sec. a.C., in

un’epoca retta dal politeismo, il Regno di Giuda, con capitale Gerusalemme, fu il primo regno nella

storia a venerare in un unico tempio un unico dio, il dio abramitico Yahweh), portò a

concepire una forma di governo dell’Impero, istituita sulla distinzione giuridica tra legge divina e

legge terrena (che verrà successivamente sintetizzata nel celebre detto attribuito a Gesù e riportato

dai Vangeli: Date a Cesare quello che è di Cesare e a Dio quello che è di Dio).

Il Senato romano e la Polis greca fornivano già tutti gli elementi necessari per l’articolazione

giuridica della legge terrena, mancava un culto religioso che potesse fornire gli elementi necessari

per l’articolazione giuridica della legge divina. Questo culto religioso prese corpo nella religione

giudaico-cristiana.

L’affermazione imperiale del culto giudaico-cristiano, deve molto della sua fortuna alla missione

apostolica di un contemporaneo di Gesù di Nazareth, Saulo di Tarso (latinizzato in Paolo, ovvero

San Paolo, 5(10)-64(67) d.C.), un predicatore greco-romano itinerante di religione ebraica poi

convertitosi al cristianesimo, che nel corso del I sec. d.C. riesce ad estendere il nuovo culto, allora

praticato solo da un ristretto numero di comunità giudeo-cristiane, fuori dai confini della

Palestina, verso l’attuale Giordania, la Turchia e la Grecia. Saulo si fece promotore di un

cristianesimo ispirato ai principii etici dello stoicismo medio (I sec. a.C.)8, basato sull’assunto che

Gesù di Nazareth (predicatore e profeta ebreo anch’egli itinerante, finito crocifisso per mano dei

romani) fosse il Messia, Il Cristo (dal greco Christòs, l’Unto), il Figlio di un Re dei re, Sacerdote

dei sacerdoti, Condottiero dei condottieri, di origine semitica: il Dio venerato a Gerusalemme,

Jahweh, Colui che È.

Jahweh, figura divina sinaitica, ispirata a una figura divina indù, Īśvara, elaborata dalla casta

sacerdotale semitica nel corso della seconda metà del II millennio a.C. (epoca in cui i popoli

semitici del Sinai inventano la scrittura alfabetica), e derivata dalla sintesi teologica della triade

cosmica sumerica Anum-Enlil-Enki (nonchè della controparte femminile di Anum, Ki, e della

divinità femminile creatrice Ninhunsag), e di quella akkadica composta da Marduk-IshtarShamash, Jahweh dunque, si fa uomo in Gesù.

L’assunzione di sembianze umane da parte di una divinità non costituisce un elemento di novità,

molte altre divinità nella Storia sia dell’emisfero boreale che di quello australe lo fanno. Il fatto

sorprendente e straordinario, per qualcuno quasi blasfemo mentre per altri semplicemente

insensato, è dato dal fatto che questo Dio non si limita ad assumere sembianze umane, no, questo

Dio si fa, letteralmente, mortale. L’aver reso mortale l’immortale e immortale il mortale (la

consustanzialità della pericoresi cristologica, base del dogma della Trinità), è una operazione di

metafisica applicata per scopi pratici unica nel suo genere9, che accoglie in pieno l’istanza

6

http://www.livius.org/na-nd/nabonidus/cylinder.html

http://www.livius.org/ct-cz/cyrus_I/cyrus_cylinder.html

8

Tutti gli uomini sono uguali di fronte alla legge universale del Lògos, direbbe uno stoico, e Saulo applicò

questo principio etico alla sua religione, affermando che tutti gli uomini, anche quelli non circoncisi, sono

figli del suo Dio.

Cfr.: http://www.latinovivo.com/schedeletteratura/stoicismo.htm

9

Anche la divisione in caste dell’India vedica, per es., è una operazione di metafisica applicata, nel senso

che rispecchia un Ordine cosmico imprescindibile:

Rg Veda X, 90, strofa 12 (Purusasukta): La sua bocca [dell’Uomo primordiale fatto a pezzi, sacrificato]

divenne il Brahmano, il Guerriero fu il prodotto delle sue braccia, le sue cosce furono l’Artigiano, dai suoi

piedi nacque il Servitore.

La differenza è che qui ci si pone nella prospettiva anti-storica della metafisica (la Tradizione), da cui tutte le

questioni di ordine pratico partono e a cui tutte fanno ritorno, mentre l’aver reso mortale l’immortale e

7

aristotelica: ciò che attiene al Lògos (in Platone il Cielo iperuranico delle Idee), al Motore

Immobile (in Aristotele la metafora della antistoricità della metafisica10), per quanto sublime possa

essere, è per definizione estraneo a questioni di ordine pratico e quindi non-utile, perciò, noi,

cultori dell’arte-arma del logos11 (la Dialettica, la serrata applicazione pratica della logica, e la

Retorica, l’abilità nell’uso della parola come chiave di ogni autorità nello Stato), ci volgiamo all’uso

esclusivo della Ragione delle idee (della matematica e della geometria).

L’evento cruciale nel processo di affermazione della ragione della metafisica applicata per scopi

pratici e della ragione della consustanzialità (gli elementi teoretico-teologici sui quali germoglierà

la postuma Età dei Lumi), fu l’incoronazione (V sec. d.C.) della religione cattolica di Santa

Romana Chiesa ad unica religione ammessa e tollerata dall’Impero Romano (d’Occidente)12.

Il sodalizio tra la Santa Romana Chiesa fattasi Stato e l’Impero Romano d’Occidente, celebra

ufficialmente il trionfo della Ragione delle idee, che, nel rivendicare la propria autonomia ed

estraneità dalle dispute metafisiche, declassa la trascendenza, (il territorio del Non-nato, meglio

noto come Non-Essere, del Senza-Nome, dell’eccedenza di senso, del simbolo), ad una questione

teologica (il territorio del Nato, meglio noto come l’Essere, dei Nomi, del senso e dei significati)

[Messori 2000, 2004].

La convergenza dei tutori del sacro e dei tutori del profano, sulla opportunità di affidare il governo

universale dei corpi e delle anime al primato della ragione della metafisica applicata per scopi

pratici, è un evento storico di eccezionale importanza, rimasto per secoli circoscritto all’area euromediterranea (nonostante l’espansione dell’Impero romano fino alle porte dell’India, nonostante

due secoli di Crociate, nonostante quattro secoli di espansionismo coloniale), che in epoca tardorinascimentale (quando la riabilitazione dei classici greci e romani era cosa fatta) porterà i

discendenti degli esperti nell’arte del sapere e del saper fare per scopi pratici dell’Età dei Metalli,

ovvero gli Artigiani, esperti nell’arte del trasformare la materia grezza in oggetti finiti (ai quali gli

alchimisti consegnano lo spirito dello sciamano-metallurgo, il Signore del Fuoco, incarnato nel

corpo esoterico della metafisica applicata che non rinuncia a cogliere dall’Albero della

Conoscenza), e i Mercanti, gli esperti per antonomasia nell’arte del fare affari con il sacro e con il

profano, ad affermarsi come soggetto sociale e politico dominante.

A decorrere dal XV sec., il trend positivo registrato dallo sviluppo e dal trasferimento delle attività

produttive e commerciali verso i centri cittadini, nonché il vuoto di potere generato dal declino del

Sacro Romano Impero e dal contemporaneo affievolimento dell'autorità papale, aprono le porte

alle istanze di un nuovo gruppo sociale urbano privilegiato (èlite), caratterizzato da specifiche

norme di comportamento e da ruoli predeterminati (ceto), che per affermarsi sistematizzerà il

ricorso ad una ragione della metafisica applicata per scopi pratici, ispirata al "sapere e saper

immortale il mortale è retorica allo stato puro, tant’è che la sua insostenibilità è messa a tacere da un dogma

mimetizzato in un atto di fede.

10

Il Motore Immobile è l’equivalente dell’Axis Mundi, del Lògos dei presocratici (Eraclito), del Dharma

della dottrina indù, del Cielo Anteriore nella cosmologia taoista, è ciò che imprime contrapposto a ciò che

esprime, è ciò che permane invariabile al centro delle rivoluzioni di tutte le cose, e che regola, senza

intervenirvi in alcun modo (il wu-wei, azione-senza-azione, del taoismo), il corso dei cambiamenti per il

fatto stesso che non ne è partecipe.

11

Il lògos dei postsocratici, la parola argomentata che sistematizza il divenire delle relazioni in regole e

segni, contrapposta alla parola rituale, ai me della civiltà akkadico-sumera (XIX-XVIII sec. a.C.), norme e

decreti di natura divina che garantiscono e determinano il destino di ogni essere, di ogni forma di vita, di

ogni impresa divina o umana, dei vari mestieri, vocazioni e istituzioni (il cui corrispettivo nella tradizione

indù sono i dharma).

12

La vocazione ad essere una religione esclusiva e non inclusiva è già presente nel I dei X Comandamenti:

Non avrai altro Dio all’infuori di me. Un comandamento che suona al tempo stesso come una promessa, una

minaccia, un avvertimento, una certezza, un premio. Per molti sarà una condanna.

fare affari inteso come ideazione, produzione e applicazione imprenditoriale di tecniche

(procedure) manuali, strumentali, economiche, politiche, finanziarie, militari finalizzate al

soddisfacimento della propria ambizione di potere": la borghesia.

Autoproclamatisi eredi legittimi dell’illuminismo greco ante litteram (sofisti, atomisti, scettici,

stoici), tra il XVII e XVIII sec. gli intellettuali borghesi inglesi danno vita a un movimento di

pensiero e d’azione, l’Illuminismo, che si fa portatore di un modello culturale emendato da

qualsiasi traccia di metafisica e di superstizione, fondato sulla fede incondizionata ed esclusiva

(non avrai altro modello di conoscenza all’infuori di me) nella ragione empirica e nella

conoscenza scientifica ritagliata sul modello scientifico sperimentale galileiano-newtoniano.

Contemporaneamente, il movimento illuminista scardina l’assetto socio-politico dominante

(rivoluzione americana e francese, nascita delle monarchie costituzionali europee), consegnando il

destino dei popoli alla visione meccanicista e riduzionista della realtà: Dio-Gesù, il grande

orologiaio, nel creare il Cielo e la Terra e tutto ciò che popola lo spazio compreso tra di essi non ha

lasciato niente al caso, anzi, tutto è stato calcolato secondo un disegno matematico di causa-effetto,

per essere affidato all'Uomo maschio, bianco, cattolico, istruito, benestante, l’unico essere del

creato in cui Dio abbia compiutamente infuso la res cogitans.

L'Universo, è un sistema meccanico di oggetti solidi (res extensa) che riempiono porzioni di uno

spazio altrimenti vuoto, posti in relazione reciproca secondo leggi di moto che, almeno in linea di

principio, sono calcolabili.

Con la progettazione e realizzazione delle prime macchine complesse in grado di produrre energia

in modo costante (nel 1730 Kay inventa la spola volante che velocizza la tessitura, nel 1764

Hargreaves inventa la spinning-jenny, un filatoio meccanico azionato dall'uomo, in grado di far

agire contemporaneamente molti fusi, nel 1768 Arkwright costruisce una filatrice che richiede

energia non manuale grazie ad un motore idraulico, nel 1784 Cartwright realizza il telaio

meccanico, nel 1781 Watt costruisce la prima vera e propria macchina a vapore), banchieri,

mercanti e imprenditori, arricchiti dall’esperienza coloniale e ferventi sostenitori dei principii

illuministici (a cui si richiama la classica definizione di energia: capacità di un sistema o di un

corpo di compiere lavoro), scoprono i vantaggi che possono trarre dallo sfruttamento

imprenditoriale delle macchine e decidono di investire denaro, beni, conoscenze, competenze,

esperienza, tempo e mano d’opera nella meccanizzazione dei processi produttivi e nello sviluppo

tecnologico.

È in quest’epoca che il processo di integrazione tra uomo e tecnologia (macchina) muove i suoi

primi passi, partendo dal presupposto che il capitale umano scarsamente o per nulla dotato di res

cogitans (gli schiavi deportati dalle colonie e tutti i non appartenenti alla razza bianca, le donne, i

bambini e i maschi prestatori d’opera) deve esercitare il proprio ruolo produttivo in funzione del

capitale tecnologico.

Nel corso del XIX sec., l’impeto rivoluzionario illuminista abbandona le piazze e viene data alla

luce la prima religione laica e scientifica della Storia, il positivismo, l’elaborazione

ideologica di una borghesia industriale liberista solidamente affermata, che fa della scienza una

metafisica di certezze assolute, tanto che negli ultimi anni della sua vita Auguste Comte (17981857), ideologo del positivismo, scrive il Catechismo positivista e fonda la Chiesa Positivista, dove

vengono trasposti gli elementi dottrinali, etici e liturgici della tradizione cattolica.

Tornata ad affermarsi, quella ragione della metafisica applicata per scopi pratici che aveva tenuto

a battesimo la scalata sociale del ceto borghese cambia nome e diventa dottrina della fede nella

Scienza.

Per molti secoli la filosofia e le scienze erano rimaste strettamente connesse in un sistema di

rapporti reciproci subordinati ai principi universali della metafisica. Il declassamento della

trascendenza ad una questione teologica aveva inferto alla metafisica e alla filosofia il primo duro

colpo, facendole cadere in disgrazia a favore delle scienze e della metafisica applicata per scopi

pratici. Il colpo di grazia verrà loro inferto dall’Illuminismo prima e dal Positivismo poi, quando

l’assolutismo teologico passa definitivamente il testimone all’assolutismo scientifico, decretando la

scomparsa della figura dello scienziato con interessi e conoscenze universali, per lasciare il posto ai

ricercatori specializzati, che dovevano dare risposte sicure ai problemi posti

dall’industrializzazione e dal progresso tecnologico.

Subordinata al punto di vista dell’individuo, scrive il Colli [4], la conoscenza diventa così

strumento dell’azione: in questa crisi, tragica e decisiva per i secoli seguenti, il filosofo in

Descartes impallidisce, trascolora sino ad annullarsi nello scienziato, e in generale la filosofia si

ritira ufficialmente dal giuoco, cedendo il banco. Il vincitore è privo di venerazione, e da allora il

titolo di filosofo designa qualcuno che sta tra l’acchiappanuvole e il giullare.

Si impone, così, il mito di una Scienza super partes che contende a Dio il suo primato di Giudice

imparziale, e così facendo sfila il destino dei popoli dalle mani dei teologi per gettarla nelle le mani

dei teo-scienziati che stabiliscono razionalmente leggi assolute, obiettive e valide sopra ogni

ragionevole dubbio. Una assunzione di assoluta imparzialità palesemente falsa.

Qual’è allora il giusto ruolo, scrive il fisico David Bohm [5], dell’incorporare fatti in ordini,

misure e strutture di teorie preesistenti? Qui è importante notare che i fatti non vanno

considerati come oggetti indipendentemente esistenti, che troviamo nei nostri laboratori. Un

fatto è piuttosto ‘ciò che è stato fatto’: in un certo senso siamo noi che ‘facciamo’ il fatto. Vale a

dire che, a partire dalla percezione immediata di una situazione reale, la trasformiamo in fatto

dandole un ordine, una forma e una struttura con l’aiuto dei nostri concetti teorici. Per esempio,

servendosi dei concetti d’ordine dominanti nell’antichità, gli scienziati furono portati a ‘fare’ il

fatto delle orbite planetarie, descrivendole e misurandole in termini di epicicli. I fatti della fisica

classica sono invece ‘fatti’ sul modello di ordine delle orbite planetarie descritte in termini di

posizioni e di tempi. I fatti della relatività generale sono ‘fatti’ in base all’ordine della geometria

riemaniana e alla misura che risulta da concetti come quello di curvatura dello spazio. Nella

teoria quantistica, i fatti sono ‘fatti’ in base all’ordine dei livelli energetici, dei numeri quantici,

dei gruppi di simmetria, e così via, insieme con opportune misure (per esempio, sezioni d’urto,

masse e cariche di particelle, eccetera). I cambiamenti di ordine e misura nella teoria portano in

ultima analisi a nuovi modi di sperimentare e a nuovi strumenti, che a loro volta portano a ‘fare’

fatti di nuovo tipo corrispondentemente ordinati e misurati.

Come conseguenza del sempre più vasto arruolamento di forza lavoro a basso costo nel ciclo

produttivo creato dal processo di industrializzazione, prendono vita un nuovo soggetto sociale, il

proletariato, e due teorie politiche e sociali, una rigidamente materialista, il socialismo scientifico

di Karl Marx e Friedrich Engels, l’altra agitata da un romantico idealismo, l’anarchismo di Michail

A. Bakunin e Petr Kropotkin. Entrambe lasciano intatto l’impianto ideologico settecentesco su

cui si erge la visione della scienza come metafisica di certezze assolute, per schierarsi a favore

della emancipazione della classe operaia e di quanti sono vittime della logica di potere del ceto

dominante.

Meno di un secolo dopo (prima metà del ‘900), la rivoluzione scientifica innescata con la

formulazione della Teoria della Relatività Generale di Einstein (che ha cambiato radicalmente ciò

che sappiamo dello spazio e del tempo) e della Meccanica Quantistica (che ha cambiato

profondamente ciò che sappiamo della materia), svela una realtà fisica microscopica e

macroscopica completamente diversa da quella teorizzata dalla fisica newtoniana, che perde il

titolo di teoria fisica universale e deve accontentarsi di mantenere una validità pratica solo sul

piano meccanico.

Le nuove acquisizioni scientifiche non tardano a trovare conferma sperimentale, e la realizzazione

dei primi ordigni nucleari, sganciati sul Giappone nell’estate del 1945, uno (soprannominato Little

Boy) su Hiroshima, l’altro (Fat Man) su Nagasaki, non lasciano ombra di dubbio: è l’avvento di

una nuova Era, l’Età dei Quanti.

2.1 Il crollo del paradigma newtoniano

Il conflitto tra scienza e religione è dovuto in realtà

ad un malinteso di entrambe. Il materialismo scientifico

ha semplicemente introdotto una nuova ipostasi,

e questo è un peccato intellettuale. Esso ha dato un altro nome

al principio primo della realtà ed ha presunto di avere così

creato un elemento nuovo e di averne distrutto uno vecchio.

In qualunque modo chiamiate il principio dell’esistenza

- Dio, materia, energia o qualsiasi altra cosa preferiate -,

non avrete creato nulla; avrete semplicemente sostituito un simbolo.

Il materialista è un metafisico malgrè lui.

Carl Gustav Jung 13

Lo scopo fondamentale della fisica classica newtoniana, era spiegare causalmente l'azione delle

forze sulle particelle che compongono il cosmo, e descrivere il loro moto reciproco con l'ausilio di

equazioni matematiche. Dalle tre leggi della dinamica14 e dalla legge di gravitazione universale15 si

ricavano le equazioni del moto, che consentono di prevedere, in riferimento alla tre dimensioni

dello spazio e al fluire unidimensionale del tempo, le traiettorie dei corpi.

Su queste basi, si stabiliscono legami deterministici tra i corpi, secondo il principio di una

connessione necessaria tra causa ed effetto, esprimibili mediante le equazioni del moto.

Nell'universo newtoniano niente accade per caso, ma tutto è necessario in quanto soggetto alle

leggi deterministiche della natura.

Newton suppose l'esistenza di uno spazio assoluto, infinito, vuoto, tridimensionale, invisibile, non

modificabile dalle masse e fermo rispetto al loro moto. Era così possibile misurare il moto

uniforme di un corpo rispetto a questo spazio assoluto. Ogni corpo occupa nello spazio assoluto

una posizione determinata ed unica, e due corpi possono occupare lo stesso spazio, ma solo in

tempi diversi. Il tempo misura così la successione e la simultaneità degli eventi nello spazio. E

come lo spazio, anche il tempo assoluto di Newton viene concepito in termini matematici: è

composto da una serie continua di istanti, disposti in un'unica dimensione. Il tempo è per Newton

una realtà fisica, universale e assoluta, non alterabile dai corpi e dal loro moto.

13

Tratto dal suo commento psicologico a: Il libro tibetano della grande liberazione, Newton Compton

Editori, 1992, pag. 11

14

I legge della dinamica o Legge di inerzia di Galilei: Un corpo si muove di moto rettilineo uniforme finché

una forza non lo costringa a muoversi diversamente; II legge della dinamica o Legge di Newton: Il

cambiamento di moto è proporzionale alla forza motrice risultante applicata, ed avviene lungo la linea retta

secondo la quale la forza stessa è stata esercitata; III legge della dinamica: Ad ogni azione corrisponde una

reazione pari e contraria.

15

Nell'universo ogni punto materiale attrae ogni altro punto materiale con una forza che è direttamente

proporzionale al prodotto delle loro masse e inversamente proporzionale al quadrato della loro distanza.

Le prime gravi difficoltà della meccanica di Newton si manifestarono a partire dalla seconda metà

dell'Ottocento, con la comparsa della teoria elettromagnetica e della termodinamica.

La fisica di Newton, con la sua la forza di gravità che agisce a distanza istantaneamente, sembrava

incompatibile con la nuova teoria di Faraday e Maxwell, che descriveva l'azione esercitata dalle

forze elettromagnetiche sul moto delle cariche elettriche. La teoria prediceva l'esistenza di onde

elettromagnetiche, che sostituiscono le particelle puntiformi della meccanica, che si propagano

nello spazio, non più concepito in termini newtoniani (assolutamente vuoto e insensibile all'azione

delle forze), ma pensato come una specie di fluido, per quanto invisibile, detto etere.

La rivoluzione relativistica fu il prodotto del sempre più evidente contrasto tra la descrizione del

moto delle particelle elettricamente cariche nei campi di Maxwell e la descrizione del moto secondo

le leggi della meccanica di Newton. La fisica classica conteneva il principio della relatività del moto,

ed anche la nozione di un moto assoluto, intesa come possibilità - mai sperimentalmente verificata

- di poter misurare il moto uniforme di un corpo rispetto allo spazio e al tempo assoluti. Per la

teoria elettromagnetica il campo elettrico genera un moto di attrazione e di repulsione delle

cariche, cioè un flusso di cariche (quelle dello stesso segno si respingono, quelle di segno diverso si

attraggono) detto corrente elettrica. Una corrente elettrica induce un campo magnetico. Ora se

applichiamo il principio della relatività del moto ai fenomeni elettromagnetici, dovremmo notare

che la velocità delle cariche elettriche dipende dal sistema di riferimento dell'osservatore. Dato un

certo sistema di riferimento l'osservatore vedrà la carica in moto, dato un altro la vedrà in quiete. Il

primo osservatore constaterà allora l'esistenza di un certo fenomeno, cioè la formazione di un

campo magnetico; il secondo osservatore non vedrà nulla.

Einstein dimostrò che la meccanica classica si basava su due assunti errati:

1) che la misura del tempo fra gli eventi fosse indipendente dal moto dell'osservatore;

2) che la misura dello spazio fra due punti di un sistema di riferimento fosse indipendente dal

moto dell'osservatore.

Le leggi di natura sono invarianti e valgono per tutti gli osservatori dell'universo, mentre lo spazio

e il tempo dei fenomeni sono relativi al moto (sistema di riferimento) in cui si trova un determinato

osservatore. Ne consegue che occorre rivedere profondamente le leggi della dinamica di Newton:

queste in senso forte non possono più essere considerate descrizioni vere dei fenomeni naturali. La

nuova teoria che sostituisce la dinamica di Newton sarà chiamata teoria della relatività speciale, o

ristretta.

Se è vera la teoria della relatività speciale, col suo principio della costanza della velocità della luce,

allora questa è incompatibile con la forza di gravità di Newton che agisce istantaneamente a

distanze infinite. Einstein lavorò al problema per diversi anni, nel 1915 aveva in mano la soluzione:

la teoria della relatività generale. I princìpi della relatività speciale venivano estesi ai moti

accelerati, mentre in origine si riferivano ai soli moti uniformi (che rappresentano sempre delle

idealizzazioni). Poiché tutte le masse sono soggette alla forza di gravità, e quindi sono accelerate

(non sono mai realmente in moto uniforme, o inerziale), le leggi relativistiche vengono fatte valere

per l'intero universo.

La relatività ristretta metteva in discussione la natura intuitiva del concetto di tempo. Ora la stessa

sorte toccava all'idea intuitiva dello spazio tridimensionale euclideo. Lo spazio di Newton veniva

infatti sostituito con una nuova geometria dello spazio, un continuo spazio-temporale a quattro

dimensioni. La geometria del cosmo è non-euclidea.

La teoria einsteiniana della relatività, per quanto lontana dal senso comune e per quanto avesse

messo in discussione i concetti fondamentali della meccanica di Newton, è ancora una teoria

classica a causa del suo determinismo. Ed è ancora una teoria deterministica, in quanto considera

le leggi di natura indipendenti dall'osservatore. All'inizio del Novecento prese avvio una nuova

prospettiva di ricerca, oltre a quella relativistica, che si concluse con l'edificazione della teoria

quantistica della materia. Questa teoria distrusse completamente l'edificio della fisica classica

newtoniana, e sostituì il determinismo con l'indeterminismo, la spiegazione causale con la

spiegazione probabilistica, e introdusse l'osservatore come soggetto non meramente

passivo nelle leggi della fisica.

Nell'anno 1900 Max Planck, fisico tedesco, dimostrò che lo scambio energetico tra materia e

radiazione avviene in modo discreto (quantizzato), e non in modo continuo come si era fino ad

allora supposto. L'energia viene assorbita o irradiata secondo quantità definite, e i loro multipli

esatti, dette quanta. L'energia di un quantum dipende dalla frequenza (v) e da una costante (h),

poi detta di Planck (E=hv). Era l'inizio dell'Età dei Quanti.

Nel 1923 il francese de Broglie, nella sua tesi di laurea, propose un modello matematico che

descriveva un campo di radiazione elettromagnetica quantizzato. Ciò significa che le particelle,

come gli elettroni, possono essere descritte come onde e la radiazione come particelle, cioè come

unità discrete di energia. Così gli atomi e i loro componenti come l'elettrone, fino ad allora descritti

in termini classici, cioè puntiformi come pianeti in orbita intorno al Sole, acquistarono una ben

diversa connotazione, ondulatoria.

La teoria einsteiniana della relatività, fin dal suo apparire, introdusse nel dibattito epistemologico

elementi di discussione molto forti, riguardanti il ruolo dell'osservatore, lo status delle leggi

naturali, il processo di formazione dei concetti scientifici e il loro valore. Lo stesso si può dire, a

maggior ragione, per la meccanica quantistica.

Per due secoli la meccanica classica aveva avuto un grande successo nello spiegare i fenomeni; era

considerata una teoria vera, un meraviglioso edificio eretto dall'intelligenza umana.

Ora questa teoria si era dimostrata falsa, incapace di spiegare i fenomeni ultramacroscopici,

cosmologici, e ultramicroscopici, elettromagnetici, atomici e sub-atomici. Al suo posto c'erano

teorie che introducevano la relatività del tempo e dello spazio, l'indeterminazione quantistica, il

dualismo onda-particella, l'entanglement16, la superposizione bosonica17 e altri "strani" fenomeni.

Con questa rivoluzione paradigmatica l’interpretazione e l’investigazione scientifica della realtà

fenomenica, incluso il fenomeno mentale, percorrerà due strade18, destinate a tracciarne una terza.

L’interazione tra oggetti quantistici porta a correlazioni non-locali che non hanno un analogo classico.

Due o più oggetti fisici sono entangled quando sono o sono stati descritti dalla stessa funzione d’onda.

Qualora decidessimo di separarli, ad es. due elettroni dei quali uno con spin su (elicità destrogira) e l’altro

con spin giù (elicità levogira), ponendoli ai capi opposti dell’Universo e variassimo lo spin di uno dei due,

poniamo da su a giù (da destrogiro a levogiro), l’altro lo avvertirebbe istantaneamente variando il proprio

spin da giù a su (da levogiro a destrogiro)! Non è ancora chiaro come ciò avvenga. Apparentemente

l’entanglement quantistico vìola il limite di propagazione di un impulso fissato dalla velocità della luce (300

mila Km/sec. nel vuoto). Di fatto non lo vìola perché l’entanglement non è un fenomeno vettoriale ma

tensoriale. L’entanglement è una misura del grado di correlazione non-locale tra oggetti quantistici, ovvero

di quanto lo stato complessivo del sistema sia non-separabile, ovvero non fattorizzabile in stati degli oggetti

individuali. Fondamentale è comprendere tutte le implicazioni insite nella equivalenza tra spazio-tempo,

campo gravitazionale e continuo spaziotemporale.

17

La Teoria Quantistica dei Campi (Quantum Field Theory) non spiega l’ontogenesi del fenomeno

energetico ma spiega la strutturazione della materia in termini di relazioni frequenziali, dove un pattern

correlativo corrisponde a un dominio di coerenza oscillatoria. In fisica quantistica (Interpretazione di

Copenaghen) l’espressione matematica del pattern correlativo di un oggetto o di un fenomeno (quantistico)

viene derivata dalla equazione di Schrödinger e prende il nome di funzione d’onda. Le particelle descritte da

funzioni d'onda simmetriche sono dette bosoni e obbediscono alla statistica di Bose-Einstein. Le particelle

descritte da funzioni d'onda anti-simmetriche sono dette fermioni e obbediscono alla statistica di FermiDirac. Tutte le particelle elementari responsabili delle forze che tengono uniti i fermioni sono bosoni.

Per il principio di esclusione di Pauli, due fermioni non possono condividere lo stesso stato quantico, mentre

i bosoni si (superposizione bosonica).

18

Cfr.: Jeffrey M. Schwartz, Henry P. Stapp, Mario Beauregard, Quantum Physics in Neuroscience and

Psychology: a Neurophysical Model of Mind/Brain Interaction, 2005,

http://rstb.royalsocietypublishing.org/content/360/1458/1309.full.pdf+html

16

Una è quella classica, ben radicata nella forma mentis occidentale contemporanea, basata (i) sul

dualismo cartesiano, che esclude la res cogitans dalla propria prospettiva di conoscenza, e (ii)

sulla fisica newtoniana, dimostratasi errata.

L’altra strada, è quella apertasi con la formulazione della Teoria della Relatività Generale e della

Meccanica Quantistica (la cui impostazione di fondo rimane comunque deterministica, altrimenti

non si chiamerebbe Meccanica).

3. Il Mondo deterministico

La scienza naturale non è semplicemente una descrizione

e una spiegazione della natura; essa è parte dell'azione

reciproca tra noi e la natura.

W. Heisenberg

Il mondo visto attraverso il paradigma newtoniano e illuminista è, come si è detto nel paragrafo

precedente, un mondo costituito da elementi deterministici di realtà che interagiscono

con altri elementi deterministici di realtà. La strutturazione degli oggetti e dei fenomeni che

osserviamo dentro e fuori di noi, avrebbe origine dalla diversa combinazione di elementi

fondamentali e irriducibili di realtà (come gli atomi di Democrito). Ogni combinazione è

predisposta da un codice (algoritmo), ovvero da una sequenza di operazioni che quando applicate

a certi dati iniziali portano ad un determinato risultato finale. La strutturazione degli oggetti e dei

fenomeni avverrebbe secondo lo schema, riduzionistico e meccanicistico, utilizzato nella ideazione,

progettazione e realizzazione di un sistema meccanico: una certa combinazione di building blocks

genera una certa struttura, che genera certi processi che grazie all’apporto di energia fanno

funzionare….. la macchina. Se si conosce il codice, e si è in possesso del materiale da combinare

(building blocks) e degli strumenti per operare19, è possibile riprodurre artificialmente quella

particolare combinazione di elementi.

Seguendo questa mappazione della realtà, gli scienziati di ieri e di oggi sono a caccia di building

blocks e dei codici per assemblarli, a tutti i livelli della materia, sub-atomico, atomico e sovraatomico, inorganico, organico e biologico, cellulare, di organo e di sistema.

Nel campo della fisica, ad es., il Modello Standard, ovvero la teoria fisica adottata agli inizi del 1970

per spiegare la composizione della materia, viene introdotto dal CERN con queste parole20: ….

everything in the universe is found to be made from a few basic building blocks called

fundamental particles, governed by four fundamental forces. Our best understanding of how

these particles and three of the forces are related to each other is encapsulated in the Standard

Model of particle physics.

19

In questo senso le bio-nano-tecnologie e la bioingegneria hanno fatto passi da gigante. Peccato che in un

settore come quello farmaceutico, circa il 40% delle sperimentazioni cliniche si dimostrino fallimentari, e

che continuino ad essere utilizzate migliaia di sostanze chimiche i cui effetti sugli esseri umani sono

semplicemente sconosciuti. Tanto che in alcuni Centri di ricerca, come il Los Alamos National Laboratory,

si sta tentando di correre ai ripari: Surrogate organ system developed for toxicity testing,

http://www.lanl.gov/discover/news-release-archive/2014/March/03.26-athena-desktop-human.php

20

CERN accelerating science, The Standard Model, http://home.web.cern.ch/about/physics/standard-model

Attualmente lo zoo delle particelle, come viene scherzosamente soprannominato l’insieme dei

building blocks-particelle, comprende circa cento esemplari, ed è destinato a crescere, tanto che

qualcuno (il fisico americano Murray Gell-Mann e il fisico svizzero George Zweig), intravedendo il

rischio che la libera moltiplicazione delle particelle-building blocks possa far collassare l’impianto

teorico su cui si regge tutto lo zoo (trasformandolo in un allevamento intensivo di particelle), ha

suggerito di considerare la maggior parte delle particelle note non come particelle fondamentali,

ma come particelle elementari costituite dalla combinazione di un numero ristretto di particelle

effettivamente fondamentali: i quarks.

Fig. 3

I sedici tipi di particelle fondamentali-building blocks dalla cui combinazione scaturisce lo zoo delle particelle di cui è

costituita la materia.

E nel campo della biologia?

3.1 Darwinismo super partes?

La nascita della teoria darwiniana dell’evoluzione, e il De profundis della teoria creazionista,

vengono fatti coincidere con la pubblicazione della prima edizione de Sull'origine delle specie per

mezzo della selezione naturale o la preservazione delle razze favorite nella lotta per la vita,

pubblicata il 24 Novembre 1859 presso l’editore Murray di Londra, anche se sarà solo con

l’edizione del 1871 che Darwin utilizzerà per la prima volta il termine evoluzione nella sua opera,

assieme all’aggiunta del concetto, espresso per primo dall’economista Thomas Robert Malthus e

poi dal filosofo positivista Herbert Spenser, di sopravvivenza del più forte, seguito, alla fine del

Cap. XV, da un esplicito richiamo alla magnificenza del Creatore (Darwin era consapevole di avere

dato il colpo di grazia alla teoria creazionista, ma evitò sempre di farsi coinvolgere in attacchi

contro la religione e da buon agnostico non negò mai l’esistenza di Dio, si preoccupò piuttosto di

dare alla Scienza ciò che era della Scienza e a Dio ciò che era di Dio): C'è qualcosa di grandioso in

questa idea della vita, con le sue infinite potenzialità, originariamente infuse dal Creatore in

pochissime o in una sola forma; e, mentre questo pianeta ha continuato a roteare seguendo le

immutabili leggi di gravità, da un inizio così semplice infinite forme, sempre più belle e

meravigliose, si sono evolute e tuttora si evolvono21.

L’opera fu accolta con grande interesse dalla comunità scientifica e intellettuale dell’epoca, che si

divise tra chi sosteneva e chi dissentiva dalla teoria espressa da Darwin, raccogliendo una strenua

opposizione, al limite dell’accusa di blasfemia, da parte dei sostenitori laici e religiosi della teoria

creazionista. Tra i positivisti europei, invece, la nuova teoria riscosse grande successo, tanto che lo

stesso Karl Marx, seppure meno entusiasta della teoria darwiniana di quanto non fosse l’amico

Friedrich Engels, nel 1873 inviò in omaggio a Darwin la seconda edizione, allora uscita, del II

volume del Capitale. La dedica autografa diceva: Al signor Charles Darwin da parte del suo

sincero ammiratore Karl Marx.

Come il suo predecessore e primo artefice di una teoria evoluzionista, il naturalista francese JeanBaptiste Lamarck (1744-1829), Darwin concepì e formulò la sua verità storica di ciò che secondo il

paradigma creazionista era considerato senza storia, basandosi sulle evidenze desunte dall’ampia

raccolta di dati empirici in suo possesso, dandone una interpretazione del tutto conforme alla

prospettiva di conoscenza elaborata dal pensiero positivista, di quello anglosassone in particolare,

che nell’800 era solidamente e irreversibilmente asceso al rango di dottrina della fede nella

Scienza.

La sua visione della Natura era deterministica. Per un uomo del suo tempo, determinismo voleva

dire la concezione esposta dal matematico e astronomo Pierre-Simon de Laplace nel Système du

monde (1814). Questa dottrina, che avrebbe dominato la scena fino alla rivoluzione concettuale

provocata dalla fisica quantistica, può essere riassunta così:

a) l'Universo è retto dalla causalità;

b) nella storia dell'universo ogni stato della materia è determinato da quello che lo precede e

determina quello che segue, secondo modalità analizzabili per mezzo della meccanica newtoniana;

c) la causalità consente la prevedibilità;

d) i fenomeni vengono descritti secondo il paradigma meccanicistico e deterministico che trae

forza dalla precisione e dal rigore della meccanica newtoniana;

e) il caso non esiste, è un concetto relativo ai limiti delle capacità umane: è infatti inconcepibile che

vi siano eventi che si sottraggono a una legge;

f) la rete causale dell'universo è tuttavia troppo complessa perché possa essere ricostruita dalla

mente umana; per questo tutte le conoscenze fisiche non possono essere che fondate sulla

probabilità.

Il modus operandi dell’evoluzione è fatto di prove e soprattutto di errori. L'unico fattore di ordine è

la selezione naturale. Questa, trasforma una improbabilità in una probabilità: fa di un evento

fortuito (la comparsa casuale di una variazione) l'inizio di un processo che, considerato

retrospettivamente, sembra indirizzato fin dall'inizio lungo una certa direzione, ma solo perché

tutti gli altri percorsi sono stati cancellati e quello che vediamo è l'unico superstite, o il più

appariscente fra i superstiti. Darwin dimostrava che le stesse cause che producevano

conservazione, stabilità ed equilibrio potevano produrre precarietà, distruzione e trasformazione.

21

There is grandeur in this view of life, with its several powers, having been originally breathed by the

Creator into a few forms or into one; and that, whilst this planet has gone circling on according to the fixed

law of gravity, from so simple a beginning endless forms most beautiful and most wonderful have been, and

are being evolved.

L'aspetto sereno, maestoso, lussureggiante della Natura coesisteva con l'aspetto tragico. La Natura

era insieme crudele e benefica, avara e prodiga.

Ma come si producono le differenze individuali all’interno di una specie, che sono il materiale da

costruzione con cui opera la selezione naturale? La base di partenza era il riconoscimento di una

variabilità spontanea delle specie in Natura, cioè del fatto che anche nello stesso ambiente gli

individui della medesima specie differiscono tutti l'uno dall'altro, seppure in modo impercettibile.

Questa variabilità è detta spontanea perché è un dato costante della Natura: è presente in tutti gli

ambienti e in tutte le condizioni. Le sue cause sono, secondo Darwin, le più disparate (clima, cibo,

abitudini di vita, effetti strani della riproduzione sessuale, ecc.), ma la variazione da sola non

spiega l'evoluzione. Infatti non tutte le variazioni hanno uguale importanza, non tutte possono

dare inizio a una linea evolutiva. Ognuna può risultare più o meno vantaggiosa delle altre, a

seconda delle circostanze: tutte devono passare attraverso il vaglio dell'ambiente, al quale spetta

l'ultima parola. La decisione avviene a un livello superiore, non più individuale, ma ecologico:

quello della selezione naturale. La formazione di specie nuove è dunque il risultato di due processi

distinti: la comparsa imprevedibile e costante di variazioni e la selezione severa esercitata

dall'ambiente.

Le variazioni, secondo Darwin, sono non solo spontanee, ma anche casuali. Questo concetto è

cruciale nella sua teoria. Parlando di variazioni casuali Darwin non intende dire che non hanno

una causa, ma che sono dovute a cause complesse e sconosciute: il termine caso sta a indicare la

nostra ignoranza delle cause, non la loro assenza.

Ma il termine casuale ha anche un altro significato, distinto logicamente ma inseparabile dal

primo: le variazioni non sono orientate a favorire la sopravvivenza dell'individuo. La singola

variazione non è di per sé la risposta giusta alle esigenze poste dall'ambiente; in altri termini, non

nasce per adattare l'organismo all'ambiente, non garantisce di per sé la sopravvivenza e il successo

riproduttivo; anzi, nella stragrande maggioranza dei casi le variazioni sono inutili o indifferenti,

alcune perfino dannose: eliminate queste ultime dalla selezione naturale, le altre rimangono, come

si dice oggi, fluttuanti, in attesa che l'ambiente si pronunci sul loro destino. Questo, però, non dà

istruzioni agli organismi su come modificarsi, ma si limita a giudicare, per così dire, il loro

comportamento spontaneo. Nella teoria darwiniana, l'organismo non si modifica per adattarsi:

varia e basta. Le variazioni si producono in molte direzioni, senza correlazione con le esigenze della

sopravvivenza. Se e quali siano adattative viene stabilito dalla rete complicatissima delle relazioni

ecologiche che costituiscono quell'ambiente particolare: la variazione propone, la selezione

dispone.

Il risultato implicito ottenuto dall’intreccio tra variazioni casuali e spontanee e selezione naturale,

equivale a ciò che il filosofo illuminista Immanuel Kant (1724-1804), tra i più convinti e influenti

esponenti della metafisica applicata per scopi pratici del settecento, definisce come: determinato

a priori nel fenomeno. Per Kant il caso non esiste, al suo posto esiste una necessità ipotetica del

reale, nel senso che si tratta semplicemente di effetti necessari conseguenti a precise cause

secondo leggi che stabiliscono che tutto quello che accade è determinato a priori nel fenomeno [I.

Kant, Analitica trascendentale, libro II, cap. II, sez. III].

Una necessità ipotetica del reale che, a ben vedere, non si discosta di molto dal tema del fato

presente nella poesia e nella tragedia greca arcaica, poi ripreso razionalmente dai filosofi greci

antichi e specialmente dallo stoicismo per poi giungere ai pensatori successivi, ivi compresi gli

illuministi settecenteschi.

Resta il fatto che in virtù della fede viscerale, nevrotica e tendenzialmente delirante, nella Scienza

super partes che dall’alto del Cielo iperuranico delle Idee (Platone) indica al superstizioso e

irrazionale uomo medievale la retta Via della Ragione, né Darwin né gli altri scienziati come lui

potevano essere minimamente toccati dall’idea che la loro interpretazione di realtà potesse di fatto

avere effetti catastrofici sull’umanità. La storia attesta di come la forte accelerazione impressa alle

scienze naturali e alla biologia in particolare dalla teoria darwinista dell’evoluzione, impallidisca di

fronte alle tragiche conseguenze prodotte dalla altrettanto decisiva e rigorosamente scientifica

accelerazione impressa a ciò che i positivisti e colonialisti europei e d’oltre oceano davano da

tempo per scontato, e cioè che la compiutezza della specie umana si realizzi solo nei suoi

rappresentanti maschi, inciviliti, benestanti, di pelle bianca. È grazie a questa visione scientifica

(?) della vita, che la civiltà occidentale si è sentita autorizzata a consegnare alla storia pagine e

pagine di crimini contro l’umanità, per poi rivolgerli con atto suicida oltre che omicida, contro se

stessa, sprofondando nei conflitti bellici più devastanti mai concepiti e realizzati a memoria

d’uomo.

Charles Darwin non era razzista o sessista più di quanto non lo fossero Engels e Marx, erano, però,

dei positivisti convinti e viscerali.

Scrive Darwin al Cap. V di The Descent of Man and Selection in Relation to Sex 22):

Nei selvaggi i deboli di corpo o di mente sono in breve eliminati; e quelli che sopravvivono

presentano comunemente una fiorente e robusta salute. D’altra parte noi, uomini inciviliti,

cerchiamo ogni mezzo onde porre ostacoli al processo di eliminazione; fabbrichiamo ricoveri per

gli idioti, gli storpi ed i malati; facciamo leggi pei poveri; e i nostri medici si stillano il cervello

per salvare la vita di ognuno fino all’ultimo momento. Vi è ragione per credere che il vaccino ha

preservato migliaia di vite, che con una debole costituzione sarebbero prima morte di vaiolo. Così

i membri deboli delle società incivilite si riproducono. Chiunque abbia avuto che fare

coll’allevamento degli animali domestici non leverà un dubbio che questo fatto non sia altamente

dannoso alla razza umana. Fa meraviglia come la mancanza di cure, e le cure male dirette

conducano alla degenerazione di una razza domestica; ma, eccettuato il caso dell’uomo stesso,

forse nessuno può essere tanto ignorante da far generare i suoi peggiori animali.

E al Cap. VI23:

Fra qualche tempo avvenire, non molto lontano se misurando per secoli, è quasi certo che le razze

umane incivilite stermineranno e si sostituiranno in tutto il mondo alle razze selvagge. Nello

stesso tempo le scimmie antropomorfe, come ha notato il prof. Schaaffhausen, saranno senza

dubbio sterminate. Allora la lacuna sarà ancora più larga, perchè starà tra l’uomo in uno stato

ancor più civile, speriamo, che non il caucusico, e qualche scimmia inferiore, come il babbuino,

invece di quella che esiste ora fra un nero od un australiano ed il gorilla.

E al Cap. VII24:

22

Charles Darwin, The Descent of Man and Selection in Relation to Sex, prima edizione, London, John

Murray, capitolo V, Dello sviluppo delle facoltà intellettuali e morali durante i tempi primitivi ed i tempi

inciviliti, 1871: With savages, the weak in body or mind are soon eliminated; and those that survive

commonly exhibit a vigorous state of health. We civilised men, on the other hand, do our utmost to check the

process of elimination; we build asylums for the imbecile, the maimed, and the sick; we institute poor-laws;

and our medical men exert their utmost skill to save the life of every one to the last moment. There is reason

to believe that vaccination has preserved thousands, who from a weak constitution would formerly have

succumbed to small-pox. Thus the weak members of civilised societies propagate their kind. No one who has

attended to the breeding of domestic animals will doubt that this must be highly injurious to the race of man.

It is surprising how soon a want of care, or care wrongly directed, leads to the degeneration of a domestic

race; but excepting in the case of man himself, hardly any one is so ignorant as to allow his worst animals to

breed.

23

Charles Darwin, The Descent of Man and Selection in Relation to Sex, prima edizione, London, John

Murray, capitolo VI, Delle affinità e della Genealogia dell’uomo, 1871: At some future period, not very

distant as measured by centuries, the civilised races of man will almost certainly exterminate and replace

throughout the world the savage races. At the same time the anthropomorphous apes, as Professor

Schaaffhausen has remarked, will no doubt be exterminated. The break will then be rendered wider, for it

will intervene between man in a more civilised state, as we may hope, than the Caucasian, and some ape as

low as a baboon, instead of as at present between the negro or Australian and the gorilla.

Quando le nazioni civili vengono in contatto coi barbari la lotta è breve, tranne ove un clima

mortale venga in aiuto della razza indigena. Fra le cause che fanno vittoriose le nazioni civili

alcune sono evidenti, altre oscurissime. Possiamo vedere che il coltivare la terra diviene fatale in

vario modo ai selvaggi perchè non possono o non vogliono mutare le loro abitudini. Nuove

malattie e i vizi nuovi sono causa di grande distruzione; e sembra che in ogni nazione una nuova

malattia produce molta mortalità, finchè quelli che sono più suscettivi alla sua mortale azione

non siano stati gradatamente portati via; e questo può anche seguire pei cattivi effetti dei liquori

spiritosi, come pure per l’invincibile gusto per essi che dimostrano tanti selvaggi. Sembra inoltre

per quanto questo fatto sia misterioso, che il primo incontro di popoli distinti e separati genera