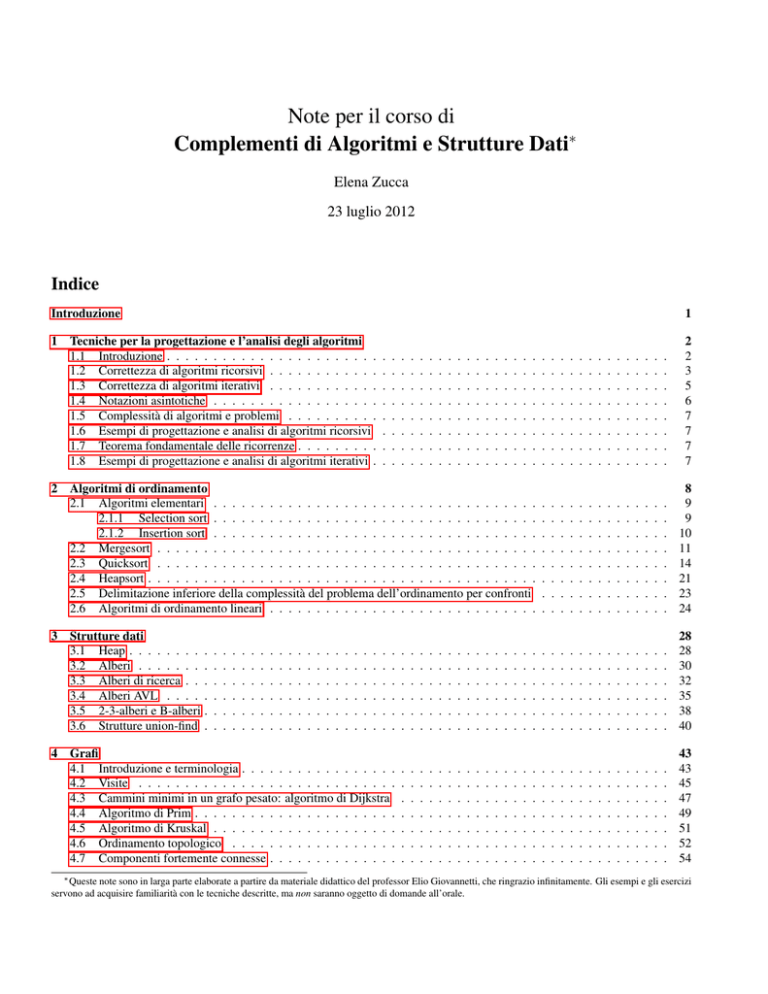

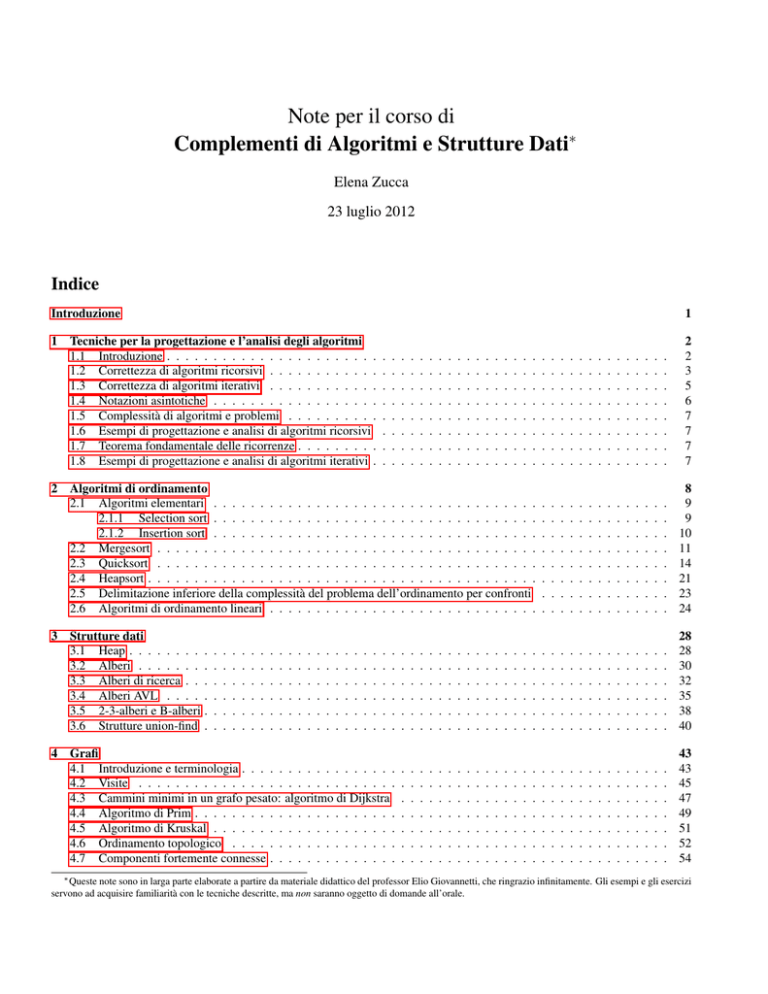

Note per il corso di

Complementi di Algoritmi e Strutture Dati∗

Elena Zucca

23 luglio 2012

Indice

Introduzione

1

2

3

4

1

Tecniche per la progettazione e l’analisi degli algoritmi

1.1 Introduzione . . . . . . . . . . . . . . . . . . . . . . .

1.2 Correttezza di algoritmi ricorsivi . . . . . . . . . . . .

1.3 Correttezza di algoritmi iterativi . . . . . . . . . . . .

1.4 Notazioni asintotiche . . . . . . . . . . . . . . . . . .

1.5 Complessità di algoritmi e problemi . . . . . . . . . .

1.6 Esempi di progettazione e analisi di algoritmi ricorsivi

1.7 Teorema fondamentale delle ricorrenze . . . . . . . . .

1.8 Esempi di progettazione e analisi di algoritmi iterativi .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

2

2

3

5

6

7

7

7

7

Algoritmi di ordinamento

2.1 Algoritmi elementari . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.1 Selection sort . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.1.2 Insertion sort . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.2 Mergesort . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.3 Quicksort . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.4 Heapsort . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.5 Delimitazione inferiore della complessità del problema dell’ordinamento per confronti

2.6 Algoritmi di ordinamento lineari . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

8

9

9

10

11

14

21

23

24

Strutture dati

3.1 Heap . . . . . . . . .

3.2 Alberi . . . . . . . .

3.3 Alberi di ricerca . . .

3.4 Alberi AVL . . . . .

3.5 2-3-alberi e B-alberi .

3.6 Strutture union-find .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

28

28

30

32

35

38

40

Grafi

4.1 Introduzione e terminologia . . . . . . . . . . . . . . . . .

4.2 Visite . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3 Cammini minimi in un grafo pesato: algoritmo di Dijkstra

4.4 Algoritmo di Prim . . . . . . . . . . . . . . . . . . . . . .

4.5 Algoritmo di Kruskal . . . . . . . . . . . . . . . . . . . .

4.6 Ordinamento topologico . . . . . . . . . . . . . . . . . .

4.7 Componenti fortemente connesse . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

43

43

45

47

49

51

52

54

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

∗ Queste note sono in larga parte elaborate a partire da materiale didattico del professor Elio Giovannetti, che ringrazio infinitamente. Gli esempi e gli esercizi

servono ad acquisire familiarità con le tecniche descritte, ma non saranno oggetto di domande all’orale.

5

Teoria della NP-completezza

5.1 Problemi astratti e concreti e classe P

5.2 Classe NP . . . . . . . . . . . . . . .

5.3 Problemi NP-completi . . . . . . . .

5.4 Algoritmi di approssimazione . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

A Relazioni d’ordine e di equivalenza

1

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

55

56

57

59

62

63

Tecniche per la progettazione e l’analisi degli algoritmi

1.1

Introduzione

Un problema algoritmico (o computazionale) consiste di:

• precondizione: una specifica precisa dei dati di partenza (input) e delle condizioni che devono essere da essi soddisfatte

• postcondizione: una specifica precisa delle condizioni che devono essere soddisfatte dai dati di uscita (output), e in particolare della relazione che vi deve essere fra l’input e l’output, ossia una specifica R(x, y) che definisca qual è, per ogni

istanza x dell’input, la risposta o l’insieme delle possibili risposte y che si vogliono ottenere.

Esempi di problemi algoritmici:

Problema del massimo di una sequenza di interi Data una sequenza non vuota di numeri interi, trovare il massimo di tale

sequenza e l’indice di un tale valore massimo nella sequenza.

Problema dell’ordinamento di una sequenza Data una sequenza di elementi presi da un insieme su cui è definita una relazione

d’ordine totale, trovare una permutazione di tale sequenza che sia ordinata.

Problema della ricerca in una sequenza ordinata Data una sequenza ordinata di elementi e dato un elemento determinare se

esso compare nella sequenza o no, e l’indice del posto in cui compare.

Problema del cammino minimo Data una mappa stradale che riporti località, strade e lunghezze dei percorsi, e data una coppia

di località (raggiungibili l’una dall’altra), trovare un percorso di lunghezza minima fra di esse.

Problema della distanza di editing Date due stringhe, trovare la più corta sequenza di operazioni (di inserimento, cancellazione

e modifica) che trasforma una stringa nell’altra.

La soluzione di un problema algoritmico è un algoritmo, ossia (la descrizione precisa di) un procedimento “meccanico” che

permetta, per ogni input soddisfacente alla relativa specifica di trovare un output che soddisfi alla relativa specifica.

Un algoritmo è corretto (risolve il problema computazionale dato) se per ogni istanza di input termina con l’output corretto.

Uno stesso problema può essere risolto da molti algoritmi, che possono richiedere un numero di operazioni elementari e uno

spazio di memoria molto diversi l’uno dall’altro. Domande fondamentali:

• un dato algoritmo quanto tempo ci mette, e di quanto spazio di memoria ha bisogno, per produrre la risposta per un input

di una data dimensione?

• qual è la massima dimensione dell’input per la quale l’algoritmo produce una risposta in un tempo accettabile e con

un’occupazione di memoria accettabile?

• dato un problema, si può trovare un algoritmo migliore di quelli esistenti per risolvere quel problema?

Per rispondere a queste domande definiremo con precisione le nozioni di complessità temporale e spaziale di un algoritmo.

L’efficienza o addirittura la definibilità di un algoritmo è spesso legata al modo in cui i dati sono rappresentati in memoria, cioè

alla struttura dati scelta. Per esempio, una soluzione del problema della ricerca in una sequenza ordinata è data dall’algoritmo di

ricerca binaria; tale soluzione è sensata, perché molto più efficiente della ricerca sequenziale, solo se la sequenza è realizzata per

mezzo di un array (o di un albero di ricerca), non se la sequenza è realizzata come una lista. Lo studio degli algoritmi è quindi

inseparabile dallo studio delle strutture dati.

2

1.2

Correttezza di algoritmi ricorsivi

È basata sul principio di induzione, di cui casi particolari sono il principio di induzione aritmetica e quello di induzione aritmetica

completa, ma che più in generale si applica a qualunque insieme definito induttivamente. Vediamo cosa significa.

Def. 1.1 [Definizione induttiva] Una definizione induttiva R è un insieme di regole Pr

c , dove Pr è un insieme detto delle premesse

e c è un elemento, detto la conseguenza della regola. L’insieme definito induttivamente I(R) è il più piccolo tra gli insiemi X

chiusi rispetto a R, ossia tali che, per ogni regola Pr

c ∈ R, se Pr ⊆ X allora c ∈ X.

In altre parole, I(R) è l’insieme di tutti e soli gli elementi che si ottengono applicando ripetutamente le regole, a partire da quelle

con premessa vuota che costituiscono la base della definizione induttiva.

Una definizione induttiva è in genere data attraverso una qualche descrizione finita “a parole”, per esempio:

L’insieme dei numeri pari è il più piccolo insieme tale che (oppure: è l’insieme definito induttivamente da):

• 0 è un numero pari,

• se n è un numero pari, allora n + 2 è un numero pari.

Questa descrizione corrisponde all’insieme (infinito) di regole:

∅

0

n

∪ { n+2

| n ∈ N}.

Prop. 1.2 [Principio di induzione (forma generale)] Sia R una definizione induttiva, I(R) ⊆ U , e P un predicato su U .

Se, per ogni Pr

c ∈ R,

(P (d) vale per ogni d ∈ Pr ) implica che valga P (c)

(?)

allora P (d) vale per ogni d ∈ I(R).

Dimostrazione Poniamo C = {d | P (d) vero} e osserviamo che la condizione (?) può essere scritta nella forma equivalente:

Pr ⊆ C implica c ∈ C.

Allora è chiaro che C risulta chiuso rispetto a R, quindi I(R) ⊆ C, quindi P (d) vale per ogni d ∈ I(R).

Si noti che nel caso Pr = ∅ richiedere la condizione (?) equivale a richiedere che P (c) sia vero. Ciò suggerisce la seguente

formulazione equivalente che è quella comunemente usata:

Sia R una definizione induttiva, I(R) ⊆ U , e P un predicato su U .

Se

Base P (c) vale per ogni

∅

c

∈R

Passo induttivo (P (d) vale per ogni d ∈ Pr ) implica che valga P (c) per ogni

Pr

c

∈ R, Pr 6= ∅

allora P (d) vale per ogni d ∈ I(R).

Vediamo alcuni casi particolari del principio di induzione.

Prop. 1.3 [Principio di induzione aritmetica] Sia P un predicato sui numeri naturali tale che

Base vale P (0)

Passo induttivo se vale P (n) allora vale P (n + 1),

allora P (n) vale per ogni n ∈ N.

Dimostrazione N può essere visto come l’insieme definito induttivamente da

• 0∈N

• se n ∈ N allora n + 1 ∈ N.

Quindi la proposizione è un caso particolare del principio di induzione.

Vediamo un esempio di applicazione.

Esempio 1.4 Proviamo per induzione aritmetica che 20 + 21 + ... + 2n = 2n+1 − 1, per tutti gli n ∈ N.

Base P (0): 20 = 1 = 21 − 1

3

Passo induttivo Assumiamo P (i) e dimostriamo P (i + 1):

20 + 21 + ... + 2i+1

= (20 + 21 + ... + 2i ) + 2i+1

= (2i+1 − 1) + 2i+1

= 2 · (2i+1 ) − 1

= 2i+2 − 1

(per ipotesi induttiva)

Esercizio 1.5

1. Si dimostri che 1 + 2 + ... + n = n(n + 1)/2.

2. Si dimostri che 12 + 22 + 32 + ... + n2 = n(n + 1)(2n + 1)/6.

Prop. 1.6 [Principio di induzione aritmetica completa] Sia P un predicato sui numeri naturali tale che

Base vale P (0)

Passo induttivo se vale P (m) per ogni m < n allora vale P (n),

allora P (n) vale per ogni n ∈ N.

Dimostrazione N può essere visto come l’insieme definito induttivamente da

• 0∈N

• se {m | m < n} ⊆ N allora n ∈ N.

Quindi la proposizione è un caso particolare del principio di induzione.

Esempio 1.7 Un altro esempio: possiamo dare una definizione induttiva degli alberi binari (con nodi in N ) :

• l’albero vuoto è un albero binario,

• se L e R sono alberi binari e x ∈ N , allora la tripla (x , L, R) è un albero binario.

Di conseguenza, è possibile provare proprietà degli alberi binari con il principio di induzione, che prende la seguente forma:

Sia P un predicato sugli alberi binari tale che

• P vale sull’albero vuoto,

• se P vale su L e R, allora vale su (x , L, R),

allora P vale su tutti gli alberi binari.

Esercizio 1.8 Dare una definizione induttiva delle liste e formulare il corrispondente principio di induzione.

Se abbiamo un algoritmo ricorsivo il cui input varia in un insieme definito induttivamente, e definito a sua volta in modo induttivo

(ossia ricalcando la definizione induttiva dell’insieme), è facile provare la correttezza dell’algoritmo con il principio di induzione.

Per esempio nel caso di un algoritmo sui numeri naturali:

• se l’algoritmo è corretto per 0

• e assumendo che sia corretto per n, è corretto per n + 1,

allora è corretto su qualunque numero naturale. Analogamente si può applicare il principio di induzione arimetica completa o il

principio di induzione per alberi, liste, etc.

Inoltre, il principio di induzione non solo ci consente di provare a posteriori la correttezza di un algoritmo, ma fornisce anche

una guida per il suo sviluppo. Per esempio, nel caso dell’induzione aritmetica:

• si scrive l’algoritmo corretto per 0

• se l’argomento è n > 0, si assume che l’algoritmo sappia operare correttamente su n − 1, e fidandosi di tale assunzione si

scrive l’algoritmo corretto per operare su n.

L’esempio “classico” è l’algoritmo ricorsivo per il fattoriale. Analogamente si ha per altri tipi di induzione.

4

Esempio 1.9 [Algoritmo di Euclide] È nota la seguente proprietà: MCD(a, b) = MCD(b, a mod b) dove a mod b è il resto

della divisione intera di a per b.

Base Sappiamo calcolare direttamente MCD(a, 0) per qualunque a, poiché esso è semplicemente a. Quindi mcd(a,0)=a.

Passo induttivo (b > 0).

Ipotesi induttiva La funzione mcd calcola correttamente MCD(a, b0 ) per qualunque b0 < b (per qualunque a).

Tesi induttiva mcd(a,b) = mcd(b, a mod b) calcola correttamente MCD(a, b). Dimostrazione: si applica la

proprietà nota, e poiché a mod b < b, si può sfruttare l’ipotesi induttiva.

Il principio di induzione è implicitamente alla base, come vedremo, anche della scrittura di algoritmi iterativi corretti.

1.3

Correttezza di algoritmi iterativi

Come si scrive un algoritmo iterativo “in modo che sia corretto”?

//Pre: precondizione = quello che sappiamo essere vero all’inizio

while (B)

C

//Post: postcondizione = quello che vogliamo sia vero alla fine

L’algoritmo è corretto se, assumendo che valga Pre all’inizio, possiamo concludere che vale Post alla fine.

Cos’è un’invariante di ciclo? qualunque condizione Inv tale che:

//Pre: Inv ∧ B

C

//Post: Inv

cioè, se devo eseguire il corpo del ciclo e la condizione vale, allora vale anche dopo averlo eseguito.

Quando un’invariante serve a provare la correttezza?

• Inv vale all’inizio

• se valgono insieme Inv e ¬ B e allora vale Post.

Infatti, in questo caso è facile vedere per induzione aritmetica sul numero di iterazioni che, assumendo che il comando termini,

alla fine vale Post. Come si prova la terminazione? trovando una quantità t (funzione di terminazione) tale che, se devo eseguire

il corpo, quindi se valgono Inv e B:

• viene decrementata eseguendo il corpo

• è limitata inferiormente.

Esempio 1.10 [Esempio “didattico”]

//Pre: x = x0 ∧ y = y0 ∧ x ≥ 0

while (x != 0)

x = x-1

y = y+1

//Post: y = x0 + y0

Ci sono molte invarianti, per esempio x ≥ 0, x ≤ x0 , y ≥ y0 , true, false, ma quella che mi serve è x + y = x0 + y0 ∧ x ≥ 0.

//Pre: x = x0 ∧ y = y0 ∧ x ≥ 0

while (x!=0) //Inv: x + y = x0 + y0 ∧ x ≥ 0

x = x-1

y = y+1

//Post: y = x0 + y0

Infatti:

• vale banalmente all’inizio

• se vale insieme a x = 0, allora vale la postcondizione.

5

• se vale insieme a x 6= 0 prima di eseguire il corpo, allora vale dopo

La funzione di terminazione che mi serve è il valore di x, infatti:

• viene decrementato a ogni passo

• assumendo che valga Inv (quindi x ≥ 0), è limitato inferiormente da 0.

Metodologia: l’invariante si ottiene in genere “indebolendo” la postcondizione, in modo da modellare il “risultato parziale

al passo generico”. L’invariante non serve solo per provare la correttezza a posteriori, ma soprattutto come guida allo sviluppo

dell’algoritmo. In molti algoritmi iterativi, inclusi una buona parte di quelli che vedremo, l’idea iniziale è “una buona invariante”.

Una volta trovata la proprietà invariante, si scrivono nell’ordine: il corpo del ciclo in modo che produca un avvicinamento alla

soluzione, la condizione di controllo in modo che in uscita si abbia la postcondizione, l’inizializzazione in modo da garantire che

l’invariante valga inizialmente. Vedremo esempi di questa metodologia nella sezione sezione 1.8.

1.4

Notazioni asintotiche

Def. 1.11 Una funzione g(n) è O(f (n)) se esistono due costanti c > 0 e n0 ≥ 0 tali che g(n) ≤ cf (n) per ogni n ≥ n0 , ossia,

da un certo punto in poi, g sta sotto una funzione “multipla” di f (“cresce al più come f ”).

Una funzione g(n) è Ω(f (n)) se esistono due costanti c > 0 e n0 ≥ 0 tali che g(n) ≥ cf (n) per ogni n ≥ n0 , ossia, da un certo

punto in poi, f sta sopra una funzione “sottomultipla” di f (“cresce almeno come f ”).

Una funzione g(n) è Θ(f (n)) se esistono tre costanti c1 , c2 > 0 e n0 ≥ 0 tali che c1 f (n) ≤ g(n) ≤ c2 f (n) per ogni n ≥ n0 ,

ossia, da un certo punto in poi, f è compresa tra un multiplo di f e un sottomultiplo di f (“cresce come f ”).

Le espressioni “multiplo” e “sottomultiplo” sono un abuso di linguaggio, giustificato dalla seguente osservazione: nella definizione di O è significativo il fatto che c possa essere maggiore di uno, mentre nella definizione di Ω è significativo che c possa

essere minore di uno.

Per comodità si usa scrivere f (n) = O(g(n)) invece di f (n) è O(g(n)), e analogamente per le altre notazioni. Occorre però

ricordare che si tratta di un abuso di notazione, poiché il simbolo = in questo caso non denota un’uguaglianza, ma l’appartenenza

a un insieme.

Proprietà della notazione asintotica

Transitiva

f (n) = O(g(n)) e g(n) = O(h(n)) implica f (n) = O(h(n))

f (n) = Ω(g(n)) e g(n) = Ω(h(n)) implica f (n) = Ω(h(n))

f (n) = Θ(g(n)) e g(n) = Θ(h(n)) implica f (n) = Θ(h(n))

Riflessiva

f (n) = O(f (n))

f (n) = Ω(f (n))

f (n) = Θ(f (n))

Simmetrica f (n) = Θ(g(n)) se e solo se g(n) = Θ(f (n))

Simmetrica trasposta f (n) = O(g(n)) se e solo se g(n) = Ω(f (n))

Comportamenti notevoli Trattabili

Θ(1)

costante

Θ(log n)

logaritmico

Θ(log n)k

poli-logaritmico

radice quadrata

Θ(n1/2 )

Θ(n)

lineare

Θ(n log n) pseudolineare

Θ(n2 )

quadratico

Θ(n3 )

cubico

Intrattabili

Θ(2n ) esponenziale

Θ(n!) fattoriale

Θ(nn ) esponenziale in base n

6

1.5

Complessità di algoritmi e problemi

In generale sia il numero di passi elementari che lo spazio richiesto da un algoritmo dipendono dalla dimensione n dell’input.

Tuttavia, in generale non sono funzioni di n, perché, a parità di dimensione, input diversi possono richiedere un tempo di calcolo

e un’occupazione di memoria molto diversi (per esempio, l’algoritmo di ordinamento insertion sort effettua Θ(n) confronti nel

caso di una sequenza ordinata, mentre in altri casi ne effettua Θ(n2 )). Scrivere T (n) ed S (n) sarebbe quindi ambiguo: occorre

distinguere, per ogni n, caso migliore, caso peggiore e caso medio. Formalmente, se i è un’istanza di input, siano t(i ) e s(i )

il tempo di esecuzione e lo spazio di memoria necessario 1 per l’esecuzione dell’algoritmo per l’input i . Le seguenti funzioni

risultano allora ben definite:

complessità temporale del caso peggiore Tworst (n) = max{t(i ) | i ha dimensione n}

complessità temporale del caso migliore Tbest (n) = min{t(i ) | i ha dimensione n}

complessità temporale del caso medio Tavg (n) = avg{t(i ) | i ha dimensione n}

Queste tre funzioni possono non avere forme matematiche elementari, ma hanno di solito andamenti asintotici ben definiti.

Analoghe definizioni si possono dare per la complessità spaziale.

Per il caso medio, per ogni n si considerano tutti i possibili input di dimensione n, siano i1 , . . . iN , e si fa la media aritmetica dei

tempi:

Tavg (n) =

t(i1 )+...+t(iN )

N

Tuttavia, se i possibili casi di input non sono equiprobabili, ma si presentano con probabilità p1 , . . . , pN con p1 + . . . + pN = 1,

la media deve essere una media pesata:

Tavg (n) =

p1 ·t(i1 )+...+pN ·t(iN )

N

Si noti che (anche nel caso equiprobabile) si fa la media sui diversi casi, non sui diversi tempi (analogia con media dei voti).

[MANCA UNA PARTE: VEDI LUCIDI 2]

1.6

Esempi di progettazione e analisi di algoritmi ricorsivi

Esempio 1.12 [Torri di Hanoi] [VEDI LUCIDI 2]

Esempio 1.13 [Ricerca binaria] [VEDI LUCIDI 2]

1.7

Teorema fondamentale delle ricorrenze

[VEDI LUCIDI 2]

1.8

Esempi di progettazione e analisi di algoritmi iterativi

Esempio 1.14 [Ricerca binaria iterativa] Sia la sequenza rappresentata con un array a con indici 0..n − 1. Idea: si confronta

l’elemento da cercare con l’elemento centrale dell’array, a seconda del risultato ci si restringe a considerare solo la prima o la

seconda metà, e cosı̀ via. Idea per l’invariante: al passo generico il valore da cercare x, se presente nell’array, si trova nella

porzione di array compresa fra due indici inf e sup, formalmente:

x ∈ a[0..n − 1] ⇒ x ∈ a[inf..sup]

Guidati da questa invariante:

Passo confronto con x l’elemento centrale a[mid] della porzione a[inf..sup], sono possibili tre casi:

• x < a[mid]: x, se c’è, si trova nella porzione a[inf..mid − 1], quindi sup = mid-1

• x > a[mid]: x, se c’è, si trova nella porzione a[mid + 1..sup], quindi inf = mid+1

• x = a[mid]: ho trovato x, fine!

Condizione di controllo la porzione di array su cui effettuare la ricerca non deve essere vuota, quindi inf ≤ sup

1 In

aggiunta allo spazio occupato dallinput stesso.

7

Inizializzazione inizialmente la porzione di array su cui effettuare la ricerca è l’intero array, quindi inf = 0 e sup = n − 1.

Algoritmo completo:

binary_search(x,a)

inf = 0; sup = n-1 //Pre: inf = 0 ∧ sup = n − 1

while (inf <= sup) //Inv: x ∈ a[0..n − 1] ⇒ x ∈ a[inf..sup]

mid = (inf + sup)/2

if (x < a[i]) sup = mid-1

else if (x > a[i]) inf = mid+1

else return true

//Post: x 6∈ a[0..n − 1]

return false

Vediamo ora un altro esempio in cui il ruolo dell’invariante è ancora più significativo.

Esempio 1.15 [Bandiera nazionale olandese] Si ha una sequenza di n elementi rossi, bianchi e blu. Vogliamo modificare la

sequenza in modo da avere prima tutti gli elementi rossi, poi tutti i bianchi, poi tutti i blu. Le operazioni che possiamo effettuare

sulla sequenza sono:

• swap(i,j) scambia di posto due elementi, per 1 ≤ i, j ≤ n

• colour(i) restituisce Red, White, Blue per 1 ≤ i ≤ n

Vogliamo inoltre esaminare ogni elemento una volta sola.

Indichiamo con Red (i, j) il predicato “gli elementi da i a j compresi sono tutti rossi” e analogamente White(i, j), Blue(i, j).

Siano inoltre U, W e B gli indici del primo elemento ignoto, bianco e blu. La postcondizione sarà quindi:

Red (1, W − 1) ∧ White(W, B − 1) ∧ Blue(B, n)

e l’invariante:

Red (1, U − 1) ∧ White(W, B − 1) ∧ Blue(B, n) ∧ U ≤ W

(l’ultima condizione nell’invariante è aggiunta per chiarezza).

Algoritmo completo:

//Pre: U = 1 ∧ W = B = n + 1

while (U < W) //Inv: Red (1, U − 1) ∧ White(W, B − 1) ∧ Blue(B, n) ∧ U ≤ W

switch (Colour(W-1)

case Red : swap(U, W-1); U = U + 1

case White : W = W - 1

case Blue : swap(W-1, B-1); W = W-1; B = B-1

//Post: Red (1, W − 1) ∧ White(W, B − 1) ∧ Blue(B, n)

Prova di correttezza:

• Inv vale all’inizio banalmente

• Inv ∧ U ≥ W implica Post perché is ha U = W

• se vale Inv e U < W eseguendo il corpo del ciclo vale ancora Inv : si vede per casi

• come funzione di terminazione possiamo prendere W − U, infatti decresce eseguendo il corpo del ciclo in ognuno dei casi,

e se vale la condizione di controllo è limitata inferiormente.

2

Algoritmi di ordinamento

Problema dell’ordinamento: data una sequenza di elementi, ordinarla rispetto a una relazione d’ordine totale definita sugli

elementi, per esempio rispetto a una chiave. Gli algoritmi che risolvono tale problema, cioè gli algoritmi di ordinamento, sono

classificabili secondo diversi criteri, quali la complessità asintotica, oppure il fatto che godano o no di certe proprietà interessanti.

8

Stabilità Un algoritmo di ordinamento si dice stabile se non altera l’ordine relativo di oggetti distinti che siano uguali rispetto

alla relazione d’ordine. Ossia, se nella sequenza da ordinare vi sono due elementi x e y uguali rispetto alla relazione d’ordine,

e x si trova prima di y, anche nella sequenza ordinata x deve trovarsi prima di y. Se una sequenza di elementi già ordinata

secondo un certo criterio viene ordinata secondo un altro criterio per mezzo di un algoritmo stabile, elementi uguali secondo il

nuovo criterio risultano ordinati secondo il precedente criterio. Per esempio, se una sequenza di persone è ordinata per nome,

ordinandola per cognome con un algoritmo stabile si ottiene una sequenza in cui le persone con lo stesso cognome sono ordinate

per nome. Naturalmente la stabilità non ha importanza se elementi uguali rispetto alla relazione d’ordine non sono distinguibili

(per esempio una sequenza di interi).

Algoritmi sul posto Un algoritmo di ordinamento si dice sul posto (o in loco, o in place) se la memoria aggiuntiva (oltre a

quella necessaria per l’input ed eventualmente per la ricorsione) utilizzata è costante, ossia se l’algoritmo riordina la sequenza

senza usare una sequenza ausiliaria o comunque uno spazio proporzionale al numero di elementi.

2.1

Algoritmi elementari

2.1.1

Selection sort

Sia la sequenza rappresentata con un array a con indici 0..n − 1. Idea: si cerca il minimo dell’array e lo si mette al primo posto

(mettendo il primo al posto del minimo), poi si cerca il minimo nella parte di array dal secondo elemento alla fine, e lo si mette

al secondo posto, e cosı̀ via. Invariante, assumendo che i sia il primo elemento ancora non esaminato:

• ordered (a, 0, i − 1)

• ∀h ∈ 0..i − 1, l ∈ i..n − 1.a[h] ≤ a[l] (lo abbreviamo a[0..i − 1] ≤ a[i..n − 1])

Si noti che ogni elemento della parte ordinata è al suo posto definitivo (a differenza di insertion sort, vedi dopo).

Passo Si scambia a[i] con l’elemento di valore minimo in a[i..n − 1], si ottiene:

• ordered (a, 0, i)

• a[0..i] ≤ a[i + 1..n − 1]

quindi incrementando i l’invariante vale ancora.

Condizione di uscita Non occorre controllare l’ultimo elemento, perché in base alla seconda condizione nell’invariante è già al

posto giusto, quindi i < n − 1.

Inizializzazione La parte da ordinare a[i..n − 1] è l’intero array, quindi i = 0.

Algoritmo completo con asserzioni (l’ultima condizione nell’invariante è aggiunta per chiarezza):

selectsort(a)

i = 0 //Pre: i = 0

while (i<n-1) //Inv: ordered (a, 0, i − 1) ∧ a[0..i − 1] ≤ a[i..n − 1] ∧ i ≤ n − 1

swap(a,i,indexMinFrom(a, i))

i++

//Post: ordered (a, 0, n − 1)

• Pre ⇒ Inv perché 0..i − 1 vuoto

• Inv ∧ i ≥ n − 1 ⇒ Post perché si ha i = n − 1, quindi ordered (a, 0, n − 2) ∧ a[0..n − 2] ≤ a[n − 1]

• Inv si mantiene

• terminazione: n − 1 − i decresce a ogni passo e se vale la condizione di controllo è limitata inferiormente.

L’algoritmo può ovviamente essere realizzato con un for:

for(i = 0; i<n-1; i++)

swap(a,i,indexMinFrom(a, i))

9

Complessità temporale della procedura indexMinFrom: deve percorrere a[i..n − 1], quindi n − i passi.

Complessità temporale dell’algoritmo di ordinamento: indexMinFrom viene invocata per i che varia da 0 a n − 2, il numero

totale di passi è quindi:

n + (n − 1) + (n − 2) + ... + 3 + 2 = n(n + 1)/2 − 1 = n2 +

n

2

−1

L’algoritmo è quadratico. A differenza di insertion sort (vedi dopo) non esistono un caso peggiore e un caso migliore: il numero

di passi non dipende dal modo in cui sono disposti i valori nell’array. Selection sort è quindi un algoritmo peggiore di insertion

sort, che, pur essendo anch’esso in media quadratico, ha un caso migliore lineare.

Complessità spaziale: l’algoritmo non usa array ausiliari, ma solo un numero fissato (e piccolo) di variabili. È pertanto un

ordinamento sul posto. Inoltre, essendo un algoritmo iterativo, la dimensione dello stack è costante. La complessità spaziale è

quindi Θ(1).

Stabilità: come quasi tutti gli algoritmi di ordinamento basati su scambi, il selection sort non è stabile. Esercizio: trovare un

esempio che lo mostri.

2.1.2

Insertion sort

Sia la sequenza rappresentata con un array a con indici 0..n − 1. Idea: si prende il primo elemento non ancora esaminato e lo si

inserisce al posto giusto nella parte già ordinata. Invariante, assumendo che i sia il primo elemento ancora non esaminato:

ordered (a, 0, i − 1)

Passo Inserisco a[i] al posto giusto in a[0..i − 1], si ottiene ordered (a, 0, i), quindi incrementando i l’invariante vale ancora.

Condizione di controllo i < n.

Inizializzazione Un array di un solo elemento è ordinato quindi i = 1.

Algoritmo completo con asserzioni (l’ultima condizione nell’invariante è aggiunta per chiarezza):

insertsort(a)

i = 1 //Pre: i = 1

while (i < n) //Inv: ordered (a, 0, i − 1) ∧ i ≤ n

insert(a,a[i],i)//inserisce a[i] al posto giusto in a[0..i − 1]

//ordered (a, 0, i)

i++

//Post: ordered (a, 0, n − 1)

• Pre ⇒ Inv perché a[0..0] ordinato

• Inv ∧ i ≥ n ⇒ Post perché si ha i = n

• Inv si mantiene

• terminazione: n − i decresce a ogni passo e se vale la condizione di controllo è limitata inferiormente.

Inserimento di x in a[0..i − 1]. Idea: confrontiamo x con gli elementi in a[0..i − 1], a partire dall’ultimo, e se è minore li

spostiamo di un posto a destra finché non troviamo l’indice in cui inserire x.

j = i //Pre: j = i ∧ ordered (a, 0, i − 1)

while(j > 0 && x < a[j-1])//Inv: ordered (a, 0, j − 1) ∧ ordered (a, j + 1, i) ∧ x < a[j + 1..i] ∧ j ≥ 0

a[j] = a[j-1]

j--;

//Post: Inv ∧ (j = 0 ∨ x ≥ a[j − 1])

a[j] = x

//ordered (a, 0, i)

• Pre ⇒ Inv perché j + 1..i risulta vuoto

• Inv ∧ ¬(j > 0 ∧ x < a[j − 1]) è proprio Post

• Inv si mantiene

10

• terminazione: j decresce a ogni passo e se vale la condizione di controllo è limitato inferiormente.

Se si esce dal ciclo con j = 0, dopo l’assegnazione si ha a[0] < a[1..i] e ordered (a, 1, i), da cui la tesi. Se si esce dal ciclo

con x ≥ a[j − 1], dopo l’assegnazione si ha a[j − 1] ≤ a[j] < a[j + 1..i], ordered (a, 0, j − 1) e ordered (a, j + 1, i), da cui

la tesi.

Complessità temporale dell’algoritmo di inserimento:

• caso migliore: valore da inserire maggiore o uguale dell’ultimo elemento della parte ordinata, un solo confronto

• caso peggiore: valore da inserire minore di tutti gli elementi della parte ordinata, i confronti

• caso medio: numero medio di confronti = (1 + ... + i)/i = i(i + 1)/2i = (i + 1)/2

Complessità temporale dell’algoritmo di ordinamento: il ciclo viene eseguito per i che varia da 1 a n − 1

• caso migliore: array ordinato, ogni inserimento fa un solo confronto, in totale n − 1 confronti

• caso peggiore: array ordinato inversamente, numero totale di confronti 1 + 2 + 3 + ... + n − 1 = n(n − 1)/2 = n2 /2 − n2

• caso medio: 1/2(2 + 3 + ... + n) = 1/2(n(n + 1)/2 − 1) = n2 /4 + n/4 − 1/2.

L’algoritmo è O(n2 ), perché è Θ(n2 ) nel caso peggiore, è Ω(n), perché è Θ(n) nel caso migliore, ma non è Θ(n2 ) nè Θ(n): per

ogni dimensione n vi sono sia input per cui il tempo è proporzionale a n, sia input per cui è proporzionale a n2 . Complessità

spaziale: come il selection sort, è iterativo e non usa array ausiliari (algoritmo sul posto), quindi S(n) = Θ(1). Inoltre è stabile.

Per esercizio: si spieghi perché.

2.2

Mergesort

Problema preliminare: date due sequenze ordinate, (fonderle in modo da) ottenere una sequenza degli stessi elementi ordinata.

Idea: si percorrono contemporaneamente le due sequenze inserendo ogni volta in fondo alla sequenza risultato il più piccolo dei

due elementi di testa.

Algoritmo con asserzioni, assumendo le due sequenze rappresentate con due array a e b con indici, rispettivamente, 0..n − 1 e

0..m − 1, e la sequenza risultato rappresentata con un array c con indici 0..n + m − 1, e le asserzioni ordered (a, 0, n − 1) e

ordered (b, 0, m − 1) costantemente vere in quanto questi array non vengono modificati:

merge(a,b)

i = 0; j = 0 \\Pre: i = 0 ∧ j = 0

while (i < m && j < n)

\\ Inv: c[0..i + j − 1] = merge(a[0..i − 1], b[0..j − 1]) ∧ i ≤ m ∧ j ≤ n

if(a[i] <= b[j]) c[i+j] = a[i]; i++

else c[i+j] = b[j]; j++

\\Post: Inv∧(i = m ∨ j = n)

while (i < m) c[i+j] = a[i]; i++

while(j < n) c[i+j] = b[j]; j++

return c

• Pre ⇒ Inv vale banalmente perché 0..i − 1, 0..j − 1, e 0..i + j − 1 sono vuoti

• Inv ∧ ¬(i < m ∧ j < n) è proprio Post

• Inv si conserva, per l’invariante e il fatto che i due array sono ordinati

• terminazione: la coppia (m − i, n − j) decresce e se vale la condizione di controllo è limitata inferiormente.

Complessità dell’algoritmo di fusione: percorre interamente i due array, una volta sola, quindi Θ(n + m), assumendo che i due

array abbiano approssimativamente la stessa lunghezza Θ(n). Non vi è distinzione fra caso migliore, caso peggiore e caso medio.

Variante (utilizzata da mergesort) che fonde due porzioni adiacenti di un array usando un array ausiliario (usiamo espressioni ++

per compattezza):

11

merge(a,inf,mid,sup)\\fonde a[inf..mid] con a[mid+1..sup]

aux = array con indici 0..sup − inf + 1

i = inf; j = mid+1; k = 0

while(i <= mid && j <= sup)

if(a[i]<= a[j]) aux[k++] = a[i++]

else

aux[k++] = a[j++]

while(i <= mid) aux[k++] = a[i++]

while(j <= sup) aux[k++] = a[j++]

for(h = 0; h < sup-inf; h++) a[inf + h] = aux[h]

La complessità spaziale è anch’essa lineare in n lunghezza dell’array. Esistono varianti dell’algoritmo le quali, attraverso meccanismi complicati di scambi, non utilizzano un array ausiliario. Tali varianti, però, per la loro complicazione, sono in generale

più lente.

Vediamo ora l’algoritmo mergesort.

Schema astratto dell’algoritmo (di tipo divide-et-impera, mentre i due precedenti erano di tipo incrementale):

mergesort(s)

if (|s|> 1)

dividi s in due sequenze s1 ed s2 di lunghezza |s|/2

mergesort(s1 )

mergesort(s2 )

merge(s1 ,s2 ,s)//fonde ordinatamente s1 ed s2 in s

Correttezza: si prova per induzione aritmetica completa sulla lunghezza di s.

Base Una sequenza di lunghezza zero o uno è ordinata, e infatti l’algoritmo non fa nulla.

Passo induttivo Poiché n2 < n, dopo l’esecuzione di mergesort(s1 ); mergesort(s2 ) per ipotesi induttiva si ha che s1

e s2 sono ordinate. Quindi, in base alla specifica di merge, la sequenza che si ottiene alla fine è ordinata e ha gli stessi

elementi della lista di partenza.

Complessità temporale: si ha la seguente relazione di ricorrenza (la fusione ha costo lineare, la divisione ha costo costante per

un array e lineare per una lista)

T (1) = 1

T (n) = 2T ( n2 ) + n per n > 1

Possiamo trovare la soluzione (assumendo per semplicità n = 2k ) espandendo l’albero di ricorsione (si hanno k+1 livelli ognuno

di costo n), o per sostituzioni successive:

T (n) = 2T ( n2 ) + n

= 2(2T ( n2 2 ) + n2 ) + n = 22 T ( n2 2 ) + 2n

= 22 (2T ( n2 3 ) + n2 2 ) + 2n = 23 T ( n2 3 ) + 3n

= ... = 2k (T ( n2 k )) + kn = n(k + 1) = n(log n + 1)

Possiamo a questo punto verificare per induzione aritmetica:

Base T (20 ) = 1(0 + 1)

Passo induttivo T (2k ) = 2T (2k−1 ) + 2k = (per ip. ind.) 2 · 2k−1 · k + 2k = 2k · k + 2k = 2k (k + 1)

La soluzione poteva anche essere trovata direttamente applicando il teorema master. Poiché l’algoritmo di merge ha complessità

Θ(n) in ogni caso, anche per il mergesort non c’è distinzione fra caso peggiore, migliore e medio, ma si ha sempre T (n) =

Θ(n log n).

Complessità spaziale: lo spazio di memoria necessario per la ricorsione è la massima profondità dello stack = altezza dell’albero

di ricorsione, quindi Θ(log n). L’algoritmo di fusione fa uso di una sequenza ausiliaria per ogni chiamata, che può poi essere

rimossa, quindi richiede uno spazio Θ(n). La complessità spaziale è perciò S (n) = Θ(log n) + Θ(n) = Θ(n). È anche possibile

dare una versione “ecologica” che usa un’unica sequenza ausiliaria che viene passata come argomento aggiuntivo (vedi sotto).

Stabilità: l’algoritmo è stabile se la fusione è realizzata in modo che quando nelle due sequenze si trovano due elementi uguali

rispetto alla relazione d’ordine, venga inserito per primo l’elemento della prima sequenza (quindi è fondamentale il ≤ nel test).

Diamo ora una versione concreta in cui la sequenza è rappresentata con un array con indici 0..n−1 ed utilizziamo l’ottimizzazione

detta sopra:

12

mergesort(a) =

aux = array con indici 0..n − 1

mergesort(a,0,n-1,aux)

mergesort(a,inf,sup,aux)

if (inf<sup)

mid = (inf+sup)/2

mergesort(a,inf,mid,aux)

mergesort(a,mid+1,sup,aux)

merge(a,inf,mid,sup,aux)//fonde a[inf..mid] con a[mid+1..sup] usando aux

merge(a,inf,mid,sup,aux)//fonde a[inf..mid] con a[mid+1..sup]

i = inf; j = mid+1; k = inf

while(i <= mid && j <= sup)

if(a[i] <= a[j])

aux[k++] = a[i++]

else

aux[k++] = a[j++]

while(i <= mid) aux[k++] = a[i++]

while(j <= sup) aux[k++] = a[j++]

for (h = inf; h <= sup; h++) a[h] = aux[h]

usando aux

Ottimizzazione ulteriore: si può evitare di copiare la parte non esaurita di array in aux per poi ricopiarla in a nel modo seguente:

• se la parte non esaurita è la seconda, questa è già al suo posto, quindi non deve essere ricopiata

• se la parte non esaurita è la prima, la si sposta direttamente al posto giusto in a, partendo dal fondo (perché?). L’algoritmo

di fusione diventa quindi:

merge(a,inf,mid,sup,aux)

i = inf; j = mid+1; k = inf

while(i <= mid && j <= sup)

if(a[i]<= a[j])

aux[k++] = a[i++]

else

aux[k++] = a[j++]

for (h = mid, l = sup; h >= i;) a[l--] = a[h--]

//

while(j <= sup) aux[k++] = a[j++]

for (h = inf; h < k; h++) a[h] = aux[h]

], e poi:

Per esempio, se a = [20 30 40 | 10], dopo il primo ciclo avrò aux = [10

a=[

40] copio da a stesso

a = [ 30 40] copio da a stesso

a = [ 20 30 40] copio da a stesso

a = [10 20 30 40] copio da aux

Versione “a passi alterni”: si può evitare di ricopiare ogni volta l’array ausiliario nell’array da ordinare, scambiando a ogni livello

di ricorsione i ruoli dei due array.

merge(a,inf,mid,sup,b)

i = inf; j = mid+1; k = inf

while(i <= mid && j <= sup)

if(a[i]<= a[j]) b[k++] = a[i++]

else

b[k++] = a[j++]

while(i <= mid) b[k++] = a[i++]

while(j <= sup) b[k++] = a[j++]

//for(h = inf; h < sup-inf; h++) a[inf + h] = aux[h]

//Post: b[inf..sup] = merge(a[inf..mid], a[mid + 1..sup])

mergesort(a,inf,sup,b) //Pre: a[inf..sup] = b[inf..sup]

if(inf<sup)

mid = (inf+sup)/2

mergesort(b,inf,mid,a)

mergesort(b,mid+1,sup,a)

13

merge(b,inf,mid,sup,a)

//Post: ordered (a, inf, sup)

mergesort(a)//top-level

aux = copia di a

mergesort(a,0,n-1,aux)

Prova di correttezza:

Base inf ≤ sup: ok

Passo Induttivo Si ha inf < sup. Dato che la lunghezza mid−inf è minore di sup−inf, e la precondizione b[inf..mid] =

a[inf..mid] è verificata, la chiamata ricorsiva mergesort(b,inf,mid,a) ordina b[inf..mid], e analogamente

mergesort(b,mid+1,sup,a) ordina b[mid+1..sup].

A questo punto merge(b,inf,mid,sup,a) produce una copia ordinata di b[inf..sup] in a[inf..sup]. Quindi,

mergesort(a,inf,sup,b) ordina a[inf..sup].

Nota: questa versione del mergesort è in sostanza quella che si trova nella libreria di Java (nella classe Arrays).

Gli elementi che alla fine si trovano in a provengono da a oppure da b a seconda del numero pari o dispari di livelli di ricorsione,

anzi sono un misto se la lunghezza dell’array non è una potenza di due. Esempio:

a = [60a 50a 40a ], b = [60b 50b 40b ]

mergesort(a,0,2,b):

mergesort(b,0,0,a) non fa nulla

mergesort(b,1,2,a):

mergesort(a,1,1,b) non fa nulla

mergesort(a,2,2,b) non fa nulla

merge(a,1,2,b) ordina a[1..2] in b[1..2]

a = [60a 50a 40a ], b = [60b 40a 50a ]

merge(b,0,2,a)ordina b[0..2] in a[0..2]

a = [40a 50a 60b ], b = [60b 40a 50a ]

Un’altra (importante) ottimizzazione: se quando si deve effettuare la fusione l’ultimo elemento del segmento sinistro è minore

o uguale al primo elemento del segmento di destra, la sequenza dei due segmenti è già un segmento ordinato e quindi la fusione

non è necessaria. Esercizio: con tale ottimizzazione la complessità asintotica in qualche caso cambia? Si considerino le diverse

versioni viste sopra.

2.3

Quicksort

È l’algoritmo di ordinamento che ha, in generale, prestazioni migliori tra quelli basati su confronti. È stato ideato da Charles

Antony Richard Hoare nel 1961. È molto popolare dato che è facilmente implementabile, ha un buon comportamento in un’ampia

varietà di situazioni, è sul posto. Gli svantaggi sono dati dal fatto che non è stabile, nel caso peggiore ha un comportamento

quadratico ed è fragile, nel senso che un errore nella sua implementazione può passare inosservato ma causare in certe situazioni

un drastico peggioramento nelle prestazioni. È stato sottoposto a un’analisi matematica approfondita ed estremamente precisa,

i risultati ottenuti in fase di analisi sono stati verificati sperimentalmente in modo esteso e l’algoritmo di base è stato migliorato

al punto da diventare il metodo ideale per un gran numero di applicazioni pratiche. Praticamente dal momento in cui Hoare

pubblicò per la prima volta il suo lavoro, sono state provate e analizzate molte varianti, ma spesso un miglioramento in un senso

porta a un peggioramento delle prestazioni in qualche altro punto.

Schema astratto dell’algoritmo, anch’esso di tipo divide-et-impera:

quicksort(s)

if (|s| > 1)

togli un elemento p da s (per esempio il primo)

partiziona gli altri elementi di s in due parti:

una sequenza s1 contenente tutti gli elementi < p

14

una sequenza s2 contenente tutti gli elementi ≥ p

forma la sequenza s1 p s2

quicksort(s1 )

quicksort(s2 )

L’elemento p è detto pivot o perno della partizione. È facile provare la correttezza dell’algoritmo per induzione aritmetica

completa sulla lunghezza n della sequenza s:

Base Una sequenza di lunghezza zero o uno è ordinata, e infatti l’algoritmo non fa nulla.

Passo Dopo la partizione si ha:

elementi di s1 < p ≤ elementi di s2

Per ipotesi induttiva, l’algoritmo ordina correttamente sequenze di lunghezza < n. Le sequenze s1 ed s2 hanno certamente

lunghezza < n perché è stato tolto p, quindi dopo le due chiamate ricorsive s1 ed s2 sono ordinate; allora la sequenza

s1 p s2 è chiaramente ordinata.

Variante:

quicksort(s)

if (|s| > 1)

scegli un elemento p di s (per esempio il primo)

partiziona gli elementi di s in due parti:

una sequenza s1 contenente elementi ≤ p

una sequenza s2 contenente elementi ≥ p

forma la sequenza s1 s2

quicksort(s1 )

quicksort(s2 )

In questa variante, il pivot non viene tolto, quindi il procedimento con cui si effettua la partizione deve garantire che s1 ed s2

risultino sempre non vuote, quindi entrambe di lunghezza minore della lunghezza di s.

Complessità temporale: assumiamo di poter effettuare la partizione in tempo lineare e senza usare strutture ausiliarie (vedremo

poi alcuni algoritmi concreti). Il tempo T (n) necessario per ordinare una sequenza di lunghezza n è quindi (per esempio per la

seconda versione):

T (1) = Θ(1)

T (n) = Θ(n) + T (r) + T (n − r) per n > 1

dove Θ(n) è il tempo necessario per effettuare la partizione, T (r) il tempo necessario per ordinare s1 di lunghezza r, T (n − r)

il tempo necessario per ordinare s2 di lunghezza n − r, ed r > 0 è diverso per ogni chiamata ricorsiva.

Nota: nel quicksort tutto il lavoro dell’algoritmo viene effettuato dal partizionamento, cosı̀ come nel mergesort veniva effettuato

dalla fusione.

Il caso migliore si avrà quando, a ogni chiamata ricorsiva, le due parti s1 ed s2 risultano di uguale lunghezza (partizione sempre

bilanciata). In questo caso avremo

T (1) = Θ(1)

T (n) = Θ(n) + T ( n2 ) + T ( n2 ), per n > 1.

Questa relazione di ricorrenza è la stessa del mergesort e, come abbiamo visto, ha soluzione T (n) = Θ(n log n).

Il caso peggiore si avrà quando, a ogni chiamata ricorsiva, le due parti s1 ed s2 risultano una di lunghezza 1 e l’altra di lunghezza

n − 1 (partizione sempre sbilanciata al massimo). In questo caso avremo:

T (1) = Θ(1)

T (n) = Θ(n) + T (n − 1) per n > 1.

che ha soluzione T (n) = Θ(n2 ), infatti assumendo per semplicità T (1) = 1, T (n) = n + T (n − 1) ed espandendo si ha

T (n) = n + (n − 1) + ... + 1 = n(n + 1)/2

come si può verificare facilmente per induzione aritmetica.

Si può provare (vedi nel seguito) che si ha anche

15

Tavg (n) = Θ(n log n)

Complessità in spazio: il quicksort opera la partizione sul posto, cioè senza bisogno di un array ausiliario. Tuttavia, essendo un

algoritmo ricorsivo, ha bisogno dello spazio per lo stack. L’altezza dell’albero di ricorsione è la massima profondità di chiamate

ricorsive annidate, quindi:

Sbest (n) = Θ(log n)

Sworst (n) = Θ(n)

Savg (n) = Θ(log n)

Partizionamento: prima versione “semplice” (ignoti in fondo) In questa variante si segue il primo schema ricorsivo. Se

a[inf..sup] è la porzione di array da ordinare, si sceglie il pivot p, per esempio a[inf], e il resto dell’array viene partizionato

in due parti: a[inf + 1..i] gli elementi minori di p, a[i + 1..sup] gli elementi maggiori o uguali a p. Si scambia quindi a[inf]

con a[i] e si ordinano ricorsivamente a[inf..i − 1] e a[i + 1..sup].

L’array risulta in ogni momento intermedio diviso in tre parti, la prima formata da elementi minori del pivot, la seconda da

elementi maggiori o uguali, la terza da elementi non ancora esaminati, come indicato in figura:

j

i

inf inf+1

<

>=

sup

unknown

Usiamo l’indice i per l’ultimo degli elementi minori del pivot, l’indice j per il primo degli “ignoti”.

Passo Si considera il primo elemento ignoto, se questo è minore del pivot lo si scambia con l’elemento di posto i + 1 e si

incrementano i e j, altrimenti basta incrementare j.

Condizione di controllo Finché ci sono elementi ignoti, quindi j ≤ sup.

Inizializzazione Tutti gli elementi sono ignoti, quindi i = inf e j = inf + 1.

Algoritmo completo con asserzioni (l’ultima condizione nell’invariante è aggiunta per chiarezza):

i = inf; j = inf+1 //Pre: i = inf ∧ j = inf + 1

while (j <= sup) //Inv: a[inf + 1..i] < p ∧ a[i + 1..j − 1] ≥ p ∧ j ≤ sup + 1

if (a[j] < p) i++; swap(a,i,j)

j++

//Post: a[inf + 1..i] < p ∧ a[i + 1..sup] ≥ p

• Pre ⇒ Inv vale banalmente perché inf + 1..i e i + 1..j − 1 vuoti

• Inv si conserva

• Inv ∧ j > sup ⇒ Post ovviamente perché si ha j = sup + 1

• terminazione: sup − j decresce e se vale la condizione di controllo è limitata inferiormente.

Inserimento del pivot: deve essere scambiato con a[i], e poi si ordinano ricorsivamente a[inf..i − 1] e a[i + 1..sup]. Più

sinteticamente con un ciclo for:

i = inf

for(j = inf+1; j <= sup; j++)

if (a[j] < p) i++; swap(a,i,j)

swap(a,inf,i)

Cosa succede in questa versione se l’array è ordinato: il pivot p è inizialmente il minimo, quindi alla fine della partizione la parte

sinistra risulta vuota e la parte destra ha lunghezza n − 1. Inoltre la condizione a[j] < p è sempre falsa, quindi non si effettua

nessuno scambio. Di conseguenza, dato che la parte destra non viene modificata, il suo primo elemento è di nuovo il minimo, e

cosı̀ via. È evidentemente un caso peggiore: ad ogni partizione si ha sempre il massimo sbilanciamento fra le due parti: quindi,

si ha complessità temporale quadratica e complessità spaziale lineare.

16

Partizionamento: seconda versione “semplice” (ignoti al centro) Anche in questa variante si segue il primo schema ricorsivo

ma, come nel problema della bandiera olandese, si tengono gli elementi non esaminati al centro. Quindi, dopo aver tolto il pivot

a[inf], l’array risulta in ogni momento intermedio diviso in tre parti, la prima formata da elementi minori del pivot, la seconda

da elementi non ancora esaminati, la terza da elementi elementi maggiori o uguali del pivot, come indicato in figura:

j

i

inf inf+1

unknown

<

sup

>=

Usiamo l’indice i per il primo degli “ignoti”, l’indice j per l’ultimo.

Passo Si considera il primo elemento ignoto, se questo è minore del pivot basta incrementare i, altrimenti lo si scambia con

l’ultimo e si decrementa j.

Condizione di controllo Finché ci sono elementi ignoti, quindi i ≤ j.

Inizializzazione Tutti gli elementi sono ignoti, quindi i = inf + 1 e j = sup.

Algoritmo completo con asserzioni (l’ultima condizione nell’invariante è aggiunta per chiarezza):

i = inf+1; j = sup //Pre: i = inf + 1 ∧ j = sup

while (i <= j) //Inv: a[inf + 1..i − 1] < p ∧ a[j + 1..sup] ≥ p ∧ i ≤ j + 1

if (a[i] < p) i++

else swap(a,i,j); j-//Post: a[inf + 1..i − 1] < p ∧ a[i..sup] ≥ p

• Pre ⇒ Inv vale banalmente perché inf + 1..i − 1 e j + 1..sup vuoti

• Inv si conserva

• Inv ∧ i > j ⇒ Post ovviamente perché si ha i = j + 1

• terminazione: j − i decresce e se vale la condizione di controllo è limitata inferiormente.

Inserimento del pivot: deve essere scambiato con a[j = i − 1], e poi si ordinano ricorsivamente a[inf..j − 1] e a[j + 1..sup].

Il caso dell’array ordinato è ancora un caso peggiore? Come nella prima versione il pivot è inizialmente il minimo, e alla fine della

partizione la parte sinistra è vuota e la destra ha lunghezza n − 1. Tuttavia, in questo caso la condizione a[i] < p risulta sempre

falsa, e quindi si operano sempre degli scambi. La parte destra risulta modificata, e il primo elemento non è più il minimo, ma il

secondo più piccolo. La partizione della parte destra risulterà quindi lievemente meno sbilanciata e, via via che si scende nella

ricorsione, lo sbilanciamento diminuisce. Il caso dell’array ordinato non è più un caso peggiore, il tempo di calcolo è espresso

da una relazione di ricorrenza complessa ed è comunque superiore a quello per un array con elementi in “ordine casuale”.

Vediamo un esempio:

[10 20 30 40 50]

[ |20 30 40 50| ]

[ |50 30 40|20]

[ |40 30|50 20]

[ |30|40 50 20]

[ | |30 40 50 20]

[ |10|30 40 50 20]

pivot 10

20 ≥ 10, scambio e decremento j

50 ≥ 10, scambio e decremento j

40 ≥ 10, scambio e decremento j

30 ≥ 10, scambio e decremento j

inserisco il pivot

Osservazione: in entrambe le versioni viste finora, gli elementi possono essere spostati due volte. Per esempio, nella versione

con gli ignoti in mezzo, se a[i] e a[j] sono ≥ p, l’elemento di posto j viene prima scambiato con quello di posto i, e poi al

passo successivo riportato a destra. In altri termini, l’algoritmo mette al posto giusto solo un elemento alla volta, eventualmente

spostandone un altro dalla parte sbagliata.

Altra osservazione: in entrambe le versioni viste finora, se nel partizionamento vi sono molti elementi uguali al pivot (anche

se scelto a caso) essi finiscono tutti da una stessa parte, producendo cosı̀ uno sbilanciamento. Un array di elementi tutti uguali,

o quasi tutti uguali, costituisce quindi un caso peggiore, di complessità quadratica, anche con pivot scelto a caso. La versione

originale di Hoare (vedi dopo) e la tripartizione (ossia un algoritmo di partizionamento in cui si distinguono elementi minori,

uguali e maggiori) evitano questo problema. Nel caso della tripartizione, su un array di elementi tutti uguali non viene effettuata

17

nessuna chiamata ricorsiva, quindi questo costituisce un caso migliore molto particolare di complessità temporale lineare e

spaziale costante. Svantaggi della tripartizione: il test è più complesso e quindi più dispendioso in tempo; tenere gli elementi

uguali al pivot in mezzo costringe a effettuare uno scambio per ogni elemento diverso dal pivot, e questo si presume sia il caso

più frequente. Un rimedio al difetto precedente può essere ottenuto posizionando la parte degli uguali al pivot a sinistra o a

destra invece che in mezzo, spostandola poi in mezzo solo alla fine del partizionamento, e combinando la tripartizione con alcuni

aspetti della versione alla Hoare, come nella versione di Bentley-McIllRoy (vedi dopo).

Partizionamento: versione [simile a] originale di Hoare In questa variante si segue il secondo schema ricorsivo, quindi gli

elementi uguali al pivot possono stare da entrambe le parti, e si deve garantire che alla fine le due parti su cui si effettuano

le chiamate ricorsive siano non vuote. La parte da esaminare è in mezzo, e si effettua uno scambio solo quando entrambi gli

elementi dopo lo scambio saranno in posizione giusta. Nessun elemento viene quindi scambiato più di una volta. Gli elementi

uguali al pivot vengono sempre scambiati. Usiamo l’indice i per il primo degli “ignoti”, l’indice j per l’ultimo.

j

i

inf

≤

unknown

sup

≥

Invariante: a[inf..i − 1] ≤ p ∧ a[j + 1..sup] ≥ p.

Condizione di controllo i ≤ j

Inizializzazione i = inf, j = sup

Passo Si incrementa i fino a trovare un elemento ≥ p, poi si decrementa j fino a trovare un elemento ≤ p. A questo punto si

hanno tre casi possibili:

• i < j: occorre scambiare i e j, e poi incrementare i e decrementare j

• i = j: (quindi a[i] = p) scambiare i e j è inutile ma non dannoso, e poi occorre spostare gli indici per terminare il

ciclo

• i = j + 1: scambiare i e j sarebbe errato.

Per semplificare possiamo ridurci a due casi: si fa lo scambio e si spostano i e j a meno che gli indici non siano

“incrociati”.

Algoritmo di partizionamento completo con asserzioni:

i = inf; j = sup //Pre: i = inf ∧ j = sup

while(i <= j) //Inv: a[inf..i − 1] ≤ p ∧ a[j + 1..sup] ≥ p ∧ ((i = inf ∧ j = sup) ∨ (inf < i ∧ j < sup))

//∧i ≤ j + 2 ∧ i = j + 2 ⇒ a[i − 1] = p

while(a[i] < p) i++ //a[i] ≥ p

while(a[j] > p) j-- //a[j] ≤ p

if(i <= j)

swap(a,i,j)

i++; j-//Post: a[inf..i − 1] ≤ p ∧ a[j + 1..sup] ≥ p ∧ inf < i ∧ j < sup

// ∧((i = j + 1) ∨ (i = j + 2 ∧ a[i − 1] = p))

Correttezza: anzitutto, i due cicli interni terminano senza uscire dai limiti dell’array. Infatti, nella prima iterazione gli indici si

fermano alla peggio sul pivot, perché il segmento a[i..sup], essendo a[inf..sup], contiene sicuramente il pivot, e analogamente

a[inf..j]. Si effettua quindi un primo scambio (alla peggio del pivot con se stesso) e si spostano gli indici, quindi dopo la prima

iterazione si ha sicuramente inf < i e j < sup, ossia le due porzioni a[inf..i − 1] e a[j + 1..sup] sono sicuramente non

vuote (eventualmente con intersezione non vuota). Quindi, a[j + 1] funge da guardia per i e viceversa.

L’uscita dal ciclo può avvenire in tre modi:

• alla fine dei due cicli interni ho i < j, effettuo lo scambio e incrementando gli indici ho i = j + 1

• alla fine dei due cicli interni ho i = j (quindi a[i] = p), effettuo lo scambio e incrementando gli indici ho i = j + 2

• alla fine dei due cicli interni ho i = j + 1, non faccio nulla.

18

Quindi i = j + 1 oppure i = j + 2. In entrambi i casi richiamo ricorsivamente su a[inf..j] e a[i..sup], e so che le due

porzioni non sono vuote. Infatti:

• nel primo caso richiamo su a[inf..i − 1] e a[j + 1..sup] che so essere non vuote (da dopo la prima iterazione)

• nel secondo caso richiamo su a[inf..i − 2] e a[i..sup], entrambe di lunghezza minore di quella della sequenza iniziale

perché ho escluso l’elemento a[i − 1] = p.

Algoritmo completo (usiamo un ciclo do-while in quanto si effettua almeno un’iterazione):

quicksort(a,inf,sup)

if (inf < sup)

p = a[inf]; i = inf; j = sup

do

while (a[i] < p) i++

while (a[j] > p) j-if (i <= j) swap(a,i,j); i++; j-while(i <= j)

quicksort(a,inf,j)

quicksort(a,i,sup)

Come si vede, il corretto funzionamento di questa versione, che minimizza il numero di spostamenti e di confronti inutili, dipende

da dettagli abbastanza sottili.

Partizionamento: versione di Bentley-McIlroy (1993) Adottata dalla Sun nelle API di Java. Combina vantaggi della versione

originale di Hoare (ogni elemento è spostato al più una volta) e della tripartizione (efficienza in caso di elementi ripetuti).

L’array è diviso in cinque porzioni:

inf

j

i

h

=

<

k

sup

=

>

unknown

Invariante: a[inf..h − 1] = p ∧ a[h..i − 1] < p ∧ a[j + 1..k] > p ∧ a[k + 1.. sup] = p.

Passo

• a[i] = p: swap(a,i,h); h++; i++

• a[i] < p: i++

• a[j] = p: swap(a,j,k); k--; j-• a[j] > p: j-• else: swap(a,i,j); i++; j-Il ramo else (quindi la sequenza i++; j--) viene eseguito nel caso a[i] > p ∧ a[j] < p, quindi non può essere i = j, ma si

ha i < j. Quindi nell’invariante si ha i ≤ j + 1, quindi in uscita i = j + 1.

inf

h

j i

=

k

<

>

sup

=

Bisogna ancora spostare le due porzioni di elementi uguali al pivot al centro, si procede nel modo seguente:

• se la parte “uguali di destra” è più corta di quella dei minori, si scambiano gli “uguali” con una parte dei minori

>

=

=

>

• se la parte “uguali di destra” è più lunga di quella dei minori, si scambiano i minori con una parte degli uguali

19

>

=

>

=

• analogamente a sinistra.

Per esercizio: scrivere il codice completo di quicksort in questo caso e la prova di correttezza per il ciclo.

Analisi rigorosa del caso medio Assumiamo che per ogni lunghezza n tutte le possibili coppie di lunghezze delle due parti

siano ugualmente probabili. È più semplice considerare la prima versione, in cui il pivot viene tolto, e quindi le possibili coppie

di lunghezze sono:

(0, n − 1), (1, n − 2) , (2, n − 3), . . . , (k, n − 1 − k), . . . , (n − 1, 0)

Si ha quindi

T (n) = n + n1 (T (0) + T (n − 1) + T (1) + T (n − 2) + . . . + T (n − 1) + T (0))

n−1

P

= n + n2

T (i)

i=0

2

Per ottenere T (n) in funzione di T (n − 1), espandiamo analogamente T (n − 1), e otteniamo T (n − 1) = n − 1 + n−1

quindi

n−2

P

T (i) =

i=0

n−1

2 (T (n

− 1) − n + 1)

e sostituendo nell’espressione di partenza:

T (n) = n + n2 ( n−1

2 (T (n − 1) − n + 1) + T (n − 1))

Semplificando si ottiene

T (n) =

n+1

n T (n

− 1) +

2n−1

n

che è una relazione di ricorrenza di forma usuale. Per risolverla, maggioriamo in questo modo:

T (n) ≤

n+1

n T (n

− 1) +

2(n+1)

n

e poi usiamo il metodo delle sostituzioni successive:

T (n) ≤

T (n) ≤

...

T (n) ≤

2(n+1)

n+1

n

2n

n ( n−1 T (n − 2) + n−1 ) +

n

2(n+1)

2(n+1)

n+1

T

(n

−

2)

+

+

n−1

n−1

n

n+1

n−1 T (n

T (n) ≤ 2(n + 1)

− (n − 1)) +

n

P

1

i=2

2(n+1)

2

... +

2(n+1)

n−1

+

2(n+1)

n

(assumendo per semplicità T (1) = 0)

i

Questa sommatoria è la somma armonica che si prova essere Θ(log n). Si può infatti osservare che

1

2

+

1

3

+

1

22

+

1

5

+

1

6

+

1

7

... +

1

23

+ ... ≤ 1 +

1

2

+

1

2

+

1

22

20

+

1

22

+

1

22

+

1

22

+ . . . = log n

n−2

P

i=0

T (i),

Randomizzazione Il caso peggiore si verifica quando, a ogni chiamata ricorsiva, gli elementi della porzione di array considerata

sono o tutti minori o tutti maggiori/uguali del pivot. Un buon modo per evitare questo consiste nello scegliere ogni volta il pivot

a caso. Si scambia poi l’elemento-pivot con il primo in modo da riportarsi alla situazione vista precedentemente. In questo modo

nessuna particolare istanza di input si comporta da caso peggiore. Un utilizzatore “maligno” può produrre un caso peggiore solo

conoscendo l’algoritmo usato per la generazione dei numeri pseudo-casuali.

Un’altra tecnica è basata sull’osservazione che la partizione è perfettamente bilanciata se il pivot è la mediana (valore appartenente all’insieme tale che metà degli elementi dell’insieme sono minori o uguali, e l’altra metà sono maggiori o uguali).2 Non

conoscendo la mediana, si può scegliere come pivot il mediano di un certo numero di elementi, per esempio il mediano di primo,

ultimo, ed elemento centrale, o di nove elementi presi ad intervalli regolari. In questo modo il caso peggiore non è più l’array

ordinato, ma è comunque una fissata configurazione dell’array. Si possono anche combinare i due meccanismi, ossia scegliere il

mediano di un certo numero di elementi di cui alcuni scelti a caso.

Uso di algoritmi elementari Il quicksort è asintoticamente molto più efficiente di algoritmi di ordinamento quadratici come

l’insertion sort, tuttavia la sequenza di operazioni che esso esegue per ciascun elemento dell’array è più complessa e quindi più

dispendiosa in tempo, quindi per piccoli valori di n (alcune decine) un algoritmo quadratico ma semplice, come l’insertion sort,

è più efficiente di quicksort. Si possono quindi confrontare sperimentalmente i tempi di calcolo di quicksort e insertion sort per

determinare in modo approssimato il valore di n0 , e quando la lunghezza della porzione da ordinare è inferiore a n0 eseguire

direttamente insertion sort.

2.4

Heapsort

Idea: si parte dal selection sort (ordinamento per estrazione successiva del minimo), quadratico, ma, invece di cercare ogni volta

il minimo, si inseriscono tutti gli elementi in una coda a priorità. Si operano quindi delle estrazioni successive del minimo. Se la

coda a priorità è realizzata tramite heap, vedi sezione 3.1, l’estrazione del minimo costa O(log n) anziché O(n), e quindi il ciclo

di n estrazioni costa O(n log n) invece di O(n2 ). Analogamente per il ciclo di inserimento nella coda.

Sia la sequenza rappresentata con un array a con indici 0..n − 1. Prima versione dell’algoritmo (non sul posto):

heapsort(a)

Q = heap di lunghezza n

for (i = 0; i < n; i++) Q.insert(a[i])

for (i = 0; i < n; i++) a[i] = Q.getMin()

Versione sul posto: possiamo osservare che ogni elemento si trova sempre o nell’array o nello heap, quindi è possibile utilizzare

l’array stesso come heap, nel modo seguente.

Prima fase Si costruisce lo heap nella porzione iniziale dell’array da ordinare.

heap

parte ancora da esaminare

i

A ogni iterazione, la porzione a[0..i − 1] (inizialmente il solo elemento a[0]) è uno heap, l’elemento di posto i è già nella

posizione di ultima foglia, basta quindi farlo risalire, rendendo cosı̀ uno heap la porzione a[0..i]. Alla fine della prima fase

tutto l’array è uno heap.

Seconda fase Si sostituisce la porzione finale dello heap con un array ordinato.

heap ancora da svuotare

parte già ordinata

i

A ogni iterazione, la porzione a[0..i] (inizialmente tutto l’array) è uno heap. Si scambia l’ultima foglia (elemento di

posto i) con la radice, che quindi viene aggiunta a sinistra della porzione ordinata dell’array. Poi si fa scendere la radice,

rendendo cosı̀ nuovamente uno heap la porzione a[0..i − 1]. Alla fine lo heap è vuoto e l’array ordinato.

Attenzione: per ottenere l’ordine giusto e non quello inverso nella seconda fase, occorre utilizzare nella prima fase uno heap a

massimo anzichè a minimo.

In questo modo l’algoritmo è sul posto, ha complessità temporale O(n log n) ottimale in ogni caso come mergesort (non un

caso peggiore quadratico come quicksort) e inoltre, a differenza di mergesort e quicksort, è un algoritmo iterativo, quindi con

2 La mediana è spesso una nozione statistica più significativa della media, per esempio considerando 11 persone, di cui 5 guadagnano al mese 2000 euro, 5

guadagnano 3000 euro, e uno guadagna 100000 euro, la media è circa 11364, la mediana 3000.

21

complessità spaziale (in ogni caso) Θ(1). Lo heapsort è quindi, dal punto di vista asintotico, l’algoritmo di ordinamento migliore

fra quelli esaminati. Tuttavia nella maggior parte delle situazioni l’algoritmo di ordinamento più veloce risulta essere quicksort.

Nella versione in place di heapsort, se si ordina un array con indici 0..n − 1, lo heap partirà dall’indice 0 invece che dall’indice

1, quindi i figli del nodo i saranno 2i + 1 e 2i + 2, e il genitore (i − 1)/2. Inoltre, dato che lo heap è a massimo, nella moveUp

(qui chiamata addToHeap) e nella moveDown i test sono invertiti rispetto alla versione data nella sezione 3.1. Si ha quindi il

codice seguente, dove scriviamo heap(a, 0, i) per “la porzione di array a[0..i] è uno heap (a massimo)”.

heapsort(a) //a con indici 0..n − 1

for (i = 1;i < n;i++) addToHeap(a,i) //Inv: heap(a, 0, i − 1)

for (i = n - 1; i > 0;i--) getMax(a,i)

//Inv: heap(a, 0, i) ∧ ordered (a, i + 1, n − 1) ∧ a[0..i] ≤ a[i + 1]

addToHeap(a,i) //Pre: heap(a, 0, i − 1)

elem = a[i] //elemento da far salire

while (i > 0 && elem > a[(i-1)/2]) //Inv: i posto vuoto

a[i] = a[(i-1)/2] //scende il genitore

i = (i-1)/2 //sale il posto vuoto

a[i] = elem

//Post: heap(a, 0, i)

getMax(a,i) //Pre: heap(a, 0, i)

swap(a,0,i) //scambia massimo con ultima foglia

moveDown(a,0,i-1)

//Post:heap(a, 0, i − 1) ∧ a[0..i − 1] ≤ a[i]

moveDown(a,k,i)

elem = a[k] //elemento da far scendere

j = 2*k+1 //j figlio sinistro

while (j < i && elem > a[j]) //Inv: i posto vuoto

if (j+1 < i && a[j+1] < a[j]) j++ //j figlio destro

a[k] = a[j] //sale il figlio

k = j //scende il posto vuoto

a[k] = elem

//Post: heap(a, k, i)

//invocata anche con k 6= 0 nella versione ottimizzata

Ottimizzazione: l’array può essere trasformato in uno heap, invece che con n inserimenti successivi, con tempo totale Θ(n log n),

applicando ripetutamente moveDown ai nodi a partire dal basso. Ciò richiede solo un tempo Θ(n) (vedi sotto).

Infatti:

• un albero costituito solo da una foglia è uno heap

• un albero quasi completo i cui sottoalberi sinistro e destro sono degli heap diventa uno heap se si applica moveDown alla

sua radice.

Corrispondente algoritmo ricorsivo:

heapify(a) //a con indici 0..n − 1

heapify(a,0)

heapify(a,i) //a con indici 0..n − 1

j = 2*i+1 //figlio sinistro

if(j < n) //i ha almeno un figlio

heapify(a,j)

heapify(a,j+1)

moveDown(a,i,n-1)

//Post: heap(a, i, n − 1)

Nota: non occorre gestire a parte il caso in cui esista solo il figlio sinistro, perchè l’algoritmo invocato su un figlio destro

inesistente non fa nulla, come nel caso di una foglia.

22

Con l’utilizzo dell’algoritmo heapify la complessità asintotica non cambia, perché il ciclo di estrazioni successive del massimo

rimane Θ(n log n), tuttavia si ha un miglioramento rispetto a 2n log n. Trattandosi di un algoritmo ricorsivo cresce ovviamente

la complessità in spazio, è facile tuttavia dare un algoritmo iterativo equivalente, che cioè esegue esattamente la stessa sequenza

di chiamate di moveDown:

heapify(a) //a con indici 0..n − 1

for (j = (n-2)/2; j >= 0; j--)

moveDown(a,j,n-1);

Si noti che (n − 2)/2, essendo il genitore dell’ultima foglia, è l’ultimo nodo interno.

Versione finale compatta di heapsort:

heapsort(a)

for (j =(n-2)/2; j >= 0; j--) moveDown(a,j,n)

for(i = n-1; i > 0; i--)

swap(a,0,i)

moveDown(a,0,i)

Calcolo della complessità di heapify: se h è l’altezza dell’albero heap, 2h è il numero delle foglie e 2h+1 − 1 = n è il numero

dei nodi, quindi, considerando la versione ricorsiva, otteniamo la seguente relazione di ricorrenza:

T (20+1 − 1) = 0

T (2h+1 − 1) = h + 2T (2h − 1) (infatti 2h+1 − 1 − 1 = 2h+1 − 2 = 2(2h − 1) )

= h + 2(h − 1 + 2T (2h−1 − 1))