Fabrizio Valpreda

VIRTUAL DESIGN

possibilità progettuali e comunicative del digitale

“quaderni di design”

Time&Mind Press

Torino, 2004

ISBN 88-901128-3-2

I recenti anni di sviluppo di tutto ciò che, digitale, si

esprime con una sequenza di zero e uno, hanno

visto proliferare strumenti software sempre più

sofisticati che spesso travalicano le capacità

dell'utente finale ponendolo in una condizione di

inferiorità espressiva.

Il distacco tra strumento e utente è paradossale

poichè il miglioramento dei software dovrebbe

portare nella direzione opposta; purtroppo accade

sempre più spesso che funzioni nuove non sono

untilizzate ma al contrario costituicono una

complicazione in più per chi, in ultima analisi, deve

imparare a progettare o, più semplicemente,

“consegnare il lavoro in tempo”.

Si vuole in questa occasione presentare alcune

considerazioni, sulla base di esperienze didattiche e

professionali, che vorrebbero spezzare una lancia

in favore di un minimalismo strumentale opposto al

pachidermico incalzare di software complessi,

pesanti, costosi, e, per questo, spesso

sottoutilizzati, se non lesivi dell'efficienza.

Efficienza che non deve essere considerata solo in

termini monetari ma prima di tutto in termini di

rapidità di esecuzione di compiti basilari come quelli

del disegno 3D e della visualizzazione del progetto:

il designer deve poter dominare tutte le fasi del

progetto fin dalle prime fasi del lavoro e combattere

con i software non aiuta a porsi nella giusta ottica

progettuale.

In questo senso è importante definire una cultura

del progetto virtuale in cui si chiarisca fin da subito

l'importanza fondamentale del cosa in

contrapposizione al come.

La figura del virtual designer: richiesta e offerta

sul piano formativo del Corso di Laurea in Virtual

Design del Politecnico di Torino

Il corso di laurea in Graphic and Virtual Design nasce dalle ceneri

della vecchia scuola di Tecniche e Arti della Stampa: questa, da

diploma, è stata trasformata in un corso di laurea.

Riteniamo fondamentale in questo corso che l’approfondimento

delle tematiche della grafica e della virtualità sia svolto fornendo agli

studenti una base culturale che serve da fondazione alla

preparazione complessiva: questa caratteristica è da noi fortemente

voluta per dare la possibilità ai ragazzi di produrre progetti che

posseggano un valore aggiunto rispetto all’esistente e che abbiano

una continuità di valore nel tempo.

Nella virtualità si verifica troppo frequentemente

un uso

indiscriminato delle tecnologie informatiche sacrificando con troppa

facilità il contenuto del progetto a favore delle tecniche di

rappresentazione: si manifesta quindi un marcato scollamento dalla

formazione culturale che costituisce invece il vero motore del

progetto. In questo senso noi cerchiamo di dare da una parte una

grossa formazione culturale e parallelamente una preparazione

tecnica specifica mirata alla definizione del progetto.

Un’altra delle caratteristiche del corso è il numero chiuso: si è

deciso di accettare un numero ridotto di studenti, solo ottanta, per

concentrare le risorse didattiche sulla preparazione professionale di

alto livello. Riteniamo di avere delle grandi responsabilità

nell’insegnamento e il nostro obiettivo risulta quindi essere la

creazione di professionalità che siano spendibili nel mercato del

lavoro.

All’interno del Laboratorio Modelli Virtuali del Cisda mi occupo di

insegnamento delle tecniche di rappresentazione del progetto di

architettura e di design con l'uso di strumenti informatici. In questa

ottica negli ultimi anni ci siamo resi conto che uno dei problemi più

importanti e più pressanti da risolvere non è tanto l'insegnamento

dello strumento informatico quanto la relazione tra l’oggetto da

rappresentare e la sua rappresentazione: infatti quello che si è

perso nel tempo è la percezione della realtà fisica che ci circonda a

favore della simulazione che un computer può farne. Il problema è

legato al fatto che mentre da un lato lo studente si presenta molto

flessibile nell'apprendimento delle tecniche, trova molte difficoltà nel

momento in cui, appresi gli strumenti di modellazione, di

illuminazione e di texturing, deve applicarli alla soluzione di un

problema reale quindi alla rappresentazione di un progetto vero e

proprio o di un oggetto esistente. Ciò che abbiamo quindi cercato di

fare è tentare di smontare il problema suddividendolo nelle sue parti

principali. Ci siamo quindi chiesto cosa poter fare quando dobbiamo

insegnare a dei ragazzi che sono molto veloci ad apprendere l'uso

dei programmi ma hanno delle difficoltà nella relazione tra reale e

virtuale.

Il primo obiettivo è chiarire da subito l’identità dello strumento

informatico per estrapolare da esso le caratteristiche fondamentali e

le differenze tra i diversi tools a disposizione; ancora più importante,

anche se solo apparentemente superfluo, risulta essere la necessità

di chiarire la finalità degli strumenti: sono semplicemente programmi

che servono a rappresentare la realtà, non a riprodurla.

L’operazione di “dissassemblaggio” della realtà conduce a quelli che

sono i tre ingredienti principali della nostra “torta digitale”, ovvero la

scena tridimensionale: il modello, la luce ed i materiali.

Questi tre elementi vengono spesso trascurati o, al contrario,

addirittura troppo elaborati dallo studente che, trovandosi a

disposizione innumerevoli funzionalità nei software, arricchisce il

modello tridimensionale di dettagli che il risultato finale non

evidenzierà oppure trascura elementi fondamentali come lo studio

delle ombre e delle penombre che la luce indiretta genera in una

qualsiasi scena.

Senza entrare nel merito delle diverse tipologie di rappresentazione

fotorealistica o non fotorealistica, quello che vogliamo cercare di

capire è quali sono i problemi legati a questo binomio reale-virtuale.

Il primo è quindi un problema di modellazione.

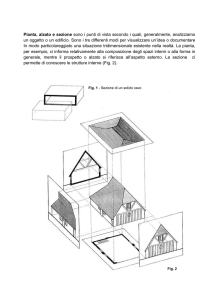

fig.1

oggetti in shading con caratteristiche di modellazione a diversi livelli

di dettaglio

Osservando fig.1 a partire dal lato sinistro si osserva una primitiva

tridimensionale di tipo cilindro costruita secondo le sue

caratteristiche teoriche cioè l'estrusione di un cerchio lungo l'asse

perpendicolare al cerchio stesso con un'altezza e un diametro dati.

Questo tipo di oggetto teorico in realtà non esiste per cui nel

momento in cui si modella una forma di questo genere si devono

introdurre quelle deformazioni che la natura dell’oggetto provoca,

procedendo quindi ad approssimazioni successive: in questa fase

nascono i primi problemi poichè gli studenti si trovano spesso nella

possibilità e nel desiderio di sfruttare computer e programmi molto

potenti e vengono invogliati ad addensare le informazioni.

In fig.2 si può osservare un esempio di ottimizzazione dei parametri

di illuminazione e texturing in cui la scena iniziale è stata ridotta

come numero di poligoni e la luce indiretta è stata calcolata con una

tecnica mista di luci aggiuntive e Global Illumination portando i tempi

di calcolo ad un decimo rispetto alle impostazioni iniziali senza

ridurre in modo percettibile la qualità dell’immagine.

fig.2

interno con illuminazione di tipo misto scanline/raytrace e G.I.

L'obiettivo principale che ci poniamo durante le lezioni è quindi

quello di far sempre ragionare gli studenti in merito allo scopo da

raggiungere: insegnare loro un uso ottimizzato delle tecniche che

consenta di ottenere esattamente i risultati voluti concentrandosi fin

da subito su di essi e non sui software utilizzati per ottenerli. Allora

nella riproduzione del cilindro di cui sopra si può passare ad un

accenno di spigoli nelle due facce superiori e poi a un leggera

flessione ad esempio allo scopo di riprodurre una parte di tronco di

legno (fig.3).

Il problema successivo in ordine di importanza è quello della luce

che in realtà risulta essere uno dei più complessi e anche quello che

riesce a fare la differenza.

fig.3

il modello con texturing a diversi livelli di dettaglio

Si preferisce, nel percorso didattico, dare priorità alla luce e al suo

comportamento nella realtà poiché il propagarsi della radiazione

luminosa nell’ambiente che ci circonda fornisce, molto più del

colore, la tridimensionalità agli oggetti.

Penombre, colore della luce, profondità di penetrazione negli spazi

chiusi sono caratteristiche che possono dare ad un ambiente

totalmente bianco quel carattere che spesso manca in immagini

ricche di texture e materiali sofisticati.

Analogamente alla luce si deve affrontare il tema dei materiali: la

loro preparazione va guidata con un percorso conoscitivo del

progetto in cui colore, riflessioni diffuse e speculari, rugosità e

imperfezioni vengono calibrate allo specifico scopo di ottenere il

risultato voluto, senza lasciarsi influenzare dalle possibilità tecniche

offerte dai software; quando queste costituiscono, come spesso

accade, un vincolo stringente, si deve operare allo scopo di

trasformare i limiti del programma in vantaggi operativi.

Le immagini seguenti sono un esempio del lavoro svolto secondo i

criteri esposti.

La luce e gli strumenti per la sua simulazione

L’illuminazione di interni

Un progettista che utilizza il computer per simulare, verificare e

presentare i propri progetti con le tecnologie attuali non può

prescindere da un legge mai scritta che recita più o meno così: “il

perfetto strumento informatico di simulazione della luce non esiste”

Questa affermazione, per essere l’incipit di un articolo che intende

analizzare le attuali metodologie di simulazione del comportamento

della luce, può suonare pessimistica, ma in realtà conduce al

nocciolo del problema della visualizzazione tridimensionale digitale

di una scena simulata con software commerciali. Una qualsiasi

simulazione virtuale di un progetto architettonico non può essere

effettuata con una sola tecnica, perché nessuna tecnica da sola è in

grado, ad oggi, di restituire risultati “assoluti”. Questo significa che

di volta in volta si utilizzerà la più opportuna tecnica di simulazione

del comportamento della luce.

Di seguito saranno analizzate le potenzialità delle tecniche di

rendering attualmente disponibili nei software commerciali

comunemente utilizzati dagli architetti per la visualizzazione, la

verifica e la presentazione dei progetti. Si tratta di programmi di alto

livello qualitativo che offrono in genere un completo set di strumenti

per le più diffuse necessità progettuali.

Gli algoritmi base di simulazione

Nel corso degli ultimi anni si sono consolidati fondamentalmente tre

algoritmi che consentono di simulare in 3D il progetto

architettonico/illuminotecnico: Radiosity, Global Illumination (G.I.) e

Scanline/Raytracing.

Senza entrare troppo nel dettaglio dei suddetti algoritmi proviamo a

dare una loro descrizione di massima per capire soprattutto quali

siano i vantaggi e gli svantaggi di ciascuno di essi.

Primo per nascita e diffusione, il metodo Scanline/Raytracing

calcola il solo apporto di luce diretta, senza nessuna possibilità di

prevedere il viaggio della radiazione visibile, una volta che questa

abbia colpito gli oggetti e non considera quindi le riflessioni

secondarie.

Con questo metodo, velocissimo nel calcolo, è necessario ipotizzare

il comportamento della luce e introdurre nella scena sorgenti virtuali

aggiuntive che simulino la diffusione indiretta da un oggetto all’altro.

La Global Illumination (G.I.) è un metodo di calcolo il cui sviluppo

deriva dall’algoritmo Raytracing. Viene utilizzato per le sue

caratteristiche di estrema flessibilità ed efficienza: il suo

funzionamento, concettualmente semplice prevede l’emissione di

raggi di luce (chiamati photons per ricordare i fotoni propri della

radiazione luminosa) dalle sorgenti presenti in scena. A partire da

alcuni punti, (definibili numericamente dall’utente) delle superfici

illuminate direttamente, viene emessa una serie di raggi secondari

(anche questi definibili dall’utente) che colpiscono gli oggetti

circostanti in un processo iterativo la cui fine è imposta dall’utente. Il

tutto viene calcolato per l’immagine statica allo scopo di risparmiare

sui tempi di calcolo: in pratica i raggi che, rimbalzando colpiscono

oggetti nascosti al punto di vista scelto per l’immagine, vengono

trascurati. Nel caso in cui sia necessario realizzare un’immagine da

un diverso punto di vista sarà possibile utilizzare la mappa di raggi

(photon map) già calcolata incrementandola solo con i nuovi raggi

necessari.

Il metodo Radiosity calcola la luce indiretta attraverso la

suddivisione delle superfici in mesh, a densità variabile,

caratterizzate da poligoni più piccoli in prossimità delle zone di

contatto tra diverse superfici.

L’algoritmo di tipo Radiosity viene utilizzato soprattutto nei casi in cui

risulti necessaria una verifica scientifica del reale bilancio energetico

all’interno di un ambiente. É infatti possibile “interrogare” i risultati

del rendering per conoscere le condizioni di illuminazione degli

oggetti a seguito della radiazione diretta ed indiretta (riflessioni

secondarie) avendo come risposta dal software valori

numericamente corretti. I valori calcolati sono ottenuti a partire dai

dati teorici di riferimento della ripartizione spaziale dell’intensità

luminosa degli apparecchi di comune produzione e/o

dell’illuminazione naturale dovuta al sole ed alla diffusione dovuta

all’atmosfera terrestre, nei diversi giorni dell’anno.

Con la suddetta tecnica è possibile utilizzare, attraverso opportuni

formati (come, ad esempio il formato IES), i files di descrizione degli

apparecchi illuminanti, simulando in questo modo le diverse

condizioni di illuminazione con l’utilizzo di diversi tipi di sorgenti

artificiali.

Non ultima risulta essere estremamente interessante la possibilità di

navigare in tempo reale la scena 3D grazie al fatto che la soluzione

radiosity viene salvata nel file del modello 3D e può essere

ricaricata automaticamente alla sua riapertura, senza necessità di

ricalcolare il rendering, poiché il bilancio energetico della radiazione

luminosa è indipendente dal punto di vista.

Il metodo Scanline/Raytracing, nonostante risulti apparentemente

inutile agli scopi specifici della verifica illuminotecnica del progetto

architettonico, (dove, in genere, la maggior parte dell’illuminazione

dipende dalla componente indiretta), viene ancora massicciamente

utilizzato grazie alla eccellente velocità di calcolo ed alla grande

flessibilità data dal fatto che la luce può essere “pilotata”. Per questo

viene specialmente utilizzato per immagini che hanno uno scopo

comunicativo e non per verifiche illuminotecniche: vedremo tuttavia

come, nonostante i suddetti limiti, questo metodo riservi, se

correttamente utilizzato, delle gradite “sorprese”.

Pregi e difetti

A questo punto la domanda che può sorgere nel lettore è: “ma

allora quale tecnica devo utilizzare per la visualizzazione del mio

progetto?”

La risposta è, come spesso accade nel mondo dell’informatica,

dipende.

Dipende prima di tutto dallo scopo che si vuole raggiungere: la

simulazione illuminotecnica oppure la verifica dei materiali e delle

finiture superficiali oppure ancora la semplice presentazione del

progetto.

Dipende dal budget a disposizione: tecniche più sofisticate

richiedono in genere tempi di calcolo molto più onerosi e hardware

più potente.

Dipende, almeno per gli studi di progettazione più piccoli, dalle

conoscenze già acquisite sui vari software e dalla possibilità di

allargare il know-how a nuove tecniche, magari non sempre

utilizzabili, quindi non meritevoli di investimento.

Tuttavia, indipendentemente dagli obiettivi da raggiungere, dal

denaro a disposizione e dal numero di persone nel gruppo di lavoro,

se è vero che nessuna delle tecniche descritte è perfetta, come

facciamo a sfruttare al meglio ciascuna di esse e come è possibile

verificare le differenti prerogative nelle diverse condizioni di utilizzo?

E ancora, è possibile utilizzare un metodo misto che tragga da

ciascuna delle tecniche suddette solo il meglio che è in grado di

fornire?

Certamente le risposte sono positive: anche nei campi di

applicazione più estremi, come ad esempio gli effetti speciali

cinematografici, le tecniche miste sono quelle che da sempre

consentono di ottenere i migliori risultati.

Ciò che faremo ora è sperimentare quanto detto su un esempio

pratico: cercheremo di riprodurre le stesse condizioni di

illuminazione naturale e artificiale con le tre tecniche descritte e

confronteremo i risultati dal punto di vista qualitativo e dei tempi di

rendering (ovviamente a parità di macchina di calcolo).

Illuminazione naturale

fig.4

Scena di prova, versione shaded

La scena di prova (fig.4) è un classico esempio in cui l’apporto della

luce indiretta è fondamentale, costituendo così una palestra di prova

ardua e inflessibile per un software di rendering: una stanza

illuminata da una finestra che lascia entrare la luce solare che incide

sul pavimento. All’interno della stanza sono disposti alcuni tipici

oggetti che consentono di vedere il comportamento della

simulazione nelle zone di penombra e nelle parti più critiche, ossia

le aree di contatto tra diverse geometrie.

Alcuni oggetti in scena (la parete a sinistra in mattoni a vista ed il

pavimento in doghe di legno) sono costituiti da materiali con

caratteristiche superficiali diverse cha danno origine a rugosità e

riflessioni. Gli altri oggetti sono privi di particolari caratteristiche

superficiali e sono dotati di semplici colori uniformi. Bisogna tenere

presente che i software commerciali attualmente disponibili

considerano tutti gli oggetti uniformemente diffondenti; le specularità

sono trattate a livello visivo. Il comportamento energetico in

riflessione di uno specchio (ad es. la riflessione di un fascio

luminoso) può essere simulato con la tecnica del calcolo delle

cosiddette caustiche, della quale non tratteremo nella presente

analisi.

fig.5

Scena di prova, simulazione calcolata con algoritmo

scanline/raytracing

Il metodo scanline/raytracing (fig.5) fornisce risultati variabili a

seconda della capacità dell’operatore di utilizzare le fonti luminose

del software a disposizione: essendo il metodo suddetto privo della

possibilità di calcolo della luce indiretta risulta infatti necessario dare

luce dove questa non può essere calcolata automaticamente.

fig.5a

Scena di prova, disposizione delle sorgenti virtuali aggiuntive per

l’algoritmo scanline/raytracing per la simulazione della componente

diffusa

In fig.5a si può vedere la disposizione di sorgenti aggiuntive che

nella realtà della scena di esempio non esistono; tali sorgenti,

opportunamente configurate consentono di simulare rapidamente la

luce diffusa. Tale configurabilità è il trucco che consente

all’operatore di simulare la luce diffusa, altrimenti non calcolabile in

automatico dal metodo utilizzato.

Il metodo scanline/raytracing risulta quindi essere estremamente

efficiente (15min:38sec) nonostante sia ovviamente necessaria una

grande esperienza da parte dell’utente per ovviare alle mancanze

del software: una configurazione non corretta delle sorgenti

aggiuntive restituisce un’immagine qualitativamente inaccettabile.

Con la G.I. si può ottenere il calcolo della luce diffusa ma soprattutto

si riescono a simulare automaticamente tutti i tipi di materiali

immaginabili: dalla rifrazione alla diffrazione, dalla traslucenza alla

riflessione sfocata, fino al displacement mapping per le rugosità

superficiali complesse.

Fig.6

Scena di prova, simulazione calcolata con algoritmo GI

In fig.6 si può osservare l’estrema qualità ottenibile con il calcolo G.I

(3h:07min:25sec):

il

metodo

infatti,

come

anticipato

precedentemente, calcola la luce diffusa solo per le parti della

scena che si vedono dal punto di vista prescelto. Per renderizzare

altri punti di vista si devono incrementare le informazioni della

photon map con un calcolo aggiuntivo delle componenti trascurate.

L’algoritmo radiosity, fisicamente corretto, genera un illuminazione

estremamente verosimile e diffusa correttamente nella scena;

mostra tuttavia il fianco nella qualità dei materiali: rifrazioni,

traslucenza e soprattutto rugosità superficiale, caratteristiche tutte

ottenibili con i materiali a disposizione dei più diffusi software di

rendering, si perdono o vengono pesantemente semplificate (fig.7).

fig.7

Scena di prova, simulazione calcolata con algoritmo radiosity

Osservando l'aspetto delle pareti in mattoni ed intonaco si deduce

che l'effetto di rugosità viene simulato con grande qualità solo con i

metodi scanline/raytracing e G.I. La qualità dei metalli e delle

riflessioni sfocate (mensola libreria a sinistra e piede del tavolino al

centro) è ottima solo nel calcolo G.I. mentre negli altri presenta

artefatti e macchie non verosimili.

L’unica possibilità per ovviare al problema è salvare la soluzione

radiosity e ricalcolare l’immagine con un metodo raytracing che

supporti le caratteristiche di cui sopra.

I tempi di calcolo per l’immagine di fig.4 non sono elevati

(1h:20min:45sec) e comunque compensati dal fatto che, definito

l’impianto luci, il calcolo viene effettuato una sola volta per qualsiasi

punto di vista da cui si decida di “fotografare” il modello.

Illuminazione artificiale

Interessante a questo punto è verificare i concetti esposti finora in

una situazione di simulazione di luce artificiale. La stessa scena

utilizzata per il caso dell’illuminazione naturale è anche banco di

prova per l’illuminazione artificiale. Valgono quindi le stesse

considerazioni sulle caratteristiche dei materiali presenti in scena

già esposte.

Per simulare l’illuminazione artificiale, è’ stato inserito un corpo

illuminante (plafoniera da ufficio con due tubi fluorescenti) a centro

volta e annullato completamente il contributo della radiazione

naturale (scena notturna). Nuovamente è stata calcolata la

simulazione con i tre metodi esposti finora.

Le osservazioni fatte precedentemente risultano essere tutte

confermate, si nota però che le differenze tra i vari metodi di calcolo

si accentuano.

Osservando le figg. 8, 9 e 10 si nota che gli algoritmi

scanline/raytracing (fig.8) e G.I. (fig.9) accentuano il contrasto tra

zone illuminate e zone in ombra, dando così agli oggetti una

maggiore tridimensionalità. Nuovamente è stato necessario

aggiungere delle sorgenti virtuali per simulare la componente diffusa

nel caso dell’algoritmo scanline/raytracing.

Con il metodo radiosity (fig.10) le penombre sono molto penalizzate

e l'immagine risulta decisamente più piatta; si osservi, ad esempio,

anche in questo caso la resa del muro in mattoni a vista e le pareti

intonacate. Questo metodo tuttavia consente una simulazione più

corretta dell'illuminazione complessiva della scena poiché è l’unico

che tiene conto della reale ripartizione spaziale dell’intensità

luminosa dell’apparecchio in scena (curve fotometriche). Negli altri

casi (scanline/raytracing e G.I.) è l’utente a definire la ripartizione

della radiazione luminosa della sorgente, imponendo un cono di

apertura del fascio luminoso. L’algoritmo radiosity tiene inoltre conto

dell’effettiva composizione spettrale della radiazione luminosa e

della sua influenza sulla resa dei colori delle superfici presenti nella

scena. Nel caso della G.I. questo calcolo viene effettuato in modo

analogo ma senza alcun riferimento alla composizione spettrale

della radiazione luminosa.

fig.8

Scena di prova, simulazione calcolata con algoritmo

scanline/raytracing, illuminazione artificiale

fig.9

Scena di prova, simulazione calcolata con algoritmo GI,

illuminazione artificiale

fig.10

Scena di prova, simulazione calcolata con algoritmo radiosity,

illuminazione artificiale

Tabella 1 caratteristiche delle immagini e tempi di calcolo

Immagine

Algoritmo di

calcolo

Risoluzione[3 Tempo di calcolo

00 dpi]

fig.2

Scanline/

Raytracing

2300x1725

pixel

15min:38sec

fig.3

G.I

2300x1725

pixel

3h:07min:25sec

fig.4

Radiosity

2300x1725

pixel

1h:20min:45sec

fig.5

Scanline/

Raytracing

2300x1725

pixel

13min:26sec

fig.6

G.I

2300x1725

pixel

1h:31min:17sec

fig.7

Radiosity

2300x1725

pixel

45min:56sec

fig.A

Scanline +G.I.

3000x2000

pixel

4h:21min:33sec

Conclusioni

Introducendo le varie tecniche di calcolo ci siamo chiesti quali

fossero i vantaggi e gli svantaggi presenti in ognuna di esse e se

fosse possibile utilizzare con profitto tecniche miste per trarre da

ciascuna di esse il meglio di quanto offrono in termini di qualità della

scena e tempi di calcolo. Come abbiamo visto è confermata

l’asserzione iniziale di questo articolo secondo cui la perfetta tecnica

di simulazione ancora non è disponibile nei software commerciali.

Ogni algoritmo presenta vantaggi e svantaggi, il trucco è nel riuscire

a sfruttare al meglio i vantaggi che ognuno è in grado di fornire.

L’immagine di apertura del presente articolo è una scena

sensibilmente più complessa di quella utilizzata come banco di

prova per i test. Le superfici hanno caratteristiche complesse e gli

algoritmi di calcolo sono applicati in modo tale da rendere al meglio

ogni aspetto. Per ottenere questo risultato è stata utilizzata una

tecnica mista G.I./scanline per ridurre drasticamente i tempi di

calcolo (4h:21min:33sec). La tecnica radiosity non è stata applicata

in quanto sono presenti superfici con materiali caratterizzati da

rugosità complesse: questi materiali possono essere riprodotti in

modo corretto solo con il binomio G.I./scanline. Inoltre non era

richiesta, nel caso specifico, una analisi illuminotecnica con

apparecchi a complessa ripartizione spaziale dell’intensità luminosa

e le sorgenti usate non introducono problemi sulla resa dei colori dei

materiali presenti in scena.

Il risultato è un’immagine fortemente d’effetto con una buona resa

realistica a fronte di un impegno di tempi di calcolo relativamente

modesto.

L’illuminazione di esterni

Nel presente articolo si affronta in modo analogo la situazione

dell’illuminazione di esterni.

Qual è il motivo che spinge ad analizzare questa situazione di

illuminazione separatamente dalla precedente?

La risposta sta nelle tecniche utilizzate per il calcolo

dell'illuminazione: alcune, già utilizzate negli interni, vengono

sfruttate in modo diverso negli esterni, altre sono invece

parzialmente o del tutto nuove e si utilizzano specificatamente nel

calcolo dell'illuminazione di esterni.

Da notare, come già fatto in precedenza, che la metodologia di

lavoro qui analizzata non considera i software scientifici di alto livello

in grado di fornire dati quantitativi esatti, ma costituisce un esempio

delle possibilità di rappresentazione tridimensionale, con software

commerciali, che, in fase di progettazione o per scopi di

comunicazione, i professionisti (architetti, designer, progettisti)

utilizzano frequentemente.

L’illuminazione degli esterni e le tecniche di simulazione.

Nella fig.11 si può vedere il modello utilizzato per il test: un edificio a

due piani con un contesto circostante (progetto arch. Renzo

Raimondi).

Il modello costituisce un classico esempio di scena in esterno e

verrà sottoposto, come nel caso degli interni già citato, a rendering

in condizioni di illuminazione naturale (caso diurno) e artificiale

(caso notturno).

Le tecniche per simulare l'illuminazione in esterni differiscono dal

caso degli interni poiché le condizioni ambientali al contorno in cui si

trovano ad essere gli oggetti nel caso di esterni o di interni sono

fortemente differenti, soprattutto per quanto riguarda il caso

dell’illuminazione naturale.

Infatti, mentre nel caso degli interni con luce solare si ha una

preponderanza di illuminazione indiretta e diffusa dagli oggetti

presenti in scena, nel caso di esterni si ha una preponderanza di

luce diretta proveniente dal sole e, soprattutto, proveniente dalla

diffusione del cielo.

fig.11

Modello utilizzato per il test

Ciò che quindi si deve replicare è proprio questa situazione,

schematicamente raffigurata in fig.12 in cui un gruppo di primitive

solide appoggiate su un piano viene illuminato da una sorgente a

raggi paralleli che simula il sole (A) e da una calotta semisferica che

simula la volta celeste (B).

fig.12

Schema di illuminazione per esterni

Nel caso, invece,dell’illuminazione artificiale di esterni, non è più

necessario tenere nella giusta considerazione i contributi delle interriflessioni delle superfici illuminate, come invece era di importanza

rilevante nel caso dell’illuminazione di interni. Infatti nel caso di

esterni il maggior contributo all’illuminazione proviene direttamente

dagli apparecchi di illuminazione presenti nella scena.

Gli algoritmi di simulazione utilizzati per simulare le condizioni di

illuminazione di esterni, come il caso della scena di test, sono i

seguenti:

scanline/raytracing

radiosity

global illumination

ambient occlusion

global illumination con HDRI

Le prime tre tecniche non verranno utilizzate nel calcolo della scena

di test poiché meno performanti delle ultime due che costituiscono

quindi i nuovi approcci al rendering di esterni e che rivoluzionano

metodi e tempi di lavorazione di una scena 3D.

L'Ambient Occlusion (AO) è una tecnica efficacissima che,

sfruttando il raytracing, proietta raggi da una calotta ipotetica (non

fisicamente presente in scena) allo scopo di colpire gli oggetti da

tutte le direzioni generando in questo modo penombre tanto più

realistiche quanti più sono i raggi emessi dal sistema (chiamati

samples). E’ una tecnica molto flessibile (con pochi raggi si genera

un disturbo nell'immagine ma si possono effettuare velocissime

prove di illuminazione in diverse condizioni) e potente che produce

solo luce diretta ma è facilmente integrabile, con una efficace

tecnica mista come accennato in, con altre sorgenti luminose.

La Global Illumination nel caso dell’illuminazione di esterni è

efficacemente integrata con le immagini HDRI (High Dynamic

Range Image) dell’ambiente circostante in cui il modello virtuale è

inserito, per ottenere i migliori risultati.

Le immagini HDRI sono il risultato dell'unione di diverse immagini

dello stesso soggetto, in questo caso il contesto, fotografato in

diverse condizioni di esposizione: la composizione di queste in una

sola immagine consente di salvare le informazioni di illuminazione

all'interno del file stesso.

La differenza tra un immagine tradizionale e una HDRI sta nel fatto

che nella prima il pixel assume un colore fisso compreso tra 0 e i

milioni di colori disponibili in funzione del numero di bit

dell’immagine: usualmente le immagini sono a 24 bit che

corrispondono a 16,8 106 colori, in alcuni casi si hanno immagini a

48 bit, per un totale di 2,8 1014 colori. Le immagini HDRI sono a 96

bit le informazioni contenute all’interno si ampliano in modo

esponenziale: 7,9 1028 valori per ogni singolo pixel!.

Il risultato finale di questa tecnica è dato da immagini ad alto

realismo in cui le componenti diretta, diffusa e speculare vengono

simulate con estrema semplicità con il solo utilizzo di un immagine

ambientale.

Il lato negativo risiede nei tempi di preparazione dell'immagine

panoramica , e nei tempi di calcolo del rendering finale.

Il test

Nella nostra prova applicheremo le due tecniche suddette

confronteremo tempi e risultati alla stessa scena di test di fig.11.

evidenzieranno le specifiche caratteristiche di ogni tecnica e

definiranno gli ambiti di applicazione specifici e i vantaggi

ciascuna.

e

Si

si

di

Il caso dell’illuminazione diurna

Nelle figg. 13 e 14 si possono osservare i risultati dell'applicazione

delle due tecniche ad una situazione di luce diurna.

fig.13

Illuminazione diurna con AO

fig.14

Illuminazione diurna con HDRI

I diversi tempi di calcolo (rispettivamente di 1h:15min per AO e

3h:27min per HDRI), dovuti al diverso tipo di metodo utilizzato (AO

non calcola la luce indiretta), dichiarano immediatamente il diverso

tipo di approccio alla simulazione che i due algoritmi possiedono.

Indubbiamente superiore come qualità, il metodo HDRI consente un

maggior controllo dell'illuminazione, ma diventa scarsamente pratico

in tutti quei casi (sempre molto frequenti) in cui la qualità assoluta si

deve parzialmente sacrificare in favore di tempi di produzione stretti.

L'AO si mostra quindi vincente in tutti quei casi in cui si richiede

rapidità di configurazione e calcolo: è sufficiente impostare un

corretto valore di “samples” ed ottenere in questo modo diverse

immagini di prova calcolate in poche manciate di secondi per poi

aumentare la definizione dei samples solo nelle immagini finali.

Il caso dell’illuminazione notturna

In questo caso il netto vantaggio dell'AO si esprime ancor meglio

poiché il contesto notturno in cui il modello virtuale è inserito non

produce grandi effetti sull’illuminazione artificiale dello stesso.

Quindi con la tecnica Global Illumination con immagini HDRI,

l'apporto di illuminazione dall’ambiente circostante, in particolare

dalla volta celeste, sostanzialmente buia e comunque priva di forti

contrasti, non restituisce risultati utili ed il lavoro di preparazione

dell'immagine ambientale non viene ripagato da un incremento

rilevante della qualità del risultato.

Nella preparazione di una scena notturna si deve ovviamente tenere

in considerazione l'introduzione di luci che simulano le sorgenti

artificiali presenti nella realtà.

Nella scena di test sono state utilizzate delle tradizionali sorgenti

virtuali di tipo spot e area light che opportunamente calibrate

forniscono la resa adeguata di lampioni, lampade da interni e altri

apparecchi tipici di una scena di questo tipo.

Il risultato dell'illuminazione dei due motori di resa dell'illuminazione

artificiale si può osservare nelle figg. 15 e 16 dove, rispettivamente,

AO e HDRI riportano risultati estremamente simili con tempi tuttavia

decisamente a favore di AO: 2h 43min per AO e 5h:07min per

HDRI.

Dalle prove effettuate si deduce una reale operatività dello

strumento di AO nel caso di illuminazione di esterni.

fig.15

Illuminazione notturna con Ambient Occlusion

fig.16

Illuminazione notturna con HDRI

Tabella 1 Caratteristiche delle immagini e tempi di calcolo

Immagine

Algoritmo di

calcolo

Risoluzione

[300 dpi]

Tempo di

calcolo

AO

1725 x 1078

pixel

1 h 15 min

Fig. 14

GI con HDRI

1726 x 1078

pixel

3 h 27 min

Fig. 15

AO

1725 x 1078

pixel

2 h 43 min

Fig. 16

GI con HDRI

1726 x 1078

pixel

5 h 07 min

Fig. 13

E’ importante sottolineare che solo la tecnica Radiosity consente di

considerare l’effettiva ripartizione spaziale dell’intensità luminosa

degli apparecchi presenti nella scena. Nel caso dell’illuminazione di

esterni, questa tecnica non viene utilizzata poiché praticamente non

esiste un ambiente ristretto di cui calcolare l’effettivo bilancio

energetico interno. Infatti nel caso notturno, l’apporto delle interriflessioni delle superfici presenti in scena è praticamente nullo e la

simulazione con le tecniche quivi descritte fornisce risultati

estremamente soddisfacenti.

Conclusioni

Il caso preso in esame ha evidenziato l’utilizzo di un metodo di

lavoro specifico del rendering di esterni in cui la scena è stata

ottimizzata al particolare scopo.

Vi sono tuttavia casi in cui i metodi esposti si applicano a scene di

interni riconducibili alla situazione degli esterni: il modello virtuale ha

dimensioni trascurabili rispetto all’ambiente circostante e/o alla

sorgente illuminante (caso illuminazione naturale in esterni).

Tipica è la situazione in cui un oggetto, contenuto all’interno di uno

spazio chiuso ha dimensioni relativamente piccole rispetto

all’ambiente che lo contiene: anche il caso dell’inserimento di un

oggetto virtuale appoggiato su un tavolo in una stanza reale, può

quindi essere efficacemente risolto con le tecniche esposte in

questa occasione.

Lo sfondo sarà costituito da un’immagine ambientale reale della

stanza e l’oggetto modellato virtualmente verrà illuminato, posto su

un tavolo, coerentemente con l’illuminazione dell’ambiente reale di

sfondo.

In fig. 17 si può osservare un caso tipico in cui gli oggetti sono stati

illuminati con l’utilizzo di Ambient Occlusion.

fig.8

Rendering di interni con Ambient Occlusion

Da aggiungere a questo punto un doveroso riferimento agli

strumenti utilizzati per questo test di resa.

Tutti i rendering del presente articolo sono stati realizzati con

Blender, uno strumento di modellazione, animazione e rendering

Open Source (quindi assolutamente gratuito, anche per utilizzo di

tipo commerciale) che si è dimostrato non solo affidabile ma anche

professionalmente operativo al pari di blasonati software che, oltre

ad essere estremamente costosi, risultano sempre più ridondanti e

pesanti dal punto di vista della gestione (oltre i 100 Mb di spazio

installato su disco).

Non ultimo il vantaggio di essere completo di tutte le funzioni

necessarie ad un software di questo tipo, tutte comprese in un file di

installazione di meno di 3Mbyte.

Sicurezza attiva e passiva in moto, simulazione di

dinamica ed eventi

L’aver affrontato un tema complesso come quello della sicurezza in

moto, è stato di stimolo per la progettazione vera e propria ma

soprattutto per la fase di impostazione del lavoro.

Se all’inizio del lavoro le idee, ma soprattutto i sogni, erano quelli di

riuscire a creare qualcosa di rivoluzionario, con lo svilupparsi della

ricerca, l’affinamento delle conoscenze ci ha portato a considerare

tutto il progetto in un’ottica più realistica.

Si è lavorato così in modo verosimile, totalmente estraneo agli

esercizi di stile tipici di carrozzieri e stilisti.

In testa alla lista esistevano dei problemi che, tradotti in esigenze,

hanno richiesto soluzioni.

Queste raramente passano attraverso il semplice esercizio al

tecnigrafo (o al computer) di tracciatura di forme a prescindere dalla

reale dinamica del caso.

Nel disegno industriale si deve tenere conto, molto di più che in

architettura, di tempi, costi, pesi, producibilità, diffusione sul mercato

e vendibilità.

Per questo si è prestata particolare attenzione alla semplicità e alla

possibilità di realizzazione con tecnologie già presenti sul mercato.

La soluzione adottata può valere per tutti gli scooter in commercio,

essendo questi ultimi molto simili tra loro nelle dimensioni, struttura

del telaio, distribuzione di pesi e volumi e soprattutto perché tutti

dotati di scudo anteriore.

Le poche ricerche fino ad ora condotte nel campo della “moto

sicura”, sono sempre state un riuso dei concetti propri della ricerca

automobilistica, e pertanto non specifiche. Come già puntualizzato,

la moto, non è l’auto, sotto nessun aspetto, e come tale va trattata a

parte, tenendo conto delle esigenze specifiche. I risultati ottenuti nel

campo automobilistico possono essere utili, ma non devono essere

il punto di partenza, né quello di arrivo, ma solo strumento di

ricerca.

La moto è un veicolo il cui mercato esiste grazie alla passione di chi

la usa.

E’ un mezzo di trasporto più disagevole dell’auto, ma nelle città dal

traffico sempre al limite del collasso per ingorghi e problemi di

parcheggio, è un mezzo di locomozione che vive ora una nuova

giovinezza. Sono in tanti ormai a pensare che i vantaggi siano

superiori ai disagi intrinseci delle due ruote, e che forse sia meglio

preoccuparsi di casco, guanti, una maglia in più, piuttosto che

passare la giornata prima fermi in coda, poi lottando, senza

esclusione di colpi, alla ricerca dell’ambito parcheggio.

Se questo non bastasse ancora, pensiamo all’ambiente: le auto in

genere, mediamente con una capienza di cinque posti, vengono

utilizzate dal solo conducente, occupano 5 volte lo spazio di uno

scooter, ed inquinano da 30 a 40 volte di più.

Dare un’immagine di maggior sicurezza a un mezzo di trasporto

simbolo del rischio per antonomasia, porterebbe forse ad evitare

che tanti diventino forzatamente utenti di un mezzo delle cui

dimensioni non necessitano effettivamente se non per l’idea che

“grosso è più sicuro”, rendendo meno congestionato il traffico in

città. Perché quello che interessa a tutti non è forse il raggiungere la

meta senza sforzo, velocemente, senza avere problemi di posteggio

e soprattutto in modo efficiente?

Ma qui siamo di nuovo sconfinati nei sogni dell’inizio... il progetto

presentato non cambierà il mondo dei trasporti, ma costituisce un

verosimile punto di partenza per ulteriori ricerche.

Un oggetto di produzione industriale ha, nella maggior parte dei

casi, dimensioni a misura d’uomo. La moto non viene meno a

questa regola.

L’utilizzo di uno scooter di produzione ha permesso di confrontarsi

direttamente con la realtà fisica delle parti.

E’ stato necessario intervenire direttamente sul mezzo per

verificare, purtroppo per ora solo staticamente, ingombri, percentili,

e interferenze reciproche dei vari elementi.

Legno, poliuretano espanso, stucco, colla vinilica, vernici all’acqua,

sono stati strumenti che hanno consentito la modellazione reale in

scala al vero, con ricadute progettuali importantissime.

Una volta realizzato il modello, però, restava un’incognita: il suo

comportamento dinamico. Avrebbe funzionato o no? La risposta a

questo quesito sarebbe venuta da una sperimentazione sul campo

troppo costosa.

Di conseguenza è stato simulato virtualmente il comportamento in

caso di urto.

L’utilizzo del computer ha consentito di verificare le ipotesi,

visualizzando attraverso animazioni, la sequenza di impatto, sia nel

caso normale, che nel caso con la protezione passiva dello scivolo.

Il computer è stato perciò uno strumento fondamentale per la

verifica delle ipotesi progettuali.

La piattaforma hardware utilizzata è stata un Personal Computer

basato su processore Intel Pentium (180 MHz di cpu clock) con 64

Mb di RAM e scheda grafica Matrox Millenium (4 Mb di Wram). Con

software Autodesk 3D Studio 4, 3D Studio Max e AutoCAD r12,

sulla base del rilievo dimensionale dello scooter Skipper, sono state

realizzate sia la modellazione tridimensionale che le prove

dinamiche dell’intero contesto progettuale. E’ stato pertanto

verificato il comportamento e la funzionalità dell’oggetto con costi

decisamente più contenuti della realizzazione di prove di crash.

Prove che possono essere realizzate solo dalle grandi industrie con

investimenti molto elevati.

BIBLIOGRAFIA

•

F. Valpreda, Le tecniche di simulazione digitale per la

comunicazione del progetto, Luce n.2 anno 2004]

•

Antonio A. Bianco, Blender 2.32, Computer Grafica, Tecniche

e Applicazioni n°35 aprile 2004

•

Ton Roosendaal e aa., The Official Blender 2.3 Guide

•

V. Mazza, Architettura virtuale – Chiostro 3D Professional n°5

dic 2000/gen 2001

•

S. Testoni, Rappresentazione ed analisi del modello digitale

in architettura 3D Professional n°7 apr/mag 2002

•

A. Rinaldi, Tecniche d'illuminazione 3D Professional n°9 dic

2003/gen 2004

•

J. Birn, Digital Lighting & Rendering New Riders, 2000

•

M. Derwyn, M. Harrison, M. Blaisdell, Motorcycle collision

experiments

SAE papers 700897

•

K. Langwieder, Collision characteristics and injuries to

motorcyclists and moped drivers

SAE papers 770920

•

P. M. Watson, Features of the experimental safety motorcycle

SAE papers 796010

•

A. Searle, J. A. Searle, The trajectories of pedestrian,

motorcycles, motorcyclists, etc., following a road

accident

SAE papers 831622

•

F. B. Cassan, J. C. Vincent, A. Fayon, C. Tarriere, Investigation

of a series of representative experimental collisions

between automobiles and two wheeled vehicles, with

specific analysis of severity of head impacts

IRCOBI 1984

•

J. Grandel, D. Shaper, Impact dynamic, head impact severity

and helmet’s energy absorption in

motorcycle/passenger car accident tests

IRCOBI 1984

•

K. D. Kulby, C. R. Buse, Motorcycle post-accident inspection

techniques

SAE papers 850064

•

J. Grandel, D. Shaper, Motorcycle collision with passenger

cars. Analysis of impact mechanism, kinematics, and

effectiveness, of full face safety helmets

SAE papers 850094

•

B. P. Chinn, P. Hopes, M. A. Macaulay, Leg protection for

riders of motorcycles

SAE 856121

•

M. Danner, K. Langwieder, A. Sporner, Accident of

motorcyclists. Increase of safety by technical measures

on the basis of knowledge derived from real-life

accidents

SAE papers 856123

•

H. Takodoro, S. Fukuda, K. Miyazaki, A study of motorcycles

leg protection

SAE 856126

•

G. L. Donne, P. D. Hopes, Motorcycle rider protection in

frontal impacts

SAE 856128

•

J. V. Ouellet, H. H. Hurt, D. R. Thom, Collision performances

of contemporary crashbars and motorcycle riders leg

injuries

SAE 870603

•

G. Bocchi, La simulazione al computer del comportamento

dinamico del telaio motociclistico

in Moto Tecnica, anno 2, n° 1, aprile 1988

•

S. Colombo, Una struttura ben calcolata è tutta salute

in Moto Tecnica, anno 2, n° 2, maggio 1988

•

M. Riccardi, BMW, la moto pensa alla sicurezza

in Motociclismo, anno 79, n°11, novembre 1992

•

F. Fazi, Stile e produzione di massa. L’esperienza Piaggio

in Moto Tecnica, anno 6, n° 12, dicembre 1992

•

F. Fazi, Sicurezza passiva anno zero

in Moto Tecnica, anno 7, n° 1, gennaio 1993

•

P. Beducci, Dossier: l’industria della motocicletta

in Tecnologie Meccaniche, anno 27, n° 1, gennaio 1996

Alcuni siti web di riferimento

www.blender.org

www.blender3d.org

www.elysiun.com

www.3dtotal.com

www.cgchannel.com

![Musica_e_immagine.pps [modalità compatibilità]](http://s1.studylibit.com/store/data/007566322_1-58d70b56b536a079f8882415348ab4fa-300x300.png)