IT Administrator

Hardware

Materiale didattico validato AICA

Modulo 1

In collaborazione con

IT administrator - Hardware

Materiale didattico

progettato per EUCIP

IT Administrator

segnalato da AICA

Modulo 1 - Hardware

“AICA, Licenziataria

esclusiva in Italia

del programma

EUCIP (European

Certification

of Informatics

Professionals)

riconosce che il

materiale didattico

segnalato è

strutturato in

modo coerente con

l’organizzazione dei

contenuti prevista

dai documenti

EUCIP di riferimento.

Di conseguenza

AICA autorizza sul

presente materiale

didattico l’uso

dei marchi EUCIP

(registrato dal

CEPIS Concil

of European

Professional

Informatics

Societies) ed AICA

protetti dalle leggi

vigenti.”

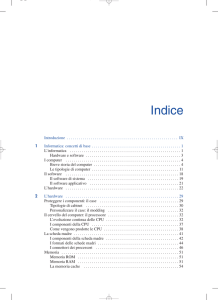

1.1 Introduzione

al PC

A scuola con PC Open

Diventa esperto

nell’hardware per PC

Inizia un nuovo corso in 11 puntate, che permetterà di

conseguire la certificazione EUCIP IT Administrator Hardware, riconosciuta a livello europeo. La prima lezione

è dedicata alle schede madri e al BIOS di Marco Mussini

componenti e le periferiche del nostro PC, un corso

che toccherà e approfondirà i temi che gravitano attorno al mondo hardware. Dopo aver concluso con

successo il modulo 5 del Syllabus (dedicato alla Sicurezza), ci spostiamo ora sul modulo 1 (Hardware) che

è organizzato in collaborazione con Foxconn Italia e

certificato da AICA, Associazione Italiana per l’Informatica e il Calcolo Automatico, la più importante associazione nazionale di professionisti di informatica,

che ha come finalità principale lo sviluppo, fra i suoi

aderenti e nella più vasta comunità nazionale, delle

conoscenze attinenti la disciplina informatica in tutti

i suoi aspetti scientifici, applicativi, economici e sociali. Il corso seguirà il Syllabus 2.0, modulo 1, della

certificazione EUCIP – IT Administrator che serve per

preparare l’esame in una delle sedi autorizzate. Iniziamo parlando di schede madri e di BIOS, la base su cui

sono installati i componenti principali del nostro PC.

I

I componenti di base

La tecnologia dell’informazione e della comunicazione (Information and Communication Technology,

o ICT) ha per oggetto i sistemi progettati per immagazzinare, comunicare, elaborare informazioni. Anche

se numerosissime classi di prodotti incorporano tecnologie e concetti dell’ICT, dagli elettrodomestici agli

orologi da polso, dai sistemi di intrattenimento ai circuiti di controllo per il motore dell’auto, lo strumento principe per l’applicazione pratica dell’ICT, quello

più diffuso e conosciuto e quello che sta avendo finora il maggior impatto sulla vita quotidiana delle persone, sulle modalità pratiche di lavoro in ogni campo,

nonché sull’aumento della produttività, è il Personal

Computer (PC), sulla cui approfondita conoscenza

questo corso si focalizzerà.

Componenti principali

1.1.1 Componenti

principali

1.1.1.1 Comprendere

i concetti

fondamentali

relativi all’hardware e

software

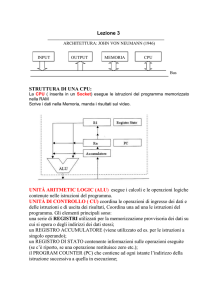

Lezione 1

Anche se verrebbe spontaneo associare il concetto di PC all’oggetto materiale che lo costituisce fisicamente, questa identificazione è superficiale e inesatta. In realtà quasi tutti i sistemi informatici, e segnatamente i PC, devono intendersi costituiti da due distinte componenti che potrebbero dirsi quasi in “simbiosi” dato che non avrebbero alcun senso né utilità

l’una separata dall’altra. Queste due componenti sono l’hardware e il software.

I fondamenti relativi all’hardware e software

L’hardware di un computer è costituito dall’insie-

PC Open 2 www.pcopen.it

PDF DEL CORSO

NEL DVD

Calendario delle lezioni

Lez 1: la scheda madre e il BIOS

Lez 2: i processori

Lez 3: la RAM

Lez 4: bus e risorse di sistema

Lez 5: interfacce

Lez 6: memorie di massa

Lez 7: i monitor e le schede grafiche

Lez 8: le stampanti

Lez 9: hardware di rete

In collaborazione con

Lez 10: alimentatori

e installazione nuovo

hardware

Lez 11: risoluzione dei

problemi

me di parti materiali, come circuiti, telai metallici, cavi, motori, ventole, spie, interruttori, spine e prese,

che concorrono a formare l’oggetto fisico e tangibile

che comunemente chiamiamo computer. Questo insieme di parti è progettato per eseguire compiti estremamente semplici con la massima velocità, accuratezza e ripetibilità. Tali compiti includono, a titolo di

esempio:

• il trasferimento di un dato da una parte all’altra della macchina o fra questa e l’esterno,

• la lettura o scrittura di un dato su memoria persistente o volatile,

• l’accensione di un singolo puntino colorato sullo

schermo,

• l’emissione di un impulso acustico,

• il rilevamento di un tasto premuto sulla tastiera,

• la somma di due numeri interi.

Come si vede, il tipo di compiti che l'hardware è

in grado di eseguire direttamente è decisamente elementare e di scarso interesse. Tuttavia, eseguendo

in modo finalizzato, coordinato e accuratamente sincronizzato un enorme numero di questi compiti elementari, è possibile svolgere compiti più utili e interessanti:

• accendendo un gran numero di puntini sul video è

possibile comporre immagini;

• emettendo in modo ben preciso alcuni impulsi acustici è possibile riprodurre musica, voci e suoni;

• ripetendo più volte il trasferimento di dati elementari dalla memoria locale non volatile alla porta di

Lezione 1

IT administrator - Hardware

comunicazione è possibile trasmettere informazioni complesse;

• effettuando somme ripetute secondo uno schema

preordinato è possibile calcolare un prodotto;

e così via.

In quest’ottica, il software è l’insieme di procedure

codificate (programmi) che prescrivono come eseguire in modo coordinato queste grandi quantità di

operazioni elementari per realizzare compiti di interesse applicativo significativo. Come già ricordato,

hardware e software possono trovare utile impiego

solamente insieme. Infatti, l’elaboratore senza programmi (hardware senza software) possiede la capacità di eseguire compiti, ma a un livello di astrazione

troppo basso perché questi risultino, di per sé, di una

qualche utilità pratica. Viceversa, un programma non

associato a una macchina in grado di comprenderlo

ed eseguirlo (software senza hardware), sebbene abbia un valore concettuale in sé, in quanto “cattura”

e descrive compiutamente un procedimento valido

e corretto per eseguire compiti complessi, da solo è

inutile come lo sarebbe un insieme di procedure burocratiche senza funzionari che le conoscano e le applichino.

I principali componenti del PC

Concentriamo ora la nostra attenzione sull’hardware, che costituirà l’oggetto dell’intero corso. Verrà considerato in particolare l’hardware dei PC, anche se la maggior parte dei concetti di base è valida

in generale per qualsiasi classe di elaboratore, dal

microcontrollore per elettrodomestici al supercomputer per calcolo scientifico. Quasi tutti i computer

oggi esistenti e la totalità dei personal computer sul

mercato sono stati progettati secondo un’architettura logica di base che rappresenta un’evoluzione dell’impostazione di base dovuta a Von Neumann. Questa si riflette parzialmente anche sulla struttura fisica

della macchina. L’hardware dei PC comprende infatti

alcune componenti fondamentali con compiti chiaramente identificati.

• La scheda madre (motherboard), detta anche

scheda principale (main board). Si tratta di un circuito stampato di elevata complessità che provvede

all’interconnessione elettrica fra le altre componenti

interne elencate di seguito, fornendo anche le sedi

(dette socket o slot, a seconda della forma piana o a

fessura) per l’ancoraggio meccanico di alcune di esse,

come la memoria, la CPU e le schede di espansione.

Sulla motherboard circolano sia correnti elettriche di

media potenza, destinate ad alimentare le varie componenti per consentirne il funzionamento, sia corren-

La CPU è sede

dell’esecuzione dei

programmi: calcoli,

confronti, decisioni,

iterazioni, trasferimenti

di dati avvengono qui o

vengono controllati da

qui. La sede che alloggia

la CPU è posizionata sulla

motherboard

1.1.1.2 Distinguere i

principali componenti

hardware del PC

ti elettriche (estremamente deboli) usate per attuare

concretamente la comunicazione dati fra una parte e

l’altra. Di queste correnti, le prime sono fornite dalla

sezione di alimentazione della macchina, che ne assicura la quantità e la stabilità; le seconde sono invece generate dai vari circuiti della macchina, in ultima

analisi in base agli ordini contenuti nel programma in

esecuzione.

• L'unità centrale di elaborazione (central processing unit, CPU), fisicamente realizzata (“implementata”) mediante un microprocessore. La CPU si occupa

di eseguire confronti e calcoli, di prendere decisioni,

di ripetere compiti e di impartire ordini al resto della

macchina perché questa memorizzi, riceva, trasmetta

o visualizzi dati. È la CPU a eseguire, ad elevatissima

velocità, le istruzioni che costituiscono i programmi.

• La memoria di lavoro (RAM), in cui devono trovarsi i programmi e i dati durante l’esecuzione perché

la CPU possa accedervi. Questa memoria è realizzata

con una tecnologia elettronica a semiconduttori che

garantisce un’elevata velocità di funzionamento e un

tempo di accesso indipendente dalla particolare locazione che deve essere letta o scritta (Random Access

Memory, RAM). Tuttavia il contenuto di questa memoria svanisce al venir meno dell’alimentazione, e perciò

si parla di memoria

“volatile”.

• La memoria di

massa, o persistente, è una forma di

memoria con caratteristiche tali da

renderla complementare alla precedente. La memoria

di massa pone innanzitutto rimedio

al problema della

volatilità della memoria di lavoro, in

quanto i dati in essa immagazzinati

vengono mantenuti

PC Open 3 www.pcopen.it

La memoria di lavoro

volatile contiene i

programmi in esecuzione

e i dati di impiego

immediato. Realizzata

con tecnologia a

semiconduttori, ha

tempo di accesso

indipendente dalla

locazione (donde il nome

RAM) ed è fisicamente

confezionata sotto forma

di moduli comprendenti

un certo numero di chip

elementari

La motherboard è il

componente hardware

che ospita direttamente

e interconnette molte

delle più importanti

componenti del PC:

CPU, memoria, schede

audio e video, porte di

espansione. Speciali

cavi, inoltre, la collegano

con altre componenti,

come l’alimentatore e

le unità di memoria di

massa a disco

La memoria di massa,

solitamente basata

su un principio di

funzionamento magnetico

o ottico anzichè

puramente elettronico,

conserva le informazioni

immagazzinate anche

quando il PC viene

spento. Per grandi

capacità la scelta

obbligata sono le unità

a disco fisso (hard disk),

solitamente montate

all’interno del cabinet,

ma che in alcuni sistemi

possono anche essere

ad accesso frontale per

consentire una facile

sostituzione in caso di

guasto

IT administrator - Hardware

La circuiteria che implementa il sottosistema video può essere integrata nella motherboard

oppure essere realizzata su una scheda come questa, da collegare a uno degli slot di espansione

presenti sulla motherboard. La scheda grafica può essere equipaggiata con una propria CPU

specializzata (GPU), RAM e dissipatore

La maggior parte delle

porte di espansione

offerte dal PC si trova

sul retro, con la possibile

eccezione di un paio di

porte USB,

Firewire o

audio che

possono

essere

replicate per

comodità

sul pannello

frontale. Gli

standard di

formato delle

motherboard

prescrivono

anche

l’ubicazione

delle porte.

Per alcune di

esse, come

quelle audio

oppure quelle

per tastiera e

mouse, anche

il colore è

standardizzato

per lunghissimi periodi anche in mancanza di alimentazione. La sua capacità è molto maggiore di quella

della memoria di lavoro, mentre la velocità è molto

inferiore. Può essere di sola lettura oppure prevedere anche la possibilità di essere scritta, una sola volta

oppure più volte.

La memoria di massa è solitamente realizzata con

tecnologia magnetica (hard disk), magneto-ottica o

puramente ottica (CD, DVD, Blu-Ray): in tutti questi

casi l'unità di memoria di massa ha parti in rotazione

(disco) o comunque in movimento (testine). Stanno

però facendosi rapidamente largo anche nelle memorie di massa le tecnologie basate su semiconduttori,

che consentono la realizzazione di dispositivi completamente a stato solido (memorie flash).

• Sottosistema video. Generalmente realizzato

sotto forma di una scheda circuitale distinta dalla

motherboard, con una propria memoria e una propria CPU ("scheda grafica" o "graphics board", la CPU

è anche detta GPU – Graphic processing unit), questo

blocco logico si occupa di mantenere una rappresentazione interna delle immagini da visualizzare sullo

schermo, e di generare i segnali elettrici adatti a pilotare l'elettronica di tale periferica affinché il disegno

generato dalle istruzioni del programma appaia sul

monitor. In alcuni PC, per ragioni di miniaturizzazione

oppure per ridurre i costi, il sottosistema video può

anche essere integrato sulla scheda madre e può fare uso della stessa memoria di lavoro usata per programmi e dati ("memoria condivisa").

• Sottosistema audio. Anche in questo caso si parla spesso di "scheda audio" oppure di "audio integra-

PC Open 4 www.pcopen.it

Lezione 1

to" a seconda che la circuiteria sia ospitata da una

scheda distinta dalla motherboard oppure a bordo

della motherboard stessa. Sono presenti prese per

collegare altoparlanti o cuffie esterne, nonché prese

per entrata audio e microfono.

• Porte di connessione ingresso/uscita (input/output, I/O). Questi connettori, e la circuiteria che gestisce i segnali elettrici in transito su di essi, servono per

collegare dispositivi esterni ("periferiche") che collaborano con il PC nell'esecuzione dei suoi compiti

- coadiuvandolo nella comunicazione con l’esterno

con l’uomo (altoparlanti, monitor, tastiere, mouse) o

con altre macchine (rete wired o wireless, porte USB,

porte seriali e parallele, porte Firewire),

- accrescendo quantitativamente le capacità intrinseche già presenti a livello elementare (dischi esterni

aggiuntivi, sistema audio migliorato),

- aggiungendo al PC capacità totalmente nuove (ricevitore TV, stampante e via dicendo).

• Alimentatore. Questo sottosistema ha il compito di convertire i livelli elettrici della fonte primaria di

alimentazione (per esempio: 220V, 50Hz) nell'insieme

di tensioni stabilizzate (12V, 5V, 3.3V...) richieste dai

componenti elettronici del PC per il proprio funzionamento. Particolarmente esigente in termini di accuratezza di regolazione è la CPU, che richiede una tensione stabilissima e precisa al centesimo di Volt.

• Involucro o chassis. Si tratta del mobile plastico o metallico al quale sono ancorati la motherboard

con il suo corteo di sottocomponenti, l'alimentatore,

le unità disco e il pannello delle connessioni I/O.

La sua struttura ha importanti implicazioni dal punto di vista funzionale (circolazione interna dell'aria di

raffreddamento) e della manutenzione (facile accessibilità alle varie parti del sistema ed ai cablaggi che le

interconnettono), oltre a determinare le possibilità di

installazione e in qualche caso la stessa destinazione

d'uso (desktop orizzontale o verticale, server in formato tower, blade o rack mounted, oppure notebook

e tablet di varie possibili forme e dimensioni).

Nel caso particolare dei notebook e tablet PC, l'involucro integra anche il monitor e deve rispondere a

importanti requisiti di leggerezza, compattezza e resistenza. Nel caso dei desktop e server, l'involucro, con

struttura metallica e qualche volta con esterno plastico, è spesso denominato chassis, case o cabinet; oltre

alla disposizione verticale o orizzontale e al numero

di sedi per unità disco esterne, la distinzione princi-

Lezione 1

IT administrator - Hardware

solo output, come stampanti, altoparlanti, monitor.

Anche l’immagazzinamento (storage) dei dati può

avvenire in modi diversi (su disco, in memoria RAM

e così via) a seconda della quantità di dati e delle esigenze di elaborazione. Tuttavia le quattro fasi fondamentali di funzionamento, input, processing, storage

e output, in qualche misura e in qualche forma, avvengono sempre.

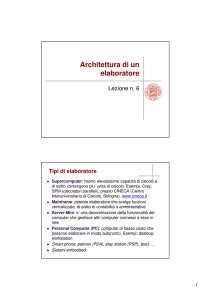

Tipologie di computer

pale riguarda il cosiddetto "fattore di forma" (per es.

ATX, mini-ATX, BTX), che determina, spesso in modo

molto preciso, sia le dimensioni generali sia la disposizione delle varie parti interne.

Fuori dall'unità centrale, che raccoglie le componenti sopra elencate, troviamo alcune parti esterne

("periferiche") che da un punto di vista logico fanno

ancora parte del computer "base" in quanto generalmente indispensabili per il suo utilizzo: tastiera, mouse, schermo

Principio di funzionamento del PC

Chiarito che un personal computer è composto da

hardware e software che possono funzionare utilmente solo l’uno in funzione dell’altro, vediamo una prima

generalizzazione del principio di funzionamento del

sistema complessivo.

Scopo del PC è sempre quello di elaborare, secondo un programma memorizzato nella macchina, dei

dati che in ultima analisi devono essere stati forniti

dall’esterno, o quantomeno derivano da dati iniziali

forniti dall’esterno. Il flusso di dati forniti in ingresso

si definisce input, mentre quello dei risultati emessi in

qualsiasi forma dalla macchina si dice output. La fase

di elaborazione dei dati è detta processing, mentre la

memorizzazione a lungo termine dei dati di input, o

dei risultati intermedi o finali, è detta storage.

Per esempio, un programma che calcola la media di

N numeri deve ricevere in input il valore N e gli N numeri da elaborare; se sono particolarmente numerosi,

i valori possono essere depositati su disco, altrimenti troveranno posto in memoria centrale; avrà quindi

inizio la fase di elaborazione, al termine della quale il

programma provvederà all’output del risultato, rappresentato da un numero.

Questo schema generale si ritrova, a saperlo riconoscere correttamente, in tutte le situazioni d’impiego del PC. Quando navighiamo in Internet, alcuni

input arrivano al PC da tastiera e mouse; come risultato, il programma (browser) incaricato di gestire la

navigazione, e in esecuzione sul computer, provvede

a generare degli output intermedi che possono essere

richieste inviate via rete verso un sito Internet, al quale si richiede di spedire una pagina Web.

Dopo pochi istanti da questo sito arrivano al PC

dei dati (il codice HTML di cui si compone la pagina)

che costituiscono un input supplementare, anch’esso

elaborato dal browser per dare luogo all’output finale,

rappresentato dalla visualizzazione sul monitor della

pagina Web richiesta.

In generale l’input può pervenire da una molteplicità di fonti e anche l’output, analogamente, può essere instradato verso numerose periferiche in grado

di trattare flussi in uscita. Esistono periferiche bidirezionali, come la rete Ethernet e Wi-Fi, il Bluetooth,

le porte a infrarossi, le porte USB, Firewire, parallela

e seriale, il modem; periferiche per solo input, come

tastiera, microfono, scanner e mouse; periferiche per

Anche se tutti i computer sono composti da hardware e software e funzionano attraverso le quattro fasi operative citate, esistono ulteriori differenze dovute principalmente alla destinazione d’uso.

La sezione di

alimentazione è un

componente la cui

importanza ai fini del

regolare funzionamento

del sistema viene spesso

sottostimata. La tensione

primaria, 220V, viene

elaborata e trasformata

in varie tensioni

secondarie stabilizzate,

generalmente comprese

fra 3.3 e 12V, che

vengono distribuite ai

vari punti del sistema per

mezzo del fascio di cavi

visibile nell’immagine

Gli svariati usi del PC

Il comune Personal Computer (PC) è destinato a

un utilizzo per molteplici scopi (general purpose) da

parte di un utente generico. Tipici impieghi includono l’accesso a Internet, l’utilizzo di posta elettronica

e programmi di video scrittura, l’ascolto di musica,

l’esecuzione di programmi educativi o di intrattenimento (giochi) e così via.

Deve pertanto essere strutturato per poter assolvere a impieghi di ogni genere, anche a costo di non avere prestazioni da primato in ognuna di esse. La macchina deve cioè anteporre la flessibilità e la versatilità

alla ricerca di prestazioni di punta in impieghi specialistici. Inoltre, l’investimento iniziale deve essere il più

possibile contenuto, senza che venga preclusa la possibilità di successive espansioni per aggiungere alla

macchina le capacità eventualmente mancanti.

È quindi importante che la macchina disponga di

ampi ma equilibrati margini di espansione, partendo

da un adeguato supporto multimediale, un elevato

numero di interfacce esterne di vari tipi (USB, Ethernet, Firewire, card reader,…), vari slot di espansione

liberi, e così via.

L’espandibilità è estremamente importante dato

che per ragioni di costo non è ipotizzabile una frequente sostituzione dell’hardware. L’utilizzo deve essere semplice per poter servire l’utenza più ampia

possibile, anche a costo di ostacolare leggermente il

lavoro di un utente esperto.

Di tutt’altro genere sono le esigenze dell’utilizzatore professionale per scopi altamente specialistici. Un

progettista o disegnatore, per esempio, necessita di

una macchina ottimizzata per le massime prestazioni grafiche, con schermi (anche multipli) di grandi dimensioni, tempi di risposta bassissimi, ampie capacità di memoria e in alcuni casi anche dispositivi di

input di tipo avanzato, come mouse a più di due assi,

tavolette grafiche e così via. Il funzionamento non deve lasciare spazio a incertezze, blocchi o malfunzionamenti e il tipo di configurazione è destinato a rimanere stabile almeno quanto la destinazione d’impiego.

La macchina, vero e proprio strumento di lavoro

quotidiano, deve certamente disporre di margini di

espansione per ridurre l’obsolescenza, ma una sua sostituzione anche entro breve tempo potrà comunque

essere presa in considerazione in base a valutazioni

economiche. Questo tipo di computer è denominato workstation. Per fare un altro esempio di computer destinato a un impiego professionale, un computer per magazzinieri dovrà possedere caratteristiche

particolari, come la leggerezza e la compattezza, la

resistenza a urti e cadute, dovrà avere alcune speciali

periferiche integrate (come un lettore di codici a barre), la capacità di funzionare senza fili e una buona

PC Open 5 www.pcopen.it

1.1.2 Differenti tipi

di PC

1.1.2.1 Differenziare

fra: comune PC

- stazione di

lavoro [Workstation]

- server

1.1.1.3 Comprendere

il principio di

funzionamento del

PC: inserimento

[input], elaborazione

[processing],

memorizzazione dati

[storage],

presentazione

risultati [output]

IT administrator - Hardware

Un palmare è privo di

tastiera e non offre

un display di grandi

dimensioni, ma in termini

di CPU, RAM e memoria

di massa è paragonabile

a un PC da tavolo di

5-6 anni fa. In tema di

connettività wireless

(Bluetooth, WiFi, UMTS)

spesso è addirittura

più avanzato di molti

portatili attuali e anche

l’autonomia può essere

superiore

autonomia della batteria, una interfaccia di controllo

(magari a touch screen) facile da usare e impiegabile

anche con una sola mano, e così via.

Le macchine destinate a funzionare non agli ordini

di una singola persona, sia essa un utente generico o

un utente professionale, ma piuttosto per supportare

un qualche tipo di servizio informatico rivolto a utenti

multipli (come un sito Web, un archivio dati, una stazione di backup, o la stessa esecuzione di applicativi

via rete), sono dette server.

Elementi essenziali di queste macchine sono la capacità di memorizzazione persistente, la potenza di

calcolo, la quantità di memoria centrale e la velocità

di accesso alla rete tutte ai massimi livelli e con ulteriori significativi margini di miglioramento grazie

a una elevata espandibilità. Un server può anche essere privo di monitor e tastiera, dal momento che la

stessa amministrazione viene eseguita da remoto. In

compenso il suo funzionamento deve essere estremamente stabile ed essere assicurato, idealmente, in

via ininterrotta.

Il funzionamento cioè non dovrebbe interrompersi

né per una (temporanea) mancanza di alimentazione,

né per operazioni di manutenzione hardware e software, ordinaria e straordinaria (in un’ottica di business continuity). Per questo i server sono macchine

del tutto particolari, con ampio uso di componentistica specifica e proprietà strutturali diverse da quelle

dei PC e delle workstation. Anche il sistema operativo

di un server possiede caratteristiche particolari, tendenti ad assicurare che il funzionamento non subisca

interruzioni a causa di malfunzionamenti del sistema

operativo stesso o ad operazioni di manutenzione o

amministrazione.

I computer Apple, fino a poco tempo fa

l’alternativa al mondo “Wintel”

1.1.2.3 Conoscere

le caratteristiche dei

computer

portatili (notebook,

palmare/PDA, tablet

computer) e

postazioni per

terminali

Internet [Network

Computer]

1.1.2.2 Conoscere

le caratteristiche

principali dei

computer Apple

Gli ultraportatili sono i

notebook più piccoli e

leggeri (poco più di 1 kg).

Generalmente montano

display da 12” ad alta

risoluzione e processori

Centrino per consumare

il meno possibile e poter

così offrire una buona

autonomia nonostante la

batteria piccola e leggera

Nell’ambito dei Personal Computer, che sono in

stragrande maggioranza basati su processori compatibili con l’architettura x86, i modelli basati sullo

standard Apple hanno per anni costituito categoria

a sé. Soprattutto in passato, le differenze fra gli Apple e i “normali” PC erano profonde e riguardavano

l’hardware, il software e la filosofia generale in fatto

di espandibilità e di profilo d’utente tipico.

I computer Apple hanno montato per anni processori della famiglia Motorola 68000, per poi passare, in

una seconda fase, ai processori PowerPC, fino a convergere anch’essi, in epoca recentissima, su processori Intel. Per quanto riguarda il sistema operativo,

quello impiegato dai Macintosh si è sempre distinto

da quello impiegato sui PC contemporanei. Dopo la

lunga epoca di Mac OS, nel 2001 fu lanciato il Mac OS

X, basato su Unix e ancor oggi fornito con i nuovi Mac.

Fin dagli albori, tutti gli Apple Mac sono tipicamente

stati caratterizzati da un look originale, moderno e

pulito, sia nell’aspetto esteriore sia nell’interfaccia

grafica del sistema operativo, e da una modalità d’uso

particolarmente semplice anche per utenti inesperti.

L’espandibilità, non eccelsa nei primi anni di storia a

causa delle molte interfacce di I/O basate su standard

proprietari Apple, col tempo è molto migliorata.

In generale, grazie al processo di “avvicinamento”

alla tecnologia dei normali PC in tema di CPU, bus e

porte di espansione, i computer Apple sono progressivamente passati da una sorta di “isolamento in nicchia ecologica” degli albori, a un periodo in cui esistevano applicativi per Mac (come Office) che offrivano

comunque piena compatibilità con il PC per quanto

riguarda il formato dei dati, fino alla situazione attuale, in cui su un Mac è perfino possibile, volendo, installare e far girare Windows con le sue applicazioni

PC Open 6 www.pcopen.it

Lezione 1

assieme a Mac OS X. In conclusione, anche se i Mac

conservano ancor oggi degli evidenti tratti distintivi

che consistono essenzialmente nel look esteriore e

nel sistema operativo specifico, il processo di convergenza tecnologica con i PC ha aumentato la compatibilità e moltiplicato le possibilità d’uso. Veniamo ora

alla categoria dei computer portatili, a sua volta comprendente diverse sottofamiglie che si differenziano

per dimensioni, modalità d’impiego e potenza.

I palmari e i

subnotebook,

i PC in miniatura

I dispositivi più

piccoli e portatili,

con importanti restrizioni soprattutto per quanto riguarda espandibilità e memoria di

massa, sono i Personal Digital Assistant (PDA), spesso

detti “palmari”.

Sebbene siano

veri e propri computer miniaturizzati, completi di tutte

le funzioni fondamentali come CPU, RAM, memoria di

massa, schermo a colori, interfacce di rete, fotocamera, telefono e così via, non sono adatti per lavori gravosi e di lunga durata, ma rispondono perfettamente

alle esigenze del viaggiatore: leggerezza e minimo ingombro, facilità d’uso, connettività wireless.

In ogni caso, data la rapidissima evoluzione tecnologia, le capacità di questi palmari raggiungono livelli

di tutto rispetto, simili a quelle di PC da tavolo di solo 4-5 anni prima: le loro CPU raggiungono attualmente i 624 MHz, la RAM i 128 MB, lo schermo arriva alla

risoluzione VGA (640x480 pixel), mentre la memoria

di massa, basata su piccole schede flash rimovibili, è

configurabile secondo necessità fino a un massimo

(per ora) di 4 GB.

Al crescere delle dimensioni, delle prestazioni e del

peso troviamo i subnotebook, o ultraportatili. Questi

sono dotati di una tastiera completa e di un display a

coperchio (in genere con diagonale non maggiore di

12 pollici) e, chiusi, hanno un’impronta a terra minore di quella di un foglio di carta A4. Per contenere il

peso e le dimensioni questi prodotti solitamente sono privi di floppy e unità ottica e anche la batteria è

di volume ridotto. Quest’ultima limitazione si tradurrebbe in una autonomia operativa non eccelsa, se non

Lezione 1

fosse per l’impiego di speciali processori a bassissimo consumo elettrico (definiti dai rispettivi produttori Ultra Low Voltage oppure Extreme Efficiency). Le

prestazioni dei subnotebook sono abbastanza simili a

quelle dei fratelli maggiori, i notebook, e anche la modalità operativa (tastiera, display ad alta risoluzione,

trackpoint o mouse) è uguale a quella di un notebook

e non a quella di un palmare.

L’espandibilità in genere è assai ridotta, dato che

per motivi di spazio il computer è quasi privo di slot e

socket vuoti, connessioni USB e Firewire a parte. Tuttavia, molto spesso i subnotebook sono venduti con

una “docking station”, sorta di piattaforma di ancoraggio da tavolo che in caso di viaggio viene lasciata

alla base; la docking station può comprendere l’unità

ottica e il floppy, un certo numero di porte e interfacce supplementari e in qualche caso anche una batteria più capace.

Piuttosto elevato il prezzo, a causa dell’avanzata

tecnologia che è necessario impiegare per miniaturizzare e alleggerire l’unità.

Le differenze tra portatili

Un gradino sopra i subnotebook ci sono i rappresentanti della fascia di mercato più ampia in termini

di volumi di vendita, chiamati tout court “portatili”,

o notebook (o laptop). Questi sistemi dispongono di

uno schermo di grandi dimensioni (solitamente almeno 15” di diagonale, sempre più spesso in fattore di

forma “wide screen” come 16:9), di processori molto

veloci, di un disco fisso e una batteria ad alta capacità

e integrano un’unità ottica; in qualche raro caso addirittura anche una seconda unità ottica o un floppy,

nel qual caso si parla di “dual spindle” per specificare

che, anche senza contare l’hard disk, vi sono due sedi

occupate da memorie di massa. A causa soprattutto

dell’elevato consumo elettrico della CPU e del display,

però, la loro autonomia non sempre riesce a raggiungere valori ragguardevoli.

Le prestazioni migliori sotto quest’ultimo aspetto

si registrano sui modelli basati su CPU specifica a basso consumo per l’impiego mobile, come Pentium M,

Core o Core Duo (per Intel) o Turion 64 X2 (per AMD).

L’espandibilità rimane piuttosto limitata, tuttavia possibile aggiungere RAM e una o due schede PCMCIA

con facilità, mentre il numero di porte USB e Firewire

è tale da consentire l’aggiunta di diversi dispositivi

esterni anche ad alta velocità.

I notebook più potenti, con schermo di dimensioni molto grandi e fattore di forma Wide, tastiera talmente larga da avere talvolta anche un pad numerico, processore equivalente a quello di un desktop di

fascia alta, sistema audio con altoparlanti integrati di

grandi dimensioni, un gran numero di interfacce e slot

di espansione, un peso ben superiore ai 3 Kg e auto-

IT administrator - Hardware

I classici notebook

montano schermi da 14

o 15”, batterie di buona

capacità e processori

potenti. Integrano,

inoltre, un’unità ottica e

in qualche caso anche un

drive per floppy

nomia spesso piuttosto limitata, costituiscono una

categoria a parte, definita “desktop replacement” o

“trasportabili”, a indicare che il sistema ha una potenza tale da non far rimpiangere un comune sistema

desktop, ma che non è idoneo all’utilizzo in mobilità,

a causa di peso e ingombro molto elevati e dell’autonomia ridotta, che di fatto costringe spesso a cercare

una presa di corrente per poter continuare a lavorare. Questi sistemi devono essere quindi visti come dei

desktop che ingombrano poco spazio sul tavolo, non

comportano una presenza eccessiva di cavi e all’occorrenza possono essere facilmente trasportati. Purtroppo il loro prezzo, a parità di prestazioni, è come

minimo doppio di un desktop equivalente, e la loro

espandibilità rimane limitata, sebbene risulti superiore

a quella di un

notebook normale.

Un tipo molto particolare

di notebook è il

cosiddetto Tablet PC, nel quale il monitor, oltre a essere pieghevole, è ruotabile di 180 gradi, così da poter essere

sovrapposto alla tastiera con il display esposto sul

lato superiore. Oltre alla possibilità di essere ruotato

in questo modo, lo schermo ha un’altra caratteristica fondamentale: quella di essere sensibile al tocco

(touch screen).

In dotazione con la macchina è fornito uno stilo che

consente di puntare in modo preciso i vari punti dello

schermo. L’utilizzo può così avvenire, anziché tramite

tastiera e mouse, direttamente toccando lo schermo.

L’immissione di testo, in particolare, può avvenire come sui palmari, “scrivendo” con lo stilo sullo schermo

come se fosse un foglio di carta. In alcuni tipi di Tablet

Computer, la struttura non è semplicemente derivata da quella di un notebook già dotato di tastiera, con

l’aggiunta del perno di rotazione sul display e del touch screen, ma il computer è un’unica struttura solida

e la tastiera manca del tutto: l’utilizzo come tablet diventa l’unico possibile e non un’opzione.

Un originale tipo di PC portatile comparso recentemente sulla scena è il cosiddetto Ultra-Mobile PC

(UMPC), le cui caratteristiche distintive sono: dimensioni compatte, intermedie fra quelle di un palmare e

quelle di un subnotebook; peso di poco inferiore a 1

kg; potenza di calcolo simile a quella di un subnotebook (i processori attualmente utilizzati sono modelli a bassissimo consumo elettrico con clock fra 1 e 2

PC Open 7 www.pcopen.it

Un Tablet PC si può

utilizzare come un

notebook oppure,

ruotando lo schermo

grazie all’apposito

perno, come una

sorta di palmare dallo

schermo gigante, agendo

direttamente sul display

con lo stilo in dotazione

A metà strada tra un

palmare e un notebook,

l’ultra mobile PC, si

propone come una

nuova concezione del PC

portatile

IT administrator - Hardware

Le porte di connessione

di un portatile sono

solitamente poste ai

lati e sono in numero

limitato

GHz); sistema operativo Windows XP Tablet PC Edition derivato dalla stessa “famiglia” di quelli adottati da laptop o desktop, anziché da quella dei palmari (Windows Mobile); buone capacità di connettività

wireless (almeno WiFi e Bluetooth); aspetto “tutto

schermo”, con utilizzo tipico senza tastiera, attraverso il touch screen da circa 7 pollici e almeno 800x600

pixel, azionabile con le dita o con lo stilo (ma alcuni

modelli potranno comunque avere una tastiera estraibile o pieghevole). In questi PC il sistema operativo

comprende una “shell” specifica, la “Ultra-Mobile PC

Interface” progettata per facilitare al massimo l’utilizzo con le mani e il puntamento con dita o stilo (la shell

di un sistema operativo è l’interfaccia di controllo attraverso cui si impartiscono i comandi fondamentali,

come il lancio di applicazioni o le operazioni sui file).

Spesso sono presenti opzioni multimediali come un

GPS (per funzionalità di navigazione), una fotocamera

(per consentire di scattare fotografie, girare video o

comunicare in video chat) e un lettore di schede flash.

L’hard disk ha una capacità tipicamente compresa fra

30 e 60 GB, la RAM è di solito di 512 MB o 1 GB. I prezzi

sono ancora piuttosto alti, a partire da 1.000 euro.

Le principali limitazioni

imposte dai computer portatili

1.1.2.4 Conoscere le

principali limitazioni

imposte dai

computer portatili

1.2 Schede Madri

1.2.1 Funzione

1.2.1.1 Comprendere

il ruolo ricoperto

dalla scheda madre

1.2.1.2 Conoscere

le principali funzioni

integrate

nella scheda madre

Seppure in misura variabile a seconda della famiglia di appartenenza, i computer portatili soffrono tutti di alcune significative limitazioni rispetto alle possibilità offerte dai computer fissi.

Innanzitutto l’espandibilità, che è quasi del tutto affidata alle porte USB o Firewire: infatti, per ragioni di

spazio, il numero di slot è ridotto e il tipo di slot non è

il PCI, ma generalmente il PCMCIA, un fattore di forma

nel quale non tutti i tipi di schede e interfacce sono disponibili e il prezzo è normalmente maggiore rispetto

a quello di prodotti equivalenti in standard PCI. Incomincia anche a diffondersi la porta ExpressCard, capace di prestazioni maggiori rispetto alla PCMCIA, ma

che per ragioni di “gioventù” acuisce ulteriormente il

problema della disponibilità di prodotti.

Anche l’espansione di memoria RAM è spesso condizionata da un ridotto numero di slot, il cui fattore

di forma è specifico per sistemi portatili con la conseguenza di un innalzamento del prezzo dei moduli

compatibili. Nel caso specifico dei palmari l’espansione di memoria RAM è addirittura impossibile, salvo casi rarissimi che in genere richiedono comunque

la manomissione dell’unità.

L’installazione di dischi fissi supplementari è possibile solo all’esterno del portatile, con collegamento

USB o Firewire, mentre la sostituzione del disco fisso

interno di solito è tecnicamente possibile ma nella

maggior parte dei casi richiede di smontare l’unità, il

che implica la decadenza della garanzia o la necessità

di ricorrere (a caro prezzo) all’intervento di un centro specializzato.

I dischi fissi montati sui portatili, che devono innanzitutto rispondere a requisiti di basso consumo e

resistenza a urti e scosse, ben raramente superano i

PC Open 8 www.pcopen.it

Lezione 1

5.400 giri al minuto, mentre lo standard nei sistemi desktop è attualmente di 7.200 giri/min e alcuni modelli

raggiungono i 10.000 giri.

I PC portatili soffrono anche di limitazioni in ambito prestazionale, a causa dei limiti imposti da questioni di spazio, dissipazione termica e di autonomia.

I processori più veloci destinati a sistemi fissi non

possono evidentemente essere montati sui portatili,

se richiedono dissipatori attivi di grandi dimensioni

e se assorbono grandi potenze elettriche; tuttavia la

tecnologia dual core ha recentemente consentito di

realizzare processori (i Turion X2 di AMD e gli Intel

serie Core/Core Duo) che erogano buone prestazioni

anche a basse frequenze di lavoro, ciò ha avuto l’effetto di ridurre significativamente il gap di performance

rispetto ai desktop.

Anche le schede video per portatili hanno fatto notevoli progressi, ma rimangono lontane dai livelli di

prestazioni possibili con i più potenti sistemi grafici

per ambiente desktop. Altre limitazioni vengono dal

fatto che quasi tutte le interfacce sono integrate sulla

scheda madre. In particolare è vero specialmente su

palmari e ultraportatili, in cui è difficile o impossibile

sostituirle per un upgrade. Questo vale, per esempio,

per le porte USB e Firewire, per la scheda di rete wired

o wireless, per la funzionalità Bluetooth: qualora compaia una nuova revisione di uno o più di questi standard, potrebbe non essere fattibile un upgrade selettivo della relativa circuiteria, ma si sarebbe costretti a

ricorrere a dispositivi esterni, ammesso che esistano

(occupando però preziose porte di espansione), oppure a sostituire l’intera macchina. Fortunatamente,

nei portatili di maggiori dimensioni, alcune delle interfacce citate sono realizzate su piccoli moduli zoccolati di tipo standard (esempio: MiniPCI) che permettono almeno teoricamente l’acquisto aftermarket

e la sostituzione dell’accessorio.

Il PC snello per la rete, il network computer

Quando il computer è destinato all’utilizzo in ambito di rete, con connessione a server remoti che erogano tutti i servizi, inclusa, non di rado, la stessa esecuzione delle applicazioni, si parla di Network Computer,

o di postazione per terminale Internet. La struttura di

un computer di questo tipo può semplificarsi grazie

all’abolizione o forte riduzione della memoria di massa locale e alla riduzione della potenza di calcolo della CPU. Entrambi queste componenti dell’architettura, infatti, in un Network Computer non devono più

sopportare lo stesso carico di lavoro che li interesserebbe in un normale PC o in una workstation. Ciò che

il Network Computer deve poter fare è soprattutto

funzionare come terminale, ossia raccogliere l’input

dell’utente (tastiera, mouse e così via), trasmetterlo

al server, su cui avvengono le fasi di elaborazione ed

eventuale memorizzazione, e ricevere i risultati per

presentarli su schermo o via audio.

Schede madri

Come già accennato a proposito della struttura fisica di un computer, la scheda madre, o motherboard, è

un circuito stampato multistrato di grandi dimensioni e di notevole complessità costruttiva, adagiato sul

fondo del contenitore del computer.

Le principali funzioni integrate nella motherboard

Essa riveste la duplice funzione di ossatura meccanica (per l’ancoraggio delle altre componenti) e di

sistema di interconnessione elettrica (per lo scambio

di segnali fra le stesse componenti). In virtù di que-

Lezione 1

sta doppia natura, potrebbe essere descritta come la

“spina dorsale” del computer.

La scheda madre ospita direttamente la CPU e i

chip che funzionano da intermediari fra la CPU e la

memoria e quelli che la collegano al bus di espansione ed alle periferiche.

In qualche caso sulla motherboard può essere presente una certa quantità di memoria ad alta velocità

(cache memory) destinata a ospitare i dati più frequentemente usati dalla CPU, per evitare di recuperarli dalla relativamente lenta RAM ogni volta che servono. In questo senso tale memoria veloce funziona

come una sorta di “nascondiglio” (“cache”: di qui il

nome) di dimensioni relativamente piccole, contenente informazioni usate spesso.

Una certa quantità di cache (cache di primo livello,

o L1 cache) è compresa nell’unità di calcolo del processore, ma per motivi tecnologici può essere dispendioso o difficile integrarne a sufficienza.

Per questo i processori spesso comprendono una

zona circuitale ben definita in cui trova posto altra cache (cache di secondo livello, o L2 cache) di dimensioni molto maggiori rispetto alla L1 anche se in qualche caso operante a frequenza più bassa.

Soprattutto nel passato, poteva essere la motherboard e non la CPU a ospitare questa cache L2, oppure, con processori attuali che sono quasi sempre dotati di L2 integrata, sulla motherboard può esservi un

ulteriore livello di cache, la L3, o saldata direttamente sulla scheda madre o ospitata su un modulo a essa

collegato attraverso un socket di tipo particolare.

Appositi connettori, detti socket, offrono alla sede

la CPU e per uno o più moduli di memoria RAM, mentre altri connettori, detti slot, servono per ospitare

una o più schede di espansione opzionali.

Normalmente, parlando di motherboard, il termine

“socket” viene usato per denotare connettori piani a

matrice quadrata ad alta densità di contatti (pin), destinati ad accogliere circuiti il cui dialogo con il resto

della macchina avviene mediante un gran numero di

segnali ad altissima frequenza e con un elevato parallelismo (per esempio, un socket per CPU può contare anche 940 pin e attraverso di esso il processore

può scambiare con l’esterno 128 bit per ogni ciclo di

clock). In qualche caso il termine socket è usato anche per i connettori dei moduli di memoria RAM, nonostante la loro topologia sia lineare anziché a matrice quadrata piana.

Data l’estrema importanza dei dispositivi che ospitano, quasi sempre i socket sono dotati di un dispositivo meccanico (ganci, levette di sgancio, riscontri)

per evitare lo sfilamento accidentale del modulo o

chip da essi ospitato e per garantire che il contatto sia

estremamente saldo e senza incertezze da cui potrebbero derivare sporadici malfunzionamenti per la macchina. Il contesto logico di interconnessione (bus) fra

CPU e memoria, ossia il “percorso” lungo il quale troviamo dei socket come connettori, è spesso chiamato

“Front side bus” (FSB) e con tecnologie attuali opera

a frequenze dell’ordine di 400-1000 MHz.

I componenti hardware di base

della scheda madre

Il termine “slot” invece si riferisce normalmente

a connettori rigorosamente lineari, con una densità

di pin spesso inferiore rispetto a quella dei socket

per la memoria, un numero di pin inferiore rispetto

a quello dei socket per CPU e una frequenza di lavoro più bassa rispetto a quella dell’FSB, dell’ordine di

33-133 MHz.

Dato che le esigenze sono meno estreme, le specifiche di funzionamento degli slot possono così essere

IT administrator - Hardware

Un tipico esempio

di motherboard ATX.

In senso orario,

riconosciamo i connettori

per il processore (1) e

RAM (3), il northbridge

chip (2), il connettore di

alimentazione ATX (4),

i connettori IDE P-ATA e

S-ATA (5), il southbridge

chip (6), gli slot PCI

(7), gli slot PCI Express

1x e 16x (8), le porte

di connessione (USB,

Ethernet, parallela,

seriale, audio, PS/2) (9)

meno stringenti di quelle per i socket, pur restando

estremamente precise dal punto di vista dimensionale ed elettrico per assicurare la necessaria compatibilità con prodotti di fabbricanti diversi.

I socket per la RAM sono in genere non più di quattro per un personal computer e nella stragrande maggioranza, su una data motherboard, sono tutti dello

stesso tipo (non è cioè possibile la coabitazione di

diversi tipi di memoria). Gli slot invece, come vedremo più avanti, possono essere di vari tipi diversi, differenziati a seconda del tipo di scheda da ospitare o

anche solo per garantire la compatibilità con schede

di espansione di fabbricazione meno recente. Sempre

sulla motherboard trova posto la circuiteria di controllo per molte porte di connessione, oltre alle porte

stesse: porte USB e Firewire, porta seriale e parallela,

porte PS/2 per mouse e tastiera; in qualche caso sono

integrati su motherboard anche il sistema audio con

le relative porte e il sistema grafico con il connettore

VGA. La motherboard svolge anche un ruolo centrale

nella distribuzione dell’alimentazione a tutti i componenti del PC. Un fascio di cavi esce dall’alimentatore

e si impegna in un apposito connettore a 20 o 24 pin

sulla motherboard e da qui le correnti vengono rese disponibili a tutti i circuiti attivi della macchina

(CPU, moduli RAM, schede di espansione, circuiteria

integrata su motherboard) e ad alcune ventole di raffreddamento, con l’unica eccezione delle unità disco

e per altre ventole per le quali vi è un cavo di alimentazione diretto.

Sulla motherboard trovano posto anche il chip di

memoria che contiene il BIOS, il programma di controllo e configurazione di cui parleremo fra poco, e la

batteria tampone al Litio, a forma di moneta, che assicura il mantenimento delle impostazioni del BIOS

anche a computer spento.

1.2.1.3 Conoscere i

componenti hardware

di base della scheda

madre, quali: zoccoli

d’innesto per CPU

(slot/socket),

chipset, cache

esterna, bus di

sistema, porte di

connessione, slot

d’espansione ecc.

1.2.1.4 Essere in

grado d’identificare i

principali componenti

hardware della

scheda madre

1.2.2 Tipologie

e differenze.

Identificazione dei

componenti hardware

della scheda madre

I componenti hardware della

scheda madre

Pur essendo tutte dotate

delle componenti fin qui citate, le schede madri possono

differenziarsi notevolmente

in funzione della disposizione di socket, slot e connettori sul circuito stampato, nonché delle dimensioni fisiche

complessive. Si parla così, per

le motherboard, di “fattore di

forma” (form factor).

Le più vecchie schede madri per Personal Computer, per

esempio, erano realizzate secondo le norme PC/XT di IBM e subito diventate uno

standard di fatto per tutti i produttori di “cloni”. La

PC Open 9 www.pcopen.it

Una motherboard in

formato ATX

IT administrator - Hardware

1.2.2.1 Conoscere

le diverse tipologie di

formato

delle schede madri e

le relative differenze

di standard, quali: AT,

ATX, BTX, LPX,

NLX e via dicendo

1.2.2.2 Conoscere

le differenti

connessioni su

schede madri con

specifiche diverse

1.3 Il BIOS

1.3.1 Caratteristiche

di base

1.3.1.1 Sapere

cos’è il BIOS,

dov’è fisicamente

memorizzato, a quali

funzioni di sistema

presiede

prima evoluzione di queste specifiche ha dato luogo

nel 1984 al fattore AT (Advanced Technology), caratterizzato da grandi dimensioni (305 mm di larghezza),

un’alimentazione da 192 watt con due connettori da 6

pin ciascuno e un nuovo sistema per il raccordo con

l’interruttore di alimentazione; il pannello posteriore

della motherboard (backplate) prevedeva un’unica

connessione, quella verso la tastiera.

Tutte le altre porte dovevano essere fornite dal

backplate delle varie schede di espansione ISA oppure essere realizzate con connettori avvitati al cabinet

e connessi alla motherboard mediante cavi volanti.

Nel 1985 fu proposta una variante leggermente più

piccola di questo standard, detta Baby AT, che riscosse un successo molto maggiore e con cui ancora oggi sono compatibili gli involucri fisici per PC (case o

chassis).

Nel 1995 fu lanciato il formato ATX – acronimo di

Advanced Technology Extended - che ancora oggi, a

più di 10 anni di distanza, rimane il più diffuso sul mercato. Le novità rispetto all’AT furono numerose:

• nell’ATX, l’interruttore di alimentazione è collegato

alla motherboard e non all’alimentatore;

• il connettore di alimentazione, monoblocco da 20

pin affiancabile da estensioni opzionali da 4 pin o

da 8 pin nel caso di CPU recenti ad alte prestazioni

con elevato fabbisogno di energia come il Pentium

4, deve fornire anche una tensione di 3.3V, il che

elimina la necessità da parte della motherboard di

integrare i circuiti analogici necessari per derivare

tale tensione dai 5V forniti in precedenza dall’alimentatore AT;

• la disposizione reciproca delle schede e della CPU

è diversa; il pannello posteriore comprende un

gran numero di connessioni solidali con la motherboard (senza cavi volanti) e con una disposizione

rigidamente definita, sebbene alcune porte opzionali possano mancare.

Il back panel ATX in particolare definisce dove debbano trovarsi, se presenti, le porte PS/2 per mouse e

tastiera, le porte jack dell’audio integrato, la porta DB15 della grafica integrata, la porta RJ-45 della scheda

di rete integrata, le porte a 9 e 25 poli per seriale e parallela, le 2 o più porte USB, la porta Firewire.

Per le parti in plastica dei connettori PS/2 di tastiera e mouse e per quelli jack 3.5” del sistema audio sono specificati anche i colori, onde facilitare il riconoscimento di porte altrimenti uguali fra loro.

Varianti dell’ATX lanciate successivamente sono la

Mini-ATX e la Micro-ATX, che rappresentano tentativi

di miniaturizzazione pensati per consentire la realizzazione di PC sempre più piccoli, fra cui perfino i cosiddetti sistemi “cube-style” da salotto.

Nel 2003 Intel ha lanciato il nuovo fattore di forma

BTX, pensato soprattutto per razionalizzare la venti-

Il Mini-ITX del 2002 è

un form factor originale

utilizzato in sistemi di

dimensioni ridotte

PC Open 10 www.pcopen.it

Lezione 1

lazione e i cablaggi, due questioni rilevanti soprattutto nelle ultime serie di schede grafiche e processori

ad alte prestazioni che possono assorbire elettricamente, e quindi dissipare termicamente, anche più

di 100W di potenza ciascuno. Questo fattore di forma non ha avuto il successo sperato, anche perché

le attuali tendenze sembrano indicare un ritorno alla

ragionevolezza: anziché inventare motherboard adatte a facilitare la dissipazione di calore da processori

sempre più “caldi” ed energeticamente inefficienti, ci

si dedicherà a risolvere il problema alla radice, abbattendo proprio i consumi elettrici delle CPU e facendo

venir meno molti dei presupposti dietro allo sviluppo

del nuovo standard BTX.

Lo standard LPX è un fattore di forma pensato per

consentire la realizzazione di PC sottili, o Low Profile

(da cui deriva l’acronimo).

Questo risultato è ottenuto montando le schede

di espansione non perpendicolarmente alla motherboard – ciò che comporterebbe automaticamente

uno spessore minimo di una quindicina di centimetri circa – ma parallelamente ad essa, grazie all’espediente di montare una piccola scheda di raccordo, o

riser board, che “innalza” (to rise) gli slot e li orienta

orizzontalmente.

Lo standard NLX è un altro standard low profile

basato su riser board, come l’LPX. Meritano un cenno per la loro originalità gli standard ITX del 2001, da

215x191 mm, il Mini-ITX del 2002, da 170x170 mm, e

il Nano-ITX del 2004, da appena 120x120 mm. Questi

form factors consentono la realizzazione di sistemi

minuscoli ma dotati di tutte le principali funzioni ed

altamente integrati, utilizzabili fra l’altro per realizzare sistemi embedded o PC destinati all’installazione

in auto.

Il BIOS

Anche se il funzionamento generale della macchina

è governato dal sistema operativo (Operating System,

OS), come Windows o Linux, le particolarità costruttive della macchina fanno sì che l’OS, per svolgere

alcuni compiti basilari su cui costruire le operazioni

più “ricche” e complesse messe a disposizione delle

applicazioni, debba rivolgersi a un interlocutore in

grado di parlare una “lingua“ standard, nascondendo

i dettagli elettrici e logici specifici dell’hardware della particolare macchina su cui l’OS viene installato e

fatto funzionare.

Questo, disaccoppiando le applicazioni e il sistema

operativo dall’hardware, semplifica la progettazione

dell’OS, da un lato, e permette ai costruttori di computer di avvalersi di una certa libertà progettuale,

dall’altro. Infatti chi progetta Windows non deve più

preoccuparsi di quali segnali elettrici e temporizzazioni è necessario usare nella comunicazione, poniamo, fra il southbridge chip e le porte USB, ma si limita a dialogare con un interlocutore standard. Questo

interlocutore è il BIOS (Basic Input/Output System), un

programma relativamente piccolo ma di fondamentale importanza, sempre più spesso memorizzato su

chip EEPROM (memoria programmabile a sola lettura

cancellabile elettricamente: Electrically Erasable Programmable Read Only Memory detta anche memoria

flash ). Il chip del BIOS è fisicamente alloggiato sulla

motherboard e può essere aggiornato senza interventi hardware qualora il fabbricante si accorga di bug

che richiedono una correzione oppure decida di inserire prestazioni aggiuntive. L’aggiornamento del BIOS

è un’operazione che non richiede di intervenire fisicamente sul PC, ma si esegue da software, scarican-

Lezione 1

IT administrator - Hardware

Il BIOS (qui un Award

WorkstationBIOS di

Phoenix Technologies)

presenta generalmente

un menu principale da cui

sono raggiungibili tutte le

varie categorie di opzioni

Le impostazioni di base

del BIOS riguardano

fondamentalmente data,

ora e unità disco

do dal sito del produttore una utility che gestisce la

cancellazione e riscrittura della memoria e un nuovo

“file immagine” che andrà a rimpiazzare l’attuale programma memorizzato nel BIOS chip. È molto importante che durante l’operazione non si verifichino interruzioni o interferenze software di alcun genere, dal

momento che la corretta programmazione del nuovo

BIOS ne potrebbe risultare compromessa e in assenza di un BIOS valido il PC non soltanto potrebbe non

avviarsi più, ma, quel che è peggio, potrebbe perdere

la capacità di aggiornarsi, richiedendo un intervento hardware. In questo malaugurato caso, qualora il

chip BIOS sia fissato in uno zoccolo, ossia fissato alla motherboard in modo non irreversibile, potrà essere sufficiente sostituirlo con un altro dal contenuto valido. In caso contrario, essendo esclusa la possibilità di un rimpiazzo, potrebbe essere impossibile rimediare al problema se non sostituendo l’intera

motherboard.

Il BIOS sovraintende anche a regolazioni e impostazioni di funzionamento della macchina che per il sistema operativo rimangono completamente trasparenti.

Un esempio è l’impostazione della frequenza di lavoro

della memoria RAM: OS e applicazioni assumono che

la RAM esista e si sentono liberi di scriverla e leggerla, ma non possono variare le caratteristiche elettriche e logiche dell’interfaccia fra CPU e memoria. Altri

esempi sono l’impostazione della frequenza di lavoro

della CPU; l’abilitazione o disabilitazione della cache

memory; l’abilitazione o disabilitazione di alcune periferiche integrate sulla motherboard come le porte

USB, il controller dei dischi, la scheda grafica, la scheda audio; l’identificazione esatta e la configurazione

delle unità disco presenti; e così via.

Power-On Self Test (POST) e comprende di solito il

test della memoria per escludere eventuali guasti, il

riconoscimento delle unità disco collegate, il controllo di presenza della tastiera, il riconoscimento e attivazione alla giusta frequenza della CPU e delle schede

grafiche installate, e così via. Qualora venisse riscontrato qualche inconveniente in qualcuna di queste

componenti, il POST si arresterebbe segnalandolo e

permettendo di entrare nella utility di configurazione

del BIOS, oppure di riavviare il PC, oppure ancora di

rimediare al problema (per esempio: tastiera scollegata) e ritentare l’avvio.

L’utility di configurazione del BIOS è detta BIOS

Setup; qualche volta è detta anche CMOS Setup, in

quanto le impostazioni in essa disponibili, per essere “ricordate” anche quando l’alimentazione viene a

cessare, vengono salvate su memoria non volatile oppure, più spesso, su un’area di memoria volatile realizzata in tecnologia CMOS (da cui il nome) salvata da

una batteria tampone. Tale batteria ha l’aspetto della

classica “monetina” visibile in apposita sede su quasi

tutte le motherboard attuali, spesso posizionata nei

pressi del chip EEPROM o flash che contiene il BIOS.

Le impostazioni di base settabili dal BIOS

Le impostazioni del BIOS sono generalmente suddivise in categorie; le opzioni di base e le “advanced

options” sono presenti su tutte le macchine, mentre le

altre categorie sono disponibili a seconda della configurazione hardware e della versione di BIOS installata.

Le impostazioni di base comprendono ad esempio:

• data e ora, presenza e tipo di unità floppy disk, presenza, tipo, geometria e capacità delle unità hard

POST, CMOS e firmware

Di tutto questo si può incaricare il BIOS, che, interloquendo con il northbridge chip e altra circuiteria

presente sulla motherboard, può regolare aspetti di

dettaglio che il sistema operativo non può o non “vuole” vedere, perché troppo di dettaglio e troppo specifici dell’hardware della macchina, sebbene siano estremamente rilevanti per le

prestazioni (una cattiva regolazione della frequenza di lavoro di memoria e bus, una

disattivazione della cache L2, un abbassamento del

clock del processore possono ridurre la velocità dei

programmi in modo anche sostanziale).

All’accensione il BIOS espleta anche un’altra delle sue funzioni, eseguendo una verifica del corretto

funzionamento di tutte le componenti hardware sotto il suo diretto controllo e per le quali è deputato a

conoscere la configurazione. Questa verifica è detta

1.3.1.3 Conoscere

quali sono le

impostazioni di

base settabili dal

BIOS

Il chip di memoria

contenente il BIOS

affiancato dalla batteria

tampone in formato

“moneta” che si

occupa di mantenere

le impostazioni

immagazzinate dal BIOS

nella memoria volatile

CMOS

1.3.1.2 Comprendere

il significato degli

acronimi: POST,

CMOS e dei termini:

setup, firmware.

Sapere a quali

funzioni di sistema

presiedono

Le opzioni avanzate del

BIOS sovraintendono

a questioni spesso

importanti quali la

sequenza di periferiche

da considerare per

l’esecuzione del

bootstrap, la cache della

CPU, la semplificazione

del POST per accelerare

il boot, l’autorepeat della

tastiera e così via

PC Open 11 www.pcopen.it

IT administrator - Hardware

Lezione 1

Il funzionamento della

RAM è governato da

5 parametri principali:

la frequenza di lavoro

e i valori di RAS, CAS,

RCD e RP. Alcuni BIOS

permettono di impostare

selettivamente questi

valori per adattare il

funzionamento del

sistema al tipo di

memoria installata

Il controller RAID, se

presente, è di solito

configurabile da una

apposita sottopagina

del menu Integrated

Peripherals

disk,

• presenza e tipo di unità ottiche (CD ROM, DVD

ROM, combo drive, masterizzatori)

Va detto che il BIOS non può riconoscere automaticamente le unità floppy, mentre quelle IDE o SATA

(hard disk o unità ottiche) possono essere anche riconosciute in modo completamente automatico. Nel

caso specifico degli hard disk il riconoscimento automatico riguarda anche il numero di cilindri, testine e

settori per traccia (i parametri che definiscono la cosiddetta geometria dell’hard disk e quindi, in ultima

analisi, anche la sua capacità). In casi particolari, tuttavia, può essere utile impostare manualmente i parametri di geometria, come pure selezionare la modalità

di indirizzamento dei settori sul disco (per esempio la

modalità LBA, Large Block Addressing, o il supporto

per dischi di capacità superiore a 137 GB, con il cosiddetto modo 48-bit LBA).

Le impostazioni avanzate comprendono

• Abilitazione di una versione “rapida” del POST

• Impostazione dell’ordine con cui deve essere tentato il boot dalle varie periferiche possibili: floppy,

USB, ZIP o simili, hard disk, CD ROM

• Abilitazione o disabilitazione della cache L1 o L2

della CPU

• Parametri di auto-repeat per la tastiera (ritardo di

innesco e periodo di ripetizione)

• Abilitazione o disabilitazione della tecnologia

Hyper Threading per CPU Pentium che la supportano

• Impostazioni riguardanti l’eventuale controller SCSI, se installato

• Abilitazione di una protezione antivirus, efficace

Un’apposita schermata

del BIOS, “Integrated

Peripherals”, è dedicata

alla gestione delle

periferiche integrate

direttamente su scheda

madre e consente di

configurarle e attivarle/

disattivarle

PC Open 12 www.pcopen.it

solo contro certi comportamenti riconoscibili di

certi virus

Altre opzioni avanzate ancora più specifiche,

che regolano il funzionamento di CPU, RAM e chipset

(Northbridge e Southbridge) vanno solitamente sotto

il nome di “advanced chipset options” e riguardano:

• Frequenza di lavoro della CPU, determinata dalla

frequenza del bus FSB, o da quella verso la memoria, moltiplicata per un fattore numerico (detto appunto “moltiplicatore”)

• Configurazione della memoria e dei suoi parametri

di lavoro, come RAS, CAS, RCD e RP

• Impostazioni relative al caching del BIOS su RAM

(per velocizzarne il funzionamento)

• Impostazioni relative alla mappa della memoria:

per esempio, spazio riservato alla comunicazione

sul bus AGP

• Frequenza di lavoro dell’eventuale bus AGP per

schede grafiche (per esempio: 8x)

Un cenno a parte merita la questione della gestione

delle periferiche Plug and Play su bus PCI (PnP/PCI).

La locuzione “Plug and Play” si riferisce al fatto che

queste schede d’espansione sono progettate per essere riconosciute e configurate automaticamente semplicemente perché sono state installate fisicamente

nel sistema.

In passato questo non era sufficiente, perché oltre

all’installazione nello slot era anche richiesta una attività di regolazione fisica della posizione di alcuni ponticelli (jumper) sulla scheda per definire quali risorse

di sistema (in primis, gli interrupt, o IRQ, e i canali di

accesso alla memoria, o DMA) fossero necessarie.

La coabitazione di più schede sul bus, con il rischio

di sovrapposizioni e conflitti nella scelta di tali impostazioni, rendeva difficoltosa un’esatta definizione di

questi assegnamenti. Il sistema plug and play mira a

risolvere il problema, effettuando automaticamente

una scelta che garantisca al tempo stesso di evitare

reciproche interferenze fra le schede. Il BIOS gioca

un ruolo di primo piano in questo processo: proprio

a questo sono dedicate alcune impostazioni nell’apposita sezione “PNP/PCI Configuration”, in cui è possibile

• stabilire se è installato un sistema operativo in grado di supportare il PNP,

• abilitare o disabilitare l’assegnazione automatica

di IRQ e DMA, oppure scegliere l’assegnazione manuale.

È spesso presente anche un sottomenu “Integrated

Peripherals” che consente la gestione, configurazione

e abilitazione (o disabilitazione) delle periferiche inte-

Lezione 1

IT administrator - Hardware

Le impostazioni di

gestione energetica

consentono di ridurre

i consumi elettrici

e prolungare la vita

utile dei componenti

della macchina, oltre

a determinare l’esatta

politica di funzionamento

del pulsante di

accensione (standby,

suspend, switch off).

grate sulla scheda madre.

Per esempio, la scheda video, la scheda audio, il

controller USB, il controller per floppy disk, le porte seriali e parallele, la porta a infrarossi. Su alcune

schede è presente anche un controller RAID per aumentare le prestazioni o l’affidabilità dei dischi fissi

utilizzandone un maggior numero; in tal caso, questo

menu generalmente contiene anche le regolazioni relative a tale controller. Un apposito menu Power Management Setup permette di abilitare vari possibili modi

di sospensione (a seconda di quali sono supportati

dal chipset), di far sì che gli hard disk si disattivino

automaticamente in caso di inattività prolungata, di

stabilire esattamente che cosa debba avvenire quando viene premuto il pulsante di spegnimento mentre

il PC è acceso: sospensione, standby, oppure spegnimento vero e proprio.

Se è presente un menu “PC Health Status” esso permette di osservare le temperature e le tensioni elettriche rilevate in vari punti della motherboard, nonché

di specificare le soglie di temperatura oltre le quali le

varie ventole di raffreddamento debbano attivarsi a

velocità media o alta o disattivarsi.

Verifica e aggiornamento del BIOS

Come tutti i programmi anche il BIOS può contenere errori ed essere soggetto a perfezionamenti e miglioramenti. Pertanto è prevista la possibilità di aggiornarlo, per esempio in caso di malfunzionamenti o

per aggiungere il supporto di qualche nuova caratteristica. Anche se i BIOS in circolazione sono sviluppati da poche software house specializzate, fra le quali

Phoenix Technologies con il suo diffusissimo Award

BIOS, l’aggiornamento va scaricato dal sito del pro-

All’accensione il BIOS

visualizza una serie di

informazioni utili per

identificare la versione

esatta. Sarà così

possibile scegliere un

aggiornamento adatto

per scaricarlo, quando

necessario, dal sito

del produttore della

motherboard

duttore della motherboard in quanto il BIOS potrebbe

avere subito degli adattamenti specifici per permetterne l’uso su uno specifico hardware. Per scaricare

l’aggiornamento del BIOS dal sito del produttore è

necessario conoscere con esattezza il modello della

propria motherboard e la versione del BIOS attualmente installato. A tale scopo le informazioni di versione e modello sono visualizzate dal BIOS all’accensione, per alcuni secondi, per permettere all’utente

di annotarle.

I codici di versione del BIOS possono essere più

d’uno, a causa del fatto che una determinata versione di base del BIOS, rilasciata dal produttore del BIOS,

con un certo insieme di funzionalità standard, menu

e impostazioni, e identificata da un suo codice di versione (come v6.00PG, in alto a destra nell’immagine),

per poter essere impiegata su una specifica motherboard potrebbe aver richiesto alcune modifiche per

adattarla alle specifiche caratteristiche elettriche e

logiche del chipset, delle periferiche integrate e degli

slot e socket presenti sulla scheda madre.

Questa personalizzazione dà quindi luogo a una

versione di BIOS specifica, o “custom”, frutto del lavoro di adattamento effettuato congiuntamente dal

produttore della motherboard e da quello del BIOS di

base; l’identificazione precisa di tale versione è data

di solito da un’altra stringa, spesso contenente anche

la data, riportata in altra zona dello schermo durante

il processo di start-up (secondo riquadro in figura).

Infine, il codice esatto di versione e revisione hardware della motherboard, da non confondersi con

quello software relativo al BIOS installato, è generalmente anch’esso riportato sulla schermata di POST,

di solito in fondo allo schermo (terzo riquadro in basso in figura). L’aggiornamento del BIOS è un’operazione delicata che va effettuata in caso di reale necessità

e con grande cura. Per effettuare l’aggiornamento è

necessario scaricare, insieme all’immagine del BIOS

stesso, un programma in grado di effettuare la cancellazione della memoria flash o EEPROM in cui è memorizzato l’attuale BIOS e la successiva scrittura della

nuova versione.

Anche tale programma è scaricabile dal sito del

produttore della motherboard. È importante seguire

scrupolosamente le istruzioni per il suo utilizzo; durante il funzionamento del programma, inoltre, è bene

evitare, nei limiti del possibile, qualsiasi interruzione

della riprogrammazione del BIOS.

PC Open 13 www.pcopen.it

1.3.2 Aggiornamento

1.3.2.2 Sapere come

verificare l’attuale

numero di versione

del BIOS.

1.3.2.3 Essere in

grado di verificare o

modificare i settaggi

del BIOS relativi alle

impostazioni delle

periferiche PnP

Il menu PC Health

Status, se presente,

consente il monitoraggio

di voltaggi e temperature

in vari punti della

motherboard, e permette

di impostare le soglie di

temperatura oltre le quali

debbano attivarsi le varie

ventole di raffreddamento

Lezione 2

IT administrator - Hardware

A scuola con PC Open

Come funzionano le diverse

classi di processori

Nella seconda puntata prendiamo in considerazione

il cuore del PC, il microprocessore. Funzionalità,

architetture, alloggiamenti a confronto per capire come

funzionano le CPU di Marco Mussini

ome già accennato nella I puntata, non sarebbe azzardato affermare che il “cervello” del Personal

Computer è il suo

processore: un componente che si incarica di eseguire ad

elevatissima velocità le istruzioni che

compongono i pro- Il microprocessore, o CPU (Central

grammi, il sistema Processing Unit), è il vero e proprio

operativo, i driver di “cervello” di ogni PC

periferiche, sovraintendendo sia all’elaborazione dei dati, sia all’interscambio di dati con

l’esterno, sia al controllo delle periferiche.

In molti casi, importanti compiti che l’hardware

deve eseguire per un regolare funzionamento della

macchina vengono portati avanti in modo autonomo

da apposita circuiteria specializzata, come il north

bridge, il south bridge o i chip della scheda grafica;

ma quasi sempre è il processore a dover intervenire

per sovraintendere a questi processi, ossia per innescarli, interromperli, regolarli, monitorarli.

Ancora, quando una periferica in grado di scambiare dati con l’esterno ha ricevuto dei dati da elaborare, è sempre il processore a essere informato attraverso un “interrupt”, una sorta di chiamata urgente

che lo forza a interrompere qualunque cosa stia facendo e a occuparsi dell’evento che si è verificato, di

solito eseguendo un apposito programma di controllo (device driver).

C

Caratteristiche principali

Tutti i processori moderni hanno una struttura

logica che comprende un certo numero di parti fondamentali:

• ALU (Arithmetic – Logic Unit). La ALU si occupa di eseguire le operazioni aritmetiche su numeri interi e quelle logiche.

Tali operazioni comprendono ad esempio, oltre

alle quattro operazioni, i confronti, i salti da un

punto all’altro del programma, le decisioni, i trasferimenti di dati fra aree di memoria, gli scambi

di dati da e verso il bus di sistema.

PDF DEL CORSO

NEL DVD

Calendario delle lezioni

Lez 1: la scheda madre e il BIOS

Lez 2: i processori

Lez 3: la RAM