PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Progetto PI2S2

PROGETTAZIONE

E IMPLEMENTAZIONE

DELLA

E-INFRASTRUTTURA DI

PRODUZIONE

DELIVERABLE: D1.2

Nome file:

PI2S2-D1.2-v1.0

Data:

31/01/2007

Attività:

WP1

Responsabile:

Consorzio COMETA

Stato:

FINAL

Abstract:

Questo documento descrive l’architettura dell’e-Infrastruttura di produzione del Progetto PI2S2 alla

fine del primo anno.

PUBLIC

- 1 - / 191

-1-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Versi

one

1.0

Data

31.01.2007

Commento

Versione finale

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Autore/i

Roberto Barbera

PUBLIC

- 2 - / 191

-2-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

INDICE

1.

INTRODUZIONE............................................................................................................................................... - 5 -

2.

ARCHITETTURA DELL’INFRASTRUTTURA DI PRODUZIONE E SERVIZI COLLEGATI ............ - 6 2.1.

2.2.

2.3.

GARA D’APPALTO PER LA FORNITURA DELL’INFRASTRUTTURA GRID .............................................................- 6 AUTORITÀ DI REGISTRAZIONE DELL’AUTORITÀ DI CERTIFICAZIONE DEL-L’INFN ..........................................- 7 CREAZIONE DELL’ORGANIZZAZIONE VIRTUALE “COMETA” E DELLE REGOLE DI ACCESSO ALL’INFRASTRUTTURA

-83.

CONCLUSIONI ................................................................................................................................................ - 10 -

4.

APPENDICE 1 .................................................................................................................................................. - 11 -

PREMESSA ............................................................................................................................................................... - 12 CONSIDERAZIONI GENERALI ........................................................................................................................... - 13 - LOTTO 1 - ............................................................................................................................................................... - 14 ART 1.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO ............................................................................................- 14 - LOTTO 2 - ............................................................................................................................................................... - 28 ART 2.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO .............................................................................................- 28 - LOTTO 3 - ............................................................................................................................................................... - 29 ART 3.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO ............................................................................................- 29 - LOTTO 4.1 - ............................................................................................................................................................ - 51 ART 4.1.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO .........................................................................................- 51 - LOTTO 4.2 - ............................................................................................................................................................ - 54 ART 4.2.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO .........................................................................................- 54 - LOTTO 5 - ............................................................................................................................................................... - 57 ART. 5.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO ............................................................................................- 57 ART. 5.2 PAVIMENTO TECNICO FLOTTANTE ..............................................................................................................- 78 5.

APPENDICE 2 .................................................................................................................................................. - 79 -

PREMESSA .................................................................................................................................................................... 81

CONSIDERAZIONI GENERALI ................................................................................................................................ 83

- LOTTO 1 - .................................................................................................................................................................... 84

ART 1.1 SISTEMA DI CALCOLO ..................................................................................................................................... 84

ART 1.2 APPARECCHIATURE DI RETE ............................................................................................................................ 85

ART 1.3 SOLUZIONI PER IL CONTROLLO REMOTO DEI SERVER E UNITÀ DI CALCOLO ...................................................... 85

ART 1.4 SISTEMA DI STORAGE....................................................................................................................................... 86

- LOTTO 2 - .................................................................................................................................................................... 88

ART 2.1 SISTEMA DI CALCOLO ...................................................................................................................................... 88

PUBLIC

- 3 - / 191

-3-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

ART 2.2 APPARECCHIATURE DI RETE ............................................................................................................................ 89

ART 2.3 SOLUZIONI PER IL CONTROLLO REMOTO DEI SERVER E UNITÀ DI CALCOLO ...................................................... 89

ART 2.4 SISTEMA DI STORAGE....................................................................................................................................... 90

- LOTTO 3 - .................................................................................................................................................................... 92

ART 3.1 SISTEMA DI CALCOLO ..................................................................................................................................... 92

ART 3.2 APPARECCHIATURE DI RETE ............................................................................................................................ 93

ART 3.3 SOLUZIONI PER IL CONTROLLO REMOTO DEI SERVER E UNITÀ DI CALCOLO ...................................................... 93

ART 3.4 SISTEMA DI STORAGE....................................................................................................................................... 94

- LOTTO 4.1 - ................................................................................................................................................................. 96

ART 4.1.1 SISTEMA DI CALCOLO .................................................................................................................................. 96

ART 4.1.2 APPARECCHIATURE DI RETE ......................................................................................................................... 97

ART 4.1.3 SOLUZIONI PER IL CONTROLLO REMOTO DEI SERVER E UNITÀ DI CALCOLO ................................................... 97

- LOTTO 4.2 - ................................................................................................................................................................. 98

ART 4.2.1 SISTEMA DI CALCOLO .................................................................................................................................. 98

ART 4.2.2 APPARECCHIATURE DI RETE ......................................................................................................................... 99

ART 4.2.3 SOLUZIONI PER IL CONTROLLO REMOTO DEI SERVER E UNITÀ DI CALCOLO ................................................... 99

- LOTTO 5 - .................................................................................................................................................................. 100

ART. 5.1 SISTEMA DI CALCOLO ................................................................................................................................... 100

ART. 5.2 APPARECCHIATURE DI RETE ......................................................................................................................... 101

ART. 5.3 SOLUZIONI PER IL CONTROLLO REMOTO DEL SISTEMA .................................................................................. 102

ART. 5.4 SISTEMA DI STORAGE .................................................................................................................................... 102

6.

APPENDICE 3 ..................................................................................................................................................... 104

7.

APPENDICE 4 ..................................................................................................................................................... 105

IBM BLADECENTER LS21 ............................................................................................................................................ 115

PUBLIC

- 4 - / 191

-4-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

1. INTRODUZIONE

Questo documento descrive l’architettura ed i servizi accesso dell’infrastruttura di produzione del Progetto

PI2S2 realizzata nel corso del primo anno.

PUBLIC

- 5 - / 191

-5-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

2. ARCHITETTURA

COLLEGATI

2.1.

DELL’INFRASTRUTTURA

DI

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

PRODUZIONE

E

SERVIZI

GARA D’APPALTO PER LA FORNITURA DELL’INFRASTRUTTURA GRID

Nel primo anno del progetto PI2S2 l’attività del WP1 ha riguardato principalmente la preparazione delle gare

d’appalto per la fornitura “chiavi in mano” della prima “tranche” dell’infrastruttura di servizio (armadi rack,

gruppi di continuità e di condizionamento) e di quella calcolo, storage e rete. Il Consiglio di

Amministrazione del Consorzio COMETA, sentito il parere del Comitato Tecnico Scientifico, ha designato

una Commissione di esperti che ha provveduto alla preparazione dei capitolati tecnici. Per completezza di

informazione, i capitolati tecnici per la gara “infrastruttura” e per la gara “calcolo” sono riportati in calce al

presente deliverable come Appendici 1 e 2. Le offerte tecniche delle ditte vincitrici delle due gare sono

invece riportate nelle Appendici 3 e 4.

Le due gare sono state espletate tra Luglio 2006 e Gennaio 2007. Le figure 1 e 2 riportano delle schede

riassuntive degli apparati di calcolo e di storage che sono stati acquistati:

Figura 1 – Scheda riassuntiva del sistema di calcolo acquistato.

PUBLIC

- 6 - / 191

-6-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Figura 2 – Scheda riassuntiva del sistema di storage acquistato.

Le offerte tecniche che sono risultate vincenti, e che forniscono un’idea completa dell’infrastruttura del

Progetto che è stata acquistata fino a questo momento, sono riportate per completezza come Appendici 3 e 4.

Alla data odierna, in tre dei 6 siti di COMETA è stata già completata l’installazione dell’infrastruttura di

rack, raffreddamento e continuità. Gli altri siti verranno completati entro la prima metà di Marzo 2007. La

fornitura delle macchine da calcolo e dei sistemi di storage, invece, è prevista avvenire in tutti i siti entro

Aprile 2007.

Altre attività preparatorie di WP1 condotte nel primo anno del Progetto PI2S2 sono riportare nei seguenti

paragrafi.

2.2. AUTORITÀ DI REGISTRAZIONE DELL’AUTORITÀ DI CERTIFICAZIONE DEL-L’INFN

I Partner del Consorzio COMETA hanno convenuto che l’Autorità di Certificazione dell’INFN (INFN CA,

http://security.fi.infn.it/CA) rilascerà tutti i certificati digitali (X.509) per gli utenti ed i servizi grid del

Progetto PI2S2. Ciò perché la INFN CA è una delle Autorità di Certificazione dell’Organizzazione

EuGridPMA (http://www.eugridpma.org) che raggruppa tutte le CA accreditate sull’Infrastruttura Grid

Europea del Progetto EGEE (http://www.eu-egee.org) e su quella mondiale del progetto WLCG

(http://www.cern.ch/lcg). A tal fine, il Consorzio COMETA ha già attivato delle Autorità di Registrazione

(RA) della INFN CA nella sedi di Catania, Messina, Palermo e Roma (per gli utenti del Consorzio SCIRE).

La lista delle RA di COMETA che sono state attivate è reperibile

http://security.fi.infn.it/CA/RA e riportata nella figura 3 seguente per completezza:

PUBLIC

alla

pagina

- 7 - / 191

web

-7-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Figura 3 – Lista delle Registration Authority del Consorzio COMETA.

2.3. CREAZIONE DELL’ORGANIZZAZIONE VIRTUALE “cometa” E DELLE REGOLE DI

ACCESSO ALL’INFRASTRUTTURA

Al fine di favorire e velocizzare l’uso dell’Infrastruttura Grid del Progetto PI2S2 da parte di utenti che non

appartengono già a Organizzazioni Virtuali pre-esistenti, è stata creata l’Organizzazione Virtuale “cometa”.

Il server di amministrazione della Organizzazione Virtuale “cometa” è raggiungibile all’indirizzo web:

https://voms.ct.infn.it:8443/voms/cometa/ ed il form di registrazione per gli utenti in possesso di certificato

digitale

personale

è

già

attivo

all’indirizzo

web:

https://voms.ct.infn.it:8443/voms/cometa/webui/request/user/create.

A tutt’oggi risultano registrati 61 utenti.

Gli utenti che si registrano nella VO “cometa” devono prima esplicitamente accettare le Regole di Accesso

all’infrastruttura del Progetto PI2S2 che sono state definite in accordo con quelle vigenti in altri progetti grid

internazionali in modo da assicurare, in futuro, una possibile interoperabilità. Il form di accettazione delle

regole di accesso è riportato nella Figura 4.

PUBLIC

- 8 - / 191

-8-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Figura 4 – Regole di Accesso all’infrastruttura del Progetto PI2S2.

PUBLIC

- 9 - / 191

-9-

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

3. CONCLUSIONI

L’infrastruttura di produzione del Progetto PI2S2 è stata progettata ed implementata incluso i servizi Grid

accessori necessari per il suo utilizzo. Ciò fa sì che la milestone M1.2 del progetto possa essere considerata

conseguita.

PUBLIC

- 10 - / 191

- 10 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

4. APPENDICE 1

Consorzio COMETA - Progetto PI2S2

FORNITURA DI INFRASTRUTTURA (RACK,

UPS E CONDIZIONAMENTO) PER LA

CREAZIONE DI UNA GRIGLIA

COMPUTAZIONALE

CAPITOLATO TECNICO

PUBLIC

- 11 - / 191

- 11 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

PREMESSA

Tutti i sistemi devono essere forniti chiavi in mano e quindi devono essere inclusi cablaggi

e posa in opera.

Garanzia e manutenzione devono essere “on-site” per almeno 3 anni e di tipo almeno NBD

(Next Business Day).

L'offerta tecnica presentata e la successiva fornitura dovranno rispettare anche le seguenti

condizioni:

•

Dichiarazione esplicita del range di temperatura ambientale all’interno del quale

l’infrastruttura globale proposta opera in sicurezza in condizioni di pieno carico

specificando se trattasi di dati rilevati in laboratorio o dichiarati dal costruttore.

•

Dichiarazione esplicita del consumo energetico totale (in W o in kW) specificando

se trattasi di dati rilevati in laboratorio o dichiarati dal costruttore.

- 12 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

CONSIDERAZIONI GENERALI

L'obiettivo finale da conseguire è quello di creare un’infrastruttura di supporto ai sistemi di

calcolo, di storage e di rete che sia in grado di soddisfare le esigenze attuali e quelle future

del Progetto PI2S2.

Il contraente dovrà fornire in opera tutti i materiali necessari alla realizzazione, secondo

quanto indicato nel presente documento e nelle specifiche tecniche di progetto, garantendo

il pieno rispetto delle normative tecniche e di sicurezza vigenti. Dovrà installare e

terminare tutti i componenti hardware necessari a realizzare un sistema funzionale nonché

fornire tutta la documentazione richiesta dal presente documento.

Tutti i lavori dovranno essere eseguiti in maniera completa e scrupolosa in base ai più alti

standard in campo industriale e dovranno essere sottoposti al controllo e all’accettazione

da parte del Consorzio COMETA.

Si stabilisce e si concorda espressamente che tali osservazioni e controlli da parte del

Consorzio COMETA o di suoi consulenti non esonerano il contraente dalla responsabilità

di un’adeguata supervisione ed esecuzione dei lavori descritti in questo documento o

concordati successivamente.

Le ditte partecipanti dovranno fornire un elenco del personale preposto al project

management e al supporto tecnico assegnato al Progetto.

Dovrà essere espressamente indicato un nominativo come Responsabile di Progetto. Il

Responsabile di Progetto del contraente dovrà garantire il pieno rispetto delle tempistiche

di esecuzione lavori eventualmente stabilite nel piano esecutivo redatto dal contraente

secondo quanto stabilito in seguito.

Tale Responsabile di Progetto dovrà essere inoltre il referente unico e diretto per il

Consorzio COMETA relativamente a tutte le problematiche che dovessero emergere nel

corso dell’esecuzione dei lavori.

I dati numerici riportati nel presente capitolato sono basati su esperienza pregressa e sono

da ritenersi indicativi.

- 13 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

- LOTTO 1 Fornitura per l’Istituto Nazionale di Fisica Nucleare, Sezione di Catania.

L’offerta economica per questo Lotto non può essere superiore a: € 75.000,00 IVA

esclusa.

ART 1.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO

L’infrastruttura richiesta (UPS, distribuzione alimentazione elettrica – PDU, armadi TLC,

condizionamento dell’aria integrato) dovrà essere un'architettura modulare, configurabile e

scalabile progettata per fornire soluzioni di protezione dell'alimentazione elettrica end-toend per qualsiasi tipo di data center.

Con il fine di ottenere il massimo livello di comunicazione tra i componenti

dell’infrastruttura (UPS, distribuzione alimentazione elettrica – PDU, armadi TLC), si

richiede che tutti i componenti appartenenti all’infrastruttura Data Center siano stati

progettati e realizzati da un unico produttore.

I componenti che verranno descritti dovranno integrarsi con l’attuale infrastruttura CED

esistente e con il management dell’infrastruttura CED.

Dovrà essere disponibile nella configurazione 400Vca trifase 50Hz, in sistemi TT, TN-C e

TN-S.

Il presente Articolo descrive i requisiti di tale architettura e i diversi componenti richiesti

per mettere a punto una soluzione mirata modulare, configurabile e scalabile.

Compatibilità e certificazioni

EN50091-1-1 / IEC62040-1-1

EN/IEC62040-2

EN/IEC62040-3

IEC61000-4-2 livello 3, criterio di performance B

IEC61000-4-4 livello 2, criterio di performance A

IEC 1000-4-5 (livello 4)

IEC 61000-4-3 livello 2, criterio di performance A

EIA-310-D (rack dove sono alloggiati gli apparati)

- 14 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

UPGRADE DEL GRUPPO DI CONTINUITA' (UPS)

Considerazioni generali

Il sistema attuale è composto da un’architettura array scalabile e ridondanta N+1 installata a rack.

L’architettura UPS dovrà essere espansa per garantire 80 KW (N+1) aggiungendo n°4 moduli di potenza da

10kW/10kVA e 4 moduli batteria. I moduli di potenza ed i moduli batteria dovranno essere installati a caldo

durante il funzionamento normale dell’UPS.

Ciascun modulo dovrà avere la topologia Double Conversion On-Line a ingresso con correzione del fattore

di potenza e bassa distorsione armonica (THDi%<5%).

Modi operativi

La topologia deve essere Double Conversion on-line. Indipendentemente dal loro numero, i moduli di

alimentazione 10kW/10kVA di ogni singolo rack devono funzionare alla stregua di un unico sistema in

ciascuno dei modi operativi descritti di seguito:

• Normale: in ciascun modulo di alimentazione il raddrizzatore funziona in parallelo per trasformare la

ca in ingresso in cc filtrata per alimentare ininterrottamente le batterie. L'inverter trasforma la

tensione del bus cc in tensione di carico ca pulita e continua.

• Interruzione dell'alimentazione: dopo aver rilevato un'interruzione dell'alimentazione, il

raddrizzatore si deve isolare dall'alimentazione di rete in ingresso e le batterie si collegheranno

all'inverter per garantire alimentazione al carico. Il tempo di autonomia da batteria sarà pari a quello

definito nella presente specifica. Quando viene ripristinata l'alimentazione elettrica, senza alcun

intervento da parte dell'utente i moduli UPS ritorneranno automaticamente al modo operativo

normale descritto in precedenza.

• Emergenza: nel caso si verifichi un guasto nel bus di uscita o una condizione di sovraccarico

estremo, il carico viene commutato senza soluzioni di continuità a uno switch statico con correzione

del fattore di potenza. Il guasto di un modulo all'interno di una configurazione ridondata non provoca

la commutazione del carico alla linea di bypass statico.

• Bypass di manutenzione: il sistema UPS comprenderà uno switch di bypass di manutenzione (MBS)

wrap around per escludere in modo sicuro l'UPS nel corso di interventi di manutenzione di routine o

di interventi di assistenza. L'MBS sarà ad apertura-chiusura perché non venga mai meno

l'alimentazione al carico nella fase di transizione.

Componenti

- Raddrizzatore

Ciascun modulo di alimentazione dell'UPS comprenderà un raddrizzatore attivo di tipo IGBT (Insulated

Gated Bipolar Transistor) con correzione del fattore di potenza.

La tensione nominale del bus cc deve essere pari a +/- 192V c.c.

- 15 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

La tensione del bus cc deve essere compensata in base alle variazioni della temperatura (compensazione in

temperatura della batteria) per mantenere costantemente una tensione ottimale di carica delle batterie in

presenza di escursioni termiche al di sopra o al di sotto di 25° C. Il tasso di compensazione deve essere pari

a 320mV/°C per valori di temperatura ambiente ≥ 20° C e a 0mV/°C per valori di temperatura ambiente <

20°C.

La tensione di ondulazione c.c. deve essere inferiore a +/- 1% del valore nominale a batterie disconnesse.

Il fattore di potenza in ingresso deve essere pari a 0,99 con ritardo se il carico è al 100% e a 0,98 se il carico

è al 50% senza l'uso di filtri passivi. Il raddrizzatore utilizzerà la tecnologia di controllo elettronico della

forma d'onda per mantenere la forma d'onda sinusoidale.

Sarà usato il controllo della corrente Pulse Width Modulation (PWM) (modulazione a durata di impulso). Per

tutte le funzioni di controllo e monitoraggio devono essere usati Digital Signal Processor (DPS). Non sono

ammessi controlli analogici.

La distorsione armonica totale (THD) riflessa della corrente di ingresso non deve essere superiore al 5% con

carico al 100%.

Intervallo della frequenza di ingresso: tra - 20% e + 15% del valore nominale.

Il tempo standard di ricarica batterie è conforme a IEEE 485.

- Batterie

La tecnologia standard delle batterie dovrà essere VRLA (Valve Regulated Lead Acid).

Le batterie non devono essere alloggiate nello stesso rack dove si trovano i moduli di alimentazione. Le

batterie devono essere modulari e collocate su scaffali estraibili per rendere più rapida l'assistenza e la

sostituzione.

La tensione delle batterie deve essere compensata in temperatura come descritto nel precedente paragrafo.

Potenza di ricarica: 5kW max.

Fine della scarica: +/- 160V c.c.

- Inverter

L'inverter sarà composto da moduli di alimentazione IGBT a commutazione rapida.

L'inverter dovrà essere controllato in modalità PWM con l'uso di logica DSP. Il controllo di tipo analogico

non è ammesso.

I moduli dell'inverter presentano la correzione del fattore di potenza, ovvero kW=kVA. L'uso di un fattore di

potenza in uscita diverso dall'unità non è ammesso.

La tensione nominale in uscita sarà pari a 400V/400V, trifase, 50Hz, a quattro fili più la terra.

Rendimento di ciascun modulo a pieno carico: non inferiore al 93,5%.

Distorsione armonica totale della tensione di uscita a pieno carico: inferiore al 2%.

Regolazione della tensione di uscita:

Statica: inferiore all'1% a pieno carico lineare e non lineare

Dinamica: +/-5% con carico a gradini 100%.

- 16 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Frequenza in uscita: 50/60 Hz libera.

Fattore di cresta: illimitato.

Predisposizione per lo spegnimento di emergenza a distanza (EPO).

- Fattori ambientali

Temperatura di funzionamento con correzione del fattore di potenza: 0-40°C

Temperatura dell'ambiente di posizionamento: tra - 15 e 45°C

Altezza di funzionamento con correzione del fattore di potenza: 0 - 1000m s.l.m.

Altezza di posizionamento: 0 - 15.000 m

Umidità relativa: 0-95% non condensing

Rumore udibile a 1 metro di distanza dall'unità:

• 70 dbA al 100% del carico

• 62 dbA al 70% del carico

•

Management

I moduli di potenza ed i moduli di batteria dovranno comunicare con l’attuale sistema di management

dell’infrastruttura fisica in modo tale che il responsabile del Data Center potrà conoscere quanti moduli sono

stati installati ed i loro stato durante l’esercizio.

MODULO RACK ED ACCESSORI

Dovranno essere forniti ed installati n°4 Armadi Rack secondo le seguenti specifiche:

Specifiche Fisiche

Dimensione Rack, compatibilità del montaggio a rack, carico massimo supportato

Altezza

Interna

EIA310

Altezza

Esterna

Larghezza

Esterna

Profondità

Esterna

Carico

Statico

Carico

Dinamico

42U

19”

2070mm

600mm

1070mm

909 Kg

909 Kg

(81.5”)

(23.6”)

(42.1”)

(2000lbs)

(2000lbs)

L’altezza esterna del 42U è di 2070mm (81.5”) per facilitarne il passaggio attraverso una

porta standard 7 Ft. (84”).

- 17 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Il carico statico supportato dovrà essere di almeno 909 Kg (peso supportato dalle ruote

orientabile e dai piedini di livellamento).

Il carico dinamico supportato dovrà essere di almeno 909 Kg (peso supportato dalle ruote

orientabile in movimento).

Accesso al carico e montaggio

L’armadio deve offrire 42U di spazio per il montaggio delle apparecchiature

I montanti verticali devono essere regolabili in profondità

Sia la porta frontale che posteriore devono possedere cardini a rilascio veloce per un

rapido e veloce smontaggio

Sia la porta frontale che posteriore devono poter essere aperte fino a 180° per un facile

accesso interno

La porta frontale deve essere reversibile in modo da essere aperta da entrambi i lati

La porta posteriore deve essere a due battenti verticali per rendere più agevole l’attività di

service

L’armadio deve possedere pannelli laterali removibili senza attrezzi migliorando l’accesso

per un veloce cablaggio dell’apparecchiature

Specifiche ambientali

L’armadio deve avere una protezione IP 20 contro il contatto, l’ingresso di corpi estranei e

l’introduzione d’acqua.

Specifiche di sicurezza

L’armadio deve rispondere alle specifiche meccaniche (stabilità, resistenza meccanica,

apertura porte, etc.) definite nel IEC 60950 Terza Edizione.

Ventilazione

L’armadio deve fornire una ventilazione che supera le specifiche della maggior parte dei

server vendor

- 18 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

L’armadio deve fornire una ventilazione per la porta frontale, la porta posteriore ed il tetto

come mostrata di seguito:

Altezza Interna

Larghezza

Esterna

Porta Frontale

Perforata

Porta Posteriore

Perforata

Tetto

Perforato

600mm

1070mm

5355 cm²

5413 cm²

1007 cm²

(23.6”)

(42.1.”)

(830 in²)

(839 in²)

(156 in²)

Canalizzazioni

Ogni Armadio Rack dovrà avere fino a 3 canalizzazioni sul tetto per garantire il passaggio

dei cavi di alimentazione e dati.

Strisce di Alimentazione

In ogni Armadio Rack dovranno essere installate n°2 strisce di alimentazioni intelligenti da

32Amp installate nella parte posteriore dell’armadio senza occupare unità.

L’installazione deve poter essere effettuata senza attrezzi.

Deve essere composta da 24 prese di cui 20 IEC 320 C13 e 4 IEC 320 C19.

Corrente 32Amp, Potenza almeno 7KW.

È richiesto un amperometro digitale integrato con display.

È richiesto il monitoraggio via IP dell’assorbimento.

È richiesta l’allarmistica con soglie.

È richiesta la possibilità di comandare da remoto l’alimentazione delle singole prese

attraverso l’accensione e lo spegnimento della singola presa.

L’accesso al management delle strisce di alimentazioni intelligenti dovrà avvenire tramite

browser ed il management delle strisce di alimentazioni dovrà comunicare con il

management dell’infrastruttura esistente.

MODULO GESTIONE AMBIENTALE E SENSORI

Dovranno essere fornite, installate e configurate n°2 centraline di gestione ambientale via IP con altezza

1U e montaggio 19”.

- 19 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Ogni centralina di gestione ambientale dovrà essere fornita con i seguenti sensori: n.°2 sensori di

temperatura ed umidità, n.°1 sensori di controllo fumi all’interno dell’armadio Rack Server, n.°1 sensori

anti-allagamento lunghezza almeno 6 m, n.°1 lampeggiante posizionato sul tetto dei Rack, n.°1 sensore

apertura porta Rack Server, n°1 sensore vibrazioni

La centralina dovrà ospitare i seguenti contatti per future integrazioni: fino a n.°4 sensori temperatura ed

umidità, sensore movimento tra le file degli armadi Rack.

n.° 4 contatti puliti disponibili

Il management della centralina di gestione ambientale dovrà essere accessibile tramite browser. Il

management della centralina di gestione ambientale dorà essere integrato con il management

dell’Infrastruttura esistente.

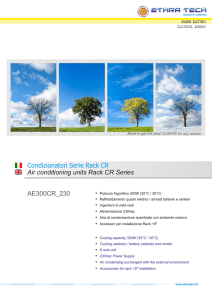

MODULO SISTEMA DI CONDIZIONAMENTO AMBIENTALE

Premessa

Il sistema di condizionamento ambientale dovrà essere progettato specificatamente per

applicazioni di controllo di precisione di temperatura ed umidità. Controllerà

automaticamente le funzioni di riscaldamento, raffreddamento e filtraggio dell’ambiente

interessato.

Il sistema dovrà essere costruito secondo i più alti standard qualitativi di ingegneria e

costruzione, e dovrà essere montato a pavimento, configurato per un flusso d’aria

condizionata up al fine di fornire la distribuzione uniforme dell’aria nell’ambiente

interessato.

Dovranno essere fornite ed installate n°2 unità di condizionamento capaci di neutralizzare

fino a 20kW per Armadio Rack aventi le seguenti caratteristiche:

Cabinet

Il cabinet del sistema di condizionamento dovrà essere provvisto di pannelli laterali e pannelli

frontali e laterali conformi allo standard relativo all’isolamento UL94-5VA ASTM e84.

I pannelli frontali e posteriori dovranno essere perforati con asole che dovranno garantire almeno il

50% di area libera e dovranno essere equipaggiati con una chiave ed una serratura per garantire un

accesso sicuro ai componenti interni all’unità di condizionamento.

Le attività di service sull’unità di condizionamento verranno eseguite sul fronte e/o sul retro al fine

di posizionare l’unità di condizionamento in fila ai Rack IT.

- 20 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

L’unità di condizionamento dovrà essere provvista di ruote e piedini di livellamento al fine di

posizionare correttamente l’unità in fila agli adiacenti Rack IT.

Ventole

Ogni unità di condizionamento include 8 ventole.

Ogni ventola dovrà essere progettata per fornire 362.5 CFM per un totale di flusso d’aria di 2900

CFM.

L’unità di condizionamento dovrà essere in grado di funzionare anche nel caso di un guasto ad una

delle 8 ventole.

Le 8 ventole dovranno essere riparabili mentre l’unità di condizionamento è in funzione.

Doppio Alimentatore A-B

Doppio alimentatore A-B di ingresso all’unità di condizionamento.

L’unità di condizionamento dovrà includere due alimentatore capaci di fornire il 60% della potenza

totale. L’assorbimento della singola unità di condizionamento non dovrà superare i 1100W durante

il funzionamento normale.

Controllore

Dal display dell’unità di condizionamento si dovrà accedere alla configurazione ed al monitoraggio

della stessa attraverso dei controlli a menu.

Le funzioni dovranno includere i report riguardanti lo stato, il set-up e la temperatura. Lo stato di

funzionamento dell’unità di condizionamento dovrà essere indicato da LED o da altri appropriati

indicatori.

Il controllore dell’unità di condizionamento dovrà essere fornito con controlli attraverso chiavi per

una navigazione attraverso i menu, gli oggetti selezionabili e le informazioni di input alpha numeriche.

Il controllore dovrà poter attivare allarmi visibili ed udibili in presenza dei seguenti eventi:

a. Filtro dell’aria intasato

b. Comunicazione fallita

c. Attuatore della valvola guasto

d. Pompa guasta

e. Unità di condizionamento guasta

f. Alta temperatura del fluido in ingresso

g. Sensore di temperatura guasto

h. Ventola guasta

- 21 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

i.

j.

k.

l.

m.

n.

o.

p.

q.

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Alimentatore guasto

Misuratore della velocità di flusso guasto

Perdita del gruppo di comunicazione

Comunicazione interna fallita

Alimentazione A-B fallita

Alta temperatura nel Rack

Bassa temperatura nel Rack

Temperatura in uscita elevata

Presenza acqua

Il controllore dovrà memorizzare e visualizzare sul display tutti gli eventi del sistema di

condizionamento. Ogni allarme dovrà contenere la data, l’ora e la modalità di funzionamento del

sistema di condizionamento nel momento dell’evento.

Scheda di Management

L’unità di condizionamento dovrà includere una scheda di management permettendo una gestione

via rete TCP/IP. Il management via rete dovrà prevedere la possibilità di fissare dei set-point,

entrare nei vari parametri del menu e cancellare allarmi.

Valvola 2 WAY/ 3 WAY

Il sistema di refrigerazione ad acqua dovrà utilizzare la valvola 2 WAY/3 WAY al fine di regolare

la quantità d’acqua verso l’unità di condizionamento per mantenere le condizioni desiderate. La

valvola dovrà essere collegata internamente all’unità di condizionamento e dovrà essere di facile

sostituzione in caso di guasto. Il valore standard della pressione è di 600 psig.

Connessioni dall’alto o dal basso

I tubi dell’acqua refrigerata dovranno poter essere connessi sia dall’alto che dal basso dell’unità. Le

connessione dei tubi dell’acqua refrigerata dovranno essere presenti all’interno dell’unità.

Sensore della temperatura remoto

Il sensore della temperatura remoto dovrà essere collegato all’unità di condizionamento al fine di

fornire il controllo della temperatura di ingresso sul fronte del Rack.

- 22 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Misuratore di flusso

Il misuratore di flusso dovrà essere installato all’interno dell’unità di condizionamento e collegato

al controllore dell’unità al fine di fornire il valore della velocità di flusso attraverso l’unità di

condizionamento.

Presenza acqua

Un cavo sensibile alla presenza d’acqua dovrà essere collegato all’unità di condizionamento. Nel

caso in cui l’acqua o altri liquidi dovessero entrare in contatto con una superficie del cavo per tutta

la sua lunghezza, il controllore visualizzerà e annuncerà in modo udibile l’allarme.

Il cavo presenza acqua non dovrà essere inferiore ai 6 mt.

Canalizzazione sul tetto dell’unità

Al fine di realizzare la canalizzazione orizzontale sul tetto dei Rack sia per i cavi di potenza che

dati, l’unità di condizionamento dovrà montare sul tetto delle canalizzazioni identiche a quelli degli

armadi Rack.

Impianto ad acqua refrigerata

Le due unità di condizionamento dovranno essere collegate all’esistente impianto ad acqua

refrigerata, pertanto dovrà essere previsto tutto il necessario per effettuare tali collegamenti a regola

d’arte.

PLENUM

L’intera infrastruttura dovrà essere chiusa su ogni lato da un plenum al fine di convogliare

tutto il calore prodotto dai rack in ingresso al condizionatore, ottenendo una maggiore

densità di potenza per rack.

Il plenum dovrà essere modulare e scalabile con la possibilità di inserire più rack in futuro.

Attività DI Post-Installazione

- 23 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Ultimata l’installazione la Ditta fornitrice dovrà garantire una serie di attività PostInstallazione necessarie per la corretta gestione e manutenzione della infrastruttura

installata.

In dettaglio dovranno essere garantite le seguenti attività:

Training di 1 giorno sulla gestione e manutenzione dell’infrastruttura installata.

Dovrà essere erogato da parte della ditta installatrice e/o produttrice del sistema un training

della durata di almeno una giornata al personale coinvolto nella gestione e nella

manutenzione del sistema installato. Durante il training dovranno essere illustrate la logica

del funzionamento del sistema installato e le sue caratteristiche tecniche e funzionali.

1 Anno di Monitoraggio 7x24 da remoto dell’intera infrastruttura installata.

Dovrà essere garantito il monitoraggio in outsourcing dell’infrastruttura installata per un

periodo continuativo di 12 mesi, 24 ore su 24, a partire dalla data della sua messa in

esercizio, volto ad individuare eventuali problemi sull’infrastruttura.

Tale monitoraggio dovrà essere preferibilmente fornito tutto o in parte con il diretto

coinvolgimento del produttore dell’infrastruttura, in grado di interpretare in anticipo

potenziali malfunzionamenti che potrebbero compromettere l’ottimale utilizzo

dell’infrastruttura installata e di suggerire i necessari interventi correttivi.

Dovrà anche essere inclusa una completa reportistica da fornire con cadenza mensile in

grado di rappresentare il funzionamento nel tempo dell’infrastruttura installata.

Integrazione del Software di gestione con la rete locale.

Dovrà essere garantita la perfetta integrazione del Software e del Server di gestione con la

rete locale presente, e tutti i componenti dell’infrastruttura dovranno essere identificati con

un loro indirizzo IP.

LAYOUT

- 24 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Lista dei componenti

L’elenco dei componenti HW che la Ditta dovrà fornire in opera configurati secondo le

esigenze dell’Università e il dettaglio delle attività che dovranno essere garantite a seguito

dell’installazione è il seguente:

Fornitura in opera Hardware

COMPONENTI:

COMPONENTI

Q.tà

DESCRIZIONE

Moduli di Poteza

4

Moduli di Potenza 10kW/10kVA

Moduli Batteria

4

Moduli Batteria

- 25 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Armadi Rack 19”

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

2

Armadi Rack 19” 42U

4

Strisce di alimentazioni intelligenti da 32A

42U

Strisce

di

Alimentazioni

con 24 prese ed accensione e spegnimento

Intelligenti

della singola presa.

Centralina

di

2

Centralina di gestione ambientale ciascuna

Gestione

con sensori: temperatura, umidità, apertura

Ambientale

porte, lampeggiante, ant-allagamento, fumi

all’interno del Rack

Condizionamento

2

Unità

di

condizionamento

ad

acqua

refrigerata fino a 20kW

Attività Post-Installazione

ATTIVITA’

Q

DESCRIZIONE

.

t

à

Assemblaggio

1

Assemblaggio dell’intera infrastruttura.

Training

1

Training di 1 giorno sulla gestione e manutenzione

dell’infrastruttura installata.

- 26 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Monitoraggio

1

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

1 Anno di Monitoraggio 7x24 da remoto dell’intera

infrastruttura installata.

Network

Integration

1

Integrazione del Software di gestione con la rete dati del

Data Center

- 27 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

- LOTTO 2 Fornitura per l’Istituto Nazionale di Astrofisica, Osservatorio Astrofisico di Catania.

L’offerta economica per questo lotto non può essere superiore a: € 5.000,00 IVA esclusa.

ART 2.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO

Sistema Rack 19” di 42U (colore nero) fornito con ventilazione forzata adeguata.

UPS da 10000 VA con ingresso trifase. Autonomia 10 minuti calcolati su 10000VA, con montaggio sul rack.

Il sistema deve poter essere monitorato via Web Browser con la possibilità di ricevere messaggi di allarmi.

Sistema di monitoraggio ambientale all’interno dell’Armadio Rack della temperatura ed umidità.

Strisce di alimentazione intelligenti fino a 24 prese dotate di sistema di Accensione e spegnimento via IP

della singola presa.

Qualora il sistema proposto per il Lotto 2 necessiti di più di un rack, l’offerta dovrà comprendere tale

opzione.

- 28 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

- LOTTO 3 Fornitura per l’Università degli Studi di Messina e l’Istituto Nazionale di Geofisica e

Vulcanologia.

L’offerta economica per questo lotto non può essere superiore a: € 174.000,00 IVA

esclusa.

ART 3.1 SISTEMA DI RACK, UPS E CONDIZIONAMENTO

L’infrastruttura richiesta (UPS, distribuzione alimentazione elettrica – PDU, armadi TLC,

condizionamento dell’aria integrato) dovrà essere un'architettura modulare, configurabile e

scalabile progettata per fornire soluzioni di protezione dell'alimentazione elettrica end-toend per qualsiasi tipo di data center.

Con il fine di ottenere il massimo livello di comunicazione tra i componenti

dell’infrastruttura (UPS, distribuzione alimentazione elettrica – PDU, armadi TLC), si

richiede che tutti i componenti appartenenti all’infrastruttura Data Center siano stati

progettati e realizzati da un unico produttore.

La soluzione UPS/PDU dovrà essere costituita da unità di alimentazione e di distribuzione

modulari e facili da installare.

Ciascun modulo dovrà essere composto da rack 23" indipendenti, simili ai rack dove

saranno alloggiati gli apparati di calcolo e di storage del data center.

La soluzione dovrà includere i componenti seguenti: UPS, switch statico (STS) con

correzione del fattore di potenza, switch di bypass di manutenzione (MBS), unità batterie,

unità di distribuzione dell'alimentazione (PDU), prese multipla (striscie di alimentazione)

con gestione delle singole porte di alimentazione, canaline per il posizionamento dei cavi e

cablaggio in testa, cavi alimentazione e dati

Dovrà essere disponibile nella configurazione 400Vca trifase 50Hz, in sistemi TT, TN-C e

TN-S.

Il presente Articolo descrive i requisiti di tale architettura e i diversi componenti richiesti

per mettere a punto una soluzione mirata modulare, configurabile e scalabile.

- 29 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

IMPIANTO ELETTRICO PER LA CONFIGURAZIONE (N+1)

Il grado di ridondanza (N+1) implica un sistema di distribuzione a singolo radiale.

Nella figura sottostante è riportato un sistema in configurazione (N+1) con ridondanza

intrinseca di UPS e ridondanza di distribuzione (cavi e interruttori generali).

Sorgente di alimentazione in configurazione (N+1)

Requisiti di impianto elettrico

Di seguito si riportano le caratteristiche elettriche richieste per i componenti di impianto

installati a monte del quadro elettrico di distribuzione denominato PDU, in riferimento alla

figura sopra riportata.

Caratteristiche elettriche

Valori

Massima Corrente di ingresso (continua, a minima tensione di alimentazione)

147A

- 30 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Protezione in corrente di ingresso

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

160A *Nota 1

Massima corrente di uscita (nella sola di condizione di bypass al 125% di

145A

sovraccarico)

Corrente di uscita sul conduttore di neutro (con 100% di carico distorcente)

*Nota 2

Sezione cavi ingresso

70mm2

Sezione cavi uscita

50mm2

Cavo PE esterno

35mm2

1) Protezione di corrente in Ingresso; I fusibili dovranno essere DIN LV HRC tipo gl 500V

2) Cavi di uscita conduttore di neutro; dimensionati per il 173% della corrente di fase, per carichi

distorcenti.

Tutti i cavi dovranno essere in rame isolati in PVC a 30°C come massima temperatura ambientale.

Si prega di osservare che carichi distorcenti (switch mode power supply) monofase causano l’aumento della

corrente di neutro:

al 100% di carico distorcente (carico SMPS) il cavo di neutro dovrebbe essere dimensionato in accordo con

quanto previsto da norma CEI64-8.

Si osservi che carichi distorcenti (switch mode power supply) monofase causano

l’aumento della corrente di neutro: al 100% di carico distorcente (carico SMPS) il cavo di

neutro dovrebbe essere dimensionato in accordo con quanto previsto da norma CEI 64-8.

Compatibilità e certificazioni

EN50091-1-1 / IEC62040-1-1

EN/IEC62040-2

EN/IEC62040-3

IEC61000-4-2 livello 3, criterio di performance B

IEC61000-4-4 livello 2, criterio di performance A

IEC 1000-4-5 (livello 4)

IEC 61000-4-3 livello 2, criterio di performance A

EIA-310-D (rack dove sono alloggiati gli apparati)

SEZIONE 1 - MODULO GRUPPO DI CONTINUITA' (UPS)

- 31 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Considerazioni generali

1. Il sistema dovrà essere composto da un’architettura array scalabile e ridondata N+1 installate a rack.

L’architettura UPS dovrà essere dimensionata per garantire 40 KW (N+1) ma dovrà essere

espandibile sino a 80 KW (N+1), e dovrà poter comprendere fino a un massimo di nove (9) moduli

di alimentazione 10kW/10kVA in una configurazione ridondante N+1, uno switch statico di bypass,

un sistema batterie in armadi separati in grado di garantire autonomia fino a 10 minuti (con carico

nominale di 40 KW ca.) e un display LCD, il tutto alloggiato in rack 19" suddivisi in moduli di

potenza e moduli batteria. La soluzione UPS dovrà consentire agli utenti di installare e rimuovere i

moduli di alimentazione 10kW/10kVA e i moduli batteria anche durante il funzionamento del

sistema (Hot-Swapable). Ciascun modulo dovrà avere la topologia Double Conversion On-Line a

ingresso con correzione del fattore di potenza e bassa distorsione armonica (THDi%<5%).

Modi operativi

La topologia deve essere Double Conversion on-line. Indipendentemente dal loro numero, i moduli di

alimentazione 10kW/10kVA di ogni singolo rack devono funzionare alla stregua di un unico sistema in

ciascuno dei modi operativi descritti di seguito:

•

•

•

•

Normale: in ciascun modulo di alimentazione il raddrizzatore funziona in parallelo per trasformare la

ca in ingresso in cc filtrata per alimentare ininterrottamente le batterie. L'inverter trasforma la

tensione del bus cc in tensione di carico ca pulita e continua.

Interruzione dell'alimentazione: dopo aver rilevato un'interruzione dell'alimentazione, il

raddrizzatore si deve isolare dall'alimentazione di rete in ingresso e le batterie si collegheranno

all'inverter per garantire alimentazione al carico. Il tempo di autonomia da batteria sarà pari a quello

definito nella presente specifica. Quando viene ripristinata l'alimentazione elettrica, senza alcun

intervento da parte dell'utente i moduli UPS ritorneranno automaticamente al modo operativo

normale descritto in precedenza.

Emergenza: nel caso si verifichi un guasto nel bus di uscita o una condizione di sovraccarico

estremo, il carico viene commutato senza soluzioni di continuità a uno switch statico con correzione

del fattore di potenza. Il guasto di un modulo all'interno di una configurazione ridondata non provoca

la commutazione del carico alla linea di bypass statico.

Bypass di manutenzione: il sistema UPS comprenderà uno switch di bypass di manutenzione (MBS)

wrap around per escludere in modo sicuro l'UPS nel corso di interventi di manutenzione di routine o

di interventi di assistenza. L'MBS sarà ad apertura-chiusura perché non venga mai meno

l'alimentazione al carico nella fase di transizione.

Componenti

- Raddrizzatore

Ciascun modulo di alimentazione dell'UPS comprenderà un raddrizzatore attivo di tipo IGBT (Insulated

Gated Bipolar Transistor) con correzione del fattore di potenza.

La tensione nominale del bus cc deve essere pari a +/- 192Vcc

- 32 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

La tensione del bus cc deve essere compensata in base alle variazioni della temperatura (compensazione in

temperatura della batteria) per mantenere costantemente una tensione ottimale di carica delle batterie in

presenza di escursioni termiche al di sopra o al di sotto di 25° C. Il tasso di compensazione deve essere pari a

320mV/°C per valori di temperatura ambiente ≥ 20° C e a 0mV/°C per valori di temperatura ambiente <

20°C.

La tensione di ondulazione cc deve essere inferiore a +/- 1% del valore nominale a batterie disconnesse.

Il fattore di potenza in ingresso deve essere pari a 0,99 con ritardo se il carico è al 100% e a 0,98 se il carico

è al 50% senza l'uso di filtri passivi. Il raddrizzatore utilizzerà la tecnologia di controllo elettronico della

forma d'onda per mantenere la forma d'onda sinusoidale.

Sarà usato il controllo della corrente Pulse Width Modulation (PWM) (modulazione a durata di impulso). Per

tutte le funzioni di controllo e monitoraggio devono essere usati Digital Signal Processor (DPS). Non sono

ammessi controlli analogici.

La distorsione armonica totale (THD) riflessa della corrente di ingresso non deve essere superiore al 5% con

carico al 100%.

Intervallo della frequenza di ingresso: tra - 20% e + 15% del valore nominale

Il tempo standard di ricarica batterie è conforme a IEEE 485.

- Batterie

La tecnologia standard delle batterie dovrà essere VRLA (Valve Regulated Lead Acid).

Le batterie non devono essere alloggiate nello stesso rack dove si trovano i moduli di alimentazione. Le

batterie devono essere modulari e collocate su scaffali estraibili per rendere più rapida l'assistenza e la

sostituzione.

La tensione delle batterie deve essere compensata in temperatura come descritto nel precedente paragrafo

3.1.c.

Potenza di ricarica: 5kW max.

Fine della scarica: +/- 160Vcc

- Inverter

L'inverter sarà composto da moduli di alimentazione IGBT a commutazione rapida.

L'inverter dovrà essere controllato in modalità PWM con l'uso di logica DSP. Il controllo di tipo analogico

non è ammesso.

I moduli dell'inverter presentano la correzione del fattore di potenza, ovvero kW=kVA. L'uso di un fattore di

potenza in uscita diverso dall'unità non è ammesso.

La tensione nominale in uscita sarà pari a 400V/400V, trifase, 50Hz, a quattro fili più la terra.

Rendimento di ciascun modulo a pieno carico: non inferiore al 93,5%.

Distorsione armonica totale della tensione di uscita a pieno carico: inferiore al 2%.

Regolazione della tensione di uscita:

Statica: inferiore all'1% a pieno carico lineare e non lineare

Dinamica: +/-5% con carico a gradini 100%

Frequenza in uscita: 50/60 Hz libera

- 33 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Fattore di cresta: illimitato

Predisposizione per lo spegnimento di emergenza a distanza (EPO)

- Switch statico

Lo switch statico sarà composto da raddrizzatori controllati al silicio (SCR) con correzione del fattore di

potenza. Non sono ammessi SCR senza correzione del fattore di potenza muniti di contattore wrap around.

Lo switch statico deve essere di tipo estraibile per facilitare la manutenzione. Sarà alloggiato nello stesso

rack dove si trovano i moduli di alimentazione principali e le batterie.

Se si verificano più di 10 commutazioni da e verso l'inverter nel corso di 10 minuti, il carico verrà bloccato

in condizione di bypass statico. Un allarme provvederà a segnalare la situazione.

- Fattori ambientali

Temperatura di funzionamento con correzione del fattore di potenza: 0-40°C

Temperatura dell'ambiente di posizionamento: tra - 15 e 45°C

Altezza di funzionamento con correzione del fattore di potenza: 0 - 1000m s.l.m.

Altezza di posizionamento: 0 - 15.000 m

Umidità relativa: 0-95% non condensing

Rumore udibile a 1 metro di distanza dall'unità:

• 70 dbA al 100% del carico

• 62 dbA al 70% del carico

- Connettività e gestione

Monitoraggio da remoto e chiusura automatica sicura del sistema operativo

Arresto del server:

L'UPS, unitamente a una scheda di interfaccia di rete, chiude automaticamente in modo sicuro uno o più

sistemi operativi in caso di alimentazione di emergenza da batteria (reti TCP/IP Ethernet)

L'UPS sarà anche in grado di utilizzare una porta RS232 per comunicare lungo un cavo seriale DB9 e

chiudere automaticamente in modo sicuro uno o più sistemi operativi in caso di alimentazione di emergenza

da batteria.

- Monitoraggio da remoto dell'UPS

Monitoraggio via Web: dovrà essere possibile monitorare da remoto l'UPS tramite un Web browser come

Internet Explorer o Netscape Navigator.

Monitoraggio via RS232: dovrà essere possibile monitorare da remoto l'UPS attraverso una connessione

RS232 oppure un contatto libero del gruppo di continuità.

- 34 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Il produttore dell'UPS deve fornire software in grado di supportare la chiusura automatica sicura e il

monitoraggio da remoto dei seguenti sistemi operativi:

Scientific Linux CERN 3.0.5 e superiori, Linux Red Hat Enterprise 3.0 e superiori, Fedora

Core 3 e superiori

Microsoft 3.1, 3.11

Microsoft Windows 95

Microsoft Windows NT

OS/2

Netware 3.12, 4.1, 4.11

Apple

DEC VMS

DG-UX

Silicon Graphics

DEC OSF/1

SCO UNIX

SCO XENIX

SVR4

Interactive

Unix Ware

SUN Solaris

SUN OS

IBM AIX

HP-UX

- Parti meccaniche

I moduli di alimentazione dell'UPS, lo switch statico e le batterie VRLA dovranno essere alloggiati in un

rack 19" standard che presenta le specifiche seguenti:

208cmH x 60cmL x 86cmP

Finito con polvere, colore nero

Acciaio laminato a freddo spessore 16

Armadio NEMA 1

Struttura con parte anteriore cieca

Munito di rotelle per favorire la mobilità. I piedini di livello sono forniti di dotazione

Ingresso cavi: dall'alto o dal basso.

- 35 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

SEZIONE 2 - UNITA' DI DISTRIBUZIONE DELL'ALIMENTAZIONE

Considerazioni generali

La PDU è un'unità indipendente dove sono alloggiati lo switch di bypass di manutenzione (MBS), gli

interruttori della distribuzione dell'alimentazione e il controller di gestione remota. La PDU deve essere

montata a fianco dell'UPS trifase in una disposizione di perfetto allineamento.

Fattori elettrici

La PDU è un'unità indipendente dove sono alloggiati lo switch di bypass di manutenzione (MBS), gli

interruttori della distribuzione dell'alimentazione e il controller di gestione remota.

La PDU dovrà essere alloggiata in un rack 23" standard che presenta la stessa altezza e profondità dell'UPS

trifase, e posizionata a fianco dell'UPS trifase in una disposizione di perfetto allineamento.

Per facilitare la manutenzione e l'assistenza dell'UPS modulare trifase senza interruzione del carico critico

dovrà essere fornito di dotazione uno switch di bypass di manutenzione (MBS) di tipo apertura-chiusura con

tre (3) interruttori.

L’Unità di distribuzione dell’alimentazione con System Bypass a 80 kW dovrà provvedere alla

distribuzione e alla gestione della corrente elettrica. Con una capacità di 80 kW, l’unità accoglierà

un ingresso trifase da 400 V, e distribuirà alimentazione monofase da 230 V (L-N) ai rack

dell’apparecchiatura e ai pannelli di distribuzione remota. Tali pannelli occuperanno le 10 U

superiori degli armadietti tipo rack progettati appositamente e distribuiranno alimentazione ai rack

dell’apparecchiatura. L’Unità di distribuzione dell’alimentazione con System Bypass sarà alloggiata

in un armadietto tipo rack progettato appositamente. Ogni Unità di distribuzione dell’alimentazione

con System Bypass da 80 kW disporrà di trenta posizioni polari per l’alimentazione dei rack

dell’apparecchiatura e di quattro posizioni tripolari per l’alimentazione di pannelli di distribuzione

remota (remote distribution panel). Ogni pannello di distribuzione remota disporrà di trentanove

posizioni polari per l’alimentazione dei rack dell’apparecchiatura e una posizione tripolare che

alimenterà, a sua volta, il pannello di distribuzione remota.

Ciascun quadro dovrà essere dimensionato in base ai seguenti valori nominali: 230V, trifase, in regime di

neutro dipendente dalla sorgente, 50Hz.

Per quanto riguarda l'installazione in testa dei cavi di alimentazione, il vendor dell'UPS fornirà adeguati cavi

monofase per collegare gli interruttori della distribuzione al rack fornito.

Ciascun cavo dovrà essere munito di una spina IEC 320-19 per l'inserimento in una PDU con gestione delle

singole porte di alimentazione (presa multipla) alloggiata nei rack forniti. La lunghezza dei cavi dipenderà

dalla lunghezza di ciascuna fila di rack.

La corrente di terra dovrà essere monitorata.

Monitoraggio tensione/corrente

- 36 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Ciascun interruttore della distribuzione deve comprendere in dotazione un trasformatore di

corrente integrato per monitorare la corrente che attraversa ciascun interruttore.

Lo stato e le condizioni della soluzione dovranno essere indicati da un'unità di

monitoraggio del controller di sistema fornita in dotazione.

Tra le condizioni monitorate figurano:

- Tensioni del sistema

- La corrente che attraversa gli interruttori della distribuzione.

Dovrà essere fornito uno switch a 32 porte per consentire il monitoraggio della rete e la

comunicazione tra la rete e i server di gestione del carico.

Per quanto riguarda l'installazione in testa, i cavi dati che si collegano allo switch a 32

porte dovranno essere forniti dal vendor dell'UPS. La lunghezza dei cavi dati dipende dalla

lunghezza di ciascuna fila di rack.

Tool HW/SW per la gestione del sistema

Un tool HW/SW dovrà essere in grado di permettere il monitoraggio del carico a livello di

singolo dispositivo, di riconoscere automaticamente tutti i componenti collegati e di

fornire una visione grafica dell’intera infrastruttura. In caso di allarme deve essere in grado

di effettuarne la notificazione via e-mail, via teledrin, e via SMS (qualora presente un

Gateway SMS). Gli allarmi debbono essere archiviati in file “log” con data e ora

dell’evento. Il sistema dovrà monitorare i seguenti componenti via Ethernet: Rack UPS,

RACK PDU, Strisce di Alimentazione contenute nei singoli Armadi Rack, Schede

Ambientali, Componenti Opzionali (come ATS e stazioni di energia in DC).

Parti meccaniche

La PDU, composta da MBS, due (2) quadri a 42 posizioni e dall'hub di rete e

monitoraggio, dovrà essere alloggiata in un rack 23" standard che presenta le specifiche

seguenti:

208cmH x 750cmL x 86cmP

Finito con polvere, colore nero

Acciaio laminato a freddo spessore 16

Armadio NEMA 1

- 37 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

Struttura con parte anteriore cieca

Munito di rotelle per favorire la mobilità. I piedini di livello sono forniti di dotazione

Ingresso cavi: dall'alto o dal basso.

Collegamenti

L’installazione dovrà comprendere:

la realizzazione dei collegamenti elettrici tra le Unità di distribuzione dell'alimentazione

(PDU) e ciascun armadio rack di carico. Tale collegamento dovrà essere realizzato

utilizzando cavo elettrico di caratteristiche e dimensioni adeguate al carico massimo che

ciascun rack potrà sopportare.

Il collegamento elettrico tra i Moduli gruppo di continuità (UPS) Trifase e il quadro

elettrico di zona. Tale collegamento dovrà essere realizzato utilizzando cavo elettrico di

caratteristiche e dimensioni adeguate al carico massimo che ciascuna soluzione UPS potrà

sopportare.

MODULO RACK ED ACCESSORI

Dovranno essere forniti ed installati n°6 Armadi Rack ed accessori aventi le seguenti

specifiche tecniche:

Specifiche Fisiche

Dimensione Rack, compatibilità del montaggio a rack, carico massimo supportato

Altezza

Interna

EIA310

Altezza

Esterna

Larghezza

Esterna

Profondità

Esterna

Carico

Statico

Carico

Dinamico

42U

19”

2070mm

600mm

1070mm

909 Kg

909 Kg

(81.5”)

(23.6”)

(42.1”)

(2000lbs)

(2000lbs)

- 38 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

L’altezza esterna del 42U è di 2070mm (81.5”) per facilitarne il passaggio attraverso una

porta standard 7 Ft. (84”).

Il carico statico supportato dovrà essere di almeno 909 Kg (peso supportato dalle ruote

orientabile e dai piedini di livellamento).

Il carico dinamico supportato dovrà essere di almeno 909 Kg (peso supportato dalle ruote

orientabile in movimento).

Accesso al carico e montaggio

L’armadio deve offrire 42U di spazio per il montaggio delle apparecchiature

I montanti verticali devono essere regolabili in profondità

Sia la porta frontale che posteriore devono possedere cardini a rilascio veloce per un

rapido e veloce smontaggio

Sia la porta frontale che posteriore devono poter essere aperte fino a 180° per un facile

accesso interno

La porta frontale deve essere reversibile in modo da essere aperta da entrambi i lati

La porta posteriore deve essere a due battenti verticali per rendere più agevole l’attività di

service

L’armadio deve possedere pannelli laterali removibili senza attrezzi migliorando l’accesso

per un veloce cablaggio dell’apparecchiature

Specifiche ambientali

L’armadio deve avere una protezione IP 20 contro il contatto, l’ingresso di corpi estranei e

l’introduzione d’acqua.

Specifiche di sicurezza

L’armadio deve rispondere alle specifiche meccaniche (stabilità, resistenza meccanica,

apertura porte, etc.) definite nel IEC 60950 Terza Edizione.

Ventilazione

- 39 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

L’armadio deve fornire una ventilazione che supera le specifiche della maggior parte dei

server vendor

L’armadio deve fornire una ventilazione per la porta frontale, la porta posteriore ed il tetto

come mostrata di seguito:

Altezza Interna

Larghezza

Esterna

Porta Frontale

Perforata

Porta Posteriore

Perforata

Tetto

Perforato

600mm

1070mm

5355 cm²

5413 cm²

1007 cm²

(23.6”)

(42.1.”)

(830 in²)

(839 in²)

(156 in²)

Canalizzazioni

Ogni Armadio Rack dovrà prevedere n°3 canalizzazioni sul tetto per la distribuzione

orizzontale dei cavi di alimentazione e dati.

Strisce di Alimentazione

In ogni Armadio Rack dovranno essere installate n°2 strisce di alimentazioni intelligenti da

32Amp installate nella parte posteriore dell’armadio senza occupare unità.

L’installazione deve poter essere effettuata senza attrezzi.

Deve essere composta da 24 prese di cui 20 IEC 320 C13 e 4 IEC 320 C19.

Corrente 32Amp, Potenza almeno 7KW.

È richiesto un amperometro digitale integrato con display.

È richiesto il monitoraggio via IP dell’assorbimento.

È richiesta l’allarmistica con soglie.

È richiesta la possibilità di comandare da remoto l’alimentazione delle singole prese

attraverso l’accensione e lo spegnimento della singola presa.

L’accesso al management delle strisce di alimentazioni intelligenti dovrà avvenire tramite

browser ed il management delle strisce di alimentazioni dovrà comunicare con il

management dell’infrastruttura.

- 40 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

MANAGEMENT dell’INFRASTRUTTURA CED

Tutti i componenti dell’Infrastruttura CED dovranno essere monitorati e gestiti via IP da un unico punto di

accesso chiamato Management dell’Infrastruttura CED.

Dovrà essere fornito un’unità di Management dell’Infrastruttura CED con almeno 25 licenze scalabili a

1000.

1.0 Specifiche Fisiche

1.1 Altezza 1U, larghezza 19”

2.0 Caratteristiche tecniche

2.1 Management centralizzato: configurazione e monitoraggio del Management

dell’Infrastruttura tramite un Web- browser da qualsiasi punto della rete.

2.2 Segnalazione guasti: dovrà effettuare il monitoraggio della corrente assorbita da ciascun

circuito derivato e dovrà segnalare potenziali situazioni di sovraccarico, garantendo la

disponibilità degli apparati collegati.

2.3 Diagramma di flusso dell’alimentazione: dovrà fornire dati storici relativi a ciascun

componente per individuare trend che potrebbero compromettere la disponibilità di apparati

critici.

2.3 Gestione a livello Rack: dovrà segnalare i Rack con minore assorbimento per consigliare dove

installare nuove apparecchiature senza sovraccaricare le linee di alimentazione.

Dovrà segnalare le variazioni di assorbimento elettrico a livello di singolo Rack

2.4 Gruppi di segnalazione: si potranno creare dei gruppi di segnalazione (lista di email) per allertare

e notificare via email più persone in merito allo stesso problema

2.5 Supporto di dispositivi multipli: al fine di gestire una vasta gamma di dispositivi tra cui UPS

monofase e trifase, unità di distribuzione dell'alimentazione, apparati di raffreddamento e gestione

ambientale.

- 41 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

2.6 Architettura scalabile: scalabile fino a 1000 dispositivi. Integrazione agevole di nuovi dispositivi

con licenze supplementari

2.7 Autodiscovery: dovrà identificare automaticamente tutti dispositivi dell’infrastruutura CED senza

interventi manuali con riduzione dei tempi di installazione.

2.10 Realizzazioni ed aggiornamenti concorrenti: al fine di diminuire la complessità e il

tempo di setup tramite la configurazione di impostazioni o l'aggiornamento del firmware

in contemporanea per dispositivi multipli

2.11 Logging dei dati: al fine di individuare situazioni potenzialmente pericolose prima

che nascano problemi o per esportare il data log a fini di analisi.

2.12 Logging degli eventi: l'event log dovrà ricostruire la tempistica e la sequenza degli eventi

che hanno provocato un incidente.

2.13

Report sullo stato delle batterie: dovrà fornire informazioni dettagliate sull'età delle

batterie, sul carico, sullo stato di funzionamento.

2.14

Private IP Network: per accedere a dispositivi multipli da un unico indirizzo IP

.

2.15 Accessibile via browser: dovrà visualizzare l'interfaccia utente attraverso un browser.

Per consentire un rapido accesso da qualsiasi punto della rete.

2.16 Allarmi innescati dal superamento delle soglie predefinite: per impostare

simultaneamente standard relativi ad alcuni parametri selezionati per UPS, distribuzione

elettrica e dispositivi di monitoraggio ambientale al fine di tenere sotto controllo la

performance del sistema

2.17 Azioni consigliate: dovrà fornire una descrizione dettagliata dei problemi nel momento in

cui si verificano sia una serie di interventi consigliati per risolvere il problema in

questione.

2.18 Wizard di setup: Wizard di facile utilizzo rendono più rapida la realizzazione riducendo il

tempo di set up.

2.19

Integrazione di Building Management Systsem: dovrà inviare allarmi ed informazioni per

- 42 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007

gestire infrastrutture critiche di Building Management da un singolo sistema.

2.20

Enterprise Management: dovrà gestire tutti dispositivi dell’infrastruttura via SNMP (trap

events) comunicando verso il sistema di Enterprise Management.

2.21

Password di sicurezza: la password di protezione dovrà essere selezionabile dall’utente.

2.22

Accesso di sola lettura: dovrà essere presente un'opzione di sola lettura per consentire di

condividere l'accesso senza rischiare modifiche non autorizzate alla configurazione dei

sistemi.

2.23

Encryption: al dine di ottenere un’accesso controllato ed integrazione con SSL browser e

sessioni SSH.

2.24

Supporto Radius: dovrà essere possibile utilizzare un esistente server radius al fine di

autenticare ed autorizzare un account per accedere ad uno dei dispositivi

dell’infrastruttura CED.

MODULO GESTIONE AMBIENTALE E SENSORI

Dovranno essere fornite, installate e configurate n°3 centraline di gestione ambientale via IP con altezza

1U e montaggio 19”.

Ogni centralina di gestione ambientale dovrà essere fornita con i seguenti sensori: n.°2 sensori di

temperatura ed umidità, n.°1 sensori di controllo fumi all’interno dell’armadio Rack Server, n.°1 sensori

anti-allagamento lunghezza almeno 6 m, n.°1 lampeggiante posizionato sul tetto dei Rack, n.°1 sensore

apertura porta Rack Server, n°1 sensore vibrazioni

La centralina dovrà ospitare i seguenti contatti per future integrazioni: fino a n.°4 sensori temperatura ed

umidità, sensore movimento tra le file degli armadi Rack.

n.° 4 contatti puliti disponibili

Il management della centralina di gestione ambientale dovrà essere accessibile tramite browser. Il

management della centralina di gestione ambientale dorà essere integrato con il management

dell’Infrastruttura esistente.

MODULO SISTEMA DI CONDIZIONAMENTO AMBIENTALE

Premessa

- 43 -

PROGETTAZIONE ED

IMPLEMENTAZIONE

DELL’INFRASTRUTTURA

DI PRODUZIONE

Doc. Identifier:

File: PI2S2-D1.2-v1.0

Date: 31.01.2007