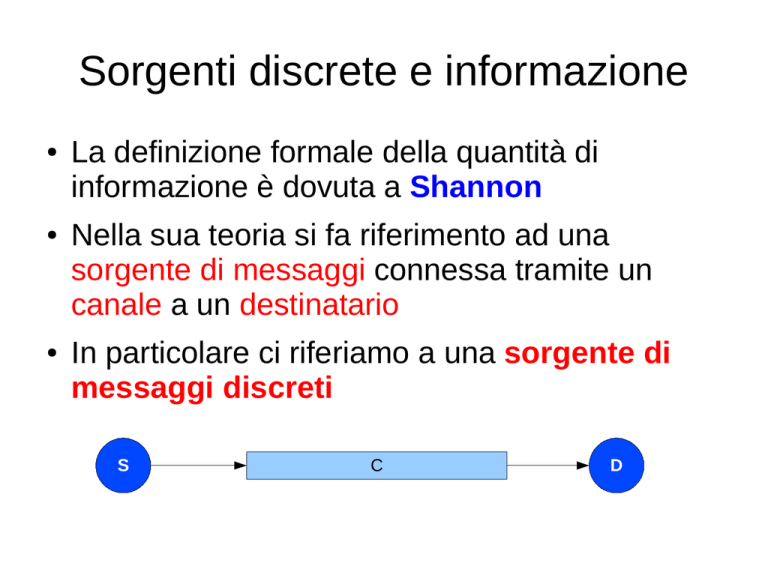

Sorgenti discrete e informazione

●

●

●

La definizione formale della quantità di

informazione è dovuta a Shannon

Nella sua teoria si fa riferimento ad una

sorgente di messaggi connessa tramite un

canale a un destinatario

In particolare ci riferiamo a una sorgente di

messaggi discreti

S

C

D

Sorgenti discrete e informazione

●

●

Nel modello preso in considerazione da

Shannon una sorgente discreta è in grado di

emettere dei simboli appartenenti ad un

insieme A detto alfabeto della sorgente

Un messaggio m emesso dalla sorgente è una

concatenazione di simboli dell'alfabeto

A

S

m = sk1 sk2 ... skM

s1,s2 .. sN

|A|=N è la cardinalità

dell'alfabeto

|m| = M è la lunghezza

del messaggio

Sorgenti discrete e informazione

●

L'informazione associata ai simboli emessi dalla

sorgente viene definita facendo riferimento alla

diminuzione dell'incertezza in seguito alla

ricezione di un simbolo dell'alfabeto o in altri

termini alla sorpresa che provoca la ricezione

di un simbolo della sorgente

A

S

s1,s2 .. sN

m = sk1 sk2 ... skM

Sorgenti discrete e informazione

●

●

●

E' necessario quindi fare riferimento alle

caratteristiche statistiche della sorgente

Più un simbolo viene emesso raramente e

maggiore è la sorpresa che provoca nel

ricevitore e maggiore è la quantità di

informazione che trasporta

Al contrario un simbolo emesso

frequentemente porta poca informazione

(non è sorprendente aspettarsi l'emissione di

questo simbolo)

Sorgenti discrete e informazione

●

Una sorgente che emette un solo simbolo, non

fornisce alcuna informazione

–

se una moneta ha una faccia truccata (più pesante)

ci si può aspettare dal lancio che questa faccia

esca più frequentemente (poca informazione) e di

conseguenza nel caso in cui esca l'altra ne

saremmo maggiormente sopresi (più informazione)

–

una vincita al super enalotto ci sorprenderebbe

parecchio (oltre che renderci felici!) visto che si

tratta di un evento raro (relativamente ad un

giocatore)

Sorgenti discrete e informazione

●

E' naturale allora misurare la sorpresa e quindi

l'informazione riferendosi alla probabilità di

emissione di un simbolo

p(sk) = pk = probabilità di emissione di sk

●

●

Nel modello di Shannon la sorgente è

rappresentata da un'urna contenente delle

palline corrispondenti ai simboli dell'alfabeto

La composizione dell'urna è determinata dalle

probabilità di emissione dei simboli dell'alfabeto

Sorgenti discrete e informazione

●

●

●

●

Se un simbolo sk ha probabilità pk di essere

emesso il numero delle palline corrispondenti è

pari a pk · Np dove Np è il numero totale di

palline dell'urna

L'emissione di un simbolo corrisponde

all'estrazione di una pallina dall'urna

Le emissioni dei simboli sono indipendenti

l'una dall'altra

Dopo ogni estrazione la pallina viene rimessa

nell'urna

Sorgenti discrete e informazione

●

●

Questo modello consente di assimilare ad una

sorgente discreta, non solo apparati che

trasmettono informazioni nello spazio, ma

anche testi (visti come successione di simboli),

immagini ecc.

I risultati della teoria dell'informazione sono

quindi applicabili sia a problemi di

trasmissione (aumento della velocità di

trasmissione) che a problemi di

memorizzazione delle informazioni

(compressione dei dati)

Sorgenti discrete e informazione

●

●

L'ipotesi di considerare i simboli emessi in

modo indipendente l'uno dall'altro non è molto

aderente alla realtà.

–

es. nella lingua italiana dopo la lettera q si incontra

quasi sempre la lettera u (tranne che nella parola

soqquadro)

–

in un brano di musica di genere ad es. rock'n roll la

sequenza degli accordi segue degli schemi

abbastanza prevedibili (es. do - fa – sol)

La trattazione matematica risulta semplificata

Definizione quantitativa di

informazione

●

Secondo Shannon la definizione di quantità di

informazione deve rispettare i seguenti vincoli

(assiomi)

–

L'informazione I(sk) associata ad un simbolo sk sarà

una funzione di pk probabilità di emissione di sk

–

Minore il valore di pk e maggiore sarà I(sk) e

viceversa

–

L'informazione associata ad un messaggio m deve

essere la somma delle informazioni di ciascun

simbolo che lo compone

Definizione quantitativa di

informazione

●

Considerando che la probabilità di un

messaggio m formato da M simboli è pari al

prodotto delle probabilità di ogni simbolo (per

l'indipendenza delle emissioni)

I sk =f

I m=f

1

pk

1

1

1

1

=f

=f

⋅⋯

pm

p k1⋅⋯ pkM

p k1

pkM

1

1

I m=I s k1 ⋯I skM =f

⋯f

p k1

p kM

quindi

1

1

1

1

f

⋅⋯

=f

⋯f

pk1

p kM

pk1

p kM

Definizione quantitativa di

informazione

●

Una funzione che trasformi un prodotto in una

somma è il logaritmo

1

1

I s k =f

=log b

pk

pk

●

L'unità di misura è il bit e per individuare la

base b del logaritmo si deve definire la

situazione in cui un simbolo ha informazione

pari ad 1 bit.

Definizione quantitativa di

informazione

●

La situazione di riferimento è quella della

sorgente più semplice possibile (in pratica il

lancio di una moneta):

–

A={0,1} alfabeto di due simboli

–

p0 = p1 = 0.5

1

I 0=I 1=log b

= log b 2=1

0.5

1

b =2

b=2

Definizione quantitativa di

informazione

●

Es. una moneta truccata ha:

–

pT = 0.6 e pC = 0.4

1

=0.737 bit

0.6

1

I C =log 2

= 1.322 bit

0.4

I T =log 2

–

come era da aspettarsi il simbolo più probabile (T)

porta meno informazione

Entropia di una sorgente

●

Per caratterizzare complessivamente la

sorgente possiamo considerare il valore medio

dell'informazione portata da un simbolo emesso

effettuando la media ponderata delle

informazioni (la somma delle probabiltà è 1)

N

N

k =1

k=1

H =∑ pk⋅I s k =−∑ p k⋅log 2 p k bit/simbolo

●

Tale grandezza viene chiamata Entropia della

sorgente

Entropia di una sorgente

●

Es. nel caso della moneta non truccata:

2

H =∑ p k⋅I s k = 0.5⋅10.5⋅1 = 1 bit/simbolo

k=1

●

Per la moneta truccata:

2

H =∑ p k⋅I s k = 0.6⋅0.7360.4⋅1.322 = 0,970 bit/simbolo

k=1

Entropia di una sorgente

●

Il significato profondo di questa grandezza è

che se misuriamo la quantità media di

informazione di un messaggio di M caratteri

emesso dalla sorgente è pari:

I m=M⋅H bit

–

es. un messaggio di 1000 simboli di una sorgente

con entropia pari a 0.970 bit/simb ha associata in

media un'informazione pari a 970 bit

Entropia di una sorgente

●

Questo vuol dire che è possibile trovare una

codifica univocamente decifrabile dei simboli

della sorgente tale che un messaggio di M

simboli sia rappresentabile con H·M binit (cifre

binarie)

–

es. nel caso della moneta truccata, si può trovare

una codifica in base alla quale 1000 lanci di moneta

siano rappresentabili con 970 cifre binarie anziché

le 1000 necessarie nella rappresentazione T=0 e

C=1

Entropia di una sorgente

●

Es.

Alfabeto={A,B,C,D}

pA=0.60

I(A)=-log2(0.60)=0.737 bit

pB=0.20

I(B)=-log2(0.20)=0.301 bit

pC=0.15

I(C)=-log2(0.15)=2.737 bit

pD=0.05

I(D)=-log2(0.05)=4,322 bit

H=0.6·0.737 + 0.2·0.301+0.15·2.737+0.05·4.322=

=1.129 bit/simb

Entropia di una sorgente

●

Il significato è questo:

–

se codifico la sorgente banalmente (4 simboli=2

binit a simbolo) un messaggio di es. 1000 simboli

occuperà 2000 binit;

–

esiste una codifica che consente di rappresentare

in media un messaggio di 1000 simboli con 1129

binit anziché 2000 (quasi la metà!)

–

non è conveniente dare lo stesso peso (stessa

lunghezza di rappresentazione) ad A che esce il

60% delle volte e a D che esce il 5% delle volte

...

Entropia di una sorgente

...

●

–

se il messaggio verrà trasmesso si impiegherà poco

più della metà del tempo

–

se il messaggio deve essere memorizzato si

occuperà poco più della metà della memoria

–

converrà rappresentare con meno binit i simboli più

frequenti

La codifica cercata è la codifica di Huffman

Entropia di una sorgente

●

Una sorgente con N simboli equiprobabili avrà

la massima entropia tra le sorgenti di N simboli:

N

N

1

1

H =∑ p k⋅log2

= ∑ ⋅log 2 N =

pk

k=1

k =1 N

1

= N⋅ ⋅log 2 N = log 2 N bit/simbolo

N

●

Si definisce ridondanza della sorgente:

H

R = 1−

H MAX