LATEX

by Alejo ;-)

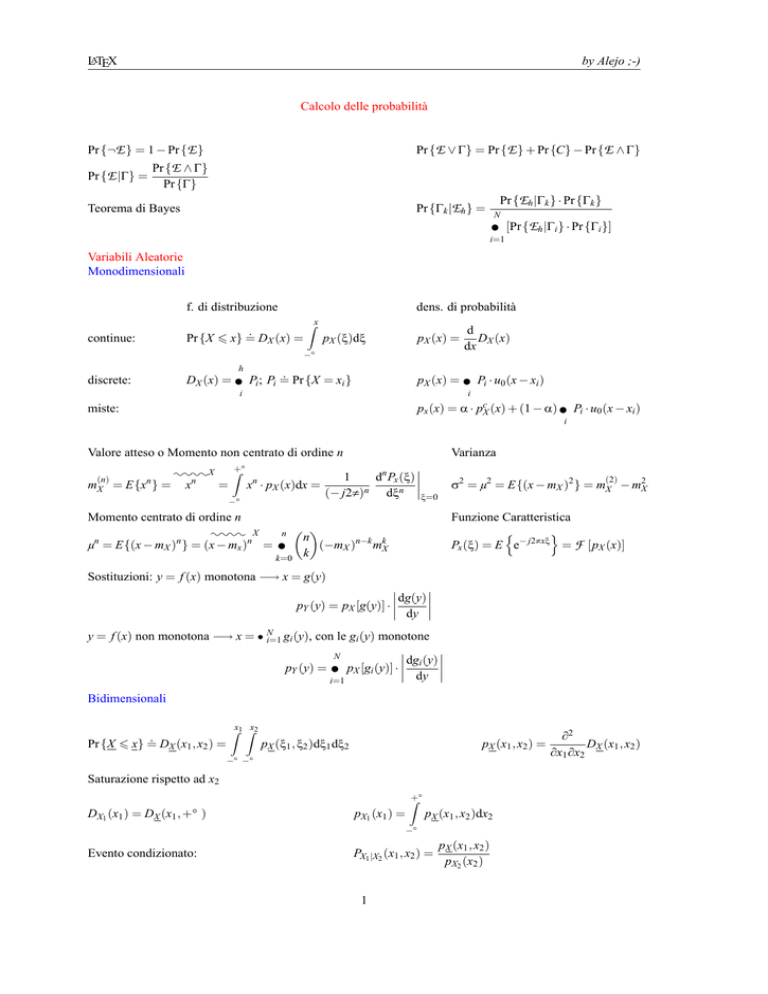

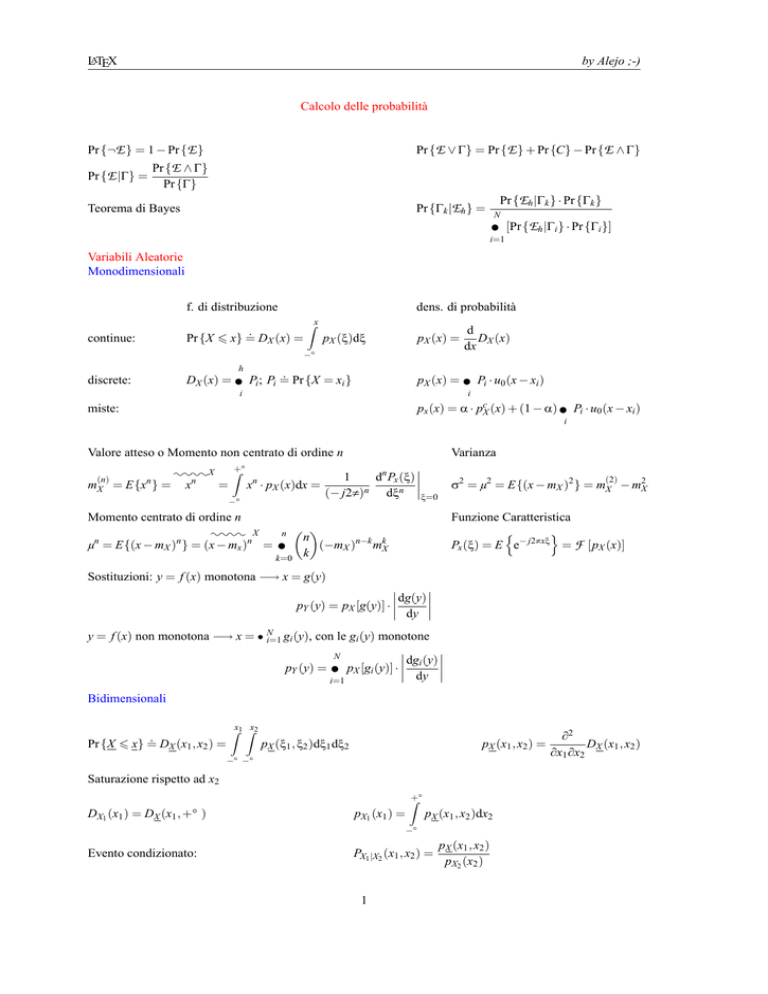

Calcolo delle probabilità

Pr {E ∨ Γ} = Pr {E } + Pr {C} − Pr {E ∧ Γ}

Pr {¬E } = 1 − Pr {E }

Pr {E |Γ} =

Pr {E ∧ Γ}

Pr {Γ}

Pr {Γk |Eh } =

Teorema di Bayes

Pr {Eh |Γk } · Pr {Γk }

N

∑ [Pr {Eh |Γi } · Pr {Γi }]

i=1

Variabili Aleatorie

Monodimensionali

f. di distribuzione

continue:

dens. di probabilità

.

Pr {X 6 x} = DX (x) =

Zx

pX (ξ)dξ

pX (x) =

−∞

h

discrete:

.

DX (x) = ∑ Pi ; Pi = Pr {X = xi }

d

DX (x)

dx

pX (x) = ∑ Pi · u0 (x − xi )

i

i

px (x) = α · pcX (x) + (1 − α) ∑ Pi · u0 (x − xi )

miste:

i

Valore atteso o Momento non centrato di ordine n

(n)

mX = E{xn } =

::::X

xn

=

Varianza

Z+∞

−∞

dn Px (ξ) 1

n

x · pX (x)dx =

(− j2π)n dξn ξ=0

Momento centrato di ordine n

:::: X

µn = E{(x − mX )n } = (x − mx )n =

(2)

σ2 = µ2 = E{(x − mX )2 } = mX − m2X

Funzione Caratteristica

n

o

Px (ξ) = E e− j2πxξ = F [pX (x)]

n

n

∑ k (−mX )n−k mkX

k=0

Sostituzioni: y = f (x) monotona −→ x = g(y)

dg(y) pY (y) = pX [g(y)] · dy y = f (x) non monotona −→ x = ∑Ni=1 gi (y), con le gi (y) monotone

N

dgi (y) pY (y) = ∑ pX [gi (y)] · dy i=1

Bidimensionali

.

Pr {X 6 x} = DX (x1 , x2 ) =

Zx1 Zx2

pX (ξ1 , ξ2 )dξ1 dξ2

pX (x1 , x2 ) =

−∞ −∞

Saturazione rispetto ad x2

Z+∞

DX1 (x1 ) = DX (x1 , +∞)

pX1 (x1 ) =

pX (x1 , x2 )dx2

−∞

Evento condizionato:

PX1 |X2 (x1 , x2 ) =

1

pX (x1 , x2 )

pX2 (x2 )

∂2

DX (x1 , x2 )

∂x1 ∂x2

LATEX

by Alejo ;-)

Momento non centrato di ordine (h, k):

(h,k)

mX

n

o Z+∞Z+∞

h k

= E x1 · x2 =

x1h · x2k pX (x1 , x2 )dx1 dx2

−∞ −∞

(h,0)

mX

(h)

(0,k)

= mX1

(k)

= mX2

n

o

µ(h,k) = E (x1 − mX1 )h (x2 − mX2 )k

mX

Momenti centrati di ordine (h, k):

(1,1)

(1,1)

σ1,2 = µX = mX

σ1,2

ρ1,2 =

σ1 · σ2

covarianza:

Coefficiente di correlazione:

Cambiamento di variabile aleatoria

(

y1 = f1 (x1 , x2 )

y2 = f2 (x1 , x2 )

(

x1 = g1 (y1 , y2 )

x2 = g2 (y1 , y2 )

=⇒

pY (y1 , y2 ) = pX [g1 (y1 , y2 ), g2 (y1 , y2 )] ||J(y1 , y2 )||

Matrice di Covarianza:

σ1,1

σ2,1

..

.

σn,1

− mX1 · mX2

J(y1 , y2 ) =

σ1,2

σ2,2

..

.

···

···

..

.

σn,2

···

σi, j = E (xi − mxi )(x j − mx j )

∂g1

∂y1

∂g1

∂y2

∂g2

∂y1

∂g2

∂y2

!

σ1,n

σ2,n

..

.

σn,m

σi, j = σ j,i

σii = σ2Xi

Indipendenza Statistica

Se E e Γ sono statisticamente indipendenti allora:

Pr {E |Γ} = Pr {E }

Pr {Γ|E } = Pr {Γ}

Pr {E ∧ Γ} = Pr {E } · Pr {Γ}

pX (x1 , x2 ) = pX1 (x1 ) · pX2 (x2 )

DX (x1 , x2 ) = DX1 (x1 ) · DX2 (x2 )

(h,k)

mX

µX

(h)

(k)

= mX1 · mX2

(h,k)

(h)

(k)

= µX1 · µX2

Combinazione lineare di n variabili aleatorie

Y = a1 · X1 + a2 · X2 + . . . + an · Xn

1

y

y

y

pY (y) =

pX

∗ pX2

∗ . . . ∗ pXn

|a1 · a2 . . . an | 1 a1

a2

an

n

n

n

n

σY2 = ∑ ∑ ai · a j · σXi X j =−−−−→ ∑ a2i · σ2Xi

i=1 j=1

stat. ind.

mY = ∑ ai · mXi

i

i

2

LATEX

by Alejo ;-)

Gaussiana

Monodimensionale

1

x − mX

DX x = 1 − erfc √

2

2σ

(x−mX )2

1

pX (x) = √

e− 2σ

2π σ

(n)

µX

(

0

=

1 · 3 · 5 · (n − 1)σnX

, n dispari

, n pari

n-dimensionale

pX (x) =

(2π)n/2

1

T −1

exp − (x − mX ) KX (x − mX )

2

det [Kx ]

1

p

F [pX (x)] = PX ( f ) = e− j2πξ

(1,1,1,1)

µX

(1,1,1)

(1,1,1,1)

mX −2πξT Kx ξ

e

= E {(x1 − mX1 )(x2 − mX2 )(x3 − mX3 )(x4 − mX4 )} = σX1 X2 · σX3 X4 + σX1 X3 · σX2 X4 + σX1 X4 σX2 X3

µX

mX

T

= E {(x1 − mX1 )(x2 − mX2 )(x3 − mX3 )} = 0

:::: X1 ,X2 ,X3 ,X4 ::::X1 ,X2 ::::X3 ,X4 ::::X1 ,X3 ::::X2 ,X4 ::::X1 ,X4 ::::X2 ,X3

= x1 x2 x3 x4

= x1 x2

· x3 x4

+ x1 x3

· x2 x4

+ x1 x4

· x2 x3

Bidimensionale

pX,Y (x, y) =

2πσX σY

1

p

1 − ρ2

exp −

(x − mX )2 2ρ(x − mX )(y − my ) (y − mY )2

1

−

+

2(1 − ρ2 )

σX σY

σY

σ2X

Variabili aleatorie condizionate

mX|Y = mX + ρ

σX

(y − my )

σY

σ2X|Y = σX (1 − ρ2 )

Distribuzione di Bernouilli

pX (x) = P0 · u0 (x) + P1 · u0 (x − 1)

B = X1 + X2 + . . . + Xn

n

n

n!

=

l

l!(n − l)!

mB = n · P1

σ2B = n · P0 · P1

n n−l l

pB (b) = ∑

P0 · P1 · u0 (b − l)

l=0 l

3