Hardware e software

01

In questo capitolo

Approfondirai le tue conoscenze sull’hardware. Esaminerai per esempio i componenti

interni di un computer, le porte FireWire, le schede di acquisizione audio/video, le

schede grafiche, le videocamere, i monitor CRT e LCD. Approfondirai anche alcuni

aspetti legati al software come i formati di compressione.

I sistemi hardware e software

Introduzione

In questi ultimi anni, si è registrata una rapidissima evoluzione di tutti i componenti

di un PC, legata principalmente alle richieste sempre più esigenti del mercato software. Nella scelta non facile del PC diventa perciò fondamentale individuare il campo

di applicazione principale dello stesso. Se da una parte il PC si può considerare costituito da una serie di componenti fondamentali, dall’altra la capacità di soddisfare

le esigenze specifiche dell’utente è possibile solo grazie alla possibilità di espandere le

potenzialità di base con dispositivi ad hoc mediante i quali il PC assume una precisa

connotazione.

Nei paragrafi successivi verranno analizzati perciò i componenti fondamentali che

costituiscono un PC, ma verrà data particolare enfasi ai componenti dedicati alla gestione del video.

I componenti interni di un computer

All’interno del computer si possono individuare cinque tipologie principali di componenti: memoria RAM, memoria ROM, processore, hard disk e schede di espansione.

Questi componenti sono connessi tra di loro attraverso la scheda madre, che consente

inoltre il collegamento tra questi componenti e i cosiddetti dispositivi di input e di output. Il funzionamento del computer si basa sul continuo rapidissimo trasferimento di

segnali elettrici fra questi componenti e fra gli stessi e le periferiche esterne. Propagandosi fra i milioni di circuiti che compongono il computer questi segnali attivano /disattivano continuamente altri circuiti producendo nuovi segnali che vanno a comandare

altre parti, e così via per centinaia di milioni di volte ogni secondo.

1

C A P I TO L O

01

I dispositivi di input/output più comuni sono: tastiera, mouse, monitor, lettore CDRom e floppy, stampante e audio (casse, microfono), modem, masterizzatore, scanner, videocamera ecc.; alcuni dei dispositivi di I/O, per poter essere collegati alla

macchina, richiedono la presenza di una scheda di espansione inserita all’interno del

computer (figura 1.1).

Figura 1.1

Dispositivi di Input/Output

La scheda madre, o motherboard in inglese, è uno dei componenti fondamentali di un

personal computer; sulla scheda madre sono connessi tutti gli altri componenti, dal

processore di sistema alla scheda video, passando per hard disk ed eventuali ulteriori

periferiche (figura 1.2).

Figura 1.2

Una scheda madre

2

Hardware e software

Il microprocessore (figura 1.3), sinteticamente chiamato CPU (dall’inglese Central

Processing Unit), è il cuore del computer in quanto è adibito allo svolgimento delle

funzioni più importanti dell’elaboratore elettronico. La CPU ha la funzione di eseguire

i programmi contenuti nella memoria centrale prelevando, decodificando ed eseguendo le istruzioni che li costituiscono. Le caratteristiche principali di una CPU sono:

• la frequenza di funzionamento: è la frequenza alla quale lavorano i processori, cioè

il quantitativo di operazioni che ogni processore è in grado di eseguire in un secondo;

• la memoria interna: generalmente di pochi KB è detta cache L1 e L2 ed è una particolare memoria di tipo statico molto veloce per la memorizzazione delle informazioni più ricorrenti;

• il tipo di collegamento con la scheda madre: a ogni tipologia di connettore (Socket

7, Slot 1, Socket 370, Slot A, Socket A, Socket 478) corrisponde un particolare

gruppo di processori che possono essere utilizzati.

Figura 1.3

Un microprocessore o CPU

La memoria RAM (Random Access Memory) (figura 1.4) è uno dei componenti fondamentali nel funzionamento di un personal computer. È la memoria dove vengono

conservati i dati in corso di elaborazione (i documenti aperti) e le istruzioni del programma in esecuzione; si tratta di una memoria temporanea che si cancella completamente quando si spegne il computer. Le schede madri possono montare differenti tipi

di memoria di sistema, a seconda del chipset da esse utilizzato.

• Moduli SIMM: è un tipo di memoria a 32 bit ed è quella di più vecchia concezione.

• SDRAM PC66: è il primo tipo di memoria SDRAM pensato per la frequenza di

lavoro di 66 MHz ed è caratterizzato dalla presenza di 168 pin o contatti.

• SDRAM PC100: pensato per un impiego alla frequenza di 100 MHz (da questo la

sigla PC100), in genere vede l’impiego di moduli memoria da 10 oppure 8 ns.

• SDRAM PC133: evoluzione della memoria PC133, come il nome suggerisce facilmente è pensata per il supporto ufficiale alla frequenza di 133 MHz. Questo tipo di

memoria utilizza chip da 7.5 oppure 7 ns.

• DDR (Double Data Rate): questa tecnologia, introdotta per la prima volta nelle

memorie delle schede video, permette di raddoppiare la bandwidth della memoria

a disposizione in quanto vengono utilizzati entrambi i fronti di clock (ascendente

e discendente).

3

C A P I TO L O

01

• Rambus: questo nuovo standard per le memorie è stato introdotto da Intel per sistemi basati su CPU Pentium IV. Esistono tre differenti varianti di questa memoria

che prendono il nome di PC600, PC700 e PC800.

Figura 1.4

(a) Modulo memoria SDRAM PC133, da 64 Mbyte di capacità; (b) Modulo memoria DDR-SDRAM

PC2100, da 128 Mbyte di capacità; (c) Modulo memoria Rambus, PC800, da 128 Mbyte di capacità

L’hard disk (figura 1.5) ha quale compito principale la memorizzazione e la conservazione dei dati. Negli hard disk i dati sono scritti sulla superficie di un disco, chiamato

piatto, in forma magnetica; la testina, una per ogni faccia del piatto, permette di scrivere i dati proprio come se fosse la testina di un giradischi, senza però che avvenga un

contatto fisico tra le due parti. I dati memorizzati nell’hard disk sono organizzati per

cilindri, tracce e settori: i cilindri sono tracce concentriche poste sulla superficie del

piatto, e ogni traccia è divisa in settori. Negli hard disk, a causa della loro sempre più

elevata capienza, possono trovarsi più piatti e ogni loro faccia è dotata di testina; ogni

hard disk ha dei settori riservati per le informazioni, che vengono utilizzate automaticamente in caso di malfunzionamento. Le caratteristiche tecniche dell’hard disk sono:

• il tipo di interfaccia con la scheda madre, che può essere di vari tipi: EIDE SATA, o

SCSI. Rispetto alla EIDE, la SCSI e la SATA sono interfacce decisamente più “professionali”. La grande potenza dello SCSI sta nel fatto che le diverse periferiche possono utilizzare il bus SCSI anche contemporaneamente, mentre con un controller

EIDE due unità collegate allo stesso canale non possono occupare il bus contemporaneamente;

4

Hardware e software

• la velocità di rotazione: più è elevata, maggiore sarà il numero di dati letti a parità

di tempo; gli hard disk EIDE hanno in genere velocità massima pari a 7.200 giri al

minuto, mentre quelli SCSI e SATA arrivano a 15.000 giri al minuto;

• il tempo di accesso ai dati: indica il tempo necessario alla meccanica dell’hard disk

per accedere ai dati memorizzati; più è basso, migliori saranno le prestazioni;

• il buffer: è una piccola memoria interna all’hard disk che memorizza alcuni dati

letti dalla testina ma non ancora inviati alla CPU per essere elaborati; permette di

velocizzare le operazioni e, più è grande, migliori saranno le prestazioni;

• il transfer rate: indica la velocità con la quale un hard disk legge i dati; in genere viene riportata la velocità massima che l’hard disk può sviluppare, ma questa in genere

è raggiunta solo in condizioni particolari.

Figura 1.5

Un hard disk

BIOS (Basic Input/Output System): è un componente che fa parte integrante della

scheda madre. Il suo scopo è quello di gestire la fase d’accensione del computer. Il

BIOS conserva in una ROM la sequenza d’istruzioni di avvio che viene eseguita automaticamente a ogni accensione del computer. L’operazione di avvio è detta boot e

passa per tre fasi successive:

• test di funzionamento del sistema (verifica dell’hardware);

• attivazione dell’hardware installato;

• verifica della presenza del sistema operativo e suo caricamento.

ROM (Read Only Memory): contrariamente alla RAM, la memoria ROM non esiste in

forma di componente separato e individuale, esistono invece numerose piccole ROM

incorporate all’interno dei vari circuiti integrati (sulla scheda madre, sulle schede

d’espansione ecc.) come nel BIOS.

Le schede di espansione sono schede che espandono le funzioni della scheda madre

per pilotare dispositivi interni o esterni. La più importante è la scheda video su cui

si connette il monitor. Molto diffusa, sebbene non strettamente necessaria per il funzionamento della macchina, è anche la scheda audio, attraverso cui il computer è in

grado di produrre o registrare suoni. Per le connessioni dirette alla rete (senza modem) occorre invece dotarsi di una scheda di rete. Infine la scheda SCSI consente di

pilotare dispositivi che richiedono una particolare velocità nel trasferimento dei dati.

Esistono poi numerosi altri tipi di schede, create per funzioni particolari, quali per

esempio la scheda di acquisizione video per collegarsi alla televisione, a un videoregistratore o a una videocamera, e molte altre ancora di uso specialistico.

5

C A P I TO L O

01

I dispositivi di Input/Output

I dispositivi di I/O, o di Ingresso/Uscita, o periferiche esterne sono tutti quegli apparecchi che servono per il trasferimento di dati e informazioni fra il computer e il

mondo esterno. Molti dispositivi sono collegati al computer dall’esterno (attraverso le

porte di I/O), ma talvolta alcuni possono essere inseriti all’interno del computer stesso: per esempio il modem può avere la forma di una scheda di espansione.

La tastiera si collega a una porta tipo PS/2 appositamente dedicata.

Le tastiere moderne (dette “estese”, per contrasto con un vecchio tipo “standard”) possiedono 101 tasti (o 104 se adattate per Windows), divisi in 4 gruppi (figura 1.6).

Figura 1.6

I 4 gruppi della tastiera

La tastiera “base” è quella inglese che però non contiene le lettere accentate (perché in

inglese non si usano), per questo motivo in molti paesi sono state adottate delle tastiere nazionali, sacrificando alcuni simboli poco usati come le parentesi graffe {} e la tilde

~ (presenti nella tastiera inglese) per sostituirli con simboli propri dell’ortografia nazionale. In Italia, per esempio, si usa una tastiera con le lettere accentate minuscole.

In commercio si trovano anche modelli di tastiere ergonomiche, studiate per il comfort

dell’utente (durezza dei tasti, sagomatura, inclinazione ecc.) in modo da ridurre al

minimo l’affaticamento delle dita e dei polsi. Naturalmente le tastiere ergonomiche

costano molto di più di quelle normali (figura 1.7).

Figura 1.7

Una tastiera ergonomica

6

Hardware e software

Il mouse fu introdotto assieme ai sistemi operativi di tipo grafico (Macintosh, Windows

ecc.) per semplificare l’invio dei comandi alla macchina, comandi che in precedenza venivano impartiti unicamente attraverso la tastiera. Lo spostamento del mouse controlla il

movimento di un puntatore sullo schermo, mentre i tasti inviano il comando. I mouse per

Macintosh possiedono un unico tasto, quelli per Windows due o tre tasti (figura 1.8).

Figura 1.8

Un mouse

In alternativa al mouse, la trackball ne usa lo stesso meccanismo, avendo però la biglia

sul lato superiore invece che sul lato inferiore (figura 1.9). Il movimento del cursore

sullo schermo si comanda muovendo la biglia con le dita senza spostare la trackball.

In questo modo non occorre lo spazio che serve invece per muovere il mouse. Lo

svantaggio è una certa scomodità d’uso (minore precisione e rapido affaticamento delle dita), oltre a una maggiore tendenza a raccogliere polvere e sporcizia. La trackball è

usata soprattutto sui portatili (che devono essere utilizzabili in ogni condizione, anche

quando non c’è spazio per muovere un mouse), sebbene nei modelli recenti sia stata

sostituita dalla touch pad, un’area rettangolare sensibile al tocco delle dita.

Figura 1.9

Una trackball

Quando si deve usare il computer per disegni di precisione (tecnici o artistici) il mouse è uno strumento del tutto inadeguato perché troppo difficile da controllare. Per

questi casi esiste la tavoletta grafica, che comanda il cursore sullo schermo facendo

uso di uno speciale stilo su un piano sensibile, esattamente come fosse una matita su

un foglio di carta (figura 1.10). Serve solo con i programmi di grafica avanzata.

7

C A P I TO L O

01

Figura 1.10

Una tavoletta grafica

I masterizzatori (figura 1.11) sono dispositivi usati per la scrittura su CD o DVD (il disco

deve essere tale da consentire la scrittura, altrimenti il masterizzatore non funziona). Funzionano anche come normali lettori di CD o DVD. Tipicamente sono inseriti all’interno

del computer e presentano uno sportello come i lettori CD/DVD, ma esistono anche dei

modelli esterni che si collegano al computer con un cavo. Come gli HD (e altri dispositivi) esistono masterizzatori EIDE (più economici) e masterizzatori SCSI (più veloci).

Figura 1.11

Un masterizzatore

Gli Zip (figura 1.12) sono dispositivi simili ai drive floppy che usano un disco speciale

(disco Zip) di capacità 70-170 volte superiore a quella dei normali floppy disk. Sono usati come “backup” (copie di sicurezza di grandi quantità di dati o documenti), oppure per

trasferire grandi quantità di dati fra computer diversi. Esistono sia drive esterni collegati

con un cavo, sia drive fissi inseriti all’interno del computer come quelli del floppy e del

CD/DVD. Sia i dischi sia i drive sono prodotti esclusivamente da Iomega.

Figura 1.12

Uno Zip Iomega

8

Hardware e software

Lo scanner (figura 1.13) è un dispositivo che consente di acquisire testo e immagini

stampate su carta per trasferirli all’interno del computer. I modelli più versatili consentono anche l’acquisizione direttamente da diapositiva o da negativo fotografico.

Somigliano a piccole fotocopiatrici. Gli scanner migliori usano la tecnologia SCSI per

collegarsi al computer.

Figura 1.13

Uno scanner

I modem (figura 1.14) si usano per la trasmissione e ricezione di dati attraverso la

linea telefonica e in particolare per la connessione a Internet. I modem possono essere esterni al computer (collegati con un cavo) oppure interni (in forma di scheda di

espansione), ma in quest’ultimo caso presentano spesso problemi di incompatibilità

col resto dell’hardware. La velocità con cui i modem sono in grado di scambiare i dati

si misura in Kbit/secondo (Kbps) ovvero il numero di bit che il modem riesce a trasferire in un secondo. Esistono quattro tipi principali di modem, a seconda del tipo di

linea telefonica disponibile: standard, ISDN, ADSL e GSM. I modem standard esterni

si collegano al PC attraverso la porta seriale.

Figura 1.14

Un modem ADSL

9

C A P I TO L O

01

Le videocamere vengono usate per catturare immagini da elaborare o da trasmettere.

Si va da videocamere professionali per riprese di alta qualità, a piccole videocamere

dette webcam (figura 1.15) usate per trasmettere riprese video attraverso la rete.

Figura 1.15

Una Webcam

I monitor

Il monitor rappresenta l’interfaccia di output per eccellenza e quindi il mezzo attraverso il quale possiamo visualizzare in modo diretto tutto quello che “succede” sul nostro

personal computer.

Attualmente i monitor presenti sul mercato sono i tradizionali monitor CRT, oppure

quelli LCD-TFT, e per ognuna di queste famiglie esiste un’ampia varietà di prodotti

che si differenziano per dimensioni, risoluzioni massime raggiunte, dispositivi opzionali quali porte USB, oppure Kit multimediali e altro ancora.

Monitor CRT

I monitor CRT (Cathode Ray Tube), cioè costituiti da un tubo a raggi catodici, sono

tutt’oggi i più diffusi in campo informatico (figura 1.16). Questa tecnologia costruttiva

risale a parecchie decine di anni fa, esattamente al 1897 per opera dello scienziato tedesco Ferdinand Braun.

Figura 1.16

Schema di un tubo CRT

10

Hardware e software

I monitor CRT si sviluppano attorno al loro componente fondamentale, cioè il sopra

citato tubo catodico, e l’evoluzione tecnologica di questo componente ha caratterizzato

anche l’evoluzione delle periferiche che lo adottano. L’offerta di mercato in questo settore è decisamente ampia e possiamo trovare sia periferiche con i “classici e tradizionali”

tubi catodici, quelli che da sempre hanno caratterizzato i relativi monitor, sia quelle con

tubi piatti, oppure corti, più recenti ed evoluti. Ovvio che l’introduzione di nuove tecnologie come quelle che caratterizzano le unità a tubo piatto (flat screen), o corto (short

neck), hanno comportato la riduzione di prezzo delle periferiche standard.

Un monitor CRT è semplicemente costituito da un tubo di vetro nel quale si realizza il

vuoto, cioè si aspira tutta l’aria in esso contenuta, con una parte anteriore rivestita da

fosfori, sostanze in grado di emettere luce se colpite da cariche elettriche in atmosfera

rarefatta (figura 1.16); la struttura è molto simile a quella di un televisore domestico.

Nei CRT abbiamo la presenza di un catodo che produce elettroni (cariche elettriche

di segno negativo), i quali vengono “sparati” verso la superficie anteriore del tubo tramite un acceleratore di cariche che sfrutta un’elevata differenza di potenziale elettrico;

questi elettroni acquistano una notevole energia in funzione della velocità raggiunta,

essendo la loro massa molto limitata. Gli elettroni vanno a colpire la parte anteriore

del tubo interagendo con il rivestimento in fosfori, in questo modo abbiamo la “conversione” della loro energia in luce e si vengono a creare delle immagini visibili dall’occhio umano. In generale nei CRT a colori abbiamo tre cannoni di elettroni, a differenza del singolo cannone presente nei monitor monocromatici oramai in disuso.

Come sappiamo il nostro occhio reagisce ai tre colori primari verde, rosso e blu, e alle

loro combinazioni che danno luogo a un numero infinito di colori. I fosfori presenti

sulla superficie frontale del tubo catodico sono particelle molto piccole che il nostro

occhio non è in grado di percepire e che riproducono questi tre colori primari; questi

fosfori, come detto, vengono accesi se colpiti dagli elettroni generati dal catodo e sparati dai tre cannoni presenti nel CRT; ogni cannone viene abbinato a uno dei tre colori

primari. I tre cannoni inviano elettroni sui vari fosfori, questi si accendono combinando i tre colori primari e formando le immagini con i colori voluti (figura 1.17).

Figura 1.17

I tre cannoni

È ovvio che per ottenere dei buoni risultati non è sufficiente il solo tubo catodico,

ma anche un ottimo circuito di controllo, cioè tutta la parte elettronica che gestisce il

funzionamento del monitor; questo è in genere quello che differenzia, da un punto di

vista qualitativo, i monitor che montano lo stesso tubo catodico ma adottano differenti

circuiti di controllo sviluppati da differenti costruttori. Come detto per ogni cannone

abbiamo un fascio di elettroni che deve andare a colpire i fosfori di un ben determi11

C A P I TO L O

01

nato colore (verde, rosso o blu); è chiaro che bisogna evitare che il fascio di elettroni

che deve colpire il fosforo rosso vada a colpire il verde, o il blu, e a tale scopo ci viene

in aiuto la cosiddetta “maschera”, una vera e propria sorta di “mirino” costruito con

particolari leghe metalliche, in grado di indirizzare con estrema precisione il fascio

di elettroni nel punto desiderato. Esistono differenti tipologie di maschere e queste, a

seconda di come sono costruite, vanno a caratterizzare i prodotti dei vari costruttori

che le hanno ideate e realizzate.

Le maschere più diffuse sono sostanzialmente due e vanno sotto il nome di Shadow

Mask e Aperture Grille.

La Shadow Mask (figura 1.18) è la maschera e quindi la tecnologia più diffusa nei

monitor CRT; il principio su cui si basa è quello di anteporre allo schermo con i fosfori una griglia metallica che funziona come un mirino, cioè impedisce che un fascio

di elettroni possa colpire il fosforo sbagliato e in un’area differente da quella voluta.

Eccitando in modo differente i fosfori e quindi combinando in modo opportuno i tre

colori primari si può ottenere nel punto desiderato il colore voluto. La distanza tra

fosfori di ugual colore espressa in mm (millimetri) e che viene intesa come la distanza

maggiore valutata misurando il lato dell’ipotetico triangolo che congiunge idealmente

i centri di tre dot (misura fatta quindi sulla diagonale), cioè punti di ugual colore,

prende il nome di dot pitch.

Figura 1.18

La Shadow Mask

L’Aperture Grille (figura 1.19) è la tecnologia adottata da alcuni costruttori con nomi

quali Trinitron (per Sony) o Diamondtron (per Mitsubishi). In questa soluzione non

abbiamo più la presenza di una griglia metallica forata come per la “Shadow Mask”,

ma bensì una griglia formata da linee verticali composta da una serie di fili tesi dove

i fosfori risultano disposti in strisce verticali di diverso colore (verde, rosso e blu) invece che a punti. Questo sistema assicura un ottimo contrasto per le immagini e una

notevole saturazione dei colori che indirizzano a un campo applicativo di tipo professionale i monitor che ne sono provvisti. La minima distanza tra strisce del medesimo

colore prende il nome di stripe pitch e, come per il dot pitch, minore è il suo valore e

maggiore risulta la qualità dell’immagine.

12

Hardware e software

Figura 1.19

L’Aperture Grille

Tutte queste maschere sono costruite con appositi materiali, vedi per esempio il noto

INVAR, cioè delle leghe metalliche aventi bassa deformabilità in modo tale che durante

il funzionamento del monitor, e quindi con l’aumento delle temperature in gioco, non si

verifichi un peggioramento delle immagini visualizzate a causa della loro dilatazione.

Come detto, oltre al tubo catodico, nel monitor abbiamo un circuito che ha il compito

di gestire il segnale che arriva direttamente dalla scheda video del PC. Il circuito in

questione deve ottimizzare l’amplificazione del segnale e il funzionamento dei cannoni

di elettroni che vanno a eccitare i fosfori creando, in questo modo, l’immagine a video.

L’immagine che viene visualizzata sullo schermo del nostro monitor, a differenza di

quanto ci possa apparire, non è fissa e stabile, ma è il risultato di un continuo accendersi e spegnersi di fosfori di differente colore, da sinistra verso destra e dall’alto verso il

basso, con una frequenza così elevata da farci apparire l’immagine fissa (da cui deriva il

nome di terminale a scansione raster, raster scan display). Il nostro occhio è in grado di

“conservare” l’immagine visualizzata per un tempo molto limitato (fenomeno della permanenza retinica) mentre sullo schermo l’accensione del fosforo permane più di quanto non permanga sulla retina dell’occhio; come conseguenza abbiamo che se un punto

si sposta lentamente sul video noi siamo in grado di coglierne lo spostamento, ma se

tale punto si sposta molto velocemente, percorrendo in continuazione la stessa traiettoria in un numero di volte pari ad almeno 20 al secondo, l’effetto che otteniamo è che il

nostro occhio non vedrà più un punto che si muove, ma bensì una linea continua fissa

nel tempo. L’abilità del circuito nell’accendere e spegnere in modo opportuno i fosfori

viene misurata dalla larghezza di banda che risulta proporzionale al numero di pixel

(dimensione minima di un punto fisico) che vengono accesi e spenti in un secondo.

La qualità di un monitor è data dalla somma di molti fattori quali, oltre al tipo di maschera e al valore del dot pitch, o stripe pitch, o slot pitch, la geometria dell’immagine,

la sua nitidezza, la messa a fuoco e così via, aspetti che se risultano ottimizzati al meglio

possono fare un’enorme differenza durante l’uso dello stesso, ma che inevitabilmente

andranno a incidere sul prezzo di acquisto; vi posso comunque garantire che spendere

qualche centinaio di euro in più per un buon monitor di qualità è una cosa che vale

davvero la pena, senza considerare il fatto che, a differenza di altri componenti informatici, un monitor non è soggetto a sostituzioni nel breve o medio periodo e quindi il

suo acquisto deve essere visto nell’ottica dell’investimento a lunga scadenza.

13

C A P I TO L O

01

La qualità dei monitor CRT sia per il numero di colori visualizzati sia per la qualità

delle immagini alle alte risoluzioni di lavoro sia per la luminosità delle stesse, riveste

ancora un ruolo di supremazia in questo specifico settore; apprezzabile in queste periferiche la facilità di poter variare senza il minimo decadimento della qualità delle

immagini la risoluzione di lavoro e il numero dei colori, a differenza di quanto non

siano in grado di fare attualmente le altre tecnologie quali LCD e TFT.

Le caratteristiche di un monitor CRT

Le caratteristiche fondamentali di un monitor CRT sono: dimensione, risoluzione e refresh. Queste tre caratteristiche vanno sempre considerate contemporaneamente quando deve essere valutata la qualità di un monitor, oppure ci si appresta ad acquistarne uno,

dato che sono tra loro strettamente dipendenti. La risoluzione in un monitor è intesa

come la dimensione dell’immagine visualizzata espressa dal numero di punti che ne costituiscono la larghezza e l’altezza; dire che un monitor ha una risoluzione di 640×480

punti vuol dire, in pratica, che l’immagine sarà formata da 640×480 = 307.200 punti, su

di un rettangolo con base pari a 640 punti e altezza pari a 480 punti. Questo spiega il

perché a una maggiore risoluzione corrisponda un maggior numero di contenuti visualizzati sullo schermo. È ovvio che la risoluzione deve essere adeguata alle dimensioni

del monitor, altrimenti si corre il rischio di avere immagini così rimpicciolite che risulteranno difficilmente visionabili. La risoluzione adottabile dipende da alcuni fattori

quali, ovviamente, le caratteristiche del monitor, della scheda video e del quantitativo di

memoria della stessa che limita anche il numero massimo dei colori visualizzabili.

Esistono alcuni parametri, legati alle caratteristiche costruttive del tubo CRT, che vengono commercialmente assunti dai vari costruttori per definire la qualità delle loro periferiche; questi parametri, quali per esempio il dot pitch, consentono, a noi potenziali

acquirenti, di meglio valutare, almeno sulla carta, la qualità costruttiva del monitor;

non sempre, però, viene fornito il dot pitch così come risulta dalla sua stessa definizione e questo può rendere più complesso valutare la qualità della periferica. Come detto

il dot pitch rappresenta la misura del lato maggiore di un triangolo ideale ai vertici del

quale abbiamo i tre dot, o punti, del medesimo colore; la distanza tra dot del medesimo

colore può essere misurata in differenti modi ottenendo misure inferiori a quelle del

reale dot pitch; questo potrebbe trarre in inganno l’acquirente per quanto concerne le

reali caratteristiche qualitative del monitor in oggetto. Nell’immagine successiva (figura 1.20) possiamo visualizzare meglio questo concetto; in un monitor con dp pari a

0,27mm la distanza tra i dot sull’orizzontale è di 0,22 mm e sulla verticale di 0,16 mm.

Figura 1.20

Il dot pitch

14

Hardware e software

La scelta della dimensione è strettamente legata all’uso che faremo del nostro PC e

quindi, per esempio, sarà in base alla tipologia dei programmi utilizzati, vedi word

processing, CAD, programmi di fotoritocco ecc.; è ovvio che a seconda del campo

applicativo avrò la necessità di dover visualizzare un numero più o meno elevato di

dettagli. In commercio ci sono unità con dimensioni variabili tra i 15 e i 24; in genere è

bene ricordare che la dimensione di un monitor viene intesa come la lunghezza in pollici misurata lungo la sua diagonale (figura 1.21) e che l’effettiva area di visualizzazione

è inferiore a quella dichiarata dal costruttore e che possiamo definire “commerciale”,

dato che parte dello schermo rimarrà nascosta dal case plastico del monitor; questo si

traduce in una diagonale effettiva più corta di circa 1,2-2 (vedi tabella 1.1).

Figura 1.21

Le dimensioni di un monitor

Tabella 1.1

Dimensione nominale

Dimensione effettiva

14

12,5-13

15

13,5-14

17

15,5-16

19

17,5-18

21

19,5-20

24

21,5-22

La frequenza verticale, meglio nota come refresh rate, espressa in Hz (Hertz), indica

il numero di volte che nel tempo pari a 1 secondo l’immagine a video viene completamente ridisegnata; questo è il parametro che può caratterizzare lo sfarfallio del

monitor se non adeguato alla risoluzione impostata. L’analisi di questa frequenza deve

essere coadiuvata dalla conoscenza delle caratteristiche della nostra scheda video e

quindi di quelli che sono i valori massimi di refresh e le relative massime risoluzioni

impostabili. Per evitare il classico e fastidioso sfarfallio che ci impedisce di poter usare

il monitor ad alcune risoluzioni, bisognerebbe verificare il valore di refresh per ogni

risoluzione e assicurarsi che per ognuna di esse il refresh rate non scenda mai al di

sotto degli 85 Hz; questo ci garantirà di poter lavorare a lungo davanti al nostro monitor senza che la nostra vista ne possa in qualche modo risentire. Il massimo refresh è

15

C A P I TO L O

01

ovviamente in funzione della scheda video che lo deve produrre e del monitor che lo

deve sopportare.

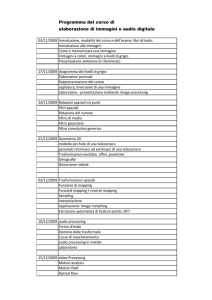

In tabella 1.2 sono indicate le minime e severe frequenze di refresh abbinate alle varie

risoluzioni considerate dalla nuova normativa TCO 99.

Tabella 1.2

Dimensione

Frequenza di refresh

Risoluzione

14-15

85 Hz

800×600

17

85 Hz

1024×768

19

85 Hz

1280×1024

20-21

85 Hz

1280×1024

24

75 Hz

1600×1200

Altro parametro da prendere in considerazione e che caratterizza i monitor dell’ultima generazione è la multifrequenza, cioè la capacità da parte della nostra periferica

di autoregolarsi secondo la frequenza che viene impostata direttamente dalla scheda

video; abbinata a questa caratteristica abbiamo alcuni nomi commerciali che alcuni

costruttori hanno dato ai loro prodotti come “multisync” o “multiscan”.

Altro aspetto importantissimo è verificare se il monitor alla sua risoluzione ottimale

di lavoro, o a quelle che avremo intenzione di sfruttare, funzioni in modalità non interfacciata; in pratica l’immagine a video si forma riga per riga è può essere costruita

in due differenti modi:

A. modalità interlacciata: vengono prima tracciate tutte le linee dispari e poi tutte le

pari, quindi la riga 1, 3, 5, 7 ecc. e poi ripartendo sempre dalla parte alta del video

le linee 2, 4, 6 ecc.;

B. modalità non interlacciata: le linee vengono tracciate in un solo passaggio una

dopo l’altra e quindi la linea 1, 2, 3, 4 ecc.; questo comporta una maggiore stabilità

dell’immagine e l’assenza dello sfarfallio, dato che si riesce a formare l’immagine a

video in tempi più brevi.

I monitor LCD

Oltre alla tecnologia CRT, che rimane di gran lunga la più diffusa nel mondo dei monitor per PC, un’altra interessante tecnologia, quella denominata LCD (Liquid Crystal

Display) si sta sempre più diffondendo e a detta di molti sostituirà completamente, in

un prossimo futuro, la CRT.

I monitor che sfruttano la tecnologia LCD (figura 1.22) sono le cosiddette periferiche

a cristalli liquidi, cioè costituiti da una particolare sostanza il cui stato fisico è a metà

strada tra un solido e un fluido; questa sostanza possiamo ritenerla composta da tante

piccole “bacchette o filamenti” orientabili. La scoperta dei cristalli liquidi avvenne nel

lontano 1888, ma le prime applicazioni risalgono ad anni più recenti ed ebbero inizio

nel momento in cui si scoprì che le piccole “bacchette” che li componevano, sotto lo

stimolo di un opportuno campo elettrico, potevano modificare il proprio orientamento, in modo tale da modificare le caratteristiche del fascio di luce che le attraversava.

16

Hardware e software

Figura 1.22

Un monitor LCD

Sulla base di questa scoperta e con gli studi successivi che vennero effettuati, si riuscì

a trovare un legame tra stimolo elettrico e orientamento dei cristalli, tale da consentire la visualizzazione di immagini. Le prime applicazioni furono nel campo dei display per le calcolatrici e successivamente nei monitor dei PC portatili; attualmente

gli enormi progressi compiuti in questo campo hanno permesso di avviare un nuovo

e interessante processo produttivo di monitor LCD per PC da tavolo approdando anche, pochi anni or sono, al colore.

È lecito domandarsi se questa tipologia di periferiche avrà lo stesso e roseo successo

che ha caratterizzato i CRT nella loro continua e progressiva evoluzione e diffusione e

se mai in un domani, più o meno prossimo, i monitor LCD potranno sostituire i più

diffusi CRT. La domanda non è certo di immediata e facile risposta anche se molti

sono gli aspetti positivi che vengono apprezzati nei monitor LCD quali, su tutti, l’ergonomia, cioè la possibilità di poter disporre di periferiche di dimensioni ottimali di 17 o

18, ma con un ingombro drasticamente inferiore a quello dei CRT; ovvio che il minor

ingombro si traduce in un minor peso e quindi in una maggiore facilità nel trovare la

posizione ottimale sulle nostre scrivanie per lo stesso.

CRT vs LCD

Le dimensioni di uno schermo LCD sono quelle effettivamente sfruttabili con le immagini a video e non inferiori alla dimensione commerciale che si attribuisce ai CRT;

come ben sappiamo su un CRT la dimensione effettiva del video è inferiore a quella

della classe dimensionale di appartenenza per il fatto che parte dello schermo rimane

inglobato nel case plastico della periferica; in genere si ha uno scarto che varia tra 1 e 2

pollici misurati sulla diagonale, quindi un CRT da 17 ha un’effettiva diagonale variabile

tra i 15 e i 16 pollici, mentre un LCD da 15 ha una effettiva diagonale di 15: è quindi, in

pratica, comparabile a un CRT da 17.

Altro aspetto apprezzato è la totale assenza di emissioni dannose per la vista, il minor

consumo energetico. Ovviamente non è tutto oro quello che luccica e i punti “negativi”

non sono certo pochi; come meglio evidenzieremo in seguito, le caratteristiche dei monitor LCD fanno sì che la qualità delle immagini, sotto alcuni aspetti, non sia ancora all’altezza dei CRT, dato il minor numero di colori visualizzabili, la minor luminosità alle

17

C A P I TO L O

01

alte risoluzioni (sono periferiche retroilluminate), la limitata possibilità di modificare

la risoluzione a video senza incidere drasticamente sulla qualità delle immagini a causa dell’architettura grid array ecc. Questa architettura si basa sul seguente concetto: il

display è composto da un numero di celle pari alla massima risoluzione visualizzabile,

dove a ogni cella corrisponde un pixel; al variare della risoluzione la qualità dell’immagine cala perché sarà formata da un’interpolazione dei colori tra le varie celle.

Altro aspetto “negativo”, o che comunque sulla base della dotazione hardware dell’utente finale può incidere sulla qualità delle immagini a video, risiede nel fatto che

la tecnologia su cui si basano gli LCD è di tipo digitale, mentre la maggior parte delle

schede video in commercio rende disponibile un segnale analogico; questo comporta

una doppia conversione del segnale da digitale ad analogico nel PC e da analogico a

digitale nel monitor LCD. I monitor LCD sono dotati di un convertitore DA (analogico/digitale) che incide in maniera significativa sul costo finale della periferica e, come

detto, sulla qualità dell’immagine. Questa conversione che non avviene quasi mai in

modo ottimale obbliga l’utente a effettuare delle opportune regolazioni intervenendo

sui “disturbi” del segnale, sul contrasto, sulla regolazione del clock e della fase ecc.

L’ultimo punto “dolente” è quello che viene definito angolo di visione, in sostanza la

massima inclinazione che possiamo assumere nei confronti del nostro monitor senza

che ne venga pregiudicata la qualità dell’immagine osservata, e questo sia in direzione

orizzontale sia verticale; i CRT emettono luce in tutte le direzioni è sono quindi caratterizzati da un ampio angolo di visione mentre gli LCD hanno un campo più limitato

e sempre più numerose sono le tecnologie che i vari costruttori stanno sviluppando

per sopperire a questa particolare, e non trascurabile, limitazione.

Com’è fatto e come funziona un monitor LCD

I “cristalli liquidi” furono scoperti più di 100 anni fa constatando che determinate

sostanze con struttura cristallina tipica di un solido, se opportunamente riscaldate,

assumevano una consistenza semiliquida, pur mantenendo una struttura cristallina

al proprio interno; i cristalli, a una osservazione microscopica, appaiono come delle

piccole bacchette o, meglio ancora, filamenti, ed è per questo che prendono il nome

di nematici, dal greco “nemo”, cioè filo. Oltre ai nematici esistono altre tipologie di

cristalli liquidi, ma sono poco utilizzati nella costruzione di display LCD. In queste

pagine riporterò alcuni disegni tratti da un interessante sito in lingua inglese (The PC

Techonology Guide), che renderanno meglio interpretabili le parti descrittive.

I “filamenti cristallini” facendo parte di una sostanza semifluida sono caratterizzati da

una certa libertà di movimento e inoltre rifrangono i fasci di luce su di essi incidenti;

ovvio che la rifrazione del fascio luminoso varierà a seconda dell’orientamento degli

stessi. Questi piccoli “filamenti” sotto lo stimolo di un apposito campo elettrico possono modificare il proprio orientamento e di conseguenza modificare le caratteristiche

del fascio di luce che li attraversava.

I monitor LCD sono costituiti da sette strati fondamentali; partendo dalla zona centrale abbiamo due pannelli di vetro che racchiudono i cristalli liquidi; questi pannelli

presentano delle scanalature che vanno a orientare i cristalli facendogli assumere una

particolare configurazione a elica (figura 1.23). Tali scanalature infatti, sono disposte

in modo tale che siano parallele su ogni pannello, ma perpendicolari tra i due pannelli

(figura 1.24).

18

Hardware e software

Figura 1.23

La configurazione

a elica

Figura 1.24

Le scanalature perpendicolari

tra i due pannelli

Le scanalature rettilinee sono ottenute posizionando sui due pannelli di vetro delle

sottili pellicole trasparenti di materiale plastico che vengono opportunamente trattate. I cristalli venendo in contatto con le scanalature si orientano di conseguenza;

le scanalature tra i due pannelli sono tra loro ortogonali; i cristalli, passando da un

pannello all’altro sono obbligati a subire una torsione di 90° assumendo, come detto,

una configurazione a elica.

La tecnologia ora descritta va sotto il nome di Twisted Nematic (TN), cioè cristalli

nematici ruotati. I due pannelli sono tra loro molto vicini, si parla di una distanza di

circa 5 milionesimi di millimetro.

Se i cristalli vengono attraversati da un fascio di luce, questo segue l’andamento della

disposizione dei cristalli e quindi subisce una rotazione di 90° nel passaggio da un

pannello all’altro. L’applicazione di una tensione elettrica causa l’orientamento dei cristalli nella direzione del campo elettrico generato, si perde la precedente disposizione

a elica e si realizza una nuova disposizione ordinata dei cristalli in direzione verticale

e non più orizzontale; la luce attraversa direttamente i cristalli senza subire la rotazione di 90°. Questo diverso comportamento del fascio luminoso non può essere colto

dall’occhio umano se non adottando opportuni filtri polarizzanti.

Questi filtri hanno la caratteristica di far passare la luce solo lungo prefissati assi e

quindi di non farla diffondere, come di consueto, a 360°; in pratica se noi andiamo ad

allineare l’asse del filtro con quello delle scanalature sul vetro, la luce entra allineata

con le scanalature, incontra i cristalli disposti lungo un’elica e arriva al secondo vetro

allineata con i solchi lì presenti e quindi il secondo filtro farà passare integralmente

tutto il fascio di luce, ma se applichiamo una differenza di potenziale tale da orientare

19

C A P I TO L O

01

i cristalli e far passare la luce senza la caratteristica rotazione a elica, il fascio di luce

giungerà sul secondo vetro perpendicolarmente ai solchi e quindi non potendo uscire,

dato che il secondo filtro lo blocca, vedremo lo schermo completamente nero (il fascio

di luce viene catturato). Posizionando un elevato numero di elettrodi che generano

differenze di potenziali in differenti punti dello schermo, le cosiddette celle di cristalli

liquidi, si è in grado di riprodurre in zone molto limitate e localizzate questo fenomeno e gestendo in modo opportuno il loro funzionamento si è anche in grado di rappresentare immagini, lettere ecc.; gli elettrodi, essendo costruiti di materiale plastico

trasparente possono essere realizzati con qualunque forma.

L’evoluzione tecnologica ha permesso di rendere queste “celle” molto piccole, in pratica dei piccoli punti, aumentando di conseguenza la risoluzione degli schermi LCD,

ogni punto corrisponde a un pixel, e consentendo di visualizzare immagini complesse

con buona definizione.

LCD a colori e a matrice attiva

L’impiego del colore ha comportato la necessità di dover retro illuminare gli schermi,

facendo in modo che la luce venisse generata nella parte posteriore del display LCD; ciò

consente un’ottimale visione dell’immagine anche in condizioni di scarsa luminosità nell’ambiente circostante, a differenza dei precedenti dispositivi che realizzavano la retro illuminazione riflettendo, con uno specchio, la luce che arrivava dall’ambiente circostante.

I colori vengono ottenuti con l’impiego di tre filtri che riproducono i tre colori fondamentali rosso, verde e blu e facendo passare il fascio di luce attraverso i filtri stessi.

Combinando per ogni singolo punto, o pixel, dello schermo questi tre colori fondamentali, siamo in grado di riprodurre il colore voluto nel punto desiderato; la combinazione dei tre colori base si ottiene gestendo in modo opportuno gli elettrodi che

puntualmente generano la differenza di potenziale necessaria per orientare i cristalli.

Nell’immagine (figura 1.25) possiamo vedere, in sezione, quello che è la struttura tipica

di un LCD a colori con i filtri colorati, gli elettrodi trasparenti e i due piani che orientano “meccanicamente” i cristalli.

Figura 1.25

La struttura tipica

di un LCD a colori

20

Hardware e software

I primi display LCD avevano dimensioni molto contenute, circa 8 pollici di diagonale,

mentre oggi possiamo arrivare ai 15 sui NoteBook e oltre i 20 per i display LCD per desktop. All’aumento delle dimensioni si è ovviamente associato l’aumento della risoluzione di questi schermi e questo ha introdotto nuove problematiche risolte adottando

particolari tecnologie alle quali faremo ora un breve accenno.

LCD a matrice passiva vs LCD a matrice attiva

Prima abbiamo parlato di matrice passiva; il termine matrice viene introdotto per la

caratteristica suddivisione dello schermo in punti, ognuno dei quali viene indirizzato

separatamente dagli altri e quindi separatamente dagli altri può essere acceso o spento

a piacere, intervenendo sui prima citati elettrodi, per la formazione delle immagini a

video. Si denomina passiva perché la tecnologia ora descritta per la produzione dei

display LCD, tecnologia più economica attualmente utilizzata, non è in grado di mantenere per lungo tempo le informazioni a video e inoltre per creare delle immagini

necessita sempre della presenza di un campo elettrico; le immagini si formano riga per

riga, con il campo elettrico che passa da una riga all’altra provocandone l’accensione e

la successiva dissolvenza, appena il campo stesso viene disattivato in quel punto; una

volta tolto il campo elettrico l’immagine progressivamente si dissolve perché i cristalli

rimangono in posizione orientata solo per qualche secondo.

I display ora descritti hanno dei grossi limiti per quanto concerne l’aspetto qualitativo

e applicativo, hanno infatti un’immagine non perfettamente nitida e tendenzialmente

sfarfallante; l’uso di cristalli lenti, dato che rimangono in posizione anche dopo aver

tolto il campo elettrico, non permette una corretta visualizzazione di immagini in

movimento. Non meno trascurabile è il problema dell’interferenza tra i vari elettrodi

che si manifesta sotto forma di aloni sul display.

Risultati molto migliori sia per quanto concerne la stabilità, la qualità, la risoluzione,

la nitidezza e la brillantezza dell’immagine si possono ottenere con gli schermi a matrice attiva che a fronte della maggiore qualità contrappongono, purtroppo, un costo

molto più alto. La matrice attiva offre notevoli vantaggi rispetto a quella passiva, quali

per esempio la maggiore luminosità e la possibilità di guardare lo schermo anche con

inclinazioni fino a 45° senza perdere in qualità di immagine, cosa impensabile con la

passiva che in pratica consente una visione ottimale solo da posizione frontale rispetto

al display; possiamo visualizzare immagini in rapido movimento senza il fastidioso effetto scia e senza sfarfallii, dato che il tempo di risposta di un display a matrice attiva è di

circa 50 ms rispetto ai 300 della passiva, inoltre si ha una qualità nel contrasto superiore

a quella offerta dai monitor a tubo catodico CRT. È proprio in base a questa elevata qualità di visualizzazione delle immagini che si è pensato di estenderne il campo applicativo

dai NoteBook ai Desktop, ottenendo dispositivi poco ingombranti e molto meno nocivi

per la salute degli operatori rispetto ai tradizionali monitor a tubo catodico.

Con la matrice passiva i vari elettrodi ricevono ciclicamente una tensione elettrica;

man mano che il display viene rigenerato per linee abbiamo che l’eliminazione del

campo elettrico comporta il progressivo dissolvimento dell’immagine, dato che i cristalli ritornano progressivamente nella loro configurazione originaria; nella matrice

attiva, invece, si è abbinato a ogni elettrodo un transistor di memoria in grado di

memorizzare un’informazione digitale (numero binario 0 o 1) e quindi di mantenere

quella determinata immagine fino al ricevimento di un altro segnale.

21

C A P I TO L O

01

Dato che il tentativo di ritardare il dissolvimento dell’immagine nei display a matrice passiva veniva parzialmente raggiunto con strati maggiori di cristalli liquidi per

aumentarne l’inerzia e quindi rallentarne i movimenti, ora abbiamo la possibilità di

ridurre fortemente lo strato di cristalli liquidi presente. I transistor, come gli elettrodi,

devono essere fabbricati con materiali trasparenti per evitare di bloccare il passaggio

del fascio luminoso e vengono poi posizionati sul retro del display su uno dei pannelli

di vetro che contengono i cristalli liquidi; a tale scopo si impiegano delle pellicole di

materiale plastico Thin Film Transistor, transistor a film sottile, da cui la nota sigla

TFT, caratterizzate da uno spessore sottilissimo tra 1/10 e 1/100 di micron.

Considerando lo spessore del Thin Film Transistor, la tecnologia impiegata per la costruzione dei transistor non può che essere altamente sofisticata, ma purtroppo non

certo esente da possibili difetti qualitativi sul prodotto finale anche perché il numero

di transistor utilizzati è decisamente alto; basti pensare a un display in grado di visualizzare immagini con una risoluzione di 800×600 in modalità SVGA e con soli 3 colori

e al fatto che in esso abbiamo la presenza di ben 1.440.000 transistor individuali per

capire quanto risulta delicata la costruzione di monitor con risoluzioni e numero di

colori sempre più elevato. I vari costruttori limitano a un certo numero il quantitativo

di transistor che possono risultare difettosi in un display LCD, per stabilire se il prodotto ottenuto è buono oppure deve essere scartato. Diventa quasi inevitabile riscontrare

anche in unità di fascia alta dei transistor difettosi che si presentano sottoforma di pixel,

cioè punti, difettosi. Come specificato in precedenza, sulla base delle nuove normative,

ci sono delle classi qualitative che meglio evidenziano il numero limite di pixel difettosi

e anche la loro tipologia. Ognuno di noi potrà condurre delle semplicissime prove per

evidenziare questi difetti e valutare direttamente se il tutto rientra nei limiti dichiarati

dal costruttore; alternando sullo schermo uno sfondo completamente nero, bianco, verde, rosso o blu possiamo individuare sia il numero sia la tipologia di pixel difettosi.

Le schede grafiche

La scheda grafica (figura 1.26) è composta da uno o più processori grafici, dalla memoria video e dal ramdac. La scheda grafica lavora in parallelo con la CPU, facendosi

carico dei processi riguardanti la grafica (maggiore è il livello di implementazione in

hardware della pipeline grafica da parte della scheda, migliori saranno le prestazioni

grafiche del computer).

Figura 1.26

Una scheda grafica

22

Hardware e software

Il processore grafico è il cuore della scheda video e a esso sono associate alcune funzioni fondamentali quali la gestione della memoria video e le funzioni per la generazione della grafica bidimensionale (filling di superfici, blitting di porzioni di immagine

ecc.), più una serie di funzionalità quali quelle per la generazione della grafica tridimensionale (implementazione in hardware di molte operazioni per la creazione di

una scena 3D: Goudard shading, clipping ecc.).

Anche su una scheda video è presente il BIOS. Questo di certo non ha le stesse funzionalità di quello presente sulla motherboard, infatti in questa memoria di tipo ROM

sono registrate tutte le informazioni necessarie per il corretto funzionamento quali

per esempio la versione del chip, la quantità di memoria presente sulla scheda ecc.

Il ramdac ha il compito di trasformare i dati digitali che rappresentano il colore di

ogni pixel in segnali elettrici adeguati e con i quali esternamente viene pilotato il monitor. Il controller si occupa di “calibrare” l’intensità con la quale occorre colpire i

fosfori. Esso converte il contenuto in bit di un pixel in un livello di intensità, cioè la

quantità di corrente sparata dal cannone per illuminare i fosfori.

Il tipo e la quantità di memoria video di cui è dotata la scheda gioca un ruolo importante nella risoluzione massima ottenibile e nel numero di colori che è possibile

visualizzare. La RAM video è del tipo VRAM (Video RAM) più veloce ma anche più

costose delle memorie ad accesso singolo. Oggi sulle schede grafiche sono montate

memorie di tipo DDR (Double Data Rate).

La memoria video

La memoria video costituisce un componente fondamentale delle schede video: in

pratica ogni volta che viene creata una schermata, sia con contenuto grafico (tipico

dell’ambiente Windows) sia in modo testo (tipico dell’ambiente Dos) viene coinvolta

la RAM video.

Una parte della RAM video viene sfruttata per la creazione del frame buffer, una matrice in cui viene memorizzata l’immagine digitale da visualizzare. Le dimensioni della matrice (cioè la sua risoluzione) dipendono dalla quantità di RAM video. La risoluzione del frame buffer è di due tipi: grafica e cromatica.

Per risoluzione grafica si intende il numero di unità fondamentali di cui è composta

l’immagine. Questa unità di base prende il nome di pixel. Questa viene indicata con

due numeri che indicano rispettivamente il numero di pixel presenti su ogni riga e il

numero di righe in cui l’immagine è stata suddivisa. La risoluzione cromatica (color

depth) serve per definire la qualità di visualizzazione, cioè quanti colori possono essere assunti da ogni pixel.

Per visualizzare un’immagine in B/N di 640×480 pixel servono approssimativamente 38 KB di VRAM (1 bit*640*480/8 = 38.400 byte); nel caso di un’immagine in scala

di grigio (a 8 bit) la quantità di VRAM necessaria sale a circa 300 KB (8*640*480/8).

Se invece vogliamo visualizzare un’immagine RGB (24 bit) abbiamo bisogno di quasi 1 MB (moltiplichiamo per 3 il risultato della precedente formula) (tabella 1.3).

Nelle schede grafiche più recenti, la memoria video supera di gran lunga gli 8 MB

necessari per la visualizzazione. La memoria video in più che viene montata sulle

schede grafiche di ultima generazione viene utilizzata per supportare la grafica 3D e

23

C A P I TO L O

01

le animazioni. In particolare un’altra quantità di memoria identica per dimensioni a

quella utilizzata per il frame buffer, denominata double buffer, contiene le informazioni sul frame che verrà visualizzato sul monitor l’istante successivo. Altra RAM video

viene sfruttata per lo Z-Buffer, area della memoria video che serve per la gestione della

profondità in una scena 3D. Tutto il resto della memoria video disponibile è in genere

utilizzato per texture mapping.

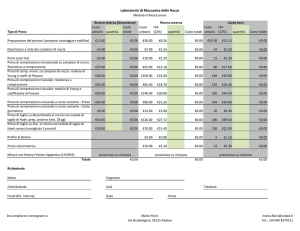

Tabella 1.3 Quantità minima di RAM video per risoluzione e numero di colori.

Risoluzione

16 colori

(4 bit)

256 colori

(8 bit)

65.000 colori

(16 bit)

16,7 milioni colori

(24 bit true color)

640×480

500 KB

500 KB

1 MB

2 MB

800×600

500 KB

1 MB

2 MB

2 MB

1024×768

1 MB

1 MB

2 MB

4 MB

1280×1024

1 MB

2 MB

4 MB

4 MB

1600×1200

2 MB

2 MB

4 MB

8 MB

1800×1440

2 MB

4 MB

8 MB

8 MB

Come funziona una scheda video

La scheda video è il componente responsabile della traduzione delle istruzioni che la

CPU invia al monitor in un linguaggio a questo comprensibile. Poiché queste istruzioni riguardano qualsiasi elemento visualizzato sullo schermo, non solo grafica, ma

anche lettere e segni di punteggiatura che viene digitata con un qualsiasi editor di testi,

si comprende come la mole di lavoro a cui la scheda video è sottoposta sia notevole.

La procedura di visualizzazione può essere schematizzata da 4 fasi principali:

• i dati in partenza dal processore centrale vengono inviati tramite il bus al processore video che provvede alla loro elaborazione;

• dal processore video i dati passano alla memoria video dove viene registrata in forma digitale una copia dell’immagine che dovrà essere visualizzata sul monitor;

• i dati procedono poi verso il RAMDAC che li converte a vantaggio del monitor;

• l’ultimo passaggio consiste nell’invio dei dati dal RAMDAC al monitor stesso.

Ogni passaggio rappresenta un rallentamento dell’intera procedura; il passaggio più

lento determina la rapidità con cui si svolge l’intera procedura. Se nel primo caso

il responsabile del rallentamento sono principalmente elementi estranei alla scheda

video e precisamente la scheda madre e il bus interno, i due passaggi successivi sono

effettuati internamente alla scheda video e costituiscono l’aspetto più importante e

impegnativo per questo componente e quindi il criterio più utile per valutarne le

prestazioni. La memoria video infatti, è sollecitata in continuazione; da un lato c’è

24

Hardware e software

il processore che scrive sulla memoria ogni volta che l’immagine sul monitor viene

modificata (e ciò avviene in continuazione poiché è sufficiente spostare il puntatore

del mouse), dall’altro c’è il RAMDAC che deve leggere i dati inviati alla memoria video

con la stessa frequenza.

A questo punto, è chiaro che il vero collo di bottiglia di tutto il sistema è rappresentato

proprio dalla memoria video. I produttori di questo componente hanno affrontato il

problema in vari modi.

Il primo consiste nel rendere la memoria video accessibile da due parti contemporaneamente, in modo che il processore video e il RAMDAC non debbano attendere

l’uno la fine delle operazioni dell’altro (memoria DDR). Una seconda tecnica consiste

nell’incrementare le dimensioni del bus della memoria video. Terza e ultima soluzione: aumentare la velocità di clock del bus che presiede allo scambio di informazioni

tra processore video, memoria video e RAMDAC.

I vari tipi di schede video

Le schede video meno recenti erano tipicamente schede video 2D, così denominate

per sottolineare l’assoluta mancanza di qualsiasi funzione di accelerazione 3D. Se si

utilizzano esclusivamente applicazioni da ufficio, una buona scheda 2D è, tutt’oggi, più

che sufficiente in quanto è quella che influisce sulla velocità di scorrimento di testo e

grafica, sulla rapidità con cui si aprono e chiudono nuove finestre e via dicendo: si tratta di soluzioni relativamente poco costose e di facile reperibilità, poiché i produttori e

relativi modelli sono numerosi e, almeno a grandi linee, equiparabili tra loro.

Attualmente le schede video sono progettate per il bus PCI o il bus AGP.

Il bus PCI è un canale di comunicazione a 32 bit capace di operare a una velocità

massima di 33 MHz. Con l’introduzione di sistemi sempre più potenti, tuttavia, il

bus PCI ha subito delle modifiche fino ad arrivare al bus PCI versione 2.1, un canale

a 64 bit in grado di funzionare a 66 MHz. La velocità del bus PCI può essere impostata in modalità sincrona o asincrona, a seconda del chipset e della scheda madre

utilizzata. Se si utilizza la modalità sincrona, la velocità del bus PCI è sempre uguale

alla metà della velocità del bus di memoria. Se si utilizza la modalità asincrona,

invece, la velocità del bus PCI è indipendente da quella del bus di memoria, e può

essere impostata al massimo delle sue capacità. La tecnologia AGP, invece, è stata

introdotta per soddisfare le necessità sempre più impellenti di disporre di adattatori grafici abbastanza veloci da poter sfruttare pienamente le enormi capacità dei

computer correnti. Il bus AGP è stato progettato per essere interamente dedicato

alla grafica e fornisce un’interfaccia estremamente veloce tra il processore video e il

processore centrale.

Per ottenere la rappresentazione grafica di un oggetto tridimensionale è necessario

passare attraverso due fasi, la descrizione geometrica dell’oggetto in un sistema di

assi cartesiani in tre dimensioni e la successiva rappresentazione bidimensionale dipendente dal punto di vista dell’osservatore. Con un software di grafica 3D, quindi, si

creano gli oggetti in uno spazio tridimensionale virtuale descritto matematicamente

nella memoria del computer; il passaggio successivo consiste nell’inviare sullo scher-

25

C A P I TO L O

01

mo del PC una specie di “fotografia” scattata sullo scenario contenuto in memoria.

La differenza di questo tipo di gestione grafica, rispetto a quella tradizionale in due

dimensioni, risulta più chiara con il classico esempio della cartolina. In pratica è

la stessa differenza che c’è tra l’osservare una cartolina di un paesaggio e trovarsi

dentro il paesaggio stesso. Nel primo caso si può vedere solo l’immagine realizzata

dal fotografo, mentre nel secondo ci si può spostare liberamente, a 360 gradi, per

osservare ogni cosa da un punto di vista diverso. In entrambe le situazioni il risultato finale sarà sempre un’immagine in due dimensioni rappresentata sullo schermo

del PC, ma con la fondamentale differenza che la gestione 3D permette di ottenere

rappresentazioni dinamicamente variabili degli scenari e degli oggetti, con tanto di

animazioni ed effetti speciali. Con un programma o un gioco in due dimensioni si

possono osservare solo le immagini create in origine dall’autore del software, mentre con un gioco 3D è possibile spostarsi liberamente in uno spazio tridimensionale

virtuale. Tutto questo, però, comporta non poche difficoltà: mentre per generare le

tradizionali immagini bidimensionali è sufficiente “disegnarle” sotto forma di bit

nella memoria lineare della scheda grafica (frame buffer), per creare invece la rappresentazione di un oggetto tridimensionale è necessario gestire una dimensione in

più in una memoria dedicata detta Z-buffer. Si passa, quindi, da un tipo di grafica

basata sulla sovrapposizione di piani per mezzo del trasferimento di grossi blocchi

di bit (bit block transfer) a un tipo completamente diverso basato sulla descrizione

matematica degli oggetti nello spazio. Ciò richiede una notevole potenza di calcolo

da parte del computer, che deve realizzare milioni di operazioni matematiche su

matrici di punti per generare in tempo reale la rappresentazione in due dimensioni

dello scenario 3D contenuto in memoria.

Queste operazioni possono essere realizzate dai cosiddetti “motori di rendering” software, cioè particolari programmi in grado di eseguire le operazioni richieste sfruttando la potenza di calcolo della CPU di sistema. In questo caso, però, si incontrano seri

limiti quando si lavora con immagini a elevata risoluzione e con molti colori; inoltre

per rendere più realistico uno scenario 3D è necessario applicare una serie di “filtri”

all’immagine, per esempio per correggere l’effetto mosaico di alcuni motivi di riempimento (bilinear filtering e mip mapping) o per correggere la prospettiva, è necessario

aggiungere effetti di illuminazione (specular highlights e depth cueing), di nebbia (fogging) e di trasparenza (alpha blending). Per ottenere una rappresentazione realistica

di uno scenario 3D con una risoluzione di almeno 640×480 punti, con 65.536 colori e

con una frequenza di 30 fotogrammi generati ogni secondo, è necessario utilizzare un

meccanismo di accelerazione hardware dedicato, cioè di una scheda grafica che sia in

grado di svolgere autonomamente questi calcoli.

Le porte di Input/Output

Le porte di I/O (figura 1.27) sono una serie di prese, localizzate sul lato posteriore del

computer, che vengono utilizzate per collegare alla macchina tutti i dispositivi esterni

(monitor, tastiera, mouse ecc.).

La disposizione delle porte varia da computer a computer.

26

Hardware e software

Tipicamente sono poste direttamente sulla scheda madre le seguenti porte:

• porte PS/2 per il collegamento del mouse e della tastiera (una è dedicata al mouse

e l’altra alla tastiera; non si possono invertire);

• porta seriale per il modem, o in generale per dispositivi che non richiedono un flusso di dati molto veloce (fino a qualche anno fa veniva usata anche per il mouse);

• porta parallela si usa quasi sempre per la stampante, ma in generale è adatta per

qualunque dispositivo che richieda un flusso di dati più veloce rispetto alla capacità

della porta seriale;

• porta USB (Universal Serial Bus) di recente introduzione, è adatta per connettere

al computer qualunque tipo di dispositivo (purché compatibile col collegamento

USB!). La tecnologia USB consente di creare “catene” di dispositivi collegati tutti su

un’unica porta (fino a 127), inoltre consente il collegamento “a caldo” (cioè a computer acceso), mentre tutti i dispositivi non USB devono sempre essere collegati a

computer spento.

Figura 1.27

Porte input/output

Le schede di espansione che vengono montate sulla scheda madre rendono poi disponibili molte altre porte, fra cui le principali sono:

• porta video (talvolta integrata direttamente sulla scheda madre, soprattutto nei

modelli di marca) per connettere il monitor al computer;

• porta di rete per collegare la macchina direttamente a una rete di computer, senza

usare il modem. Ne esistono di vari tipi, ma ormai la presa RJ45 ha di fatto rimpiazzato tutte le altre;

• porta SCSI per dispositivi che richiedono un flusso di dati molto veloce (scanner,

masterizzatore esterno ecc.). La tecnologia SCSI consente inoltre, come la USB, il

collegamento di dispositivi a catena (fino a 7), ma non il collegamento a caldo.

La tabella 1.4 riporta le velocità di trasferimento dati per le diverse tipologie di porte.

27

C A P I TO L O

01

Tabella 1.4 Velocità di trasferimento dati per i diversi tipi di porte.

NOME PORTA

VELOCITÀ

Seriale

14,3 KB/s

Parallela

115 KB/s

USB

1,43 MB/s

ECP/EPP

3 MB/s

IDE

da 3,3 a 16,7 MB/s

SCSI-1

5 MB/s

SCSI-2

10 MB/s

Fast Wide SCSI

20 MB/s

Ultra SCSI

20 MB/s

Ultra ATA/33

33 MB/s

Ultra ATA/66

66 MB/s

Wide Ultra SCSI

40 MB/s

Ultra 2 SCSI

40 MB/s

IEEE-1394

da 12,5 a 50 MB/s

USB 2.0

60 MB/s

Wide Ultra 2 SCSI

80 MB/s

Ultra 3 SCSI

80 MB/s

Ultra ATA/100

100 MB/s

Wide Ultra 3 SCSI

160 MB/s

Un discorso a parte merita la FireWire che sarà trattata nel paragrafo relativo alle

schede di acquisizione.

Le memorie di massa

Vengono detti memorie di massa tutti i supporti (dischi e nastri) su cui vengono registrati dati, documenti e programmi che si vogliono conservare, sono quindi memorie

di massa i floppy, i CD, gli hard disk, gli zip ecc.

I supporti per le memorie di massa si dividono in quattro grandi categorie.

Alla prima categoria appartengono i dischi magnetici: sui quali la memorizzazione

dei dati avviene magnetizzando la superficie, tramite un’apposita testina di lettura/

scrittura. Sullo stesso disco i dati possono essere scritti, cancellati e riscritti per un

numero indefinito di volte senza logorare il supporto. I dischi magnetici sono volatili

per natura, un forte campo magnetico è sufficiente a cancellarne l’intero contenuto

28

Hardware e software

in pochi istanti, per questo motivo vanno tenuti distanti dalle fonti di campo, come

trasformatori di potenza o grosse calamite. Dei dischi magnetici fanno parte floppy,

hard disk e zip.

Alla seconda categoria appartengono i dischi ottici; essi sono dischi su cui la memorizzazione dei dati avviene “bruciando” con un laser la superficie, che da lucida diviene così opaca. Normalmente i dati scritti su un disco ottico non possono più essere

cancellati, esistono tuttavia dei dischi particolari (CD riscrivibili) che consentono la

cancellazione e la riscrittura per un numero comunque limitato di volte (a ogni cancellazione la superficie tende a deteriorarsi sempre di più finché non diventa inutilizzabile). Fanno parte dei dischi ottici i CD-Rom, i Mini CD, i DVD.

La terza categoria comprende i dischi magneto-ottici che sono dischi a supporto magnetico, su cui però la scrittura dei dati può avvenire solo dopo un forte riscaldamento

della superficie con un fascio laser. A temperatura ambiente i dischi magneto-ottici

non sono sensibili ai campi magnetici e questo li mette al riparo dalle cancellazioni

accidentali. I dischi magneto-ottici esistono in numerosi modelli, con capacità che arriva fino ad alcuni GByte, e richiedono la presenza di un apposito drive. Furono messi

in commercio nella seconda metà degli anni ’80, prima dell’avvento dei CD-Rom, ma

non hanno mai preso campo, sia per il costo eccessivo (soprattutto del drive), sia per

la contemporanea affermazione degli hard disk e dei CD. Rimangono in uso solo in

alcuni sistemi dove è richiesto il frequente salvataggio di una grande quantità di dati

in condizioni di sicurezza (per esempio nelle banche). Fanno parte di questa categoria

i MOD (Magneto Optical Disk).

I nastri magnetici sono l’ultima tipo di memoria di massa. Vengono usati dagli amministratori di grandi sistemi di computer per creare periodicamente copie (backup)

del contenuto degli hard disk, in modo da salvare i dati qualora se ne guastasse uno.

La lettura/scrittura è però molto lenta (può richiedere alcune ore), per questo l’operazione di backup viene lanciata tipicamente durante la notte. Fanno parte di questa

categoria i DAT (Digital Audio Tape).

Il software

Il sistema operativo

Si intende per sistema operativo (o software di sistema) un gruppo di programmi che

gestisce il funzionamento di base del computer. Il sistema operativo rimane sempre

attivo dal momento in cui viene caricato (all’accensione della macchina) fino allo spegnimento.

Sono gestite dal sistema operativo tutte le funzioni generali della macchina, come

l’aspetto grafico delle visualizzazioni su monitor, la scrittura e la lettura dai dischi, la

messa in esecuzione e la chiusura dei vari programmi, la ricezione e trasmissione di

dati attraverso tutti i dispositivi di I/O. Non fanno invece parte del sistema operativo

i vari programmi come per esempio i programmi di scrittura, di ritocco fotografico,

gli antivirus ecc. che vengono acquistati a parte e installati sulla macchina dopo che

questa contiene già il sistema operativo.

29

C A P I TO L O

01

In definitiva si può dire che il software di sistema serve alla macchina per funzionare,

mentre il software applicativo serve all’utente per lavorare.

Il sistema operativo risiede sull’hard disk come tutti gli altri programmi e viene caricato nella memoria RAM all’accensione della macchina.

Esistono molti sistemi operativi: i più diffusi oggi sono i vari Windows di Microsoft

(98, Me, NT, 2000), MacOS di Apple per i computer Macintosh, Linux e Unix. Molto

diffuso fino ad alcuni anni fa era anche l’MS-DOS, oggi soppiantato da Windows.

MS-DOS, Linux e Unix sono sistemi operativi cosiddetti a linea di comando: sullo

schermo (di un colore scuro uniforme) non compare nessuna grafica e tutti i comandi

devono essere digitati da tastiera.

Tali sistemi operativi sono estremamente scomodi e difficili da usare, per cui sono

stati creati programmi che, appoggiandosi comunque alle funzioni del sistema a linea

di comando, forniscono all’utente un’interfaccia grafica a finestre. Per esempio le versioni di Windows 1, 2 e 3 e 95, precedenti a Windows 98, non erano sistemi operativi,

ma solo programmi applicativi che si appoggiavano sull’MS-DOS. Allo stesso modo,

esistono vari tipi di interfacce grafiche per Linux e Unix.

Windows 98 (e successivi) e MacOS sono invece sistemi operativi a interfaccia grafica

(Graphical User Interface, GUI): tutte le operazioni si svolgono tramite icone e finestre, usando intensivamente il mouse per lanciare comandi, scegliere opzioni ecc.

Il software applicativo

Vengono detti software applicativi (o semplicemente “applicativi”) l’insieme dei programmi che non sono compresi nel sistema operativo, ma che vengono invece installati

dall’utente per svolgere compiti specifici. Sono degli applicativi i programmi antivirus

(Norton, McAffee, InoculateIt, F-Prot...), i programmi per la compressione dei file (Winzip, ZipCentral...), la posta elettronica (Eudora, Outlook Express...), il ritocco fotografico (Photoshop, PaintShop Pro...), la composizione multimediale (Dreamweaver, FrontPage, Flash, Director...), i lettori audio/video (QuickTime Player, Real Player...) ecc.

I driver

Nel gergo informatico si tende spesso a fare confusione fra drive e driver, termini che

si riferiscono in realtà a due cose molto diverse. I drive (hardware) sono i lettori in cui

si inseriscono i vari dischi del computer (floppy, CD, zip...); i driver (software) sono

invece dei file accessori al sistema operativo che consentono la comunicazione fra il

computer e le varie periferiche, servono cioè da “interpreti” fra l’hardware e il sistema

operativo. Per poter funzionare correttamente, ogni dispositivo deve avere il suo particolare driver registrato dal sistema operativo. Esistono perciò i driver di stampante,

modem, masterizzatore, lettore CD, scheda madre, scheda video, scheda audio, scheda di rete ecc. Talvolta hanno i loro driver anche il mouse e il monitor, mentre non li

hanno mai la RAM, la tastiera, le casse audio e il drive del floppy.

Le librerie grafiche

Le API (Application User Interface) sono un’insieme integrato di interfacce di programmazione sviluppate per aiutare lo sviluppo di applicazioni multimediali. Queste inter-

30

Hardware e software

facce si basano sul concetto di periferica virtuale, che permette una più facile programmazione delle periferiche rendendo però impossibile l’accesso diretto all’hardware.

Le librerie grafiche sono le API dedicate alla grafica e fungono da interfaccia tra l’hardware grafico e i software. Le librerie grafiche più conosciute sono le Open GL (sviluppate dalla SGI) e le Direct 3D (sviluppate di Microsoft).

Le librerie grafiche mettono a disposizione del sistema operativo una serie di funzionalità che definiscono il processo di visualizzazione chiamato pipeline grafica.

La telecamera

La telecamera (figura 1.28) è l’apparecchiatura che provvede a effettuare le riprese e a

tradurre le immagini raccolte nei corrispondenti segnali elettrici. È costituita da quattro parti: il corpo camera, l’obiettivo, il mirino e il supporto.

Figura 1.28

Una videocamera

Il corpo camera

Il corpo camera è la parte che propriamente genera il segnale elettrico in funzione

dell’immagine ricevuta dall’obiettivo.

Il corpo di una videocamera (in bianco e nero) è costituito da due principali unità: il

sensore d’immagine e la parte circuitale (figura 1.29).

Figura 1.29

Il corpo macchina

31

C A P I TO L O

01

I sensori di immagine

Il sensore d’immagine è il trasduttore opto-elettrico che provvede a convertire l’informazione luminosa in informazione elettrica (figura 1.30). Il segnale prodotto, non

ancora adatto alla riproduzione, verrà poi elaborato dalla parte circuitale.

Figura 1.30

Due tipi di sensori d’immagine

Il tubo da ripresa

Dispositivo costituito da un tubo a vuoto di forma cilindrica contenente da una parte

una sorgente di elettroni e terminante sulla parte opposta con una superficie fotoconduttiva (figura 1.31). Per fotoconduttività si intende la proprietà per cui una sostanza è

in grado di condurre corrente solo se colpita da radiazione luminosa.

Figura 1.31

La struttura di un tubo da ripresa

Il sensore allo stato solido (CCD)

Questo dispositivo è un componente optoelettronico integrato di piccole dimensioni,

in cui gli elettroni sono generati e spostati all’interno della sua struttura (stato solido)

senza dover ricorrere al complesso supporto del tubo a vuoto.

La composizione del CCD prevede tre elementi paralleli (figura 1.32): uno strato fotoconduttivo (che riceve l’immagine dall’obiettivo), una porta di trasferimento e uno

strato CCD vero e proprio.

32

Hardware e software

Figura 1.32

Lo schema di un CCD

Lo strato fotoconduttivo è ripartito in tante cellette, ciascuna capace di generare un

elemento d’immagine o “pixel”. Una volta raggiunto dalla luce, questo strato rende

liberi, all’interno di ciascuna celletta, alcuni elettroni, in numero proporzionale all’intensità luminosa dei vari raggi incidenti. Ogni cella si troverà pertanto caricata con

una quantità di elettroni variabile, a seconda delle diverse sfumature dell’immagine.

La porta di trasferimento svolge la funzione di otturatore elettronico: essa cioè è normalmente chiusa e si apre solo in corrispondenza dei tempi di ritorno della scansione,

trasferendo gli elettroni liberati nelle cellette, dallo strato fotoconduttore al CCD.

Lo strato CCD infine, ripartito anch’esso in cellette corrispondenti a quelle del fotoconduttore, ricevuti gli elettroni li scarica di cella in cella verso una porta di uscita

laterale, generando il segnale video.

La parte circuitale