1.

Il Numero di Avogadro

I problemi che si erano accumulati, nel corso di tutto l’800, nel tentativo

di costruire una teoria atomica della materia hanno richiesto e dato origine,

tra il 1900 e la fine degli anni ’20, a una revisione profonda dei concetti

fondamentali della Meccanica.

La costituzione atomica della materia era stata suggerita, fino dai primi

dell’800, dalla sistemazione delle leggi fondamentali della chimica, in particolare dalla legge delle proporzioni multiple di Dalton, per la quale, nella

formazione di diversi composti a partire dalle stesse sostanze, le quantità di

ciascuna sostanza che entrano nella formazione dei diversi composti stanno

fra loro come numeri interi e piccoli.

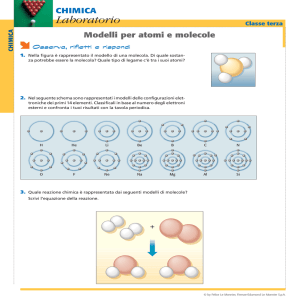

I componenti fondamentali della materia che spiegano la legge di Dalton

sono chiamati atomi; ogni elemento chimico è pensato come formato da atomi

identici, ed è essenziale che tali atomi passino invariati in tutti i processi

chimici. D’altra parte, corrispondendo agli elementi della chimica, gli atomi

devono rendere conto di una serie piuttosto articolata di proprietà, associate

in particolare ai legami che possono formare tra loro e che sono la base della

formazione delle molecole e di tutta la chimica.

Qualsiasi modello meccanico degli atomi deve soddisfare questi requisiti

di complessità e di stabilità; requisiti che incontrano, nel corso dell’800, difficoltà di realizzazione che aumentano al crescere delle conoscenze sui possibili

costituenti degli atomi e delle loro interazioni.

La prima domanda che nasce in vista di una descrizione meccanica degli

atomi è quella sulle loro dimensioni. La legge di Dalton è compatibile con

qualsiasi dimensione degli atomi e richiede solo la loro identità e stabilità.

La stessa indifferenza alle dimensioni atomiche è comune a tutti gli effetti

ed i fenomeni che non dipendano dalle quantità di materia che coinvolgono,

cioè, nel linguaggio della Meccanica Statistica, a tutti gli effetti intensivi,

per esempio i calori specifici, per definizione indipendenti dalla grandezza

del campione in esame.

Per stimare le possibili dimensioni degli atomi occorre perciò studiare

fenomeni che fissino una scala, macroscopica ma dipendente dal carattere

discreto e dalle dimensioni dei costituenti della materia. Uno dei più semplici fenomeni con queste caratteristiche è la formazione delle gocce da un

rubinetto; le loro dimensioni sono infatti sostanzialmente sempre le stesse e

possono perciò dipendere solo dalla costituzione interna dell’acqua.

Vediamo come si possono stimare le dimensioni atomiche a partire

dal bilancio energetico del distacco di una goccia d’acqua. Supponiamo

1

che l’acqua sia formata da costituenti elementari identici (molecole), che lo

stato liquido sia il risultato di forze di coesione tra le molecole e che queste

forze agiscano solo tra molecole vicine.

Per semplicità, in vista di una stima di un ordine di grandezza, trattiamo

una goccia in formazione come se avesse una forma geometrica costante, per

esempio una semisfera, di raggio R; la forza di gravità sulla goccia è data

dalla sua massa per l’accelerazione di gravità e la sua energia potenziale

gravitazionale vale

U (R) = ρ (2π/3 R3 ) g (−3/8 R) ,

−3/8 R essendo l’altezza del baricentro rispetto al piano di formazione della

goccia.

Se l’energia della goccia non avesse altri contributi, non ci potrebbe essere

equilibrio per nessun R positivo. Ma la goccia è costituita di molecole, che

supponiamo interagire con quelle più vicine; ad ogni coppia di molecole vicine

sarà associata una energia potenziale di interazione negativa (altrimenti le

molecole si staccherebbero e formerebbero un gas e non un liquido), che

indichiamo con −ε.

Al variare delle dimensioni della goccia, il numero delle coppie di molecole

di acqua interagenti (nella goccia e nel rubinetto) cambia leggermente come

risultato del cambiamento dell’area della superficie della goccia: le molecole

del primo stato superficiale hanno infatti come prossime vicine un numero

minore di molecole rispetto a quelle interne; supponendo per semplicità che

le interazioni avvengano tra molecole vicine situate su un reticolo cubico,

alle molecole superficiali mancherà una delle 6 molecole vicine. All’energia

interna dell’acqua, per il resto indipendente da forma e dimensioni della goccia, mancherà perciò un contributo E(R) proporzionale al numero di goccie

nel primo strato superficiale.

Se in un centimetro cubo d’acqua si trovano N molecole, il loro volume è

1/N centimetri cubi, le loro dimensioni (stimate come il lato di un cubetto)

1/N 1/3 centimetri. Il primo strato consiste perciò di 2πR2 N −1/3 N molecole

e l’energia di legame mancante associata alla superficie è

E(R) = 2πR2 N 2/3 ε/2 ,

l’ultimo fattore 1/2 essendo richiesto dal conteggio delle coppie mancanti. Il

rapporto tra questa energia (positiva, perchè “mancante” rispetto a quella

negativa di legame tra molecole in assenza di effetti superficiali) e la superficie

si chiama tensione superficiale e chiaramente dipende da N , cioè dalle

dimensioni delle molecole.

2

L’energia totale delle goccia è Etotale = U (R) + E(R) ed è crescente per

piccoli R e poi decrescente. Per piccoli R la goccia mantiene una coesione,

anzi tenderebbe a contrarsi, e si accresce infatti solo per la pressione dell’acqua che si aggiunge dal rubinetto; la goccia si stacca nel momento in cui

la forza di gravità prevale su quella di coesione, cioè quando Etotale diventa

decrescente; derivando, si ottiene che il massimo di Etotale è raggiunto per

4ρ 2π/3 R3 3/8 g = 4πR N 2/3 ε/2 .

(1)

L’energia di interazione ε può essere stimata sulla base dell’energia richiesta per la vaporizzazione dell’acqua, che è precisamente il processo che separa

le molecole, e che richiede un’energia Evap uguale a quella di legame. Questa

è data da ε per il numero di coppie di molecole vicine; per un centimetro

cubo di acqua:

Evap = 6 N ε/2 ,

dove il fattore 6 conta le molecole interagenti con una data, il fattore 1/2 il

numero di coppie in interazione.

L’eq. (1) diventa perciò

ρ R2 g = 4 N −1/3 Evap /6 ,

cioè

N 1/3 = 2/3 Evap /(ρ R2 g) .

(2)

Usando grammi, centimetri e secondi come unità di misura, ρ = 1,

g = 103 ; l’energia di vaporizzazione si misura facilmente (basta far evaporare l’acqua su un fornello elettrico di potenza nota) e vale circa 700 calorie/grammo, cioè 700 ∗ 4 = 2.8 103 Joule = 2.8 1010 erg. Il raggio delle gocce

al momento del distacco è dell’ordine di 0.3 cm e il risultato per N è perciò

N 1/3 = 2/3 ∗ 2.8 1010 /(9 10−2 ∗ 103 ) ∼ 2 108 , N = 8 1024 ,

corrispondente a dimensioni molecolari N −1/3 dell’ordine di una frazione di

10−8 centimetri.

In realtà, il numero di molecole presenti in una mole, cioè in una quantità

in grammi pari al peso molecolare della sostanza data, è il numero di Avogadro, che vale circa 6 1023 . Perciò in un grammo di acqua, che consiste di circa

1/18 di mole (il peso atomico dell’ossigeno è circa 16, quello dell’idrogeno 1),

sono in realtà presenti 1/18 ∗ 6 1023 = 1/3 1023 molecole.

La nostra stima per N 1/3 è dunque sbagliata per circa un fattore 6, e

le dimensioni atomiche sono in realtà dell’ordine di 10−8 centimetri, unità

3

che si denota anche come un Ängstrom. Simili stime hanno tuttavia un

grande interesse di principio, dato che mettono in relazione una grandezza

apparentemente lontana e inaccessibile come la dimensione degli atomi con

fenomeni ben noti e facilmente quantificabili.

Inoltre, si potrebbe vedere che l’errore è dell’ordine di grandezza di quello

associato all’estrema semplificazione della descrizione delle gocce, il cui distacco avviene in realtà con un cambiamento radicale di forma, come anche

si osserva facilmente.

Imponendo il bilancio energetico su una forma geometrica costante abbiamo sostanzialmente vincolato le gocce a seguire un percorso speciale e

non realistico; in tali condizioni, il distacco avverrebbe più tardi, cioè con

un raggio maggiore di quello reale, e in effetti avremmo ottenuto il numero

di Avogadro corretto inserendo nella formula finale un raggio poco più che

doppio.

2.

I gradi di libertà atomici

Data una stima delle possibili dimensioni degli atomi, occorre capire quali variabili si rendano necessarie per la costruzione di un modello atomico,

incominciando dal numero dei possibili gradi di libertà.

Per far questo bisogna individuare dei fenomeni che dipendano da tale

numero e possibilmente quantificarne la dipendenza. Assumendo la costituzione atomica della materia, e interpretando i fenomeni termici in termini di

scambi di energia con i gradi di libertà dei costituenti, l’energia meccanica

degli atomi si può identificare con l’Energia interna che il primo principio

della Termodinamica attribuisce agli stati di equilibrio termico dei sistemi

macroscopici.

I calori specifici (per semplicità a volume costante in modo da escludere

il lavoro delle forze di pressione) divisi per il numero di atomi o molecole,

che abbiamo stimato, misurano allora la variazione di energia dei singoli

costituenti al variare della temperatura del sistema. Se fossimo in grado di

stimare l’energia da fornire a ciascun grado di libertà atomico per aumentare

la temperatura di un grado, i calori specifici, confrontati con il numero di

Avogadro, darebbero un’informazione diretta sul numero dei gradi di libertà

atomici.

4

Temperatura ed energia cinetica

La stima di tali energie è piuttosto semplice nel caso di un gas perfetto, cioè

un gas per cui valga la relazione

pV = nRT ,

(3)

V il volume, n il numero di moli di gas, T la temperatura assoluta (definita

proprio da questa relazione), R una costante, che vale circa 8 Joule per mole

e grado. L’eq.(3) si può infatti derivare da un modello che descrive gli atomi

come punti materiali, con i soli gradi di libertà di posizione, con interazioni

trascurabili, identificando, a meno di una costante di scala, temperatura assoluta e energia cinetica media degli atomi. L’analisi che segue viene attribuita

a Clausius, ma risale a Waterstone, una decina di anni prima di Clausius (la

storia, molto istruttiva, è ricostruita da Brush, nel libro “The kind of motion

we call heath”)

Consideriamo una scatola contenente un gas, descritto come un insieme

di punti materiali (o “particelle”) di massa m, che rimbalzano elasticamente

sulle pareti. Fissiamo una porzione di parete di area unitaria, ortogonale

all’asse x. Indicando con vx la componente lungo l’asse x dellla velocità di

una particella, diretta verso la parete, la quantità di moto ceduta alla parete

con un rimbalzo è diretta come l’asse x e vale 2mvx . Il numero di particelle

che urtano la parete per unità di tempo e intervallo di velocità è ρ(vx ) vx dvx ,

con ρ(vx ) il numero di particelle per unità di volume e di intervallo di velocità,

che supponiamo uniforme nella scatola; ne segue che la forza che occorre

esercitare sulla parte per tenerla ferma, uguale alla variazione di quantità di

moto nell’unità di tempo, è

F = 2m

Z ∞

0

dvx vx2 ρ(vx ) ,

dove si integra solo sulle velocità dirette verso la parete. Assumendo che la

densità non dipenda dal segno della velocità, si ottiene

F = mρ < vx2 > ,

dove ρ indica la densità (uniforme) del gas (numero di particelle per unità di

volume) e < vx2 > la loro velocità (lungo l’asse x) quadratica media. La forza

che abbiamo calcolato non è altro che la pressione p del gas, che soddisfa

l’eq.(3).

Considerando una mole di gas, contenente cioè N particelle, N il numero

di Avogadro, la densità è ρ = N/V . Si ottiene perciò, confrontando le due

5

espressioni per la pressione,

m N/V < vx2 >= R T /V ,

cioè

m < vx2 >= R/N T .

R/N si chiama costante di Boltzmann e si indicacon k; il risultato è che

l’energia cinetica media delle particelle vale 3/2 k T , o anche che l’energia

cinetica media per grado di libertà è 1/2 k T .

In particolare, il calore specifico per mole, a volume costante, di tutti i

gas descrivibili come punti materiali con interazioni trascurabili, è previsto

valere 3/2 k, a ogni temperatura. Questa relazione è ben verificata sperimentalmente per i gas monoatomici, le cui molecole sono cioè costituite da

singoli atomi. In questo caso, il modello descrive perciò completamente l’energia trasferita ai gradi di libertà atomici; per quanto riguarda le legi dei

gas, questo rappresenta un successo del modello, ma dal punto di vista della

identificazione dei gradi di libertà interni degli atomi, necessari per spiegarne

le proprietà, il risultato è del tutto negativo: nessun grado di libertà interno

contribuisce al bilancio energetico descritto dal primo principio della Termodinamica. Inoltre, nel caso dei gas poliatomici, costituiti cioè da molecole

formate da più atomi, i calori specifici osservati sono maggiori e dipendono

dalla temperatura.

Si pongono perciò le domande seguenti: è possibile che, trasferendo energia a un sistema meccanico, ci siano gradi di libertà che restano esclusi da

tale trasferimento? Si può prevedere in generale il contributo dei diversi gradi

di libertà ai calori specifici? Si possono almeno spiegare i calori specifici dei

gas poliatomici con modelli che sostituiscano ai punti materiali un qualche

modello delle molecole?

Per rispondere è necessario introdurre i principi della Meccanica Statistica, che descrive, per sistemi meccanici con un grande numero di costituenti,

configurazioni interpretabili come stati di equilibrio termico nel senso della

Termodinamica.

I fondamenti della Meccanica Statistica

Consideriamo un sistema formato da un gran numero di costituenti, la cui

energia sia la somma delle energie dei singoli costituenti e di energie di mutua interazione. Nel limite di un numero infinito di costituenti, una

6

grande classe di configurazioni del sistema darà origine a una ben definita

distribuzione statistica per le variabili dei suoi costituenti; per esempio, in un gas, formato da un numero di molecole dell’ordine del numero di

Avogadro, ci si potrà chiedere quante molecole hanno velocità comprese in

un certo intervallo. Tale statistica sembrerebbe dipendere in modo sostanziale dalle configurazioni considerate; in realtà, per la maggior parte delle

configurazioni, in un senso che preciseremo almeno in parte, la statistica risultante dipende da pochi parametri, nel caso più semplice dal solo valore

medio dell’energia.

Verificheremo queste affermazioni nel caso di un sistema la cui energia

sia la somma di termini quadratici, per esempio un insieme di punti materiali, un insieme di oscillatori armonici, o un insieme di corpi rigidi (la

cui energia è quadratica nei momenti coniugati agli angoli che descrivono le

configurazioni). In questa discussione faremo uso di variabili canoniche, in

pratica coordinate qi e momenti coniugati pi , che danno origine a una misura

Q

i dpi dqi invariante sotto la dinamica; le variabili di posizione e velocità sono

tutttavia sufficienti per la maggior parte degli argomenti e delle conclusioni.

Consideriamo perciò un sistema descritto da 2N coordinate (canoniche),

con energia

H=

N

X

ai /2 p2i + bi /2 qi2 .

i=1

Per semplicità consideriamo il caso in cui tutti i coefficienti ai e bi siano

strettamente positivi (le modifiche necessarie nel caso di coefficienti nulli

sono piuttosto semplici). Si può anche scrivere

H=

2N

X

ci /2 x2i .

i=1

Fissiamo l’energia in modo proporzionale al numero di coordinate,

H = NE ,

e costruiamo, per cominciare, la statistica che si ottiene se si distribuiscono le

configurazioni dell’intero sistema in modo uniforme (rispetto all’elemento di

volume dato dalle coordinate canoniche, invariante per evoluzione nel tempo)

su tale superficie a energia data.

Nel caso ci = 2, ∀i, la superficie a energia N E è una sfera di raggio R,

con R2 = N E e la distribuzione per ciascuna delle variabili xi , al variare delle

configurazioni con la misura definita dall’area della sfera, normalizzata a 1, è

ottenuta esplicitando l’integrale che definisce l’area della sfera in termini di

7

una delle coordinate; il risultato è una misura di probabilità p(x) dx, con p(x)

proporzionale all’area S2N −1 (r) della sfera di raggio r, in 2N − 1 dimensioni,

con

r2 = (R2 − x2 ) .

Perciò

p(x) = C2N −1 (N E − x2 )(2N −2)/2 = CN0 (1 − x2 /N E)(2N −2)/2 .

Non è necessario calcolare le costanti C, C 0 , dato che per definizione p(x) ha

integrale 1; l’ultimo termine a destra si riduce alla successione che definisce

il numero e; perciò, nel limite N → ∞,

p(x) = exp −x2 /E

a parte una normalizzazione. La stessa derivazione si applica alla distribuzione di un numero finito qualsiasi n di variabili xi , proporzionale all’area di

una sfera in dimensione 2N − n:

p(x1 . . . xn ) = exp −

n

X

x2i /E ,

i=1

a parte la normalizzazione. La conclusione è che, nel limite N → ∞, la

distribuzione di un numero qualsiasi di variabili xi è gaussiana, di larghezza

E. Il caso di coefficienti ci > 0 qualsiasi si ottiene con un cambio di variabili,

xi = (ci /2)1/2 yi ; a parte una normalizzazione, si ottiene

p(y1 . . . yn ) = exp −

n

X

ci /2 yi2 /E .

(4)

i=1

La media di ciascuna delle variabili yi2 si calcola immediatamente usando

Z

Z

2

x exp(−ax) dx /

exp(−ax) dx = d/da log(a1/2 ) = 1/2a

e si ottiene

ci /2 < yi2 >= E/2 .

(5)

Il risultato sembra dipendere in modo sostanziale dalla statistica definita

dalla distribuzione uniforme, che indicheremo con dµN E (x), sulla superficie

a energia N E dell’intero sistema. Per discutere la dipendenza da questa

ipotesi, supponiamo per semplicità che tutti i coefficienti ci siano uguali,

per esempio ci = 2; l’argomento si applicherà facilmente anche al caso in cui

i ci assumano un numero finito di valori, corrispondenti ai diversi gradi di

8

libertà (di traslazione, rotazione, vibrazione, ecc.) di costituenti atomici o

molecolari tutti identici tra loro.

Supponiamo di definire sulla superficie a energia costante statistiche diverse, ottenute per esempio con la distribuzione uniforme su un sottoinsieme,

di area pari a una frazione di quella dell’intera sfera; più in generale, possiamo considerare distribuzioni di probabilità della forma FN (x) dµN E (x).

Assumeremo solo che le funzioni FN (x) siano limitate da una costante indipendente da N , il che significa che la distribuzione non si concentra, al

variare di N , su insiemi di misura arbitrariamente piccola sulle sfera.

Date le distribuzioni di probabilità FN (x) dµN E (x), consideriamo la statistica che ne deriva per qualsiasi numero finito di variabili xi e facciamone

la media sulle traslazioni degli indici i (più in generale sulle traslazioni dell’indice che elenca atomi o molecole identiche); per esempio, se pF (xi ) sono

le distribuzioni per le variabili xi , consideriamo la distribuzione definita da

p̃F (xj ) = 1/2N

X

pF (i)

∀j

i

e, analogamente,

X

p̃F (xj1 , . . . xjn ) = 1/2N

pF (xj1+i , . . . xjn+i ) .

i

L’operazione di media è importante anche per l’interpretazione del risultato,

che descriverà la statistica che si ottiene al variare dei costituenti, per esempio

la statistica delle velocità sulle diverse molecole, data la distribuzione di

partenza definita da FN .

Supponiamo che, per una data successione FN , il limite, per N → ∞, per

la distribuzione di probabilità in un qualsiasi numero finito di variabili esista

(il limite esiste sempre pur di passare a sottosuccessioni, per la compattezza

dell’insieme delle misure di probabilità nello spazio duale dello spazio delle

funzioni continue). Per la condizione di limitatezza uniforme FN ≤ C, la

misura limite dνF soddisfa, integrando con una qualsiasi funzione positiva f

di un qualsiasi numero finito di variabili xi ,

Z

Z

dνF f ≤ C

dν f

dove dν = dν1 è la misura costruita in precedenza (identificabile con la

presente costruzione per FN = 1 , ∀N , dato che in questo caso la media sulle

traslazioni dell’indice i è irrilevante).

Ne segue (per il teorema di Radon-Nikodym) che la misura dνF si scrive

in termini di una densità rispetto a dν:

dνF = gF (x) dν .

9

Ma per costruzione dνF è invariante, come dν, per traslazione degli indici, e

perciò lo è anche gF . Ora, la misura dν (in infinite variabili) è ergodica per

traslazioni, cioè le sole funzioni dν misurabili e invarianti per traslazioni sono

le costanti; ne segue gF = 1 e

dνF = dν .

L’ergodicità per traslazioni di dν si vede facilmente usando il fatto che

per costruzione dν è definita, come misura in infinite variabili, dalla statistica

sulle funzioni di un numero finito qualsiasi di argomenti; per costruzione,

tali funzioni (che indichiamo per semplicità con f (xi ) anche se si tratta di

funzioni di un numero finito qualsiasi di argomenti) approssimano le funzioni

h misurabili e limitate, h ≤ M , a meno di un errore piccolo come si vuole,

nel senso

Z

dν |h − fε |2 < ε2 ;

se h è invariante per traslazioni degli indici, per l’invarianza di dν, vale anche

Z

dν |h − fε (xi+m )|2 < ε2

∀m ;

ne segue, dalla diseguaglianza di Schwartz,

Z

dν (h − fε (xi ))(h − fε (xi+m )) < ε2

∀m ;

prendendo m abbastanza grande, gli indici degli argomenti delle due f sono

disgiunti e, essendo dν il prodotto delle corrispondenti misure, l’integrale del

loro prodotto è il prodotto degli integrali. Perciò:

Z

Z

dν (h2 − 2hfε ) + (

dν fε )2 < ε2 ∀m ;

inoltre, per Schwartz e per la limitatezza di h,

Z

Z

dν |h − fε | < ε ,

e perciò

Z

dν |h(h − fε )| < M ε

Z

2

dν h − ( dν h)2 < M ε + 2ε2 ,

e h può differire da una costante solo per meno di qualsiasi numero positivo

dato e su un insieme di misura piccola come si vuole.

La conclusione è perciò che la distribuzione di probabilità data dall’eq.(4)

si presenta con grande generalità per un sistema grande, e che i suoi sottosistemi, anche grandi, si possono pensare tutti in equilibrio tra loro, in un

10

senso molto simile a quello dell’equilibrio termico, con il parametro E che

gioca il ruolo della temperatura.

Anzi, intepretando le distribuzioni ottenute come stati di equilibrio termico, se il sistema che stiamo considerando contiene un gas perfetto come

sottosistema (con le coordinate di posizione che non contribuiscono al’energia), confrontando l’eq.(5) con l’energia cinetica media pe i gas perfetti si

ottiene

E = kT

e la distribuzione (4) si scrive anche

p(y1 . . . yn ) = exp −H(y1 . . . yn )/kT ,

(6)

dove H(y1 . . . yn ) è l’energia del sottosistema descritto dalle coordinate (yi ,

i = 1 . . . n.

In generale, l’eq.(6) si indica come distribuzione di Gibbs, associata alla

funzione energia H; la si deriva, generalizzando il procedimento che abbiamo

appena descritto, da distribuzioni di un sistema grande della stessa forma di

quelle che abbiamo considerato sopra, per sistemi di un numero grande di

particelle.

In tale generalità, per l’esistenza del limite N → ∞ è essenziale che

l’energia potenziale di interazione tra le particelle si azzeri abbastanza rapidamente al crescere della distanza e soddisfi una condizioni di stabilità, che

ha la funzione di rendere poco probabili, attribuendo loro energie abbastansa alte, configurazioni con molte particelle in regioni piccole. Le condizioni di stabilità valgono per potenziali fortemente repulsivi vicino all’origine,

mentre sono violate, insieme alle condizioni di decrescenza all’infinito, dalle

interazioni Coulombiane.

Il principio di equipartizione e i calori specifici dei gas e dei solidi

Ritornando a sistemi con energia quadratica nelle variabili, il risultato principale della nostra analisi è l’eq.(5), cioè l’equipartizione dell’energia tra i gradi

di libertà, più precisamente tra le coordinate (canoniche) che vi contibuiscono con coefficienti non nulli. Insieme alla identificazione E = kT , questo

implica che i calori specifici di tali sistemi valgono, per una mole, cioè per

una massa corrispondente a un numero di Avogadro N di costituenti atomici

o moleolari, ciascuno con s coordinate che contribuiscono all’energia

cV = s/2 N k = s/2 R .

11

Descrivendo i gas biatomici e poliatomici rispettivamente come coppie di

punti a distanza fissa e come corpi rigidi, si ottiene nei due casi s = 5 e

s = 6, cioè cV = 5/2 R e cV = 3 R.

Queste relazioni sono verificate solo a temperature “intermedie”, per

esempio, per l’ossigeno e l’azoto, alle temperature ambiente ordinarie, mentre si ottengono calori specifici più bassi a temperature minori e più alti a

temperature maggiori.

Per cercare di spiegare quest’ultimo risultato, si possono descrivere le

molecole dei gas come sistemi di punti che oscillano intorno a posizioni di

equilibrio; ma in questo caso, ogni coppia di posizioni e velocità che si aggiunge alla descrizione (con energia che si può assumere quadratica trattandosi

di piccole oscillazioni) porta un contributo R al calore specifico.

Il calore specifico previsto per i gas poliatomici cresce perciò al crescere

della precisione con cui si descrivono le loro molecole e diventa molto grande

per le molecole composte di molti atomi, in modo del tutto non realistico.

Inoltre, nel caso dei gas monoatomici, i gradi di libertà interni degli atomi,

necessari per spiegare le loro diverse proprietà di legame, dovrebbero contribuire al calore specifico con un termine R/2 per ogni componente di velocità

(essendo l’energia cinetica quadratica nelle velocità) e per un termine non

negativo per le coordinate; infatti i contributi ai calori specifici si ottengono

derivando rispetto a T le energie medie definite dall’eq.(6) e il risultato è

semptre positivo anche per i termini di potenziale.

La spiegazione di Clausius dei calori specifici osservati per i gas monoatomici si rovescia perciò in un disastro non appena ci si chieda quale sia il

contributo di altri gradi di libertà. Resta solo la possibilità di ritenere inadeguata, eccetto che per i gradi di libertà di traslazione e in parte per quelli di

rotazione, la trattazione statistica dei fenomeni termici, una questione sulla

quale infatti si è discusso a lungo nella seconda metà dell’800. Tale possibile inadeguatezza appare associata ai gradi di libertà interni degli atomi e a

quelli più rigidi, cioè che vibrano ad alta frequenza, nel caso delle molecole

poliatomiche,

Questo quadro viene confermato da una discussione dei calori specifici dei

solidi. Considerando un solido come un insieme di particelle che compiono

piccole oscillazioni intorno a posizioni di equilibrio, che formano per

esempio un reticolo cristallino, si ottiene, per il solito numero N di particelle,

un calore specifico

cV = 3 R ,

essendo 6N le coordinate, di posizione e velocità degli atomi, con energia

quadratica. Questo vale qualunque sia l’energia potenziale di oscillazione

12

come forma quadratica sugli spostamenti rispetto alle posizioni di equilibrio;

infatti, qualsiasi forma quadratica, strettamente positiva, si diagonalizza, con

autovalori tutti positivi, con un cambiamento ortogonale di coordinate.

Sperimentalmente, i calori specifici dei solidi assumono un valore vicino a 3 R solo a temperature relativamente alte, dell’ordine di quelle ordinarie; scendendo in temperatura, i calori specifici dei solidi diminuiscono

sensibilmente, e anzi tendono a zero nel limite di temperatura assoluta zero.

Tale comportamento è anzi stato osservato in tutti i sistemi ed è in relazione con il principio di Nerst, che afferma che l’entropia S di qualsiasi

sistema rimane finita nel limite di temperatura zero e implica, poichè per

definizione

dS = cV dT /T

che i calori specifici (positivi per il secondo principio della termodinamica)

tendono a zero nel lmite T → 0.

Considerando che lo spettro di frequenza delle oscillazioni nei solidi è in

sostanza lo spettro di frequenza delle onde di spostamento di materia che

vi si propagano, che va da zero a un certo massimo, anche per i solidi la

situazione è consistente con l’ipotesi che, a temperatura data, solo i gradi di

libertà con frequenza sufficientemente bassa, per esempio

ν < α kT ,

α una qualche costante, contribuiscano agli scambi di energia e perciò ai

calori specifici.

3.

Termodinamica del campo elettromagnetico

Abbiamo visto come la costruzione di modelli per gli atomi e le molecole

sia scontri con il problema della identificazione del numero stesso dei loro

gradi di libertà; i dati sperimentali sui calori specifici non sono infatti consistenti con i risultati più generali della descrizione meccanico-statistica degli

stati termici e sembrano paradossalmente indicare un numero di gradi di libertà dipendente dalla temperatura, o comunque dall’energia dei costituenti

atomici e molecolari.

13

Le implicazioni di questo fatto non sono tuttavia univoche in conseguenza della natura ipotetica della descrizione meccanica dei sistemi atomici, che

avrebbe dovuto essere chiarita proprio dalla discussione degli scambi energetici. Per risalire in modo univoco all’origine delle difficoltà occorrerebbe

a questo punto esaminare gli stati termici e gli scambi energetici in sistemi la cui descrizione meccanica fosse completamente nota e possibilmente

semplice.

Un sistema con queste caratteristiche è il campo elettromagnetico, che

nel vuoto soddisfa equazioni lineari, le equazioni di Maxwell, che si possono

ridurre a equazioni delle onde e riscrivere in termini di una collezione di

oscillatori armonici.

Gli oscillatori del campo elettromagnetico

Le equazioni di Maxwell sono equivalenti alle equazioni d’onda per dei potenziali vettori Ai , che soddisfano ∂i Ai = 0,

∂t2 Ai = c2 ∂k ∂k Ai

con c la velocità della luce. I campi elettrici e magnetici sono dati da Ei =

∂t Ai /c, B = rot A.

Il sistema che vogliamo discutere è il campo elettromagnetico all’interno

di una regione, che per semplicità assumiamo cubica, con lato L. Assumendo

al bordo condizioni di riflessione come da una superficie perfettamente conduttrice, le configurazioni del campo si possono espandere in autofunzioni

del laplaciano in tre dimensioni con condizioni al bordo zero

Ai (x, t) =

X

1/c (2/L)3/2 ελi aλn (t) sin πn1 x1 /L sin πn2 x2 /L sin πn3 x3 /L

n,λ

con ελi , λ = 1, 2 due vettori indipendenti ortogonali al vettore n in modo da

soddisfare la condizione ∂i Ai = 0. Il fattore 1/c serve solo a semplificare la

successiva espressione dell’energia; il secondo fattore normalizza le autofunzioni del laplaciano; le “polarizzazioni” λ non hanno nessun ruolo importante

nel seguito. Omettendole per semplicità, scriviamo, con k = πn/L,

A(x, t) =

X

1/c (2/L)3/2 an (t) sin k1 x1 sin k2 x2 sin k3 x3 .

I coefficienti an (t) soddisfano le equazioni

d2 /dt2 an (t) = −c2 n2 π 2 /L2 an (t) ,

14

(7)

che si possono scrivere in forma Hamiltoniana come

d/dt an = pn

, d/dt pn = −ω 2 (n2 , L) an ,

con Hamiltoniano

Hn = 1/2 (p2n + ω 2 (n2 , L) a2n ) ,

ω 2 (n2 , L) = c2 n2 π 2 /L2 .

(8)

Sommando sui modi dell’espansione e usando ortonormalità e completezza

delle autofunzioni, si riproduce l’energia del campo elettromagnetico.

Se le pareti della scatola contenente campo elettromagnetico si trovano in

uno stato termico, a temperatura T , il campo sarà in equilibrio con le pareti;

il sitema di (infiniti) oscillatori che lo descrive sarà cioè in uno stato termico,

alla stessa temperatura T .

È evidente che, dato che il sistema consiste di infiniti oscillatori, i suoi

stati termici non possono soddisfare il principio di equipartizione dell’energia, che sarebbe infinita, insieme con il calore specifico. Il problema della

distribuzione dell’energia tra gli oscillatori è perciò in questo caso ineludibile

per l’esistenza stessa degli stati termici.

I principi dell’equilibrio termico

È perciò di grande interesse esaminare i vincoli che i principi della termodinamica pongono alla distribuzione dell’energia tra gli oscillatori. La prima

osservazione è che la densità di energia per unità di volume, u, per volumi

grandi, come richiede in generale il limite termodinamico, deve essere indipendente dal volume e dalla forma della scatola, u = u(T ). Inoltre, la

distribuzione dell’energia può dipendere solo dalla frequenza ν e non dalla

direzione dei vettori k e definisce una funzione uT (ν); infatti, se si trovassero

sistemi alla stessa temperatura con distribuzioni diverse, utilizzando i flussi

di energia associati alle diverse frequenze (proporzionali, in generale per le

onde elettromagnetiche, alle densità di energia), si potrebbe trasferire energia

da un sistema all’altro e ottenere lavoro da sorgenti alla stessa temperatura.

La distribuzione dell’energia tra gli oscillatori si riduce perciò allo studio

delle possibili forme della funzione uT (ν). Notiamo che la temperatura assoluta T , che deve esistere per il secondo principio della Termodinamica, è per

il momento sconosciuta nella sua relazione con l’energia del sistema e ha il

solo ruolo di parametrizzare gli stati di equilibrio termico.

Per ottenere la dipendenza di u da T e da ν conviene partire dalle informazioni che si possono ottenere dalla meccanica degli oscillatori discutendo

15

cambiamenti dei parametri del sistema in assenza di scambi di calore. Tali

trasformazioni, che si chiamano adiabatiche in Termodinamica, da una parte,

se eseguite in maniera suficientemente lenta, mantengono il sistema, ad ogni

loro stadio, in stati di equilibrio termico; dall’altra, non coinvolgendo scambi

di calore, possono essere discusse usando relazioni puramente meccaniche.

Le trasformazioni adiabatiche

Supponiamo perciò di cambiare lentamente il volume V della scatola, per

esempio scalando tutti i lati dello stesso fattore. In questo caso, i singoli

oscillatori di cui si compone il sistema si trovano con un Hamiltoniano che

dipende dal tempo attraverso la dipendenza della frequenza dal lato L della

scatola, eq.(8).

Occorre perciò chiedersi come cambia nel tempo l’energia di un oscillatore

sottoposto a un tale cambiaento dei parametri. La risposta è che, nel limite

di variazioni molto lente, il rapporto tra energia e frequenza rimane costante;

scriviamo infatti la derivata di H(t)/ω(t) rispetto al tempo, sulle traiettorie

che risolvono le equazioni definite da H(t):

d(H/ω)/dt = 1/ω (p dp/dt+ω 2 (t)q dq/dt+ q 2 ω dω(t)/dt)−H/ω 2 dω(t)/dt =

= ( q 2 − H/ω 2 )dω(t)/dt = 1/2 dω/dt (ω 2 q 2 − p2 )/ω 2 .

Il coefficiente di dω/dt si annulla se lo si integra su un periodo del sistema a

frequenza costante; ne segue che la variazione su un periodo di H(t)/ω(t) è

infinitesima rispetto a dω/dt e perciò la variazione totale si annulla, nel limite

dω/dt → 0, per una qualsiasi variazione finita di ω (controllare esplicitamente

assumendo ω(t) = f (t/n), t ∈ [0, n]).

Nel corso di una trasformazione adiabatica restano perciò costanti i rapporti tra le energie ε(n, L) dei singoli oscillatori e le loro frequenze ν(n, L) =

c/2 |n|/L; per le considerazioni di isotropia fatte sopra, le energie dipendono

anzi solo dal modulo di n. Possiamo perciò scrivere

ε(|n|, L) = ν ε/ν = ν f (|n|) = ν f (ν L) ,

(9)

dove ν indica la frequenza assunta dall’oscillatore indicizzato da n in corrispondenza di una lunghezza L del lato della scatola.

Al variare di L il sistema passerà per diversi stati di equilibrio, con temperature (per il momento sconosciute) T (L); la distribuzione di energia diventerà, esplicitando un fattore ν 2 di densità degli oscillatori in funzione

16

della frequenza e attribuendo agli oscillatori di frequenza ν l’energia data

dall’eq.(9),

uT (L) (ν) = ν 3 f (ν L) .

(10)

Il primo principio della Termodinamica

L’eq.(10) dà solo informazioni indirette sulla funzione uT (ν), ma fornisce

anche la base per ottenere la funzione T (L) ed essere cosı̀ tradotta in una

relazione tra u, ν e T . L’energia del sistema è infatti data da

Z

U =V

Z

3

−4

u(ν) dν = L L

(Lν)3 d(Lν) f (Lν) = cost L−1 .

Le trasformazioni adiabatiche soddisfano perciò

0 = d(LU ) = L dU + dL U = dU + U dL/L = dU + U/3 dV /V .

(11)

Il secondo termine dell’eq.(11) fornisce il lavoro compiuto dal sistema quando

cambia il volume, che si scrive anche P dV , con P la pressione del campo

sulle pareti della scatola; ne segue in particolare

P = u/3 .

(12)

Il primo principio della Termodinamica si scrive dunque

δQ = dU + u(T )/3 dV = V du + 4/3u dV .

(13)

Il secondo principio della Termodinamica

Scritto il primo principio, la temperatura assoluta è definita, a meno di costanti moltiplicative, come il fattore che trasforma δQ in un differenziale

esatto, δQ/T = dS, dove S sarà l’entropia. Calcolando nelle variabili u e V ,

la condizione di differenziale esatto si scrive

∂/∂V V /T = ∂/∂u 4/3 u/T ;

Usando per semplicità (non sarebbe necessario, data l’unicità del fattore

integrante) il fatto che T non dipende da V , si ottiene

1/T = 4/3 1/T − 4/3 u/T 2 dT /du ,

17

cioè

dT /du = 1/4 T /u , T = cost u1/4

, u = cost T 4 .

La legge di Wien

Conoscendo le equazioni delle adiabatiche e l’espressione della temperatura

assoluta, possiamo ora concludere il ragionamento sulla distribuzione dell’energia tra gli oscillatori: in una trasformazione adiabatica, poiché U L =

uL4 = cost, anche LT = cost e perciò (introducendo, per semplificare la

discussione in termini dimensionali, la costante di Boltzmann) l’eq.(10) si

scrive anche

uT (ν) = ν 3 f (ν/kT ) .

(14)

L’eq.(14) dà la forma più generale della funzione uT (ν) compatibile con i

principi della Termodinanica, che infatti la implicano e che sono soddisfatti

se uT (ν) è integrabile, dato che allora l’eq.(14) implica

u(T ) = cost T 4 .

È interessante vedere le implicazioni dell’eq.(ŕefuT) in termini dimensionali: poichè uT (ν) ha le dimensioni di un’energia divisa per un volume e

per una frequenza, c3 uT (ν)/ν 2 ha le dimensioni di un’energia, proporsionale infatti a quella di ciascuno degli oscillatori con frequenza vicina a ν. Se

dividiamo l’eq.(14) per ν 2 kT , in modo da confontare questa energia con il

principio di equipartizione, troviamo

c3 uT (ν)/ν 2 kT = c3 ν/kT f (ν/kT ) ≡ g(ν/kT ) .

Ora, g assume valori adimensionali e non può essere costante se uT (ν) è

integrabile; ciò permette di costruire una costante universale, indipendente

cioè da qualsiasi parametro variabile a seconda del sistema considerato, con le

dimensioni del rapporto tra un’energia e una frequenza, che si denota anche

con il termine azione. Se g non assume sempre lo stesso valore, tale costante

può per esempio essere costruita risolvendo l’equazione g(x) = c, che avrà

soluzioni non zero per almeno un valore di c. Alla stessa conclusione si arriva

scrivendo l’eq.(14) come

uT (ν) = (kT )3 (ν/kT )3 f (ν/kT ) = (kT )3 h(ν/kT ) ;

ne segue che il massimo della densità di energia in funzione della frequenza,

che si osserva abbastanza facilmente in un forno molto caldo o nella luce

18

solare, è dato dal massimo della funzione h; il punto in cui viene raggiunto

tale massimo definisce una costante con le dimensioni di un’azione.

Le somma di Planck su energie discrete

L’applicazione al campo elettromagnetico dei principi della Termodinamica

richiede dunque l’esistenza di una costante fondamentale, con le dimensioni

di un’azione, cioè una energia per un tempo, o anche una lunghezza per un

impulso, in altri termini un’area in uno spazio delle fasi.

D’altra parte, la funzione f (ν/kT ) resta indeterminata, e il solo argomento che fino a questo punto conosciamo per determinarla, la statistica sulle

configurazioni discussa sopra, porterebbe alla conclusione di equipartizione

dell’energia,

ν f (ν/kT ) = cost kT , g = cost ,

incompatibile con un’energia totale u(T ) finita (si noti anche che solo per

g = cost non si può costruire una costante di azione).

Determinare f richiede perciò una nuova teoria, che sostituisca la statistica sulle configurazioni nella descrizione dell’equilibrio termico. La proposta

di Planck è stata quella di una modifica in un certo senso minima di tale statistica, una modifica però con profonde implicazioni sulla descrizione delle

configurazioni di un sistema meccanico.

L’idea di Planck (o meglio, la sua presentazione più razionale a posteriori)

è di mantenere la conclusione degli argomenti statistici generali, nel senso di

adottare per le configurazioni un peso proporzionale a

exp(−E/kT ) ,

assumendo però che una costante h con le dimensioni di un’azione, che deve

apparire necessariamente in questa teoria, entri nella identificazione stessa

delle configurazioni degli oscillatori.

Invece di integrare il fattore esponenziale con la misura dp dq, Planck

propose di sommarlo su energie discrete,

En = n h ν

cioè di considerare le configurazioni degli oscillatori non come descritte da

variabili continue, di posizione e impulso, ma da una variabile, di energia,

quantizzata, che assuma cioè solo valori discreti.

19

Conviene notare che le aree dello spazio delle fasi tra due traiettorie successive con queste energie discrete sono costanti e valgono precisamente h,

dato che

Z

Z

E/ν = Edt = dp dq

dove gli integrali sono rispettivamente su un periodo e sulla regione racchiusa

dalla traiettoria a energia E e la seconda relazione può essere verificata esplicitamente usando l’equazione delle traiettorie. La modifica nella descrizione

del sistema può perciò essere intepretata come una discretizzione dello spazio

delle fasi che tratta gli stati del sistema in modo discreto e li associa ciascuno

a una unità h di area.

Consideriamo allora la distribuzione di probabilità, per i valori sopra

ipotizzati dell’energia,

p(n h ν) = exp(−n h ν/kT ) /

∞

X

exp(−n h ν/kT ) .

n=0

L’energia media ε per un oscillatore di frequenza ν in equilibrio alla temperatura T si calcola immediatamente. Ponendo β = 1/kT ,

ε=

X

n

p(n) nhν =

X

n h ν e−β n h ν /

n

X

e−β n h ν =

n

= d/dβ(1 − e−βhν )−1 (1 − e−βhν ) = h ν e−βhν /(1 − e−βhν )

Fissati β e ν, per h → 0 si ottiene ancora

h ν/β h ν = kT ,

come doveva essere, dato che la costante h rappresenta la lunghezza degli

intervalli in una somma il cui limite definisce un integrale di Riemann. Ma

per β e h fissi, il limite ν → ∞ è ben diverso: l’energia media e la sua derivata

rispetto a T , che fornisce il contributo del grado di libertà al calore specifico,

si annullano infatti esponenzialmente in questo limite.

Tale andamento esponenziale, che era da tempo osservato sperimentalmente per il campo elettromagnetico e che è stato in realtà la principale

motivazione della proposta di Planck, ha implicazioni risolutive su tutti i

problemi dei calori specifici, dando origine precisamente a una drastica riduzione dei contributi ai calori specifici da parte dei gradi di libertà che

oscillino con frequenze alte rispetto a kT /h. Per il campo elettromagnetico,

l’espressione risultante dalla somma di Planck per uT (ν),

uT (ν) = cost ν 2 h ν e−βhν /(1 − e−βhν )

20

è in perfetto accordo con i dati sperimentali. Anzi la costante h ne è determinata abbastanza precisamente, e vale circa 6.6 10−27 erg sec.

La teoria di Einstein dell’effetto fotoelettrico

La proposta di Planck sulle natura discreta dell’energia dagli oscillatori che

descrivono il campo elettromagnetico risale al 1900. Cinque anni dopo, Einstein mostra che le stesse ipotesi permettono di spiegare aspetti fino a quel

momento misteriosi dell’effetto fotoelettrico e portano in modo quasi obbligato ad associare alle onde elettromagnetiche delle particelle, che vengono

chiamate fotoni.

L’effetto fotoelettrico consiste nella estrazione di elettroni da un metallo

da parte di un fascio di luce incidente. Nella descrizione classica delle onde

elettromagnetiche, in ogni punto i campi, elettrico e magnetico, oscillano con

la frequenza dell’onda e con un’ampiezza il cui quadrato è proporzionale al

flusso di energia associato all’onda.

La dinamica di un elettrone in un metallo dipenderà dalle forze di interazione con gli atomi che lo costituiscono, che possono essere schematizzate con

una funzione di energia potenziale, dipendente dalla posizione dell’elettrone

e da quelle degli atomi. In una approssimazione ragionevole, si può trattare

un elettrone come in moto in un potenziale dato, che lo costringe all’interno

del metallo. In generale, estrarlo dal metallo richiederà un’energia, pari in

questo modello alla differenza ∆U di energia potenziale tra la regione interna

al metallo e lo spazio esterno. Sempre in questa semplice approssimazione,

fornendo a un elettrone un’energia E < ∆U , l’elettrone rimarrà nel metallo,

mentre per E > ∆U , l’elettrone uscirà con energia cinetica E − ∆U .

La corrente prodotta dagli elettroni che escono dal metallo e la loro energia cinetica sono misurabili facilmente osservando la corrente che si produce

tra una seconda superficie metallica che raccoglie gli elettroni e il metallo

stesso, attraverso un filo che li colleghi, e la dipendenza di tale corrente da

una differenza di potenziale contraria applicata tra il metallo e la superficie di raccolta; la corrente si arresta, infatti, quando la differenza di energia

potenziale supera l’energia cinetica degli elettroni.

L’energia ceduta dalla luce a un elettrone può dipendere dalla frequenza dell’onda, ma dipenderá soprattutto dall’ampiezza, e anche dalla durata

dell’illuminazione.

Gli esperimenti, che richiedono un apparato simile a una vecchia valvola di

radio (ma anche la cella di un giocattolo a energia solare genera una corrente

21

per effetto fotoelettrico) mostrano invece caratteristiche diverse e incompatibili con la descrizione classica. Non si osserva infatti alcuna corrente se la

frequenza della luce non supera una certa soglia, indipendentemente dalla

intensità e dalla durata del fascio luminoso; solo per frequenze maggiori di

tale soglia la corrente diventa proporzionale all’intensità della luce.

La spiegazione di Einstein assume che gli scambi di energia tra la luce e

gli elettroni non siano descritti dai campi oscillanti dell’elettromagnetismo

classico, ma avvengano per quanti di energia discreti, esattamente quelli

che proponeva Planck per la statistica delle onde elettromagnetiche in una

scatola.

Ciascuno di tali quanti ha l’energia ipotizzata da Planck, E = hν; ogni

quanto può essere assorbito da un elettrone, che ne acquista allora tutta l’energia. Per hν > ∆U l’assorbimento di un quanto fa perciò uscire l’elettrone

dal metallo, con un’energia cinetica hν−∆U ; se la frequenza è invece inferiore

a ∆U/h, l’uscita dal metallo è impossibile, a meno di un assorbimento di un

secondo quanto, in succssione cosı̀ rapida da prevenire la perdita dell’energia

assorbita con il primo, una possibilità rara se la luce non è estremamente

intensa.

La teoria di Einstein spiega molto bene l’effetto di soglia ed è confermata

dalla misura dell’energia cinetica degli elettroni che escono dal metallo. Se

ne conclude che al campo elettromagnetico devono essere associati quanti

discreti di energia, legata alla frequenza dalla relazione di Planck E = hν. Il

campo elettromagnetico sembra perciò consistere di particelle, che si chiameranno fotoni, in qualche modo associate alle onde elettromagnetiche, e perciò

in movimento alla velocità della luce.

L’impulso del fotone

A questo punto, le relazioni che abbiamo ottenuto per la variazione dell’energia dei singoli oscillatori del campo elettromagnetico possono essere interpretate in termini di impulso di tali particelle. Infatti, la relazione P = u/3,

eq.(12), tra pressione e densità di energia fornisce il bilancio dell’impulso tra

il campo elettromagnetico e le pareti della scatola e vale separatamente, per

la derivazione che ne abbiamo fatto, per ciascuna delle componenti alle diverse frequenze ν. Pensando i campi alla frequenza ν come descritti da particelle

di energia hν, possiamo confrontare tale pressione con quella calcolata alla

maniera di un gas in una scatola.

Consideriamo perciò una scatola contenente particelle che si muovono alla

22

velocità della luce, c, e hanno ciascuna quantità di moto p = pν . L’impulso

trasferito a una parete, per unità di superficie e di tempo, dalle particelle

che la urtano a un angolo θ con la normale è p = 2N c cos2 θ pν , con N la

densità delle particelle. Assumendo velocità distribuite in modo isotropo e

mediando sugli angoli si ottiene (un fattore 1/2 venendo come per i gas dalla

limitazione a velocità positive)

P = pν N c/3 .

Perciò

N c pν = u(ν) = N hν ,

dove la seconda relazione esprime il fatto che l’energia del campo è data dal

numero di particelle per l’energia di Planck hν. Perciò l’impulso di un fotone

di energia hν vale

p = h ν/c = h/λ .

λ la lunghezza d’onda della luce di frequenza ν.

L’associazione di un impulso ai quanti del campo elettromagnetico introdotti da Planck li trasforma a tutti gli effetti in particelle, di cui si possono

discutere per esempio gli urti con gli elettroni (effetto Compton) in termini

di conservazione di energia e impulso. Naturalmente questo rappresenta un

rovesciamento della descrizione ondulatoria della luce, che risale a Newton,

e pone un problema di conciliazione tra la descrizione ondulatoria e quella

corpuscolare (della luce ma non solo, come vedremo) che sarà uno dei temi

centrali della Meccanica Quantistica.

4.

Il principio di indeterminazione

Gli effetti della costante di Planck

L’introduzione della costante di Planck come unità minima di area dello

spazio delle fasi genera una situazione del tutto nuova per la meccanica degli atomi. Anche se la logica che seguiremo non farà uso di questo fatto,

né delle considerazioni e delle prescrizioni che costituiscono la vecchia teoria dei quanti, conviene valutare brevemente l’impatto sulle teorie atomiche

dell’introduzione della costante di Planck.

Una volta che nella meccanica si sostituiscono posizioni e impulsi esattamente definiti con “aree quantizzate” nello spazio delle fasi, i problemi della

stabilità degli atomi, delle loro dimensioni e della loro energia hanno soluzioni

semplici e naturali.

23

Assumendo di sapere (come era stato scoperto da Rutherford nel 1910)

che gli atomi consistono di un nucleo, di dimensioni molto ridotte, carico positivamente, e di elettroni, di massa molto piccola rispetto a quella del nucleo

(di un fattore circa 2000 per l’atomo di idrogeno), in interazione Coulombiana tra loro e con il nucleo, la possibilità di ottenere atomi stabili, cioè con

energia limitata inferiormente, si realizza immediatamente una volta che si

vincolino dei prodotti tra impulsi e coordinate a un valore minimo dell’ordine

di h, o si introducano aree discrete, multiple di h.

Per un atomo di idrogeno, di Hamiltoniana

H = p2 /2m − e2 /r ,

m la massa dell’elettrone, se si assume una relazione p r = h, si ottiene, per

l’energia in funzione di r,

E = h2 /2mr2 − e2 /r ,

che ha minimo per

r = h2 /me2 .

Alternativamente, si possono considerare orbite circolari, di raggio r,

velocità v, momento angolare L = mvr, con la relazione

mv 2 /r = e2 /r2

che si ottiene uguagliando la massa per l’accelerazione dell’elettrone e la forza

Coulombiana.

Se si impone che l’orbita delimiti un’area nh nello spazio descritto dall’angolo e dalla variabile canonica coniugata, il momento angolare L, si ottiene

L = nh/2π. Sostituendo questo vincolo nell’equazione precedente scritta

come

L2 = me2 r

si ottiene

r = n2 h2 /me2 (2π)2 .

Per n = 1 il risultato è un raggio minimo

r = (6.6)2 10−54 2000 6 1023 /(4.8)2 10−20 (2π)2 = 0.5 10−8 cm

Come si vede, la costante di Planck dà origine a raggi atomici precisamente dell’ordine di grandezza richiesto dal Numero di Avogadro.

24

Inoltre, usando le relazioni precedenti, l’energia di legame di un atomo di

idrogeno, nella sua configurazione di energia più bassa, è data da

E1 = mv 2 /2 − e2 /r = −e2 /2r = (4.8)2 10−20 /10−8 = 22 10−12 erg = 13 eV ,

dove l’ultimo passaggio viene dalla definizione del Volt come Joule su Coulomb, dal valore della carica dell’elettrone in Coulomb, circa 1.6 10−19 ,

dal fattore 107 di conversione tra Joule e erg e dalla definizione dell’elettronvolt come la variazione dell’energia elettrostatica di un elettrone all’attraversamento di una differenza di potenziale di un Volt, da cui 1 eV

= 1.6 10−12 erg.

L’espressione in eV è significativa perchè il Volt è l’ordine di grandezza

della differenza di potenziale ai poli di una pila, che riflette le differenze

di energie di legame degli elettroni in diversi metalli e perciò l’ordine di

grandezza delle energie di legame degli elettroni negli atomi.

Inoltre, se i trasferimenti di energia tra la luce e gli atomi avvengono

per quanti discreti, E = hν, le frequenze associate a cambiamenti di energia

dell’ordine dell’energia di legame di un elettrone in un atomo di idrogeno

sono

ν = 22 10−12 /6.6 10−27 = 3 1015 ,

corrispondenti a lunghezze d’onda

λ = c/ν = 3 1010 /3 1015 = 10−5 cm ,

appena sotto l’intervallo della luce visibile.

Riassumendo, l’introduzione della costante di Planck con il ruolo di area

minima che restringe e discretizza le configurazioni possibili, nello spirito

della descrizione di Planck degli oscillatori, rende gli atomi stabili, ne dà le

dimensioni e le energie di legame; insieme alla relazione di Planck per il campo

elettromagnetico fornisce l’ordine di grandezza della lunghezza d’onda della

luce emessa dagli atomi. Le costanti che abbiamo trovato in questo modo

continuano anzi a caratterizzare gli atomi anche in Meccanica Quantistica:

aB ≡ h2 /(2π)2 me2 = 0.53 10−8 cm

viene indicato come il raggio di Bohr,

R ≡ E1 /h = e2 /2hr = 13 eV /h = 3.1 1015 sec−1

la frequenza di Rydberg.

25

Si può aggiungere che le possibili orbite circolari ottenute sopra, di raggio

rn = n2 aB hanno energia

En = e2 /2hrn = E1 /n2 .

Al passaggio dell’elettrone da una all’altra di queste orbite corrisponde perciò

una differenza di energia

∆En,m = E1 (1/n2 − 1/m2 ) ;

se tale energia viene fornita a (o assorbita da) un quanto del campo elettromagnetico, la sua frequenza sarà

νn,m = ∆En,m /h = R (1/n2 − 1/m2 ) .

Questa formula riproduce con buona precisione le frequenze della luce emessa

o assorbita dagli atomi di idrogeno, in parte note (per n = 2 e m > 2) fin

dalla metà dell’800.

Il principio di indeterminazione

Indipendentemente dal suo uso più o meno euristico nella meccanica degli

atomi, quali sono le implicazioni dell’introduzione della costante di Planck

sui concetti fondamentali della Meccanica? La risposta viene da Heisenberg

nel 1925, con un’analisi che rivoluziona le nozioni di variabile e di stato nella

descrizione dei sistemi fisici. La meccanica, e in generale la fisica classica,

descrive infatti i possibili stati dei sistemi fisici in termini di un certo numero

di proprietà, per esempio posizioni e velocità di punti materiali o valori dei

campi elettromagnetici in ciascun punto dello spazio, determinabili, almeno

in linea di principio, con precisione arbitraria.

La tesi di Heisenberg è che questo punto di vista non ha fondamento

una volta introdotta la costante di Planck perchè non è possibile e non ha

significato attribuire dei valori simultaneamente alle diverse variabili, per

esempio alla posizione e insieme all’impulso di una particella. Heisenberg

mostra infatti che ogni misura di posizione richiede uno scambio di impulso,

tanto maggiore quanto maggiore è la precisione della misura: a una precisione

∆x nella misura di una posizione corrisponde un trasferimento di impulso ∆p,

con la relazione

∆x ∆p ≥ h/4π

Conviene ricordare che, nel clima di crisi dei fondamenti della meccanica,

che si aggiungeva alla rivoluzione prodotta dalla relatività sulla concezione

26

di Galileo e Newton dello spazio e del tempo, si era affermato dai primi

del ’900 il punti di vista dell’operazionismo, cioè la tesi che non si debbano

mai introdurre concetti e relazioni che non abbiano un significato diretto in

termini di operazioni fisiche.

Applicando tale criterio, Heisenberg si chiede quale sia il significato operazionale di posizione e impulso e discute perciò in che modo una posizione

possa essere determinata. L’apparato più preciso per questo scopo sembra

essere il microscopio, che si può schematizzare come un sistema di lenti che

raccolgono la luce diffusa da un oggetto, che supporremo di dimensioni trascurabili in modo che la luce possa essere pensata come diffusa da un solo

punto.

In generale, il limite dei microscopi nel distinguere punti diversi di provenienza della luce era molto ben noto e ben compreso come conseguenza del

carattere ondulatorio della luce. Se si tiene conto del carattere ondulatorio

della luce, le immagini che si formano in un sistema di lenti seguono infatti

le leggi dell’ottica geometrica solo approssimativamente; l’immagine su uno

schermo, secondo l’ottica geometrica, di una sorgente puntiforme attraverso

un sistema di lenti non è infatti altro che il punto nel quale le onde emesse da

una sorgente interferiscono costruttivamente, avendo percorso cammini tutti

uguali, a meno di piccole frazioni della lunghezze d’onda della luce impiegata.

Tale immagine ha perciò in realtà una certa larghezza, comprendendo tutti i punti in cui l’interferenza rimane approssimativamente costruttiva, i punti

cioè per ciascuno dei quali i diversi cammini che lo raggiungono attraverso il

sistema di lenti differiscono tra loro solo per una piccola frazione della lunghezza d’onda. Le immagini di due punti diversi possono perciò sovrapporsi

parzialmente, e sono distinguibili se e solo se l’immagine in senso geometrico

di uno dei punti non soddisfa la condizione di interferenza costruttiva per

l’altro.

Dato un sistema di lenti, su un certo asse, che raccolga la luce emessa dalle sorgenti in un cono di ampiezza α e formi le immagini a grande distanza,

necessaria per un grande ingrandimento, consideriamo una prima sorgente

sull’asse del sistema e una seconda a distanza ∆x, su un piano ortogonale

all’asse. Consideriamo il punto immagine della sorgente sull’asse e chiediamoci se anche per la seconda sorgente tale punto soddisfa la condizione di

interferenza costruttiva; mentre i cammini provenienti dalla seconda sorgente e vicini all’asse mantengono, nel limite di grande ingrandimento, la stessa

lunghezza, i cammini sul bordo del cono differiscono per ±∆x sin α. La

condizione di distinguibilità, che associamo per semplicità a una differenza

27

di fase δϕ = 1 tra i cammini ai due bordi del cono è perciò

2 ∆x sin α > λ/2π ,

con λ la lunghezza d’onda della luce.

Fin qui il quadro è classico e ben noto a chi usa microscopi. Quello che

Heisenberg aggiunge nasce dal considerare la luce come composta di particelle, i fotoni, di cui almeno uno deve essere prodotto, o diffuso, dalle sorgenti in

esame (per consistenza del ragionamento occorre pensare che i singoli fotoni,

in quanto descrizione discreta della luce, ne subiscano gli effetti di interferenza); ma un fotone associato alla lunghezza d’onda λ ha un impulso p = h/λ,

h la costante di Planck, e la sua produzione o diffusione cambia l’impulso

della sorgente in esame di un ordine di grandezza ∆p = h/λ; di conseguenza la relazione di distinguibilità di una differenza di posizione ∆x si scrive

in termini dell’impulso trasferito al sistema di cui si vuole determinare la

posizione:

2 ∆x sin α > h / 2π ∆p ,

e perciò almeno (per grandi ampiezze del cono di accettazione della luce)

∆x ∆p > h/4π .

Le regole di commutazione di Heisenberg

Oltre a introdurre un principio di indeterminazione tra i valori attribuibili a

posizione e impulso, l’analisi di Heisenberg conclude che misurare un impulso

dopo aver misurato una posizione dà un risultato diverso rispetto a misure

effettuate nell’ordine inverso. I valori ottenuti per posizione e impulso attraveso misure successive non vanno perciò pensati come preesistenti, ma come

risultato di operazioni che hanno agito sul sistema e dal cui ordine dipendono

i risultati.

Quelle che nella fisica classica sono variabili, i cui valori devono solo essere

registrati dalle misure, diventano per Heisenberg simboli associati a procedure sperimentali il cui ordine non è trascurabile. Mentre somme e prodotti di

variabili classiche sono ancora variabili classiche, i cui valori sono dati dalle

stesse operazioni, l’analisi di Heisenberg conclude che al prodotto di tali simboli può essere associato un significato solo in termini della successione delle

corrispondenti operazioni, e che tale prodotto non è perciò commutativo.

28

A questo punto è decisivo chiedersi “quale sia la differenza” tra i prodotti

px e xp. Perchè tale differenza abbia senso conviene che i simboli che stiamo

usando si possano sommare (e moltiplicare per numeri), oltre che moltiplicare

tra loro, un’ipotesi tutt’altro che evidente se si tiene conto che si sta parlando

di operazioni.

Assumiamo tale ipotesi, assumiamo per semplicità che c ≡ xp − px commuti con x e con p e chiediamoci quali siano le conseguenze di questa semplice

relazione. Vedremo che essa implica sia le relazioni di indeterminazione sia

il carattere discreto, En = nhν degli scambi di energia di un oscillatore armonico di frequenza ν, cioè l’ipotesi alla base della soluzione di Planck per

la meccanica statistica del campo elettomagnetico.

Intanto osserviamo che, con le operazioni di somma e prodotto, i polinomi

in x e p formano un’algebra, non commutativa, sui numeri reali; la “realtà”

di x e p può essere formalizzata introducendo una coniugazione A∗ , che soddisfi, come per l’algebra delle matrici, (AB)∗ = B ∗ A∗ , con x = x∗ , p = p∗ ;

ne segue c∗ = −c, cioè c ha le proprietà di un numero immaginario puro;

conviene allora introdurre i numeri complessi scrivendo c = ig, e assumere

che g sia semplicemente una costante reale; l’algebra dei polinomi in x e p assume allora automaticamente coefficienti complessi, con l’unità immaginaria

identificata con g −1 c

La derivazione del carattere discreto degli scambi di energia di un oscilatore usa solo il commutatore tra x e p, l’interpretazione dei polinomi in x e

p come le possibili operazioni sul sistema e l’ipotesi che l’energia di un oscillatore armonico di frequenza ν = 2πω si scriva, come in meccanica classica

(a meno di un cambio di variabili x0 = λx, p0 = λ−1 p che lascia invariata c)

H = ω/2 (p2 + x2 ) .

In queste ipotesi, si può calcolare la variazione di H sotto qualsiasi operazione, che assumiamo descritta dalla moltiplicazione per un polinomio in x e p.

Consideriamo infatti il risultato del prodotto di x + ip con H; dalla relazione

di commutazione, indicando

[A, B] ≡ AB − BA

e usando la regola [A, BC] = [A, B]C + B[A, C], si ottiene

(x + ip)H = H(x + ip) + ω g (x + ip) .

Allo stesso modo,

(x − ip)H = H(x − ip) − ω g (x − ip) .

29

Usando ripetutamente la regola per il commutatore di un prodotto, si ottiene

anche

(x + ip)n H = (H + n ω g)(x + ip)n ,

(x − ip)k (x + ip)n H = (x − ip)k (H + n ω g)(x + ip)n =

= (H + (n − k) ω g)(x − ip)k (x + ip)n .

Tenendo conto che ogni polinomio in x e p può essere scritto come un polinomio in x + ip e x − ip (anche ordinando i termini come sopra dato che il

commutatore tra x + ip e x − ip è un numero), il risultato è che ogni operazione sull’energia di un oscillatore armonico si può scrivere come una somma

di termini ciascuno dei quali cambia l’energia per un multiplo intero di g ω.

Ponendo g = h/2π, cioè

xp − px = i h/2π ,

l’energia cambia solo per multipli interi di hν.

Le relazioni di indeterminazione, intese come relazioni tra “valori quadratici medi ” delle dispersioni x − < x > e p − < p > si derivano per la

più generale nozione di “media”, indicata con < A >, che si possa dare per

gli elementi A di un’algebra non commutativa: chiameremo infatti media (e

interpreteremo come media dei risultati delle misure in una situazione fisica

data) ogni regola che associ a ogni elemento A dell’algebra dei polinomi in x

e p un numero (complesso) in modo lineare,

< aA + bB >= a < A > + b < B >

∀a, b ∈ C

I

positivo, cioè

< A∗ A > ≥ 0 ,

e normalizzato,

< 1 >= 1 .

Per una qualsiasi di tali “medie”, calcoliamo, con 0 6= λ ∈ IR

0 ≤ < (λx − iλ−1 p)(λx + iλ−1 p) > = λ2 < x2 > + λ−2 < p2 > − h/2π .

Dovendo valere per ogni λ, la disequazione implica che nessuna delle due

medie si può annullare e, per λ2 = (< p2 > / < x2 >)1/2 ,

2 < x2 >1/2 < p2 >1/2 ≥ h/2π .

La stessa derivazione si applica alle variabili x − < x > e p − < p >.

30

Con le nozioni e le ipotesi che abbiamo introdotto, la regola di comutazione di Heisenberg implica perciò sia il carattere discreto delle differenze di

energia realizzabili in un oscillatore armonico sia la regola di indeterminazione

tra posizione e impulso.

Le nozioni fondamentali che abbiamno introdotto in questo modo sono

quella di variabile come elemento di un’algebra non commutativa

e quella di media come funzionale lineare, positivo e normalizzato.

Mostreremo che queste nozioni sono sufficienti per costruire una nuova teoria

delle variabili e degli stati dei sistemi fisici in generale e in particolare una

nuova meccanica dei punti materiali.

Il percorso logico che abbiamo seguito è leggermente diverso da quello

originale: la “Meccanica delle matrici”, cioè la sostituzione delle variabili

classiche con operatori, viene proposta da Heisenberg nel 1925 per spiegare

gli spettri di emissione degli atomi; la discussione dei limiti alle osservazioni

con il miscroscopio viene due anni dopo e risponde all’esigenza di esplicitare

le implicazioni e dare un fondamento di principio alle regole di comutazione,

ed è questo il punto di vista che abbiamo adottato.

31