Prof. M. Chiodi

Modelli lineari

1

Appunti del Corso di

a.a. 2001-2002;

Statistica 3

Prof. Marcello Chiodi

Istituto di Statistica

Facoltà di Economia di Palermo

Viale delle Scienze;

90128 - Palermo-Italy

(tel. xx39-0916626238; 0916626322; fax. xx39-091485726)

e-mail [email protected])

home page: http://statistica.economia.unipa.it/chiodi

PARTE 4

Sommario parte 4.

Variabili Statistiche Multiple ..................................................................3

Definizione della matrice dei dati...................................................................... 4

I momenti primi e secondi (multivariati) di una variabile statistica multipla................. 5

I momenti di combinazioni lineari di variabili statistiche multipla ......................... 7

&

Stimatori di massima verosimiglianza per campioni provenienti da una normale

multivariata...................................................................................................................... 11

Dimostrazione ...........................................................................................................12

&

ACP per variabili statistiche osservate............................................................. 15

Inferenza nel caso normale sugli autovalori:...............................................................17

&

Test di Multinormalità .................................................................................... 19

esempio: 20

&

Introduzione ai Modelli Lineari ............................................................22

Il modello lineare di dipendenza per variabili normali. ...............................................24

Il modello lineare generale.........................................................................................25

&

componente sistematica e componente casuale. ............................................... 28

Caratteristiche essenziali degli elementi del modello lineare ........................................ 30

&

Caratteristiche più dettagliate degli elementi del modello: ............................... 31

&

Versatilità del modello lineare ........................................................................ 34

&

Generalizzazioni............................................................................................. 35

Problemi di inferenza..............................................................................................36

&

Ipotesi sulle ε ................................................................................................. 37

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

2

La matrice delle X ...................................................................................................38

Osservazioni ripetute. ................................................................................................. 39

Disegni fattoriali......................................................................................................... 41

Disegni 2k..................................................................................................................46

&

Regressione multipla. ..................................................................................... 47

relazione di regressione in termini di scarti.................................................................48

Regressione polinomiale:............................................................................................ 50

Polinomi in più variabili e superfici di risposta...........................................................50

Regressione parametrica e non parametrica ................................................................53

Regressori del tipo 0/1 (dummy variables) .................................................................. 55

Analisi della varianza ad effetti fissi ed un criterio di classificazione ........................... 57

&

Analisi della varianza ad effetti fissi con due criteri di classificazione.............. 60

&

Analisi della covarianza.................................................................................. 61

&

Rette o piani di regressione con pendenze diverse: termini polinomiali moltiplicativi

63

Esempio di polinomio di secondo grado per effetto interazione: ...........................63

Esempio 2: (confronto fra due rette).....................................................................65

Esempio di piano fattoriale 2k: .............................................................................66

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

3

VARIABILI STATISTICHE MULTIPLE

In questa breve sezione introduciamo la notazione per insiemi di dati

multivariati, le cosiddette matrici di dati; in questo contesto verranno

rivisti i concetti di momento primo e secondo di variabili statistiche

multiple, per i quali spesso è utile adottare un simbolismo compatto, e se

ne vedrà il significato; si vedranno poi gli stimatori dei parametri di una

normale multivariata sulla base di un campione di osservazioni; quindi si

darà un' interpretazione all'analisi delle componenti principali valida

quando si hanno variabili statistiche osservate e non variabili casuali,

come abbiamo fatto finora. Faremo anche un piccolo accenno ai test di

normalità multivariata.

Resta inteso che il significato da attribuire ai momenti primi e secondi

multivariati empirici è diverso secondo che si supponga di avere un

campione proveniente da una distribuzione normale multivariata oppure

solo un insieme di dati da una popolazione non specificata:

Nel primo caso i momenti primi e secondi empirici sono proprio gli

stimatori di massima verosimiglianza dei parametri di una normale

multivariata (gli unici parametri di tale distribuzione);

Nel secondo caso i momenti avranno soltanto un valore sintetico o

descrittivo e non è detto che siano le migliori misure di media e

dispersione multivariata per i dati in esame.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

4

&

Definizione della matrice dei dati

Supponiamo di avere l'informazione relativa a n unità su cui sono state

rilevate p variabili statistiche.

in questa fase di definizione del simbolismo che adotteremo per un insieme di dati

multivariato, non ci preoccuperemo del fatto che queste unità costituiscano una popolazione

completa o piuttosto un campione (casuale semplice, stratificato, ragionato, etc): supponiamo

che si tratti comunque dell’intera informazione disponibile dall'osservazione, comunque essa

sia stata effettuata.

Variabile p

Xp

x1j

...

x1p

...

...

...

...

...

...

...

...

...

...

xi1

xi2

...

xij

...

xip

...

...

...

...

...

...

...

...

...

...

...

...

xn1

xn2

...

xij

...

xnp

M1

M2

...

Mj

...

Mp

Variabile i

Xj

...

...

...

Unità 1

U1

Unità i

Ui

Unità n

Un

Medie:

x12

x11

X[n×p] =

Variabile 2

X2

Variabile 1

X1

L'informazione completa è in ogni caso costituita da una matrice di dati

X[n×p]:

• La matrice X (n righe e p colonne), di elemento generico xij è data dai

valori osservati di p variabili (che per ora supporremo quantitative),

per ciascuna delle n unità statistiche:

L'informazione relativa ad una unità Ui è dunque costituita dalla riga iesima delle p osservazioni relative alle p variabili:

Ui: = {xi1; xi2; ...; xij;...; xip};

i=1,2,...,n

L' informazione (univariata) relativa alla j-esima variabile Xj è

contenuta nella j-esima colonna:

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

Xj = {x1j; x2j; ...; xij;...; xnj}T;

5

j=1,2,...,p

(E' invalso di recente l'uso di indicare una matrice dei dati X come

matrice a due vie unità×variabili per distinguerla dalle cosiddette matrice

a tre vie unità×variabili×occasioni in cui per esempio l'elemento xijk

rappresenta l'osservazione della j-esima variabile nell'i-esimo individuo

nell'occasione k, se per esempio lo stesso insieme multivariato è stato

osservato in diverse occasioni, o in diverse località; evidentemente in

questo caso potremo fare diverse sezioni a due vie dei dati, ma non è un

argomento che trattiamo adesso).

Non verranno prese in considerazione in questo momento le

problematiche derivanti da matrici di dati incomplete, ossia in cui alcune

delle osservazioni xij relative ad uno o più casi ed ad una o più variabili

sono mancanti. Alcune di queste problematiche verranno riprese più

avanti, in particolare nel corso di esercitazioni.

Non si confonda adesso la matrice dei dati X, con un vettore aleatorio X: sebbene abbia usato

lo stesso simbolo, sarà sempre chiaro dal contesto a quale tipo di ente ci si riferisce.

I momenti primi e secondi (multivariati) di una variabile

statistica multipla

Ritornando alle ordinarie matrici di dati a due vie, la media aritmetica

di ciascuna variabile è data:

n

Mj= ∑ xij/n

j=1,2,...,p

i=1

Il vettore delle medie è costituito dalle p medie aritmetiche:

M...

M(X)= M

...

M

1

j

p

Se consideriamo una rappresentazione geometrica delle n unità

statistica, la nostra matrice dei dati costituisce l'insieme delle coordinate

di n punti in uno spazio p-dimensionale, ed il punto di coordinate M(X) è

detto centroide dell'insieme multivariato di dati.

E' facile vedere che in notazione matriciale possiamo esprimere M(X)

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

6

mediante la relazione:

M(X)= XT 1n /n

Da ora in poi indicheremo con 1k un vettore colonna di k elementi tutti

uguali ad 1:

1

…

1k= 1

k volte

…

1

n

σ2J= ∑ (xij- Mj)2/n

i=1

Per i momenti del secondo ordine si ha:

la varianza della singola variabile Xj:

j=1,2,...,p

la covarianza fra la variabile Xj e la variabile Xk :

n

σjk= ∑ (xij- Mj) (xik- Mk)/n

i=1

j=1,2,...,p; k=1,2,...,p;

n

∑ xij2/n - Mj2

σ2J=

E' noto che tali relazioni riguardanti momenti secondi centrali, sono

esprimibili in termini dei momenti primi e secondi con origine lo zero:

j=1,2,...,p

i=1

n

σjk= ∑ xij xik /n - MjMk

j=1,2,...,p; k=1,2,...,p;

i=1

zij = xij - Mj

i=1,2,...,n; j=1,2,...,p.

E' utile spesso fare riferimento alla matrice degli scarti Z, il cui

generico elemento è definito da:

Evidentemente le nuove variabili Zj risultano a media nulla.

Con questa posizione di comodo, è facile ora vedere che la matrice di

varianze e covarianze p×p delle variabili Xj (o delle variabili Zj) è

esprimibile in forma matriciale compatta da:

V(X)= V(Z)= Z' Z /n.

Si può anche vedere che:

Z=X-1n M(X)'

=X -1n 1n' X /n = (In -1n 1n' /n) X

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

7

V(X)= V(Z)= [X'- M(X) 1n'] [X-1n M(X)'] /n =

= X' X /n -M(X) M(X)'

ricordando, per l'ultimo passaggio, che:

[X'- M(X) 1n'] [1n M(X)'] /n=0 e M(X) 1n' X /n= M(X) M(X)'.

Oppure, dalla relazione prima vista:

Z = (In -1n 1n' /n) X,

si ha:

Z' Z = X' (In -1n 1n' /n)' (In -1n 1n' /n) X;

e considerando che la matrice (In -1n 1n' /n)' è simmetrica e

idempotente, si ha infine:

nV(X)= nV(Z)= Z' Z = X' (In -1n 1n' /n)' (In -1n 1n' /n) X =

=X' (In -1n 1n'/n) X;

Si vedrà a proposito anche l'espressione della devianza residua

nell'analisi dei modelli lineari, che è formalmente analoga a questa

espressione.

Come si vede, si ottengono risultati già noti nel caso a una e due

variabili sui momenti primi e secondi; la notazione matriciale permette di

ottenere risultati anche mnemonicamente simili a quelli più che noti del

caso univariato.

E’ appena il caso di osservare che mentre la notazione matriciale fornisce espressioni

compatte ed è inoltre implementabile facilmente negli ambienti di programmazione che

supportano operazioni matriciali, difficilmente fornisce gli algoritmi più efficienti per il calcolo

dei momenti multivariati.

I momenti di combinazioni lineari di variabili statistiche multipla

Per i momenti di combinazioni lineari di una variabile multipla

valgono ovviamente relazioni del tutto analoghe a quelle viste per

combinazioni lineari di vettori di variabili aleatorie:

costruiamo una nuova variabile statistica a k componenti, mediante una

qualsiasi trasformazione lineare delle variabili Xj, colonne della matrice

dei dati X:

Y = X A'+1n c'

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

8

M(Y) = M(X) A'+ c

• La matrice A[k × p] ha k righe e p colonne e per il resto è qualsiasi,

nel senso che il suo rango può anche essere inferiore a min(k,p).

• Il vettore c[k × 1] ha k elementi.

• La nuova matrice di dati Y ha n righe e k colonne

Con semplici passaggi si vede come data la matrice A e il vettore c è

possibile ottenere tutti i momenti di Y in funzione di quelli di X:

V(Y) = V(X A'+1n c') =A V(X) A'

MOMENTI DI UNA TRASFORMATA LINEARE Y DI UNA

VARIBILE STATISTICA MULTIPLA

M(X A'+1n c') = M(X) A'+ c

Speranza matematica

Matrice di varianze e covarianze

V(X A'+1n c') = A V(X) A'

X: Y=X A'+1n c'

In particolare se k=1 allora A è un vettore riga b', c è uno scalare e Y è

una v.c. semplice (ossia scalare) e si ha:

♦ Y = b'X +c e quindi:

E(Y)= b' E(X) +c =

V(Y)= b'V(X) b =

b1 µ1 + b2 µ2 + … + bp µp+c

b²1 σ1² +b²2 σ2² +…+b²i σ²i +…+

+b²p σp² +2b1b2 σ12 + ...+ 2 bibj σij +

+ ... + 2bp-1bp σp-1,p

Formule più complesse valgono per i momenti multivariati di

ordine superiore al secondo, ma è possibile ricavare tutti i momenti

(multivariati) di grado k di Y, sia centrali che non centrali, a partire

dalla conoscenza della matrice di trasformazione A e dei momenti

multivariati di grado 1,2,...,k di X.

Come per le variabili aleatorie semplici i momenti di ordine 3 e 4

forniscono degli indici di forma, i momenti multivariati di ordine

superiore al secondo forniscono degli indici di forma multivariati,

degli indicatori di allontanamento dalla multinormalità, indici di non

linearità delle regressioni e di eteroscedasticità.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

9

Esempio: n=20, p=4

435

440

470

480

480

460

495

500

500

490

500

500

505

505

510

510

515

525

550

535

779

64660

9905

6697

/20 =

38.95

3233.00

495.25

334.85

M(X)= XT 120/20 =

304

315

321

332

335

330

330

333

325

314

350

340

345

327

340

335

342

346

370

363

1930

2100

2920

2900

3000

2770

3400

3500

3430

3200

3530

3310

3650

2920

3120

3500

3540

3640

4160

4140

X[20,4]=

36

36

40

36

40

34

40

40

41

40

41

40

39

40

39

36

39

41

41

40

V(X)=X'X/n- =

30427

2532510

386525

261120

2532510 215035800 32309200 21794920

/20 386525 32309200 4921075 3323975

261120 21794920 3323975 2247269

-M(X)M(X)'

=

cov(x)

V1

4.471053

V2

737.000000

V3

38.171053

V4

14.307895

737.000

38.17105

315264.211 15070.26316

15070.263

822.30263

7553.632

383.46053

Appunti del Prof. M. Chiodi per il corso di Statistica 3

14.30789

7553.63158

383.46053

251.50263

a.a. 2001-2002

Prof. M. Chiodi

1.0000000

0.6207622

0.6295256

0.4266773

0.6207622

1.0000000

0.9359824

0.8482956

10

0.6295256

0.9359824

1.0000000

0.8432057

0.4266773

0.8482956

0.8432057

1.0000000

> cor(x)

V1

V2

V3

V4

>

Modelli lineari

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

11

&

Stimatori di massima verosimiglianza per campioni

provenienti da una normale multivariata

In effetti, in analogia al caso univariato, se la matrice n×p dei dati

costituisce effettivamente un campione(multivariato) casuale di ampiezza

n estratto da una normale multivariata a p componenti, i momenti primi e

secondi calcolati sul campione multivariato sono le stime di massima

verosimiglianza dei corrispondenti parametri della distribuzione di

provenienza; in sintesi:

Lo stimatore di massima verosimiglianza del vettore delle speranze

matematiche µ di una variabile normale multipla è dato dal vettore

M(X) delle medie aritmetiche di un campione multivariato X di n

osservazioni i.i.d. estratto dalla corrispondente distribuzione.

Tale stimatore, come nel caso univariato, è corretto, ossia non

distorto.

Lo stimatore di massima verosimiglianza della matrice di varianze e

covarianze Σ di tale variabile è dato dalla matrice delle varianze e

covarianze empiriche calcolata su un campione multivariato di n

osservazioni i.i.d. estratto dalla corrispondente distribuzione. Tale

stimatore, come nel caso univariato, è invece distorto.

E’ possibile costruire uno stimatore corretto moltiplicando sia le

n

varianze che le covarianze empiriche per il fattore correttivo n-1 ,

^

ottenendo quindi lo stimatore: Σ =V(X)= V(Z)= Z' Z /n

In effetti, dal momento che gli unici parametri della distribuzione

normale multivariata sono il vettore delle medie e la matrice di varianza e

covarianza, per ottenere gli stimatori di massima verosimiglianza

(puntuali!) di tutte le quantità necessarie per calcolare le distribuzioni

congiunte, marginali, condizionate e per le componenti principali da un

campione proveniente da una normale multivariata, si impiegheranno le

stesse formule già viste per la distribuzione teorica, sostituendo ai

momenti primi e secondi teorici quelli empirici stimati dal campione, dal

momento che lo stimatore di massima verosimiglianza di una funzione

dei parametri g(θ

θ) è dato ^dalla stessa funzione dello stimatore di

Masssima verosimiglianza, g(θ )

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

12

Dimostrazione

Omettere nel corso breve

Per ricavare gli stimatori di massima verosimiglianza dei parametri di

una normale multivariata costruiamo come sempre la verosimiglianza, o

meglio il suo logaritmo, supponendo di avere n osservazioni indipendenti

ciascuna con p componenti.

Per comodità e perché questo facilita i passaggi successivi,

consideriamo come parametri gli elementi cij di C, l'inversa della matrice

Σ di varianze e covarianze, oltre ovviamente al vettore delle speranze

matematiche µ. Sappiamo dalle proprietà degli stimatori di massima

verosimiglianza che la parametrizzazione è irrilevante ai fini della

determinazione degli stimatori puntuali.

È opportuno a questo punto richiamare e rivedere le proprietà viste precedentemente sulla

derivazione di forme quadratiche di determinanti e di matrici inverse.

Costruiamo la quantità -2log verosimiglianza (rispetto a µ e C), sulla

base di un campione di n osservazioni indipendenti (si riveda la parte

iniziale sulla normale multivariata, per questa parametrizzazione):

n

l(µ,C; X ) = -2log L(µ,C;X) =k-nlog|C| + ∑ (xi - µ)'C(xi - µ),

i=1

essendo xi il vettore (p-variato) osservato relativo all'i-esima

osservazione. Procedendo a derivare prima rispetto al vettore µ si ha:

n

n

∂ l(µ,C; X )

C(x

µ

)

=-2

C

=-2 ∑

∑ (xi - µ)

i

∂µ

i=1

i=1

E' immediato vedere che

∂ l(µ,C; X )

si annulla se:

∂µ

n

^

2 C ∑ (xi - µ )=0

i=1

ossia (dato che C è di rango pieno!) solo quando:

n

∑

^

(xi - µ )=0,

i=1

ed infine:

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

13

M...

(=M(X)= M

...

M

1

n

^

n

^

∑ xi = nµ

µ = ∑ xi/n

i=1

j

i=1

p

)

n

Per quanto riguarda invece le derivate rispetto agli elementi di C

conviene distinguere gli elementi diagonali cjj da quelli fuori dalla

diagonale cjk (k≠j)

∑ (xi - µ)'C(xi - µ)

∂ l(µ,C; X )

n ∂ |C| i=1

+

=|C| ∂ cjj

∂ cjj

,

j=1,2,…,p

∂ cjj

Per il primo addendo a secondo membro ricordiamo il risultato

generale per i determinanti di matrici simmetriche:

∂ |C|

= Cii essendo Crs il cofattore di crs in C,

∂ cii

mentre per il secondo addendo ovviamente si tratta di termini lineari in

C, per cui basterà nella sommatoria selezionare solo le componenti

opportune dei vettori (xi - µ), ossia solo quelle che moltiplicano cjj:

n

∂ l(µ,C; X )

Cjj

=- n

+∑ (xij - µj)2,

|C|

∂ cjj

•

i=1

Cjj

Σ−1 e quindi Σ=C −1 e

=σ2j dal momento che C=Σ

|C|

gli elementi di un'inversa sono proprio dati dai rapporti fra cofattori e

determinante.

Per trovare le espressioni degli stimatori σ^ 2J occorre annullare le

precedenti derivate, avendo sostituito alle speranza matematiche µj gli

stimatori di massima verosimiglianza Mj. Pertanto:

Si vede subito che:

∂ l(µ,C; X )

=0

∂ cjj

Î

n

Cjj

-n

+ ∑ (xij - Μj)2=0;

|C|

i=1

e quindi:

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

n

∑

σ^ 2J=

14

(xij - Μj)2

i=1

n

Deriviamo adesso rispetto agli elementi non diagonali cjk (k≠j):

n

∂ l(µ,C; X )

n ∂ |C| i=1

+

=|C| ∂ cjk

∂ cjk

∂ cjk

∑ (xi - µ)'C(xi - µ)

,

j,k=1,2,…,p; k≠j

Procediamo come prima, e per il primo addendo a secondo membro

ricordiamo il risultato generale per i determinanti di matrici simmetriche:

∂ |C|

= 2Cjk

cofattore di cjk in C, k≠j.

∂ cjk

mentre per il secondo addendo selezioniamo le componenti dei vettori

(xi - µ) che moltiplicano cjk:

•

n

∂ l(µ,C; X )

Cjk

=- 2n

+2 ∑ (xij - µj)(xik - µk),

|C|

∂ cjk

i=1

Cjk

=σjk e per trovare le espressioni degli stimatori σ^ jk

|C|

occorre annullare le precedenti derivate, avendo sostituito alle speranze

matematiche µj gli stimatori di massima verosimiglianza Mj. Pertanto:

n

∂ l(µ,C; X )

Cjk

=0

Î - 2n

+2 ∑ (xij - Mj)(xik - Mk)=0;

|C|

∂ cjk

Ancora si ha:

i=1

e quindi:

n

∑

σ^ jk=

(xij - Mj)(xik - Mk)

i=1

n

e quindi in definitiva il risultato prima anticipato:

^

Σ =V(X)= V(Z)= Z' Z /n

essendo X il campione multivariato

originario e Z la matrice degli scarti

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

15

&

ACP per variabili statistiche osservate

Vale la pena di ricordare che l’analisi delle componenti principali può

essere ancora vista come un problema di determinazione delle

combinazioni lineare (non correlate) di massima varianza di variabili

statistiche effettivamente osservate, piuttosto che di variabili aleatorie

multiple (oppure come problema di determinazione della combinazione

lineare,vincolata, di varianza minima!); oppure come problema di

determinazione di un nuovo spazio di riferimento ortogonale. Si

ottengono comunque, se si prendono tutti gli autovettori, le componenti

per la rotazione della matrice dei dati che determinano un nuovo insieme

di variabili non correlate.

Nel caso di variabili statistiche multiple esiste un’altra possibilità di

interpretazione, più vicina alla logica della regressione lineare.

Si supponga di avere una matrice n×p di dati Z relativa a p variabili

centrate (ossia a medie nulle): 1n’Z=0p; possibilmente le variabili sono

standardizzate (diversamente l’analisi sarebbe influenzata dalle diverse

scale e unità di misura delle variabili).

Problema:

• Trovare una retta r1 (nello spazio p-dimensionale definito dalle

variabili originali) di coseni direttori y1, che minimizzi la somma delle

distanze dei punti originali Pi dalle rispettive proiezioni ortogonali Qi1

su r1; gli n punti proiettati avranno coordinate qi1 (i=1,2,...,n); il

vettore di tali coordinate, ossia il vettore dei valori assunti dalla nuova

variabile si ottiene ovviamente mediante la proiezione q1=Zy1.

• il vincolo di normalizzazione: y1'y1=1, è ovvio dato che y1 è un vettore

dei coseni direttori.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

16

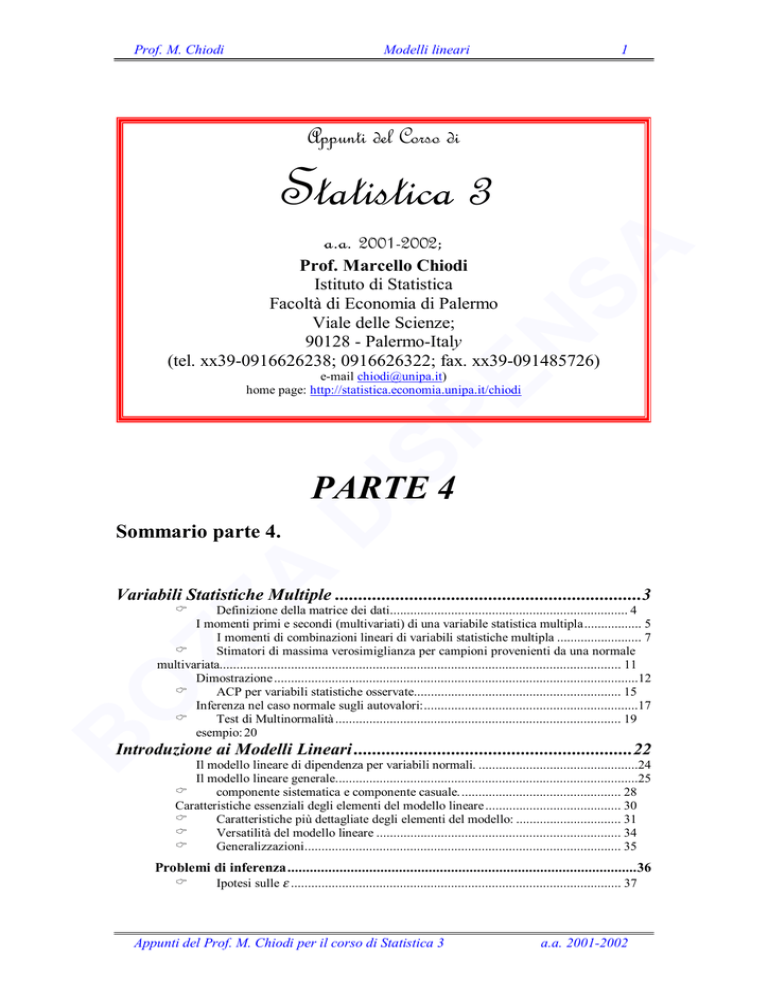

Analisi componenti principali (2 variabili, esempio)

5

4

3

Hi

zi1

Pi

2

Qi

zi2

1

Z2

O

0

-1

-3

-2

-1

0

1

-3

-2

-4

r1

2

3

4

Z1

Figura 1 Retta di minima distanza (ortogonale!) dai punti osservati

(regressione principale

Si noti dalla figura che il quadrato della distanza euclidea di ogni

singolo punto Pi dall’origine O (baricentro, o centroide, poichè

coincide con il vettore delle medie delle p variabili), può essere

espresso come:

____

____

____

____

2

____

OPi = OQi +PiQi2

e si ha anche palesemente:

2

____

OPi2 = OH2 +PiH2

Uguagliando i secondi membri di tali relazioni pitagoriche, ed

esprimendo in termini di coordinate centrate, (ossia a media nulla) nel

caso generale di p coordinate si ha:

p

____

∑ zij2 = qi 2 +PiQi2

j=1

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

17

essendo qi la coordinata di Qi sul nuovo asse r1. Si ricordi che essendo

le variabili originarie a media nulla, qualsiasi loro combinazione lineare,

sarà ancora a media nulla. Pertanto sommando ora per tutte le n unità:

p

∑∑

zij2

∑∑

zij2

i=1 j=1

p n

j=1 i=1

p

n

n

i=1

i=1

n

____

= ∑ qi 2 + ∑ PiQi2;

____

= Dev(q)+ ∑ PiQi2;

i=1

n

n

____

∑ Dev(Zj) = Dev(q)+ ∑ PiQi2.

j=1

i=1

In questa relazione la somma delle devianze delle variabili originarie

(che è anche uguale alla somma delle distanze dei punti dal centroide) è

ovviamente invariante rispetto a qualsiasi scelta della retta e pertanto è

una costante. Se indichiamo con q la nuova variabile, massimizzare

Dev(q), funzione obiettivo dell’ACP, corrisponde a minimizzare

n

____

∑ PiQi2

i=1

Quindi r1 è la retta che minimizza la somma delle distanze dei punti dalle

loro proiezioni ortogonali sulla retta stessa. Chiaramente la soluzione del

problema di determinazione di combinazioni lineari di massima varianza

(e non correlate) è sempre fornita dagli autovettori della matrice di

varianze e covarianze delle variabili originarie:

Z’Z

S= n

(che è anche la matrice di correlazione, se le variabili sono

standardizzate).

r1 va anche sotto il nome di retta di regressione principale.

E’ intuitiva la spiegazione geometrica delle componenti successive,

come rette, ortogonali alle precedenti.

è possibile anche un'interpretazione in funzione delle distanze euclidee fra coppie di punti,

che per brevità e compattezza di impostazione, ometto

Inferenza nel caso normale sugli autovalori:

Sebbene solitamente si impieghino le tecniche di analisi delle

componenti principali a scopo esplorativo, è interessante accennare al

caso in cui si abbia a disposizione un campione multivariato estratto da

una distribuzione normale; abbiamo infatti già visto come per una

distribuzione normale multivariata gli autovalori e gli autovettori

assumano dei significati ben precisi.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

18

Evidentemente gli stimatori di massima verosimiglianza degli

autovalori e degli autovettori sono forniti dagli autovalori e dagli

autovettori della matrice di varianza e covarianza campionaria (che è lo

stimatore di massima verosimiglianza della matrice di varianza e

covarianza teorica); dal momento che per gli stimatori delle varianze e

delle covarianze per campioni provenienti da una normale valgono della

proprietà di regolarità e dei teoremi che forniscono le distribuzioni

campionarie e che garantiscono la consistenza degli stimatori insieme con

loro correttezza asintotica, dobbiamo aspettarci che anche per gli

autovalori e gli autovettori ricavati da tali matrici campionarie valgano

delle proprietà di consistenza e di correttezza asintotica. In effetti qui mi

limito a riportare un risultato asintotico che riguarda la distribuzione degli

autovalori per campioni provenienti da una distribuzione normale

multivariata.

Asintoticamente gli lj, stime campionarie dei veri autovalori λj, ottenute

da un campione di n osservazioni estratto da una normale multivariata, si

distribuiscono secondo una normale multivariata a componenti

indipendenti:

E[lj ]= λj

2λj2

e varianza campionaria : Var[lj ]=

n-1

(si ricordi il caso particolare di matrici di varianze e covarianze diagonali:

questi risultati coincidono con quelli classici della distribuzione di una

varianza campionaria!)

Casi interessanti:

con valore atteso:

H0: λj=1, j=1,2,…,p

che corrisponde al caso di indipendenza fra le variabili (standardizzate).

È da intendersi che questi risultati sono semplicemente delle

approssimazioni ma danno delle indicazioni sull'ordine di grandezza

dell'errore campionario.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

19

&

Test di Multinormalità

Quando si ha a disposizione un campione di dati multivariato, molto

spesso è necessario verificare se è plausibile l'ipotesi di provenienza da

un universo normale multivariato.

Un modo semplice per verificare la normalità di un campione

d'osservazioni multivariate, consiste ovviamente nell'effettuare dei test di

normalità su ciascuna delle distribuzioni univariate. Ricordo che la

normalità delle distribuzioni marginali è una condizione necessaria ma

non sufficiente per la normalità multivariata: pertanto i test sulla

normalità delle distribuzioni marginali costituiscono uno sbarramento

preliminare, nel senso che se danno esito negativo possiamo senz'altro

scartare l'ipotesi di multinormalità, altrimenti occorrerà procedere col

saggiare l'ipotesi di normalità multivariata con test basati sulla

distribuzione congiunta.

Se l'insieme in esame è costituito da molte variabili non sarà possibile

utilizzare i normali test di bontà dell'adattamento; tuttavia è possibile

ottenere delle informazioni eventualmente anche grafiche trasformando

opportunamente l'insieme di dati multivariato.

Come si è visto infatti nel capitolo sulla distribuzione normale

multivariata, la forma quadratica ad esponente della densità normale ha

una distribuzione proporzionale a quella di una χ² con p gradi di libertà.

Infatti se:

Y∼

∼ Np(µ , Σ),

Σ

si è già visto prima che la variabile casuale

Q=(Y-µ)' Σ-1 (Y-µ) ∼χ²p

Pertanto se trasformiamo ognuno degli n vettori osservati xi a p

componenti secondo la stessa relazione, dovremo aspettarci che questi n

valori trasformati qi seguano ciascuno una distribuzione χ2 con p gradi di

libertà:

qi=(xi - µ)' Σ-1 (xi - µ) ∼χ²p

(le n trasformate qi risultano indipendenti per l'indipendenza ipotizzata

dei vettori osservati xi)

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

20

Quindi, se è valida l' ipotesi di multinormalità, il vettore delle n

trasformate qi costituisce un campione casuale semplice estratto da una

distribuzione χ² con p gradi di libertà. In effetti le quantità che si usano

effettivamente per il calcolo delle qi sono gli stimatori di µ e Σ, Μ e S, e

non i parametri veri (usualmente incogniti); questo fa sì che le quantità:

^

qi=(xi - M)' S-1 (xi - Μ)

seguono

una

distribuzione

χ²p solo approssimativamente;

l'approssimazione è soddisfacente per campioni grandi.

In effetti, un'informazione utile si ricava dalla rappresentazione grafica

di tali valori trasformati in corrispondenza dei percentili teorici di una

variabile χ2; un altro elemento di cui si potrebbe tenere conto nella

costruzione di un test di normalità è andato dagli angoli che i vettori

osservati formano con il centroide del campione; tuttavia adesso per

semplicità non vedremo quest'ulteriore possibilità.

esempio:

Questo esempio è tratto dall'insieme di dati antropometrici di cui si è fatto cenno in

capitoli precedenti (1432 casi x 7 variabili).

trasformatachi2#x_' :

Module#n, p, c, z, m, prob, dist, n, p Dimensions#x';

c Inverse#CovarianceMatrix#1.x'';

m Mean#1.x';

z Table#+x##i'' m/.c.+x##i'' m/, i, n';

dist ChiSquareDistribution# p';

prob CDF#dist, z''

y trasformatachi2#a';

Dimensions#y'

1432

ListPlot#Sort#y''

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

21

1

0.8

0.6

0.4

200

400

600

800

1000

1200

1400

Graphics

0.2

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

22

INTRODUZIONE AI MODELLI LINEARI

Inserire grafici sulle

distribuzioni normali

condizionate

Rappresentazione in 3D di una regressione lineare normale omoscedastica;

E(Y)=x-2

con dati empirici provenienti da schemi diversi

f(y|xi)

f(y|xi)

xi

y

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

23

Rappresentazione in 3D di una normale bivariata in cui risulta:

E(Y)=x-2; V(Y|x)=1

campione casuale

bivariato di 200 elementi

1

1

2

Σ= 1

f(y|xi)

2

(r =1/2)

f(y|xi)

y

x

Rappresentazione in 3D di una normale bivariata in cui risulta:

Rappresentazione in 3D di una regressione lineare normale omoscedastica;

E(Y)=x-2; V(Y|x)=1

Σ=

f(y|xi )

1

2

f(y|xi )

2

(r =1/2)

f(y|xi )

1

1

E(Y)=x-2; V(Y|x)=1

y

f(y|xi )

y

x

5

xi

4

4

3

3

2

2

1

y

y

1

0

0

-1

-1

-2

-2

-3

-3

-4

-4

-0,5

0,5

1,5

2,5

3,5

4,5

5,5

-0,5

0,5

x

Appunti del Prof. M. Chiodi per il corso di Statistica 3

1,5

2,5

3,5

4,5

5,5

x

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

24

Il modello lineare di dipendenza per variabili normali.

Per quanto visto nelle lezioni sulla normale multivariata, la

distribuzione di un numero qualsiasi di componenti condizionatamente a

valori qualsiasi Z2 di altre componenti del vettore aleatorio normale è

normale, con valore atteso che è funzione lineare di Z2, e matrice di

varianze e covarianze indipendente dai particolari valori condizionanti;

quindi le regressioni sono tutte lineari e omoscedastiche. Pertanto se si ha

a disposizione un campione casuale semplice da una normale

multivariata, non esiste alcun problema di identificazione del modello, né

di scelta della funzione, perché tutte le distribuzioni condizionate sono

note.

Ovviamente restano rinviati (ma solo per poche pagine!) i problemi relativi alla stima dei

parametri sulla base di un campione di osservazioni p-variate, che verranno affrontati

estendendo opportunamente le tecniche già note quando si studia la dipendenza di una

variabile y da una variabile indipendente x.

Tuttavia sono rari i casi in cui nello studio della dipendenza di uno o

più fenomeni, si può ragionevolmente ipotizzare di avere un campione

casuale semplice da una distribuzione normale multipla, perché spesso ci

si trova in altre situazioni, fra cui essenzialmente si hanno le seguenti:

I dati costituiscono un campione casuale semplice proveniente da una

distribuzione multivariata non normale.

I dati non costituiscono un campione casuale semplice ma, per

esempio, i valori delle variabili indipendenti

sono stati

opportunamente selezionati o predisposti

oppure si ha un campione non probabilistico o comunque un archivio

di dati che non costituisce un campione.

Il modello da cui si possono selezionare i dati è effettivamente una

distribuzione normale multivariata (almeno approssimativamente

normale), e si può estrarre un campione casuale semplice, tuttavia

l’interesse dell’analisi è limitato allo studio della distribuzione di una

delle componenti Y condizionatamente a valori particolari o estremi

delle altre componenti X: è noto anche nell’analisi della regressione

semplice, che l’inferenza è migliore (ossia le bande di confidenza

della relazione di regressione sono più strette) se si selezionano unità

con valori estremi delle componenti condizionanti X più vicine a

quelle di interesse.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

25

In effetti anche nel caso di campioni casuali semplici da distribuzioni

non normali multivariate, si possono cercare le migliori (nel senso dei

minimi quadrati) relazioni lineari fra le speranze matematiche di Y e

particolari valori di X. In ogni caso, come si apprestiamo a discutere

diffusamente, i valori delle X possono anche non essere delle

determinazioni di variabili casuali, ma valori anche scelti in modo non

casuale.

Nei paragrafi che seguono verranno affrontati diversi aspetti relativi

alla versatilità del modello lineare ed alle diverse possibilità interpretative

del modello e dei suoi parametri: alcuni dei concetti fondamentali relativi

a particolari modelli lineari vengono introdotti fra breve, prima che

vengano affrontati gli aspetti inferenziali. L’approccio tecnico scelto in

questo corso ci consentirà di affrontare in modo simile gli aspetti

inferenziali relativi alla regressione multipla, all’analisi della varianza,

della covarianza; inoltre costituirà una buona base per alcuni tipi di GLM

(Generalized linear models) sia per l’interpretazione dei parametri che per

l’inferenza.

Il modello lineare generale.

Per modello lineare in generale si intende un modello nel quale una

variabile di risposta osservabile Y è spiegata da una combinazione lineare

di k variabili esplicative Xj , secondo dei parametri incogniti βj, più una

componente accidentale ε (non osservabile) , secondo la generica

relazione lineare:

Y=X1 β1 +X2 β2 +...+ Xk βk +ε

In generale si può avere: Y=g(X1,..., Xk β, ε)

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

26

In particolare comunque ci occuperemo di modelli lineari di

dipendenza nei quali le Xj non sono variabili casuali, ma costanti note,

che assumono n valori in ℜk (tutti distinti oppure con ripetizioni, questo si

vedrà meglio in seguito). A differenza di quanto visto nelle lezioni

precedenti, non ci stiamo occupando della distribuzione simultanea di k+1

variabili aleatorie, perché le Xj sono variabili i cui valori possono

addirittura essere prefissati ed assegnati.

La generica osservazione i-esima è quindi caratterizzata da un

particolare vettore di valori delle k variabili Xj, indicato con:

x...

x= x

...

x

i1

i2

i

ik

Eventualmente le X potranno essere dei valori particolari (fissati!) di

variabili casuali, nel caso in cui studiamo le distribuzioni condizionate

della variabile aleatoria Y, condizionatamente agli n valori di k variabili

aleatorie Xj, e ipotizzeremmo in quel caso l'esistenza di k+1 variabili

aleatorie osservabili. Anche in questo caso però non ci occuperemo della

distribuzione congiunta delle Xj, ma solo di f(Y|Xnxk), ossia la

distribuzione di Y condizionatamente a particolari valori delle x.

E' più opportuno allora fornire l'equazione per la variabile casuale Yi

corrispondente alla generica i-esima osservazione:

Yi = xi1 β1 + xi2 β2 + ... + xik βk + εi= xi'β+ εi

Il vettore delle n osservazioni può essere quindi così espresso

formalmente:

MODELLO LINEARE GENERALE

Y[n×1]= X[n×k] β[k×1] + ε [n×1]

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

27

L' equazione deve essere lineare nei parametri β.

Rappresentando i dati in blocchi si ha:

β[k×1

=

x12 β2 +

...

...

xi2 β2 +

...

...

xn2 β2 +

x11 β1 +

...

...

xi1 β1 +

...

...

xn1 β1 +

Y1

...

...

Yi

...

...

Yn

+ ε[n×1]

...

...

...

...

...

...

...

+ x1k βk

...

...

+ xik βk

...

...

+ xnk βk

1]

]

= X[n×k]

Y[n×

+

ε1

...

...

εi

...

...

εn

L'utilità e la versatilità di tale modello per la descrizione di

fenomeni reali risiede nella possibilità di dare un significato agli

elementi di X e di β.

Il nome lineare presuppone in generale che il modello sia

lineare nei parametri βj

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

28

&

componente sistematica e componente casuale.

Possiamo interpretare le due componenti fondamentali del modello che

forniscono la risposta Y come:

• Xβ: la componente sistematica del modello

• ε:

la componente accidentale, che qui sto supponendo

additiva, per semplicità, e per comodità interpretativa

Se:

E(ε) = 0n

(come è ovvio assumere se ε è effettivamente una componente

accidentale additiva) allora:

E[Y] =Xβ,

= E(Y)

+

ε

Y

e quindi il modello è schematizzabile come:

In questo caso quindi possiamo vedere la variabile Y come una

variabile casuale, di cui abbiamo un campione di n osservazioni, la cui

speranza matematica è funzione lineare di k variabili Xj secondo la

relazione:

E(Yi)=

k

∑ xijβj;

i=1,2,...,n

j=1

questa proprietà è in stretta relazione con l’ipotesi di

additività della componente accidentale

L'assunzione E(ε) = 0n presuppone la validità del modello per le

speranze matematiche e quindi implicitamente si ipotizza:

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

29

che la componente accidentale (che ha un effetto additivo) sia a media

nulla: questo in effetti è quasi scontato quando parliamo di errori

accidentali additivi;

che le k variabili siano le uniche rilevanti ai fini della spiegazione della

speranza matematica di Y, o meglio della spiegazione di sue variazioni.

Il modello per la parte sistematica non è distorto perchè E[Y] =Xβ.

In ogni caso non si sta implicitamente assumendo l'esistenza di

relazioni di causa effetto fra le X e la Y, ma semplicemente che la

conoscenza delle X può spiegare meglio la variabilità del fenomeno

Y (nel senso che ne diminuisce la variabilità); ricordo inoltre che

non é necessario ipotizzare modelli distributivi per le Xj, perché,

almeno per ora, si sta supponendo che siano dei termini fissati,

secondo differenti possibili schemi che vengono adesso esaminati

Ad esempio nella regressione lineare semplice si ipotizza:

Yi = β0+xi β1 + εi

con E(Yi) = β0+xi β1

Adesso occorre citare e studiare opportunamente gli esempi della lezione introduttiva, che in

buona parte sono tutti suscettibili di essere posti in questa forma.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

30

Caratteristiche essenziali degli elementi del modello lineare

Caratteristiche

♦ Vettore aleatorio osservabile;

è la variabile di risposta di interesse, ossia quella di

cui si cerca di studiare (e di spiegare) la variabilità;

X matrice

♦ Matrice di costanti note.

n× k

• Le k componenti (vettori di n elementi) sono

elementi

variabili non aleatorie osservate senza errori

Sono le k variabili esplicative che si pensa

influenzino la risposta Y.

Si vedranno dopo alcune delle numerose

configurazioni che può assumere la matrice X.

β vettore

♦ Vettore di parametri incogniti

k elementi

β andrà stimato dai dati del campione

• In generale sono dei parametri fissi, (in certi

modelli, che tratteremo in questo corso solo

marginalmente) alcuni dei coefficienti sono

considerati come effetti casuali, e quindi come

variabili aleatorie.

ε vettore

♦ Vettore

aleatorio

osservabile

non

n elementi

direttamente;

♦ In funzione delle diverse ipotesi fatte sulla natura

della distribuzione di ε (che può dipendere in

generale da un insieme di parametri θ) si

possono avere differenti stime dei parametri

incogniti del modello.

Dim.

Y vettore

n elementi

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

31

&

Caratteristiche più dettagliate degli elementi del modello:

•

•

•

•

•

•

vettore di n elementi

Y

•

•

•

Vettore aleatorio osservabile;

è la variabile di risposta di interesse, ossia quella di cui si

cerca di studiare (e di spiegare) la variabilità;

e' una variabile quantitativa;

solo in casi speciali si considerano Y qualitative (ad

esempio presenza/assenza; oppure successo/insuccesso). In

questo corso non affronteremo, almeno non queste

tecniche, casi di risposte Y qualitative non dicotomiche.

Ci stiamo occupando essenzialmente di modelli nei quali

la risposta Yi è univariata; diversamente, con risposte

multiple, abbiamo modelli multivariati.

Si considera la distribuzione di Y come vettore aleatorio,

perché si pensa che questa distribuzione possa per qualche

aspetto (media, varianza, etc.) variare al variare delle X.

Il modello è multiplo se si hanno diverse X

con y indichiamo il vettore dei valori osservati

Di solito è utile vedere (preliminarmente) se la

variabilità osservata della Y è dovuta solo alla variabilità

naturale o anche a fattori sistematici (ossia la dipendenza

dalle X).

Le n unità dovrebbero essere gli elementi di un campione

casuale; tuttavia questo modello viene utilizzato anche per

analisi esplorative su dati osservazionali o comunque non

provenienti da un campione

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

32

Matrice di costanti note.

• Le k componenti (vettori di n elementi) sono variabili non

aleatorie osservate senza errori

• o comunque con un eventuale errore di ordine di grandezza

molto inferiore rispetto a quello di Y.

• I valori delle X potrebbero essere n valori particolari

assunti da un vettore aleatorio p-dimensionale. In questo

caso studiamo la distribuzione condizionata di Y per quei

particolari valori di X

Le Xj sono le k variabili esplicative che si pensa influenzino

la risposta Y. Le configurazioni di X possono essere

numerose: quantitative:

La matrice delle X (o meglio l'intero insieme dei dati) può

provenire da:

X

variabili indicatrici (0/1 o –1/1) , variabili miste.

• studi osservazionali:

in cui si scelgono le k variabili, ma gli n valori di ciascuna

variabile sono quelli osservati negli n individui scelti, per

cui non è possibile in generale pianificare particolari

combinazioni degli n×k valori.

• esperimenti pianificati:

in cui si scelgono non solo le k variabili, ma anche tutto lo

schema degli n×k valori, per cui è possibile stabilire in

anticipo quali valori verranno utilizzati per ciascuna delle k

variabili ed inoltre quali combinazioni di valori dei fattori

(o delle variabili) verranno impiegate insieme.

• dati ricavati da statistiche ufficiali o archivi e/o databasese

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Modelli lineari

33

Vettore di parametri incogniti

β andrà stimato dai dati del campione

• In generale sono dei parametri fissi, se non precisato

diversamente;

• in certi modelli alcuni dei coefficienti sono considerati

come effetti casuali, e quindi come variabili aleatorie.

Ciascun parametro esprime la dipendenza (lineare) dalla

corrispondente variabile esplicativa.

Pertanto βj misura l'incremento medio della risposta Y in

corrispondenza di un incremento unitario della j-esima

variabile Xj.

Se Xj è una variabile indicatrice (0/1) della presenza di una

certa caratteristica (non quantitativa), allora βj misura l'effetto

medio della presenza di tale caratteristica sulla risposta Y.

In generale:

β

Prof. M. Chiodi

βj=∂[E(Yi)]/ ∂xij;

se il modello è lineare però vale anche:

xij=∂[E(Yi)]/ ∂ βj

vettore di

ε

Vettore aleatorio non osservabile direttamente;

♦ In funzione delle diverse ipotesi fatte sulla natura della

distribuzione di ε (che può dipendere in generale da un

insieme di parametri θ) si hanno differenti stime dei

parametri incogniti del modello.

Rappresenta la componente accidentale, che viene supposta

additiva, in modo tale che se è anche con speranza matematica

nulla (come spesso si può ipotizzare) si ha:

E[Y] =Xβ

In effetti ε a rigore dovrebbe essere una variabile aleatoria

non dipendente da variabili esterne, che esprime

semplicemente l'errore sperimentale, o l'errore di

misurazione;

nel caso in cui il modello non sia correttamente

specificato, ε finirà per inglobare le variabili ed i fattori

non esplicitati nella parte sistematica, e quindi perderà la

sua natura di componente accidentale.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

34

&

Versatilità del modello lineare

La formulazione di tale modello per la speranza matematica di una

v.a., sebbene molto semplice, permette di trattare diversi tipi di situazioni

e di risolvere differenti problemi di inferenza.

In funzione di particolari configurazioni che può assumere la matrice

X, si può sfruttare questa impostazione ad esempio:

•

per l'analisi della regressione lineare multipla, se le colonne della

matrice X sono n osservazioni di k variabili quantitative,

•

per l'analisi della regressione polinomiale, se le colonne della

matrice X sono le potenze di una o più variabili quantitative,

•

oppure per l'analisi della varianza se le k colonne di X sono delle

variabili dicotomiche indicatrici (dummy variables) di appartenenza

ad un gruppo;

•

per l'analisi della covarianza;

•

per particolari analisi di disegni sperimentali a più vie con

interazioni fino ad un ordine massimo fissato.

•

Analisi di superfici di risposta

•

Analisi discriminante

•

Analisi dei modelli di crescita

soltanto alcune di queste problematiche verranno trattate in questo corso

esempi tratti di nuovo dalla sezione di problemi introduttivi

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

35

&

Generalizzazioni

Possiamo pensare che la speranza matematica della risposta sia una

funzione qualsiasi dei parametri e delle variabili:

Y= f (X, β) + ε

E(ε) = 0

Modello non lineare con errori additivi.

f: vettore di funzioni non lineari.

Modello non lineare con legame qualsiasi fra

Y= g(X,β,ε)

componente accidentale e sistematica.

Modello non lineare con errori moltiplicativi.

Yi= fi(X, β) × εi

GLM: General Linear Model

La speranza matematica di una particolare

funzione h(.) della variabile di risposta ha una

h(Y)= g[(Xβ) , ε];

dipendenza lineare dalle variabili Xj.

E(h(Y))= Xβ

Una sottoclasse di GLM molto impiegata nelle

applicazioni è quella in cui la distribuzione della

componente accidentale appartiene alla famiglia

di distribuzioni esponenziale

La probabilità del verificarsi di un evento

Regressione

(variabile di risposta) dipende dalle variabili Xj.

logistica

Una relazione di regressione può essere

individuata da una spezzata, ossia da una retta

che cambia inclinazione in corrispondenza dei

Regressione

livelli delle variabili esplicative. Nel caso in cui i

piecewise

punti di cambio dell'inclinazione non siano noti,

il problema è configurabile nell'ambito dei

modelli non lineari (rispetto ai parametri!)

Eventualmente un modello lineare può essere

Approssimazione di

visto come approssimazione del primo ordine di

modelli non lineari.

un modello non lineare

La forma funzionale f(X, β) non è precisata e

va stimata anche in modo non parametrico, ossia

stimando direttamente E(Yi|xi) ed eventualmente

Regressione non

dopo cercando di valutare f(.). In caso k=1,2

parametrica

questo può servire come indizio per la scelta del

tipo di funzione, o per la scelta del tipo di

polinomio, etc.

GRAFICI

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

36

Problemi di inferenza

In generale in un modello lineare possiamo avere diversi problemi di

inferenza, in particolare di stima e di prova delle ipotesi, in funzione della

natura dei dati e del tipo di problema. Ad esempio:

•

stimare il vettore dei parametri β nel caso generale;

•

stimare il vettore dei parametri β nel caso in cui vengono imposti

dei vincoli su alcune delle sue componenti (alcune componenti nulle o

uguali, per esempio)

•

Il valore del vettore dei parametri β è uguale ad un certo valore β0?

•

Costruzione di una regione di confidenza per il vettore dei

parametri β;

•

Costruzione di un intervallo di confidenza per una delle componenti

di β; (o per una combinazione lineare delle componenti di β, ad

esempio β1−(β2+β3)/2).

•

Inferenza su r componenti di β; le altre k-r componenti di β non

interessano e svolgono però il ruolo di parametri di disturbo.

•

Gli effetti di alcune variabili Xj sono uguali? ossia alcuni dei

parametri sono uguali?

•

Alcuni dei parametri sono uguali subordinatamente al valore di altre

variabili Xj?

•

Qual è la combinazione di fattori che fornisce la risposta media Y

più elevata?

•

Subordinatamente al fatto che alcuni effetti siano significativamente

diversi da zero, quali hanno condotto alla significatività?

•

Una o più fra le variabili Xj può essere eliminata, senza che questo

riduca in modo sostanziale la spiegazione della variabile di risposta?

Eliminare una variabile esplicativa Xj dal modello corrisponde ad

ipotizzare βj=0.

•

Anche se βj è significativamente diverso da zero, può comunque

convenire lavorare con un modello ridotto anche se distorto?

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

37

&

Ipotesi sulle ε

ε∼φ(θ).

Per potere dare una risposta, anche approssimativa, ad alcune di queste

domande, e quindi per la costruzione di stimatori e test, e per fare in

generale inferenza (almeno muovendosi in un contesto parametrico),

occorrerà fare ovviamente delle ipotesi, più o meno restrittive, sulla

distribuzione di ε. Questa distribuzione dipenderà in generale da un

vettore di parametri θ:

E’ ovvio che, anche ammettendo di conoscere la forma funzionale φ,

occorrerà stimare il vettore di parametri θ.

Va tenuto presente che ε non è direttamente osservabile, come accade

invece, ad esempio, quando si osserva un campione proveniente da una

normale univariata di parametri incogniti µ (costante) e σ2.

• θ svolge in generale il ruolo di parametro di disturbo.

Ovviamente il numero dei parametri incogniti θs non dovrà essere

elevato, diversamente non sarà possibile stimarli.

•

ESEMPIO: se si suppone ε∼N(0,Σ) non possono essere incogniti tutti

gli elementi della matrice di varianza e covarianza Σ (perchè sono

n(n+1)/2 parametri)

Quanto interagiscono la stima di θ e quella di β?

E’ possibile in qualche modo verificare a posteriori la validità delle

ipotesi fatte sulla distribuzione delle ε?

Le possibili scelte verranno analizzate successivamente alla

discussione sul significato della parte sistematica.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

38

La matrice delle X

La struttura ed il metodo di scelta delle Xj, insieme con la

parametrizzazione scelta determina in parte il tipo di analisi.

Sostanzialmente le Xj (tutte o alcune) possono provenire da:

♦ studi osservazionali

Questo caso si presenta quando non è possibile in generale stabilire a

priori la matrice X: si sceglieranno solo le k particolari variabili da

analizzare e le n unità che costituiscono il campione. Eventualmente

potremo, entro certi limiti, operare alcune trasformazioni sulle X in

modo da ricondurci a schemi particolari.

♦ esperimenti pianificati con:

•

variabili controllabili

in cui alcune variabili (h), e tutto lo schema degli n×h valori

corrispondenti della matrice X, vengono pianificati in anticipo, per cui

si stabilisce in partenza il range di valori di ciascuna variabile

esplicativa e le combinazioni di valori delle variabili esplicative che si

vogliono osservare, in funzione delle risposte che si vogliono ottenere

dall'esperimento. Con un esperimento mal pianificato, in cui ad

esempio non sono previste alcune combinazioni di livelli di variabili,

non si potranno per esempio condurre tutti i test che si possono

effettuare con dati provenienti da un esperimento ben pianificato.

•

variabili note ma il cui valore non è pianificabile

Ad esempio vengono selezionati alcuni soggetti in base al sesso ed

alla condizione lavorativa, per cui si stabilisce in anticipo quante

osservazioni fare per tutte le combinazioni sesso x condizione

lavorativa mentre per le altre variabili non è possibile pianificare dei

valori particolari.

ESEMPI VARI

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

39

Osservazioni ripetute.

Alcune delle righe della matrice X potrebbero essere (volutamente o

per caso) replicate. Nel caso di presenza di osservazioni ripetute per

ciascuna combinazione di fattori, l’analisi potrà anche dire qualcosa di

più:

sulla bontà delle assunzioni fatte sulla distribuzione degli errori

sulla forma funzionale della relazione (se lineare o meno).

Sulla variabilità della componente accidentale per ciascuna

combinazione di fattori.

AMPLIARE

Box Plot (non è considerata la diversa dimensione campionaria)

180

190

SPEZZATA DI REGRESSIONE

RETTA DI REGRESSIONE

ALTEZZA

160

170

150

Massimo

Minimo

140

Media+sigma

Media-sigma

Media

130

120

1

2

3

4

5

variabile di classificazione (quantitativa)

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

40

INSERIRE ESEMPIO E

GRAFICO a 2D e 3D

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

41

Disegni fattoriali

Un disegno si dice fattoriale se vengono pianificate le osservazioni di

tutte le possibili combinazioni dei livelli dei k fattori.

Pertanto se ogni fattore può assumere mj livelli, si avranno:

k

C = ∏ mj distinte combinazioni,

j=1

ciascuna delle quali può essere replicata, per ottenere la matrice X.

Fattore

dosi di un farmaco

Sesso

Condizione sperimentale

TOTALE:

Esempio:

In un esperimento farmacologico si vuole stimare l'effetto di un

farmaco (tre dosi: una nulla, una media, una alta) su pazienti con una

particolare patologia. Si vuole verificare anche l'effetto su pazienti sani, e

vedere se il sesso del paziente influenza il tipo di risposta.

Complessivamente si hanno i seguenti fattori e corrispondenti livelli:

SESSO

F

F

M

M

F

F

M

M

F

F

CONDIZIONE

Sano

Malato

Sano

Malato

Sano

Malato

Sano

Malato

Sano

Malato

1

Bassa

M

Sano

1

Bassa

M

Malato

1

2

3

4

5

6

7

8

9

1

DOSE

Alta

Alta

Alta

Alta

Media

Media

Media

Media

Bassa

Bassa

livelli (o modalità qualitative)

3 livelli quantitativi di dose

2 livelli

2 livelli: malati e sani

12 combinazioni

0

1

2

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

42

SESS

Valore numerico

M

F

+1

-1

Se si conviene di assegnare i seguenti valori numerici:

DOSE

Valore numerico

Alta

+1

Media

0

Bassa

-1

O

Sano

Malato

Valore

numerico

+1

-1

CONDIZIONE

Si ottiene la seguente matrice dei regressori:

SESSO CONDIZIO

+1

+1

+1

-1

-1

+1

-1

-1

+1

+1

+1

-1

-1

+1

-1

-1

+1

+1

+1

-1

1

-1

-1

+1

1

-1

-1

-1

1

2

3

4

5

6

7

8

9

1

DOSE

+1

+1

+1

+1

0

0

0

0

-1

-1

1

2

0

Se i livelli sono quantitativi ed equispaziati, l'analisi risulta

ortogonale (vedere anche più avanti)

Anche se non si riesce a costruire un disegno fattoriale, perché

troppo oneroso, sarà opportuno di solito ricorrere a disegni

ortogonali.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

43

piano fattoriale 3x5x3

L'opportunità di avere l'ortogonalità dei fattori (ossia variabili non

correlate) è pienamente giustificata solo nell'ambito della teoria

normale completa sui minimi quadrati.

Comunque è ragionevole che i fattori non siano correlati (se

possibile).

In un esperimento a molti fattori sarà opportuno che siano

bilanciate in corrispondenza a ciascuna coppia di fattori, le possibili

combinazioni di coppie di livelli

ESEMPIO di DISEGNO FATTORIALE completo

ESEMPIO di DISEGNO FATTORIALE incompleto

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

44

piano fattoriale (incompleto) 3x5x3

X1: 5 LIVELLI; X2 e X3 con 3 livelli

SCARTI DALLE MEDIE

Z1

Z2

-2

-1

-1

-1

0

-1

1

-1

2

-1

-2

0

-1

0

0

0

1

0

2

0

-2

1

-1

1

0

1

1

1

2

1

-2

-1

-1

-1

0

-1

1

-1

2

-1

-2

0

-1

0

0

0

1

0

2

0

-2

1

-1

1

0

1

1

1

2

1

-2

-1

-1

-1

0

-1

1

-1

2

-1

-2

0

-1

0

0

0

1

0

LIVELLI ORIGINALI

X1

X2

1

0

2

0

3

0

4

0

5

0

1

1

2

1

3

1

4

1

5

1

1

2

2

2

3

2

4

2

5

2

1

0

2

0

3

0

4

0

5

0

1

1

2

1

3

1

4

1

5

1

1

2

2

2

3

2

4

2

5

2

1

0

2

0

3

0

4

0

5

0

1

1

2

1

3

1

4

1

X3

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

1

1

1

1

1

1

1

1

1

1

1

1

1

1

1

2

2

2

2

2

2

2

2

2

Appunti del Prof. M. Chiodi per il corso di Statistica 3

Z3

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

-1

0

0

0

0

0

0

0

0

0

0

0

0

0

0

0

1

1

1

1

1

1

1

1

1

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

5

1

2

3

4

5

1

2

2

2

2

2

2

2

2

2

2

2

2

-2

-1

0

1

2

45

0

1

1

1

1

1

1

1

1

1

1

1

90

0

0

0

30

0

z'z=

0

0

30

(vedere anche > > esempi e grafici qualitativi e quantitativi)

Disegni 2k

Un caso particolare di disegno fattoriale si ha nel caso di k fattori

qualitativi dicotomici, per cui le variabili assumeranno il valore 1 o 0

secondo che la caratteristica è presente o assente; è conveniente anche

utilizzare i valori 1 e –1, in modo che in un piano completo le variabili

risulteranno centrate (ossia con media nulla) e con varianza unitaria

♦ Per esaminare tutte le combinazioni (senza repliche) occorre prevedere

2k osservazioni.

Disegno fattoriale completo 4 fattori a due livelli –1,1. Es:

1. farmaco si/no;

2. sesso M/F

3. malato si/no

4. ospedalizzato si/no

Si ottiene una matrice (centrata, ossia con medie nulle) con 16=24

righe:

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

16

0

0

0

Z3

1

1

-1

-1

1

1

-1

-1

1

1

-1

-1

1

1

-1

-1

0

16

0

0

Z4

1

-1

1

-1

1

-1

1

-1

1

-1

1

-1

1

-1

1

-1

0

0

16

0

0

0

0

16

z'z=

Z2

1

1

1

1

-1

-1

-1

-1

1

1

1

1

-1

-1

-1

-1

Z1

1

1

1

1

1

1

1

1

-1

-1

-1

-1

-1

-1

-1

-1

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

46

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

47

&

Regressione multipla.

,

y[n×1]

X[n×k]

L'informazione campionaria, relativa a n unità, è costituita da:

• Un vettore di n valori osservati y della variabile di risposta

quantitativa Y.

• La matrice X (n righe e k colonne) è data dai valori di k regressori

quantitativi, noti, per ciascuna delle n osservazioni

•

x12

...

...

xi2

...

...

xn2

...

...

...

...

...

...

...

x11

...

...

xi1

...

...

xn1

y1

...

...

yi

...

...

yn

Le n unità osservate sono quindi costituite da k+1 variabili e sono

schematizzabili nelle n righe:

x1k

...

...

xik

...

...

xnk

La dipendenza di Y dalle Xj è espressa quindi dalla relazione:

E(Yi)=α+

k

∑ xijβj

j=1

♦ abbiamo quindi k coefficienti di regressione incogniti βj che

esprimono la dipendenza media (parziale) della risposta da ciascun

regressore;

♦ in generale nel modello si considera anche un termine noto incognito

α, che esprime la risposta media corrispondente a valori nulli dei

regressori;

♦ α in generale non è oggetto di particolare interesse ed usualmente

svolge il ruolo di parametro di disturbo.

La relazione è analoga, almeno formalmente, alla relazione di

regressione lineare che studia la dipendenza della speranza matematica di

una variabile aleatoria rispetto ai valori (fissati!) di altre k variabili

aleatorie.

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

48

Non si confonda la regressione multipla (una variabile di risposta e

molti regressori) con la regressione multivariata (molte variabili di

risposta e uno o più regressori).

relazione di regressione in termini di scarti

Per comodità interpretativa, e per motivi più tecnici che si vedranno al

momento di affrontare i problemi di stima, convenzionalmente si può

porre:

• la prima colonna (j=0) composta tutta da 1 (in modo da prevedere la

presenza di un termine noto);

• le altre colonne costituite dagli scarti semplici rispetto alla media di

ciascuna variabile;

Con la posizione:

zij=xij - M(Xj)

i=1,2,...,n; j=1,2,...,k

la matrice X può essere messa nella forma più conveniente:

z11

...

zi1

...

zn1

...

...

...

...

...

z1j

...

zij

...

znj

...

...

...

...

...

z1k

...

zik

...

znk

Media variabile:

1

0

…

0

…

0

X=

1

...

1

...

1

Per i parametri si ha:

β0

β1

...

βj

Termine noto

Coefficiente di regressione parziale variabile 1

" "

" "

variabile j

...

...

βk

" "

" "

" "

β

=

βT = β0, β1,...,βj,...,βk

variabile k

Quindi la matrice dei regressori e il vettore dei coefficienti risultano

partizionati in:

Appunti del Prof. M. Chiodi per il corso di Statistica 3

a.a. 2001-2002

Prof. M. Chiodi

Modelli lineari

49

X =[1n|Z]

β' = [β0|β{1,k}]

Il legame lineare è ora dato da:

k

• E(Yi)

=

∑ zijβj

j=0

k

k

k

j=1

j=1

∑ zijβj =β0+ ∑ zijβj= β0- ∑ M(Xj)βj + ∑ xijβj

j=0

E(Yi) =

k

Per cui la risposta viene vista come somma di:

un effetto generale, β0, corrispondente a livelli nulli degli scarti zij, e

quindi a livelli medi dei regressori originari xij

k singoli effetti proporzionali agli scarti dei singoli regressori dalla

propria media.

Dal punto di vista interpretativo, la riscrittura in termini di scarti

consente di dare un significato logico, ed utile per i confronti, al termine

noto.

Rispetto alla parametrizzazione originaria si ha:

j=1

Quindi:

• i coefficienti di regressione sono sempre uguali (si sono solo effettuate

delle traslazioni di assi!)

k

• Per il termine noto: α=β0- ∑ M(Xj)βj

j=1