Note per le esercitazioni di Geometria 1

a.a. 2011/12

A. Lotta

Versione del 9/1/2012

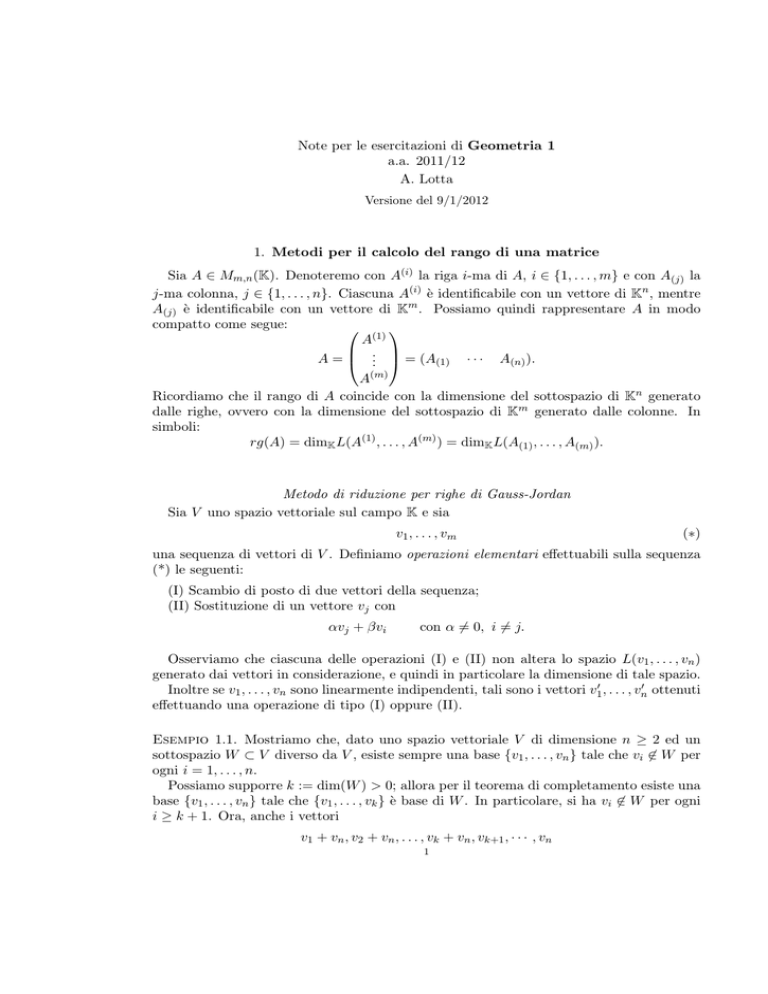

1. Metodi per il calcolo del rango di una matrice

Sia A ∈ Mm,n (K). Denoteremo con A(i) la riga i-ma di A, i ∈ {1, . . . , m} e con A(j) la

j-ma colonna, j ∈ {1, . . . , n}. Ciascuna A(i) è identificabile con un vettore di Kn , mentre

A(j) è identificabile con un vettore di Km . Possiamo quindi rappresentare A in modo

compatto come segue:

(1)

A

..

A = . = (A(1) · · · A(n) ).

A(m)

Ricordiamo che il rango di A coincide con la dimensione del sottospazio di Kn generato

dalle righe, ovvero con la dimensione del sottospazio di Km generato dalle colonne. In

simboli:

rg(A) = dimK L(A(1) , . . . , A(m) ) = dimK L(A(1) , . . . , A(m) ).

Metodo di riduzione per righe di Gauss-Jordan

Sia V uno spazio vettoriale sul campo K e sia

v1 , . . . , vm

(∗)

una sequenza di vettori di V . Definiamo operazioni elementari effettuabili sulla sequenza

(*) le seguenti:

(I) Scambio di posto di due vettori della sequenza;

(II) Sostituzione di un vettore vj con

αvj + βvi

con α 6= 0, i 6= j.

Osserviamo che ciascuna delle operazioni (I) e (II) non altera lo spazio L(v1 , . . . , vn )

generato dai vettori in considerazione, e quindi in particolare la dimensione di tale spazio.

Inoltre se v1 , . . . , vn sono linearmente indipendenti, tali sono i vettori v10 , . . . , vn0 ottenuti

effettuando una operazione di tipo (I) oppure (II).

Esempio 1.1. Mostriamo che, dato uno spazio vettoriale V di dimensione n ≥ 2 ed un

sottospazio W ⊂ V diverso da V , esiste sempre una base {v1 , . . . , vn } tale che vi 6∈ W per

ogni i = 1, . . . , n.

Possiamo supporre k := dim(W ) > 0; allora per il teorema di completamento esiste una

base {v1 , . . . , vn } tale che {v1 , . . . , vk } è base di W . In particolare, si ha vi 6∈ W per ogni

i ≥ k + 1. Ora, anche i vettori

v1 + vn , v2 + vn , . . . , vk + vn , vk+1 , · · · , vn

1

2

sono linearmente indipendenti, in quanto tale sequenza è ottenuta da v1 , . . . , vn applicando

k operazioni elementari di tipo (II). Tali vettori costituiscono pertanto una base di V ; essa

soddisfa la condizione richiesta: infatti, essendo W un sottospazio, è sempre vero che se

w ∈ W e v 6∈ W , allora w + v 6∈ W .

Esempio 1.2. Dato uno spazio vettoriale V di dimensione n ≥ 1, e dato un vettore non

nullo u ∈ V , esiste una base {v1 , . . . , vn } di V tale che

u = v1 + · · · + vn .

Infatti, consideriamo una base del tipo {u, u2 , . . . , un } (esiste per il teorema di completamento). Allora anche

u − (u2 + · · · + un ), u2 , . . . , un

è una base, ottenuta dalla precedente applicando n − 1 operazioni elementari di tipo (II).

Essa soddisfa la condizione richiesta.

Esempio 1.3. Consideriamo lo spazio M2 (R) delle matrici quadrate di ordine 2. Mostriamo

che esso non ammette alcuna base del tipo

t

{A, A,

B, tB}

con A, B ∈ M2 (R). Infatti, se una tale base esistesse, anche i vettori

t

t

t

A − tA, A,

B − B,

B

sarebbero linearmente indipendenti, ed in particolare tali sarebbero le matrici antisimt

metriche A − tA e B − B,

il che è impossibile in quanto il sottospazio di M2 (R) costituito

dalle matrici antisimmetriche ha dimensione uno.

Definizione: Siano A, S ∈ Mm,n (K); diremo che S è ottenuta da A mediante operazioni

elementari sulle righe se S è la matrice che si ottiene da A effettuando sulla sequenza

A(1) , . . . , A(m) una o più operazioni elementari di tipo (I) oppure una sola operazione

elementare di tipo (II) applicata ad una o più righe distinte di A. In tal caso scriveremo

A → S.

In base a quanto osservato sopra

A → S ⇒ rg(A) = rg(S).

Notiamo inoltre che se A → S, allora lo spazio vettoriale generato dalle righe di A

coincide con quello generato dalle righe di S; lo stesso non può dirsi per quel che concerne

le colonne.

Definizione: Un elemento aij di A si dice un pivot di A se

aij 6= 0

e

asj = 0 per ogni s > i.

Tale condizione significa che tutti gli elementi “sottostanti” aij sono nulli.

A si dice ridotta per righe se ogni riga non nulla contiene un pivot.

3

Le matrici ridotte per righe sono interessanti perchè per esse il calcolo del rango è

immediato. Allo scopo di giustificare ciò, proviamo un risultato di carattere generale.

Fissato n ≥ 1, denoteremo le componenti di un vettore v ∈ Kn con

x1 (v), . . . , xn (v)

di modo che

v = (x1 (v), . . . , xn (v)).

Per come sono definite le operazioni di somma e prodotto per uno scalare nello spazio Kn

abbiamo, per ogni fissato j ∈ {1, . . . , n}:

xj (v + w) = xj (v) + xj (w),

xj (λv) = λxj (v)

per ogni j e per ogni v, w ∈ Kn e λ ∈ K. In altri termini, le applicazioni xj : Kn → K sono

tutte K-lineari.

Proposizione 1.4. Sia v1 , . . . , vr una sequenza di vettori di Kn . Si supponga che per ogni

i ∈ {1, . . . , r} esista j ∈ {1, . . . , n} (dipendente da i), tale che

xj (vi ) 6= 0,

xj (vs ) = 0 per ogni s > i.

Allora i vettori v1 , . . . , vr sono linearmente indipendenti.

Dimostrazione: Consideriamo una combinazione lineare nulla

(1)

λ1 v1 + · · · + λr vr = 0.

Per l’ipotesi applicata al primo vettore v1 della sequenza, esiste j ∈ {1, . . . , n} tale che

xj (v1 ) 6= 0,

xj (vs ) = 0 per ogni s > 1.

Calcolando allora la coordinata j-ma di ambo i membri di (1) si ottiene

λ1 xj (v1 ) = 0

da cui λ1 = 0. Sostituendo nella (1) si perviene quindi a

λ2 v2 + · · · + λr vr = 0.

Applicando ancora l’ipotesi al vettore v2 e ragionando allo stesso modo si ricava che λ2 = 0

e l’argomento si itera giungendo alla conclusione che λ1 = λ2 = · · · = λr = 0.

2

Esempio 1.5. I vettori

1

1

(3, 5, − , 2), (3, 5, 0, −7), (0, 5, 0, 2), (0, , 0, 0)

2

3

4

sono indipendenti e quindi costituiscono una base di R .

Teorema 1.6. Il rango di una matrice ridotta per righe coincide con il numero r delle

sue righe non nulle. Siano inoltre A(i1 ) , . . . , A(ir ) le righe non nulle di una matrice ridotta

A, i1 < · · · < ir . Scelto su ciascuna riga A(ik ) un pivot occupante la colonna jk , risulta

che le colonne corrispondenti A(j1 ) , . . . , A(jr ) sono indipendenti e costituiscono una base

di L(A(1) , . . . , A(n) ).

4

Dimostrazione: Per definizione di pivot, per ogni k = 1, . . . , r abbiamo

aijkk 6= 0,

aijsk = 0

per s > i.

(∗)

Considerata allora la sequenza

A(i1 ) , . . . , A(ir )

di vettori di Kn , la (*) garantisce che ad essa può applicarsi la Proposizione precedente,

in quanto per ogni i ∈ {1, . . . , m} e j ∈ {1, . . . , n} si ha

aij = xj (A(i) ).

Lo stesso può dirsi per la sequenza dei vettori di Km :

A(jr ) , . . . , A(j1 )

avendosi anche

aij = xi (A(j) ).

2

Teorema 1.7. Ogni matrice A si può trasformare, mediante una sequenza finita di operazioni elementari, in una matrice ridotta per righe. Più precisamente, esiste una sequenza

finita di matrici S1 , . . . , Sk in Mm,n (K) tale che

A → S1 → S 2 → · · · → S k

e Sk è ridotta per righe.

Dimostrazione: Descriviamo un algoritmo per ottenere la sequenza S1 , . . . , Sk . Sia

la prima riga non nulla di A (se non esiste, A = 0 e quindi A è già ridotta); si

scelga un elemento aij11 non nullo di A(i1 ) . Effettuando su ciascuna riga successiva A(s)

l’operazione elementare

A(i1 )

A(s) → aij11 A(s) − asj1 A(i1 )

si ottiene una nuova matrice S1 = (bij ) tale che bsj1 = 0 per ogni s > i1 . Dunque A → S1 .

Ora, se tutte le righe di S1 successive alla i1 -ma sono nulle, S1 è ridotta per righe con pivot

bij11 = aij11 sulla riga i1 -ma e colonna j1 -ma. In caso contario, si opera su S1 prendendo in

considerazione la prima riga non nulla di indice maggiore di i1 , scegliendo un elemento

non nullo di tale riga e ripetendo quanto fatto in precedenza. Si procede finchè vi sono

righe non nulle con cui operare.

2

Esempio 1.8. Applicando l’algoritmo descritto nella dimostrazione precedente alla matrice

A ∈ M4,5 (R) indicata di seguito si ottiene:

5

1

1

0

1

0

3

3

9

0

3

0

0

1

0

0

0

2 1 2

0 2 1

1 1 2

2 4 5

A

2 1

−2 1

3 0

6 0

S2

1

0

→

0

0

2

−1

→

3

6

0

2 1

3 −2 1

3

1 1

9

0 3

S1

1 0

2

0 3 −2

0 0

3

0 0

0

S3

2

−1

→

2

3

1

2

1 −1

0

3

0

0

Abbiamo cerchiato gli elementi che ad ogni passo vengono scelti per “divenire” pivots.

Dunque rg(A) = rg(S3 ) = 3.

Notiamo che, utilizzando il risultato precedente, determinando la matrice ridotta Sk si

ottiene non solo il rango di A, ma anche una base dello spazio R(A) generato dalle righe:

una tale base è costituita dalle righe non nulle di Sk .

Il procedimento di riduzione altera invece lo spazio C(A) generato dalle colonne. Dimostreremo però che lo stesso procedimento permette facilmente di determinare una base

di C(A), estraendo da {A(1) , . . . , A(n) } una base {A(j1 ) , . . . , A(jr ) } : gli indici colonna

j1 , . . . , jr da scegliersi sono quelli delle colonne occupate dai pivots di Sk . Allo scopo di

provare quest’affermazione, premettiamo qualche ulteriore osservazione sulle operazioni

elementari.

Notiamo che l’operazione elementare

A(j) → αA(j) + βA(i) ,

α 6= 0, j 6= i

equivale ad effettuare il prodotto

ZA

dove Z ∈ Mm (K) è la matrice

e1

···

ej−1

.

αe

+

βe

Z=

j

i

ej+1

···

em

Tale matrice è quella che si

ottiene

effettuando la corrispondente operazione elementare

e1

sulla matrice identica Im = ... . In particolare, rg(Z) = rg(Im ) = m e pertanto Z è

em

invertibile.

Una giustificazione di ciò può darsi rapidamente ricordando le seguenti proprietà fondamentali del prodotto righe per colonne tra matrici; se A ∈ Mm,n e B ∈ Mn,q sono due

6

matrici moltiplicabili, allora

A(1) B

AB = ... = (AB(1)

···

AB(q) ).

A(m) B

Inoltre

ei A = A(i) ,

Aej = A(j)

per ogni i = 1, . . . , m, e per ogni j = 1, . . . , n.

Anche per quel che concerne lo scambio di due righe vale un principio analogo. Da queste

considerazioni segue subito, essendo il prodotto di matrici invertibili anch’esso invertibile,

che se A → S, allora esiste una matrice invertibile Z ∈ GL(m, K) tale che S = ZA.

Proposizione 1.9. Siano A ∈ Mm,n (K), Z ∈ Mm (K) e si ponga

S = ZA.

Se S(j1 ) , . . . , S(jp ) sono colonne di S indipendenti, tali sono le colonne corrispondenti

A(j1 ) , . . . , A(jp ) di A.

Dimostrazione: Supponiamo S(j1 ) , . . . , S(jp ) indipendenti e assumiamo che

p

X

λk A(jk ) = 0.

k=1

Moltiplicando per Z ambo i membri si ottiene

p

X

λk ZA(jk ) = 0,

k=1

che possiamo riscrivere

p

X

λk (ZA)(jk ) = 0,

k=1

ovvero

p

X

λk S(jk ) = 0.

k=1

Pertanto λk = 0 per ogni k per l’ipotesi.

2

Corollario 1.10. Sia A ∈ Mm,n (K) e sia assegnata una sequenza di matrici S1 , . . . , Sk

tali che

A → S1 → S 2 → · · · → S k

e S := Sk è ridotta per righe.

Si scelga su ciascuna riga non nulla di S un pivot; dette j1 , . . . , jr le colonne occupate

da tali pivots, si ha che le colonne corrispondenti A(j1 ) , . . . , A(jr ) di A sono linearmente

indipendenti.

7

Dimostrazione: Sappiamo che da A → S1 segue che S1 = Z1 A per un’opportuna

Z1 ∈ GL(m, K). Analogamente, Si = Zi Si−1 per i > 1. Dunque

S = (Zk · · · Z1 )A.

L’asserto segue applicando la proposizione precedente, perchè le colonne S(j1 ) , . . . , S(jr )

sono indipendenti.

2

Esempio 1.11. Facendo riferimento all’Esempio 1.8 otteniamo che una base dello spazio

generato dalle colonne di A è costituita da A(1) , A(3) , A(4) . Un’altra base è {A(1) , A(2) , A(3) }.

Il metodo degli orlati di Kronecker

È noto che il rango di una matrice A coincide anche con il massimo degli ordini dei

minori non nulli di A. Discuteremo un risultato che permette di ridurre il più possibile il

numero di minori da calcolare per determinare il rango utilizzando tale caratterizzazione.

Sia A ∈ Mm,n (K); dati due sottoinsiemi

I = {i1 , . . . , ir } ⊂ {1, . . . , m},

J = {j1 , . . . , jq } ⊂ {1, . . . , n},

denoteremo con AIJ la corrispondente sottomatrice di A, avente r righe e q colonne. Nel

caso |J| = n (risp. |I| = m) , scriveremo semplicemente AI (risp. AJ ). Ovviamente

AIJ = (AI )J = (AJ )I .

Cosı̀, ad esempio, se

1

0

A=

0

0

allora

0

0

1

0

2

0

1

0

4

1

0

0

5

0

0

0

1 0 2 4 5

A{1,3,4} = A{4,1,3} = 0 1 1 0 0 .

0 0 0 0 0

2 5

{1,3,4}

A{2,5} = (A{1,3,4} ){2,5} = 1 0 .

0 0

Ricordiamo che un minore di A di ordine k ≥ 1 è uno scalare del tipo |AIJ | dove AIJ è

una sottomatrice quadrata di A di ordine k.

Sia ρ = |AIJ | un minore non nullo di ordine k. Allora le righe di A corripondenti sono

linearmente indipendenti e le colonne di A corrispondenti sono linearmente indipendenti.

Infatti, le sottomatrici AI e AJ hanno entrambe rango k, essendo ρ anche un minore di

esse.

Definizione 1.12. Sia ρ = |AIJ | un minore di ordine k ≥ 1 della matrice A ∈ Mm,n (K).

0

Si dice orlato di ρ ogni minore di ordine k + 1 del tipo |AIJ 0 | dove I ⊂ I 0 e J ⊂ J 0 .

8

Teorema 1.13. (Principio degli orlati di Kronecker)

Sia A ∈ Mm,n (K) e sia ρ un minore non nullo di A di ordine r. Allora, se tutti gli

orlati di ρ sono nulli, rg(A) = r.

Dimostrazione: Posto I = {i1 , . . . , ir } e J = {j1 , . . . , jr }, supponiamo che tutti gli

orlati di ρ = |AIJ | siano nulli, e per assurdo ammettiamo che rg(A) > r. Allora, poichè le

righe A(i1 ) , . . . , A(ir ) sono linearmente indipendenti, deve esistere una riga A(i) di A tale

che A(i1 ) , . . . , A(ir ) , A(i) sono ancora indipendenti (si applichi il Teorema di completamento

allo spazio vettoriale generato dalle righe di A). Posto I 0 = {i1 , . . . , ir , i}, la sottomatrice

0

0

AI ha pertanto rango r + 1. Poichè ρ è anche un minore non nullo di AI , abbiamo che

0

0

0

I , . . . , AI

I

I0

le colonne A(j

(jr ) di A sono indipendenti. Ancora dal fatto che rg(A ) = r + 1,

1)

0

0

0

0

0

segue che esiste una colonna AI(j) di AI tale che AI(j1 ) , . . . , AI(jr ) , AI(j) sono indipendenti.

0

0

Posto J 0 = {j1 , . . . , jr , j}, consideriamo allora la sottomatrice (AI )J 0 = AIJ 0 ; essa ha rango

0

r + 1 perchè le sue colonne sono indipendenti e pertanto |AIJ 0 | =

6 0, e resta cosı̀ determinato

un minore non nullo di ordine r + 1, che per costruzione è un orlato di ρ. Ciò è contro

l’ipotesi.

2

Questo risultato fornisce il seguente algoritmo per calcolare il rango di A: si individua

un elemento non nullo di A e si esaminano tutti i minori orlati di tale elemento: se sono

tutti nulli il rango è 1; in caso contrario, scelto un minore di ordine due ρ2 non nullo,

si calcolano gli orlati di ρ2 . Se questi sono tutti nulli, il rango è 2, altrimenti si procede

scegliendo un orlato non nullo ρ3 e si itera il procedimento calcolando gli orlati di ρ3 . Si

termina quando si individua un minore non nullo ρr di ordine r i cui orlati (se esistono)

sono tutti nulli, ricavando che rg(A) = r.

2. Metodi per la risoluzione di un sistema lineare

Si consideri un sistema lineare di m equazioni nelle n incognite x1 , . . . , xn :

(2)

Ax = b

dove A ∈ Mm,n (K) e b ∈ Km . Denotiamo con C = (A b) la matrice completa del sistema.

Si ricordi che (2) è compatibile se e solo se rg(A) = rg(C) (Teorema di Kronecker-RouchéCapelli).

Il sistema in questione può anche riscriversi utilizzando solo la matrice C come segue:

x1

..

(3)

C . = 0.

xr

−1

La i-ma equazione può a sua volta riscriversi

x

(i)

C

= 0.

−1

9

Notiamo che, se (2) è compatibile, fissata una base A(i1 ) , . . . , A(ir ) dello spazio generato

dalle righe di A, allora (2) risulta equivalente al sistema che si ottiene scartando le equazioni

non coinvolgenti le righe i1 , . . . , ir di C, ovvero

A0 x = b0

(4)

A(i1 )

bi1

..

..

0

0

dove A = . e b = . .

bir

A(ir )

Ciò segue dal fatto che, essendo rg(C) = rg(A) = r, ogni riga di C è combinazione

lineare delle righe C (i1 ) , . . . C (ir ) .

Nei paragrafi seguenti descriviamo due metodi per discutere e risolvere un sistema.

Metodo di riduzione ad un sistema di Cramer

Utilizzando il metodo degli orlati, si calcolano il rango r di A e di C e si stabilisce se il

sistema è risolubile. Posto r := rg(A), si fissi una sottomatrice non singolare

{i ,...,i }

M = A{j11 ,...,jrr }

di A di ordine r, corrispondente alle righe di indici i1 < · · · < ir ed alle colonne j1 < · · · <

jr .

Posto inoltre k := n − r, si denotino con p1 < · · · < pk gli indici colonna diversi da

j1 , . . . , jr . Allora ogni vettore x ∈ Kn si scrive in modo unico come

(5)

x = xj1 ej1 + · · · + xjr ejr + λ1 ep1 + . . . λk epk =: x0 + x00 .

Poniamo ora

bi1

b0 := ... ,

bir

{i ,...,i }

Z := A{p11 ,...,prk } .

Ad esempio, dato il sistema

x + 2y + 3z + 4t = 8

2x + 4y + 6z + 8t = 16

2x + 4y + 5z = 7

si ha rg(A) = rg(C) = 2 e si può scegliere M =

0

b =

16

,

7

{2,3}

A{1,3}

Z=

=

2 6

; in tal caso

2 5

4 8

.

4 0

10

Ciò premesso, affermiamo che un vettore x = x0 + x00 ∈ Kn è soluzione di (2) se e solo

se z = (xj1 , . . . , xjr ) è soluzione del sistema di Cramer

λ1

..

0

(6)

M z = ξ,

ξ := b − Z .

λk

di ordine r nelle incognite xj1 , . . . , xjr .

Si osservi che, assumendo n > r, le altre incognite xp1 , . . . xpk sono confluite nei termini

noti del sistema (6). Nel caso in cui n = r, allora M = A{i1 ,...,in } e (6) è un sistema di

Cramer coinvolgente tutte le incognite x1 , . . . , xn .

Tornando all’esempio di cui sopra, il sistema (6) è

2x + 6z = 16 − 4λ1 − 8λ2

.

2x + 5z = 7 − 4λ1

Per giustificare l’affermazione di cui sopra, basta ricordare che il nostro sistema è equivalente a (4); ora, x ∈ Kn è soluzione se e solo se

A0 x = b0

ovvero

A0 x0 = b0 − A0 x00

che può riscriversi

λ1

M z = b0 − Z ... .

λk

Dunque per ogni valore (λ1 , . . . , λn−r ) attribuito alle incognite xp1 , . . . , xpk si ottiene

un’unica soluzione z del sistema (6) e quindi una ben determinata soluzione di (2) data da

x = x0 + x00 in accordo con la (5), che può calcolarsi con la formula di Cramer. Viceversa,

ogni soluzione x di (2) è ottenuta in questo modo in corrispondenza della scelta di un’unica

k-pla (λ1 , . . . , λk ).

Nell’esempio già esaminato, si ottiene che la generica soluzione del sistema è

(−2λ1 + 20λ2 − 19, λ1 , 9 − 8λ2 , λ2 ),

al variare di λ1 , λ2 ∈ R.

In altri termini, denotato con S ⊂ Kn l’insieme di tutte le soluzioni del sistema (2),

assumendo n > r vi è una bigezione

Ψ : Kn−r → S

data da

Ψ(λ1 , . . . , λn−r ) := x0 + x00

dove

x0 = xj1 ej1 + · · · + xjr ejr , x00 = λ1 ep1 + · · · + λk epk

essendo (xj1 , . . . , xjr ) l’unica soluzione di (6).

11

Diremo quindi che il sistema ammette ∞n−r soluzioni, descritte al variare dei parametri

liberi λ1 , . . . , λn−r .

Notiamo anche che il sistema ammette un’unica soluzione se e solo se r = n; formalmente, si conviene di far rientrare anche questo caso nella simbologia ∞n−r . Nelle

notazioni precedenti, ciò corrisponde a porre K0 = {0} e x00 = 0.

Il lettore osservi infine che, nel caso in cui il sistema in esame è omogeneo, allora S è

un sottospazio vettoriale di Rn ed inoltre Ψ è lineare. Dunque Ψ è un isomorfismo e la

dimensione di S è n − r.

Riduzione di un sistema per righe

Per stabilire se il sistema (2) ovvero (3) è risolubile, si può procedere col seguente

algoritmo: se C contiene almeno una riga del tipo (0 . . . 0 α) con α 6= 0, allora il sistema

non ha soluzioni. Altrimenti si considera la prima riga non nulla di C e si procede alla

riduzione per righe di C scegliendo ad ogni passo un pivot non appartenente all’ultima

colonna. Ogni trasformazione effettuata trasforma il sistema (3) in uno equivalente. Se ad

un certo passo non è possibile scegliere un pivot sulle prime n − 1 colonne, il sistema non

è compatibile perchè equivalente ad un sistema contenente un’equazione del tipo 0 = α

con α 6= 0.

Terminata, se possibile, la procedura di riduzione per righe, si perviene ad una matrice

ridotta C 0 e quindi ad un sistema equivalente

(7)

A0 x = b 0

in cui sia A0 che C 0 = (A0 b0 ) sono ridotte per righe e dello stesso rango. Questo sistema

è pertanto compatibile e tale è il sistema iniziale (2).

Detti j1 , . . . , jr gli indici delle colonne occupate dai pivots di C 0 , il sistema (7) si risolve agevolmente nelle incognite xj1 , . . . , xjr cominciando dall’ultima equazione non banale (cioè non della forma 0 = 0) ricavando l’incognita xjr (l’unica che compare tra le

xj1 , . . . , xjr ) in funzione di tutte le altre; si procede quindi a ritroso risolvendo tutte le

altre equazioni rispetto alle incognite rimanenti. Le n − r incognite diverse da xj1 , . . . , xjr

svolgono quindi il ruolo di parametri liberi al variare dei quali si ottengono ∞n−r soluzioni.