4. Introduzione al test di ipotesi

4. 1. Due esempi introduttivi

4. 1. 1. Confronto di una media col corrispondente parametro: primo caso

Da una indagine condotta in modo esaustivo su tutte le scuole di una certa provincia si sa che il punteggio grezzo medio

in una prova standardizzata per accertare certe abilità matematiche in ingresso nella scuola media inferiore è pari a

57.6 e che la deviazione standard è 20.38 .

Quando i risultati sono stati pubblicati (supponiamo l’anno successivo), una certa realtà locale, diciamo un istituto,

vuole confrontare la propria situazione rispetto al il risultato provinciale; si somministra dunque la medesima prova

standardizzata nelle nuove classi prime per un totale di 95 studenti e si sintetizzano i risultati attraverso la media,

ottenendo: Y 61.1 . Precisiamo che Y è una media campionaria che stima il valore incognito del corrispondente

parametro locale che indicheremo col simbolo L.

Supponiamo che l’istituto sotto esame abbia fama di essere una scuola molto impegnativa e selettiva. In tale ipotesi è

ragionevole supporre che già nel momento delle iscrizioni la popolazione scolastica locale si autoselezioni, nel senso

che le famiglie di ragazzi scolasticamente più deboli optano per istituti meno impegnativi. Proprio questa autoselezione

è sottoposta a indagine. In altre parole, si vuole verificare se i risultati delle prove di ingresso nella realtà locale siano

superiori alla media provinciale per effetto dell’autoselezione.

Di fatto abbiamo due ipotesi in opposizione:

c’è sostanziale omogeneità fra i risultati locali e quelli provinciali; formalizzando in senso statistico: il campione

locale appartiene ad una popolazione con media parametrica L uguale alla media parametrica della popolazione

provinciale; in simboli: L = ;

i risultati locali sono migliori di quelli provinciali; ovvero: il campione locale appartiene ad una popolazione con

media parametrica L maggiore di quella della popolazione provinciale ; in simboli: L> .

Nella seconda ipotesi alcuni aggettivi sono evidenziati dal corsivo. Di questa seconda ipotesi verrà fornita una seconda

versione in § 4. 1. 2. che si diversificherà proprio in quegli aggettivi in corsivo.

Lo schema di ragionamento che seguiremo è questo:

supponiamo valida la prima ipotesi, e cioè che la media locale L sia uguale alla media provinciale ; in base a questa

ipotesi calcoliamo (seguendo la falsariga del Box 3.1) la probabilità di ottenere una media campionaria come

Y 61.1 da una popolazione con media . Se per questa probabilità otterremo valori bassi (cioè se l’evento è

scarsamente probabile) rifiuteremo la prima ipotesi in favore della seconda, altrimenti terremo buona la prima. Per

giudicare se la probabilità calcolata è alta o bassa ci atterremo ad una convenzione diffusamente accettata secondo cui

sono basse probabilità p 5% .

Passiamo alla realizzazione pratica.

Cominciamo a standardizzare il valore della media campionaria utilizzando la (3.4):

z

61.1 57.6

20.38

1.67

95

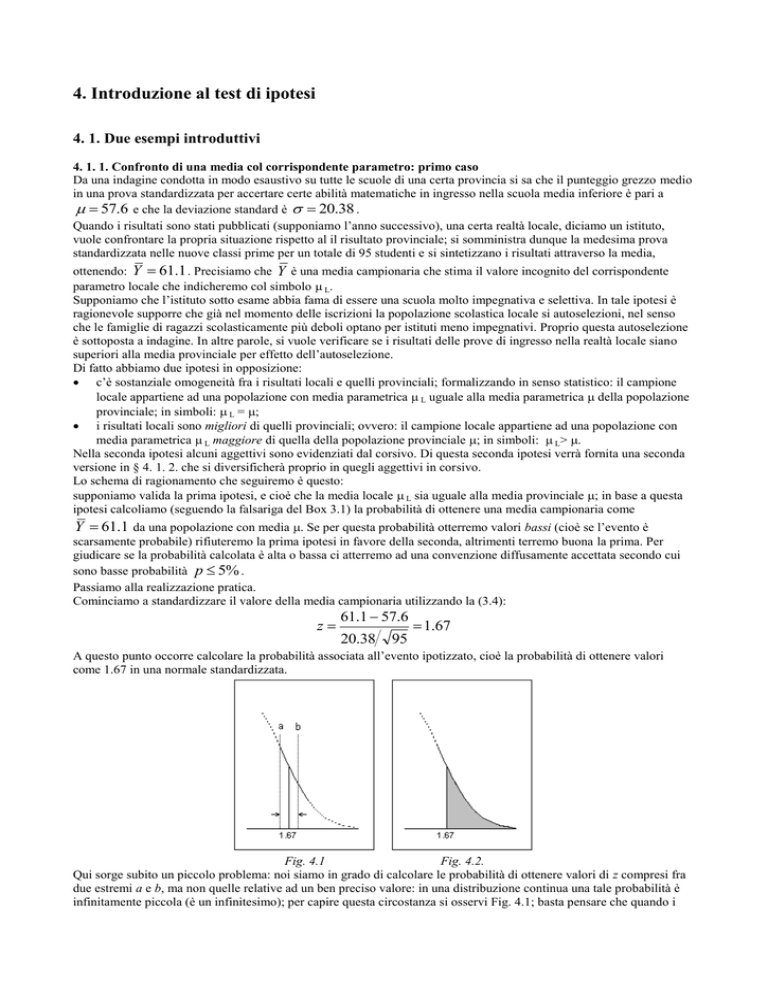

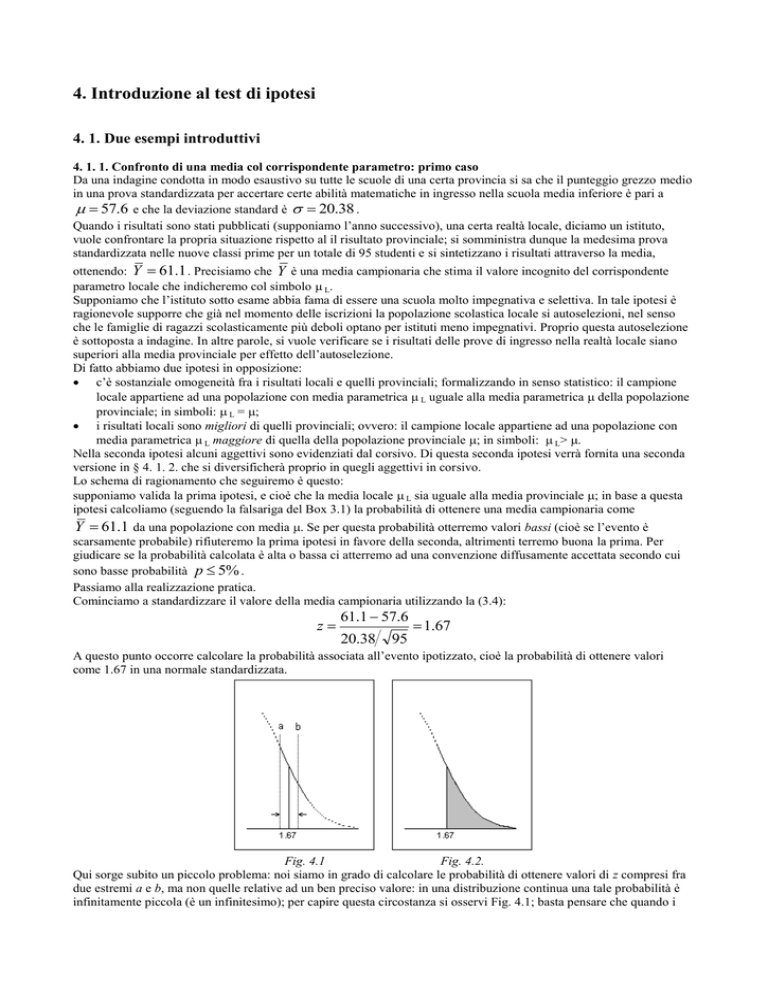

A questo punto occorre calcolare la probabilità associata all’evento ipotizzato, cioè la probabilità di ottenere valori

come 1.67 in una normale standardizzata.

Fig. 4.1

Fig. 4.2.

Qui sorge subito un piccolo problema: noi siamo in grado di calcolare le probabilità di ottenere valori di z compresi fra

due estremi a e b, ma non quelle relative ad un ben preciso valore: in una distribuzione continua una tale probabilità è

infinitamente piccola (è un infinitesimo); per capire questa circostanza si osservi Fig. 4.1; basta pensare che quando i

due estremi a e b si avvicinano indefinitamente al valore 1.67, la superficie sotto la curva si assottiglia indefinitamente e

la corrispondente area tende a 0.

Anziché calcolare la probabilità di ottenere il valore 1.67, calcoliamo allora la probabilità di ottenere il valore 1.67 o un

valore anche maggiore; quindi la probabilità che z 1.67 ; come sappiamo questo equivale a calcolare l’area sotto una

coda della curva di distribuzione, come mostra Fig.4.2.

Con l’aiuto della Tavola 2 ottengo prima l’area sotto la normale standardizzata da 0 a 1.67, che vale 0.4525. Poi, per

differenza da 0.5000 ottengo: 0.5000 – 0.4525 = 0.0475, pari ad una probabilità di 4.75%.

Quindi: il fatto di ottenere una media così alta in una popolazione come quella provinciale è scarsamente probabile (in

quanto la probabilità è inferiore al limite convenzionalmente fissato al 5%); dunque rifiuto l’ipotesi che la popolazione

locale sia uguale a quella provinciale.

Ora si faccia attenzione ad una circostanza essenziale. Questo test non mi dà la certezza di aver preso la decisione

giusta, in quanto una probabilità di ottenere medie così alte in una popolazione come quella provinciale è sì bassa, ma

non nulla. Quindi la mia decisione non è presa in condizioni di certezza, ma è esposta ad una probabilità di errore,

sebbene bassa, pari al 4.75%.

4. 1. 2. Confronto di una media col corrispondente parametro: secondo caso

Torniamo alla situazione descritta in § 4. 1. 1.: i parametri provinciali siano dunque ancora

57.6 e 20.38 .

Ancora una volta ipotizziamo che una realtà locale ripeta la prova ottenendo una media Y 61.1 su un campione di

95 studenti. Ancora una volta precisiamo che si tratta di una media campionaria che stima il valore incognito del

corrispondente parametro locale che indicheremo col simbolo L.

In questo nuovo esempio tuttavia supponiamo di non avere nessun motivo di pensare che la media locale sia superiore o

inferiore a quella provinciale: non vi sono elementi che facciano ipotizzare autoselezioni in ingresso (si noti che questa

è l’ordinaria amministrazione). Si vuole solo confrontare alla cieca la situazione locale con quella provinciale.

Di fatto abbiamo due ipotesi a confronto:

c’è sostanziale omogeneità fra i risultati locali e quelli provinciali; in termini statistici maggiormente formalizzati:

il campione locale appartiene ad una popolazione la cui media parametrica L è uguale a quella della popolazione

provinciale ; in simboli: L = ;

i risultati locali sono diversi da quelli provinciali; ovvero: il campione locale appartiene ad una popolazione con

media parametrica L diversa da quella della popolazione provinciale ; in simboli: L .

Come si vede la prima ipotesi è uguale a quella in § 4. 1. 1.; la seconda invece è leggermente differente, avendo

sostituito all’ipotesi L > l’ipotesi più generica L . In questo esempio non ipotizziamo dunque che la differenza

fra le due medie locale e provinciale abbia un ben preciso verso.

Anche in questo caso lo schema di ragionamento che seguiremo è lo stesso del precedente esempio:

supponiamo valida la prima ipotesi, e cioè che la media locale L sia uguale alla media provinciale ; in base ad questa

ipotesi calcoliamo la probabilità di ottenere per la media il valore 61.1 o un valore anche maggiore. Ancora una volta se

otterremo una probabilità al di sotto del 5% (cioè se l’evento si rivelerà scarsamente probabile) rifiuteremo la prima

ipotesi e accetteremo la seconda, altrimenti sarà buona la prima.

Il calcolo preliminare di z conduce allo stesso risultato di § 4.1.1.: z = 1.67.

Prima di passare ai calcoli delle aree sotto la normale standardizzata, occorre prestare attenzione al significato della

seconda ipotesi enunciata sopra: noi non abbiamo motivo per dire che la media locale sia maggiore (o minore) di quella

provinciale; siamo interessati solo a vedere se le due medie sono differenti, senza ipotizzare un particolare verso della

eventuale differenza.

Si potrebbe dire che in effetti il nostro valore di

Y è maggiore di , e che quindi noi conosciamo l’orientamento della

differenza. Così facendo però si confonde una stima della media locale (appunto Y ) col corrispondente parametro, che

abbiamo chiamato L, che invece è incognito. Ecco perché in assenza di ulteriori eventuali considerazioni noi

valutiamo solo la diversità fra i due parametri, e non ipotizziamo che questa diversità abbia un verso specifico a favore

dell’una o dell’altra.

In generale i valori di z possono essere sia positivi (nel caso che Y sia maggiore di ) che negativi (nel caso opposto).

Quindi non possiamo limitarci a considerare la sola coda di destra della distribuzione (quella da z = 1.67 in avanti,

corrispondente ai soli valori estremi positivi di z) ma dobbiamo considerare anche quella sinistra (corrispondente ai

valori da z = -1.67 indietro), come mostra la Fig. 4.3.

Fig. 4.3

Sottoponendo a test l’ipotesi di diversità delle due popolazioni (senza ulteriori specificazioni circa il verso della

diversità) occorre dunque calcolare l’area sotto entrambe le code.

Ancora ricorrendo alla Tavola 2 troviamo che l’area sotto una coda vale 0.0475; raddoppiando (per le due code)

otteniamo 0.095 pari a alla probabilità 9,5%.

Il valore ottenuto è troppo alto per poter rifiutare la prima ipotesi ( L = ) perché ci esporrebbe ad un rischio di errore

pari quasi al 10%. Quindi non rifiutiamo la prima ipotesi e concludiamo che le due popolazioni sono omogenee.

Ancora una volta dobbiamo precisare che la decisione non è presa in condizioni di certezza. Noi non sappiamo se la

popolazione locale nella realtà dei fatti ha la stessa media della popolazione provinciale oppure no; possiamo solo dire

che escludere questa possibilità ci espone ad una probabilità di errore pari a 9.5%. Quindi, concludiamo che non ci sono

elementi sufficienti per respingere l’ipotesi di uguaglianza L = .

4. 2. La struttura del test di ipotesi

4. 2. 1. L’ipotesi nulla H0 e l’ipotesi alternativa H1

Esaminiamo le ipotesi poste in opposizione nei due esempi:

c’è sostanziale omogeneità fra i risultati locali e quelli provinciali; in simboli: L = ;

i risultati locali sono migliori (o diversi) di quelli provinciali; in simboli: L> (o L )

La prima delle ipotesi afferma che la media Y è in qualche modo compatibile col parametro . Proprio per l’asserita

mancanza di diversità fra le due popolazioni provinciale e locale questa ipotesi viene detta ipotesi nulla, e viene indicata

col simbolo H0 (dall’iniziale della parola inglese Hypothesis).

L’ipotesi che si oppone all’ipotesi nulla è detta ipotesi alternativa, e si indica con H1. Nei due esempi l’ipotesi

alternativa è quella che afferma una diversità (direzionata o non) fra le due popolazioni.

Seguendo lo schema logico dei due esempi notiamo che nel corso del test noi lavoriamo sempre per confutare l’ipotesi

nulla, a volte riuscendoci e a volte no:

nel primo caso riusciamo a dimostrare che la media locale è superiore a quella provinciale facendo vedere che è

improbabile ottenere una differenza come quella osservata se vale l’ipotesi nulla di omogeneità delle due popolazioni;

nel secondo caso invece non riusciamo a dimostrare che la media locale è diversa a quella provinciale perché così

facendo saremmo esposti ad una probabilità di errore inaccettabile (quasi 10%).

Insomma, a parte gli esiti differenti, i due test sono stati condotti con l’obiettivo di dimostrare l’insostenibilità

dell’ipotesi nulla (in termini probabilistici) e conseguentemente la plausibilità dell’ipotesi alternativa. In generale si può

dire che nella grande maggioranza dei casi un test statistico funziona con questa logica:

si desidera verificare una certa ipotesi (ad esempio che un determinato tipo di insegnamento risolve un certo problema

didattico); si formula l’ipotesi contraria, detta ipotesi nulla (quel determinato insegnamento non risolve il problema

didattico); poi si cerca di confutare l’ipotesi nulla: se questo riesce ciò richiama automaticamente in campo l’ipotesi

alternativa che nega l’ipotesi nulla.

Andando più nello specifico diciamo che dopo aver formulato H0 e H1:

1. si ammette H0;

2. si calcola con che probabilità i dati osservati possono essere ottenuti sotto H0;

3. se la probabilità ottenuta, chiamiamola , è sufficientemente bassa, si rifiuta H0 a favore di H1; la probabilità

diventa la probabilità di errore nella decisione presa;

4. se invece la probabilità non è sufficientemente bassa, si conclude che non ci sono sufficienti elementi per

rigettare H0.

Le probabilità di errore si calcolano sempre come aree sotto le code di una curva di distribuzione (nei nostri esempi

abbiamo usato la distribuzione normale standardizzata, ma già dal prossimo capitolo ne useremo un’altra di tipo più

generale).

A volte è necessario calcolare l’area sotto una sola delle due code, a volte invece si deve calcolare l’area complessiva

sotto tutte e due. Nel primo caso si parla di test ad una coda o monodirezionale, mentre nel secondo si parla di test a

due code o bidirezionale. La scelta dell’uno o dell’altro tipo dipende dall’ipotesi alternativa: nei nostri esempi

sottoponendo a test l’uguaglianza di due medie se l’ipotesi alternativa è L il test sarà a due code, mentre se

l’ipotesi alternativa è L> (o anche L < ) il test è a una coda.

Generalizzando possiamo dire che se le ipotesi riguardano non tanto la statistica , ma una statistica qualsiasi , se

l’ipotesi alternativa è 1 > 2 o 1 < 2 si tratta di un test a una coda, mentre se l’ipotesi alternativa è 1 2 si tratta di

un test a due code.

4. 2. 2. Errori statistici del primo e del secondo tipo

Abbiamo detto che la struttura logica di un test di ipotesi è tesa alla confutazione dell’ipotesi nulla. Allora ragioniamo

più approfonditamente su H0.

Le possibilità che si possono prospettare quando si prendere una decisione statistica sulla base di un test possono essere

riassunte nello schema seguente:

H0 accettata

H0 respinta

H0 vera

Decisione

corretta

Errore statistico

del I° tipo

H0 falsa

Errore statistico

del II° tipo

Decisione

corretta

Le righe della tabella si riferiscono al fatto che una ipotesi nulla può essere nella realtà dei fatti vera o falsa (e questo

dilemma non potrà mai essere risolto con certezza); le colonne invece si riferiscono alla circostanza che

indipendentemente da come le cose stanno in realtà lo statistico prende una determinata decisione, che può essere di

accettare o di rifiutare H0.

Le combinazioni possibili di queste circostanze indipendenti sono quattro:

1. H0 è vera e viene accettata: in questo caso abbiamo una decisione corretta;

2. H0 è vera, ma viene rigettata: si tratta di un errore che gli statistici chiamano del primo tipo;

3. H0 è falsa, ma viene accettata: anche in questo caso si tratta di un errore detto del secondo tipo;

4. H0 è falsa e viene respinta; in questo caso la decisione è corretta.

Negli esempi in § 4. 1. 1. e § 4. 1. 2. abbiamo parlato di certe probabilità di errore. Si tratta di capire, sulla scorta delle

definizioni introdotte ora, di che tipo di errore si tratti esattamente.

Nel primo esempio abbiamo rifiutato l’ipotesi nulla esponendoci ad un errore del 4.75% nel caso che le due popolazioni

fossero in effetti omogenee, cioè nel caso che H0 fosse vera. Parliamo di un errore nel rifiutare una ipotesi nulla

eventualmente vera: si tratta dunque di un errore statistico del primo tipo. In altre parole, quando in un test arriviamo a

rifiutare H0 in favore di H1, ci esponiamo ad un errore statistico del primo tipo.

La probabilità di un errore statistico del primo tipo è indicata in genere con la lettera ; nel caso dell’esempio

richiamato poco sopra, = 4.75%. Sebbene noi ci atterremo a questa convenzione simbolica, occorre segnalare una

seconda convenzione che ricorre talvolta in letteratura, che è quella di utilizzare la lettera p (di probabilità); in tal caso

la probabilità d’errore statistico del primo tipo viene segnalato con la scrittura p = 4.75%. Per concludere con le

convenzioni simboliche, occorre precisare che in letteratura le probabilità di errore vengono in genere segnalate

attraverso la notazione decimale e non attraverso la notazione percentuale; quindi, non = 4.75% o p = 4.75%, ma

= 0.0475 o p = 0.0475 (basta dividere per 100 la percentuale). Un ultimo esempio sul simbolismo: < 0.01 o p < 0.01

sono due scritture equivalenti che indicano una probabilità di errore statistico del primo tipo inferiore a 1%.

Analizziamo ora il secondo esempio, nel quale, respingendo l’ipotesi nulla L = saremmo esposti ad una probabilità

di errore di 9.5%. Anche in questo caso si tratta di un errore statistico del primo tipo (rifiutare H0 quando fosse vera), e

dunque possiamo quantificare della probabilità di errore con l’appropriato simbolismo: = 0.095 (o p=0.095). Essendo

troppo elevato non rifiutiamo H0. Così facendo, e nell’ipotesi che H0 sia invece falsa (e non possiamo escluderlo), ci

esponiamo ad un errore statistico del secondo tipo (appunto accettare H0 quando falsa), la cui probabilità è indicata con

la lettera . In questo contesto non ci occuperemo più a lungo della probabilità di errore del secondo tipo , se non per

dare la definizione di potenza di un test statistico in § 4. 2. 3.

4. 2. 3. Potenza di un test

Nel secondo esempio non siamo nelle condizioni di respingere H0; questo non significa che sia vera l’ipotesi nulla, ma

solo che non abbiamo sufficienti elementi per respingerla; forse, ripetendo lo stesso test ma su un campione

maggiormente numeroso, potremmo ottenere il risultato desiderato. Sulla base dei dati a disposizione non siamo riusciti

a dimostrare ciò che ci interessava.

Supponiamo ora che utilizzando un diverso test con gli stessi dati si riesca a ottenere il risultato desiderato di rifiutare

H0. Il nuovo test si direbbe più potente del primo.

In termini informali: la potenza di un test esprime la sua maggiore o minore capacità di arrivare a conclusioni forti sulla

base di pochi dati; per conclusioni forti intendiamo una buona capacità di respingere l’ipotesi nulla a favore dell’ipotesi

alternativa (a cui in genere il ricercatore è interessato).

Quanto detto può essere espresso affermando che un test è tanto più potente quando più limita la probabilità di errore

statistico del secondo tipo , cioè quanto più è alta la probabilità di rifiutare H0 quando è falsa. La definizione formale

di potenza P di un test sta nella semplice equazione:

(4.1)

P 1

Si può dimostrare (ed è del tutto intuitivo) che per un determinato test la potenza aumenta all’aumentare della

numerosità n del campione.

Il concetto di potenza di un test non verrà approfondito oltre.

4. 2. 4. Significatività e suoi livelli convenzionali

Se in un test riusciamo a respingere H0, ciò avviene in forza del fatto che la statistica su cui è basato (nei tre esempi la

statistica z) ha un valore sufficientemente alto da rendere l’area sotto alla coda corrispondente, cioè l’errore ,

sufficientemente piccolo. Quando avviene si dice che il valore della statistica (z nei nostri esempi) è significativo.

Con questa terminologia possiamo dire che nel primo caso z ha assunto un valore significativo, mentre nel secondo caso

il valore di z è non significativo.

Si è già accennato al fatto che esistono dei limiti convenzionali per definire accettabile una probabilità di errore . Nei

due test esemplificati abbiamo parlato di un 5%. Assieme a questo livello sono comunemente usati in ricerca altri due

livelli standard, che sono 0.01 (1%) e 0.001 (0.1%).

A seconda del valore di ottenuto nel test si parla di differenti livelli di significatività:

se 0.05 (5%) si dice che la statistica (z negli esempi) non è significativa e si etichetta col simbolo ns;

se 0.01 0.05 ( compreso fra 5% e 1%) si dice che la statistica (z negli esempi) è significativa a livello

0.05 e si etichetta col simbolo *;

se 0.001 0.01 ( è compreso fra 1% e 0.1%) si dice che la statistica (z negli esempi) è significativa a

livello 0.01 e si etichetta col simbolo **;

se infine 0.001 ( è minore di 0.1%) si dice che la statistica (z negli esempi) è significativa a livello 0.001 e

si etichetta col simbolo ***.

Utilizzando la terminologia appena introdotta possiamo dire che nel primo esempio z è significativa a livello 0.05, nel

secondo esempio z è non significativo.

4. 2. 5. Regioni critiche o di rifiuto, valori critici

Nei precedenti test basati sulla statistica z abbiamo potuto calcolare le aree sotto le corrispondenti code della normale

standardizzata (cioè i valori di ) direttamente con l’aiuto della Tavola 2.

I test che presenteremo nel seguito si basano su statistiche differenti (t, F e 2); per le rispettive differenti curve di

distribuzione non è possibile (per un semplice motivo chiarito nel prossimo capitolo) costruire tavole del tipo della

Tavola 2, in cui noto il valore della statistica (ancora una volta t, F e 2) possiamo leggere l’area della corrispondente

coda. Per abituarci da subito a questa situazione, introduciamo il concetto di regione critica e di valore critico

esemplificando con la statistica z e la corrispondente distribuzione normale standardizzata.

Partiamo considerando un test a due code. Se vogliamo che la nostra statistica sia significativa a livello 0.05, occorre

che il valore di z cada sotto una delle due code indicate in Fig. 4.4, che complessivamente danno un’area pari al 5%.

Possiamo facilmente vedere dalla Tavola 2 che il valore di z che delimita tali code è 1.96. Quindi se vogliamo rifiutare

H0 con un test a due code occorre che z sia minore di –1.96 o che z sia maggiore di 1.96. Le due code segnate in grigio

in Fig. 4.4 vengono dette zone critiche o di rifiuto (in quanto permettono di rifiutare H0) ed il valore che le delimita è

detto valore critico per la statistica z; tale valore critico viene indicato col simbolo z 0.05 , dove il pedice sta ad indicare

il livello di significatività. Per sapere se z è significativa a livello 0.05 in un test a due code basta che il suo valore

assoluto superi il valore critico

z 0.05 . Nell’esempio in § 4. 1. 2. abbiamo z z 0.05 , perché 1.67 1.96 , dunque z

non è significativo.

Fig. 4.4

Fig. 4.5

Le tavole fornite per le statistiche t, F e 2 non forniranno le aree sotto le code delle corrispondenti distribuzioni, ma i

t , F e 2 per la significatività delle corrispondenti statistiche a livello , con

0.05, 0.01, 0.001 .

valori critici

Passiamo ora al test ad una coda, facendo riferimento alla Fig. 4.5. In questo caso il 5% dell’area totale deve essere

raggiunto con una sola coda (destra, come in figura, o anche sinistra); ancora una volta consultiamo la Tavola 2

ricavando il valore critico 1.65. Nell’esempio in § 4. 1. 1. abbiamo z z 0.05 , perché 1.67 1.65 , dunque z è

significativo a livello 0.05.

In modo del tutto analogo, dalla Tavola 2 possono essere ricavati i valori critici della statistica z a livello 0.01 e 0.001

sia per un test a due code che per un test ad una coda.

Il Box 4.1 ripresenta in forma definitiva il test a due code di § 4. 1. 2.

Box 4.1. Confronto di una media parametrica con una media campionaria in una popolazione normalmente

distribuita. Test a due code.

Confronto fra i valori parametrici provinciali e i valori campionari locali.

Parametri della popolazione provinciale: = 5.76; = 20.38.

Campione locale:

Y = 61.1; n = 95.

H0: la popolazione locale ha una media parametrica L uguale alla media parametrica provinciale : L =

la popolazione locale ha una media parametrica L diversa dalla media parametrica provinciale : L

Calcolo la statistica z attraverso la (3.4):

z

Y

61.1 5.76

1.67

20.38

n

95

Stante la normalità della popolazione, la statistica z è distribuita come una normale standardizzata.

Metodo delle aree:

Dalla Tavola 2: l’area sotto la curva normale standardizzata da 0 a 1.67 è pari a 0.4525.

L’area sotto la coda di destra della distribuzione dei valori di z è pertanto:

0.5000 – 0.425 = 0.0475

l’area sotto le due code è pertanto

= 0.0475 . 2 = 0.0950

pari ad una probabilità di errore del primo tipo di 9.5%

Metodo del valore critico:

z 0.05 1.96

z 1.67 z 0.05

Conclusioni:

z = 1.67 risulta non significativo. Non ho sufficienti elementi per respingere l’ipotesi nulla, cioè non vi è evidenza

statistica per affermare una differenza fra la popolazione provinciale e quella locale.

Rif.:

§ 4. 2. 1.–5.