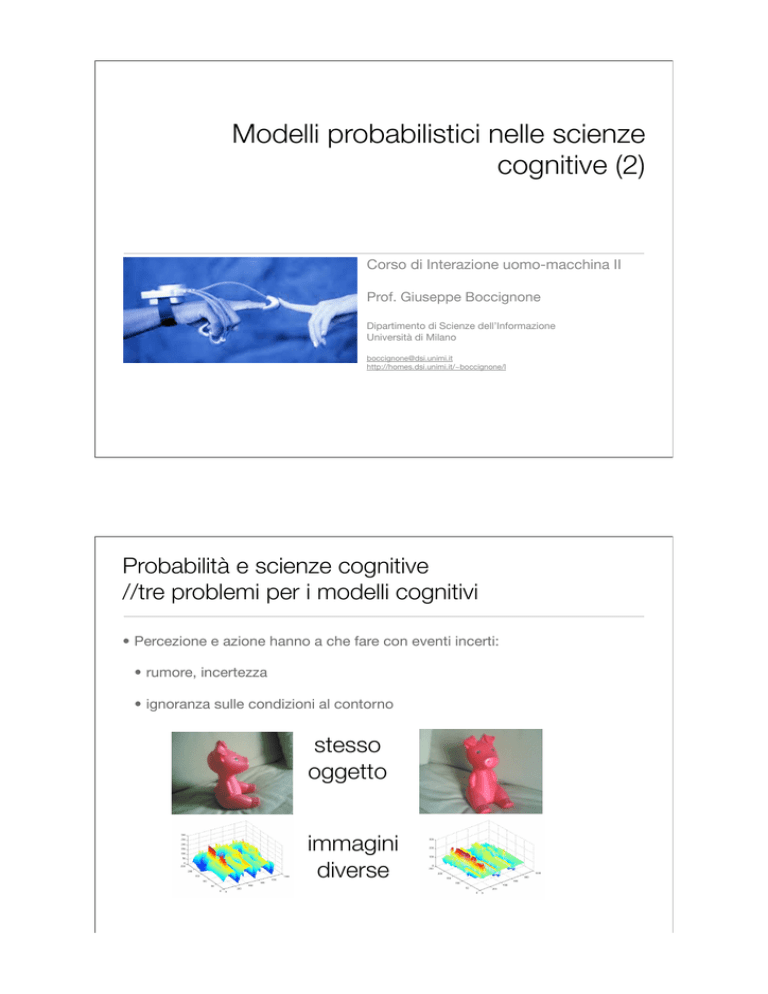

Modelli probabilistici nelle scienze

cognitive (2)

Corso di Interazione uomo-macchina II

Prof. Giuseppe Boccignone

Dipartimento di Scienze dell’Informazione

Università di Milano

[email protected]

http://homes.dsi.unimi.it/~boccignone/l

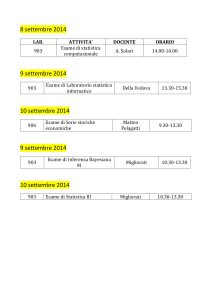

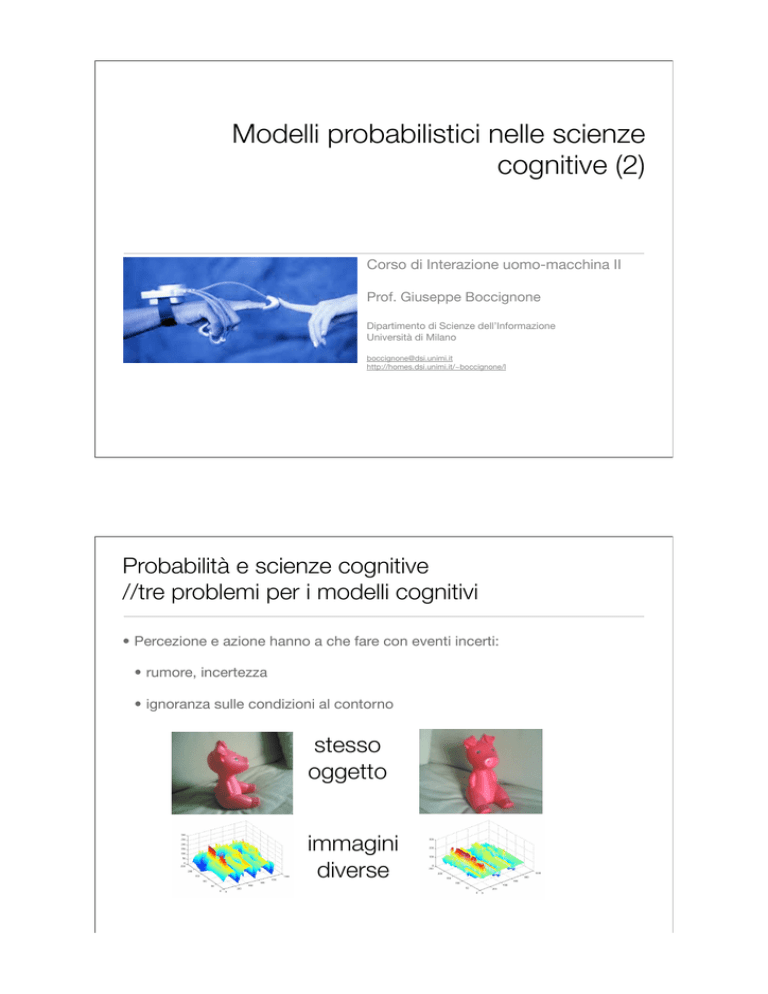

Probabilità e scienze cognitive

//tre problemi per i modelli cognitivi

• Percezione e azione hanno a che fare con eventi incerti:

• rumore, incertezza

• ignoranza sulle condizioni al contorno

stesso

oggetto

immagini

diverse

Probabilità e scienze cognitive

//tre problemi per i modelli cognitivi

• Percezione e azione hanno a che fare con eventi incerti:

• rumore, incertezza

• ignoranza sulle condizioni al contorno

oggetti

diversi

immagini

identiche

Probabilità e scienze cognitive

//tre problemi per i modelli cognitivi

• Percezione e azione hanno a che fare con eventi incerti:

• rumore, incertezza

• ignoranza sulle condizioni al contorno

! incertezze

}

! conoscenza

! modularità

Module

design

Module integration

?

La logica dell’incerto

• Come già osservava Locke (1632-1704), anche gli agenti più razionali

prendono le loro decisioni non nella chiara luce della certezza nel “crepuscolo

delle probabilità”.

• “Merita forse anche il titolo di conoscenza l'opinione fondata sulla plausibilità;

[…] Per questo credo che la ricerca sui gradi di probabilità sia estremamente

importante; […] Così, quando non si potesse decidere con assoluta certezza una

questione, si potrebbe almeno determinare il grado di probabilità alla luce

dell'evidenza”. (G.W. Leibniz, Nuovi Saggi sull’Intelletto Umano).

Probabilità e scienze cognitive

//percezione come inferenza inconscia

• Come già osservava Locke (1632-1704), anche gli agenti più razionali

prendono le loro decisioni non nella chiara luce della certezza nel “crepuscolo

delle probabilità”.

Te o r i a d e l l a

probabilità

! incertezze

! conoscenza

! modularità

Module

design

Module integration

}

?

Quale probabilità

//Tre concetti di probabilità: la definizione classica

• La probabilità di un evento è il rapporto tra il numero dei casi favorevoli e il

numero dei casi possibili, purché questi ultimi siano ugualmente possibili.

• Quindi se i casi possibili sono n e i casi favorevoli sono nA, per la teoria

classica la probabilità che accada l'evento A sarà:

Tre concetti di probabilità: la definizione

frequentista

• La probabilità di un evento è il limite della frequenza (relativa) dei successi,

cioè del verificarsi dell'evento, quando il numero delle prove tende all'infinito.

Tre concetti di probabilità: la definizione

soggettivista

• La probabilità di un evento è il prezzo che un individuo razionale ritiene equo

pagare per ricevere 1 se l'evento si verifica (e 0 altrimenti).

• Alessio è disposto a scommettere 1 contro 20 sul fatto che nel pomeriggio arrivi

finalmente l'idraulico a riparare il rubinetto che perde da una settimana:

attribuisce cioè a tale evento una probabilità ! 1/21 (meno del 5%).

• È come se ci trovassimo ad effettuare un sorteggio da un'urna con 1 pallina

rossa (evento positivo = arrivo dell'idraulico) e 20 palline nere (eventi negativi =

assenza dell'idraulico).

Come si valuta la probabilità?

• Immaginiamo che ci sia una partita di calcio. Lo spazio degli eventi

comprende (1) la vittoria della squadra di casa, (2) la vittoria della squadra

ospite e (3) il pareggio.

• Secondo la teoria classica esiste 1 probabilità su 3 che abbia luogo il primo

evento

• secondo la teoria frequentista ci si può dotare di un almanacco e controllare tutte

le partite precedenti e calcolare la frequenza dell’evento “vittoria della squadra di

casa”.

• Secondo la teoria soggettivista, ci si può documentare sullo stato di forma dei

calciatori, sul terreno di gioco e così via fino ad emettere una probabilità

soggettiva.

Probabilità e scienze cognitive

//percezione come inferenza inconscia

• Probabilità soggettiva: mette in relazione le asserzioni fatte sul mondo con lo

stato di conoscenza dell’agente

Te o r i a d e l l a

probabilità

! incertezze

! conoscenza

! modularità

Module

design

}

?

Module integration

Probabilità e scienze cognitive

//percezione come inferenza inconscia

...(Helmholtz, 1925)

I called the connections of ideas which take place in these processes

unconscious inferences.

These inferences are unconscious insofar as

their major premise is not necessarily expressed in the form of a proposition;

it is formed from a series of experiences whose individual members have

entered consciousness only in the form of sense impressions which have long

since disappeared from memory.

Some fresh sense impression forms the minor premise, to which the rule

impressed upon us by previous observations is applied

Probabilità e scienze cognitive

//percezione come inferenza inconscia

...(Helmholtz, 1925)

(T. Bayes, 1702-1761)

fresh sense

impression forms

the minor premise

unconscious inferences

rule impressed upon us by

previous observations

P( osservazioni

| conoscenza) x P((knowledge)

conoscenza)

P (observation|knowledge)P

(knowledge|observation)

P(Pconoscenza

| osservazioni) = =

P (observation)

P( osservazioni )

Probabilità e scienze cognitive

//percezione come inferenza inconscia

• Probabilità soggettiva: mette in relazione le asserzioni fatte sul mondo con lo

stato di conoscenza dell’agente = grado di credenza

! incertezze

Teoria

Bayesiana

! conoscenza

! modularità

Module

design

Module integration

della probabilità

Probabilità

//sintassi

• Proposizioni elementari

C, L, I

le possiamo considerare

variabili aleatorie

che assumono un valore

(discreto/continuo)

rispetto agli eventi che

accadono nel mondo.

Il risultato numerico di un

esperimento

• C = IN, “la curvatura è di tipo IN”

• Proposizioni complesse

• L=sopra ! C = IN

C

Curvatura C={IN, OUT}

L

Posizione sorgente di luce L={sopra, sotto}

I

Immagine I ={

Probabilità

//assiomi

• P(A) ! 0

• P (A ! ¬A) = 0

• P (¬A) = 1 - P(A)

• P(A " B) = P(A) + P(B) - P(A ! B)

,

}

Probabilità

//modellare la percezione del mondo

Probabilità

//modellare la percezione del mondo

• La scelta delle variabili

aleatorie di interesse

L

C

• discrete

• continue

I

C={IN, OUT}

L={sopra, sotto}

Immagine I ={

,

}

Probabilità

//la probabilità del tutto: congiunta

P(I ! C ! L)=P(I, C, L)

P(I, C, L)

I

L

C

I

C={IN, OUT}

L={sopra, sotto}

Immagine I ={

,

}

C

L

IN

sopra

IN

sopra

OUT

sopra

OUT

sopra

IN

sotto

IN

sotto

OUT

sotto

OUT

sotto

Probabilità

//la probabilità condizionata

• Probabilità condizionata di A dato B (posto che conosco il valore di B)

• P(A | B) = P(A ! B) / P(B) = P(A , B) / P(B)

• Ci consente di strutturare la conoscenza sul mondo

B

• Regola del prodotto

A

• P(A , B) = P(A | B) P(B) = P(B | A) P(A)

poichè P(A ! B) = P(B ! A)

• P(A , B , C) = P(A | B, C) P(B | C) P(C)

(chain rule)

semplifica una

query difficile

in query più

semplici

Probabilità

//la probabilità condizionata

• Da un punto di vista strettamente Bayesiano esistono solo probabilità

condizionate

• P(A ) -> P(A | H )

• H è l’insieme di ipotesi che ci consentono di esplicitare la conoscenza sul

mondo

Alcune delle ipotesi in H

Posizionamento luci

possibile

L

P(L | H)

L

0,9

sopra

0,1

sotto

P(L | H)

L

0,9

sopra

0,1

sotto

Posizionamento luci

inammissibile

P(L | H)

L

0,9

sopra

0,1

sotto

Probabilità

//la probabilità condizionata

• Da un punto di vista strettamente Bayesiano esistono solo probabilità

condizionate

• P(A ) -> P(A | H )

• H è l’insieme di ipotesi che ci consentono di esplicitare la conoscenza sul

mondo

Alcune delle ipotesi in H

Oggetti che esistono Oggetti che non esistono

nel mondo osservato

nel mondo osservato

C

P(C | H)

C

0,5

IN

0,5

OUT

Probabilità

//specificare un modello del mondo: struttura

P(I ! C ! L)=P(I, C, L) = P(I | C, L) P(C | L) P(L)

Indipendenza di C da L

L

C

P(C | L) = P(C)

P(I, C, L) = P(I | C, L) P(C ) P(L)

I

questo è il mio modello del mondo

C={IN, OUT}

L={sopra, sotto}

Immagine I ={

,

}

Probabilità

//specificare un modello del mondo

• Il modello del mondo mi semplifica la probabilità del tutto (23 -1 stati)

P(I, C, L)

I

C

L

IN

sopra

IN

sopra

OUT

sopra

OUT

sopra

IN

sotto

IN

sotto

OUT

sotto

OUT

sotto

Probabilità

//specificare un modello del mondo

P(I, C, L) = P(I | C, L) P(C ) P(L)

P(C )

C

P(L )

L

0,5

IN

0,9

sopra

0,1

sotto

0,5 OUT

L

C

P(I |C, L)

I

C

IN

IN

OUT

OUT

IN

IN

OUT

OUT

0

1

1

0

1

0

0

1

I

L

sopra

sopra

sopra

sopra

sotto

sotto

sotto

sotto

Probabilità

//specificare un modello del mondo

P(I, C, L) = P(I | C, L) P(C ) P(L)

P(C )

C

P(L )

L

0,5

IN

0,9

sopra

0,1

sotto

0,5 OUT

L

C

I

Probabilità a priori=

la mia conoscenza del mondo

Probabilità

//specificare un modello del mondo

P(I, C, L) = P(I | C, L) P(C ) P(L)

Verosimiglianza=

la mia osservazione del

mondo

L

C

P(I |C, L)

I

I

C

IN

IN

OUT

OUT

IN

IN

OUT

OUT

0

1

1

0

1

0

0

1

Probabilità

//fare inferenze: la regola di Bayes

• Dalla Regola del prodotto:

• P(A , B) = P(A | B) P(B) = P(B | A) P(A)

poichè P(A ! B) = P(B ! A)

P(A | B) P(B) / P(A) = P(B | A)

B

B

A

A

Probabilità

inversa

L

sopra

sopra

sopra

sopra

sotto

sotto

sotto

sotto

Probabilità

//Indipendenza (marginale)

Indipendenza di C da L

L

C

P(C | L) = P(C)

P(C, L) = P(C| L) P(L)

= P(C) P(L)

C={IN, OUT}

L={sopra, sotto}

Immagine I ={

,

}

Probabilità

//Indipendenza (marginale)

• Eventi mutualmente esclusivi

• P(A , B) =P(A ! B) =0

P(

,

)=0

• Si semplifica la regola della somma:

• P(A " B) = P(A) + P(B) - P(A ! B) = P(A) + P(B)

P(

"

)=P(

• Generalizzata:

• P(A1 " A2 " ... " AN ) = " i=1;..;N P(Ai )

) +P(

)

Probabilità

//Marginalizzazione

• Dalla probabilità congiunta possiamo ottenere la probabilità (marginale) di una

variabile sommando su tutti i possibili valori delle altre variabili

• P(X) = ! Y P(X, Y)

• P(X) = ! Y P(X, Y) = ! Y P(X | Y) P(Y)

Probabilità

//Marginalizzazione

• La marginalizzazione ci consente inferenze:

• Se osservo I=

, qual è la probabilità di P( C = OUT | I =

P( I =

P( C = OUT | I =

)

, C = OUT )

=

P( I =

#!

L

L={sopra, sotto}

)

P( I =

= ! L={sopra, sotto} P( I =

, C = OUT, L )

| C = OUT, L ) P(C ) P(L)

0,5

{

= P(C = 0UT )

0,9

[ P( I =

| C = OUT, L = sopra ) P(L =sopra)

+ P( I =

| C = OUT, L = sotto ) P(L = sotto) ]

{

{

C

)

0

Probabilità

//Problema per l’inferenza Bayesiana

• La marginalizzazione ci consente inferenze:

• Se osservo I=

, qual è la probabilità di P( C = OUT | I =

P( I =

P( C = OUT | I =

)

, C = OUT )

=

P( I =

P( I =

)

= ! C={IN, OUT} ! L={sopra, sotto} P( I =

)

)

Hic sunt

leones !

, C, L)

= [ P( I =

| C = OUT, L = sopra ) P(L =sopra) P( C = OUT)

+ P( I =

| C = OUT, L = sotto ) P(L = sotto) P( C = OUT)

+ P( I =

| C = IN, L = sopra ) P(L =sopra) P( C = IN)

+ P( I =

| C = IN, L = sotto ) P(L = sotto) P( C = IN)]

Probabilità e scienze cognitive

//percezione come inferenza Bayesiana

Modello generativo

X oggetti

(hidden)

insieme di parametri

Y immagine

(visible)

Probabilità e scienze cognitive

//percezione come inferenza Bayesiana

Likelihood

P (X|Y, Θ, M) =

X

Y

Prior

P (Y |X, Θ, M)P (X|Θ, M)

P (Y |Θ, M)

Inferire

Occorrono i

parametri!

variabili nascoste

Θ

Probabilità e scienze cognitive

//percezione come inferenza Bayesiana

P (X|Y, Θ, M) =

P (Y |X, Θ, M)P (X|Θ, M)

P (Y |Θ, M)

X

P (Θ|Y, M) =

Y

Θ

P (Y |Θ, M)P (Θ|M)

P (Y |M)

Inferire

Occorrono

parametri

i modelli!

= Parameter Learning

Probabilità e scienze cognitive

//percezione come inferenza Bayesiana

P (X|Y, Θ, M) =

P (Y |X, Θ, M)P (X|Θ, M)

P (Y |Θ, M)

X

P (Θ|Y, M) =

Y

Θ

P (M|Y ) =

P (Y |Θ, M)P (Θ|M)

P (Y |M)

P (Y |M)P (M)

P (Y )

Inferire modelli = Model selection

Probabilità e scienze cognitive

//percezione come inferenza Bayesiana

P (X|Y, Θ, M) =

X

Y

Hic sunt

leones !

Θ

P (Θ|Y, M) =

P (M|Y ) =

P (Y |X, Θ, M)P (X|Θ, M)

P (Y |Θ, M)

P (Y |Θ, M)P (Θ|M)

P (Y |M)

P (Y |M)P (M)

P (Y )

Probabilità e scienze cognitive

//percezione come inferenza Bayesiana

• Dove non è possibile

inferenza esatta

1.Metodi Monte Carlo

P (X|Y, Θ, M) =

P (Y |X, Θ, M)P (X|Θ, M)

P (Y |Θ, M)

2.Tecniche variazionali:

• Variational Bayes

P (Θ|Y, M) =

• Loopy Belief

propagation

P (M|Y ) =

• Expectation

propagation

P (Y |Θ, M)P (Θ|M)

P (Y |M)

P (Y |M)P (M)

P (Y )

Modelli nelle scienze cognitive e nella percezione

//da Marr a Bayes

Teoria

computazionale

Livelli di

spiegazione

secondo Marr

Rappresentazione e

algoritmo

Implementazione

hardware

Modelli nelle scienze cognitive e nella percezione

//da Marr a Bayes

Qual è il goal della

computazione?

Livelli di

spiegazione

secondo Marr

Quale

rappresentazione e

quale algoritmo?

Come realizzarla

fisicamente?

Modelli nelle scienze cognitive e nella percezione

//da Marr a Bayes

Teoria Bayesiana

Livelli di

spiegazione

(Kersten e Yuille)

Vincoli

e

ipotesi

Implementazione

Modelli nelle scienze cognitive e nella percezione

//da Marr a Bayes

Modelli teorici

Bayesiani:

Modello Grafico +

PDF

Livelli di

spiegazione

(Boccignone e

Cordeschi)

Inferenza su MG

SIMULAZIONE

Modello

implementativo