Corso di Laurea in

Biotecnologie Industriali

A.A. 2002/2003

Cenni storici.

Le radici dell'Artificial Life possono essere rinvenute negli automi cellulari di John Von Neumann e

Arthur W. Burks. Von Neumann cercava un tipo di organizzazione logica sufficiente ad un automa per

riprodurre se stesso, ma non tentò di simulare l'autoriproduzione di un sistema naturale a livello

genetico e biochimico, bensì “voleva astrarre dal problema naturale dell'autoriproduzione la sua

forma logica." (Burks, 1970).

Il formalismo che permise la realizzazione di un tale sistema, fu proposto da Stan Ulam, con il nome di

Automa Cellulare. Un automa cellulare è semplicemente un sistema che può avere un numero finito di

stati ed il cui stato è determinato dallo stato di altri automi che lo circondano. Il comportamento degli

automi cellulari diventa interessante proprio perché formano una rete di interazioni, il cui

comportamento globale, nel tempo, non è prevedibile; anche se le leggi che governano i passaggi di

stato per ogni singolo automa sono semplici e ben determinate. Lo stato di ogni automa di questa rete,

in ogni istante di tempo, è determinato dallo stato posseduto, nell'istante precedente, dagli automi che

lo circondano. Con gli automi cellulari, Von Neumann impostò un sistema capace di autoreplicarsi e

stabilì che, qualunque sistema capace di fare ciò, doveva fare uso delle informazioni contenute nella

sua descrizione in due modi fondamentalmente differenti: sia interpretando, che non interpretando.

Interpretate le informazioni dovevano tradursi in azioni da compiere per realizzare il replicante, non

interpretate dovevano essere soltanto copiate, perché sarebbero state l'analoga descrizione per il

replicante. Quando, in seguito, si scoprì la struttura ed il funzionamento del DNA emerse che erano

proprio i modi in cui la cellula fa uso delle informazioni contenute in esso durante i suoi processi di

trascrizione e traduzione da una parte e replicazione dall'altra.

Fino agli anni ottanta possiamo dire che l'unico filone di ricerca sull'artificial life è stato questo degli

automi cellulari. In seguito si è avuto quell'interesse convergente in questo campo da vari ambiti cui

abbiamo fatto cenno sopra. Proprio per unificare gli sforzi e fare il punto della situazione, nel settembre

del 1987 si è tenuta a Santa Fe la prima conferenza sull'Artificial Life (che è considerata l'atto di

nascita ufficiale di questa nuova scienza), organizzata da Chris Langton del Santa Fe Institute. Ad essa

parteciparono non solo scienziati che, con vari approcci, lavoravano alla costruzione di robot, o

scienziati cognitivi, ma anche filosofi, chimici e biologi. In seguito si è tentato di definire meglio le

competenze dell' Artificial Life e di formalizzarne i confini e gli ambiti. Si sono avute altre conferenze

negli Stati Uniti ed in Europa, oltre a sempre più frequenti pubblicazioni.

Oggi possiamo distinguere due grossi filoni che si intrecciano tra loro: quello della robotica e quello

delle simulazioni.

Un altro tipo di distinzione che si può fare, che è in realtà molto più profonda e destinata ad

approfondirsi, è tra gli approcci che potremmo definire top-down, quali quelli della tradizione cognitiva

o dell'Intelligenza Artificiale, e quelli bottom-up nel quale troviamo connessionismo (in particolare il

filone degli agenti situati) e automi cellulari. Per quanto riguarda l'apprendimento, possiamo

distinguere un apprendimento genetico ed uno individuale, proprio come negli esseri viventi reali. In

genere oggi si tende ad utilizzare o l'uno o l'altro, ma con un uso integrato di entrambe le forme di

apprendimento si potrà fare, tra l'altro, ulteriore chiarezza su una questione antropologicamente molto

rilevante: quanta parte del comportamento di un organismo è attribuibile al suo patrimonio genetico e

quanto all'apprendimento nella sua vita. La questione ormai ha raggiunto un sufficiente grado di

chiarezza con il riconoscimento del contributo integrato di entrambe le componenti, ma si ripropone

ogni volta la proporzione e, soprattutto, la natura delle predisposizioni genetiche quando si parla di

comportamenti o di attività mentali.

Nelle simulazioni che si fanno in questo campo, si utilizzano in genere alternativamente strategie che

possiamo considerare ispirate all'apprendimento in vita (tramite backpropagation principalmente, ma

anche con l'apprendimento competitivo, con la regola di Hopfield, o comunque apprendimenti basati

2

sulla modifica dei valori delle connessioni tra neuroni); oppure all'apprendimento su base genetica, che

si compie di generazione in generazione (algoritmi genetici).

Ultimamente si sta diffondendo enormemente soprattutto l'uso di questa ultima strategia. Ciò è logico,

se si considera, al di là di un'analisi più circostanziata, che, in questa fase iniziale, potrebbe essere una

buona strategia, quella di lasciare sviluppare le specie più adatte ai vari scopi che si propongono i

diversi ricercatori. E' comunque auspicabile che si arrivi presto all'utilizzo complementare di ambedue

la strategie.

Gli algoritmi genetici consistono fondamentalmente in varie tecniche, che portano alla selezione degli

algoritmi che danno (in base ad un determinato criterio) i risultati migliori ed alla ricombinazione

casuale di alcune loro porzioni e/o alla mutazione di alcune loro parti.

In genere si parte con una certa popolazione di automi che hanno leggere differenze tra loro e si fanno

agire in un ambiente per un certo numero di cicli. In seguito quelli che si saranno comportati meglio

avranno la possibilità di riprodursi. Cioè si prenderà, ad esempio, il venti per cento della popolazione

che si è comportato nel modo migliore e da questi, con mutazioni casuali e ricombinazioni, si otterrà

anche il restante ottanta per cento di automi; con questa nuova popolazione si farà un altra sessione di

cicli, al termine dei quali, si ripeterà lo stesso procedimento. All'interno di questo schema generale, le

effettive realizzazioni degli algoritmi possono essere molto diverse: da programmi in vari linguaggi, a

valori di connessioni di reti neurali.

L'apprendimento ontogenetico, invece, può utilizzare varie strategie per la modifica delle connessioni,

sia con un supervisore sia senza. Negli apprendimenti supervisionati, lo sperimentatore (o una memoria

di tipo statico), in caso di risposta diversa da quella ritenuta più opportuna, fornisce la risposta

desiderata, mentre nelle strategie di apprendimento non supervisionato, è la rete stessa che propone le

risposte e modifica le connessioni.

Anche se abbiamo diversi tipi di reti che possono apprendere, quelle che effettivamente si sono rivelate

adatte, a far apprendere ad un automa senza supervisore un certo compito, sono quelle basate sulla

backpropagation e sull'apprendimento competitivo.

Bisogna considerare che, in questi primi tentativi di realizzare automi in grado di modificare il proprio

comportamento in modo da ottimizzare un certo risultato, l'importanza che hanno i metodi di

apprendimento effettivamente utilizzati è molto relativa. Infatti possiamo ottenere risultati piuttosto

simili, sia utilizzando una strategia "filogenetica", come gli algoritmi genetici, che una "ontogenetica",

come la modifica delle connessioni in base al risultato delle azioni. Quello che effettivamente si sta

sperimentando, non sono tanto queste teorie "parziali" dall'apprendimento, quanto proprio la strategia

globale di organizzazione del proprio comportamento da parte di questi sistemi.

Queste limitazioni vengono però superate se si aggiunge almeno un altro strato tra quello di ingresso e

quello di uscita. Una rete a tre o più strati può classificare in qualunque modo si voglia. Una regola per

la modifica dei coefficienti di connessione, in questi casi in cui gli strati sono più di due, è stata

proposta nel 1986 da Rumelhart, Hinton e Williams. La regola è la celeberrima error backpropagation,

consistente, appunto, nella propagazione dell'errore a ritroso. Vengono prima modificati i coefficienti

delle connessioni tra il penultimo e l'ultimo strato e poi si risale, di strato in strato, fino a modificare

quelli delle connessioni tra il primo ed il secondo strato. Data la possibilità di far apprendere ad una

rete a tre o più strati qualunque tipo di associazione, o criterio di categorizzazione, oggi reti di questo

tipo sono molto usate nei campi più disparati.

Un difetto di queste reti è l'enorme mole di calcoli che devono essere fatti, in fase di apprendimento,

dopo la presentazione di ogni stimolo, prima che la rete converga verso un valore dei coefficienti

relativamente definitivo. Tra l'altro non è detto che questi valori siano i migliori possibili in assoluto,

potrebbe trattarsi, infatti, di un minimo locale. In altre parole la regola della backpropagation è fatta in

modo da far diminuire, dopo ogni iterazione, la differenza che, a livello di connessioni, si ha tra l'uscita

prodotta e quella voluta; ma ciò non garantisce che si ottengano i valori migliori in assoluto. Questo

3

progressivo approssimarsi a dei valori delle connessioni che ottimizzano l'errore, potrebbero portare a

delle connessioni che non danno il migliore "compromesso" possibile in modo da ottenere, in tutti i

casi memorizzati fino a quel momento, la migliore combinazione possibile di risposte.

Questo pericolo è particolarmente concreto nel caso di utilizzo di queste reti nel modo più naturale,

detto "on line", cioè quando le modifiche alle connessioni sono apportate dopo ogni iterazione. L'altro

metodo (batch) prevede, invece, il solo calcolo delle variazioni dei coefficienti, finché non è stato

presentato l'intero set di rappresentazioni che la rete deve apprendere, è solo a questo punto che le

connessioni vengono effettivamente modificate. Il metodo batch, oltre a non poter essere proposto

come modello dell'apprendimento umano, (infatti la variazione delle connessioni, o qualunque altro

processo sia alla base dell'apprendimento umano, si verifica dopo la presentazione di ogni elemento di

una sequenza da classificare) è anche più lento, ma ha il vantaggio di essere meno soggetto al pericolo

di incorrere in minimi locali ed è quindi preferito nelle applicazioni pratiche che lo permettono.

Sono state proposte anche delle modifiche alla regola di Rumelhart, Hinton e Williams che permettono

una convergenza più veloce, con un minor numero di iterazioni, come la quickpropagation, ma non è

ancora stato risolto il problema dell'evitamento dei minimi locali.

Con i progressi fatti in questo ambito, si sono moltiplicate anche le utilizzazioni pratiche delle reti (in

particolare proprio della backpropagation). Esse si utilizzano oggi nell'interpretazione di segnali radar e

sonar, nel riconoscimento della voce, nel riconoscimento della scrittura naturale, nella visione

artificiale, nella robotica, per risolvere vari problemi di ottimizzazione.

Vi sono anche altre soluzioni, al problema di modificare le connessioni di reti multistrato in modo tale

che si abbia apprendimento. Tali reti utilizzano vari tipi di apprendimento competitivo ed hanno

appunto in comune il fatto di "aumentare i valori dei coefficienti di connessione eccitatori associati alle

linee che, dallo strato immediatamente inferiore, inviano segnali alle unità che hanno vinto la

competizione" (Pessa, 1993; pag.195). Queste reti hanno connessioni eccitatorie con le unità dello

strato superiore e connessioni di tipo inibitorio tra unità che appartengono allo stesso strato.

Le più utilizzate realizzazioni di questo principio, prevedono uno dei seguenti criteri per la

propagazione del segnale:

1) La strategia con più vincitori. Si fa una media delle somme pesate degli ingressi ad ogni neurone ed

emettono un'uscita solo quelle che in cui essa è superiore alla media.

2) La strategia Winner Takes All. In questo caso emette un'uscita solo l'unità che ha la più alta somma

pesata degli ingressi.

3) Le strategie a bolla. In queste si immaginano i neuroni disposti su una griglia, in modo tale che ci

siano vicinanze e distanze tra i vari elementi. Le unità che si considerano vincenti sono tutte quelle che

si trovano in un opportuno intorno spaziale di quella che ha ottenuto la più alta somma pesata degli

ingressi. La prima è stata proposta da Kohonen, ma in seguito egli stesso ed altri ne hanno proposte

molte diverse versioni.

In seguito vengono modificati i coefficienti delle unità vincitrici o, in alcuni casi, anche di quelle che

non hanno vinto la competizione.

Parallelamente a queste linee di ricerca, lo studio delle possibilità delle reti neurali, si è sviluppato in

altre direzioni. Oltre a reti a strati, in cui uno strato ha funzioni di input ed un altro di output, ce ne sono

molti altri tipi composti da un solo strato ed altri aventi architetture più complesse.

4

Reti di Caianello

Ritornando alle prime reti che sono state proposte (McCulloch e Pitts), esse sono state generalizzate nel

1961 da Caianello, il quale ha proposto delle equazioni in cui lo stato di attivazione di ogni neurone

non dipende solo da quello di tutti gli altri nell'istante precedente (il tempo anche in queste reti è

discreto), ma dipende anche dallo stato di attivazione che si è avuto negli istanti precedenti. Questa

modifica permette di catturare maggiormente la realtà del funzionamento neuronico, sappiamo infatti

che i neuroni reali rispondono non solo in conseguenza della stimolazione che ricevono in un dato

istante, ma anche dipendentemente da quelli precedenti, variando le disponibilità dei diversi

neurotrasmettitori in conseguenza della frequenza di risposta. In realtà con questa modifica non si è

preteso di riprodurre tutta la ricchezza di possibilità che sta dietro la scarica di un neurone reale, ma ci

si è spostati comunque in direzione di quella maggiore complessità.

Più importante, dal punto di vista teorico, gli studi di Caianello hanno permesso di trovare un algoritmo

che permette di risolvere (almeno in linea di principio, data la grande mole di calcoli necessaria in caso

di reti composte da moltissimi neuroni) le equazioni che governano lo sviluppo di una rete di questo

tipo, in maniera da poter sempre sapere in partenza come si evolverà una data rete (quali sono i suoi

punti di equilibrio ed il suo ciclo) ed anche progettare una rete che abbia le caratteristiche dinamiche

desiderate.

Oggi sono disponibili molti tipi di reti, adatte a vari scopi, con caratteristiche molto differenti,

sviluppatesi nel tentativo di superare alcune delle limitazioni delle reti.

Il problema più importante che si ha con le reti neurali e quello dell'«interferenza catastrofica». Cioè il

problema dato dal fatto che, una rete addestrata ad un certo set di stimoli, se viene poi addestrata a

rispondere ad un altro set di stimoli, può non rispondere più adeguatamente al set di stimoli a cui era

addestrata precedentemente. Questi effetti negativi possono essere in parte limitati agendo sulla

plasticità della rete. Così, se si desidera che la rete mantenga comunque l'apprendimento di un primo

gruppo di elementi, si può rendere meno plastica, meno soggetta a modificarsi ulteriormente per effetto

degli stimoli successivi. D'altra parte ciò comporta una ridotta capacità di adattarsi e, nei casi in cui ciò

è importante, si può rendere comunque più plastica considerando più importanti le ultime cose via via

apprese.

Un importante tentativo di superare questo problema sono le reti ART (adaptive resonance teory)

sviluppate da Grossberg. Esse sono in grado di mantenere la flessibilità che permette di apprendere

nuove classificazioni e, nello stesso tempo, di non perdere le classificazioni fatte in precedenza. Questo

è ottenuto con un procedimento che prende a modello ciò che effettivamente avviene nel

riconoscimento effettuato da soggetti umani. Infatti lo stimolo proposto non dà il via ad un passivo

convergere verso una risposta, ma alla proposta di un'ipotesi basata su le classificazioni effettuate in

precedenza. A questo punto, se si ha una convergenza soddisfacente tra l'ipotesi e lo stimolo reale,

questo viene classificato nel modo previsto, altrimenti si crea una nuova categoria.

Illustrare tutti i tipi di reti oggi esistenti sarebbe molto lungo ed esulerebbe dagli scopi di questa

illustrazione sommaria delle possibilità delle reti. Più importante può essere, invece, un confronto tra le

possibilità e le limitazioni delle reti rispetto alle possibilità offerte dal paradigma dell'intelligenza

artificiale tradizionale.

L'interesse attuale per le reti ed il crescere di importanza del paradigma connessionistico, sono dati non

solo e non tanto dalle migliori prestazioni delle reti attuali rispetto a quelle di qualche anno fa, ma

soprattutto dalla necessità di trovare nuove strade per risolvere le due limitazioni più grandi mostrate

dall'approccio simbolico: la scarsi flessibilità di fondo; e la separazione irriducibile tra il livello astratto

e quello "reale". Questi problemi hanno fatto si che fosse molto difficile riprodurre molte capacità

umane di base all'apparenza elementari come la percezione, la capacità di sorvolare su alcune

5

imprecisioni nello stimolo, la capacità di apprendere dalla realtà, o quella di comprendere il linguaggio

naturale. Nel paradigma simbolico tutto deve essere previsto in anticipo, una situazione leggermente

diversa da quella conosciuta è, a tutti gli effetti, una situazione nuova. Sono stati ottenuti dei risultati

notevoli, soprattutto con i sistemi esperti, ma un piccolo errore di inferenza, una deduzione, può falsare

completamente la soluzione di un problema e per ottenere questi risultati, è stato necessario prevedere

il maggior numero possibile di possibilità e sfumature.

Le reti neurali presentano proprio queste caratteristiche di flessibilità e di auto adattamento. Sono in

grado di richiamare o riconoscere delle informazioni anche se queste sono degradate, oppure in

presenza di rumore. Inoltre non è necessario fornirle di una base dati di partenza perché svolgano un

dato compito, sono invece in grado di apprendere autonomamente dai propri errori, o comunque

dall'ambiente e di generalizzare questi apprendimenti. D'altra parte l'apprendimento, che sostituisce la

programmazione e la creazione di una base dati, oltre ad essere molto lungo e laborioso, necessita di

molti esempi che devono essere forniti in modo efficace. Inoltre la capacità di ricostruire stimoli

parziali, ha come rovescio della medaglia la scarsa precisione e accuratezza; in alcuni campi, come

nella contabilità, è importante che il dato sia riprodotto con precisione e non "approssimato". Un altro

difetto che possiamo individuare, è dato dal fatto che rimane oscuro ciò che effettivamente è avvenuto

all'interno della rete come è giunta ad una determinata risposta e come potrebbe essere modificata per

migliorarne un determinato aspetto.

6

Reti Neurali in Generale

Bisogna distinguere due motivazioni diverse nello studiare Reti Neurali Artificiali:

1. riprodurre (e quindi comprendere) il cervello umano, il che comprende :

modellare tutto o almeno parti del cervello umano in modo affidabile

riprodurre fedelmente fenomeni neurofisiologici

verificare sperimentalmente se il modello proposto riproduce i dati biologici

2. estrarre i principi fondamentali di calcolo utilizzati dal cervello

evincere quali sono i principi fondamentali di calcolo che il cervello umano utilizza

semplificazioni ed astrazioni del cervello umano sono permesse, anzi, sono lo

strumento principale di lavoro

produrre un sistema artificiale che sia eventualmente diverso dal cervello umano ma

che riproduca alcune delle sue funzioni, magari in modo pi `u veloce ed efficiente

(metafora del volo: aereo “contro” uccello)

I modelli di Reti Neurali Artificiali proposti nel secondo caso sono molteplici e con scopi diversi. Ad

esempio, esistono modelli per:

l’apprendimento supervisionato (Classificazione, Regressione, Serie Temporali, ...);

l’apprendimento non supervisionato (Clustering, Data Mining, Self-Organization maps,...);

realizzare Memorie Associative;

_

Tali modelli, in generale, differiscono per:

topologia della rete

funzione calcolata dal singolo neurone

algoritmo di apprendimento

modalità di apprendimento (utilizzo dei dati di apprendimento)

_

_

_

Le Reti Neurali Artificiali si ispirano al cervello umano; Il cervello umano è costituito da circa 1010

neuroni fortemente interconnessi fra loro; ogni neurone possiede un numero di connessioni che va da

circa 104 a circa 105 ed il tempo di risposta di un neurone è circa 0.001 secondi; Considerando che per

riconoscere il contenuto di una scena un umano impiega circa 0.1 secondi, ne consegue che il cervello

umano sfrutta pesantemente il calcolo parallelo: infatti, in questo caso, non può effettuare più di 100

calcoli seriali [0.1/0.001=100].

7

Il Neurone Biologico

Il modello a cui ci si è ispirati per poter sviluppare gli attuali sistemi basati su reti neurali è il neurone

biologico. Il segnale (input) arriva alla cellula grazie ai dendriti che si innervano nel soma.

L’informazione decodificata dalla cellula è determinata dalla somma degli n input trasmessi dai singoli

dendriti.

La cellula così eccitata trasferirà lo stimolo attraverso l’assone, permettendo la trasmissione

dell’impulso alle cellule effettrici (Output).

8

Il sistema effettore viene attivato grazie al rilascio da parte del terminale pre-sinaptico di molecole

neuro-trasmettitrici, la cui quantità e durata del rilascio è determinata dalle caratteristiche dello stimolo

proveniente dal neurone.

9

Gli impulsi elettrici propri dei neuroni sono segnali stereotipati, caratterizzati da una soglia oltre la

quale si scatena il potenziale d’azione. Questo tipo di segnalazione si ritrova nel percettrone, in cui il

segnale di attivazione del neurone artificiale è costituito da una funzione “a gradino” caratterizzato da

un segnale di output binario.

Rete Neurale Biologica

Come nella rete neurale biologica la forza delle giunzioni sinaptiche determina l’intensità del segnale

effettore, così nelle reti neurali artificiali i pesi tra le connessioni influenzano il segnale di output.

10

Il Neurone Artificiale

L’ingresso di un input in un neurone artificiale darà luogo ad un valore di eccitazione dato dalla somma

pesata degli ingressi (x1, x2, x3,…,xn) con i pesi (w1, w2, w3,….,wn). I valori di uscita vengono valutati

in base ad un valore di soglia. Il tipo di risposta di ciascun neurone può essere diverso da rete a rete;

tale tipo di risposta è regolato dalla “funzione di attivazione”.

nel primo caso si ha una funzione di attivazione “a gradino”, cioè una funzione discontinua tipica di un

sistema Crisp.Questa funzione permette la discriminazione lineare dei dati di ingresso in due classi.

Questo tipo di funzioni però limita l’output a fornire solo un bit in uscita (acceso/spento) e non è quindi

adatto nel risolvere problemi di una certa complessità: i neuroni necessari alla rete sarebbero troppi. Il

secondo caso è caratterizzato da una sigmoide, funzione di attivazione continua utilizzata nei sistemi

Fuzzy e permette la discriminazione non-lineare dei dati di ingresso.

Reti Neurali Artificiali

Una Rete Neurale Artificiale è un sistema costituito da unità interconnesse che calcolano funzioni

(numeriche) non-lineari:

le unità di input rappresentano le variabili di ingresso; le unità di output rappresentano le

variabili di uscita;

le unità nascoste (se ve ne sono) rappresentano variabili interne che codificano (dopo

l’apprendimento) le correlazioni tra le variabili di input relativamente al valore di output che si

vuole generare.

Sulle connessioni fra unità sono definiti pesi adattabili (dall’algoritmo di apprendimento).

11

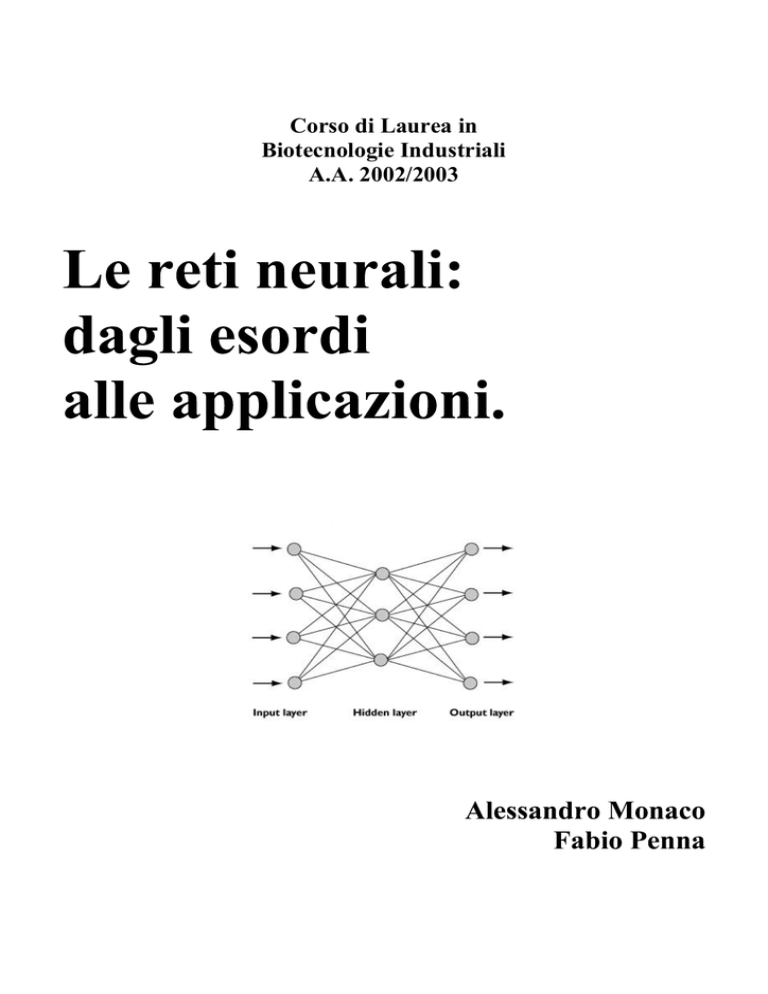

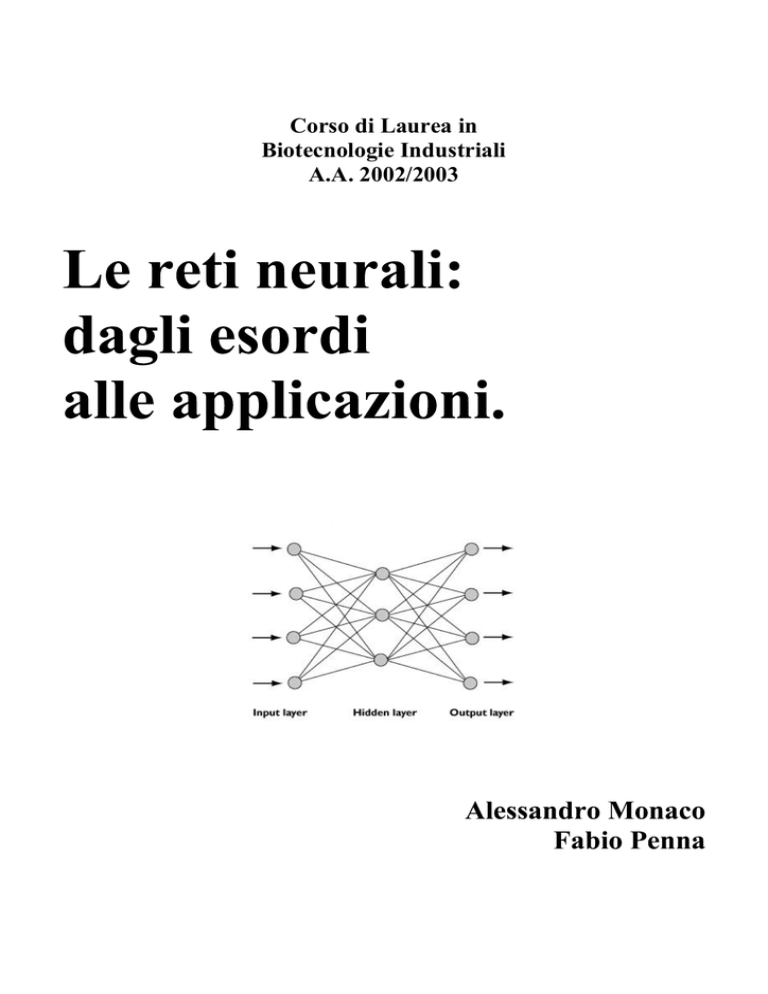

Reti Neurali Feed-forward (un solo livello nascosto)

Questo tipo di reti sono in grado di svolgere funzioni complesse, quali il riconoscimento di forme

qualsiasi e la estrapolazione di correlazioni tra insiemi di dati apparentemente casuali. Le reti neurali

feed forward sono unidirezionali nel senso che i segnali si propagano solamente dall'input verso

l'output senza retroazioni, i neuroni possono assumere valori reali (compresi tra 0.0 e 1.0) e non più

valori booleani 0 e1 per cui la flessibilità della rete risulta nettamente migliorata nella applicabilità a

problemi reali. Ogni neurone di ogni strato sarà collegato ad ogni neurone dello strato successivo,

mentre non vi saranno collegamenti tra i neuroni dello stesso strato.

Quella nella figura è la configurazione più semplice di rete multistrato, dotata di un solo strato

intermedio normalmente chiamato "hidden layer": gli strati decisionali di tale rete sono lo strato

intermedio e lo strato di output. lo strato di neuroni di input non ha potere decisionale poichè ciò che

una rete neurale impara sta proprio nel valore dei pesi che collegano i neuroni opportunamente

modificato in base ad una legge di apprendimento su un set di esempi; pertanto lo strato di input non è

uno strato decisionale perche non ha pesi modificabili in fase di apprendimento sui suoi ingressi.

Back Propagation

Il metodo di Back-propagation è applicabile a qualsiasi rete multistrato, con un numero qualunque di

connessioni ed è facilmente utilizzabile su reti con strutture molto disparate.

La peculiarità di questo meccanismo sta nel metodo con cui la rete reagisce ogni volta che effettua un

errore: tali errori vengono infatti propagati da ogni strato attraverso le connessioni sinaptiche e sommati

per ciascuna unità da cui ricevono segnale.

Grazie a questo metodo la rete è molto efficace nel raggiungimento di risultati validi ed a generalizzare

le soluzioni per esempi che non gli sono stati presentati durante l’addestramento.

Lo scopo della rete è naturalmente quello di minimizzare la differenza tra la risposta desiderata e quella

fornita dalla rete stessa. Per fare in modo che la rete si migliori, i parametri vengono fatti variare lungo

la superficie dell’errore verso la direzione di massima pendenza negativa, applicando cioè quello che è

definito come metodo di discesa del gradiente; L’errore è, in altre parole, propagato all’indietro da uno

strato a quello precedente.

12

Questa metodica contrappone ad una serie di vantaggi, alcuni problemi nell’applicare tale metodo agli

esperimenti. Il primo è dovuto all’attivazione non lineare dei nodi che provoca un andamento assai

complicato della funzione di errore: la superficie presenta un grande numero di minimi locali in cui la

rete può restare "intrappolata" ed una serie di superfici piatte che rallentano l’apprendimento. Il

secondo problema riguarda invece la lentezza di tale algoritmo che può richiedere alcuni giorni per un

singolo allenamento.

Attualmente, vi sono numerosi metodi si apprendimento per le RN. Nessuno può dire esattamente

quanti siano in tutto. Ogni settimana ne escono fuori di nuovi (o quanto meno come varianti di metodi

già esistenti).

Nelle righe che seguono vi è una raccolta dei metodi maggiormente conosciuti, senza alcuna pretesa di

completezza.

La principale classificazione di questi metodi si rifà alla distinzione tra apprendimento supervisionato e

non supervisionato:

Nell'apprendimento supervisionato, vi è un "insegnante" che nella fase di apprendimento "dice"

alla rete quanto bene sta funzionando ("apprendimento rinforzato") o quale sarebbe dovuto

essere il comportamento corretto ("apprendimento totalmente supervisionato").

Nell'apprendimento non supervisionato, la rete è autonoma: non appena i dati vengono

esaminati,la rete cerca alcune delle proprietà del set di dati e impara a riferirle ai suoi output.

Quali esattamente queste proprietà siano, che la RN possa apprendere a riconoscere, dipende

dal

particolare

modello

di

rete

e

dal

metodo

di

apprendimento.

Molti di questi metodi di apprendimento sono strettamente connessi a una topologia di rete.

Appartenenti a quest’ultimo tipo sono le SOM (self organizing maps) di Kohonen che di cui vedremo

una applicazione.

Tipi di reti neurali

Esistono molti tipi di reti neurali che sono differenziati sulla base di alcune caratteristiche

fondamentali:

• tipo di utilizzo

• algoritmo di apprendimento

• architettura dei collegamenti

• tipo di apprendimento :supervisionato/non supervisionato

Quest’ultima è la divisione fondamentale: nel primo caso si addestra la rete con degli esempi che

contengono un input e l 'output associato desiderato, mentre nel secondo caso la rete deve essere in

grado di estrarre delle informazioni di similitudine tra i dati forniti in input (senza associazioni con

output desiderati) al fine di classificarli in categorie.

13

Tipo di utilizzo

Dal punto di vista del tipo di utilizzo possiamo distinguere tre categorie basilari:

• Memorie associative

possono apprendere associazioni tra patterns (insieme complesso di dati come un insieme dei pixels di

una immagine) in modo che la presentazione di un pattern A dia come output il pattern B anche se il

pattern A è impreciso o parziale(resistenza al rumore).

Esiste anche la possibilità di utilizzare la memoria associativa per fornire in uscita il pattern completo

in risposta ad un pattern parziale in input.

• Simulatori di funzioni matematiche complesse(e non conosciute)

sono in grado di comprendere la funzione che lega output con input in base a degli esempi forniti in

fase di apprendimento. Dopo la fase di apprendimento, la rete è in grado di fornire un output in risposta

ad un input anche diverso da quelli usati negli esempi di addestramento. Ne consegue una capacità

della rete di interpolazione ed estrapolazione sui dati del training set.

Tale capacità è facilmente verificabile addestrando una rete con una sequenza di dati input/output

proveniente da una funzione nota e risulta, invece, utile proprio per il trattamento e la previsione di

fenomeni di cui non sia chiaro matematicamente il legame tra input e output.In ogni caso la rete si

comporta come una "black box", poiché non svela in termini leggibili la funzione di trasferimento che

è contenuta al suo interno. Di questo tipo fa parte la rete a retropropagazione dell’ errore o error back

propagation che è quella attualmente più utilizzata per efficacia e flessibilità.

• Classificatori

con essi è possibile classificare dei dati in specifiche categorie in base a caratteristiche di

similitudine.

In questo ultimo tipo di rete esiste il concetto di apprendimento non supervisionato o

"autoorganizzante", nel quale i dati di input vengono distribuiti su categorie non predefinite .

Reti neurali autoorganizzanti

Un tipico problema è quello di cercare classi di dati aventi caratteristiche similari(per cui associabili)

all’ interno di un gruppo disordinato di

dati. Questo problema può essere

affrontato con una rete neurale

autoorganizzante, cioè in grado di

interagire con i dati, addestrando se stessa

senza un supervisore che fornisca

soluzioni in punti specifici nello spazio

delle variabili.

Si parla in questo caso di apprendimento

"non supervisionato“

Il

principale

utilizzo

delle

reti

autoorganizzanti è precisamente quello di

analisi di dati al fine di riscontrarne gruppi

aventi similitudini (preprocessing di dati) o classificazione di forme come riconoscimento immagini o

segnali.

14

Rete di Kohonen

E’ costituita da due strati:

• Input

• Output o strato di Kohonen: i neuroni sono connessi, ciascuno,con un "vicinato " di neuroni

secondo un sistema di inibizione laterale definito a "cappello messicano".

I neuroni dei due strati sono completamente connessi tra loro. I pesi dei collegamenti intrastrato dello

strato di output o strato di Kohonen non sono soggetti ad apprendimento ma sono fissi e positivi nella

periferia adiacente ad ogni neurone.

Nello strato di output un solo neurone che risulta "vincente" (con il massimo valore di attivazione) per

ogni input pattern che viene fornito alla rete.

In pratica il neurone vincente

identifica una classe a cui l'input

appartiene. Il collegamento a

cappello messicano, nella versione

originale di questo tipo di rete,

tende a favorire il formarsi di

"bolle

di

attivazione"

che

identificano inputs simili. Lo scopo

di una rete di Kohonen è quello di

avere, per inputs simili, neuroni

vincenti vicini, così che ogni bolla

di attivazione rappresenta una

classe

di

inputs

aventi

caratteristiche somiglianti.

Il comportamento sopra descritto si

15

raggiunge dopo la presentazione di molti inputs per

un certo numero di volte alla rete, modificando, per

ogni presentazione di input solo i pesi che collegano

il neurone vincente(Kohonen layer) con i neuroni

dello

strato

di

input

(apprendimento

autoorganizzante).

Quando viene impiegata una rete autoorganizzante,

la matrice di neuroni(detti anche “neurodi”, da

neurone e nodo) di output si presenta con un

insieme di bolle di attivazione che corrispondono

alle classi in cui la rete ha suddiviso gli inputs per

similitudine.

Se noi addestriamo una rete con dati di cui

conosciamo a priori la appartenenza a specifiche

classi, potremo associare ciascuna delle bolle di

attivazione a ognuna di queste classi.

Più bolle di attivazione possono rappresentare una

classe di inputs

Le Reti Neurali Artificiali sono studiate sotto molti punti di vista. In particolare, contributi alla ricerca

in questo campo provengono da:

_

Biologia (Neurofisiologia)

Informatica (Intelligenza Artificiale)

Matematica (Ottimizzazione, Proprietà di approssimazione)

Statistica (Regressione, Classificazione)

Ingegneria (Pattern Classification, Teoria del Controllo)

Economia (Studio di serie temporali)

Fisica (Sistemi Dinamici)

Psicologia (Apprendimento e Scienze Cognitive)

_

Applicazioni già attivate

- Previsione del passaggio ad HIV conclamato

- Eliminazione dinamica dei disturbi nelle telecomunicazioni (GSM...)

- Valutazione del rischio nelle ipoteche

- Individuazione bombe al plastico

- Controllo di qualità nella produzione di lampadine

- Riconoscimento di vocaboli

- Previsione di problemi ai motori delle auto

- Comprensione e classificazione dei risultati nella ricerca scientifica

- Classificazione di segnali sonar

- Previsione della vulnerabilità all'eroina

- Identificazione ed inseguimento di oggetti mobili

- Compressione di immagini e di dati

16

- Riconoscimento di caratteri scritti a mano

- Validazione di firme

- Controllo di qualità nei processi di automazione industriale

- Reti neurali per la ricostruzione e la classificazione di immagini tattili

- Predizione delle proprietà dei filati nella tecnologia dei processi chimici.

- Riconoscimento di giacimenti di gas sfruttabili

- Modelli delle dinamiche di mercato nei settori dei prodotti alimentari, di consumo e finanziari.

- Predizione delle vendite dei giornali

- Qualificazione dei dispositivi anti shock nelle automobili

- Diagnosi sui punti di saldatura

- Progettazione automatica di apparecchiature per la produzione di contenitori

- Rilevamento di frode nelle transazione tramite carta di credito

- Gestione dell'approvvigionamento di acqua potabile

- Riconoscimento testi nelle domande di assunzione, negli ordini di vendita, nei questionari per la

sicurezza sociale

- Predizione delle vendite nei supermercati

- Sistema do controllo automatico della qualità nella produzione di tegole

- Controllo della qualità ed incremento dell'efficienza nei progetti medici

- Ottimizzazione degli impianti per la polimerizzazione

- Classificazione dei difetti nei metanodotti

- Nuova metodica per la predizione assistita al computer delle metastasi linfonodali nel carcinoma

gastrico

- Selezione e classificazione materiali specifici

- Ottimizzazione della regolazione di essiccatoi

- Applicazione delle reti neurali per la valutazione dello stato di reattività dei fermenti produttori di

penicillina

- Sostituzione degli analizzatori nelle colonne di distillazione

- Puntamento ottico nella produzione industriale

- Previsioni del tempo a breve termine

- Monitoraggio di dighe

- Controllo di accesso utilizzando il riconoscimento automatico del viso

- Controllo di fornaci

- Analisi dei dati di volo di elicotteri

Applicazioni in fase di attivazione

Generali

- Valutazione probabilistica della presenza di petrolio in formazioni geologiche

- Identificazione dei canditati per una qualifica specifica all'interno di una ditta

- Minimizzazione di database in imprese

- Miglioramento del rapporto posti/prezzo per i biglietti aerei

- Valutazione dei premi assicurativi

- Selezione di team specializzati

- Modelli di simulazione di sviluppo urbano

- Previsioni sulla mobilità lavorativa

- Previsioni del tempo

- Previsioni sul grado di inquinamento

17

- Analisi dei movimenti migratori

Biologia

- Funzionamento di un cervello danneggiato

- Modelli di funzionamento della retina e della coclea

- Studi sul DNA (identificazione dei siti che codificano per l'insulina ...)

- Simulazione di nuove molecole (affinità recettoriali..)

. Finanza

- Analisi del rischio nei crediti

- Identificazione delle perdite

- Lettura e validazione di schede compilate a mano

- Analisi dei tassi di investimento e del portfolio

- Previsione e simulazione degli scenari del cambio monetario

- Previsioni su titoli ed obbligazioni

- Simulazione di scenari economici

- Analisi della evasione e della elusione fiscale

Manifattura

- Automazione in robotica e sistemi di controllo multiparametrici

- Controllo dei processi di produzione

- Supervisione nel controllo di qualità

- Selezione di parti per linee di montaggio

Campo sanitario e sociale

- Analisi del linguaggio nel trattamento della sordità grave

- Diagnosi e prescrizione di trattamenti partendo da sintomi

- Monitorizzazione di interventi chirurgici

- Previsione di effetti collaterali di alcuni farmaci in determinati soggetti

- Interpretazione radiografie

- Comprensione delle cause dei fenomeni epilettici

- Previsione della vulnerabilità alla schizofrenia

- Previsione della mancata frequenza scolastica

. Sicurezza e campo militare

- Analisi dei dati durante conflitti, battaglie e/o rivolte

- Classificazione dei segnali radar

- Creazione di arme intelligenti

- Riconoscimento di azioni

- Miglioramento delle risorse carenti

- Identificazione ed ancoraggio di oggetti mobili

- Identificazione di denaro riciclato nel riciclo di società

- Simulazione di operazioni ad alto rischio

- Analisi di attentati terroristici

- Interrogazione intelligente di grossi database

- Analisi delle testimonianze

- Strategie di investigazione

Campo giuridico

18

- Valutazione dell'evidenza

- Valutazione delle sospensioni delle concessioni edilizie

- Miglioramento delle strategie di instruzione dei processi

19

1) Una applicazione allo studio delle strutture proteiche

La predizione delle strutture proteiche

- Il problema:

Le proteine costituiscono la componente di gran lunga preponderante fra le macromolecole costituenti

le cellule. Questo sia dal punto di vista ponderale che in considerazione dell'importanza e varietà delle

funzioni svolte. Capire in che modo tali funzioni siano legate alla struttura molecolare costituisce uno

degli argomenti centrali dell'odierna ricerca in Biologia Molecolare, Biochimica e Biofisica [Branden

and Tooze, 1992].

Le proteine sono polimeri lineari formati da centinaia di unità elementari, gli aminoacidi, caratterizzati

da una estremità carbossilica (acida) ed una amminica (basica) ed esistenti in natura in 20 diverse

varietà (Finestra 3.3). Lo studio della organizzazione strutturale delle proteine avviene a 4 diversi livelli

:

- Struttura Primaria: corrisponde alla sequenza degli aminoacidi e alla posizione dei legami disolfuro,

quando ve ne sono, e riflette quindi l’insieme dei legami covalenti di una proteina.

- Struttura Secondaria: si riferisce alla disposizione nello spazio dei residui di aminoacidi adiacenti

nella sequenza lineare. Alcune di queste relazioni steriche sono di tipo regolare e danno origine a

strutture periodiche: l’ α-elica e la struttura β sono elementi di struttura secondaria. Quando le relazioni

non sono di tipo regolare, esse si dicono random-coil.

- Struttura Terziaria: riguarda la disposizione nello spazio dei residui di aminoacidi lontani fra loro

nella sequenza lineare. La linea di divisione fra struttura secondaria e terziaria non è netta.

- Struttura Quaternaria: le proteine che contengono più di una catena polipeptidica hanno un ulteriore

livello di organizzazione strutturale: ciascuna catena polipeptidica viene chiamata subunità e la

struttura quaternaria si riferisce alla disposizione nello spazio di queste subunità.

Predire l'arrangiamento tridimensionale delle proteine, cioé le loro strutture secondaria e terziaria, dalla

sequenza lineare degli aminoacidi componenti (struttura primaria), è diventato un argomento di grande

attualità da quando le tecniche di biologia molecolare (DNA ricombinante) consentono di accumulare

informazione sulle strutture primarie ad una velocità molto maggiore di quanto non facciano,

relativamente alle strutture tridimensionali, le tecniche spettroscopiche (diffrazione dei raggi X, NMR,

etc.).

Bisogna inoltre considerare che per le proteine cosidette "intrinseche di membrana", molte delle quali

svolgono un ruolo chiave in processi fondamentali come la respirazione (citocromi b, c1, a, etc.) o il

riconoscimento (complesso maggiore di istocompatibilità, etc.) cellulare, l'uso delle tecniche

diffrattometriche é fortemente ostacolato dalla difficile cristallizzabilità. D'altra parte,i data-base su cui

si fondano le tecniche predittive sono costituite nella quasi totalità da proteine solubili: ci si trova

insomma nella sfavorevole situazione per cui proprio laddove dei metodi predittivi si avrebbe più

bisogno (proteine di membrana), essi sono meno efficienti per la squilibrata

composizione dei data-base.

20

I metodi statistici tradizionali:

Mentre non é possibile, al momento, fare a meno dell'informazione sperimentale diretta nello studio

delle strutture terziarie e quaternarie, per la predizione delle strutture secondarie un considerevole

numero di proposte [Pascarella et al., 1990], basate su metodi di tipo statistico, sono apparse in

letteratura a partire dal classico lavoro di Chou e Fasman [Chou & Fasman, 1978]. Il metodo

tradizionale attualmente più popolare per facilità d'uso e affidabilità dei risultati é dovuto a Garnier e

collaboratori [Garnier et al., 1987].

Esso, dal punto di vista dell'utilizzatore finale, si riduce all'uso di tavole di “propensità” a formare le tre

principali strutture secondarie (α-eliche, foglietti β e strutture disordinate) da parte dei residui

all'interno di una finestra di ampiezza arbitraria. Di considerevole interesse per la sua originalità appare

il metodo suggerito da Lim [Lim, 1974] basato sull'identificazione di 'patterns' locali di idrofobicità

lungo la sequenza.

Non va dimenticato, comunque, che lo scopo finale di ogni metodo predittivo é di chiarire

l'arrangiamento tridimensionale della proteina e che, in questa prospettiva, percentuali di correttezza

nella predizione delle strutture secondarie dell'ordine del 65-70%, quali si ottengono con i metodi

succitati, sono ancora inadeguate. Tali prestazioni migliorano quando ci si riferisce a condizioni

particolarmente favorevoli, cioé quando le proteine di “test” sono omogenee alla gran maggioranza

delle proteine contenute nel data-base. In mancanza di tale omogeneità la “performance” del metodo é

drasticamente ridotta.

L’approccio connessionista

L'uso di reti neurali ad apprendimento supervisionato nei problemi relativi allo studio della struttura

tridimensionale di proteine è relativamente recente e limitato alla predizione delle strutture secondarie,

ed i lavori specifici sull'argomento sono pochi.

21

Alcuni di essi, tuttavia, riportano i risultati dell'applicazione del metodo in forma tabulare, analoga alle

tavole dei valori di “propensità” degli amminoacidi per le varie conformazioni, prodotte da alcuni dei

metodi statistici. Ciò mette in grado chiunque di utilizzare tali risultati ai fini della predizione della

struttura secondaria di un qualunque polipeptide. Lo schema funzionale per un percettrone impiegato

nella predizione di strutture secondarie proteiche è comunque basato sulle due fasi seguenti:

Fase 1 (apprendimento): Si sottopongono alla rete un certo numero di casi significativi, per i quali si

conosce l’esatta corrispondenza fra struttura primaria e secondaria della proteina, ottimizzando in base

a questa corrispondenza la geometria e l’intensità delle connessioni e il valore di soglia per i neuroni.

Questa fase, assolutamente peculiare di questo approccio, viene schematizzata nella Figura 3.2.

Fase 2 (interrogazione): Si sottopone allo strato di input della rete una struttura primaria lasciando

che, in base ai valori relativi alle connessioni e alle soglie, ottimizzati nella precedente fase di

“Apprendimento”, lo strato di Output proponga una struttura secondaria corrispondente.

La Figura 3.3 illustra l'architettura di un generico percettrone usabile nella predizione della struttura

secondaria di proteine. Numerose varianti rispetto a tale schema di massima sono state, tuttavia,

ampiamente sperimentate.

Un'osservazione di rilievo è che le prestazioni di una rete non dipendono in modo semplice dalle

dimensioni del "training set" usato nella fase di apprendimento. In particolare:

- grande importanza riveste il grado di omologia esistente fra le proteine del “training set” e quelle del

“testing set” (usate nella fase di interrogazione );

- tanto meglio la rete “impara a riconoscere” le proteine del training set, tanto peggiore sarà la sua

abilità predittiva nei confronti di proteine “non note” .

22

Considerazioni conclusive

Le peculiarità dell'uso di reti neurali nella predizione delle strutture proteiche che sembrano

particolarmente promettenti rispetto agli approcci di tipo tradizionale sono:

- la non necessità di assunzioni teoriche preliminari;

- la flessibilità nella definizione dell'architettura delle reti, che consente di trovare arrangiamenti

ottimali per problemi/situazioni particolari;

- la prospettiva di sfruttare appieno alcuni recenti sviluppi nelle tecnologie informatiche come l'uso

contemporaneo di numerosi processori "in parallelo", con conseguenti miglioramenti nella efficienza

computazionale misurabili in ordini di grandezza.

I limiti riscontrati nelle applicazioni realizzate finora indicano tuttavia che non ci si puo' aspettare

miglioramenti sostanziali nella soluzione del problema da un uso indiscriminato del metodo in termini

di scatola nera. Esso va visto, a nostro parere, come un ulteriore strumento di indagine, potente e

flessibile, che si aggiunge agli altri già in nostro possesso, complementandoli con caratteristiche nuove

ed originali.

23

Implementazione e Risultati

Il caso della Nitrito-reduttasi di Pseudomonas aeruginosa

In questo paragrafo viene descritto un caso interessante di applicazione del metodo di predizione della

struttura secondaria di una proteina che utilizza un percettrone ad uno strato di sinapsi e l'algoritmo di

retropropagazione dell'errore riportato nella Finestra 3.2. La proteina é la nitrito-reduttasi di

Pseudomonas aeruginosa , un enzima che catalizza la reazione:

2 H + + 1e - + NO 2 - -------> H2 O + NO

all'interno della catena respiratoria batterica che opera la denitrificazione dissimilativa ovvero la

trasformazione metabolica del nitrato ad azoto [Horio et al., 1958; Yamanaka, 1961] * .

24

L'enzima é un omodimero di P.M. 120 KDalton contenente 4 gruppi prostetici, due emi di tipo c e due

emi di tipo d1 [Gudat et al., 1963; Kuronen and Ellfolk, 1972; Kuronen et al., 1975; Silvestrini et al.,

1978], responsabili dei caratteristici spettri di assorbimento nel visibile dell'enzima. L'eme c

costituisce il sito di interazione con i substrati macromolecolari riducenti (citocromo c551 ed azzurrina)

[Horio, 1960], mentre al livello dell'eme d1 avviene la riduzione del nitrito e l'interazione con altri

ligandi tipici delle emoproteine (NO, CO, O2 , etc.). I potenziali redox dei due emi sono poco diversi

fra loro e fortemente dipendenti dalle condizioni sperimentali : pH, ligandi, etc.

Nuovi motivi d'interesse nello studio di tale enzima sono costituiti da:

A) la disponibilità della struttura primaria, recentemente ottenuta;

B) la conoscenza del gene corrispondente, che é stato clonato, sequenziato e recentemente espresso in

un sistema eterologo (Pseudomonas putida ) [Silvestrini et al., ].

Informazioni strutturali disponibili

L'enzima é sintetizzato come una pre-proteina di 567 aminoacidi i primi 22 dei quali costituiscono il

peptide segnale che dirige la proteina nello spazio periplasmatico e che viene successivamente

proteolizzato. La proteina matura è quindi costituita da 543 residui aminoacidici (Figura 3.4 A). Il sito

dell'eme c é situato vicino all'estremità aminico-terminale della catena polipeptidica; nulla si sa,

viceversa, del sito di legame dell'eme d1 .

Per quanto riguarda la struttura secondaria, studi di dicroismo circolare hanno mostrato una rilevante

percentuale di foglietto-β, circa il 48%, ed una minore percentuale di α-elica, circa il 16% [Tordi et al.,

1984].

La bassa qualità dei cristalli finora ottenuti ha impedito qualunque studio diretto della struttura

tridimensionale con la diffrattometria a raggi X. Studi a bassa risoluzione [Berger and Wharton, 1980;

Saraste et al., 1977] indicano una struttura dimerica le cui dimensioni sono di circa 40 x 80 Å; studi di

fluorescenza [Mitra and Bersohn, 1980] indicano che i quattro emi si trovano ad un polo del dimero

(Figura 3.4 A). Numerose evidenze (studi di denaturazione termica e di proteolisi in condizioni

controllate) suggeriscono variazioni conformazionali sull'enzima dipendenti dallo stato redox e dalla

presenza di ligandi sugli emi.

25

Risultati

La osservazione, ampiamente documentata in letteratura [Quian & Sejnowskj, 1988] e da noi riprodotta

che la performance funzionale di un percettrone dipenda strettamente dalla composizione del 'training

set', ci ha indotto ad esaminare l'efficacia predittiva di un semplice percettrone a 2 livelli, implementato

su un foglio elettronico programmabile (Wingz1.1), ed addestrato con tre diversi training-sets. I

risultati ottenuti, riportati nella Tabella 3.1, mostrano che in uno dei tre casi la predizione é in accordo

soddisfacente con le stime ottenute dagli spettri di dicroismo circolare delle percentuali di α-elica e

foglietto β esistenti nell'enzima completamente ridotto.

26

Tali risultati indicano che la miglior strategia per ottimizzare la performance di un percettrone nella

predizione delle strutture secondarie incognite consista non tanto nell'amplificare il più possibile le

dimensioni del training set usato nella fase di addestramento, quanto nello scegliere con estrema cura la

sua composizione. Questo, ovviamente, assegna una responsabilità primaria al ricercatore, che deve

utilizzare tutta l'informazione disponibile sul sistema in studio e su quelli ad esso in qualche modo

correlati e di struttura nota * . Laddove ciò si rivelasse un compito difficile o impossibile, tuttavia, si

dovrebbe ancora poter sfruttare le capacità classificatorie delle mappe di Kohonen per individuare

automaticamente, sulla base della conoscenza della sola struttura primaria, i migliori candidati per la

composizione del training-set.

27

2) Una corteccia somatosensoria simulata

Il sistema sensorio che per primo si sviluppa nei mammiferi è il sistema somato-sensitivo. E' ormai

assodato che udito e, soprattutto, vista non costituiscano, almeno nei primi mesi di vita, un efficiente

sistema di comunicazione con il mondo esterno. L'esperienza tattile, invece, offre un grado di

risoluzione e discriminazione, nella percezione sensibile, fin dai primi momenti elevato, tanto da

ritenere chesia la cute a permettere la realizzazione del primo «rapporto oggettuale».

Ciò che differenzia questo sistema dagli altri sistemi sensori è la distribuzione dei suoi recettori : i

recettori per la sensibilità somatica non sono localizzati in piccole regioni del corpo (come avviene,

invece, nell'occhio o nella coclea) ma sono distribuiti su tutta la superficie corporea, la cute. Diversi tipi

di sensazioni somatiche sono possibili : tatto (che ci permette di riconoscere la grandezza, la forma e le

caratteristiche superficiali degli oggetti ed il loro movimento sulla cute), propriocezione (senso della

posizione statica e dinamica del corpo e degli arti), dolore e senso termico ; ciascuna di queste è,

inoltre, descritta da altre submodalità. Un aspetto di profondo interesse è la capacità di discriminazione

tattile differente in funzione della particolare regione del corpo coinvolta : l'assunzione che non tutte le

parti del corpo sono egualmente sensibili e la conseguente indagine sui meccanismi stessi di

sensibilizzazione ha messo in evidenza che la maggiore o minore sensibilità tattile di una regione

corporea è collegata alla sua relativa rappresentazione corticale: la nostra sensibilità non è dovuta tanto

all'organo di senso periferico, quanto al cervello e alla rappresentazione interna che in esso si ha

dell'esperienza sensibile. L'intensità di una sensazione somatica è legata sia all'intensità della risposta

dei neuroni corticali coinvolti che al numero stesso di questi ultimi. Sono frequenti casi di assoluta

insensibilità periferica dovuta a lesioni corticali, pur rimanendo perfettamente funzionanti gli organi

periferici.

Dallo studio di alcune patologie sono risultati estremamente interessanti alcuni fenomeni di

riorganizzazione della rappresentazione somatosensitiva corticale in seguito a lesioni (in genere,

dell'innervazione afferente, che dalla periferia conduce il segnale sensorio al cervello), anche in

soggetti adulti. Tale capacità rende assolutamente indiscutibile che i meccanismi di sensibilizzazione,

che permettono di ottenere livelli di discriminazione tattile differenti, siano di tipo epigenetico : anche

se su una struttura predeterminata geneticamente, essi si evolvono e mantengono il cervello plastico

grazie alla continua e sempre differente attività percettiva.

28

La rappresentazione interna corticale con conservazione di topologia che si ottiene con il processo di

auto-organizzazione permette una minimizzazione quasi ottima del costo di connessione tra cellule

corticali : quelle rispondenti a stimoli simili sono più vicine tra loro.

Moderni studi elettrofisiologici hanno dimostrato, oltre all'esistenza di una relazione reciproca tra aree

corporee e aree corticali, che esiste una distorsione di rappresentazione che si evidenzia nella diversità

delle aree cerebrali destinate alla rappresentazione di parti differenti del corpo: le proporzioni tra

l'estensione superficiale della parte descritta e l'estensione corticale della sua rappresentazione non

sono assolutamente rispettate. Queste distorsioni sono invece in relazione con l'importanza di una

particolare regione della superficie corporea per la sensibilità tattile. Nell' essere

umano, in cui la manipolazione degli oggetti ed il linguaggio sono funzioni di importanza vitale, la

mano e la lingua occupano un ruolo predominante, e le loro rappresentazioni corticali sono molto più

grandi delle altre. Per definire il concetto di «importanza», motivandolo biologicamente, si può

attribuire un ruolo fondamentale alla frequenza con la quale viene svolta un certa funzione: data la

particolare configurazione anatomica e "ingegneristica" della mano umana, è statisticamente più

probabile, per esempio, che vengano sollecitati di più i cuscinetti digitali distali (i polpastrelli !) che

non i cuscinetti palmari : ciò che si osserva è infatti una area di rappresentazione corticale

sensibilmente maggiore nei primi. La spiegazione di tale distorsione è nella differente concentrazione

superficiale e dimensione dei campi recettivi. Si ricorda che il campo recettivo di un neurone è

costituito da quella zona della superficie recettoriale, in questo caso la cute, la cui stimolazione è in

grado di eccitare o di inibire la scarica della cellula stessa. Nel formalismo dei modelli neuronali

teorici, esso descrive quella regione dello spazio parametrico del segnale di ingresso che ha come

effetto l'attivazione di uno specifico neurone formale dello strato di uscita. Possiamo dire che ciascun

neurone corticale, o ciascuna microstruttura colonnare di neuroni, ha uno specifico campo recettivo. A

regioni di corteccia a rappresentazione distorta che hanno maggiore estensione saranno associati, sulla

29

superficie recettoriale, campi recettivi più piccoli la cui densità superficiale è maggiore : ingrandimento

corticale e dimensione dei campi recettivi sono quindi inversamente correlati. L'ingrandimento

corticale che ne deriva permette di ottenere, per tali zone, una discriminazione spaziale senza dubbio

migliore : una sorta di lente di ingrandimento che sfrutta la minor lunghezza d'onda della sonda. La

dimensione limitata del campo recettivo di un neurone ha, infatti, conseguenze funzionali di grande

rilievo. Se applichiamo uno stimolo ad un punto della cute, verranno eccitati i neuroni connessi con le

fibre afferenti che innervano il punto stimolato. Se, successivamente, lo stimolo viene portato in un

nuovo punto della cute, verrà attivata un'altra popolazione di neuroni. La discriminazione spaziale

cosciente tra i due stimoli sarà inversamente proporzionale alla grandezza dei campi recettivi coinvolti :

il rapporto, per esempio, tra l'ingrandimento corticale della rappresentazione delle dita e quello della

rappresentazione del tronco è, nell'essere umano, di circa 100:1. Ciò permette di comprendere perchè

sia, in fin dei conti, più facile leggere la scrittura Braille con i polpastrelli che non con il gomito. Allo

scopo di dimostrare la capacità delle SOM di Kohonen di conservare la topologia e, soprattutto, di

organizzare in maniera gerarchica la risposta neuronale, una di tali reti è stata utilizzata per simulare la

formazione dei campi recettivi tattili di una mano nella corteccia somatosensoria [Kaas et al.,1979] e la

successiva riorganizzazione corticale in seguito a lesione di un nervo afferente [Merzenich & Kaas,

1982]. Nel caso in esame non c'è una riduzione di dimensionalità poichè lo stimolo x è descritto in uno

spazio parametrico bidimensionale (la distribuzione dei "somatomeri" - i recettori al tatto - sulla cute)

ed è «mappato» conformemente sullo spazio, anch'esso bidimensionale, della corteccia

somatosensoriale.

Descrizione dell' esperimento :

1) Si è prodotto artificialmente un repertorio di base di circa 300 «stimoli» x=(x1 ,x2 ) (con xiÎ{0,100}

e xiÎN) facendo in modo che la proiezione sul piano x1 ,x2 della distribuzione di probabilità P(x1 ,x2 )

avesse, più o meno, la forma di una mano (vedere figure seguenti). Nell' ambito, poi, di tale repertorio

di stimoli, si è fatto in modo che P(x1 ,x2 ) fosse leggermente maggiore in corrispondenza dei

polpastrelli. Con lo stesso principio si è prodotto un secondo repertorio, sempre di circa 300 «stimoli»,

relativo ad una mano lesionata, nella quale viene a mancare il segnale afferente da un dito centrale. La

procedura di realizzazione di questi insiemi di stimoli, anche se decisamente «artigianale», si è

dimostrata efficiente ai fini dell'esperimento, e la sua descrizione non sembra sufficientemente

interessante.

2) Si è inizializzata la matrice w degli accoppiamenti sinaptici dei 400 neuroni della corteccia (un

reticolo 20x20), in modo tale che tutti i neuroni avessero i valori iniziali delle sinapsi disposti

casualmente intorno al punto centrale dello spazio parametrico di ingresso, e cioè wi,j,1 , wi,j,2 » 50 ,

con i,j=1,...,20. Una scelta alternativa sarebbe stata quella di assegnare a wi,j,1 , wi,j,2 dei valori casuali

tra 0 e 100, ma si è osservata, in questo caso, una minor velocità di organizzazione. Il numero di

neuroni utilizzati si è preso dell'ordine del numero di stimoli di base del repertorio (come verrà detto in

seguito, su ciascuno stimolo di base sarà prodotta, nel corso del programma di apprendimento, una

«nuvola» di rumore).

30

3)

Viene

avviato

il

processo

di

apprendimento,

descritto

dalle

equazioni:

dove Nc (t) è un intorno circolare di raggio R(t) del neurone "best match" per lo stimolo x al tempo t (si

ricorda che t è diventato un contatore di stimoli) ; per gli andamenti temporali di a(t) e R(t) si sono

adottate le seguenti:

Poichè il numero di stimoli a disposizione (300) è minore del numero richiesto per l'intero programma

di apprendimento (10 3 ¸10 4 «stimolazioni»), come capita di frequente in problemi di questo tipo, si è

riutilizzato ciclicamente il repertorio a disposizione, sommando ogni volta allo stimolo un rumore a

media nulla di dinamica pari al 5% di quella del segnale (100).

4) Dopo aver raggiunto, in circa 2000 «stimolazioni», una situazione di stabilità evidenziata dalla

formazione di campi recettivi ordinati spazialmente con densità direttamente proporzionale

all'importanza informativa dello stimolo descritto, si è sostituito al repertorio originale di stimoli quello

descrivente la «mano lesionata», senza il «dito» centrale. Si è continuato, quindi, il processo di

apprendimento, che, seppur nella fase di specializzazione, si è fatto in modo che mantenesse una certa

plasticità. Per ottenere ciò è stato fondamentale che il raggio minimo di interazione Rmin non fosse

unitario o, ancor peggio, nullo così come non dovesse essere indefinitamente decrescente il guadagno

plastico a(t) (cose che invece si verificano nella maggior parte delle realizzazioni del

modello di Kohonen).

31

I risultati ottenuti sono stati tradotti in forma grafica, di grande aiuto nello studio di questo modello. La

prima serie di immagini (Fig. 2.5, vedi appresso) rappresenta i vari stadi del processo di autoorganizzazione: vi sono riportati, sovrapposti e descritti nello stesso spazio parametrico (in questo caso

bidimensionale), i punti corrispondenti ai 300 stimoli di base x di repertorio e i valori istantanei degli

accoppiamenti sinaptici w. Per evidenziare l'effetto di organizzazione spaziale, questi ultimi sono stati

collegati da linee rette se relativi a neuroni adiacenti sulla corteccia simulata. Quello che succede, nel

corso dell'apprendimento, è che la distribuzione dei valori di accoppiamento sinaptico nello spazio

parametrico dei patterns di ingresso tende a riprodurre la distribuzione di probabilità di questi ultimi.

Tale processo avviene in due fasi.

Prima si verifica un ordinamento grossolano, ma rapido: si ha un grande raggio di interazione R(t) ed

un alto valore di guadagno plastico. Dopo avviene la specializzazione, più lenta, nella quale i dominii

di interazione hanno raggiunto il valore minimo asintotico ed il guadagno plastico si è stabilizzato su di

un valore di regime, inferiore ai valori iniziali, e tale da permettere variazioni sinaptiche piccole ma, a

tempi lunghi, significative. E', infatti, interessante notare la plasticità e la dinamicità della rete che,

successivamente alla «lesione», ridistribuisce i campi recettivi dei neuroni associati al dito «inibito» in

modo tale da aumentare il numero di neuroni attivati dalle zone recettoriali rimaste funzionanti,

ottenendo quindi un aumento di sensibilità e di discriminazione spaziale per le dita rimaste : è la

manifestazione di quel comportamento gerarchico prima accennato, per il quale quando una particolare

afferenza diviene inattiva, il suo territorio di rappresentazione sulla corteccia può venire invaso dalle

afferenze che provengono dalle zone rimaste attive.

Successivamente, con metodi analoghi a quelli che si usano in elettrofisiologia per la determinazione

delle mappature corticali, si sono prodotti degli «stimoli» sulla superficie recettoriale (quindi, sulla cute

della mano formale), e cioè sono stati utilizzati dei vettori appartenenti all'insieme P(x1 ,x2 ) per

sollecitare una risposta nella rete. Alcune delle attività misurate con questa serie di «stimolazioni» sono

state riportate nella Fig. 2.6. Per evidenziare il miglioramento in risoluzione ottenuto con il processo di

apprendimento viene mostrato anche uno stato di attivazione attinente alla fase iniziale

dell'apprendimento (t=30), nel quale la risposta non è ancora localizzata. Da tali figure si evidenzia

ulteriormente la corrispondenza tra stimoli simili e zone attivate adiacenti. Dopo aver registrato una

sufficiente quantità di attivazioni, relative a tutta la superficie della mano, se ne è ricavata una mappa

corticale. Una analoga mappa è stata ricavata (Fig. 2.7), con lo stesso procedimento, a seguito della

riorganizzazione dopo la «lesione»: da quest'ultima si può notare la ridistribuzione dei campi recettivi,

originariamente associati al dito lesionato, tale da migliorare la sensibilità residua. Insieme con queste

ultime, vengono riprodotti (Fig. 2.8) alcuni risultati delle ricerche di Kaas e Merzenich sulla

rappresentazione della mano nella corteccia somato-sensoria delle scimmie nictipiteco [Kaas et

al.,1979][Merzenich et al.,1983] [Merzenich & Kaas,1982]. Le analogie, soprattutto, nella forma della

mappa corticale nell'area di

Brodmann 3b, sono abbastanza evidenti.

32

33

34

Una ulteriore simulazione potrebbe essere quella della formazione delle microstrutture colonnari della

corteccia visiva sensibili alla orientazione nello spazio di semplici stimoli visivi.

In conclusione, il modello delle Self Organizing Maps di Kohonen si dimostra notevolmente

interessante, oltre che per le sue possibili applicazioni, anche per la sua innegabile interpretazione

descrittiva (e non esclusivamente strumentale) dei sistemi sensoriali biologici.

35

Gli esperimenti di mappatura di Kaas, Merzenich e coll. indicano cha ciascuna delle quattro subregioni

del giro postcentrale (3a, 3b, 1 e 2) contiene una propria rappresentazione. A) Veduta dorsolaterale

della corteccia di un nictipiteco che documenta come, sia nell'area 3b che nell'area 1, esista una

rappresentazione cutanea distinta. La rappresentazione delle superfici fornite di peli del piede e della

mano sono ombreggiate. Le dita della mano e dei piedi sono numerate. B1) E' una mappa più espansa e

più dettagliata delle aree della mano della corteccia della scimmia riportata in A. In B2) le distorsioni di

rappresentazione del palmo della mano sono in relazione con l'estensione delle rappresentazioni di

ciascuna zona a livello corticale. I cuscinetti palmari, quindi, sono numerati da P4 a P1; vi sono due

cuscinetti insulari (I), uno ipotenare (H) e due tenari (T). I cinque cuscinetti digitali sono anch'essi

numerati.

36

1)Applicazioni di reti neurali per il monitoraggio e il controllo della qualità e quantità delle risorse

idriche sotterranee

In questa parte della ricerca si intende studiare la capacità di riconoscimento, da parte di RNA, delle

condizioni iniziali di fenomeni contaminativi in atto nelle risorse idriche sotterranee.

Si intende pertanto verificare se le RNA siano in grado di identificare nel dominio idrogeologico in

studio la posizione di una sorgente di contaminante, note le concentrazioni di un inquinante nella rete

di monitoraggio.

Il progetto è articolato nelle seguenti attività principali:

• Individuazione di un bacino idrogeologico da utilizzare come caso di prova e conseguente creazione

dei modelli di flusso e di trasporto;

• Analisi dei dati forniti dal modello e loro pre-elaborazione e conversione dei dati al fine di estrarre da

essi caratteristiche che li rappresentino compattamente senza, al contempo, perdere informazioni utili,

affinché possano essere elaborati dalla rete neurale ;

• Studio delle architetture neurali più adatte per il problema in oggetto;

• Addestramento delle reti con dati generati dal modello;

• Post-elaborazione e riconversione dei risultati

• Creazione di dati per la validazione del sistema neurale ed eventuale reperimento di dati acquisiti sul

campo;

• Test della capacità di generalizzazione del sistema mediante simulazione.

I° Individuazione di un bacino idrogeologico da utilizzare come caso di

prova e conseguente creazione dei modelli di flusso e di trasporto

Per creare modelli di flusso e di trasporto si stanno simulando diversi scenari idrogeologici mediante il

software di modellazione Processing Modflow, basato sul MODFLOW del U.S. Geological Survey per

il flusso e sui codici MT3D ed MT3DMS per il trasporto.

Le applicazioni di MODFLOW , con il metodo alle differenze finite, consentono di ottenere un

modello delle acque di falda modulare tridimensionale, per la descrizione e predizione del

comportamento dei sistemi.

Si possono realizzare modelli con i limiti massimi di:

•1000 periodi di tempo

•80 strati

•250000 celle.

Le dimensioni delle celle possono essere differenti in alcune aree della falda: ciò consente uno studio

meno approssimato nei punti più critici e risoluzioni meno dettagliate nelle aree dove è consentito una

approssimazione maggiore.

I tools di modellazione consentono all’utente di estrapolare i risultati della simulazione per ogni

periodo di tempo da un spread sheet. I risultati possono essere visualizzati o memorizzati in file dati

ASCII o SURFER compatibile.

37

Essi includono:

i carichi idraulici; abbassamenti; consolidamenti; subsidenze; velocità darciana; concentrazioni;

Il tool “ Presentation ” consente di creare mappe dei dati dei risultati delle simulazioni con contorni

etichettati.

Per simulare la diffusione del contaminante si é utilizzato il programma di trasporto MT3D che usa un

approccio Euleriano-Lagranciano alla soluzione delle equazioni di trasporto.

MT3D può essere usato per simulare il trasporto di soluto, usando i carichi idraulici e vari termini di

flusso calcolati con le elaborazioni del MODFLOW.

Con esso si possono simulare le variazioni in concentrazione di singole specie misurate e contenute

nelle falde acquifere considerando:

•l’advezione ;

•la dispersione e

•le reazioni chimiche semplici.

MT3DMS è un ulteriore sviluppo dell’MT3D che consente di ottenere risultati analoghi nel caso di più

contaminanti che possono reagire chimicamente tra di loro.

Inoltre i programmi PEST e UCODE permettono di adattare i parametri del modello e/o i dati in modo

da ridurre al minimo eventuali discrepanze tra i numeri generati dal modello ottenuto con la

simulazione e le misure effettuate in laboratorio e/o nella falda in esame.

II° Pre-elaborazione e conversione dei dati dei dati forniti dal modello

I campioni ottenuti dallo studio del modello sono costituiti da matrici di dimensioni [m,n], una per ogni

strato esaminato e per ogni valore del tempo t. Cij rappresenta il valore della concentrazione del o dei

contaminanti relativi alla cella della riga i-esima (delle m totali) e alla colonna j-esima (delle m*n

totali).

Tali matrici vengono convertite in vettori di dimensioni [(m*n),1], troppo elevate per poter essere

successivamente elaborati con le reti neurali, in quanto richiederebbero un numerotroppo grande di

esempi.

Per questo motivo diventa assolutamente necessaria una pre-elaborazione finalizzata alla riduzione

drastica delle dimensioni dei vettori.

La conversione e riconversione dei dati rappresentano due fasi molto delicate per la natura intrinseca

del problema che deve gestire campioni di esempi con una grande quantità di dati.

Attualmente si sta cercando di ottenere la condizione ottimale che consenta di ottenere la massima

riduzione possibile conservando tutta l’informazione utile.

Si stanno esaminando in dettaglio 2 possibilità:

• Trasformata di Fourier del 2 ordine, con una pre-compressione dei dati;

• PCA Principal Component Analysis, preceduta da una normalizzazione dei dati tale

che risultino a media nulla e deviazione standard unitaria.

Con entrambi i metodi si riesce a risalire al punto esatto di partenza del contaminante, mentre si

commettono ancora errori non accettabili sui valori delle concentrazioni nelle celle interessate dalla

presenza di contaminante all’istante iniziale.

Il secondo metodo presenta il vantaggio di eliminare le componenti principali che

contribuiscono meno di un valore predefinito ?, espresso in % della totale variazione nel set

dei dati.

38

In questo modo è possibile definire a priori l’ordine di approssimazione dovuto al taglio di

informazione.

Tale applicazione presenta l’inconveniente che il numero dei campioni relativi a ciascun esempio

deve essere minore o uguale al numero di esempi.

Per la natura del nostro problema (almeno 1000 campioni per esempio), il numero di esempi

dovrebbe essere molto alto.

Per superare i limiti dovuti a questo vincolo, si sta perfezionando l’applicare del metodo della PCA, a

sottoblocchi della matrice degli esempi pn, che per sua natura presenta un numero elevato di campioni

per esempio.

Per una matrice pn (900*90) si riesce ad ottenere una pn trans (30*90) con un taglio di informazione ?

% =10%

III° Architetture neurali più adatte per il problema in oggetto

Le reti neurali che utilizzate sono le Reti Neurali Ricorrenti, perché consentono di esaminare le

evoluzioni temporali dei fenomeni in studio. Per la loro applicazione si sta usando il Neural Network

Toolbox di Matlab.

Per ottenere un numero di vettori di input e di output sufficientemente limitato, si sta studiando la

possibilità di ridurre i vettori intorno alle dimensioni (30*1) con la finalità di utilizzare un rete con 30

nodi di input, un solo strato nascosto, con un massimo di 5 nodi e 30 nodi nello strato di output.

39

Il numero delle distribuzioni di contaminazione iniziale sono tali che studiando una evoluzione

temporale in un periodo 10 anni, si possano ottenere almeno 5000 esempi. Di questi esempi il 70% é

utilizzato per il training e la restante parte per i test .

Stato di avanzamento dello studio

Attualmente per ottenere risultati soddisfacenti si sta facendo una messa a punto della procedura

complessiva, cercando di tarare i seguenti parametri fondamentali:

•numero degli strati e delle celle utilizzati nelle simulazioni dei fenomeni fisici;

•numero delle righe dei vettori relativi agli esempi ottenibili senza perdita di informazione con la

pre-elaborazione;

•minimo numero di nodi nello strato nascosto della rete;