Psicologo: verso la professione

(Paolo Moderato, Francesco Rovetto)

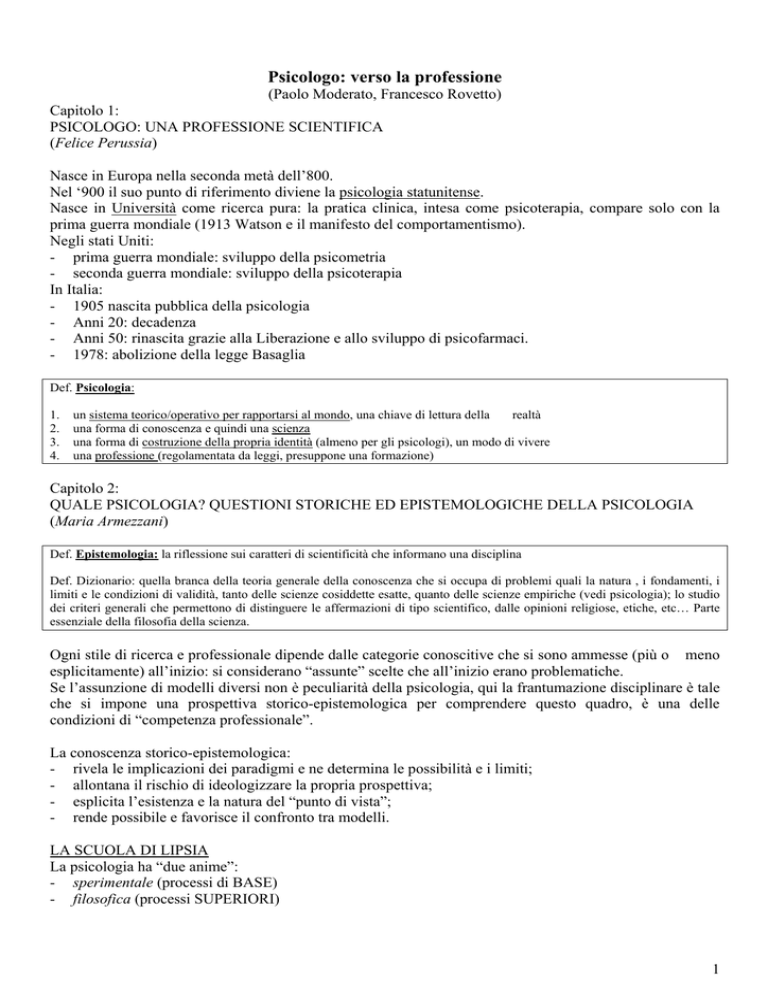

Capitolo 1:

PSICOLOGO: UNA PROFESSIONE SCIENTIFICA

(Felice Perussia)

Nasce in Europa nella seconda metà dell’800.

Nel ‘900 il suo punto di riferimento diviene la psicologia statunitense.

Nasce in Università come ricerca pura: la pratica clinica, intesa come psicoterapia, compare solo con la

prima guerra mondiale (1913 Watson e il manifesto del comportamentismo).

Negli stati Uniti:

- prima guerra mondiale: sviluppo della psicometria

- seconda guerra mondiale: sviluppo della psicoterapia

In Italia:

- 1905 nascita pubblica della psicologia

- Anni 20: decadenza

- Anni 50: rinascita grazie alla Liberazione e allo sviluppo di psicofarmaci.

- 1978: abolizione della legge Basaglia

Def. Psicologia:

1.

2.

3.

4.

un sistema teorico/operativo per rapportarsi al mondo, una chiave di lettura della

realtà

una forma di conoscenza e quindi una scienza

una forma di costruzione della propria identità (almeno per gli psicologi), un modo di vivere

una professione (regolamentata da leggi, presuppone una formazione)

Capitolo 2:

QUALE PSICOLOGIA? QUESTIONI STORICHE ED EPISTEMOLOGICHE DELLA PSICOLOGIA

(Maria Armezzani)

Def. Epistemologia: la riflessione sui caratteri di scientificità che informano una disciplina

Def. Dizionario: quella branca della teoria generale della conoscenza che si occupa di problemi quali la natura , i fondamenti, i

limiti e le condizioni di validità, tanto delle scienze cosiddette esatte, quanto delle scienze empiriche (vedi psicologia); lo studio

dei criteri generali che permettono di distinguere le affermazioni di tipo scientifico, dalle opinioni religiose, etiche, etc… Parte

essenziale della filosofia della scienza.

Ogni stile di ricerca e professionale dipende dalle categorie conoscitive che si sono ammesse (più o meno

esplicitamente) all’inizio: si considerano “assunte” scelte che all’inizio erano problematiche.

Se l’assunzione di modelli diversi non è peculiarità della psicologia, qui la frantumazione disciplinare è tale

che si impone una prospettiva storico-epistemologica per comprendere questo quadro, è una delle

condizioni di “competenza professionale”.

La conoscenza storico-epistemologica:

- rivela le implicazioni dei paradigmi e ne determina le possibilità e i limiti;

- allontana il rischio di ideologizzare la propria prospettiva;

- esplicita l’esistenza e la natura del “punto di vista”;

- rende possibile e favorisce il confronto tra modelli.

LA SCUOLA DI LIPSIA

La psicologia ha “due anime”:

- sperimentale (processi di BASE)

- filosofica (processi SUPERIORI)

1

¾ Fondatore ufficiale: Wundt, ha fondato a Lipsia nel 1879 il primo laboratorio di psicologia

sperimentale. E’ il primo che decise di applicare la metodologia delle scienze naturali all’indagine

sulla “psiche” (da criteri filosofici si passa a criteri sperimentali-quantitativi).

¾ Oggetto di indagine: “l’esperienza umana immediata”, ciò che è reperibile immediatamente nella

coscienza soggettiva.

¾ Variabili controllate: processi sensoriali semplici (escluse tutto quello che oggi chiamiamo

psicologia)

¾ Strumento: l’introspezione, resa sistematica da precise regole che tendono ad equipararla

all’osservazione scientifica

¾ Scopo: indagare sulla struttura della mente per scoprirne regole e componenti

Accanto a questa psicologia sperimentale, lo stesso W. sostiene la necessità di una psicologia filosofica,

vicina alle scienze “umane”.

→ la psicologia è iniziata come scienza della “coscienza”: è proprio l’idea di analizzare la soggettività con

criteri empirici, che fonda la psicologia moderna.

Le correnti si dividono:

In Europa continua la tradizione filosofica, mentre in USA quella sperimentale

Correnti in Nord-America:

STRUTTURALISMO E FUNZIONALISMO (fine ‘800, primi del ‘900)

Strutturalismo

¾ Fondatore : Cattell, allievo di Wundt, ma dà una interpretazione diversa agli studi di Lipsia: i dati

ottenuti non sono misura delle sensazioni, ma misura dell’entità fisica oggettiva degli stimoli, da

misure dell’esperienza soggettiva si passa a misure dell’oggetto che provoca l’esperienza.

Collabora con Galton e introduce la statistica e i test mentali; l’interesse si sposta dal soggetto, alle

prestazioni soggettive (e poi alle differenze individuali).

¾ Fondatore: Titchener, allievo di Wundt, esclude tutta la parte filosofica dalla sua traduzione

dell’opera di Wundt e sposta tutto l’interesse sulla parte sperimentale, “risolvendo” così la

contraddizione interna. Vuole indagare la struttura della mente. Alla sua morte il movimento si

dissolve.

Funzionalismo

¾ Fondatore: James, più le correnti evoluzionistiche: Angell e Carr.

¾ Oggetto di indagine: non i contenuti psichici, ma i processi e le funzioni che favoriscono

l’adattamento dell’organismo all’ambiente.

¾ Metodi: eclettismo, basato sull’utilità pratica e sulla capacità di indagare le interazioni dell’uomo

con l’ambiente naturale (NO laboratorio!) Declino dell’introspezione!

2

Rif. culturali: teorie di Darwin, Neopositivismo.

COMPORTAMENTISMO (“manifesto” del 1913)

¾ Fondatore: Watson, per garantire la scientificità della psicologia, W. elimina come oggetti di studio

gli “eventi mentali”.

¾ Oggetto: comportamento osservabile, a prescindere dai rapporti che ha con la coscienza

¾ Metodo: sperimentale di laboratorio, che consente di manipolare le variabili indipendenti

(ambientali), osservandone gli effetti sulle var. dipendenti (comportamentali)

¾ Modello matematico: statistica inferenziale

Confermato dagli studi di Pavlov, W. utilizza il modello S-R (stimolo-risposta) che risponde ai criteri di

previsione e controllo delle variabili.

¾ Oggetto: diventa l’apprendimento, con gli esperimenti sul condizionamento (classico e operante),

per stabilire le leggi del comportamento.

La psicologia immette così sul mercato i primi strumenti di misurazione psicometrica che offrono garanzie

di controllabilità e prevedibilità.

Dalla fine degli anni trenta, si introduce il criterio della significatività statistica come ulteriore

rassicurazione: si può generalizzare i risultati come nelle altre scienze naturali.

(criterio molto criticato: la significatività è un criterio di ordine matematico, che non può rispondere tout

cour a domande di natura psicologica! Anche Hathaway critica il suo stesso test, l’MMPI)

Le correnti contemporanee conservano la concezione epistemologica, ma valorizzano una visione solistica

e attiva del comportamento umano con l’introduzione della nozione di “contesto”: il comportamento è

sempre un atto in un contesto che attribuisce i significati e le funzioni agli stimoli specifici dell’ambiente.

→ rientra il “significato”!!!

COGNITIVISMO (fine degli anni ’50)

Def. Cognitivo: “indica tutti quei processi che comportano trasformazioni, elaborazioni, riduzioni , immagazzinamenti, recuperi

e altri impieghi dell’input sensoriale. Termini […] che si riferiscono a ipotetici stadi o aspetti dell’attività cognitiva” (Neisser,

1976)

¾ Fondatori: Neisser (1967) e Miller, Galanter e Pribram, “comportamentismi soggettivi”(1960)

¾ Oggetto: attività e processi cognitivi non osservabili. Si ripropongono i problemi epistemologici.

→ La teoria non pretende di rispecchiare il reale stato dei fatti, ma di rappresentarlo.

E viene utilizzata la metafora del computer: la conoscenza umana è una manipolazione di simboli

realisticamente rappresentabile con l’analogia con il software.

I paradigmi sono storicamente due:

- HIP: sistema cognitivo definito come una serie di regole per la trasformazione di simboli (= un

processore di segnali) Æ paradigma computazionale simbolico teorizzato da Fodor e Pylyshyn.

Le regole sequenziali e il carattere localizzato dell’elaborazione non rendono conto di fenomeni quali la

riorganizzazione cognitiva, meglio spiegati dal secondo paradigma.

3

- PDP: connessionista, il sistema cognitivo è visto come una rete di interconnessioni auto-organizzato, la

metafora è con il SNC reale, con i neuroni.

¾ Metodi: costruzione di modelli e verifica tramite PC

¾ Modello matematico: teoria della probabilità

¾ Critiche:

- rapporto debole tra modello e esperimento

- artificialità dei modelli (situazioni lontane dalla vita quotidiana)

- dalla costruzione dei significati, si è passati a studiare l’elaborazione dell’informazione: di nuovo

impersonalità e oggettività

- sono stati esclusi dalle ricerche i processi che poco si adattano alla rappresentazione computazionale:

emozioni, creatività, interazioni tra soggetti, ecc.

- come nel comportamentismo, il cognitivismo è limitato dalla riduzione dell’oggetto di studio al metodo

disponibile.

TEORIE COSTRUTTIVISTICHE (anni ’80)

¾ Autori: Watzlawick

¾ Teoria: non esiste un mondo reale pre-esistente e indipendente dall’osservatore, ma esistono varie

versioni di mondo a seconda del punto di vista. Ogni pensiero/giudizio/percezione è un’operazione

costruttiva e autoreferenziale dell’osservatore.

¾ Oggetto: l’uomo come essere attivo, costruttore di significati e l’ambiente come universo di simboli

e di esperienze possibili.

¾ Metodo: rivalutazione dell’osservazione nelle situazioni di vita quotidiana, dei metodi qualitativi e

di strategie che prevedono un’interazione tra ricercatore e soggetto.

¾ Critiche:

il cognitivismo aveva enfatizzato il metodo, adattandovi l’oggetto di studio. In modo inverso, il

costruttivismo recupera il “significato” come oggetto di studio, non avendo però un metodo per studiarlo.

Correnti Europee:

→ La psicologia Resta legata alle discipline filosofiche ed ha un carattere più accademico della psicologia

nordamericana, e minore influenza sociale.

GESTALT (nascita ufficiale: 1912 Germania)

¾ Fondatore: Wertheimer, nel 1912 pubblica un importante lavoro sul movimento stroboscopio che dà

inizio alla scuola della Gestalt.

→ Gestalt = forma, come totalità significativa, le cui proprietà sono conoscibili attraverso un atteggiamento

e un metodo fenomenologico..

¾ Oggetto: “l’esperienza umana immediata” (N.B. come Wundt!!!), ma la intendono in modo diverso:

l’esperienza è un “campo psicologico organizzato” dove il soggetto si lega in modo intenzionale

all’ambiente.

Per la Gestalt:

- l’esperienza diretta è il materiale grezzo sia della fisica, come della psicologia;

4

-

non esiste osservazione neutra, l’osservazione è sempre prospettica;

sia la realtà fisica che quella psicologica sono “esperienze soggettive”, “fenomeni”.

¾ Metodi: esperimenti percettivi

¾ Applicazioni: psicologia della percezione, pensiero, memoria, personalità e sociale.

→ Kohler (1917) def. Insight:“ristrutturazione improvvisa del campo percettivo“ (≠ apprendimento per

prove ed errori di Thorndike)

PSICOANALISI (1900)

¾ Fondatore: Freud, nel 1900 pubblica “L’interpretazione dei sogni”: propone un’interpretazione

psicologica dei disturbi psichiatrici (N.B. novità assoluta!!)

Def. Psicoanalisi:

1) un procedimento per l’indagine dei processi psichici

2) un metodo terapeutico basato su tale indagine

3) una serie di conoscenze sul funzionamento psichico acquisite per questa via

¾ Oggetto: i processi psichici inconsci

¾ Metodo: metodo clinico, basato sull’interpretazione.

→ Dopo Freud la psicoanalisi si è diversificata anche a causa dell’esportazione dal contesto austrotedesco,

restando accomunata unicamente dal riferimento alla dimensione inconscia.

PSICHIATRIA FENOMENOLOGICA (inizi del ‘900)

¾ Fondatore: Biswanger

¾ Oggetto di indagine: l’ ”Erlebnis”(l’esperienza vissuta), il vissuto soggettivo

¾ Scopo: pervenire alle forme strutturali della conoscenza, attraverso un’analisi sistematica dei tratti

comuni delle esperienze umane.

Teoria di rif.: fenomenologia husserliana (cosa≠fenomeno)

¾ Metodo: limitazione dell’analisi a ciò che è reperibile nella coscienza (≠psicoanalisi), analizzare

l’esperienza umana per comprenderne le strutture fondamentali che lo mettono in rapporto con lo

spazio, il tempo, mettendo da parte ogni distinzione pregiudiziale tra normale e patologico e ogni

interpretazione causalistica-meccanicistica (≠comportamentismo).

EPISTEMOLOGIA GENETICA (anni ’50)

¾ Fondatore: Piaget, detta anche “scuola di Ginevra” o “costruttivismo piagetiano”.

¾ Oggetto: “conoscenza” , così come si sviluppa, nell’interazione organismo-ambiente; la relazione

tra il soggetto che agisce e pensa e il mondo che lo circonda, oggetto delle sue esperienze.

¾ Metodo: sperimentale e clinico. (osservazioni sui bambini)

5

Teoria: l’attività senso-motoria determina la costruzione del reale secondo processi alternati di

assimilazione e accomodamento combinati tra individuo e ambiente e, attraverso una riorganizzazione delle

strutture mentali, determina lo sviluppo ontogenetico del soggetto.

Osservazioni sulle diverse scuole:

- coerenza e rigore sono comunque attributi della scientificità, in qualunque modo la si concepisca;

- nella dialettica tra metodo e oggetto, spesso è stato sacrificato l’uno per l’altro senza trovare un giusto

equilibrio;

- è inevitabile operare una scelta di “punto di vista”, esserne consapevoli e esplicitarla nel lavoro di

professionisti.

Capitolo 3:

CRITERI DI COERENZA TRA TEORIA E PRATICA IN PSICOLOGIA CLINICA

(Franco Di Maria e Calogero Lo Piccolo)

Def. Psicologia clinica è confusa:

1. definita dal suo oggetto: cioè la cura → identificazione della psicologia clinica con la psicoterapia

2. definita da un modello di cura → definizione dello psicologo clinico come appartenente a una determinata scuola

E’ in netta ascesa la richiesta di interventi psicologici ma non psicoterapici: richiesta di soluzione di un

disagio psicologico (≠ psicopatologico), formazione professionale, gestione delle risorse umane.

La difficoltà di def., sta nella mancanza di coerenza tra teoria e pratica: le teorie più diffuse NON hanno al

centro la relazione (ma l’intrapsichico), la pratica ha sempre al centro la relazione.

¾ Propongono il modello della psicologia Clinica come dell’ action-research:

- perché tiene ben presente il significato di irruzione nel sistema, da parte del ricercatore

- si allontana dai criteri di oggettività intesa come neutralità: trasformiamo la realtà nell’atto stesso di

osservarla e conoscerla.

- non scotomizza la relazione, ma la utilizza per i propri scopi: la relazione come metodo di conoscenzaintervento

Ri-def: psicologia clinica = action-research che mira a valutare, comprendere ed trasformare i sistemi relazionali

umani, tenendo presente che agire-conoscere-trasformare sono fasi inseparabili.

¾ E’ importante che ogni professionista faccia della sua tecnica un oggetto di studio, apra una riflessione

teorica sul proprio operare.(teoria della tecnica)

¾ L’intervento si configura come la costruzione di uno spazio relazionale “altro” che renda pensabili e

osservabili i comportamenti degli attori, anche al di fuori del setting clinico tradizionale. La relazione è

il metodo di conoscenza-intervento.

¾ Analisi della domanda: come analisi di tutti gli aspetti anche fantasmatici della relazione, per la

costruzione di un area di senso “comune” che possa fare da base alla relazione.

¾ Distinzione tra set e setting:

set : tutti gli aspetti organizzativi che rendono possibile l’incontro (orario, frequenza, ecc.)

setting: accadimenti emotivi e relazionali dell’incontro, spazio relazionale e psichico che si ritaglia

all’interno di un set adeguato.

Ciò che lo psicologo clinico fa è usare la propria competenza per cambiare il set in funzione di un setting

più adeguato a riconoscere e pensare le emozioni.

6

Capitolo 4:

CONSIDERAZIONI SUL CONCETTO DI NORMALITA’ NELLO SVILUPPO COGNITIVO

(Silvia Perini)

Quesito della ricerca moderna: Normalità e ritardo cognitivo fanno parte di un continuum o di continua

differenti?

Inizio secolo: bambino come diverso dall’adulto, inizia ad interessare la ricerca.

Anni 20: Watson in USA e Piaget in Europa spiegano la genesi e l’evoluzione cognitiva.

Anni 60: teorie dell’elaborazione dell’informazione

Oggi: due correnti di pensiero sullo sviluppo cognitivo

¾

Sviluppo cognitivo come struttura/competenza: trasformazione quantitativa che si realizza nel

corso di stadi (lo sviluppo = sovrapposizione di strati di diverso livello)

Strutture come ogg. di studio dei cognitivisti Æ studiano conoscenza e mente, cioè costrutti

metaforici non osservabili. Manipolano variabili e attribuiscono le modificazioni del

comportamento correlate alle attività cognitive che si presumono influenzate dalle manipolazioni.

Æ ritardo mentale: prodotto da strutture della mente deficitarie.

¾

Sviluppo cognitivo come funzione/performance: crescita, vista come incremento quantitativo e

continuo.

Funzioni come ogg. di studio dei comportamentisti Æ studiano le relazioni osservabili fra eventi

ambientali e attività, in termini di stimoli, risposte ed eventi contestuali osservabili.

Æ ritardo mentale: rallentamento nel processo di cambiamento; il ritardo è evolutivo.

Def. Teoria: è esplicativa e rappresenta un tentativo di organizzare una serie di leggi derivate da dati empirici allo

scopo di spiegare e prevedere eventi.

Def. Modello: non è esplicativo, è un’applicazione metaforica della teoria, una rappresentazione della realtà, non una

descrizione. Non richiede dati empirici su cui basarsi.

¾ Oggetto: sia per la teoria che per il modello, studiare lo sviluppo, significa studiare il cambiamento

lungo la dimensione temporale.

Teoria Cognitiva (da Piaget al connessionismo):

La maggioranza degli studiosi ritiene che l’architettura cognitiva, sia una struttura immutabile dell’attività

cognitiva, nel senso che il suo funzionamento non cambia nel corso dello sviluppo.

L’attività dei sistemi cognitivi si può solo inferire da ciò che produce sul piano del comportamento.

Un costrutto ipotetico funge da mediatore fra il comportamento e ciò che lo determina.

Per Piaget si tratta delle strutture che sottostanno al pensiero, mediando le interazioni con l’ambiente

esterno. I processi di assimilazione e accomodamento fanno evolvere e sviluppare sia le strutture cognitive

sia le modalità con cui esse fungono da mediatori: prima i riflessi, poi schemi non simbolici, quindi

rappresentazioni mentali.

- Anni 60: la teorizzazione piagetiana viene influenzata dalle scienze dell’informazione, e vede la mente

come un sistema che manipola simboli. Æ il sistema cognitivo elabora i simboli in modo seriale e li

finalizza in accordo a regole che si modificano nel tempo.

Limiti dell’approccio seriale dell’elaborazione dell’informazione:

- qual è la natura del sistema di elaborazione, la sua organizzazione e i processi che lo guidano?

7

-

Come può il sistema essere adattato a compiti particolari?

-

I modelli connessionisti sembrano dare una soluzione: l’immagazzinamento e l’elaborazione

dell’informazione sono visti come processi che avvengono in parallelo anziché in sequenza seriale,

grazie a unità che hanno un reciproco effetto facilitante o inibente.

Fine anni 70: metacognizione, come conoscenza introspettiva sul proprio funzionamento mentale e sui

processi che lo regolano.

-

La teoria comportamentale: da Watson all’analisi del comportamento

L psicologia del comportamento considera lo sviluppo infantile un sottoinsieme della teoria generale:

l’oggetto di studio è il comportamento osservabile e il metodo è quello delle scienze naturali.

Sviluppo:

- interazioni continue tra bambino che si evolve biologicamente e cambiamenti dell’ambiente

- queste interazioni cambiano sia l’individuo, sia l’ambienteÆ le interazioni si modificano nel tempo in base all’età.

¾ Watson: C = f (s), gli stimoli colpiscono gli organi di senso e le risposte sono azioni del corpo.

(condizionamento della paura di Albert)

Il comportamentismo radicale di Skinner e l’intercomportamentismo di Kantor danno forma sistematica alla

psicologia del comportamento, dotandola di un chiaro ogg di studio, metodo e rapporto tra ricerca di base e

applicata.

¾ Skinner: teoria dell’apprendimento operante Æ rifiuta il dualismo mente-corpo e ritiene che anche i

processi mentali possano essere indagati con metodi delle scienze naturali, in situazioni sperimentali.

Diventa importante l’interazione tra comportamento e ambiente.

¾ Kantor: elabora ulteriormente il concetto di interazione. Privilegia come oggetto di studio la

coordinazione dell’intero organismo all’interno di un campo. Per spiegare il comportamento umano,

non solo funzioni stimolo e funzioni risposta, ma anche eventi situazionali (ciò che caratterizza il

setting).

Anni 60: integrazione dei due modelli ha prodotto paradigmi operanti nella ricerca in età evolutiva e

applicazioni in campo educativo in soggetti con ritardo mentale.

Capitolo 5:

METODOLOGIA DELLA RICERCA IN PSICOLOGIA: PIANIFICAZIONE, CONTROLLO E MISURA

(Paolo Moderato e Renato Gentile)

Ogni disciplina scientifica è caratterizzata, oltre che da affermazioni teoriche specifiche, da una serie di

riconoscimenti (assunti) più o meno espliciti che riguardano:

- la filosofia della scienza (assunti metateorici)

- i fenomeni da osservare (assunti teorici)

- i metodi di ricerca

(assunti metodologici)

Kuhn ha utilizzato per identificare questi elementi, il termine paradigma.

Questo termine viene utilizzato in un senso più ristretto per definire:

- i dispositivi fondamentali usati dal ricercatore per produrre il fenomeno che lo interessa (rif. paradigma

di ricerca).

La scelta del paradigma dipende strettamente da ciò che vogliamo studiare.

Quindi ogni buona ricerca deve partire da una buona definizione del proprio oggetto di studio.

Considerare un fenomeno, significa formulare delle ipotesi sul processo: su quali sono le variabili e che

funzione reciproca svolgono.

Va elaborato, a partire dal paradigma, un piano sperimentale (progettazione del disegno sperimentale) che

permetta lo studio dei singoli elementi (e la verifica delle ipotesi specifiche) con il minimo possibile di

errori.

Per cui vanno definite le possibili variabili interferenti (possono minacciare la validità della ricerca).

8

Un buon disegno deve rispettare due esigenze di controllo(procedimenti utilizzati per eliminare le minacce

alla validità della ricerca):

- individuare le fonti di errore (funz. preventiva): controllo metodologico

- verificare l’effettiva influenza delle var. indipendenti che agiscono nell’esperimento (funz. diagnostica):

controllo statistico

CONTROLLO SUL PIANO METODOLOGICO:

Il campionamento: ha la funzione di limitare o controllare possibili fonti di interferenza. Il campione

deve possedere le stesse caratteristiche della popolazione per poter poi generalizzare i risultati ottenuti a

tutti gli altri membri della popolazione. Quando ciò è possibile, la ricerca ha validità ecologica e i suoi

risultati sono facilmente estendibili. Il campione rappresentativo risulterà tanto più selezionato quanto più

numerose saranno le variabili che definiscono la popolazione.

Metodo: pretest (accerta l’omogeneità dei sogg per una o più caratteristiche), parallelizzazione tra gruppo

sperimentale e di controllo(casuale o in base ai risultati ottenuti al pretest), blocchi randomizzati (2 gruppi

omogenei fra loro ma non internamente).

Il piano sperimentale 1: il controllo riguarda : le variazioni della situazione.

Standardizzazione e taratura

Il compito va standardizzato (non ci devono essere differenze nella consegna) e tarato per i soggetti

dell’esperimento (evitare floor effect Æ livello troppo alto, prestazioni scarse o ceiling effectÆ difficoltà

bassa, livello massimo di performance).

Bisogna ricordarsi che anche le aspettative dello sperimentatore sono una possibile var. interferente (effetto

Rosenthal: influenza la condotta dello sperimentatore e la raccolta dati Æ si elimina col doppio cieco).

Il piano sperimentale 2: il controllo riguarda: il numero e tipo di variabili.

Progettazione del tipo di piano

→ per numero di var. indipendenti: disegni unifattoriali o multifattoriali

→ per tipo di var. indipendenti: disegni intersoggetti (between) o intrasoggetti (within)

¾ I disegni unifattoriali:

- between-subjects hanno tanti gruppi quanti sono i livelli della variabile, in modo da somministrarne uno

solo per ciascun gruppo.

- within-subjects hanno un unico gruppo che sottopongono a tutti i livelli della var. (disegni a misure

ripetute)Æ prestet (baseline), trattamento e post-test.

¾ I disegni multifattoriali sono più diffusi perché rispettano di più il contesto naturale dove si danno

numerose var. che interagiscono:

- quello between-subjects è noto come piano fattoriale a gruppi indipendenti

- quello within-subjects richiede l’uso di piani fattoriali a misure ripetute (una variante è il disegno a

trattamenti alternati).

¾ I disegni fattoriali a piani sperimentali combinati:

- disegno con più variabili miste, è il disegno fattoriale misto

- disegno con 2 variabili, di cui 1 within-subjects è il piano a quadrato latino

- disegno con più variabili, di cui 1 within-subjects, è il disegno fattoriale split-plot

- disegno con più variabili, di cui 2 within-subjects, è il disegno fattoriale split-split-plot

Var. interferenti intra-soggettti:

- sensibilizzazione: l’assuefazione altera la prestazione.(x ovviare: distanziare le prove nel tempo)

9

- pratica: effetto dell’allenamento sulla prestazione (x ovviare: utilizzare disegno between-subjects o

controbilanciare l’ordine di presentazione dei compiti)

- carry over: influenza degli effetti dalla prova “prima” a quella “dopo”.(Difficile da eliminare. X

ovviare: distanziare temporalmente le prove)

- effetti relativi all’ordine e alla sequenza (x ovviare: bilanciare i trattamenti così che un sogg li riceva in

tutti gli ordini possibiliÆnel quadrato latino si controlla l’effetto dell’ordine,ma non la successione)

I disegni between-subjects risultano generalmente più validi (validità interna: la var. indipendente è la causa

degli effetti osservati sulla var. dipendente) di quelli within-subjects, che invece hanno una maggiore

validità ecologica (validità esterna: i risultati sono generalizzabili alla popolazione e a situazioni diverse) ed

hanno una più immediata generalizzabilità dei risultati.

CONTROLLO STATISTICO

¾ Le analisi statistiche dei risultati di un esperimento si operano a due livelli:

- analisi descrittiva : la statistica descrittiva serve a presentare in modo chiaro le informazioni disponibili

per favorire la produzione di inferenze.

- inferenza statistica : verifica delle inferenze con i test più idonei.

¾ Metodi della statistica descrittiva:

- Distribuzioni di frequenza: le osservazioni vengono distribuite in classi ordinate in senso crescente o

decrescente, nelle quali si calcola la frequenza delle osservazioni presenti;

- Misurazioni della tendenza centrale: media (Sx/N), mediana (val centrale in una distribuzione),moda

(val. più frequente);

- Misure di dispersione o variabilità: varianza (scostamento medio delle osservaz. rispetto alla media) e

deviazione standard (scostamento quadratico medio)

- Forme della distribuzione: la più nota è la curva di Gauss o curva normale. Perché i dati prendano

questa distribuzione bisogna che le misure di tendenza centrale coincidano, i dati si dispongano

simmetricamente rispetto al punto centrale e la curva deve essere mesocurtica

- Correlazione e Regressione: servono rispettivamente per stabilire se c’è una relazione (il grado di

dipendenza funzionale tra i fenomeni) e di che tipo;

¾ Metodi della statistica inferenziale:

- Stime dei parametri della popolazione: si calcola il valore che con maggior probabilità corrisponde al

parametro della popolazione oppure l’intervallo entro il quale il parametro oscilla;

- Verifica delle ipotesi: verificare, a un certo grado di probabilità, la validità dell’assunzione che le

statistiche riferite al campione siano indicative anche dei parametri della popolazione.

Si sottopone a verifica l’ipotesi nulla H0: perché possa essere accettata le differenze del campione devono

essere dovute al caso con una probabilità superiore a una soglia (0,05 o 0,01). Se la probabilità che siano

dovute al caso è inferiore alla soglia, allora le differenze saranno significative (p<0,05) o altamente

significative (p<0,01)

Gli errori possibili sono di due tipi:

- I tipo: respingere H0, anche se è vera. Si associa a una probabilità α

- II tipo: accettare H0, anche se è falsa. Si associa a una probabilità β.

La potenza di un test (di respingere H0 quando è falsa) è uguale a 1-β.

MISURE E SCALE

Nella verifica delle ipotesi si possono usare test parametrici: si devono usare test non parametrici se le

osservazioni sono misurate su scala non parametrica o quando le popolazioni di riferimento non sono

normali.

Test parametrici sono più potenti dei non parametrici.

10

Def. misura: il procedimento mediante il quale le proprietà aritmetiche di un insieme ordinato di numeri reali,

vengono attribuite a un insieme di eventi empirici (Caracciolo).

Si considera che gli elementi dei due insiemi stabiliscano tra loro relazioni analoghe, tale per cui è possibile operare

sugli eventi come sui numeri. La relazione eventi-numeri è chiamata Scala di Misura.

Stevens studiò questo problema in psicologia e delineò quattro tipi di relazioni eventi-numeri:

1) relazioni di IDENTITA’: scala nominale, a classi o categorie omogenee al loro interno secondo un

“etichetta”, il numero ha valore nominale;

proprietà: equivalenza (riflessiva, simmetrica e transitiva)

es. Sistema diagnostico DSM IV

2) relazioni di ORDINE: scala ordinale, a ranghi, i numeri hanno valore di ordine crescente/decrescente;

proprietà: equivalenza + maggiore/minore di (non riflessiva, asimmetrica e transitiva)

es. valutazioni di profitto con voti agli studenti

3) relazione di INTERVALLI: scala a intervalli; scala a 0 arbitrario, quantitativa:, i numeri rappresentano

l’ampiezza delle distanze tra gli elementi e delle differenze tra due gradini qualsiasi della scala;

proprietà: operazioni algebriche

es. scala celsius o fahrenheit

4) relazione di RAPPORTO: scala a rapporti; scala a 0 reale che coincide con l’origine della scala stessa,

quantitativa, i numeri rappresentano i rapporti tra gli elementi;

proprietà: tutte le operazioni aritmetiche.

Solo le ultime due scale sono parametriche e solo agli elementi di queste possono essere applicati i test

parametrici: ANOVA, t di Student.

Capitolo 6:

IL METODO SPERIMENTALE NELLE APPLICAZIONI PSICOLOGICHE

(Santo Di Nuovo)

La ricerca di base tende all’incremento delle conoscenze e non si pone obiettivi pratici diretti, mentre la

ricerca applicata mira alla soluzione di problemi operativi ed è orientata verso decisioni mirate agli

interventi: il metodo sperimentale è tipico delle scienze “naturali” dove esiste una netta distinzione tra

“osservatore” e “osservato”ed è’ stato applicato alla psicologia fin dalle fasi della sua fondazione.

Questo metodo non si adatta in quelle aree:

- dove è importante la relazione soggetto-operatore;

- dove la complessità investe sia le relazioni tra variabili che le modificazioni dovute all’intervento dello

sperimentatore.

RICERCA SUI GRUPPI

Per risolvere questo tipo di problematiche si utilizza la ricerca-intervento(def. action research proposta da

Lewin nel 1948): un tipo di ricerca che è al tempo stesso momento di conoscenza scientifica della realtà

(ricerca di base) e contributo all’attivo cambiamento di essa (ricerca applicata):

-

¾ Oggetto di studio:

come avviene il cambiamento e in quale misura

nel caso in cui avvenga come ipotizzato, quali siano i fattori di ostacolo e quali lo favoriscano

quali sono gli effetti del trattamento a breve e lungo termine

11

¾ Metodo:

- la verifica delle ipotesi e il trattamento avvengono in contemporanea;

- i destinatari dell’intervento sono coinvolti attivamente nel processo di definizione e verifica degli

obiettivi;

- processo ciclico ricorrente: formulazione di ipotesi e obiettivi → intervento → verifica degli effetti →

aggiustamento delle ipotesi e degli obiettivi.

¾ Punti deboli: la necessità, a volte, di modificare il disegno di ricerca in itinere,sia per le variabili sia

per il campionamento.

¾ Problemi caratteristici dell’action research:

- la posizione del ricercatore non è neutra;

- il punto di vista del ricercatore influenza non solo lo studio delle ipotesi e l’analisi dei dati, ma anche il

“durante” della ricerca;

- le capacità relazionali del ricercatore e i suoi valori assumono un’importanza fondamentale.

Def. ricerca applicata rappresenta un processo di problem solving, nel quale la situazione-problema può

essere costituita di diverse situazioni (disagio psichico,stato di incompetenza, situazione di rischio di

malattia, ecc) Esso è un processo in diverse tappe:

1) delimitazione del problema

2) formulazione di un ipotesi diagnostica, mirata alla comprensione dei processi che mantengono il

problema e degli aspetti strutturali;

3) definizione degli scopi

4) intervento mirato alla soluzione del problema, inserito in un contesto relazionale e guidato del

ricercatore;

5) verifica periodica del cambiamento;

6) follow-up a distanza.

→ attenzione agli aspetti evolutivi e relazionali: c’è l’assunzione dell’impossibilità di scomporre-isolare le

variabili di un oggetto che è un sistema complesso.(la ricerca di base scompone il fenomeno per studiarlo e

ridurne la complessità; l’action research non può farlo!)

¾ Nella sperimentazione si usa il massimo controllo delle variabili, usando gruppi di controllo, al fine di

ridurre il più possibile l’errore. Il controllo tra gruppi non è usato perché spesso poco affidabile: è

difficile trovare gruppi confrontabili, o a volte eticamente scorretto, e spesso influenzato in maniera

poco prevedibile dal drop-out. Il metodo per garantire l’equivalenza è la randomizzazione (selezione

casuale della pop. di riferimento e assegnazione casuale a gruppi), ma se non è possibile, si può fare il

matching dei soggetti tra gruppo sperimentale e di confronto, che hanno le stesse caratteristiche nelle

var. da controllare. Se né randomizzazione, né matching sono possibili, si ha un disegno “quasisperimentale”(il gruppo di controllo non è equivalente).

¾ La varianza di errore attribuibile a mancato controllo delle variabili diventa un’informazione essenziale

sulla diversità dei soggetti e degli effetti: con un campione ampio, anche se non casuale, è necessario

conoscere le caratteristiche dei soggetti e le variabili osservate per correlarle (disegno correlazionale).

Ma anche la correlazione può essere dovuta a una variabile “altra” latente, di livello superiore a quelle

analizzate. Al criterio di significatività si sostituisce quello di rilevanza in relazione agli obiettivi fissati:

il trattamento funziona e i risultati non sono dovuti al caso.

¾ La composizione del campione nell’action research, quasi mai ha criteri di casualità o stratificazione

tipici dei disegni sperimentali.

¾ Attività fondamentale diventa l’assessment: valutazione e monitoraggio degli effetti.

Servono strumenti:

- che possano essere somministrati in modo rapido;

- ripetibili frequentemente;

12

- adatti al contesto (≠ strumenti già validati, ma in altri ambiti);

- adatti al campione con cui si lavora;

Esempi: colloquio, l’intervista, questionari self-rating e altri strumenti utilizzati invece solo

occasionalmente, questo per avere un assessment multiplo che permetta ipotesi diversificate.

I disegni applicativi privilegiano misurazioni in fasi successive delle variabili da modificare mediante il

trattamento. I dati ottenuti si dispongono in serie temporali (time- series) che permettono lo studio del

cambiamento:

- Per controllare il fattore “tempo”, esso può essere inserito nei disegni fattoriali quale variabile.

1.

2.

3.

Disegno a un baseline:

misurazione della baseline: si registrano le var. a intervalli regolari;

intervento: continuano le misurazioni;

verifiche periodiche.

- Disegno a baseline multipli: verificare se gli effetti di trattamenti diversi si verificano in corrispondenza

dell’introduzione di questi in momenti diversi. Possono valutare:

• Var. differenti nello stesso sogg. (fra comportamenti)

• Stesso var. in sogg. diversi (fra soggetti)

• Stessa var. nello stesso sogg. In situazioni diverse (fra setting)

Questi disegni pongono molti problemi metodologici in aggiunta a quelli che già si pongono con la baseline

semplice.

¾

-

Critiche:

il controllo delle var. è limitato a una o poche per volta;

non vengono considerate adeguatamente le differenze individuali dei soggetti;

gli strumenti di assessment spesso hanno effetti sulle var.

RICERCA SU CASI SINGOLI

Il soggetto è controllo a se stesso e l’uso di sequenze alternative di trattamenti alternativi fa da controllo

logico, per confrontare ipotesi contrapposte nella spiegazione degli effetti di ciascuno di essi.

Sono un utile strumento per il controllo e monitoraggio del lavoro quotidiano.

Ma hanno scarsa generalizzabilità: si diventa ragionevolmente sicuri del successo/insuccesso del

trattamento su quel caso (interesse per il clinico), ma non sul fatto che quell’intervento sia valido per altri

soggetti (interesse per il ricercatore).

Per aumentare la generalizzabilità, vanno ripetuti numerosi interventi su casi singoli (disegno “N = 1 alla

volta”), ripetizione che può essere sistematica per variabili prese in considerazione.

→ La generalizzazione non può essere solo su base logica, ma deve avvenire su base empirica con studi di

meta-analisi.

Capitolo 7:

PROBLEMI E METODOLOGIA NELLA RICERCA PSICOSOCIALE

(Saulo Sirigatti e Cristina Stefanile)

¾ Premessa

La ricerca psicosociale accetta una visione deterministica dei fenomeni, per cui il comportamento è un

oggetto definibile e causato da eventi specificabili.

Per questo, il metodo sperimentale è quello preferibile. Nel contesto applicativo, dove le var. sono

complesse e difficilmente isolabili, vengono utilizzati i disegni cosiddetti deboli come i disegni quasisperimentali, correlazionali, descrittivi.

13

DISEGNI:

Le minacce alla validità della ricerca sono raggruppabili in 4 categorie: statistica, interna, di costrutto di

causa-effetto, esterna. Esaminiamo quindi diversi tipi di ricerca con validità diverse:

1. Pre-test e Post-test con un gruppo (es. progetto sul burn-out)

Viene incluso tra gli approcci pre-sperimentali. Si fa un test come diagnosi del quadro iniziale, si applica

l’intervento, e si fa un test di verifica sugli stessi soggetti.

¾ Minacce:

- drop-out selettivi (dovuti forse ad attenuazione dell’evento indipendentemente al trattamento)

- effetti dovuti alla storia (eventi estranei al trattamento,maturazione)

- effetto Hawthorne (miglioramento nelle prestazioni dovuto alla consapevolezza nei soggetti di essere

studiati)

- regressione verso la media (per probabile errore di misurazione)

¾ Qualità:

- disegno snello, poco invasivo e poco costoso

- l’effetto Hawthorne comunque va nel senso del cambiamento cercato

2. Pre-test e Post-test con due gruppi non equivalenti (es. Ed. motoria su bambini e funz. cognitive)

E’ il disegno quasi-sperimentale più frequente: si effettuano il pre-test e il post-test su due gruppi ma solo

su un gruppo si applica l’intervento.

¾

-

Minacce:

interazione tra elementi come storia, maturazione, ecc. e modalità di selezione

diffusione o imitazione del trattamento all’interno del gruppo di controllo (validità di costrutto)

impiego di campioni “opportunistici” (validità esterna)

¾ Qualità:

- disegno snello

- controlla gli effetti principali: storia, maturazione, effetto Hawthorne

3. Approccio correlazionale (es. anomia e caratteristiche sociali negli anziani)

Mira a identificare le possibili relazioni tra due variabili.

Non definisce un rapporto di causalità perché non controlla la possibilità di terze variabili latenti che

influenzino entrambe le var. prese in considerazione.

¾

-

Qualità:

setting naturale

acquisizione di informazioni utili sulla popolazione generale

utile nelle fasi iniziali di una ricerca

4. Approccio descrittivo (es. questionario sulla scuola x infermieri)

Disegno di ricerca finalizzato all’illustrazione/rappresentazione, il più accurata possibile, di eventi che

interessano il ricercatore. Ai dati ottenuti, per esempio, attraverso un sondaggio di opinione vengono

applicate analisi statistiche descrittive, che danno un’idea generale sull’oggetto di studio.

5. Ricerca-intervento (vedi Cap. 6)

14

Action-research lewiniana, introdotta negli anni 40, si proponeva di applicare sul campo i risultati degli

studi sulle dinamiche di gruppo. I punti cardine consistono quindi nell’attenzione al cambiamento sociale e

nella partecipazione attiva dei gruppi coinvolti.

¾

-

Qualità:

procedura flessibile e adattabile durante l’esperimento

prevede verifica in ogni fase

può produrre profonda conoscenza socioculturale della realtà in cui si fa l’esperimento

consente integrazione tra conoscenza teorica e applicazione

¾

-

Critiche:

troppo influenzabile da eventi accidentali

validità scientifica insufficiente e risultati poco generalizzabili

campioni scarsamente rappresentativi

TECNICHE PER LA RACCOLTA DEI DATI

Dopo aver deciso il disegno da usare, si deve decidere con quale tecnica raccogliere i dati.

Le informazioni utili al ricercatore in psicologia sociale sono: comportamenti, stati emozionali o mentali,

dati riferiti al contesto-situazione.

¾ Possono derivare da varie fonti:

- informazioni soggettive-verbali acquisite da colloqui, questionari,ecc.

- informazioni acquisite dall’osservazione

- informazioni acquisite da registrazioni di indicatori psicofisiologici

¾ Fonti di minacce alla validità delle misure (Webb, Campbell e al.):

- soggetti: effetto reattivo alla misurazione, consapevolezza di essere esaminati, stili sistematici di

risposta (response set) o scelta di un ruolo per rispondere, la misura può produrre cambiamento su ciò che

misura.

- ricercatore: aspettative, caratteristiche personali, cambiamenti nella tecnica durante la ricerca

- campione: restrizioni che attengono al reperimento dei soggetti, limitazione nell’utilizzo di alcune

misure (es. saper leggere, disporre della vista,ecc), la popolazione da cui estraggo il campione può

modificarsi nel tempo.

¾ Colloquio e Intervista

Sono modalità di raccolta delle informazioni che prevedono lo scambio verbale faccia a faccia tra

ricercatore e soggetto. Possono essere impiegati in diverse fasi dell’esperimento. Sono più o meno

strutturati, duttili e flessibili: l’intervista può essere organizzata lungo un continuum che va da non

strutturata (detta anche tematica o in profondità) a completamente strutturata (detta anche standardizzata).

Comunque sia, il materiale ottenuto con un intervista è spesso molto abbondante e necessita di essere

organizzato per poterlo interpretare. Le informazioni vanno codificate per mezzo di griglie per poi

procedere ad un’analisi quantitativa.

¾ Questionario

Tecnica di auto somministrazione che richiede minima partecipazione da parte del ricercatore. E’ corredato

da istruzioni dettagliate, e la somministrazione può essere individuale o di gruppo.

Gli item sono domande o affermazioni, e attengono a svariati argomenti.

Diverse forme di risposta:

- domande aperte (risposta libera): utilizzato se non si hanno indicazioni circa la gamma delle possibili

risposte ottenibili dai soggetti.

- domande chiuse (risposta multipla):ampiamente usate, prevedono risposte a livello categoriale(es.

diploma, laurea, master,ecc), ma anche ordinale (quando si chiede di mettere in ordine di preferenza)

15

Qualità:

- strumento rigido e standardizzato Æ comparabilità delle risposte

- tempi di rilevazione modesti Æ riduzione dei costi

- strumento versatile Æimpiegabile in diversi tipi di ricerche

- impiegabile per grandi numeri e garantisce l’anonimato

Difetti:

- resoconto soggettivo: si presta a falsificazioni intenzionali delle risposte

- registra quello di cui una persona è consapevole (se non capisce la domanda, risponde male)

- non registra direttamente il comportamento, ma un resoconto di questo.

- scarsa motivazione dei soggetti Æ informazioni poco accurate

¾ Focus group

Affine all’intervista, si caratterizza per il tipo di setting e per le procedure di attuazione. E’ un’intervista

basata sulla discussione di gruppo, che produce un particolare tipo di dati qualitativi. Particolarmente usata

in psicologia della salute.

L’incontro è programmato quanto alle linee essenziali e finalizzato alla raccolta di informazioni. La

discussione si attiva a partire da uno “stimolo” che propone il ricercatore.

Questa tecnica evidenzia sia le dinamiche di interazione, che i contenuti.

Il gruppo deve avere da 6 a 12 persone. La durata di una sessione è di 1 o 2 ore. La discussione viene

generalmente audio- o videoregistrata.

¾ Osservazione diretta

Registrazione dei comportamenti verbali e non verbali di alcuni soggetti in una specifica situazione. Di

solito implica un osservatore esterno alla situazione che registra; si usa anche l’osservazione partecipante,

nella quale il ricercatore svolge duplice ruolo, prendendo parte attiva alla situazione che osserva.

La consapevolezza di essere osservati influenza il comportamento dei soggetti (effetto Hawthorne). Una

corretta osservazione è volta a ricavare campioni rappresentativi del comportamento e a questo scopo si

deve definire prima, chi e cosa osservare, per quanto tempo e in che modo.

Il ricercatore può registrare una vasta gamma di indicatori, vanno definite:

- le categorie di osservazione

- le unità di comportamento

- frequenza delle osservazioni

- durata delle osservazioni

Il ricercatore si costruisce una griglia di osservazione dove le categorie si autoescludono e coprono tutta la

gamma dei comportamenti possibili (registrazione degli eventi)

L’osservazione è considerato un buon metodo nella ricerca sociale, ma piuttosto complesso e impegnativo.

Il supporto audiovisivo consente una maggiore affidabilità dello strumento.

¾ Diari

La tecnica del diario trova utilizzi nella ricerca psicosociale, soprattutto negli ambiti della salute e del

lavoro. Registrazione di eventi, effettuate direttamente dalla persona coinvolta, e ancorati a determinati

periodi temporali. Possono essere più o meno strutturati.

Nell’ottica della ricerca-intervento, questa tecnica di auto-osservazione, facilita il coinvolgimento del

soggetto che può favorire il cambiamento desiderato.

Può produrre anche effetti reattivi indesiderati e minare la validità della ricerca.

¾ Tecniche proiettive

Vari materiali che hanno in comune l’ambiguità dello stimolo, ampia libertà di espressione, l’assenza,

spesso, di rigidi criteri quantitativi. Permettono di indagare in maniera indiretta vissuti profondi e aree

delicate della personalità. Sono stati oggetto di critiche per la loro scarsa obiettività, e per la supposta

16

appartenenza a modelli di riferimento aprioristici. Sono utili e hanno una validità accettabile, se utilizzati

nelle fasi preliminari di una ricerca.

¾ Tecniche psicofisiologiche

Tecniche che consentono di misurare reazioni psicofisiologiche in un soggetto in relazione a un eventostimolo. Il loro impiego richiede apparecchiature complesse e competenze specifiche. Sembra importante

evitare di fondarsi su singoli indicatori, ma utilizzare molteplici elementi che consentano di ottenere un

ampio profilo di risposta individuale.

¾ Tecniche non intrusive

Tecniche di osservazione indiretta, registrazione all’insaputa del soggetto di informazioni attuali o passate

tratte frequentemente da materiale d’archivio.

Il problema più evidente è la scelta degli indicatori da utilizzare.

CENNI PER L’ELABORAZIONE DEI DATI

¾ Esplorazione di strutture latenti

Si ricorre a statistiche come:

- analisi fattoriale (es. SPSS)

- uso di rotazioni di fattori

- analisi dei cluster (raggruppare unità o oggetti simili tra loro)

Le ricerche svolta in questo modo spesso danno risultati contrastanti o poco confrontabili per diverso

numero di fattori estratti, differente rotazione applicata.

¾ Verifica della corrispondenza dei dati empirici ai modelli teorici

Procedura statistica complessa: l’analisi fattoriale confirmatoria, si basa su quattro indici:

- χ quadro (bassi valori corrispondono a un buon Fit)

- relativi gradi di libertà (buon modello = χ quadro/G.L. ≤ 2.0)

- indice di Goodness-of-fit (GFI)Æ grado di adeguatezza del modello; si usa per confrontare due modelli

(0-1: dove 1 è perfetta adeguatezza)

- misura dell’ampiezza media dei residui stimati (RMR)

¾ L’esame di differenze tra gruppi

La ricerca prevede a volte di accertare le differenze tra gruppi per una caratteristica. Dopo una elaborazione

descrittiva (media e deviazione standard) si procede all’analisi della varianza a una via per determinare

l’eventuale significatività statistica delle differenze.

Limiti Æ quando si svolgono ripetuti confronti, c’è la probabilità che alcuni risultino casualmente

statisticamente significativi. Inoltre variabili intercorrelate, vengono trattate come indipendenti.

¾ Previsione di eventi

Un obiettivo importante è dato dalla previsione di eventi futuri basato sui dati disponibili.

Procedure statistiche sui dati disponibili:

- regressione semplice

- regressione multipla

con il calcolo del coefficiente di correlazione.

→ sono tecniche parametriche e si posso applicare solo su dati parametrici!

¾ Analisi di contenuto

Nelle indagini psicosociale, spesso si raccolgono dati qualitativi. Per trattarli bisogna predisporre uno

schema di classificazione, conosciuto come analisi di contenuto. Vi sono diverse tecniche per la formazione

di uno schema di classificazione dei dati qualitativi secondo tre differenti approcci.

L’approccio può essere:

17

- qualitativo: se si vuol comprendere il significato del materiale

- quantitativo: per ottenere dati numerici da elaborare in seguito

- strutturale: mettere in luce relazioni latenti tra il materiale raccolto.

In ogni caso il ricercatore dovrà decidere quali categorie impiegare in base ai suoi scopi.

Per rendere questa procedura più attendibili è utile utilizzare più codificatori e poi calcolare un indice di

accordo.

PROCEDURE RECENTI

- Simulazioni al computer Æ reti neurali basate su modelli connessionistici.

- Meta-analisi Æ sintesi delle conoscenze acquisite da diversi studi sullo stesso argomento.

Capitolo 8:

EFFICACIA DEGLI INTERVENTI TERAPEUTICI E PSICOSOCIALI

(PierLuigi Morosini e Paolo Michielin)

Def. efficacia: in campo sanitario, la capacità di modificare in senso favorevole il decorso di una malattia o di un

problema, o in altri termini, di produrre esiti di salute migliori di quanto non possa avvenire in caso di decorso

spontaneo. Occorre inoltre che i benefici siano superiori ai possibili affetti collaterali.

Efficacia sperimentale ≠ efficacia nella pratica: la prima riguarda gli studi su soggetti selezionati e in

laboratorio, mentre la seconda riguarda le condizioni quotidiane della professione, con soggetti non

selezionati..

¾ Fattori che ostacolano l’attribuzione di successo di casi singoli alla psicoterapia applicata (var.

interferenti):

1. miglioramento o remissione spontanei

2. regressione verso la media

3. effetto placebo

4. fattori aspecifici appartenenti alle varie tipologie di psico-terapie (es. alleanza terapeutica)

5. selezione dei casi

6. soggettività nell’interpretazione degli esiti.

¾ Principi di valutazione dell’efficacia:

- Confronto tra pazienti trattati in modo diverso

- Confrontabilità dei gruppi a confronto ( i gruppi dovrebbero essere simili per i fattori di significato

prognostico, come età, gravità di malattia, ecc)

- Confrontabilità delle rilevazioni dei dati: utilizzare stessi criteri di rilevazione per la diagnosi, la

prognosi, e l’esito, utilizzando il doppio cieco.

- Completezza degli esiti: devono essere valutati soprattutto gli esiti importanti per la qualità di vita del

paziente e non solo quelli fisiologici.

- Completezza del follow-up: valutare gli effetti a lungo termine (benefici iniziali possono tradursi in

peggioramenti)

- Replicabilità dei trattamenti: devono essere ben descritti, così da poterli replicare

- Valutazione dell’importanza della variabile “casualità”

- Comparabilità tra pazienti trattati (pazienti sui quali si è vista l’efficacia, devono essere simili ai

pazienti sottoposti agli altri trattamenti)

- Continuità nel tempo dello studio (valutare eventuali effetti collaterali dopo la fine della terapia)

- Costi (a parità di efficacia, quale trattamento costa meno in termini di tempo e soldi?)

¾ Disegni di ricerca per la valutazione degli interventi:

Si può operare uno studio di ricerca controllato randomizzato (Trial): se approvato da un comitato etico, i

soggetti si assegnano casualmente ai due trattamenti da confrontare.

18

Perché lo studio sia ben condotto è necessario:

- mascheramento della randomizzazione

- doppio cieco

- scelta degli esiti importanti e completezza- sufficiente durata del follow up

- considerazione della var. casuale

Questo è il miglior strumento a disposizione, ma ha il limite della ricerca sperimentale: in centri di terapiaricerca applicata, con pazienti non selezionati e poche risorse, non è detto che si avrebbero gli stessi dati.

Un altro disegno è la meta-analisi: studio sistematico delle ricerche effettuate su un determinato argomento

e loro confronto al fine di ottenere evidenze di vari livelli.

Solo una piccola parte degli interventi psicosociale nel mondo è stata oggetto di valutazione rigorosa

dell’efficacia.

Si sa che spesso sono efficaci anche interventi brevi, interventi cognitivo-comportamentali e interventi

gruppali, che hanno un ottimo rapporto tra costi e benefici.

Capitolo 9:

IL PRIMO COLLOQUIO NELL’ASSESSMENT CLINICO

(Ezio Sanavio)

Assessment Æ valutazione iniziale che uno psicologo clinico svolge in rapporto alla possibile presa in

carico di un paziente, al fine di:

- ricostruire meccanismi che sottendono i problemi lamentati

- concordare obiettivi immediati e a lungo termine

- identificare un trattamento adeguato

- decidere per la presa in carico

Vengono formulate ipotesi su relazioni tra disturbi e situazioni, ipotesi di ordine eziopatogenetico, ipotesi

sulle strategie di approccio e sulle tecniche di trattamento: l’assessment procede quindi per falsificazione di

ipotesi. Il primo colloquio è un sottoinsieme dell’assessment. Nell’assessment si usano tre classi di indici:

- indici soggettivi (autoriferiti dal sogg) Æ cognitivo-verbale

- indici motori e comportamentali (dall’osservazione esterna del sogg) Æ comportamentale-motorio

- indici fisiologici (con strumenti di registrazione)Æ psicofisiologico

Il primo colloquio non è autonomo, ma si inserisce in un assessment multidimensionale (comunemente

l’assessment iniziale prevede 2-3 colloqui) e tende a stabilire una relazione collaborativi col paziente.

Attraverso ridefinizione e riformulazione del problema, il colloquio termina con un avanzamento

conoscitivo da parte del paziente.

¾ Topografia dei colloqui iniziali:

- presuppostiÆ il colloquio è reso possibile da un contesto motivazionale

- Fase dei preliminareÆ convenevoli e richiamo degli eventuali antefatti (invio da parte di altri)

- AperturaÆ qual è il problema?

- Specificazione del problemaÆ ottenere descrizione del problema

- Ipotesi di mantenimento Æ esaminare eventuali stimoli che elicitano i disturbi

- AllargamentoÆ specificare problemi attuali oltre al problema di base

- Storia dei problemiÆ ricostruzione dell’inizio del disturbo e formulazioni di ipotesi eziopatogenetiche

- Storia personaleÆtralasciando problemi e patologia, cenni storici sul paziente

- Aspettative di trattamentoÆapprofondire le aspettative del paziente

- Ipotesi di trattamentoÆ precisazione di obiettivi di trattamento possibili

- Formulazione conclusiva e chiusuraÆ restituzione delle informazioni raccolte dai colloqui ed esami

19

Capitolo 10

IL COLLOQUIO IN PSICOLOGIA CLINICA

(Franco Del Corno, Margherita Lang)

(Wiens) Def. Il colloquio è un processo interattivo che ha luogo tra almeno due persone, diverso dalla conversazione

in quanto l’interazione è finalizzata al conseguimento di un obiettivo predeterminato.

Il paziente che si autoinvia Æ è da considerare che c’è differenza tra un paziente che si rivolge per la prima

volta a un terapeuta ed uno insoddisfatto della diagnosi di un altro.

Il paziente inviato dai familiariÆ capire perché i familiari l’hanno inviato e cosa pensa il paziente.

Il paziente inviato da un collegaÆ capire perché lo invia e come il pz ha vissuto l’invio

Il paziente inviato da altre figureÆse l’invio è corretto bisogna differenziare l’approccio tra pz volontario o

coatto.

Dopo aver stabilito un’alleanza diagnostica, bisogna rilevare elementi informativi diretti o inferiti, in modo

da farsi un quadro del paziente. E’ fondamentale indagare anche il funzionamento emotivo, il

funzionamento mentale, le sue modalità di interazione ed eventualmente, se necessari, si possono

interpellare familiari che chiariscano i punti oscuri.

Capitolo 11:

VALUTARE E SCEGLIERE UN TEST

(Luigi Pedrabissi e Alessandra Romito)

Qualità di un test

¾ Il significato del costrutto

Bisogna che sia chiaro il significato del costrutto a cui si è interessati e vedere se corrisponde a quello del

test. I significati espliciti sono riportati nel manuale, ma i significati impliciti si possono ricavare solo

dall’analisi degli item e vanno quindi verificati.

Vanno controllate le affermazioni dell’autore del test in riferimento agli scopi e all’uso del test.

¾ Attendibilità

Grado di ripetibilità dei punteggi ottenuti con un test (necessaria ma non sufficiente per la validità di un

test). Le fonti di errori sistematiche sono eliminabili. La fonte di errore sempre presente è la casualità,

quindi un certo margine è tollerato (maggiore è l’errore casuale, minore la coerenza dello strumento).

Punteggio ottenuto = punteggio “reale” + quota di errore

Si può testare un gruppo di sogg e utilizzare medie e DS dei punteggi del gruppo per derivarne le stime

dell’attendibilità.

Questa stima sui gruppi si calcola come:

- fedeltà test-retest (correlazione tra risultati del test in due tempi diversi: maggiore è la correlazione,

maggiore è l’attendibilità)

- coerenza interna, cioè dell’omogeneità degli item (metodo dello split-half, alfa di Cronbach)

- coerenza tra forme diverse (coerenza tra punteggi in forme parallele di test)

¾ Validità

Posto che un test ha punteggi ripetibili (ed è quindi attendibile), ci si chiede se i suoi item hanno indagato

davvero il costrutto che volevamo.

Intesa tradizionalmente come:

- validità di costrutto (detta anche di contenuto) Æ gli item rappresentano il costrutto?

- validità predittivaÆ il punteggio predice il comportamento?

- validità concorrente Æ relazione con punteggi di altri test che misurano la stessa cosa

- validità discriminante Æ relazione col punteggio di altri test che misurano cose diverse

20

¾ Il campione normativo

Deve essere rappresentativo della popolazione e corrispondere alle caratteristiche del soggetto. Importante è

la metodologia di selezione, l’ampiezza e l’attualità del campione.

¾

-

Item

Chiari come formulazioneÆprivi di bias

Essere a una sola dimensioneÆ rappresentare solo un comportamento, concetto.

Rappresentare il costrutto indagato

Questioni pratiche

¾ Somministrazione

Le istruzioni devono essere chiare ed assicurare l’interpretabilità di tutti i punteggi: item omessi, tempi,

livello di abilità necessarie,ecc.

¾ Scoring

Metodi di calcolo dei punteggi:

- Modello cumulativoÆ più alto è il punteggio, più è presente il costrutto nel sogg

- Modello di categorizzazioneÆinserisce la persona in classi,categorie a scopo predittivo

- Modello ipsativoÆ valuta se la prestazione del sogg è diversificata rispetto a certe variabili

¾ Costi

I costi di un test sono economici o sociali.

Le informazioni importanti devono essere esplicitate nel manuale.

Altre fonti di informazione sono: le revisioni critiche e le ricerche pubblicate su quel test.

Per l’utilizzo responsabile di un test psicologico, bisogna avere competenze:

- specifiche sull’uso del test

- relazionali (→ attenzione per le minoranze)

- psicodiagnostiche

Capitolo 12

IL PROCESSO DIAGNOSTICO IN PSICOLOGIA CLINICA

(Francesco Rovetto)

Nosografico/descrittivo : la classificazione è basata sulla descrizione del

quadro patologico osservato

Sistema

Interpretativo /esplicativo: la diagnosi si riferisce a un modello

epistemologico che ritiene le patologie espressione di cause sicuramente

identificate e descritte. [se si facesse unicamente riferimento a tale sistema, la

comunicazione tra operatori di diverso indirizzo sarebbe impossibile e

assumerebbe aspetti paradossali]

Nessuna classificazione dei disturbi mentali può avere un numero sufficiente di categorie specifiche per

comprendere tutti i casi clinici immaginabili. Pertanto ogni operazione diagnostica, per quanto corretta e

accurata, costituisce una forzatura, un limite e non solo un vantaggio per la comprensione del paziente in

quanto individuo.

In psicologia clinica non esistono i casi puri e lineari, nonostante ciò bisogna cercare di collocare il quadro

patologico del paziente in un sistema nosografico, per potersi “intendere” con i colleghi. Bisogna evitare

21

impulsività diagnostica ed eccessivo tecnicismo: utilizzare test per confermare o respingere le ipotesi

costruite sulla prima impressione.

E’ anche vero che una precoce e puntuale diagnosi consente di fare riferimento alla esperienza della

comunità scientifica, di comunicare quanto si è fatto, di esprimere una prognosi o valutare i rischi di

trasmissione ereditaria o le possibili evoluzioni di un quadro patologico.

Il sistema multiassiale oltre a consentire di identificare in modo universale le patologie tiene conto di alcuni

dei principali aspetti della vita e dell’esistenza del paziente (DSM IV)

La diagnosi viene emessa solo quando i sintomi superano il valore di soglia sia per durata che per intensità,

diventando così invalidanti.

Def. La diagnosi è un ragionamento plausibile e utile che mette ordine tra i fenomeni psicopatologici osservati,

utilizzando un minimo di inferenze.

¾ I disturbi mentali sono spiegati partendo da diverse prospettive e da diversi concetti:

1. lo stress (es. disturbo acuto da stress)

2. l’alterato controllo (es. disturbi del controllo degli impulsi)

3. la menomazione e la disabilità (es. demenza)

4. mancanza di flessibilità (es. disturbi dell’adattamento)

5. quadro sindromico, sintomatologico e comportamentale presentato (es. DCA, disturbi sessuali)

6. eziologia (es. disturbi d’ansia, disturbi da sostanze)

7. deviazione statistica (es. disturbi di personalità, ritardo mentale)

Se la diagnosi è corretta si tratta della migliore ipotesi fattibile in quel momento. A essa deve seguire un

costante tentativo di validazione. L’andamento nel tempo del caso e la risposta alla terapia possono fornire

occasione per una conferma, una modificazione o una smentita della diagnosi.

¾ Finalità diagnostiche:

1. indirizzare la scelta terapeutica

2. facilitare la comunicazione tra operatori

3. rendere possibili le indagini epidemiologiche ed eventuali studi genetici oltre alla stesura di

statistiche sanitarie

4. rendere possibile una prognosi in base all’andamento tipico di pazienti con patologie

5. valutare l’efficacia di un trattamento farmacologico psicoterapeutico.

6. facilitare la reperibilità su mezzi informatici

7. facilitare la formazione di gruppi omogenei di pazienti sui quali c0mpiere ricerche

8. fornire un chiarimento lo stesso paziente che può sentirsi rassicurato nel vedere che la sua

patologia è nota ed esistono realistiche possibilità terapeutiche

9. fornire i concetti base necessari per formulazioni teoriche i ambito scientifico

Il processo diagnostico, soprattutto se mal condotto e mal utilizzato, presenta notevoli rischi. La diagnosi è

una previsione che spesso tende ad autoavverarsi [ETICHETTATURA]. La persona deve essere vista come

un tutto senza dimenticare che i disturbi psicopatologici variano nel tempo, per cui la diagnosi ha una sua

validità limitata nel tempo

Una sindrome è un insieme di sintomi che, di solito, si manifestano in concomitanza.

Dopo aver identificato un sintomo, per esempio una condizione di tristezza, il passo successivo consiste

nell’analizzarlo più approfonditamente. La tristezza può essere un sintomo isolato o la punta di un iceberg.

Se è affiancata ad altri sintomi accuratamente descritti può consentire la diagnosi di disistima o depressione.

Una volta identificato il sintomo primario si va quindi alla ricerca di eventuali sintomi correlati.

22

¾ La diagnosi multiassiale secondo il DSM-IV

-

Asse 1: disturbi clinici e altre condizioni che possono essere oggetto di attenzione clinica.

Asse 2: disturbi di personalità e ritardo mentale. Utilizzato anche per annotare meccanismi di

difesa maladattivi che non raggiungono la soglia per un disturbo di personalità.

Asse 3 : condizioni mediche generali

Asse 4: problemi psicosociali e ambientali. Sull’asse IV si riportano i problemi psicosociali ed

ambientali che possono influenzare la diagnosi, il trattamento e le prognosi dei disturbi mentali.

Asse 5: Scala per la valutazione globale del funzionamento (VGF): Questo tipo di informazione è

utile per pianificare il trattamento o misurare il suo impatto e per predire l’esito. Il VGF può essere

utile per misurare i progressi clinici. Il VGF riguarda il funzionamento psicologico, sociale e

lavorativo.

Nel DSM-IV per la descrizione di ogni classe patologica sono descritte:

- Caratteristiche diagnostiche;

- Sottotipi e/o specificazioni;

- Procedure di registrazione;

- Manifestazioni o disturbi associati;

- Caratteristiche collegate a cultura, età e genere;

- Prevalenza;

- Decorso;

- Familiarità;

- Diagnosi differenziale.

I sintomi, per diventare indicatori di patologia, devono essere quantificati, valutati, posti in relazione con le

condizioni di vita del paziente , con le sue condizioni fisiche e con la sua cultura di riferimento.

¾ La diagnosi secondo il modello multimodale di Lazarus

Lazarus propone di prendere in considerazione 7 dimensioni in ciascun paziente : BASIC ID

B = comportamento

A = processi emotivi

S = sensazioni e funzionamento degli organi sensoriali

I = immaginazione

C = cognizioni

I = rapporti interpersonali

D = aspetto organico (farmaci e dieta)

¾ La diagnosi in ambito cognitivo comportamentale

Il modello legato alla diade S-R non è mai stato applicato fuori dall’ambito sperimentale. Negli ultimi anni

si è usata l’ analisi funzionale e la strategia diagnostica, definita come “formulazione del caso”: non

specifica una diagnosi, ma mette a fuoco le condizioni che precedono la comparsa del problema, compresi

gli schemi cognitivi appresi in età infantile e rinforzati dall’abitudine. Oltre agli aspetti motori vengono

compresi aspetti affettivi e fisiologici. Particolare importanza viene attribuita alle dinamiche individuali e

sociali di induzione e mantenimento del quadro patologico.

23

Capitolo 13

PSICOFISIOLOGIA SPERIMENTALE E CLINICA

(Daniela Palomba, Luciano Stegagno)

Def. Interessi primari della psicofisiologia clinica sono lo studio e la comprensione di quei meccanismi di

anomala reattività dell’individuo: la relazione reciproca tra eventi mentali, comportamento e disfunzioni

somatiche o psichiche è l’elemento centrale di studio.

La psicofisiologia clinica ha l’impianto concettuale e metodologico della psicofisiologia dalla quale deriva

ed ha due elementi fondanti:

- la psicologia sperimentale (da cui prende il metodo di studio)

- la fisiologia (da cui prende gli strumenti d’indagine e le basi funzionali)

es. patologia coronaria (correlazione tra personalità e modificazioni fisiologiche)

La psicologia clinica, la medicina e la psichiatria possono quindi ricorrere alla psicofisiologia clinica per

l’indagine dello stato funzionale di apparati fisiologici, risposte endocrine, ecc e per la correlazione delle

modificazioni osservate con eventi mentali e comportamentali.

¾ L’assessment psicofisiologico:

L’assessment si riferisce alla raccolta di tutte le informazioni necessarie per inquadrare il disturbo del

paziente, per stabilire un’ipotesi patogenetica e per impostare un intervento: l’accertamento può riferirsi sia

alla fase diagnostica, che alla fase di verifica dell’andamento del disturbo durante il trattamento.

¾ Caratteristiche dell’accertamento psicofisiologico:

Il requisito fondamentale deve includere componenti soggettive (resoconto del paziente) e oggettive

(alterazioni fisiologiche e comportamentali)

¾ Strumenti principali dell’assessment psicofisiologico

Gli strumenti indagano il disturbo a tre livelli:

- soggettivo-cognitivoÆ valutazione della condizione psicofisica e del proprio stato emotivo da parte del

paziente

- comportamentale-espressivo Æcomportamenti manifesti o situazioni sociali che precedono, si

associano o conseguono al sintomo

- fisiologicoÆ modificazioni somatiche correlate al sintomo-malattia. Viene valutato in condizioni basali

e di attivazione.

¾ Criteri metodologici:

I dati devono essere decifrati e interpretati in modo da costituire elementi informativi utili alla diagnosi e al

trattamento. Per far ciò bisogna:

- effettuare misurazioni di base ripetute (baseline) e replicare l’accertamento in condizioni diverse (es. al

lavoro)

- eseguire l’accertamento ai tre livelli, soggettivo, comportamentale e psicofisiologico

- tentare una valutazione quantitativa della sintomatologia (in modo da confrontarla con il posttrattamento)

% di miglioramento = valore di baseline – valore post-trattamento x 100

valore di baseline

L’accertamento psicofisiologico è utile se inserito in un programma più ampio che preveda tre aspetti:

ricerca(es. stress sul lavoro), prevenzione (es. prevenzione cefalea) e inquadramento diagnosticotrattamento (es. disturbi d’ansia).

24

Capitolo 14:

APPRENDIMENTO

(Paolo Moderato e Maria Lea Ziino)

L’apprendimento è prima di tutto uno strumento di adattamento dell’uomo verso l’ambiente come

l’evoluzione: Darwin per primo mise in evidenza come l’evoluzione e l’apprendimento interagiscano.

In termini più moderni: la trasmissione genetica e l’apprendimento non sono fattori antagonisti, ma processi

che interagiscono in funzione di un miglior adattamento dell’uomo al suo ambiente.

Def. apprendimento: quella modificazione comportamentale che consegue a, o viene indotta da,

un’interazione con l’ambiente ed è il risultato di esperienze che conducono allo stabilirsi di nuove

configurazioni di risposta alle situazioni-stimolo esterne.

Ogni organismo percepisce le variazioni dell’ambiente in cui vive: queste variazioni sono chiamate stimoli

o evento-stimolo.

Il cambiamento ha come oggetto la risposta, intesa come forma diversa di comportamento. Le modalità di

produzione di risposte dono due:

- risposte elicitate: conseguono automaticamente alla presentazione dello stimolo, sono reazioni

psicofisiologiche in reazione al perturbamento di un sistema che le attiva in funzione di ritrovare

l’omeostasi;

- risposte emesse: comportamenti tendenti a modificare l’ambiente, sono molto variabili, dalle più

semplici alle più complesse, praticamente comprendono l’ampia gamma delle manifestazioni umane.

La relazione stimolo-organismo è influenzata (acquista significato e rilevanza differente) da una terza

variabile, il contesto: definibile come l’insieme di eventi situazionali che fanno da sfondo a una particolare

situazione.

Vi sono anche cambiamenti non imputabili all’apprendimento:

- dovute a fattori fisiologici (es. crescita), oppure patologici

- fenomeni come l’assuefazione (diminuzione della risposta di fronte al ripetersi dello stimolo) e la

sensibilizzazione (es. fuga davanti all’iniezione) Æ si estinguono rapidamente

I cambiamenti dovuti all’apprendimento hanno perlopiù valore adattivo: La sopravvivenza della specie è

assicurata dall’apprendimento e dalla selezione naturale.

Misure del cambiamento in psicologia:

1. la forza della risposta (in senso analogo a quello fisico)

2. l’ampiezza della risposta (misura quantitativa: es. salivazione nel paradigma pavloviano)

3. la latenza della risposta (tempo tra stimolo e risposta)

4. la durata (periodo durante il quale il comportamento appreso è attivo)

5. la frequenza (numero di volte in cui un comportamento viene attuato in una situazione)

6. numero di tentativi o prove che vengono effettuate prima che un soggetto abbia appreso un

comportamento

APPRENDIMENTO E CONDIZIONAMENTO: PAVLOV

Pavlov era un fisiologo russo che mise a punto, con la pubblicazione del 1927 di “Riflessi condizionati” , il

paradigma del condizionamento classico o rispondente.

Pavlov studiava l’attività digestiva dei cani, e notò che la salivazione compariva anche in presenza del solo

sperimentatore senza cibo.

25

Salivazione in presenza di cibo = risposta incondizionale (RI)

Cibo = stimolo incondizionale (SI)

Associando per un certo numero di volte uno stimolo neutro (SN) come una luce, al cibo (Si), si assisteva

alla comparsa del riflesso condizionato (RC).

Un evento neutro acquista valenza di evento-stimolo perché è associato (associazionismo) a un eventostimolo.

Si (carne) Æ Ri (salivazione)

Si (carne) + Sn (luce) Æ Ri (salivazione)

Sn (luce) Æ Rc (salivazione)

APPLICAZIONI DERIVATE DAL PARADIGMA PAVLOVIANO

Il paradigma pavloviano, non riguarda solo gli animali, ma interessa molti fenomeni umani: su questi si

basa la tecnica del bio-feedback per l’eliminazione della paura e delle fobie.

Se si ha paura di uno stimolo non pericoloso, essa non è adattiva e quindi significa che si è instaurata una

fobia.

Watson, negli anni ’20, descrisse il caso del “Piccolo Albert”: W. condizionò Albert sperimentalmente alla

paura di una cavia bianca (associandola ad un forte rumore improvviso). Albert generalizzò la sua paura ad