115

Dopo una iniziale facilitazione, lo spostamento dell'attenzione causa

un effetto inibitorio sull'unità che codifica la localizzazione. Mentre nella

figura 98 lo spegnimento dell'indizio e lo spostamento dell'attenzione

coincidono nel tempo, nella figura 99 possiamo verificare che è

quest'ultimo la causa dell'inibizione.

4.12 Il modello di Grossberg

Nonostante il fatto che Houghton dimostri come sia possibile

implementare un meccanismo di controllo adattivo della dinamica neurale,

il

modello

ha

alcuni

difetti

invalidanti.

La

semplificazione

dell’elaborazione sensoriale e “motivazionale” è infatti eccessiva, per cui è

difficile ricercare analogie nei sistemi biologici. L’architettura proposta

risulta quindi piuttosto debole ed implausibile, anche se il processo che

riesce a portare a termine presenta un sicuro interesse.

Un’architettura molto più ammissibile è stata suggerita da

Grossberg in un altro contesto, quello del condizionamento classico.

Sebbene si possa pensare, di primo acchito, che condizionamento classico

ed attenzione selettiva siano due temi poco correlati, in realtà il modello di

Grossberg, opportunamente adattato, è in grado di esibire performance

simili a quello di Houghton utilizzando una struttura che ha nella

plausibilità biologica il suo punto di forza.

Il modello di Grossberg che prenderò in considerazione (Grossberg

1982, 1988, 1991) è stato originariamente concepito per riprodurre su di

una rete neurale artificiale i fenomeni tipici del condizionamento classico,

come il paradigma del “blocking”. Nel blocking uno stimolo condizionato

CS1, ad esempio un tono, viene ripetutamente seguito da uno stimolo

incondizionato US, ad esempio uno shock elettrico, dando vita al consueto

apprendimento. Successivamente CS1 è presentato assieme ad un altro

stimolo condizionato, CS2, ad esempio una luce, seguiti sempre da US.

Ciò che si verifica è che CS2 non è in grado di elicitare una risposta

116

condizionata:

è

come

se

CS1

“bloccasse”

l’apprendimento

dell’associazione CS2 ⇒ US in quanto CS1 è sufficiente per predire

perfettamente US. Una spiegazione di tale fenomeno è data analizzando il

modello proposto da Grossberg nella figura….

La rete implementa delle unità dove convergono segnali sensoriali e

rinforzanti (limbici) al fine di regolare l’attivazione del sistema in base ai

suoi obiettivi. Nella figura 100 vengono rappresentati tre nodi, X11, X12,

X13, che codificano per tre stimoli: lo stimolo incondizionato US ed i due

stimoli condizionati CS1 e CS2.

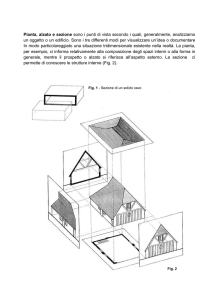

Fig. 100Rete proposta da Grossberg per spiegare il fenomeno del

condizionamento classico e del blocking. Ogni rappresentazione sensoriale ha

due livelli di STM, Xi1 e Xi2. Un CS o US attiva la sua Xi1, che a sua volta elicita

una risposta in Xi2 ed invia un segnale a Y (drive). I segnali incentivanti che si

generano da Y attivano a loro volta il secondo stadio Xi2, che invia segnali di

feed-back a Xi1. I semicerchi rappresentano le sinapsi condizionabili nel lungo

periodo (LTM, Long Term Memory).

Questi nodi sono legati da sinapsi inibitorie: in questo modo si

implementa un meccanismo di competizione locale intra-modulo. Gli

stessi neuroni proiettano all’unità Y, che codifica per un segnale

motivazionale (drive input), ad esempio un segnale omeostatico interno.

Prove neurofisiologiche dell’esistenza di questa classe di neuroni con

proprietà facilitatorie è fornita da Hawkins (Hawkins 1983) e Walters e

117

Byrne (Walters e Byrne 1983) con studi condotti sul mollusco Aplysia.

Quest’unità proietta al secondo stadio di unità , le Xi2 , che codificano uno

stadio successivo di rappresentazione degli stimoli, a loro volta connesse

unidirezionalmente con delle unità motorie e reciprocamente con il primo

strato.

Uno stimolo incondizionato attiva, nel modello, l’unità US, che per

definizione elicita una risposta dell’unità Y, la quale a sua volta proietta

alle unità Xi2 e genera una risposta motoria. Si presuppone infatti che

esista una via preferenziale, geneticamente costituita, che associ ad un dato

stimolo una certa risposta motoria: una sorta di riflesso innato, uno stimolo

incondizionato primario sul quale si basano i successivi condizionamenti.

L’apprendimento non sarebbe che una catena ininterrotta dove uno stimolo

che al tempo t era uno CS diviene al tempo t+1 un US per un nuovo

stimolo condizionato.

Alla presentazione di US, i due stimoli CS1 e CS2 risultano inibiti

dalla forte attivazione dello stimolo incondizionato filtrata dalle sinapsi

inibitorie. Questo processo simula un meccanismo di STM interno alla rete

e dimostra come stimoli con importanza adattiva riescono a spostare il

focus dell’attenzione verso la propria elaborazione.

L’accoppiamento di CS1 con US provoca un rafforzamento delle

connessioni fra CS1 e Y in virtù dell’aumentare dell’attivazione di Y

generata dallo stimolo incondizionato, US. In sostanza, si tratta di un

apprendimento hebbiano. Una successiva presentazione di CS1 sarà in

grado di generare una risposta incondizionata.

Il fenomeno del blocking è spiegato dal concetto di STM: una volta

attivato, uno stimolo significativo (nel nostro caso, un CS1 appreso)

inibisce le altre rappresentazioni sensoriali, compreso un eventuale CS2. In

questo modo, CS2 non rafforza le proprie connessioni con Y in quanto la

regola di Hebb presuppone la coincidenza dell’attivazione delle unità

affinché si abbia apprendimento. Lo stesso modello spiega anche il perché

118

fra due stimoli da condizionare debba trascorrere une certo ISI (Inter

Stimulus Interval): con un ISI troppo piccolo, lo stimolo incondizionato

blocca l’elaborazione di quello condizionato monopolizzando la STM,

mentre con ISI troppo lunghi la rappresentazione sensoriale dello stimolo è

decaduta dalla STM.

Una ulteriore complicazione del modello è necessaria per spiegare il

fatto che non solo l’apparizione di uno stimolo, ma anche la sua sparizione

può essere fonte di apprendimento. Basti pensare ad una luce che viene

presentata in concomitanza con la cessazione di una stimolazione

dolorosa: questo CS viene interpretato come una fonte di sollievo, uno

stimolo positivo, anche se di positivo nell’ambiente non c’è nulla: anzi, si

registra piuttosto la presenza di uno stimolo nocivo. La figura 101

schematizza

l’architettura

proposta

per

spiegare

questo

ulteriore

fenomeno.

Fig 101 Un esempio di un “gated dipole”. In risposta alla presentazione e

successiva privazione di uno stimolo rinforzante (J, input fasico) mentre viene

fornito un arousal costante alla rete (I, input tonico), si verifica una risposta

positiva del canale on (on-response) ed una risposta off (off-response) in seguito

allo spegnimento del segnale. Vedere testo per i dettagli.

Nel modello del “gated dipole” proposto da Grossberg uno stimolo

fasico codificante per un rinforzo, J, viene presentato all’unità di sinistra

(canale On) della rete assieme ad un input tonico I (arousal). I due canali

119

codificano per rinforzi di segno opposto, uno positivo e l’altro negativo. Il

segnale viene elaborato da X1 e X2, con l’attivazione della prima che

supera quella della seconda grazie all’input fasico di J, e filtrato da Y1 e

Y2, due sinapsi caratterizzate da un accumulo/deplezione di trasmettitore

in seguito a rispettivamente inattività /eccesso di attività . Grazie alla

maggiore attivazione di X1, viene attivata l’unità X3, che a sua volta eccita

la X5 , l’unità di output, e inibisce la X6 del canale opposto. Lo

spegnimento dell’input J, ad esempio un rinforzo positivo, priva l’unità X1

del suo input fasico. Nel frattempo, la sinapsi Y1 si è privata di buona parte

del suo trasmettitore, mentre la Y2 è stata oggetto di un processo di

accumulo. Il risultato è un ampio segnale eccitatorio generato dal canale

silente nella prima fase del rinforzo che segue immediatamente lo

spegnimento del target, generando un output che potrà essere utilizzato

come fonte di condizionamento per uno stimolo che sia apparso in

concomitanza con questo evento. Il processo consente quindi di

condizionare non solo l’apparizione, ma anche la scomparsa di uno

stimolo.

4.13 Unità superiori: livello associativo

Nei paragrafi finali della tesi analizzeremo l’implementazione degli

ultimi strati della rete. L’obiettivo è quello fare esibire al modello dei

comportamenti più articolati: acquisire una certa risposta ad una data

configurazione

sensoriale

e

incrementando

l’elaborazione

spostare

di

il

oggetti

proprio

focus

che

appreso

ha

attentivo

essere

determinanti attraverso procedure di rinforzo. Per ottenere queste

prestazioni è necessario introdurre alcuni ulteriori strati di neuroni

artificiali.

Il livello che segue immediatamente le unità semplici sarà chiamato

strato delle unità associative, in quanto questi neuroni ricevono notevoli

proiezioni dalle SI, sinapsi che sono soggette a rafforzamento o

120

decremento selettivi utilizzando una regola di apprendimento, appunto,

associativa. Per semplificare, le associative ricevono proiezioni solo da SI:

nelle simulazioni sarà quindi più conveniente utilizzare stimoli con alta

frequenza spaziale, elaborati preferenzialmente da quest’ultime.

Lo strato delle associative è molto ristretto: a scopo descrittivo,

sono state implementate 12 unità (Fig. 102) che ricevono proiezioni da

tutte le SI sottostanti, oltre che dalle altre associative, fornendo a loro volta

una connessione di feed-back: la rete passa quindi a 5.172 neuroni

artificiali e 528.411 sinapsi. L’attivazione della i-esima unità associativa è

data dalla (14):

AiASS = Σ OiSEMI WiASS-iSEMI

(14)

dove AiASS è l’attivazione della i-esima unità associativa, Σ OiSEMI WiASSiSEMI

è la sommatoria dell’output della i-esima unità SI pesata per la

connessione che da SI raggiunge le associative. Ogni unità associativa

riceve quindi 361 x 6 = 2166 connessioni dallo strato SI. La funzione di

output dell’unità associativa è data dalla (15):

se AiASS < 0

OASS =

⇒ - (-AiASS) ℜ

se 0≤ AiASS ≤ 10 ⇒ 0

(15)

se AiASS > 10 ⇒ AiASS ℜ

Per questa funzione, ℜ è fissato a 0.3. Per simulare la maggiore

refrattarietà alla scarica dei neuroni più interni del SN, la soglia è stata

alzata: l’unità è silente per input la cui somma è compresa fra 0 e 10.

I pesi della simulazione possono essere inizializzati a piccoli valori

casuali compresi fra –1 e +1; è altrimenti possibile aprire un set di pesi che

sia stato memorizzato in precedenza in seguito ad una procedura di

apprendimento, come vedremo tra breve.

121

L’inizializzazione casuale dei pesi genera un altrettanto casuale

risposta delle associative. Vedremo fra breve come, attraverso

Fig. 102 Schema dell’organizzazione dello strato associativo. Ogni unità

associativa (in viola) riceve proiezioni da tutte le unità dello strato SI, al quale

restituisce connessioni di feed-back (in verde). Nella figura è esemplificata la

connettività di A1. Questa è reciprocamente connessa, oltre che con le SI, anche

con tutte le altre associative.

l’applicazione di una semplice regola di apprendimento, queste unità

presentino una spiccata attitudine a modificare le proprie sinapsi in modo

tale da specializzare la propria risposta nei confronti di alcuni stimoli.

Prima di vedere in pratica come e perché, introduciamo l’ultimo strato

della rete.

122

4.14 Unità rinforzanti

Questo ultimo strato implementa delle unità che codificano per

rinforzi negativi o positivi. Ovviamente, non è possibile manipolare il

vissuto “psicologico” della rete creando unità la cui attività rappresenti una

particolare sensazione “biologica”. Quello che si ricerca è un parallelismo

nell’architettura.

Lo strato contiene 2 unità rinforzanti (R1+ ed R1-, Fig. 103), che si

ipotizza ricevano un input motivazionale (ad esempio, un segnale

omeostatico) che viene in realtà fornito dall’utente. Non è difficile

immaginare un paragone fra queste unità ed i neuroni dell’ipotalamo, o le

cellule facilitatorie trovate da Kandel nell’Aplysia. Queste due unità

rinforzanti ricevono proiezioni dalle 12 associative ed a loro volta

proiettano a due unità del secondo stadio dello strato rinforzante (R2+ ed

R2-). Queste chiudono il loop con le associative attraverso 12 connessioni.

Fig. 103 Strato delle unità rinforzanti. I due canali sono rappresentati in blu

(R1+, R2+) ed in giallo (R1-, R2-). R1+ ed R1- ricevono connessioni dalle 12

associative e proiettano con una connessione eccitatoria (in nero) all’unità R2 del

proprio canale ed una connessione inibitoria (in rosso) alla R2 del canale

opposto. Quest’ultime chiudono il loop motivazionale con le associative.

123

La funzione di attivazione delle R1+ e R1- è la convenzionale

funzione pesata degli input, con la variante di un “veto” posto dall’unità :

questa scarica solo se esiste un input rinforzante, altrimenti non scarica

indipendentemente dall’ampiezza dell’attivazione proveniente delle unità

associative.

Il secondo strato di unità , le R2+ ed R2-, è concepito al fine di

evitare uno sgradevole inconveniente computazionale. Infatti, se la R1+ e

la R1- non interagissero in un primo stadio con il segnale proveniente dalle

associative, ma competessero solo in base alla forza del drive interno,

potrebbe accadere che un drive che abbia un’attivazione maggiore di un

altro propaghi il proprio output verso le associative anche in mancanza di

un adeguato input ambientale. In sostanza, questo tipo di architettura

consente alla rete di rispondere non solo in base all’entità del rinforzo, ma

anche in base alla presenza di un input ambientale congruente.

La versione finale della rete conta quindi 5.176 neuroni artificiali e

528.439 sinapsi.

I due canali si ispirano all’architettura del “gated dipole” di

Grossberg: viene ipotizzato che questi codifichino per due rinforzi di

segno opposto (nel modello, R1+ ed R1-). Se la rete avesse una dinamica

temporale, avrebbe senso implementarla anche in queste unità . Si potrebbe

allora riprodurre i fenomeni già visti per la rete di Grossberg. In questa

simulazione, ci accontenteremo di notare come queste unità possano

veicolare l’apprendimento delle unità associative e determinare la

selezione attenzionale di alcuni stimoli a scapito di altri. Per le unità

rinforzanti, ℜ è 0.8.

4.15 Apprendimento ed attenzione selettiva: simulazione

Vedremo in quest’ultima simulazione come la rete, nella sua

versione finale, sia in grado di apprendere dei pattern di stimolazione e

selezionarli attentivamente nelle successive presentazioni.

124

Nelle precedenti simulazioni ci eravamo fermati allo stadio di feedback verso le unità intermedie. Da qui il segnale fluisce modificato verso

le SI che a loro volta proiettano alle 12 unità associative. Queste calcolano

il proprio stato di attivazione ed il proprio output, non prima di aver

inizializzato le connessioni a piccoli valori casuali compresi fra –1 e +1. A

questo punto le unità generano un primo stadio di competizione locale, nel

quale l’unità più attiva tende a “spegnere” quelle meno attive o inibire

ancora più profondamente quelle già depresse. Dopo questo singolo ciclo

di competizione locale, il segnale si propaga alle unità rinforzanti, sempre

previa inizializzazione casuale dei pesi. A questo punto le R1+ e R1leggono l’eventuale segnale rinforzante. Senza di esso, non si genera alcun

feed-back verso le unità associative e la rappresentazione in quest’ultime

decade progressivamente dopo la cessazione dell’input ambientale.

Qualora invece fosse presente un segnale rinforzante, le R1+ e R1si attiverebbero. Se, ad esempio, viene fornito un input di 5 alla R1+ e di 0

alla R1-, la R2+ viene eccitata e la R2- inibita. A questo punto si genera un

feed-back verso le associative. Questo segnale a sua volta causa

l’instaurazione di una sorta di loop motivazionale, in cui le associative e le

rinforzanti si stimolano vicendevolmente. E’ in questa situazione che ha

luogo l’apprendimento, in quanto la modifica a lungo termine delle

connessioni sinaptiche è praticamente impermeabile alle veloci variazioni

di attivazione tipiche della MBT, ma sensibile a stati come questi, che

potrebbero essere definiti di risonanza. La regola di apprendimento

utilizzata nella simulazione è una variante della regola di Hebb: se l’unità

pre-sinaptica e quella post-sinaptica sono contemporaneamente attive,

allora il peso che le connette viene rafforzato estesa (tab. 2). Nel caso in

cui le unità siano inattive, non si verifica alcun cambiamento. In tutti gli

altri casi, l’efficienza della sinapsi diminuisce.

125

UNITÀ PRESINAPTICA

UNITÀ POSTSINAPTICA

PESO SINAPTICO

>0

>0

⇑

>0

≤0

⇓

0

>0

⇓

>0

0

⇓

0

0

-

Tab 2. Regola di modifica dei pesi sinaptici. La connessione viene rafforzata in

presenza di coincidenza d’attivazione fra le unità pre e post-sinaptiche (⇑

⇑ ),

mentre viene decrementata in caso contrario (⇓

⇓ ). Se le due unità sono entrambe

inattive, non si ha alcuna modifica(-).

L’applicazione di questa regola di apprendimento genera un pattern

di pesi sinaptici in grado di modificare la curva di attivazione delle unità

associative: da una primitiva risposta indifferenziata si passa ad una più

fine sensibilità verso un certo stimolo (Fig. 104).

attivazione

attivazione

4

3

2

1

0

b

c

d

pattern

e

0.05

f

g

5

4

3

2

1

0

b

c

d

e

0.05

f

g

pattern

Fig. 104 Selettività nell’attivazione di un’unità associativa prima (sinistra) e

dopo (destra) apprendimento. L’unità passa da una riposta abbastanza erratica ad

una fine discriminazione di un particolare stimolo. Pattern ed attivazione sono

arbitrari.

Allo stesso tempo vengono assoggettati ad apprendimento anche i

pesi sinaptici che connettono reciprocamente associative ed unità

rinforzanti.

126

Fig. 105 Modello generale. Per motivi di esposizione, la nello schema non è

riprodotta la ricchezza delle connessioni. Vedere testo per i dettagli.

127

A questo punto la rete possiede, per la prima volta, un’esperienza

“personale”. Quel determinato pattern è stato associato ad un certo stato

motivazionale. In linea di principio, se tutto funziona nel dovuto modo,

alla presentazione di due pattern, di cui uno è stato precedentemente

rinforzato e l’altro è invece giudicato neutro dalla rete, le connessioni di

feed-back verso le unità semplici dovrebbero selettivamente inibire

l’oggetto non target, il distrattore, qualora lo stato motivazionale della rete

propenda per quel particolare drive. Detto in termini del nostro modello, se

un pattern è associato ad un rinforzo positivo, la presenza di questi tipo di

segnale contribuisce ad incrementare l’attivazione dell’oggetto ad esso

associato in una precedente fase di apprendimento. Negli esempi seguenti

si potrà constatare come la rete sia in grado di riprodurre questo fenomeno

e quindi esibire una forma di attenzione selettiva, seppur primitiva e

semplificata. La figura 105 permette di visualizzare la struttura

complessiva della rete. E’ impossibile riprodurre in una figura

bidimensionale la ricchezza delle connessioni di feed-back e feed-forward,

nonché la loro polarità e forza. Lo schema rende però l’idea del tipo di

architettura utilizzata, una combinazione di organizzazioni gerarchiche ed

in parallelo. Le unità associative, come detto, sono connesse unicamente a

SI. A lato dei cubi rappresentanti quest’ultime, come delle SII, sono

riprodotti i campi recettivi delle unità (6 per le SI, 8 per le SII). I numeri

rappresentano le dimensioni delle griglie. In tutto la rete utilizza 5.176

neuroni artificiali e 528.439 sinapsi.

128

Fig. 106 In quest’ultima simulazione verrà analizzata la capacità della rete di

apprendere l’associazione di una data configurazione visiva (un quadrato

luminoso) con un rinforzo e di selettivamente attendere quegli stimoli che ha

appreso essere determinanti.

Fig 107 Feed-back di SI ed SII verso le intermedie. Solo le SI proiettano alle

associative. Per questo motivo viene utilizzato uni stimolo con frequenza

spaziale relativamente alta.

129

Fig. 108 Strato delle unità associative. L’attivazione delle 12 unità è

rappresentata da una scala di grigi, l’inibizione dal rosso. Tutte le associative

sono interconnesse fra loro e ricevono proiezioni da tutte le SI. I pesi sono

inizializzati a piccoli valori casuali compresi fra –1 e +1. Nella figura è stato

eseguito un ciclo di competizione locale.

Fig. 109 Strato delle unità rinforzanti. I pesi sono inizializzati casualmente (il

valore ha un analogo nel colore, grigio-attivazione, rosso-inibizione). Le caselle

bianche servono all’utente per inserire il valore del rinforzo nei due canali ( 3 e

0). Le due connessioni rosse centrali sono inibitorie, le due nere eccitatorie. Da

R2+ l’output si propaga tramite feed-back alle associative.

130

Fig. 110 Unità associative in seguito al feed-back delle rinforzanti. L’attivazione

dell’unità A vince la competizione locale ed è pronta a generare un processo di

apprendimento.

Fig. 111 Pesi sinaptici che legano l’unità A con le SI. Come si può facilmente

notare, la coincidenza fra l’attivazione della SI e della associativa incrementa

l’efficienza della connessione, mentre la mancanza di questa coincidenza la

indebolisce.

131

Fig. 112 L’unità N, leggermente inibita, sviluppa dei pesi diametralmente

opposti rispetto alla A: laddove l’una ha un peso eccitatorio, l’altra ne sviluppa

uno inibitorio (in rosso).

Fig. 113 In questa fase la rete sarà testata con due stimoli, di cui uno è il target

precedente (il quadrato centrale) e l’altro è un rettangolo. La stimolazione

dell’unità rinforzante che è stata precedentemente associata al quadrato dovrebbe

innalzare la rappresentazione di quest’ultimo ed inibire quello del rettangolo.

132

Fig. 114 Unità rinforzanti (rinforzo R1+ = 2) con i pesi appresi nel ciclo

precedente. L’output delle R2+ viene trasmesso alle associative.

Fig. 115 Effetto del feed-back delle associative sulle SI. Si può facilmente notare

che la rappresentazione del quadrato (bianca) emerge da una superficie

uniformemente inibita (rossa), eccezion fatta per alcune strutture che codificano

il distrattore. La rappresentazione di quest’ultimo è inibita, ma non

completamente assente.